Atti delle XIV Giornate del GFS

Viterbo, 4-6 dicembre 2003

La “partitura”:

un sistema di annotazione multilivello di interazioni multimodali basata

su ANVIL

Emanuela Magno Caldognetto*, Piero Cosi*, Federica Cavicchio*,

Isabella Poggi°

*ISTC CNR Sezione di Padova “Fonetica e Dialettologia”

°Dipartimento di Scienze dell'Educazione Università di Roma Tre

e-mail: [email protected], [email protected]

1. UNA “PARTITURA”

MULTIMODALE

PER

L’ANALISI

DELLA

COMUNICAZIONE

In una interazione comunicativa faccia-a-faccia il parlante che produce un

enunciato, realizzato oralmente grazie all'attività del sistema pneumo-fonoarticolatorio, trasmesso per via acustica e percepito nella modalità uditiva,

può produrre contemporaneamente gesti e movimenti trasmessi per via ottica

e percepiti nella modalità visiva (Magno Caldognetto e Poggi 2001).

Dal punto di vista metodologico, nell’analisi degli scambi comunicativi, lo

studioso dovrà affrontare due problemi analitici, connessi tra loro:

1- la descrizione esaustiva dei sistemi di comunicazione modo-specifici,

studiati separatamente e indipendentemente l’uno dall’altro;

2- la descrizione delle sincronizzazioni dei segnali che sono all’opera

nell’interazione multimodale, che non necessariamente sono in rapporti di

simultaneità, ma anche di anticipazione o di perseverazione tra le diverse

unità nei diversi segnali.

Con questa serie di dati si potranno definire le interazioni tra i diversi

sistemi all’interno di un atto di comunicazione complesso e formulare le

regole di pianificazione, cioè le regole in base alle quali questi diversi

sistemi di comunicazione interagiscono gli uni con gli altri e insieme

cooperano a costituire il complesso atto finale di comunicazione. Per

descrivere la multimodalità della comunicazione, è stato suggerito e

applicato un metodo (Magno Caldognetto e Poggi 1994, 2001; Poggi e

Magno Caldognetto 1996, Magno Caldognetto et al., in corso di stampa): la

Partitura, un sistema per trascrivere e analizzare i segnali multimodali

classificati sia separatamente che nella loro interazione reciproca.

Questo metodo permette di individuare gli elementi comunicativi trasmessi

simultaneamente da: contenuto verbale del parlato, prosodia, gesto,

movimenti di bocca, occhi, sguardo, sopracciglia, testa e postura, poichè

ogni segnale in ciascuna modalità viene segmentato ed etichettato su cinque

diversi livelli, relativi a:

- Descrizione del segnale, che fornirà una descrizione discorsiva o in

termini di movimenti o di parametri formazionali (se si analizza un gesto

coverbale, vedasi Stockoe 1980; per la descrizione del segnale verbale su

base acustica vedasi § 2).

- Tipologia descrittiva, che classificherà il segnale in base alle categorie

individuate (se si analizza, per esempio, un gesto coverbale quale l’indice

teso e innalzato che si muove avanti e indietro, si sceglierà tra simbolico,

batonico, iconico, ecc.).

- Significato, che riporta una parafrasi verbale del significato di quel

particolare segnale (es. per il gesto simbolico sopra citato: “Stai/state

attento/i” “ Fai/fate attenzione!”); con una opportuna sigla di segnalazione

(M per “Metaforico”) può essere indicato il passaggio da un significato

concreto ad uno astratto o metaforico (da “pesare” a “valutare, giudicare”).

- Tipologia semantica, che classifica il significato di gesti e movimenti in

base ad una tassonomia semantica od ontologica (conoscenze del mondo,

conoscenze della mente del parlante, autopresentazione; l’etichettatura del

gesto coverbale sopra citato sarà “conoscenza della mente del parlante”).

- Funzione, che individua il rapporto semantico fra il segnale considerato e

il concomitante segnale verbale. La funzione può essere ripetitiva, quando

il segnale analizzato ha lo stesso significato del verbale; aggiuntiva, se vi

aggiunge informazioni; sostitutiva, se porta informazioni che l’altro

segnale non esplicita; contraddittoria, se ne contraddice il significato;

indifferente, se i due segnali fanno parte di piani comunicativi diversi.

Oltre a queste valutazioni, che devono essere il più possibile oggettive, cioè

aderenti alla struttura del segnale e non alle “ricostruzioni” dello studioso,

sarà probabilmente da implementare un livello finale di valutazione, non

limitato al solo segmento in analisi, in cui si dovrà utilizzare il contesto per

giungere all’individuazione di sovrascopi e significati indiretti. Ad esempio,

ad un aggrottamento di sopracciglia fornito dall’interlocutore come segnale

di backchannel è possibile attribuire, al di là di un significato letterale di

incomprensione (“non capisco”), un significato indiretto di disaccordo (“non

sono d’accordo con te”). Nel caso del gesto “mano a borsa”, il significato

letterale “ma che dici?” trasmette l’affermazione “non è vero quello che

dici”. In questi casi, a seconda che si stia analizzando il livello letterale o

quello indiretto, si dovrebbero forse utilizzare delle etichette diverse per la

tipologia semantica e la funzione.Un problema metodologico reale potrebbe

porsi quando si dovesse giudicare la funzione non solo dei gesti e dei vari

movimenti rispetto al parlato (che nel nostro approccio è stato scelto come

segnale di riferimento), ma dei gesti e altri tipi di movimenti tra loro, come

nel caso dell’interazione tra espressione facciale e gesto simbolico.

2. LA PARTITURA IMPLEMENTATA IN ANVIL

Analisi della comunicazione multimodale basate sulla Partitura sono state

già presentate nel passato: i risultati ottenuti dall’analisi frame by frame,

della sequenza della registrazione televisiva, dalla sua visualizzazione

contemporanea al segnale vocale grazie a schede di acquisizione quali

Adobe Première, e dall’analisi del segnale acustico, eseguite off line in

termini di caratteristiche spettrali, di andamenti di F0 e di intensità, venivano

riportati manualmente su grafici (Magno Caldognetto e Poggi 1994, Poggi e

Magno Caldognetto 1996). Tali descrizioni potevano generare errori nella

valutazione confrontativa di dati elaborati separatamente e a volte con scale

temporali diverse a causa della diversità dei dispositivi di analisi. Queste

limitazioni metodologiche sono state superate implementando la Partitura su

ANVIL (Kipp 2001) per le sue qualità di robustezza, flessibilità e relativa

facilità d’uso.

E' stato creato innanzi tutto un menu dei sistemi comunicativi che utilizzano

i canali uditivo e visivo e per ciascuno di essi sono stati implementati i

cinque livelli di analisi riportati in § 1.

Ove possibile, per esempio nel caso della tipologia del gesto o della sua

funzione, sono state elaborate, sulla base di ricerche precedenti (per es.

Kendon 1995, McNeill 1992), delle liste di etichette classificatorie inserite in

menu a tendina, mentre per gli altri livelli analitici è prevista una descrizione

discorsiva o una descrizione simbolica (vedasi Poggi 2001 e per i cheremi

Stokoe 1980). Ciò che rende particolarmente utile il sistema ANVIL è la

possibilità di memorizzare le segmentazioni relative a ciascun segnale in

relazione alla scala temporale scelta dalla visualizzazione della forma d'onda

e dello spettrogramma del segnale verbale. Una volta eseguite tutte le

valutazioni previste dalla Partitura, è possibile il controllo delle relazioni

temporali tra le unità delle varie modalità e la valutazione confrontativa dei

significati trasmessi dai vari segnali. Etichettature del segnale restano

comunque totalmente affidate allo studioso.

A fronte delle potenzialità del sistema descrittivo appena illustrato, vanno

ricordati alcuni limiti tecnologici di ANVIL 3.6 soprattutto per quanto

riguarda l’analisi acustica, sia a livello segmentale che soprasegmentale.

Mentre ANVIL prevede solo la trascrizione ortografica delle parole, è già

stato inserito un livello di trascrizione fonetica e sillabica, anche se la

segmentazione non è ancora soddisfacente perché viene eseguita sulla base

dello spettrogramma importato grazie al plug in Sonogram che sembra

presentare errori di allineamento con ANVIL di almeno un frame.

Deve essere anche migliorato il sistema di analisi prosodica e intonativa,

poiché PRAAT, importato in ANVIL, non fornisce per il momento le scale

quantitative di F0 e dell’energia, privando i linguisti di importanti

informazioni. Queste lacune saranno superate con la messa a punto di nuovi

plug in per l’implementazione del sistema ToBI e di diversi tipi di sistemi di

trascrizione (es. grafema-fonema IPA, fonema-visema, vocabolario LISfonemi).

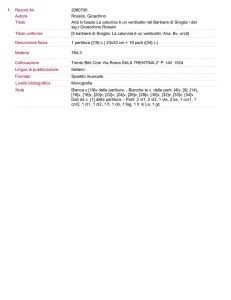

Va ricordato che ogni etichettatura e descrizione viene inserita all’interno di

caselle definite temporalmente in base ai frame in cui è stato individuato il

segnale sottoposto ad analisi. All’interno di ciascuna casella, una volta

attivata, è possibile leggere le relative etichette definitorie, anche se nelle

schermate statiche (Fig. 1), in casi di ridotta durata del track, risultano

disponibili solo le sigle o le iniziali della etichetta o della descrizione. Il

contenuto delle descrizioni e delle categorizzazioni sono disponibili nella

loro completezza e totalità solo nella presentazione multimediale on line:

solo in questo caso, infatti grazie al cursore che scorre lungo l’andamento

temporale del campione da analizzare, è possibile scoprire come

interagiscono, in relazione allo stesso frame le diverse modalità

comunicative. Proprio questa importante caratteristica rende particolarmente

significativo ricorrere a sistemi informatizzati come ANVIL .

3. UN ESEMPIO DI PARTITURA IMPLEMENTATA IN ANVIL

Per illustrare l’utilità della Partitura nell’analisi di diversi casi di

comunicazione multimodale, nel corso della relazione orale, sono stati

presentati campioni di parlato e gestualità coverbale (intervista di un uomo

politico), di parlato e visual prosody (notiziario TV letto da una giornalista),

di parlato ed emozioni (prodotto in laboratorio da un parlante naive), di

lingua dei segni e informazione fonologica trasmessa da movimenti

articolatori visibili (traduttrice in lingua dei segni di un telegiornale). Per

motivi editoriali è possibile riprodurre in questa sede solo la schermata

statica relativa all’analisi di un segmento tratto dall’intervista televisiva di un

uomo politico (S. B.).

Il parlante ha pronunciato la frase /lori’pεto#pernon’εs:erefraιn’tezo#/ in

circa 3000 ms, corrispondenti a 86 frame, e ha prodotto più volte con la

mano destra il gesto dell’anello (ring= “asserisco”). Sulla base dell’attuale

visualizzazione spettrografica il parlato è stato suddiviso in sillabe e, dove

possibile, in foni, individuando inoltre le pause. E’ visualizzato l’elevato e

simile livello di intensità delle tre sillabe iniziali e l’andamento ascendente di

F0 sulla sillaba finale di /ri’pεto/. Il parlante inizia la produzione con un

finger bunch (Kendon 1995) della durata di 8 frame, di seguito si ha la

produzione del primo ring che inizia 2 frame prima della produzione

verbale, è tenuto per l’intera durata della prima pausa (da frame 20 a frame

27), riprende il movimento durante la produzione di /pernon’εs:erefraιn’tezo/

e termina 8 frame dopo l’inizio della seconda pausa, durante la quale si ha

anche la produzione di un simbolico (mano aperta con palmo in

avanti=“attenzione”) nei frame 58-68. Infine, sempre durante la seconda

pausa, c’è la produzione di un secondo ring da frame 69 fino alla fine del

campione.

Fig. 1: Schermata della partitura implementata in ANVIL relativa all’analisi di gesto e

parlato.

I gesti coverbali esaminati hanno funzione aggiuntiva rispetto al parlato e

trasmettono informazioni sulla mente del parlante.

Per quanto riguarda i movimenti della testa, la cui analisi per motivi di

spazio non viene riprodotta in Fig. 1, il parlante compie dei cenni

(movimenti dall’alto verso il basso) verso l’ascoltatore (“mi rivolgo proprio

a te”), l’ultimo dei quali coincide con l’inizio della prima pausa. Lo sguardo

è diretto all’interlocutore (a sinistra del parlante) e tenuto fisso su di esso

(“richiedo la tua attenzione”). Sono presenti solamente due brevi blinking: il

primo in corrispondenza dell’inizio del primo sintagma connesso al topic,

mentre il secondo blinking cade 2 frame dopo la seconda pausa e ha la durata

di 5 frame.

4. FINALITÀ DELLE RICERCHE SULLA MULTIMODALITÀ E PROSPETTIVE

Le analisi ottenute attraverso la Partitura della comunicazione multimodale

implementata in ANVIL hanno come risultato una metodologia descrittiva,

utile per esaminare, segmentare ed etichettare secondo una stessa procedura

campioni audiovisivi che possono poi essere scambiati telematicamente tra

gruppi di esaminatori per contribuire così alla creazione di Corpora

multimodali. Tali analisi, inoltre, sono indispensabili alla messa a punto di

una teoria della comunicazione multimodale poiché implicano, come

abbiamo visto, la definizione delle strutture dei sistemi di comunicazione

non verbali utili a delineare i modelli di produzione della comunicazione

multimodale, indispensabili anche per la costruzione di Facce Parlanti e

Agenti Virtuali (Cassell et al. 2000, Magno Caldognetto e Poggi 2001).

Bibliografia:

1. Cassell J., Sullivan J., Prevost S. e Churchill E., “Embodied Conversational Agents”,

Cambridge (Mass.), The MIT Press, 2000.

2. Kendon A., Gestures as Illocutionary and Discourse Structure Markers in Southern Italian

Conversation, Journal of Pragmatics, 23, 1995, pp. 247-279.

3. Kipp M., “Anvil-A Generic Annotation Tool for Multimodal Dialogue”, in: Proceedings of

Eurospeech 2001, (Aalborg, September 2001), http://www.dfki.de/∽kipp.

4. Magno Caldognetto E., Poggi I., "Il sistema prosodico intonativo e l’analisi multimodale

del parlato", Atti delle IV Giornate di Studio del Gruppo di Fonetica Sperimentale, Torino 1112 Novembre 1993, 1994, pp. 143-151.

5. Magno Caldognetto E. e Poggi I., “Dall’analisi della multimodalità quotidiana alla

costruzione di agenti animati con facce parlanti ed espressive”, in: Cosi P. e Magno

Caldognetto E., (Eds.), Multimodalità e multimedialità della comunicazione, Atti delle XI

Giornate di Studio del G.F.S., Padova 29-30 novembre, 1 dicembre 2000, Padova, Unipress,

2001, pp. 47-53.

6. Magno Caldognetto E., Ursini F. e Poggi I., “Italiano parlato o comunicazione

multimodale? Le ragioni di un successo” Atti del Convegno Italiano parlato, Napoli febbraio

2003, in corso di stampa.

7. Mc Neill D., Hand and Mind, Chicago, University of Chicago Press, 1992.

8. Poggi, I., “Mind Markers” in Gestures. Meaning and Use in Rector, M., Poggi, I. & Trigo,

N. (Eds), Gestures. Meaning and use, Universidad Fernando Pessoa, Porto 2003, pp. 119-132.

9. Poggi I., Magno Caldognetto E.,"I rapporti fra gesto e parlato. Una partitura per l’analisi

della comunicazione", in Studi Italiani di Linguistica Teorica e Applicata, 25,1996, pp. 235256.

10. Poggi I., “Toward the Lexicon and Alphabet of Gesture, Gaze and Touch”,

http://www.semioticon.com, 2001.

11. Stokoe, W. C., (1980) Sign Language Structure, Annual Review of Anthropology, 9, pp.

365-390.