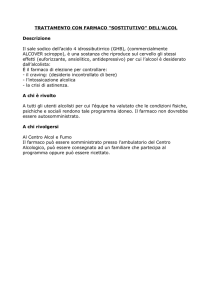

Quelli che seguono sono due capitoli tratti dal libro: Matteo Alemanni Introduzione allo Sviluppo del Farmaco 2012 Edizione ilmiolibro.it ISBN: 9788891026842 Acquistabile sul sito www.ilmiolibro.it e presso le librerie Feltrinelli, e disponibile come e‐book nei principali siti italiani per il download (Amazon, IBS, iTunes). La riproduzione integrale o parziale di questo testo e la sua diffusione per via telematica, purché non a scopi commerciali, è consentita senza limitazioni, a condizione che titolo, autore e la presente dicitura siano integralmente riprodotti. CAPITOLO 8 8 PRINCIPI DI STATISTICA Per garantire l’attendibilità dei risultati ottenuti da uno studio clinico, e quindi anche per assicurarne l’eticità, poiché una sperimentazione clinica che non porti a risultati chiari non è etica, è indispensabile un’accurata pianificazione statistica dello studio in fase di stesura del protocollo, per individuare il numero di soggetti necessari da includere nello studio, e un’analisi statistica attendibile dei risultati al termine dello studio. Tuttavia, nonostante un corretto approccio statistico sia parte fondamentale di ogni studio clinico, una descrizione esaustiva delle metodiche statistiche che vengono correntemente applicate in una sperimentazione clinica è al di là degli scopi di questo testo. In questo capitolo verranno descritti solo i principi che stanno alla base di tali metodiche, mentre si rimanda a testi specifici per un approfondimento delle stesse1,2. Qualunque fenomeno accade in natura è associato a variabilità: il tempo che un masso impiega per cadere da una certa altezza non è mai esattamente il medesimo ogni volta che viene fatto cadere; il picco glicemico nel sangue di un gruppo di soggetti che mangiano lo stesso pasto varia da soggetto a soggetto; la pressione sanguigna di un individuo misurata tutti i giorni alla stessa ora presenta valori anche solo leggermente diversi da un giorno all’altro. Le cause della variabilità insita nell’osservazione di un fenomeno naturale sono molteplici e possono essere anche molto diverse tra di loro: la precisione degli strumenti impiegati per valutare il fenomeno, il cambiamento delle condizioni ambientali tra una misura e la seguente, la presenza di una modificazione significativa tra le rilevazioni o i diversi soggetti presi in analisi. Consideriamo un esempio pratico: un gruppo di soggetti affetti da ipertensione vengono sottoposti a trattamento con un farmaco anti‐ipertensivo. Il valore medio di pressione arteriosa dopo un mese viene comparato con il valore osservato prima dell’inizio del trattamento, e si registra una diminuzione della pressione arteriosa rispetto al valore iniziale. Questo fenomeno biologico ha più possibili spiegazioni: Variabilità biologica Dal momento che ogni fenomeno è associato a variabilità, e che quindi ogni rilevazione di pressione dà anche nello stesso soggetto un risultato diverso, casualmente i valori medi al termine del trattamento erano più bassi rispetto a quelli iniziali. Variabilità connessa all’intervento Il farmaco testato era efficace nell’abbassare i valori di pressione arteriosa, comportando una variazione nei valori rilevati tra l’inizio e la fine del trattamento. Variabilità connessa a un evento esterno Potrebbe essere occorso un evento che ha portato a una modificazione della pressione arteriosa indipendentemente dal trattamento, come una variazione della dieta dei soggetti o l’assunzione concomitante di un altro farmaco che ha un effetto ipotensivo. Variabilità conseguente a un errore Lo sfigmomanometro impiegato per le misurazioni si è starato prima dell’ultima misurazione, oppure è cambiato l’operatore che ha eseguito le rilevazioni. Esistono quindi una serie di fattori che possono aver determinato l’abbassamento dei livelli medi di pressione arteriosa, e che ci impediscono di sapere con sicurezza se il CAPITOLO 8 trattamento è stato efficace, nonostante si sia osservata una diminuzione dei livelli medi di pressione arteriosa. Naturalmente, la variabilità osservata (cioè la diversità dei valori medi tra la prima e la seconda misurazione) può essere dovuta alla presenza concomitante di più di uno dei fattori sopra elencati, e anzi è importante sottolineare come la variabilità biologica sarà sempre presente e, quindi, ad ogni misurazione ci si deve aspettare una variazione casuale dei valori medi. Per poter valutare se la variazione osservata è effettivamente dovuta all’efficacia del farmaco testato, è innanzi tutto necessario adottare una serie di precauzioni per eliminare dove possibile i fattori di confondimento, ovvero tutte quelle variabili che possono influenzare il risultato indipendentemente dal trattamento in esame. Ad esempio, assicurarsi che sia sempre lo stesso operatore che esegua tutte le misurazioni, che lo strumento sia correttamente tarato e che non ci siano differenze sostanziali di età o nelle abitudini alimentari dei soggetti selezionati (questi ultimi aspetti sono considerati nei criteri di inclusione e di esclusione durante la selezione dei soggetti; si veda il capitolo 5). Un importante metodo per minimizzare l’influenza di tutte le variabili di confondimento è l’adozione di un gruppo di controllo: il trattamento viene ripetuto in un secondo gruppo di soggetti (gruppo B) che sono però esposti a placebo. In questo caso, se la diminuzione di pressione arteriosa osservata nel gruppo A (anti‐ipertensivo) è simile a quella osservata nel gruppo B (placebo), il farmaco non viene considerato efficace. Però, anche nel caso in cui la pressione arteriosa diminuisca nel gruppo A e rimanga inalterata nel gruppo B, non si può escludere a priori che questa variazione sia semplicemente dovuta al caso. L’analisi statistica impiega una serie di tecniche matematiche (test statistici) per permettere di distinguere, con un ragionevole grado di sicurezza – ma senza fornire mai la certezza assoluta – tra una variazione casuale e una variazione causale, ovvero dovuta a un intervento esterno (il farmaco anti‐ipertensivo, nel nostro caso). Ripercorriamo ora lo stesso esempio per caratterizzare dal punto di vista statistico gli aspetti fin qui considerati. FORMULAZIONE DELL’IPOTESI Lo scopo dello studio è quello di valutare l’efficacia di un farmaco anti‐ipertensivo. Per poter far questo è necessario formulare un’ipotesi, che verrà accettata o rigettata in base al risultato della sperimentazione. Una corretta formulazione dell’ipotesi è fondamentale per ottenere risultati attendibili da una sperimentazione. Innanzi tutto, dal punto di vista statistico è più semplice rigettare un’ipotesi piuttosto che accettarla, quindi è necessario formulare un’ipotesi che sia rigettabile (falsificabile). Consideriamo l’affermazione: c’è un leone nel parco1. Questa affermazione è difficile da rigettare perché se, andando nel parco, non si vede nessun leone, non si può escludere con certezza la sua presenza. Potrebbe essere nascosto, o stare in una parte del parco in cui non si è guardato. Anche andando nel parco più volte, se il leone non viene visto non si può escluderne la presenza, e quindi non si può affermare con certezza né che il leone c’è, né che il leone non c’è, a meno che il leone venga visto. Consideriamo l’affermazione opposta: non c’è un leone nel parco. In questo caso è sufficiente che durante una sola osservazione si veda un leone, per poter rigettare l’ipotesi formulata. Questo esempio spiega come, se si vuole dimostrare un effetto, piuttosto che cercare in tutti i modi di osservarlo, sia più semplice provare a negare l’opposto. Tornando all’esempio del farmaco ipertensivo, quindi, l’ipotesi da formulare è: non esiste differenza tra il trattamento con il farmaco anti‐ipertensivo e il placebo nel modulare la pressione arteriosa. Questa ipotesi viene definita ipotesi nulla. Tutti i test statistici sono disegnati affinché sia possibile valutare se l’ipotesi nulla è falsa o meno. UNIVERSO E CAMPIONE Come si è già detto, non è mai possibile rigettare o accettare l’ipotesi nulla con certezza assoluta. Questo è dovuto alla presenza della variabilità biologica che comporta una risposta anche solo leggermente differente tra ogni soggetto preso in considerazione; sarebbe possibile CAPITOLO 8 affermare con certezza assoluta che il farmaco in analisi sia efficace nel ridurre la pressione arteriosa se si prendessero in esame tutti i soggetti ipertesi esistenti, considerando anche quelli che diventeranno ipertesi in futuro, il che è chiaramente impossibile. Per cui, necessariamente, dall’universo, ovvero la totalità di individui ipertesi passati, presenti e futuri, viene estratto un campione di individui sui quali verrà eseguito l’esperimento. Il campione è tanto più adatto a valutare l’ipotesi quanto più è rappresentativo dell’universo. Nel nostro esempio, il campione di individui ipertesi è rappresentativo se include soggetti di entrambi i sessi, di età variabile, e con una serie di co‐morbidità che possono influenzare il risultato. Negli studi clinici la rappresentatività viene modulata in base ai criteri di inclusione e di esclusione. Includere individui molto diversi tra di loro, però, se da un lato aumenta la rappresentatività del campione rispetto all’universo, dall’altro aumenta la presenza di variabili di confondimento: una co‐morbidità o una medicazione concomitante, ad esempio, possono ridurre l’efficacia del farmaco anche se questo è in grado di abbassare la pressione arteriosa. Quindi, a seconda dell’ipotesi che si vuole testare, può essere opportuno restringere o ampliare i criteri di inclusione: quando si vuole ottenere la proof of concept (si veda i capitoli 1 e 4) è necessario avere un campione abbastanza omogeneo per valutare se il farmaco sia effettivamente efficace nel ridurre la pressione arteriosa, mentre se si vuole analizzare l’efficacia del farmaco nella popolazione generale, come negli studi di fase III e fase IVb, è desiderabile avere un campione che presenti maggiore variabilità. Inoltre, anche la dimensione del campione ha un ruolo nel test dell’ipotesi. Infatti, è più semplice determinare se il nostro farmaco è in grado di ridurre la pressione arteriosa rispetto al placebo se mille individui vengono trattati con il placebo e altrettanti con il farmaco, piuttosto che trattare dieci individui per gruppo, perché si riduce l’effetto della variabilità della risposta da soggetto a soggetto. STATISTICA DESCRITTIVA Una volta terminata la sperimentazione, la prima esigenza è quella di riassumere i dati ottenuti così da poter avere un’idea generale della sperimentazione stessa. La statistica descrittiva comprende una serie di indicatori statistici che permettono di creare una specie di “riassunto” dei dati. Gli indicatori della tendenza centrale descrivono il valore più rappresentativo di un set di dati. L’indicatore di tendenza centrale maggiormente conosciuto è la media aritmetica (xm), che si ottiene sommando tutti i valori ottenuti xi per un dato parametro e dividendo il risultato per il numero n di dati ottenuti: xm = ∑(xi)/n Nel nostro esempio la media è utile per raffrontare il valore medio di pressione arteriosa prima del trattamento e dopo il trattamento, oppure in seguito a trattamento con farmaco o placebo. Tuttavia, la media aritmetica è un indicatore valido per valori con distribuzione normale, ovvero valori che si distribuiscono in maniera uniforme attorno a un valore medio – cioè la quantità di valori inferiori a xm è approssimativamente simile alla quantità di valori maggiori di xm. Le distribuzioni normali di valori possono essere descritte da una curva gaussiana (si veda la figura a pagina 162, pannello a) e, in virtù della loro simmetria, permettono di condurre dal punto di vista statistico l’analisi più approfondita (quella cioè che permette di ricavare il maggior numero di informazioni dai dati di partenza). Questo tipo di analisi viene detta statistica inferenziale e si basa su alcune assunzioni a riguardo della caratteristiche della popolazione in analisi valide solo quando la popolazione ha distribuzione normale. Nel caso in cui la distribuzione dei dati non approssimi una curva gaussiana (distribuzione non normale, come nel caso del pannello b nella figura, caratterizzata da asimmetria rispetto al valore più rappresentato, cioè il massimo della curva), esistono indicatori della tendenza centrale più appropriati rispetto alla media aritmetica. CAPITOLO 8 Prendiamo in esame questo gruppo di valori: 1 3 5 4 2 2 in questo caso la media aritmetica è un buon descrittore perché tutti i dati sono distribuiti attorno al valore medio 2.83. Se invece consideriamo la serie: 1 3 5 4 2 20 in questo caso il valore medio 5.83 è inadatto a descrivere l’insieme di dati, perché, ad eccezione di un valore, tutti gli altri sono inferiori alla media aritmetica. Il valore 20, molto discostato dagli altri, rende infatti la distribuzione non normale. In questo caso è più opportuno utilizzare la mediana. La mediana si ottiene ordinando tutti i valori, dal minore al maggiore. In caso il numero di valori sia dispari, la mediana è il valore centrale dopo che questi sono stati ordinati. Nel caso il numero di valori sia pari, come nella serie precedente, la mediana è la media aritmetica dei due valori centrali. Nel nostro caso, ordinando la serie: 1 2 3 4 5 20 la mediana è la media tra 3 e 4, cioè 3.5. In questo caso metà dei valori della serie sono inferiori alla mediana, e l’altra metà sono maggiori, come accade per la media aritmetica nelle distribuzioni normali. Un altro indicatore di tendenza centrale comunemente impiegato è la moda, ovvero il valore che ricorre più volte nella distribuzione. Nel caso considerato in precedenza non esiste moda, perché tutti i valori compaiono una volta sola. La moda infatti è un indicatore utile per serie di dati grandi, cioè con molti valori. Può capitare che esistano due valori che si presentino nella distribuzione con una frequenza maggiore degli altri, in quel caso si parla di distribuzione bimodale. È importante sottolineare come nella distribuzione normale media aritmetica, moda e mediana coincidano, mentre nelle distribuzioni non normali questi valori siano diversi tra di loro. Un indicatore di tendenza centrale utile per descrivere insiemi di dati caratterizzati da grande variabilità è la media geometrica (xg), data dalla radice n‐esima del prodotto di n valori xi: xg = (∏xi)1/n La media geometrica è impiegata frequentemente negli studi di farmacocinetica, dove le concentrazioni plasmatiche di farmaco generalmente variano molto da individuo a individuo. Gli indicatori di tendenza centrale da soli non sono sufficienti a descrivere un insieme di dati, perché non forniscono indicazioni a riguardo della variabilità presente in essi. Gli indicatori di dispersione sono stati sviluppati a questo scopo, per descrivere la variabilità. Per il calcolo della maggior parte degli indicatori di CAPITOLO 8 dispersione, è comunque necessario conoscere il valore medio dell’insieme dei dati. Uno dei più importanti indicatori di dispersione è la varianza (2). La varianza è calcolata a partire dalla differenza di ogni dato dalla media. A seconda che il valore del dato sia maggiore o minore della media, la differenza potrebbe essere positiva o negativa, quindi la somma delle differenze dalla media non è un buon indicatore di dispersione perché questo valore tende ad essere prossimo allo zero indipendentemente dalla variabilità associata al campione. La somma dei quadrati delle differenze invece permette di avere una somma di valori positivi. La varianza è calcolata quindi come la somma dei quadrati delle differenze normalizzata per i gradi di libertà, ovvero la dimensione del campione meno uno: 2 = ∑(xi – xm)2 / (n – 1) I gradi di libertà sono la quantità di dati che possono assumere un valore qualsiasi, senza alcuna costrizione matematica. Nel computo della media aritmetica, ad esempio, i gradi di libertà sono n, cioè la dimensione del campione e per questo la somma di valori viene divisa per n. Prendiamo ora in considerazione una serie di tre numeri a b e c che hanno media 4 (cioè questo valore è già noto): (a + b + c) / 3 = 4 appare chiaro come, mentre a e b possono assumere qualunque possibile valore, c dovrà necessariamente essere pari a: c = 12 – a – b così da poter ottenere un valore medio di 4. Per questo motivo c non è “libero” di assumere un qualsiasi valore. Poiché nel computo della varianza è necessario conoscere il valore medio xm, si perde un grado di libertà, quindi la somma dei quadrati deve essere divisa per n – 1. La varianza è un parametro molto importante, perché solo medie derivate da gruppi di dati che hanno varianza paragonabile possono essere comparate tra di loro, per via delle assunzioni matematiche alla base dei test impiegati. Quindi, conoscere la varianza del gruppo trattato con il nostro farmaco anti‐ipertensivo e quella del gruppo trattato con placebo ci permette di sapere, mediante opportuni test statistici, se i risultati ottenuti in questi due gruppi possono essere analizzati con un test di statistica inferenziale. Normalmente, la varianza non viene impiegata per descrivere una popolazione, per via dell’unità di misura, che è il quadrato di quella impiegata per descrivere il dato. Non avrebbe infatti senso parlare di valore medio di pressione sistolica pari a 120 mmHg ± 20 mmHg2. Per questo motivo si preferisce calcolare la deviazione standard (), ovvero la radice quadrata della varianza: = [ ∑(xi – xm)2 / (n – 1) ]1/2 La deviazione standard è l’indicatore di dispersione maggiormente utilizzato. Dal momento che ogni esperimento viene condotto su un campione prelevato dall’universo, e non su tutto l’universo, necessariamente l’indicatore di tendenza centrale rappresenta una stima del reale valore, che si potrebbe ottenere solo se si analizzasse l’intero universo. L’errore standard (standard error, SE) descrive la precisione di questa stima, ed è calcolato a partire dalla deviazione standard: SE = / n1/2 È importante ricordare che l’errore standard non è un indice di dispersione come la deviazione standard, perché mentre questa descrive la variabilità del campione, quello è una misura della precisione della stima del campione stesso, cioè della precisione dell’indicatore di tendenza centrale. CAPITOLO 8 Un alto indicatore di precisione della stima molto impiegato è l’intervallo di confidenza (confidence interval, CI). Esso descrive l’intervallo di valori entro cui con una confidenza di una certa percentuale cade il valore reale dell’indicatore di tendenza centrale. Ad esempio, nel nostro esperimento la pressione sistolica può essere pari a: 120 mmHg (102 – 145 mmHg CI 95%) che significa che il valore medio è di 120 mmHg, e che esiste una probabilità del 95% che nella realtà (cioè nell’universo) il valore medio sia compreso tra 102 e 145 mmHg. Normalmente, gli intervalli di confidenza sono calcolati al 90, 95 o al 99%. Tutti gli indicatori descritti fino ad ora si riferiscono a valori assoluti. Tuttavia, spesso negli studi clinici si presenta l’esigenza di descrivere la frequenza con cui si presenta un certo fenomeno. Nel nostro esempio, è possibile analizzare la percentuale (pA) di persone nel gruppo A (anti‐ipertensivo) che hanno avuto, dopo un mese di trattamento, una diminuzione della pressione sistolica di almeno il 10%, o di almeno 5 mmHg, per confrontarla con la percentuale nel gruppo B (pB) che ha ottenuto la stessa variazione. pA descrive la probabilità che una persona nel gruppo A abbia di avere una diminuzione della pressione sistolica di almeno 5 mmHg dopo un mese di trattamento; pB la probabilità per una persona del gruppo B. Esistono indicatori statistici che mettono in relazione queste due probabilità: Rapporto tra rischi (risk ratio, RR) Valuta il rapporto della probabilità tra i due gruppi di sviluppare l’evento (pA/pB). Può essere compreso tra 0 e l’infinito e misura la forza dell’efficacia di un trattamento: tanto maggiore è l’efficacia del farmaco rispetto al placebo, tanto più grande è il valore di RR. Differenza tra rischi (risk difference, RD) È la differenza tra rischi (pA‐pB), ed è sempre compreso tra 0 e l’unità. RD misura l’impatto clinico del trattamento, in quanto il suo inverso dà il number needed to treat (NNT). Nel nostro esempio, se il 70% degli individui nel gruppo A ha una riduzione della pressione sistolica di almeno 5 mmHg (pA = 0.70), contro il 20% degli individui nel gruppo B (pB = 0.20), RD è pari a: RD = pA – PB = 0.70 – 0.20 = 0.50 ovvero gli individui del gruppo A hanno il 50% di probabilità in più rispetto agli individui del gruppo B di ridurre la pressione sistolica di almeno 5 mmHg. Di conseguenza, il numero di individui da trattare nel gruppo A perché uno abbia una riduzione di pressione di almeno 5 mmHg (NNT) è: NNT = 1/RD = 1/0.50 = 2 cioè ogni due individui trattati nel gruppo A, uno ha una riduzione di pressione di almeno 5 mmHg. Odds ratio (OR) È il rapporto tra gli odd; un odd è: OddA = pA / (1 – pA) quindi OR è pari a: OR = OddA / OddB = [ pA (1 – pB) ] / [ pB (1 – pA) ] OR è simile a RR quando i due eventi hanno frequenza molto piccola (<10%), perché in questo caso la relazione: OR = RR [ (1 – pB) / (1 – pA) ] ha il rapporto [ (1 – pB) / (1 – pA) ] che approssima l’unità. TEST DELL’IPOTESI Come già anticipato, una volta formulata un’ipotesi sperimentale, i dati devono essere analizzati per poter valutare se l’ipotesi nulla è vera o meno. Per far questo si CAPITOLO 8 ricorre a una serie di analisi matematiche dette test statistici. Indipendentemente dalla metodica analitica che li caratterizza, i test statistici hanno una caratteristica comune: il loro risultato è un valore di probabilità. Ogni test statistico, se correttamente applicato, restituisce infatti la probabilità p che l’ipotesi nulla sia vera, sotto certe condizioni, che sono la tolleranza che si decide di accettare riguardo alle probabilità di commettere due errori, dette e . Nel nostro esempio l’ipotesi nulla è: non esiste differenza tra il trattamento con il farmaco anti‐ipertensivo e il placebo nel modulare la pressione arteriosa. Applicando un test statistico per valutare questa ipotesi sono possibili quattro situazioni: Accettare l’ipotesi nulla quando questa è vera Nella realtà il farmaco non è efficace e il risultato del test conferma questa situazione. Rigettare falsamente l’ipotesi nulla Nella realtà il farmaco non è efficace ma il risultato del test porta a rigettare l’ipotesi nulla, ovvero afferma che il farmaco è più efficace del placebo nel ridurre la pressione arteriosa. In questo caso viene commesso un errore del primo tipo e è la probabilità di commettere questo tipo di errore. Rigettare l’ipotesi nulla quando questa è falsa Nella realtà il farmaco è efficace e il risultato del test conferma questa situazione. Accettare falsamente l’ipotesi nulla Nella realtà il farmaco è efficace ma il risultato del test porta ad accettare l’ipotesi nulla, ovvero afferma che il farmaco non è efficace. In questo caso viene commesso un errore del secondo tipo e è la probabilità di commettere questo tipo di errore. Dal momento che il test dell’ipotesi viene condotto su una popolazione campione e mai sull’intero universo, è sempre possibile correre il rischio di commettere uno di questi due errori. In fase di disegno dello studio, però, è possibile stabilire delle condizioni che permettano di contenere la probabilità di commettere di due errori. Normalmente, i test statistici sono costruiti in maniera tale che sia il 5% ( = 0.05), ovvero che vi sia il 5% di probabilità di rigettare l’ipotesi nulla quando questa è vera. a sua volta è influenzata da , in quanto diminuire comporta sempre un aumento del valore di . Tuttavia, la dimensione del campione permette di contenere : tanto maggiore è la dimensione del campione, tanto minore è . Il valore 1 – viene detto potenza del test, che viene normalmente fissata all’80 o 90% ( = 0.20 o 0.10, rispettivamente). In fase di disegno dello studio, è possibile calcolare, per il test che si prevede di impiegare per testare l’ipotesi nulla riguardo all’end point primario (si veda il capitolo 5), il numero di pazienti da arruolare affinché il test abbia adeguata potenza. Una volta definita la tolleranza accettata di commettere gli errori del primo e secondo tipo, è possibile testare l’ipotesi nulla. I test statistici restituiscono la probabilità p che una differenza maggiore o uguale a quella osservata sia dovuta al caso: se la pressione sistolica del gruppo A alla fine del trattamento si è ridotta mediamente di 10 mmHg, mentre nel gruppo B di 3 mmHg, p descrive la probabilità che, semplicemente per caso, si possa ottenere una differenza maggiore o uguale a 7 mmHg tra i due gruppi, con il rischio di commettere l’errore del primo tipo, e il rischio di commettere l’errore del secondo tipo. Per convenzione, l’ipotesi nulla viene rigettata quando p < 0.05, ovvero quando la probabilità di osservare casualmente una differenza maggiore o uguale a quella ottenuta è minore del 5%. PREREQUISITI PER CONDURRE L’ANALISI PARAMETRICA La statistica inferenziale, condotta mediante l’analisi parametrica, ovvero un’analisi basata sul valore di un parametro della distribuzione, quale la media o la deviazione standard, permette di raccogliere il numero maggiore di informazioni sui dati ottenuti da una sperimentazione, ma è applicabile solo quando i dati hanno una distribuzione normale. Quindi, la scelta di un test parametrico rispetto a un test non parametrico (per il quale non è necessario assumere una distribuzione normale dei dati) dipende dalla CAPITOLO 8 distribuzione del campione. Il test di Shapiro‐Wilk permette di testare l’ipotesi nulla che la distribuzione sia normale, quindi un valore di p < 0.05 indica che la distribuzione non è normale. È possibile che una trasformazione matematica dei dati permetta di rendere una distribuzione non normale in una distribuzione normale. Alcune trasformazioni normalmente impiegate sono la radice quadrata dei dati, la radice n‐esima e la trasformata logaritmica, frequentemente impiegata negli studi di bioequivalenza (descritti nel capitolo 4). La seconda condizione necessaria per poter eseguire un’analisi parametrica dei dati è che le popolazioni del campione possiedano la medesima varianza. L’F‐test permette di raffrontare le varianze di due popolazioni a distribuzione normale, per testarne l’omogeneità. L’ipotesi nulla dell’F‐test è che il rapporto fra le due varianze sia pari all’unità, e quindi che le due varianze siano paragonabili. Un valore di p < 0.05 indica che le due popolazioni non hanno varianze omogenee. Nel caso in cui due popolazioni abbiano distribuzione normale ma non varianze paragonabili, è ancora possibile condurre l’analisi parametrica se vengono introdotte delle opportune correzioni nei test impiegati. ANALISI PARAMETRICA I test parametrici maggiormente impiegati in statistica sono il t‐test di Student, l’analisi di varianza (ANOVA) e l’analisi di covarianza (ANCOVA). Il t‐test di Student viene impiegato per confrontare due popolazioni. Assumendo che i dati ricavati dal gruppo trattato con il farmaco anti‐ipertensivo e il gruppo trattato con il placebo abbiano distribuzione normale e varianze paragonabili, il t‐test di Student permette di testare l’ipotesi nulla che le medie dei valori di pressione arteriosa nei due gruppi siano uguali. Quindi, un valore di p < 0.05 significherà che i valori medi di pressione arteriosa tra i due gruppi sono significativamente differenti fra di loro, mentre un valore di p > 0.05 indicherà che non c’è differenza tra le due popolazioni. Dal punto di vista matematico, il t‐test di Student valuta la differenza tra le medie di due popolazioni rapportata all’errore standard di questa differenza. L’errore standard, a sua volta, è calcolato a partire dalla varianza delle due popolazioni. Il valore ottenuto, rapportato ad una distribuzione teorica detta distribuzione t, permette di ricavare il valore di p. Queste operazioni matematiche permettono di comprendere i requisiti necessari per l’analisi parametrica: la differenza dei valori medi è applicabile con distribuzioni normali, perché in questo tipo di distribuzione la media aritmetica è un buon indicatore di tendenza centrale, altrimenti non darebbe risultati attendibili; l’errore standard della differenza tra medie è ottenuto a partire dalle varianze delle popolazioni, che per questo motivo devono essere paragonabili. L’ANOVA permette di eseguire lo stesso tipo di analisi nel caso in cui le popolazioni da confrontare siano più di due. Ad esempio, verrebbe impiegata se oltre ai due gruppi del nostro esempio, ne venisse considerato un terzo trattato con un anti‐

ipertensivo di riferimento (gruppo C). Eseguire il t‐test tra tutte le coppie possibili – gruppo A con gruppo B; gruppo B con gruppo C; gruppo A con gruppo C – infatti, aumenterebbe la probabilità di commettere un errore del primo tipo. Questo tipo di analisi viene detta ANOVA a una via. Se nella nostra analisi si considerassero anche i due tempi di rilevamento della pressione – prima (T1) e dopo (T2) il trattamento – allora l’ipotesi nulla verrebbe testata con una ANOVA a due vie, perché due variabili categoriche sarebbero considerate: il tempo (T1 e T2) e il trattamento (A, B e C). I raffronti fra le singole coppie di gruppi vengono realizzati mediante delle analisi post hoc, cioè fatte a posteriori. Le più comuni sono la correzione di Bonferroni e l’analisi di Tukey. Consistono nell’eseguire dei raffronti tra coppie, analogamente a come si farebbe con il t‐test di Student, ma con un livello di errore accettato minore (0.025 o meno a seconda dei casi), così da contenere la probabilità totale di commettere un errore del primo tipo. L’ANCOVA viene impiegata al posto dell’ANOVA quando si ha a che fare con un misto di variabili categoriche e continue. Nel nostro esempio verrebbe applicata se si volesse analizzare CAPITOLO 8 l’effetto della variabile categorica trattamento (gruppi A, B e C) tenendo conto anche della variabile continua età. ANALISI NON PARAMETRICA Quando i prerequisiti necessari per condurre l’analisi parametrica vengono meno, si conduce un tipo di analisi – definita non parametrica – che non necessita di conoscere a priori le caratteristiche della popolazione in analisi. I test non parametrici più comunemente impiegati si basano sull’analisi dei rank, ovvero analizzano l’ordine dei dati. Immaginiamo che nel nostro esempio i valori di pressione sistolica dopo un mese di trattamento siano i seguenti in pazienti trattati con il farmaco sperimentale (gruppo A): 120 120 125 125 125 125 110 100 110 115 120 115 125 mentre nei pazienti trattati con placebo (gruppo B): 120 135 140 145 140 130 140 150 120 135 145 120 145 Le due popolazioni non hanno distribuzione normale, quindi è necessario impiegare un test non parametrico per confrontarle. In questi test viene considerato l’ordine di tutti i dati derivati da entrambe le popolazioni, dal valore minore a quello maggiore. Nel nostro caso, l’ordine sarebbe (in apice la posizione, o rank): 100 1 110 2.5 110 2.5 115 3.5 115 3.5 120 4.2 120 4.2 120 4.2 120 4.2 120 4.2 120 4.2 125 5.2 125 5.2 125 5.2 125 5.2 125 5.2 130 6 135 7.5 135 7.5 140 8.3 140 8.3 140 8.3 145 9.3 145 9.3 145 9.3 150 10 dove i valori del gruppo B sono quelli sottolineati. Si noti come valori identici (ties) hanno un rank intermedio (i tre valori di 140 mmHg hanno posizione 8.3 anziché 8). Il test statistico quindi valuta se il rank medio del gruppo A (3.97) sia statisticamente differente dal rank medio del gruppo B (7,41). In questo caso, il valore p = 0.00082 indica che le due popolazioni sono statisticamente differenti. Il test di Wilcoxon (noto anche come test di Mann‐Whitney), impiegando questo tipo di analisi, permette di raffrontare due gruppi, e costituisce quindi l’analogo del t‐test di Student. L’ANOVA di Kruskall‐Wallis invece costituisce l’equivalente dell’ANOVA per l’analisi non parametrica. L’analisi non parametrica è più permissiva dell’analisi parametrica, ovvero se sulle stesse popolazioni viene eseguito sia un test parametrico, come il t‐test di Student, e un test non parametrico, come il test di Wilcoxon, il valore di p ottenuto con il primo sarà generalmente più basso di quello ottenuto con il secondo. ANALISI DI PROPORZIONI I test statistici fino a qui riportati possono essere impiegati per confrontare valori assoluti, ovvero il risultato di una rilevazione che, almeno teoricamente (ma non sempre dal punto di vista biologico), possono assumere un qualsiasi valore. Tuttavia, sono inadatti ad analizzare dati che siano espressi come proporzioni di una popolazione, cioè in percentuali. Riprendendo un’ultima volta il nostro esempio, potrebbe essere necessario sapere se, tra il gruppo A (farmaco anti‐ipertensivo) ed il gruppo B (placebo), la percentuale di soggetti che avevano una pressione sistolica minore o uguale a 120 mmHg era differente. Questo tipo di informazione viene ricavata rapportando per ogni gruppo il numero di soggetti che, alla fine del trattamento, soddisfacevano questo criterio (pressione sistolica minore o uguale a 120 mmHg), sul numero totale di soggetti che componevano quel gruppo. Normalmente sono tre i test statistici che possono essere impiegati a questo scopo: il test della proporzione, che rapporta il numero di soggetti che soddisfano il criterio al totale dei soggetti analizzati; il test del chi quadro, il più impiegato, che considera per ogni gruppo il numero di soggetti che soddisfano il criterio ed il numero di soggetti che non lo soddisfano CAPITOLO 8 (creando quelle che sono dette tabelle di contingenza); il test esatto di Fisher, con procedimento analogo al test del chi quadro, ma impiegato quando il numero di individui considerati è molto basso. In tutti e tre i casi, questi test valutano l’ipotesi nulla che non ci sia differenza tra le due popolazioni, quindi un valore di p < 0.05 indica che le percentuali tra le popolazioni sono significativamente differenti tra di loro. ANALISI DI SOPRAVVIVENZA L’analisi di sopravvivenza mette in relazione la comparsa di un evento con il tempo in cui tale evento si verifica. Ad esempio, volendo raffrontare due chemioterapici, l’analisi di sopravvivenza può essere condotta per verificare se il tempo medio di sopravvivenza nei due gruppi di pazienti è statisticamente differente. In questo caso si mette in relazione l’evento (morte) con il tempo di comparsa dal termine del trattamento, per gli individui appartenenti ai due gruppi. Inoltre, invece di un end point semplice, nel nostro caso la morte dei pazienti, è possibile impiegarne uno composito, ad esempio la morte o la comparsa di una recidiva (ricomparsa del tumore). In questo caso il tempo considerato è quello al quale si verifica una delle due condizioni (o morte, o comparsa di recidiva), e si parlerebbe, nel nostro esempio, non più di tempo di sopravvivenza ma di tempo libero da malattia. È importante sottolineare come l’analisi di sopravvivenza possa essere condotta anche quando nell’end point non viene considerata la morte: ad esempio, l’analisi di sopravvivenza viene frequentemente condotta per valutare il tempo libero da infarto in pazienti cardiologici. L’analisi delle curve di sopravvivenza viene effettuata mediante lo stimatore di Kaplan‐Meier (S). Il principio su cui si basa questa metodica sta nella considerazione che la sopravvivenza (o la libertà dall’evento considerato) dopo dieci giorni dipende dalla sopravvivenza nei nove giorni precedenti, e così via procedendo a ritroso, fino al primo giorno considerato. Quindi la probabilità di sopravvivere l’n‐esimo giorno è condizionata dalla probabilità di sopravvivere nei giorni precedenti. La probabilità di sopravvivere il primo giorno (p1) viene definita come: p1 = (N1 – Ne1) / N1 ovvero dalla differenza tra il numero di soggetti a rischio il primo giorno (N1) e il numero di soggetti nei quali l’evento si verifica in quel giorno (Ne1), rapportato a N1 stesso. La probabilità p2 di sopravvivere il secondo giorno verrà calcolata alla stessa maniera, ma se il primo giorno si sono verificati degli eventi, il numero di soggetti a rischio sarà minore, perché i soggetti nei quali l’evento si è verificato non sono più a rischio: se un paziente è morto il primo giorno, il secondo giorno non sarà più a rischio di morte. Se consideriamo la probabilità di sopravvivenza a due giorni S(2), questa è data dalla probabilità di sopravvivere il secondo giorno, alla condizione che i soggetti siano sopravvissuti il primo giorno. Questa condizione si stima moltiplicando p2 per la probabilità p1 di sopravvivere il primo giorno. Generalizzando al giorno n: S(n) = ∏pi ovvero la probabilità di sopravvivere n giorni sarà data dal prodotto della probabilità di sopravvivere ogni singolo giorno. Al calcolo dello stimatore di Kaplan‐Meier concorrono anche i dati censurati. Esistono tre tipi di dati censurati: Individui che, al termine del periodo di osservazione, non avevano ancora presentato l’evento. Individui che presentano l’evento durante il periodo di osservazione, e che quindi non rientrano più nella popolazione a rischio i giorni seguenti. Individui che invece vengono persi prima del termine del follow‐up, ad esempio perché hanno ritirato il consenso a partecipare alla sperimentazione. Mentre i primi due tipi di dati censurati di fatto non CAPITOLO 8 rappresentano un problema, perché hanno fornito informazioni sul loro stato riguardo a tutto il periodo di osservazione, gli ultimi forniscono informazioni fino alla data di censura, ma in seguito non si può sapere se hanno sviluppato l’evento o meno, riducendo la capacità dello stimatore di fornire una stima puntuale della probabilità di sopravvivenza. I dati censurati vengono comunque inclusi nella popolazione a rischio fino a giorno della censura, in seguito vengono esclusi dalla popolazione a rischio. È comunque bene che l’analisi di sopravvivenza venga condotta finché i gruppi in osservazione siano adeguatamente rappresentati. Generalmente, quando in uno dei gruppi sperimentali considerati ha meno di 30 individui che costituiscono la popolazione a rischio, è consigliabile terminare l’analisi di sopravvivenza. La valutazione delle differenze tra vari gruppi, invece, viene eseguita con dei modelli statistici che tengano in considerazione l’andamento dell’intera curva di sopravvivenza durante tutto il periodo di osservazione. Popolazioni per l’analisi degli studi clinici Capita frequentemente, soprattutto negli studi clinici che arruolano un grande numero di pazienti, che esistano dei pazienti il cui trattamento devia dal protocollo, ad esempio perché dei pazienti ritirano il consenso alla partecipazione allo studio dopo aver già iniziato la terapia, oppure un paziente che ha assunto il farmaco in maniera errata, o ancora non si è presentato a delle visite di controllo. Queste deviazioni dal protocollo aprono più possibilità di analisi, qui di seguito riassunte brevemente: Intention to treat (ITT) I pazienti che abbiano assunto almeno una dose del farmaco assegnato vengono raggruppati secondo l’assegnazione di origine – cioè secondo l’intenzione di trattamento, e non secondo il trattamento effettivo. Di fatto si segue l’esito della randomizzazione indipendentemente da eventuali, successive, deviazioni dal protocollo. Questo tipo di analisi è oggi quella più diffusa, perché evita di introdurre errori sistematici (bias) che potrebbero influenzare il risultato dell’analisi statistica, e quindi è la più corretta dal punto di vista etico. Ad esempio è possibile che i drop‐out in un gruppo sperimentale siano maggiori per un effetto collaterale del farmaco o per una sua mancanza di efficacia. Se questi soggetti fossero esclusi, si potrebbe evidenziare un’efficacia del farmaco che in realtà è fittizia, o sbagliare la valutazione del profilo rischi/benefici. Inoltre, l’analisi ITT in parte mima la reale pratica clinica, dove alcuni soggetti possono decidere di terminare prematuramente la terapia, assumere incorrettamente un farmaco o prendere un farmaco controindicato. In questo modo i risultati dell’analisi sono più attinenti a quanto si osserverà una volta che il farmaco sarà immesso in commercio. Per protocol (PP) Vengono analizzati solo i pazienti, per ogni gruppo, che hanno ricevuto il trattamento previsto dal protocollo, completandolo. Questa analisi permette di evidenziare maggiormente l’efficacia di un farmaco, ma raramente viene eseguita senza un’analisi ITT in parallelo, per i motivi precedentemente descritti. As Treated (AT) I pazienti vengono raggruppati secondo il trattamento che effettivamente hanno ricevuto, nel tentativo di far emergere il reale effetto di un farmaco. È usata poco frequentemente. Safety L’analisi per valutare l’incidenza degli effetti collaterali viene eseguita su tutti i pazienti che abbiano assunto almeno una dose di farmaco o di placebo. In alcuni casi, può essere presa in considerazione anche la frequenza con cui avvengono i drop‐out nei vari gruppi. ANALISI A INTERIM Negli studi di lunga durata, con un gran numero di pazienti o incentrati su patologie con esito potenzialmente grave, si programma in fase di stesura del CAPITOLO 8 protocollo una o più analisi ad interim. Lo scopo di queste analisi è di valutare se il risultato della sperimentazione è talmente evidente che è possibile individuarlo con chiarezza prima che vengano arruolati tutti i pazienti. I criteri per decidere dell’interruzione anticipata di uno studio, che viene presa da un comitato indipendente che non partecipa alla sperimentazione, vengono anch’essi stabiliti in fase di stesura del protocollo. L’interruzione può avvenire per la comparsa di effetti collaterali che alterano sostanzialmente il profilo rischi/benefici della terapia; perché l’inefficacia del farmaco è talmente evidente che l’arruolamento di altri pazienti non consentirà comunque il raggiungimento dell’end point primario; perché l’efficacia del farmaco emerge inequivocabilmente con i dati raccolti per l’analisi ad interim. In particolare, per questa ultima possibilità vengono definiti dei valori di errore del primo tipo tollerati nell’analisi statistica tanto più inferiori a = 0.05, quanto minore è il numero di pazienti considerati nell’analisi ad interim. In questo modo si limita la possibilità di considerare (falsamente) efficace la terapia. BIBLIOGRAFIA 1.

2.

Crawley MJ. Statistics: an introduction using R. John Wiley & Sons Ltd. 2005 Petrie A & Sabin C. Medical Statistics at a glance. John Wiley & Sons Ltd. 2009, 3rd ed. APPUNTI CAPITOLO 9 9 EPIDEMIOLOGIA Lo studio dell’efficacia o della tollerabilità di un farmaco mediante tecniche di epidemiologia adotta un approccio completamente differente rispetto a quello proprio degli studi clinici interventistici, fin qui descritti. Al di là delle metodiche di raccolta dati, che verranno descritte in questo capitolo, la differenza sostanziale tra i due tipi di studi risiede nella capacità degli studi epidemiologici di considerare l’effetto di un farmaco nella reale pratica clinica e su un vasto numero di pazienti, una condizione che uno studio clinico interventistico riesce – nella migliore delle ipotesi – solo ad approssimare. Quindi, una volta che un farmaco è stato immesso in commercio, gli studi epidemiologici permettono di monitorare le sue efficacia e sicurezza, generalizzando maggiormente i risultati ottenuti negli studi clinici realizzati per la registrazione del farmaco su popolazioni selezionate (e quindi più omogenee rispetto alle realtà) e di osservare anche effetti inattesi, così da generare nuove ipotesi che possono essere testate con degli studi interventistici appositamente disegnati. Gli studi registrativi, infatti, salvo eccezioni dovute a particolarità nell’indicazione terapeutica, tendono a escludere dalla popolazione in analisi donne e soprattutto bambini e anziani. In questo modo mettono in evidenza l’efficacy di un farmaco cioè, come abbiamo già detto, la proof of concept. Tuttavia, l’effectiveness del farmaco, ovvero la sua capacità di portare un reale beneficio alla popolazione una volta che è stato messo in commercio, non viene dimostrato da questi studi. Inoltre, gli studi registrativi durano al massimo qualche anno, un periodo insufficiente per valutare in maniera soddisfacente la sicurezza di farmaci assunti in cronico. Infine, eventi avversi particolarmente rari non possono essere individuati in questi studi, a motivo della dimensione del campione limitata – si ricordi a questo proposito la legge di Harvey (Capitolo 7). Per quanto riguarda il monitoraggio della sicurezza dei farmaci, il sistema di farmacovigilanza, descritto nel Capitolo 7, risulta particolarmente efficace nell’isolare eventi inusuali o a maggiore intensità, oppure reazioni avverse dovute a farmaci di recente immissione in commercio, ovvero a individuare fenomeni che colpiscono l’attenzione del paziente o del medico curante, ma vengono generalmente trascurate, e quindi sottostimate, reazioni avverse di natura lieve o moderata, che generalmente il medico non segnala se osservate al di fuori di uno studio clinico. Per ovviare a questo inconveniente è stato ideato il sistema di monitoraggio attivo, con l’obbiettivo di identificare eventi clinici all’interno di una sottopopolazione sottoposta a un monitoraggio più stringente, come ad esempio i pazienti di un MMG o i pazienti che accedono a un Pronto Soccorso. In queste sottopopolazioni si cerca di individuare una correlazione tra un evento avverso e un trattamento anche ricorrendo a degli algoritmi di associazione predefiniti, come quelli di dechallenge e rechallenge (descritti a pagina 104). Tuttavia, il sistema di monitoraggio attivo ha alcune limitazioni sostanziali: nella maggior parte delle osservazioni il nesso di causalità tra ADR e farmaco non è chiaro, è quindi l’attribuzione è probabile ma non certa, l’adozione di un criterio di valutazione piuttosto di un altro complica ulteriormente il processo di attribuzione di un nesso di causalità e, infine, manca un gruppo di controllo, così che non è possibile validare un criterio di attribuzione in modo inequivocabile. L’approccio epidemiologico, condotto mediante l’analisi di database medici, d’altro canto, permette di applicare un criterio di valutazione che prescinda dal singolo giudizio clinico, perché valuta la frequenza con cui ADR si manifesta prima di stabilire CAPITOLO 9 un’associazione con l’impiego del farmaco. In questo modo può essere applicato anche nella valutazione di fattori di rischio ambientali (ad esempio l’effetto del fumo di sigaretta sulla salute umana). Per questo motivo gli studi epidemiologici possono essere applicati anche quando un gruppo di controllo vero e proprio non può essere individuato, e quindi uno studio clinico randomizzato non è possibile. MISURE DI FREQUENZA Come già accennato prima, uno studio epidemiologico valuta la frequenza con la quale un evento clinico di interesse, come la comparsa di una malattia o di una ADR, si presenta. Il soggetto che presenta l’evento viene detto caso, contrapposto al controllo, cioè l’individuo che non sviluppa l’evento. L’evento clinico può essere descritto in termini di: Casi incidenti Identificano i nuovi eventi che si presentano in un determinato lasso temporale (nuovi caso all’anno, al mese, ecc.). Casi prevalenti Sono costituiti da tutti i casi noti in un determinato istante o in un certo intervallo temporale (nuovi casi più casi già noti). Questa distinzione sta alla base di una serie di indici che permettono di descrivere la frequenza con la quale gli eventi clinici si presentano: le proporzioni, definite come probabilità o rischio, che misurano la frequenza dell’evento in relazione alla totalità della popolazione (eventi osservati divisi per tutti gli eventi possibili), e i tassi, che misurano il cambiamento di una quantità, come la transizione da sano a malato, rispetto a un intervallo temporale. Gli indici più frequentemente impiegati in epidemiologia sono: Rischio Descrive la probabilità che l’evento si manifesti nella popolazione. Si ottiene dal rapporto tra il numero di eventi osservati e il numero di individui a rischio durante il periodo di osservazione, ovvero i soggetti che non hanno ancora sviluppato l’evento ma potrebbero farlo. Tasso di incidenza Con questo indice il numero di eventi viene rapportato alla durata complessiva dell’osservazione, ovvero al periodo durante il quale ogni soggetto è stato sottoposto ad osservazione. Il tasso di incidenza identifica il numero di nuovi casi che si verificano in un determinato intervallo temporale, ad esempio 0.08/anno indica che ogni 100 anni persona si verificano mediamente 8 eventi clinici. Gli anni persona (anni complessivi di rischio) sono dati dalla somma dei periodi durante i quali ogni singola persona è stata posta in osservazione. Tasso di prevalenza Nonostante il nome, non si tratta di un tasso vero e proprio, perché non prende in considerazione un intervallo di tempo, ma fornisce la probabilità istantanea dell’evento: indica cioè in un dato istante il numero di individui che presentano l’evento in rapporto al numero di persone a rischio. Questi indicatori sono influenzati dall’efficienza di monitoraggio della popolazione: a parità di frequenza reale dell’evento, se il monitoraggio degli eventi clinici è efficiente si avranno più casi, e quindi un valore dell’indicatore considerato maggiore, rispetto a un monitoraggio meno stringente. METODI DI OSSERVAZIONE EPIDEMIOLOGICA Esistono diverse metodiche per valutare frequenza degli eventi clinici e quindi testare se una condizione o un trattamento costituiscono un fattore di rischio o meno: Serie di casi e sperimentazioni non controllate Valutano l’outcome di soggetti esposti a un particolare trattamento, ma senza adottare nessun tipo di controllo. È un metodo di osservazione particolarmente rischioso, perché specie in caso di malattie con sintomatologia intermittente non è mai possibile sapere con certezza che il trattamento sia stato veramente efficace. Questo tipo di osservazione viene impiegato quando si considerano malattie ad esito invariabilmente fatale, con terapie la cui efficacia è CAPITOLO 9 assolutamente evidente o quando non esistono trattamenti alternativi. Studi con controlli storici In questo tipo di studi i controlli vengono selezionati in base a osservazioni precedenti, oppure da dati riportati in letteratura. Hanno la tendenza a sovrastimare gli effetti dei trattamenti, principalmente perché con il passare del tempo alcune metodiche diagnostiche o terapie concomitanti migliorano, costituendo quindi un fattore di confondimento. Studi con controlli concorrenti (di coorte) Questi studi prevedono un gruppo di controllo in parallelo con il gruppo di trattamento. Il gruppo di controllo viene determinato a partire dall’esposizione e non dall’effetto finale, cioè si scelgono soggetti che non siano stati esposti al farmaco o al fattore di rischio, e non soggetti che al termine del periodo di osservazione non abbiano sviluppato l’evento clinico. Generalmente i risultati sono espressi come rapporto tra rischi (Capitolo 8). Questi studi a loro volta possono essere suddivisi in prospettici o retrospettivi. Negli studi di coorte prospettici i gruppi di studio sono scelti in base all’esposizione al fattore di rischio – ma senza randomizzazione, che negli studi epidemiologici non può essere eseguita – e con un follow‐up di durata prestabilita si valuta la comparsa dell’evento nei gruppi. Negli studi di coorte retrospettivi si considerano gruppi di soggetti che sono stati esposti o meno al fattore di rischio nel passato, per osservare se nel tempo presente hanno sviluppato l’evento o meno. I due gruppi vengono comunque stabiliti in base all’esposizione e non in base all’outcome, come accade negli studi casi‐controllo. Questo tipo di studi ha il vantaggio di considerare più esiti rispetto ad una singola esposizione, di calcolare direttamente l’incidenza di un esito e di rispettare il verso naturale della malattia. Hanno però il limite di essere di lunga durata (anni), costosi e complessi da gestire, e la numerosità del campione impedisce di raccogliere molte informazioni da ogni soggetto. In epidemiologia gli studi di coorte vengono condotti in ogni caso mediante la consultazione di database. Sudi casi‐controllo Contrariamente a quanto accade per gli studi di coorte, in questo tipo di studi si parte dall’outcome per determinare i gruppi di studio (gruppo di individui che hanno sviluppato l’evento e gruppo di individui che non lo ha sviluppato) per valutare retrospettivamente se nei due gruppi l’esposizione a un fattore di rischio era differente. Se l’evento in esame è relativamente raro, vengono considerati tutti i casi che lo hanno sviluppato, mentre tra tutti i soggetti che non lo hanno sviluppato viene eseguita una campionatura (1/10, 1/100, ecc.) perché rappresentano una popolazione troppo grande per essere considerata nella sua totalità. Il campionamento permette di definire un gruppo di controllo e viene eseguito in maniera da limitare i fattori di confondimento, quindi i soggetti in questo gruppo, che vengono comunque selezionati in maniera random, devono riprodurre le caratteristiche della popolazione selezionata per il gruppo che ha sviluppato l’evento (analoga distribuzione di età, di fattori di rischio, di sesso, ecc.). Viene calcolato l’odds ratio dell’esposizione, e non quella di manifestazione dell’evento, così da avere una stima della probabilità che un individuo presentante l’evento sia stato esposto al fattore di rischio. Questi studi hanno il vantaggio di avere durata limitata, di essere economici e facili da gestire. Inoltre permettono di raccogliere numerose informazioni da ciascun soggetto, perché hanno elevata potenza anche con campioni di numerosità ridotta. Tuttavia, sono tendenzialmente soggetti ad errori sistematici (bias) nella selezione del gruppo di controllo, e pertanto richiedono particolare accorgimenti in fase di disegno dello studio. Esistono diverse metodologie per scegliere i soggetti da includere nel gruppo di controllo: Disegno caso‐coorte Il gruppo di controllo viene scelto dalla medesima popolazione (coorte) che ha originato i casi, selezionando quegli individui che non presentavano la CAPITOLO 9 malattia all’inizio del periodo di osservazione, ma potrebbero comunque svilupparla in seguito (questo non influenza l’analisi successiva). Disegno caso‐controllo innestato I controlli vengono selezionati durante tutto il periodo di osservazione (si ricordi che l’osservazione viene condotta analizzando lo storico di un database): ogni volta che si verifica un evento, vengono scelti degli individui di controllo tra i soggetti che in quel momento sono ancora liberi da evento. Anche in questo disegno è possibile che un controllo sviluppi in seguito l’evento, ma se un soggetto continua a non sviluppare l’evento può essere selezionato come controllo di più casi. Attualmente è il disegno più impiegato negli studi caso‐controllo. Disegno caso‐crossover Viene impiegato un controllo interno, considerando nello stesso soggetto che sviluppa l’evento una finestra di esposizione precedentemente la comparsa dell’evento. Questo disegno valuta solo rischi acuti a breve termine, e può essere impiegato solo quando il lasso di tempo tra esposizione ed evento è breve e ha effetti poco prolungati. Disegno case‐time‐control È un evoluzione del caso‐

crossover, in quanto adotta un gruppo di controllo in cui valutare l’esposizione durante una finestra temporale paragonabile. In questo modo, se il livello di esposizione nel tempo cambia (non tutti i casi si presentano nello stesso tempo, ma possono essere distanziati anche di anni), è possibile normalizzare questo cambiamento. Analisi di database di prescrizioni Normalmente uno studio epidemiologico impiega informazioni raccolte da database, che contengono dati su le malattie diagnosticate a soggetti, generalmente classificate secondo un codice, l’International statistical Classification of Diseases and related health problems (ICD), i medicinali che hanno assunto, le manovre strumentali a cui sono stati sottoposti, i referti diagnostici, gli esiti dei trattamenti. La tipologia di dati contenuti in un database può variare anche di molto, per cui a seconda della situazione in cui ci si trova ad operare può essere necessario integrare le informazioni di più database (database ospedalieri, database di prescrizioni, database di assicurazioni), se contengono un identificatore comune del paziente. In Italia, ad esempio, molti database identificano i soggetti con il codice assistito o con il codice fiscale, così che l’integrazione delle informazioni è possibile. Esistono però dei disegni sperimentali che cercano di trarre le maggiori informazioni possibili analizzando un unico database, così da ridurre i costi e i tempi. In particolare, per quanto riguarda i database di prescrizioni, esistono due particolari disegni sperimentali: Disegno dell’analisi della sequenza delle prescrizioni Viene impiegato per individuare reazioni avverse inattese di farmaci a vasta diffusione. Si basa sul principio che se esiste una relazione causale tra esposizione al farmaco ed evento avverso, posto che questo richieda un’ulteriore medicazione, questa sequenza temporale dovrebbe emergere con frequenza insolitamente elevata dall’analisi delle prescrizioni. Se il farmaco A non induce una ADR, allora la probabilità di iniziare casualmente una terapia con B durante o appena dopo il trattamento con A è direttamente proporzionale alla durata del trattamento con A: tanto più lungo il trattamento, tanto maggiore la probabilità che per altri motivi venga prescritto anche B. Questa probabilità viene stimata con una simulazione: a partire dalle durate di trattamento realmente osservate nel database con il farmaco A, un algoritmo assegna dei trattamenti B in maniera casuale (rispettando la frequenza media con cui B viene prescritto), e si calcola con che frequenza i trattamenti con A e B sono concomitanti o B segue a stretto giro la fine della terapia con A. Quindi, si valuta la frequenza reale presente nel database. Se questa è significativamente maggiore di quella ottenuta dalla simulazione, allora c’è una buona probabilità che A induca CAPITOLO 9 una ADR che viene trattata con B. Se invece le due frequenze – simulata e osservata – sono paragonabili, allora A non induce una ADR trattata con B. Questo disegno, impiegando un controllo frutto di una simulazione casuale, non è soggetto a bias da selezione del gruppo di controllo. Tuttavia, è soggetto a una distorsione delle informazioni ricavate perché non necessariamente la prescrizione del farmaco B implica la sua immediata assunzione (per certi farmaci un paziente richiede la prescrizione per averne una scorta in caso di bisogno), e mancano informazioni sulla ragione della prescrizione del farmaco B, che potrebbe avere più indicazioni terapeutiche anche slegate da una possibile ADR indotta da A. Disegno della simmetria della sequenza delle prescrizioni Questo disegno si basa sull’assunzione che se esiste un nesso di causalità tra la prescrizione del farmaco A e quella del farmaco B (cioè una ADR indotta da A), allora esisterà un’asimmetria nella sequenza delle prescrizioni: la prescrizione di A seguita da B avrà frequenza maggiore della prescrizione di B seguita da A. L’asimmetria è valutabile semplicemente calcolando il rapporto tra rischi (Capitolo 8). Anche questo disegno risente però della mancanza di informazioni sulla prescrizione del farmaco B e il risultato è influenzato anche da un possibile cambio della rimborsabilità del farmaco B, che ne altererebbe la frequenza di prescrizione, durante il periodo di osservazione. Nonostante le limitazioni, questi due disegni sperimentali sono utili per lo sviluppo di sistemi di monitoraggio semi‐

automatici, che analizzino periodicamente i database delle prescrizioni e generino attenzione attorno a possibili associazioni, che devono essere verificate in seguito con studi appositamente disegnati. ERRORI NELLA STIMA DEI PARAMETRI IN EPIDEMIOLOGIA Come già descritto nel capitolo 8, in ogni valutazione statistica è presente una variabilità dovuta al caso che potenzialmente potrebbe mascherare l’effetto di un trattamento, tuttavia esistono degli accorgimenti, come l’adozione di un’adeguata numerosità campionaria, che permettono di contenere questo fenomeno aumentando la precisione della stima dell’effetto. Gli studi di epidemiologia, basati sull’analisi di database che permettono un contenimento dei costi, lavorano su campioni a elevata numerosità (anche migliaia di pazienti), quindi consentono di effettuare stime molto precise degli effetti osservati. Negli studi di coorte è inoltre possibile impiegare il propensity score in fase di selezione dei soggetti per attenuare l’influenza di fattori di confondimento. Il propensity score è un punteggio che indica la probabilità che un soggetto, date le sue caratteristiche di base, sviluppi una patologia o inizi un certo trattamento. I soggetti di diversi gruppi vengono quindi appaiati così che, per ogni soggetto nel gruppo di trattamento, sia presente nel gruppo di controllo un individuo con analogo propensity score. La principale limitazione all’impiego del propensity score è che richiede che le coorti abbiano la stessa numerosità campionaria, per cui se una delle due coorti contiene più soggetti dell’altra, alcuni devono essere scartati, con conseguente perdita di informazioni in fase di analisi. Anche in epidemiologia, inoltre, è presente il rischio di commettere errori sistematici. Il controllo degli errori sistematici è possibile mediante un’accurata pianificazione dello studio, per evitare errori di classificazione di una patologia o di un trattamento, e l’assunzione di una serie di precauzioni in fase di analisi dei dati. I criteri di selezione del gruppo di controllo, che non devono essere eccessivamente restrittivi per non limitare la generalizzabilità dei risultati, ad esempio, devono essere modulati così che il gruppo di controllo sia rappresentativo della popolazione generale. In caso contrario, i risultati ottenuti sarebbero applicabili solo ad una particolare sottopopolazione e non all’intera popolazione a rischio. La rappresentatività del gruppo di controllo può essere valutata in base al rapporto standardizzato di incidenza: i CAPITOLO 9 principali fattori di confondimento, come l’incidenza di eventi cardiovascolari, diabete, ecc. sono stati caratterizzati nella popolazione generale, e un campione rappresentativo della popolazione generale deve presentare questi fattori di confondimento con frequenze paragonabili a quelle note (per questo definite standardizzate). Per quanto riguarda i fattori di rischio cardiovascolari, ad esempio, la loro incidenza viene valutata dal rapporto Framingham1, che viene periodicamente aggiornato. L’attendibilità di uno studio epidemiologico, ovvero la sua validità generale e l’affidabilità dei risultati ottenuti, può essere valutata in base ai criteri di Hill, una serie di aspetti che, se presenti nello studio, lo rendono più robusto e quindi attendibile. Sono: L’esistenza di un relazione temporale tra casi e controlli e la presenza di un follow‐up. La forza dell’associazione tra causa ed effetto. La determinazione di una relazione dose‐risposta. La coerenza con altri studi. La plausibilità biologica del meccanismo proposto. L’assenza di possibili spiegazioni alternative (lo studio è conclusivo). La presenza di sperimentazione clinica a supporto dei dati. La specificità dello studio (la capacità di riconoscere correttamente i soggetti non esposti al trattamento). La coerenza con teorie e conoscenze consolidate. Recentemente, sono stati sviluppati anche altri metodi in sostituzione dei criteri di Hill per valutare l’attendibilità di uno studio epidemiologico2. METANALISI Le metanalisi sono analisi basate sul raggruppamento di dati derivanti da più sperimentazioni allo scopo di ottenere informazioni più solide grazie all’ottenimento di un campione più ampio. Le metanalisi possono essere divise in tre tipi a seconda della metodica di raggruppamento dei dati e di analisi degli stessi. Le pooled analysis sono le metanalisi che permettono l’analisi più robusta, ma sono anche le più difficili da realizzare. In questo tipo di metanalisi vengono impiegati direttamente i dati originali ricavati da due o più studi clinici. Questo tipo di metanalisi è applicabile in una minoranza di casi, perché i dati originali sono di difficile accesso, ed inoltre gli studi devono avere un disegno molto simile così che i parametri considerati e le tempistiche di rilevazione di questi siano i medesimi. Metanalisi di questo tipo vengono ad esempio condotte sugli studi di fase III, realizzati da un’unica azienda (così che sia possibile avere accesso a tutti i dati originali) e condotti in duplicato applicando lo stesso protocollo sperimentale. Gli altri due tipi di metanalisi vengono condotte analizzando i dati medi riportati in una serie di pubblicazioni. I lavori vengono selezionati in base a criteri di inclusione e esclusione degli articoli stabiliti a priori: parole chiave per la ricerca dei lavori, dati minimi che devono contenere per essere inclusi, ecc. Generalmente la selezione viene eseguita in parallelo da almeno due autori, l’uno indipendente dall’altro, e sui lavori su cui c’è disaccordo (un autore li ritiene includibili, l’altro escludibili) viene presa una decisione o mediante discussione ragionata tra i due autori, oppure sulla base del giudizio di un terzo autore che non ha partecipato alla selezione (anche questo aspetto viene deciso prima di iniziare l’analisi). Ogni lavoro viene poi pesato per la sua importanza, ovvero per il numero di pazienti che ha arruolato: dal momento che la varianza di un campione diminuisce all’aumentare della dimensione del campione stesso, la varianza osservata in una pubblicazione diventa lo strumento di misura del suo peso all’interno della metanalisi. Esistono due possibili modi di calcolare il peso di una pubblicazione in base alla varianza associata all’end point di interesse: Fixed model In questo modello si assume che ogni studio sta misurando lo stesso identico effetto, ovvero tutti gli studi sono basati sulla medesima popolazione, e quindi le differenze nelle quantità stimate sono dovute solo alla CAPITOLO 9 variabilità nella risposta tra un soggetto considerato e l’altro. In questo caso il peso di ogni studio è dato dall’inverso della varianza (1/vi). Random model In questo modello si assume che ogni studio stia misurando un suo effetto, cioè che le popolazioni in analisi avevano delle differenze di fondo, e che quindi il risultato sia influenzato da dei fattori di confondimento. In questo caso l’effetto misurato dipende anche dai diversi criteri di inclusione o esclusione adottati, e il peso di ogni lavoro è influenzato anche dalla variabilità T (che deve essere a sua volta stimata) che intercorre tra i diversi studi, e sarà dato da: 1/(vi + T). Qualunque sia il modello adottato – generalmente si eseguono entrambi i tipi di analisi, e si adotta il fixed model quando questo non produce risultati sostanzialmente differenti da quelli ottenuti con il random model – i risultati di una metanalisi vengono riportati nel Forest plot. Nel Forest plot vengono riportati il valore medio (o l’indicatore di tendenza centrale adottato) di ogni studio, con i rispettivi intervalli di confidenza, e il valore medio derivato dall’analisi integrata dei vari studi. Graficamente questo viene reso con un quadrato per ogni studio, la cui posizione sull’asse delle ascisse indica il valore dell’indicatore di tendenza centrale, mentre la sua dimensione rappresenta il peso assegnato allo studio. Due barre laterali indicano invece l’intervallo di confidenza. Sotto questi, un diamante () indica il valore medio ricavato dall’analisi integrata di tutti gli studi. Le estremità laterali del diamante rappresentano gli intervalli di confidenza. Il diamante rappresenta quindi il risultato finale di una metanalisi, ovvero il valore medio dell’end point di interesse ricavato dai diversi studi, pesati per la loro rilevanza. I risultati di una metanalisi possono essere distorti dal publication bias, ovvero dal fatto che preferenzialmente vengono pubblicati risultati positivi (presenza di effetto), a discapito dei risultati negativi (assenza di effetto). Quindi, una metanalisi potrebbe evidenziare la presenza di un effetto solo perché alcuni studi che non hanno evidenziato un effetto non sono stati pubblicati. Per valutare la presenza di un publication bias viene impiegato il Funnel plot. In questo grafico viene riportato l’inverso della varianza (1/vi) di ogni studio in funzione del logaritmo del RR di ogni lavoro. Lo studio con il valore 1/vi maggiore, ovvero quello a varianza minore, viene considerato lo studio con la stima dell’effetto maggiormente accurata, e viene adottato come valore di riferimento. In assenza di publication bias, i valori degli altri studi, considerati meno accurati, si distribuiranno in maniera simmetrica rispetto al valore di riferimento. Nel caso in cui un publication bias sia presente, allora i valori calcolati per gli altri studi saranno distribuiti preferenzialmente a destra – log(RR) maggiore – rispetto al valore di riferimento. I risultati di una metanalisi vanno interpretati con cautela. In particolare, metanalisi che indicano un effetto modesto e basate su un numero esiguo di studi non dovrebbero essere considerate come conclusive. Gli studi osservazionali Gli studi osservazionali permettono di valutare l’effetto di una terapia nel contesto della normale pratica clinica. Negli studi osservazionali l’esposizione di un soggetto a un trattamento è di tipo passivo, ovvero l’assegnazione della terapia è indipendente alla partecipazione o meno del soggetto allo studio: la decisione di includere o meno un paziente nello studio è indipendente dalla decisione di sottoporlo o meno al trattamento in analisi. Gli studi osservazionali, che per loro natura sono condotti solo su farmaci in commercio, non impiegano quindi alcuna randomizzazione. Gli studi osservazionali descrittivi raccolgono informazioni su una determinata caratteristica di un campione per stimare il suo valore reale nella popolazione. Studi di questo tipo valutano la presenza di comorbidità in una popolazione CAPITOLO 9 malata (ad esempio: la presenza di ipertensione in una popolazione di diabetici). La correttezza della stima eseguita in questi studi, e quindi l’attendibilità dello studio stesso, dipende interamente dalla rappresentatività del campione in analisi, ovvero quanto il campione rispecchi le caratteristiche della popolazione generale. Gli studi osservazionali analistici invece ricercano l’associazione di un outcome in presenza di un supposto agente causale. Ad esempio, la presenza di un effetto (outcome) in seguito a somministrazione di un farmaco (agente causale), rispetto a un gruppo non trattato o trattato diversamente – negli studi osservazionali l’impiego di placebo non è ritenuto eticamente corretto. In questo tipo di studi, data l’assenza di randomizzazione, il controllo dei fattori di confondimento viene fatto raccogliendo il maggior numero di informazioni possibili sui potenziali fattori di confondimento nei vari gruppi in analisi. Questo permette di controllare i fattori di confondimento noti, ovvero i fattori la cui influenza sull’outcome è accertata o quanto meno supposta, ma non quelli ignoti. In fase di analisi, inoltre, l’analisi multivariata permette di valutare se sono presenti eventuali fattori di confondimento (l’analisi multivariata viene eseguita valutando come l’outcome cambia se si considera o meno una o più variabili potenzialmente confondenti). Gli studi osservazionali sono sottoposti a una normativa semplificata rispetto agli studi clinici controllati. Una linea guida AIFA indica le caratteristiche di uno studio osservazionale e i criteri per la sua conduzione3. Queste linee guida, però, non regolamentano gli studi osservazionali descrittivi, che non sono condotti su un farmaco. Dal momento che uno studio osservazionale è condotto nell’ambito della normale pratica clinica, tutte le procedure diagnostiche e valutative devono corrispondere a quelle normalmente impiegate. Vengono però considerate procedura di normale pratica clinica anche le visite di follow‐