Appunti di

Fisica

Ambientale

Per la classe quarta

dell’articolazione di

Biotecnologie Ambientali

degli Istituti Tecnici

Alessandro Ciucci

[email protected]

Luce

Ottica

Energia solare

Elettromagnetismo

CLIL “the optics of rainbow”

1

Introduzione

Questi appunti sono la prosecuzione del percorso di Fisica Ambientale iniziato nella classe terza

dove, a partire dalle nozioni di fisica generale appresi nel biennio, sono stati approfonditi alcuni

argomenti specifici (trasmissione del calore e termodinamica) e altri sono stati introdotti come

nuovi (fisica dell’atmosfera, le onde, il suono). A fine di ogni modulo è stato affrontato un tema

specifico ambientale come competenza da acquisire in capo ambientale (la trasmittanza termica e il

risparmio energetico, il funzionamento delle pompe di calore, la dispersione di inquinanti, le onde

sismiche, il rumore).

In questa seconda parte saranno affrontati i seguenti argomenti:

-

Ottica geometrica e ondulatoria e funzionamento dei principali strumenti (telescopio,

microscopio, spettrometro

Onde elettromagnetiche, generazione propagazione e assorbimento. Inquinamento

elettromagnetico

Sistemi energetici rinnovabili (energia solare).

In preparazione alla classe quinta saranno introdotto un argomento in lingua inglese da affrontare

con metodologia CLIL (Content and Language Integrated Learning) e anche una delle verifiche sarà

svolta mediante una esposizione orale con ausilio di slide e/o altri strumenti multimediali.

Ciascun argomento è affrontato con il duplice obiettivo di offrire un compendio di conoscenze di

fisica specifico del settore e fornire gli strumenti interpretativi di alcune problematiche ambientali

di rilievo.

2

Argomenti:

-

-

Strumenti matematici

o Le funzioni goniometriche

o La funzione esponenziale

o I logaritmi

Ottica

o Natura della Luce

o Misura della velocità della luce

o Propagazione della luce

Riflessione

Rifrazione

o Ottica geometrica

Specchi piani e sferici

Diottro sferico

Lenti sottili

Sistemi ottici (microscopio e telescopio)

o Ottica ondulatoria

Dispersione della luce: il prisma

-

-

-

Diffrazione e interferenza

Polarizzazione

Equazioni di Fresnel

Intensità della luce e assorbimento

Funzionamento di uno spettrometro

Elettromagnetismo

o Le grandezze elettriche

o Richiami circuiti in CC

Circuito RC

Circuito RL

Circuito RCL

o Sorgenti di Onde EM

Lo spettro EM

o Energia delle onde EM

Misure di campo elettrico e di campo magnetico

o Inquinamento EM

Fonti ambientali di radiazione EM

Effetti biologici della radiazione EM

Energia solare

o Solare termico

o Fotovoltaico

CLIL

o Rainbow

3

Funzioni goniometriche

Consideriamo un triangolo rettangolo come in figura:

c

b

a

Chiamiamo i cateti a e b, l’ipotenusa c. Chiamiamo l’angolo opposto

al cateto a.

Definiamo delle funzioni che dipendono solo dall’angolo

SEN() = a/c

(si legge “seno di alpha”, sulla calcolatrice è il tasto “SIN”)

COS() = b/c

(si legge “coseno di alpha”, sulla calcolatrice è il tasto “COS”)

TAN() = SEN()/COS() = a/b

(si legge “tangente di alpha”, sulla calcolatrice è tasto “TAN”)

Il seno di un angolo è il rapporto tra il cateto che sta davanti all’angolo e l’ipotenusa, il coseno di un

angolo è il rapporto tra il cateto adiacente all’angolo e l’ipotenusa. La tangente di un angolo è il

rapporto tra il cateto opposto all’angolo e quello adiacente

Calcolare il seno e il coseno di un angolo è un operazione che non si può fare a mente, i calcoli sono

semplici solo in alcuni casi particolari, per questa ragione si ricorre alle calcolatrici tascabili oppure

alle applicazioni di calcolo per personal computer o telefono, in passato si usavano delle tavole.

I valori del seno e del coseno un angolo sono sempre compresi tra -1 e +1. Di seguito si riporta una

tabella riassuntiva dei valori per i principali angoli compresi tra 0° e 180°

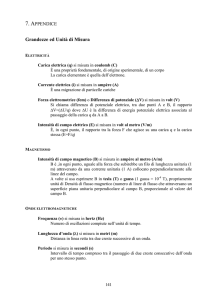

ANGOLO

gradi

0°

30°

45°

60°

90°

120°

135°

150°

180°

radianti

0

/6

/4

/3

/2

/3

/4

/6

SEN()

esatto

0

1/2

√2/2

√3/2

1

√3/2

√2/2

1/2

0

SEN()

approssimato

0

0.5

0.707

0.866

1

0.866

0.707

0.5

0

COS()

esatto

1

√3/2

√2/2

1/2

0

-1/2

-√2/2

-√3/2

-1

COS()

TAN()

approssimato

1

0.866

0.707

0.5

0

-0.5

-0.707

-0.866

-1

TAN()

approssimato

0

√3/3

1

√3

non def.

−√3

-1

-√3/3

0

0

0.577

1

1.732

-1.732

-1

-0.577

0

(notiamo che la funzione SENO è crescente tra 0° e 90°, decrescente tra 90° e 180°, sempre positiva. La funzione

COSENO è sempre decrescente tra 0° e 180°, positiva tra 0° e 90°, negativa tra 90° e 180°. Vale per ogni angolo l’identità

goniometrica 𝑆𝐸𝑁 2 (𝛼) + 𝐶𝑂𝑆 2 (𝛼) = 1 )

Nella tabella gli angoli sono espressi nei gradi sessagesimali (i normali gradi ai quali siamo abituati) e

in radianti, quest’ultimo modo di esprime gli angoli è diffuso in ambiente scientifico, in radianti

l’angolo piatto vale (pi greco = 3.1459….). Le formule necessarie per fare la conversione da una

scala all’altra sono:

(angolo in gradi) = (angolo in radianti) ×

180

𝜋

4

𝜋

(angolo in radianti) = (angolo in gradi) × 180

Per calcolare il valore delle funzioni SEN e COS (sulla calcolatrice sono SIN e COS) dobbiamo

verificare la modalità di espressione dell’angolo. Per usare i normali gradi è necessario che sul

display ci sia una scritta “DEG” o la semplice lettera “D”, per i radianti ci deve essere la scritta “RAD”

o la lettera “R”. C’è poi una terza modalità di esprimere gli angoli (angolo retto = 100) detta “gradi

centesimali”, in questo caso ci sarà la scritta “GRAD” o la lettera “G”. Per passare da una modalità

all’altra è necessario usare il tasto “DRG” (Deg – Rad – Grad).

L’utilizzo delle funzioni goniometriche in geometria permettere di “risolvere” un triangolo

rettangolo conoscendo un lato e un angolo (che non sia quello retto) piuttosto che due dei tre lati.

Sfruttando la definizione data all’inizio e potendo ricavare il valore delle funzioni SEN e COS con un

calcolatore o con le tabelle, è possibile determinare i cateti conoscendo l’ipotenusa:

a = c x SEN()

b = c x COS()

oppure l’ipotenusa conoscendo uno dei due cateti:

c = a / SEN()

c = b / COS()

L’utilità pratica delle funzioni goniometriche è legata al fatto che spesso è più semplice misurare un

anglo piuttosto che una distanza. Le misure degli angoli

si fanno con strumenti ottici

h

Come esempio di applicazione vediamo come sia

possibile misurare l’altezza di un edificio.

Si misura la distanza dalla base dell’edificio d e a quella

distanza si misura sotto quale angolo è visibile la

l’altezza dell’edificio. L’ipotenusa c sarà c = d/COS(),

mentre l’altezza h = c SEN()

d

Nel caso non sia possibile misurare la distanza dalla base

dell’oggetto di cui si intende misurare l’altezza h si

procederà in due fasi. Dopo una prima misura di angolo

1, si avanzerà di un tratto d e si farà una seconda

h

misura di angolo 2. Per determinare l’altezza h sono

necessari i seguenti passaggi:

c1 = h/SEN(1), c2 = h/SEN(2). Osserviamo che la

d

distanza d è la differenza tra i cateti adiacenti agli angoli

che si ottengono moltiplicando l’ipotenusa per il

coseno. d = c1COS(1)-c2COS(2). Sostituendo i valori di c1 e c2 si ha:

𝑑=ℎ

𝐶𝑂𝑆(𝛼1 )

𝑆𝐸𝑁(𝛼1 )

−ℎ

𝐶𝑂𝑆(𝛼2 )

𝑆𝐸𝑁(𝛼2 )

, quindi per h avremo: ℎ =

𝑑

𝐶𝑂𝑆(𝛼1 ) 𝐶𝑂𝑆(𝛼2 )

−

𝑆𝐸𝑁(𝛼1 ) 𝑆𝐸𝑁(𝛼2 )

5

Facciamo un esempio numerico:

Utilizzando i dati nella figura otteniamo:

ℎ=

2 = 30°

= 20°

𝑑

𝐶𝑂𝑆(𝛼1 ) 𝐶𝑂𝑆(𝛼2 )

−

𝑆𝐸𝑁(𝛼1 ) 𝑆𝐸𝑁(𝛼2 )

90.0

= 0.940

0.866

−

0.342 0.500

=

90.0

2.75− 1.73

= 88 𝑚

1

d = 90.0 m

Se il lettore ha riconosciuto la figura, sa anche che si

tratta di una misura più che realistica.

Le misure ottiche di angoli di elevazione posso essere fatte con semplicissimi strumenti (anche fatti

in casa) come quello descritto nella figura sottostante

Un semplice strumento per misurare l'altezza angolare (angolo rispetto al piano

orizzontale) di un oggetto celeste. Un cartoncino a forma di quarto di cerchio su

cui è riportato un goniometro, nel centro è attaccato un sottile filo con un

“pesetto”, su un piccolo tubo (cannuccia) che fa di mirino. L’angolo che il tubo

fa con il piano orizzontale è uguale a quello che il filo (sempre verticale per via

del peso) fa con l’altro lato del goniometro.

Ecco come appare il grafico delle funzioni SENO e COSENO con gli angoli espressi rispettivamente in

gradi sessagesimali e radianti

Alcune considerazioni sui piccoli angoli

L’utilità di esprimere gli angoli in radianti

risiede nella proporzionalità diretta tra arco ed

angolo che si esprime attraverso il raggio Arco

= angolo x raggio. Se gli angoli sono piccoli

(inferiori a 5° e quindi inferiori a 5/180 =

0,087 rad) il seno è praticamente

indistinguibile dall’angolo stesso (poiché il seno rappresenta la corda, per angoli piccoli corda e arco

sono molto simili), infatti sen(0,087) = 0,087 (la differenza è sulla quarta cifra dopo la virgola), in

questi limiti il coseno è circa uno. Per cui, per angoli inferiori a 5° si ha

6

sin 𝜗 ≅ 𝜗

cos 𝜗 ≅ 1

tan 𝜗 ≅ 𝜗

La funzione Esponenziale

Abbiamo familiarità con il concetto di elevamento a potenza di un numero intero, scrivere 3 4

significa che il dobbiamo moltiplicare i numero quattro volte per se stesso, 3 4 = 81. Non è difficile

pensare a nemmeno a 34.5, sarà un qualcosa di intermedio tra 34 e 35 (infatti 34.5 = 140.3, 35 = 243).

Se raffiniamo questo ragionamento possiamo pensare ad un numero intero elevato ad un

esponente che sia, in generale, un numero reale (non necessariamente intero e non

necessariamente un numero originato da una frazione) 3 . Ma lo stesso ragionamento lo possiamo

portare a pensare ad un numero reale elevato ad un esponente che sia anch’esso reale. Questa

funzione è spesso riportata nelle calcolatrici tascabili o nelle applicazioni da PC, smartphone e altro

con il tasto xy. . Tra tutte le possibili basi x assume particolare importanza quella che usa il numero

e, detto numero di Eulero (o numero di Nepero). Tale numero (come è irrazionale e vale

approssimativamente 2,71828. Pertanto il grafico della funzione ex sarà compreso (per x > 0) tra

quello di 2x e quello di 3x. L’importanza di questa funzione in fisica è grandissima perché ogni volta

che la variazione temporale dell’intensità di un fenomeno risulta essere proporzionale all’intensità

stessa del fenomeno, si ha che l’andamento nel tempo è descritto dalla funzione esponenziale

(crescente o decrescente).

In fisica, sono descritti da esponenziali le leggi

del decadimento radioattivo, la distribuzione

delle particelle in relazione all’energia e alla

temperatura, ma anche l’andamento della

velocità di un corpo soggetto al peso e ad una forza di attrito viscoso proporzionale alla velocità.

Di una certa importanza è anche la funzione y = xe-x, il cui grafico è riportato nella figura sottostante

solo per i valori di x > 0.

7

y = xe-x

0.5

0.4

0.3

0.2

0.1

0

0.0

1.0

2.0

3.0

4.0

5.0

6.0

7.0

8.0

Tale funzione passa dall’origine e va asintoticamente a zero per x tendente all’infinito, essendo una

funzione continua essa ha almeno un massimo (1; 1/e). Anche l’integrale indefinito (cioè l’area

individuata dalla funzione e dall’asse x estesi all’infinito) ha un valore “finito” uguale a 1.

I Logaritmi

Abbiamo tutti una certa familiarità con la seguente espressione 23 = 8, si impara nella scuola

primaria che l’espressione precedente è equivalente a 23 = 2 ∙ 2 ∙ 2 = 8, di questa scrittura

3

sappiamo fare anche il procedimento inverso, possiamo scrivere cioè √8 = 2, esiste una diversa

domanda legata a questa espressione e cioè: quale esponente devo applicare al numero 2 per

ottenere 8? La risposta alla domanda la si ottiene con i Logaritmi. Possiamo scrivere

log 2 8 = 3

Si legge: il logaritmo in base 2 di 8 è uguale a 3. Il numero 2 è chiamato base del logaritmo, il

numero 8 è l’argomento. L’argomento deve essere necessariamente un numero maggiore di zero.

I logaritmi hanno alcune importanti proprietà che rendevano il loro uso indispensabile prima

dell’avvento dei calcolatori elettronici:

log 𝑎 ( 𝑏 ∙ 𝑐) = log 𝑎 𝑏 + log 𝑎 𝑐

(trasforma il prodotto in una somma)

log 𝑎 𝑏 𝑐 = c ∙ log 𝑎 𝑏

(porta fuori l’esponente, riduce il grado)

log 𝑎 𝑏 =

log𝑐 𝑏

log𝑐 𝑎

(cambio di base)

Tali proprietà, che non dimostriamo, sono dirette conseguenze delle proprietà delle potenze.

Tra tutte le possibili basi hanno particolare importanza la base 10 e la base e. Le calcolatrici tascabili

riportano queste operazioni con i tasti Log e ln . La funzione ln è detta logaritmo naturale (e in

analisi matematica semplicemente logaritmo). Notiamo che la funzione ln(x) è la funzione inversa di

quella esponenziale. Le applicazioni dei logaritmi sono molteplici, dalla fisica all’elettronica, spesso

legate alla prima proprietà illustrata.

8

Facciamo un esempio. Si deve eseguire la seguente moltiplicazione 1.234 x 5.678, senza la

calcolatrice ma con la possibilità di usare una tabella di logaritmi. Inizieremo osservando che

log (1.234 × 5.678) = log (1.234) + log (5.678) = 0.0913 + 0.7524 = 0.8455

Quindi il risultato della moltiplicazione sarà

1.234 × 5.678 = 100.8455 = 7.006

che

possiamo ottenere usando la tabella al

contrario. Se lo confrontiamo con il risultato

“esatto” troviamo 1.234 × 5.678 = 7.007,

una discrepanza più che accettabile se

confrontata con la necessità di fare una

moltiplicazione (in colonna) di due numeri di

4 cifre ciascuno.

Log10(x)

1.50

1.20

0.90

0.60

0.30

0.00

-0.30 0

-0.60

-0.90

-1.20

-1.50

1

2

3

4

5

Una importante applicazione dei logaritmi è

la scala dei “deciBel”, usata in alcuni settori

tecnologici per descrivere grandezze la cui variabilità è molto grande. Il decibel è una grandezza

derivata dal Bel. Facciamo un esempio legato al suono. Supponiamo di avere un sistema fatto da

microfono, amplificatore e casse audio. Il nostro amplificatore ha la capacità di moltiplicare per 100

il segnale ricevuto dal microfono, cioè se sul microfono incide una potenza P in = 1 W, alle casse esce

una potenza Pout = 100 W.

La capacità di amplificazione (o guadagno) G viene descritta nel seguente modo:

𝐺 = log10

𝑃𝑜𝑢𝑡

100

= log10

= 2 [𝐵𝑒𝑙]

𝑃𝑖𝑛

1

Il guadagno G è 2 Bel. Se ridefiniamo il guadagno come la scala Bel moltiplicata per 10 otteniamo

𝐺 = 10 ∙ log10

𝑃𝑜𝑢𝑡

100

= 10 ∙ log10

= 20 [𝑑𝑒𝑐𝑖𝐵𝑒𝑙]

𝑃𝑖𝑛

1

O semplicemente G = 20 dB. Notiamo che se la potenza in uscita raddoppia, cioè se passa 100 a 200

W, il guadagno cresce di 10Log(2), circa 3 dB

G= 10∙log 10

Pout

200

= 10∙log 10

= 10∙( log 10 2 + log 10 100)= 10 ∙(0.31+2)=23.1 dB

Pin

1

L’utilità pratica della scala dei Decibel risiede nel trasformare una catena di amplificazioni o perdite

(pensate ai segnali delle antenne televisive) in somma di guadagni o perdite (dB negativi) espressi di

decibel.

9

La luce

Sappiamo che la luce è un particolare tipo di onde elettro-magnetiche di lunghezza d’onda

compresa all’incirca tra i 400 e i 700 nm, può sembrare una considerazione banale ma la conoscenza

dalla natura della luce non è sempre stata tale, d’altronde le onde elettromagnetiche (come le onde

radio) hanno prevalentemente origine antropica anche se non mancano le sorgenti cosmiche

mentre la luce è sempre stata presente, per questo motivo lo studi della luce, de suo

comportamento e della sua natura è antecedente all’elettromagnetismo, nel quale ambito la luce è

stata ricondotta solo alla fine del diciannovesimo secolo.

Natura della luce

Alcune osservazioni sul comportamento della luce sono note: le ombre riproducono i contorni degli

oggetti in modo netto quindi la luce si propaga in linea retta (la luce non sembra aver la capacità di

aggirare gli ostacoli), esistono dei corpi in grado di emettere luce e sono detti sorgenti, alcuni corpi

si lasciano attraversare dalla luce senza modificarne (in modo apprezzabile) la traiettoria e sono

detti trasparenti, altri “sparpagliano” la luce e sono detti traslucidi, altri non si lasciano attraversare

e sono detti opachi. Alcuni corpi appaiono di diversi “colori” e legato al comportamento della luce ci

sono curiosi fenomeni che hanno affascinato umanità e studiosi per secoli come i miraggi e gli

arcobaleni. Una teoria in grado di spiegare tutti questi fenomeni non è affatto semplice e le due

idee che storicamente si sono contrapposte sono quella “corpuscolare” (luce composta da piccoli

oggetti dotati di massa) e quella “ondulatoria” (luce è fatta da onde che si propagano in mezzo

speciale, l’etere). Alcuni fenomeno come la riflessione e la rifrazione potevano essere descritti con

grande accuratezza anche senza una teoria sottostante, pertanto le leggi che descrivono il

comportamento degli specchi e delle lenti erano note anche se non era chiara la natura della luce. I

protagonisti del dibattito onda- corpuscolo sono Christiaan Huygens (1629 – 1695) e Isaac Newton

(1643 -1727)

La velocità della luce. (da “Libro di Fisica” di Isaac Asimov)

Ovviamente, la luce viaggia a velocità straordinaria: se girate l'interruttore, piombate

immediatamente nel buio, nell'attimo stesso in cui effettuate il gesto. Il suono non è altrettanto

veloce: se guardate da una certa distanza un uomo che taglia la legna, udite il colpo solo qualche

istante dopo aver visto abbattersi l'ascia; evidentemente, il suono ha impiegato qualche istante per

raggiungere l'orecchio. In effetti, è facile misurarne la velocità: 332 metri al secondo, nell'aria al

livello del mare. Galileo fu il primo a cercare di misurare la velocità della luce; stando su un'altura

mentre un suo assistente stava su un'altra, Galileo scopriva una lanterna e l'assistente, non appena

ne scorgeva il lampo, segnalava la cosa scoprendo a sua volta un'altra lanterna. Galileo effettuò

quest'esperimento a distanze sempre maggiori, presumendo che il tempo necessario all'assistente

per dare la sua risposta restasse sempre uguale, così che ogni aumento dell'intervallo di tempo tra il

momento in cui egli scopriva la sua lanterna e quello in cui vedeva la risposta avrebbe

rappresentato il tempo impiegato dalla luce a coprire la distanza in più. L'idea era buona, ma la luce

è di gran lunga troppo veloce perché con un metodo così rudimentale si possa registrare una

differenza.

10

Metodo usato da Galilei per misurare la

velocità della luce. Galilei e un

assistente, posti sulla cima di due

colline, misurano il tempo impiegato a

rispondere al segnale. Ripetono il

procedimento su distanze sempre

maggiori. Il metodo non permise a

Galilei di ottenere una misura ma solo

di ipotizzare che la velocità della luce

fosse altissima

Nel 1676, l'astronomo danese Olaus Roemer riuscì invece a misurare la velocità della luce,

ricorrendo alle distanze astronomiche; studiando le eclissi dei quattro satelliti di Giove (eclissi

prodotte dal pianeta stesso), Roemer notò che gli intervalli tra eclissi successive diventavano più

lunghi quando la terra si allontanava da Giove e più brevi quando gli si avvicinava. Era presumibile

che la differenza nei periodi delle eclissi riflettesse la differenza delle distanze tra la terra e Giove,

cioè che fosse una misura dei diversi tempi impiegati dalla luce per percorrere la distanza da Giove

alla terra. In base a una stima approssimativa delle dimensioni dell'orbita terrestre e alla massima

discrepanza tra i periodi delle eclissi (ritardo), che Roemer considerò come il tempo impiegato dalla

luce per attraversare in tutta la sua ampiezza l'orbita terrestre, egli calcolò la velocità della luce: la

sua stima fu di 212 mila chilometri al secondo, valore notevolmente prossimo alla velocità reale per

quello che può essere considerato un primo tentativo, e anche sufficientemente elevato per

suscitare l'incredulità dei suoi contemporanei. I risultati di Roemer vennero però confermati mezzo

secolo dopo in base a considerazioni del tutto diverse.

11

Giove ha un periodo di rivoluzione intorno al sole di circa 12 anni, nel tempo che la terra passa da

punto A al punto B della sua orbita (6 mesi) Giove ha compiuto un ventiquattresimo della sua (si è

mosso poco). Il satellite “Io”, il più interno, ha un periodo di rivoluzione intorno a Giove di circa 42

ore, pertanto le eclissi si ripetono con regolarità e frequenza tale da poter essere previste e

osservate più volte alla settimana. Roemer osservò che mentre la terra andava dal punto A al punto

B il ritardo tra l’orario previsto per l’eclissi e la sua osservazione aumentava (di poco) fino a

raggiungere un ritardo massimo di venti minuti circa (t = 20 x 60 = 1200 s). Roemer imputò questo

ritardo al maggior percorso che la luce doveva fare per raggiungere la terra da A a B e, in base alle

conoscenze astronomiche del tempo che davano per il diametro medio dell’orbita terrestre AB =

254 milioni Km (ora si considera AB circa 300 milioni di Km), calcolo la velocità della luce c = AB / t

= 214000 Km/s

Nel 1728, l'astronomo inglese James Bradley scoprì che le stelle sembravano cambiare posizione a

causa del moto della terra - non per via della parallasse, ma perché la velocità del moto della terra

intorno al sole costituisce una frazione misurabile, benché piccola, della velocità della luce. Di solito

per illustrare questo concetto si ricorre all'analogia di un uomo che cammina sotto un ombrello

durante un temporale: anche se le gocce cadono verticalmente, l'uomo deve inclinare l'ombrello in

avanti, perché si sta spostando rispetto alle gocce; più svelto cammina, più deve inclinare

l'ombrello. Analogamente, la terra si muove rispetto ai raggi luminosi che provengono dalle stelle, e

l'astronomo deve inclinare un pochino il telescopio, e in direzioni diverse, via via che la terra muta la

sua direzione di moto. Dall'entità dell'inclinazione ("aberrazione della luce"), Bradley poté stimare il

valore della velocità della luce, che risultò pari a 283 mila chilometri al secondo - un valore più

elevato, e anche più esatto, di quello di Roemer, benché ancora troppo basso del 5,5 per cento

circa. Infine gli scienziati ottennero misurazioni ancora più precise, perfezionando l'idea originale di

Galileo.

12

Metodo di Bardley. L’astronomo studiò il moto apparente di alcune stelle, in particolare studiò il

moto della Draconis (la stella del costellazione del Drago), chiamata Etamin. Questa stella ha la

caratteristica di trovarsi quasi esattamente sull’asse dell’eclittica, ossia sull’asse dell’orbita di

rivoluzione della terra attorno al sole. Bradley intuì che questo spostamento non ha nulla a che

vedere col moto vero della stella, ma che è una conseguenza del moto della Terra attorno al

Sole. Per lo stesso motivo la pioggia, che in assenza di vento cade verticale, non appare più tale

se ci si mette in corsa. La luce di una stella lontana che illumina la Terra perpendicolarmente

rispetto alla sua velocità è vista inclinata di un angolo rispetto alla verticale da un osservatore

terrestre. Misurando tale angolo e conoscendo la velocità orbitale della Terra si trova facilmente

c dalla relazione tg = v/c

Nel 1849, il fisico francese Armand Hippolyte Louis Fizeau ideò un dispositivo nel quale un lampo di

luce veniva inviato su uno specchio situato a 8 chilometri di distanza; lo specchio lo rifletteva fino

all'osservatore: il tempo trascorso per percorrere i 16 chilometri non superava di molto 1 su 20 mila

di secondo, ma Fizeau riuscì a misurarlo ponendo sul percorso del raggio luminoso una ruota

dentata in rapida rotazione; quando la ruota girava a una data velocità, il lampo, passato tra un

dente e l'altro all'andata, colpiva il dente successivo al ritorno; quindi Fizeau, situato dietro alla

ruota, non lo vedeva. Se poi si aumentava la velocità di rotazione della ruota, il raggio sulla via del

ritorno non veniva più bloccato, ma passava nel successivo intervallo tra un dente e l'altro. Così,

regolando e misurando la velocità di rotazione della ruota, Fizeau riuscì a calcolare il tempo

trascorso, e quindi la velocità con cui viaggiava il lampo luminoso; egli trovò che questa era di 315

mila chilometri al secondo, un valore troppo alto del 5,2 per cento.

13

La luce emessa dalla sorgente S viene collimata mediante la lente L1, la successiva lente L2 focalizza

il fascio in corrispondenza della ruota dentata R dopo averla fatta incidere sullo specchio semi

riflettente M1, il cammino ottico sarà ostruito dai denti della ruota altrimenti proseguirà per un

tratto lungo a e verrà riflesso dallo specchio M2 e tronerà indietro. Un osservatore posto in asse

con gli specchi nel punto O osserva la luce riflessa dallo specchio M2 (illuminato a intervalli)

fintanto che essa passa tra due denti della ruota. Aumentando la velocità di rotazione nel tempo

t in cui la luce percorre il tratto a in avanti e indietro un dente si troverà al posto della gola e

l’osservatore non vedrà la luce da M2. Aumentando ulteriormente la velocità di rotazione nel

tempo t una gola sarà sostituita dalla successiva e quindi l’osservatore vedrà nuovamente la luce

riflessa. Questa condizione permette di determinare l’intervallo t che risulterà essere una

frazione del periodo di rotazione, se la ruota R ha n denti e gira con frequenza f, t = 1/(nf) e la

velocità della luce sarà c = 2xa/t

Un anno dopo, Jean Foucault (che poco tempo più tardi avrebbe effettuato il famoso esperimento

del pendolo, perfezionò il metodo usando uno specchio rotante al posto della ruota dentata. Ora il

tempo trascorso veniva misurato da un leggero cambiamento della direzione in cui veniva riflesso il

raggio di luce da parte dello specchio in rapida rotazione. La migliore misurazione ottenuta da

Foucault nel 1862 fornì, come velocità della luce nell'aria, 298 mila chilometri al secondo. Un valore

troppo basso solo dello 0,7 per cento. In più, Foucault usò il suo metodo per determinare la velocità

della luce in vari liquidi e trovò che essa era considerevolmente inferiore alla velocità della luce

nell'aria. Anche questo risultato confortava la teoria ondulatoria di Huygens.

Una precisione ancora maggiore nella misurazione della velocità della luce fu resa possibile

dall'opera di Michelson, il quale - per più di quarant'anni, a partire dal 1879 - applicò il metodo di

Fizeau e Foucault, perfezionandolo progressivamente. Michelson, alla fine, fece passare la luce

attraverso il vuoto anziché attraverso l'aria (anche l'aria, infatti, rallenta leggermente la luce): a

questo scopo egli usò tubi d'acciaio lunghi oltre un chilometro e mezzo in cui veniva fatto il vuoto. In

tal modo stabilì che la velocità della luce nel vuoto era pari a 299774 chilometri al secondo - un

valore troppo basso solo dello 0,006 per cento. Egli dimostrò inoltre che le onde luminose di

qualsiasi lunghezza viaggiano nel vuoto con la stessa velocità. Nel 1972, un'équipe di ricerca diretta

da Kenneth M. Evenson effettuò delle misurazioni ancora più precise, trovando una velocità di

299792,4494 chilometri al secondo; una volta che tale velocità fu nota con una precisione così

14

stupefacente, divenne possibile usare la luce per misurare le lunghezze. (Tuttavia ciò era

conveniente anche quando si conosceva la velocità della luce con minor precisione.)

La luce emessa dalla sorgente S passa

attraverso lo specchio semiriflettente P,

incide sullo specchio rotante N, viene

focalizzata dalla lente L sullo specchio

fisso R. La luce tornando indietro

incontrerà lo specchio rotante spostato

(di poco) e verrà poi focalizzata sullo

schermo in un punto che dipende dal

tratto 2f + a e dall’angolo fatto dallo

specchio durante il tempo impiegato

dalla luce a percorrere due volte il tratto

a + 2f. Se chiamiamo lo spostamento

lineare dell’immagine sullo schermo,

avremo che = (2f-a)xTan(2)

La luce per percorrere due volte il tratto a + 2f impiega un tempo t =

2(a+2f)/c, in questo tempo lo specchio ruota di un angolo = t ( è la

velocità angolare = 2/T), l’angolo è espresso in radianti. Per angoli piccoli

(minori di 5°) la tangente è uguale all’angolo (espresso in radianti). Dalla

misura di si risale ad ( = /(4f-2a)), per cui t = /ec = (4f+2a) / t

(la figura riporta la configurazione usata da Michelson per semplificare i

calcoli)

La riflessione della Luce

Nel nostro percorso consideriamo a luce come onda pertanto valgono per la luce le considerazioni

fatte per le onde elastiche in generale e i fenomeni associati (riflessione, rifrazione, diffrazione,

interferenza). Convenzionalmente la luce come onda non viene descritta mediante i suoi fronti (con

una serie di linee parallele poste a distanza pari alla lunghezza d’onda) ma mediante un segmento

orientato (raggio di luce) perpendicolare al fronte d’onda. Pertanto, per un raggio di luce che incide

su una superficie riflettente, vale la legge della riflessione:

-

-

Raggio di luce incidente, raggio di luce

riflesso e retta perpendicolare alla

superficie passante per il punto in cui il

raggio di luce incide (normale nel punto di

incidenza) giacciono sullo stesso semi piano

Angolo di incidenza 𝑖̂ (angolo formato dal

raggio incidente e dalla normale) e angolo

di riflessione 𝑟̂ (angolo formato dal raggio

riflesso e dalla normale) sono uguali

Se la superficie è piana la riflessione avviene come nella figura seguente

15

Specchi piani

Lo specchio piano è il comune specchio, ci

siamo così abituati che spesso non notiamo le

sue proprietà. Un oggetto posto davanti alla

superficie riflettente viene percepito come

“se si trovasse al di là della superficie

riflettente”, l’immagine si forma sul

prolungamento dei raggi riflessi che originano

da un punto posto simmetricamente

all’oggetto rispetto alla superficie. L’immagine

che si forma è orientata (alto-basso) come

l’oggetto che l’ha prodotta mentre ha

SPECCHIO

rotazione invertita (destra e sinistra

scambiate). L’immagine dello specchio piano è

“virtuale” perché i raggi che arrivano

all’occhio dell’osservatore sono percepiti “come provenienti” da un punto posto dietro lo specchio,

cioè sul prolungamento virtuale dei raggi stessi oltre la superficie dello specchio.

La relazione che lega la distanza p dell’oggetto dallo specchio e della sua immagine q è

semplicemente p + q = 0, in quanto si considerano positive le distanze misurate davanti allo

specchio.

Specchi sferici

Uno specchio è sferico se la superficie riflettente è una sfera o (molto più comunemente) una parte

di essa. Gli specchi sferici (e gli specchi curvi in generale) si dividono in due gruppi:

- Specchi concavi (la superficie riflettente è rivolta verso un semispazio convesso)

- Specchi convessi (la superficie riflettente è rivolta verso un semispazio concavo, un loro

comune utilizzo è nei segnali stradali)

Per comprendere il “funzionamento” degli specchi sferici (e trovare una relazione tra la distanza di

un oggetto dalla superficie riflettente e la sua immagine), facciamo una costruzione geometrica

applicando la legge della riflessione. Chiamiamo “asse ottico” la linea retta congiungente l’oggetto e

il centro della sfera AO (quindi perpendicolare alla

superficie).

Applichiamo il teorema dei seni al triangolo formato

dall’asse ottico, il raggio incidente AB e il raggio di

B

i r

curvatura dello specchio R, abbiamo

R

A

O

𝐴𝐵

𝑝−𝑅

C

=

p

sin(180° − 𝛽)

sin(𝑖)

q

Mentre applicandolo al triangolo formato dal raggio R,

il raggio di luce riflesso e l’asse ottico otteniamo

𝐵𝐶

𝑅−𝑞

=

sin(𝛽)

sin(𝑟)

Facendo il rapporto membro a membro delle due ultime equazioni, ricordando che per la legge

della riflessione abbiamo i = r e che sin(180° - ) = sin(), otteniamo

16

𝐴𝐵 sin 𝛽

𝑝−𝑅

∙

=

𝐵𝐶 sin 𝛽

𝑞−𝑅

Usiamo l’approssimazione di Gauss di raggi quasi paralleli, allora 𝐴𝐵 ≅ 𝑝 𝑒 𝐵𝐶 ≅ 𝑞, otteniamo

𝑝 ∙ (𝑞 − 𝑅) = 𝑞 ∙ (𝑅 − 𝑝)

Dividendo per pqR abbiamo

2

1 1

= +

𝑅

𝑝 𝑞

2

Definendo 𝑅 =

1

𝑓

, la legge dei punti coniugati assume la sua forma classica

1 1

1

+ =

𝑝 𝑞

𝑓

p è la distanza del punto oggetto dalla superficie dello specchio misurata lungo l’asse ottico, q è la

distanza dell’immagine dallo specchio, f è la distanza focale, il punto dove convergono le riflessioni

dei raggi paralleli (sorgente all’infinito). Le distanze p, q, f hanno lo stesso segno se si trovano dalla

stessa parte rispetto allo specchio. La distanza focale è la metà del raggio di curvatura (f = R / 2).

Formazione delle immagini

La formazione dell’immagine è dovuta al meccanismo per il quale raggi di luce provenienti da un

medesimo punto dell’oggetto, dopo la riflessione convergono in un stesso punto, pertanto un

osservatore percepisce i raggi come uscenti dal punto di convergenza a colloca l’immagine

dell’oggetto nel punto di convergenza. In tal caso parliamo di immagine “reale” di un oggetto.

L’immagine reale di un oggetto è generalmente “rovesciata” come è possibile verificare

specchiandosi da una certa distanza in specchio da toilette.

L’eq

uazi

one

dei

punt

i

coniugati è risolvibile con semplici passaggi algebrici. In particolare abbiamo

1

1 1

= −

𝑞

𝑓 𝑝

1

𝑝−𝑓

=

𝑞

𝑝𝑓

𝑞=

𝑝𝑓

𝑝−𝑓

Esaminiamo alcuni casi particolari

17

-

p = f, l’equazione perde significato, ciò significa che un oggetto posto nel fuoco di uno

specchio sferico non produce immagine (facilmente verificabile con una costruzione grafica).

p < f, l’equazione ha significato e q < 0, significa che l’immagine si forma “dietro” lo specchio

ed è pertanto un’immagine virtuale, non rovesciata.

f < 0, lo specchio è convesso, poiché p deve essere necessariamente positivo ne consegue

che q < 0, immagine sempre virtuale, non rovesciata.

Ingrandimento

Metodi grafici di costruzione dell’immagine. Specchi concavi, figure (a) e (b). Nella figura (a) si considerano

due raggi uscenti dall’oggetto (O), uno parallelo all’asse ottico che verrà riflesso passante per il fuoco, un

secondo esce e incide sullo specchio passando per il fuoco e viene riflesso parallelo all’asse ottico.

L’immagine (i) si forma dove i raggi riflessi si incontrano poiché un osservatore li percepisce uscenti da lì.

Nella figura (b) un raggio (4) esce dall’oggetto (o) e incide sulla superficie dello specchio nel punto di

contatto con l’asse ottico e viene riflesso simmetricamente rispetto all’asse ottico. Il secondo raggio (3)

incide sullo specchio passando per il centro e viene riflesso su se stesso. L’immagine che si forma è reale

rovesciata.

Specchi convessi, figure (c) e (d). Nella figura (c) il raggio (1) incide sullo specchio parallelamente all’asse

ottico, viene riflesso lungo una retta passante per il fuoco (che si trova dietro lo specchio), il raggio (2) incide

sullo specchio lungo una retta passante per il fuoco e viene riflesso parallelamente all’asse ottico. I raggi

riflessi non si incontrano ma un osservatore li percepisce come provenienti da un punto posto dietro lo

specchio. Nella figura (d) un raggio incide sullo specchio nel punto di incontro con l’asse ottico ed è riflesso

ribaltato orizzontalmente, il secondo raggio incide sullo specchio lungo una retta passante per lo specchio

ed è riflesso su se stesso. L’immagine è virtuale non rovesciata.

E’ possibile definire l’ingrandimento di uno specchio come il rapporto tra l’altezza (distanza dall’asse

ottico) apparente dell’immagine HI di un oggetto con la sua altezza reale HO. Considerando la prima

costruzione geometrica in alto a sinistra, osserviamo due triangoli simili, possiamo pertanto scrivere

la seguente proporzione:

𝐻0 : (𝑝 − 𝑓) = 𝐻1 : 𝑓

18

𝐻0

𝐻1

=

𝑝−𝑓

𝑓

𝐻0

𝑝−𝑓

1 1

𝑝+𝑞

𝑝2 − 𝑝𝑓 + 𝑞𝑝 − 𝑞𝑓

𝑝 𝑓

𝑓

=

= ( + ) ∙ (𝑝 − 𝑓) = (

) ∙ (𝑝 − 𝑓) =

= − +1−

𝐻1

𝑓

𝑝 𝑞

𝑝𝑞

𝑝𝑞

𝑞 𝑞

𝑝

𝑓

Osserviamo che la somma degli ultimi tre termini è nulla 𝑝 +

della legge dei punti coniugati, pertanto l’ingrandimento 𝐺 =

𝑓

− 1 = 0, come conseguenza diretta

𝑞

𝐻1

𝐻0

=

𝑞

𝑝

La rifrazione della luce

Secondo il modello ondulatorio la luce ha una velocità di propagazione caratteristica del mezzo in

cui si propaga (nota: l’enorme velocità della luce portava ad immaginare l’esistenza di un mezzo

dalle caratteristiche singolari: rigido e allo stesso tempo impalpabile, dal nome di etere, fu Einstein

ha proporre la propagazione nel vuoto e quindi a “spazzare via” la teoria dell’etere cosmico), se

quindi la luce attraversa la superficie di separazione tra due mezzi diversi incidendo con angolo

diverso da zero si ha il ben noto fenomeno della rifrazione descritto dalla legge di Snell. Con

riferimento alla figura abbiamo: la luce propagandosi passa da un primo mezzo di indice n1 ad un

secondo di indice n2 (con n2 > n1) la legge della rifrazione che dice:

1 – raggio incidente PO, raggio rifratto OQ e normale alla

superficie di separazione nel punto di incidenza,

giacciono sullo stesso piano;

2 - l’angolo di incidenza i (1) e di rifrazione r (2) seguono

la legge di Snell

sin 𝑖

𝑛2

=

sin 𝑟

𝑛1

Per cui, con riferimento alla figura, se la luce passa da un mezzo meno rifrangente ad uno più

rifrangente il raggio rifratto si avvicina alla normale, cioè l’angolo di rifrazione è in generale minore

di quello di incidenza.

In ottica vale il principio di reversibilità del cammino ottico, per cui se la luce si propagasse dal

mezzo 2 al mezzo 1 avremmo la stessa figura soltanto con la freccia orientata in verso opposto.

mezzo

aria

acetone

acqua

alcol etilico

quarzo

vetro crown

vetro flint

indice di

rifrazione n

1,000292

1,359

1,334

1,365

1,458

1,517

1,732

nota

l'aria si comporta in pratica come il vuoto

19

vetro pesantissimo 1,890

diamante

2,419

il diamante è il mezzo più rifrangente

Angolo limite

Il passaggio da un mezzo più rifrangente ad uno

meno, con conseguente aumento dell’angolo

(allontanamento dalla normale), comporta

l’esistenza di un angolo di incidenza iL (inferiore a

90°) che comporta un angolo di rifrazione r = 90°.

La situazione è facilmente ricostruibile nel caso di

passaggio della luce dall’acqua all’aria, in tal caso

n1 = 1.33 e n2 = 1, la legge di Snell assume la

seguente forma

Il raggio passando in mezzo meno rifrangente si allontana

dalla perpendicolare. L’angolo limite di incidenza produce

un raggio rifratto parallelo alla superficie di separazione.

sin 𝑖𝐿

𝑛2

=

1

𝑛1

𝑛2

1

𝑖𝐿 = sin−1 ( ) = sin−1 (

) = 49°

𝑛1

1.33

L’esistenza di un angolo di incidenza per il quale l’angolo di rifrazione è 90° pone la domanda su

cosa succede ad un raggio di luce che incida con angolo superiore a quello limite. In questa

situazione la legge di Snell perde significato. Ciò significa che non si ha raggio rifratto ma il raggio

viene riflesso totalmente (riflessione totale).

Nel caso del passaggio dal vetro all’aria l’angolo limite è di circa 42°, questo permette di usare un

prisma ottenuto dividendo in due un cubo come specchio perfetto, sia per deviare un raggio di 90°

sia per rimandarlo indietro.

Utilizzo di un prisma retto in

due importanti configurazioni:

riflettore a 180° e 90°. E

entrambe le situazioni si

sfruttano incidenze con angoli

maggiori di quello limite che

per il vetro-aria è 42°

La riflessione totale ha importanti applicazioni, dalla più semplice che permette di utilizzare dei

prismi vetro o cristallo come specchi perfetti, oppure utilizzare dei materiali trasparenti e flessibili

(fibre ottiche) per convogliare la luce che non “esce” perché incide sulla superficie con un angolo

che è sempre maggiore dell’angolo limite.

20

L’utilizzo delle fibre ottiche come mezzo di trasmissione delle informazioni ha alcuni vantaggi

evidenti: la luce attraversa il mezzo dissipando pochissima energia permettendo la riduzione dei

sistemi intermedi di amplificazione e permettono la sovrapposizione di più segnali sulla stessa fibra

con poche interferenze, gli svantaggi sono altrettanto evidenti, la fibra è una materiale delicato, non

può essere “piegato” oltre un certo raggio di curvatura, la giunzione di diversi spezzoni di fibra

necessita di un accoppiatore ottico che è più complesso di un accoppiatore elettrico. Lo sviluppo

della trasmissione in fibra ottica è stato possibile solo dopo l’introduzione dei materiali adatti alla

costruzione delle fibre e di sorgenti di luce monocromatiche e collimate (laser).

Curiosità sulla riflessione totale

E’ esperienza relativamente comune aver osservato in estate che le superfici esposte al sole in

lontananza appaiono riflettenti tanto che danno l’impressione di essere bagnate, questo fenomeno

è dovuto alla variazione dell’indice di rifrazione dell’aria in relazione alla densità, e quindi alla

pressione e alla temperatura.

L’asfalto appare riflettente per ché la luce proveniente dall’alto incontra strati di aria sempre più

caldi per effetto della vicinanza alla superficie stradale, l’aria più caldo e meno densa ha un indice di

rifrazione “minore” per cui il raggio rifratto si allontana progressivamente dalla perpendicolare fino

superare l’angolo limite e ed essere completamente riflesso.

Per la dipendenza dell’indice di rifrazione dalla densità possiamo usare la seguente formula

approssimata:

𝑛 ≅1+ 𝛼∙𝜌

21

Con = 1.2 kg/m3 e = 2.5 x 10-4 che produce per l’indici di rifrazione n = 1.0003. Ricordiamo che la

densità dell’aria dipende dalla temperatura secondo la legge dei gas perfetti applicata all’aria

𝑝 = 𝜌 ∙ 𝑅𝑎 ∙ 𝑇

Quindi

𝜌 =

𝑝

𝑅𝑎 ∙ 𝑇

L’equazione ci dice che, a parità di pressione (aria stabile), all’aumentare della temperatura la

densità diminuisce e, quindi, diminuisce anche l’indice di rifrazione. L’aria a contatto con una

superficie esposta al sole può avere una temperatura superiore a quella degli strati vicini di decine

di gradi con conseguente variazione dell’indice di rifrazione. In quest’ultima situazione anche la

stabilità della colonna d’aria viene meno e la pressione negli strati superficiali è maggiore di quella

sovrastante con conseguenti moti convettivi.

A sinistra la formazione di un miraggio, a destra quella di un “fata morgana”. Gli eventi tipo fata

morgana sono meno frequenti ed hanno portato alla formazione di leggende come “navi fantasma”

o roba simile

22

Il diottro sferico

Il sistema ottico più semplice dopo la superficie piana è rappresentato da una superficie di

separazione sferica. Si considerano due mezzi di indici di rifrazione n1 e n2 separati da una superficie

sferica, generalmente n2 > n1 e la luce proviene dal mezzo 1. Si chiama asse ottico la retta che unisce

il punto oggetto (la sorgente) e il centro della sfera. Si chiama p la distanza della sorgente dei raggi

di luce e la superficie di separazione (oggetto) e q la distanza del punto di convergenza (reale o

virtuale) dei raggi rifratti dalla superficie si separazione. Se p e q si trovano rispettivamente nei

mezzi 1 e 2 avranno valore positivo, altrimenti è negativo. Cerchiamo una relazione tra p e q che

dipenda esclusivamente dai parametri del sistema (n1, n2 e R).

n2

n1

i

P

p

A

R

C

r

B

O

q

Q

Il raggio di luce che emerge

da P, incide sulla superficie

sferica nel punto A e viene

rifratto. Incontra l’asse

ottico nel punto Q.

Osserviamo che per gli angoli di incidenza e di rifrazione valgono le relazioni i = + , r = – ,

mentre le distanze sull’asse ottico sono p = PC e q = CQ, applicando il teorema dei seni ai triangoli

APO ed AOQ

sin 𝑖

sin 𝛽

=

𝑝+𝑅

𝑃𝐴

sin 𝑟

sin(𝜋 − 𝛽)

=

𝑞−𝑅

𝐴𝑄

Eseguendo il rapporto membro a membro delle due espressioni, otteniamo

sin 𝑖 𝑞 − 𝑅

𝐴𝑄

∙

=

sin 𝑟 𝑝 + 𝑅

𝑃𝐴

Sostituendo la legge di Snell

sin 𝑖

𝑛2

=

sin 𝑟

𝑛1

Con piccoli arrangiamenti abbiamo

𝑛2 𝑞 − 𝑅

𝐴𝑄

𝑃𝐴

𝐴𝑄

𝑛1 (𝑝 + 𝑅)

𝑛2 (𝑞 − 𝑅)

∙

=

→

=

→

=

𝑛1 𝑝 + 𝑅

𝑃𝐴

𝑛1 (𝑝 + 𝑅)

𝑛2 (𝑞 − 𝑅)

𝑃𝐴

𝐴𝑄

23

Quest’ultima espressione non è ulteriormente semplificabile e ci dice che, in generale, non c’è una

relazione semplice tra p e q, essa dipende dal cammino ottico fatto (PA e AQ), quindi un oggetto

puntiforme non forma un’immagine puntiforme, il diottro è astigmatico. Introduciamo

un’approssimazione di raggi che sono quasi paralleli all’asse ottico (raggi parassiali), in tal caso

𝑃𝐴 ≅ 𝑝 𝑒 𝑄𝐴 ≅ 𝑞, allora dopo opportune semplificazioni (dividendo per R) otteniamo

𝑛1 𝑛2

𝑛2 − 𝑛1

+

=

𝑝

𝑞

𝑅

L’approssimazione utilizzata è nota come approssimazione di Gauss e la formula trovata è nota

come equazione di Cartesio per i punti coniugati. L’approssimazione di Gauss, nella pratica, non è

molto stringente perché se immaginiamo una superficie sferica che delimita una lente di 4 cm di

diametro, con un oggetto posto a 25 cm di distanza tutti i raggi incidenti rispetteranno tale

approssimazione tan() = ((diametro/2))/distanza = 2/25 = 0.08, quindi è inferiore a 5°.

Analizziamo la formula di Cartesio nel caso di un oggetto molto lontano dalla superficie, (𝑝 → ∞),

in tal caso n1/p sarà così piccolo da poter essere trascurato e tutti i raggi convergeranno in un punto

chiamato fuoco, la distanza di questo punto dalla superficie di separazione prende il nome di

distanza focale (f2 nel nostro caso)

𝑛2

𝑛2 − 𝑛1

𝑛2

=

→ 𝑓2 =

𝑅

𝑓2

𝑅

𝑛2 − 𝑛1

Osserviamo che in caso di n1 = n2 l’espressione perde di significato, mentre per un passaggio da un

mezzo meno rifrangente ad uno più rifrangente (aria – vetro, n2 > n1 come in figura) f2 > R.

Chiediamoci se esiste una distanza f1 dalla superficie di separazione per la quale non si forma

immagine, cioè q = ∞, quindi 1/q è trascurabile

𝑛1

𝑛2 − 𝑛1

𝑛1

=

→ 𝑓1 =

𝑅

𝑓1

𝑅

𝑛2 − 𝑛1

Anche in questo caso f1 è positiva ma non è necessariamente maggiore di R (f1 < f2). Con l’aiuto delle

distanze focali è abbastanza semplice costruire graficamente l’immagine e determinarne

l’ingrandimento.

n1

n2

A

f1

B

p

f2

B’

O

q

A’

24

Osserviamo che l’immagine è reale rovesciata, la relazione tra le distanze dell’oggetto e

dell’immagine è data dalla formula di Cartesio, per calcolare il fattore di ingrandimento, osserviamo

che dentro il mezzo 2 si formano due triangoli simili, pertanto

𝐴′𝐵′

𝐴𝐵

𝐴′𝐵′

𝑓2

=

→ 𝑖𝑛𝑔𝑟𝑎𝑛𝑑𝑖𝑚𝑒𝑛𝑡𝑜 𝐺 =

=

𝑞 − 𝑓2

𝑓2

𝐴𝐵

𝑞 − 𝑓2

Analogamente nel mezzo 1 abbiamo

𝐴′𝐵′

𝐴𝐵

𝐴′𝐵′

𝑝 − 𝑓1

=

→ 𝑖𝑛𝑔𝑟𝑎𝑛𝑑𝑖𝑚𝑒𝑛𝑡𝑜 𝐺 =

=

𝑓1

𝑝 − 𝑓1

𝐴𝐵

𝑝

Lente sottile

Consideriamo il sistema di due superfici

sferiche di raggi R1 e R2 che delimitano una

regione di spazio con indice di rifrazione n12

(n12 = n2/n1, se il mezzo 1 è l’aria n1 = 1 e n12 =

n2). Osserviamo la figura e notiamo che le

distanze p e q sono calcolate relativamente

all’asse centrale, applicando la legge del

diottro sferico alla prima superficie di

curvatura R1 abbiamo

n12

o

q

p

i’

i

q’

d

1

𝑛12

𝑛12 − 1

+ ′

=

𝑝−𝑑 𝑞 +𝑑

𝑅1

Con questa formula possiamo determinare dove si formerebbe l’immagine i’ se non ci fosse la

seconda superficie, notiamo che i’ è a destra della seconda superficie, quindi essendo per

quest’ultima un oggetto ha coordinate negative, infatti applicando la formula di Cartesio rispetto

alla seconda superficie (di curvatura R2 negativa) troviamo

1

𝑛12

1 − 𝑛12

− ′

= −

𝑞−𝑑 𝑞 −𝑑

𝑅2

Osserviamo che il passaggio è dal mezzo 2 al mezzo 1. Introduciamo l’ipotesi di sistema sottile, cioè

d << p e q, allora sommando le due equazioni abbiamo

1 1

1

1

1

+ = (𝑛12 − 1) ( +

)=

𝑝 𝑞

𝑅1 𝑅2

𝑓

Determinata la geometria del sistema (raggi di curvatura e materiale), se lo spessore della lente è

piccolo, l’oggetto e l’immagine sono determinati da una semplice legge (punti coniugati)

formalmente analoga a quella degli specchi sferici ma con convenzione diversa per i segni, p e q

hanno lo stesso segno se si trovano da parti opposte della lente. Osserviamo che anche la distanza

1

focale può essere negativa nel caso in cui (almeno una curvatura è negativa) risulti (𝑅 +

1

1

𝑅2

) < 0.

25

L’ingrandimento angolare

L’occhio umano è sicuramente un organo importante ma le sue capacità possono essere migliorate

in diversi modi con strumenti ottici come occhiali, microscopi e telescopi. Molti di questi dispositivi

espandono la capacità del nostro occhio oltre la regione visibile, ad esempio i satelliti sono

equipaggiati con sensori infrarossi e microscopi a raggi X. La legge dei punti coniugati aplicabile agli

specchi e alle lenti sottili può essere applicata agli strumenti solo come prima approssimazione,

infatti in molti strumenti ottici le lenti sono “lenti composte” e spesso le superfici non sono sferiche,

ciò nonostante descriviamo il principio di funzionamento degli strumenti ottici come se la legge dei

punti coniugati fosse esatta.

Un normale occhio umano è in grado di mettere a fuoco sulla retina l’immagine definite di u oggetto

se questo è posto ad una distanza compresa tra l’infinito e una determinata distanza detta “punto

prossimo”. Avvicinando l’oggetto ulteriormente all’occhio l’immagine appare sfocata. La distanza di

punto prossimo cambia con l’età, generalmente aumenta. Possiamo affermare che la distanza

media per il punto prossimo sia 25 cm. La figura mostra un oggetto O posto nella vicinanza del

punto prossimo di un occhio umano. La dimensione dell’immagine sulla retina dipende dall’angolo

che l’oggetto occupa nel campo visivo. Muovendo l’oggetto verso l’occhio (come in figura) l’angolo

aumenta e, quindi, anche la possibilità di distinguere dei dettagli dell’oggetto. Comunque, poiché

l’oggetto si avvicina al punto prossimo, l’immagine non sarà a più a fuoco e perderà definizione. E’

possibile recuperare la nitidezza dell’immagine osservando l’oggetto attraverso una lente

convergente posta in modo che l’oggetto sia a distanza inferiore alla distanza focale f1 della lente.

Ciò che si osserva è l’immagine virtuale dell’oggetto prodotta dalla lente. L’immagine è allontanata

dal punto prossimo e l’occhio la distingue nitidamente. L’angolo q’ sotto il quale è percepita

l’immagine virtuale è maggiore dell’angolo q sotto il quale era percepito l’oggetto. L’ingrandimento

angolare, da non confondere con l’ingrandimento lineare sarà

𝜃′

𝐺𝜃 =

𝜃

26

L’occhio

La parte anteriore dell'occhio si comporta come un sistema ottico centrato, le cui caratteristiche

geometriche sono controllate dai muscoli del corpo ciliare i quali modificano la curvatura delle

superfici rifrangenti, regolando le distanze focali del sistema. La parete posteriore dell'occhio è il

supporto della retina, uno strato di cellule fotosensibili sul quale viene a formarsi l'immagine reale

degli oggetti della visione.

Schematizzazioni dell’occhio

umano

In condizioni di riposo del muscolo ciliare la seconda distanza focale dell'occhio f2, il cui valore è

essenzialmente fissato dalla curvatura della cornea, cade sulla retina. Su di essa si formano le

immagini reali degli oggetti posti a grande distanza. Può capitare per ragioni patologiche o

congenite che la lunghezza dell'occhio, ovvero la distanza tra il sistema rifrangente e la retina sia

maggiore di f2. In questo caso si dice che l'occhio è miope e l'immagine degli oggetti distanti si

forma di fronte alla retina e su di essa arriva sfuocata. In una lente, le immagini reali di oggetti vicini

si mettono a fuoco a distanze maggiori della distanza focale. Affinché nell'occhio siano a fuoco sulla

retina, occorre che f2 sia minore della lunghezza oculare. Per ottenere questo risultato va variata la

curvatura del cristallino. Questa procedura ha un limite fisiologico che impedisce di mettere a fuoco

oggetti più prossimi di una certa distanza, detta di minima visione distinta. Per un adulto giovane

questa distanza vale all'incirca d0=25 cm e diventa sempre maggiore con l'età (un bambino di 10

anni ha una distanza di visione distinta di 7 cm).

La dimensione apparente di un oggetto è legata all'angolo visuale che esso individua. Questo è

approssimativamente dato dal rapporto tra le dimensioni lineari dell'oggetto e la distanza alla quale

esso si trova dall'occhio dell'osservatore. È questo il motivo per cui uno stesso oggetto ci pare più o

meno grande a seconda della sua distanza dal nostro occhio. Dunque avvicinando all'occhio un

oggetto se ne aumenta la dimensione apparente. Tuttavia, come già detto, l'occhio umano è in

grado di mettere a fuoco un oggetto solo se questo si trova ad una distanza superiore al cosiddetto

limite della visione distinta (o punto prossimo), che corrisponde all'incirca a 25 cm.

Per questo motivo non è possibile apprezzare i dettagli di un oggetto molto piccolo semplicemente

aumentandone la dimensione apparente, ossia avvicinandolo indefinitamente all'occhio. Questo

problema può essere risolto facendo uso di dispositivi ottici noti come microscopi.

27

Sistemi Ottici: il microscopio

Il microscopio semplice, ovvero la comune lente di ingrandimento, è costituito da una singola lente

convergente (biconvessa). L'osservatore mantiene il suo occhio in corrispondenza di uno dei fuochi

della lente, e fa sì che l'oggetto si trovi tra la lente e il secondo fuoco. In queste condizioni si forma

un'immagine virtuale dell'oggetto, ingrandita e non capovolta. Quanto più l'oggetto è vicino al

secondo fuoco, tanto più lontana dalla lente (e dall'occhio) si forma l'immagine virtuale. Quando

l'oggetto si trova in corrispondenza del secondo fuoco, la sua immagine virtuale si forma all'infinito.

Dunque, aggiustando la distanza tra l'oggetto reale e il secondo fuoco, si può far sì che l'immagine

virtuale si formi oltre il limite della visione distinta. Poiché in condizioni rilassate l'occhio focalizza

all'infinito

Il microscopio composto è in grado di produrre ingrandimenti maggiori di quelli possibili con un

microscopio semplice. Esso è costituito da due lenti convergenti poste sullo stesso asse ottico. La

prima, detta obiettivo (focale foc), ha lo scopo di produrre un'immagine reale e fortemente

ingrandita dell'oggetto sulla quale la seconda lente, detta oculare (focale fob), agisce come un

microscopio semplice, producendone un'immagine virtuale ulteriormente ingrandita. Perché ciò

possa succedere, l'immagine reale prodotta dall'obiettivo deve cadere tra il primo fuoco dell'oculare

e l'oculare stesso. l'immagine reale prodotta da una lente risulta capovolta rispetto all'oggetto. Ne

segue che l'immagine prodotta da un microscopio composto è capovolta. Dovendo produrre

ingrandimenti elevati, l'obiettivo di un microscopio composto ha in genere una lunghezza focale

piuttosto breve. Inoltre, la distanza tra obiettivo e oculare, detta tiraggio ottico del microscopio, è

solitamente fissa (circa 16,5 cm). Regolando la distanza tra il campione e il blocco obiettivo-oculare

si modifica la posizione dell'immagine reale e quindi di quella virtuale. Quando quest'ultima si trova

al di là del limite della visione distinta, essa può essere messa a fuoco dall'occhio. Come discusso

sopra, se si porta l'immagine reale esattamente sul fuoco dell'oculare, l'immagine virtuale viene

prodotta da quest'ultimo all'infinito. In queste condizioni l'occhio deve fare il minimo sforzo per

metterla a fuoco.

Rappresentazione non in scala di un microscopio composto. La lente Obiettivo produce un’immagine reale dell’oggetto

O a una distanza di poco inferiore alla distanza focale delle F 1 della lente Oculare. L’immagine I è l’oggetto per la lente

oculare che produce un’immagine virtuale I’ che viene percepita dall’osservatore. S è la lunghezza del tubo che separa le

due lenti

28

Il sistema ottico del microscopio fa sì che l’immagine I dell’oggetto O rispetto all’obbiettivo si formi

sufficientemente vicino al fuoco f1’ dell’oculare, di modo che l’immagine I’ rispetto all’oculare si

formi in un punto più lontano del punto prossimo e sia ingrandita (si agisce sulla distanza s). La

grandezza s (distanza tra i due fuochi f2 e f1’) è detta tiraggio e normalmente nei microscopi s>>fob

per cui si ha 2 fob + s s mentre l’oculare agisce come una lente. I due ingrandimenti Gob e Goc sono:

𝐺𝑜𝑏 = −

𝑖

𝑠

25 𝑐𝑚

≈ −

𝐺𝑜𝑐 =

,

𝑝

𝑓

𝑓𝑜𝑐

𝐺 = 𝐺𝑜𝑏 ∙ 𝐺𝑜𝑐 ≈ −

𝑠 25 (𝑐𝑚)

∙

𝑓𝑜𝑏

𝑓𝑜𝑐

Il telescopio

Il telescopio serve ad osservare oggetti molto distanti, la sua configurazione è abbastanza simile a

quella del microscopio composto. Come il microscopio composto, anche il telescopio è formato da

un obiettivo e da un oculare. Il sistema è costruito in modo che i fuochi delle due lenti siano

coincidenti. L’immagine dell’oggetto O posto a distanza quasi infinita e visto sotto l’angolo qob ad

occhio nudo viene fatta convergere nel fuoco F2 F1’ e vista dall’occhio sotto l’angolo qoc (invertita).

L’ingrandimento (angolare) vale

𝑓𝑜𝑏

𝐺𝑞 = −

𝑓𝑜𝑐

Rappresentazione non in scala di un telescopio rifrattore. I raggi provenienti da un oggetto lontano raggiungono la lente

Obiettivo approssimativamente paralleli. L’Obiettivo crea un’immagine I reale approssimativamente nel fuoco F 2 che

coincide con il fuoco F1 della lente Oculare.

Contrariamente a quanto succede per il microscopio composto, nel telescopio è l'oculare ad avere

la distanza focale minore. Poiché l'oggetto osservato è molto lontano, i raggi che provengono da

esso arrivano praticamente paralleli all'obiettivo, è allora chiaro che quest'ultimo produce

un'immagine capovolta nel suo piano focale rivolto verso l'oculare. La dimensione di tale immagine

coincide con quella apparente con cui vediamo l'oggetto lontano ad occhio nudo. Anche in questo

caso l'oculare funge da microscopio semplice, producendo un'immagine virtuale fortemente

ingrandita dell'immagine reale creata dall'obiettivo. A differenza del microscopio semplice, nel

telescopio il tiraggio ottico non è fissato. Infatti, essendo l'oggetto da osservare molto lontano, la

sua distanza dall'obiettivo non può essere variata sensibilmente. I raggi provenienti dall'oggetto

sono paralleli (o quasi), per cui l'obiettivo ne forma un'immagine reale in prossimità del suo

secondo piano focale. Ne segue che, per spostare al di là del limite della visione distinta l'immagine

virtuale formata dall'oculare, conviene aggiustare opportunamente il tiraggio ottico.

29

Il prisma (non dispersivo)

i

r

r’

i’

n12

Consideriamo un prisma (un solido di sezione triangolare) di materiale trasparente il cui indice di

rifrazione rispetto al mezzo esterno sia n12 > 1, sia l’angolo di apertura del prisma, consideriamo

un raggio di luce che incide (come in figura) ci chiediamo con quale angolo emergerà dal prisma,

cioè quale angolo ci sarà tra il raggio incidente su una faccia del prisma e il raggio che emerge dalla

faccia opposta. Applichiamo la legge di Snell alla prima rifrazione, avremo

sin 𝑖

= 𝑛12

sin 𝑟

Analogamente per la seconda rifrazione abbiamo

sin 𝑖′

1

=

sin 𝑟′

𝑛12

Ora un’osservazione geometrica, consideriamo il quadrilatero formato dai lati del prisma e dalle due

perpendicolari nel punto incidenze ed emergenza, sappiamo che la somma degli angoli interni di un

quadrilatero è un angolo giro, dal momento che in questo quadrilatero ci sono due angoli retti,

risulta che l’angolo opposto ad sarà 180° - , per cui l’angolo in figura risulta essere . Allora = r

+ i’, quindi i’ = - r. Osserviamo il triangolo formato dal raggio dentro il prisma e dai prolungamenti

del raggio incidente ed emergente, l’angolo esterno è l’angolo di deviazione tra il raggio incidente

ed emergente, = (i - r) + (r’ – i’), cioè

𝛿 = (𝑖 + 𝑟 ′ ) − (𝑟 + 𝑖 ′ ) = (𝑖 + 𝑟 ′ ) − 𝜔

Si trova sperimentalmente (ma anche teoricamente) che questo angolo ha un minimo al variare

dell’angolo i. In condizione di minimo si ha

𝛿

+ 𝜔

sin 𝑚𝑖𝑛2

𝑛12 =

𝜔

sin 2

Condizione che permette la misura dell’indice di rifrazione del materiale con cui è fatto il prisma con

grande precisone.

30

La dispersione della luce

Fino a questo punto abbiamo parlato di luce in modo indistinto pur sapendo che si tratta di un

gruppo di onde elettromagnetiche di lunghezza d’onda compresa tra 400 e 700 nm, abbiamo

descritto quei fenomeni (riflessione e rifrazione) che in prima analisi non dipendono dalla lunghezza

d’onda.

Dipendenza dell’indice di rifrazione dalla lunghezza d’onda

L’indice di rifrazione di un mezzo materiale manifesta una debole (ma non troppo) dipendenza dalla

lunghezza d’onda della luce che lo attraversa. Si osserva sperimentalmente una diminuzione dell’indice n

al crescere della lunghezza d’onda (dispersione normale). In prossimità di un assorbimento (quando cioè

l’energia dei singoli fotoni è vicina all’energia necessaria ad un elettrone a salire di livello, l’indice di

rifrazione varia in modo sensibile con la lunghezza d’onda e può essere anche minore di uno! Ciò non

significa che l’onda viaggia ad una velocità cn = cv/n > cv, ma che l’onda si disperde, cioè onde con diverse

lunghezza d’onda emesse contemporaneamente dalla stessa sorgente, viaggiando a velocità diversa

perdono il “loro stare insieme” pur mantenendo una velocità media complessiva (velocità di gruppo)

inferiore alla velocità della luce nel vuoto.

Si trova che, per la maggior parte delle sostanze, l'indice di rifrazione decresce con regolarità

all'aumentare della lunghezza d'onda della radiazione visibile considerata; la relazione che lega

l'indice di rifrazione alla lunghezza d'onda, n=n(λ), è detta relazione di dispersione. In buon accordo

con i dati sperimentali, vale la formula dovuta ad A. Cauchy:

𝑛=𝑎+

𝑏

𝑐

+

𝜆2 𝜆3

dedotta dalla teoria elettromagnetica dell'interazione della radiazione elettromagnetica con la

materia, in cui a, b e c sono costanti positive. Poiché la dispersione, come grandezza fisica, è definita

dal rapporto n/λ tra la variazione infinitesima dell'indice di rifrazione e la corrispondente

variazione infinitesima di lunghezza d'onda, per la formula di Cauchy si ha:

𝑑𝑛

2𝑏

= − 3

𝑑𝜆

𝜆

31

essendosi trascurato, come è lecito, il che dipende da potenze superiori. Risulta pertanto che le

radiazioni di lunghezza d'onda maggiore subiscono una deviazione minore; in altre parole, le

radiazioni nella zona del rosso dello spettro visibile hanno una dispersione minore di quelle della

zona del violetto. In pratica, la dispersione di un mezzo si misura mediante il numero di Abbe, detto

anche potere dispersivo, o costringenza, o coefficiente di dispersione media. Si noti, tuttavia, che,

talvolta, si definisce potere dispersivo l'inverso del numero di Abbe. Il fenomeno della dispersione

sopra trattato fu definito dispersione normale, in contrapposizione al fenomeno della dispersione

anomala presentato da alcune sostanze (per esempio, la parafucsina solida) e consistente nel fatto

che per esse la formula di Cauchy non è più valida e, in particolare, si ha un incremento dell'indice di

rifrazione all'aumentare della lunghezza d'onda della radiazione. In realtà, le radiazioni luminose

costituiscono una piccola porzione dello spettro elettromagnetico, che va dalle radioonde ai raggi

infrarossi e, dall'altra parte del visibile, dai raggi ultravioletti ai raggi X e ai raggi γ. La teoria

completa dell'interazione elettromagnetica con la materia prevede nei materiali la presenza di

bande di assorbimento in corrispondenza di determinati valori della lunghezza d'onda della

radiazione che le attraversa; vicino a queste bande di assorbimento non è più valida la formula di

Cauchy e la relazione di dispersione presenta una forma molto complessa che, in particolare,

descrive il comportamento caratteristico della dispersione anomala. Tutte le sostanze presentano

quindi dispersione anomala, solo che per la maggior parte di esse le bande di assorbimento non

cadono nel visibile e pertanto il fenomeno non poté nei primi tempi, essere osservato. Per quanto

detto, quindi, la distinzione tra dispersione normale e dispersione anomala ha sostanzialmente un

significato storico.

L’interferenza della luce – L’esperimento di Young

Nel 1801 l’inglese Thomas Young (1773-1829) eseguì un esperimento di importanza fondamentale

che confermò l’ipotesi della natura ondulatoria della luce e fornì un metodo operativo per

misurarne la lunghezza d’onda. La figura seguente mostra uno schema dell’esperimento, in cui la

luce di una sola lunghezza d’onda (detta luce monocromatica) passa prima attraverso una fenditura

singola molto sottile e poi va a incidere su altre due fenditure S1 e S2, molto sottili e molto vicine tra

loro. Le due fenditure S1 e S2 si comportano come sorgenti coerenti di luce perché la luce emessa da

ciascuna di esse proviene dalla stessa sorgente, cioè dalla fenditura singola. Queste due fenditure

producono su uno schermo una figura d’interferenza formata da frange chiare alternata a frange

scure.

32

La figura seguente mostra il cammino delle onde che incidono nel punto centrale dello schermo.

Nella parte A della figura le distanze ℓ1 e ℓ2 tra questo punto e le fenditure sono uguali e ciascuna

contiene lo stesso numero di lunghezze d’onda. Perciò le onde interferiscono costruttivamente e

danno origine a una frangia chiara. La parte B della figura mostra che le onde interferiscono

costruttivamente perché la differenza di cammino è uguale ad una lunghezza d’onda producendo

due frange chiare in posizioni simmetriche rispetto alla frangia centrale quando la differenza dei

cammini è uguale a una lunghezza d’onda (nella figura è mostrato solo il caso ℓ2 − ℓ1 = 𝜆).

Le onde interferiscono costruttivamente, producendo altre frange chiare (non rappresentate nella

figura) da entrambe le parti della frangia centrale, ogni volta che la differenza tra i cammini ℓ2 e ℓ1

è uguale a un numero intero di lunghezze d’onda: λ, 2λ, 3λ ecc.

La parte C della figura mostra come si forma la prima frangia scura. In questo caso la distanza ℓ2 è

maggiore di ℓ1 e la differenza ℓ2 − ℓ1 è esattamente uguale a mezza lunghezza d’onda, perciò le

onde interferiscono distruttivamente e danno origine alla frangia scura. Le onde interferiscono

distruttivamente, producendo altre frange scure da entrambe le parti della frangia centrale, ogni

volta che la differenza tra ℓ1 e ℓ2 è uguale a un numero dispari di mezze lunghezze d’onda:

ℓ2 − ℓ1 = (2𝑛 + 1)

𝜆

2

𝑛 = 0, 1, 2, 3, … … …

Ai tempi in cui l’esperimento fu condotto fu considerato una prova molto convincente in favore

della teoria ondulatoria della luce.

33

Condizione di interferenza

Le posizioni delle frange sullo schermo possono essere calcolate osservando la figura seguente. Se la

distanza dello schermo dalla doppia fenditura è molto grande rispetto alla distanza d tra le due

fenditure, le rette indicate con ℓ1 e ℓ2 nella parte A della figura sono praticamente parallele e

quindi formano angoli θ praticamente uguali rispetto alla retta perpendicolare allo schermo con le

due fenditure. La differenza Δℓ tra le distanze ℓ1 e ℓ2 nella figura è uguale alla lunghezza del lato

minore del triangolo colorato rappresentato nella parte B della figura. Poiché questo triangolo è

rettangolo, si ha che

∆ℓ = 𝑑 sin 𝜗

L’interferenza è costruttiva quando le distanze ℓ1 e ℓ2 differiscono di un numero intero di lunghezze

d’onda, cioè quando ∆ℓ = 𝑑 sin 𝜗 = 𝑚 𝜆

.

Perciò le ampiezze dell’angolo θ che danno luogo ai massimi di interferenza possono essere

calcolate con la formula seguente:

𝑓𝑟𝑎𝑛𝑔𝑒 𝑖𝑛𝑡𝑒𝑟𝑓𝑒𝑟𝑒𝑛𝑧𝑎 𝑐ℎ𝑖𝑎𝑟𝑒:

sin 𝜃 = 𝑚

𝜆

𝑑

𝑚 = 0, 1, 2, 3, … ..

Il valore di m è chiamato ordine della frangia; per esempio, m = 2 indica la frangia chiara «di

secondo ordine». Gli angoli θ che si ricavano dall’equazione precedente individuano le posizioni

delle frange chiare su entrambi i lati della frangia centrale (figura C).

Ragionando in modo analogo si giunge alla conclusione che le posizioni delle frange scure che si

formano tra quelle chiare possono essere calcolate con la formula seguente:

𝑓𝑟𝑎𝑛𝑔𝑒 𝑖𝑛𝑡𝑒𝑟𝑓𝑒𝑟𝑒𝑛𝑧𝑎 𝑠𝑐𝑢𝑟𝑒:

1 𝜆

sin 𝜃 = (𝑚 + )

2 𝑑

𝑚 = 0, 1, 2, 3, … ..

Interferenza su lamine sottili

Nella vita quotidiana è piuttosto frequente osservare il fenomeno dell’interferenza delle onde

luminose riflesse da lamine sottili (figura seguente). La parte B della figura schematizza una sottile

34

pellicola di benzina che galleggia sull’acqua e sulla quale incide in direzione quasi perpendicolare un

fascio di luce monocromatica. Nel punto d’incidenza si hanno due raggi luminosi: il raggio riflesso 1

e il raggio rifratto che attraversa la pellicola. Dove il raggio rifratto incontra la superficie di

separazione benzina-acqua si origina un fascio riflesso 2 che attraversa la pellicola e torna a

propagarsi nell’aria. Le onde 1 e 2 possono interferire fra loro come le onde luminose provenienti

dalle due fenditure nell’esperimento di Young. Per determinare le condizioni d’interferenza bisogna

valutare i due fattori che cambiano la fase delle onde: la distanza percorsa e la riflessione. L’indice

di rifrazione di un mezzo materiale è legato alla costante dielettrica, il campo elettrico dell’onda

luminosa nel passaggio da un mezzo materiale ad un altro subisce una variazione (se il passaggio è

verso un mezzo ad indice di rifrazione maggiore il campo si riduce), la grandezza campo elettrico

però non può essere discontinua, ciò significa che nel mezzo da cui proviene la luce deve prodursi

una nuova onda con fase opposta che compensi il valore del campo. Ciò significa che il fenomeno

della rifrazione è accompagnato da quello della riflessione. Se il passaggio è da un mezzo

rifrangente ad uno più rifrangente si ha necessariamente un’inversione di fase dell’onda riflessa,

non succede nel caso contrario. Ricordiamo che la frequenza dell’onda non è modificata nella

rifrazione ma, cambiando la velocità, si modifica la lunghezza d’onda, abbiamo cioè:

𝜆𝑚𝑒𝑧𝑧𝑜 =

𝜆𝑣𝑢𝑜𝑡𝑜

𝑛

Questo fatto spiega come mai un sottile strato di idrocarburo galleggiante sull’acqua appare

iridescente. Un raggio di luce nel passaggio dall’aria all’idrocarburo viene rifratto e la lunghezza

d’onda nell’idrocarburo si riduce, il raggio riflesso subisce un’inversione di fase. Nel passaggio

dall’idrocarburo all’acqua (che ha indice di rifrazione inferiore) il raggio riflesso è in fase con il raggio

incidente. Un osservatore vede la luce emergere dalla superficie dell’idrocarburo con diverse fasi

per cui è possibile che si formi interferenza. La condizione di interferenza costruttiva si avrà se la

luce emergente dall’idrocarburo riflessa dall’acqua sia in fase con la luce riflessa dall’idrocarburo, se

lo sfasamento è di mezza lunghezza d’onda avremo interferenza distruttiva. Se chiamiamo t lo

spessore dell’idrocarburo, i raggi 1 e 2 della figura faranno interferenza distruttiva se la differenza di

35

cammino 2t sommata all’inversione di fase per riflessione sia un multiplo della lunghezza d’onda più

mezza lunghezza d’onda, ricordando che nell’idrocarburo la lunghezza d’onda è ridotta si ha:

2𝑡 = 𝑚

𝜆

,

𝑛

𝑚 = 1, 2, 3 … ..

La superficie dell’acqua (all’aperto) difficilmente è stazionaria, per cui sulla stessa direzione si hanno

interferenze di diverse lunghezze d’onda, da cui l’iridescenza. In caso di osservazione quasi

perpendicolare l’osservazione della “luce mancante” permette di risalire allo spessore dello strato.

Questo meccanismo è alla base dei così detti filtri interferenziali utili per ridurre determinate

lunghezza d’onda.

Diffrazione (fonte Cutnell and Johnson – elementi di fisica)

L’interferenza produce i suoi effetti anche quando la luce attraversa anche una sola fenditura.

L’intensità del fenomeno è legata alla larghezza d della fenditura ed è apprezzabile se 𝑑 ≈ 𝜆 cioè

se la larghezza della fenditura è confrontabile con lunghezza d’onda (es: luce verde, = 500 nm, per

osservare la diffrazione d deve essere la massimo 10 – 100 volte , cioè 𝑑 ≈ 0.05 𝑚𝑚).

Consideriamo un fronte d’onda piano che incide perpendicolarmente su una fenditura molto stretta

e determiniamo le caratteristiche della figura di diffrazione che si forma su uno schermo molto

lontano dalla fenditura. Immaginiamo come in figura che la fenditura si comporta come un fronte

d’onda caratterizzato da cinque sorgenti in fase che, secondo il principio di Huygens emettono onde

circolari. La figura mostra cinque delle sorgenti di onde sferiche secondarie descritte dal principio di

Huygens. Consideriamo il modo in cui la luce emessa da queste cinque sorgenti raggiunge il punto