Università degli Studi di Trieste

FACOLTÀ DI SCIENZE MATEMATICHE, FISICHE E NATURALI

Corso di Laurea Triennale in Fisica

Tesi di Laurea Triennale

Esempi di deconvoluzione di

distribuzioni sperimentali da effetti del rivelatore

Candidato:

Relatore:

Alessandro Angioi

Dott. Giuseppe Della Ricca

Matricola SM2000095

Correlatore:

Dott. Vieri Candelise

Anno Accademico 2011-2012

—A Bianca, Maura e Claudia

RINGRAZIAMENTI

Per questa tesi, vorrei innanzitutto ringraziare Giuseppe Della Ricca e Vieri

Candelise per la loro dedizione e la loro pazienza nel lavoro che abbiamo

svolto insieme. Voglio ringraziare anche i miei genitori, ai quali devo tutto,

inclusa l’opportunità di studiare fisica a Trieste, e ringrazio mia sorella per

l’appoggio morale che mi ha fornito durante questi mesi di lavoro per la tesi.

Inoltre mi sento in debito con tutti i professori che ho avuto nell’arco di questa triennale, per la passione verso la fisica e l’insegnamento che ciascuno di

loro ha mostrato. Un ringraziamento anche agli amici ed ai colleghi che ho

trovato a Trieste; credo fermamente che non sarei mai riuscito a concludere

questo corso di studi senza di voi! Infine, ringrazio i miei parenti e tutti

gli amici di famiglia, che mi hanno fatto crescere in un ambiente bizzarro e

variegato, ma soprattutto molto umano e pieno d’affetto.

iii

INDICE

1

introduzione al metodo

1

1.1 Il problema dell’Unfolding

1

1.2 Esempio semplice

1

1.3 Unfolding basato sul teorema di Bayes

1.4 Unfolding SVD

3

2

lhc,

2.1

2.2

2.3

3

validazione ed analisi dati

17

3.1 Descrizione dei dati

17

3.2 Operazioni preliminari all’Unfolding

3.3 Test di validazione

18

3.4 Unfolding dei dati

19

4

cms e fisica dei jet

LHC

9

CMS

11

Fisica dei Jet

14

conclusioni

bibliografia

2

9

17

21

23

v

1

1.1

INTRODUZIONE AL METODO

il problema dell’unfolding

Nella fisica delle alte energie, ci si trova spesso a dover misurare delle distribuzioni che sono in qualche modo distorte da effetti come accettanza limitata o risoluzione finita del rivelatore. Risulta quindi poco sensato confrontare

direttamente le predizioni teoriche con i dati misurati senza prima compiere

qualche studio atto a deconvolvere (to unfold) gli effetti del rivelatore dalla

distribuzione misurata.

Chiamato b il vettore che ha come componente i-esima il numero di

entries dell’i-esimo bin della distribuzione misurata, e chiamato x il vettore

che ha come componente i-esima il rapporto tra l’i-esimo bin della distribuzione soggiacente all’evento che vogliamo misurare e l’i-esimo bin della

distribuzione che il rivelatore dovrebbe misurare secondo una simulazione

Monte Carlo del fenomeno, l’effetto del rivelatore è descritto da una matrice

A, che agisce su x per dare b:

Ax = b.

(1)

dove Aij è il numero di eventi che sono migrati dal j-esimo bin di x all’iesimo bin di b. Sia nE il numero di bin dell’istogramma b e nC il numero

di bin dell’istogramma x; ne consegue che A ∈ CnE ×nC . Si supponga inoltre che nE 6 nC . Questa matrice A viene solitamente trovata attraverso

una simulazione Monte Carlo del processo di misura con il rivelatore, vista

l’estrema difficoltà di trovare un’espressione analitica di essa a causa della

complessità tecnica dei tipici rivelatori.

Si potrebbe pensare che per ottenere x sapendo b ed A si possa calcolare

A−1 e scrivere

x = A−1 b

(2)

il problema però è più complesso di così, per almeno due buone ragioni:

• non esiste alcuna ragione fisica, e nemmeno una ragione statistica, per

la quale in generale debba esistere la matrice A−1 .

• anche nei casi in cui la matrice la matrice A−1 esiste, la sua inversa è

di solito inutile al fine di deconvolvere dagli effetti del rivelatore i dati

misurati; le soluzioni di (1) date da (2) infatti possono essere molto

sensibili a piccole variazioni di b, il quale è affetto da errori statistici.

Per capire meglio quest’ultimo punto, prendiamo in considerazione un esempio tratto da Höcker e Kartvelishvili, 1995, p.5

1.2

esempio semplice

Supponiamo che l’apparato sperimentale sia descritto da una matrice

1 1+ 1−

A=

2 1− 1+

(3)

1

2

introduzione al metodo

è facile intuire qual’è il comportamento di questo rivelatore al variare di :

per = 1 il rivelatore è perfetto; infatti per tale valore di la matrice A

diventa l’identità, quindi x = b, ovvero il rivelatore non distorce minimamente la distribuzione che si cerca. Per quanto riguarda il comportamento

per = 0, invece, il rivelatore è praticamente ”cieco”: supponendo infatti

che la distribuzione incognita sia x = (x1 , x2 ), la distribuzione misurata sarà b = Ax = 21 (x1 + x2 , x1 + x2 ), quindi qualunque fosse la distribuzione

vera degli eventi, il rivelatore misura una distribuzione uniforme.

La matrice A−1 esiste per ogni diverso da zero, e vale

1

1 1 1

1

1 + −1 + 1 −1

−1

=

+

(4)

A =

2 −1 + 1 + 2 1 1

2 −1 1

e quindi, posto b = (b1 , b2 )

b1 − b2 1

b1 + b2 1

−1

x=A b=

+

−1

1

2

2

(5)

Ipotizziamo che la differenza tra b1 e b2 non sia statisticamente rilevante,

ad esempio ponendo (b1 − b2 )2 6 (b1 + b2 ), e quindi che in un processo di

misura b1 − b2 sia effettivamente un numero casuale. Allora, la soluzione

(3) del sistema è la somma di una parte casuale ed una statisticamente significativa. Per valori di non troppo piccoli, il primo termine è abbastanza

innocuo; prendendo però un valore di sufficientemente piccolo si può far

dominare il primo termine sul secondo, e ciò porta ad avere una soluzione

x che non ha più nulla a che fare col fenomeno che si sta studiando.

Analizzeremo due modi per superare questo problema: uno basato sul

teorema di Bayes (G.D’Agostini, 1994) e uno basato sulla decomposizione

SVD (Höcker e Kartvelishvili, 1995)

1.3

unfolding basato sul teorema di bayes

Si consideri la distribuzione di eventi che soggiace al fenomeno che si sta

studiando (che chiameremo distribuzione ”vera”) come un insieme di cause

{Cj , j = 1, . . . , nC } che può produrre un insieme di effetti {Ei , i = 1, . . . , nE }.

Poniamo come i-esimo effetto l’osservazione di un certo numero di eventi

nell’i-esimo bin dell’istogramma b dei dati misurati. Applicando il teorema

di Bayes, si trova che

P(Ei |Cj )P(Cj )

P(Cj |Ei ) = PnC

l=1 P(Ei |Cl )P(Ci )

(6)

dove P(A|B) è la probabilità di A condizionata dal fatto che si è verificato B.

Questa formula a prima vista può apparire non utilizzabile poiché richiede

una conoscenza a priori di P(Cj ); tuttavia si può far partire il processo di

inferenza da una distribuzione a priori uniforme, e aggiornarla a posteriori

attraverso la formula di Bayes dopo l’osservazione.

Nella formula di Bayes si vede anche che la probabilità condizionata a

0 ; quest’ultima probabilità si

posteriori P(Cj |Ei ) dipende da P(Ei |Cj ) = Aij

può calcolare a partire dalla matrice A precedentemente definita normalizzandone a 1 i vettori riga.1

1 Si ricordi che la j-esima componente della i-esima riga di A rappresenta il numero di eventi

misurati nell’i-esimo bin che nella distribuzione vera erano nel j-esimo; normalizzando la i0 sia la probabilità che un evento

esima riga di A si ottiene quindi una matrice A 0 tale che Aij

nel bin i della distribuzione misurata fosse originariamente nel bin j della distribuzione vera.

1.4 unfolding svd

P nE

È importante notare che 0 < εj =

i=1 P(Ei |Cj ) 6 1: non è necessario che un evento venga misurato. La causa di ciò è che i rivelatori reali

hanno un’accettanza limitata. Il termine εj indica quindi l’efficienza che si

ha nel rilevare la causa Cj in uno qualsiasi degli eventi misurati, ovvero

la probabilità che la causa Cj sia misurata dal rivelatore, anche se nel bin

errato.

Dopo un numero Nobs di osservazioni sperimentali, si ottiene una distribuzione n(E) = {n(E1 ), . . . , n(EnE )}. Il valore atteso del numero di cause da

attribuire solo agli eventi osservati è

nE

X

P(Cj |Ei )n(Ei )

n̂(Cj )obs =

(7)

i=1

tenendo conto dell’efficienza del rivelatore,

nE

1 X

n̂(Cj ) =

P(Cj |Ei )n(Ei )

εj

εj 6= 0

(8)

i=1

dove la divisione per εj non è mai un problema poiché se esiste un j̄ tale

che εj̄ = 0, l’esperimento è cieco a Cj̄ , e quindi non era corretto da principio

accorparlo alle cause del processo.

Dalla distribuzione unfoldata n(C) = {n(C1 ), . . . , n(CnC )} possiamo ricavare il vero numero di eventi, la probabilità delle cause e l’efficienza

totale

N̂true =

nC

X

n(Cj )

j=1

P̂(Cj ) = P(Cj |n(E)) =

n̂(Cj )

N̂true

N

ε̂ = obs

N̂true

Se la distribuzione iniziale non è consistente coi dati, si può verificare

che la distribuzione così ottenuta tenderà ad avere valori compresi tra quelli della distribuzione iniziale e quelli della distribuzione vera; questo suggerisce di applicare iterativamente i passaggi fatti finora scegliendo come

nuova distribuzione iniziale quella ottenuta dall’applicazione precedente

dell’algoritmo.

1.4

unfolding svd

Il metodo di unfolding SVD consente, attraverso l’analisi dei valori singolari di una certa matrice, di regolarizzare le soluzioni del sistema (1),

sopprimendone le componenti spurie e velocemente oscillanti.

Definizione (singular value decomposition). Sia A ∈ Cm×n ; una sua decomposizione ai valori singolari (SVD) è una fattorizzazione della forma

A = USV T ,

dove

• U è una matrice unitaria m × m

3

4

introduzione al metodo

• S è una matrice diagonale m × n

• V è una matrice unitaria n × n

I valori {Si,i , i = 1, . . . , n} sono detti valori singolari della matrice A; possono sempre essere presi in modo che S1,1 > S2,2 > · · · > Sn,n

Torniamo quindi al problema (1), e guardiamolo da un diverso punto di

vista: esso è la soluzione di un problema di minimi quadrati

nC

nE X

X

Aij xj − bi

2

(9)

= min

i=1 j=1

Questa soluzione è adeguata nel caso in cui l’equazione sia esatta, oppure

se gli errori sulle varie componenti di b fossero identici. Questo non è

ciò che avviene in generale; la cosa più sensata da fare è considerare un

problema ai minimi quadrati dove si minimizza la forma quadratica

nE

X

P nC

j=1 Aij xj

− bi 2

∆bi

i=1

(10)

= min

ovvero, si pesano i vari termini dell’equazione a seconda dell’errore associato. L’espressione (10) può essere generalizzata scrivendo

(Ax − b)T B−1 (Ax − b) = min

(11)

dove B è la matrice di covarianza dei dati B.

Nel caso più generale in cui B non sia diagonale, possiamo comunque

scalare le equazioni in modo analogo a (11); infatti B, essendo una matrice di covarianza, deve essere simmetrica e definita positiva, quindi la sua

decomposizione ai valori singolari deve essere

B = QRQT ,

Rii ≡ ri 2 > 0,

B−1 = QT R−1 Q.

(12)

Scalando sia A che b in questo modo:

Ãij ≡

1 X

Qim Amj

ri m

b̃i ≡

1 X

Qim bm

ri m

(13)

sostituendo in (11), troviamo

(Ãx − b̃)T (Ãx − b̃) = min

(14)

la cui minimizzazione ci porta al sistema

nC

X

Ãij xj = b̃.

(15)

j=1

Dopo le trasformazioni effettuate, la matrice di covarianza di b̃ non è altro

che la matrice identità2 , e inoltre tutte le equazioni hanno uguale importanza.

2 In (13) si è prima ruotato il vettore b applicando ”a destra” (nel senso del prodotto righe per

colonne) la matrice Q, e poi diviso ogni componente per il corrispondente valore singolare della matrice R. Facendo la stessa rotazione alla matrice B, troviamo QT BQ = QT QRQT Q =

R =⇒ se dividiamo ogni componente di b per il corrispondente valore singolare della matrice

R, la matrice di covarianza ruotata diventa l’identità.

1.4 unfolding svd

I passaggi fatti finora hanno solo cambiato la forma del sistema da risolvere, ma le soluzioni sono rimaste le stesse; in particolar modo, se si cercasse di

risolvere esattamente il sistema (15) si troverebbero ancora i comportamenti

spuri della soluzione. Queste componenti spurie devono essere soppresse

utilizzando una qualche condizione a priori sulla soluzione; un modo di

farlo è aggiungere un termine di regolarizzazione all’espressione che si sta

minimizzando

(Ãx − b̃)T (Ãx − b̃) + τ(Cx)T Cx = min.

(16)

In questa formula, la matrice C definisce la condizione di regolarità che si

impone alla soluzione, ed il parametro τ determina il peso di questa condizione; ad esempio, ponendo Cik = δik si cerca di minimizzare la norma

euclidea del vettore x, e se si facesse tendere τ ad infinito la soluzione sarebbe il vettore nullo, indipendentemente da à e b̃. Una scelta abbastanza

generale è quella di imporre che l’istogramma x, che è il rapporto tra la

distribuzione unfolded u che stiamo cercando e la distribuzione che il rivelatore dovrebbe misurare secondo la simulazione Monte Carlo, abbia delle variazioni tra bin adiacenti molto piccole. Definendo la curvatura della

distribuzione discreta x come

X

[(xj+1 − xj ) − (xj − xj−1 )]2

(17)

j

allora la scelta

−1

1

0

C=

1

−2

1

...

...

...

0

1

−2

0 ...

0 ...

1 ...

...

1 −2

1

1

−1

(18)

sopprimerà le soluzioni x che hanno grandi curvature. La minimizzazione

di (16) porta ad un nuovo sistema, che ha NC equazioni in più:

Ã

b̃

√

x=

.

τ·C

0

(19)

Questo sistema è sovradeterminato, e si può applicare l’SVD alla matrice

(nE + nC ) × nC nel lato sinistro dell’equazione per risolverlo; questo però

comporterebbe l’effettuare la decomposizione SVD per ogni valore di τ. Esiste però un metodo più efficiente, chiamato damped least squares (C.E.Lawson

e R.J.Hanson, 1974, Cap. 25, Sez. 4) che consente di esprimere la soluzione

di (19) per ogni τ attraverso la soluzione del problema con τ = 0. La prima cosa da fare è rendere il termine di regolarizzazione proporzionale alla

matrice identità I:

−1 b̃

ÃC

√

Cx =

.

0

τ·I

(20)

Bisogna fare attenzione al fatto che la matrice C, per come è stata definita,

non è invertibile (per avere un indizio di ciò, si può notare che tutte le righe,

5

6

introduzione al metodo

e tutte le colonne, hanno somma zero). Per superare questo problema, basta

aggiungere una piccola componente diagonale,

−1 + ξ

1

0

0

...

1

−2 + ξ

1

0

...

0

1

−2

+

ξ

1

.

.

.

(21)

C=

...

...

...

1 −2 + ξ

1

...

1

−1 + ξ

con ξ che sia abbastanza grande da rendere l’inversione numericamente

possibile, ma abbastanza piccola da non cambiare la condizione di minima

curvatura; nella maggior parte dei casi, ξ = 10−3 o 10−4 è una buona scelta.

Risolviamo quindi il sistema (20) con τ = 0; iniziamo col decomporre ai

valori singolari la matrice ÃC−1 :

ÃC−1 = USV T

(22)

e chiamiamo si gli elementi della diagonale di S; in seguito ruotiamo b̃ e

Cx:

d ≡ UT b̃,

z ≡ V T Cx.

(23)

ed in conclusione, il sistema può essere scritto come

s i · z i = di ,

i = 1, . . . , nC .

(24)

che ha come soluzione

(0)

zi

=

di

si

x(0) = C−1 Vz(0)

(25)

e la distribuzione unfolded u(0) può essere ottenuta moltiplicando ogni

componente di x(0) per la corrispondente componente della ricostruzione

Monte Carlo; avendo scelto τ = 0, però, otteniamo la soluzione non regolarizzata. Grazie al metodo descritto da C.E.Lawson e R.J.Hanson, 1974, Cap.

25, Sez. 4, si può calcolare la soluzione per ogni τ in maniera molto semplice; in sostanza, introdurre un τ 6= 0 è equivalente al sostituire di con

(τ)

di

= di

s2i

s2i + τ

(26)

e quindi la soluzione del sistema diventa

(τ)

zi

=

di s i

s2i + τ

x(τ) = C−1 Vz(τ) .

(27)

Le matrici di covarianza Z e X possono essere calcolate, tenendo conto

che la matrice di covarianza di d è unitaria, come

(τ)

Zik =

s2i

δik

(s2i + τ)2

X(τ) = C−1 VZ(τ) V T CT

(28)

−1

.

(29)

Per ottenere la distribuzione unfolded u e la sua matrice di covarianza U,

si devono moltiplicare x e X per la ricostruzione Monte Carlo m:

(τ)

ui

(τ)

Uik

(τ)

(30)

(τ)

mi Xik mi .

(31)

= mi xi

=

1.4 unfolding svd

Una cosa fondamentale per l’unfolding SVD è la scelta di un τ appropriato; questo si può fare facendo un grafico logaritmico delle componenti di

d; tali componenti rappresentano i coefficienti dell’espansione in funzioni

ortogonali (definite dai vettori colonna di U) di b̃. Per distribuzioni abbastanza regolari, soltanto i primi termini della espansione dovrebbero essere

significativi, mentre gli altri dovrebbero essere statisticamente compatibili

con zero (ricordiamo che la varianza delle componenti di d è 1). Nel grafico,

quindi, si dovrebbero riuscire a distinguere due comportamenti diversi delle

componenti di d: per piccoli i, i di dovrebbero essere statisticamente significativi, e man mano dovrebbero decrescere fino a diventare variabili casuali

distribuite secondo una gaussiana standard. Il valore critico i = k dopo il

quale i di non sono più statisticamente significativi è il rango effettivo del

sistema; ovvero k è il numero di equazioni statisticamente significative del

sistema. Una buona scelta del parametro di regolarizzazione τ è quindi

τ = S2kk ,

(32)

poiché dalla forma delle soluzioni (27), e considerando che i valori singolari (le componenti diagonali di S) sono una successione monotonamente

decrescente, si evince che gli zi con i > k verranno fortemente soppressi.

7

2

2.1

LHC, CMS E FISICA DEI JET

lhc

L’LHC (Large Hadron Collider) è un collisore protone-protone e Pb-Pb situato

al CERN di Ginevra. L’anello acceleratore percorre una circonferenza di circa 27Km, ed è situato nel tunnel sotterraneo che precedentemente ospitava

l’acceleratore LEP. L’obiettivo di questa macchina è il riuscire ad accelerare

fasci di protoni a 7T eV per la fine del 2013; per essere in grado di curvare un

fascio di particelle così energetiche, essa impiega oltre 1900 elettromagneti

che generano un campo di 8.4T (vedi LHC Study Group, 1995). Tali magneti sfruttano il fenomeno della superconduzione, che avviene a temperature

molto basse; in particolare, i magneti di LHC devono essere mantenuti alla

temperatura di 1.9K per funzionare; si raggiunge tale scopo attraverso un

sistema di raffreddamento ad elio liquido.

Gli scopi scientifici di questa macchina sono molteplici; uno dei più importanti è la verifica della validità del Modello Standard. Esso è una teoria

quantistica dei campi che descrive tre delle quattro forze fondamentali a noi

note (interazione elettromagnetica, forte e debole) ed il loro rapporto con

delle particelle elementari (per le quali c’è forte evidenza del fatto che siano

prive di struttura). Il Modello standard è una teoria che ha avuto un numero enorme di conferme sperimentali e sta alla base della comprensione

delle particelle attuale; tuttavia in esso ci sono alcuni tasselli mancanti che

non consentono di spiegare alcuni fenomeni, ed inoltre sono presenti un

gran numero di parametri liberi da determinare sperimentalmente. Inoltre,

prima della costruzione di LHC non è mai stata trovata alcuna evidenza

sperimentale di un bosone scalare, l’Higgs, teorizzato nel modello standard,

con un ruolo di primaria importanza; è infatti l’accoppiamento dell’Higgs

con le particelle che dovrebe fornire massa alle particelle stesse.

Gli obiettivi scientifici principali di LHC possono essere riassunti così:

• Trovare quale sia l’origine della massa delle particelle del modello standard; in particolare, le teorie più accreditate prevedono l’esistenza dell’Higgs. In merito a questa ricerca, il 4 Luglio 2012 il CERN con un

annuncio ufficiale ha comunicato la scoperta di un nuovo bosone che

Figura 1: Collocazione geografica di LHC

9

10

lhc, cms e fisica dei jet

Figura 2: Complesso di acceleratori al CERN

ha delle caratteristiche compatibili con quelle che sono state ipotizzate

per il bosone di Higgs.

• Studiare uno stato della materia chiamato Quark Gluon Plasma, nel

quale gluoni e quark si muovono liberamente, senza essere soggetti al

principio di confinamento dei quark.1 Capire le caratteristiche di tale

stato è molto importante, perché si ipotizza che tale stato fosse quello

prevalente dell’universo pochi istanti dopo il Big Bang

• Osservare i cosiddetti partner supersimmetrici, ipotizzati dalle teorie

supersimmetriche (SUSY) che associano ad ogni fermione del modello

standard un superpartner bosonico e ad ogni bosone un superpartner

fermionico attraverso un’operazione di simmetria; tali partner però

non sono mai stati osservati in natura. Le teorie supersimmetriche

sono un argomento di ricerca molto fertile, poiché potrebbero consentire di spiegare la materia oscura (un problema irrisolto della fisica

moderna) e di formulare una descrizione unificata delle quattro forze fondamentali; inoltre risolvono vari problemi teorici del modello

standard.

• Cercare una spiegazione della asimmetria tra materia ed antimateria

nell’universo; si cerca di raggiungere tale scopo attraverso lo studio

della violazione della simmetria CP nelle interazioni deboli.

I fasci di protoni di LHC sono composti da circa 2800 pacchetti contenenti

ciascuno 100 miliardi di particelle; i pacchetti distano l’uno dall’altro circa

7m (nel sistema del laboratorio), e sono accelerati da delle cavità risonanti

a radiofrequenze disposte periodicamente lungo l’anello2 ; prima di essere

immessi in LHC, questi fasci sono accelerati da degli acceleratori ausiliari

posti in cascata, che forniscono attraverso vari stadi sempre più energia

cinetica al fascio, come mostrato in Figura 2.

1 Per spiegare come più quark con caratteristiche identiche possano occupare lo stesso stato

all’interno degli adroni senza violare il principio di Pauli, si introduce una quantità chiamata

”carica di colore”. Esiste un principio, chiamato principio di confinamento, che asserisce che

particelle che hanno carica di colore non sono osservabili individualmente.

2 La suddivisione del fascio in pacchetti è qualcosa di comune a tutte le macchine acceleratrici

circolari; proprio a causa della geometria circolare, i campi elettrici e magnetici oscillanti disposti lungo la macchina acceleratrice tendono ad accelerare solo particelle aventi fase compresa

in un certo range rispetto al campo elettrico e magnetico.

2.2 cms

In quattro punti dell’anello, chiamati punti di interazione, i fasci provenienti da due direzioni diverse vengono focalizzati in un punto di una camera a vuoto attraverso dei quadrupoli magnetici; questo processo (chiamato

bunch crossing) viene effettuato ogni 25ns e provoca in media 20 eventi di

scattering inelastico tra protoni (un numero esiguo di eventi, rispetto alle

migliaia di eventi con piccolo momento trasferito); ogni secondo si avranno

quindi 30 milioni di crossings, che daranno origine ad una media di 600

milioni di eventi.

In fisica delle particelle, è comune definire ”luminosità” la costante che lega la

frequenza di eventi alla sezione d’urto; tale quantità ha le dimensioni di T −1 L−2 .

Si può dimostrare che la luminosità di un

collider è pari a

L = fn

N1 N2

,

A

dove f è la frequenza di rivoluzione dei fasci nel collider, N1 e N2 sono il numero di

pacchetti nel primo e nel secondo fascio ed

A è la sezione geometrica dei fasci. LHC è stato progettato in modo da raggiungere un’elevata luminosità: 1034 s−1 cm−2 ; tale luminosità è richiesta

dal fatto che gran parte della nuova fisica che si cerca in LHC è composta

da eventi molto rari.

Una luminosità così alta, però, genera anche il problema logistico di come gestire i dati misurati, sia per quanto riguarda la quantità di essi, che

per la velocità di trasferimento. In un rivelatore di LHC si generano circa 300GBytes/s di dati; un sistema di trigger (ad esempio, per i trigger

di CMS vedi CMS Collaboration, 2000), discriminando gli eventi ”interessanti” da quelli che non lo sono, riesce a filtrare questi dati fino a circa

300MBytes/s, e deve riuscire a farlo in circa un microsecondo, anche se la

completa ricostruzione di certi eventi può richiedere fino ad un secondo.

Un altro problema (al quale ci si riferisce col nome di pile up) causato da

una luminosità così alta è che quando si generano nuove particelle in un

urto, altre particelle provenienti da un urto precedente non hanno ancora

lasciato il rivelatore; affinché non si confondano particelle prodotte in due

eventi diversi è necessaria quindi una grandissima risoluzione temporale dei

rivelatori, ed il clock dato ai milioni di componenti elettronici deve essere

sincronizzato in modo estremamente preciso.

In LHC, sono presenti quattro esperimenti in presenza dei quattro punti

di interazione: CMS, ATLAS, ALICE e LHCb; i primi due sono rivelatori general purpose, costruiti per dare risposte ad un po’ tutti i problemi

precedentemente esposti, ALICE è dedito soprattutto allo studio del QuarkGluon Plasma nelle interazioni Pb-Pb e LHCb allo studio della fisica del

quark bottom.

Figura 3: Tunnel di LHC

2.2

cms

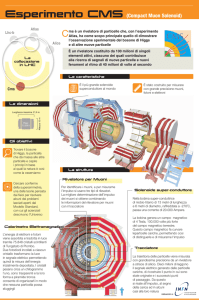

L’esperimento CMS (Compact Muon Solenoid) è un rivelatore general purpose progettato per poter esplorare un ampia gamma di fenomeni fisici

differenti (CMS Collaboration, 1994). Esso è costituito da diversi rivelatori

posti attorno al punto di incontro tra i fasci durante i bunch crossing, ed

11

12

lhc, cms e fisica dei jet

Figura 4: Spaccato di CMS

ha una struttura composta da una parte cilindrica (barrel) e da due tappi

(endcap) al fine di coprire la maggior parte possibile di tutto angolo solido che circonda il punto di interazione; questa ermeticità è fondamentale

per identificare con precisione gli eventi in cui ci sia ”energia mancante”,

ovvero nei quali vengono prodotte particelle che non interagiscono col rivelatore, e delle quali quindi bisogna ricostruire energia e momento a partire

dall’energia delle altre particelle misurate e dal principio di conservazione

del quadrimomento. Partendo dall’interno, le componenti di CMS sono:

Tracker

Nella parte più interna di CMS si trova un

tracciatore al silicio (vedi CMS Collaboration,

1997d), che si occupa di identificare le traiettorie delle particelle cariche prodotte nelle collisioni; la curvatura della traiettoria di queste

particelle causata dal campo magnetico prodotto dal solenoide in cui è alloggiato il tracker

consente una misura del loro momento. Il tracFigura 5: Silicon Strip nel ciatore di CMS è fatto da vari strati di diversi

sensori al silicio; nei primi tre livelli è compotracker di CMS

sto da 66 milioni di pixel detector, sensori molto piccoli (100µm × 150µm) che consentono di distinguere singole particelle,

anche in presenza di un flusso molto intenso. I quattro livelli successivi sono composti da strip di silicio di 10cm × 180µm, seguiti da altri sei livelli di

strip da 25cm × 180µm. In totale, sono presenti 9, 6 milioni di canali per le

strip di silicio. I sensori sono via via più grandi man mano che ci si allontana

dal punto di interazione.

2.2 cms

ECAL

All’esterno del tracker è presente un calorimetro elettromagnetico (ECAL)

costituito da scintillatori di cristalli di tungstenato di piombo (PbWO4 ), il

cui scopo è misurare l’energia di particelle che hanno interazioni elettromagnetiche con la materia (elettroni, positroni e fotoni) facendole sciamare e

misurando il segnale prodotto dallo sciame (vedi CMS Collaboration, 1997a).

Il PbWO4 è un materiale molto denso (8.3g/cm3 ) e dotato di piccola lunghezza di radiazione (0.89cm) e piccolo raggio di Molière (2.2cm); i cristalli

utilizzati hanno una dimensione di 22mm × 22mm × 230mm, e sono collocati in una matrice di fibra di carbonio per tenere i singoli cristalli otticamente

isolati; per la lettura del segnale generato sono utilizzati dei fotodiodi a valanga. In tutto il barrel sono collocati 61, 200 cristalli, mentre per ciascun

endcap ne sono stati utilizzati 7, 324.

HCAL

Il calorimetro adronico (HCAL), ha lo scopo di

misurare l’energia degli adroni prodotti in ogni

evento. Esso è costituito da strati di materiali

assorbitori densi (ottone) inframezzati da scintillatori; quando un adrone interagisce con l’assorbitore, genera una cascata di particelle, che

via via attraversano i vari livelli di assorbitori

e scintillatori, producendo sempre più particelle via via meno energetiche, ed attraverso una

lettura del segnale proveniente dai vari strati di

scintillatori, si può risalire all’energia dell’adroFigura 6: Vista frontale di ne di partenza. HCAL, al fine di essere il più erCMS, senza endcap metico possibile, è costituito da varie parti leggermente differenti l’una dall’altra (vedi CMS

Collaboration, 1997b), sia geometricamente che per il tipo di materiali utilizzati: HB ed HO nel barrel, HE nell’endcap e HF in una regione chiamata

forward (3.0 < |η| < 5.0). HF in particolare è abbastanza diverso dalle altre zone di HCAL, in quanto deve riuscire a misurare l’energia di singole

particelle in una zona in cui si hanno un gran numero di particelle molto

energetiche prodotte.

Magnete

I tre componenti appena elencati sono collocati dentro un magnete solenoidale da 3.8T , lungo 13m con un diametro di 6m; è il magnete solenoidale

superconduttore più grande mai prodotto al mondo, ed il suo forte campo

magnetico orientato lungo l’asse della beamline è ciò che rende possibile

la misura dell’impulso delle particelle generate nelle collisioni. Il magnete è circondato da un giogo di ferro che fa in modo che le linee di flusso

del campo magnetico siano il più uniformi possibile; esso inoltre ”filtra” le

particelle lasciando passare ai livelli successivi del rivelatore solo muoni (in

quanto emettono una piccolissima radiazione di bremsstrahlung, quindi sono molto penetranti) e particelle che interagiscono in maniera estremamente

trascurabile con la materia (neutrini).

13

14

lhc, cms e fisica dei jet

Figura 7: Rivelatori di CMS

Rivelatori di µ

Infine, nella parte più esterna del rivelatore, è presente un sistema di rivelazione per i muoni CMS Collaboration, 1997c. I muoni più energetici

possono penetrare facilmente attraverso diversi metri di materiale, quindi

sistemi simili ai calorimetri precedentemente descritti non vanno bene; al

fine di misurare il momento dei muoni vengono utilizzati circa 250 Drift

tubes e 540 Cathode Strip Chambers, rivelatori che consentono di calcolare la

traiettoria dei muoni, e in più sono presenti 610 Resistive Plate Chambers, che

sono importanti soprattutto per i trigger, in quanto attraverso la loro estrema granularità temporale riescono a dare una veloce e istantanea misura

del momento dei muoni, fornendo così indicazioni significative riguardo i

muoni al trigger. Nel barrel vengono impiegati i Drift tubes, mentre negli endcap sono presenti le Cathode Strip Chambers; sia nel barrel che negli endcap

vengono inoltre utilizzate le Resistive Plate Chambers.

2.3

fisica dei jet

Dallo studio delle collisioni protone-protone (p-p) si cerca di trovar risposte

alla maggioranza dei quesiti che LHC e CMS sono stati costruiti per risolvere; inoltre, i dati ai quali applicheremo gli algoritmi di unfolding saranno

proprio quelli relativi ad urti p-p.

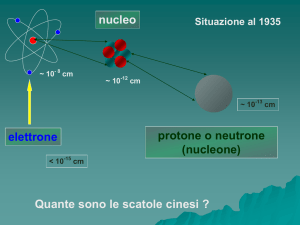

Un fascio di protoni può essere visto come un fascio di gluoni e quarks,

chiamati collettivamente partoni (vedi Griffiths, 1987); ciascun partone avrà

una frazione dell’energia dei fasci, cioè un’energia x × Ep , dove Ep è l’energia dei fasci e x è detta variabile di Bjorken, e può assumere solo valori tra

0 e 1. Consideriamo il caso di un urto p-p: chiamiamo i due protoni A e B;

sia a un partone di A e sia b un partone di B; vale che

~pa = xa~pA

~pb = xb~pB

Nel modello a partoni, possiamo calcolare la sezione d’urto di un certo

processo p + p → X come

XZ

σp+p→X =

dxa dxb fa (xa , Q2 )fb (xb , Q2 )σa+b→X

a,b

dove con la somma su a e b si intende di effettuare una somma per tutti

i partoni di A e B, con Q si è indicato il momento trasferito nel processo

2.3 fisica dei jet

Figura 8: Scattering p-p nel modello a partoni

Figura 9: Processo che nello stato finale ha Z + 3 jet

e sia fa (xa , Q2 ) che fb (xb , Q2 ) sono le Parton Distribution Function (PDF),

definite come la densità di probabilità che un partone abbia una frazione

di momento longitudinale rispettivamente xa o xb e modulo quadro del

momento trasferito Q2 .

I quark e gli antiquark possono emettere gluoni

in modo analogo al processo di bremsstrahlung

Meson

per cui gli elettroni emettono fotoni nell’interazioAntigreen

ne elettromagnetica; i gluoni a loro volta possono

creare coppie quark-antiquark.

I quark e i gluoni, inoltre, sono particelle che

hanno una carica di colore, ovvero un numero quantico che è stato introdotto per spiegare come posGreen

sano coesistere nello stesso stato in un adrone dei

quark

con tutti i numeri quantici uguali senza vioBaryon

lare il principio di Pauli. Una caratteristica importante delle particelle aventi carica di colore è quella

Red

del confinamento; l’interazione tra particelle ”colorate” (aventi carica di colore), infatti, ha la caratteristica di essere asintoticamente nulla più si avvicinano le due particelle, ma più si allontanano le due

particelle,

più il potenziale associato a questa forza

Blue

Green

aumenta. A causa di questa interazione, ad oggi

Figura 10: Vari modi di non è mai stato osservato un quark isolato, ma soformare parti- lo confinato in stati legati non colorati: i mesoni ed

celle non coloi barioni.

rate

Negli urti tra due partoni possono essere emessi nello stato finale un gran numero di gluoni e

coppie quark-antiquark; a causa del confinamento dei quark, però, queste particelle non possono rimanere isolate. Attraverso un processo chiamato adronizzazione, queste particelle si ricombinano con altri quark e an-

15

16

lhc, cms e fisica dei jet

tiquark creati dal vuoto in modo da formare adroni; viene chiamato jet

un fascio di particelle approssimativamente collineari in impulso, prodotte

dall’adronizzazione dei partoni che hanno subito un processo di scattering.3

Un processo di grande interesse è quello di produzione di eventi con

Z(+jets) nello stato finale; un esempio di questo tipo di processo è rappresentato in Figura 9: il bosone Z, in figura emesso dal quark u, decade poi in

una coppia muone-antimuone, e viene rivelato ricostruendo la sua massa invariante a partire dall’energia misurata dei due muoni. In questo processo,

inoltre, nello stato finale vengono formati anche due quark ed un gluone,

ma essi subito dopo la loro formazione adronizzeranno e formeranno tre

jet.

3 Più formalmente, un jet viene definito come una certa regione circolare nello spazio eta-phi.

3

3.1

VA L I DA Z I O N E E D A N A L I S I DAT I

descrizione dei dati

Le distribuzioni che ci si appresta ad analizzare sono due:

• La molteplicità dei jet; in particolare, studieremo la distribuzione del

numero di eventi con Z + > N jet

• Il momento trasverso pt dei jet negli eventi in cui si produce anche

una Z

Sono stati effettuati vari tagli sui dati di CMS per selezionare gli eventi

sopracitati con la minor quantità di fondo possibile; nello specifico, il dataset

che analizzeremo è composto dagli eventi in cui la Z decade in e+ + e− .

Per fare ciò, sono stati selezionati gli eventi in cui erano soddisfatti tutti i

seguenti prerequisiti:

1. L’energia trasversa degli elettroni e positroni deve essere di almeno

20GeV, per ottimizzare l’efficienza dell’algoritmo di ricostruzione degli eventi.

2. Si considerano solo regioni aventi pseudorapidità η tale che |η| < 2.4,

escludendo inoltre la regione 1.4442 < |η| < 1.566 in cui si ha una

sovrapposizione tra endcap e barrel.

3. Si deve osservare una coppia elettrone-positrone che abbia una massa

invariante compresa tra 71 e 111 GeV, così si selezionano gli eventi in

cui si è formata una Z, ed in seguito è decaduta in e+ + e− .

3.2

operazioni preliminari all’unfolding

Per ciascuna delle due distribuzioni precedentemente elencate si è innanzitutto generata una distribuzione chiamata Monte Carlo Truth, ottenuta

eseguendo simulazioni a partire dalla teoria di cui si dispone riguardo i

jet. In seguito, vengono simulate le interazioni tra gli adroni prodotti nelle collisioni ed il rivelatore, e facendo ciò si costruiscono due importanti

oggetti:

• Una distribuzione detta Monte Carlo Reconstruction (spesso abbreviato in Reco), che rappresenta la distribuzione che si dovrebbe misurare

col rivelatore se il processo fisico che si sta misurando seguisse la distribuzione Monte Carlo Truth. La Monte Carlo Reco è in generale

diversa dalla Monte Carlo Truth in quanto un generico rivelatore reale

ha accettanza limitata1 e risoluzione finita. In particolare, soprattutto

nel caso della molteplicità dei jet, le cose sono ulteriormente complicate dal fatto che esistono errori associati al processo di ricostruzione

degli eventi, aggiungendo ulteriori effetti di migrazione di bin.

1 Un rivelatore, in generale, non riesce a rilevare tutti gli eventi che accadono, ma il numero

totale di eventi osservati sarà inferiore al numero totale di eventi reale.

17

validazione ed analisi dati

• Una matrice A il cui ij-esimo elemento è il numero di eventi che sono

migrati dal bin j della distribuzione Monte Carlo Truth all’i-esimo bin

della distribuzione Monte Carlo Reco; questa matrice non è altro che

quella introdotta nel primo capitolo; viene spesso chiamata Response

Matrix.

Una volta che si hanno questi elementi, si può procedere con l’unfolding

di un set di misure, che chiameremo genericamente Data; prima ancora,

però, verificheremo che l’algoritmo sia ben funzionante.

3.3

test di validazione

Avendo a disposizione le distribuzioni Monte Carlo Reco e Monte Carlo

Truth, e disponendo della matrice A, si può verificare cosa succede quando

si applicano gli algoritmi di Unfolding per deconvolvere la distribuzione

Monte Carlo Reco dagli effetti del rivelatore. Quello che ci si aspetta è che la

soluzione data dall’algoritmo sia proprio la distribuzione Monte Carlo Truth.

L’implementazione che è stata fatta dell’algoritmo che sfrutta il teorema di

Bayes, come si può vedere da Figura 11, riesce, se applicato al Monte Carlo

Reco, a ritrovare il Monte Carlo Truth; in entrambi i grafici, il rapporto tra

la distribuzione Unfolded ed il Monte Carlo Truth è esattamente uno.

Lo stesso discorso si può fare per quanto riguarda l’algoritmo che sfrutta

la decomposizione ai valori singolari, come mostrato in Figura 12.

Distribuzioni Truth, Reco ed Unfolded

hv

Z + (>=N) Jet

Entries

754428

Monte

Carlo Truth

Mean

RMS

105

Distribuzioni Truth, Reco ed Unfolded

Monte Carlo Truth

1.247

0.5404

Monte Carlo Reco

Unfolded Distribution

Monte Carlo Reco

105

Unfolded Distribution

4

10

104

103

102

103

1

2

3

4

5

6

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

1

2

3

4

(a) Molteplicità

5

6

100

150

200

250

300

Jet Pt (GeV/C)

1.5

Unfolded/MCTruth

1.4

0.5

50

hr

Rapporto Unfolded/Truth

Entries754428

Mean

3.5

RMS

1.708

1.5

Unfolded/MCTruth

18

1.4

1.3

1.2

Rapporto Unfolded/Truth

hr

Entries 707308

1.1

Mean

RMS

1

0.9

0.8

0.7

0.6

0.5

2

4

6

8

10

12

(b) Momento trasverso

Figura 11: Test di validazione per l’algoritmo bayesiano

14

8

4.32

3.4 unfolding dei dati

hv

Entries

Monte Carlo 754422

Truth

Mean

1.247

RMS

0.5404

Z + (>=N) Jet

Spettro >= N: Truth, Reco, Unfolded e Data

105

19

Spettro pT: Truth, Reco, Unfolded e Data

Monte Carlo Truth

Monte Carlo Reco

Monte Carlo Reco

105

Unfolded Distribution

Unfolded Distribution

104

104

103

103

102

1

2

3

4

5

6

50

Mean

RMS

200

250

300

Jet Pt (GeV/c)

hr

Rapporto Unfolded/Truth

Entries 707308

1.5

3.5

1.708

Unfolded/MCTruth

Unfolding/MCTruth

150

Entries 754428

1.5

1.4

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

100

hr

Rapporto Unfolded/Truth

1

2

3

4

5

7.997

4.321

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

6

Mean

RMS

1.4

2

(a) Molteplicità

4

6

8

10

12

14

(b) Momento trasverso

Figura 12: Test di validazione per l’algoritmo SVD

3.4

unfolding dei dati

Una volta effettuata la validazione degli algoritmi, si è proceduto all’applicarli ai dati di CMS.

Per l’algoritmo che sfrutta il teorema di Bayes, si è scelto un numero di

iterazioni abbastanza grande da assicurare la convergenza dell’algoritmo,

mentre per l’algoritmo SVD si è visto dal grafico delle componenti di d

quale fosse il numero k di esse che fossero statisticamente significative, e

quindi sopprimendo i valori singolari dopo il k-esimo.

I risultati ottenuti con i due metodi sono mostrati in Figura 14; si può

notare che essi sono molto simili, ed entrambi tendono ad avere errori molto

grandi nei canali dove si ha poca statistica (ad esempio, nel sesto canale della

distribuzione della molteplicità dei jet).

hv

Monte Carlo Truth

Entries

754422

Mean

1.247

RMS

Monte Carlo0.5404

Reco

Z + (>=N) Jet

Distribuzioni Truth, Reco ed Unfolded

Distribuzioni Truth, Reco ed Unfolded

Monte Carlo Truth

Monte Carlo Reco

5

10

Data

105

Data

Unfolded Distribution

104

Unfolded Distribution

4

10

3

10

103

102

1

2

3

4

5

6

50

100

150

200

250

300

Jet Pt (GeV/c)

hr

Rapporto Unfolded/Truth

Entries 754428

1.4

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

Mean

3.585

RMS

1.792

1

2

3

4

(a) Molteplicità

5

6

hr

Rapporto Unfolded/Truth

Entries707308

Mean 7.688

1.5

RMS

Unfolded/MCTruth

Unfolded/MCTruth

1.5

1.4

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

2

4

6

8

10

12

(b) Momento trasverso

Figura 13: Unfolding dei dati con l’algoritmo bayesiano

14

4.323

validazione ed analisi dati

hv

Monte Carlo Truth

Entries

754422

Mean

1.247

0.5404

RMS

Monte Carlo Reco

Z + (>=N) Jet

Spettro >= N: Truth, Reco, Unfolded e Data

5

10

Data

Unfolded Distribution

104

3

10

102

1

2

3

4

5

6

hr

Rapporto Unfolded/Truth

Entries

754428

1.5

Mean

Unfolded/MCTruth

RMS

3.56

1.805

1.4

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

1

2

3

4

5

6

(a) Molteplicità

Spettro pT: Truth, Reco, Unfolded e Data

Monte Carlo Truth

Monte Carlo Reco

105

Data

Unfolded Distribution

104

103

102

50

100

150

200

250

300

Jet Pt (Gev/c)

hr

Rapporto Unfolded/Truth

Entries 707308

1.5

Unfolded/MCTruth

20

1.4

Mean

7.792

RMS

4.399

1.3

1.2

1.1

1

0.9

0.8

0.7

0.6

0.5

2

4

6

8

10

12

14

(b) Momento trasverso

Figura 14: Unfolding dei dati con l’algoritmo SVD

4

CONCLUSIONI

Il problema che si pone con l’Unfolding dei dati è, come tanti problemi inversi, un problema malposto, dove si ha una forte dipendenza della soluzione

dalle condizioni iniziali. Risulta difficile formulare condizioni sufficienti o

necessarie per tante proprietà interessanti di queste soluzioni, dall’esistenza

all’unicità.

I metodi utilizzati per risolvere questo problema hanno portato a soluzioni simili, e la loro complessità è paragonabile. L’algoritmo SVD, in particolare, è quello che fornisce una maggiore comprensione del fenomeno, perché

studiando i valori singolari in gioco in questo problema si riescono a fare

molte considerazioni sui dati che si hanno in possesso, in particolare si può

capire se gli errori siano stati sovrastimati o sottostimati. L’algoritmo che

sfrutta il teorema di Bayes, invece, fornisce meno informazioni sul sistema

oggetto di studio, ma comunque riesce a fornire una soluzione accettabile.

Le soluzioni ottenute con i due algoritmi risultano simili; l’algoritmo che

sfrutta il teorema di Bayes sembra convergere, nei dati utilizzati per questa tesi, alla soluzione che si trova ”riducendo” il rango del sistema oggetto di studio a k (numero di componenti statisticamente indipendenti della decomposizione in funzioni ortogonali del sistema). Per un confronto

più esaustivo, sarebbe necessario studiare meglio la convergenza del primo

algoritmo.

Entrambi i metodi hanno portato a delle correzioni da applicare ai dati

decisamente significative; l’Unfolding è quindi necessario per confrontare

predizioni teoriche e dati misurati, in luce del fatto che le distribuzioni che

si misurano possono essere distorte in maniera non trascurabile da effetti

del rivelatore.

21

BIBLIOGRAFIA

C.E.Lawson e R.J.Hanson

1974 Solving Least Square Problems, Prentice-Hall Inc., Englewood Cliffs.

CMS Collaboration

1994 “The Compact Muon Solenoid - Technical Proposal”, CERN/LHCC

94-38.

1997a “The CMS electromagnetic calorimeter project: Technical Design

Report”, CMS-TDR-004.

1997b “The CMS hadron calorimeter project : Technical Design Report”,

CMS-TDR-002.

1997c “The CMS muon project : Technical Design Report”, CMS-TDR003.

1997d “The CMS tracker system project: Technical Design Report”, CMSTDR-005.

2000 “CMS TriDAS project : Technical Design Report; 1, the trigger systems”, CMS-TDR-006.

G.D’Agostini

1994 “A Multidimensional Unfolding Method Based on Bayes’ Theorem”, DESY 94-099.

Griffiths, David

1987 Introduction to elementary particles, John Wiley and sons, Inc.

Höcker, Andreas e Vakhtang Kartvelishvili

1995 “SVD Approach to Data Unfolding”, arch-ive/9509307.

LHC Study Group

1995 “The Large Hadron Collider, Conceptual design”, CERN/AC/95-05.

23