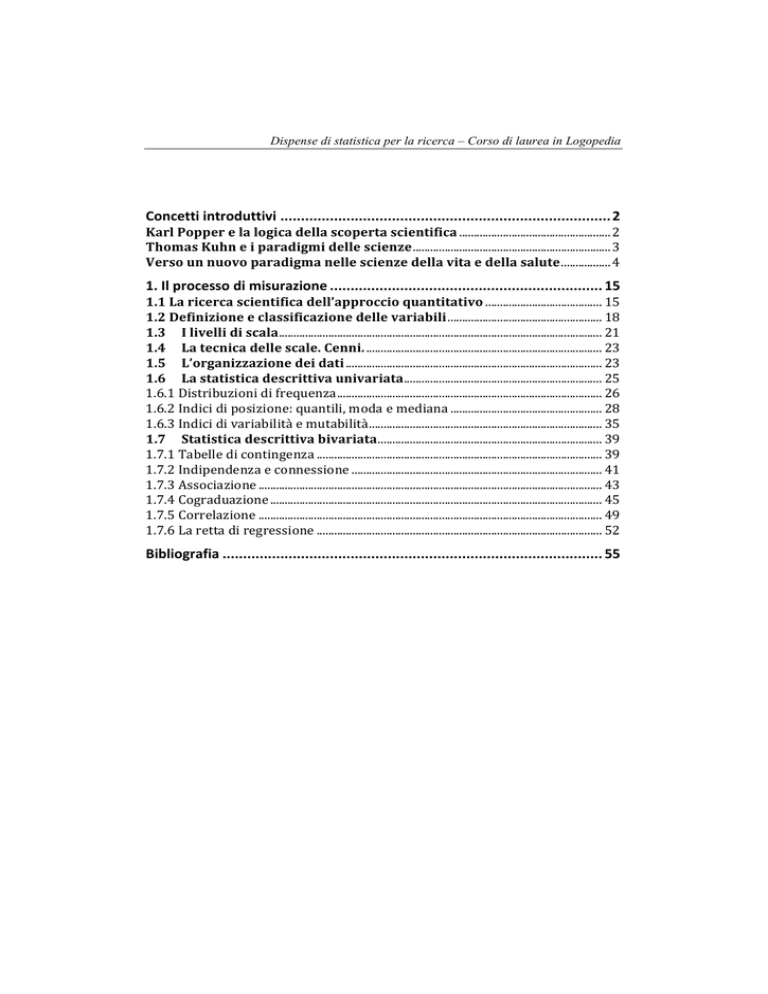

Dispense di statistica per la ricerca – Corso di laurea in Logopedia

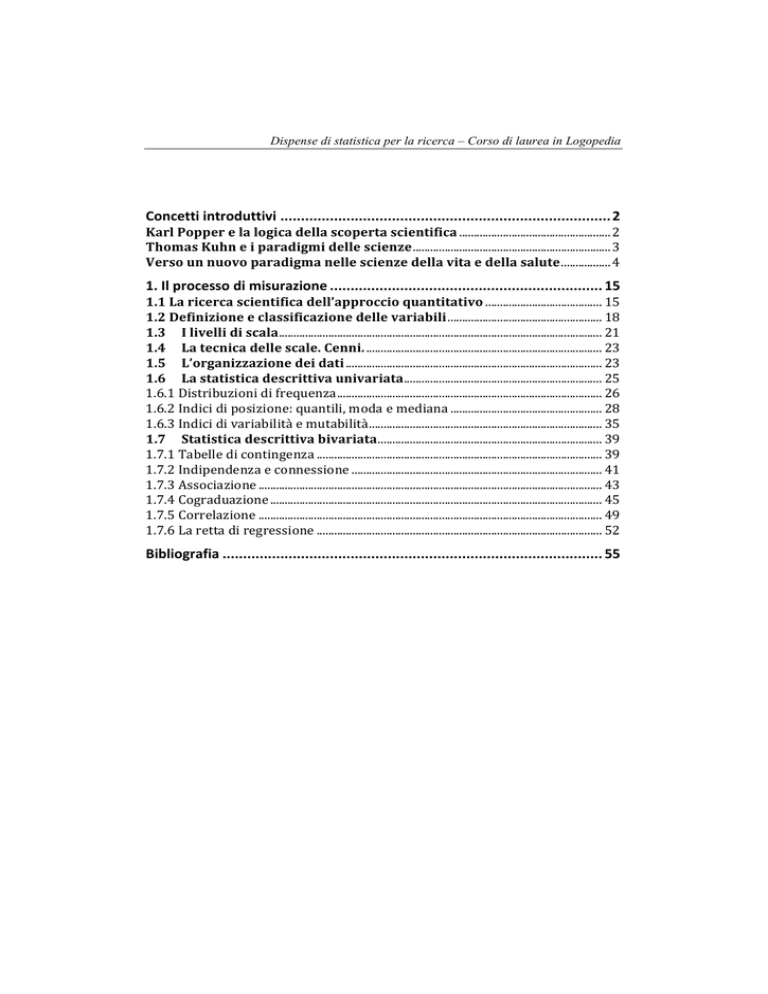

Concetti introduttivi ................................................................................ 2 Karl Popper e la logica della scoperta scientifica .................................................... 2 Thomas Kuhn e i paradigmi delle scienze .................................................................... 3 Verso un nuovo paradigma nelle scienze della vita e della salute ................. 4 1. Il processo di misurazione .................................................................. 15 1.1 La ricerca scientifica dell’approccio quantitativo ........................................ 15 1.2 Definizione e classificazione delle variabili ..................................................... 18 1.3 I livelli di scala ............................................................................................................... 21 1.4 La tecnica delle scale. Cenni. ................................................................................. 23 1.5 L’organizzazione dei dati ........................................................................................ 23 1.6 La statistica descrittiva univariata .................................................................... 25 1.6.1 Distribuzioni di frequenza ........................................................................................... 26 1.6.2 Indici di posizione: quantili, moda e mediana .................................................... 28 1.6.3 Indici di variabilità e mutabilità ................................................................................ 35 1.7 Statistica descrittiva bivariata ............................................................................. 39 1.7.1 Tabelle di contingenza .................................................................................................. 39 1.7.2 Indipendenza e connessione ...................................................................................... 41 1.7.3 Associazione ...................................................................................................................... 43 1.7.4 Cograduazione .................................................................................................................. 45 1.7.5 Correlazione ...................................................................................................................... 49 1.7.6 La retta di regressione .................................................................................................. 52 Bibliografia ............................................................................................ 55 2

Introduzione

Concetti introduttivi

Karl Popper e la logica della scoperta scientifica

La maggior parte di noi conosce Karl Raimund Popper come filosofo della politica. Per lo più,

infatti, abbiamo letto o abbiamo sentito parlare di quello che è considerato il più rilevante dei

suoi lavori di filosofia politica: La società aperta e i suoi nemici, edito a Londra nel 1945 e

comparso in Italia solo nel 1973. Ma Karl Popper è stato soprattutto un filosofo della scienza,

un epistemologo.

Il termine «epistemologia» deriva dalle parole greche episteme (scienza) e logos (discorso).

Indica, pertanto, quella parte della teoria della conoscenza, della gnoseologia, che si occupa dei

fondamenti e dei limiti, in una parola, della validità del sapere scientifico.

Per molti autorevoli pensatori, come per esempio Richard Rorty, l’epistemologia sarebbe il

programma prevalente nella filosofia occidentale da Cartesio in poi. Né potrebbe essere

diversamente. La peculiarità che contraddistingue la nostra civiltà è, infatti, la scienza: il sapere

in grado di «dominare un massimo di avvenimenti, di processi naturali, ossia di pronosticarli

nel modo più esatto possibile» (Popper 1997; p. 189). E la scienza «esige che a ogni

conoscenza, anche a quelle scoperte per via intuitiva, sia data una giustificazione oggettiva: e

una giustificazione oggettiva è una giustificazione metodologica che può essere sottoposta a

controlli intersoggettivi» (Popper 1997; p. 119). Pertanto, non è sbagliato dire che la «logica

della scoperta scientifica» assume, per noi, quel ruolo di «filosofia prima» che fino alle soglie

della Modernità o in altre civiltà è ricoperto dalla metafisica1.

Karl Popper ha saputo dare un contributo originale e un impulso decisivo a questa disciplina.

Con ciò, ha anche tenuto alta la tradizione del pensiero razionalista che è fondamento di tutte

le nostre migliori conquiste.

Colosso del pensiero novecentesco, Karl Raimund Popper occupa una posizione

assolutamente cruciale all'interno della filosofia della scienza del secolo scorso, avendo operato

una vera e propria linea di demarcazione nel dibattito epistemologico; tanto che si può

tranquillamente affermare, e lo si riscontra facilmente anche sui manuali, come nella filosofia

esista un prima di Popper e un dopo Popper. Il suo cosiddetto razionalismo critico infatti lo ha

condotto a elaborare modelli applicabili non solo alla ricerca scientifica ma anche alla

dimensione teorica nel suo insieme.

Il «razionalismo critico» di Karl Popper si inserisce nel clima culturale segnato dal declino,

conseguente alle scoperte della fisica (per esempio la teoria della relatività) del positivismo

ottocentesco.

Benché non ne avesse mai fatto parte, Popper si formò a stretto contatto con il Circolo di

Vienna, il movimento culturale nato per iniziativa di Moritz Schlick, che, nel 1922, era

succeduto a Ernst Mach nella cattedra viennese di filosofia delle scienze.

Il Circolo, che riunì, a partire dal 1923, pensatori come Ludwig Wittgenstein, Rudolf Carnap,

Otto Neurath e Hans Hahn, ha avuto il merito di far nascere la filosofia della scienza come

disciplina distinta dalla tradizionale gnoseologia, oltre che di apportare grandi contributi alla

filosofia analitica di stampo anglosassone.

Nel 1934, Karl Popper pubblicò Logica della scoperta scientifica con la quale prese le distanze dal

Circolo di Vienna, partendo dalla critica del procedimento induttivo: la pretesa di formulare

leggi generali partendo da un numero finito di casi particolari.

Nel merito, Karl Popper riprende l’allegoria dei corvi neri resa celebre da David Hume: «Per

1

Il termine (dal greco metà tà physiká, dopo le cose della natura) ha un'origine puramente accidentale perché indicava, nell'edizione delle opere di Aristotele, gli scritti che venivano dopo i libri della Fisica e nei quali si trattava della «filosofia prima», dell’«ente in quanto ente», cioè dei principi immutabili ed eterni. Introduzione

quanto numerosi siano i casi di cigni bianchi che possiamo avere osservato, ciò non giustifica la

conclusione che tutti i cigni sono bianchi» (Popper, 1998, pp. 5-6)

Ciò vuol dire che una teoria non può mai essere «verificata», cioè fatta vera (verum facere),

dall’osservazione o dall’esperimento.

L'induzione non è infatti un processo che possa essere giustificato razionalmente, anzi, essa è

per Popper addirittura impossibile: teorie universali non sono mai deducibili da asserzioni

singolari, da descrizioni di fatti osservabili (Popper, 1998). Questo significa che, per quanto

grande sia il numero delle osservazioni empiriche che noi possiamo effettuare nel tentativo di

verificare una teoria, non riusciremo mai a giungere a una sua verifica definitiva, in quanto,

essendo costituita da un'asserzione di portata universale, il suo significato trascende sempre il

numero finito delle nostre osservazioni empiriche. Delegittimato così il principio di

verificazione, Popper propone il principio di falsificazione, il quale afferma che una sola

osservazione negativa ci mette in condizione di concludere per la falsità di un'enunciazione.

Se l’esperienza contraddice la teoria, quest’ultima risulta falsificata e deve essere abbandonata.

Ma il lavoro non è stato inutile. Infatti, dalla sua falsificazione si sono comunque ottenute

nuove informazioni.

Se, al contrario, esiste accordo tra teoria ed esperimento, allora la teoria viene assunta come

vera, ma solo provvisoriamente, perché la falsificazione è sempre in agguato. Per esempio, la

fisica di Isaac Newton è stata falsificata dalla «relatività» di Albert Einstein. E, proprio in questi

anni, alcuni scienziati stanno lavorando all’ipotesi che la velocità della luce non sia una

costante. Ciò «falsificherebbe», a sua volta, la teoria di Albert Einstein. Quindi, gli esperimenti

non sono tentativi di verifica, bensì di confutazione.

Se, dunque, non possiamo mai sapere, in modo conclusivo, se una teoria è vera, possiamo

invece sapere, con una certa sicurezza, se la nostra teoria è falsa, qualora si verifichi

nell'esperienza anche un solo fatto in contraddizione con quanto sostenuto da tale teoria. La

scienza empirica procede per congetture e confutazioni, secondo un iter schematizzabile in

problemi - teorie - critiche:

• si inizia sempre da problemi, che sono il frutto delle nostre aspettative deluse rispetto

a una precedente teoria (che costituisce la nostra conoscenza di sfondo);

• si formula una nuova congettura o teoria soddisfacente rispetto ai problemi stessi;

• si cercano, attraverso osservazioni ed esperimenti, elementi atti alla sua confutazione

e falsificazione per sostituirla al più presto con un'altra teoria provvisoriamente più

adatta a spiegare la realtà.

Karl Popper definì il suo metodo come «ipotetico-deduttivo»: il punto di vista secondo cui

un’ipotesi può essere soltanto controllata empiricamente e soltanto dopo che è stata proposta.

La ricerca procede, pertanto, per tentativi ed errori: congetture e confutazioni. (Popper, 1998)

Questo modo di pensare permette «di distinguere le proposizioni delle scienze empiriche dalle

asserzioni metafisiche» (Popper, 1998).

Secondo questo nuovo criterio di «demarcazione», le affermazioni della scienza si

distinguerebbero da quelle metafisiche proprio in quanto suscettibili di essere «falsificate».

Infatti, le asserzioni della metafisica non sono falsificabili, perché non possono essere

sottoposte a esperimento: non possono essere controllate. In conclusione, la controllabilità,

ovvero la falsificabilità di una teoria è la condizione della sua scientificità.

Thomas Kuhn e i paradigmi delle scienze

La parola paradigma è stata utilizzata da Platone (modello) e da Aristotele (esempio). Nelle

scienze umane si usa molto, e ha diversi significati (teoria, articolazione interna di una teoria,

scuola o pensiero).

Nel 1972 Thomas Kuhn scrive l’opera “La struttura della rivoluzioni scientifiche” in cui rifiuta

la concezione tradizionale della scienza come accumulazione progressiva di nuove scoperte,

affermando invece che in certi momenti (detti rivoluzionari) si interrompe il rapporto di

4

Introduzione

continuità con il passato e si inizia un nuovo corso, in modo non completamente razionale:

Si tratta di un elemento arbitrario composto di accidentalità storiche e personali sempre presente come

elemento costitutivo nelle convinzioni manifestate da una data comunità scientifica in un dato

momento (Kuhn, 1972).

Il passaggio da una teoria a un’altra è così globale e ha tali conseguenze che Kuhn lo chiama

rivoluzione scientifica. C’è un cambiamento dei problemi da proporre all’indagine scientifica e

dei criteri con cui si stabilisce cosa si considera come un problema ammissibile, cambia anche

la struttura concettuale attraverso cui gli scienziati guardano il mondo (paradigma). Il

paradigma è una prospettiva teorica che è condivisa e riconosciuta dagli scienziati, è fondata su

acquisizioni precedenti e indirizza la ricerca riguardo alla scelta dei fatti rilevanti da studiare, alla

formulazione delle ipotesi e ai metodi e tecniche di ricerca necessari.

Senza un paradigma una scienza non ha orientamenti né criteri di scelta, perché tutti i criteri, i

problemi e le tecniche diventano ugualmente rilevanti. Il paradigma è una guida e fornisce agli

scienziati un modello e le indicazioni per costruirlo. Con il paradigma lo scienziato acquisisce

contemporaneamente teorie, metodi e criteri. Il paradigma è qualcosa di più ampio di una

teoria, è una visione del mondo, una finestra mentale, una griglia di lettura che precede

l’elaborazione teorica. La scienza normale corrisponde a quei periodi in cui esiste all’interno di

una disciplina un paradigma condiviso dagli scienziati.

Verso un nuovo paradigma nelle scienze della vita e della salute

Nella storia della medicina e delle scienze sanitarie si può osservare il succedersi di paradigmi

molto diversi tra loro. Innanzitutto si nota come nell'antichità (e ancor oggi tra i popoli

primitivi), mancando conoscenze certe sulla natura dei processi patologici, la medicina viene

prevalentemente esercitata in stretta relazione alla mitologia, alla magia o alla religione: le

malattie sono viste come castighi mandati dagli dei, i medici sono anche guaritori, stregoni o

sciamani. Anche nella medicina cinese e nelle altre medicine orientali, il paradigma dominante è

extra-scientifico, è costituito di una serie di "regole" interpretative basate sulla filosofia (ad. es.

il "Tao") e derivate, per analogia, dalla osservazione del cosmo: si applicano al vivente concetti

quali caldo/freddo, sole/luna, terra/acqua, ecc... A sostenere lo sforzo terapeutico è più la

coscienza della necessità di trovare una "armonia" con i ritmi del cosmo che un'analisi

razionale delle componenti in gioco. Fino alla fine del medioevo, la pratica della medicina non

si discosta molto da tali vedute.

Anche se si devono registrare alcuni notevoli tentativi di fondare la medicina sull’osservazione

dei fenomeni naturali, sul ragionamento, sull'esperimento (basti pensare a personaggi come

Ippocrate, Celso, Galeno, Paracelso), la medicina per molti secoli resta ancorata a una serie di

precetti empirici, soggetti alle più strane applicazioni e modifiche, e fruisce di un armamentario

terapeutico basato sull'uso indiscriminato di rimedi quali purghe, salassi, oppio e alcoolici.

L’impostazione razionalistica della medicina come scienza ha le sue origini al tempo della

cosiddetta “rivoluzione scientifica” nel XVII secolo, con la nascita della scienza moderna

riconducibile a Copernico, Galileo, Cartesio e Newton. Da quel momento, la matematica

diviene strumento di conoscenza (mathesis) applicabile anche alla medicina.

I fondatori della scienza moderna avevano un programma ben preciso che consisteva nel

«distruggere un mondo e rimpiazzarlo con un altro» (Koiré, 1953), fare cioè tabula rasa

dell’esistente e ricominciare da capo, a partire dall’interrogazione dell’esperienza, rinunciando

alla tradizione. È il programma d’intenti che segna l’inizio della Modernità, intesa come

impalcatura che ha impregnato la filosofia, la cultura e la scienza nei quattro secoli successivi,

fino ai nostri giorni. Il filosofo inglese Stephen Toulmin osserva:

Nel 1650 la tolleranza umanista per l’incertezza, l’ambiguità e la diversità cedettero il posto

all’intolleranza puritana, all’insistenza razionalista sulla teoria esatta e universale, all’enfasi sulla

certezza a riguardo di tutto (Toulmin, 1990).

I concetti di scienza e verità, ancorati al pensiero logico e matematico, diventano indissolubili

Introduzione

nel percorso della Modernità, sullo sfondo di una concezione riduzionistica dell’universo e

della vita che pretende di spiegare tutti i fenomeni della natura con le semplici leggi della

meccanica (Abbagnano, 1998). E con il passare del tempo, anche i biologi e i medici finiscono

per adottare ingranaggi simili a orologi come modelli per descrivere i processi della vita

(Damasio, 1995).

Dopo la nascita della scienza occidentale (1600) si assiste, quindi, al tentativo di impostare

l'attività medica sulla base di sistemi organicamente coerenti con teorie fisiche, chimiche o

biologiche. Da questo momento la pratica della medicina si collega con le conoscenze

scientifiche e con gli sviluppi tecnologici: i paradigmi cambiano in conseguenza di ciò.

Dovendo necessariamente semplificare e schematizzare questi mutamenti culturali e

metodologici, si può constatare come all'inizio è la meccanica a prevalere, e di conseguenza il

paradigma dominante in medicina è la descrizione anatomica della "macchina-uomo", le

descrizioni e le classificazioni delle forme delle ossa, dei muscoli e apparati tendinei, sulla

circolazione del sangue, ecc... Gli anatomici, al tavolo autoptico, scoprono le modificazioni

patologiche visibili della malattia che viene con esse identificata. La nozione di uomo-macchina

e lo "scisma" cartesiano (anima/corpo) si consolidano e divengono il paradigma dominante.

A tal proposito, può essere interessante riflettere sull’ordine “gerarchico” esistente tra le

diverse discipline mediche, e in particolare tra clinica e anatomia patologica, nel percorso per

giungere alla verità diagnostica (Giannetta e Federspil, 2008). Per lungo tempo, e fino a pochi

decenni orsono, la valutazione dell’anatomopatologo era ritenuta conclusiva: una sorta di

giudizio finale e inappellabile sull’accuratezza della diagnosi clinica e del conseguente

comportamento terapeutico.

La credenza della maggiore prossimità dell’anatomia patologica alla verità clinica può essere

ricondotta alla visione meccanicistica del corpo umano, come parte di un universo scritto in

lingua matematica e assimilabile al funzionamento di una macchina. Non a caso, i medici di

scuola galileiana applicano alla medicina la iatromeccanica e la iatrofisica; William Harvey,

sviluppando le teorie di Cartesio, studia «il moto del cuore e del sangue»; e Giorgio Baglivi,

nella seconda metà del 1600, parla di «economia fisica dell’uomo», asserendo che il cuore è una

molla, lo stomaco una storta, le mascelle tenaglie, le vene e le arterie tubi idraulici, i visceri filtri

e setacci, i polmoni mantici (Cosmacini, 2008). Se, dunque, l’uomo è una macchina, solo

l’anatomopatologo che ha accesso alle intime alterazioni morfologiche può rintracciare il

malfunzionamento delle sue parti con ben maggiore precisione del clinico, che invece svolge

un lavoro induttivo o abduttivo, interpretando i dati disponibili all’esterno.

Il paradigma meccanicistico rimane prevalente nella teoria e nella pratica della medicina

occidentale fino ai giorni nostri anche se viene riadattato, con le opportune varianti, passando

dal livello macroscopico-anatomico a quello microscopico, fino ad arrivare al livello

molecolare.

Con lo sviluppo della chimica, la cellula viene analizzata nelle sue componenti molecolari e

chimiche. Nasce la bio-chimica e quindi la farmacologia, che studia gli effetti di sostanze

chimiche definite sul sistema vivente. Si scoprono gli antibiotici, gli ormoni, i metodi di

antisepsi (che consentono enormi avanzamenti nella chirurgia), gli analgesici, gli

antiinfiammatori, i vasodilatatori, ecc... Siamo nella prima parte del nostro secolo. Qualcosa,

però, ancora sfugge alla comprensione del modo di funzionamento dei sistemi biologici, è

come se si conoscessero molti "effetti", senza conoscerne a fondo i meccanismi. Un altro

grande salto concettuale viene fatto quindi con l'avvento della biologia molecolare. Il

paradigma molecolare si impone a partire dagli anni sessanta, perché la scoperta della struttura

del DNA rappresenta la possibilità di de-codificare il nucleo fondamentale dell'informazione

biologica. Non si è più di fronte solo alla possibilità di conoscere i costituenti della materia

vivente (chimica e biochimica), ma si è imparato il linguaggio con cui è scritto il "programma"

degli esseri viventi, programma di cui esiste duplice copia in ogni singola cellula somatica. Se di

una casa si conoscono i materiali, non si è ancora in grado di ricostruirla e, spesso, neppure di

ripararla adeguatamente, ma se si conoscono sia i materiali che il progetto, si dispone di ogni

6

Introduzione

elemento per fare, rifare, modificare la casa stessa. L'analogia con l'ingegneria è talmente

calzante che si inizia a parlare proprio di "ingegneria genetica" e di "biotecnologia" (spesso

anche con esagerazioni e inesattezze quando si identifica la biotecnologia con l'ingegneria

genetica, perché la biotecnologia in realtà è sempre esistita in campo agricolo e alimentare).

Lo straordinario aumento di possibilità di analisi che si è avuto a seguito dell'introduzione delle

tecniche di biologia molecolare, soprattutto nello studio delle proteine e degli acidi nucleici, ha

consentito un enorme ampliamento delle conoscenze sulle alterazioni molecolari che

caratterizzano moltissime malattie, sia ereditarie che acquisite. Le conoscenze sulle basi

molecolari di molte malattie vengono oggi ad avere un impatto sempre crescente sulla medicina

anche per le loro ricadute diagnostiche (vedi, ad esempio, la diagnosi prenatale basata sui

polimorfismi, o la reazione a catena della polimerasi, PCR, applicata in campi che vanno

dall'AIDS alle leucemie) e terapeutiche (vedi trapianto di geni in malattie della serie

emopoietica, prospettive di terapia genica nella fibrosi cistica). L'approccio molecolare ha

avuto, e avrà ancora per molti anni, il compito di descrivere in modo più preciso possibile le

basi di una grande varietà di situazioni patologiche possibili (in teoria, per ciascuno delle

migliaia di geni finora identificati, sono possibili miglioaia di diverse mutazioni patologiche). Si

tratta di fare, in altri termini, la "anatomia patologica" delle molecole, un compito vari ordini di

grandezza più vasto di quello già svolto dall'anatomia patologica a livello di organi o cellule.

L'aumento delle conoscenze in senso estensivo introdotto dall'approccio molecolare ha fatto

crescere ulteriormente anche la consapevolezza della estrema complessità dei sistemi viventi.

Anche il DNA, ritenuto inizialmente l'ultimo approdo della ricerca in biologia (il "deposito"

dell'informazione, la "molecola della vita"), si è mostrato molto più complesso e mutevole del

previsto. A ciò si aggiunga l'accresciuta consapevolezza dell'esistenza di numerose differenze

biologiche tra gli individui della stessa specie, che rendono difficile, a volte impossibile, stabilire

i valori di normalità e prevedere l'esito di interventi regolatori esterni. In altre parole, con

l'aumentare delle conoscenze sulle sub-componenti del sistema vivente, aumenta la difficoltà di

descrivere il comportamento unitario del sistema stesso. La parola "complessità" compare

sempre più frequentemente nei lavori scientifici e nei libri di testo. I medici, così come i

professionisti dell’assistenza e della riabilitazione, sempre di più si rendono conto che le

nozioni di biologia molecolare, di biochimica, di fisiopatologia, studiate a fondo nei primi anni

del corso di studi, sono difficilmente applicabili al letto del paziente. La ragione fondamentale

di ciò sta nel fatto che il medico si trova sempre ad applicare le nozioni biologiche generali a un

caso particolare:

L'elemento veramente caratteristico, che fa della Clinica una scienza tutta speciale, è costituito dal

fatto che essa, in primis, deve accertare in quale situazione biologica si trovi quel fenomeno unico,

irripetibile sulla scena del mondo, che è il singolo malato (Federspil e Scandellari, 1991).

Anche da un punto di vista epidemiologico, si può facilmente constatare che, dopo i grandi

progressi che hanno inciso drasticamente sullo stato di salute dell'uomo e sulla durata della vita

media (vaccinazioni, antisepsi, antibiotici, terapie sostitutive, chirurgia, ecc...), la medicina si

trova di fronte sfide molto più complesse. Come già riconosceva Alexis Carrel, Nobel per la

Medicina nel 1912, uno dei primi scienziati che avvertì acutamente questi problemi:

è giocoforza ammettere che i progressi della medicina sono ben lungi dall'aver soppresso la malattia.

Anziché morir rapidamente di infezione, moriamo più lentamente, più dolorosamente, di malattie

degenerative: affezioni cardiache, cancri, diabete, lesioni del rene, del cervello, di qualsiasi organo. La

medicina non ha ridotto la sofferenza umana tanto largamente quanto noi lo crediamo. La sofferenza

nasce non solo dai batteri e dai virus, ma anche da agenti più sottili (Carrel, 1945).

Tutto ciò avviene nonostante le spese per il sistema sanitario nei paesi occidentali siano

notoriamente enormi e in continua ascesa.

Nella seconda metà del Novecento, la Modernità entra in crisi sotto la spinta delle nuove teorie

scientifiche che, nel rimpiazzare l’impalcatura del modello newtoniano, mettono in luce il

carattere di irrimediabile provvisorietà e incompiutezza dell’impresa scientifica; e soprattutto

sotto il peso di una sfiducia che investe la scienza e i suoi metodi rispetto alla possibilità di

Introduzione

offrire una prospettiva di senso e di giustificazione ai fatti tragici della storia (Husserl, 2002).

Cominciano ad affiorare tendenze epistemologiche destinate a cambiare profondamente i

rapporti tra scienza e verità; anzi, è il concetto stesso di verità che inizia a diventare scomodo

(Bowler e Moris, 2005). Bruno Latour, dopo aver studiato la pratica della ricerca scientifica al

Salk Institute con un approccio di tipo antropologico, afferma che «l’attività scientifica non è

fondata sulla natura, ma è una dura lotta per costruire la realtà» (Latour e Woolgar, 1979).

Le filosofie postmoderne accreditano una diversa idea di verità, come sistema di credenze

socialmente determinato e dal carattere inevitabilmente relativo; e si rivolgono alla scienza non

più come a un idolo, ma come a un «genere letterario, un genere che deve trovare il suo posto

con la letteratura, la critica, la politica e la storia nella conversazione del genere umano» (Rorty,

1999).

Nel suo lavoro, comparso l’8 aprile del 1977 su Science, Engel analizza i pilastri del paradigma

biomedico dominante: riduzione di fenomeni complessi a determinanti semplici

(riduzionismo), separazione dei fenomeni biologici da quelli psico-sociali (dualismo mente

corpo), interpretazione dei fenomeni vitali in termini fisico-chimici (fisicalismo). George Engel,

propone il modello biopsicosociale che

fornisce una matrice (blueprint) per la ricerca, uno schema (framework) per l’insegnamento, un

orientamento (design) per l’azione nel mondo reale dell’assistenza sanitaria (Engel, 1977, p. 135).

Con la perdita di tenuta del modello meccanicistico tramonta anche la superiorità indiscussa

dell’anatomia patologica: il patologo può andare incontro a errori, necessita di integrare gli

aspetti morfologici con le informazioni cliniche, e la sua conclusione diagnostica può divergere

da quella formulata dal clinico, soprattutto nei casi di particolare complessità.

La verità rimanda piuttosto ad approcci multidisciplinari e si orienta verso l’integrazione della

pluralità dei diversi angoli visuali. E anche il concetto di malattia – come anche quelli di causa e

di prognosi – si emancipa da una definizione semplice e non equivoca che rimanda a un

insieme di elementi totalmente omogenei rispetto alle proprietà costituenti.

Le humanities suggeriscono come la medicina dovrebbe essere più attenta a riflettere non solo

sulla verità scientifica, ma anche sulla verità delle emozioni e dei sentimenti, così importanti nel

rapporto medico-paziente.

Questo tema conduce verso l’orizzonte pre-moderno dei classici dell’antichità. Fino a riflettere

sulla parresia, espressione con la quale gli epicurei e gli stoici intendevano l’etica della parola, il

parlar franco, il dovere e la libertà di dire, cui Michel Foucault dedica alcune lezioni al corso

tenuto al Collège de France nel 1981-82 su “la cura del sé”.

A un tempo qualità morale e tecnica, la parresia fa riferimento a

qualcuno che parla, che parla all’altro, solo che gli parla in modo tale che [….] questi potrà dar vita

a un rapporto con se stesso che sarà un rapporto autonomo, indipendente, completo e soddisfacente

(Foucault, 2003).

Qui Foucault allude ai “discorsi veri”, a quell’equipaggiamento morale che ciascuno di noi

dovrebbe raccogliere per sviluppare il proprio sé, fortificarlo, convertirsi a sé, per poterne

disporre nei momenti difficili di sofferenza e di malattia. Foucault spiega che, secondo il

filosofo romano Filodemo, la parresia fa pensare in tutto e per tutto all’arte o alla pratica del

medico: essa rappresenta una forma di soccorso, di terapia, che consente di curare nel modo

dovuto.

L'opinione pubblica e gli stessi "addetti ai lavori" si interrogano sempre più frequentemente sul

senso e la liceità della utilizzazione di tecnologie avanzate in momenti molto delicati quali la

generazione e la morte. La questione del "fine", cioè la questione del nesso tra l'azione

particolare e le sue ultime conseguenze sull'individuo e sulla specie, si pone prepotentemente

allorché ci si rende conto delle potenzialità, insite nelle moderne tecnologie, di andare a

modificare la "natura essenziale" dell'essere umano. E' per questo che si sta prendendo

coscienza dei rischi insiti nel portare alle estreme conseguenze l'applicazione del metodo

scientifico cartesiano in medicina, cioè di escludere totalmente le questioni etiche dalla

medicina scientifica.

8

Introduzione

Il problema, a questo proposito, riguarda le modalità e gli strumenti per attuare tale

collegamento tra il livello scientifico e il livello dei giudizi di valore. E' necessario un lavoro di

ricostruzione dei "nessi" tra le conoscenze scientifiche, che si occupano dei particolari

biologici, strutturali e funzionali dell'organismo, e le acquisizioni filosofiche, ottenute mediante

la riflessione sulla natura dell'uomo e sui suoi valori peculiari. A nostro giudizio, la scienza

potrebbe contribuire a tale sviluppo con le proprie specifiche metodologie, basate sul metodo

sperimentale, approfondendo la conoscenza delle leggi della vita, delle caratteristiche proprie

dell'essere umano considerato nella sua complessità, unitarietà e individualità e nei suoi rapporti

con l'ambiente in cui vive e che continuamente modifica. E' interessante, a questo proposito, la

definizione di uomo data da Carrel: Un tutto indivisibile, che si manifesta con delle attività

fisico-chimiche, fisiologiche e psicologiche" (Carrel, 1935). Si tratta, come si vede, di un

concetto operativo, elaborato da uno scienziato che, forse per primo nell'era moderna, si è

posto l'obiettivo di una sintesi tra scienze umane e scienze biomediche. Sempre Carrel scriveva:

L'avvenire della medicina è subordinato al concetto di uomo. La sua grandezza dipende dalla

ricchezza di questo concetto. Anziché limitare l'uomo a certi suoi aspetti, deve abbracciarlo tutto

quanto, cogliendo il corpo e lo spirito nell'unità della loro realtà. Supererà le astrazioni che

l'anatomia, la fisiologia, la pedagogia, la sociologia considerano rispettivamente come equivalenti

all'individuo. In effetti, l'uomo è solo quello che l'osservazione ci rivela di lui. Ci appare come un

corpo composto di tessuti, di organi e di umori. Questo corpo manifesta certe attività che noi

distinguiamo arbitrariamente in fisiologiche e mentali. (...) L'uomo è al tempo stesso complessità e

semplicità, unità e molteplicità. Ogni individuo è una storia diversa da tutte le altre. E' un aspetto

unico nell'universo. Benché non interamente incluso nel continuum fisico e tale da sfuggire, grazie al

proprio spirito, fuori dallo spazio e dal tempo, è inseparabile dall'ambiente fisico e chimico e

psicologico. E, in ultima analisi, dalle istituzioni economiche e sociali. (...) Fin qui, ci siamo studiati

solo di procurarci concetti frammentari. La nostra analisi ha cominciato prima di tutto con lo

spezzare la continuità dell'uomo e dell'ambiente cosmico e sociale. Poi ha separato l'anima dal corpo.

Il corpo è stato diviso in organi, cellule e liquidi. E in questo processo di dissezione, lo spirito è

svanito. Così sono molte le scienze che hanno ognuna per tema un aspetto isolato dell'uomo. Noi le

chiamiamo sociologia, storia, pedagogia, fisiologia, ecc. Ma l'uomo è molto di più che la somma di

questi dati analitici. Conviene quindi considerarlo nelle sue parti e nel suo insieme, in quanto

nell'ambiente cosmico economico e psicologico reagisce come unità, e non come molteplicità (Carrel,

1945).

La medicina può documentare che "l'uomo è molto più che la somma dei dati analitici",

aprendosi allo studio della complessità. Si tratta di un'esigenza sempre più avvertita da parte

degli "addetti ai lavori", coscienti della necessità di far rifluire le grandi potenzialità insite nei

moderni mezzi tecnologici di indagine e di terapia in una sintesi che sia a misura del singolo

paziente. Cresce la consapevolezza dell'importanza della globalità, dell'individualità, dei

fenomeni di interrelazione sistemica, dell'ecologia.

Non esiste una definizione univoca di complessità, anche se, nella vita quotidiana, si usa spesso

questo termine: problema complesso, figura complessa, meccanismo complesso, ecc...

Esistono definizioni diverse a seconda del contesto (Arecchi e Arecchi, 1990). Una cosa però è

certa, che il termine "complessità" è utile per descrivere e capire i sistemi altamente organizzati

(Cramer, 1993).

Da un punto di vista puramente matematico, la complessità viene definita come il logaritmo

del numero dei possibili stati di un sistema. Secondo la teoria dell'informazione, la complessità

viene definita come la dimensione del programma di calcolo (misurata in bits) necessario per

descrivere una "struttura", come ad esempio una sequenza di numeri o di lettere (Arecchi e

Arecchi, 1990, Cramer, 1993).

Naturalmente, queste definizioni di complessità dipendono da quali si considerano i possibili

stati utili per il calcolo: la complessità di una proteina potrebbe essere calcolata sulla base delle

combinazioni possibili degli aminoacidi che la compongono, arrivando quindi a un enorme

numero di possibili combinazioni. D'altra parte, si potrebbe considerare la complessità di una

Introduzione

proteina solo in base alla presenza di aminoacidi idrofilici o idrofobici (operazione utile per

vedere la possibile integrazione nelle membrane fosfolipidiche), e questo semplificherebbe il

calcolo, riducendo la complessità della proteina e le differenze tra diverse proteine. Si potrebbe

poi riferirsi solo ai suoi possibili cambiamenti conformazionali, che di solito sono limitati a uno

o pochi, in quanto la proteina tende sempre a disporsi nella forma in cui l'energia libera è

minore. Ad esempio, un enzima che può assumere due forme, attivo e non attivo (on/off) a

seconda che leghi o no una molecola di AMP ciclico, può essere considerato, da questo punto

di vista, meno complesso dell'emoglobina, che ha quattro forme, a seconda del numero di

molecole di ossigeno che lega.

Nel passaggio dai modelli chimico-fisici a quelli biologici, si assiste a un enorme aumento di

complessità, perché i sistemi viventi sono composti di moltissime parti diverse tra loro in

relazione. Da questo punto di vista, si tratta di un aumento quantitativo di complessità. E' stato

sostenuto che la complessità degli esseri viventi è tale che il programma necessario per

descriverli è di una dimensione simile al sistema stesso. Si parla, in questo caso, di "complessità

fondamentale", perché essa non può essere in alcun modo semplificata.

Quanto più un sistema è complesso, tanto più ha reso complessa la gestione delle

informazioni, che può essere effettuata da molti elementi disposti in sequenze e in reti. Tali reti

(networks) connettono diversi elementi e gestiscono l'informazione com meccanismi di

amplificazione o di feed-back multipli e incrociati. Esempi di tali reti sono quelle neurali, quelle

del sistema immunitario, quelle delle citochine, ecc... L'informazione, nelle reti biologiche, è

solitamente "ridondante", cioè lo stesso segnale può agire su molteplici bersagli ed essere

prodotto da molteplici elementi del sistema.

Tra l'altro, bisogna notare che l'informazione contenuta in un individuo umano è miliardi di

volte superiore a quella contenuta nel DNA. Il cervello umano rappresenta l'oggetto di

massima complessità conosciuto in tutto l'universo. La morfologia del cervello rivela che i

neuroni del cervello (10 miliardi) sono connessi da un milione di miliardi di connessioni

sinaptiche. Tale numero è enormemente più grande di qualsiasi possibile informazione

genetica, indicando che la struttura del cervello non è ultimamente determinata geneticamente,

ma piuttosto dall'interazione tra le potenzialità genetiche e le sollecitazioni ambientali. Le

ramificazioni dendritiche che collegano vari neuroni si sovrappongono notevolmente (fino

anche al 70%), così che non è possibile disegnare dei circuiti unici e precisamente definiti.

Esaminando la formazione del cervello, si vede che un preciso modo di connessione tra un

neurone e l'altro, pre-specificato dall'inizio, è da escludersi. I neuroni, quando emettono i

prolungamenti assonici non sanno dove inviarli, con quale altro neurone connettersi. In ogni

individuo, persino in gemelli identici, i neuroni si ramificano in diversi modi. Non è pensabile

che le connessioni siano specificate unicamente a livello molecolare (molecole di adesione),

perché non esistono marcatori di membrana così specifici da dirigere una architettura così

complessa (notare che ciò è sostenuto dal Nobel G. M. Edelman, scopritore delle molecole di

adesione neurali e fondatore della topobiologia (Edelman, 1993).

Studiando il funzionamento di neuroni di aree cerebrali deputate a specifiche funzioni, si

osserva che ogni individuo ha mappe diverse e che anche nello stesso individuo le mappe

variano a seconda dell'esperienza, allargandosi, restringendosi e anche spostandosi

lateralmente. Nella stessa area, molti neuroni rimangono silenti anche quando la funzione è

attiva, ed è impossibile predire quali neuroni saranno silenti e quali scaricheranno applicando

un determinato stimolo.

Le cellule della corteccia cerebrale sono organizzate in gruppi funzionalmente accoppiati:

quando arriva uno stimolo alla corteccia, ad esempio uno stimolo luminoso proveniente dalla

retina, molti neuroni sono attivati e scaricano impulsi, ma non in modo casuale, bensì in modo

coordinato, con oscillazioni alla frequenza di circa 40 Hz. D'altra parte, la regolarità non è una

costante: l'elettroencefalogramma rivela che nelle oscillazioni cerebrali è presente, come

componente normale, una notevole caoticità (Freeman, 1991).

In sintesi, nel cervello sono rappresentate in modo emblematico tutte le caratteristiche della

10

Introduzione

complessità: enorme quantità di informazioni, reti, comportamenti collettivi, fondamentale

importanza della forma, plasticità evolutiva, caos. Alcuni studiosi si sono spinti ad affermare

che la coesistenza di ordine e caos nel cervello è proprio ciò che garantisce la possibilità di

generare nuove idee e, persino, la possibilità del libero arbitrio in un mondo retto da leggi

deterministiche (Crutchfield et al., 1991).

Oggi quindi assistiamo da una parte allo sviluppo progressivo, che ancora non mostra segni di

"saturazione", della biologia molecolare, dall'altra all'aumento di coloro che si collocano in un

nuovo paradigma, che fa riferimento alla scienza della complessità. In estrema sintesi, si

potrebbe parlare di un passaggio da un paradigma basato sul riduzionismo meccanicisticomolecolare a un paradigma basato sulla complessità e sulla bioetica (intesa in senso molto

ampio). Il paradigma riduzionista dominante ha raggiunto il suo acme nell’ultimo decennio del

Novecento con il Progetto Genoma, nella coerente illusione di trovare nei geni i determinanti

semplici e ultimi della varietà delle patologie umane. Come sappiamo, la promessa non è stata

mantenuta.

Sebbene i segni dell'emergere dei nuovi approcci concettuali e sperimentali, nel campo della

biologia, della medicina dell’infermieristica e di altre scienze sanitarie e sociosanitarie, sono

ancora piuttosto sporadici nella pratica professionale rispetto al paradigma dominante, i tempi

per una inversione di tendenza sembrano maturi. Multidisciplinarietà, integrazione, contesto:

da qualche anno questi termini sono divenuti di uso corrente anche nell’ambito delle discipline

biomediche e in particolare in sanità pubblica. Il riferimento comune che spiega questo

cambiamento lessicale può essere rintracciato nel concetto di complessità che sembra

riassumere in sé la portata dei cambiamenti in corso nella cultura e nella società: lo spirito del

tempo che esprime l’irriducibilità della realtà al determinismo e al riduzionismo dell’approccio

scientifico tradizionale. A tal punto che l’espressione ‘complessità’ è divenuta un modo di dire

assai diffuso sia nel linguaggio comune che nel gergo tecnico delle diverse discipline. In

letteratura biomedica sono apparse all’inizio di questo secolo numerose pubblicazioni che

trattano di complessità nell’assistenza sanitaria (Plsek e Greenhalgh , 2001; Sweeney e

Griffiths, 2002), in medicina clinica (Wilson e Holt 2001), e in sanità pubblica e epidemiologia

(Materia e Baglio, 2005).

Spesso il termine complessità viene definito in antitesi al concetto di semplicità, confondendo

così il concetto di complessità con quello di complicazione. E' interessante, per comprendere la

differenza di significato tra il termine complesso e il termine complicato, risalire all'aspetto

etimologico delle parole: mentre complicato deriva dal latino cum plicum, che significa “con

pieghe”, complesso deriva dal latino cum plexum, che significa “con nodi”,

intrecciato. L'etimologia latina plicum richiama la piega del foglio, che deve essere "spiegato" per

poter essere letto e compreso, mentre il plexum è il nodo, l'intreccio, come quello di un tessuto

o di un tappeto, che non si può sbrogliare senza perdere la sua stessa natura, la visione

d’insieme che esso consente.

L'approccio "complicato" è di tipo analitico: il fenomeno-problema si suddivide in parti, che

vengono studiate, analizzate e ricomposte. L'approccio "complesso", invece, è di tipo

relazionale, integrato ed emergenziale con lo scopo di fornire una visione del fenomenoproblema nella sua unitarietà e La complessità è anche un movimento epistemologico, di cui il

sociologo Edgar Morin è principale esponente:

Il pensiero complesso è consapevole in partenza dell’impossibilità della conoscenza completa: uno degli

assiomi della complessità è l’impossibilità, anche teorica, dell’onniscienza. Riconoscimento di un

principio di incompletezza e di incertezza. Il pensiero complesso è animato da una tensione

permanente tra l’aspirazione a un sapere non parcellizzato, non settoriale, non riduttivo, e il

riconoscimento dell’incompiutezza e della incompletezza di ogni conoscenza. Questa tensione ha

animato tutta la mia vita…Per tutta la vita…ho sempre aspirato ad un pensiero multidimensionale.

(…) Ho sempre sentito che alcune verità profonde, antagoniste tra loro, erano per me complementari,

senza smettere di essere antagoniste (Morin, 1993, p. 3).

interezza.

Introduzione

La scienza della complessità pone una condizione iniziale: l’interrelazione dinamica tra

l'osservatore e l'osservato. Il substrato di cui si alimenta la scienza della complessità è quello

della vita, ed è proprio dalla scienze della vita che la complessità è nata e si è evoluta come

scienza unitaria. Poiché queste scienze poggiano le loro fondamenta sui presupposti della vita

stessa, la scienza della complessità si alimenta dei principi che determinano la dinamica della

vita. La vita è, infatti, dinamica, è generata dalle interrelazioni, è soggetta alle contingenze dei

mutamenti ed è dipendente dalle trasformazioni e dall’imprevedibilità degli eventi. La scienza

della complessità è una “scienza delle scienze” in cui confluiscono, integrandosi, i presupposti

e le proprietà che caratterizzano in modo ricorrente ciascuna di esse; coniuga le scienze naturali

con le scienze umane, lo scientifico con l'umanistico, l'osservatore con l'osservato, scardinando

in tal modo tutti i presupposti posti alla base dell'edificio meccanicista. È altresì la scienza

transdisciplinare dedita allo studio dei sistemi adattativi complessi e dei cosiddetti “fenomeni

collettivi emergenti” che si creano per auto organizzazione dai margini del caos: frontiera della

ricerca anche per i fisici, alle prese con il comportamento delle particelle elementari.

La scienza della complessità consente di comprendere come funziona l’insieme, svolgendo

un'analisi sia del tutto che delle relazioni tra le parti che compongono il tutto, in un sistema

dinamico di relazioni. Complexus significa ciò che è tessuto insieme; in effetti, si ha complessità

quando sono inseparabili i differenti elementi che costituiscono un tutto e quando vi è tessuto

interdipendente, interattivo e inter-retroattivo tra l’oggetto di conoscenza e il suo contesto, le

parti e il tutto, il tutto e le parti, le parti tra di loro. La complessità è, perciò, il legame tra l’unità

e la molteplicità.

Si comprende immediatamente la grande differenza che caratterizza il paradigma della

complessità rispetto al paradigma della riduzione. Questo non vuol dire che i due paradigmi

siano in antitesi l’uno all’altro, come uno sguardo superficiale potrebbe far ritenere. Si può

invece affermare che l’uno integra l’altro consentendo di allargare il campo di osservazione

dalle singole parti, tra loro separate, alle relazioni che le interconnettono, fino all’analisi degli

effetti che tali relazioni determinano sull’intero sistema.

Le dimensioni della complessità – molteplicità, integrazione, contesto, incertezza – si

accreditano come coordinate di valore e di senso all’interno delle quali si va strutturando la

condizione postmoderna di cui interpretano i costrutti positivi.

Di fronte a quella che Feyerabend (1999) definiva l’”abbondanza” del reale, la sua molteplicità,

variabilità e imprevedibilità, sembra oggi prevalere una tendenza all’eclettismo metodologico,

alla pluralità dei punti di vista e alla tolleranza per l’incertezza.

Questa trasformazione coincide con quello che gli storici delle idee e gli epistemologi indicano

come un cambio di paradigma della conoscenza: la fine della modernità.

La modernità ha rappresentato l’impalcatura che ha sostenuto la filosofia della scienza e

impregnato la cultura per più di tre secoli, da Cartesio, Newton e Kant fino ai nostri giorni. Il

primato della scienza e del pensiero logico-matematico, la ricerca di un metodo assoluto e

maiuscolare in grado di separare in modo definitivo il sapere scientifico dalle altre forme di

pseudo-conoscenza, ne hanno rappresentato le caratteristiche distintive. Nell’era moderna,

l’uomo e la sua ragione sono il centro del mondo. L’emblema della modernità e del potere della

scienza di asservire la natura alle sue leggi assolute è il pendolo di Foucault che si può oggi

ammirare al Museo delle Arti e dei Mestieri di Parigi: il punto fermo dell’universo, il luogo di

osservazione assoluto ricercato dall’uomo moderno.

Come scrive Prigogine (1979):

Ogni grande era della scienza ha avuto un modello della natura. Per la scienza classica fu l’orologio;

per la scienza del diciannovesimo secolo…fu un meccanismo in via di esaurimento. Che simbolo

potrebbe andare bene per noi? Forse l’immagine che usava Platone: la natura come un’opera d’arte.

Nell’epoca della complessità, in assenza di un principio cardinale dominante o di un paradigma

al quale rifarsi, non rimane che rivolgersi al gioco, al dialogo, alla riflessione critica. In breve

all’ironia e all’autoironia che si propongono come l’unico possibile atteggiamento intellettuale e

conoscitivo.

12

Introduzione

I concetti di complessità, integrazione, contesto e incertezza appaiono alla radice di molti

cambiamenti che sono in corso nel settore sanitario (Materia e Baglio, 2008).

La contrapposizione tra le strategie di politica sanitaria dell’Organizzazione Mondiale della

Sanità (OMS) e della Banca Mondiale che si sono contese la leadership nell’arena della sanità

internazionale può essere interpretata come uno scontro tra diverse visioni epistemologiche e

non solo politico. Di recente l’OMS ha riproposto l’approccio della Primary Health Care per lo

sviluppo sanitario, concepito negli anni ’70 con la Conferenza di Alma-Ata sul coinvolgimento

delle comunità, l’equità, l’intersettorialità e l’utilizzo di tecnologie appropriate, principi che

rimandano alla complessità epistemologica e sociale (Walt, 2004).

Nel management sanitario, una visione complessa si esplicita, ad esempio, nell’organizzazione

dipartimentale dei servizi sanitari, nelle nuove concezioni associative della medicina di base

(UTAP – Unità Territoriali di Assistenza Primaria), negli approcci integrati dei servizi

ambulatoriali (day service o pacchetti ambulatoriali complessi), che valorizzano l’integrazione,

la multidisciplinarietà e la continuità delle cure.

Se la molteplicità si esprime nell’approccio transdisciplinare e multiprofessionale dei processi di

cura, nei nuovi modelli organizzativi delle cure primarie, nella valutazione multidimensionale

dei pazienti fragili, nell’eclettismo metodologico che si fa strada tra le discipline biomediche,

l’integrazione rimanda alla ricomposizione della multidisciplinarietà nell’assistenza e nella

ricerca, all’organizzazione degli ospedali per livelli di complessità assistenziale, e alle reti

assistenziali, strutture naturali ubique della complessità (Parisi, 2007), basate sulla cooperazione

tra nodi fiduciari.

Il contesto emerge come dimensione irrinunciabile per comprendere i fenomeni in campo

sanitario, dalla ricerca alla clinica, senza perdere di vista le radici sociali della salute e delle

malattie.

Infine, l’incertezza richiama una cultura del dubbio inteso come controllo permanente delle

proprie asserzioni, e come richiamo alla finitezza umana. L’«etica dell’incertezza» (Baglio e

Materia, 2006) sollecita la composizione del bilancio tra beneficî e rischi di un intervento

sanitario e il coinvolgimento del paziente nelle decisioni cliniche che lo riguardano nel tentativo

di riequilibrare l’asimmetria informativa tipica del rapporto medico-paziente.

La complessità, ridando valore ai fenomeni collettivi, ai fattori sociali e al contesto, è inoltre

attrezzata per recuperare le dimensioni dell’etica e dell’equità, connaturate alla pratica della

medicina, eppure oggi minate dalla logica mercantile e del profitto che ha pervaso anche il

settore sanitario.

Anche nella ricerca sanitaria si possono rintracciare i cambiamenti in atto.

In epidemiologia si torna a rivalutare il contesto e il ruolo dei fattori socioeconomici. Dallo

studio decontestualizzato delle associazioni tra fattori di rischio individuali ed esiti di salute,

l’attenzione si rivolge sempre più verso le dinamiche sociali e i fattori di popolazione. Torna a

essere attuale la lezione di Rose (2001) che sottolineava l’importanza dell’approccio di

popolazione sia sul versante della comprensione dei nessi causali che della prevenzione.

L’importante contributo di Rose è stato di recente ripubblicato sull’International Journal of

Epidemiology.

In questa stessa prospettiva va interpretata la rivalutazione degli studi ecologici, screditati in

passato dal rischio della ‘fallacia ecologica’, l’errore che si produce nel trasferire a livello

individuale i risultati di uno studio di popolazione. Si ricorre ai metodi di analisi multilivello che

permettono di modellizzare contemporaneamente sia le variabili individuali che quelle

aggregate a livello di popolazione.

Anche la rinnovata attenzione dei metodi bayesiani in statistica biomedica è riconducibile al

cambiamento epistemologico. La logica bayesiana fa riferimento all’incertezza della

valutazione, al ruolo del contesto e alla conoscenza di sfondo (probabilità a priori) nella

costruzione delle probabilità finali di un’ipotesi. Si propone dunque di superare l’approccio

frequentista alla teoria della probabilità giudicato troppo semplicistico (Healy, 2000).

Si ricorre sempre più di frequente a un maggiore eclettismo metodologico nella ricerca in sanità

Introduzione

pubblica e nella valutazione delle tecnologie sanitarie (Health Technology Assessment), per

superare il settorialismo degli approcci e restituire una rappresentazione della realtà meno

astratta e semplificata. L’esempio più importante è rappresentato dal crescente utilizzo anche in

ambito sanitario dei metodi e delle tecniche qualitative – approccio biografico, etnografico,

focus groups, tecnica di Delphi, interviste semistrutturate o in profondità – mutuati dalle

scienze sociali, e alla loro integrazione con le tecniche quantitative epidemiologiche.

Nella clinica, infine, sempre più pressante diviene il richiamo a recuperare la dimensione umana

nel rapporto professionista-paziente, piuttosto che ricorrere ad astratti algoritmi informatici di

formalizzazione del ragionamento clinico. In questa prospettiva le medical humanities

esprimono il tentativo di riposizionare la pratica clinica al servizio delle persone nell’ambito

delle scienze umane. L’eclettismo degli approcci si traduce nel ricorso vieppiù crescente alle

medicine alternative, nell’ambito della ricerca accademica e soprattutto nella pratica clinica da

parte dei pazienti, dei medici, degli infermieri, terapisti della riabilitazione e della stessa

industria farmaceutica.

Il movimento evidence based (EBM – evidence based medicine, EBN - evidence based

nursing, EBP - evidence based practice, EBH – evidence based health), sviluppatosi per porre

freno alle pratiche inefficaci attraverso la ricerca di evidenze scientifiche definitive, di prove di

efficacia e di regole e comportamenti universalmente validi, affonda le sue radici nella

modernità. Un bilancio critico dell’esperienza dell’EB nell’ultimo decennio è attualmente in

corso, innescato dalle riflessioni dei filosofi della medicina e dei professionisti alle prese sul

campo con i problemi del mondo reale. Gli elementi più significativi di questa revisione sono

riassumibili nei punti seguenti:

• La valutazione della qualità delle prove di efficacia si sta spostando, con i nuovi

sistemi di grading delle evidenze e delle raccomandazioni (GRADE Working Group,

2004), dagli aspetti esclusivamente legati al disegno e alla validità interna dello studio,

alla coerenza dei risultati (consistency) e alla loro trasferibilità nel contesto di interesse

(directeness).

• Una crescente attenzione viene riservata agli RCT ‘pragmatici’, orientati a valutare

l’efficacia nella pratica piuttosto che quella teorica, e ai cluster RCT, che tengono

conto dei fattori di popolazione degli interventi sanitari (Glasziou et al., 2004).

• Gli studi osservazionali entrano a far parte delle revisioni sistematiche Cochrane a

partire dalla constatazione che gli RCT non rappresentano più il gold standard per

tutti i tipi di quesiti clinici e che la scelta del disegno di studio più idoneo dipende

dallo specifico obiettivo della ricerca della letteratura (Campbell et al., 2004).

• Le linee guida per la pratica clinica sono sempre più orientate verso l’operatività, gli

aspetti clinico organizzativi, la traduzione locale in percorsi clinici integrati e la

promozione dell’appropriatezza degli interventi sanitari.

Nella formazione ci si ispira esplicitamente al pragmatismo di John Dewey proponendo

l’apprendimento basato sull’esperienza e sulla capacità di risolvere i problemi pratici,

all’apprendimento collaborativo e alla costruzione attiva da parte del soggetto della conoscenza

di matrice costruttivista.

In breve, i fenomeni collettivi emergenti sono oggi all’attenzione di molti campi del sapere: dal

comportamento collettivo delle particelle subatomiche, al volo degli storni fino agli effetti del

capitale sociale sulla salute. La consapevolezza che le proprietà dei sistemi complessi non sono

riducibili a quelle dei loro costituenti implica la necessità di considerare la dimensione

collettiva, sociale e del contesto come imprescindibile, tanto nella ricerca quanto nella pratica

della sanità pubblica. Questa prospettiva epistemologica richiede che l’equità venga

riconosciuta come principio guida del sistema sanitario e che l’attenzione alle fasce deboli e

marginali della popolazione diventi una priorità operativa.

Alla ricerca viene richiesto un sapere pertinente cui è più facile giungere attraverso l’eclettismo

metodologico, la tolleranza per i diversi punti di vista, la multidisciplinarietà, che permettono

14

Introduzione

una più completa comprensione dei fenomeni orientata alla soluzione di problemi pratici.

Viene rilanciata l’etica dell’incertezza incentrata sul valore del dubbio, inteso come controllo

permanente delle proprie asserzioni e, soprattutto, come luogo esistenziale di incontro e di

convivenza delle diversità.

A questo punto sorge, però, spontaneo il quesito se sia possibile un’integrazione di tutti questi

aspetti, nei loro vari livelli che vanno dal molecolare al mentale, in un quadro generale teorico

e, ciò che più conta, nella pratica clinica. La risposta a tale quesito è certamente negativa se si

intende con il termine "integrazione" una teoria onnicomprensiva, una teoria esatta e completa

dell'essere vivente, dell'uomo, della malattia. I processi biologici raggiungono un tale alto grado

di complessità che non è possibile descriverli in modo completo, preciso e predicibile.

La teoria della complessità e del caos deve ancora trovare la sua espressione pratica nel metodo

con cui si applicano la medicina e le altre scienze sanitarie. E' possibile però, già da subito,

un’integrazione dei vari aspetti qui considerati, se non altro come un "cambiamento di

mentalità" di chi opera in campo biomedico e assistenziale: riconoscere l'esistenza dei diversi

livelli in cui si può descrivere l'essere umano e l'esistenza delle interrelazioni di tali livelli. In

altri termini è proprio dalla consapevolezza della complessità che può prendere le mosse un

realistico tentativo di integrazione. Scrive Carrel:

L'uomo, in quanto è al tempo stesso molteplice e semplice, richiede uno studio analitico e sintetico, il

quale a sua volta deve avvalersi di parecchi metodi convergenti (Carrel, 1945).

Introdurre il concetto di complessità e di caos nella biologia, nella medicina e nella sanità in

generale significa introdurre, in un certo senso, un nuovo modo di pensare, di tipo non-lineare

e sistemico, basato sull'integrazione di più approcci allo stesso sistema-oggetto. Il paradigma

della complessità, paradossalmente, implica la eliminazione dei paradigmi dalla pratica della

scienza e della medicina e

noi dobbiamo rifiutare i sistemi filosofici e scientifici come spezzeremmo le catene di una schiavitù

intellettuale. E in quanto disciplina scientifica, la medicina è indipendente da ogni dottrina. Non c'è

nessuna giustificazione che essa sia piuttosto vitalista che meccanicista, materialista che spiritualista

(Carrel, 1945).

Diventa necessario fare un uso costruttivista delle teorie ed essere costruttivisti non significa

essere relativisti. Significa essere consapevoli delle operazioni attraverso cui noi strutturiamo la

realtà. Significa ammettere che il processo di pratica clinica (medica, infermieristica o di

riabilitazione) non è solo un processo di science making (produzione di scienza) o di decision

making (assunzione di decisioni) ma è sempre anche un processo di sense making, cioè una

dinamica relazionale nella quale la cultura, i pregiudizi, i vissuti di tutti i protagonisti caricano

ogni cosa di significati e di valori tutti da interpretare.

Ciò non significa, come scriveva Foucault (1967), cancellare le disposizioni fondamentali del

sapere e con queste l’uomo stesso «come sull’orlo del mare un volto di sabbia» ma di accettare

una prospettiva della conoscenza più inclusiva e pluralista e di raccogliere la sfida per

ricomporre i saperi su una nuova base transdisciplinare consapevoli che

In una società libera il risultato dipenderà da coloro che hanno il coraggio di provare nuove strade e

dalla saggezza di fornire loro il necessario supporto. (Engel, 1977)

15

Il processo di misurazione

1. Il processo di misurazione

Dov’è la sapienza

che abbiamo smarrita nella conoscenza?

Dov’è la conoscenza

che abbiamo smarrita nell’informazione?

T.S. Eliot

Dov’è l’informazione

che abbiamo smarrita nei dati?

M.U. Porat

1.1 La ricerca scientifica dell’approccio quantitativo

La ricerca scientifica è un processo creativo di scoperta che si sviluppa secondo un itinerario

prefissato e secondo procedure prestabilite che si sono consolidate all’interno della comunità

scientifica. Questo significa che esiste un atto della scoperta che sfugge alle analisi logiche ma

allo stesso tempo la ricerca empirica deve essere pubblica, controllabile e ripetibile per poter

essere definita scientifica.

Ciò implica:

• Il controllo (pubblicità e ripetibilità): i concetti e i procedimenti adoperati

devono essere standardizzati e i risultati corroborati anche da altri. «La scienza

è pubblica e non privata … I concetti e i procedimenti adoperati anche dal più

intuitivo dei sociologi, devono essere standardizzati, e i risultati delle loro intuizioni

debbono poter essere verificati anche da altri» (Merton 1968, trad. it. 1994, p. 119)

«Pubblicità, Controllabilità, Ripetibilità l’unica possibile oggettività della conoscenza

sociologica» [Statera 1984, p. 250]

• La cumulatività: la scienza è accumulazione sistematica di conoscenza. «Se ho

visto più lontano è perché stavo sulle spalle di Giganti» [Isaac Newton]

La ricerca empirica dell’approccio quantitativo per poter essere definita scientifica deve

soddisfare cinque requisiti (metodo scientifico):

• Ripetibilità

• Controllabilità

• Pubblicizzazione delle procedure di ricerca

• Ispezionabilità della base empirica

• Impiego della statistica

Esiste un percorso “tipico” della ricerca quantitativa che parte dalla teoria, attraversa le fasi

si raccolta e analisi dei dati e ritorna alla teoria. Più precisamente, si possono individuare cinque

fasi e cinque processi che le legano.

La prima fase è quella della teoria, la seconda quella delle ipotesi, legate tra di loro attraverso il

processo della deduzione. La teoria è generale mentre l’ipotesi ne rappresenta un’articolazione

specifica. La terza fase è quella della raccolta dei dati, a cui si arriva attraverso il processo di

operativizzazione, cioè la trasformazione delle ipotesi in affermazioni empiricamente

osservabili. L’operativizzazione porta alla definizione del disegno della ricerca, cioè di un piano

di lavoro che stabilisce le varie fasi dell’osservazione empirica. La quarta fase è quella

dell’analisi dei dati, preceduta dall’organizzazione dei dati rilevati. Di solito questa fase nella

ricerca quantitativa consiste nella creazione di una matrice di dati. La quinta fase è quella della

rappresentazione dei risultati, a cui si arriva tramite un processo di interpretazione delle analisi

statistiche condotte nella fase precedente. Infine il ricercatore ritorna alla teoria iniziale tramite

un processo di induzione, che confronta i risultati ottenuti con la teoria precedente.

16

Il processo di misurazione

La teoria può essere definita come

Insieme di proposizioni organicamente connesse che, si pongono ad un elevato livello di astrazione e

generalizzazione rispetto alla realtà empirica, le quali sono derivate da regolarità empiriche e dalle

quali possono essere derivate delle previsioni empiriche (Corbetta, 2003, 18).

Una teoria deve essere organizzata in ipotesi specifiche. L’ipotesi implica una relazione tra due

o più concetti, si colloca a un livello inferiore di astrazione e generalità rispetto alla teoria, e ne

permette una traduzione in termini empiricamente controllabili.

La teoria trascende da specifiche espressioni empiriche sia dal punto di vista concettuale

(astrazione) sia da quello del campo di applicazione (generalizzazioni empiriche). La teoria

nasce ed è confermata/falsificata nella constatazione di ricorrenze nella realtà osservata, ciò

consente di inferire accadimenti in altri e differenti contesti.

È importante la differenza tra generalizzazioni empiriche e teorie: le generalizzazioni

empiriche sono proposizioni isolate che riassumono uniformità relazionali osservate tra due o

più variabili, la teoria nasce quando queste proposizioni sono raccolte e ricondotte a un sistema

concettuale che si colloca ad un livello superiore di astrazione (ad esempio, permette di

avanzare ipotesi in campi diversi e remoti da quelli originari).

In sintesi:

• La teoria è un insieme di proposizioni (relazionali causali/assiomi) connesse tra loro

non in modo gerarchico.

• La proposizione è astratta e generale, essa è il risultato di osservazioni empiriche e

consente di effettuare generalizzazioni.

• Una teoria nasce quando si osservano più generalizzazioni empiriche (scoperta).

• Una teoria è valida solo se è controllabile empiricamente ovvero se è trasformabile in

ipotesi attraverso l’uso dei concetti (rilevati dalla teoria)

• Una teoria scientifica è una rete fluttuante costituita da vari nodi, corrispondenti ai

termini teorici (concetti). La rete è fluttuante, sollevata dal terreno dei fatti (empiria)

ma è saldamente e sempre collegata ad esso attraverso fili (asserti) ovvero le regole di

corrispondenza tra i termini teorici e i termini osservativi che però esplicitano solo in

modo parziale il significato dei primi e attraverso uncini (controllo empirico).

La validità di una teoria dipende, quindi, dalla sua traduzione in ipotesi empiricamente

controllabili, perché se una teoria è troppo vaga per dar luogo a ipotesi, non può essere

controllata nella realtà. Il criterio della controllabilità empirica o falsificabilità è il criterio stesso

della scientificità. Per spiegare un fenomeno (controllo empirico), la proposizione teorica

(teoria) deve essere articolata in ipotesi specifiche per controllarne la sua validità.

Talvolta la pratica delle ricerca si sviluppa con ordini diversi rispetto a quello canonico: è

possibile che le ipotesi vengano sviluppate dopo aver raccolto i dati, e con questi confrontati a

posteriori. Oppure si ricorre alla teoria dopo aver analizzato i dati, per spiegare un fatto

anomalo o un risultato inaspettato. Infine, una nuova teoria può essere scoperta nel corso della

fase empirica. Talora la rilevazione viene prima della delle ipotesi per ragioni di forza maggiore,

nel caso dell’analisi secondaria, quando cioè si applica una seconda analisi a dati raccolti da altri

ricercatori in tempi precedenti.

L’ipotesi è una proposizione che implica una interconnessione fra due o più concetti (un

nesso causale) legati tra di loro attraverso il processo della deduzione.

L’ipotesi si colloca su un livello inferiore di astrazione e di generalità rispetto alla teoria e

permette una traduzione della teoria in termini empiricamente controllabili, in altre parole, la

teoria è generale mentre l’ipotesi ne rappresenta un’articolazione specifica. Essa è

un’affermazione provvisoria, ancora da provare che deriva dalla teoria e che attende il controllo

empirico per poter essere confermata.

Rispetto alla teoria, l’ipotesi è:

• Meno astratta (più concreta)

• Meno generale (più specifica)

Il processo di misurazione

17

• Più provvisoria (ipoteticità): deriva dalla teoria ma necessità di corroborazione.

L’ipotesi deve essere sottoposta a controllo empirico mediante la raccolta e l’analisi dei dati al

fine di stabilire la relazione esistente (o non esistente) tra due fenomeni

Il controllo empirico è l’adozione rigorosa del metodo e l’uso attento delle tecniche che

corrobora le risposte.

Nel suo significato più ampio, il termine concetto si riferisce al contenuto semantico

(significato) dei segni linguistici e delle immagini mentali. Proprio per questa sua generalità, il

concetto può includere ogni specie di segno o di procedura semantica, astratto, concreto,

universale, individuale, ecc.

Essendo l’ipotesi una interconnessione tra concetti, emerge il fatto che i concetti sono i

“mattoni della teoria”, e attraverso la loro operativizzazione si realizza la traduzione empirica di

una teoria. Il concetto è il legame tra la teoria e il mondo empirico osservabile.

I concetti possono riferirsi ad astrazioni impossibili da verificare empiricamente (potere,

felicità, ecc), oppure a entità concrete (oggetti, persone, ecc).

Ma se i concetti formano una teoria, come si può verificarla empiricamente? Bisogna

operativizzarli ovverosia passare dai concetti astratti alla loro applicazione come proprietà degli

specifici oggetti studiati (chiamati unità di analisi). Una proprietà misurabile di una unità di

analisi si chiama variabile.

Per esempio, il peso è un concetto, ma il peso di un oggetto è la sua proprietà. Il peso

dell’oggetto misurato in chilogrammi con la bilancia è una variabile. Oppure, il livello culturale

è un concetto astratto, ma se applicato a un individuo diventa una proprietà, e se è misurabile

attraverso la rilevazione del suo titolo di studio è una variabile.

La terza fase consiste nella raccolta dei dati (informazioni) attraverso l’utilizzo di specifiche

tecniche di raccolta. A tale fase si arriva con il processo di operativizzazione ovvero con la

trasformazione delle ipotesi in affermazioni empiricamente osservabili. L’operativizzazione

porta alla definizione del disegno della ricerca, cioè di un piano di lavoro che stabilisce le varie

fasi dell’osservazione empirica.

La raccolta dei dati è preceduta dalla predisposizione degli strumenti e sperimentazione sul

campo (pre-test), dall’individuazione delle fonti e dal campionamento.

L’analisi dei dati richiede l’organizzazione dei dati rilevati (codifica e la registrazione dei dati)

per essere analizzati. L’organizzazione dei dati quantitativi consiste nel trasferire le

informazioni in una matrice rettangolare di numeri, la matrice dei dati, detta anche matrice casi

per variabili. La matrice ottenuta è il punto di partenza per l’analisi dei dati, cioè delle

elaborazioni statistiche condotte.

L’ultima fase è la presentazione dei risultati, a cui si arriva tramite un processo di

interpretazione delle analisi statistiche condotte nella fase precedente; il ricercatore ritorna alla

teoria iniziale tramite un processo di induzione, che confronta i risultati ottenuti con la teoria di

partenza per arrivare a una sua conferma o riformulazione. La presentazione dei risultati

prevede la generalizzazione limitata a tempo e spazio.

La valutazione può avvenire ex ante (relazione tra variabili) o ex post (valutazione dei

cambiamenti).

In conclusione, la validità di una teoria dipende dalla sua traduzione in ipotesi empiricamente

controllabili; l’ipotesi, a sua volta, è una proposizione che implica una interconnessione fra due

o più concetti (un nesso causale) legati tra di loro attraverso il processo della deduzione.

Per questo motivo, una volta identificata l’ipotesi è necessario procedere a una riduzione della

complessità della realtà, definendo, innanzitutto, i concetti che costituiscono l’ipotesi

specificandone le proprietà e gli oggetti ai quali tali proprietà afferiscono. Ciò consente di

identificare gli “strumenti” empirici utili alla raccolta (casi e variabili) e all’elaborazione dei dati

(matrice dati).

18

Il processo di misurazione

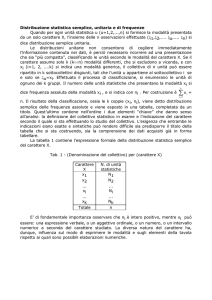

1.2 Definizione e classificazione delle variabili

La statistica, nella sua veste di scienza descrittiva, utilizza le informazioni derivanti da

un’indagine compiuta su una popolazione di soggetti per darne una rappresentazione globale,

il più possibile esaustiva e, allo stesso tempo, parsimoniosa. A questo scopo, la statistica si

avvale delle informazioni derivanti da certi caratteri (o variabili statistiche) che si manifestano

sui soggetti di interesse. Per una migliore comprensione degli strumenti statistici che verranno

presentati successivamente, si considerino le seguenti definizioni:

ü Unità statistica: è il soggetto elementare dell’indagine statistica per la sua appartenenza a

una popolazione di interesse (ad esempio, in un’indagine sul gradimento di un servizio, la

popolazione obiettivo sarà costituita da tutti gli utenti e ognuno di essi rappresenterà

un’unità statistica).

L’unità di analisi rappresenta l’oggetto al quale afferiscono, nella ricerca empirica, le

proprietà studiate. Esse devono essere determinate con precisione nel momento in cui si

vuole sottoporre a controllo empirico una teoria mediante una specifica ricerca di tipo

quantitativo, in quanto sono un elemento importante del disegno della ricerca (il

programma di lavoro empirico). Le unità di analisi possono essere concretamente

rappresentate dall’individuo (la più comune), dall’aggregato di individui (di solito basate

sulla territorialità), dal gruppo-organizzazione-istituzione (quando l’unità di rilevamento è

rappresentata dal collettivo stesso), dagli eventi sociali (quando gli eventi stessi sono le

unità di analisi) e dalle rappresentazioni simboliche – prodotto culturale (quanto l’unità di

analisi consiste da messaggi di comunicazione).

L’unità di analisi è singolare e astratta, mentre chiamiamo casi gli esemplari specifici di

quella data unità di analisi che vengono studiati, sui quali si rilevano i dati. Essi sono gli

oggetti specifici della ricerca empirica.

ü Variabile: una variabile è un concetto operativizzato, o meglio la proprietà operativizzata

di un oggetto, in quanto il concetto, per poter essere operativizzato, ha dovuto essere

applicato a un oggetto diventandone proprietà. Un concetto può essere operativizzato in

modi diversi. Le variabili possono variare tra diverse modalità; il caso limite è quello in cui

risulta invariante nello specifico sottoinsieme degli oggetti studiati, nel qual caso prende il

nome di costante. Le variabili possono variare nel tempo, su uno stesso caso (studio

longitudinale o diacronico) oppure fra i casi, nello stesso tempo (studio trasversale o

sincronico). Le variabili possono esser classificate secondo la loro manipolabilità, la

posizione nella relazione causa/effetto, l’osservabilità, il carattere individuale o collettivo e

il trattamento dei loro valori.

§ La prima distinzione è quella tra variabili manipolabili e non manipolabili. Le

variabili manipolabili sono quelle che possono essere modificate dal ricercatore,

viceversa quelle non manipolabili non possono essere controllate. La maggior parte

delle variabili sociali non sono manipolabili, anche se esistono dei casi in cui il

ricercatore può controllarle.

§ La seconda distinzione è quella tra variabili dipendenti e variabili indipendenti. In

una relazione asimmetrica tra due variabili, quando cioè una variabile influenza

un’altra, la variabile indipendente è ciò che influenza (la causa), mentre la variabile

dipendente è ciò che è influenzato (l’effetto). Nel caso in cui le variabili indipendenti

siano più di una abbiamo una relazione multivariata.

§ La terza distinzione è quella tra variabili latenti e variabili osservate. La distinzione

si basa sulla osservabilità, ossia sulla possibilità di rilevazione empirica. Le prime sono