CLASSE : VA E.T.A.

ALUNNO: Bovino Silvano

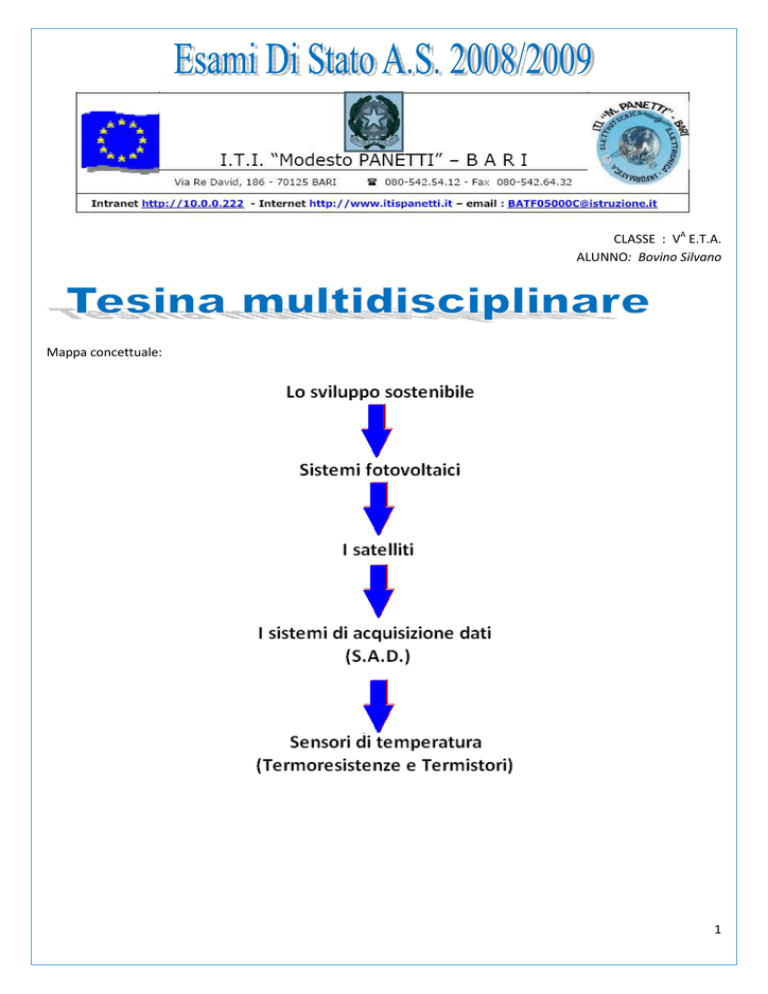

Mappa concettuale:

1

Percorso disciplinare

Percorso di Italiano e Storia:

Lo sviluppo sostenibile

• Le problematiche derivate dal consumismo:

o Problema demografico

o Inquinamento delle acque e del suolo

o Deforestazione

o

Calamità naturali

• Le principali problematiche ambientali:

o Effetto serra

o Buco dell'ozono

• Le soluzioni al problema ambientale:

o L'orientamento verso lo sviluppo sostenibile

o La conferenza di Kyoto del 1997 e i numerosi vertici sulla questione ambientale

o La politica del risparmio energetico

Percorso di telecomunicazioni:

I satelliti

•

•

•

•

•

Sistemi satellitari in orbita;

Progetti Italiani nel campo satellitare;

Bande di frequenza dei sistemi satellitari;

Satelliti geostazionari;

Strumenti di bordo dei satelliti:

o Pannelli fotovoltaici

o Sistema di alimentazione

o Trasponder

• Tecniche di multiplazione dei canali satellitari;

• Applicazioni dei satelliti:

o Sistema GPS

o Satelliti Meteorologici

2

Percorso di sistemi:

Sistemi di acquisizione dati(S.A.D)

•

•

•

•

•

•

•

•

Definizione di sistema di acquisizione dati;

Schema a blocchi di un sottosistema di misura;

Circuito di rilevamento;

Caratteristiche e classificazione dei trasduttori;

Circuito di condizionamento;

Circuito di Sample/Hold;

Convertitore ADC;

Sistemi multicanale.

Percorso di T.D.P. :

Sensori di temperatura

Termoresistenze e Termistori

• Cenni teorici sui sensori e i trasduttori;

• Termoresistenze;

• Termistori.

Percorso di Diritto:

L’attività economica e l’azienda

• Definizione di attività economica;

o Le fasi dell’attività economica;

o Obbiettivi e fasi dell’attività economica;

• Concetto di azienda;

o Elementi costitutivi di un azienda

3

CLASSE : VA E.T.A.

ALUNNO: Bovino Silvano

Indice:

1. Definizione di sviluppo sostenibile

2. Le problematiche derivate dal consumismo:

• Problema demografico

• Inquinamento delle acque e del suolo

• Deforestazione

• Calamità naturali

3. Le principali problematiche ambientali:

• Effetto serra

• Buco dell'ozono

4. Le soluzioni al problema ambientale:

• L'orientamento verso lo sviluppo sostenibile

4

• La conferenza di Kyoto e i numerosi vertici sulla questione ambientale

• La politica del risparmio energetico

5

Definizione:

Lo sviluppo sostenibile è una forma di sviluppo che non compromette la possibilità delle future generazioni di

perdurare nello sviluppo, preservando la qualità e la quantità del patrimonio e delle riserve naturali (che sono

esauribili, mentre le risorse sono considerabili come inesauribili). L'obiettivo è di mantenere uno sviluppo economico

compatibile con l'equità sociale e gli ecosistemi, operante quindi in regime di equilibrio ambientale.

Nell’ultimo secolo e in particolare in anni recenti l’attenzione per il problema ecologico si è intensificata. Questo

perché è cresciuto quello che viene definito l’impatto ambientale delle attività umane. Se nei secoli precedenti lo

sviluppo tecnologico e intellettivo dell’uomo aveva consentito un rapporto equilibrato uomo-natura che non

alterasse il mondo naturale, gli eventi dell’ultimo secolo hanno suscitato dei cambiamenti nella società e negli stili di

vita umani introducendo tecnologie e forme di sviluppo ad alto impatto ambientale.

Questo significa che negli ultimi anni lo stile di vita assunto dalla popolazione umana ha influenzato fortemente

l’ambiente naturale del pianeta influenzando sempre più i microequilibri naturali. Per questo motivo al contrario di

quanto avveniva nel passato l’uomo ha iniziato a imporsi sull’ambiente naturale e a modificarlo.

Le possibilità di dominare la natura e di alterarla si sono moltiplicate enormemente man mano che l’uomo ha

acquisito maggiori conoscenze tecniche ed è riuscito a realizzare armi e strumenti sempre più innovativi e potenti,

talvolta distruttivi. Tuttavia il problema ecologico non deriva dai mezzi di cui l’uomo ha potuto disporre ma al

contrario l’uso che l’uomo stesso ha fatto di questi ultimi.

Con l’avvento della odierna società basata sul sistema economico e commerciale gli stili di vita umani mirano sempre

più alla ricerca di uno sviluppo

obbiettato al profitto piuttosto che

alla sopravvivenza o soddisfazione

dei veri bisogni della società. La

società del consumismo che ne è

derivata ha promosso settori

industriali per ottenere maggiori

profitti

trascurando

quelli

socialmente più utili e meno

inquinanti. Soltanto dopo ci si è

accorti che le risorse naturali non

sono inesauribili, ma limitate e non

rinnovabili se non in tempi

lunghissimi.

Solo in tempi recenti inoltre ci si è

resi conto che la natura non è in

grado ad oggi di sopportare tale sfruttamento derivato dallo stile di vita consumistico.

Nonostante ciò il progresso di un paese e l’efficienza del suo sistema produttivo è ancora oggi valutato in base alla

sua capacità di imporsi sui mercati internazionali.

L’orientamento verso uno sviluppo in questo senso ha causato nel giro di pochi anni, la distruzione di ingenti

giacimenti di materie prime e un incremento esponenziale dei livelli di inquinamento.

6

L’insieme di tali fattori ha causato nel giro di pochi anni la morte di milioni di persone, il problema della

deforestazione, l’incremento dei disastri naturali e della loro distruttività, l’estinzione del 10% delle specie animali e

vegetali e tanti altri problemi che magari non sono stati ancora collegati al problema dell’inquinamento. Le maggiori

preoccupazioni che affliggono gli esponenti politici mondiali e della scienza e che evidenziano il difficile momento

attraversato dal nostro pianeta sono:

•

Il problema demografico

•

Degrado ambientale: Inquinamento delle acque e del suolo

•

Deforestazione

•

Calamità naturali

•

Effetto serra

•

Il buco nell’ozono

PROBLEMA DEMOGRAFICO:

Alla nascita di Cristo si contavano circa 350 milioni di unità umane sulla terra. Alla fine del XVIII secolo si contavano

invece 1 miliardo di esseri umani, 2 miliardi nel 1930, 5

a metà degli anni ’80, 6 nel 2000 e, secondo le stime

ONU ben presto si conteranno 8 miliardi di esseri umani.

Questa crescita esponenziale verificatasi negli ultimi

secoli si è tradotta in un aumento delle richieste di cibo

e dei bisogni con un conseguente incremento della

richiesta di risorse naturali e materie prime. E’ da

evidenziare però che l’incremento demografico si

diversifica a seconda delle aree geografiche del pianeta.

In generale però si nota come la crescita sia stata

enorme soprattutto nei paesi sottosviluppati mentre in

quelli sviluppati(o industrializzati) è quasi statica.

Nonostante ciò,sono proprio i paesi sviluppati ad essere i maggiori colpevoli del degrado delle risorse ambientali.

Alcuni dati pratici ci illuminano su quest’ultimo aspetto. Si consideri infatti che un cittadino europeo consuma in

media 400 litri d’acqua contro i soli 50 di un cittadino di un paese emergente. Negli stati uniti si stima che per ogni

cittadino siano necessari ben 800 litri d’acqua al giorno, distribuiti tra il fabbisogno personale e i consumi

civili(piscine, irrigazione pubblica etc….). I dati riguardanti il consumo d’acqua suggeriscono analoghe considerazioni

riguardo i consumi di petrolio, produzione di rifiuti e inquinamento e quindi emissioni di anidride carbonica, molto

più elevati come al solito, nei paesi industrializzati.

INQUINAMENTO DELLE ACQUE E DEL SUOLO

Il danno più considerevole arrecato dall’uomo alla natura è proprio quello dell’inquinamento. Tale problema si

traduce in vari aspetti e quindi tipologie di inquinamento. Uno di quelli che desta maggiori preoccupazioni è quello

che riguarda le acque del pianeta. I rifiuti cittadini, gli scarichi industriali, l’insensibilità per la questione del riciclaggio

hanno fatto si, che nel giro di pochi anni, si accumulassero enormi quantitativi di sostanze e materiali inquinanti nei

mari del nostro pianeta. Se le acque risultano inquinate ne deriva che lo sia anche il cibo e l’acqua che beviamo. Non

solo, il rischio più elevato riguarda anche gli esseri viventi che popolano le acque marine. La presenza elevata di

fosfati e nitrati, immessi attraverso gli scarichi industriali, nelle acque ha provocato il fenomeno dell’eutrofizzazione

ossia un eccessivo nutrimento di alghe e flora marina. La conseguenza di tale fenomeno è il consumo elevato di

7

ossigeno, che viene sottratto alla fauna marina e ai microorganismi, come il Plancton, necessari al sostentamento

della maggior parte della fauna acquatica. L’inquinamento

delle acque inoltre costituisce una minaccia diretta per il

suolo, sempre più inquinato dai fertilizzanti e sostanze

chimiche usate nell’agricoltura e addirittura talvolta

soggetto alle radiazioni nucleari che ne compromettono la

produttività per lunghissimi periodi di tempo con seri

danni all’agricoltura e rischi per la salute. L’esempio più

eclatante fu quello della centrale di Chernobyl in Ucraina,

dove un danno ai reattori provoco la fuoriuscita di

sostanze radioattive. La nube radioattiva si diffuse su gran

parte dell’Europa, provocando decine di vittime e paurosi

effetti sulla salute dei neonati, generati con anomalie di

carattere genetico ricollegabili direttamente a tale evento.

Se il disastro di Chernobyl rappresenta l’esempio maggiore dei pericoli del nucleare è anche vero che ad oggi si

contano nel mondo episodi analoghi di minore intensità e che hanno provocato in ogni caso l’inquinamento di interi

ettari di suolo.

Deforestazione:

La crescita delle richieste di materie prime si è tradotta in un aumento della richiesta di legname. Per questo motivo

la deforestazione, cioè l’abbattimento nel giro di un breve periodo di tempo di interi ettari di foreste, è cresciuta a

ritmi elevatissimi. Le stime in merito parlano di un ritmo di circa 11 milioni di ettari di foreste, abbattute in un anno.

E’ come se in un solo anno, una foresta che si estende su una superficie pari alla Grecia, venisse abbattuta. Il

fenomeno è accentuato soprattutto nelle zone tropicali ed in particolare in Amazzonia, dove l’omonima foresta

Amazzonica, rischia di scomparire entro i prossimi anni. Nell’immagine si nota il ritmo con il quale procede

l’abbattimento degli alberi in queste zone:

In questo modo viene meno l’azione fondamentale svolta dagli alberi nella protezione del suolo da frane e

straripamento delle acque. I disastri naturali collegati a tale fenomeno sono cresciuti negli ultimi anni in maniera

proporzionale ad esso. In Italia, ad esempio, si contano tantissimi casi di alluvioni e allagamenti che sarebbero potuti

essere evitati attraverso la conservazione dello scenario naturale e delle foreste, abbattute in maniera scriteriata per

dar spazio alle costruzioni, talvolta abusive. Casi come quello dei paesi di Quindici e Lauro, in provincia di Avellino e

Siano, Bracigliano e Sarno in provincia di Salerno sono una testimonianza della forza distruttiva delle acque, causata

8

dalla mancanza di un adeguata vegetazione. In secondo luogo la riduzione delle aree “verdi del pianeta” contribuisce

all’innalzamento dei livelli di anidride carbonica, in quanto una delle funzioni naturali svolte dagli alberi è proprio

quella di assorbire anidride carbonica per svolgere alcuni processi fondamentali come la fotosintesi.

Calamità naturali:

Sebbene inizialmente la maggior parte delle calamità vengano definite fenomeni naturali, spesso queste sono

direttamente collegate all’inquinamento. Difatti alcuni studi

hanno dimostrato che l’alto tasso di inquinamento insieme ai

comportamenti irresponsabili dell’uomo ha contribuito negli

ultimi anni ad aumentare la frequenza e l’intensità di questi

eventi catastrofici.

Un esempio è quello dei terremoti. Questi fenomeni sono

provocati dal continuo movimento delle placche terrestri. Nel

momento in cui le enormi masse terrestri vengono a contatto

tra loro o si verifica una fase di instabilità, il terremoto è la

conseguenza di tale situazione. L’intensità dei terremoti è

aumentata nell’ultimo periodo a causa di diversi motivi. In

primo luogo vi è la costruzione scriteriata di abitazioni in

luoghi sismici; in secondo luogo vi è l’inadeguatezza e la scarsa qualità dei materiali di costruzione utilizzati per gli

edifici. In ultimo il continuo assorbimento di risorse dal sottosuolo, come il petrolio, i gas, il metano, hanno

provocato situazioni di instabilità, tali che un piccolo terremoto provocherebbe crolli ed effetti inimmaginabili.

Un altro problema legato alle azioni dell’uomo è quello delle piogge acide. Tale fenomeno è provocato nei paesi

industrializzati dall’emissione di sostanze come l’anidride solforosa e l’ossido di azoto. Il risultato è che tali sostanze,

combinandosi con la particelle di vapore acqueo nell’atmosfera, si riversano al suolo sottoforma di precipitazioni. Le

piogge acide sono responsabili dell’erosione dei monumenti artistici, degli edifici ed inoltre privano il terreno di

sostanze nutritive, provocando la morte di foreste, l’inquinamento dei laghi e la scomparsa di alcune forme di vita.

Ennesimo problema è rappresentato dagli tsunami, dirette conseguenze di terremoti con epicentro in mare. Lo

tsunami è un sistema complesso di onde che raggiunge gli 800Km di velocità con una lunghezza d’onda di 200Km.

Uno dei più violenti tsunami si abbatté nel 2004 sulle coste di alcuni paesi asiatici(Sri Lanka, Indonesia, India;

Thailandia) provocando migliaia di vittime e danni per milioni di dollari.

Anche nel caso degli Tsunami è riconosciuta la responsabilità dell’uomo. Infatti l’inquinamento delle acque insieme

all’aumento delle temperatura ha contribuito al

degrado delle barriere coralline, strutture calcaree

che hanno la funzione di proteggere le coste.

Un ultimo fenomeno in cui è riconosciuta la non

estraneità dell’uomo è quello degli uragani, definiti

per eccellenza spettacolari ed alquanto distruttivi

fenomeni naturali. Anche in questo caso i

cambiamenti climatici provocati dall’inquinamento

hanno accresciuto l’intensità e la frequenza di tali

fenomeni. Gli uragani sono la conseguenza

dell’evaporazione-condensazione dell’aria umida in

corrispondenza delle zone dove si è registrato un

aumento della temperatura. Secondo alcuni studiosi, l’aumento delle temperature medie del pianeta ha accresciuto

9

la frequenza degli uragani e alcuni sostengono addirittura che la loro frequenza è direttamente proporzionale alla

quantità di gas serra presente nell’atmosfera.

Le problematiche maggiormente rilevanti:

Queste che abbiamo elencato sono solo alcune delle problematiche legate al comportamento

irresponsabile dell’uomo. Lo sviluppo legato al consumismo ha generato oltre a queste, 2 problematiche

maggiormente rilevanti. Alla loro risoluzione è legato il futuro del nostro pianeta:

Il primo grave problema è l’effetto serra. Questi è un fenomeno naturale che contribuisce alla regolazione

della temperatura del pianeta. L’anidride carbonica presente nell’atmosfera contribuisce

all’intrappolamento della giusta quantità del calore dei raggi solari. Se tale fenomeno non si verificasse la

temperatura della terra sarebbe più bassa di 30-40o e la vita non sarebbe possibile. Negli ultimi anni però si

sono registrate delle anomalie in questo processo naturale, causate in sostanza dalla presenza eccessiva di

anidride carbonica( e di altri gas ad effetto serra), nell’atmosfera, il che ha modificato gli equilibri termici

del pianeta. L'interferenza dei gas serra alla dissipazione della radiazione infrarossa comporta

l'innalzamento della temperatura superficiale fino al raggiungimento di un punto di equilibrio tra

radiazione solare in arrivo e infrarossa in uscita.

La presenza eccessiva di gas serra nell’atmosfera ha provocato un innalzamento delle temperature medie

del pianeta con effetti che potrebbero rivelarsi catastrofici se non saranno elaborate delle valide soluzioni.

Nell’immagine che segue si possono notare alcune delle cause dell’effetto serra ed in particolare

dell’aumento di gas serra.

10

Il secondo grave problema è la riduzione dello strato di ozono registrata negli ultimi anni dai laboratori

NASA. Come per i gas serra, l’ozono è un elemento dell’atmosfera essenziale per la vita ma anch’esso

svolge il suo ruolo benefico solo in determinate condizioni. Fino a qualche decennio fa lo strato di ozono

era presente nella nostra atmosfera in quantità ideali e così è stato per milioni di anni. Come si osserva

nella figura seguente però negli ultimi anni si è registrato un assottigliamento dello strato di ozono che si

manifesta ancor più in maniera evidente in Antartide dove i venti polari accentuano tale carenza.

Nella figura le rilevazioni effettuate a distanza di 6 anni l’una dall’altra, rivelano la diradazione graduale

dello strato di ozono.

Secondo gli scienziati, alcune sostanze chimiche sono le principali responsabili del problema. Queste

sostanze chimiche sono dette "sostanze che consumano l' ozono" ( ODS, Ozone Depleting Substancies) e

comprendono molti gas contenenti cloro o bromo, come : i clorofluorocarburi (CFC) , che contengono

cloro, fluoro e carbonio, usati nei frigoriferi e come agenti espandenti nelle schiume; gli "Halons", usati

come antifiamma; il bromuro di metile, usato in agricoltura.

Tali sostanze sono emesse quotidianamente nell’atmosfera in quanto l’attuale stile di vita umano ne

richiede l’utilizzo(Si veda il caso dei CFC emessi dai frigoriferi).Gli effetti che ne derivano sono tutt’altro che

ignorabili. Nella tabella seguente si può notare come le emissioni di C02 derivano dall’utilizzo di materiali

che vengono quotidianamente consumati dalla nostra società:

11

La riduzione dello strato di ozono causerà un incremento delle radiazioni UV a livello del suolo. Un eccesso

di raggi UV è stato associato a bruciature della pelle, cancro della pelle, cataratte, e danni ad alcune

tipologie di raccolti agricoli e agli organismi marini.

Un modo di vivere compatibile con l’ambiente: LO SVILUPPO SOSTENIBILE

Questi motivi abbastanza convincenti, hanno spinto alcuni esponenti della politica e dell’economia

mondiale ad orientarsi su un nuovo tipo di sviluppo, abbandonando difatti gli stili di vita consumistici e

dannosi effettuando una svolta sullo sviluppo sostenibile. Lo sviluppo sostenibile si basa sull’idea che non è

possibile ritornare indietro rinunciando agli standard di vita del nostro secolo, ma piuttosto è necessario

trovare un compromesso. Lo sviluppo sostenibile si basa dunque sull’idea di una produzione e una crescita

economica compatibile con l’ambiente, cioè un consumo delle risorse naturali disponibili senza

comprometterne l’uso alle future generazioni. Questo richiede d’altra parte una modifica delle logiche

industriali, con l’ideazione di produzioni mirate e programmate di beni senza danneggiare l’ambiente. Le

soluzioni più accreditate sono una maggiore politica di riciclaggio delle materie prime e dell’energia e

l’utilizzo delle fonti rinnovabili.

A questo proposito in anni recenti si sono svolte importanti manifestazioni e campagne di sensibilizzazione

al problema ambiente. L’ONU ha indetto la giornata internazionale dell’ambiente, che si tiene ogni 5

Giugno. Il 5 Giugno del 2007 fu varato lo slogan “Ghiaccio che si scioglie, terra che scotta”, volto a

sottolineare gli effetti disastrosi dei cambiamenti climatici. Un'altra campagna indetta il 5 Giugno è stata

“Una pianta per il pianeta” con la quale si incoraggiavano giovani e meno giovani a piantare alberi con

l’obbiettivo di far crescere almeno 1 miliardo di alberi nel 2007. Anche i governi hanno risposto

positivamente ed in particolare il comune di Roma si prefisse di raddoppiare il verde urbano nel giro di 5

anni.

Il protocollo di Kyoto

12

Dato che la risoluzione del problema è legata maggiormente a scelte politiche ed economiche e ad

interventi tecnici e finanziari che spettano solo ai governi, a partire dal 1989 la Comunità internazionale ha

indetto numerose conferenza per prendere delle decisioni per la risoluzione di tale problema ambientale.

Inizialmente nessuna di queste conferenze produsse alcun risultato, anzi si poté assistere a discussioni

furibonde tra i vertici dei vari paesi.

Uno scatto che riprende un vertice tra i rappresentanti delle nazioni mondiali

La conferenza tenutasi a Kyoto nel 1997 sortì i primi risultati positivi. A tale conferenza parteciparono i

vertici di 170 paesi e aveva come obbiettivo principale la riduzione dei gas serra prodotti dal’uso di

combustibili fossili. Anche in questo caso, non mancarono le polemiche e le discussioni in particolare tra i

paesi Europei e gli USA. Gli Stati Uniti, considerati i maggiori responsabili delle emissioni inquinanti,

rifiutavano di provvedere alla riduzione di gas serra in quanto ciò avrebbe provocato seri danni alla loro

economia.

Gli Europei invece proponevano una riduzione del 15% delle emissioni inquinanti. Alla fine si raggiunse un

compromesso:

I paesi industrializzati avrebbero provveduto a ridurre le emissioni di gas serra del 5,2% entro il 2012.

Inoltre fu deciso che tutti i paesi partecipanti alla conferenza avrebbero ratificato ufficialmente entro il

2002 e solo quando il 55% dei paesi rappresentanti il 55% delle emissioni avrebbe ratificato la loro

adesione , il protocollo sarebbe divenuto valido.

Moltissimi movimenti ambientalisti tra cui il WWF e Greenpeace sottolinearono a ragione che il 5,2% era

insufficiente per salvare il pianeta dal disastro annunciato.

Nonostante ciò, nelle successive conferenze sul clima molti paesi si coalizzarono manifestando la loro

decisione di non aderire o piuttosto far si che fossero soprattutto gli altri a risolvere il problema. Si

formarono quindi 2 schieramenti: da una parte i paesi Europei insieme ai meno industrializzati che avevano

deciso di aderire al protocollo di Kyoto in tutte le sue clausole, dall’altra gli Stati Uniti, il Canada, Nuova

Zelanda, lo stesso Giappone, Cina, Australia che si opponevano nel timore che l’adesione al protocollo

avrebbe provocato delle considerevoli perdite economiche.

13

In particolare gli Stati Uniti sostenevano che i tagli alla loro produzione di CO2 dovevano essere ridotti in

quanto essi erano pronti a finanziare progetti antinquinamento nei paesi in via di sviluppo. Inizialmente

l’Europa si oppose sottolineando che l’inquinamento dei paesi in via di sviluppo era molto minore di quello

Americano. Successivamente nel 2001 il presidente americano Bush manifestò la volontà di non aderire al

protocollo di Kyoto in nessuna delle sue parti.

Le intense polemiche portarono finalmente ad un compromesso, proposto dall’unione Europee. La

riduzione delle emissioni inquinanti sarebbe stata valutata sia attraverso la riduzione diretta dei gas serra

emessi nell’atmosfera sia indirettamente attraverso i finanziamenti verso i paesi sottosviluppati per la

costruzione di dispositivi antinquinamento. Aderirono in virtù di tale compromesso il Canada e il Giappone

mentre ancora una volta gli Stati Uniti si isolarono dal gruppo.

Nel 2002 a Johannesburg, un'altra conferenza sullo sviluppo sostenibile ebbe esiti negativi in merito

all’adesione degli USA che rifiutarono l’adesione a tutti gli argomenti di discussione tra cui la riduzione

dell’emissioni dei gas serra, i contributi per l’aumento della quantità di acqua potabile, per la riduzione

delle infezioni da HIV.

Stesso risultato fu sortito nel 2003 nella conferenza internazionale sul clima tenutasi a Milano tra l’1 e il 12

Dicembre, durante la quale gli Stati Uniti confermarono il loro pensiero in merito alla questione

ambientale.

Finalmente nel 2004, con l’adesione della Russia fu raggiunto il fatidico 55%, che rese a tutti gli effetti

operativo il protocollo di Kyoto, tanto che il 16 Febbraio 2006 esso divenne finalmente legge. Durante i

successivi vertici tenutisi tra il 2005 e il 2006 si discusse molto sul rendere vincolanti o volontarie le

riduzioni di gas serra. Ovviamente gli Stati Uniti optavano per la seconda possibilità e le discussioni furono

rinviate al 2008.

Per quanto concerne l’Italia, la risposta al protocollo fu più che positiva, tant’è che il ministro dell’ambiente

invitò le industrie Italiane, in particolar modo quelle del settore termoelettrico ad attuare una riduzione

del 10% delle emissioni inquinanti entro il 2008.

In totale, ben 141 paesi aderirono al protocollo in tutte le sue parti.

Il fondamentale vertice del 2007:

14

Nel 2007 durante il consiglio dei capi di stato e di governo dei 27 paesi membri della UE, presieduto dalla

cancelliera tedesca Angela Merkel sono stati raggiunti importanti accordi in merito alla questione

ambientale. Durante la riunione è stata confermata la volontà dell’Unione Europea di fare da guida

mondiale nella campagna contro l’inquinamento ed il surriscaldamento del pianeta. Sono stati inoltre

definiti i tetti massimi di emissioni inquinanti a seconda delle necessità e della situazione dei singoli paesi.

Inoltre finalmente durante l’incontro del G8 svoltosi a Giugno in Germania, gli Stati Uniti si sono dimostrati

favorevoli alla proposta di ridurre del 50% il totale delle emissioni inquinanti entro il 2050.

Il percorso per giungere a tale risultato è stato molto lungo. Difatti le tappe per l’adesione ad uno sviluppo

sostenibile sono state numerose. Di seguito sono elencati cronologicamente gli eventi principali che hanno

anteceduto la conferenza di Kyoto e che hanno permesso nel loro insieme di formare un consiglio di

nazioni unito per la risoluzione del problema ambientale:

•

•

•

•

•

•

•

•

•

•

•

Nel 1972 si tenne “La conferenza di Stoccolma”. Questa città è stata la prima che ha toccato i temi

ambientali ed ha inoltre adottato una “dichiarazione” all’interno della quale si propone la salvaguardia

dell’ambiente.

Nel 1979 a Ginevra viene firmata la convenzione sull’inquinamento atmosferico regionale per affrontare

problemi legati all’ acidificazione, eutrofizzazione e smog.

1987 protocollo di Montreal: coinvolge i paesi per diminuire lo sfruttamento dell’ozono stratosferico.

1989: Convenzione di Basilea sottoscritta per eliminare rifiuti dannosi.

1992 Rio de Janeiro: conferenza mondiale sull’ ambiente e lo sviluppo --> approvazione della dichiarazione di

Rio sull’ ambiente e lo sviluppo.

Proprio nel XXl sec. Si e ritenuto opportuno creare un documento inerente le proposte e gli obbiettivi da

raggiungere per l’ambiente: L’agenda 21 delle nazioni unite è stata costituita da 170 Paesi di tutto il mondo e

provvede a stabilire i programmi e le attività per lo sviluppo sostenibile.

In Italia si è concretizzata nel 1994, in seguito alla conferenza di Aaalborg in Danimarca. Da qui nasce inoltre

la “CAMPAGNA EUROPEA: CITTA’ SOSTENIBILE”; le diverse città che hanno aderito a questa campagna ne

stanno promuovendo altre per attuare diverse strategie ecologiche nel proprio territorio.

1993: Convenzione sulla diversità biologica --> protezione di animali e vegetali.

1997: Conferenza di Kyoto.

2001: Convenzione di Stoccolma --> eliminazione di inquinanti organici non degradabili.

2002: Johannesburg --> Summit mondiale sullo sviluppo sostenibile: vengono messi a fuoco problemi sociali

ed economici.

2006: Entra in vigore il protocollo di Kyoto che diviene legge per i paesi aderenti

Lo sviluppo sostenibile si realizza con comportamenti responsabili e

con la ricerca e l'applicazione di TECNOLOGIE per L'AMBIENTE:

•

•

•

•

la difesa delle risorse naturali;

le fonti di energia rinnovabile;

la riduzione dell’ inquinamento;

il riciclaggio dei rifiuti.

Argomento di discussione delle ultime conferenze sull’ambiente ha riguardato anche l’introduzione della

politica sul risparmio energetico dove per risparmio energetico non si intende esclusivamente la riduzione

degli sprechi energetici ma si intende in maniera più accentuata la ricerca di tecnologie e sistemi in grado

di ridurre il consumo di energia a parità di produzione.

Questo implica la ricerca di tecnologie che permettano la produzione di energia in modo più efficiente ed

evoluto. In altre parole si vuole ottenere gli stessi risultati a parità di una produzione minore di energia.

15

Emblema di tale politica è l’esempio delle lampadine fluorescenti moderne che consentono un

illuminazione maggiore rispetto alle vecchie lampadine consumando inoltre meno energia. La seconda

soluzione è la ricerca di fonti rinnovabili in grado di sostituire quelle inquinanti e limitate per ottenere

energia in modo pulito e senza limiti nel tempo.

Tra i dispositivi in grado di fornire energia elettrica ottenuta da fonti rinnovabili vi sono:

•

•

•

•

•

•

Impianti fotovoltaici

Impianti eolici

Impianti solari

Centrali a biomassa per produzione energia elettrica e/o termica

Centrali idroelettriche

Centrali di combustione biogas

Tra quelli citati i sistemi su cui si basa tuttora l’attenzione dei maggiori produttori di energia, sono i sistemi

fotovoltaici. Questi sistemi sono valorizzati in quanto sfruttano una energia naturale di tipo illimitato e

soprattutto maggiormente costante e subito disponibile rispetto alle altre.

CLASSE : VA E.T.A.

ALUNNO: Bovino Silvano

Progetto personale

16

• Definizione

• Funzionamento

• Caratteristiche I-V del generatore fotovoltaico

• Efficienza dei fotovoltaici e parametri:

1. Radiazione solare

2. Temperatura

3. Inclinazione

4. Orientamento

5. Fattore di albero

6. Ombreggiamento

7. Tipologia dei moduli fotovoltaici

8. Tipologia dell’installazione

• Costo di un impianto

17

Definizione:

Si definisce impianto fotovoltaico un sistema in grado di convertire l’energia solare in energia elettrica.

I vantaggi di tale impianto sono:

• Non inquinano

•

minimo rapporto massa/energia

• Contributo in conto energia per 20 anni;

• Costi di esercizio e manutenzione dell’impianto molto contenuti;

• Alta affidabilità dell’impianto in quanto non esistono parti in movimento;

• Possibilità di accesso a strumenti di finanziamento;

•

Possibilità di aumentare successivamente il numero dei moduli (modularità del sistema);

•

Utilizzo di superfici marginali o altrimenti inutilizzabili;

Gli Svantaggi invece sono:

• Investimento iniziale molto elevato;

•

Necessità di avere a disposizione un’elevata superficie rispetto alla potenza installata ( circa 10 m2

per ogni kWp installato);

• Variabilità ed aleatorietà della fonte energetica (irraggiamento solare).

Una persona che decide di investire nel fotovoltaico deve considerare tali elementi. Per prima cosa è

necessario considerare che tipo di applicazione progettare e verificare teoricamente la produttività

energetica dell’impianto. In base a quest’ultimo dato si può di conseguenza valutare il periodo di

ammortamento dell’investimento iniziale.

Sulla base di quanto detto è fondamentale quindi valutare la produttività di un impianto fotovoltaico e

considerare quelle che sono le sue applicazioni ideali. Prima di fare questo è necessario conoscere il

principio di funzionamento di un modulo fotovoltaico e comprendere quali elementi influiscono sulla sua

efficienza.

18

Come funziona il fotovoltaico?

Un impianto fotovoltaico è costituito essenzialmente da silicio. La produzione di energia deriva dal

fenomeno secondo il quale se una giunzione fra una piastrina di silicio drogato di tipo p e una drogata di

tipo n, viene esposta al sole e quindi alla radiazione solare, si crea una differenza di potenziale di tipo

continuo tra i 2 strati.

In particolare si viene a creare una differenza di potenziale di circa 0.5V che non dipende dalla superficie

delle celle del modulo fotovoltaico, mentre la corrente di corto circuito dipenderà principalmente dalla

quantità di radiazione solare che investe la cella e quindi dalla sua superficie. Tale fenomeno denominato

appunto “effetto fotovoltaico” deriva dal fatto che le onde elettromagnetiche della radiazione solare

conferiscono sufficiente energia alla cella composta dalla giunzione di silicio PN tale che gli elettroni situati

più esternamente siano eccitati abbastanza da abbandonare l’atomo, passando ad una banda di valenza

più esterna. Se l’energia della radiazione solare è abbastanza elevata da

superare la barriera di potenziale della giunzione si crea così un flusso

continuo di fotoni. La maggioranza di questi fotoni contribuirà alla

produzione di corrente elettrica mentre una parte di essi si ricombinerà

lungo il suo cammino con altre lacune.

Gli impianti fotovoltaici moderni utilizzano come materiale principale il

Silicio poiché questi è largamente disponibile sulla terra ed inoltre è

facilmente reperibile come scarto dell’industria elettronica. I materiali più

utilizzati attualmente risultano:

• Silicio mono, policristallino e amorfo

• Arseniuro di Gallio(Ga-As),(utlizzato per le

applicazioni spaziali)

• Seleniuro di Indio e rame(Cu-In-Se2), il solfuro di

Cadmio e rame, etc…

Il flusso luminoso che investe la cella è costituito da

fotoni di diversa lunghezza d’onda. A seconda della

loro energia essi provocano la liberazione delle coppie

elettrone-lacuna. Da notare che tale effetto si verifica

sia in presenza di raggi diretti che diffusi e riflessi.

Questo è il motivo per cui i sistemi fotovoltaici sono in

grado di funzionare anche nei giorni di meteo

nuvoloso.

19

Caratteristiche I-V del generatore fotovoltaico

Nel momento in cui la cella fotovoltaica elementare è sottoposta all’irraggiamento solare, se si immagina

di collegare ai suoi morsetti di uscita un resistore di resistenza variabile da zero (corto circuito) fino a

infinito (corto aperto), si potranno misurare per ogni condizione di resistenza un valore di tensione e uno di

corrente.

Se si riportano tali valori in un piano cartesiano I-V si ottiene la “caratteristica I-V del generatore

fotovoltaico”

Caratteristica I-V del generatore fotovoltaico

Dall’esame di questa caratteristica si può notare che il generatore non può essere schematizzato né come

un generatore di tensione né di tensione né di corrente, né come un generatore di tensione con in serie

una resistenza interna ,poiché la caratteristica non è una retta.

La caratteristica può essere però suddivisa in tre parti:

•

nella zona “vicina” alla condizione di corto circuito (Tratto AB) la corrente è quasi costante, ovvero si

comporta da generatore di corrente;

•

nella zona “vicina” alla condizione di circuito aperto (Tratto CD) la tensione è quasi costante e in

questo tratto il comportamento è simile a quello del generatore di tensione;

•

nella zona rimanente BC, chiamata anche “ginocchio” per la pronunciata curvatura, il generatore non è

schematizzabile in alcuno dei modi visti e per lo studio delle prestazioni farà uso dei metodi grafici.

20

Per quello che si è già visto, la potenza erogata in un punto della caratteristica è rappresentabile dall’area

che l’ascissa e l’ordinata del punto formano con gli assi cartesiani.

Si nota che il punto di massima potenza si trova nel ginocchio della caratteristica.

Le prestazioni di una cella fotovoltaica sono influenzate prevalentemente dalla temperatura e dalla

“quantità di luce” o “irraggiamento” che investe la cella.

Nella successiva Figura si evidenzia il comportamento di un generatore fotovoltaico alla temperatura

costante di 25° C e con irraggiamento variabile da 100 a 1000W/m2.

Caratteristiche I-V con temperatura di 25° e irraggiamento variabile

Si può notare come la corrente di corto circuito risulti proporzionale all’irraggiamento mentre la tensione a

vuoto varia di molto poco (da 0.5 a 0.6V quando l’irraggiamento aumenta di dieci volte, da 100 a

1000W/m2).

Da ciò consegue che risulta fattibile la misura dell’irraggiamento dalla misura della corrente di corto

circuito di una cella campione (per la quale sia nota cioè con molta precisione la corrente Icc0 relativa ad

una condizione di irraggiamento nota Irrag0); si avrà infatti:

Irragmis = Irrag0 • Iccmis/Icc0

(12)

Per esempio una cella al silicio monocristallino con area pari a 100 cm2 eroga all’irraggiamento di 1000

W/m2 una corrente di corto circuito di circa 3 A; pertanto se viene misurata una corrente Iccmis = 2.4 A la

condizione di irraggiamento sarà di 800 W/m2.

21

Di tutta l’energia che giunge su di un impianto fotovoltaico, le tecnologie odierne permettono di

convertirne il 44%. Questo perché l’efficienza di conversione di una cella è limitata da:

• non tutti i fotoni incidenti sulla cella penetrano al suo interno(alcuni sono riflessi dalla superficie

della cella, altri incidono sulla

griglia metallica dei contatti);

• fotoni che non hanno energia sufficiente per liberare una coppia

elettrone/lacuna;

• una parte degli elettroni “liberati” dai fotoni non arrivano al carico

esterno in quanto trovano lungo il percorso delle cariche di segno

opposto con cui ricombinarsi (effetto di “ricombinazione”);

• esistono le cosiddette “resistenze parassite”: i contatti metallici

posti sul fronte e sul retro della cella presentano una resistenza

che provoca dissipazioni di potenza.

22

Efficienza degli impianti fotovoltaici

L’efficienza del fotovoltaico è legata quindi a:

• Radiazione solare

• Temperatura dei moduli

• Orientamento dei moduli

• Inclinazione dei moduli

• Fattore di albero

• Ombreggiamento

• Tipologia dei moduli fotovoltaici

• Tipologia dell’installazione

Radiazione solare:

Per radiazione solare intendiamo l’energia elettromagnetica emessa dal sole a seguito dei processi di

fusione dell’idrogeno in esso contenuto, e si propaga con simmetria sferica nello spazio. L’unità di misura

della radiazione solare è dunque il Wh/m2.

Per irraggiamento solare invece intendiamo la potenza del campo elettromagnetico incidente sull’unità di

superficie.(W/m2).

Si consideri che un irraggiamento di 1000 W/m2 corrisponde a quello di mezzogiorno in una giornata

serena estiva, mentre quello di 100 W/m2 corrisponde a quello di mezzogiorno in una giornata con cielo

completamente coperto da nuvole bianche.

All’esterno dell’atmosfera tale irraggiamento ha un valore di 1.367 W/m2±3.3%(variazione della distanza

Terra-Sole). Tale valore rappresenta la COSTANTE SOLARE.

A livello internazionale sono stati definiti alcuni indici matematici che definiscono l’irraggiamento solare

terrestre ed extraterrestre:

Indice AM(air mass):funzione dell’angolo di elevazione del sole sull’orizzonte nell’istante considerato.

• AM0: Indice AM valido fuori dall’atmosfera

23

• AM1: Spessore di atmosfera standard attraversato dai raggi solari in direzione perpendicolare alla

superficie terrestre e misurato al livello del mare (1.000 W/m2)

• AM1,5:Standard di riferimento sulla superficie terrestre

Nella zona in cui è valido l’indice AM1,5 si notano attenuazioni e perdite della radiazione solare. Influiscono

su tale fenomeno diversi fattori:

• Assorbimento delle molecole aria, acqua e pulviscolo atmosferico

• Riflessione

Nell’immagine che segue si nota come l’irraggiamento sia influenzato da questo indice e che all’interno

dell’atmosfera questi risulta attenuato(area della zona m=1)

Al contrario di quanto avviene nello spazio quindi, i raggi

solari incontrano, una volta entrati nell’atmosfera terrestre,

diversi ostacoli. Alcuni di questi sono le particelle molecolari

di acqua e i diversi elementi che costituiscono l’atmosfera. Si

deduce quindi che dell’irraggiamento solare complessivo che

raggiunge la terra, solo una parte viene effettivamente a

contatto con la superficie terrestre.

Come si nota nella figura di fianco, l’irraggiamento solare

che

raggiunge

la

superficie

terrestre

dipende

dall’irraggiamento DIRETTO e DIFFUSO:

Irraggiamento solare globale=Diretto+Diffuso

24

Il resto dei raggi solari subiscono riflessione e rifrazione

atmosferica e in parte vengono assorbiti dalla terra.

Gli strumenti a disposizione dei tecnici per effettuare misura

precise dell’energia della radiazione solare incidente nell’unità

di tempo(W/m2), sono il Piranometro e il Solarimetro. Tali

strumenti considerano misurazioni istantanee o sulla base di

medie giornaliere.

Dei 2 strumenti è preferito il Solarimetro, che offre un costo contenuto, una buona precisione nelle

misurazioni con un errore massimo del 5% e una ridotta necessità di calibrazioni.

Nella foto, un esempio di solarimetro:

Temperatura dei moduli:

La temperatura è un parametro estremamente importante in quanto da esso dipende l’efficienza dei

singoli moduli e quindi dell’impianto fotovoltaico.

Se si considera il grafico I-V generato dalla cella fotovoltaica si nota come al variare della temperatura la

corrente I si mantiene quasi costante mentre la tensione V è fortemente influenzata da tale temperatura.

Come si può notare l’aumento di temperatura costituisce una diminuzione della tensione del modulo e di

conseguenza provoca una riduzione della potenza fornita dall’impianto. Per questo motivo in fase di

progettazione è necessario considerare quali saranno le temperature alle quali sarà sottoposto l’impianto.

Si deduce inoltre che a parità di irraggiamento solare, l’efficienza dei moduli subirà delle variazioni nel

corso dell’anno. La stagione in cui il fotovoltaico ha un rendimento più elevato è la primavera in quanto

durante tale periodo le giornate di sole sono caratterizzate da una temperatura ottimale. La giornata ideale

per un impianto, è invece quella del “sole d’inverno” ma come si può immaginare nella stagione invernale

la probabilità di giornate piovose o nuvolose è molto elevata e il rendimento dell’impianto risulta ridotto.

25

Per il silicio cristallino la tensione si riduce del 4 % per 10 °C di aumento della temperatura.

In definitiva la temperatura influenza la tensione mentre l’irraggiamento determina la corrente del

dispositivo fotovoltaico.

Per questo motivo, un altro aspetto da tener conto in fase di progettazione è la temperatura che caratterizzerebbe la

zona di montaggio dei moduli.

ORIENTAMENTO E INCLINAZIONE DEI MODULI:

Ai fini di una maggiore efficienza degli impianti risulta fondamentale scegliere un adatta inclinazione e

orientamento del modulo. Tali fattori sono dipendenti dal luogo di ubicazione cioè di installazione dei

moduli.

Per Angolo di inclinazione di tilt β intendiamo l’angolo di inclinazione del modulo rispetto al piano

orizzontale:

Rispettando le tabelle di inclinazione ottimale dei moduli si è in grado di massimizzare l’irraggiamento

solare diretto. L’angolo di inclinazione dipende anche dalla posizione del sole nel corso delle varie stagioni.

Nel caso di installazioni fisse però è necessario trovare un compromesso e scegliere un anglo di

inclinazione ottimale.

26

Per anglo di orientamento o di azimut α si intende l’angolo di orientazione del piano dei moduli rispetto al

meridiano 0o . Si misura quindi lo scostamento del piano rispetto all’orientazione verso sud(per i siti

nell’’emisfero settentrionale) e verso nord (per i siti nell’emisfero meridionale).

La seguente immagine ci chiarisce quindi quali sono i fattori che individuano il posizionamento del modulo:

A livello internazionale sono stati fissati i valori ottimali di inclinazione(angolo di tilt) e orientamento

(angolo di azimut). Nella tabella seguente si mostrano i valori ottimali di orientamento a seconda

dell’angolo di inclinazione e le conseguenti perdite di efficienza in caso di errata ottimizzazione:

27

Fattore di albero

Un terzo fattore importante nelle valutazioni pre -installazione è il fattore di ALBERO. Tale fattore fa

riferimento alla quantità di radiazioni riflesse che colpiscono il modulo aumentando di conseguenza la

produzione di energia. Tale fattore dipende moltissimo dal tipo di superficie che circonda il sito di

installazione. La tabella seguente mostra alcuni esempi di superfici e il relativo fattore di ALBERO:

La scelta di superfici circostanti dal colore prevalente vicino al bianco è ottimale per ottenere un buon

indice di albero.

28

Ombreggiamento:

Un ultimo fattore che influenza l’efficienza degli impianti fotovoltaici è l’ombreggiamento prodotto dalle

costruzioni che circondano l’impianto o dalle file di moduli vicine.

Per individuare gli ombreggiamenti si ricorre a:

• bussola,con la quale si individua l’angolo tra la direzione del sud e

l’ostacolo α;

• con il clinometro si determina l’angolo rispetto all’orizzontale con

cui l’osservatore vede l’ostacolo β.

Gli ombreggiamenti possono essere locali e non locali.

Si definiscono non locali, gli ombreggiamenti prodotti dalle costruzioni circostanti:

A questo proposito è necessario verificare, a seconda del percorso solare e dell’altezza dell’ostacolo, se nel

corso dell’anno questi produce ombra sull’impianto.

29

30

Nell’esempio è illustrato il percorso solare inerente alla città di Bari. Per calcolare se gli ostacoli che

circondano il nostro impianto producono ombreggiamento si disegna il seguente grafico:

Come si osserva, nel caso dell’ostacolo rosso, l’impianto non risente nel corso dell’anno di

ombreggiamenti. Nel caso dell’ostacolo blu invece, vi sono alcuni mesi dell’anno durante i quali l’impianto

subisce l’effetto delle ombre. Di conseguenza sarà necessario adattare l’impianto per una produzione

elettrica compatibile con questo inconveniente.

Si definiscono locali, gli ombreggiamenti provocato da moduli vicini.

Nell’immagine si può notare come, nel momento in cui viene superato l’angolo limite β, i moduli

fotovoltaici delle file vicine subiscono ombreggiamento locale. Per poter ovviare al problema degli

ombreggiamenti locali è necessario stabilire una distanza minima tra le file dei moduli. Questa distanza nel

sud Italia è pari a:

31

Tipologia dei moduli:

Per quanto riguarda i moduli, a seconda della natura dei materiali che li compongono, si ottengono diversi

valori di efficienza. Nel caso del Silicio, questo elemento può essere lavorato con tecniche diverse che

consentono di ottenere i seguenti tipi di Silicio:

Le tipologie di moduli maggiormente utilizzate, a seconda del tipo di Silicio utilizzato sono:

• Moduli monocristallini

• Moduli policristallini

• Moduli amorfi

I monocristallini, sono moduli realizzati con Silicio monocristallino, i cui cristalli sono orientati nella stessa

direzione. Questa tipologia di moduli vanta una efficienza maggiore a fronte di un costo più elevato

derivata dai complessi processi di lavorazione.

I policristallini, sono moduli che utilizzano il Silicio policristallino. Hanno rendimento leggermente inferiore

ai monocristallini ed un costo relativamente inferiore.

I moduli fotovoltaici realizzati con Silicio amorfo hanno un rendimento molto più basso ma sono ottimi nel

caso di installazioni in luoghi ombreggiati dove è presente in prevalenza un tipo di irraggiamento diffuso.

Le caratteristiche che distinguono le diverse tipologie di moduli sono riassunte nella seguente tabella:

32

Tipologie di installazione per gli impianti fotovoltaici:

• Integrato

• Parzialmente integrato

• Non integrato

Gli

Impianti

fotovoltaici

integrati

costituiscono una delle più promettenti

applicazioni del fotovoltaico.

Si tratta di sistemi che vengono installati su

costruzioni civili o industriali per essere

collegati alla rete elettrica di distribuzione in

bassa tensione.

I moduli fotovoltaici in questo tipo di

installazione possono essere utilizzati come

elementi di rivestimento degli edifici anche in

sostituzione di componenti tradizionali come

tettoie.

L’impiego di tali moduli fotovoltaici può essere di grande utilità come schermi frangisole o per ombreggiare

ampie zone nel caso delle coperture.

Gli impianti fotovoltaici sono completamente integrati quando:

•

•

•

•

•

•

•

i moduli sostituiscono i materiali di rivestimento di tetti, coperture, facciate di edifici e fabbricati,

avendo quindi la stessa inclinazione e funzionalità architettonica

i moduli e i relativi sistemi di supporto costituiscono la struttura di copertura di pensiline, pergole e

tettoie

i moduli sostituiscono la parte trasparente o semi trasparente di facciate o lucernari, garantendo

l’illuminazione naturale degli ambienti interni all’edificio

i moduli sostituiscono parte dei pannelli fonoassorbenti delle barriere acustiche

i moduli e i relativi sistemi di supporto costituiscono dei frangi sole

i moduli sostituiscono o integrano i vetri di finestre

i moduli costituiscono gli elementi strutturali di persiane

Gli impianti fotovoltaici parzialmente integrati si hanno quando i

moduli fotovoltaici non sostituiscono i materiali che costituiscono la

superficie d'appoggio e vengono installati su tetti piani e terrazze, in

modo complanare ad esempio sul manto di copertura.

Possono essere considerati parzialmente integrati anche quei pannelli

installati ad esempio su terrazza la quale sia circondata da balaustra la

33

quale nasconda parzialmente i pannelli fotovoltaici.

Generalmente gli impianti fotovoltaici parzialmente integrati

vengono utilizzati su fabbricati o parti di questi che risultano già

esistenti.

Gli impianti fotovoltaici non integrati sono cosiddetti perché

appunto non si integrano armoniosamente con le strutture o

superfici che li ospitano. Trattasi di impianti generalmente

realizzati a terra o anche su parti strutturali di edifici quali

terrazzi, falde, pensiline e/o elementi di arredo urbano e viario

(*).

I pannelli fotovoltaici sono installati in maniera non complanare

alle superfici su cui sono fissati. Generalmente hanno un impatto maggiore dal punto di vista estetico e quindi non

sono gradevoli alla vista. Per questo genere di impianti le tariffe incentivanti sono inferiori rispetto alle tipologie

integrati e parzialmente integrati.

Le differenze nell’utilizzo delle varie tipologie di impianti sta sia nel diverso impatto visivo che esse hanno,

sia nella diversità degli incentivi previsti. Infatti nella seguente tabella si nota come gli incentivi sono

maggiori se l’impianto è integrato con la struttura dove vengono installati:

Anche se in alcuni casi, preferire l’integrazione significa rinunciare ai livelli ottimali di inclinazione e

orientamento, spesso gli incentivi garantiscono un risparmio di lunga superiore alle perdite derivate da tali

fattori.

34

Tipologie di impianti:

Vi sono 2 importanti tipologie di impianti:

Grid connected

Gli impianti grid connected o connessi alla rete, lavoro in un regime di interscambio con la rete elettrica.

Quest’ultima svolge il ruolo di un immensa batteria inesauribile e affidabile nel tempo.

Di giorno, cioè nelle ore di luce in cui l’impianto produce energia il carico assorbe l’energia prodotta dai

moduli. Di notte invece, l’utenza preleva l’energia dalla rete.

Se nelle ore di produzione, l’impianto produce più di quanto l’utenza consuma, l’energia viene immessa

nella rete e il GSE paga le unità di energia immesse nella rete all’utente, convertendole in sconti sulle

future bollette. Negli impianti che prevedono la sola vendita dell’energia, cioè gli impianti di produzione, il

GSE, calcolata la quantità mensile di energia immessa nella rete, recapita il corrispettivo in denaro al

proprietario dell’impianto. Le tariffe nei 2 casi sono diverse e sono più remunerative per gli impianti di

vendita. Di conseguenza è consigliato il dimensionamento corretto dell’impianto, in quanto il guadagno nel

caso di impianti grid connected consiste nel prelevare meno possibile dalla rete più che vendere l’energia

in eccesso.

Stand alone

Prevedono l’alimentazione di utenze isolate dalla rete (Stand alone)come ad esempio stazioni di

pompaggio, Illuminazione pubblica, elettrificazione di villaggi o utenze isolate.

35

L’energia prodotto dai moduli viene accumulata attraverso la batteria, che rappresenta l’elemento critico

di tale applicazione in quanto richiede una costante manutenzione. Il più famoso esempio di applicazione

stand alone sono i satelliti per telecomunicazioni.

Costo degli impianti:

I fattori che influenzano il costo finale dell’impianto sono numerosi. Difatti bisogna tener

conto del costo dei moduli, dei supporti dei moduli, dei cavi, dell’inverter, del contatore, del

collegamento alla rete, della manodopera, del costo di permessi e degli atti amministrativi

ecc. A livello generale però è possibile effettuare una stima approssimativa del costo

dell’impianto a seconda del wattaggio che si desidera ottenere. Si tiene conto dunque dei

seguenti parametri:

•

•

•

•

•

•

Generatore fotovoltaico: 5.9€/W

Inverter:

0.8€/W

Struttura di sostegno:

0.3€/W

Quadro elettrico:

0.5€/W

Cablaggio e installazione:

0.3€/W

Totale:

7.8€/W

A questi costi si aggiunge una spesa fissa che tiene conto del costo del contatore di energia e di tutte quelle

spese indipendenti dalla potenza dell’impianto. Questo ammontare fisso equivale a 260€.

Esempio:

Progettazione di un impianto di potenza pari a 3000W, collegato alla rete pubblica di

distribuzione:

Calcolo dei costi:

36

A questo totale parziale si aggiungono i costi per oneri professionali e amministrativi. Questi costi sono

variabili e vengono calcolati di volta in volta a seconda dei casi.

Esempio di modulo fotovoltaico al silicio policristallino

Nella scheda che segue, un esempio di modulo fotovoltaico policristallino, realizzato da

SHARP. Si riportano caratteristiche e parametri definiti dal costruttore:

37

38

39

CLASSE : VA E.T.A.

ALUNNO: Bovino Silvano

Indice:

• Introduzione

1. Sistemi satellitari in orbita

2. Progetti Italiani nel campo satellitare

3. Bande di frequenza dei sistemi satellitari

• Satelliti geostazionari

• Strumenti di bordo dei satelliti:

1. Pannelli fotovoltaici

2. Sistema di alimentazione

3. Trasponder

• Tecniche di multiplazione dei canali satellitari

• Applicazioni dei satelliti:

1. Sistema GPS

2. Satelliti Meteorologici

40

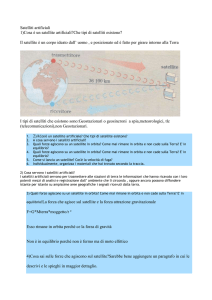

Introduzione:

Una delle prime fondamentali applicazioni del fotovoltaico si è avuta negli anni ’60, con la costruzione dei primi

satelliti. I satelliti sono stati creati inizialmente per gestire tramite ponte radio, le comunicazioni per scopi militari o

per la raccolta di dati meteorologici e scientifici. I primi satelliti lanciati nello spazio furono costruiti attraverso un

progetto che vedeva riuniti 11 paesi (tra cui anche l’Italia). Questo consorzio venne denominato International

Telecommunications consorsum INTELSAT. Il primo satellite lanciato in orbita attraverso tale progetto, venne

denominati Intelsat 101. Col passare del tempo gli scienziati si resero conto dell’enorme potenziale e contributo che i

satelliti avevano da offrire sia in merito alla raccolta dati ma anche per quanto riguarda la gestione delle

telecomunicazioni del pianeta. Per questo motivo furono finanziati diversi progetti che miravano a migliorare le

potenzialità dei satelliti cercando di aumentare la loro vita media, le loro prestazioni e i loro consumi.

La serie più recente di satelliti lanciati in orbita tramite il consorzio INTELSAT sono della serie VIII e sono stati per

questo denominati INTELSAT 801 , 802 e 803, lanciati rispettivamente nel Marzo, Giugno e Settembre del 1997.

Successivamente nuove organizzazioni e consorzi locali e mondiali progettarono la messa in orbita di altri satelliti

deputati allo svolgimento di nuovi obbiettivi. Alcuni di questi sono:

•

•

Sistema satellitare INMARSAT (International Maritime Satellite Organizzation): avvalendosi di 4 satelliti

geostazionari, questo sistema consente le comunicazioni telefoniche e dati tra stazioni marittime o

aeronautiche con la terra ferma. Su questo sistema si basano anche le comunicazioni di emergenza per i

servizi di soccorso e salvataggio.

Sistema GPS: Tale sistema è costituito da una ventina di satelliti(attualmente ne sono operativi 13) situati in

orbita bassa con distanza di 20000Km dalla terra. Questo sistema consente agli apparecchi portatili di

conoscere in maniera sempre più precisa la propria posizione, con un margine di errore di pochi metri. In

particolare si tratta di sistemi di posizionamento in grado di fornire all’utente longitudine, latitudine e

quota in base alla propria posizione e in alcuni casi anche la velocità dell’utente o del mezzo mobile.

•

Questo è possibile poiché il satellite invia un segnale da cui è possibile ricavare la propria esatta posizione e

le relative coordinate attraverso un dispositivo capace di decodificare il segnale satellitare.

Sistema satellitare EUTELSAT: Tale sistema è costituito da una decina di satelliti lanciati a partire dal 1983

capaci di gestire il traffico telefonico e radiotelevisivo dei paesi EUROPEI.

Il miglioramento delle potenzialità dei satelliti, verificatosi negli ultimi anni, ha accresciuto l’attenzione dei maggiori

gestori delle telecomunicazioni (telefoniche, radiotelevisive, dati etc…) e ha fatto si che il numero di satelliti e di

progetti per il loro lancio in orbita stia crescendo in maniera esponenziale.

I progetti Italiani:

Per quanto riguarda il programma satellitare Italiano, la nostra nazione oltre ad essere coinvolta nel progetto

INTELSAT, è riuscita a lanciare in orbita 2 satelliti attraverso il progetto nazionale ITALSAT. I 2 satelliti denominati

ITALSAT F1 e ITALSAT F2 operano per la gestione delle comunicazioni telefoniche. Difatti ITALSAT F2 è dotato di un

sistema di bordo paragonabile ad una vera e propria centrale telefonica in grado di multiplare 12000 comunicazioni,

lavorando nella banda compresa tra 20GHz e 30GHz. Tale satellite collega tra loro le centrali di Bari, Torino, Milano,

Roma, Palermo, Milano, Verona e Fucino.

Oltre a gestire le comunicazioni telefoniche per la società italiana TELECOM, tale satellite è in grado di fornire servizi

aggiuntivi in merito alla videotelefonia, videoconferenze e trasmissione di dati.

41

BANDE DI FREQUENZA DEI SISTEMI SATELLITARI:

Le bande utilizzate dai satelliti per gli scopi commerciali, quindi per la gestione delle normali comunicazioni sono

distribuite in questo modo:

•

•

•

•

banda L compresa tra

banda C compresa tra

banda Ku compresa tra

banda Ka compresa tra

1GHz – 2 GHz

4GHz – 8 GHz

12GHz – 18GHz

27GHz – 40GHz

Per le comunicazioni di tipo militare invece si utilizzano apparecchiature più sofisticati in modo tale che queste

ultime non siano facilmente intercettabili. Per questo motivo si lavora con le seguenti bande di frequenza:

•

•

•

UHF compresa tra 225 MHz – 400 MHz

SHF compresa tra 5 GHz – 8 GHz

EHF compresa tra 20 GHz – 40 GHz

Le bande di frequenza attualmente più utilizzate sono la C e la Ku che difatti è la usata anche dai satelliti INTELSAT,

ARABAT, PANAMSAT, ASIASAT, ecc…

Satelliti Geostazionari:

Come abbiamo visto, la maggior parte dei satelliti svolge operazioni deputate alla gestione di servizi di

telecomunicazioni per aree geografiche più o meno estese. Affinché questo sia possibile, è necessario che durante la

rotazione della terra , il satellite rimanga 24 ore su 24 nello stesso punto rispetto all’area geografica coperta.

I satelliti che soddisfano questo requisito sono detti geostazionari. Questi si trovano su orbite equatoriali a distanze

opportunamente calcolate, in modo tale che il periodo di rivoluzione del satellite che percorre tale orbita, coincida

con il periodo di rivoluzione della terra. Tale orbita viene definita geostazionaria in quanto per un osservatore a

terra, il satellite appare fermo in cielo, sospeso sempre al di sopra del medesimo punto dell'equatore.

Nel caso della terra la velocità di rotazione è tale da permettere orbite situate a distanze ideali dal centro terrestre in

modo tale da coprire e gestire vaste aree.

Affinché, il satellite conservi la sua orbita è necessario che la forza centrifuga a cui è sottoposto sia uguale alla forza

di attrazione che la terra esercita su di esso. Se non venisse verificata tale condizione, nell’arco di un certo periodo di

tempo, il satellite devierebbe dall’orbita prestabilita disperdendosi nello spazio o, avvicinandosi troppo alla terra,

verrebbe attratto in maniera sempre più violenta verso l’atmosfera terrestre.

Per questo motivo definendo M la massa della terra e m la massa del satellite deve valere la seguente relazione:

42

Da cui:

In questo formula G è la costante di Gravitazione Universale ed è costante in natura a prescindere dalle proprietà dei

corpi che interagiscono(in questo caso la terra ed il satellite).

Il valore di tale costante è:

La massa della terra invece è:

Il fattore “r” invece definisce la distanza tra il centro della terra e il satellite ed è calcolato sommando la distanza

della terra dal suo centro(RT) e la distanza tra la terra ed il satellite(h). Di conseguenza si ottiene:

Per far si che il satellite percorra la sua orbita in un tempo T pari al periodo di rotazione terrestre deve verificarsi che:

Il satellite deve essere in grado di percorrere l’orbita intorno alla terra in un tempo di 86400 secondi. Di conseguenza

la velocità di rotazione vale:

Da questa formula siamo in grado di determinare che la velocità di rotazione è pari a 3070m/sec. Infatti dalle

relazioni precedenti si ottiene che:

Questa è la distanza complessiva tra il satellite ed il centro della terra. Se vogliamo conoscere la distanza tra la terra

ed il satellite basta eseguire il seguente calcolo tenendo conto che il raggio della terra è di 6370km:

43

Da tale distanza, il satellite è in grado di ricoprire teoricamente un angolo di 17030’ che definisce l’IMPRONTA

(FOOTPRINT) che copre un area di circa 17000km2 cioè il 40% della superficie del globo. In questo caso sarebbe

possibile attraverso 3 soli satelliti disposti in maniera equidistante, la copertura di un area equivalente all’intera

superficie terrestre.

Fig.1 Orbita Geostazionaria

Attualmente vi sono numerosi satelliti geostazionari operativi. Tra i più famosi citiamo l’INTELSAT701, Superbird B2,

i satelliti Hotbird della EUTELSAT e tanti altri, dei quali alcuni risultano non più operativi per via di malfunzionamenti

o addirittura a causa di presunte collisioni con detriti spaziali.

In casi diversi da quello dell’orbita circolare geostazionaria, i satelliti possono ruotare intorno a orbite di tipo ellittico

dove la terra rappresenta uno dei 2 fuochi. Il punto più distante del satellite dalla terra viene denominato apogeo

mentre quello più distante è detto perigeo. Queste orbite sono ottenute modificando la velocità di rotazione del

satellite.

Affinché il satellite conservi l’orbita devono essere rispettate le leggi delle gravitazione a cui abbiamo accennato. Di

conseguenza la velocità di rotazione del satellite sarà compresa tra 2 valori Vmin e Vmax tali che entro tale intervallo

sia garantito l’equilibrio tra la forza centrifuga e la forza di attrazione gravitazionale che la terra esercita sul satellite.

Orbite diverse da quelle geostazionarie sono utilizzate per le rilevazione di dati meteorologici e scientifici o in ambito

militare.

Quanto appena detto è valido se la terra fosse caratterizzata da una superficie regolare intorno a tutto il globo.

L’esistenza delle catene montuose e di perturbazioni che interessano i criteri della gravitazione del satellite quali

l’attrazione della luna, la diversa distribuzione delle acque del nostro pianeta fanno si che il satellite sia sottoposto a

forze inattese che se non bilanciate potrebbero modificare l’orbita del satellite. Inoltre, tenendo conto che da tali

fattori è influenzata anche la velocità di rotazione del satellite, ne consegue che è necessario equipaggiare ogni

sistema satellitare di una opportuna

strumentazione di bordo affinché sia

possibile gestirne da terra il corretto

funzionamento e posizionamento.

Per questo motivo consideriamo quali

sono le caratteristiche dei tipici strumenti

di bordo di un comune satellite.

STRUMENTAZIONE DI BORDO:

I satelliti utilizzati per le telecomunicazioni

sono a tutti gli effetti dei ponti radio, in

quanto il loro ruolo è quello di una

stazione ripetitrice che consente il

collegamento tra una stazione terrestre,

marittima o aerea con una seconda o più stazioni situate nelle diverse aree del globo sotto la copertura del satellite.

Il collegamento che si realizza pertanto si definisce:

44

•

Punto - punto: in questo caso, il satellite collega tra loro una stazione trasmittente ed una ricevente.

Utilizzano questo tipo di collegamento le centrali telefoniche. La figura seguente mostra un esempio di

questo caso:

Fig.2 Esempio di collegamento punto-punto via satellite

•

•

Punto - multipunto: in questo caso una stazione trasmittente viene connessa a più stazioni riceventi, come

nel caso delle trasmissioni radiotelevisive.

Multipunto - punto: si realizza nel caso dei sistemi di rilevazione dati meteorologici quando più stazioni

trasmittenti(ad esempio i sistemi di acquisizione dati), inviano i loro dati ad una sola stazione ricevente

deputata all’elaborazione simultanea dei dati raccolti.

Per questo motivo, un primo blocco fondamentale di un satellite è il TRASPONDER, cioè l’insieme di tutti i dispositivi

che consentono le operazioni di ricetrasmissione dei segnali, utilizzando le opportune tecniche di modulazione dati

utilizzando 2 diverse frequenze di portante, una per l’up-link e l’altra per il down-link. In questo modo si evitano le

possibili interferenze tra i segnali in ricezione e i segnali in trasmissione.

45

Fig.3 Schema a blocchi della strumentazione di un satellite

Come si osserva nello schema a blocchi, vi sono diversi strumenti che garantiscono le funzionalità del satellite:

•

Pannelli solari: I pannelli solari o meglio fotovoltaici, come sappiamo sono quei dispositivi in grado di

convertire l’energie solare del sole in energia elettrica sfruttando il fenomeno dell’effetto “fotovoltaico”

ottenuto dall’esposizione diretta alla radiazione solare di materiali semiconduttori come il silicio. Sfruttando

tali dispositivi è possibile provvedere al sostentamento energetico del satellite. Questi pannelli infatti

vengono orientati automaticamente verso il sole ed è possibile ricavare una potenza di circa 2 o 3 KW.

Durante la rotazione però il satellite viene spesso a trovarsi in condizioni di ombra. Per questo motivo,

trattandosi di una applicazione stand-alone è necessario implementare un sistema di alimentazione.

•

Sistema di alimentazione: Questo sistema svolge la funzione fondamentale di immagazzinare l’energia

prodotta dai fotovoltaici, nel periodo in cui il satellite è esposto alla radiazione solare. Nel momento in cui la

terra si interpone tra il satellite ed il sole, gli accumulatori rendono disponibile l’energia accumulata agli

strumenti di bordo. Per poter garantire il funzionamento duraturo nel tempo gli accumulatori devono

soddisfare alcuni requisiti:

1. Elevata durata di esercizio in modo da garantire una vita minima del satellite di 15 anni.

2. Elevate energie specifiche in modo da ottenere un buon rapporto energia/massa (wh/Kg)

tenendo conto che in genere gli accumulatori costituiscono il 15-20% della massa del

satellite e, come abbiamo visto, il calcolo della massa dell’intero corpo satellitare è

indispensabili per la definizione dei criteri della sua orbita.

3. Nessuna richiesta di manutenzione. A volte però nei casi di satelliti particolarmente costosi

ed indispensabili, vengono disposte missioni spaziali per la loro manutenzione che hanno

proprio l’obbiettivo di eseguire la manutenzione del sistema di alimentazione o addirittura la

sostituzione di alcuni dei suo componenti. In ogni caso è richiesta una tecnologia

particolarmente sofisticata e costosa.

Gli accumulatori maggiormente utilizzati sono quelli al Nichel/Cadmio o quelli al Nichel/Ioduri - metallici. Il

rapporto energia/massa in questi casi è elevato e si attesta rispettivamente per il primo e il secondo tipo

intorno ai 25 e 35 Wh/Kg. Data la natura ferromagnetica del Nichel questi accumulatori devono essere

schermati affinché il satellite non sia soggetto a tali campi. Il problema può essere eliminato utilizzando le

batterie agli ioni di litio di recente scoperta che generano una tensione di 3V per elemento con un ottimo

rapporto energia (50Wh/Kg) e garantendo una quasi totale immunità ai campi magnetici.

•

Trasponder: Come abbiamo accennato, il trasponder comprende tutti i dispositivi per la gestione dei canali

di trasmissione. Alcuni satelliti ne montano più di uno in modo tale da aumentare le capacità di

multiplazione dell’intero ponte radio satellitare. Le principali funzioni svolte dai blocchi che compongono il

trasponder riguardano la conversione di frequenza del segnale ricevuto in modo tale che, ricevuto il segnale

di frequenza portante di up-link, il segnale sia poi trasmesso con portante di frequenza di down-link. Le 2

frequenze, di up-link e down-link sono assegnate in modo tale che quella di up-link sia la maggiore delle 2. In

questo modo viene semplificata la tecnologia di bordo. I valori delle frequenze di up e down link sono stati

fissati a livello internazionale dall’ITU-T e sono suddivisi a seconda delle varie aree geografiche:

1. REGIONE 1: Europa, Africa, Medio Oriente, Nord Asia.

2. REGIONE 2: Le Americhe e il Giappone.

3. REGIONE 3: India, Cina, Australia.

Di seguito troviamo elencate le principali frequenze utilizzate dai trasponder dei satelliti Europei:

46

Bande di frequenza

GHz

Banda

•

2

4/6

S

C

7/8

12/14

X

Ku

20/30

40/50

Ka

Q

Frequenza f1 di

up-link

Tratta Terra - Spazio

2.665-2.690

4.4-4.7

5.925-6.425

7.9-8.4

14.0-14.5

17.700-21.200

42.5-43.5

47.2-50.2

50.4-51.4

Frequenza f2 di

down-link

tratta Spazio - Terra

2.500-2.535

3.4-3.7

3.7-4.2

7.250-7.750

10.950-11.200

11.450-11.700

11.700-12.200

27.500-31.000

37.5-40.5

Larghezza di banda

(MHz)

35

500

500

500

500

500

500

3500

3000

3000

3000

Antenne: Per quanto concerne le antenne situate a bordo dei satelliti e che consentono la ricezione e la

trasmissione, queste sono di tipo parabolico e il loro numero è proporzionale al numero dei trasponder che

si trovano a bordo del satellite. E’ proprio dalle antenne, che dipende la copertura radioelettrica, che il

satellite garantisce sull’area terrestre. Si distinguono a questo proposito due tipologie di satelliti:

1. Satelliti a copertura globale: I satelliti a copertura globale coprono l’angolo massimo di 17030’ per cui

consentono di garantire la copertura radioelettrica di un area pari al 40% della superficie terrestre.

2. Satelliti multifascio: Questo tipo di satelliti monta delle antenne realizzate in modo tale da ricoprire

con fasci radio direzionali(spot) una regione geografica ben definita.

In questo caso la potenza del segnale non è costante su tutta l’area geografica ma decresce man

mano che ci si avvicina ai limiti dell’area interessata dal fascio direttivo. Si evince quindi che l’EIRP

del segnale è massimo nel centro e decresce allontanandosi da tale punto. Alcuni grafici forniscono il

footprint del satellite che fa riferimento proprio al fattore EIRP del segnale a seconda del punto della

zona geografica interessata dalla copertura satellitare. Di seguito si riporta un esempio di footprint di

un satellite:

47

Fig.4 Esempio di footprint di un satellite

Per poter aumentare la qualità del segnale nelle zone ai limiti dei grafici di footprint satellitare, è necessario

aumentare il diametro delle antenne paraboliche. Dal grafico inoltre si evince che affinché non vi siano interferenze

tra i segnali degli spot adiacenti, è necessario suddividere la banda totale in sottobande eseguendo la suddivisione in

celle, una tecnica utilizzata anche nella telefonia cellulare. In questo modo gli spot adiacenti lavorano sempre con

frequenze diverse ed inoltre è possibile introdurre il riuso delle frequenze.

48

Fig.5 Esempio di suddivisione a celle del territorio

Come si nota nella figura in alto, se il fascio direttivo del satellite è suddiviso in tanti piccoli fasci di diversa frequenza,

si può riutilizzare la frequenza di un determinato sottofascio, facendo si che un altro fascio direttivo situato ad un

opportuna distanza usi la medesima frequenza del primo fascio.

Il riuso delle frequenze è una tecnica che può essere ulteriormente potenziata attraversa l’implementazione della

tecnica della polarizzazione delle onde elettromagnetiche. Con il termine polarizzazione elettromagnetica si intende

la direzione del piano di oscillazione del campo elettrico associato all’onda elettromagnetica. Di conseguenza, se la

componente del campo elettrico, oscilla in un piano parallelo alla terra si dice che la polarizzazione è del tipo

orizzontale (H); se invece oscilla in un piano perpendicolare alla terra si dice che la polarizzazione è verticale(V).

La potenzialità di questa tecnica si evince dal fatto che sfruttando tali concetti è possibile trasmettere dei segnali con

medesime frequenze, nella stessa area geografica e senza il rischio di interferenze.

Concludendo, le antenne che montano sul satellite devono quindi essere in grado di sfruttare tali tecniche ed inoltre

devono garantire una sufficiente potenza di trasmissione affinché il fattore di attenuazione dello spazio libero (ASL)

non comprometta l’intelligibilità delle trasmissioni. Tale parametro deve essere considerato in fase di progettazione

attraverso la seguente relazione:

Dove con R indichiamo ovviamente la distanza tra il satellite e la stazione a terra. Questa distanza può essere

calcolata dalla seguente formula:

RT vale come abbiamo visto circa 6370km essendo il raggio della terra e la distanza del satellite tra la terra è invece

r=42200km. L invece fa riferimento alla latitudine del luogo di ricezione ed in ultimo il parametro Δl si definisce

come: