LA RIVELAZIONE NON COERENTE

1 – Il problema della rivelazione.

Il segnale che si presenta all'ingresso del ricevitore è costituito da una replica del segnale inviato dal trasmettitore eventualmente distorta per effetto del canale di trasmissione e

corrotta da disturbi ed interferenze. Nei sistemi di modulazione M -ari, com’è noto, l'informazione trasmessa è associata ad un insieme di M simboli {am }m =1 . Nelle modulazioni priM

ve di memoria, cui si fa riferimento, il segnale trasmesso, nel generico intervallo di simbolo

di durata T , dipende dal corrispondente simbolo am ; esso è pertanto costituito da una

forma di segnalazione sm (t) , appartenente ad un insieme composto da M elementi, scelta

in corrispondenza uno ad uno con il simbolo da trasmettere. Inoltre, supponendo di poter

trascurare ogni influenza fra i simboli trasmessi, la rivelazione può essere effettuata simbolo per simbolo. Si può far allora riferimento all'intervallo [ 0,T ) corrispondente alla rivelazione del simbolo di posto 0 nella sequenza trasmessa. Ciò comporta che il segnale ricevuto può di conseguenza essere posto nella forma:

r (t ) = αsm (t − t0 ) + n(t )

(1.1)

(0 ≤ t < T )

ammesso che il trasmettitore abbia inviato la segnalazione sm (t) . Nella (1.1) si è supposto

che il segnale in arrivo sia attenuato (si suppone α < 1 ), ritardato di una quantità t0 e corrotto da un rumore additivo n( t) che, in quel che segue, si suppone gaussiano, a media

nulla e stazionario (in senso lato almeno fino al secondo ordine).

Tenendo presente che il segnale trasmesso è di tipo passa-banda il cui spettro si suppone centrato attorno alle frequenze ± f0 , essendo f0 la frequenza della portante, il segnale

r (t ) può essere riscritto introducendo la rappresentazione complessa usando f0 come fre-

quenza di riferimento. In altri termini, denotando con r (t ) s˜m (t) e n(t ) gli inviluppi complessi dei segnali r (t ) , sm (t) e del rumore n(t ) si ha:

(1.2)

r (t ) = Re ⎡⎣ r (t )e j 2 πf0t ⎤⎦

sm (t ) = Re ⎡⎣ sm (t )e j 2 πf0t ⎤⎦

n(t ) = Re ⎡⎣ n(t )e j 2 πf0t ⎤⎦

e quindi la (1.1) si può scrivere come segue:

(1.3)

Re ⎡⎣ r (t )e j 2 πf0t ⎤⎦ = Re ⎡⎣ αsm (t − t0 )e− j 2 πf0t0 e j 2 πf0t ⎤⎦ + Re ⎡⎣ n(t )e j 2 πf0t ⎤⎦

0≤t <T

e cioè:

(1.4)

r (t ) = αsm (t − t0 )e − jϕ0 + n(t )

0≤t <T

dove si è posto ϕ 0 = 2 πf0 t0 .

Perché il segnale possa essere correttamente rivelato occorre conoscere e il ritardo t0 e

la fase ϕ 0 . In quel che segue si suppone che il ricevitore sia sincronizzato al trasmettitore

per cui il ritardo t0 si suppone noto. Tuttavia lo stesso non può dirsi per quanto concerne

la fase perché, a causa degli elevati valori della frequenza della portante, un errore nella

stima del ritardo, anche se di modesta entità, produce un errore elevato nella fase ϕ 0 . Inoltre la fase ϕ 0 può variare anche per effetto di un’instabilità dell’oscillatore usato in tra-

-2–

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

smissione. Per questi motivi non è sempre possibile ritenere noto il valore della fase ϕ 0 .

Quando ciò si verifica, si parla di rivelazione (o demodulazione) non coerente; in contrasto con la rivelazione (o demodulazione) coerente che si verifica quando tali parametri

sono esattamente noti al ricevitore.

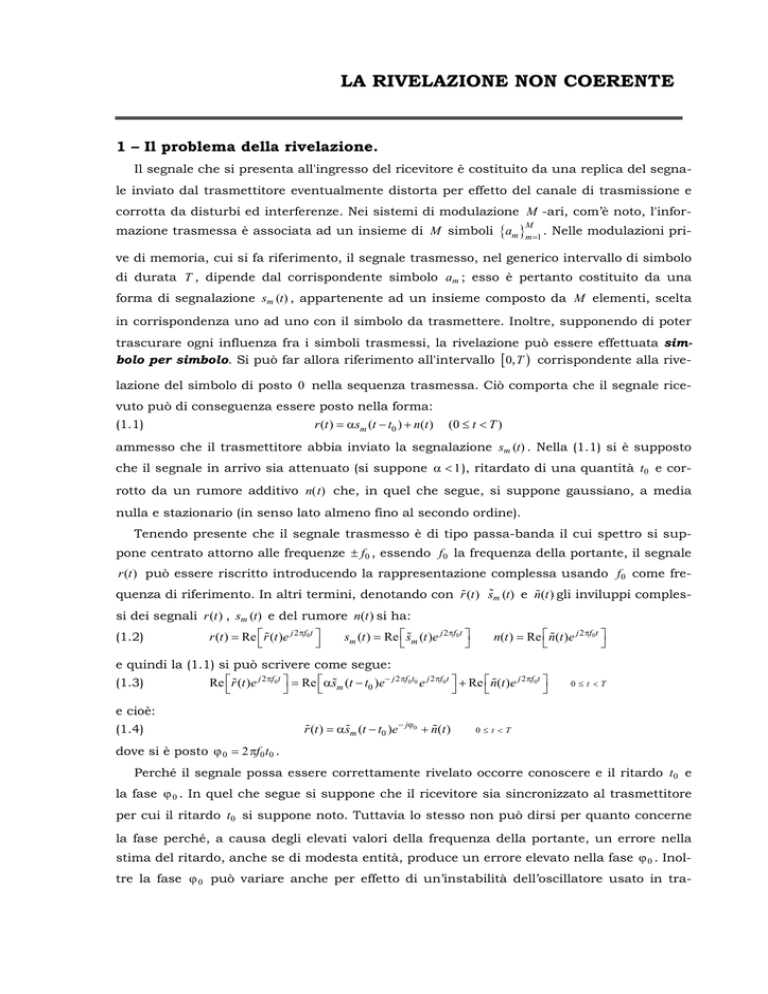

r(t)

Demodulatore

{rk }kN=1

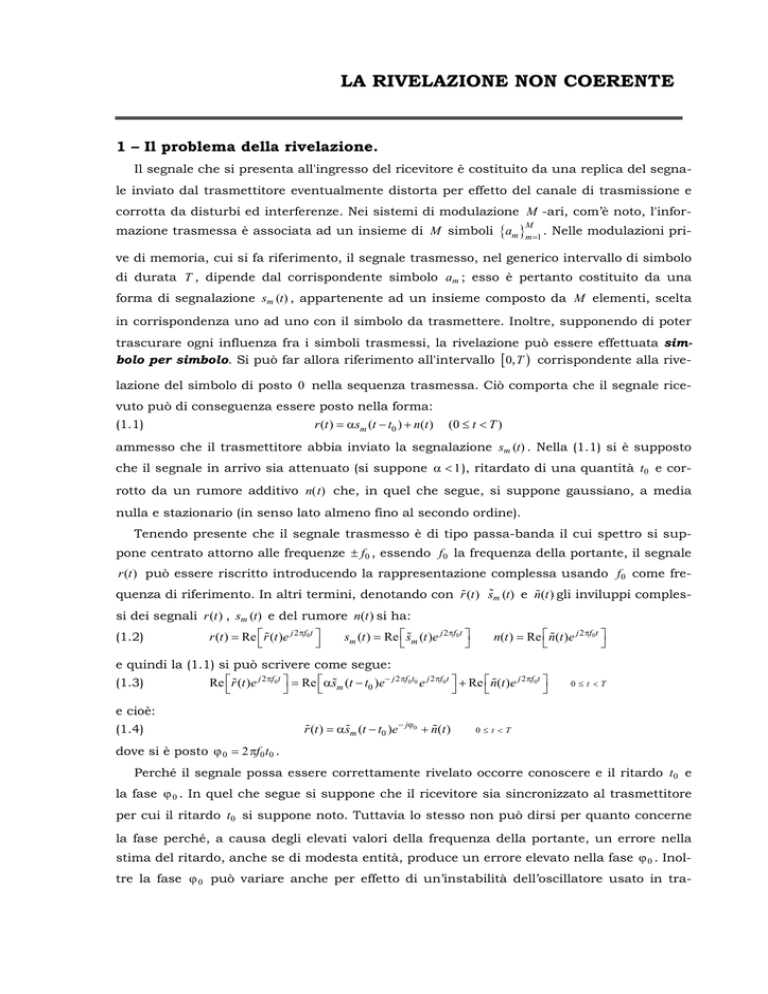

Da un punto di vista concet-

sˆm(t)

Rivelatore

tuale è utile considerare il ricevitore

Fig. 1 – Schema di principio di un ricevitore.

come

composto

da

due

elementi in cascata (v. Fig. 1):

a) il demodulatore che fornisce in uscita un insieme numerabile di variabili aleatorie

{rk }kN=1

a partire dalla conoscenza del segnale r (t ) con t ∈ [ 0, T ) ;

b) il rivelatore che fornisce una stima del dato trasmesso sulla base delle osservazioni

{rk }kN=1 .

2 – Stima del segnale trasmesso.

L’inviluppo complesso del segnale in arrivo al ricevitore si può scrivere come segue (1):

r (t ) = sm (t )e − jϕ0 + n(t )

(2.1)

0≤t <T

in cui la fase ϕ 0 si considera una variabile aleatoria, con densità di probabilità pϕ0 (ϕ0 ) ,

indipendente dalla segnalazione trasmessa e dal rumore additivo supposto gaussiano.

Sia S N = {ui (t )}i =1 (con N ≤ M ) un insieme finito di funzioni complesse linearmente indiN

pendenti, confinate in [0, T ) , che costituisce una base completa per le segnalazioni

{sm (t )}mM=1 . Le funzioni {ui (t )}iN=1

inoltre si suppongono ortonormali e cioè tali che si abbia:

T

⎧1

r =s

∫0 ur (t )us (t )dt = ⎨⎩0 r ≠ s

(2.2)

*

Ogni funzione sm (t ) può allora essere espressa come combinazione lineare delle funzioni

dell’insieme S N . La proiezione di r (t ) ortogonale al sottospazio S N allora vale:

N

rN (t ) = ∑ rk uk (t )

(2.3)

0≤t <T

k =1

dove i coefficienti rk sono dati dalle:

(2.4)

rk =

T

∫0 r (t )uk (t )dt = e

*

− jϕ0

T

T

∫0 sm (t )uk (t )dt + ∫0 n(t )uk (t )dt =

*

*

= e − jϕ0 sm, k + nk

in cui si è posto:

(2.5)

sm , k =

nk =

T

∫0 sm (t )uk (t )dt

T

∫0

*

1≤ k ≤ N

n(t )uk* (t )dt

È da tener presente che i coefficienti {rk }k =1 dipendono dal valore della fase ϕ0 .

N

Le componenti nk sono delle variabili aleatorie gaussiane a valori complessi, in quanto

(1) Si è considerato il ricevitore sincronizzato al trasmettitore per cui è t0 = 0 e si è posto inoltre per semplicità

α =1.

La rivelazione non coerente

-3-

ottenute con operazioni lineari da segnali gaussiani. Esse costituiscono un vettore aleatorio a valori complessi n di N dimensioni la cui statistica dipende soltanto dal vettore dei

valori medi e dalle correlazioni fra le variabili aleatorie nk . A tal fine, se il rumore

all’ingresso si suppone a media nulla e bianco con densità spettrale pari a

N0

2

, ricordando

le proprietà dell’inviluppo complesso di un rumore bianco, si ha:

(2.6)

E {nk } = 0

Inoltre è:

{ }

E {n(t1 )n (t2 )} ur (t1 )us (t2 )dt1dt2 =

0 ∫0

E nr ns* = ∫

T

T

*

= 2 N0 ∫

T

T

*

δ(t2 − t1 )ur (t1 )us (t2 )dt1dt2 =

0 ∫0

(2.7)

*

r=s

T

⎧2 N

= 2 N 0 ∫ ur* (t )us (t )dt = ⎨ 0

0

⎩0

r≠s

e:

(2.8)

E {nr ns } =

T

T

∫0 ∫0 E {n(t1 )n(t2 )} ur (t1 )us (t2 )dt1dt2 = 0

*

*

per cui, ricordando la proprietà sui numeri complessi già utilizzata al Cap. 2, le correlazioni associate alle parti reali e alle parti immaginarie delle nk sono:

(2.9)

E {Re [ nr ] Re [ ns ]} =

1

2

E {Im [ nr ] Im [ ns ]} =

1

2

E {Re [ nr ] Im [ ns ]} =

1

2

E {Im [ nr ] Re [ ns ]} =

1

2

( Re ⎡⎣n n ⎤⎦ + Re [n n ]) = ⎧⎨⎩0N

*

r s

0

r s

( Re ⎡⎣n n ⎤⎦ − Re [n n ]) = ⎧⎨⎩0N

( Im ⎡⎣n n ⎤⎦ + Im [n n ]) = 0

( − Im ⎡⎣n n ⎤⎦ + Im [n n ]) = 0

*

r s

r s

*

r s

r s

*

r s

0

r =s

r ≠ s

r =s

r ≠ s

r s

Il vettore delle parti reali n f e quello delle parti immaginarie nq costituiscono due vettori a

valori reali ad N dimensioni congiuntamente incorrelati; inoltre le componenti di n f , come

pure quelle di nq , sono incorrelate ed hanno la stessa varianza N 0 .

La statistica del vettore complesso n = n f + jnq è definita dalla:

pn (n) = pn f , nq (n f , nq )

(2.10)

e cioè dalla statistica congiunta del vettore delle parti reali e dei coefficienti delle parti immaginarie di n . Ricordando i risultati sopra ottenuti, si ha:

(2.11)

⎧⎪ 1

exp ⎨−

pn (n) =

N

(2πN 0 )

⎩⎪ 2 N 0

1

N

∑

i =1

(n 2f ,i

2

⎪⎧ n ⎪⎫

exp ⎨−

=

⎬

N

⎭⎪ (2πN 0 )

⎪⎩ 2 N 0 ⎪⎭

⎫⎪

+ nq2,i ) ⎬

1

Sulla base del segnale ricevuto, il ricevitore deve prendere una decisione sulla segnalazione am inviata dal trasmettitore. Nella trasmissione numerica il ricevitore decide a favore

di quella segnalazione che conduce ad una decisione con il minimo della probabilità di errore. È facile rendersi conto che tale criterio equivale alla stima:

(2.12)

aˆm = arg max {Pr {am | r (t )}}

am

Che questo criterio (noto come criterio della massima probabilità a posteriori MAP) corrisponda alla scelta del simbolo che conduce al minimo della probabilità di errore, noto

r (t ) , è facile verificare. Infatti poiché Pr {am | r (t )} è la probabilità che si sia trasmesso sm (t )

-4–

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

noto r (t ) ; allora 1 − Pr {am | r (t )} denota la probabilità che non si sia trasmesso sm (t ) noto

r (t ) . Se il ricevitore stabilisce che il segnale trasmesso è sm (t ) commette un errore con

probabilità 1 − Pr {am | r (t )} . La condizione (2.12) corrisponde quindi alla scelta del simbolo

in corrispondenza del quale la probabilità di errore è minima, o che è lo stesso, la probabilità della corretta decisione è massima.

Poiché la componente del segnale ricevuto r (t ) ortogonale al sottospazio S N non porta

alcun contributo alla decisione, quest’ultima può essere presa sulla base del vettore delle

variabili di decisione

r = [ r1

r2 … rN ] , la funzione

T

Pr {am | r (t )}

è equivalente alla

Pr {am | r } . Applicando la regola di Bayes, si può scrivere:

Pr {am | r } =

(2.13)

pr |am ( r | am ) Pr {am }

pr (r )

in cui:

1) Pr {am } è la probabilità associata al simbolo am o, che è lo stesso, alla segnalazione

sm (t ) ;

2) pr (r ) è la densità di probabilità associata al vettore r ;

3) pr |am ( r | am ) è la densità di probabilità del vettore r noto che il simbolo trasmesso è am .

Se le forme di segnalazione sono equiprobabili, la (2.12) si riduce alla:

aˆm = arg max pr |am (r | am )

(2.14)

am

{

}

poiché, essendo pr (r ) positiva ed indipendente da am , non interviene nella determinazione

del massimo.

Tenendo conto delle (2.4) è evidente che il vettore r , corrispondente al segnale ricevuto,

dipende dalla fase ϕ0 , la stima del simbolo trasmesso è ottenuta dalla:

{

π

aˆm = arg max 1 ∫ pr |am ( r | sm (t ) ) d ϕ0

−π

2π

am

(2.15)

}

dove si è supposto che la fase ϕ0 sia uniformemente distribuita in [ −π, π ) .

Dalla statistica del vettore delle componenti del rumore, si deduce facilmente:

⎧ r − s e − jϕ0 2 ⎫

m

1

⎪

⎪

(2.16)

exp ⎨−

pr |am ( r | sm (t ) ) =

⎬

N

2

N

(2πN 0 )

0

⎪

⎪

⎩

⎭

Poiché è

r − sm e− jϕ0

(2.17)

2

(

= (r

= r − sm e− jϕ0

H

) (r − s e ) =

)( r − s e ) =

H

m

− smH e jϕ0

m

− jϕ0

− jϕ0

= r H r − e jϕ0 smH r − e− jϕ0 r H sm + smH sm =

= r − 2 Re ⎡⎣ e jϕ0 smH r ⎤⎦ + sm

2

2

la (2.16) si riduce alla:

(2.18)

pr |am ( r | sm (t ) ) =

⎧⎪ r 2 + s

m

exp

⎨−

N

2

N

(2πN 0 )

0

⎪⎩

1

2

⎫⎪

⎧ 1

⎫

jϕ H

⎬ exp ⎨ N Re ⎡⎣ e 0 sm r ⎤⎦ ⎬

⎩ 0

⎭

⎪⎭

La stima della segnalazione trasmessa può essere semplificata considerando solo i termini dipendenti dal vettore sm . Si ha così:

La rivelazione non coerente

⎧ − sm 2

1

⎪

aˆm = arg max ⎨e 2 N0

am

2

π

⎪

⎩

(2.19)

-5-

⎫

⎧

⎫

⎪

exp ⎨ 1 Re ⎣⎡ e jϕ0 smH r ⎦⎤ ⎬ d ϕ0 ⎬

−π

N

0

⎩

⎭

⎪

⎭

∫

π

Essendo:

sm

(2.20)

2

= Em =

smH r =

T

∫0

T

2

sm (t ) dt

∫0 r (t )sm (t )dt

*

e ponendo:

T

∫0 r (t )sm (t )dt = ρm e

(2.21)

*

j ϑm

la (2.19) si può scrivere come segue:

⎧ − Em

⎫

⎧ ρm

⎫

1 π

⎪

⎪

exp

cos(

)

(2.22)

aˆm = arg max ⎨e 2 N0

d

ϑ

+

ϕ

ϕ

⎨

0 ⎬

0⎬

m

∫

−π

am

2

π

N

⎩ 0

⎭

⎪⎩

⎭⎪

Risulta:

(2.23)

1

2π

π

∫−π e

ρm

cos( ϑm +ϕ0 )

N0

1

d ϕ0 =

2π

ρm

θm +π N cos α

0

∫θ

m −π

e

1

dα =

2π

π

∫−π e

ρm

cos α

N0

⎛ρ ⎞

d α = I0 ⎜ m ⎟

⎝ N0 ⎠

dove si è tenuto conto che l’integrando è una funzione periodica di periodo 2π e si è introdotta la funzione di Bessel modificata di prima specie e di ordine zero definita dalla:

1 π x cos α

(2.24)

I 0 ( x) =

e

dα

2π ∫−π

La stima ottima diviene allora:

⎧ − Em ⎛ ρ

⎪

aˆm = arg max ⎨e 2 N0 I 0 ⎜ m

am

⎝ N0

⎩⎪

(2.25)

⎞ ⎫⎪

⎟⎬

⎠ ⎭⎪

Nel caso di segnalazione binaria, dette s0 (t ) e s1 (t ) gli inviluppi complessi delle forme di

segnalazione corrispondenti ai simboli a0 e a1 rispettivamente, la stima del segnale trasmesso avviene secondo la regola:

E0

−

E1

2 N0

⎛ρ

I0 ⎜ 1

⎝ N0

−

⎞

⎛ ρ0 ⎞

2N

⎟ > e 0 I0 ⎜

⎟ ⇒ aˆ = a1

⎠

⎝ N0 ⎠

−

E1

2 N0

⎛ρ

I0 ⎜ 1

⎝ N0

⎞ − 2 N ⎛ ρ0

⎟ < e 0 I0 ⎜

⎠

⎝ N0

e

(2.26)

e

E0

⎞

⎟ ⇒ aˆ = a0

⎠

3 – Modulazione OOK.

3.1 – Struttura del ricevitore.

Nel caso di modulazione OOK gli inviluppi complessi dei segnali trasmessi sono:

a = a0 ⇒ s0 (t ) = 0

(3.1)

t−T

a = a1 ⇒ s1 (t ) = V0 rect T 2

( )

Si ha E0 = 0 , E1 = V02T per cui la (2.26), tenendo conto che è I 0 (0) = 1 , diventa:

-6–

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

V02T

⎛ρ ⎞

I 0 ⎜ 1 ⎟ > e 2 N0 ⇒ aˆ = a1

⎝ N0 ⎠

(3.2)

⎛ρ

I0 ⎜ 1

⎝ N0

V02T

⎞

2N

⎟ < e 0 ⇒ aˆ = a0

⎠

dove ρ1 è il modulo di:

ρ1 =

(3.3)

∞

T

T

T

∫−∞ r (t )s1 (t )dt = V0 ∫0 r (t )dt = V0 ∫0 rf (t )dt + jV0 ∫0 rq (t )dt

*

avendo posto r (t ) = r f (t ) + jrq (t ) . Poiché la funzione I0 (⋅) è monotona crescente del suo argomento, la (3.2), si trasforma nella:

w > λ ⇒ aˆ = a1

w < λ ⇒ aˆ = a0

(3.4)

dove w =

ρ1

e λ è un’opportuna costante.

V0

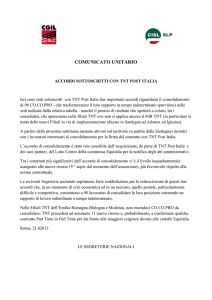

La struttura del ricevitore si presenta allora come è indicato in Fig. 2. in quanto le grandezze w f e wq presenti all’uscita dei due integratori, supponendo f 0T >> 1 :

wf = 2

(3.5)

T

T

∫0 cos(2πf0t ) ⎡⎣rf (t ) cos(2πf0t ) − rq (t ) sin(2πf0t ) ⎤⎦ dt = ∫0 rf (t )dt

wq = −2

T

T

∫0 sin(2πf0t ) ⎡⎣rf (t ) cos(2πf0t ) − rq (t ) sin(2πf0t ) ⎤⎦ dt = ∫0 rq (t )dt

coincidono con la parte reale e la parte immaginaria della variabile di decisione

ρ1

V0

2cos2πf0t

∫0 (⋅)dt

T

r(t)

λ

wf

w2f

∫0 (⋅)dt

T

+ wq2

w > λ ⇒ aˆ = a1

w

Decisione

w < λ ⇒ aˆ = a2

wq

−2sin2πf t

0

Fig. 2 – Struttura del ricevitore per rivelazione non coerente di segnalazione OOK.

Poiché è r (t ) = sm (t )e − jϕ0 + n(t ) , la statistica delle variabili aleatorie w f e wq , nota che sia

T

la fase ϕ0 , dipende dalla statistica della parte reale e immaginaria di N = ∫ n(t )dt . A tal

0

proposito, posto N = N f + jN q , in presenza di rumore bianco con densità spettrale pari a

N0

2

, si ha:

{

}

E {n f (t1 )nq (t2 )} dt1dt2 = 0

0 ∫0

T T

T

E { N 2f } = ∫ ∫ E {n f (t1 )nq (t2 )} dt1dt2 = N 0 ∫ dt = N 0T

0 0

0

T T

T

2

E { N q } = ∫ ∫ E {nq (t1 )nq (t2 )} dt1dt2 = N 0 ∫ dt = N 0T

0 0

0

E {n f (t1 )n f (t2 )} = E {nq (t1 )nq (t2 )} = N 0 δ(t2 − t1 ) e E {n f (t1 )nq (t2 )} = 0 . Le variabili aleatorie

E N f Nq = ∫

(3.6)

essendo

T

T

N f e N q costituiscono pertanto un vettore di variabili aleatorie gaussiane, a media nulla e

statisticamente indipendenti e caratterizzate dalla stessa varianza.

La rivelazione non coerente

-7-

3.2 – Probabilità di errore.

Se è trasmesso il simbolo a = a0 , il segnale complesso in arrivo al ricevitore è:

r (t ) = n(t )

(3.7)

per cui le uscite dai correlatori di Fig. 2 sono:

T

w f = ∫ n f (t )dt

0

T

(3.8)

wq = ∫ nq (t )dt

0

Esse sono variabili aleatorie gaussiane a valor medio nullo, indipendenti, e caratterizzate

da una medesima varianza σ2 = N 0T . Facendo riferimento all’Appendice A, la densità di

probabilità del primo ordine del modulo w = w2f + wq2 obbedisce alla distribuzione di Rayleigh e si ha:

⎧w

⎧⎪ w2 ⎫⎪

⎪ 2 exp ⎨− 2 ⎬

pw|a0 ( w | a0 ) = ⎨ σ

⎪⎩ 2σ ⎪⎭

⎪

⎩0

(3.9)

w≥0

w<0

Se è trasmesso il simbolo a = a1 , il segnale complesso in arrivo al ricevitore è:

r (t ) = V0 rect

(3.10)

( )e

t − T2

T

− jϕ0

+ n(t )

per cui è per le (3.5):

T

(3.11)

T

w f = ∫ ⎡⎣V0 cos ϕ0 + n f (t ) ⎤⎦ dt = V0T cos ϕ0 + ∫ n f (t )dt

0

0

T

T

wq = ∫ ⎡⎣ −V0 sin ϕ0 + nq (t ) ⎤⎦ dt = −V0T sin ϕ0 + ∫ nq (t )dt

0

0

Le variabili aleatorie w f e wq sono gaussiane, indipendenti con valori medi pari a

V0T cos ϕ0 e −V0T sin ϕ0 rispettivamente ed aventi la stessa varianza σ2 = N 0T . Con riferimen-

to all’Appendice A, la densità di probabilità del primo ordine del modulo w = w2f + wq2 obbedisce alla distribuzione di Rice e si ha:

w2 +V02T 2

⎧

−

w

⎛ V0T ⎞

2 σ2

⎪

⎜ 2 w⎟

pw|a1 ( w | a1 ) = ⎨ σ2 e

(3.12)

⎝ σ

⎠

⎪

⎩0

w≥0

w<0

La probabilità di errore, sulla base del criterio di decisione espresso dalla (3.4),

nell’ipotesi che i dati siano equiprobabili vale:

(3.13)

Pe = 12 Pr {w > λ a0 } + 12 Pr {w < λ a1 } =

∞

1

2 λ

∫

pw a0 ( w a0 )dw + 12

λ

∫−∞ pw a (w a1 )dw

1

che, ricordando le (3.9) e (3.12), diviene:

λ2

(3.14)

2

2 2

1 − 2 1 λ w

⎪⎧ w + V0 T ⎪⎫ ⎛ V0T ⎞

Pe = e 2σ + ∫ 2 exp ⎨−

⎬I 0 ⎜ 2 w ⎟ dw

2

2 0 σ

2σ2

⎠

⎪⎩

⎪⎭ ⎝ σ

Al fine di semplificare l’espressione della probabilità di errore basta osservare che, sotto

l’ipotesi a = a1 , la quantità w vale:

{(

w = V0T cos ϕ0 + N f

(3.15)

) (

2

+ −V0T sin ϕ0 + N q

)}

2

1

2

=

1

2

⎧⎪ N 2f + N q2

Nq

⎛ Nf

⎞ ⎫⎪

= V0T ⎨1 +

+

ϕ

−

ϕ

2

cos

sin

⎜

0

0 ⎟⎬

V0T

V02T 2

⎝ V0T

⎠ ⎪⎭

⎪⎩

-8–

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

Introducendo l’ulteriore ipotesi che sia:

γ=

(3.16)

V02T

N0

sufficientemente elevato, è facile dedurre che la probabilità che si verifichino gli eventi

Nf

Nq

<< 1

<< 1

V0T

V0T

è molto elevata cosicché, con probabilità molto prossima all’unità, la (3.15) si può semplificare come segue:

1

(3.17)

Nq

Nq

⎛ Nf

⎞ ⎪⎫ 2

⎞ ⎪⎫

⎪⎧

⎪⎧ ⎛ N f

w ≅ V0T ⎨1 + 2 ⎜

cos ϕ0 −

sin ϕ0 ⎟ ⎬ ≅ V0T ⎨1 + ⎜

cos ϕ0 −

sin ϕ0 ⎟ ⎬ =

V0T

V0T

⎝ V0T

⎠ ⎭⎪

⎠ ⎭⎪

⎩⎪

⎩⎪ ⎝ V0T

= V0T + N f cos ϕ0 − N q sin ϕ0

La quantità w pertanto si riduce ad una variabile aleatoria gaussiana, in quanto ottenuta dalla combinazione lineare di variabili aleatorie gaussiane. Il suo valor medio vale

V0T e la sua varianza è:

{

{ }

}

{ }

E N f cos ϕ0 − N q sin ϕ0 = E N 2f cos ϕ0 + E N q2 sin ϕ0 = N 0T = σ2

(3.18)

In tale ipotesi risulta quindi:

2

⎪⎧ ( w − V0T ) ⎪⎫

exp ⎨−

⎬

2σ 2

2πσ2

⎩⎪

⎭⎪

1

pw|a1 ( w | a1 ) =

(3.19)

È pertanto:

λ2

1 − 2 1

Pe = e 2σ +

2

2

(3.20)

λ

∫0

2

⎪⎧ ( w − V0T ) ⎪⎫

exp ⎨−

⎬dw

2σ 2

2πσ 2

⎩⎪

⎭⎪

1

Essa è una funzione del valore della soglia λ . Il valore ottimo λ 0 può allora essere de-

)

∂Pe

∂λ λ=λ

0

terminato imponendo la condizione

= 0 . È facile verificare che tale valore è la solu-

zione dell’equazione trascendente:

λ

2 0 = 1+

V0T

(3.21)

che, per elevati valori del rapporto

λ ⎤

λ ⎤

⎡

⎡

log ⎢ 2π 0 ⎥

log ⎢ 2π 0 ⎥

σ

σ⎦

⎣

⎦ = 1+

⎣

2 2

2

V0 T

V0 T

2

2 N0

2σ

V02T

N0

, diventa:

λ0 =

(3.22)

V0T

2

In tali condizioni la probabilità di errore vale:

V02T 2

1 − 2 1

Pe = e 4σ +

2

2

(3.23)

V0T

2

∫0

−

1

e

2πσ2

( w −V0T )2

2σ2

dw

D’altra parte, avendosi:

(3.24)

J=

V0T

2

∫0

−

1

2πσ

2

e

( w −V0T )2

2 σ2

dw =

VT

− 20σ

∫−

V0T

σ

−

1

2π

e

x2

2 σ2 dx

=

∫

V0T

σ

V0T

2σ

1

2π

−

e

si ha:

(3.25)

1 −

Pe = e

2

V02T 2

4 σ2

1

+ ⎡⎢Q

2⎣

( ) − Q ( )⎤⎦⎥

V0T

2σ

V0T

σ

x2

2 σ2 dx

=Q

( ) −Q( )

V0T

2σ

V0T

σ

La rivelazione non coerente

-9-

Tenendo conto della quantità γ definita dalla (3.16) è:

γ

Pe =

(3.26)

1 ⎡ −4

⎢e + Q

2 ⎢⎣

(

⎤

) ( γ )⎥⎥

γ −Q

1

2

⎦

4 – Modulazione FSK.

4.1 – Struttura del ricevitore.

Nel caso di modulazione FSK gli inviluppi complessi dei segnali trasmessi sono:

jam Δ f t

(4.1)

sm (t ) = V0 e

essendo

(4.2)

am = [ 2m − ( M + 1) ]

rect

( )

t − T2

T

( m = 1, 2, … , M )

( m = 1, 2, … , M )

e dove è T Δ f = k (intero) per garantire l’ortogonalità delle forme di segnalazione.

La (2.25) fornisce:

⎪⎧ ⎛ ρ ⎞ ⎪⎫

aˆm = arg max ⎨ I 0 ⎜ m ⎟ ⎬

am ⎪ ⎝ N 0 ⎠ ⎪

⎩

⎭

(4.3)

essendo Em = V02T indipendente da m e dove ρm è il modulo della quantità complessa:

ρm =

(4.4)

∞

T

∫−∞ r (t )sm (t )dt = V0 ∫0 r (t )e

*

− j 2 πam Δ f t

dt

Ricordando che la I 0 (⋅) è una funzione monotona crescente dl suo argomento, la (4.3)

può essere riformulata come segue:

(4.5)

aˆm = arg max {wm }

am

essendo wm =

ρm

N0

.

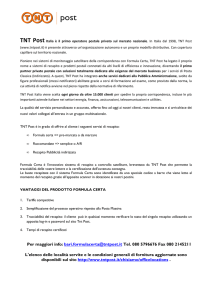

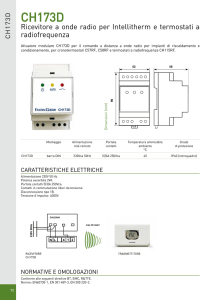

La struttura del ricevitore si presenta come mostrato in Fig. 3 in quanto le quantità

w f ,m e wq ,m all’uscita del generico integratore, nell’ipotesi che sia f 0T >> 1 :

T

w f ,m = 2∫ cos[2π( f 0 + am Δf )t ] ⎡⎣ r f (t ) cos 2πf 0t − rq (t ) sin 2πf 0 t ⎤⎦ dt =

0

T

(4.6)

T

= ∫ r f (t ) cos(2πam t Δf ) + ∫ rq (t ) sin(2πam t Δf )

0

0

T

wq ,m = −2 ∫ sin[2π( f 0 + am Δf )t ] ⎡⎣ r f (t ) cos 2πf 0 t − rq (t )sin 2πf 0 t ⎤⎦ dt =

0

T

T

0

0

= − ∫ r f (t )sin(2πam t Δf ) + ∫ rq (t ) cos(2πam t Δf )

coincidono con le parti reali e immaginarie di wm =

T

Con r (t ) = sm (t )e − jϕ0 + n(t ) è wm = ∫ sm (t )e− jϕ0 e

0

ρm

N0

− j 2 πam Δ f t

.

dt +

T

∫0 n(t )e

− j 2 πam Δ f t

dt per cui, una volta

assegnata la segnalazione sm (t ) , la statistica della parte reale e immaginaria di wm dipende

T

dalla statistica della parte reale e immaginaria di N m = ∫ n(t )e

0

− j 2 πam Δ f t

dt . A tal proposito po-

sto N m = N f ,m + jN q , m e ricordando la proprietà fra numeri complessi già utilizzata nel Cap.

2, si ha:

- 10 –

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

2cos[2π( f0 + a1Δ f )t]

T

∫0 (⋅)dt

wf ,1

w2f ,1 + wq2,1

−2sin[2π( f0 + a1Δ f )t]

w1

T

∫0 (⋅)dt

wq,1

v(t)

Calcola

il massimo

2cos[2π( f0 + aM Δ f )t]

T

∫0

(⋅)dt

â

wf ,M

w2f , M + wq2,M

2sin[2π( f0 + aM Δ f )t]

wM

T

∫0 (⋅)dt

wq,M

Fig. 3 – Struttura del ricevitore per rivelazione non coerente di segnalazione FSK.

(4.7)

{

}

{

}

{

}

{

}

T T

T T

⎛

⎞

E N 2f , m = 12 ⎜ Re ⎢⎡ ∫ ∫ E n* (t1 )n(t2 ) e j 2 πam (t2 −t1 ) dt1dt2 ⎥⎤ + Re ⎢⎡ ∫ ∫ E {n(t1 )n(t2 )} e− j 2 πam (t2 + t1 ) dt1dt2 ⎥⎤ ⎟

0

0

0

0

⎣

⎦

⎣

⎦

⎝

⎠

T

T

T

T

⎛

⎞

E N q2,m = 12 ⎜ Re ⎡⎢ ∫ ∫ E n* (t1 )n(t2 ) e j 2 πam (t2 −t1 ) dt1dt2 ⎤⎥ − Re ⎡⎢ ∫ ∫ E {n(t1 )n(t2 )} e− j 2 πam (t2 + t1 ) dt1dt2 ⎤⎥ ⎟

⎣ 0 0

⎦⎠

⎦

⎝ ⎣ 0 0

{

}

T T

T T

⎛

⎞

E N f , m N q ,m = 12 ⎜ Im ⎢⎡ ∫ ∫ E n* (t1 )n(t2 ) e j 2 πam (t2 −t1 ) dt1dt2 ⎥⎤ + Im ⎢⎡ ∫ ∫ E {n(t1 )n(t2 )} e− j 2 πam (t2 + t1 ) dt1dt2 ⎥⎤ ⎟

⎦

⎣ 0 0

⎦⎠

⎝ ⎣ 0 0

{

}

da cui, si ottiene:

{ }

E {N } = N ∫

T

E N 2f , m = N 0 ∫ dt = N 0T

(4.8)

2

q,m

{

0

}

0

T

0

dt = N 0T

E N f ,m N q,m = 0

Le quantità N f , m e N q , m sono pertanto due variabili aleatorie gaussiane, indipendenti a

valor medio nullo e caratterizzate dalla stessa varianza σ2 = N 0T .

4.2 – Probabilità di errore.

Allo scopo di determinare l’espressione della probabilità di errore per simbolo basta

supporre che il trasmettitore invii la segnalazione s1(t ) . Poiché per la simmetria del sistema

tale probabilità condizionata è la stessa qualsiasi sia la segnalazione inviata, la probabilità

di errore, se le segnalazioni sono equiprobabili, si identifica con la probabilità di errore

condizionata P (e a1 ) .

La rivelazione non coerente

- 11 -

j 2 πa Δ t

Essendo con a = a1 , r (t ) = V0 e 1 f e− jϕ0 + n(t ) si ha:

T

T

ρ

w1 = 1 = ∫ ⎡⎣V0 e j (2 πa1t Δf −ϕ0 ) + n(t ) ⎤⎦e− j 2 πa1t Δf dt = V0Te− jϕ0 + ∫ n(t )e− j 2 πa1t Δf dt

0

0

N0

(4.9)

T

T

ρ

wm = m = V0 ∫ ⎡⎣V0 e j (2 πa1t Δf −ϕ0 ) + n(t ) ⎤⎦e − j 2 πamt Δf dt = V0 ∫ n(t )e− j 2 πa1t Δf dt

0

0

N0

( m ≠ 1)

le cui parti reali e i coefficienti delle pari immaginarie si possono porre nella forma:

⎧⎪ w f ,1 = V0T cos ϕ0 + N f ,1

⎨

⎪⎩ wq,1 = −V0T sin ϕ0 + N q,1

(4.10)

⎧⎪ w f ,m = N f ,m

( m ≠ 1)

⎨

⎪⎩ wq,m = N q,m

Dalle (4.10) si deduce facilmente che le quantità w f ,m e wq,m sono delle variabili aleatorie gaussiane statisticamente indipendenti e hanno la stessa varianza data da σ2 = N 0T . È

da osservare che per m ≠ 1 presentano valor medio nullo, mentre per m = 1 si ha

{

}

{ }

E w f ,1 = V0T cos ϕ0 e E wq,1 = −V0T sin ϕ0 . Quanto detto comporta che la densità di proba-

bilità del modulo w1 obbedisce ad una distribuzione di Rice, mentre quelle dei moduli wm ,

con m ≠ 1 , obbediscono a distribuzioni di Rayleigh. È pertanto:

w2 +V 2T 2

⎧

− 1 02

w

⎛ V Tw ⎞

2σ

⎪

I 0 ⎜ 0 2 1 ⎟ w1 ≥ 0

pw1 ( x ) = ⎨ σ2 e

⎝ σ ⎠

⎪

w1 < 0

0

⎩

(4.11)

2

w

⎧

− m

⎪ wm e 2σ2

wm ≥ 0

pwm ( x ) = ⎨ σ2

(m

⎪

wm < 0

⎩0

≠ 1)

La probabilità di una corretta decisione è la probabilità che si verificano gli eventi

w1 > w2 > … > wM e quindi è

{

Pc = Pr w2 < w1, w3 < w1,… , wM < w1 a1

(4.12)

}

che si può riscrivere come segue:

(4.13)

Pc =

∞

∫−∞ Pr {w2 < w1, w3 < w1,… , wM

< w1 w1, a1} pw1 a1 ( w1 a1 )dw1

e cioè condizionandola al valore della quantità w1 . Dal momento che le quantità wm ( m ≠ 1 ),

essendo gaussiane e incorrelate, sono statisticamente indipendenti, la precedente si semplifica nella:

(4.14)

Pc =

∞

∫−∞ ⎡⎣Pr {w2 < w1 w1, a1}⎤⎦

M −1

pw1 a1 (w1 a1 )dw1

Tenendo conto delle prime delle (4.11) si ha:

(4.15)

Pr {w2 < w1 w1, a1 } =

w1

∫0

pw1 a1 ( x a1 )dx =

w1

∫0

e quindi

(4.16)

x2

⎡

− 2

2

⎢

Pc = ∫ 1 − e σ

−∞ ⎢

⎣

∞

⎤

⎥

⎥

⎦

M −1

⎧⎪ x 2 + V02T 2 ⎫⎪ ⎧V0T ⎫

−

exp

⎨

⎬ I 0 ⎨ 2 x ⎬ dx

2σ 2

σ2

⎭

⎪⎩

⎪⎭ ⎩ σ

x

w2

− 12

⎧⎪ x 2 ⎫⎪

2σ

exp

1

dx

e

−

=

−

⎨

2⎬

σ2

⎩⎪ 2σ ⎭⎪

x

- 12 –

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

x2

⎡

− 2

2

Sviluppando l’espressione ⎢1 − e σ

⎢

⎣

⎤

⎥

⎥

⎦

x2

⎡

− 2

⎢1 − e 2σ

⎢

⎣

(4.17)

M −1

con la formula di Newton, si ottiene:

⎤

⎥

⎥

⎦

M −1

M −1

∑

=

k =0

x2

−k 2

n ⎛ M −1⎞

⎟⎟e 2 σ

(−1) ⎜⎜

⎝ k ⎠

e quindi:

Pc =

(4.18)

M −1

∑

k =0

⎛ M −1⎞ ∞

⎟⎟

(−1)n ⎜⎜

⎝ k ⎠ −∞

∫

x

σ

2

−

( k +1)x 2 +V02T 2

2 σ2

e

⎧V T

I 0 ⎨ 02

⎩σ

⎫

x ⎬ dx

⎭

È facile verificare che dalla precedente, sommando e sottraendo al termine

la quantità

V02T 2

2

2 σ ( k +1)

( k +1) x 2 +V02T 2

2σ2

si ottiene:

Pc =

(4.19)

−

M −1

∑

k =0

k V02T 2

−

2

k ⎛ M −1⎞ 1

k

⎟⎟

(−1) ⎜⎜

e +1 2σ

+

1

k

k

⎝

⎠

⎧ x 2 + V02T 2 ⎫ ⎧ V02T

2 ⎪

⎪

⎪

exp ⎨ − ( k 2+1) ⎬ I 0 ⎨ k +21

σ2

σ

2σ

⎪

⎪ ⎪

k +1

k +1

⎩

⎭ ⎩ k +1

∞

x

∫−∞

⎫

⎪

x ⎬ dx

⎪⎭

dove, come si può riconoscere essendo la funzione integranda una distribuzione di Rice

con parametri

(4.20)

σ

2

=

σ2

k +1

e

m

=

V02T

k +1

, l’integrale vale 1 .Si ha in definitiva:

Pc =

M −1

∑

k =0

k V02T 2

−

2

k ⎛ M −1⎞ 1

k

(−1) ⎜⎜

e +1 2σ

⎟⎟

⎝ k ⎠ k +1

e quindi la probabilità di errore per simbolo è

(4.21)

Pe = 1 −

M −1

∑

k =0

k V02T 2

−

2

k ⎛ M −1⎞ 1

⎟⎟

(−1) ⎜⎜

e k +1 2σ

⎝ k ⎠ k +1

Ricordando l’espressione della varianza σ2 si deduce infine:

(4.22)

Pe = 1 −

M −1

∑

k =0

k V0T

−

k +1 2 N0

k ⎛ M −1⎞ 1

⎟⎟

(−1) ⎜⎜

e

⎝ k ⎠ k +1

Introducendo l’energia media della segnalazione E =

(4.23)

Pe = 1 −

M −1

V02T

, la

2

k E

−

k +1 N 0

precedente diviene:

∑ (−1)k ⎜⎜⎝ Mk−1⎟⎟⎠ k + 1 e

⎛

1

⎞

k =0

Nel caso di modulazione FSK binaria ( M = 2 ), dalla precedente si ha:

(4.24)

Pe = e

1

2

che in termini del rapporto segnale/rumore γ =

−

E

2 N0

V02T

N0

γ

(4.25)

−

Pe = 1 e 2

2

si scrive:

La rivelazione non coerente

- 13 -

APPENDICE

DISTRIBUZIONI DI RAYLEIGH E DI RICE

1 - Distribuzione di Rayleigh.

Sia

Z = X + jY

(1)

una variabile aleatoria complessa dove X e Y denotano due variabile aleatorie reali che si

suppongono entrambe gaussiane, a media nulla, aventi la stessa varianza σ2 e statisticamente indipendenti. Ciò comporta che la loro densità di probabilità incrociata è espressa

dalla:

p X ,Y ( x, y ) =

(2)

x2 + y 2

2σ2

−

1

2πσ2

e

Posto

Z = Re jϕ

(3)

per dedurre la statistica della variabile aleatoria R , basta considerare la trasformazione da

coordinate polari a coordinate cartesiane:

x = r cos ϕ

(4)

y = r sin ϕ

ϕ ∈ [ −π, π )

ed eguagliare la probabilità con cui si verifica un evento elementare sia che esso sia rappresentato nel sistema di coordinate cartesiane ( X , Y ) che in quello polare ( R, Φ) .

Cioè

(5)

dr

dy

dx

r

dϕ

p X ,Y ( x, y )dxdy = pR ,Φ (r , ϕ)drd ϕ

D’altra parte, facendo riferimento alla

Fig.1, è:

Fig. 1 – Coordinate rettangolari e polari.

dxdy = dr ( rd ϕ)

(6)

per cui, tenendo conto delle (3) e della (4), si deduce la seguente densità di probabilità congiunta:

(7)

pR ,Φ (r , ϕ) =

−

r

2πσ

2

e

r2

2 σ2

r ∈ [ 0, ∞ )

ϕ ∈ [ −π, π]

Integrando la (7) rispetto a ϕ si ottiene la densità di probabilità del primo ordine della

variabile aleatoria R :

(8)

pR ( r ) =

2

⎪⎧ r ⎪⎫

r

exp

dϕ

−

⎨

2⎬

2πσ2 ∫−π

⎩⎪ 2σ ⎭⎪

1

π

e risulta:

(9)

⎧ r

⎪ exp

pR ( r ) = ⎨ σ 2

⎪0

⎩

nota come distribuzione di Rayleigh.

{ }

−

r2

2 σ2

r ≥0

r ≤0

- 14 –

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

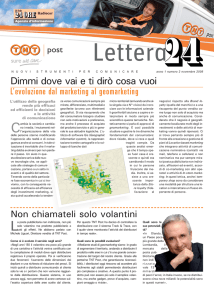

In Fig. 2 è riportato l’andamento della distribuzione di Rayleigh.

In modo analogo, integrando la (7) rispetto

pR (r)

a r si ottiene la densità di probabilità del

primo ordine della variabile aleatoria Φ :

⎧⎪ r 2 ⎫⎪

∞

1

pΦ (ϕ) =

r

exp

(10)

⎨− 2 ⎬ dr

∫

2πσ 2 0

⎩⎪ 2σ ⎭⎪

e risulta, come è facile verificare:

⎧1

−π ≤ ϕ < π

⎪

(11)

pΦ (ϕ) = ⎨ 2π

⎪⎩ 0

altrove

r

Fig. 2 – Distribuzione di Rayleigh

e cioè la variabile aleatoria Φ è uniformemente distribuita in [ −π, π ) .

Poiché, tenendo conto delle (7), (9) e (10) risulta:

(12)

pR ,Φ (r , ϕ) = pR (r ) pΦ (ϕ)

si conclude chele variabili aleatorie Φ e R sono statisticamente indipendenti.

2 - Distribuzione di Rice.

Si consideri la variabile aleatoria complessa

(13)

Z = Re jΦ = X + jY

in cui X e Y denotano due variabile aleatorie reali che si suppongono entrambe gaussiane,

aventi la stessa varianza σ2 , statisticamente indipendenti ma aventi valori medi dati da

mx e m y rispettivamente. La loro densità di probabilità incrociata è espressa dalla:

(14)

p X ,Y ( x, y ) =

−

1

2πσ2

e

( x − mx ) 2 + ( y − m y ) 2

2σ2

Per dedurre la statistica della variabile aleatoria R , si può, anche in questo caso, fari

riferimento alla trasformazione:

(A.12)

x − mx = r cos ϕ

y − m y = r sin ϕ

ϕ ∈ [ −π, π )

ed eguagliare la probabilità con cui si verifica un evento elementare sia che esso sia rappresentato nel sistema di coordinate cartesiane ( X , Y ) che in quello polare ( R, Φ) .

Con la stessa procedura sviluppata nel caso della distribuzione di Rayleigh, si può verificare che la densità di probabilità incrociata delle variabili aleatorie R e Φ è data dalla

(15)

pR ,Φ (r , ϕ) =

−

r

2πσ

2

e

che, ponendo

(16)

diventa:

m = mx2 + m 2y

e

( x − mx ) 2 + ( y − m y ) 2

2 σ2

mx = m cos ψ

m y = m sin ψ

La rivelazione non coerente

- 15 -

⎧⎪ r 2 + m 2 − 2mr (cos ψ cos ϕ + sin ψ sin φ) ⎫⎪

exp

⎨−

⎬=

2πσ2

2σ 2

⎩⎪

⎭⎪

r

pR ,Φ (r , ϕ) =

(17)

2

2

⎪⎧ r + m − 2mr cos(ϕ − ψ ) ⎪⎫

exp

−

⎨

⎬

2πσ2

2σ 2

⎪⎩

⎪⎭

r

=

La densità di probabilità della variabile aleatoria R si ottiene allora per integrazione della

(17) rispetto a ϕ ; si ha:

pR ( r ) =

(18)

π

∫−π

pR ,Φ (r , ϕ)d ϕ =

−

r

2πσ

2

e

r 2 + m2

2 σ2

π

∫−π

mr

eσ

2

cos( ϕ−ψ )

dϕ

Per calcolare l’integrale che compare nella (A.16) basta porre ϕ − ψ = θ . Risulta:

I =∫

(19)

π

−π

mr

cos( ϕ−ψ )

2

eσ

dϕ

=∫

π−ψ

−π−ψ

mr

cos θ

2

eσ

dθ

=∫

π

−π

mr

cos θ

2

eσ

dθ

dove si è tenuto conto del fatto che, essendo l’integrando una funzione di θ periodica di

periodo 2π , l’integrale può essere esteso ad un qualsiasi intervallo purché di lunghezza 2π .

Ricordando infine che

1 π x cos θ

I 0 ( x) =

e

dθ

(20)

2π ∫−π

rappresenta

la

funzione

pR (r)

m1

di

Bessel

modificata di prima specie e di ordine 0 , la

(18) diventa:

(21)

r 2 + m2

⎧

−

r

2 σ2 I

⎪

0

pR ( r ) = ⎨ σ 2 e

⎪

⎩0

( )

mr

σ2

m2 < m1

m3 < m2

m4 < m3

r ≥0

r

r <0

Fig. 3 – Distribuzione di Rice per diversi valori di m .

che costituisce la distribuzione di Rice.

La distribuzione di Rice è riportata in Fig. 3 per diversi valori del parametro m dove è

m < m2 <

.