Analisi degli errori

Università degli Studi di Milano

Facoltà di Scienze MM, FF, NN

Corso di Laurea in Fisica

Laboratorio di fisica

ANNO ACCADEMICO 2001-2002

Laboratorio di fisica: Professori

Masserini

Colò

Piovella

Appunti di:

Dario Mazzorin

-1-

Analisi degli errori

Laboratorio di fisica........................................................................................................................... 1

Le incertezze: ...................................................................................................................................... 4

Le Incertezze .................................................................................................................................................. 4

Stima delle Incertezze:............................................................................................................................... 4

Incertezze relative:..................................................................................................................................... 4

Discrepanza:.................................................................................................................................................. 5

Confronto di due misure: ........................................................................................................................... 5

Distribuzione Normale: ..................................................................................................................... 6

Distribuzione limite ....................................................................................................................................... 6

La distribuzione normale: ............................................................................................................................. 6

La media come miglior stima: ................................................................................................................... 7

Sigma: la deviazione standard ................................................................................................................... 8

Propagazione degli errori: ............................................................................................................................ 9

Due casi facili: ........................................................................................................................................... 9

Somma di grandezze misurate: .................................................................................................................. 9

Il caso generale: ....................................................................................................................................... 10

Prodotto di grandezze misurate: .............................................................................................................. 11

Incertezza sulla media: la deviazione standard della media. ................................................................... 11

Accettabilità di una risposta misurata......................................................................................................... 11

Trattamento Avanzato dei Dati ...................................................................................................... 13

Rigetto dei dati ............................................................................................................................................ 13

Quando: ................................................................................................................................................... 13

Come: ...................................................................................................................................................... 13

Medie pesate ................................................................................................................................................ 13

Quando .................................................................................................................................................... 13

Come: ...................................................................................................................................................... 14

Regressione lineare: .................................................................................................................................... 15

Quando: ................................................................................................................................................... 15

Come: ...................................................................................................................................................... 15

Incertezza su y ......................................................................................................................................... 16

Incertezza su A e B .................................................................................................................................. 16

Incertezza non trascurabile su x............................................................................................................... 17

Altre regressioni: ......................................................................................................................................... 17

Regressione polinomiale.......................................................................................................................... 17

-2-

Analisi degli errori

Funzioni esponenziali .................................................................................................................................. 18

Regressione multipla ................................................................................................................................... 19

Covarianza e Correlazione .............................................................................................................. 20

Covarianza: ................................................................................................................................................. 20

Coefficiente di correlazione lineare: ........................................................................................................... 21

Valutazione del coefficiente di correlazione lineare ................................................................................... 21

La distribuzione binomiale .............................................................................................................. 22

Tanto per intenderci:................................................................................................................................ 22

Definizione di distribuzione binomiale ................................................................................................... 22

Proprietà della binomiale ......................................................................................................................... 22

Distribuzione di Poisson .................................................................................................................. 24

La Poisson ................................................................................................................................................... 24

come conteggio medio atteso ............................................................................................................... 24

Proprietà della distribuzione di Poisson ..................................................................................................... 25

La deviazione Standard: .......................................................................................................................... 25

Approssimazione Gaussiana alla distribuzione di Poisson ...................................................................... 25

Come eliminare il rumore di fondo: ........................................................................................................ 25

Il test chi–quadro per una distribuzione ........................................................................................ 26

2 per la distribuzione di Gauss................................................................................................................... 26

Gli intervalli per il 2: ................................................................................................................................. 26

Misure di una variabile continua ............................................................................................................. 27

Misura di una variabile discreta............................................................................................................... 27

Altri utilizzi: ............................................................................................................................................ 27

Chi–quadrato ridotto ................................................................................................................................... 27

Vincoli e gradi di libertà di una distribuzione ......................................................................................... 27

Chi–quadro ridotto................................................................................................................................... 28

Probabilità per il chi–quadro ...................................................................................................................... 28

Integrale normale ............................................................................................................................. 29

Note: .................................................................................................................................................. 30

-3-

Analisi degli errori

Le incertezze:

INCERTEZZA

In ogni misura c'è una possibilità di errore, da qui l'importanza di considerare una grandezza ne tenga conto:

l'incertezza. Siccome è poco probabile azzeccare con delle misurazioni il valore vero di una grandezza da

misurare, allora si indica la miglior stima che sì è giunti a valutare, e, assieme a questa indicazione, si dichiara

l'incertezza: ovvero il margine di errore: l'insieme dei valori più probabili.

L'incertezza di una misura x viene sovente indicata col simbolo: x

Stima delle Incertezze:

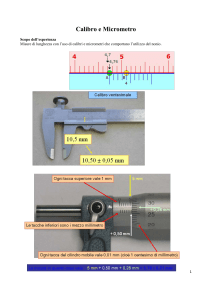

Se si misura una lunghezza con uno strumento millimetrico digitale è evidente che l'incertezza (al di là degli

errori che può commettere chi prende la misura, o degli errori che può aver commesso chi ha tarato lo

strumento) è di 1 mm. Questo fatto comporta che se una lunghezza viene attesta ad un valore di 58 mm,

questa misura indica che il valore vero è compreso tra 57,5 e 58,5.

[58 0,5 mm]

Se si utilizzasse un righello centimetrico, invece, chi compie la misura osserverebbe che il valore è compreso

tra 5 cm e 6 cm e che si avvicina più a 6 cm. Anche qui stima 5,8 cm ma questa volta l'incertezza è più

ampia, di 0,2 cm, per esempio, e quindi dichiarerebbe che la lunghezza dell'oggetto è compresa tra 5,7 e 5,9

cm.

[58 1 mm]

Non tutte le incertezze sono dovute alla lettura o alla scala utilizzata dallo strumento; certe volte le incertezze

sono dovute a difficoltà tecniche: come l'avvio e lo stop di un cronometro. Sebbene molti cronometri abbiano

precisione di un decimo di secondo, se questi debbono essere attivati manualmente, è facile che la maggior

fonte di errore sia dovuta al tempo fisiologico di reazione. Per questo è consigliabile ripetere più volte questo

tipo di misurazioni. In questi casi è naturale assumere come migliore stima il valore medio ed è ragionevole

presumere che il valore vero sia compreso tra il valore più piccolo ed il più grande.

Si supponga di star effettuando un esperimento che implichi il conteggio di un determinato evento A che si

presenta casualmente nel tempo. Se l'evento possiede un tasso medio di occorrenze definito (come accade

agli oscillatori al quarzo), allora l'incertezza nel numero conteggiato di eventi casuali, inteso come stima del

valor medio atteso di eventi, è la radice quadrata del numero conteggiato.

Incertezze relative:

L'incertezza x indica la precisione e quindi l'attendibilità di una misura. Tuttavia occorre tener presente che

una stessa incertezza può essere indice di una pessima misura come di un'ottima. Per esempio se avessimo x

= 3000 0,01m vorrebbe dire che la misura è estremamente precisa mentre se x = 0,03 m 0,01 m la stessa

incertezza sarebbe sintomo di una misura piuttosto grossolana. Da ciò è la necessità di istituire un'altra

grandezza: l'incertezza frazionaria: definita nel seguente modo:

Incertezza frazionaria

-4-

x

|xbest |

Analisi degli errori

l'incertezza frazionaria è detta anche precisione o incertezza relativa.

DISCREPANZA:

La discrepanza è la differenza algebrica tra due sessioni di misurazioni. La discrepanza si dice significativa

se l'intersezione dei valori possibili dichiarati dalla prima e dalla seconda sessione è vuota. Ovvero se non

vengono indicati valori possibili comuni alle due misurazioni. Non significativa in caso contrario. La

discrepanza, quindi, non deve essere valutata per la sua entità, quanto piuttosto per quanto essa è grande in

confronto con le incertezze nelle misure.

Se il rapporto tra la discrepanza di una misura con il valore vero e l'incertezza della misura stessa è minore o

di poco maggiore a 2, allora la stima è detta accettabile.

Confronto di due misure:

Potrebbe presentarsi la necessità di dover confrontare due misure a e b che secondo una teoria dovrebbero

essere uguali, per farlo introduciamo il concetto di consistenza. Se i margini di errore delle due grandezze a e

b misurate si sovrappongono, allora le misure si dicono consistenti con la teoria.

-5-

Analisi degli errori

Distribuzione Normale:

In questo capitolo si occupa del trattamento statistico di dati misurati affetti da piccoli errori casuali e da

trascurabili errori sistematici.

DISTRIBUZIONE LIMITE

Supponiamo di possedere un set di N dati, possiamo dividerlo in intervalli di ugual dimensione e contare

quante delle nostre rilevazioni cadono in ogni intervallo. Se si rappresenta graficamente il risultato con un

istogramma, si ottiene una certa figura detta distribuzione. Man mano che aumenta il numero di misurazioni,

l'istogramma dovrebbe assumere sempre più una forma definita. Quando il numero di misure si avvicina

all'infinito, la loro figura si avvicina ad una curva continua, definita. Se e quando ciò accade, la curva

continua è chiamata curva della distribuzione limite.

La distribuzione limite è una curva teorica che non può essere ottenuta dall'istogramma: solo se potessimo

fare infinite misurazioni e distinguere i dati in intervalli infinitesimi potremmo ottenerla.

Supponiamo di avere molti dati raccolti su un esperimento e di rappresentarli graficamente con un

istogramma. A questo punto potremmo riuscire a determinare la distribuzione limite come funzione f delle

ascisse. Allora si avrebbe che:

f(x) dx = numero di misure che cadono tra x e x + dx

b

f x d x = numero di misure che cadono tra x = a

e x = b.

a

Per sfruttare statisticamente la distribuzione limite occorre che sia normalizzata. Ovvero che il suo integrale

tra meno infinito ed infinito abbia valore unitario. Se la funzione limite è normalizzata allora:

f(x) dx = probabilità che una misura cada tra x e x + dx

b

f x d x = probabilità che una misura cada tra x = a

e x = b.

a

Inoltre si hanno i seguenti importanti risultati:

x =

x f x d x

x =

2

x x

2

f x d x

LA DISTRIBUZIONE NORMALE:

Misurazioni affette da piccoli errori casuali e trascurabili errori sistematici, riprodotte graficamente tramite

istogramma, dovrebbero assumere una forma a campana tipo la seguente:

-6-

Analisi degli errori

se ciò non avviene le cause possono essere molteplici come la non casualità degli errori che noi pensiamo

casuali.

Se invece ciò avviene allora chiameremo la distribuzione a campana, distribuzione normale. Di questa

distribuzione conosciamo pure la funzione della distribuzione limite che è descritta dalla funzione di Gauss

così definita:

x X 2

f = e 2

La funzione gaussiana ha due parametri X e . X è il valore vero e x = X è un asse di simmetria per la curva,

infatti, se gli errori sono veramente casuali la probabilità di sovrastimare è la stessa di sottostimare. Il

parametro invece ne determina la larghezza detta anche snellezza: se i nostri dati sono accurati cadranno

vicini al valore vero quindi la curva sarà più alta e snella, ovvero il parametro sarà piccolo. Normalizzata

la funzione di Gauss assume una forma lievemente diversa: visto che

2

e

x x

2

2

2

dx 2

per la normalizzazione è sufficiente introdurre una costante moltiplicativa perché l'integrale della gaussiana

abbia valore unitario. Ovvero la curva, nella sua forma più comune, normalizzata sarà:

G x , (x) =

1

2

x x 2

e

2 2

La media come miglior stima:

Se effettivamente conoscessimo la funzione che caratterizza la distribuzione, potremmo calcolare il valore

vero e la sigma dopo infinite misurazioni. Purtroppo così non è, in pratica la distribuzione limite è il risultato

di una sega mentale: noi abbiamo solo un numero finito di valori: x1, x2, … , xN e la distribuzione limite

possiamo solo immaginarci come sia.

In questo sottocapitolo si dimostrerà che la miglior stima per X (il valore vero di x) è proprio il valor medio

x

Pensiamo di costruire una distribuzione limite con dei valori arbitrari di X e di . Una volta scelti i

parametri, è possibile ottenere la probabilità che esca un determinato valore x molto vicino a xj:

-7-

Analisi degli errori

x j X

2

1

P(x vicino a xj) e

2 2

Da questa relazione si può arrivare a calcolare la probabilità totale di ottenere l'intero set di dati. Infatti:

x j x 2

N

1 2 2

P(set dati) =

P x i N e

i 1

Ora supponiamo di cercare per quali valori di X la produttoria è massima: ovvero il valore di X che rende più

probabile il set di dati. A questo scopo bisogna che l'argomento dell'esponenziale sia massimo; ovvero è

sufficiente trovare il valore di X che rende massima la seguente somma:

Se si deriva su X si ottiene la seguente sommatoria:

x j X 2

2 2

x j X

2

che posta uguale a zero dà i seguenti risultati:

x j X = 0

x – NX = 0

N

N

=>

j

j1

j1

Pertanto risulta evidente che:

X= x

x

j

N

Sigma: la deviazione standard

Lo stesso procedimento impiegato per la determinazione della miglior stima per X lo si può applicare anche

per trovare il valore di : basta derivare per invece che per X. Il risultato è il seguente:

x j x 2

2 2

e

N 1

N xj x

2

2

0

Da cui si può verificare che risulta:

xj x

2

xj x

1

N

N

2

= x

Questo valore è detto Deviazione Standard e viene indicato con il simbolo x. Questo indice, oltre ad indicare

la larghezza della gaussiana, è un indice di quanto le nostre misure sono precise. Se si volesse calcolare la

probabilità che un valore cada tra X– x e X + x è sufficiente calcolare il seguente integrale:

x

G

x

X ,

x =

1

2

x X 2

X

e

2 2

X

Sostituendo (x – X) / = z, e cambiando gli estremi di integrazione si ottiene il seguente integrale:

-8-

Analisi degli errori

1

1

2

z2

e 2

d z = 0,6826…

1

Questo risultato è molto importante perché afferma che in tutti i casi, per qualunque set di dati, calcolata la

deviazione standard e la media è possibile dire che i valori, al 68%, cadono dentro l'intervallo X – x e X +

x . Per questa ragione la deviazione standard è sovente utilizzata per indicare l'incertezza dei dati.

Quella data non è l'unica definizione di deviazione standard, ne esiste un'altra, perfezionata, che garantisce

risultati migliori in condizioni di scarsità di dati.

x

xj x

2

N 1

Questa seconda definizione non verrà giustificata se non osservando che, se per assurdo, avessimo una sola

misura il valore di sigma sarebbe nullo!

PROPAGAZIONE DEGLI ERRORI:

Ora sappiamo trovare la miglior stima di un set di dati e calcolare la loro incertezza. Ma di rado le

misurazioni sono fini a se stesse: solitamente devono essere combinate con altre, allora come si propaga

l'errore?

Due casi facili:

Supponiamo di aver misurato una grandezza e di averlo espresso nella forma X = x x.

Se dovessimo sommare a X una costante A priva di incertezza, quanto sarà l'incertezza su X + A? Mi rifiuto

di dimostrarlo, rimane x! Ovvero: X + A = (x + A) x.

Ovvero, pensiamo di produrre X per una costante priva di incertezza k e di voler calcolare l'incertezza del

prodotto. Allora si ha:

y = kX

P(un valore y) P(x = y/k)

e

2

y

X

k

2

2 x

y kX 2

2 k 2 2x

e

Quindi risulta chiaro che y = kx.

Somma di grandezze misurate:

Supponiamo di aver trovato due grandezze nella forma X = x x e Y = y y. Incominciamo col calcolare

la probabilità di trovare un determinato valore per x e per y:

P(x) exp(–x2/2x2)

P(y) exp(–y2/2y2)

-9-

Analisi degli errori

Per il calcolo statistico si ha che la probabilità di ottenere una coppia di x e y è il prodotto delle probabilità

quindi:

P(x, y) = P(x)P(y) exp[(–x2/2x2) + (–y2/2y2)]

Concentriamoci sull'esponente:

2

2

2

1 x 2 y 2

1 x y 2 1 y x x y

1 x y 2 z 2

2

2

2

2

2

2

2

2

2 x y

2 x y 2 xy x y

2 2x 2y

2

Il primo addendo dell'espressione risultante è una funzione di x + y, mentre il secondo è una combinazione di

x – y. Per questo motivo i valori assunti dal primo addendo al variare di x e y sono assolutamente scollegati

ed indipendenti da quelli che assumono il secondo addendo. Siccome del secondo addendo non ce ne può

fregar dimeno, l'ho abbreviato con z2 che, per le considerazioni appena fatte, funziona come variabile a se

rispetto ad x e y. Detto questo, la probabilità di ottenere un determinato valore di x ed un determinato valore

di y si è trasformata nella probabilità di ottenere un determinato valore di x + y e un valore di z. Ovvero

possiamo scrivere:

1 x y 2 z 2

2 2x 2y 2

1 x y 2

2 2x 2y

z2

2

P(x + y, z) e

e

e

Per ottenere la probabilità di ottenere un determinato valore di x + y ed un arbitrario valore di z bisogna

integrare la probabilità precedente su z da – a +. In realtà, per osservazioni fatte il primo termine

(funzione di x + y) del prodotto risultante appena espresso, è completamente indipendente dal secondo

termine funzione di z, per cui agli effetti pratici si comporta come una costante. Quindi abbiamo che:

1 x y

2 2x 2y

2

e

e

z2

2

dze

1 x y 2 z 2

2 2x 2y

e 2

dze

1 x y 2

2 2x 2y

2

A questo punto abbiamo finito, infatti sarà chiaro a tutti che:

P(x + y) e

1 x y 2

2 2x 2y

Ovvero che l'errore su x + y è distribuito normalmente attorno al valore vero con larghezza =

2x 2y

Il caso generale:

Supponiamo di avere due grandezze misurate X e Y espressi nella forma X = x + x e Y = y + y. In questo

sottocapitolo ci chiediamo come si propaga l'errore su una grandezza q = f(X, Y), con f funzione qualunque.

La risposta è molto semplice: se effettivamente le deviazioni x e y sono ragionevolmente piccole rispetto a

x e y, allora è possibile fare la seguente approssimazione:

f

f

( x) + ( y)

x

y

f(X, Y) f(x, y) +

Quindi si ottiene che f(X, Y) è uguale ad un valore f(x,y) privo di incertezze più la somma di due incertezze

moltiplicate per due costanti; quindi, memori dei risultati ottenuti:

2

f

f

x y

x

y

f(X, Y) = f(x, y)

-10-

2

Analisi degli errori

Prodotto di grandezze misurate:

Supponiamo di avere due grandezze misurate X e Y espressi nella forma X = x + x, Y = y + y e Z = z + z

e di voler calcolare l'incertezza sul prodotto q = XYZ.

Per la regola appena enunciata abbiamo che :

q =

y z x 2 x z x 2 x y x 2

Quindi se ci interessa l'incertezza relativa q / q si ottiene:

q

q

1

2

x y2z2

y z

x

2 x z x 2 x y x 2

2

2

2

y

x

z

x

z

y

=

Incertezza sulla media: la deviazione standard della media.

Supponiamo di avere N misure scritte nella solita maniera Xj = xj xj provenienti da rilevazioni fatte su un

unico esperimento e tutte allo stesso modo, con lo stesso strumento e di voler calcolare la media dei risultati.

Allora l'incertezza sulla media può essere facilmente calcolata. Innanzitutto dalle ipotesi abbiamo che tutte le

deviazioni sono uguali al medesimo valore x. Inoltre visto che:

x

1

N

N

x

i

i 1

la derivata parziale di x medio su xj vale zero per tutti gli addendi della sommatoria che non contengono xj.

Ovvero risulta:

x

xj

1

0 ... 0

0 ... 0

x j

x j N

N

Il che significa che applicando la legge generalizzata sulla propagazione dell'errore si ha:

=

N

2

1

N

i 1

x

1 2

N 2 x x

N

N

Questo valore è detto anche deviazione standard della media ed è dotato di una simbologia ad hoc: x

ACCETTABILITÀ DI UNA RISPOSTA MISURATA

Supponiamo di misurare una grandezza X = xbest . Supponiamo inoltre di attenderci per teorie alternative

o per misure di altri un valore xe. Allora si dice che il nostro valore X differisce da xe per t deviazioni

standard, dove:

t=

x best x e

-11-

Analisi degli errori

Assumendo che x sia normalmente distribuito attorno a xe con larghezza , possiamo trovare, grazie

all'integrale normale, la probabilità P(fuori di t) nella seguente maniera:

P(fuori di t) = 1 – P(entro t) = 1 –

1

2

t

e

z2

2

dz

t

A questo punto abbiamo un indice di quanto la nostra misura sia "irragionevolmente improbabile".

Usualmente si fissa l'indice al 5%, questo significa che se P(fuori di t) è minore della soglia fissata (0,05)

la misura non è accettabile e si dice che la discrepanza è significativa.

-12-

Analisi degli errori

Trattamento Avanzato dei Dati

RIGETTO DEI DATI

Quando:

Supponiamo che purtroppo i conti non tornino e che la responsabilità sia da attribuirsi a una quantità

piuttosto ristretta di dati. Se proprio non riuscite a migliorare statisticamente i vostri dati allora potreste

trovarvi di fronte ad un errore straordinario che vi sballa le statistiche: in questo caso leggete quanto segue.

Come:

Come prima cosa si verifica se effettivamente è il dato discordante a turbare le statistiche, se così non è fate

più bella figura a non eliminarlo.

In secondo luogo si cerca di aumentare il più possibile il numero dei dati, in modo da riassorbire l'errore.

Questo sarebbe il modo più corretto, purtroppo non sempre è possibile, per esempio per questioni di tempo o

di denaro.

In questi casi si impone una doppia relazione con i dati sospetti e senza. Ma quali dati possono a diritto

essere rigettati? La risposta più semplice è data dal principio di Chauvenet.

Il principio di Chauvenet dice che se su N misurazioni le probabilità di ottenere un dato tanto sbagliato sono

minori del 50% allora il dato può essere scartato. Ovvero se il numero previsto statisticamente di misure

tanto sbagliate quanto la misura sospetta è minore di 0,5.

Applicativamente si procede nel seguente modo:

1. Si calcola di quante deviazioni standard esce il dato sospetto:

tsos =

x sos x

x

2. Si trova la probabilità di ottenere un risultato così cattivo:

P(fuori tsosx) = 1 – P(entro tsosx) = 1 –

1

2

t so s

e

z2

2

dz

t so s

3. Si calcola quanti risultati così cattivi ci si dovrebbe aspettare:

n = NP(fuori tsosx)

4. Valutare n, se è più piccolo del valore fissato (normalmente 0,5) allora dichiararlo scartabile.

MEDIE PESATE

Quando

Supponiamo di avere tante misurazioni dello stesso fenomeno effettuate in laboratori differenti, quale sarà la

miglior stima per la misurazione che meglio si approssima al valore vero? Si potrebbe dire la media

aritmetica, ma questo metodo metterebbe sullo stesso livello tutte le misurazioni, indipendentemente dalla

loro accuratezza.

In questi casi è consigliabile utilizzare una media pesata.

-13-

Analisi degli errori

Come:

Incominciamo con un esempio semplice: supponiamo di avere due laboratori che emettono i loro risultati e

di voler conoscere il valore migliore X con la sua deviazione standard:

XA = xA A XB = xB B

Come al solito cominciamo col calcolare la probabilità di trovare un determinato valore x A e xB. Dal capitolo

precedente di ha:

1

PX(xA)

e

A

x A X 2

1

PX(xB)

e

B

22A

x B X 2

2 2B

La probabilità di ottenere una determinata coppia di xA e xB è esattamente il prodotto delle probabilità:

1

PX(xA, xB)

e

AB

x A X 2

22A

x B X 2

22B

Per il criterio di massima verosimiglianza possiamo dire che il valore di X è quello che rende massima la

probabilità PX(xA, xB), quindi è il valore di X che rende massimo l'argomento dell'esponenziale:

x A X 2

x B X 2

2 2A

2 2B

Derivando su X e ponendo uguale a zero si ottiene:

xA X

2A

xB X

0

2B

Da cui la miglior stima per X è:

xA

X=

2A

1

2A

xB

2B

1

2B

Un po' complicata a dire il vero; tuttavia, se si introduce la definizione di peso:

wA =

1

2A

e wB =

1

2B

Con questo alleggerimento la definizione di media pesata risulta alleggerita ed è:

X=

w Ax A w Bx B

wA wB

L'incertezza sul valore X è facilmente verificabile che è:

X =

1

wA wB

-14-

Analisi degli errori

REGRESSIONE LINEARE:

Quando:

Spesso e volentieri ci capiterà di dover confrontare grandezze misurate per trovare la legge matematica che li

lega. Consideriamo come primo esempio due variabili x e y che dovrebbero essere legate da una relazione

lineare del tipo:

y = Ax + B

dove A e B sono due costanti.

La prima cosa che si può fare per vedere se i dati stanno insieme e seguono suddetta relazione è di

rappresentarli graficamente e verificare che effettivamente siano allineati e che la retta sostegno abbia un

coefficiente angolare A ed intercetti l'asse y ad una quota B. Ma questo ci può fornire solo informazioni

qualitative.

Il primo problema che tratteremo nel prossimo sottocapitolo, è come trovare analiticamente la retta che

meglio si adatta ai dati sperimentali; ovvero dato un set di N dati come trovare le costanti A e B che rendono

massima la probabilità del nostro set.

In secondo luogo ci occuperemo di stabilire un parametro che dichiari quanto effettivamente i nostri dati

soddisfino realmente la legge lineare.

Come:

Supponiamo per semplicità che la misura di y abbia una deviazione standard costante su tutte le rilevazioni

y e che la misura di x non abbia incertezza. Come al solito poniamo incognite le costanti A e B e poniamo

che il valore vero di y = Ax + B

(valore vero yi) = Axi + B

La misura yi è governata da una distribuzione normale centrata sul valore vero, con parametro di larghezza

y. Allora la probabilità di ottenere un determinato valore per yi è:

y i Axi B 2

1

e

y

PA, B(yi) =

2 2y

Quindi la probabilità, sempre con A e B costanti incognite, di trovare tutto il nostro se di dati è:

N

P

P(Set N dati) =

A ,B

y i

i 1

1

e

N

y

yi Axi B 2

2y

Per trovare per quali valori di A e B la probabilità del set di dati è massima è sufficiente trovare per quali

valori è massimo l'argomento dell'esponenziale. Per trovare i valori deriviamo l'esponente per A e per B

yi Axi B2 1

2

2y

A

y

N

x y

i

i

Ax i B 0

i 1

yi Axi B2 1

2

2y

B

y

N

y

Ax i B 0

i

i 1

Questi risultati possono anche essere riscritti nel seguente modo:

x y

i

i

A

x

-15-

2

i

x

B

i

Analisi degli errori

y

i

A

x

i

BN

Da cui si ricavano facilmente i valori delle costanti A e B:

A=

N

x y x y

N x x

i

i

i

2

i

B=

i

2

i

x y x x y

N x x

2

i

i

i

i

i

2

2

i

i

A e B sono le costanti della retta y = Ax + B, basate sui punti (x1, y1), … , (xN, yN). La retta risultante è

chiamata la retta dei minimi quadrati o retta di regressione di y in x.

Incertezza su y

Si può stimare l'incertezza y nei numeri y1 y2 … yN. la misura di ogni yi è (lo assumiamo) normalmente

distribuita attorno al suo valore vero Axi + B, con parametro di larghezza y . Così gli scarti yi – Ax – B sono

normalmente distribuiti, tutti con lo stesso valore centrale zero e la stessa larghezza y. Questo suggerisce

immediatamente che una buona stima per y dovrebbe essere data dalla media quadratica con la forma

familiare:

1

N

y =

y

Ax B2

i

Il più delle volte questo è un risultato più che soddisfacente, ed è verificabile con il principio di massima

verosimiglianza. Tuttavia non possediamo né A né B, abbiamo loro approssimazioni e questo riduce

lievemente il valore finale. Per contrastare questa tendenza è consigliabile sottrarre ad N, due.

y =

1

N2

y

i

Ax B2

Questa formula garantisce risultati migliori, la differenza è apprezzabile soprattutto se N è piccolo.

Incertezza su A e B

È facile calcolare l'incertezza su A e B: una volta nota l'incertezza su y e su x è un semplice calcolo di

propagazione degli errori. Il risultato finale è che le incertezze su A e B valgono:

N

A = y

N

x x

x

B = y

N

2

2

i

i

2

i

x x

2

i

-16-

2

i

Analisi degli errori

Incertezza non trascurabile su x

Fino ad ora si è considerato l'errore su x trascurabile e che le

misure di y fossero tutte ugualmente incerte. Questa supposizione

è un po' stretta, perciò vediamo di ampliare l'applicabilità di questa

legge.

In figura è riportato un caso tipo di errore in una regressione

lineare: è chiaro che considerare l'errore x è esattamente la stessa

cosa che considerare un errore equivalente y. Il calcolo

dell'errore equivalente è semplice, è sufficiente valutare

l'incremento che si avrebbe su y corrispondente ad uno

spostamento x. Ovvero il lettore avveduto avrà già capito che:

dy

x

dx

y =

Il che, come è facilmente prevedibile, si traduce in:

y (equivalente) =

dy

x

dx

Questo risultato è vero per qualunque y come funzione di x, ma nel caso che stiamo analizzando y = Ax + B.

Ovvero, nel nostro caso la legge precedente si risolve in:

y (equivalente) = Bx

ovvero tutti i nostri errori sulle misure di x sono facilmente traducibili in errori sulla variabile y, e pertanto

non sarà necessario modificare i risultati finora ottenuti per quanto riguarda la regressione lineare.

In conclusione: se la misura y ha un'incertezza y (la stessa per tutte le misure), e così pure la misura x ha

incertezza x, la regressione lineare è da farsi tenendo conto che in luogo all'usuale y bisognerà utilizzare la

seguente:

y (equivalente) =

2y B2x

ALTRE REGRESSIONI:

Regressione polinomiale

Si suppone di avere N coppie di misure (x1, y1), …, (xN, yN) che presumibilmente si adattano ad una legge

polinomiale tipo la seguente:

k

y=

a x

i 0

i

i

inoltre si ipotizza di avere i dati su x tutti esatti ed i dati su y distribuiti normalmente attorno al valore vero

con larghezza y. Queste premesse ci permetto di calcolare la probabilità di ottenere il nostro set di dati,

ovvero:

-17-

Analisi degli errori

P(y1, … , yN) e

-

yi

a jx ij

2 2y

Le migliori stime per a1, …, ak si ottengono derivando l'argomento dell'esponenziale rispetto a a1, …, ak e

ponendo queste derivate tutte uguali a zero si ottengono k equazioni nelle variabili a1, …, ak da risolvere a

sistema.

k

N

N

j0

i 0

t 1

a j xij yt

k

N

N

j0

i 0

t 1

k

N

N

j0

i 0

t 1

a j xij1 yt x t

a j xij2 yt x 2t

k

N

N

j0

i 0

t 1

a j xijk1 yt x kt 1

FUNZIONI ESPONENZIALI

Si suppone di avere N coppie di misure (x1, y1), …, (xN, yN) che secondo una teoria sono in rapporto

esponenziale secondo la legge:

y = A eBx

Dove A e B sono costanti ed incognite. Purtroppo per le funzioni esponenziali non c'è un metodo diretto per

la determinazione delle costanti, per questo motivo è suggeribile adattare la nostra funzione calcolando la

regressione lineare sul logaritmo di y. Infatti se si pone: zi = ln(yi) si ottiene:

z = ln(A) + Bx

In questo caso già sappiamo come calcolare il valore dell'intercetta ln(A) e del parametro B. Graficamente

potremmo avere conferma se si rappresentano i punti (z; x) che dovrebbero essere allineati lungo la retta z =

ln(A) + Bx.

In realtà il lettore avveduto si sarà già accorto di una grossolana approssimazione: infatti, una delle ipotesi

fondamentali che abbiamo utilizzato per dimostrare la regressione lineare prevedeva che l'errore fosse

costante, mentre qui, chiaramente varia a seconda del valore di y. Questo implica un limite di questa

soluzione ma non ne compromette la validità: infatti, sebbene non tutti i rapporti esponenziali saranno

tradotti soddisfacentemente, la maggior parte lo saranno in particolare se si trattano valori per Bx positivi e

se si opera su un range limitato. Questo perché, tra le funzioni divergenti, il logaritmo è una delle meno

inclinate e al limite la sua derivata è nulla.

-18-

Analisi degli errori

REGRESSIONE MULTIPLA

Fino adora si è trattato di come fittare i dati con rette, polinomiali ed esponenziali, tutte curve che prevedono

due sole variabili. Ma non è l'unico caso possibile, anzi diciamo che è il più elementare. Se invece ci

troviamo di fronte una relazione tipo la seguente:

z = A + Bx + Cy

come reagiremmo? I più male, ma vi è stato qualcuno che invece ha scoperto un semplicissimo metodo per

determinare le costanti. È sufficiente risolvere il seguente sistema a tre equazioni in tre incognite:

x + C y = z

A x + B x + C xy = xz

A y + B xy + C y = yz

AN + B

2

2

-19-

Analisi degli errori

Covarianza e Correlazione

COVARIANZA:

Supponiamo che per trovare il valore di una funzione q(x, y) si misurano N coppie di dati (x i, yi). Allora la

deviazione standard degli N valori q1, … , qN è data da:

q2 = N–1 q i q

2

Si può facilmente verificare che: q q x , y e che:

qi = q(xi, yi) q x , y +

q

q

x i x yi y

x

y

le derivate parziali sono calcolate chiaramente nel punto x medio e y medio pertanto sono le stesse per tutti

gli N punti. Viste queste osservazioni si può ricalcolare la deviazione standard come:

q2

q

q

x x i x x x i x

2

2

q 1

2

2

q 1

x i x yi y

x N

y N

2

2

q q 1

xi x yi y

x y N

Le somme dei primi due termini sono quelle che appaiono nella definizione generalizzata per la

propagazione degli errori della deviazione standard x e y. La somma finale, invece, è definita covarianza di

x e y ed è denotata

xy

1

x i x yi y

N

Ovvero il nuovo valore per la deviazione standard di q è:

2

q

q q

q

xy

2x 2y 2

x y

x

y

2

2

q

Questa definizione standard è più versatile perché fornisce un valore sia che le misure di x e di y siano o

meno effettivamente indipendenti e normalmente distribuite. È chiaro a colpo d'occhio che se le misure sono

normalmente distribuite e soprattutto indipendenti si verificherà che la covarianza è molto, molto piccola. In

particolare se si considera un set di dati numeroso.

Quando la covarianza non è zero, anche se si aumenta il numero dei dati, allora si dice che gli errori in x e y

sono correlati: ovvero che una sovrastima di x comporta sistematicamente una sovrastima o una sottostima di

y o viceversa. In questa circostanza bisognerebbe evidenziare le possibili cause e indicare i valori delle

deviazioni standard con e senza covarianza.

Ma a cosa serve? È semplicissimo: se la covarianza non è nulla bisognerà fare attenzione nel calcolo della

propagazione degli errori. Bisognerà prendere in considerazione di non utilizzare la somma in quadratura,

potrebbe essere una sottostima.

-20-

Analisi degli errori

COEFFICIENTE DI CORRELAZIONE LINEARE:

Nel capitolo precedente abbiamo affrontato il problema di come costruire una regressione lineare. Si può

obbiettare a quanto detto in quel capitolo che un qualunque set di dati si presta ad essere utilizzato per

costruire una qualunque regressione. In effetti non è stato fornito uno strumento che, a livello generale,

quantifichi la bontà della regressione, ovvero, quanto la regressione si avvicini ai punti. Da qui la necessità di

definire il coefficiente di correlazione lineare:

r=

xy

x y

Anche per quanto osservato in precedenza questo rapporto è sempre compreso tra 1 e –1. Se assume valori

che si avvicinano a 0 vuol dire che i punti sono lontani da una retta, al contrario, man mano che si avvicina a

1 o a –1 è indice che i punti sono ben allineati.

Dimostrare formalmente questo fatto è complicato, si può verificare che effettivamente se i dati sono in

relazione lineare perfetta il risultato è necessariamente o 1 o –1.

Dunque per le definizioni varie si ha:

x x y y

x x y y

i

r=

i

2

i

2

i

Se supponiamo i dati legati da una relazione del tipo: y = A + Bx si ha che:

yi y A Bxi A Bx B xi x i N(1, N)

cioè:

r=

B x i x

x

x B

2

i

2

2

x

i

x

2

B

1

B

quindi è verificato che se i punti cadono perfettamente sulla retta allora il coefficiente di correlazione lineare

è 1

VALUTAZIONE DEL COEFFICIENTE DI CORRELAZIONE LINEARE

Supponiamo che due variabili x e y siano effettivamente non correlate: allora se potessimo fare infinite

misurazioni il coefficiente di correlazione lineare dovrebbe risultare nullo. Un metodo un po' complicato…

perciò dobbiamo stabilire un sistema di valutare r con soli N valori. Denotiamo con

PN(|r| r0)

la probabilità di ottenere dopo N rilevazioni un coefficiente di correlazione inferiore a r 0. E purtroppo non

siamo in grado di valutarla. La tabella è in appendice C

-21-

Analisi degli errori

La distribuzione binomiale

Tanto per intenderci:

Lanciamo tre dadi e osserviamo quanti sei escono: le possibilità possono essere: = 0, 1, 2 o 3. Calcoliamo

la probabilità di ottenere 3 sei ( = 3). Poiché la probabilità di ottenere da una dado sei è 1/6 e siccome i dadi

rotolano indipendentemente:

1

3

P(sei, sei, sei) = 0 ,5%

6

La probabilità di ottenere 2 sei è un po' più complicata: la probabilità di ottenere sei, sei, non sei è:

P(sei, sei, non sei) =

1 1 5

2 , 3%

6 6 6

Ma siccome le combinazioni possibili sono tre, la possibilità di ottenerli in qualsiasi ordine aumenta:

1 1 5

6 6 6

P(2 sei su 3) = 3 6 ,9%

Calcoli analoghi danno la probabilità di ottenere 1 solo sei su tre (34,7 %) e nessun sei su 3 (57,9%).

Definizione di distribuzione binomiale

Supponiamo di lanciare un dato e di contare quante volte esce il 6. L'eventualità che esca il 6 è detta

successo, insuccesso altrimenti. Allora denotiamo con p la probabilità di successo, con q = 1 – p la

probabilità di insuccesso. In questo caso la probabilità di ottenere successi su n lanci è:

n

P( successi su n lanci) = Bn,p() = p q n

Il coefficiente binomiale (da cui prende il nome la distribuzione) indica le combinazioni possibili di n

elementi in gruppi di elementi, p è la probabilità di ottenere successi, qn– è la probabilità di ottenere n –

insuccessi. Pertanto il prodotto di questi tre fattori da proprio la probabilità di ottenere successi, n –

insuccessi con n lanci.

Proprietà della binomiale

Chiaramente la media di successi è:

np

si può ora calcolare la deviazione standard del nostro numero di successi. Il risultato è:

=

q np 1 p

Approssimazione gaussiana alla binomiale

Si può osservare che se p = 0,5 (come nel caso del lancio di una moneta) allora la binomiale è perfettamente

simmetrica. Se la probabilità non è un mezzo, la binomiale assume forme non esattamente simmetriche, ma,

-22-

Analisi degli errori

se si considera un gran numero di lanci, la binomiale è ben approssimata dalla distribuzione di Gauss con la

stessa media e deviazione standard.

Bn,p() GX, ()

(n grande)

X = np

=

e

np 1 p

Questa proprietà ci sarà molto comoda, per una semplicità di calcolo. Se si deve determinare la probabilità di

avere 24 teste o più su 36 lanci, basandoci sulla binomiale dovremmo calcolare:

P(23 o più) = P(23) + P(24) + P(25)…

Questo è un calcolo noioso: mentre calcolarlo con la Gaussiana diventa un giochetto:

X = 18

=3

t=2

P(x = 24 o più) = 2,3%

-23-

Analisi degli errori

Distribuzione di Poisson

Capita, in fisica, che si presenti un fenomeno assolutamente casuale, ma dotato di una particolarità: il numero

di occorrenze in un intervallo di tempo ha un valore medio molto preciso. Si pensi al decadimento di

materiale radioattivo. La distribuzione, tra quelle studiate fino ad ora, che sembra essere più adatta al

fenomeno ora descritto è la binomiale, infatti un atomo di materiale radioattivo, ha una determinata

probabilità di decadere in un certo intervallo di tempo t. Se conoscessimo questa probabilità e il numero di

atomi allora potremmo calcolare la probabilità di rilevare particelle nell'intervallo di tempo t con la

binomiale. Ovvero:

P( particelle da n nuclei in un t) = Bn, p()

LA POISSON

Non verrà dimostrato ma negli esperimenti tipo quello appena descritto, la distribuzione limite più

appropriata è quella di Poisson. La Poisson descrive fenomeni in cui si contano eventi che in genere

avvengono a caso con un tasso medio ben definito. Questo comporta che la Poisson è solamente un caso

particolare della binomiale. Questa semplificazione può essere fatta a condizione che n sia molto grande e p

molto piccolo, tipo, appunto, i casi di conteggio del decadimento atomico. La Poisson è descritta ne seguente

modo:

P() = e

!

come conteggio medio atteso

Supponiamo di ripetere il nostro esperimento di conteggio molte volte e di trovare che il numero di conteggi

medio è . Allora sappiamo che il valore medio è dato dalla somma dei possibili valori per la relativa

probabilità:

0

0

P e

!

2 3

e 1

...

2 ! 3!

1 n 1 !

= e

1

Ma l'argomento entro le parentesi è lo sviluppo di Taylor per e quindi risulterà semplicemente:

cioè il parametro che caratterizza la Poisson è proprio il numero medio di conteggi attesi se ripetiamo

l'esperimento di conteggio molte volte. A volte si conosce il tasso medio di decadimento

che è definito come segue:

R = (tasso medio) =

-24-

t

Analisi degli errori

PROPRIETÀ DELLA DISTRIBUZIONE DI POISSON

La deviazione Standard:

La distribuzione di Poisson dà la probabilitò di ottenere conteggi di un certo fenomeno in un determinato

periodo di tempo. Quando si ripete l'esperimento molte volte si può calcolare la deviazione standard dei

conteggi . Questa vale:

2

2

Per calcoli che al momento mi sfuggono si ottiene che il valore della deviazione standard dopo molte misure

è:

Approssimazione Gaussiana alla distribuzione di Poisson

Si può dimostrare che, sebbene la Poisson non è mai centrata sul valor medio e non è simmetrica, può essere

approssimata con una gaussiana. In particolare per grandi la Poisson assume sempre più la caratteristica

forma a campana ed è ben approssimabile dalla gaussiana con la stessa media e deviazione standard. Cioè, se

X = e allora:

P() GX, ()

(per grandi)

Come eliminare il rumore di fondo:

Se si dovesse misurare il decadimento di un oggetto radioattivo, ci sarebbe il reale rischio che dentro i nostri

conteggi finiscano particelle non provenienti dal nostro oggetto (materiali radioattivi nelle vicinanze, raggi

cosmici). Questi ultimi costituiscono il rumore di fondo e sono facilmente rilevabili: è sufficiente rimuovere

la sorgente radioattiva e conteggiare per un periodo il rumore di fondo. Quindi risulterà evidente che una

semplice sottrazione toglierà ogni traccia del rumore di fondo; infatti si ha che:

RTot =

Tot

TTot

e

RFondo =

Fondo

TFondo

Per calcolare il tasso medio della sorgente è ora sufficiente una differenza:

RSorg = RTot – RFondo

-25-

Analisi degli errori

Il test chi–quadro per una distribuzione

Per determinare se un set di dati effettivamente si adatti o meno ad una certa distribuzione si può utilizzare il

test del chi–quadro (denotato con 2)

2 PER LA DISTRIBUZIONE DI GAUSS

Supponiamo di avere un determinato set di dati. Per verificare che esso si adatti effettivamente ad una

distribuzione gaussiana si può utilizzare il seguente metodo: come prima cosa si determinano media e

deviazione standard con le solite formule. Poi si suddivide il range dei dati in n intervalli. Si contano il

numero di rilevazioni che cadono all'interno di ogni intervallo e si genera la successione O k, dove Oj =

#(numero di elementi che cadono nel j–esimo intervallo). Poi si determina il valore atteso dalla distribuzione

per ciascun intervallo. Questo valore lo si ottiene moltiplicando la probabilità di ottenere rilevazioni

all'interno dell'intervallo per il numero di rilevazioni e si costruisce la successione Ek.

Già osservando Ok – Ek si può avere un'idea di quanto i dati siano adeguati alla gaussiana.

Ej indica il numero di rilevazioni che cadono all'interno del j–esimo intervallo, pertanto può essere visto

come un esperimento di conteggio. In quanto tale, Ej sarà dotato di deviazione standard E E j . Per

j

decidere la consistenza della discrepanza tra il valore osservato e il valore atteso secondo la distribuzione

bisogna che il rapporto:

Oj Ej

Ej

sia il più piccolo possibile, e comunque compreso tra 1. Per alcuni intervalli questo rapporto sarà positivo,

per altri negativo: per alcuni intervalli potrebbe essere consistentemente maggiore di una, ma per la maggior

parte dovrebbe essere dell'ordine di uno o più piccolo. Per valutare complessivamente questi risultati, e per

evitare che discrepanze negative elidano le discrepanze positive, costruiamo la somma:

n

Oi E i

i 1

Ei

2

2

Il numero 2 è un indicatore ragionevole dell'accordo tra la distribuzione osservata e quella attesa. Se 2 = 0,

l'accordo sarebbe perfetto, cioè si dovrebbe verificare che Oj = Ej j: cosa assai improbabile.

In generale ci si accontenta che il chi–quadro sia dell'ordine del numero di intervalli n.

GLI INTERVALLI PER IL 2:

Il test del 2 è molto versatile e può essere definito per qualunque distribuzione e ovunque occorra fare un

confronto tra un valore osservato ed un valore teorico sempre con la stessa formula:

n

Oi E i

i 1

Ei

2

Tuttavia risulterà pratico seguire alcune idee:

-26-

2

Analisi degli errori

Misure di una variabile continua

Si è visto come calcolare il 2 per una variabile continua nel caso essa segua una distribuzione gaussiana. Più

in generale se ci si aspetta che le misure di una determinata grandezza seguano una distribuzione f(x) le cose

non cambiano molto. Prendiamo in considerazione il k – esimo intervallo [ak, ak+1] allora il numero atteso di

misure in questo intervallo (dopo N misure totali) è:

a k 1

Ek = N

f x

ak

Più avanti si discuterà la scelta degli aj, in generale è raccomandabile che per ogni intervallo il numero di

misure attese sia circa cinque o più.

Misura di una variabile discreta

Negli esperimenti con misure discrete il discorso è ancora più semplice. In ogni esperimento di questo tipo,

gli intervalli dovrebbero essere scelti in modo da contenere ciascuno uno dei possibili risultati, ammesso che

il numero di occorrenze attese sia almeno cinque. In caso contrario sarà necessario accorpare più risultati

possibili sotto uno stesso intervallo, al fine di ottenere tutti intervalli il cui numero di occorrenze sia almeno

cinque.

Altri utilizzi:

Il test del 2 può essere utilizzato anche per verificare se una determinata regressione sia più o meno idonea.

Ovvero supponiamo che sia stato supposto che:

y = f(x)

e supponiamo di avere N coppie di misure (xi , yi), dove gli xi hanno incertezza trascurabile e gli yi incertezza

nota i. Qui il valore atteso di yi è semplicemente f(xi) e per verificare l'adeguatezza della serie di dati alla

funzione si potrà utilizzare la seguente:

yi f x i

=

i

i 1

N

2

2

a tutti gli effetti pratici si potrà utilizzare questa formula, e il 2 sarà da trattarsi e valutarsi come in tutti gli

altri casi.

CHI–QUADRATO RIDOTTO

Vincoli e gradi di libertà di una distribuzione

I vincoli, indicati con la lettera c, sono grandezze che devono essere calcolate direttamente dai dati per la

determinazione della distribuzione attesa.

Per esempio se si presume che un certo set di dati segua una distribuzione gaussiana, allora per calcolare il 2

occorre stabilire il valore di Ek definito come:

-27-

Analisi degli errori

a k 1

Ek = N

ak

x x

1

2

e

2 2

2

dx

Dove N è il numero di misurazioni, la deviazione standard e x è il valore medio di x. Questi tre parametri

che caratterizzano la distribuzione limite devono essere calcolati direttamente dal set di dati e in questo caso

costituisco tre vincoli.

Analoghi esempi possono essere fatti per altri tipi di distribuzioni: la distribuzione binomiale non necessita di

parametri calcolati dai dati; ovvero, se, per esempio, volessimo calcolare il numero atteso di ottenere k volte

"sei" dal lancio di n dadi dovremmo porre:

k

1

5

Ek = B 1 k

n,

6 6

6

n k

n

k

Dal nostro set di dati proviene soltanto il parametro n: per questo motivo, in questo caso, si avrà un solo

vincolo.

In generale il numero di gradi di libertà in un calcolo statistico, indicato con d, è definito come il numero di

dati osservati meno i vincoli che la distribuzione comporta. Ovvero:

d=n–c

Chi–quadro ridotto

Si può dimostrare che il valore atteso di 2 è precisamente il numero di gradi di libertà. Questo non significa

che 2 = d, ma che se potessimo ripetere infinite volte le nostr misurazioni ci si aspetterà un valore per 2 che

si attesta nelle vicinanze di d. O meglio se 2 risulterà essere molto maggiore di d sarà molto improbabile che

abbiamo fatto i conti giusti o che effettivamente il nostro set di dati segua la distribuzione supposta.

Per stabilire quanto il 2 sia un buon risultato si definisce il chi–quadro ridotto e lo si denota con 2 :

2

2

d

chiaramente il valore atteso per 2 è 1

PROBABILITÀ PER IL CHI–QUADRO

Supponiamo di aver ottenuto 2 = 1,5… tutto sommato non è che ci dica molto: certo non è uno ne è nelle

vicinanze. Possiamo decretare l'inesattezza della distribuzione limite? Bo.

Una via percorribile è quella di calcolare la probabilità di ottenere un 2 tanto buono o peggiore, se questa

probabilità sarà sotto la soglia prestabilita (in genere 5%) si dice che il disaccordo è significativo e si rigetta

la distribuzione assunta al livello di confidenza del 5%. Se è inferiore a 1% si dice che il disaccordo è totale e

non è possibile fissare soglie sotto l'1%.

-28-

Analisi degli errori

Integrale normale

Qui sono riportati alcuni valori per l'integrale normale: ovvero per la probabilità di ottenere risultati entro t

deviazioni standard. Ovvero

P(t) =

1

2

t

e

z2

2

dz

t

P(t) 0,00 0,01 0,02 0,03 0,04 0,05 0,06 0,07 0,08 0,09

0,0

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0,9

1,0

1,1

1,2

1,3

1,4

1,5

1,6

1,7

1,8

1,9

2,0

2,1

2,2

2,3

2,4

2,5

0,00

0,08

0,16

0,24

0,31

0,38

0,45

0,52

0,58

0,63

0,68

0,73

0,77

0,81

0,84

0,87

0,89

0,91

0,93

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,01

0,09

0,17

0,24

0,32

0,39

0,46

0,52

0,58

0,64

0,69

0,73

0,77

0,81

0,84

0,87

0,89

0,91

0,93

0,94

0,96

0,97

0,97

0,98

0,98

0,99

0,02

0,10

0,17

0,25

0,33

0,40

0,46

0,53

0,59

0,64

0,69

0,74

0,78

0,81

0,84

0,87

0,89

0,91

0,93

0,95

0,96

0,97

0,97

0,98

0,98

0,99

0,02

0,10

0,18

0,26

0,33

0,40

0,47

0,53

0,59

0,65

0,70

0,74

0,78

0,82

0,85

0,87

0,90

0,92

0,93

0,95

0,96

0,97

0,97

0,98

0,98

0,99

0,03

0,11

0,19

0,27

0,34

0,41

0,48

0,54

0,60

0,65

0,70

0,75

0,79

0,82

0,85

0,88

0,90

0,92

0,93

0,95

0,96

0,97

0,97

0,98

0,99

0,99

-29-

0,04

0,12

0,20

0,27

0,35

0,42

0,48

0,55

0,60

0,66

0,71

0,75

0,79

0,82

0,85

0,88

0,90

0,92

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,99

0,05

0,13

0,21

0,28

0,35

0,42

0,49

0,55

0,61

0,66

0,71

0,75

0,79

0,83

0,86

0,88

0,90

0,92

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,99

0,06

0,13

0,21

0,29

0,36

0,43

0,50

0,56

0,62

0,67

0,72

0,76

0,80

0,83

0,86

0,88

0,91

0,92

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,99

0,06

0,14

0,22

0,30

0,37

0,44

0,50

0,56

0,62

0,67

0,72

0,76

0,80

0,83

0,86

0,89

0,91

0,92

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,99

0,07

0,15

0,23

0,30

0,38

0,44

0,51

0,57

0,63

0,68

0,72

0,77

0,80

0,84

0,86

0,89

0,91

0,93

0,94

0,95

0,96

0,97

0,98

0,98

0,99

0,99

Analisi degli errori

Note:

-30-