aggiungere profondità (quella vera) ad una foto digitale

ovvero ricostruzione dello zbuffer e applicazione di un filtro con il sequencer di blender e altre applicazioni

powered by BullX

Scopo di questo tutorial è di fornire ad un'immagine 2D informazioni relative allo Z buffer della scena allo

scopo di postprocessarla per ottenere un effetto (realistico) di DOF (profondità di campo)

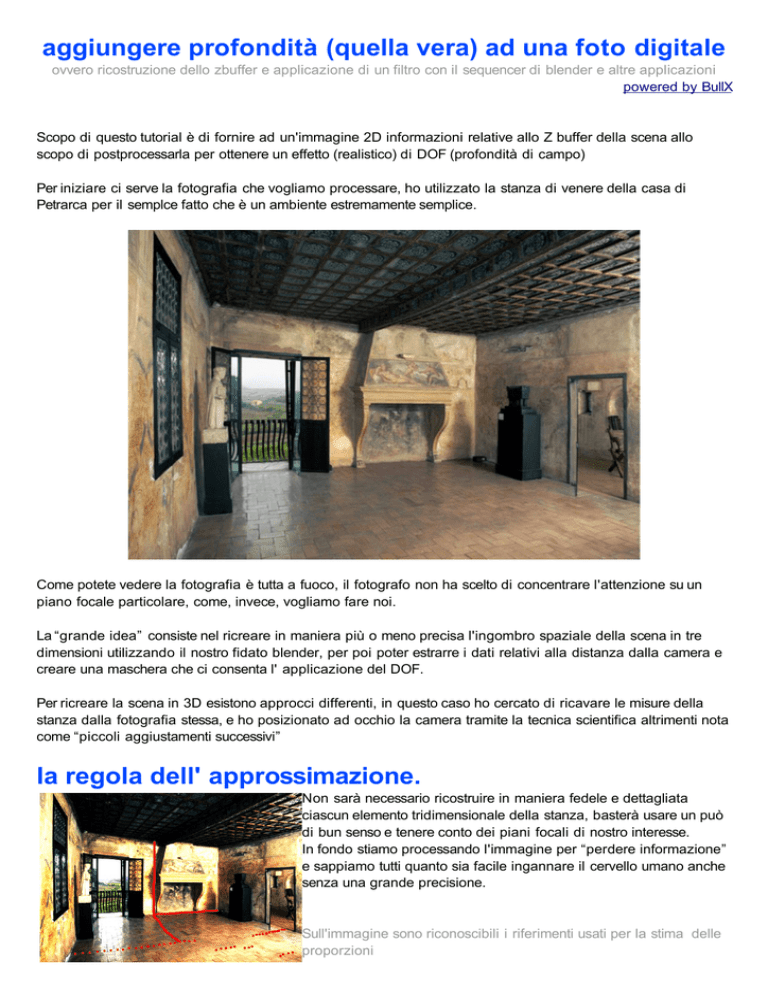

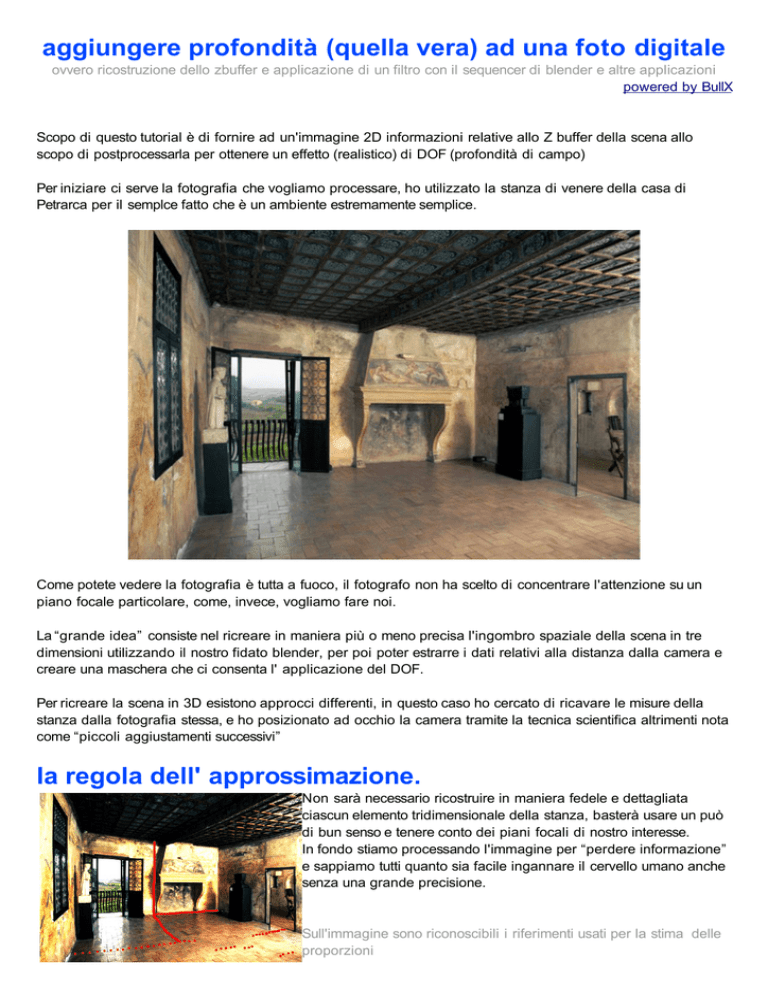

Per iniziare ci serve la fotografia che vogliamo processare, ho utilizzato la stanza di venere della casa di

Petrarca per il semplce fatto che è un ambiente estremamente semplice.

Come potete vedere la fotografia è tutta a fuoco, il fotografo non ha scelto di concentrare l'attenzione su un

piano focale particolare, come, invece, vogliamo fare noi.

La “grande idea” consiste nel ricreare in maniera più o meno precisa l'ingombro spaziale della scena in tre

dimensioni utilizzando il nostro fidato blender, per poi poter estrarre i dati relativi alla distanza dalla camera e

creare una maschera che ci consenta l' applicazione del DOF.

Per ricreare la scena in 3D esistono approcci differenti, in questo caso ho cercato di ricavare le misure della

stanza dalla fotografia stessa, e ho posizionato ad occhio la camera tramite la tecnica scientifica altrimenti nota

come “piccoli aggiustamenti successivi”

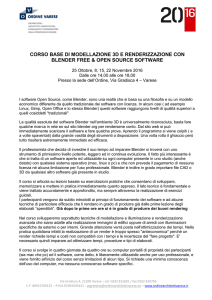

la regola dell' approssimazione.

Non sarà necessario ricostruire in maniera fedele e dettagliata

ciascun elemento tridimensionale della stanza, basterà usare un può

di bun senso e tenere conto dei piani focali di nostro interesse.

In fondo stiamo processando l'immagine per “perdere informazione”

e sappiamo tutti quanto sia facile ingannare il cervello umano anche

senza una grande precisione.

Sull'immagine sono riconoscibili i riferimenti usati per la stima delle

proporzioni

lo spazio virtuale.

Le immagini mostrano la ricostruzione dell'

ambiente in 3D, si noti che gli oggetti sono

modellati solo a livello di ingombro,

dettaglio più che sufficiente per l'effetto

desiderato.

Per ottenere un modello visivo della distanza di ciascun pixel dalla camera (estrazione dello Zbuffer) viene

assegnato al modello un materiale shadeless con una texture di tipo ” blend”, i dettagli di questa ed altre

tecniche possono essere ricavati da qui: http:/ / blenderartists.org/forum/showthread.php?t=66055

i nodi.

L' ultima cosa che ci resta da fare è utilizzare il compositor a nodi di blender per ottenere l'immagine finale.

il risultato finale.

altre possibili applicazioni.

La tecnicea della ricostruzione di un ambiente sintetico per la creazione di informazioni aggiuntive utili a

processare immagini digitali va oltre l'esempio del deep of field.

E' infatti possibile sfruttare tutti i dati che siamo in grado di “creare” in blender, come ad esempio il vettore di

velocità di un offetto in movimento, che ci consntirebbe di aggiungere motion blur ad una foto scattata con

tempi brevissimi, o ltre tecniche come il camera mapping per creare stereoscopie da una singola immagine.

E' importante notare che moltissimi effetti di post produzione possono essere realizzati in maniera più che

credibile utilizzando solo informazioni 2D, è quindi utile valutare caso per caso se sia realmente necessario

l'utilizzo di tecnologie 3D per la creazione di informazioni aggiuntive.

É inoltre possibile sfruttare la tecnica descritta (come suggerito da Gillan) su file renderizzati con altri motori di

rendering, nel caso questi non disponessere di funzionalità quali il DOF, il MBLUR, ecc.

note.

Il compositor a nodi a cui si fa riferimento in questo tutorial è presente a partire dalla versione 2.42 di Blender.

Sito ufficiale

www.blender.org/

community internazionale

www.blenderartists.org

community italiana

www.kino3d.com

camera calibration script

blix.sourceforge.net

powered by BullX