IL BINDING PROBLEM:

EVIDENZA DI ATTRATTORI CAOTICI NELLE

OSCILLAZIONI CORTICALI A 40 Hz

Da dove origina l’unità delle percezioni ?

Esiste una struttura cerebrale preposta a questo binding

funzionale?

Forse la soluzione è l’ organizzazione delle onde gamma

(~ 40 Hz) emesse dai neuroni corticali

Come risposta a diversi stimoli sensoriali si formano

pattern autoorganizzati

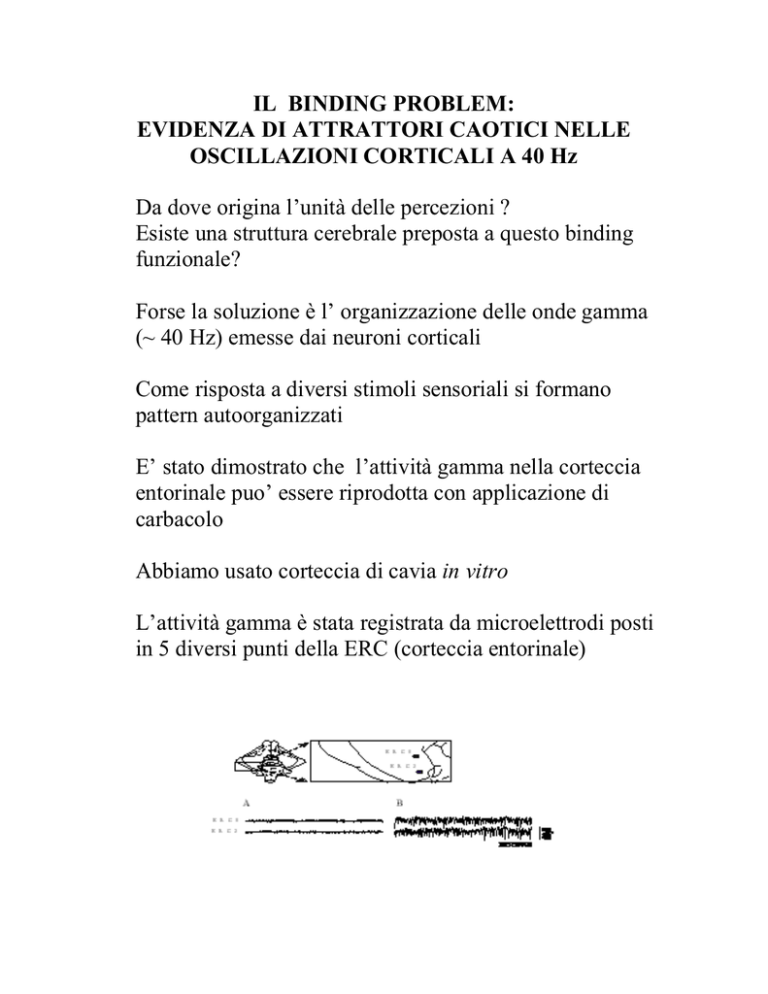

E’ stato dimostrato che l’attività gamma nella corteccia

entorinale puo’ essere riprodotta con applicazione di

carbacolo

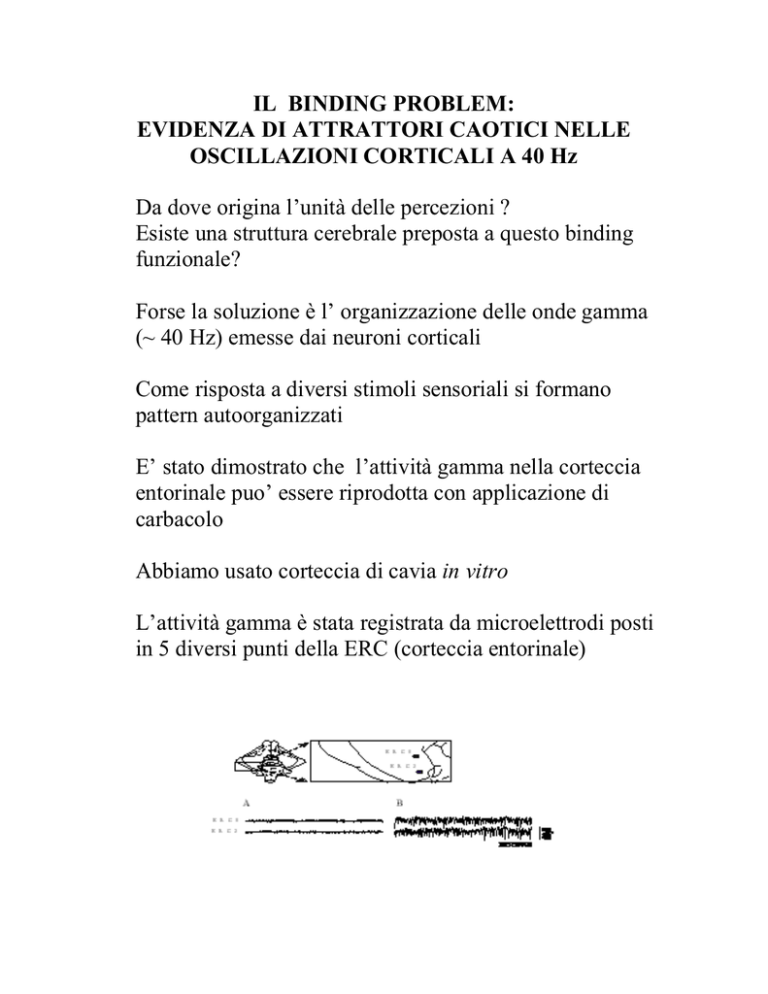

Abbiamo usato corteccia di cavia in vitro

L’attività gamma è stata registrata da microelettrodi posti

in 5 diversi punti della ERC (corteccia entorinale)

RETI NEURALI AUTOORGANIZZANTI

(Self Organizing Map)

La SOM e’ stata sviluppata negli anni 80 da T. Kohonen

sulla base di precedenti studi di neurofisiologia.

La struttura di una rete di Kohonen consiste in uno strato di

N elementi, detto strato competititivo.

Ciascuno di questi riceve n segnali x1,…,xn che

provengono da uno strato di input di n elementi, le cui

connessioni hanno peso wij.

Se lo strato competititvo e’ di tipo matriciale, i neuroni

vengono collegati tra loro secondo uno schema quadrato,

esagonale o romboidale. Se e’ di tipo vettoriale, i neuroni

sono semplicemente connessi fra loro a formare una catena.

Per stimare l’intensità Ii dell’input di ciascun elemento

dello strato di Kohonen:

Ii = D(wi,x)

wi=(wi1,…,win)T

x i =(x1,...,xn)T

D(u,x) e’ una qualche funzione distanza, ad es. quella

euclidea.

A questo punto viene messa in atto una competizione per

valutare quale elemento ha la minore intensità di input

(ossia quale wi e’ il piu’ vicino ad x).

La SOM prevede un meccanismo cosiddetto di inibizione

laterale, che e' presente anche in natura sotto forma di

trasformazioni chimiche a livello sinaptico.

Nella regione corticale del cervello neuroni fisicamente

vicini ad un neurone attivo mostrano legami piu' forti,

mentre ad una certa distanza da questo iniziano a mostrare

legami inibitori.

In questa architettura, ciascun elemento riceve sia stimoli

eccitatori da parte degli elementi adiacenti (la cosiddetta

neighborhood), sia stimoli inibitori da parte degli elementi

piu' lontani, secondo la cosiddetta forma "a cappello

messicano".

L'esistenza della neighborhood e' utile per non polarizzare

la rete su pochi neuroni vincenti.

In tal modo vengono attivati solo gli elementi con distanza

al di sotto di un certo valore, in casi restrittivi solo l'unità

con minima distanza.

A questo punto ha luogo la fase di apprendimento, secondo

la cosiddetta "Winner Take All Law" (WTA).

I dati di training consistono in una sequenza di vettori di

input x .

Lo strato di Kohonen decide poi il neurone vincitore sull

abase della distanza minima.

Ora i pesi vengono modificati secondo la legge

winew = wiold + (x - wiold)zi

dove 0<<1 e decresce lentamente nel tempo con una legge

del tipo

(t) = [1 - t/]

dove e' un'opportuna costante.

Essendo zi ≠ 0 solo per il neurone vincitore, i pesi dei

neuroni vincenti ruotano sempre piu' verso gli stimoli

vettorialmente piu' vicini, fino a sovrapporsi idealmente

con essi.

La SOM effettua cosi' una quantizzazione vettoriale, ossia

una mappatura da uno spazio a molte dimensioni in uno

spazio con numero minore di dimensioni, conservando la

topologia di partenza.

Limiti:

• lo strato competitivo non puo’ seguire input

strettamente non lineari

• manca esplicitazione dell’output (clustering)

ITSOM (Inductive Tracing Self-Organizing Map)

Se una SOM e’ applicata a dati strutturati, la serie

temporale dei neuroni vincenti tende a ripetersi

- Si forma una configurazione ciclica che caratterizza

univocamente lo stream di input

- E’ possibile classificare anche input con topologia

complessa

- Non e’ necessario giungere alla convergenza: la

configurazione si stabilizza dopo poche epoche

• Codifica le configurazioni di neuroni vincenti con

algoritmo z-score:

• I punteggi cumulativi di ciascun input vengono

normalizzati secondo la distribuzione della variabile

standardizzata

z= (x – )/

media su tutti i neuroni dello strato competitivo

deviazione quadratica media

z = 1 per z>

z = 0 per z

soglia

Ogni configurazione sara’ rappresentata da un numero

binario, formato da tanti 1 e 0 quanti i neuroni dello

strato competitivo.

- Carico computazionale lineare

- Processo induttivo pochi-a-molti da configurazioni

cicliche note all’intero stream di input.

- Puo’ riconoscere tipici attrattori quando compaiono nella

serie temporale

- Una buona sequenza non supera i 20 cicli

- Si confrontano le sequenze di neuroni vincitori con un

reference set che dia loro un’interpretazione automatica

DIMENSIONE FRATTALE E DIMENSIONE DI

CORRELAZIONE

Definiamo dimensione D di un oggetto l’esponente che

mette in relazione la sua estensione b con la distanza

lineare r:

brD

L’estensione b puo’ riferirsi a distanza lineare, area,

volume, o quantità di informazione in bit.

Per una linea b r 1 (ed infatti una linea ha dimensione 1),

per un piano b r 2 , ecc.

Passando ai logaritmi si ottiene

D = lim r->0 (log(b)/log(r)) .

E’ possibile costruire oggetti di dimensione non intera, i

cosiddetti frattali. Essi hanno caratteristica di

autosimilarità, ossia non posseggono scala caratteristica.

Ad esempio un ramo e’ un oggetto frattale di dimensione

fra 1 e 2.

Si dimostra che gli attrattori caotici hanno dimensione

frattale >2.

Si e’ visto che la dimensione frattale dell’EEG ad occhi

chiusi (circa 2) e’ piu’ bassa che ad occhi aperti (circa 6).

Secondo Freeman l’attività caotica prepara alla ricezione di

un particolare stimolo, che manda entro un bacino di

attrazione periodico (ciclo limite) o caotico.

DIMENSIONE DI CORRELAZIONE D2

– D2 e’ una misura della complessità dell’attrattore

– D2 e’ limite inferiore per la dimensione frattale di

Hausdorff

PARAMETRO DI HURST

Una serie autosimilare mostra dipendenza a lungo

raggio, con funzione di autocorrelazione

r(k) ~ k – per k

0<<1

L’autosimilarità è espressa da

H = 1 – /2

Per serie autosimilari

½<H<1

D=2–H

D dimensione di Hausdorff

RECURRENCE QUANTIFICATION ANALYSIS

Analizza le distanze fra coppie di punti di serie temporali

- Localizza caratteristiche locali (adatta per segnali

fisiologici rapidamente variabili)

- DET (Determinismo): percentuale di punti ricorrenti in

sequenza ; corrisponde al valore del massimo esponente di

Lyapounov della serie (L>0 per sistemi caotici)

- I segnali sono stati considerati simultaneamente per

evidenziare correlazioni fra siti distanti

- Elaborazione delle serie di neuroni vincenti con

MATLAB/SIMULINK

- Scarsa correlazione fra siti distanti prima

dell’applicazione di carbacolo

- Dopo l’induzione di attività gamma compaiono pattern

caotici

Serie dei neuroni vincitori prima e dopo applicazione di

carbacolo - spazio delle fasi

• Valutazione quantitativa:

- H

< 0.4 prima di carbacolo

>0.5 (fino a 0.8) dopo carbacolo

- D2

2.6-3.2 sia prima che dopo lo stimolo

(parametro caratteristico del sistema)

- DET fino a 98% dopo lo stimolo

VISUAL RECURRENCE ANALYSIS

Pattern organizzati in corrispondenza di alti valori di H

ANALISI SULLE SERIE ORIGINALI

- Metodo lineare : power spectrum e cross power

spectrum < 0.5

- Metodi non lineari:

valori di H spesso meno significativi

Pattern autoorganizzati in serie originali

• L’analisi attraverso rete neurale conferma l’esistenza

di pattern caotici autoorganizzati in presenza di onde

gamma

• L’analisi lineare non evidenzia correlazioni fra siti

distanti

• L’analisi non lineare conferma l’esistenza di attrattori

caotici ma meno frequentemente della rete neurale

• E’ possibile identificare attrattori tipici attraverso il

codice z-score e riconoscerli all’interno delle serie

temporali

• La rete neurale ITSOM permette di valutare la

correlazione di tutti i siti di registrazione

contemporaneamente