PROCESSI STOCASTICI

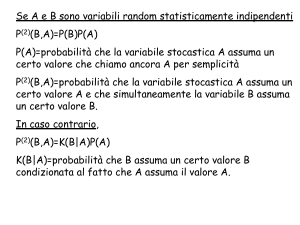

Un processo stocastico è una successione di variabili aleatorie.

I processi stocastici possono essere indicizzati sia da valori reali (es. il tempo) (processi a

tempo continuo) sia da numeri interi (processi a tempo discreto).

Inoltre i processi, ossia le v.a. sottostanti, possono essere discreti o continui.

L'insieme dei valori assunti dal processo è detto spazio degli stati S e può essere discreto

o continuo. Esistono quindi quattro classi di processi combinazione della natura di S e

della scansione temporale.

Si chiama traiettoria di un processo stocastico l'intera realizzazione di una successione di

variabili Xn, n0, Xt, t0 .

Nel caso di un processo stocastico generato da una v.a. binomiale (processo di

Bernoulli), la traiettoria è rappresentata dai valori assunti dalle v.a. Xi in corrispondenza

degli n tempi i=1,2,...,n , quindi avrà l'aspetto di un diagramma a dispersione con punti

disposti a caso su ordinata 0 e 1.

Il processo di Bernoulli è caratterizzato dal parametro p probabilità di successo.

PASSEGGIATE ALEATORIE

Un esempio di processo derivato da quello di Bernoulli è la passeggiata aleatoria sulla

retta.

Supponiamo di avere una particella posta in x=0 al tempo zero, ossia con X0=0 con

probabilità 1.

La particella si può muovere solo in senso orizzontale. Ad ogni nuovo istante, la particella

fa un salto a destra di lunghezza 1 con probabilità p o a sinistra con probabilità 1-p.

Dove sarà la particella dopo n passi ?

E 'intuitivo che se p>1/2 la particella si sposterà verso +viceversa se p<1/2.

Resta da valutare il caso p=1/2.

A questo scopo trasformiamo la sequenza di 0 e 1 in una sequenza di -1 e 1, sommando

gli n valori. Il valore della somma ci dice la posizione della particella al tempo n.

Un modo per evidenziare la traiettoria è quello di tracciare una linea crescente nel caso di

passo +1 e una decrescente nel caso di passo -1.

E' interessante valutare la traiettoria delle passeggiate aleatorie in presenza di vincoli.

Il caso p=1/2 è tipico dell'andamento di un titolo azionario, e si può allora valutare quanto

tempo passa prima che un titolo raggiunga un certo livello L>0 o –L .

Si utilizza allora un'applicazione del metodo Monte Carlo.

Si eseguono diverse simulazioni di una traiettoria, e per ciascuna si verifica quando viene

raggiunto il livello L la prima volta. Alla fine si calcola la media dei tempi.

Se fissato n alcune traiettorie non raggiungono L, si fissa n in modo che sia corrispondente

al primo passaggio.

Il valore L viene detto barriera assorbente se assumiamo che la traiettoria termini la corsa

quando raggiunge L (tempo medio di assorbimento). Se la particella rimbalza quando

raggiunge il livello L si parla di barriera riflettente. In tal caso, raggiunto L, la particella fa

un balzo pari a -1 invece che +1. Si possono aggiungere due barriere riflettenti L1 e L2.

CATENE DI MARKOV

Lo studio di questo tipo di processi è iniziato con A.A. Markov all'inizio del '900.

L'idea era studiare un processo aleatorio per cui sia possibile descrivere i possibili valori al

tempo n+1 grazie solo all'informazione disponibile all'istante n.

Tutto ciò che avviene prima dell'istante n non influenza ciò che avviene all'istante n+1,

ossia

P( X n1 k | X n , X n1 ,..., X 0 ) P( X n1 k | X n ) , k S

dove S è lo spazio degli stati di X. Questo è un processo in tempo discreto e spazio degli

stati discreto.

Le probabilità di transizione pij , i, j S sono definite

pij P( X n 1 j | X n i)

ossia, sono le probabilità con cui il processo che si trova nello stato i al tempo n passa

nello stato j al tempo n+1.

In generale queste probabilità dipendono dall'istante n. Ma se si assume che la struttura

della probabilità di transizione non dipenda dal tempo, si dice che la catena di Markov è

omogenea. Questo tipo di catene di Markov è quello descritto nel seguito.

Dati k stati in S, per ogni valore i=1,..., k avremmo allora un'intera distribuzione di

probabilità condizionate pij , rappresentate dalle righe di una matrice P detta matrice delle

probabilità di transizione:

p11

p 21

.

P

.

.

p

k1

p12

p 22

.

.

.

pk 2

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

p1k

p2k

.

.

.

.

p kk

Un esempio.

Esprimiamo la matrice delle probabilità di transizione per una situazione così descritta:

- non si verificano mai due giorni di sereno S di seguito

- se oggi è bel tempo S, domani può nevicare N o piovere P con uguale probabilità

-se nevica N o piove P e il tempo cambia, solo la metà delle volte il tempo volge al bello S

- se nevica N o piove P, nel 50% il tempo rimane invariato, altrimenti nel restante 50% dei

casi il tempo cambia in uno degli altri stati.

Allora se X n P

P( X n1 P | X n P) 1 / 2

P( X n1 S | X n P) 1 / 4

P( X n1 N | X n P) 1 / 4

e analogamente per i casi X n S , X n N , per cui la matrice di probabilità assume la

forma:

1 / 2 1 / 4 1 / 4

P 1 / 2 0 1 / 2 .

1 / 4 1 / 4 1 / 2

P|P

Dove il primo stato è P, il secondo è S e il terzo è N: P S | S

P | N

S|P

S|S

S|N

N|P

N | S .

N | N

Vogliamo allora rispondere a questo quesito:

-

se oggi è sereno S, come sarà il tempo fra due giorni ?

Siano i e j due stati qualsiasi di S, allora:

P( X 2 j | X 0 i ) P( X 2 j | X 1 k ) P( X 1 k | X 0 i )

kS

Nel caso specifico, ponendo i=S

P( X 2 P | X 0 S ) P( X 2 P | X 1 k ) P( X 1 k | X 0 S )

kS

P( X 2 P | X 1 P) P( X 1 P | X 0 S )

P( X 2 P | X 1 S ) P( X 1 S | X 0 S )

P( X 2 P | X 1 N ) P( X 1 N | X 0 S )

1 / 2 1 / 2 1 / 2 0 1/ 4 1 / 2

3/8

e analogamente per gli altri casi.

Si ottiene quindi alla fine

P( X 2 P | X 0 S ) 3 / 8

P( X 2 S | X 0 S ) 2 / 8

P( X 2 N | X 0 S ) 3 / 8

Queste probabilità di transizione “a due passi” pij2 dipendono dallo stato iniziale X0.

Invece la probabilità di X all’istante n+1 sarà

p (jn 1) P( X n 1 j ) P( X n1 j | X n k ) P( X n k )

p kj p

kS

kS

(n)

k

in termini matriciali

p ( n1) p ( n) P

dove p (n) e p ( n1) sono i vettori delle distribuzioni di X al tempo n ed n+1 e P è la matrice

delle probabilità di transizione.

Vale anche quindi

p ( n) p ( n1) P p ( n2) P 2 p (0) P n .

Di conseguenza nel caso in esempio, per calcolare la distribuzione di X 2 dato X 0 S si

può utilizzare la formula ottenendo

p ( 2) p ( 0) P 2 .

Ogni passeggiata aleatoria può essere vista come una catena di Markov in cui

S ,...,1,0,1,...,è lo spazio degli stati, e la distribuzione iniziale X0 assume valore

1 in corrispondenza di 0 e zero altrove.

La matrice di probabilità di transizione ha un numero infinito di righe e colonne in cui ogni

riga i è del tipo

pi ,i 1 p

pi ,i 1 (1 p )

p 0

altrove

ij

Uno stato di una catena di Markov viene detto assorbente se una volta raggiunto, la

catena non ne esce più, ossia X ij 1 . Una catena di Markov è detta assorbente se ha

almeno uno stato assorbente e questo è raggiungibile dagli altri stati della catena (anche

in più passi). Gli stati non assorbenti sono detti transitori.

Una catena di Markov è detta regolare se esiste un indice n tale per cui P n ha tutti

elementi positivi.

Se ( 1 , 2 ,..., k ) è un vettore di lunghezza k pari al numero di stati di una catena

regolare, si dimostra che

1 2

1 2

.

.

lim

Pn

.

n

.

.

.

2

1

.

.

.

.

.

.

.

.

.

.

.

.

. k

. k

.

.

.

.

. k

Provando infatti a calcolare nell’esempio le matrici P10,P11,P12 si vede che sono uguali a

0.4 0.2 0.4

0.4 0.2 0.4

0.4 0.2 0.4

Inoltre si dimostra che vale sempre

P .

Infatti si ha che se P è la matrice di probabilità di transizione di una catena regolare e p 0 è

un qualsiasi vettore di probabilità, allora

lim

p0 P n .

n

Se la distribuzione iniziale di X 0 è p0 , allora vale

P n n .

In questo caso la catena di Markov si trova in uno stato di equilibrio o stazionario.

Per un’ampia classe di catene di Markov si dimostra che la distribuzione limite è unica.

Ciò è in particolare vero per le catene ergodiche, ossia quelle in cui ogni stato può essere

raggiunto dagli altri.

Una catena regolare è anche ergodica, perché per definizione esiste un certo indice n tale

per cui tutti gli elementi di P n sono positivi, quindi al massimo in n passi ogni stato può

raggiungere gli altri.

Una catena di Markov è detta irriducibile se comunque fissati due stati i e j esiste un

intero k = k(i; j) tale che dopo k unità di tempo sia possibile passare da i a j.

In altre parole, una catena di Markov è irriducibile se comunque dati due vertici sul grafo

ad essa associato esiste almeno un percorso orientato che li collega.

Si dimostra che una catena di Markov è irriducibile se non è possibile riportare la matrice

di probabilità ad una forma diagonale a blocchi del tipo

0 1 0

1 0 0

0 0 1

Se la catena di Markov è irriducibile, allora la distribuzione stazionaria esiste ed è unica.

Esempio numerico.

Sia

0 1

P

1 0

e

p 0 (1 / 2

1 / 2)

Allora

p1 p 0 P (1 / 2

1 / 2)

p 2 p 0 P 2 (1 / 2

1 / 2)

e quindi

p m p 0 P m (1 / 2

1 / 2)

m .

RAPPRESENTAZIONE GRAFICA DI UNA CATENA DI MARKOV

Prendiamo un meteo, in cui si hanno soltanto due stati:

sole, S;

nuvoloso, N.

Se oggi c'è il sole, allora domani ci sarà

sole con probabilità 1/3

nuvoloso con probabilità 2/3

(S|S=1/3)

(N|S=2/3)

Al contrario, se oggi è nuvoloso, allora domani ci sarà

sole con probabilità ½

nuvoloso con probabilità ½ (N|N=1/2).

(S|N=1/2)

Questa è una catena di Markov. Il tempo di domani dipende dal tempo di oggi, e non dal

tempo di ieri; inoltre, la probabilità che esce da ogni stato è unitaria, quindi anche la

probabilità che in un dato istante si sia in un determinato punto soddisferà anch'essa la

proprietà di unitarietà.