true

Accastampato non è un periodico, pertanto non è registrato e non ha un direttore responsabile, è solo un esperimento – per ora occasionale – realizzato dagli studenti di Fisica

dell’Università degli Studi di Roma “Sapienza”

Gli articoli contenuti in questo numero sono protetti con

marca digitale grazie a patamu.com

I QR Code in calce ad alcuni articoli codificano il loro URL di

pubblicazione on-line e sono generati mediante invx.com

La rivista è prodotta dal motore di composizione tipografica LATEX. I sorgenti sono disponibili richiedendoli alla

Redazione.

Quest’opera è rilasciata sotto la licenza Creative Commons

Attribuzione-Non commerciale-Condividi allo stesso modo

3.0 Unported. Se non specificato altrimenti, tutti gli articoli in essa contenuti sono rilasciati dai rispettivi autori sotto la medesima licenza. Per leggere una copia della

licenza visita il sito web http://creativecommons.

org/licenses/by-nc-sa/3.0/ o spedisci una lettera a Creative Commons, 171 Second Street, Suite 300, San

Francisco, California, 94105, USA.

accastampato

Rivista degli Studenti di Fisica

dell’Università Sapienza di Roma

www.accatagliato.org

EDITORIALE

R EDAZIONE

[email protected]

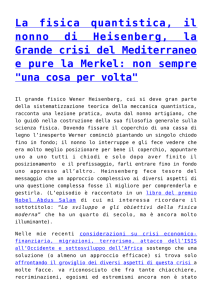

La divulgazione della Scienza a partire da chi la fa

La ricerca scientifica a Roma: informare, orientare, incuriosire

n pochi sanno che a Roma e dintorni si fa ricerca di livello internazionale. Una delle motivazioni di questa diffusa ignoranza è sicuramente il fatto che le riviste e i programmi di divulgazione

di qualità sono quasi sempre tradotti dall’inglese e si contrappongono a prodotti di scarso livello che, nel tentativo di essere commercialmente accattivanti, danno un’idea della scienza

completamente sbagliata, tale da renderli addirittura dannosi e fuorvianti. Al contrario, una delle differenze fra la scienza e, per esempio, l’alchimia è stata storicamente proprio la divulgazione. Solo

avendo delle conoscenze di base si può capire un dibattito serio sui temi di attualità che pressano, o

almeno dovrebbero, l’agenda politica nazionale e internazionale: esempi eclatanti sono la produzione

di energia, gli organismi geneticamente modificati, gli effetti dei campi elettromagnetici sulla salute.

Troppe volte si sentono dire cose che non sono neanche lontanamente verosimili e questo significa

che manca nel nostro paese una cultura minima in questo settore, non solo sugli argomenti di ricerca,

ma anche su cosa sia Scienza, su cosa la distingua dalla religione o, appunto, dall’alchimia. Per questi motivi abbiamo deciso di intraprendere un progetto ambizioso e difficile: realizzare una rivista di

divulgazione scientifica e diffonderla gratuitamente nelle scuole superiori con tutti i mezzi cui abbiamo accesso, una rivista redatta dagli studenti di Scienze della Sapienza dedicata principalmente agli

studenti dei licei di Roma. Non pensiamo di poter risolvere i problemi descritti prima, ovviamente.

Speriamo solo di poter generare curiosità in qualcuno dei nostri lettori.

I

Non è semplice scrivere e parlare della ricerca di frontiera a non specialisti: non bisogna dare nulla

per scontato e, nel mettersi nei panni del proprio interlocutore, è necessario usare un linguaggio comprensibile senza rinunciare a spiegare quali siano le cose fondamentali. Per questo ci poniamo due

obiettivi: incuriosire coloro che non studiano fisica e confrontarci con l’arte difficile del raccontare

cosa studiamo con parole accessibili. Nel mondo accademico italiano si è data sempre troppo poca

importanza alla divulgazione e questo progetto vuole configurarsi come un vero e proprio laboratorio

di comunicazione scientifica: per questo motivo invitiamo tutti i nostri lettori a inviarci commenti, critiche e giudizi di qualunque genere, in modo da poter correggere e migliorare sia la nostra competenza

specifica, sia la rivista stessa. Questo progetto è stato pensato e realizzato da studenti, ma si avvale

dell’importante collaborazione di ricercatori e docenti del Dipartimento di Fisica della Sapienza. Sono

loro che formano la nostra autorevole commissione scientifica che garantisce al lettore la qualità di ciò

che sta leggendo.

Ricerca, quindi, ma non solo: crediamo che una delle cose più interessanti sia sottolineare le ricadute

della ricerca di base nella vita di tutti i giorni, sia nel medio che lungo periodo. Siamo convinti che

il senso della ricerca non sia solo nelle applicazioni tecnologiche che ne possono derivare e in questo

concordiamo con l’affermazione di Feynman: “Non si lavora per le applicazioni pratiche, ma per

l’emozione della scoperta. . . l’emozione, che è la vera molla dell’impresa scientifica. Se non capite

questo, non avete capito niente”. Pensiamo però che spiegare come funzionino cose con cui si ha a che

fare nella vita quotidiana sia un modo efficace di spiegare la Scienza. È poi della politica il compito di

tradurre in atti concreti la possibilità di uscire dalla crisi grazie a investimenti in ricerca e conoscenza

e alle loro ricadute innovative. Purtroppo le politiche adottate dai governi che si sono succeduti in

questi ultimi anni sono state miopi da questo punto di vista: l’istruzione e la ricerca sono state oggetto

di tagli indiscriminati, fatti in nome della razionalizzazione e dell’efficientismo, ma spesso al di fuori

di un quadro strategico di largo respiro. Per questo una rubrica sarà dedicata all’analisi degli effetti,

anche nel breve periodo, di tali politiche.

Alla luce di tutto ciò riteniamo che una buona divulgazione scientifica non possa esimersi dal cercare

di far prendere coscienza di cosa sia la Scienza e del perché noi scienziati e comunicatori riteniamo

sia cosı̀ importante per la vita della nostra società.

Alessio Cimarelli

[email protected]

Carlo Mancini

[email protected]

Silvia Mariani

[email protected]

Leonardo Barcaroli

[email protected]

Erica Chiaverini

[email protected]

Niccolò Loret

[email protected]

Isabella Malacari

[email protected]

Massimo Margotti

[email protected]

Kristian Gervasi Vidal

[email protected]

C OMMISSIONE SCIENTIFICA

Giorgio Parisi

[email protected]

Giovanni Battimelli

[email protected]

Fabio Bellini

[email protected]

Lara Benfatto

[email protected]

Riccardo Faccini

[email protected]

Francesco Piacentini

[email protected]

Antonio Polimeni

[email protected]

Antonello Polosa

[email protected]

H ANNO CONTRIBUITO

L. Benfatto, A. Bonforti, A. Cimarelli, C. Cosmelli, U. Ferrari, M. Margotti, M. Mitrano, L. Orlando, la

Redazione, T. Scopigno.

S I RINGRAZIANO ANCHE

Donald E. Knuth, Leslie Lamport,

la Comunità del TEX Users Group

(TUG: www.tug.org) e Gianluca

Pignalberi

Con il patrocinio del

accastampato num. 1, Giugno 2010

Indice

num. 1, Giugno 2010

La ricerca scientifica a Roma: informare, orientare, incuriosire

EDITORIALE

La divulgazione della Scienza a partire

da chi la fa

3

Un progetto ambizioso e difficile, una rivista realizzata

interamente da studenti

accastampato, Creative Commons e

Patamu

9

di A. Bonforti

Tutti i contenuti di accastampato sono rilasciati sotto

licenza Creative Commons BY–NC–SA e la loro paternità

protetta da marca digitale grazie a patamu.com: vediamo

cosa significa. . .

IL RESTO DEL NEUTRINO

I segreti del cinema 3D

RECENSIONI

Storia del laser

6

di M. Mitrano

Breve storia di un’invenzione che ha cambiato il mondo

ESPERIMENTI

Un palloncino sul phon

7

di C. Cosmelli

Come il getto d’aria del phon tiene il palloncino sospeso

sopra di sé

ONDA LUNGA

h̄σω τσ. . .

di A. Cimarelli

Gli enormi passi avanti fatti dalle tecnologie stereoscopiche

aprono finalmente le porte a una forte espansione dell’intrattenimento cinematografico tridimensionale

Il comportamento

collettivo animale

16

di A. Cimarelli

Cosa hanno in comune gli stormi di uccelli con i banchi

di pesci o gli alveari di api? Un comportamento collettivo

emergente sorprendentemente simile nonostante le differenze tra le specie

8

di la Redazione

Breve descrizione di come è strutturata accastampato

4

11

accastampato num. 1, Giugno 2010

ONDA LUNGA

La riforma dell’Università italiana

22

di L. Benfatto

L’idea stessa di creare una vera competizione tra le varie

università, allo scopo di attrarre gli studenti migliori,

fallisce miseramente a fronte di un’obiettiva immobilità

sociale del sistema italiano

IL RICERCATORE ROMANO

La transizione

vetrosa

26

di T. Scopigno

Nonostante un utilizzo molto diffuso dei materiali vetrosi,

alcuni aspetti della transizione a questa particolarissima

fase della materia non sono ancora pienamente compresi

SCIENZARTE

La pittura silenziosa

30

di M. Margotti

Il lavoro di Piero della Francesca è emblematico del passaggio che nella sua epoca stava avvenendo in Italia a livello

intellettuale e sociale: l’incontro tra arte e matematica,

riconosciuta come unica risorsa per una descrizione della

realtà

NANOS GIGANTUM

La prima lezione di

Ettore Majorana

32

di A. Cimarelli

La Prolusione di Ettore Majorana del 13 gennaio 1938

per il suo corso di Fisica Teorica all’Università Federico

II di Napoli permette di comprendere le grandi capacità

didattiche dello scienziato, scomparso misteriosamente nel

marzo dello stesso anno

EVENTI

Copenhagen

36

di L. Orlando

“Copenhagen” di Michael Frayn, da dieci anni nei teatri di

tutto il mondo

RECENSIONI

Storia del laser

C OPERTINA

Breve storia di un’invenzione che ha cambiato il mondo

di Matteo Mitrano

(studente di Fisica)

Per completezza e per la sua chiarezza mi permetto di citare la quarta di copertina, pubblicata anche

sul sito della casa editrice.

Il termine laser è ormai conosciuto al grande pubblico e molte delle applicazioni della luce che esso emette sono sotto gli occhi di tutti. Si parla di operazioni chirurgiche e di cure mediche eseguite

mediante raggi laser; si sa che le discoteche usano questi raggi per creare particolari effetti di luce e

che, per esempio, brevi impulsi di luce, sempre emessi da laser, viaggiando entro fibre di vetro e sostituendosi agli impulsi elettrici, permettono di realizzare collegamenti telefonici. Il laser è l’elemento

essenziale delle stampanti dei quotidiani, di quelle dei computer e di alcuni radar e, inoltre, con i suoi

raggi si può tagliare e forare ogni sorta di materiale, leggere CD, registrare, e riprodurre fotografie

tridimensionali (ologrammi) e fare innumerevoli altre cose. Ma che cosa in effetti sia un laser e come

esso funzioni sono in pochi a saperlo, oltre agli addetti ai lavori. Questo libro cerca di spiegarlo in

modo comprensibile, pur senza prescindere da un certo numero di considerazioni strettamente tecniche, raccontando come si sia arrivati a costruirlo, insieme al maser, che è il suo gemello nel dominio

delle microonde. La caratteristica dei laser di emettere fasci collimati e colorati deriva dal diverso

modo in cui in essi è emessa la luce rispetto alle altre sorgenti. Nel libro si approfondisce cos’è la

luce e come viene emessa, e a tale scopo si esamina come si comportano gli atomi, utilizzando alcuni

concetti della meccanica quantistica adatti a descriverli... Nel cercare di capire i vari fenomeni seguendo un filo storico l’autore ricostruisce, in un certo senso, parte della storia della luce e i primi

passi della meccanica quantistica, sia pure a un livello elementare.

Detto questo il libro che sto descrivendo è un bel libro divulgativo che si muove in un segmento

editoriale sempre più trascurato ovvero quello del lettore con preparazione scientifica di base medioalta che desidera approfondire un singolo tema o settore a lui poco noto. Ovviamente è un libro di

lettura con un formalismo matematico veramente ridotto all’osso e presente solo quà e là nel testo

ove necessario. A mio avviso, specialmente all’inizio, l’autore la prende troppo alla larga partendo da

Galileo e il metodo scientifico e talvolta si perde in parentesi troppo dettagliate (ad es. il cap. 6 su

Einstein). Naturalmente questo è il parere di uno studente del I anno di specialistica e necessariamente

sarà diverso da quello del lettore non addetto ai lavori. Tuttavia gli ultimi capitoli riscattano tutto il

testo fornendo molti retroscena storici e veramente molte informazioni sulla grande varietà di lasers

oggi esistenti. Complessivamente i soldi investiti sono pienamente ripagati da questo saggio veramente

completo e molto scorrevole nella lettura.

Matteo Mitrano

I NDICE

1. Introduzione

2. Le teorie ondulatoria e corpuscolare della luce

3. La spettroscopia

4. La teoria del corpo nero

5. L’atomo di Rutherford e di Bohr

6. Einstein

7. Einstein e la luce, l’effetto fotoelettrico e l’emissione stimolata

8. Microonde

9. Spettroscopia: atto secondo

10. La risonanza magnetica

11. Il maser

12. La proposta per un maser ottico

13. Le disavventure di Gordon Gould

14. E finalmente fu il laser!

15. A che cosa serve il laser?

I N BREVE

Titolo

Autore

Editore

Anno

Pagine

Prezzo

6

accastampato num. 1, Giugno 2010

Storia del Laser

Mario Bertolotti

Bollati Boringhieri

1999

390

35.00 e

ESPERIMENTI

Un palloncino sul phon

S CHEMA

Come il getto d’aria del phon tiene il palloncino sospeso sopra di sé

di Carlo Cosmelli

(Professore di Fisica alla Sapienza)

A

ccendere il phon a mezza forza e tenerlo fermo con il getto d’aria rivolto verso l’alto.

Prendere il palloncino e poggiarlo delicatamente nel mezzo del flusso di aria sopra il

phon. Si vedrà che il palloncino si metterà in una posizione di equilibrio, più in alto o

più in basso del punto in cui l’avevate lasciato, e ci rimarrà stabilmente.

Suggerimenti e astuzie

Se il palloncino fosse troppo leggero, cioè se vola via, vuol dire che il getto d’aria è troppo forte. In

tal caso ridurre il getto d’aria. Se non fosse possibile, provare ad aumentare la massa del palloncino

inserendo un po’ d’acqua (circa mezzo cucchiaino) dentro di esso prima di gonfiarlo.

Approfondimento

Il palloncino rimane in equilibrio per due ragioni: la prima è semplicemente la forza generata dal

flusso d’aria diretto verso l’alto. Il flusso d’aria è più forte all’uscita del phon e diminuisce di intensità

man mano che ci si allontana dalla bocca del phon. Ci sarà un punto in cui la forza esercitata dal flusso

d’aria è uguale alla forza di gravità che si esercita sul palloncino. In questa posizione il palloncino

potrà stare in equilibrio.

Tuttavia questo potrebbe essere un punto di equilibrio instabile, per spostamenti laterali. Invece si può

vedere che se diamo delle piccole botte al palloncino, questo si sposta dalla posizione di equilibrio,

ma tende poi a ritornare verso il centro del getto d’aria, rimanendo sempre in equilibrio.

Questo vuol dire che c’è un secondo effetto che mantiene il palloncino in posizione: si tratta dell’effetto combinato del principio di Bernouilli e dell’effetto Coandă. Quello che succede è che l’aria che

esce dal phon crea una specie di guscio intorno al palloncino, dandogli un ulteriore supporto. Possiamo accorgerci di questo effetto anche spostando il getto di aria del phon dalla posizione verticale,

inclinandolo lateralmente. Si può vedere come, per angoli non troppo grandi, il palloncino continua

a restare sospeso nel mezzo del getto di aria, anche se ora si trova fuori dalla verticale innalzata dalla

bocca del phon.

Il palloncino può essere anche sostituito da una pallina da ping-pong, dipende dalla potenza del phon.

Principio di Bernoulli ed effetto Coandă

Esempio dell’effetto Coandă, da it.

wikipedia.org

M ATERIALE

• 1 palloncino gonfiato poco (10 ÷

15cm)

• 1 phon elettrico

A RGOMENTO

• Equilibrio di un corpo in un fluido

• Fluidi reali

di Isabella Malacari

Un problema con cui ci siamo confrontati tutti? Riuscire a bere da una fontanella senza bagnarsi completamente

volto e maglietta! Perché l’acqua che ci bagna il viso, anziché gocciolare giù dal mento, scorre lungo il collo?

L’adesione di un fluido (un liquido o un gas) lungo superfici ricurve prende il nome di effetto Coandă: lo strato del

fluido prossimo alla superficie su cui scorre, rallentando per attrito, vincola il movimento degli strati esterni a causa

della reciproca attrazione; l’effetto mette in rotazione gli strati esterni verso l’interno, facendo aderire il fluido

alla superficie stessa. Ma questo non è certo l’unico fenomeno visibile nella dinamica dei fluidi. Prendiamo ad

esempio tra le dita gli angoli del lato corto di un foglietto di carta (uno scontrino per esempio) e avviciniamoli alla

bocca. Soffiando delicatamente appena sopra il foglio, questo si alzerà, restando sospeso a mezz’aria; aumentando

la forza del soffio, il foglio inizierà a sbattere freneticamente. Il fluire dell’aria sul lato superiore del foglio causa,

infatti, una diminuzione della pressione rispetto al lato inferiore che, pertanto, è spinto verso l’alto. In questo caso

è il principio di Bernoulli che garantisce infatti che ad ogni aumento della velocità di un fluido corrisponde una

diminuzione della sua pressione e viceversa.

Effetto Coandă e principio di Bernoulli non sono indipendenti, ma possono essere descritti come casi particolari di

una teoria generale dei fluidi, fondata sui lavori degli scienziati Claude-Louis Navier e George Stokes.

accastampato num. 1, Giugno 2010

h̄σω τσ. . .

Breve guida per evitare di perdersi fra queste pagine

la Redazione

ara lettrice e caro lettore, queste poche righe sono

per spiegarti come è nata questa rivista e come provare a interpretarla. Accastampato è nata dall’impegno di un gruppo di studenti di Fisica della Sapienza, certamente non specialisti nella difficile arte della divulgazione scientifica, ma senza dubbio appassionati di ciò che

hanno scelto di studiare. L’intento esplicito è quello di raccontare non solo la fisica già data per assodata, ma soprattutto gli

esperimenti e la ricerca di frontiera, cercando di evidenziare quali siano i problemi ancora aperti delle teorie oggi comunemente accettate o ancora dibattute nella comunità scientifica. Non

pensiamo di poter riuscire a pieno in questo progetto ambizioso,

ma speriamo di poterti almeno incuriosire. Ti invitiamo a non

scoraggiarti nel caso in cui alcune cose ti siano poco chiare e

ti esortiamo ad approfondire i concetti più difficili. Per aiutarti ogni articolo è accompagnato da una bibliografia dettagliata

e da un indice di difficoltà (da 1 a 3 atomini) con cui stimiamo l’impegno richiesto per una buona comprensione. Non esitare a mandarci commenti, critiche o richieste di qualunque tipo

a [email protected].

C

Ecco qui si seguito una breve panoramica della rivista, divisa in

diverse sezioni e varie rubriche.

La sezione Il Ricercatore Romano racconterà il lavoro dei ricercatori del Dipartimento di Fisica della Sapienza. Abbiamo scelto

di non limitare troppo la lunghezza dei singoli articoli, pur sapendo di violare una delle prime regole dell’editoria contemporanea:

preferiamo rischiare e dilungarci un po’ più del dovuto che rinunciare a spiegare almeno nei punti essenziali quale sia il senso di

una ricerca che spesso richiede anni per essere portata a termine. Per facilitare la lettura abbiamo cercato di illustrare gli aspetti

fondamentali nelle prime pagine, lasciando alla seconda parte un

approfondimento successivo.

Una sezione speciale, Il Resto del Neutrino, sarà dedicata alla

spiegazione scientifica di tecnologie e fenomeni comuni, troppo

spesso sconosciuti e a volte percepiti come apparentemente misteriosi. Con questi articoli vogliamo sottolineare come la Scienza

e il metodo scientifico permeino ormai profondamente quasi ogni

aspetto della vita, con l’esplicito scopo di combattere il sempre

più diffuso utilizzo inconsapevole della tecnologia moderna.

La sezione Nanos Gigantum ripercorrerà alcune delle tappe fondamentali del pensiero scientifico, affinché le meraviglie naturali

a cui rivolge la sua attenzione possano essere comprese non solo

sul corretto piano logico o applicativo, ma anche nel loro inquadramento storico. Sarà quindi un’opportunità preziosa per recuperare il gusto del cammino verso la conoscenza, a fianco allo

stupore mai sopito per i contenuti della conoscenza stessa.

Completano la rivista le rubriche dedicate agli Eventi rilevanti nel

panorama scientifico italiano e internazionale, alle Recensioni di

libri e non solo, che possano fungere da spunto per un approfondimento o da guida per esplorare nuovi orizzonti, agli Esperimenti

da fare anche in casa per toccare con mano alcuni principi delle

leggi naturali, alle problematiche sociali, politiche ed economiche connesse alla pratica scientifica di Onda Lunga e infine ai

rapporti più o meno ovvi tra Arte e Scienza in ScienzArte.

In conclusione ti ricordiamo che Accastampato è protetta con licenza Creative Commons, il che significa che sei libero di scaricarla, copiarla, stamparla e diffonderla. Le uniche limitazioni sono l’obbligo di citare la fonte, di coprire con la stessa licenza le eventuali opere derivate e il divieto di usarle in opere

commerciali.

Buona lettura!

Cos’è Accatagliato

Accatagliato è un’associazione di studenti di Fisica della Sapienza, esiste di fatto dalla fine del 2005, ma da Dicembre 2009 è riconosciuta dalla Regione Lazio. Il sito è raggiungibile all’indirizzo www.accatagliato.org e le varie attività possono essere seguite online mediante la pagina Facebook (www.facebook.com/accatagliato), il canale Twitter (twitter.com/accatagliato) e il canale di Youtube (www.youtube.com/user/

accafilmato). Il nome un po’ bizzarro e difficilmente comprensibile per chiunque non abbia

studiato la Meccanica Quantistica deriva da una costante ben nota a tutti coloro che studiano FisiSimbolo di h̄, costante di Planck.

ca: si tratta della costante di Dirac, proporzionale alla più nota costante di Planck h, che definisce

la scala a cui è necessario usare la Meccanica Quantistica al posto della Fisica Classica.

8

accastampato num. 1, Giugno 2010

accastampato, Creative

Commons e Patamu

Una questione di licenze. . .

Adriano Bonforti

(Studente di Fisica, Terza Università degli Studi di Roma)

a rivista accastampato ha scelto di liberare sin dal

suo primo numero il proprio contenuto con licenze

Creative Commons (CC), attraverso la consulenza e

la collaborazione del sito patamu.com, che ha contestualmente fornito un servizio di tutela dal plagio. Per una rivista di carattere scientifico divulgativo la scelta non poteva essere migliore, poiché la Scienza e il Sapere in generale sono o

dovrebbero essere per definizione libere da vincoli di diffusione

ed elaborazione. D’altra parte la storia della scienza è un’ottima

e convincente dimostrazione di quanto virtuose possano essere la

condivisione e la libera fruizione del sapere per il progresso scientifico. In questo articolo proponiamo una breve panoramica sulle

licenze CC e sul servizio offerto da Patamu.

L

-------------------------------------------

accastampato ha scelto di liberare sin da

questo primo numero il proprio

contenuto con licenza Creative

Commons

------------------------------------------Per questo ci si riferisce spesso alle licenze di Creative Commons

come licenze copyleft. Per favorire il più possibile la libera circolazione di questa rivista e dei suoi contenuti, abbiamo scelto

di liberarla attraverso la licenza CC di tipo BY- NC - SA (attribution, non commercial, share alike): significa che tutti i suoi contenuti possono essere riprodotti e diffusi, a condizione che ciò

non avvenga per scopi commerciali e che venga sempre indicato

l’autore. Le opere possono inoltre essere modificate a condizione

che sussista l’assenza di lucro e che l’autore e l’opera originaria

vengano sempre indicati e informati ove possibile; infine, l’opera

derivata deve essere a sua volta liberata con le stesse condizioni.

Figura 1 Logo di patamu.com

Creative Commons Public Licenses

Le Creative Commons Public Licenses (CCPL) sono delle particolari licenze che permettono di distribuire un’opera d’arte o di

ingegno svincolandola parzialmente dalle rigide imposizioni del

diritto d’autore tradizionale (copyright). La loro nascita si ispira

al principio di natura legislativa in base al quale chi crea un’opera di ingegno, una volta dimostratane la paternità, può disporre

di essa come meglio crede, riservandosene i diritti in toto o solo

in parte. Le licenze CCPL si basano quindi sul principio “alcuni diritti riservati” anziché “tutti i diritti riservati”: attraverso di

esse l’autore svincola la propria opera secondo determinate modalità, concedendone ad esempio la diffusione gratuita e libera in

assenza di scopo di lucro. In altre parole, per mezzo delle CCPL

l’autore dà esplicitamente il consenso affinché la sua opera possa

circolare ed essere diffusa più o meno liberamente, disponendo

come vuole dei propri diritti. Ciò in contrapposizione al caso del

copyright tradizionale, nel quale ciò non è possibile.

Figura 2 Locandina Creative Commons (da OilProject)

accastampato num. 1, Giugno 2010

9

ONDA LUNGA

Patamu

Spendiamo infine qualche parola per presentare il sito Patamu,

attualmente in versione beta, che oltre ad offrire consulenza per

quanto riguarda le tematiche CC e la cultura libera in generale,

permette di integrare le licenze CC apponendo ad ogni opera inviata una sorta di timbro temporale informatico con validità legale

riconosciuta dallo Stato Italiano.

Il servizio al livello base è gratuito e permette di tutelare dal plagio e di rilasciare contestualmente in Creative Commons qualsiasi opera artistica o di ingegno: opere musicali, foto, ma anche

libri, articoli di giornale o di blog, articoli scientifici e quant’altro. Per case editrici, etichette, associazioni, società, o per chiunque volesse accedere a servizi più specifici e mirati, sarà possibile

abbonarsi con una piccola somma a vari servizi avanzati.

Pur essendo possibile su Patamu la semplice tutela dell’opera, abbiamo scelto di offrire il servizio gratuitamente per chiunque sia

disposto a liberare contestualmente l’opera in CC. Questa scelta è

stata certamente fatta per incoraggiare e favorire la diffusione della cultura cosiddetta open source, ma c’è anche un altro motivo:

capita spesso infatti che le persone rimangano diffidenti di fronte

alla dicitura “alcuni diritti riservati” e ritengano che il modo più

pratico e sicuro di tutelare la propria opera sia quello di rimanere

detentore di tutti i diritti. Paradossalmente, però, in questo modo sono essi stessi a frenare la diffusione della propria opera, in

quanto il copyright tradizionale ne rende più difficoltosa la diffusione – ad esempio via internet, o via radio – anche in assenza di

lucro.

Il copyleft è quindi, a nostro avviso, anche il modo più pratico e

moderno per permettere di promuovere e far conoscere ad un numero più ampio possibile di persone il proprio prodotto artistico.

In questo contesto la tutela dal plagio fornita dal sito non diventa

più un’azione di tutela dell’autore fine a se stessa, ma si trasforma in un mezzo per diffondere le proprie opere senza il timore

di essere plagiati, favorendo la libera circolazione della creatività

e della cultura sotto qualsiasi forma e contribuendo a innescare

un circolo virtuoso da cui possono trarre vantaggio autori e utenti

dell’opera allo stesso tempo.

Per richiedere qualsiasi informazione sulle tematiche CC o sui

servizi del sito, o per partecipare alla fase di test della versione

beta, siete i benvenuti su patamu.com.

Bibliografia

(1) Creative Commons: www.creativecommons.it

(2) Copyleft: www.copyleft-italia.it

(3) Patamu.com: www.patamu.com

Sull’autore

Adriano Bonforti ([email protected]) è esperto

in licenze di copyleft ed è amministratore del sito www.

patamu.com

I segreti del cinema 3D

Teoria e tecniche alla base della nuova era

dell’intrattenimento digitale

Alessio Cimarelli

(Laboratorio Interdisciplinare per le Scienze Naturali e Umanistiche – Sissa)

a visione tridimensionale o, in altre parole, la percezione della distanza a partire da una proiezione bidimensionale della luce in ingresso è basata sulle leggi

della stereometria. Il supporto può essere la retina,

una pellicola fotografica o una CCD, non c’è differenza: la stessa scena fotografata contemporaneamente da due posizioni leggermente diverse, ad esempio meno di una decina di centimetri nel caso degli occhi, produce due immagini in cui gli oggetti

più vicini presentano una traslazione laterale relativa all’interno

del campo visivo maggiore rispetto agli oggetti piu lontani (vedi

Figura 1).

L

Figura 2 Alcuni esempi di videocamere dedicate al cinema 3D (quelle

con doppio obiettivo) o adattate per lo scopo in alcuni recenti film 3D.

In fase di riproduzione si vuole far giungere all’occhio destro dello spettatore il film girato dalla macchina destra e viceversa, in

modo che il cervello possa combinare naturalmente le due immagini e ricostruire la scena tridimensionale. Ci sono molti modi per ottenere questo effetto: mediante filtri colorati (anaglifia),

filtri polarizzati circolarmente o linearmente oppure filtri shutter

LCD, la cui trasparenza varia alternativamente in sincronia con le

immagini.

Anaglifia

Figura 1 Sovrapposizione di due fotogrammi scattati da due posizioni

differenti, in cui il borotalco è centrato e a fuoco.

Attraverso questo shift relativo è possibile ricavare con una certa

precisione la distanza dell’oggetto in questione: nel caso di macchine fotografiche, conoscendo solo la distanza tra gli obiettivi,

le loro inclinazioni relative e applicando semplici equazioni. Il

cervello umano riesce a risolvere naturalmente queste equazioni

a partire dal secondo, terzo anno di età. Nel cinema 3D vero, cioè

né d’animazione, né adattato in post-produzione, il film viene girato contemporaneamente da due videocamere ad alta risoluzione

e velocità, montate l’una accanto all’altra con una certa distanza

tra gli obiettivi. Macchine di questo tipo molto diffuse sono per

esempio la Red One e la Silicon Imaging SI-2K Digital Cinema

Camera (vedi Figura 2).

Si tratta del 3D tradizionale e più conosciuto, che ha però il grosso limite di non poter rendere scene colorate, in quanto i filtri

utilizzati lavorano proprio in frequenza su due soli colori (vedi

Figura 3). La luce infatti non è altro che un’oscillazione del campo elettromagnetico e per questo è detta onda elettromagnetica:

i campi elettrico e magnetico oscillano in direzioni perpendicolari, tra loro e rispetto alla direzione di propagazione dell’onda.

La frequenza di quest’ultima è semplicemente il numero di oscillazioni che compie nell’unità di tempo. L’unità di misura delle

oscillazioni è l’Hz, un’oscillazione al secondo. In questo ambito si usa molto il terahertz (THz), che corrisponde a 109 Hz e ad

una lunghezza d’onda di 3 × 105 nm (nanometri, 10−9 m). Le due

grandezze sono legate tra loro dalla semplice relazione λ = νc , con

λ lunghezza d’onda, c velocità della luce e ν frequenza. L’insieme

dei valori della frequenza della luce viene detto spettro e la finestra del visibile (ovvero le frequenze della luce a cui i nostri occhi

sono in media sensibili) va dai 400 ai 790 THz o, se si preferisce,

dai 750 ai 380 nm. Il cervello percepisce le diverse frequenze

sotto forma di colori, dal rosso (basse frequenze, grandi lunghezze d’onda) al violetto (alte frequenze, piccole lunghezze d’onda),

come evidenziato nella Figura 4.

accastampato num. 1, Giugno 2010

11

IL RESTO DEL NEUTRINO

Figura 4 Spettro della luce, in cui è evidenziato l’intervallo a cui l’occhio

umano è in media sensibile. Qui sono riportati i valori della lunghezza

d’onda in nm (nanometri, 10−9 m) invece delle frequenze.

Figura 3 Esempio di anaglifo stampato su carta.

zione di raggi luminosi i cui campi sono diretti casualmente l’uno

rispetto all’altro. Una luce si dice invece polarizzata se la direzione di oscillazione del campo elettrico è costante nel tempo (tra le

due situazioni ce ne sono infinite intermedie, dette di luce parzialmente polarizzata). Dato che campo magnetico ed elettrico sono

perpendicolari, qualsiasi direzione sul piano che individuano può

essere scomposta in due contributi lungo due assi perpendicolari

a scelta. Mediante speciali filtri è possibile selezionare una particolare direzione di polarizzazione e scartare l’altra: è il caso delle

ben note lenti Polaroid (vedi Figura 6).

-------------------------------------------

La stereoscopia permette di ricavare la

distanza di un oggetto da una coppia di

immagini prese da due posizioni diverse

------------------------------------------Le due immagini stereoscopiche prendono il nome di stereogrammi e vengono stampate sulla stessa foto, ma mediante due colori

complementari, tipicamente rosso e verde. I filtri sono costituiti

da una coppia di lenti colorate montate su di un paio di occhiali

(vedi Figura 5). Questi filtri sono costituti da sostanze che assorbono o riflettono tutto lo spettro tranne la piccola porzione relativa al proprio colore, che viene trasmessa e/o in parte riflessa.

Essendo verde e rosso complementari, quindi lontani in frequenza, un filtro rosso assorbe tutta la luce verde e viceversa. Cosı̀ ad

ogni occhio giunge solo la sequenza di immagini che gli spetta e

il cervello interpreta la differenza tra i due flussi come distanza

degli oggetti. Il sistema è estremamente economico, ma ormai

superato.

Luce polarizzata e la soluzione RealD

La resa dei colori è invece ottima mediante filtri che lavorano in

polarizzazione, nome con cui si indica la direzione di oscillazione del campo elettrico. Normalmente la luce a cui siamo abituati

non è polarizzata, nel senso che è composta da una sovrapposi12

Figura 5 Schema di funzionamento del tradizionale cinema 3D.

Nel caso del cinema 3D, quindi, i due filmati, uno per l’occhio

destro e l’altro per quello sinistro, vengono proiettati contemporaneamente sullo schermo da due proiettori sincronizzati: di fronte a ognuno di essi è posto un polarizzatore, lineare o circolare.

Nel primo caso i campi elettrico e magnetico oscillano in fase,

cioè raggiungono il loro valore massimo insieme, mentre nel secondo in controfase: quando uno è massimo, l’altro è minimo e

viceversa.

In questo modo agli occhi dello spettatore la luce dei due filmati

giunge con due polarizzazioni indipendenti e le lenti montate op-

accastampato num. 1, Giugno 2010

IL RESTO DEL NEUTRINO

(vedi Figura 8).

Sono quindi necessari schermi speciali, detti silverscreen perché

trattati con particelle d’argento che, essendo un metallo, riflette quasi tutta la luce, lasciandone cosı̀ intatta la polarizzazione.

Schermi costosi e che soprattutto non sono adatti alle classiche

proiezioni 2D, perché troppo luminosi: necessitano quindi di sale

dedicate alle sole proiezioni 3D.

Figura 6 Schema intuitivo del funzionamento di un filtro Polaroid.

portunamente sugli occhiali selezionano quella corretta per ogni

occhio. In altre parole, di fronte ad ogni proiettore c’è lo stesso filtro Polaroid montato davanti all’occhio a esso associato. La scelta

dei due tipi di polarizzazione, lineare o circolare, non è equivalente: nel primo caso i filtri del proiettore e dell’occhio associato

sono uguali, cioè lasciano passare esattamente le stesse immagini,

solo se la testa dello spettatore è perfettamente verticale e quindi

allineata con il filtro del proiettore. In questo caso piegare la testa

di lato significa per ogni occhio vedere parte del filmato destinato all’altro perché i due filtri inclinati tra loro mescolano le due

polarizzazioni, fino a che l’effetto 3D non svanisce completamente. Nel caso della polarizzazione circolare questo problema non

esiste, ma in compenso i filtri relativi sono più costosi e un po’

meno efficienti: è il caso comunque della tecnologia più diffusa

al momento, RealD (vedi Figura 7), che tra l’altro utilizza un solo

proiettore a doppia velocità (48 fps, frames al secondo, con fotogrammi destro e sinistro alternati) e un filtro Polaroid oscillante,

che polarizza in maniera opposta i fotogrammi alternati. Ciò diminuisce sicuramente i costi, ma riduce anche sensibilmente la

luminosità delle immagini, anche del 50%, a causa del lavoro dei

filtri.

-------------------------------------------

Figura 7 Occhiali polarizzatori del sistema RealD.

Luce colorata e la soluzione Dolby3D

La tecnologia concorrente alla RealD più accreditata al momento

è quella della Dolby, Dolby3D (vedi Figura 9), basata invece su un

avanzato sistema di filtri in frequenza e il cui proiettore produce

ben 144 fps, 72 per ogni occhio: ogni frame viene ripetuto tre

volte consecutivamente.

I filtri Polaroid permettono a ogni occhio

di vedere solo il filmato a esso dedicato

------------------------------------------Un elemento importante per i sistemi basati sulla polarizzazione

della luce è lo schermo, in quanto la luce proiettata, prima di giungere agli occhi degli spettatori, deve essere da esso riflessa. Una

superficie qualsiasi, però, come quella degli schermi classici, fa

perdere irrimediabilmente polarizzazione alla luce incidente: la

rugosità della superficie in un certo senso mescola le carte, in

quanto ogni microsuperficie piana riflette la luce polarizzandola

in parte lungo la direzione parallela a sé, che è diversa dalla direzione di polarizzazione incidente e soprattutto casualmente diretta

Figura 8 Una luce incidente all’angolo di Brewster (specifico per ogni

materiale e dipendente anche dalla frequenza) viene riflessa e assorbita

in proporzioni diverse a seconda della polarizzazione.

accastampato num. 1, Giugno 2010

13

IL RESTO DEL NEUTRINO

Figura 9 Occhiali con filtri dicroici del sistema Dolby3D.

Come nel caso RealD, il proiettore non è dedicato, purché assicuri velocità e risoluzioni richieste. Tra la lampada e l’ottica viene

posto un filtro cromatico rotante (un disco diviso in sei settori colorati) che per ogni frame filtra un colore diverso. Tre settori sono

rosso, verde e blu, gli altri hanno gli stessi colori, ma di una tonalità leggermente più chiara. Su uno schermo bianco normale arrivano in un 24-esimo di secondo le sei immagini, riflesse verso gli

spettatori. Le lenti degli occhiali sono filtri dicroici composti da

qualche decina o centinaia di strati atomici depositati sotto vuoto

su un substrato di vetro. Hanno una finestra di trasmissione in

frequenza molto stretta proprio attorno ai colori del filtro rotante,

controllata con molta precisione variando lo spessore degli strati

depositati. Il resto della luce viene riflesso e ciò, come nel caso

di RealD, causa una diminuzione notevole della luminosità. In

questo modo, comunque, a ogni occhio giungono solo i rispettivi

tre fotogrammi colorati, che il cervello combina in un’immagine

tridimensionale a colori reali (vedi Figura 10).

I vantaggi di questa soluzione rispetto alle concorrenti sono molti: occhiali passivi, quindi economici quasi quanto quelli della

RealD, costi contenuti, ma soprattutto la possibilità di adattare in

poco tempo qualsiasi sala cinematografica 2D, purché dotata di

un proiettore digitale moderno, in maniera non permanente grazie all’uso dello schermo standard e alla rimovibilità del filtro rotante colorato. Un punto a favore molto importante per la rapida

estensione di questa tecnologia.

Schermi LCD

Un’ulteriore tecnologia 3D, messa in campo per prima dalla nVidia per il settore videoludico, si basa su particolari occhiali attivi le cui lenti, dette shutters, possono oscurarsi alternativamente,

passando da uno stato di trasmissione totale della luce a uno di

riflessione in pochi centesimi di secondo. Le lenti sono costituite

da uno strato di cristalli liquidi che si orientano opportunamente

quando sono sottoposti a una differenza di potenziale, esattamente come i ben conosciuti schermi LCD (Liquid Crystal Display).

Nel caso in esame rendono semplicemente la lente trasparente o

opaca. Un proiettore a doppia velocità (48 fps) alterna i fotogram14

Figura 10 Schema di funzionamento del sistema Dolby3D. 1) Colori

primari nei proiettori del cinema 2D standard. 2) Nel Dolby3D ogni

colore primario è separato in due tonalità, una per l’occhio sinistro e

l’altra per il destro. 3) Dato che per ogni occhio sono usati tutti e tre i

colori primari, la resa cromatica finale è realistica.

mi destinati ai due occhi e gli occhiali sono a esso sincronizzati

mediante un sistema wireless, in modo da selezionare il giusto

fotogramma per ogni occhio (vedi Figura 11).

Le lenti sono basate sulle peculiari proprietà ottiche dei cristalli

liquidi, che rispondono a campi elettrici esterni orientandosi parallelamente a essi. Tale liquido è intrappolato fra due superfici

vetrose provviste di contatti elettrici, ognuno dei quali comanda

una piccola porzione del pannello identificabile come un pixel.

Sulle facce esterne dei pannelli vetrosi sono poi posti due filtri

polarizzatori disposti su assi perpendicolari tra loro. I cristalli

liquidi, quando sono orientati casualmente, sono in grado di ruotare di 90◦ la polarizzazione della luce che arriva da uno dei polarizzatori, permettendole di passare attraverso l’altro. Quando il

campo elettrico viene attivato, invece, le molecole del liquido si

allineano parallelamente a esso, limitando la rotazione della luce

in ingresso. A un allineamento completo dei cristalli, corrisponde

una luce polarizzata perpendicolarmente al secondo polarizzatore, che quindi la blocca del tutto (pixel opaco). Controllando la

torsione dei cristalli liquidi in ogni pixel, proporzionale al campo

elettrico applicato, si può dunque regolare quanta luce far passare.

Questa tecnologia, che non fa uso di filtri né in frequenza né in

accastampato num. 1, Giugno 2010

IL RESTO DEL NEUTRINO

Figura 11 Alcuni esempi di occhiali LCD Shutters.

polarizzazione, risolve alla radice alcuni problemi, come la non

perfetta resa cromatica del primo caso, ma riduce sensibilmente

la luminosità e ha il costo più alto in assoluto (ogni occhiale può

raggiungere i 100$). È però la più accreditata, come dimostra

l’offerta dedicata all’Home Enterteinment di nVidia, per il prossimo futuro dell’Home Cinema 3D, soprattutto alla luce dei moderni schermi LCD o al plasma con frequenze di aggiornamento

di 200 Hz o più.

A margine segnalo che la Creative offre una soluzione ulteriore e

radicale con il suo nuovo sistema MyVu, in cui all’interno degli

occhiali sono montati veri e propri schermi LCD opportunamente

messi a fuoco da lenti ottiche: semplicemente infilandosi gli occhiali, si può vedere il filmato scelto come in un sistema head-up

(schermo virtuale sovrapposto alla realtà esterna) con una risoluzione di 640x480 a 24 bit di profondità di colore e una frequenza

di aggiornamento di 60Hz, vale a dire una qualità equivalente al

dvd, ma non ancora all’alta definizione del blu-ray.

Per ora non si parla di funzionalità 3D, ma è evidente che un

semplice sistema di input a doppio canale video, uno per ogni

schermo, lo permetterebbe. Soluzione sicuramente interessante

per l’intrattenimento privato, a differenza evidentemente di quello

cinematografico.

Commenti

A mio avviso nelle tecnologie appena elencate c’è un problema

di fondo che non è legato alla particolare implementazione usata,

ma proprio alle caratteristiche intrinseche della fotografia e della

stereoscopia. Il sistema visivo umano è tale che la messa a fuoco

è automatica e segue il processo attentivo: il punto della scena

su cui poniamo attenzione è sempre messo a fuoco (nei soggetti

sani o portatori di occhiali correttivi, naturalmente), a meno che

non cerchiamo consapevolmente di vedere zone sfocate dell’immagine (il classico caso delle gocce su una finestra). Nella fotografia (sia da stampa che cinematografica), invece, l’estensione

della zona di messa a fuoco (profondità di campo) è limitata, soprattutto per scene miste con oggetti sia in primo piano che sullo

sfondo. Guardando una foto o un film bidimensionale noi vediamo le zone sfocate e non possiamo ovviamente metterle a fuoco

ulteriormente. Usiamo però quest’informazione per ricostruire

idealmente le distanze relative tra i vari oggetti, partendo dal presupposto che gli oggetti più lontani siano più sfocati rispetto al-

l’oggetto in primo piano, a fuoco. Nel caso del cinema 3D, però,

noi già vediamo una scena tridimensionale e l’informazione data

dalle zone fuori fuoco non serve. Porre quindi l’attenzione su queste zone dà fastidio, soprattutto se ci sono oggetti in movimento,

che evidenziano l’omonimo effetto (motion blur, in inglese).

Curiosamente questo permette al

regista, che decide dove mettere a fuoco la scena, di catturare molto di più l’attenzione dello

spettatore sui particolari che gli

interessa sottolineare, quasi costringendolo a guardare ciò che

vuole.

Bibliografia

(1) Anaglifia:

http://en.wikipedia.org/wiki/

Anaglyph_image

(2) Semplice tutorial per realizzare stereogrammi:

http://dicillo.blogspot.com/2007/07/

tutorial-stereografia-come-realizzare.html

(3) Silicon Imaging SI-2K Digital Camera:

www.siliconimaging.com/DigitalCinema/SI_2K_

key_features.html

(4) 3DStereo.it: www.3Dstereo.it

(5) Bob’s trip into Dolby3D Technology:

www.moviestripe.com/dolby3D/

(6) The Dolby solution to Digital 3D:

http://www.edcf.net/edcf_docs/dolby-3D.pdf

(7) Dolby3D: http://www.dolby.com/consumer/

technology/dolby-3D.html

(8) Filtri dicroici: http://en.wikipedia.org/wiki/

Dichroic_filter

(9) LCD: http://it.wikipedia.org/wiki/LCD

(10) Creative MyVu: www.tecnologiecreative.it/

schede/MyVu_Edge_301/index.html

Sull’autore

Alessio Cimarelli ([email protected])

si è laureato in Fisica nel settembre 2009 alla Sapienza di Roma, con una tesi sul comportamento collettivo degli stormi di uccelli in volo (progetto Starflag). È tra gli ispiratori e gli amministratori del portale accatagliato.org. Al momento frequenta il Master in Comunicazione Scientifica alla Sissa di Trieste, collaborando attivamente con il portale

accatagliato.org e la rivista accastampato.

accastampato num. 1, Giugno 2010

15

Il comportamento

collettivo animale

Una grande varietà di specie animali mostrano spesso comportamenti di gruppo simili

Alessio Cimarelli

(Gruppo S TARFLAG, CNR/INFM)

on il termine comportamento collettivo si intende

l’emergenza di proprietà di un gruppo irriducibili a

quelle dei singoli individui che lo compongono, caratteristiche per lo più dipendenti dalle mutue interazioni tra di essi. Condizione fondamentale per un comportamento

emergente è che ogni individuo interagisca con gli altri alla pari, con le stesse modalità, che non ci siano cioè elementi primari

(ad es. leader) che dettino il comportamento ad altri elementi

secondari, né elementi esterni che influiscano globalmente sul sistema, individuo per individuo indipendentemente. Le interazioni

hanno normalmente natura locale, vale a dire che ogni individuo

interagisce con un numero limitato di altri suoi simili, rimanendo

sostanzialmente all’oscuro del comportamento globale del gruppo a cui appartiene, molto più vasto della sua sfera di interazione.

Spesso l’interazione con un ambiente esterno dinamico è centrale, specialmente nei sistemi biologici. Il principale indizio della

presenza di un comportamento collettivo è l’apparire di patterns

macroscopici ordinati, di configurazioni particolari e persistenti

del sistema su scala maggiore dell’estensione dei singoli individui. Questa è una condizione necessaria, ma non sufficiente, in

quanto ci sono casi in cui è sufficiente il teorema del Limite Centrale (box a pag. 20) dei processi aleatori per spiegare fenomeni

ordinati e apparentemente coordinati (2).

C

I principi base dell’auto-organizzazione, condizione primaria del

comportamento collettivo emergente, possono essere individuati

in feedback positivi e negativi, in meccanismi di amplificazione

di fluttuazioni casuali, di inibizione, catalizzazione, risposta a soglia, ridondanza e sincronizzazione (2). Tutta la ricerca che in

questi decenni è andata sotto il nome di complessità ha insegnato

che meccanismi di questo genere possono prodursi a partire da

elementi legati tra loro da semplici regole, per lo più di natura

non lineare. Ha insegnato come normalmente ci sia un parametro critico, interno o esterno al sistema, il cui valore permette la

presenza o meno di uno stato ordinato, l’emersione quindi di un

comportamento collettivo: la teoria delle transizioni di fase e dei

fenomeni critici è una delle maggiori conquiste della Fisica moderna e sta dimostrando di essere applicabile con successo a tutti

i fenomeni che mostrino auto-organizzazione.

Nel caso di sistemi biologici, però, non si può prescindere dall’evoluzione e dalla selezione naturale dovute all’interazione continua e profonda con l’ambiente, per cui devono essere considerati anche meccanismi di massimizzazione della sopravvivenza e

minimizzazione dei rischi, sia per gli individui, sia per l’intero

gruppo. In un’ottica evolutiva l’aggregazione nel mondo biolo16

gico porta all’emersione di nuove funzioni che il gruppo riesce

a espletare molto meglio del singolo individuo o che sono addirittura fuori dalla portata di quest’ultimo. Esempi sono l’abilità

di costruire un formicaio, di regolare termicamente un alveare,

di procacciarsi il cibo, di difendersi dai predatori, di aumentare

l’efficacia delle scelte in un processo decisionale complesso (2).

Figura 1 A sinistra, Lunepithema humile; a destra, code di turisti.

Tutto ciò può far pensare che la selezione naturale abbia individuato nel comportamento collettivo un efficace mezzo per sopravvivere meglio all’ambiente, ma spesso questa connessione non è

affatto immediata. Ad esempio l’aggregarsi in certi casi aiuta a

difendersi dai predatori, ma in altri li attira: si pensi ai banchi di

pesci, un incubo per gli squali, ma una benedizione per i pescatori.

Inoltre i singoli animali sono molto più complessi di qualsiasi molecola e nel comportamento collettivo le dinamiche sociali devono

sempre confrontarsi con quelle individuali: ad esempio la ricerca di cibo all’interno di una mandria è più efficiente, ma in caso

di risorse scarse richiede la suddivisione tra tutti i suoi membri.

Questo che potremmo definire dilemma dell’individualità si può

tradurre nella domanda: su che scala agisce la selezione? Quali

variabili determinano il punto oltre il quale il comportamento collettivo si esplica in configurazioni realmente adattative e con quali

modalità? Queste domande appaiono ancora più importanti alla

luce degli studi che hanno mostrato come l’auto-organizzazione

sia un ingrediente centrale anche a livello genetico e di sviluppo

dell’embrione.

Nel seguito, senza alcuna pretesa di essere esaustivo o esauriente,

presenterò e descriverò una parte degli studi sulla grande varietà

di fenomeni biologici che a buon titolo rientrano nella categoria

comportamento collettivo, sia dal punto di vista biologico e spe-

accastampato num. 1, Giugno 2010

IL RESTO DEL NEUTRINO

Figura 2 A sinistra, alveare di api; a destra, traffico a Los Angeles.

rimentale, che da quello matematico e computazionale. Il tutto

corredato da suggestive immagini che appartengono alla nostra

esperienza quotidiana, ma che celano fenomeni naturali ancora

non del tutto compresi.

Colonie di formiche

Una delle prime evidenze della presenza di meccanismi di autoorganizzazione nel mondo biologico si è avuta studiando le formiche (famiglia delle Formicidae, a cui appartengono più di 12000

specie, componenti il 10% dell’intera biomassa animale e il 50%

di quella degli insetti) e il loro sistema di comunicazione e coordinamento basato su tracce chimiche di feromone. In molte specie

le formiche operaie (foragers) rilasciano durante il loro cammino

una sostanza volatile rilevabile dalle altre, con cui riescono a tracciare una pista invisibile dal formicaio alle risorse di cibo. Essendo volatile, la persistenza della pista dipende dalla frequenza del

suo utilizzo da parte delle formiche, che la rafforzano seguendola. Questo è un tipico esempio di feedback positivo, unitamente

a un meccanismo di inibizione (la volatilità del feromone). La

possibilità che si instauri un procacciamento stabile di cibo basato sulle tracce di feromone dipende fortemente dal numero di

operaie impegnate in questo compito, o in altre parole dalla dimensione del formicaio: vari esperimenti hanno dimostrato che il

passaggio da una ricerca individuale e casuale a una basata sulle tracce chimiche ha le stesse caratteristiche delle transizioni di

fase del primo ordine, confermate anche da simulazioni apposite

(vedi box a pagina 29).

Storicamente lo studio delle società di insetti è considerato alla

base del paradigma dell’auto-organizzazione, perché inizialmente le incredibili capacità del formicaio o dell’alveare nel risolvere problemi molto al di là delle capacità della singola formica

o ape apparivano incomprensibili senza appellarsi a improbabili

capacità percettive e comunicative della regina. Poi, attraverso

osservazioni, modelli e soprattutto un cambio di paradigma interpretativo, è stata individuata tutta una serie di abilità e comportamenti con alla base meccanismi auto-organizzativi. Ad esempio

la presenza di fenomeni di biforcazione e di rottura spontanea di

una simmetria: in un classico esperimento si costruiscono due vie

identiche ma alternative tra il formicaio e una risorsa di cibo e si

scopre che, superato un certo numero di operaie, l’utilizzo prima

simmetrico di esse viene a mancare in favore di un solo cammino

(cfr. Figura 3). In questo caso le leggere differenze iniziali nel

numero di formiche che si dirigono da una parte o dall’altra divengono determinanti per la scelta finale del percorso. Da notare

che se le due vie sono diverse, per esempio una più lunga dell’altra, la deposizione del feromone fa sı̀ che sia più concentrato

lungo la via più breve e che quindi a regime sia sempre questa la

più usata dalle operaie.

È interessante anche un altro esperimento che dimostra come sia

importante nei sistemi biologici un buon bilanciamento tra comportamento sociale e individuale, quest’ultimo modellizzabile in

qualche caso come rumore statistico. Tale concetto è chiarito da

un semplice esempio. Introducendo una risorsa di cibo nei pressi

di un formicaio, dopo qualche tempo una formica scout la individuerà e, nel caso ci siano abbastanza operaie, si formerà una traccia persistente e un flusso stabile di cibo. Introducendo ora una

nuova risorsa più energetica, la possibilità che il formicaio la scopra e la sfrutti dipende dall’accuratezza delle formiche nel seguire

la vecchia traccia. Se fossero tutte infallibili, infatti, non abbandonerebbero mai un percorso già fissato. Solo se le caratteristiche

comportamentali individuali sono abbastanza forti le operaie sono invece in grado di stabilire una nuova traccia verso la nuova

risorsa, abbandonando la vecchia (3).

Da quando il meccanismo delle tracce chimiche è stato scoperto,

si è dimostrato che è alla base di numerose abilità delle formiche:

raccolta di cibo, ottimizzazione dei percorsi anche sulla scala dei

chilometri (4), strategie di combattimento, costruzione di formi-

Figura 3 Esempi di configurazioni auto-organizzate nelle colonie di formiche (3). A sinistra, selezione spontanea di un percorso verso il cibo

attraverso un ponte a diamante da parte di Lasius niger; a destra, gocce di Lunepithema humile cadono non appena raggiungono una taglia

critica.

accastampato num. 1, Giugno 2010

17

IL RESTO DEL NEUTRINO

Figura 4 A sinistra, stormo di pipistrelli; a destra, sciame di locuste.

cai sotterranei. Appare ora chiaro del perché quello degli insetti

sia un esempio paradigmatico: a fronte di interazioni non lineari

locali dirette (contatto e sfregamento) e indirette (deposito di feromone), grazie a meccanismi di feedback positivo (rafforzamento

della traccia) e negativo (volatilità del feromone), si produce un

qualche tipo di transizione di fase dipendente dalle dimensioni

del formicaio, da cui emergono abilità collettive che amplificano

enormemente le capacità dei singoli insetti.

scale differenti. La fase ordinata è individuata dal grado di allineamento dei pesci e anche in questo caso sono stati forniti indizi della presenza di una transizione dal disordine all’ordine al

variare della densità.

I primi tentativi di analisi quantitativa risalgono a metà degli anni

’70, con un lavoro di Graves in cui si presenta un setting sperimentale originale per fotografare banchi di pesci nel loro ambiente naturale e stimarne densità e distanza media di primo vicino.

Dal 1983 si inizia a utilizzare la tecnica stereoscopica per ricostruire le posizioni individuali dei pesci all’interno del banco, ottenendone una stima della densità, delle distanze reciproche, della

distanza media di primo vicino, della forma e delle proporzioni.

Vengono utilizzate tecniche di videofotografia stereo e un algoritmo di tracking per ricostruire le velocità dei pesci e individuare

cosı̀ l’emergenza di una fase con forte allineamento a partire dalle interazioni di primo vicino in tre dimensioni, ma limitandosi a

soli 8 pesci.

Sciami di locuste

Le locuste sono insetti molto particolari il cui comportamento collettivo è purtroppo tristemente famoso: per lunghi periodi della

propria vita sono insetti solitari, che tendono a mantenere territori separati l’uno dall’altro, ma in vari momenti attraversano fasi

di aggregazione, formando sciami di miliardi di individui capaci

di devastare completamente qualsiasi terreno attraversino, inclusi naturalmente quelli coltivati dall’uomo (5). Per avere un’idea

dell’imponenza di questi sciami, le loro dimensioni possono raggiungere i 1000km2 con una densità media di ben 50 milioni di

locuste per km2 , viaggianti a 10–15 km/h per migliaia di km: tenendo conto che ogni insetto mangia l’equivalente del proprio peso al giorno, si sta parlando di un consumo dello sciame pari a 200

milioni di kg al giorno! Le dinamiche interne di questi sciami

sembrano simili a quelle dei fluidi e sono trattabili matematicamente in modo analogo, cioè mediante modelli continui, grazie

alle loro dimensioni e densità. Il principale problema è capire come possa mantenersi la coesione dello sciame su dimensioni cosı̀

grandi rispetto a quelle del singolo insetto e i meccanismi che

sono alla base della transizione alla fase di aggregazione.

Banchi di pesci

Tra le innumerevoli specie di pesci molte presentano comportamenti di aggregazione, che originano da interazioni diverse da

quelle viste per le formiche.

Non si tratta ora di utilizzare l’ambiente come deposito del proprio segnale perché l’interazione è diretta, riassumibile nella terna di regole repulsione-allineamento-attrazione, ognuna agente a

18

Figura 5 Qualche esempio suggestivo di banchi di pesci nella loro fase

di aggregazione.

Sono poi videoregistrati gruppi di Nile Pilatias (Oreochromis niloticus L.) di un centinaio di elementi, costretti però a muoversi in

due dimensioni all’interno di una vasca opportunamente progettata. Su tempi di decine di secondi Becco et al. hanno tracciato le

traiettorie dei singoli pesci e sono stati in grado di portare a termine analisi sulla struttura e sulla dinamica del banco in funzione

della sua densità: distribuzione delle distanze di primo vicino e

grado di allineamento hanno mostrato indizi di una transizione di

fase disordine-ordine a una densità critica di circa 500 pesci/m2 .

Purtroppo fino a ora conclusioni sperimentali quantitative sono

praticamente assenti, a causa di grandi problemi metodologici

non ancora del tutto risolti: estrema ristrettezza della base statistica dovuta allo studio di non più di un centinaio di pesci, forti

bias introdotti dalle dimensioni e forme delle vasche, limitazioni dovute alle tecniche di tracciamento dei pesci e da una non

sempre corretta gestione degli effetti di taglia finita.

Da un punto di vista etologico e biologico molto lavoro è stato fatto per comprendere la funzione adattativa delle varie caratteristiche della fase ordinata, tra cui la forma del banco, i profili interni

accastampato num. 1, Giugno 2010

IL RESTO DEL NEUTRINO

Figura 6 A sinistra, mandria di bufali; a destra, formiche Matabele.

di densità, le posizioni dei pesci collegate alla loro grandezza o al

grado di familiarità, ecc. Le due funzioni primarie sono senz’altro la protezione dai predatori e la ricerca di cibo, mentre i meccanismi di base individuati vanno nel primo caso dalla diluizione

del rischio all’effetto di confusione, dalla capacità di individuare prima il predatore al coordinamento di manovre di evasione,

mentre nel secondo caso consistono in una maggiore velocità di

trasferimento dell’informazione sulla distribuzione delle risorse

di cibo (per un’ampia lista di referenze, cfr. (1)).

I banchi di pesci sono anche alla base di moltissimi modelli, poi

efficacemente adattati anche ad altre specie animali come gli uccelli: le interazioni dirette a corto raggio descritte prima sono facilmente implementabili in algoritmi bottom-up che hanno dimostrato di poter riprodurre non solo la transizione alla fase ordinata,

ma anche parte delle caratteristiche di quest’ultima riscontrate in

vari esperimenti.

-------------------------------------------

È possibile ricavare il comportamento

collettivo simulando semplici modelli al

computer

------------------------------------------Stormi di uccelli

Nel caso degli uccelli, l’approccio sperimentale è ancora più problematico rispetto al caso dei pesci, dato che non è possibile ricorrere a una situazione controllata in laboratorio ed è obbligatorio considerare tutte e tre le dimensioni spaziali (6). A parte

lavori pionieristici degli anni ’60, nel ’78 vi è la prima ricostruzione delle posizioni degli uccelli, limitata a 70 individui in volo dalle campagne ai dormitori, seguita da quella delle traiettorie

complete di poco più di 16 individui.

È evidente come qualsiasi analisi su una base di dati cosı̀ ristretta

non possa che portare a risultati solo qualitativi, con il rischio di

introdurre bias non controllabili (si pensi al problema del bordo:

in tre dimensioni trattare piccoli gruppi significa considerare per

lo più individui sul bordo e quindi ottenere risultati pesantemente

affetti da problemi di taglia finita). Il problema primario di questa

mancanza di dati sperimentali nello studio degli uccelli sta prevalentemente nelle tecniche di ricostruzione delle posizioni che non

possono essere chiaramente invasive e devono essere implementate sul campo. Per questi motivi sono tecniche per lo più di tipo

ottico (stereoscopia, metodo ortogonale) che prevedono l’utilizzo di immagini sincrone del gruppo e che richiedono di risolvere

esplicitamente il problema del matching, cioè il riconoscimento

dello stesso individuo in ogni immagine (6). Queste difficoltà

hanno reso per decenni impossibile una comparazione adeguata

tra modelli teorici, numerici e dati sperimentali, perché il comportamento collettivo emerge all’aumentare del numero di individui e limitarsi a piccoli gruppi spesso non permette di studiarne

efficacemente le caratteristiche globali.

Figura 7 Esempi degli stormi più suggestivi visibili a Roma nel periodo

invernale (foto dell’autore e della squadra STARFLAG).

Dinamiche di folla

A volte si dice che l’intelligenza di una folla di persone è inversamente proporzionale al numero di cervelli che la compongono.

Questa massima deriva dall’osservazione che spesso le dinamiche interne di una folla appaiono irrazionali se viste dall’esterno,

tanto da produrre veri e propri disastri nelle situazioni di pericolo,

vero o presunto, che scatenano il panico. Si pensi a incendi in edifici chiusi, ma anche a concerti di star famose o all’apertura della

stagione dei saldi in alcuni grandi magazzini. Questi fenomeni

sono in aumento con il crescere delle dimensioni di eventi che attirano grandi masse, ma è solo da poco più di un decennio che si

stanno studiando e sviluppando teorie quantitative e modelli delle

dinamiche di folla (7).

Simulazioni di questo tipo hanno permesso di migliorare la comprensione di questi fenomeni e individuare tutti quegli elementi,

architettonici e psicologici, che contribuiscono a rallentare o a

rendere più pericolosa la fuga in situazioni di panico: ad esempio uscite strette o allargamenti prima delle uscite ostacolano il

deflusso, che invece è facilitato dalla presenza di colonne poste

asimmetricamente di fronte alla uscite che spezzano gli ingorghi.

Inoltre sono risultati utili nello studio anche di altre formazioni,

come il traffico automobilistico o le ola negli stadi.

accastampato num. 1, Giugno 2010

19

IL RESTO DEL NEUTRINO

chiaramente dallo studio dei modelli, sia analitici che numerici, che mostrerò nel dettaglio in un prossimo articolo dedicato

al comportamento collettivo animale.

Bibliografia

(1) Cimarelli A., Funzioni di struttura e correlazioni di velocità in stormi di uccelli in volo: un’analisi empirica nell’ambito del progetto Starflag, Tesi magistrale

(Settembre 2009)

(2) Sumpter D.J.T., The principles of collective animal behaviour, in Phil. Trans.

R. Soc. B, vol. 361:5–22 (2006)

Figura 8 A sinistra, folla a Longchamp, Parigi; a destra, sciame di batteri

M. Xanthus.

(3) Detrain C. e Deneubourg J.L., Self-organized structures in a superorganism:

do ants behave like molecules?, in Physics of Life Rev., vol. 3:162–187 (2006)

(4) Hölldobler B. e Wilson E.O., The ants, Harvard University Press (1990)

(5) FAO Locust watch: www.fao.org/ag/locusts/en/info/info/

(6) Giardina I., Collective behavior in

Conclusioni

animal groups: theoretical models and

empirical studies, in HFSP J., vol.

Da questa breve panoramica delle specie animali che mostrano

peculiari comportamenti collettivi emerge una delle caratteristiche fondamentali e più interessanti di questi sistemi: dinamiche macroscopiche simili a fronte di elementi microscopici estremamente diversi tra loro. Si tratta di un qualche tipo di universalità del comportamento collettivo, che apparirà ancora più

2(4):205–219 (2008)

(7) Helbing D., Farkas I. e Vicsek T.,

Simulating dynamical features of escape panic, in Nature, vol. 407:487–490

(2000)

Il Teorema del Limite Centrale

di Ulisse Ferrari

Curiosando tra risultati statistici d’ogni sorta, come la distribuzione delle altezze in un paese o quella dei risultati degli

esami di maturità di un particolare anno, non si può non notare la presenza ricorrente di una particolare curva, detta Gaussiana, dalla forma a campana, con un picco al centro e code

laterali sottili.

Quella che può apparire come una semplice curiosità è invece la realizzazione di un importante teorema della teoria della

probabilità, il ramo della matematica che studia e descrive il

comportamento delle variabili casuali (dette aleatorie), ossia

delle quantità che possono assumere diversi valori, ciascuno con una certa probabilità. Il Teorema del Limite Centrale (nella versione generalizzata dal fisico-matematico russo

Funzione di densità della variabile casuale normale (o di Gauss).

Aleksandr Lyapunov), sotto alcune ipotesi, asserisce che: µ indica il valor medio (posizione del picco), σ2 la varianza

la somma di n variabili casuali indipendenti ha una distribu(legata alla larghezza della campana). Da wikipedia.org

zione di probabilità che tende a una curva Gaussiana al crescere di n all’infinito. In altre parole, un fenomeno aleatorio,

risultato della cooperazione di molti piccoli fattori casuali indipendenti, avrà una distribuzione di probabilità Gaussiana.

Il voto che uno studente prenderà alla maturità, per esempio, dipenderà da molti fattori, quali la sua preparazione, le

abilità acquisite, la capacità di concentrazione, ecc. . . Nonostante la distribuzione di probabilità di questi fattori non sia

necessariamente Gaussiana, il voto, che è la somma di questi fattori, si distribuirà secondo tale curva.

20

accastampato num. 1, Giugno 2010

La riforma dell’Università

italiana

Dove siamo e dove stiamo andando. . .

Lara Benfatto

(Dipartimento di Fisica della Sapienza di Roma)

a circa 6 mesi è stata presentata una bozza del Disegno di Legge Gelmini riguardante la riforma dell’Università (1). Ora tale DDL è in discussione al

Senato a meno di un anno dall’imponente mobilitazione di tutto il settore dell’Istruzione seguito al decreto legge

133 dell’agosto 2009, con il quale si pianificavano pesantissimi

tagli a scuola ed università, in termini sia di finanziamento che

di reclutamento, riguardanti il periodo 2009–2013. Il successivo

decreto legge 180 del dicembre 2009 ha parzialmente corretto il

tiro sul fronte del blocco delle assunzioni e dei tagli all’università, lasciando tuttavia in essere un taglio di 946 milioni di euro

in 5 anni, pari al 2, 7% del Fondo di Finanziamento Ordinario

(FFO) del comparto università (2). A prima vista tale riduzione

può sembrare non particolarmente significativa: tuttavia, occorre

ricordare che le università utilizzano già circa il 90% del FFO per

pagare gli stipendi. Ma per fare didattica e ricerca servono anche

(ingenti) fondi per la gestione di strutture didattiche e laboratori,

per le collaborazioni scientifiche, partecipazione a convegni, personale a tempo determinato, ecc. Quindi un taglio del 2, 7% del

FFO azzera in pratica ogni possibile margine operativo in ricerca e sviluppo del nostro sistema universitario, che non può essere

compensato da alcun progetto di riorganizzazione amministrativa

del medesimo.

D

Figura 1 Uno striscione degli studenti del Dipartimento di Fisica durante

una manifestazione contro il DDL Gelmini e il Decreto Legge 133 dello

scorso autunno.

22

Prima di entrare nel merito del DDL Gelmini vale la pena di fare uno sforzo analitico di lettura dei contenuti reali e di quelli

virtuali del DDL. È infatti interessante notare come gran parte

degli editoriali apparsi negli ultimi mesi su autorevoli quotidiani

nazionali si siano focalizzati sui punti più vaghi della prospettata

riforma, quelli cioè la cui definizione viene affidata a decreti leggi

successivi all’approvazione del DDL, e quindi dai contenuti assolutamente incerti e al momento imprevedibili. Tentiamo quindi di

riassumere a grandi linee i contenuti del DDL, distinguendo tra i

provvedimenti di immediata attuazione e quelli da definirsi.

-------------------------------------------

. . . un taglio del 2, 7% del Fondo di

Finanziamento Ordinario azzera in

pratica ogni possibile margine operativo

in ricerca e sviluppo del nostro sistema

universitario. . .

------------------------------------------Provvedimenti immediati

• Riorganizzazione della struttura amministrativa (Art.

2). Questa si articola in vari punti: in particolare, si prevede

che al senato accademico venga affiancato un consiglio di

amministrazione in cui il 40% dei membri sono esterni all’ateneo e con competenze gestionali-amministrative. Tale

CdA ha anche potere decisionale che spazia dalla definizione delle “funzioni di indirizzo strategico” alla soppressione/istituzione di corsi di studio e sedi. Si prevede inoltre

l’accorpamento dei dipartimenti (aventi un numero minimo

di docenti di 35 o 45) in massimo 12 facoltà o ’scuole’. Si

parla poi di un codice etico che le università sono tenute ad

adottare entro centottanta giorni dall’entrata in vigore della

legge, ma non si dà indicazione alcuna rispetto ai contenuti

in questione.

• Fondo per il merito degli studenti (Art. 4). Si tratta di

borse di studio e prestiti di onore, da attribuirsi con criteri

unicamente meritocratici (non di reddito) e previa selezione

nazionale. Si occupa della gestione del tutto una società, la

Consap S.p.A., che andrà pagata con i soldi stessi destinati

al fondo. Il fondo è istituito presso il Ministero dell’Economia, a cui il Ministero dell’Istruzione fa comunque riferimento per coordinarne la gestione. Il fondo viene finanziato

con “trasferimenti pubblici e con versamenti effettuati a ti-

accastampato num. 1, Giugno 2010

ONDA LUNGA

tolo spontaneo e solidale effettuati da privati, società, enti

e fondazioni, anche vincolati, nel rispetto delle finalità del

fondo, a specifici usi”.

• Riordino del reclutamento (Art. 7-10). I punti salienti

sono:

Art. 8 Si istituisce l’abilitazione nazionale per associato e

ordinario, basata sui soli titoli. La valutazione viene fatta da una commissione di durata biennale, con

4 membri sorteggiati da una lista di ordinari (a cui si

aggiungono anche gli associati solo se gli ordinari di

quel settore sono meno di 50) che fanno richiesta di

esserci e il cui curriculum è pubblico, più un membro

straniero. Le selezioni hanno cadenza annuale, ma nel

caso in cui il candidato non ne superi una deve aspettare 2 anni per riprovarci, e 3 per riprovare il livello

successivo. Da notare che una volta ottenuta l’abilitazione bisogna comunque sostenere il concorso presso

le singole sedi universitarie qualora queste bandiscano

dei posti. Le università possono anche indire procedure riservate per personale già in servizio nell’ateneo,

ma destinandovi non più del 30% dei posti disponibili

nei primi 5 anni successivi all’attuazione della riforma. Dopo questo periodo si richiede che siano obbligatoriamente esterni 1/5 dei posti da ordinari e 1/3 di

quelli da associati.

Art. 10 Gli assegni di ricerca hanno durata da 1 a 3 anni, rinnovabili, ma non devono superare complessivamente

i 10 anni. Oltre ai bandi locali di ateneo (che possono

basarsi su fondi di ateneo o fondi esterni su progetti

specifici) vengono istituiti anche dei bandi per selezioni nazionali, nelle quali il ricercatore presenta un

progetto che, in caso di vittoria, verrà svolto presso

una sede universitaria scelta dal candidato.

Art. 11 Per i contratti di insegnamento ci sono due casi: contratti a titolo gratuito o oneroso da dare a studiosi

esterni per potersi avvalere delle loro prestazioni. Poi

i veri contratti di docenza da attribuirsi previo espletamento di procedure disciplinate con propri regolamenti, che assicurino la valutazione comparativa dei

candidati e la pubblicità degli atti. Lo stipendio viene

deciso a livello ministeriale, ma non si sa in che modo.