S

Saverio Forestiero

C

I

E

N

Z

A

LE DIMENSIONI DELLA COMPLESSITÀ

BIOLOGICA

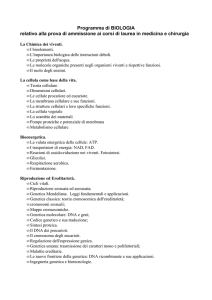

L’esame di alcuni punti critici del dibattito filosofico sulla complessità biologica precede la presentazione delle componenti, quantitativa e qualitativa, della complessità biologica. L’illustrazione delle

varie manifestazioni della complessità degli organismi è fatta ricorrendo alle tre nozioni chiave di organizzazione, individualità e

relazionalità. Il saggio contiene anche un’analisi del rapporto tra

biocomplessità e selezione naturale, e riassume in pochi punti

salienti l’ipotesi ricostruttiva dell’incremento di complessità lungo

l’organizzazione gerarchizzata dei viventi. La riflessione finale è

dedicata agli effetti della storia sulla complessità biologica.

“Complessità” è una tra le parole più ricorrenti e uno dei

concetti più trasversali delle scienze fisico-matematiche e

naturali. Esaminando gli scritti che trattano della complessità

biologica si nota subito che la nozione di complessità ha

carattere multidimensionale e che la relativa discussione

sull’argomento presenta molteplici aspetti. Senz’altro c’è l’irrisolta questione della definizione, c’è l’interrogativo se

complessi siano gli oggetti biologici o i modelli e le teorie,

ci sono posizioni antagoniste sulle eventuali differenze qualitative tra complessità dei sistemi fisici e dei biosistemi, troviamo il dibattito sulla misurazione della complessità, ricerche sul rapporto tra complessità e ordine e tra complessità e

informazione, saggi sugli aspetti semantici della complessità

e riflessioni sul rapporto tra complessità biologica e semiotica. Molto interesse suscitano anche gli interrogativi sull’ipotetico incremento di complessità dei sistemi viventi e sulle

eventuali tendenze progressive della complessità nell’evoluzione organica.

Sebbene da un punto di vista scientifico l’instabilità semantica della nozione di complessità biologica rappresenti

ovviamente una limitazione, tuttavia questa nozione conserva dei contenuti euristicamente utili e spendibili anche sul

piano teorico. Perciò tenteremo qui di seguito una sorta di

fenomenologia della complessità dei sistemi viventi. Naturalmente sarà una fenomenologia in formato ridotto: un’illustrazione corredata da alcune riflessione su certi fatti biologici, e su problemi e metodi dove entra in scena la complessità.

76

Kéiron

La complessità biologica

come problema

epistemologico

Sappiamo che i sistemi viventi della biosfera vengono di

norma ordinati in una gerarchia di entità secondo un criterio

di complessità crescente. L’organismo unicellulare, quello pluricellulare, la popolazione di organismi, e la biocenosi rappresentano quattro distinti livelli di organizzazione della materia vivente (Eldredge e Salthe, 1984). Ma diciamo subito che

non c’è accordo sul numero dei livelli gerarchici della complessità strutturale, sulla quantità delle scatole cinesi in cui è

C omplessità

C

organizzata la materia vivente. McShea (1991), ad esempio, riferisce che Ledyard

Stebbins individua non quattro ma otto differenti gradi di

organizzazione: i sistemi

organici capaci di autoriproduzione, i procarioti, gli

eucarioti monocellulari, gli

eucarioti pluricellulari semplici, gli organismi provvisti

di tessuti e organi differenziati, gli organismi con arti

ben sviluppati e dotati di

sistema nervoso, gli organismi omeotermi, l’uomo.

Sia come sia, tale complessità è stata giudicata come

un fatto tanto ovvio, da non

suscitare nessuna particolare attenzione teorica. Fino a

tempi recenti, questa accettazione acritica della complessità biologica non ha

prodotto ricerche mirate a

chiarirne i vari aspetti; prerequisito viceversa indispensabile per una definizione.

Come dire: i viventi sono

complessi, non c’è bisogno

di dimostrarlo e tanto meno

è necessario definire in cosa

consista tale complessità.

Ora, dietro questo atteggiamento trapela una precisa posizione filosofica, una scelta realista che dà per scontata la

complessità e non si dà pena di discutere un’altra possibilità,

l’alternativa, nominalista, che la complessità sia non un attributo dei viventi quanto piuttosto delle rappresentazioni

costruite dalla scienza. In questo secondo caso, intrinsecamente complessi sarebbero semmai i modelli della conoscenza biologica e non gli oggetti del mondo biologico, che

certo potranno essere più o meno complicati ma non complessi. Chiedersi perciò se i sistemi viventi siano oggetti “davvero” complessi può essere una domanda filosoficamente

interessante ma non scientificamente produttiva, perché

quel “davvero” complica anziché semplificare la strada verso

l’osservazione e la sperimentazione. Noi avvieremo il nostro

discorso assumendo invece, come artifizio operativamente

utile, che i sistemi viventi possiedano un qualche tipo di

complessità (della quale a priori non vogliamo decidere se

abbia natura reale o nominale) e che essa sia una proprietà

interessante che noi vogliamo caratterizzare. Agiremo perciò

Il passaggio critico nella gerarchia della

complessità corrisponde all’incremento

di complessità dei sistemi viventi, particolarmente intenso durante le transizioni evolutive più importanti (procarioti/eucarioti, unicellulari/pluricellulari).

Charles Darwin,

“Illustrazione italiana”, a.VII, n.6, 1880.

77

Kéiron

S

Una distinzione

C

I

E

N

Z

A

come se la complessità dei viventi fosse reale, e ne ricercheremo le manifestazioni visto che siamo interessati a esplorarne la fenomenologia e non a dimostrarne fondata o infondata l’ontologia.

fondamentale

Complessità algoritmica:

il contenuto informativo

dei sistemi viventi

78

Kéiron

In campo scientifico, il termine complessità viene impiegato

in due differenti accezioni (Lepschy, 2000). Chi ha familiarità

con l’informatica e con l’analisi numerica sa che la complessità corrisponde a una caratteristica quantitativa di un algoritmo di calcolo che ne determina la possibilità di impiego

per la soluzione pratica di un problema. Nell’ambito dei sistemi dinamici, invece, la complessità è di solito considerata

una caratteristica qualitativa di un sistema. Prima di abbozzare un identikit della complessità dei sistemi viventi visti

come sistemi dinamici, consideriamo brevemente la complessità biologica di tipo algoritmico.

Sappiamo che nei sistemi viventi l’informazione è conservata

e trattata negli acidi nucleici che specificano in maniera non

lineare i vari fenotipi; i quali, a loro volta, manifestano complessità gerarchizzata. Nel decennio successivo al 1953,

dopo che Watson e Crick ebbero scoperto la struttura a doppia elica del DNA, altri ricercatori concorsero tra il 1962 e il

1966 a decifrare il cosiddetto codice genetico grazie al quale

una sequenza di nucleotidi di un gene viene tradotta nella

sequenza di amminoacidi di una proteina (Corbellini, 1999).

Probabilmente anche la prossimità temporale tra la scoperta

dell’esistenza di tale codice e l’elaborazione teorica della

nozione di informazione a opera di E. Shannon e W. Weaver

(1949), concorse a suggerire l’accostamento tra l’informazione

biologica e l’informazione della teoria omonima. Più precisamente vennero cercate correlazioni e analogie in ordine alla

misura del contenuto di informazione di sequenze (normali e

mutanti per una o più variazioni) e alla misura dell’entropia

di informazione.

Nell’approccio algoritmico, le sequenze nucleotidiche vengono considerate sequenze di simboli dell’alfabeto a quattro lettere proprio degli acidi nucleici. La formazione di una data

sequenza Ik di lunghezza n avviene allora con probabilità

pk = 4-n, e il contenuto di informazione, espresso in bit, della

sequenza è Ik = 2n. Tutto questo vale indipendentemente

dalla particolare sequenza considerata. Infatti l’informazione

di Shannon considera solo la componente statistica dell’informazione senza riferimento al suo contenuto, dunque al

significato, che è invece estremamente importante per i sistemi viventi dato che è il significato del messaggio a determinare le conseguenze dell’informazione erogata. Approcci

successivi dovuti a A. N. Kolmogorov e a G. J. Chaitin (rispettivamente nel 1968 e nel 1969) considerarono la struttura

interna delle sequenze. Nella teoria algoritmica dell’informazione il contenuto informativo di un messaggio è pari alla

lunghezza del più piccolo programma di computer che, una

volta eseguito, è in grado di produrre l’oggetto. Ne deriva

C omplessità

C

che messaggi periodici o

molto ridondanti possiedono

basso rapporto di informazione algoritmica/complessità, mentre sequenze casuali hanno un alto rapporto di

i n f o r m a z i o n e

algoritmica/complessità, non

potendo essere create attraverso un programma che sia

più breve delle sequenze

stesse. Tuttavia, come ogni

biologo sa, il fatto che una

sequenza casuale sia dotata

di alta complessità (nel

senso algoritmico-informatico sopra specificato) contraddice la realtà biologica

nella quale i sistemi viventi

giudicati altamente complessi non hanno strutture e

comportamenti governati dal

caso ma possiedono invece

un elevato livello di organizzazione interna. Neanche la

nozione di complessità algoritmica, essendo interessata

alla struttura interna del

messaggio consente di

affrontare il problema cruciale della significatività dell’informazione. Quanto sia

importante questo punto è immediatamente chiaro considerando per esempio che i geni strutturali dell’uomo e dello

scimpanzé sono identici al novantanove per cento (come

dimostrarono King e Wilson nel 1975, le differenze amminoacidiche del loro corredo preoteico non superano l’uno

per cento) e che basta solo una frazione piccola, ma altamente significativa, di geni diversi per determinare differenze biologiche di grande rilievo. La distanza genetica media

tra le due specie, stimata su circa cinquanta geni strutturali,

è risultata essere addirittura inferiore a quella tra specie

sorelle (sibling species) del moscerino di Drosophila, che

sono per definizione morfologicamente indistinguibili. È

peraltro noto che tali piccole differenze di sequenza, capaci

però di generare differenze organizzative tra le due specie,

vanno quasi certamente ricondotte a cambiamenti prodotti

da pochi geni regolatori.

Il passaggio critico nella gerarchia della complessità corrisponde ovviamente all’incremento di complessità dei sistemi

viventi, particolarmente intenso durante le transizioni evolutive più importanti: per esempio il passaggio da cellula pro-

Frontespizio della prima edizione in

opuscolo de L’uomo e le scimmie, 1864.

79

Kéiron

S

Complessità qualitativa

L’evoluzione dell’uomo secondo un’incisione del periodico satirico inglese

“Punch” (6 dicembre 1881).

80

Kéiron

C

I

E

N

Z

A

cariotica a cellula eucariotica, quello da sistema unicellulare

a sistema pluricellulare oppure quello da individuo a colonia

(Maynard Smith e Szathmary, 1995). Ancora manca una teoria generale dell’incremento di complessità, ma questo fenomeno ha iniziato ad avere una sua spiegazione quando l’analisi è stata circoscritta a sistemi molto semplici come i virus.

Alla fine degli anni Settanta, Manfred Eigen e Peter Schuster

hanno proposto un modello teorico, detto dell’iperciclo, di

notevole interesse euristico, in cui sono specificate le condizioni minime che permettono di conservare e di accumulare

informazione biologica: un passo indispensabile per l’aumento di complessità di un sistema (Eigen e Schuster, 1979).

Sistemi complessi se ne trovano già nel mondo non vivente.

Sono tali i ben noti sistemi a molte componenti interagenti e

caratterizzati da dinamiche dissipative: le turbolenze nei fluidi

di una turbina o di una camera di scoppio di un motore a

combustione, le nuvole, i profili delle coste, gli alberi, danno

C omplessità

C

luogo a strutture complesse accomunate dalla nascita di una

spontanea autosomiglianza interna e da invarianza di scala

(Mandelbrot, 1983). Si tratta di strutture dotate della cosiddetta “auto-organizzazione”, una proprietà che rappresenta tra

l’altro un ottimo esempio di proprietà emergente di un sistema.

I fenomeni di auto-organizzazione sono diffusamente presenti anche nei sistemi biologici, basti pensare alla complessità organizzativa delle reti metaboliche intracellulari. Secondo alcuni, anzi essi potrebbero spiegare molti comportamenti dei sistemi viventi intrattabili con i tradizionali utensili

esplicativi della biologia evoluzionistica. Stuart Kauffmann,

ad esempio, ha ipotizzato che l’ordine biologico si sviluppi

spontaneamente, che esso sia prodotto dall’interno dei sistemi viventi grazie agli stessi principi di auto-organizzazione

(leggi della complessità), agenti nei sistemi fisici (Kauffmann,

1995). All’origine delle configurazioni ordinate dei sistemi

complessi vi sarebbero sistemi in equilibrio dotati di bassa

energia e strutture dissipative. Ora noi osserviamo che mentre l’idea che l’auto-organizzazione possa concorrere alla

variabilità dei sistemi è un’ipotesi plausibile, è invece già

dimostrato che soltanto l’interazione con l’ambiente esterno

determina selettivamente quali stati del sistema saranno mantenuti e quali no. Per dirla con Antoine Danchin (1998): la

selezione non è sensibile alla struttura ma all’organizzazione;

insomma, l’ambiente non giudica direttamente le strutture ma

le loro organizzazioni attraverso i loro funzionamenti. L’autoorganizzazione potrà spiegare il panorama di forme potenziali, l’insieme delle strutture consentite dalle leggi della complessità, ma non ci sono indicazioni che tali leggi riescano a

spiegare né tantomeno a prevedere (come invece Kauffmann

sembra sostenere) le strutture, le forme che effettivamente

sono o saranno prodotte e riprodotte. Anche per il cosiddetto problema dell’ “universalità”. Infatti, se i sistemi fisici

dotati di auto-organizzazione sembrano essere caratterizzati

da una “ridotta universalità”, è chiaro che quelli biologici lo

sono in misura ancora maggiore (Pietronero, 1998).

L’organizzazione, l’individualità e la relazionalità non sono

soltanto tre caratteristiche comuni a tutti i sistemi viventi ma

sono anche tre diverse manifestazioni della complessità biologica (Forestiero, 2000, 2001). Vediamole singolarmente più

da vicino.

Proprietà fondamentale di tutti i viventi è quella di essere

sistemi organizzati (Mayr, 1982). Possedere un’organizzazione significa presentare un certo insieme di relazioni non

casuali che assicurano la coerenza interna del sistema. Queste relazioni sono responsabili dell’unitarietà di ogni sistema

vivente e della sua tenuta. L’organizzazione dei viventi

mostra di avere una natura gerarchica per cui i sistemi dei

vari livelli si presentano come entità fenomeniche caratteriz-

81

Un primo identikit della

complessità biologica

L’organizzazione

Kéiron

S

L’individualità

e le sue conseguenze:

la biodiversità

C

I

E

N

Z

A

zate da configurazioni strutturali e da dinamiche processuali differenti a ciascun livello, e dotate di proprietà né immediatamente deducibili né prevedibili. Oltre che gerarchica,

tale organizzazione è anche chiusa, grazie all’innesco di circolarità in meccanismi altrimenti lineari di causa ed effetto.

La logica circolare (perfettamente esemplificata dal rapporto

causale: gameti-zigote-gameti) percorre tutti i livelli della

gerarchia, dalla cellula all’ecosistema.

L’individualità dei sistemi viventi risulta dal fatto che essi non

sono ripetitivi: l’eterogeneità è la norma (Ageno, 1986). Di

norma ogni vivente possiede una propria individualità (un’unicità originariamente dovuta alle proprietà stocastiche della

sorgente di variazione) che viene codificata nei geni, viene

costruita epigeneticamente e viene trasmessa alla posterità.

L’unicità degli individui è una caratteristica essenziale per l’adattamento della popolazione a un ambiente perennemente

mutevole. L’individualità dei sistemi biologici ha duplice natura: essa è con-causa ed effetto dell’evoluzione. La più appariscente conseguenza dell’individualità è la diversità biologica o

biodiversità. Globalmente, la biodiversità è costituita dall’insieme delle differenze osservabili tra i viventi. Tali differenze

possono essere descritte in termini di quantità, di variazione

e di variabilità degli organismi; nonché, semplificando, in rapporto ai geni, alle specie e agli ecosistemi (Heywood, 1995).

La relazionalità

82

Kéiron

A differenza di quanto accade nei sistemi fisici dove le relazioni tra le parti sono mantenute dall’azione di forze, la coesione tra le componenti della materia vivente è affidata innanzitutto ai segnali. Per esempio è mediante segnali che le cellule di una coltura batterica o le componenti di un sistema

pluricellulare trasferiscono informazione dall’una all’altra,

oppure coordinano i processi interni con quanto accade all’esterno di ciascuna di esse. A livello degli organismi pluricellulari, il sistema costituito dal segnale e dal suo recettore non

solo assicura l’integrazione tra le varie cellule, per esempio

durante i processi di sviluppo (Bonner, 1984), ma negli animali può anche consentire l’integrazione sociale degli individui vuoi attraverso l’azione ormonale, vuoi attraverso quella

dei neurotrasmettitori. In tutti i gruppi di organismi si assiste

a una diversificazione della coppia segnale-recettore (Bonner,

1984, 1988). Tale diversificazione evolutiva produce sia una

complicazione del sistema sia la sua compartimentalizzazione,

con la localizzazione, in alcune regioni del corpo, delle cellule contenenti i differenti recettori. Inoltre, se da una parte l’evoluzione filogenetica della coppia segnale-recettore rende

più efficiente e affidabile l’integrazione tra gli individui (con

ciò aumentando la diversità interna, intrasistemica, dei sistemi

viventi), dall’altra essa serve a mantenere isolati sistemi tra

loro incompatibili e in competizione (favorendo così la diversità esterna, intersistemica). I segnali coinvolti nel comportamento riproduttivo e responsabili della produzione delle barriere interspecifiche di isolamento pre-copula, esemplificano

puntualmente la funzione di

mantenimento e di incremento della diversità intersistemica. Negli animali dotati

di un sistema nervoso e di un

cervello

sufficientemente

complesso, il sistema segnale-recettore è ancora all’opera nel consentire l’apprendimento e dunque, ricorsivamente, nel permettere la

generazione di più sofisticati

meccanismi di produzione di

diversità e di complessità. Se

poi guardiamo a un altro

ambito fenomenologico, è

sempre la capacità relazionale dei sistemi viventi che

viene chiamata in causa nell’

elaborazione epigenetica dell’informazione

genomica,

come pure nei processi di

riconoscimento immunitario,

nella morfogenesi, nell’ontogenesi del comportamento.

Rientra in una più ampia

accezione di relazionalità,

infine, anche la capacità dei

sistemi viventi di mantenersi

in rapporto con l’esterno sia

attraverso

l’adattamento

genetico che quello ecologico.

Progresso?

Il consueto ordinamento di complessità crescente: cellula procariotica, cellula eucariotica, organismo pluricellulare, popolazione, comunità, ecosistema, di solito si accompagna all’idea

che nella storia della vita sul pianeta sia riconoscibile una tendenza storica verso la crescita di complessità dei sistemi viventi. Niente di più inesatto. Si tratta di una convinzione errata

perché se da una parte è indiscutibile che le forme organizzative più semplici hanno preceduto di norma quelle più complesse, tuttavia la coesistenza temporale di forme poco complesse accanto a forme molto complesse testimonia non della

sostituzione di sistemi relativamente semplici con sistemi complessi, ma della coesistenza di sistemi a vario grado di complessità. Inoltre, è anche noto che spesso nell’evoluzione i

sistemi viventi sono andati incontro a processi di drastica semplificazione di alcune subunità, dunque a una riduzione della

loro complessità generale (ad es. anoftalmia degli animali troglobi). Si può invece sostenere con buone argomentazioni che

nel corso dell’evoluzione vi sia stata una sorta di processo di

83

Kéiron

Incisione su rame acquerellata nell’Historie naturelle di George-Louis

Leclerc Conte di Buffon (1785 - 91).

Questa raffigurazione di scimpanzè,

volutamente rappresentato in atteggiamento umanizzato, suscitò scandalo.

S

Riferimenti bibliografici

Ageno, M., Le radici della biologia,

Milano, Feltrinelli, 1986.

C

I

E

N

Z

A

diffusione della complessità biologica, nel senso che sembra

essere aumentata la capacità dei sistemi viventi di adattarsi a

un ambiente che pone richieste tra loro contrastanti (Omodeo,

1987).

Bonner, J. T., The Evolution of Chemical Signal-receptor Systems (from slime

moulds to man), in Oxford Surveys in

Selezione naturale, complessità gerarchica

e complessità biologica come effetto storico

Evolutionary Biology, a cura di R.

Dawkins e M. Ridley, vol.1, 1984, pp. 115.

- The Evolution of Complexity, Princeton, Princeton U.P., 1988.

Corbellini, G., Le grammatiche del

vivente, (II ed.), Roma-Bari, Laterza,

1999.

Dahlberg, J. E. e Tocchini Valentini, G.

P. (a cura di), Frontiere della vita. Vol.

I. All’origine della vita, Roma, Istituto

della Enciclopedia Italiana, 1998.

Danchin, A., La barque de delphes. Ce

que révèle le texte des génomes, Paris,

Odile Jacob, 1998.

Eigen, M. e Schuster, P., The Hypercycle: a Principle of Natural Self-organization, Berlin, Springer-Verlag, 1979.

Eldredge, N. e Salthe, S.N., Hierarchy

and Evolution, in Oxford Surveys in

Evolutionary Biology, cit., pp.184-220.

Forestiero, S., Complessità: complessità

biologica, in Enciclopedia italiana, VI

Appendice, Roma, Istituto della Enciclopedia Italiana, 2000, pp.405-410.

- Identification Clues of the Biological

Complexity, in “Systema naturae”, vol.

84

3, 2001 (in stampa).

Hamilton, W. D., The Genetical Evolu-

Kéiron

tion of Social Behaviour, in “Journal of

Theorethical Biology”, 7, 1964, pp. 152.

Heywood, V. H. e Watson, R. T., Global Biodiversity Assessment, Cambridge, Cambridge U.P., 1995.

Kauffman, S. A., At Home in the Universe, Oxford, Oxford U.P., 1995, trad.

it. A casa nell’universo, Roma, Editori

Riuniti, 2001.

King, J. L. e Wilson, A. C., Evolution at

Two Levels: Molecular Similarities and

Biological

Differences

Between

Humans and Chimpanzees, in “Science”, 188, 1975, pp. 107-116.

In larga misura la storia dei viventi è storia dei passaggi da un

livello di complessità all’altro, cioè da un’unità di selezione

all’altra. Secondo una ricostruzione ampiamente accettata,

l’avvio del processo evolutivo coincise con l’originarsi di

molecole capaci di autoreplica; queste furono poi incorporate in unità cellulari assai ben delimitate, capaci successivamente di integrare al loro interno i genomi di organelli dotati

di autoreplicabilità, e poi diventate capaci di sfruttare con la

sessualità l’enorme vantaggio della ricombinazione genetica.

A questo punto del processo evolutivo, con la comparsa del

sesso e della specie la selezione naturale assunse la forma che

è più familiare ai biologi, quella di riproduzione differenziale

di genotipi.

Negli anni Sessanta, dopo il lavoro di Hamilton (1964), la questione dell’esistenza di multipli livelli di azione della selezione

naturale (livelli sia sopra che sottoindividuali) diventò un argomento molto scottante. La questione in sé è della massima rilevanza e si presenta in modo assai articolato. Qui di seguito

illustriamo i punti salienti della ipotetica logica processuale

con cui si può salire da un livello di complessità a quello successivo.

Il quadro generale che sta dietro all’idea di molteplici unità di

selezione è che al nascere di un nuovo livello organizzativo

della materia vivente si verifichi un cambiamento nel bersaglio e nella forma della selezione. Mentre fino a quel momento la selezione viene esercitata soltanto dall’ambiente esterno,

con la nascita del nuovo livello strutturale (a condizione che

esso però contenga fisicamente il livello strutturale più antico)

l’ambiente esterno agisce solo sull’unità di questo nuovo livello (l’unità neoformata) e la selezione sull’unità gerarchicamente inferiore non è più esercitata dallo stesso ambiente di

prima (quello che precedentemente era esterno) ma dall’unità

neoformata, che pertanto funzionerà come ambiente per l’unità più vecchia e gerarchicamente inferiore. Questa concezione prevede un controllo verticale, dall’alto, dell’unità maggiore sull’ambito delle possibili variazioni dell’unità minore. E

anche se, in effetti, i cambiamenti dell’unità di livello inferiore possono arrivare a influenzare la replica dell’unità del livello immediatamente superiore, tale azione dal basso è consentita nella misura in cui questi cambiamenti non sono svantaggiosi per l’unità maggiore che è quella che interagisce con

l’ambiente esterno. In questa visione, all’incremento di complessità è associato lo slittamento della selezione dal vecchio

al nuovo livello di organizzazione, che quindi perde gradi di

libertà trasformandosi in vincolo interno al sistema.

C omplessità

C

Uno degli aspetti più ricchi di conseguenze teoriche dei sistemi viventi è quello di essere sistemi non universalmente

necessitati nel senso che le loro strutture e i loro comportamenti non sono descrivibili con leggi universali bensì da

enunciati validi caso per caso, o tutto al più validi per una

casistica assai limitata. Da cosa derivi questa caratteristica è

facilmente comprensibile considerando un esempio che illustra un altro peculiare aspetto dei sistemi viventi: l’enorme

discrepanza tra quanto è teoricamente possibile su base combinatoria e quanto invece si è storicamente realizzato.

Preso il caso del polimorfismo genetico, cerchiamo di rappresentarci quello che Lewontin (1974) ha chiamato “lo spazio dei genotipi”. Partendo da seimila geni strutturali (numero medio stimato per Drosophila) e ammettendo verosimilmente che la metà sia polimorfica, avremo tremila geni. Assumendo, quindi, una media di due alleli per locus elettroforetico, avremo tre possibili combinazioni alleliche per ciascun

locus; che per tutti i loci fa un numero totale di combinazioni alleliche pari a 33.000 (63.000 nel caso diploide). Come si

vede, l’insieme potenziale di tutti i genotipi così calcolato, è

costituito da una quantità strabiliante, non solo assolutamente superiore al totale dei genotipi aploidi già prodotti e producibili in futuro, ma addirittura di gran lunga superiore

anche al numero stimato di tutte le particelle elementari del

nucleo atomico presenti nell’universo (circa 1079). La massa

di questi genotipi, se tutti fossero prodotti, supererebbe la

massa dei nucleoni.

In conclusione, il fatto, invece, che di tutte le possibili combinazioni genotipiche solo alcune effettivamente si siano realizzate e solo alcune altre si potranno realizzare in futuro, rappresenta una chiara evidenza della natura relativa e contingente dei sistemi biologici. È questa contingenza a fondare la

natura storica dei viventi: la complessità osservabile deriva da

vincoli strutturali e funzionali pre-esistenti che a loro volta

determinano la dinamica futura dei sistemi. Non tutti i cammini evolutivi sono dunque possibili ma solo quelli compatibili con il regime di vincoli esterni e interni al sistema. I sistemi viventi sono dunque entità storicamente determinate e la

biologia assume anche essa carattere storico ogni volta che si

pone problemi che vanno oltre il comportamento delle molecole.

La natura dei vincoli che determinano le condizioni di possibilità dei sistemi viventi è esplicitabile solo in termini evolutivi. Si tratta dei vincoli adattativi, sincronici, che strutturano il

collegamento con l’ambiente, e dei vincoli di sviluppo che

specificano diacronicamente il modo d’essere di ciascun individuo e di ciascuna specie. La natura di questi vincoli legittima, inoltre, gli interrogativi teleonomici sui perché di certe

manifestazioni dei viventi (Mayr, 1982, 1997). Le domande sui

perché non sembrano riducibili a domande sul come. Piuttosto si hanno spiegazioni di due ordini distinti: una funzionale, finalizzata all’esplicitazione delle cause prossime, dei meccanismi in gioco; l’altra tesa a elaborare una spiegazione che

è storia delle vicende responsabili del fenomeno osservato.

Lepschy, A., Complessità: sistemi complessi, in Enciclopedia italiana, VI

Appendice, cit., pp. 401-405.

Lewontin, R. C., The Genetic Basis of

Evolutionary Change,

New

York,

Columbia U. P., 1974.

Mandelbrot, B., The Fractal Geometry

of Nature, New York, Freeman, 1983.

Maynard Smith, J. e Szathmary, T., The

Major

Transitions

in

Evolution,

Oxford, Oxford U.P., 1995.

Mayr, E., The Growth of Biological

Thou-ght, Diversity, Evolution, and

Inheritan-ce. Cambridge (Mass.), The

Belknap Press of Harvard University

Press, 1982, trad.it., Storia del pensiero

biologico, Torino, Bollati-Boringhieri,

1990.

- This is Biology, Cambridge (Mass.),

Harvard U.P., 1997, trad. it. Il modello

biologico, Milano, McGraw-Hill, 1998.

McShea, D. W., Complexity and Evolution: What Everybody Knows, in “Biology and Philosophy”, 6, 1991, pp. 303324.

Omodeo, P., Progressive Evolution and

Increase of Genetic Information, in

Proceedings of the International Symposium on Biological Evolution (Bari,

9-14 April, 1985), a cura di V. Pesce

Delfino, Bari, Adriatica Editrice, 1987,

pp. 23-38.

Pietronero, L., Il semplice e il complesso dalla fisica alla biologia, in Frontiere della vita.Vol. I. All’origine della

85

vita, cit., pp. 71-87.

Wagensberg, J., Complexity versus

Uncertainty : the Question of Staying

Alive, in “Biology and Philosophy”, 15,

2000, pp. 493-508.

Kéiron

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 703

L’ecologia: aspetti scientifici e

problemi di conservazione

di Saverio Forestiero

L’idea che percorre tutta la storia dell’ecologia è la necessaria interdipendenza

dei viventi: nella biosfera tutto si tiene in equilibrio. L’ecologia studia strutture e

processi sincronicamente e diacronicamente, a varie scale spaziali e temporali; si

concentra sulle relazioni intra e interspecifiche, ne indaga la natura economica,

conflittuale o cooperativa, ne misura l’intensità; ricorre descrittivamente al

concetto di ecosistema. Il vocabolario dell’ecologia è spesso antropocentrico; la

conoscenza degli ecosistemi e degli ambienti di vita delle altre specie è

severamente condizionata dai limiti percettivi degli ecologi. L’ecologia del

secondo Novecento ha dovuto concentrarsi su problemi applicativi di enorme

complessità: boom demografico, inquinamento, crisi climatiche e della

disponibilità d’acqua, erosione della biodiversità di specie di interesse

agronomico o ittico, alterazione degli ecosistemi, insorgenza di nuove patologie

mediche e veterinarie, estinzione. Oggi molti dei problemi affrontati

dall’ecologia scientifica intercettano questioni economiche e politiche.

Identità dell’ecologia

Poche scienze sono allo stesso tempo tanto popolari e così mal conosciute e fraintese come l’ecologia. Anche se in modo ovviamente

assai meno vistoso di quanto non accada presso il pubblico, pure tra

gli addetti ai lavori si possono trovare punti di vista diversi e spesso

discordanti sull’identità e la natura dell’ecologia. Gli storici della

scienza si dividono sulla sua origine e la sua storia, gli ecologi ne

tratteggiano differenti profili a seconda della loro formazione accademica e del loro specifico oggetto di studio: piante, animali, cenosi (specie viventi) terrestri, lacustri, fluviali, marine, benthos, plancton, foreste, paesaggio ecc., arrivando a differenti conclusioni anche

a seconda della scala di osservazione e misura a cui si svolgono le loro ricerche. Potrà stupire ma non tutti gli ecologi concordano sulle

proprietà di base delle biocenosi e degli ecosistemi. La natura composita descrittiva e meccanicistica, quantitativa e olistica dell’ecologia si è manifestata sin dalle origini ottocentesche della disciplina attraverso i contributi della geobotanica, della fisiologia vegetale, interessata al rapporto tra piante, clima e suolo, dello studio della dinamica della vegetazione nel tempo. Tale natura polimorfica dell’ecologia in parte è frutto della sua storia e delle diverse tradizioni di

ricerca, in parte deriva dall’oggetto stesso della disciplina: le relazioni tra organismi e ambiente. Più che in altre discipline biologiche

è importante in ecologia il posizionamento teorico del ricercatore, il

suo punto di vista, la sua epistemologia. Diversamente dalla genetica o dalla biologia molecolare in ecologia non si fanno delle improvvise scoperte: è una scienza giovane e il suo oggetto di studio è

estremamente complesso, spazialmente eterogeneo e temporalmente variabile, sensibile agli effetti di scala. Gli avanzamenti sono rappresentati piuttosto da progressi nell’accuratezza delle misure, nella ricostruzione dei meccanismi, nell’attendibilità delle rappresentazioni dei fenomeni, dalla scoperta di regolarità piuttosto che di

leggi. La tensione e il contrasto teorico tra descrizioni ai diversi livelli organizzativi dei sistemi ecologici sono al momento alquanto

Veduta panoramica di Shangai

Negli ultimi anni, lo sviluppo

industriale in Cina e India,

accompagnato da un eccessivo

incremento nel consumo dei

combustibili, rischia di rendere

vani gli sforzi a tutela

dell’ambiente portati avanti

dagli altri Paesi.

forti: gli aspetti microscopici e quelli macroscopici restano abbastanza separati. La teoria dei flussi energetici nell’ecosistema non è

connessa con l’ecologia di popolazione né l’ecologia di comunità

sembra facilmente riducibile a quella di popolazione, la quale a sua

volta si interfaccia malamente con la genetica di popolazione; l’ecologia del paesaggio si connette a fatica con l’ecologia popolazionistica e ancora meno con l’ecologia fisiologica e con quella comportamentale dal momento che manca in sostanza una teoria integrata

e generale dell’ecologia: quello che vale per gli ecosistemi non è trasferibile ai livelli organizzativi più bassi.

Decisiva nella ricerca ecologica è l’attività di identificazione e rilevamento dei parametri ambientali, importantissime sono la descrizione demografica delle popolazioni, problematica è quasi sempre

la delimitazione spaziale delle cenosi e degli ecosistemi, l’analisi del

funzionamento dei medesimi, la descrizione dei grandi cicli biogeochimici della biosfera. L’indagine sul campo è molto sviluppata (forse più di quella sperimentale di laboratorio) e richiede molto dispendio di tempo e il contributo di molti specialisti che operano in

condizioni concrete spesso logisticamente difficili, quando non ostili, e mai pienamente controllabili. Si conosce l’autoecologia di pochissime specie, altrettanto poco si sa della loro sinecologia; ancora

meno della variabilità adattativa delle diverse popolazioni di una

703

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 704

Scienza e tecnologia “Conosci te stesso”: l’organismo e l’ambiente, la salute e la malattia

Un esempio di degrado ambientale,

Sardegna

stessa specie. Tenendo conto che le specie note alla scienza si aggirano come minimo attorno ai 2 milioni, si deduce che lo spazio tassonomico e quello ambientale indagato dall’ecologia sono estremamente lacunosi. Ambienti come quelli delle profondità oceaniche,

delle alte quote, dei grandi fiumi tropicali, della volta forestale, delle grotte, sono di difficile accesso e si conosce pochissimo dei loro

habitat e delle specie che li popolano. L’analisi statistica dei dati

ecologici può essere molto sofisticata e così pure sono i modelli di

simulazione di fenomeni intrattabili sperimentalmente e i modelli

matematici, deterministici o probabilistici, a carattere predittivo. Il

sostegno dell’informatica è indispensabile; lo stesso vale per l’uso di

strumenti e tecnologie che vanno dai semplici termometri ai satelliti da telerilevamento ai correntometri ai batiscafi, ecc. La fase descrittiva dell’ecologia è lontana dall’essere compiuta.

Parole, concetti, teorie

Ottocento, Storia:

Le trasformazioni

dell’ambiente fisico

Sebbene il termine sia stato coniato in tedesco (Ökologie) dal biologo Ernst Haeckel (1834-1919) nel 1866, molto prima che l’ecologia si rendesse autonoma dalla botanica e dalla zoologia, la maggior

parte dei teorici ha parlato e parla angloamericano. Attraverso molti autori, da Haeckel che cita la darwiniana economia della natura,

agli ecologi sperimentali di popolazione come Thomas Park (19081968), al limnologo e teorico George E. Hutchinson (1903-1991),

l’influenza di Darwin – soprattutto relativamente al concetto di selezione naturale – sul pensiero ecologico è assolutamente pervasiva

a livello organismico, popolazionale e biocenotico, meno sentita, invece, a livello ecosistemico. Mancando, quindi, una specifica teoria

generale dell’ecologia, l’unica teoria generale disponibile rimane

quella della selezione naturale, anche se poi questo non implica alcuna integrazione automatica delle conoscenze ecologiche con

quelle genetiche.

Tipicamente, l’ecologia studia i rapporti tra gli organismi e il loro

ambiente; sotto alcuni aspetti essa è l’erede moderna della più antica storia naturale degli organismi; moderna perché affianca allo studio qualitativo degli ottocenteschi “costumi” di animali e piante la

descrizione quantitativa e l’analisi causale dei fenomeni studiati.

Una sua caratteristica, rivelata dalla radice comune ai due termini

economia-ecologia, è l’interesse per la dimensione economica della

natura: attenzione manifestata attraverso l’elaborazione di stime

quantitative dell’efficienza ecologica. Stimare il rapporto tra le

quantità di materia vivente prodotta e i costi di produzione è una

sfida per gli ecologi. Quando, per esempio, dopo molti decenni di

lavoro si riesce a dimostrare che gli ecosistemi più efficienti ai tro-

704

La biocenosi

La biocenosi è un insieme di popolazioni vegetali

e animali che vivono in una medesima area. Si tratta

insomma della parte vivente di un ecosistema. Le specie che costituiscono la biocenosi sono legate le une

alle altre da complesse relazioni trofiche, cioè alimentari: di solito infatti in una biocenosi si trovano organismi produttori di sostanze organiche, organismi

consumatori e organismi decompositori. I primi sono

i vegetali che grazie alla clorofilla sintetizzano glucidi ricchi di energia e altre sostanze. I consumatori di

primo ordine sono gli animali erbivori, i consumatori

di ordine superiore sono i carnivori e i parassiti. Decompositori sono i microrganismi che, nutrendosi degli organismi morti, scindono le sostanze organiche liberando sostanze inorganiche. Attraverso questo ciclo

i singoli elementi e composti chimici circolano nel

pici sono le foreste pluviali mentre nei climi temperati sono i laghi

e gli stagni, tutti gli studiosi di ecologia hanno la forte consapevolezza di avere compiuto un progresso importante. Storicamente uno

dei contributi paradigmatici della nascente ecologia è l’idea deterministica e finalistica di Frederich Edward Clements (1874-1945)

secondo cui le cenosi si comportano analogamente a superorganismi, di cui le popolazioni sono loro organi. Per Clements (1916),

botanico del Nebraska, le cenosi, al pari degli organismi, sono dotate di omeostasi e, come quelli, si sviluppano nel tempo maturando attraverso la successione ordinata di stadi culminanti nel climax

(la cenosi terminale della serie in equilibrio con l’habitat). All’opposto, nel 1926, Henri A. Gleason (1882-1975) dell’Università dell’Illinois concepisce probabilisticamente le cenosi come associazioni opportunistiche, casuali e temporanee, di popolazioni di specie;

Gleason è contro l’approccio olistico alle cenosi: sono individui

piuttosto che classi.

Negli stessi anni in Inghilterra Arthur G. Tansley (1871-1955), fondatore del “New Phytologist” (1902), della British Ecological Society (1913) e del “Journal of Ecology” (1917) è favorevole a una

concezione quasi organismica delle cenosi e degli ecosistemi, ed è

convinto che le successioni ecologiche possano essere progressive

quanto regressive, quindi non destinate all’equilibrio. Nel 1925 con

Elements of physical biology, dell’americano Alfred James Lotka

(1880-1949), che tratta di demografia, cicli di nutrienti e flussi di

energia, nasce il primo libro di ecologia teorica. L’anno dopo, Raymond Pearl (1879-1940) fonda la rivista “The Quarterly review of

Biology”, inaugurando il primo numero con un articolo, poi diventato celeberrimo, di rassegna della crescita demografica di popolazioni di lievito, drosofile e uomo. Di solito si fa coincidere con quella data la “riscoperta” dell’equazione logistica del matematico bel-

mondo vivente per poi tornare nel mondo inorganico.

L’organizzazione di una biocenosi, dunque, potrebbe

essere paragonata a quella di un enorme organismo,

in cui tutte le attività metaboliche interagiscono in

modo ordinato.

Al pari di un organismo, poi, una particolare biocenosi acquisisce infatti caratteristiche proprie che

vanno al di là delle caratteristiche dei singoli individui

e delle popolazioni che la compongono, ma dipendono piuttosto dall’interazione fra le diverse specie

presenti. Questo concetto è fondamentale per l’ecologia applicata e fornisce linee guida per la gestione delle popolazioni: secondo questa visione, il controllo di

una certa popolazione, animale o vegetale che sia,

non va attuato agendo solo su quella popolazione ma

sull’intera comunità.

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 705

L’ecologia: aspetti scientifici e problemi di conservazione

Nicchia ecologica

Il termine nicchia (niche in inglese) viene introdotto la prima volta nel 1910 dall’americano Roswell Hill Johnson in un lavoro dedicato alla colorazione delle coccinelle. La seconda volta la parola

viene impiegata nel 1914 da Joseph Grinnell (18771939) in uno studio sui mammiferi e gli uccelli del

basso corso del fiume Colorado. Il termine, che non

ha ancora connotazioni tecniche, presenta il generico riferimento spaziale al luogo dove si può trovare

un animale. Il processo di tecnicizzazione proseguirà in successivi lavori di Grinnell ove è chiaro che

i referenti della nicchia diventano le relazioni di ordine funzionale (quello che la specie fa nella comunità, il suo ruolo) piuttosto che le variabili di tipo

spaziale (dove la si può trovare, il suo posto fisico).

Il riferimento alla componente biocenotica (le relazioni con le altre specie) è esplicita nei lavori di

Charles Elton. Con la teoria della nicchia elaborata

ga Pierre-François Verhulst (1804-1849) risalente al 1838 (ispiratagli a sua volta dal suo maestro Adolphe Quetelet (1796-1874) e l’inaugurazione di un nuovo campo di ricerche. Anni prima, nel 1908,

il fisiologo e biochimico australiano Thorburn Brailsford Robertson

(1884-1930) aveva però già pubblicato articoli in cui venivano riportati i dati di Quetelet e veniva introdotta la curva logistica, che

Robertson chiama autocatalitica; Pearl conosceva questi articoli e li

aveva anche molto criticati.

L’idea universale e astorica della curva logistica è che qualsiasi popolazione – a qualsiasi specie appartenga, non importa se di batteri

protisti funghi vegetali animali – nelle prime fasi della propria crescita aumenta di numero seguendo una legge matematica descrivibile mediante una curva di cui è nota la funzione. Nella logistica c’è

poi l’idea che il massimo numero di individui della popolazione che

può mantenere un equilibrio nell’ambiente non dipende dalle caratteristiche della popolazione, ma solo dal contesto ambientale,

cioè dalla sua capacità di sostenere la popolazione: è la nozione di

capacità portante dell’ambiente. Tutta l’ecologia dei rapporti tra le

specie – dalle equazioni di competizione, a quelle sulla predazione,

al principio di esclusione competitiva di Volterra-Gause – è stata

sviluppata a partire dall’equazione di Pearl-Verhulst.

Nel 1927 in Inghilterra Charles Elton (1900-1991) pubblica Animal

ecology dove, oltre a sostenere l’autoregolazione demografica, si occupa del rapporto tra livelli trofici dell’ecosistema, cioè tra tutti

quegli organismi che nella catena alimentare si nutrono della stessa

tipologia di cibo (piante, erbivori, carnivori, sostanze inorganiche),

e distribuzione delle biomasse, cioè delle masse di organismi prodotte da un ecosistema in un dato periodo, tra i livelli. Altrove vengono affrontate altre differenti questioni ecologiche: nello stesso anno lo svizzero Josias Braun-Blanquet (1884-1980) pubblica Pflanzensoziologie il trattato di riferimento della scuola fitosociologica di

Zurigo-Montpellier. Intanto nel 1926 il fondatore della biogeochimica, il russo Vladimir I. Vernadskij (1863-1945) elabora una concezione globalistica e panecologica del nostro pianeta, conia la parola biosfera, riconosce che tra i processi più importanti della biosfera c’è la produzione di materia vivente, reputa fondamentale –

anche per ragioni applicative – riuscire a stimare l’ammontare delle

risorse organiche del pianeta. Vernadskij conosce i lavori di Lotka e

li cita; Lotka citerà i suoi; entrambi concordano su una visione dell’ecologia che solo anni dopo verrà chiamata sistemica. Al loro punto di vista si rifarà, mezzo secolo dopo, il rumeno Nicholas George-

Ottocento, Scienza e

tecnologia: Charles Darwin,

Il secolo dell’evoluzione

in più riprese da G.E. Hutchinson – un ecologo di

origine britannica ma radicato a Yale e maestro di

una schiera di illustri studiosi tra cui i fratelli Eugene

P. e Howard T. Odum (1924-2002), Raymond Lindeman, Rachel Carson, Robert MacArthur (19301972), Lawrence Slobodkin (1923-) – si precisa finalmente l’idea che la nicchia ecologica, in quanto

“spazio occupato da una specie”, rimanda allo spazio astratto delle rappresentazioni matematiche e

non di certo a una porzione dell’ordinario spazio fisico-empirico dell’habitat. Nel 1957 durante i Concluding Remarks del simposio di biologia quantitativa di Cold Spring Harbor, Hutchinson formalizzerà

la nozione di nicchia servendosi del principio di

esclusione competitiva: “nicchia è l’espressione della risposta di una popolazione in un iperspazio a ndimensioni, descritto dall’insieme di tutte le Xn variabili, fisiche e biologiche”.

scu-Roegen (1906-1994) pioniere dell’economia ecologica, olistica

ed ecocentrica. Da metà degli anni Venti alla fine degli anni Trenta

matura l’ecologia teorica; oltre a Lotka tra i principali contributori

troviamo il matematico italiano Vito Volterra (1860-1940), il matematico Vladimir A. Kostitzin (1882-1950), e il microbiologo Giorgi

F. Gause (1910-1986), entrambi russi, e gli australiani Alexander

John Nicholson (1865-1969) e Victor Albert Bailey (1895-1964).

Il più importante concetto dell’ecologia scientifica è quello di ecosistema; il termine venne coniato dall’ecologo vegetale inglese

Arthur Tansley nel 1935 e sette anni più tardi implementato quantitativamente dal limnologo americano Raymond Lindeman (19151942). È su questo concetto, portato al successo nel 1953 dal più famoso dei trattati di ecologia, Fondamenti di ecologia di Eugene P.

Odum (1913-2002), che si fonda l’autonomia dell’ecologia come

scienza. Tutta l’ecologia è impregnata di pensiero sistemico, molto

essa deve alla teoria dei sistemi di Ludwig von Bertalanffy (19011972), alla cibernetica di Norbert Wiener (1894-1964) degli anni

Cinquanta e Sessanta e, più di recente, alla teoria del caos e della

complessità. I pattern (campioni) e i processi derivanti dall’interazione tra individui, popolazioni, specie e comunità all’interno di paesaggi sono al centro degli studi attuali dell’ecologia. Queste interazioni

Operazioni di smaltimento di rifiuti

radioattivi

705

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 706

Scienza e tecnologia “Conosci te stesso”: l’organismo e l’ambiente, la salute e la malattia

Gli effetti delle piogge acide sugli alberi

di una foresta

Le specie forestali coinvolte

nel problema delle piogge acide

sono numerose e alcune di esse

rivestono una grande

importanza produttiva e

paesaggistica. Tra queste si

trovano l’abete bianco, l’abete

rosso, il pino silvestre, il faggio

e molte specie di conifere

e latifoglie.

Novecento*, Storia:

Ambiente e ambientalismo,

La demografia

706

formano complesse reti (la nozione di rete è centrale in molte scienze

di fine Novecento), oggetto di intensa ricerca nell’ambito della teoria

della complessità, dell’informatica e della meccanica statistica. Oltre

ad avere stabilito rapporti con le scienze dure di tipo fisico-matematico, per il suo approccio sistemico e globalistico, l’ecologia conserva

intatti i legami con le altre scienze naturali e con la biologia e manifesta più di un’apertura verso le scienze umane attraverso l’economia,

l’antropologia, la geografia. Un’esame ravvicinato merita la nozione

di nicchia ecologica.

to Ambientale (VIA) di un intervento antropico è quella di offrire

eventuali alternative per l’ottimizzazione del progetto rispetto agli

inevitabili danni arrecati all’ambiente. Nel 1969 gli Stati Uniti sono

stati il primo Paese a legiferare adottando l’obbligo di una procedura di VIA; in Italia le prime norme sulla VIA risalgono al 1986.

Visto che dipendiamo dagli ecosistemi per l’aria, l’acqua, le materie

prime, il cibo, le medicine e altri beni e servizi, quello che è dannoso per la biodiversità è quasi sempre dannoso per la nostra specie.

Se l’uomo comune difficilmente si rende conto di questa dipendenza, invece essa è chiarissima agli esperti di conservazione. L’ecologia, o meglio la biologia della conservazione combina molte competenze settoriali per fronteggiare la crisi della biodiversità e più in generale quella ambientale. Questo obiettivo viene perseguito sia valutando gli effetti dell’attività antropica su specie, biocenosi ed ecosistemi, sia elaborando procedure capaci di prevenire l’estinzione

delle specie. Dato che la causa principale della crisi ecologica deriva dall’impatto umano, è diventato indispensabile modificare culturalmente i comportamenti delle persone nei confronti della natura. Solo in casi eccezionali è possibile ricorrere a degli strumenti

coercitivi come leggi restrittive delle libertà personali e particolarmente punitive. Nella maggioranza dei casi la società ricorre alla

mobilitazione di conoscenze antropologiche, sociologiche, economiche e geografiche per veicolare la cultura ecologica e programmare azioni di sensibilizzazione e di educazione alla difesa e alla

conservazione delle specie e degli ecosistemi. Come gran parte dell’ecologia applicata, anche la biologia della conservazione si presenta come una disciplina dell’emergenza, visto che è assai ricorrente che qualche Paese del mondo debba decidere su temi critici

di conservazione con pressante urgenza e disponendo di solito di

informazioni largamente insufficienti.

Ecologia e società: uno studio del secondo Novecento

Nel secondo Novecento l’interesse per le modificazioni ambientali,

il rapido degrado, l’esplosione demografica della nostra specie e

quindi per i correlati problemi alimentari e di inquinamento, ha influito pesantemente sugli sviluppi dell’ecologia promuovendo certi

temi con forte impatto sociale, spesso a scapito di altri forse anche

più interessanti sotto il profilo schiettamente scientifico. Nei Paesi

occidentali economicamente più ricchi, gli ecologi sono stati presto

chiamati a consigliare i politici in molte occasioni in cui erano in

ballo questioni ambientali. La nascita dell’ambientalismo postbellico può essere fatta risalire al 1962, quando con la pubblicazione Silent Spring Rachel Carson (1907-1964) denuncia i nefasti effetti ambientali del DDT e di altri pesticidi, criticando anche l’idea di

progresso tecnico-scientifico. Da allora l’interesse del pubblico verso le conoscenze dell’ecologia scientifica si è andato restringendo a

favore del richiamo dell’ecologia applicata orientata a studiare gli

impatti dell’inquinamento e di altri stress sulla struttura e il funzionamento degli ecosistemi.

Naturalmente, si potrebbero fare moltissimi esempi di impatto ambientale, ma una lista delle principali macrocategorie può bastare a

rendere l’idea: inquinamento dell’aria, contaminazione da elementi

tossici, acidificazione, inquinamento da petrolio, eutrofizzazione

delle acque, presenza di pesticidi, deforestazione, perdita di biodiversità, effetti ecologici delle guerre. L’azione antropica ha una tale

influenza sull’ambiente che oramai esistono protocolli standard di

riferimento e un apposito settore dell’ecologia applicata specializzato nella previsione degli effetti derivanti da interventi come l’apertura di un’autostrada, l’edificazione di un complesso industriale, la costruzione di una diga foranea, la posa sul fondo marino di

condutture e cavi. La finalità della Valutazione a priori dell’Impat-

La cultura della conservazione

Sono decine di anni che nei Paesi occidentali c’è la consapevolezza

di dover conservare la diversità biologica e gli ecosistemi. Naturalmente questa consapevolezza non è una prerogativa né dell’Occidente né dell’approccio scientifico alla natura in quanto in tutto il

mondo si trovano credenze religiose e filosofiche i cui precetti dettano la protezione della natura. Negli Stati Uniti, in particolare, la

cultura del rispetto della natura e della sua conservazione è molto antica e si può dire che sia nata ben prima che fosse elaborata dall’ecologia scientifica. Pensatori e profeti del pensiero ecologico e dell’azione ecologista come Ralph Waldo Emerson (1803-1882) poeta e filosofo di una visione romantica della natura con finalità moralistiche

e utopistiche, Henry David Thoreau (1817-1862) sostenitore di una

visione arcadica e sensuale ove la natura è animata e governata da

una forza vitale, John Muir (1838-1914) fondatore nel 1892 della prima organizzazione conservazionista, il Sierra Club, e quindi ritenuto

il padre del movimento ecologista, Aldo Leopold (1887-1948) che

per primo elaborò l’idea di risorsa ambientale, applicandola alla selvaggina, e stabilì i fondamenti scientifici della gestione razionale delle fauna selvatica, sono altrettanti precursori del moderno pensiero

conservazionista. Una prospettiva tardo novecentesca (1979) è offerto dall’idea del biofisico James Lovelock (1919) e della biologa

Lynn Margulis (1938), conosciuta come ipotesi Gaia secondo cui la

Terra con tutto l’insieme dei suoi ecosistemi abbia le proprietà di un

superorganismo e che, in quanto tale, sia capace di interagire e di regolare lo stato dell’atmosfera e del clima. Già agli albori della tradizione conservazionista coesistono perciò posizioni di intransigenza

nei riguardi dell’ambiente con posizioni che, con un occhio all’economia, hanno come obiettivo la gestione razionale degli ecosistemi

412-711_Vol1_Scienza.QXD

8-06-2007

16:12

Pagina 707

L’ecologia: aspetti scientifici e problemi di conservazione

naturali. Da queste posizioni gestionali deriva il moderno concetto

di sviluppo sostenibile, risalente al 1987, definito come quella forma

di sviluppo che soddisfa i bisogni primari del presente, senza compromettere la capacità delle generazioni future di soddisfare i propri

bisogni. Questa idea (espressa dal rapporto Brundtland della Commissione mondiale dell’ONU per l’ambiente e lo sviluppo) si basa

sull’assunto che possa esistere un modello economico capace di soddisfare contemporaneamente tre requisiti: i bisogni della popolazione globale in crescita, l’incremento del tenore di vita dei Paesi del

Terzo Mondo, la riduzione delle interazioni tra sistema produttivo e

ambiente in maniera compatibile con i cicli della biosfera. Attualmente l’entusiasmo che aveva accompagnato la nascita del concetto

di sviluppo sostenibile si è molto attenuato e sono in aumento le critiche alla sua inconsistenza teorica, e alla debolezza di alcune premesse come l’inesauribilità delle risorse naturali. Voci critiche si levano contro l’idea stessa che l’ambiente sia una risorsa, qualcosa da

potere sfruttare e non piuttosto un bene da tutelare.

Estinzioni

La ricerca ha dimostrato che l’estinzione non avviene a caso ma colpisce certe specie più di altre. L’identikit delle specie maggiormente minacciate contempla l’appartenenza a livelli trofici alti, la bassa

densità di popolazione, un lungo periodo di gestazione nei mammiferi e una piccola area di distribuzione geografica. Purtroppo oggi

le specie di animali che possiedono queste caratteristiche sono numerosissime. La perdita di biodiversità di specie fa danni maggiori

quanto più filogeneticamente isolate sono le specie che si estinguono. Specie, come per esempio il panda gigante, che appartengono a

branche evolutive poco ramificate dell’albero della vita, sono più in

pericolo di altre e la loro estinzione implica la perdita di interi brani di storia evolutiva. La distruzione degli habitat per scopi agricoli

o di sviluppo economico, lo sfruttamento di specie per la pesca e la

caccia, l’introduzione volontaria o involontaria di specie esotiche

rappresentano altrettante cause di modificazioni ambientali nocive

agli equilibri degli ecosistemi. Naturalmente, le condizioni geografiche di alcuni territori espongono le specie che li abitano a un maggiore rischio di estinzione. La teoria dell’equilibrio insulare di Robert MacArthur (1930-1972) ed Edward O. Wilson (1929-) elaborata negli anni Sessanta afferma che su di un’isola il numero di specie rimane pressoché stabile, è in equilibrio, quando il tasso di specie immigranti sull’isola eguaglia il tasso di specie che vi si estinguono. Più piccole sono le isole maggiore è la velocità di estinzione,

più lontane esse sono dal continente (o da isole maggiori) minore è

la velocità di immigrazione. La teoria prevede che le faune di isole

piccole e lontane dal continente siano caratterizzate da un equilibrio alquanto precario. Questo modello è stato confermato in moltissime occasioni, per molte isole e per molti gruppi di organismi.

La teoria sembra purtroppo convalidata anche da dati storici: la colonizzazione umana delle isole del Pacifico ha provocato l’estinzione di circa 2 mila specie di uccelli terrestri. L’induzione antropica

dell’estinzione è continuata nel Novecento. Similmente alle faune e

alle flore delle isole geografiche, anche le specie relegate in ambienti ecologicamente isolati, come le parti più elevate delle montagne o

i laghi, sono più a rischio di estinzione. Ci sono poi dei gruppi come gli anfibi che per specialissime caratteristiche biologiche sono

molto sensibili all’inquinamento e per questo corrono rischi più e

prima degli altri. Delle 5.743 specie di anfibi, 1856 (32 percento) sono già minacciate e altre 1.300 stanno per esserlo (per confronto: di

tutte le specie di uccelli ne sono a rischio il 12 percento, dei mammiferi il 23 percento). Dato che la pelle di rane, rospi e salamandre

è altamente permeabile essa è molto sensibile ai cambiamenti dei

parametri ecologici dell’habitat incluse le modificazioni nella qualità dell’acqua e dell’aria. Questi animali sono stati perciò scelti come indicatori privilegiati dello stato dell’ambiente. L’IUCN, che ha

promosso insieme ad altre agenzie e società il monitoraggio della

fauna mondiale di anfibi, ha accertato che nelle Americhe e in Australia la scomparsa degli anfibi è dovuta a infezioni fungine contratte a seguito dell’inaridimento climatico, mentre in Europa, Asia

e Africa ne sono responsabili la distruzione degli habitat, l’inquinamento e anche la domanda di mercato a scopo alimentare. L’allarme è a scala mondiale anche se, ovviamente, alcune aree sono più

toccate di altre; come era prevedibile gli anfibi delle isole tropicali

sono i più minacciati, addirittura il 92 percento della fauna di Haiti è in pericolo di estinzione. La drammatica situazione degli anfibi

suona come un campanello di allarme segnalando che la situazione

ambientale è critica a livello mondiale.

Novecento*, Scienza

e tecnologia: Chimica e

ambiente, La cibernetica

e le scienze dell’artificiale,

La biodiversità,

L’evoluzione

dell’evoluzionismo

Teorie del caos e della complessità

All’inizio degli anni Sessanta, il meteorologo Edward

Norton Lorenz asserì che, per sbagliare completamente nel prevedere che tempo farà a Boston, è sufficiente

trascurare il battito d’ali di una farfalla a migliaia di

chilometri di distanza. Insomma il caos (spesso chiamato “caos deterministico”) e l’impossibilità di azzardare previsioni nel lungo termine non sono caratteristiche tipiche solo dei sistemi più complessi, ma anche

di sistemi composti da pochi corpi (ad esempio, anche

il newtoniano sistema Terra-Sole). Il comportamento

più comune in natura segue infatti dinamiche non li-

Vista aerea di un impianto per il

trattamento dei reflui in Florida

Le acque, purificate con un

filtraggio su sabbia, vengono poi

utilizzate per l’irrigazione.

neari. Si può immaginare cosa questo significhi quando, ad esempio, da sistemi tutto sommato semplici si

passa a considerare oggetti ben più complessi, come il

cervello umano. Oltre che con la complessità dinamica, che mette in gioco la possibilità di prevedere il futuro, è inoltre inevitabile fare i conti con la complessità

cosiddetta strutturale, che comporta l’impossibilità di

descrivere esaurientemente sistemi complessi riducendoli a un’estrapolazione di poche proprietà dei loro

componenti: a ogni livello di complessità, infatti,

emergono nuove proprietà e comportamenti diversi.

707

412-711_Vol1_Scienza.QXD

6-06-2007

L’etologia

12:09

Pagina 693

di Saverio Forestiero

Il comportamento è la proprietà degli organismi animali che collega la loro

fisiologia alla loro ecologia, e rappresenta grazie a precisi movimenti coordinati

la forma con cui si esprime il legame tra il sistema nervoso e l’ambiente.

L’etologia, la scienza che studia il comportamento, investigando sulle sue

componenti innate o apprese, sulla sua ontogenesi individuale e sui vincoli

filogenetici, mette direttamente a tema e senza pregiudizi il dibattito naturacultura. Lo fa su base osservativa e sperimentale sia sul campo sia in laboratorio;

i suoi risultati contribuiscono a una conoscenza più precisa e attendibile della

natura degli animali e dell’uomo.

La nascita dell’etologia

L’etologia moderna nasce nel Novecento, ma il termine etologia, al

pari di ecologia, è tuttavia più antico della disciplina stessa e viene

impiegato la prima volta in ambiente francese da Étienne Geoffroy

Saint-Hilaire (1772-1844) e da suo figlio Isidore (1805-1861) che

per primo lo intende modernamente come studio naturalistico delle abitudini e degli istinti. Nel 1902 la parola compare in inglese in

un saggio dello studioso americano di formiche William Morton

Wheleer (1865-1937).

Guardando alla storia degli studi sul comportamento si possono

schematicamente rintracciare tre grandi filoni di ricerca, diversi per

la visione d’insieme, per le domande formulate, per le specie animali utilizzate, le tecniche e i metodi impiegati. Due di essi, la psicologia comparata e l’analisi neurofisiologica, derivano da una stessa radice filosofica: il meccanicismo riduzionista cartesiano. La terza, cioè l’etologia naturalistica, è un’applicazione del metodo comparativo allo studio naturalistico del comportamento, interpretato

in termini evoluzionistici. Va subito detto però che questi tre approcci non sono in effetti mai del tutto completamente separati; la

psicologia comparata dell’Ottocento per esempio è spesso sensibile

alla teoria darwiniana e nella moderna etologia si fa ricerca sui meccanismi nervosi che stanno alla base dei comportamenti stereotipati. Molti studiosi dell’Ottocento, dalle provenienze più diverse, si

interessano in termini puramente speculativi o attraverso l’osservazione e la sperimentazione della psicologia e del comportamento

umani, e molti di loro anche di quelli animali. Le riflessioni di filosofi come John Stuart Mill (1806-1873), Herbert Spencer (18201903), e le osservazioni e le conclusioni di psicologi come Alexandre Bain (1818-1903), di biologi come Charles Darwin (1809-1882),

Thomas Huxley (1825-1895), George Romanes (1848-1894) condividono l’idea sostanziale di continuità evolutiva tra l’uomo e gli altri animali. Grande sostenitore dell’etologia è il naturalista francese

Alfred Giard (1846-1908), evoluzionista lamarckiano, anche se non

mancano in Francia e nello stesso periodo antievoluzionisti come

Jean-Henri Fabre (1823-1915) che pure è un grande precursore dell’etologia di campagna. I suoi metodi di osservazione sono estremamente efficaci sia per la straordinaria acutezza osservativa sia per la

capacità di estrarre l’essenziale da comportamenti complessi (riconosce per primo l’esistenza dei comportamenti stereotipati), anche

se la sua posizione rimane decisamente antievoluzionista. Nell’ultima parte dell’Ottocento e nel primo ventennio del Novecento, in un

eterogeneo intreccio di figure, problemi ed esperienze, si accumu-

Konrad Lorenz

Konrad Lorenz (1903-1989),

zoologo austriaco, premio

Nobel per la medicina nel 1973.

Lorenz è considerato il

fondatore della moderna

etologia scientifica, definita

come ricerca comparata sul

comportamento.

lano nuove conoscenze sul comportamento e maturano le condizioni culturali che negli anni Trenta e Quaranta daranno origine alla

etologia moderna come la si intende comunemente: l’etologia di

Konrad Lorenz (1903-1989) e di Nikolaas Tinbergen (1907-1988).

Tra questi studiosi che contribuiscono a preparare la nascita dell’etologia vanno ricordati Douglas Spalding (1840-1877) geniale autodidatta che indaga sperimentalmente sugli istinti; lo psicologo

Conwy Lloyd Morgan (1852-1936) specialmente attivo nella psicologia comparata; il fisiologo della riproduzione Francis Hugh Adam

Marshall (1878-1949), eccellenti etologi dilettanti conoscitori del

comportamento degli uccelli come Edmund Selous (1858-1934);

zoologi professionisti come Julian Huxley (1887-1975), Charles O.

Whitman (1842-1910), Jacques Loeb (1859-1924) che elabora l’idea dei tropismi; Wallace Craig (1876-1954) analista del comportamento appetitivo, William M. Wheeler che scopre la trofallassi (lo

scambio di cibo liquido) negli insetti sociali; Oskar Heinroth (18711945) che impiega gli schemi comportamentali come caratteri omologici nella ricostruzione delle parentele tra specie di uccelli; Jakob

von Uexküll (1864-1944) che è anche tra i principali fondatori della fisiologia degli invertebrati e infine Karl von Frisch (1886-1982)

grande studioso della comunicazione nell’ape da miele. Nel 1973

von Frisch, Lorenz e Tinbergen ricevono il Nobel per la fisiologia e

la medicina.

Lorenz e Tinbergen

Le ricerche di Lorenz si basano principalmente sull’osservazione diretta di uccelli. L’etologo austriaco infatti vivendo insieme ad ana-

Ottocento, Scienza e

tecnologia: Charles Darwin,

Il secolo dell’evoluzione

693

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 694

Scienza e tecnologia “Conosci te stesso”: l’organismo e l’ambiente, la salute e la malattia

Novecento*, Scienza e

tecnologia: La biochimica,

La psichiatria, La

sociobiologia, L’ecologia:

aspetti scientifici e problemi

di conservazione,

L’evoluzione

dell’evoluzionismo

Un etologo osserva un esemplare di

pappagallo grigio africano (Psittacus

erithacus)

Il pappagallo gioca con un

computer nell’ambito di una

ricerca condotta presso il

Massachusetts Institute of

Technology (MIT), a

Cambridge. Il pappagallo è

stato addestrato a interagire con

le immagini sullo schermo e a

manipolare una leva di

comando installata sul trespolo.

Il tropismo

Il termine tropismo indica il movimento di una

cellula o di un organismo provocato e guidato in una

particolare direzione da uno stimolo esterno. È positivo se il movimento si compie verso lo stimolo, negativo se si compie nel senso opposto. Si tratta di reazioni non necessariamente costanti anche all’interno

di una data specie, ma che possono variare con l’età

dell’individuo e il suo stato fisiologico (per esempio

all’epoca della riproduzione).

Il tropismo può essere provocato da diversi fattori,

tre, oche e taccole, libere di muoversi e di interagire con altri individui – Lorenz compreso – dentro e fuori casa, è facilitato nell’osservazione dello sviluppo, giorno dopo giorno, di moduli comportamentali che si esprimono spontaneamente senza alcun apprendimento. Questa spontaneità è garantita dall’isolamento dei pulcini

rispetto agli adulti della specie. L’oggetto delle prime ricerche di

Lorenz è perciò lo schema motorio innato di cui egli riconosce la natura spontanea; diversamente da quanto sostenuto nella teoria classica del riflesso, secondo la quale uno schema motorio fisso si manifesta come risposta a uno stimolo. Altre sue ricerche riguardano

la natura degli stimoli chiave (ad esempio la colorazione rossa ventrale dei maschi dello spinarello, una specie territoriale, che scatena

nel maschio un comportamento aggressivo), stimoli che inducono

risposte nell’individuo indipendentemente dall’effettivo vantaggio

che offrono nella concreta situazione reale (lo spinarello reagisce

anche contro sagome di varia forma purché con la parte inferioreventrale colorata di rosso). La scoperta per cui Lorenz è diventato

famoso è quella dell’imprinting (Prägung, in tedesco). Altri autori

prima di lui (Spalding sui pulcini del pollo domestico ed Heinroth

sui piccoli dell’oca, per esempio) avevano osservato l’esistenza di

apprendimento nelle primissime fasi di vita degli animali, ma fu Lorenz nel 1935 a caratterizzarne le modalità, a osservarne la genesi in

molte specie di uccelli e a dimostrarne il valore evolutivo. L’imprinting si può realizzare solo durante una finestra temporale limitata e

precoce (dalle prime ore dopo la schiusa ai primissimi giorni di vita), ed è un apprendimento irreversibile. Gli esperimenti hanno dimostrato che negli uccelli questo attaccamento allo stimolo si mani-

che vanno dalla luce alla presenza di un campo elettrico. Molti insetti e pesci, ad esempio, mostrano un

fototropismo positivo, cioè si dirigono verso la sorgente luminosa; i lombrichi, i millepiedi, i centopiedi,

gli scarafaggi hanno invece un fototropismo negativo

e fuggono la luce. I parameci hanno un galvanotropismo negativo e si dirigono verso il catodo, se vengono posti in un campo elettrico. Il reotropismo è il movimento guidato dalla corrente: i pesci che risalgono i

fiumi, dunque, dimostrano un reotropismo negativo.

festa tipicamente come reazione dei piccoli a seguire (imprinting filiale). L’innesco può essere fornito da molti stimoli diversi: zimbelli

di adulti della propria specie e di specie simili, esseri umani, oggetti vistosi, suoni determinati. Lo studio dell’imprinting ne ha messo

in risalto ulteriori caratteristiche: in primo luogo l’apprendimento si

realizza anche laddove non vi sia premio; l’influenza dello stadio generale di sviluppo individuale e delle esperienze postschiusa; gli effetti nell’adulto sulle preferenze sessuali in quanto facilita l’apprendimento di tratti sopraindividuali che sono specie-specifici, il fatto

che l’imprinting può essere relativo al cibo, al canto, all’habitat. Lorenz dimostra sperimentalmente, e i lavori di altri dopo di lui lo confermano, che lo sviluppo ontogenetico di un modulo comportamentale si realizza attraverso un processo la cui efficacia migliora

gradualmente: in certi momenti mediante l’apprendimento, in altri

grazie alla maturazione della componente istintiva. Quest’ultimo fenomeno, in particolare, dimostra in molti casi la problematicità di

una netta opposizione tra natura e cultura: infatti molti comportamenti innati, a forte determinazione genetica, se sono complessi,

hanno bisogno per esprimersi compiutamente del contributo di

informazione proveniente dall’ambiente. Una sequenza comportamentale come la costruzione di un nido, per esempio, consiste nell’integrazione della componente innata con quella acquisita.

Niko Tinbergen è invece un etologo spiccatamente sperimentale,

famoso per la sua grande capacità di progettare eleganti esperimenti in natura. Sebbene sia olandese di nascita e di formazione, lavora

per la maggior parte del tempo in Inghilterra dopo un periodo trascorso in Austria, ad Altenberg, presso Lorenz. Tinbergen affronta

lo studio degli stimoli scatenanti utilizzando l’osservazione dei gabbiani; in seguito si rivolge agli imenotteri, (negli stessi anni in cui

von Frisch lavora al linguaggio della danza delle api). Tinbergen

adotta un approccio evoluzionistico ai segnali e alla loro ritualizzazione; getta poi le basi della cosiddetta ecologia comportamentale

inaugurando gli studi sui meccanismi che guidano il comportamento degli uccelli predatori. I suoi studi dimostrano che esiste un processo di prova ed errore che sfocia in un adattamento ecoetologico

del predatore e che tale adattamento retroattivamente ne modifica

il comportamento esplorativo; essi indicano, inoltre, l’esistenza di

una scelta attiva della preda del tutto indipendente dalla sua semplice abbondanza nell’ambiente.

Psicologi ed etologia

Nel Novecento gli studi neurofisiologici del comportamento sono

caratterizzati in particolare dalla riflessologia fondata e sviluppata

da Vladimir Bechterev (1857-1927) e da Ivan Petrovic Pavlov

(1849-1936) che tende a ridurre il comportamento a un complesso

gioco (catena) di riflessi condizionati e non. E mentre alcuni psicologi animali, come il vitalista olandese Johan A. Bierens de Haan

694

412-711_Vol1_Scienza.QXD

6-06-2007

12:09

Pagina 695

L’etologia

(1883-1958), arrivano a giudicare il comportamento animale non

analizzabile in termini meccanicistici, oppure pensano come William McDougall (1871-1938), che l’animale sia motivato da un insieme di attese largamente inspiegabili se non in termini di tendenze innate e di pulsioni istintuali ce ne sono altri, come l’associazionista Edward Lee Thorndike (1874-1949), inventore del labirinto

sperimentale, che vedono il comportamento come qualcosa di sostanzialmente appreso. Thorndike ritiene che l’apprendimento sia

guidato da due soli principi: la scelta di atti che danno soddisfazione e il miglioramento attraverso ripetizione delle prove (principi rispettivamente noti come legge dell’effetto e legge dell’esercizio).

Per il behaviorismo il modello epistemologico di riferimento è fornito dalle scienze naturali e il comportamento, giudicato dal suo

fondatore John B. Watson (1878-1958) come l’unica entità osservabile teoricamente, viene collegato alla coppia stimolo-risposta. Sul

piano fenomenologico stimolo e risposta corrispondono anche agli

unici enti osservabili e quindi sono al centro dell’analisi sperimentale; quello che eventualmente intercorre tra lo stimolo e la risposta,