Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

Dispensa n° 2

L’analisi statistica dei dati testuali

Questioni di teoria e di metodo

CAPITOLO 1 - Obiettivi, oggetti, concetti e strumenti

1.1 - Cos’è l’analisi automatica dei testi (AAT) in una logica di tipo metrico

Il trattamento automatico dei testi, in una prospettiva di analisi qualitativa e quantitativa dei loro

contenuti, proprietà e caratteristiche, presuppone di non leggere il testo. Servendosi della statistica,

della information retrieval e della linguistica computazionale, le sue molteplici letture automatiche

avvengono nel corso dell’analisi con strumenti centrati maggiormente ora su una ora sull’altra di

queste discipline, sempre fortemente integrate fra loro. Tuttavia le categorie di quantità e qualità

risultano non del tutto appropriate ad inquadrare problemi e caratteristiche di un approccio che

definiamo “metrico”, per sottolineare la sua vocazione a fornire “misurazioni oggettive” dei

fenomeni. Misurazioni nel senso di valutazioni basate su analisi quantitative, oggettive non tanto

per esprimere una intersoggettività condivisa - opposta alla soggettività presente in molte analisi del

contenuto tradizionali - quanto perché mantengono uniformi i criteri di osservazione lungo l’intera

superficie dell’oggetto di studio. Dove quest’ultimo è un corpus o collezione di testi. La sua analisi,

assistita dal computer, permette di essere liberi dalla sua dimensione. Implica rapidità nelle

operazioni. Garantisce omogeneità dei criteri di ricerca di informazioni in ogni sua parte, dall’inizio

alla fine della collezione, senza distorsioni “cronologiche”. Consente cioè di esprimere la validità

della misurazione lungo tutta l’estensione dei materiali testuali analizzati.

La lettura automatica del testo avviene per modelli. Ciascun modello costituisce di per sé una

“metrica”, ovvero una rappresentazione ora di tipo lessicale (paradigmatica del linguaggio

utilizzato), ora di tipo testuale (ovvero sintagmatica del “senso”, inteso come informazione

d’insieme, presente nel corpus).

L’approccio statistico, grazie all’ausilio dell’informatica, permette di analizzare quindi corpus di

dimensione qualsiasi, soprattutto molto ampi, limitati superiormente solo dalle capacità di

archiviazione elettronica e dalle potenze di calcolo. Tutto ciò implica semmai che i testi non siano

troppo piccoli, in quanto sarebbero poco robusti ad un’analisi quantitativa delle frequenze.

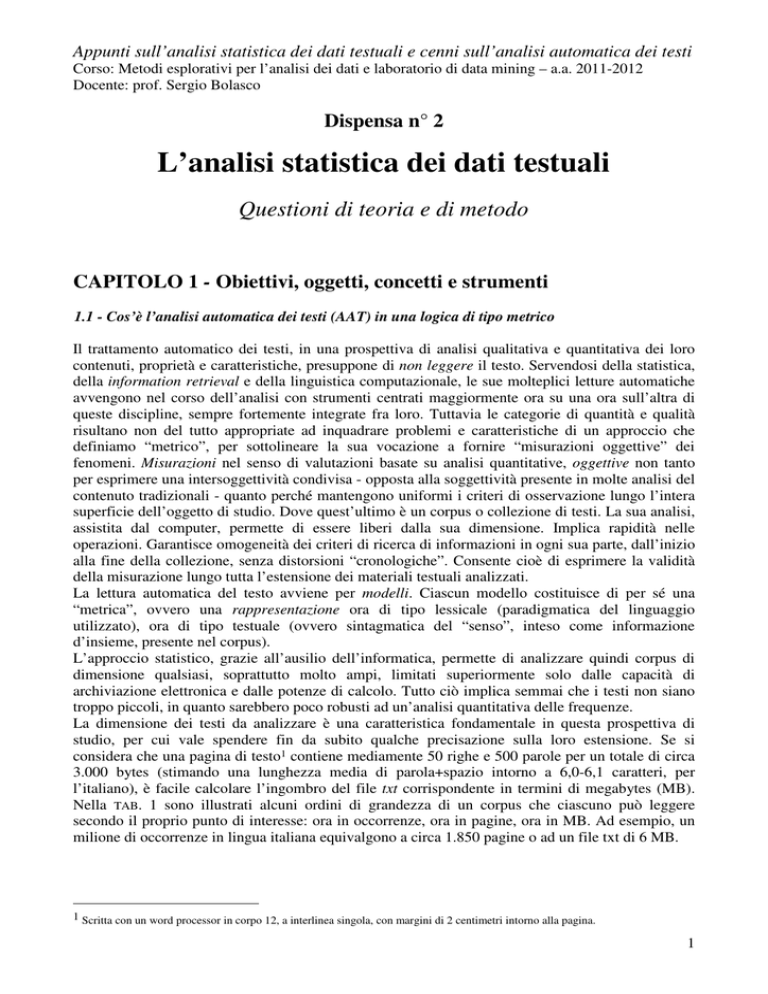

La dimensione dei testi da analizzare è una caratteristica fondamentale in questa prospettiva di

studio, per cui vale spendere fin da subito qualche precisazione sulla loro estensione. Se si

considera che una pagina di testo1 contiene mediamente 50 righe e 500 parole per un totale di circa

3.000 bytes (stimando una lunghezza media di parola+spazio intorno a 6,0-6,1 caratteri, per

l’italiano), è facile calcolare l’ingombro del file txt corrispondente in termini di megabytes (MB).

Nella TAB. 1 sono illustrati alcuni ordini di grandezza di un corpus che ciascuno può leggere

secondo il proprio punto di interesse: ora in occorrenze, ora in pagine, ora in MB. Ad esempio, un

milione di occorrenze in lingua italiana equivalgono a circa 1.850 pagine o ad un file txt di 6 MB.

1 Scritta con un word processor in corpo 12, a interlinea singola, con margini di 2 centimetri intorno alla pagina.

1

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

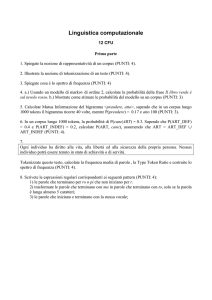

Tabella 1 – Alcuni esempi di ordini di grandezza di un corpus in termini di occorrenze, pagine e megabytes.

Occorrenze

Dimensione (MB) di

un file.txt

Pagine

25.000

50

0,15

167.870

335

1

1.000.000

1.850

6

5.000.000

9.350

30

16.750.000

31.000

100

55.000.000

100.000

322

A parità di risorse impiegate - ad esempio i tempi di calcolo - al crescere delle dimensioni dei testi,

diminuisce la complessità dell’analisi che si intraprende. Ma occorre definire cosa si intende per

“analisi di un testo”, proprio in relazione alle dimensioni considerate. Naturalmente dipende dagli

obiettivi e dagli strumenti disponibili. Ad esempio, la realtà del web (la più ampia fonte di miliardi

di “pagine”, non di solo testo, alla quale si possa concretamente attingere perché già indicizzate)

può essere scandagliata per estrarre qualche informazione in pochi secondi o frazioni di secondo e

questo avviene essenzialmente solo per parole chiave con richieste (queries) più o meno avanzate.

Nell’AAT si conosce quindi il testo grazie a modelli o rappresentazioni. Le analisi per produrre

rappresentazioni del “lessico”, inteso come il vocabolario del corpus, oppure rappresentazioni del

testo, inteso come “discorso” secondo quanto diremo più avanti, vengono realizzate con strumenti

assai diversi. Può trattarsi ora di una query, ora di una concordanza, ora di un test statistico, ora di

un indice d’information retrieval. Oppure anche di un’analisi statistica di una matrice di dati con

tecniche di rappresentazione multidimensionale o di classificazione automatica.

La logica dell’AAT su base statistica, permette non solo di non leggere il testo, ma di darne

rappresentazioni, indipendentemente dalla lingua. Gli elementi di conoscenza della lingua, intesa

come idioma del linguaggio praticato nel corpus, sono un complemento all’analisi, una metainformazione e non una pre-condizione. Nei software di analisi dei dati testuali, il 90% delle

funzionalità sono indipendenti dall’idioma: ciò consente di analizzare anche un corpus multilingue

(come il web), con in verità non pochi problemi, quando ci si basa sulle sole “forme grafiche”,

come si vedrà nel seguito. Le rappresentazioni, ovvero le svariate letture del corpus, dipendono

essenzialmente dai criteri di misurazione sottostanti sia i metodi, sia gli indici quantitativi utilizzati.

I limiti oggettivi di questo approccio sono quelli insiti nei dati testuali, in quanto dati non strutturati

con informazione sparsa, il cui riscatto dall’ambiguità è fortemente legato alla finezza delle risorse

impegnate e all’analisi del contesto, non sempre praticabile fino in fondo. La visione d’insieme

tipica della statistica, il comportamento in media delle parole viste come fenomeno collettivo, si

scontrano talvolta con la coerenza di un caso singolo, irrilevante in quanto tale.

L’analisi automatica di un corpus di dati testuali affrontata secondo una logica “metrica” non si

identifica con l’approccio quantitativo, pur servendosene. Semmai propone un’analisi qualitativa

fortemente integrata con una quantitativa, a garanzia dell’oggettività delle misurazioni. Questa

logica propone un trattamento dei dati che viene messo in discussione attraverso processi di verifica

del risultato delle ricerche sul testo, con correzioni in modalità semi-automatica e con il ricorso a

risorse linguistiche esterne di riferimento.

1.2 - Definizioni e concetti generali

Prima di inoltrarsi nella trattazione, è opportuno introdurre elementi di nomenclatura e concetti di

base della linguistica computazionale propri dell’analisi automatica dei testi, in particolare secondo

2

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

l’approccio tipico della statistica testuale e del text mining. Molti dei contenuti di questo capitolo

sono ripresi, in sintesi, sotto forma di un Glossario (vedi dispensa 1).

Procediamo nell’illustrare la terminologia dall’oggetto più ampio e generale via via verso quelli più

analitici. All’opposto Rastier distingue i livelli di questi oggetti, dal più piccolo al più grande,

microtestuali (morfemi, lessemi e lessie), mesotestuali (dalla frase al paragrafo, dal periodo al

capitolo), macrotestuali (il testo completo) e intertestuali (il corpus).

1.2.1 - Corpus, testo, frammento

In primo luogo per semplicità utilizziamo strumentalmente tre termini: "parlante" per indicare

l’elemento o fonte che ha generato il testo, "discorso" per indicare lo sviluppo delle frasi

componenti un testo, “parola” a indicare convenzionalmente l’unità elementare del testo. Il nostro

oggetto di studio è un insieme di materiali testuali, ossia un discorso espresso dalle parole di uno o

più parlanti, denominato anche un corpus di dati testuali.

Un corpus testuale è una collezione di unità di contesto, o frammenti, che si ritengono fra loro

coerenti e pertinenti per essere studiate sotto un qualche punto di vista o proprietà. Questi

frammenti possono essere anche interi documenti. Salem (1994) afferma che un corpus deve essere

rigorosamente omogeneo, costituito di testi prodotti in condizioni di enunciazione simili e con

caratteristiche lessicometriche confrontabili (struttura delle frasi, ricchezza del vocabolario ecc.).

Inoltre è prudente che, ai fini del confronto, i testi che si racchiudono in una stessa collezione

abbiano delle lunghezze comparabili.

I frammenti, siano essi interi testi, documenti, loro sezioni o semplici frasi, sono generati sia da testi

scritti che dalla trascrizione di discorsi orali. Il loro studio, generalmente, è volto ad un'analisi del

contenuto, ad un’analisi del discorso2, ad un’analisi del linguaggio o all’estrazione d’informazione,

alla ricerca di regolarità linguistiche o di altre entità d’interesse. Una raccolta di articoli di stampa

su un dato tema o di un intero anno è un esempio di corpus. Molte altre esemplificazioni di corpora

si troveranno nel capitolo 2. Quando la collezione che costituisce il corpus è ampia (diverse decine,

centinaia o migliaia di unità di contesto) è possibile associare ad ogni elemento della collezione

informazioni strutturate (variabili codificate: quantitative o qualitative). In tal modo, il corpus è

assimilabile ad un database “sfogliabile” in differenti modi, a seconda degli obiettivi, in funzione di

queste informazioni strutturate. Se lo si immagina come il testo di un libro, strutturato in capitoli,

paragrafi e proposizioni, lo si può sfogliare per capitoli, o all'interno di un capitolo per paragrafi, o

nel suo insieme confrontando tutti i primi paragrafi di ogni capitolo (in pratica secondo le

introduzioni) con gli ultimi (le conclusioni).

Ogni raggruppamento di unità di contesto (TAB. 1.1a) secondo una qualche caratteristica definisce

una parte (detta anche testo) di una possibile partizione del corpus. In un corpus che raccolga

l’opera di un Autore, ciascuno dei suoi scritti rappresenta un testo diverso, a sua volta composto di

molti frammenti (paragrafi o frasi). Se si volessero studiare le prime frasi di ogni testo, nell’esempio

in tab. 1.1a, si studierebbe la parte identificata dalla chiave Q=2. Ogni lettura del corpus secondo

uno di questi criteri genera, dal punto di vista della statistica testuale, un insieme di "profili

lessicali" prodotti dalla corrispondente partizione del corpus.

Il testo è quindi quella parte del corpus alla base di una fra tante possibili sue partizioni (TAB. 7.1a).

Nel corpus dell’intera opera di un Autore, un raggruppamento degli scritti ad esempio secondo il

genere (racconti, saggi, poesie) ne costituisce una partizione e quindi quei generi rappresentano

2 E’ opportuno distinguere analisi del contenuto (Bardin 1977) da analisi del discorso (Ghiglione 1985, 1991, 1998): la prima è

incentrata su cosa è presente in un testo (tratti semantici), la seconda piuttosto sul come (modalità di produzione del discorso,

tipologie discorsive) e su chi (quali sono i protagonisti del discorso).

3

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

altrettante parti o testi del corpus. Nel caso di una survey con domande aperte sono da considerarsi,

come altrettanti testi, i diversi raggruppamenti delle risposte libere degli intervistati secondo

caratteristiche strutturali degli individui (ad esempio secondo il livello d’istruzione o il sesso, in

pratica le risposte dei maschi distinte da quelle delle femmine ecc.). Lo studio si sostanzia così in

un’analisi delle varietà socio-linguistiche di una popolazione. Il “testo” o parte è l’ordine di

grandezza “intermedio” per la lettura della collezione.

TAB. 1.1a

Esempio di corpus composto di 2 testi e 5 frammenti, rispettivamente categorizzati. Separatori, segmentazioni e categorizzazioni nel

corpus.

------------------------------------------------------------------------------------------------------------------------------------

-C/T=1/ <R=3>

/F=1/ <Q=2> Il contenuto di un discorso è sempre espressione di un contesto, cioè dell'universo concettuale di riferimento:

/F=2/ <Q=1> si tratta, di volta in volta, di un campo, area o settore, in sostanza di un genere.

/F=3/ <Q=3> Il linguaggio è diverso a seconda che tratti di politica, di letteratura, d'informazione, di sport.

/T=2/ <R=1>

/F=4/ <Q=2> Con il termine "contesto locale" si indica, invece, un determinato insieme di parole adiacenti ad un termine prefissato, che

funge da polo (pivot).

/F=5/ <Q=3> Lo studio sistematico dei contesti locali (o intorni) di una parola data è detto analisi delle concordanze di quel termine.

-----------------------------------------------------------------------------------------------------------------------------------CORPUS =

-C-. TESTO = /T=#/. FRAMMENTO = /F=#/. CATEGORIE = <Q=#>, <R=#>. SEPARATORI = " ' ( ) , . : [blank].

Dimensioni minime del corpus

In un testo molto corto, ad esempio di sole 100 occorrenze, quasi tutte le parole sono diverse. Via via

che il testo cresce in ampiezza, le parole diverse aumentano dapprima velocemente e poi sempre più

lentamente. Ovvero il tasso di accrescimento di un vocabolario (come insieme delle parole diverse di

un testo) decresce all’aumentare della dimensione del corpus. In un corpus formato da un miliardo di

occorrenze il vocabolario sarebbe così esteso da tendere pressoché a stabilizzarsi, nell’eventualità di

un ulteriore aumento della dimensione del corpus. Questa circostanza dipende, tuttavia, dal tipo di

testi considerati3.

Ai fini di un’analisi statistica è importante conoscere quali debbano essere le dimensioni minime di un

corpus. Un criterio empirico che spesso si è rivelato utile è quello di osservare il rapporto V/N: se

questo supera il 20% il corpus non può considerarsi sufficientemente esteso4.

In generale, un corpus, ai fini di un’analisi su base statistica, è considerato piccolo quando si aggira

sulle 50 pagine convenzionali, corrispondenti a circa 15.000 occorrenze (100KBytes). E’ di

dimensione media intorno alle 150 pagine (45.000 occorrenze equivalenti a circa 300KB), è mediogrande quando raggiunge le 100.000 occorrenze (più di 300 pagine e circa 700KB)5. Quando il

vocabolario di un corpus supera le 500.000 occorrenze (3MegaBytes, equivalenti a oltre 1500 pagine)

la sua estensione raggiunge la dimensione minima di un lessico (vedi più avanti il par. 1.2.4).

Ogni frammento, come unità di contesto, costituisce invece, il livello elementare (individuale) per

“sfogliare” la collezione. A sua volta, esso, come ogni insieme, è composto da unità elementari

3 In uno studio su intere annate di Le Monde, sebbene l’ammontare dei testi superasse i 20 milioni di occorrenze per anno, Silberztein

(1995) scopre che l’intersezione fra due annate non raggiunge il 90% a livello di lemmi, non supera il 56% a livello di forme flesse,

ovvero di parole riconoscibili da un dizionario (quindi già al netto dei refusi di stampa e di altri innumerevoli casi particolari, come

nomi e sigle), mentre è appena il 36% a livello di forme grafiche qualsiasi (a causa delle maiuscole, dei nomi, numeri e sigle). Come

dire, nessuna raccolta per grande e omogenea che sia, assicura la stabilità del linguaggio.

4 4 A meno che il testo non contenga più “idiomi” che si sovrappongono, com’è il caso del linguaggio “globale” delle mailing list in

Internet, infarcite di inglese.

5 Una survey di 800-1000 risposte non vuote ad una domanda aperta produce generalmente un testo compreso fra le diecimila e le

ventimila occorrenze, a seconda dell’ampiezza delle risposte. Occorrono invece almeno 50 interviste libere di oltre mezz’ora di

registrazione per riempire 100 pagine di testo trascritto. In sostanza, un testo che non raggiunga le 10000 occorrenze, possiede delle

frequenze che nei valori bassi sono inattendibili statisticamente (sull’argomento, vedi Sciarone, 1995, p. 57).

4

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

denominate per ora convenzionalmente “parole”6. Il frammento può avere una lunghezza assai

variabile: se si tratta di un intero documento, dipenderà dal genere e tipo di materiali raccolti nella

collezione. Se ogni frammento è un record di informazioni riconducibile ad un diverso parlante,

come la risposta ad una domanda in un campione di intervistati, o come un messaggio (sms o altro)

di un database aziendale, esso sarà di ampiezza assai limitata (testo breve). In entrambe le casistiche

il frammento è pre-definito. Ma un corpus può anche essere costituito da un unico testo, tutto da

frammentare. Allora si pone il problema della sua segmentazione, in unità di contesto (macrosegmentazione del corpus secondo Salem et al. 2006). In tali casi, il frammento può corrispondere

ad una proposizione con valore di enunciato (ossia con un senso compiuto); oppure ad una frase

(ossia con una rilevanza sintattica). Il problema della sua delimitazione non esiste ogni qualvolta la

punteggiatura ne assicura l'unità semantica e sintattica (TAB. 1.1a). Altrimenti, la segmentazione del

testo in frammenti non è facilmente risolvibile a priori. Talvolta la frammentazione può costituire

già il risultato di una prima analisi7.

In alcune situazioni, il frammento è ulteriormente articolato in sezioni, analizzabili separatamente o

meno. Ad esempio, se consideriamo come corpus una rassegna stampa, ogni frammento è un

articolo di giornale, in cui è possibile distinguere le seguenti sezioni: titolo, sottotitolo, occhiello e

testo dell’articolo. Oppure, se il corpus è derivato da una indagine campionaria, ogni frammento

corrisponde al “discorso” di un individuo intervistato: in tal caso, ogni sua risposta libera ad una

delle domande aperte del questionario appartiene ad una diversa sezione. In una survey sui massmedia (Censis 2004), ogni intervistato dà la sua opinione su 8 mezzi di comunicazione o

d’informazione (tv, tv satellitare, radio, giornale, libro, rivista, cellulare, internet): ogni record

individuale è articolato quindi in 8 sezioni di testo, una per risposta.

In alcune fasi del trattamento automatico del corpus, il frammento viene esplorato a tratti per

spezzoni di testo o chunk. Qui si tratta di finestre - di lunghezza pre-definita o anche variabile

dinamicamente - aperte temporaneamente sul testo al fine di ricercare coppie di parole (cooccorrenze) o sequenze di parole (segmenti). Nel primo caso si considera una finestra di ampiezza

predefinita che scorre al variare della parola considerata come pivot; nel secondo si tratta di una

sequenza di parole comprese fra i due estremi del chunk. Questi sono chiamati separatori forti

(punteggiatura): per dettagli su questi aspetti si rimanda il lettore ai capitoli successivi.

1.2.2 - Contesto e situazione

Con il termine “contesto locale” si indica un determinato insieme di parole adiacenti (co-testi) ad un

termine prefissato, che funge da polo (pivot). Lo studio sistematico dei co-testi (o intorni destro e

sinistro) di una parola, come contesti situazionali8, è detto analisi delle concordanze di quel termine

(TAB. 1.1b). Il testo visualizzato è compreso ad esempio tra 5-10 parole prima e 5-10 dopo il

termine prescelto come polo, oppure riproduce l’intero contesto locale (frase elementare, delimitata

da punteggiatura).

TABELLA

1.1b – Analisi delle concordanze del termine <di> nel corpus in TAB. 1.1a ordinate secondo la parola che segue il pivot

F01

F01

F01

Il contenuto di un discorso è sempre espressione di

nuto di un discorso è sempre espressione di un contesto, cioè dell' universo con

ontesto, cioè dell' universo concettuale di riferimento: si tratta, di volta in

6 Più avanti si discuterà cosa s’intende per parola.

7 E’ questo il caso del programma Alceste, cfr. Reinert (1986, 1992). In un trattamento semi-automatico la lunghezza delle unità di

contesto “generalmente è compresa fra 120 e 200 parole, affinché le co-occorrenze abbiano un senso” (Bardin 1991, p. 271).

8 De Mauro, 1998, p. 53.

5

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

F02

F02

F02

F03

F03

F03

F04

F05

F05

di un campo, area o settore, in sostanza

ferimento: si tratta, di volta in volta,

o concettuale di riferimento: si tratta,

inguaggio è diverso a seconda che tratti

iverso a seconda che tratti di politica,

litica, di letteratura, d' informazione,

indica, invece, un determinato insieme

a data è detto analisi delle concordanze

tematico dei contesti locali( o intorni)

di

di

di

di

di

di

di

di

di

un genere. Il linguaggio è diverso a

un campo, area o settore, in sostanz

volta in volta, di un campo, area o

politica, di letteratura, d' informa

letteratura, d' informazione, di spo

sport. Con il termine" contesto loca

parole adiacenti ad un termine prefi

quel termine.

una parola data è detto analisi dell

Più in generale, il contenuto di un discorso è sempre espressione di un contesto, inteso come

l'universo concettuale di riferimento: si tratta, di volta in volta, di un campo, area o settore. Il

linguaggio è assai diverso a seconda che tratti di politica, di letteratura, d’informazione, di sport.

In ogni discorso, è utile poter distinguere il linguaggio utilizzato, secondo alcune sue componenti di

fondo (FIG. 1). In primo luogo, la componente dovuta al lessico della lingua, inteso come l'idioma

della comunità di appartenenza del "parlante" (italiano, inglese, cinese, egiziano ecc.) in un dato

periodo storico. Secondariamente, la parte di linguaggio che caratterizza il contesto, ossia l’ambito

concettuale del discorso, l’aspetto tematico e/o settoriale della terminologia. In terzo luogo è

importante poter individuare quale e quanta parte del discorso è dovuta alla situazione, ossia alla

specifica condizione di enunciazione del discorso (o di stesura del testo), che riflette la modalità

d'interazione fra colui che emette (E) e colui che riceve (R) il messaggio.

Fig. 1 – Componenti del linguaggio

Idioma

Situazione

Contesto

Il tipo di discorso dipende dal rapporto "uno a uno" (dialogo, lettura) o "uno a molti" (manifesto,

assemblea), e ancora, a seconda che vi sia co-presenza o meno fra E e R (dialogo a vista o a

distanza, via telefono o via mass-media), o che abbia carattere pedagogico/polemico. Le situazioni

sono assai diverse a seconda che il rapporto si stabilisca fra due soggetti o fra un soggetto e un

gruppo, oppure a seconda che il carattere del discorso sia formale o informale, e si svolga, ad

esempio, in pubblico o in privato.

Riepilogando, il corpus è una collezione di testi, il testo è una raccolta di frammenti, il frammento

è un insieme di parole definente un “contesto”, delimitato da segni di punteggiatura o pre-definito a

seconda della natura del corpus.

1.2.3 - Occorrenza, parola, segmento

Nel trattamento automatico del testo una occorrenza di “parola” è una sequenza di caratteri (bytes)

di un alfabeto predefinito, compresa fra due separatori. La scansione del testo byte per byte da parte

di un analizzatore (parser) automatico corrisponde ad eseguire il parsing o micro-segmentazione

del corpus in occorrenze. A tale scopo, di volta in volta, occorre definire l’insieme dei separatori

(TAB. 7.1a), ossia i caratteri non appartenenti all’alfabeto. Per complemento all’insieme totale dei

6

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

caratteri, tutti gli altri costituiranno “l’alfabeto”. Sono considerati, ad esempio, separatori caratteri

quali lo spazio bianco (blank), il fine paragrafo (ossia il CRLF, definito dal segno ¶), il fine riga

(LF, ¬), il tabulatore (→|), la punteggiatura (, . : ; ? ! ¡ ¿), le parentesi ( { } ( ) [ ] ). Possono esserlo

le virgolette (“ ” ″ ‘ ’ ‛ « » ‹ › < >), i “tratti” (- _ / \ | ) e ogni carattere speciale (#, @, §, &, £, $, € *

× ¼ ½ ecc.) presente nel testo. Più problematica la decisione sugli apici (` ΄) che possono essere

accenti o virgolette (per questo si veda il paragrafo sulla normalizzazione). Ma potrebbero

considerarsi tali, ad hoc, i numeri o quant’altro. La scelta del ruolo che i singoli bytes devono

assumere non è affatto scontato. Verrebbe spontaneo pensare ad esempio in un testo italiano di

definire l’alfabeto con l’insieme delle 21 lettere minuscole (a...z), più le 21 omologhe maiuscole

(A...Z), più le accentate (àéèìòù) e le cifre (0...9). Ma, riflettendo, in un testo italiano esistono molti

esotismi, stranierismi o prestiti linguistici9, per cui lettere come k j x y w ç possono facilmente

incontrarsi, per non dire di caratteri con altri accenti, dierisi o tilde se capitano parole in inglese,

francese, tedesco, spagnolo e di caratteri quali @ € % $ £ tutt’altro che speciali in testi economici o

con riferimenti al web. Per questo è prudente pensare all’alfabeto come il complemento all’insieme

dei separatori e non viceversa.

Dunque ogni “parola” che appare o ricorre in un corpus si definisce una occorrenza. Si chiama

anche un token, come segno o entità che può replicarsi nel testo. Il parsing è dunque quel processo

di “tokenizzazione” che consiste nell’assegnare ad ogni “parola” del testo un doppio codice

numerico: un ID_type per ogni sequenza diversa di caratteri alfabetici ossia per ogni tipo di parola

diversa (type) e un ID_token per ogni occorrenza incontrata, in grado di risalire al suo indirizzo

ossia al suo posto nello sviluppo del discorso (posizione del token nel frammento). Il parsing

produce anche il cosiddetto indice del corpus, come insieme di indirizzi di riconoscimento delle

occorrenze lette. Se una stessa sequenza di caratteri ricorre più volte nel testo, essa si troverà

associato sempre lo stesso codice. Indicizzare un corpus è appunto ricostruire l’insieme di questi

codici: il codice numerico identificativo della parola e l’insieme dei suoi indirizzi, ossia delle sue

localizzazioni. Il numero totale delle occorrenze (tokens) determina la dimensione o lunghezza del

corpus (N), come estensione del testo.

Un esempio di tokenizzazione del seguente testo “type per ogni parola diversa, token per ogni

occorrenza diversa“ è proposto nella seguente tabella:

testo

ID_type:

ID_token:

type per ogni parola diversa , token per ogni occorrenza diversa

1

1

2

2

3

3

4

4

5

5

6

6

7

2

8

3

9

7

10

5

11

per cui il type “diversa” è la parola 5, che appare in due token allocati agli indirizzi delle

occorrenze 5 e 11. Si noti che il separatore è anch’esso una occorrenza con il suo ID_token ma il

suo ID_type, talvolta, è annullato se considerato equivalente ad un blank.

In un’analisi automatica del testo, dunque le parole sono le unità di testo, tokenizzate (individuate

come singole occorrenze) in maniera automatica da un software per il trattamento del linguaggio

naturale, una volta definito l’insieme dei caratteri definenti l’alfabeto. Questo primo livello di

“scansione” può migliorare in modo significativo con l’ausilio di meta-informazioni, passando da

una tokenizzazione per forme grafiche (sequenze di caratteri) ad un parsing per forme miste

(semplici e complesse) dette lessie. In questa prospettiva di analisi è opportuno fornire altri concetti

e relativi termini.

9 Dal Gradit (De Mauro, 1999), esotismo (sinonimo di stranierismo): elemento linguistico proveniente da una lingua straniera,

entrato nell’uso comune; prestito: fenomeno per cui una lingua trae da un'altra lingua un elemento, di solito un vocabolo, più o meno

adattandolo al suo sistema fonologico e morfologico.

7

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

Si definisce segmento una sequenza di parole adiacenti nel testo. Fra questi, di particolare interesse,

sono i poliformi, ossia quei segmenti di senso compiuto, come ad esempio: buona volontà,

presidente del consiglio, vigili urbani, in un battibaleno, andare al creatore.

Si definisce invece quasi-segmento una sequenza di parole non necessariamente adiacenti (Becue

1993). Se si ricerca la locuzione “in modo”, occorre tener conto che nei testi essa può trovarsi anche

come “in particolar modo”, “in tal/quel/questo modo”, “in un dato modo”, “in un certo qual modo”

ecc. Sono tutti esempi di quasi-segmenti della struttura “in modo”10.

1.2.4 - Vocabolario, dizionario, lessico e rango

I termini vocabolario, dizionario e lessico possono essere utilizzati in molti ambiti come sinonimi.

In questo ambito, i tre termini vengono utilizzati per individuare oggetti assai diversi, a cui è bene

attenersi per non confondersi.

Ai nostri fini, il vocabolario è una rappresentazione concreta del discorso di un parlante. E’ un fatto

attualizzato e “individuale”, è un’espressione della “parole” nel significato saussuriano del termine

francese11.

L'insieme delle parole diverse (types) (ovvero distinte fra loro: <casa> è diversa da <case> o da

<cane>) individua il vocabolario del corpus. In questa lista, a ciascuna parola è associato il

rispettivo numero di occorrenze. Il numero di parole diverse in un testo definisce l'ampiezza del

vocabolario (V). Ad esempio, in un corpus composto di 7.940 occorrenze di parole, sono stati

rilevati 1.610 types diversi, e, fra questi, ad esempio il termine "deve" appare 28 volte (i-esima

classe di occorrenze). Quindi N=7.940, V=1.610, i=28. Nel corpus vi potranno essere anche altre

parole che occorrono un numero di volte pari a 28, che appartengono cioè alla stessa classe di

occorrenze (vedi TAB. 1.3).

Più in generale si indichi con Vi il numero di parole diverse che appaiono (o ricorrono) "i" volte in

un vocabolario. V1 rappresenta quindi l'insieme delle parole che appaiono una sola volta, ossia

l'insieme degli hapax di un testo, V2 quelle che ricorrono due volte ecc. Vale la relazione seguente:

V1 +V2 +V3 + ... + Vfmax = V

dove "fmax" esprime il valore delle occorrenze della parola con il maggior numero di occorrenze del

vocabolario. Si vedrà più avanti che la classe "fmax", come altre, è formata da una sola parola

(Vfmax=1).

Il vocabolario di un corpus può essere espresso in forme grafiche (ossia parole tal quali sono scritte

nel testo) o in lemmi (ossia riconducendo le parole del testo al corrispondente vocabolo presente in

un dizionario della lingua). In quest'ultimo caso, l’ampiezza del vocabolario cambierà

conseguentemente.

Al contrario il lessico, in quanto insieme virtuale e astratto di segni linguistici, costituisce quello

stock mentale di radici lessicali - esistente nella memoria collettiva di una comunità o in quella di

un individuo - da cui possono essere estratte tutte le parole di ogni potenziale discorso12. Si può dire

10 Una maniera per individuare detta struttura può essere l’uso di un’espressione regolare del tipo “in LAG5 modo”, che permette di

cercare nel testo la sequenza <in ... modo> con un intervallo massimo di 5 parole tra la prima e la seconda.

11 Cfr. Saussure (1962).

12 Se un individuo conosce il significato della radice “lavor-“ può generare sia il sostantivo <lavoro>, sia il verbo <lavorare>, ma

anche forme come <lavorante> o altre flessioni dei due lemmi. Non tutte le forme possibili saranno attualizzate di fatto (occorrenze),

sebbene siano potenzialmente conosciute. Ogni individuo nel corso della sua esistenza non utilizza tutte le parole che conosce o

meglio che è in grado di creare sulla base della grammatica di un dato idioma. Un giorno mia figlia di dieci anni mi chiese: “papà

8

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

che, in quanto riflesso della lingua (nel senso dell’idioma), sia un’espressione della “langue”

saussuriana. E’ evidente che il lessico di un individuo è un riflesso delle sue origini, dell’esperienza,

della cultura acquisita, in sostanza delle sue appartenenze socio-antropologiche13. Stime del lessico

sono i cosiddetti “lessici di frequenza” ossia conteggi di occorrenze di vastissimi corpus di

materiale testuale, che proprio per la loro vastità possono “approssimare il linguaggio potenziale”:

per questi aspetti si veda più avanti.

Infine, con il termine dizionario si indica, invece, l'insieme dei lemmi di un idioma, raccolti dal

lessicografo in un unico repertorio o inventario. Sono i dizionari cartacei (anche bi/multi-lingue),

che recentemente, si vanno diffondendo sempre più anche come dizionari in forma elettronica. Ai

fini del trattamento automatico della lingua i dizionari elettronici propriamente detti, sono strumenti

predisposti per essere consultati da una macchina e non dall’uomo. In quanto databases lessicali14,

sono inventari "completi" non solo dei lemmi, ma anche delle forme flesse (le voci declinate dei

sostantivi, aggettivi, pronomi, preposizioni articolate o quelle coniugate dei verbi), nonché di lessie

o lessemi complessi (locuzioni e forme idiomatiche)..

Vocabolari, dizionari e lessici producono comunque delle liste di unità lessicali, che possono essere

ordinate secondo diversi criteri.

Fra quelli lessicografici, il più consueto è quello alfabetico, rispettivamente diretto o inverso. Il

primo, in vocabolari di forme grafiche, è utile a ricostruire lemmi o radici (TAB. 1.2/a), il secondo a

raggruppare morfemi (TAB. 1.2/b)15. Questi ultimi offrono ampie possibilità di categorizzazione

delle parole (per tipo di classi grammaticali o flessive16, per soggetti, tempi ecc.), in genere

scarsamente sfruttate in un’analisi testuale, ma molto utili a trovare errori, eccezioni o altri aspetti

specifici.

Fra quelli lessicometrici, per i vocabolari si adotta spesso il criterio che ordina le forme secondo il

numero decrescente di occorrenze (TAB. 1.2/c). Talvolta per ordine di apparizione delle types nel

corpus (secondo l’ID_type).

TABELLA

1.2 – Vocabolario di forme grafiche secondo differenti ordini lessicografici e lessicometrici

a

b

alfabetico

abbandonato

....

fine

....

infezione

infezioni

infiammabile

infiammata

infiammato

infiammazione

inficia

inficiata

infila

infilare

c

inverso

occorrenze decrescenti

3

21

11

15

1

2

2

9

1

1

4

7

inficia

infila

parla

infiltra

inficiata

parlata

infiammata

infilava

parlava

infiammabile

fine

infine

1

4

34

1

1

8

2

3

5

1

21

63

infine

parla

fine

parlato

infezioni

infezione

inizio

infiammazione

infiltrazioni

parlata

infilare

infilato

63

34

21

19

15

11

10

9

8

8

7

7

perché si dice calore e non “caldezza” se esiste freddezza? Ecco un esempio di termine “potenziale”, nell’infinita varietà della lingua:

nel suo piccolo, aveva creato grammaticalmente una nuova parola, inesistente solo perché non usualmente praticata.

13 Sul lessico e le sue rappresentazioni si veda l’interessante raccolta di contributi proposta in Laudanna e Burani (1993).

14 Questi databases sono costruiti (Silberztein, 1993; Elia, 1995) a partire da fonti assai eterogenee, fra le quali anche vocabolari

provenienti dallo spoglio di corpus differenti.

15 Secondo la definizione della grammatica tradizionale, ogni parola (in quanto monema) può suddividersi in un radicale (morfema

lessicale) e in una desinenza o un affisso (morfema grammaticale): il primo cattura l’aspetto semantico del termine, il secondo quello

grammaticale. La parola “scrivere” si articola ad esempio in scriv-ere. Queste definizioni variano a seconda dei linguisti che ne

discutono: per approfondimenti vedi un dizionario di linguistica, ad esempio Dubois (1979).

16 Si veda per l’italiano di base, l’analisi su tali classi svolta da Thornton (1994).

9

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

infilato

infilava

infilò

infiltra

infiltrarsi

infiltrazione

infiltrazioni

infine

inizio

iniziò

....

parla

parlare

parlarsi

parlata

parlato

parlava

parlò

....

zio

7

3

1

1

1

6

8

63

10

1

34

2

1

8

19

5

1

infiammazione

infiltrazione

infezione

infilare

parlare

infiltrazioni

infezioni

parlarsi

infiltrarsi

zio

inizio

iniziò

infilò

parlò

infilato

parlato

infiammato

abbandonato

9

6

11

7

2

8

15

1

1

3

10

1

1

1

7

19

2

3

infiltrazione

parlava

infila

abbandonato

infilava

zio

infiammata

infiammato

parlare

infiammabile

inficia

inficiata

infilò

infiltra

infiltrarsi

iniziò

parlarsi

parlò

6

5

4

3

3

3

2

2

2

1

1

1

1

1

1

1

1

1

3

Fonte: corpus POLIF (Bolasco e Morrone, 1998a)

Si definisce rango, il posto occupato da un termine in una graduatoria. Il primo posto in graduatoria

è pari al rango 1. In un vocabolario, al decrescere del numero di occorrenze, il numero associato al

rango aumenta (TAB. 1.3). Pertanto, in un vocabolario ordinato per occorrenze decrescenti il rango

di un elemento è tanto più “elevato” quanto minore è il numero delle sue occorrenze. Nel caso di

più elementi con la stessa quantità di occorrenze, il loro rango rimane costante, in quanto riflette la

condizione di parità nella graduatoria.

TABELLA

1.3 - Esempio di vocabolario per occorrenze decrescenti (in forme grafiche con relativo

rango)

rango

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

forma grafica

occ

è

di

una

e

un

la

che

regione

isola

per

non

Sardegna

più

i

con

da

in

ma

le

a

molto

si

l

il

bella

sono

essere

ha

ancora

293

217

214

197

194

184

149

147

114

113

112

104

101

89

87

83

82

78

71

68

67

61

60

56

52

50

48

45

43

rango

forma grafica

occ

rango

forma grafica

occ

29

terra

31

dal

31 disoccupazione

31

problemi

34

se

35

ci

35

della

37

c

37

sviluppo

39

del

39

stato

41

bellissima

42

deve

42

isolamento

42

lavoro

45

dell

45

delle

45

isolata

48

gli

48

soprattutto

50

bisogno

50

resto

50

sardi

53

ambiente

53

cui

53

dove

53

poco

53

troppo

58

al

43

41

41

41

38

35

35

33

33

31

31

30

28

28

28

27

27

27

26

26

25

25

25

23

23

23

23

23

22

58

58

58

58

58

64

65

65

67

...

74

76

79

85

92

97

100

108

124

139

156

173

199

222

266

320

425

657

dei

però

possibilità

potenzialità

sempre

come

Italia

occupazione

bene

...

potrebbe

fare

giovani

perché

classe

anche

alla

abitanti

bellezze

economica

ai

aiuti

agricoltura

abbastanza

acque

oggi

abbiamo

abbandonate

22

22

22

22

22

21

20

20

19

...

18

17

16

15

14

13

12

11

10

9

8

7

6

5

4

3

2

1

Fonte: corpus Sardegna (Censis)

Le fasce di frequenza di un vocabolario

10

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

Si considerino le parole di un vocabolario ordinate per frequenze decrescenti, partendo dalla parola

con freqmax fino ad arrivare a quelle con freqmin, ossia con una sola occorrenza (hapax). Questa

gamma di parole s’articola in classi di occorrenze, che possono essere raggruppate in differenti

fasce di frequenza. Si possono considerare tre fasce: le alte, le medie e le basse frequenze. La fascia

delle alte frequenze è quella in cui ogni parola ha un numero diverso di occorrenze da ogni altra.

Generalmente è composta all’incirca da 30 o 50 forme (a seconda delle dimensioni del corpus) e,

fra queste, al più 4 o 5 sono parole principali, mentre le altre sono parole grammaticali.

Il limite fra le alte e le medie frequenze si colloca subito sopra la prima parità: ossia la prima coppia

di parole che occorrono lo stesso numero di volte (cioè, in tab 1.3, al rango della forma <ha>). La

fascia delle medie frequenze si caratterizza per avere al suo interno parole con diverse condizioni

sia di parità sia di numero di occorrenze (nella quale cioè non tutte le possibili quantità di

occorrenze sono presenti). Partendo poi dal basso della lista di parole, ossia dagli hapax, il confine

fra medie e basse frequenze è individuato dalla prima lacuna nel numero consecutivo di occorrenze

crescenti (ossia in corrispondenza della parola <sardi> in TAB. 1.3; per un esempio vedi anche

Guilbaud, 1980). La fascia delle basse frequenze possiede tutte le classi di frequenze decrescenti

fino alla V1 e contiene la stragrande maggioranza delle parole del vocabolario. Nelle tre fasce si

articolano progressivamente i diversi tipi di parole: parole “vuote”, parole strumentali, parole

principali. Ciò consente di utilizzare questa informazione per individuare un’opportuna soglia di

frequenza (§ 4.1.4).

1.2.5 - Sulla definizione di parola: forma grafica, lemma

Come ricorda Ch. Muller, nessuna definizione del termine "parola" è soddisfacente: si tratta di

adottare delle convenzioni, in parte comunque arbitrarie. Da un punto di vista della sua funzione,

non è secondario ricordare che, nel discorso, una parola può denotare un oggetto (sostantivo),

un'azione o uno stato (verbo), una qualità (aggettivo, avverbio) o una relazione (preposizione,

congiunzione). Come già detto, la parola intesa come forma grafica (type), ossia in quanto <catena

di caratteri di un alfabeto delimitata da due separatori> è la base per ogni riconoscimento

automatico delle occorrenze di un testo.

Ma il problema della scelta dell'unità di testo, affrontato più avanti nel cap. 2, consiste nel decidere

quale tipo di riconoscimento adottare per la micro-segmentazione in occorrenze. Ad esempio

l'espressione "sono finiti" costituisce una sola occorrenza della voce del verbo finire, oppure si

tratta di due occorrenze "sono" (voce del verbo essere) e "finiti" (aggettivo)? Ai fini del

riconoscimento automatico, si sceglie di considerarle sempre due occorrenze diverse, in quanto

forme grafiche differenti. Ma, in seguito si vedrà che sotto diverse ipotesi di scansione del testo,

questi casi possono considerarsi una sola occorrenza. Si vorrà infatti tendere a ricostituire le unità

minimali di senso, che i linguisti chiamano lessie (Pottier, 1992). Per cui anche un’intera locuzione,

come <per quanto riguarda>, può considerarsi una sola occorrenza. Ma altre volte, per corpus di

ampiezza limitata o per scopi specifici, si considerano come unità di testo dei grafemi o degli ngrammi (sequenze di n-caratteri): come ad esempio i digrammi o trigrammi, coppie o triplette di

lettere (sillabe, fonemi o altro), componenti fondamentali ad esempio per analisi di relazione e

similarità e in modelli di analisi del linguaggio basati su catene di Markov.

In un vocabolario di forme grafiche si nascondono spesso molte ambiguità, in quanto una parola

può avere anche più di un significato: lo studio del vocabolario del corpus è dunque arduo e

impreciso. In generale, tanto più una parola è frequente, tanto più essa è sfruttata per molteplici usi

e relativi significati. Ma in particolare esistono, in ciascuna lingua, numerosi omografi (non

omofoni), ossia parole identiche come caratteri ma diverse nella loro pronuncia. Da esempi ben noti

11

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

come pesca (il frutto o il catturare un pesce) o capita (dai verbi capire o capitare), ad altri meno

consueti come ordinale (l’aggettivo, ‘ordinàle’, o l’imperativo del verbo con enclitica pronominale,

‘òrdinale’). Un passo verso la disambiguazione dei termini è costituito dalla lemmatizzazione, ossia

il processo di riconoscimento della categoria grammaticale di una parola, che produce la

riconduzione della forma grafica al lemma di appartenenza.

Per lemma s’intende la coppia di informazioni [vocabolo, categoria grammaticale], o, talvolta più

comunemente, la forma base o forma canonica con cui una parola è presente in un dizionario della

lingua (come entrata di una voce)17. Ad esempio le occorrenze <scrive> e <scrivevano>

individuano due forme grafiche distinte, appartenenti ad uno stesso lemma: [scrivere, Verbo]. Si

può osservare che la fusione delle due flessioni sotto un unico lemma trasforma una certa quantità

d'informazione: da un lato fa guadagnare l’appartenenza alla funzione grammaticale ma dall’altro fa

perdere, nel caso verbale, il tipo di soggetto e il tempo18. Anche a livello di lemmi possono

permanere o nascere ambiguità. Ad esempio, la forma canonica <essere> da sola può nascondere

due diversi lemmi: [essere, Verbo] e [essere, Nome] (“l’essere umano”).

Ulteriori distinzioni possono essere fatte all’interno di una categoria grammaticale, riguardo al

genere: ad esempio la forma canonica <fine> che in prima istanza si può distinguere in [fine,

Aggettivo] e [fine, Nome], vede poi quest’ultimo, a sua volta, pienamente ben definito solo in

quanto [fine, Nm] (nome maschile, il fine come “scopo”) distinto da [fine, Nf] (nome femminile, la

fine come “termine”). E, a sua volta, l’aggettivo <fine> può distinguersi dal punto di vista

semantico, in quanto è conosciuto con diverse accezioni, quali ad esempio <fine> come “sottile” o

<fine> come “raffinato”.

1.2.6 – Collocazione e lessicalizzazione

Si definisce collocazione l’associazione abituale di un morfema lessicale con altri all’interno di un

enunciato, a prescindere dalle relazioni grammaticali esistenti fra questi morfemi. Ad esempio pane

è in collocazione con fresco, secco, bianco. Le coppie di parole sono co-occorrenti. (Dubois et al.,

2002: 91). Nel Gradit, DeMauro (1999) definisce una collocazione come “una combinazione di

parole che, diversamente da quanto avviene nelle locuzioni idiomatiche, restando semanticamente

autonome e sostituibili, danno luogo a espressioni favorite dall’uso particolarmente frequente in una

data lingua e non necessariamente in altre, anche relativamente affini (come ad es. efferato delitto o

fare (una) lezione in italiano, rispetto alle sequenze meno frequenti odioso, o infame delitto o tenere

(una) lezione)”.

La lessicalizzazione è il processo con il quale un insieme di morfemi (un sintagma) diventa una

unità lessicale. E’ un processo di “degrammaticalizzazione”, che privilegia il lessico a spese della

grammatica. La lessicalizzazione porta cioè a introdurre termini nuovi in una lingua. Ai fini

dell'analisi testuale, equivale a considerare un sintagma (ovvero una sequenza di parole) come una

sola unità lessicale: per es.: "del tutto", come equivalente a "completamente" o "interamente". In

pratica, le due occorrenze <del> e <tutto> sono fuse in una sola nuova occorrenza <del_tutto> che

costituisce una nuova entrata del vocabolario del corpus (Dubois et al., 2002: 277).

17 L’infinito per i verbi (dire), il singolare per i sostantivi (politica), il singolare-maschile per gli aggettivi (buono).

18 Il vocabolario generato da un corpus può essere espresso anche in unità di lemmi, ma ciò comporta la lemmatizzazione del testo.

La forma grafica <particolare> può infatti appartenere ad uno dei due lemmi: [particolare, Nome] o [particolare, Agg]. Dal momento

che i termini omografi non sono riconoscibili automaticamente come diversi, queste ambiguità non saranno risolte nel primo parsing

del corpus. Potranno in una seconda fase attraverso la sottomissione del testo a dizionari e a grammatiche locali (Silberztein, 1993),

ovvero a lemmatizzatori. Per i problemi legati alla lemmatizzazione, automatica e non, si rimanda il lettore interessato al § 2.3.3 xxx,

vedasi anche Grigolli et al. (1992), Viprey, Labbé, Bolasco (1993).

12

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

CAPITOLO 2 - Unità di analisi, dati e meta-dati

Caratteristiche di una analisi automatica del testo

Nel trattamento automatico dei testi, secondo un approccio di tipo metrico, risultano essenziali e

centrali i concetti di unità di analisi, di tipo di dati e di meta-dati. Questi ultimi rappresentano quelle

informazioni che in forma di annotazioni di vario genere arricchiscono i dati e consentono una loro

gestione in processi di data mining e text mining. In questo capitolo si approfondiscono queste

nozioni discutendo alcune implicazioni a seconda dei tipi di corpus e di analisi. E’ importante

sottolineare fin dall’inizio che i meta-dati sono oggetti virtuali e “stratificati”, sfruttabili nel

trattamento automatico attraverso una “chiamata” del corrispondente strato.

Nell’approccio metrico risulta fondamentale l’integrazione fra dati non strutturati (testuali) e dati

strutturati (codificati), che permette un rapporto fra testi, dati e meta-dati, così come tra

informazioni a priori (variabili associate ai frammenti) e informazioni a posteriori frutto dell’AAT.

In sostanza nei software per il trattamento automatico di dati testuali è indispensabile una

comunicazione più ampia possibile tra la consultazione full text del corpus e le annotazioni sulle

unità di testo e di contesto, e fra queste ultime e la costruzione di tabelle e matrici di dati da

sottoporre ad analisi statistiche. Attraverso questi passaggi si realizza il dialogo fra il livello

paradigmatico di studio del lessico e quello sintagmatico di analisi del discorso e si produce il salto

da un trattamento delle parole fuori contesto, come fossero estratte da un urna (bag of words), ad

una rappresentazione, grazie a modelli statistici, sia del contesto complessivo sia del senso, anche

latente, espresso dalle informazioni del corpus. Per questo, le scelte sul tipo di unità di analisi in

funzione degli obiettivi risultano cruciali per il buon risultato dello studio.

2.1 - Tipi di unità di contesto

Ai fini dell’analisi automatica di un corpus, può considerarsi come una unità di contesto sia un

intero testo/corpus (un libro, un discorso, un documento), sia una sua parte/testo (un capitolo, un

paragrafo) - ovvero un raggruppamento pertinente di frammenti -, sia ogni singolo frammento o

record individuale (frase, risposta, messaggio). Dipende dal tipo di obiettivo dell’analisi e dal

genere di materiali testuali analizzati.

2.1.1 - I frammenti

E’ appena il caso di ricordare che il termine frammento, nella terminologia dell’AAT, è l’elemento

base della collezione dei testi (corpus). Se un corpus viene studiato come un unico frammento non

vi è alcuna macro-segmentazione e quindi non è possibile stabilire confronti al suo interno: se ne

studierà soprattutto il lessico complessivo, per confrontarlo con quello di altri corpus d’interesse.

Come già visto nel § 1.2.1 un frammento può anche essere una frase semplice (proposizione

sintatticamente indipendente), o un enunciato (proposizione di senso compiuto), o una risposta

individuale (al limite, costituita da una sola parola: <sì>), o quant’altro sia da considerarsi unitario

sotto un qualche punto d’interesse: ad esempio, il titolo di un articolo di giornale.

13

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

La ricerca dell’unità di contesto più opportuna risulta essenziale quando si intenda sviluppare lo

studio del corpus considerando i frammenti come unità d’analisi, al fine di poterli confrontare fra

loro, sulla base del loro profilo lessicale o poterli classificare in tipi omogenei.

I frammenti possono essere già definiti dalla natura della collezione, come nel caso delle risposte

libere in un questionario con domande aperte o degli articoli di quotidiani, o dei paragrafi e/o

commi di un corpus di testi giuridici. Nei casi invece in cui i frammenti non sono pre-definiti, come

ad esempio quando si analizza un testo letterario o delle interviste in profondità, non vi sono regole

fissate una volta per tutte per la macro-segmentazione del corpus. Esistono solo criteri generali di

cui tener conto. In primo luogo vale il presupposto che un frammento, in quanto unità di contesto su

cui operare ogni ricerca per la cattura di un’occorrenza, di un segmento o di una co-occorrenza,

appartenga allo stesso parlante (autore o generatore del testo). Quindi se il corpus è una raccolta di

fonti testuali riconducibili a più parlanti, un frammento non sarà mai costituito da pezzi di testo di

parlanti diversi. In secondo luogo è determinante individuarne l’ampiezza. Questa non sarà

prefissata come numero di caratteri (in quanto si rischia di spezzare una parola) o di occorrenze (in

quanto si rischia di spezzare un sintagma19), ma viene generalmente determinata da elementi di

carattere linguistico o in taluni casi di carattere metrico-statistico. La frammentazione del testo in

frasi è cruciale per qualsiasi analisi di tipo sintattico, quindi l’elemento determinante sarà la

punteggiatura. In altre circostanze, soprattutto per “testi frammento”, dove i discorsi non sono

strutturati con punteggiatura o altri separatori evidenti, può essere determinante far valere un

criterio metrico. E’ possibile considerare un numero di occorrenze di parole piene compreso fra 12 16 elementi, sufficienti a “profilare” l’unità di contesto in maniera efficace ai fini di confronti o di

una classificazione, come propone Max Reinert nel software Alceste.

2.1.2 - I segmenti ripetuti

Per fini più limitati e particolari, possono essere prese in considerazione altre unità di analisi di

contesto: ad esempio, le sequenze di parole o i sintagmi di base della linguistica strutturale

(nominali, verbali, preposizionali). Ogni ricerca automatica di sequenze di parole, sintagmi o

segmenti, non avviene a cavallo di due frammenti, poiché non avrebbe senso. Per definizione, una

qualsiasi sequenza di parole sarà riconosciuta come tale, solo se contenuta interamente in un

frammento. Alcuni software di trattamento automatico del testo - come Lexico, Sphinx, Taltac ed

altri - hanno sviluppato un algoritmo per l‘indicizzazione di tutti i segmenti di un testo, sotto

opportuni vincoli. Nell’algoritmo prima di tutto si definisce il chunk di testo20 all’interno del quale

cercare l’entità da individuare. La segmentazione del frammento in chunk condiziona

l’individuazione dei segmenti ripetuti, ossia “tutte le disposizioni a 2, 3, ..., q parole che si ripetono

più volte nel corpus” (Salem, 1987). Più in particolare, ogni sequenza di types di lunghezza q

compresa tra due separatori forti, dove 2 < q < Lmax. Illustriamo l’algoritmo attraverso un esempio.

Dati due chunk

| A B C D | E F G |

Sep fg fg fg fg Sep fg fg fg Sep

dati i separatori (forti)

, . ; : ! ?

preso uno stralcio di discorso:

“... è un' isola stupenda, solo che è abbandonata.”

A B C D

| E F A

G

19 Si definisce sintagma ogni sequenza ordinata (disposizione) di elementi nel discorso. Ad esempio la parola è un sintagma di

lettere e la frase un sintagma di parole.

20 In particolare, ogni chunk è definito da uno spezzone di testo (“frase”), delimitato da due separatori “forti”, all’interno dei quali è

possibile identificare uno o più segmenti ripetuti. Se la virgola è considerata fra i separatori forti, nella lettura automatica della

seguente sequenza di testo “... in modo, tale che ...”, il segmento <in modo tale> non verrà identificato, ma saranno riconosciuti solo

<in modo> e <tale che>.

14

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

l’indice di tutte le sequenze calcolabili per i due chunk come segmenti ripetuti è il seguente:

AB / ABC / ABCD / BC / BCD / CD

| EF / EFA / EFAG / FA / FAG / AG

Ad esempio un chunk del tipo “il governo si propone di” contribuisce alle occorrenze di segmenti

(fino a 4 elementi) quali: <il governo>, <il governo si>, <il governo si propone>, <governo si>,

<governo si propone>, <governo si propone di >, <si propone>, <si propone di>, <propone di>.

Uno stralcio di discorso di 5 parole ha prodotto 9 segmenti entro una lunghezza massima di 4

parole.

La ridondanza

Il precedente indice di sequenze è un inventario di segmenti tale che quelli di lunghezza inferiore

sono censiti già in quelli di lunghezza maggiore: la sequenza BC è contenuta anche in ABC, ABCD,

BCD. Pertanto esiste ridondanza nell’informazione, ma in tal modo per ogni sequenza si conosce il

100% delle sue occorrenze. A differenza del vocabolario, per il motivo anzidetto, le occorrenze dei

segmenti in generale non sono sommabili. La ridondanza dei segmenti estratti infatti è duplice, nel

senso che: i segmenti più corti come types sono inclusi in quelli più lunghi21 e, viceversa ai fini del

conteggio dei tokens, le occorrenze di quelli più lunghi sono comprese nella quantità di occorrenze

di quelli più corti.

La ridondanza garantisce il riconoscimento di strutture semantiche e di frasi modali. Per limitare la

ridondanza, riducendo la quantità di segmenti da pubblicare, si possono introdurre numerosi vincoli.

In primo luogo la frequenza delle parole facenti parte dei segmenti. Una soglia di occorrenze pari a

5, esclude dal calcolo tutte le parole con frequenza inferiore a tale valore, ovvero vengono saltate

quando il chunk le contiene (nel primo esempio, se stupenda ha nel corpus 3 sole occorrenze, il

segmento ABCD ai fini del calcolo non esiste). Puntando a cercare i segmenti ripetuti si

individuerebbero sequenze formate solo da parole con almeno 5 occorrenze. Un secondo parametro

è la frequenza minima dei segmenti da pubblicare: se la soglia è 4 l’inventario conterrebbe solo le

sequenze ripetute almeno 4 volte. E’ evidente che parole frequenti almeno 5 volte possono far parte

di sequenze identiche ripetute almeno 4 volte. Al contrario una parola con 5 occorrenze non può

presentarsi in un segmento ripetuto 10 volte22.

Occorre tener presente che i segmenti ripetuti possono essere assai più numerosi delle stesse forme

grafiche componenti un corpus. Per esempio, ad una soglia di 3 occorrenze, in un corpus ampio, si

ottengono oltre 18.000 segmenti diversi, quando le forme grafiche distinte, a quella soglia, sono

9.40023: un rapporto 2 a 1. Per limitare la quantità di segmenti pubblicati si possono introdurre altri

vincoli. Il numero massimo di parole componenti il segmento (Lmax): è inutile richiedere lunghezze

superiori a 9-10 parole. A meno di operazioni di “taglia e incolla”, i testi non contengono formule

così lunghe. Per la varietà linguistica del discorso è davvero raro, per non dire impossibile, trovare

segmenti ripetuti identici superiori a 10 parole. Fanno eccezioe i testi giuridici nei quali le

“formule” stereotipate di questo linguaggio possono produrre sequenze identiche di lunghezze

anche assai maggiori.

21 Per limitare la ridondanza, a parità di numero di occorrenze di due segmenti uno incluso nell’altro, l’algoritmo pubblica solo il

segmento più lungo.

22 Se la soglia di frequenza minima delle parole è inferiore a quella della frequenza minima dei segmenti l’algoritmo lavora in parte

a vuoto perché individua molti segmenti (con parole a bassa frequenza) che tuttavia non pubblica, perché sono ripetuti in quantità

inferiore alla soglia minima fissata per i segmenti da pubblicare.

23 Al contrario in un corpus molto piccolo (minore di 5.000 occorrenze), a soglia di frequenza elevata (ad esempio 10) il numero di

segmenti ripetuti può essere inferiore a quello delle parole alla stessa soglia. E’ un riscontro dell’inefficacia (eccessiva schematicità)

di un’analisi statistica su testi di piccola dimensione.

15

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

L’individuazione di segmenti ripetuti consente, per le parole più frequenti (quelle che più

probabilmente si presentano in accezioni diverse), di rendere più ricca l'analisi. E’ infatti essenziale

distinguere in testi giuridici sintagmi nominali quali: stato democratico da stato giuridico o da stato

di diritto; o nel linguaggio politico: nuovo governo da precedente governo. L’individuazione di

nuove lessie garantisce la ricostruzione di unità di senso meno ambigue e di parole chiave del

corpus.

2.2 – Tipi di unità di analisi del testo

Obiettivi di studio e scelta di unità lessicali

Il problema essenziale per l’analisi automatica dei testi è operare il riconoscimento del senso del

discorso. La soluzione al problema si fonda in gran parte sulla scelta dell’unità di analisi del testo,

indicata convenzionalmente con il termine parola. A seconda degli obiettivi, tale unità può essere

una forma grafica, un lemma, una multiword o una lessia ovvero una unità mista (in grado di

catturare al meglio i significati presenti nel testo). Una forma grafica se corrisponde ad una parola

di un idioma è sempre una forma flessa o flessione di un lemma. Spesso viene detta anche soltanto

una forma. Ognuna di queste può rappresentare una entrata del vocabolario quindi un type.

Se s’intende studiare il lessico di un autore attraverso l’analisi dell’insieme dei suoi scritti, al fine di

confrontarlo con quello di altri autori, interessandosi pertanto ad aspetti stilometrici, l’analisi

automatica si fonderà sui lemmi e quindi sullo studio delle relative liste di frequenza24. Se

l’obiettivo è studiare il contenuto d’una raccolta di testi corti (articoli di giornale, risposte a

domande aperte di un questionario), l’analisi si fonderà sulle forme grafiche, da trasformare

eventualmente, come unità di analisi, in lessie. Se si vuole invece individuare un lessico settoriale,

lo studio è caratterizzato da interessi terminologici (dove ogni termine ha un significato univoco) e

l’attenzione del ricercatore si fonderà principalmente sulla ricerca di poliformi e multiwords - cioè

lessie complesse e collocazioni, locuzioni verbali - ovvero tutte quelle entità che costituiscono delle

sequenze ricorrenti, con un alto livello di cristallizzazione semantica (Elia, 1996) o con significato

idiomatico.

Parole piene e parole vuote

Quale che sia l’obiettivo, è possibile distinguere o categorizzare in svariati modi le entrate di un

vocabolario: rispetto al loro ruolo nella frase, alla loro categoria grammaticale, o ad altri criteri di

appartenenza. Spesso si distinguono le parole piene dalle parole vuote: le prime sono portatrici dei

significati oggetto di studio, le seconde invece sono quelle che non esprimono in sé un contenuto

d’interesse e vengono trascurate ai fini dell’analisi.

Le parole piene sono dette anche parole principali, in quanto portatrici di parti “sostantive” del

contenuto di un discorso (nomi e aggettivi), delle sue modalità di enunciazione (avverbi) o di azione

(verbi). Uno degli obiettivi più ricorrenti di un’analisi testuale consiste nell’identificare quali siano

le parole principali caratteristiche, ossia le parole chiave, di un testo, sia per la loro presenza intesa

come sovrautilizzo rispetto agli altri testi, sia per la loro rarità/assenza (sottoutilizzo). In entrambe le

situazioni si parla di specificità (§ 3.2.3) nelle differenti parti del corpus e se ne analizza così la

varietà tematica.

Vengono spesso considerate vuote molte parole grammaticali o di legame (il, di, e, in, ... ): ma

qualsiasi lista è soggettiva e funzionale alle particolarità dell’analisi. Infatti parole grammaticali

(articoli, preposizioni, congiunzioni, alcuni aggettivi) possono essere assai importanti per

24 Ad esempio gli studi di Brunet sui classici della letteratura francese, fra gli altri si vedano quelli su Giraudoux e Hugo (1978b,

1988); oppure gli studi di Labbé sul linguaggio politico di Mitterand (xxx).

16

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

interpretare un testo. Ad esempio, il sovrautilizzo di preposizioni come in o di sottolinea il carattere

descrittivo del discorso; una prevalenza di non, per e con sottolinea particolari intenzionalità del

parlante, mentre quella dei ma e se evidenzia elementi legati ad incertezza. Inoltre, anche alcuni

semplici determinanti25 sono fondamentali per identificare differenti gruppi nominali (il governo, un

governo, questo governo). Le parole grammaticali vanno considerate, dunque, come parole

strumentali, in quanto sono i cardini di alcuni costrutti lessico-grammaticali, utili a discernere la

semantica del discorso.

In molti processi di information retrieval e text mining vengono stilate delle liste di parole da

trascurare (stop words), ai fini delle ricerche. Sono parole che vengono filtrate, prima, dopo, durante

un processo di archiviazione di un testo 26. Sono in prevalenza parole grammaticali o assai frequenti

(come verbi ausiliari e modali avere, essere, andare, venire, dovere, potere, volere ecc.) e “poco”

informative, nel senso della teoria dell’informazione. Una sorta di “rumore” che può essere

tralasciato senza troppo danno nella trasmissione del “segnale”.

2.2.1 - Le unità di analisi del testo

La forma grafica

In statistica testuale, le analisi basate sulle forme grafiche hanno il vantaggio di essere indipendenti

dalla lingua. E’ un approccio puramente formale che privilegia i segni (significanti) per arrivare al

senso (in quanto insieme di significati) come rappresentazione del contenuto o del “discorso”.

Il segno linguistico, come noto, è composto di un significante distinto dal punto di vista "fonico"

(parlato) e/o "grafico" (scritto) e di un significato a sua volta distinto dal punto di vista della

"forma" (come classe "sintattica": grammatica, morfologia e sintassi) e della "sostanza" (come

classe "semantica"). L'analisi statistica, secondo i cosiddetti formalisti, è condotta “a prescindere dal

significato delle unità di testo”.

Il senso (significato/accezione) di una parola è determinato dalle parole che la circondano (asse

sintagmatico), ma anche dalla selezione delle altre parole che possono rimpiazzarla nella stessa

frase (asse paradigmatico); ossia dall'insieme delle parole che possono essere sostituite fra loro nel

sintagma, senza modificare la struttura dell'enunciato, poiché "funzionano" in maniera equivalente.

Il senso sottostante un testo/discorso, di cui s'intende dare una rappresentazione con metodi

statistici, è costituito dal sistema dei significati che "si tiene" - come una sorta di ecosistema - sulla

base dell'insieme delle co-occorrenze nell'intero corpus di dati testuali.

La lessia

Una evoluzione dell’approccio per forme grafiche è basato sullo sfruttamento di informazioni sia

endogene che esogene al corpus per disambiguare al meglio le unità di analisi del testo. Nell'ambito

della statistica testuale, cresce l'attenzione a considerare un'unità di analisi di tipo misto che è ben

rappresentata con la nozione di lessia nel senso di B. Pottier (1992), come l'unità di comportamento

lessicale27, in quanto unità minima significativa del discorso, sia essa semplice (tavola), composta

(piccole imprese) e/o complessa (dalla testa ai piedi). In sostanza un’unità minimale di senso, non

ulteriormente decomponibile, ossia un atomo di significato. E' facile che una lessia composta o

complessa, in quanto unità semantica, possa essere una polirematica (Elia, 1992), cioè un poliforme

25 In generale, i determinanti sono i costituenti del sintagma nominale, ovvero gli elementi che attualizzano il nome. Nell’accezione

corrente, sono gli articoli, gli aggettivi possessivi, dimostrativi, interrogativi, relativi e indefiniti, i numerali e cardinali (Dubois,

1979, p. 87).

26 Il termine stopwords fu coniato da H. P. Luhn, pionere nell'information retrieval, per indicare le parole in cui il processo di

archiviazione si ferma, salta la parola "inutile" e riprende. In generale le stopwords sono filtrate in base al loro livello di utilità in un

dato contesto o percentuale di uso (http://get.fastpopularity.com/search_engime_optimization/stopwords_nuova_vita.php).

27 Per approfondimenti si rimanda a dizionari di linguistica; cfr. Dubois et al. (1979) e Beccaria (1994).

17

Appunti sull’analisi statistica dei dati testuali e cenni sull’analisi automatica dei testi

Corso: Metodi esplorativi per l’analisi dei dati e laboratorio di data mining – a.a. 2011-2012

Docente: prof. Sergio Bolasco

il cui significato è frutto di un calcolo non composizionale. In questo caso il senso del poliforme

non è risultante dalla somma dei significati delle singole parole componenti ma produce un

significato diverso e autonomo (es. capo_dello_stato, carta_di_credito); esempi di polirematiche

sono gli idiomi verbali (es. venir_meno, portare_avanti).

Elia, nei suoi studi, dichiara che la presenza di polirematiche in un testo può arrivare a coprire il

60% dell'intero testo. Altre stime più prudenti ipotizzano un 40-50%. Questo dato insinua il dubbio

sulle possibilità di una decodifica automatica del senso di un testo, quando questa non venga

supportata da altri strumenti messi in atto dal ricercatore: come per esempio il confronto con dei

dizionari di poliformi. La scelta di unità di analisi del testo miste (considerando cioè come singole

occorrenze sia forme semplici, sia lessie complesse) permette di andare incontro alla soluzione di

questi problemi, escludendo alcune alternative semantiche teoricamente possibili, ma assolutamente

improbabili, nel contesto investigato.

Nasce così un approccio lessico-testuale, nel quale è riconosciuta migliore una unità d'analisi di

tipo “flessibile”, come può essere appunto una lessia, che comprenda sia forme grafiche sia

espressioni, ogni qualvolta queste ultime rappresentino delle unità minimali –atomi di senso- in

grado di catturare il giusto significato (carta; carta geografica; carta di credito). In questo caso, il

parsing del testo è svolto ora per forme ora per polirematiche28, come certi gruppi nominali di tipo

Nome+Aggettivo (lavoro nero, economia sommersa), Aggettivo+Nome (terzo mondo, estratto

conto, ampio respiro) o Nome+Preposizione+Nome (ordine del giorno, capo dello stato, anni di

piombo, chiavi in mano). Le polirematiche e le locuzioni grammaticali (avverbiali, preposizionali,

aggettivali) -una volta isolate- permettono di abbassare drasticamente il livello di ambiguità delle

singole parole, prima della loro lemmatizzazione.

……………………….

28 cf. Bolasco (1999, p. 196).

18