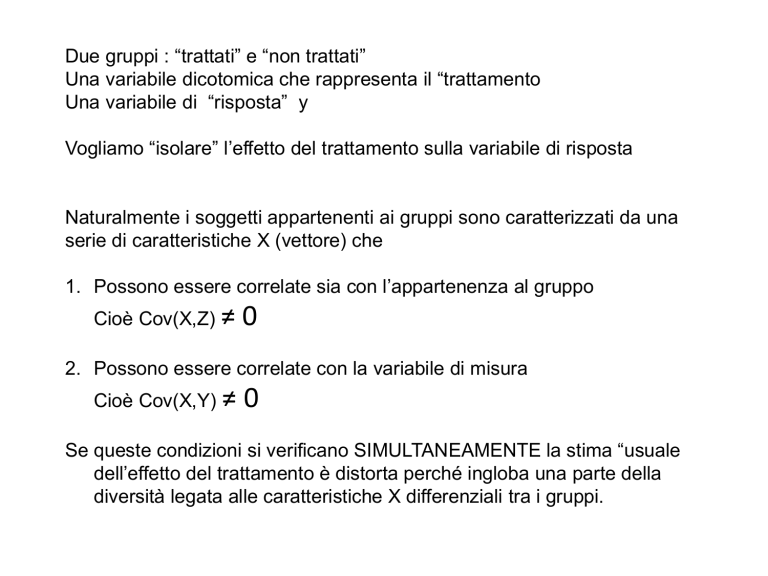

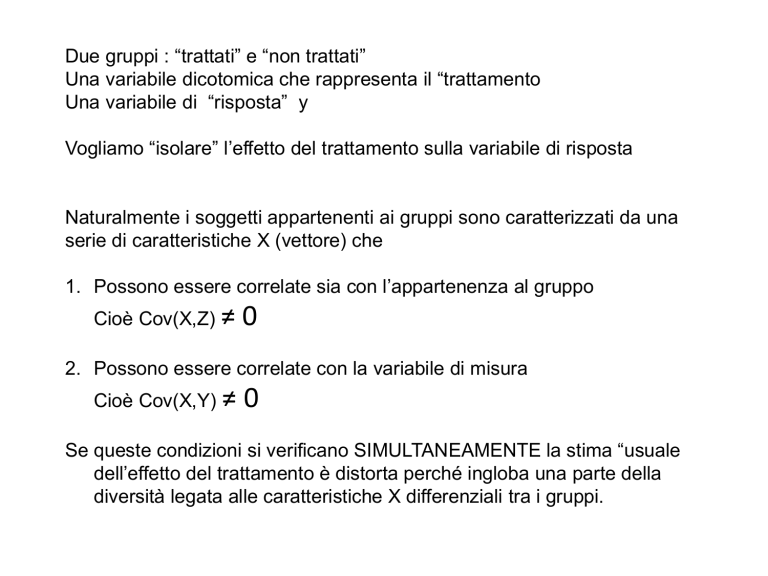

Due gruppi : “trattati” e “non trattati”

Una variabile dicotomica che rappresenta il “trattamento

Una variabile di “risposta” y

Vogliamo “isolare” l’effetto del trattamento sulla variabile di risposta

Naturalmente i soggetti appartenenti ai gruppi sono caratterizzati da una

serie di caratteristiche X (vettore) che

1. Possono essere correlate sia con l’appartenenza al gruppo

Cioè Cov(X,Z) ≠

0

2. Possono essere correlate con la variabile di misura

Cioè Cov(X,Y) ≠

0

Se queste condizioni si verificano SIMULTANEAMENTE la stima “usuale

dell’effetto del trattamento è distorta perché ingloba una parte della

diversità legata alle caratteristiche X differenziali tra i gruppi.

STUDIO DEGLI EFFETTI DI UN “TRATTAMENTO”

Es. Istruzione, formazione, tipologia famigliare, campagna pubblicitaria….

Consideriamo un individuo, in linea teorica siamo interessati a misurare

l’effetto di una certa variabile Z=0,1 (dicotomica= trattato/non trattato) su

una variabile “di risposta” Y.

Se chiamiamo Y1 e Y0 i valori di risposta per Z=1 e per Z=0, siamo

interessati ad una stima della quantità (relativa a tutto il collettivo):

E (Y1 ) E (Y0 )

Dove la media è estesa a tutta la popolazione di individui.

Ciascun individuo è anche caratterizzato da un vettore di covariate X, che

in ipotesi possono avere una correlazione sia con la Y che con la Z, cioè

possono influenzare sia la variabile di risposta che la scelta.

L’ASSEGNAZIONE CASUALE

In generale la quantità non è osservabile, infatti non è possibile sottoporre e non

sottoporre lo stesso individuo ad un trattamento, per cui ogni individuo mostra solo

UNO dei valori Y utili per la stima.

Abbiamo quindi due collettivi disgiunti e la comparazione “diretta” tra i valori Y cioè

la stima di è corretta solo se la distribuzione delle covariate X è “simile” nei due

collettivi, cioè se

Corr(X,Z)=0

Se così non è una parte di cioè della differenza trattati/non trattati dipende dalle

X e non dal trattamento.

L’assegnazione casuale dei soggetti ai due gruppi ha esttamente questo compito,

per definizione (a lungo andare) se l’assegnazione è casuale la distribuzione delle

X (o di loro opportune trasformate) nei due sottoinsiemi è statisticamente identica.

Quindi la media delle Y nei due collettivi ha la stessa componente “legata” alle X e

nella differenza Y1-Y0 si elide e la stima di è corretta, cioè

UNA PICCOLA TRASFORMAZIONE

Definiamo come “propensity score” (PS) la probabilità che, dato un insieme di

covariate X, un individuo i appartenga al gruppo dei “trattati” (o dei “non trattati”):

s(Xi) = P(Z=1/Xi)

L’assegnazione casuale ha il compito di rendere il PS indipendente da X, cioè

identico nei due gruppi, definiamo questa selezione come IGNORABILE:

s(Xi) = P(Z=1/Xi) = P(Z=1)

Se l’assegnazione non è “strettamente” casuale questa condizione non è

rispettata, ma ha senso chiedersi se esiste una qualche combinazione delle X che

“restituisce” la condizione di comparabilità.

Ci chiediamo cioè se esiste una trasformazione b tale che:

s(Xi) = P(Z=1/b(Xi)) = P(Z=1)

In questo caso diversi termini: selezione “RESA IGNORABILE” o anche

IGNORABILE tout-court + altri termini

Esempio classico: campione stratificato, confronto medie “pesate”

ESEMPIO

Supponiamo che le donne, solo per il fatto di essere donne, riescano in media ad

ottenere 3 voti in più ad un certo esame. In questo caso la X è una dicotomica che

indica il genere

Poiché in media le performances degli studenti (uomini e donne) a quell’esame

sono basse, la Facoltà decide di offrire una serie di esercitazioni integrativa con

adesione volontaria. Supponiamo, come al solito, di sapere in anticipo che l’effetto

“vero” delle esercitazioni sia di aumentare di 6 punti il voto.

La situazione “vera” sia la seguente:

Uomini

Donne

Totale

Iscritti

60

40

100

Voto medio "prima"

21

24

22,2

Voto medio "dopo"

27

30

28,2

Differenza=effetto del trattamento

6

ESEMPIO - continua

Nella valutazione ex post dell’effetto, la composizione del sub-collettivo che sceglie

di frequentare le esercitazione è cruciale. Indichiamo con n il numero di

frequentatori delle esercitazioni e con N il numero di iscritti, con i pedici d e u il

genere (uomo/donna), con 1 e 0 la frequenza alle esercitazioni.

Ipotesi 1:

Sub-collettivo “bilanciato” esito tipico (long-run) SRS:

nd/Nd = nu/Nu. cioè P(Z=1/X)=P(Z=1) SELEZIONE IGNORABILE

Diciamo 30 uomini e 20 donne

27nu 30nd 27 * 30 30 * 20

Y1

28.2

nu nd

50

28.2 22.2 6

Corretto!

ESEMPIO - continua

Ipotesi 2

Sub-collettivi di uguale numerosità:

nd/Nd nu/Nu. cioè P(Z=1/X) P(Z=1)

SELEZIONE NON IGNORABILE

Diciamo 20 uomini e 20 donne P(z=1/X=1) = 1/3 e P(Z=1/X=2) = 1/2

27nu 30nd 27 * 20 30 * 20

Y1

28.5

nu nd

40

28.5 22.2 6.3

Distorto!

In generale:

Distorsione (%) nella stima della differenza di voti secondo la probabilità di inclusione

Intervalli pari al +/- 2%

1

0,9

18%-20%

0,8

16%-18%

14%-16%

12%-14%

0,7

10%-12%

8%-10%

6%-8%

0,6

Prob(uomini)

4%-6%

2%-4%

0%-2%

0,5

-2%-0%

-4%--2%

0,4

-6%--4%

-8%--6%

-10%--8%

0,3

-12%--10%

-14%--12%

-16%--14%

0,2

-18%--16%

-20%--18%

0,1

0,1

0,2

0,3

0,4

0,5

0,6

Prob(donne)

0,7

0,8

0,9

1

Oppure, più leggibile…

Distorsione (%) nella stima della differenza di voti secondo la percentiuale di donne nel subcolletivo

40%

30%

20%

differenza

10%

0%

0%

10%

20%

30%

40%

50%

-10%

-20%

-30%

percentuale donne

60%

70%

80%

90%

100%

ESEMPIO - continua

Come interveniamo, di solito? Facile, pesiamo i risultati in modo da correggere la

distorsione legata alla diversa probabilità di inclusione, in particolare utilizziamo

l’inverso della probabilità

Diciamo 20 uomini e 20 donne P(z=1/X=1) = 1/3 e P(Z=1/X=2) = 1/2

Cioè (media uomini *3 + media donne *2) / 5

(27*3 + 30 *2)/5 = 28.2

Corretto!

Stimatore di Horwitz-Thompson e similari

Abbiamo trovato un “peso” legato alle probabilità di inclusione (un PS) che ha reso

ignorabile il processo

La Y di ogni soggetto viene pesata con l’inverso della probabilità di aderire al

trattamento. Ammesso di conoscere tale probabilità, l’ignorabilità è ripristinata.

s(Xi) = P(Z=1/b(Xi)) = P(Z=1)

Che fare se non si conosce questa probabilità, cioè se le adesioni non sono frutto

di un disegno, ma di una scelta non controllata?

RIEPILOGHIAMO:

Obiettivo : Verificare l’effetto di un trattamento Z (1=trattato, 0 =non trattato) su un

collettivo di individui in generale diversi tra loro per qualche caratteristica X.

Indicatore: Differenza tra una qualche statistica di una variabile di risposta Y

Problema: la variabile di risposta Y relativa al singolo individuo i non è osservabile nei

due stati di Z

Conseguenza: Noi vorremmo stimare

f (Yi ,1 Yi ,0 )

Ma possiamo osservare solo

f (Yi ,1 ) f (Y j ,0 )

i Z 1 j Z 0

A quali condizioni l’inferenza è corretta? In generale se

P( z 1 / Y ) P( Z 1)

MA….

naturalmente la Y è osservata solo parzialmente, quindi la condizione non è verificabile

UN BEL PROBLEMA DI INFERENZA

In sé l’ipotesi di indipendenza di Z e Y NON può essere oggetto di inferenza,

sappiamo, però, che l’assegnazione “puramente” casuale ai due sottoinsiemi

garantisce questa condizione (perché garantisce l’indipendenza da qualsiasi

variabile)

La garanzia starebbe, quindi, nel meccanismo di assegnazione

MA…..

1. In molti (moltissimi) casi l’assegnazione non è per nulla casuale (scelte volontarie

di individui, condizioni di tempo e luogo differenti, etc..)

2. Anche quando il meccanismo è progettato per essere casuale, vi sono

numerosissime deviazioni dal progetto iniziale (non risposte, errori di lista,

sostituzioni di intervistati indisponibili, etc…)

3. E’ possibile, pur con un SRS puro, che il gioco del caso nella singola fattispecie

formi insiemi diversissimi (siamo stati sfortunati)

In generale il SRS “puro” è una condizione difficilmente conseguibile

INFATTI, OGNI TANTO ABBIAMO DEI DUBBI

Per esempio quando osserviamo che per le caratteristiche note X, i due sottoinsiemi

definiti da Z appaiono “troppo” diversi, perché questo ci fa venire sospetti circa la

casualità (valutata ex-post) del processo di assegnazione.

Siamo portati a credere che, per un qualche motivo, la formazione dei due insiemi sia

stata effettivamente influenzata da qualche altro fattore che non sia la pura casualità

(che dovrebbe generare insiemi simili per le X)

In realtà questa posizione è legata ad una ipotesi “a priori”, infatti la preoccupazione

sarebbe infondata se non avessimo il sospetto che “potrebbe” esserci una

correlazione tra le X e la Y. Anzi ci insospettiamo solo per le differenze in “alcune” X.

Per esempio consideriamo poco preoccupante nella misura delle differenze di reddito,

il colore degli occhi. Tanto che non lo rileviamo neppure (per quanto.....)

D’altra parte, se avessimo due insiemi “identici” per “tutte” le possibili caratteristiche X,

allora anche in presenza di correlazione l’ipotesi di indipendenza di Z e Y sarebbe

verificata.

UNA INFERENZA “INDIRETTA”

Ma se l’idea (o il sospetto) è che le X siano correlate con le Y, l’ipotesi di indipendenza

tra Z e X può essere verificata (naturalmente per le X osservate).

Anzi, di più: abbiamo metodi per stimare P(Z=1/X) e per fare inferenza sulle stime.

Ad esempio i modelli del tipo logit/probit, ma anche i modelli per dati Troncati e

censurati che abbiamo visto in precedenza.

Sia pure sotto diverse forma, ciò che facciamo è:

1. Ipotizzare un modello per la probabilità di assegnazione (o di scelta) al trattamento

2. Utilizzare una combinazione (non lineare) delle X per stimare questa probabilità

3. Sfruttare questa stima come “correttore” della distorsione nel confronto tra i livelli

della variabile di risposta Y

Nell’esempio abbiamo stimato P(Z=1) come funzione del genere, mediante uno

stimatore “naif” (frequenza relativa) e poi abbiamo utilizzato la stima come “peso”

per correggere la media dei trattati.

La stima della probabilità in questo contesto è il “PROPENSITY SCORE”

UN APPROCCIO MOLTO GENERALE

Naturalmente vi sono molti metodi in cui il percorso descritto può essere compiuto

tuttavia è importante sottolineare che questo modo di affrontare il problema:

Pone al centro dell’inferenza NON il meccanismo di selezione dei soggetti, MA il

processo di generazione dei dati, di cui la selezione è SOLO un elemento

Da questo punto di vista, il problema non è se la selezione è casuale, na se

disponiamo di un modello che è in grado di rappresentare il processo di misura

Cade la distinzione tra campioni casuali e sottoinsiemi non casuali, la legittimità

dell’inferenza sta nelle ipotesi del modello di misura, NON nel meccanicismo del

processo di selezione

Dal punto di vista teorico il modello di misura acquista importanza e dignità come

momento di conoscenza, non solo come “buona prassi” spesso impossibile da

rispettare fino fino in fondo

Si aprono possibilità enormi e non convenzionali per l’utilizzo di dati tradizionalmente

trascurati (es.: dati parziali, di origine amministrativa, su base volontaria etc..)