Guida al colloquio del nuovo Esame di stato

© Edizioni Bruno Mondadori 1999

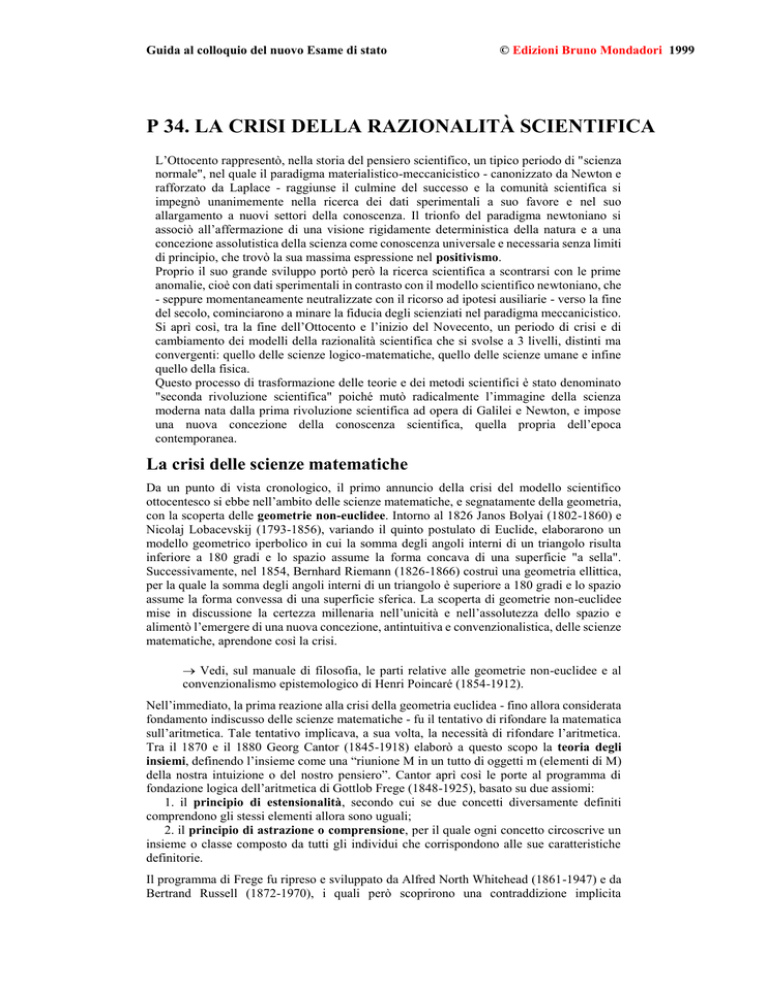

P 34. LA CRISI DELLA RAZIONALITÀ SCIENTIFICA

L’Ottocento rappresentò, nella storia del pensiero scientifico, un tipico periodo di "scienza

normale", nel quale il paradigma materialistico-meccanicistico - canonizzato da Newton e

rafforzato da Laplace - raggiunse il culmine del successo e la comunità scientifica si

impegnò unanimemente nella ricerca dei dati sperimentali a suo favore e nel suo

allargamento a nuovi settori della conoscenza. Il trionfo del paradigma newtoniano si

associò all’affermazione di una visione rigidamente deterministica della natura e a una

concezione assolutistica della scienza come conoscenza universale e necessaria senza limiti

di principio, che trovò la sua massima espressione nel positivismo.

Proprio il suo grande sviluppo portò però la ricerca scientifica a scontrarsi con le prime

anomalie, cioè con dati sperimentali in contrasto con il modello scientifico newtoniano, che

- seppure momentaneamente neutralizzate con il ricorso ad ipotesi ausiliarie - verso la fine

del secolo, cominciarono a minare la fiducia degli scienziati nel paradigma meccanicistico.

Si aprì così, tra la fine dell’Ottocento e l’inizio del Novecento, un periodo di crisi e di

cambiamento dei modelli della razionalità scientifica che si svolse a 3 livelli, distinti ma

convergenti: quello delle scienze logico-matematiche, quello delle scienze umane e infine

quello della fisica.

Questo processo di trasformazione delle teorie e dei metodi scientifici è stato denominato

"seconda rivoluzione scientifica" poiché mutò radicalmente l’immagine della scienza

moderna nata dalla prima rivoluzione scientifica ad opera di Galilei e Newton, e impose

una nuova concezione della conoscenza scientifica, quella propria dell’epoca

contemporanea.

La crisi delle scienze matematiche

Da un punto di vista cronologico, il primo annuncio della crisi del modello scientifico

ottocentesco si ebbe nell’ambito delle scienze matematiche, e segnatamente della geometria,

con la scoperta delle geometrie non-euclidee. Intorno al 1826 Janos Bolyai (1802-1860) e

Nicolaj Lobacevskij (1793-1856), variando il quinto postulato di Euclide, elaborarono un

modello geometrico iperbolico in cui la somma degli angoli interni di un triangolo risulta

inferiore a 180 gradi e lo spazio assume la forma concava di una superficie "a sella".

Successivamente, nel 1854, Bernhard Riemann (1826-1866) costruì una geometria ellittica,

per la quale la somma degli angoli interni di un triangolo è superiore a 180 gradi e lo spazio

assume la forma convessa di una superficie sferica. La scoperta di geometrie non-euclidee

mise in discussione la certezza millenaria nell’unicità e nell’assolutezza dello spazio e

alimentò l’emergere di una nuova concezione, antintuitiva e convenzionalistica, delle scienze

matematiche, aprendone così la crisi.

Vedi, sul manuale di filosofia, le parti relative alle geometrie non-euclidee e al

convenzionalismo epistemologico di Henri Poincaré (1854-1912).

Nell’immediato, la prima reazione alla crisi della geometria euclidea - fino allora considerata

fondamento indiscusso delle scienze matematiche - fu il tentativo di rifondare la matematica

sull’aritmetica. Tale tentativo implicava, a sua volta, la necessità di rifondare l’aritmetica.

Tra il 1870 e il 1880 Georg Cantor (1845-1918) elaborò a questo scopo la teoria degli

insiemi, definendo l’insieme come una “riunione M in un tutto di oggetti m (elementi di M)

della nostra intuizione o del nostro pensiero”. Cantor aprì così le porte al programma di

fondazione logica dell’aritmetica di Gottlob Frege (1848-1925), basato su due assiomi:

1. il principio di estensionalità, secondo cui se due concetti diversamente definiti

comprendono gli stessi elementi allora sono uguali;

2. il principio di astrazione o comprensione, per il quale ogni concetto circoscrive un

insieme o classe composto da tutti gli individui che corrispondono alle sue caratteristiche

definitorie.

Il programma di Frege fu ripreso e sviluppato da Alfred North Whitehead (1861-1947) e da

Bertrand Russell (1872-1970), i quali però scoprirono una contraddizione implicita

Percorso 9 - Danna e società nell’Ottocento

2

nell’assioma di astrazione. Si trattava dell’antinomia delle classi per la quale se R è la classe

di tutte le classi che non contengono se stesse come elemento ne deriva che R non può

contenere ma nemmeno non contenere se stessa: nel primo caso R conterrebbe una classe che

contiene se stessa, cioè avrebbe un elemento spurio, nel secondo escluderebbe una delle

classi che non contengono se stesse, cioè mancherebbe di un elemento proprio.

Per risolvere l’antinomia, Whitehead e Russell elaborarono la teoria dei tipi, secondo la

quale una classe non può appartenere a se stessa ma solo a un’altra classe superiore ad essa

per estensione. Ma per fondare la matematica sulla teoria dei tipi, essi furono costretti a

ammettere gli assiomi dell’infinito, di scelta e di riducibilità, che non risultavano

razionalmente evidenti.

Vedi, a questo proposito, i Principia Mathematica (1910-1913) in cui Whitehead e

Russell cercano di salvare il programma di rifondazione logica della matematica

elaborando la teoria dei tipi.

Lo scacco del programma logicista aprì la strada, intorno al 1900, al programma formalista di

David Hilbert (1862-1943) che tentò di rifondare la matematica come un sistema

assiomatico-deduttivo, cioè come un insieme di teorie sintatticamente coerenti aventi tre

requisiti: la non-contraddittorietà, la completezza e l’indipendenza. Ma nel 1931 Kurt

Gödel (1906-1978) dimostrò due teoremi che colpivano alle radici il programma formalista.

Il primo affermava che in ogni sistema assiomatico-deduttivo è possibile costruire una

proposizione che il sistema non è in grado né di confermare né di smentire, il secondo che il

sistema non può dimostrare al suo interno la sua non-contraddittorietà.

I teoremi di Gödel, rimasti a tutt’oggi insuperati, favorirono nell’immediato un nuovo

tentativo di fondazione intuizionista della matematica, ma soprattutto sancirono nel lungo

periodo i limiti di principio di quella che era stata considerata fino a quel momento la scienza

"esatta" per eccellenza.

Vedi sul manuale di filosofia la parte relativa ai teoremi di Gödel che dimostrano i

limiti di principio delle scienze matematiche.

La crisi nelle scienze umane

Uno degli indici più significativi del trionfo ottocentesco del paradigma newtoniano fu il

tentativo, in gran parte riuscito, di conquistare e di annettersi le discipline conoscitive che si

occupavano della realtà storico-sociale dell’uomo, tradizionalmente legate a modelli

conoscitivi di stampo metafisico o retorico antitetici a quelli delle scienze naturali. Nel corso

dell’Ottocento, infatti, sotto la spinta del positivismo, nacquero la sociologia, la storia e la

psicologia come scienze sperimentali, basate cioè sugli stessi presupposti e sullo stesso

metodo delle scienze naturali e in particolare della fisica meccanica. Il sintomo più

emblematico di questa impostazione fu la definizione della sociologia come “fisica sociale”

e la sua divisione in “statica” e “dinamica” ad opera di August Comte (1798-1857). Ma

anche in questo ambito, alla fine del secolo, il paradigma meccanicistico venne messo in

discussione sia dai progressi della ricerca sia dallo sviluppo della riflessione metodologica.

Nell’area delle discipline storico-sociali la reazione critica alla fisica sociale è rappresentata

dallo storicismo tedesco, e in particolare da Max Weber (1881-1961), il quale da un lato

accettò pienamente l’identità tra scienze della natura e scienze umane sul piano

logico-metodologico, dall’altro ne evidenziò i limiti elaborando un modello di scienza

decisamente divergente da quello della fisica newtoniana.

Guida al colloquio del nuovo Esame di stato

© Edizioni Bruno Mondadori 1999

Percorso 9 - Danna e società nell’Ottocento

3

Innanzitutto, per Weber, la scienza storico-sociale per principio non può indagare tutti i

fatti, ma deve selezionarli sulla base di criteri valutativi che sono del tutto soggettivi. Essa

mantiene una universalità-in quanto l’indagine deve essere condotta rispettando precise

regole logico-metodologiche-ma tale universalità è sempre limitata e prospettica. Dunque è

possibile una compresenza di più indagini scientifiche relative a una stessa realtà storica con

risultati diversi e perfino antitetici.

In secondo luogo, poiché i criteri di selezione del campo d’indagine sono valori storici

che cambiano nel tempo, la conoscenza storico-sociale non può mai essere definitiva, ma è

destinata a un perenne mutamento.

In terzo luogo, anche la regola fondamentale di tutte le scienze-la spiegazione

causale-per Weber deve essere ridefinita poiché non esistono fatti assolutamente oggettivi,

ma essi sono sempre connessi a una teoria. Di conseguenza il rapporto di causalità ha un

fondo interpretativo ineliminabile e non può essere concepito come una connessione

necessaria, ma solo come una possibilità oggettiva.

Su queste basi Weber giunse ad asserire che le stesse regole logico-metodologiche della

scienza sono relative a un determinato contesto storico-culturale e come tali sono destinate a

mutare nel tempo. In questo modo Weber, partendo da una riflessione critico-metodologica

sulle scienze storico-sociali, giunse a elaborare una concezione della scienza come sapere

limitato, probabilistico, pluralistico e in perenne evoluzione, molto vicina a quella cui

sarebbe pervenuto a metà del Novecento il dibattito epistemologico sulle scienze naturali.

Vedi, sul manuale di filosofia, i saggi metodologici scritti tra il 1904 e il 1917,

raccolti in Il metodo delle scienze storico-sociali (1958). Qui Weber sostiene

l’inapplicabilità del paradigma newtoniano alla conoscenza della realtà

storico-sociale.

Ma ancora più dirompente fu l’effetto arrecato, nell’ambito delle discipline psicologiche,

dall’irruzione della psicanalisi di Sigmund Freud (1856-1939). L’affermazione del

paradigma meccanicistico in psicologia aveva portato gli scienziati a un riduzionismo

materialistico radicale, di cui fu emblema la tesi del positivista Kurt Vogt secondo cui il

pensiero è una secrezione del cervello come la bile del fegato. Certo Vogt costituiva un

caso-limite, ma l’indirizzo scientifico, largamente dominante in ambito psicologico, ne

condivideva completamente la concezione organicistica, secondo la quale ogni fenomeno

psichico doveva essere ricondotto a una causa fisica. Fin dai suoi primi studi sull’isteria,

Freud, che pure era un medico di formazione positivista, cominciò a rovesciare questo

assunto sostenendo una eziologia psichica dei disturbi della personalità e quindi l’autonomia

della sfera psichica rispetto a quella somatica. Ma la vera rivoluzione avvenne quando Freud

arrivò alla scoperta dell’inconscio come fondamento di tutta la psiche umana, facendo

crollare il presupposto secolare della psicologia secondo cui la sfera dello psichico si

identificava con quella della coscienza. Questa, inoltre, non solo veniva ridimensionata da

totalità a piccola parte della psiche, ma soprattutto era drasticamente depotenziata in quanto

epifenomeno dell’inconscio. In questo modo, la psicanalisi freudiana colpiva al cuore la

concezione tradizionale della razionalità sia relativamente al suo merito sia relativamente al

suo metodo, in quanto, da un lato, il primato dell’inconscio metteva in discussione

l’autonomia della ragione umana, dall’altro perché, mentre tutta la metodologia scientifica si

fondava sul presupposto della razionalità del proprio oggetto, la psicoanalisi si proponeva

come scienza di un oggetto in sé irrazionale. In questo senso il metodo scientifico messo a

punto da Freud, basato com’era sul presupposto del transfert personale del paziente verso lo

psicanalista e sull’interpretazione simbolica dei sogni, degli atti mancati e delle libere

associazioni, risultava decisamente eretico rispetto alla metodologia consolidata sia delle

scienze naturali sia delle scienze umane.

Vedi sul manuale di filosofia l’opera L’interpretazione dei sogni (1900), di Freud,

in cui l’interpretazione simbolica, tradizionalmente considerata estranea alla

scienza, assurge al ruolo di metodo scientifico della psicologia del profondo.

Guida al colloquio del nuovo Esame di stato

© Edizioni Bruno Mondadori 1999

Percorso 9 - Danna e società nell’Ottocento

4

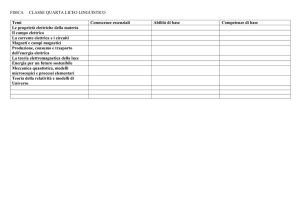

La crisi della fisica

Nel campo della fisica, la crisi del paradigma newtoniano cominciò nel 1873 con

l’elaborazione della teoria elettromagnetica da parte di James Clerk Maxwell (1831-1879).

Le equazioni con cui Maxwell descriveva e unificava i fenomeni elettromagnetici, infatti,

risultavano in contrasto con il principio classico della relatività galileiana: mentre per la

meccanica due osservatori in movimento l’uno rispetto all’altro "vedono" lo stesso

fenomeno-in quanto attraverso le formule delle trasformazioni galileiane è possibile

unificare la descrizione di un osservatore immobile con quella di un osservatore in moto

rettilineo uniforme-ciò non risultava valido per l’elettromagnetismo, le cui equazioni sono

modificate dalle trasformazioni galileiane rendendo impossibile l’unificazione delle

descrizioni di due diversi osservatori. Ne conseguiva il paradosso che un fenomeno elettrico,

a differenza di uno meccanico, doveva essere descritto in due modi diversi a seconda della

condizione dell’osservatore.

L’anomalia fu brillantemente risolta da Hendrik Antoon Lorentz (1853-1928), che

elaborò le nuove formule di trasformazione applicabili alle equazioni di Maxwell. Ma le

trasformazioni di Lorentz, ineccepibili dal punto di vista matematico, comportavano sul

piano fisico delle anomalie ben più gravi di quella che avevano risolto. Esse infatti implicano

che per un osservatore di un sistema in movimento la lunghezza dei corpi si contragga nella

direzione del moto e gli intervalli di tempo si dilatino.

Furono queste anomalie che nel 1905 spinsero Albert Einstein (1879-1955) alla

formulazione della prima teoria della relatività , detta ristretta o speciale perché valida solo

per il moto rettilineo uniforme. Einstein basò la sua teoria sul postulato della costanza della

velocità della luce per qualunque osservatore, scardinando il principio-fino allora

considerato autoevidente-secondo cui la velocità di un corpo varia a seconda che

l’osservatore si muova nella sua stessa direzione, in direzione contraria o stia fermo. Ne

derivava una rivoluzione nella concezione classica dello spazio e del tempo in quanto questi

non potevano più essere concepiti né come assoluti, in quanto variabili in relazione al

movimento, né come indipendenti uno dall’altro. Inoltre la legge che coronava la teoria della

2

relatività-E=mc -identificando materia ed energia, faceva venire meno una distinzione

fondamentale della fisica classica mettendone in crisi la concezione della materia. La

rivoluzione della relatività ristretta fu poi radicalizzata, nel 1916, dalla teoria della relatività

generale o allargata che, includendo anche il moto accelerato, rappresentava una nuova

teoria globale della gravitazione universale alternativa a quella newtoniana. Con essa

Einstein spiegava il movimento dei pianeti intorno al Sole non più come l’effetto di una forza

attrattiva bensì della curvatura dello spazio prodotta dalla massa. La nuova concezione di uno

spazio curvilineo legittimava pienamente anche dal punto di vista fisico le geometrie

non-euclidee, che divennero la geometria di riferimento della nuova fisica relativistica.

Vedi sul manuale di filosofia e su quello di fisica le parti relative alla teoria della

relatività di Einstein, che divenne il nuovo paradigma scientifico nell’ambito della

fisica

macroscopica.

Mentre Einstein elaborava la sua rivoluzione scientifica a livello della fisica macroscopica,

una rivoluzione ancora più radicale si andava compiendo nella fisica microscopica. Essa

prese l’avvio da un’anomalia rispetto alle leggi della termodinamica classica mostrata dai

fenomeni di interazione tra la materia e le radiazioni. L’anomalia venne spiegata nel 1900 da

Max Planck (1858-1947) con l’elaborazione della teoria dei "quanti", secondo la quale

l’energia delle radiazioni non viene emessa o assorbita dalla materia per valori continui ma

solo per multipli interi di una certa quantità, data dal prodotto della frequenza della

radiazione per una costante, detta di Planck.

Guida al colloquio del nuovo Esame di stato

© Edizioni Bruno Mondadori 1999

Percorso 9 - Danna e società nell’Ottocento

5

La teoria quantistica fu applicata nel 1913 da Niels Bohr (1885-1962) alla descrizione dei

fenomeni subatomici e in particolare del movimento degli elettroni, scoperti nel 1897. Il

modello di Bohr si rivelò efficace ma al prezzo di sovvertire le leggi della meccanica classica,

dal momento che stabiliva che gli elettroni possono percorrere solo alcune orbite-dette

stazionarie-intorno al nucleo e che possono spostarsi da un’orbita stazionaria all’altra senza

però passare per le orbite intermedie. Era il cosiddetto "salto quantico" che fece crollare la

millenaria convinzione nella continuità dei fenomeni naturali.

Dopo le prime conferme sperimentali, tra il 1924 e il 1927 la comunità scientifica mise a

punto il nuovo paradigma scientifico della meccanica quantistica che comportava altre

radicali rotture con la meccanica classica. In primo luogo il comportamento degli elettroni

non risultava prevedibile in modo deterministico ma solo in termini probabilistici su basi

statistiche. L’irregolarità del movimento degli elettroni fu spiegata nel 1927 da Werner

Heisenberg (1901-1976) con il principio di indeterminazione, in base al quale non è

possibile stabilire contemporaneamente sia la posizione sia la velocità di un elettrone, in

quanto l’energia luminosa necessaria per rilevarle interagisce quantisticamente con

l’elettrone in modo tale che, se si vuole ridurre l’interferenza rispetto alla posizione, si

aumenta quella relativa alla velocità, e viceversa. Heisenberg negava la possibilità di

determinare il comportamento dell’elettrone, dal momento che per farlo occorre conoscerne

nello stesso tempo sia la velocità sia la posizione.

Ma non era ancora tutto. Sempre nel 1927, Bohr formulò il principio di complementarità,

secondo il quale il comportamento di un elettrone può essere descritto sia attraverso il

concetto di corpuscolo sia attraverso quello di onda, sebbene non nello stesso contesto

sperimentale. Il principio di Bohr rifletteva i risultati di numerosi esperimenti nei quali gli

elettroni avevano mostrato in alcuni casi caratteristiche corpuscolari e in altri caratteristiche

ondulatorie. Esso costituiva una radicale rottura con la concezione classica secondo cui

l’oggetto, in quanto materiale, aveva una natura stabile e univoca.

In questo modo la fisica quantistica sconvolse il modello di razionalità della scienza classica

in modo ben più radicale della fisica relativistica di Einstein. Questi infatti, nonostante le sue

forti innovazioni, non aveva mai abbandonato la convinzione in un ordine deterministico del

cosmo-espressa nella sua famosa sentenza “Dio non gioca a dadi”-e infatti spiegò le

anomalie della fisica quantistica come conseguenze dei difetti e dell’incompletezza della

teoria. La successiva ricerca però da un lato ha ulteriormente confermato la precisione della

teoria quantistica e dall’altro non è riuscita a elaborare una teoria capace di superare la

frattura tra i fenomeni macroscopici e quelli microscopici. Pertanto il risultato più clamoroso

della Seconda rivoluzione scientifica fu l’introduzione nella fisica di un dualismo di

paradigmi, dal momento che al paradigma newtoniano non si è sostituito un unico nuovo

paradigma, ma due paradigmi incompatibili tra loro, quello della relatività per la fisica delle

grandezze macroscopiche e quello quantistico per la fisica delle grandezze microscopiche.

Vedi sul manuale di filosofia e su quello di fisica le parti relative alla teoria

quantistica, che divenne il nuovo paradigma scientifico della fisica delle particelle

subatomiche.

Conclusione

L’evoluzione della ricerca, al livello delle scienze matematiche, delle scienze umane e della fisica,

ebbe dunque un esito comune: quello di rovesciare il modello ottocentesco della razionalità

scientifica. Ad esso si è sostituito un nuovo modello, radicalmente diverso, che ha rimesso in

discussione la concezione stessa della materia, ha sostituito il determinismo con il probabilismo, ha

accettato la pluralità e la libertà dei metodi delle diverse scienze, ha ammesso la provvisorietà delle

teorie scientifiche e più in generale ha riconosciuto il carattere problematico e limitato della

conoscenza scientifica.

Guida al colloquio del nuovo Esame di stato

© Edizioni Bruno Mondadori 1999