Capitolo 4

Il modello di regressione lineare

multivariato

Richiami al modello di regressione lineare semplice

Il modello di regressione lineare multipla

Violazione delle ipotesi e analisi dei residui

Modelli con variabile dipendente dicotomica

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

1/85

Copyright © 2009 – The McGraw-Hill Companies srl

L’analisi di regressione

Obiettivo: investigare sulle relazioni empiriche tra variabili per

analizzare le cause che possono spiegare un dato fenomeno

I modelli utilizzati sono basati su funzioni lineari nei parametri

del tipo Y = α + β X

Alcune funzioni non lineari sono riconducibili a lineari attraverso

opportune trasformazioni delle variabili:

Y = α Xβ log Y = log α + β log X

Anche in caso di relazioni non lineari e non linearizzabili una prima

analisi fondata su forme funzionali lineari è un utile punto di

partenza per passare poi a eventuali modelli più complessi

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

2/85

Copyright © 2009 – The McGraw-Hill Companies srl

L’analisi di regressione

Regressione semplice: una sola variabile indipendente o esplicativa;

Regressione multipla: più di una variabile indipendente

Esempio: effetti sulle vendite di un supermercato derivanti da

una azione di promozione

Da un campione di supermercati si rilevano le vendite settimanali

e la spesa settimanale per promozione regressione semplice

Se si ritiene che anche altre cause influiscano sulle vendite si

rilevano anche altre variabili regressione multipla

Obiettivi conoscitivi: c’è una relazione significativa tra il volume delle

vendite e la spesa per promozione (e le altre variabili) ?

Sulla base di tale relazione come prevedere il volume delle vendite a

seguito di una spesa settimanale per promozione di 1500 euro ?

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

3/85

Copyright © 2009 – The McGraw-Hill Companies srl

Le fasi di un’analisi di regressione lineare

- Si ipotizza una relazione funzionale lineare tra una variabile

oggetto di studio (variabile dipendente o risposta) e una o più

altre variabili (indipendenti o esplicative)

- Si stimano i parametri di tale relazione funzionale sulla base dei

dati campionari a disposizione

- Si effettuano i test statistici sulla significatività dei parametri e si

valuta la bontà dell’adattamento del modello ai dati

- Si effettuano altre analisi di conferma sulla validità delle

assunzioni su cui si basa la stima del modello (linearità e altro)

- Eventualmente, sulla base del modello stimato e di valori

ipotizzati per le variabili indipendenti si stimano i valori previsti

per la variabile dipendente

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

4/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il modello di regressione lineare semplice

- Richiami

Su un campione di n unità sono osservati i valori relativi a due variabili:

Y variabile dipendente o variabile risposta

X variabile indipendente o variabile esplicativa

Esempio: Y volume delle vendite; X spesa per promozione

Campione di supermercati:

Diagramma di dispersione:

Vendite

(x100 euro)

Spesa prom

(x10 euro)

300

43.2

48

250

132

134

155

122

13

100.9

80

187.4

99

185

77

Vendite

76

200

150

100

50

0

0

60.7

50

82.9

44

61.3

25

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

20

40

60

80

100

120

140

-50

Spesa_prom

5/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il modello di regressione lineare semplice

Relazione lineare ipotizzata:

Yi X i ui

i = 1, 2,…, n

α e β: parametri del modello di regressione

α: intercetta; β: coefficiente di regressione

u: termine di errore (discrepanze tra valori osservati di Y e quelli

derivanti da una relazione esatta con X). Comprende:

- errori di specificazione (alla spiegazione esatta di Y in genere

concorrono moltissime variabili esplicative, ma solo la principale

di esse – o le principali nel caso della regressione multipla – sono

inseribili nel modello);

- errori di misura o di risposta presenti nella variabile Y

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

6/85

Copyright © 2009 – The McGraw-Hill Companies srl

Le ipotesi del modello

Yi X i ui

i = 1, 2,…, n

ui: variabili casuali che si

ipotizzano:

- distribuite normalmente

- a media E(ui) = 0

- varianza costante E(ui2) = σ2u

- covarianza nulla E(ui , uj) = 0

X è assunta non affetta da errore di misura

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

7/85

Copyright © 2009 – The McGraw-Hill Companies srl

La retta di regressione stimata

In base alle n osservazioni campionarie: stime dei parametri

α e β del modello di regressione, indicate con a e b

Stimati i parametri, la relazione che lega le due variabili

corrisponde a una particolare retta nel piano:

Ŷ a bX

retta di regressione stimata

dove:

Yˆ indica l’ordinata teorica corrispondente ad un dato

valore di X

il coefficiente a - o intercetta - rappresenta l’ordinata

all’origine della retta

il coefficiente di regressione b è il coefficiente angolare

della retta

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

8/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

La retta stimata è tanto più adatta a descrivere la relazione

tra le due variabili quanto più i punti osservati sono vicini a

tale retta, ovvero quanto minori sono i “residui campionari”

Esempio:

Regressione di Vendite da Spesa_prom (R²=0,507)

300

250

Yi

Vendite

200

ei : residui

| ei

150

Yˆi a bX i

100

campionari

50

0

0

20

40

60

80

-50

100

Xi

120

140

Spesa_prom

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

9/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

Criterio dei minimi quadrati (OLS):

a e b sono scelti in modo da minimizzare la somma dei quadrati

dei residui campionari ei Yi Yˆi Yi a bX i

n

n

i 1

i 1

f (a, b) ei2 Yi a bX i

2

Le derivate parziali di f(a,b) rispetto ai parametri a e b :

n

f (a, b)

2 (Yi a bX i ) 0

a

i 1

n

f (a, b)

2 X i (Yi a bX i ) 0

b

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

n

Y na b X

i 1

n

n

i

i 1

i

n

n

i 1

i 1

2

X

Y

a

X

b

X

ii i i

i 1

10/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

Dalla risoluzione del sistema di equazioni si ottengono le

seguenti stime dei parametri:

a Y bX

n

b xi yi

i 1

n

2

x

i

i 1

( xi X i X ; yi Yi Y )

Codev( X , Y ) Cov( X , Y )

b

Dev( X )

Var ( X )

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

11/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio – Stima dei parametri

Dati dell’esempio precedente:

stime dei parametri

Regressione di Vendite da Spesa_prom (R²=0,507)

300

250

Parametri

a

b

Stima

43.6

0.94

Vendite

200

150

100

50

0

0

20

40

60

80

100

120

140

-50

Spesa_prom

Yˆ 43.6 0.94 X

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

il coefficiente di regressione ci

dice che a seguito di un incremento

unitario della variabile X (una decina

di euro settim. di spesa di

promozione) la variabile Y subisce

un incremento di 0.94 (centinaia di

euro di vendite: 94 euro)

12/85

Copyright © 2009 – The McGraw-Hill Companies srl

Distribuzioni dei parametri

Punto di partenza: gli stimatori a e b sono esprimibili come

funzioni lineari di Yi

n

1

a ( X

i 1 n

n

xi

Y

2 i

i 1 xi

b

xi

)Yi

2

xi

i

i

Dove: Yi X i ui

e

ui

N 0; u2

Ne consegue:

che gli stimatori a e b hanno distribuzione di probabilità normale

e che E(a) = α ; E(b) = β stimatori corretti

Ne derivano le espressioni di Var(a) e Var(b):

2

1

X

Var (a) u2 (

)

2

n xi

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

i

Var (b)

u2

2

x

i

i

13/85

Copyright © 2009 – The McGraw-Hill Companies srl

Distribuzioni dei parametri

Distribuzione di probabilità degli stimatori a e b:

a

2

N ; u 1 n X 2

2

xi

i 1

N ; u2

n

b

2

x

i

i 1

n

Da cui le seguenti variabili standardizzate:

a

u 1 n X 2

n

2

x

i

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

b

N (0,1)

u

n

N (0,1)

2

x

i

i 1

14/85

Copyright © 2009 – The McGraw-Hill Companies srl

Distribuzioni dei parametri

Varianza dell’errore σ2u ignota; suo stimatore corretto s2:

n

s 2 ( ei2 ) / (n 2)

i 1

Dalle distribuzioni normali standardizzate alle distribuzioni t di

Student:

a

s 1 n X 2

n

2

x

i

i 1

b

t( n2)

n

s

2

x

i

t( n2)

i 1

Denominatori: errori standard dei parametri

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

15/85

Copyright © 2009 – The McGraw-Hill Companies srl

Inferenza sui singoli parametri

Test di significatività per b :

H0:

β=0

H1:

β≠0

(H0: la variabile esplicativa X

non ha nessuna influenza

sulla variabile risposta Y)

La statistica test: rapporto tra stima e suo errore standard

b

n

s/

2

x

i

t

2

sì

si respinge H0

β =0

no

si accetta H0

β =0

, n2

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

16/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio – Stime e inferenza

Dati dell’esempio precedente: test sulle stime dei parametri

Stima

(1)

Errore

standard

(2)

t

(3)=(1)/(2)

p-value

(Pr > |t|)

Intercetta

43.566

25.839

1.686

0.130

Spesa_prom

0.937

0.327

2.868

0.021

Yˆ 43.6 0.94 X

P-value: livello di significatività

osservato (probabilità che, vera

H0 , t assuma un valore assoluto

≥ a quello osservato)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

il p-value ci dice che il

test è significativo: il

suo valore ha staccato

un’area di probabilità pari a

0,021 sulla coda della

distribuzione; ci troviamo

quindi nella regione di

17/85

rifiuto del test

Copyright © 2009 – The McGraw-Hill Companies srl

Il modello di regressione multipla

Più variabili indipendenti o esplicative considerate congiuntamente

Nell’esempio: oltre alla spesa per promozione, anche superficie

espositiva e densità della popolazione

Obiettivo: stimare la relazione tra vendite e spesa per

promozione al netto degli effetti della superficie espositiva e

della densità

Caso generale: modello a k variabili, di cui k-1 indipendenti

Yi 1 2 X i 2 ... k X ik ui

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

(i 1,..., n)

18/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il modello di regressione multipla

Yi 1 2 X i 2 ... k X ik ui

(i 1,..., n)

Per esteso:

Y1 1 2 X12 ... k X1k u1

Y2 1 2 X 22 ... k X 2 k u2

.

Yi 1 2 X i 2 ... k X ik ui

.

Yn 1 2 X n 2 ... k X nk un

In notazione vettoriale:

y 1x1 2 x 2 ... k xk u

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

y : vettore n osservazioni relative

alla variabile dipendente

x1: vettore n elementi unitari

xj (j = 2, 3,…, k): vettori

n osservazioni relative

alle k-1 variabili esplicative

u : vettore n termini di errore

β1 : intercetta

β2 , β3 , …, βk : coefficienti

di regressione del modello

19/85

Copyright © 2009 – The McGraw-Hill Companies srl

La notazione matriciale

Caso generale in forma matriciale:

y Xβ u

Dove:

Y1

Y

2

.

y ;

Yi

.

Yn

1

1

.

X=

1

.

1

X 12 X 13 ... X 1k

X 22 X 23 ... X 2 k

.

. ... .

;

X i 2 X i 3 ... X ik

.

. ... .

X n 2 X n 3 ... X nk

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

1

2

.

β ;

j

.

k

u1

u

2

.

u .

ui

.

u n

20/85

Copyright © 2009 – The McGraw-Hill Companies srl

Le ipotesi del modello

1.

2.

la linearità del modello

le caratteristiche della matrice X:

- non stocastica (senza componenti di errore)

- a rango pieno ρ(X) = k

(variabili linearmente indipendenti: nessuna variabile è

combinazione lineare delle altre)

3.

Le caratteristiche dell’errore u: u N (0, 2I) I .D.

- distribuzione normale

- media nulla: E(u) = 0

- varianza costante

} E(uu’) = σ2I

- covarianza nulla

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

21/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

Matrice di varianza-covarianza del termine di errore:

E (u12 ) E (u1u2 ) ... u2 0

2

E (uu ') E (u2u1 ) E(u2 ) ... 0 u2

...

... ...

...

...

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

...

...

...

22/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

Obiettivo dell’analisi: la stima del vettore dei coefficienti di

regressione b in modo da ottenere il modello:

yˆ Xb

Dove ŷ è il vettore delle ordinate teoriche corrispondenti ai

valori stimati b

Per la generica unità i:

Yˆi b1 b2 X i 2 b3 X i 3 ... bk X ik

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

23/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

Metodo dei minimi quadrati: scegliere il vettore b in modo

da minimizzare la somma dei quadrati dei residui

Definizione vettore dei residui:

Y1 (b1 b2 X 12 ... bk X 1k )

Y (b b X ... b X )

1

2 22

k

2k

2

e y yˆ y Xb ...

...

Yn (b1 b2 X n 2 ... bk X nk )

Somma dei quadrati dei residui da minimizzare:

2

y Xb

e

e

e

y

Xb

i

n

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

24/85

Copyright © 2009 – The McGraw-Hill Companies srl

La stima dei parametri

1. Somma quadrato dei residui:

ee y Xb y Xb yy yXb bXy bXXb

yy 2 bXy bXXb

2. Derivata rispetto a b uguagliata a 0:

(ee)

min ee

2 Xy 2XXb 0

b

b

3. Risoluzione rispetto a b:

b XX Xy

1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

25/85

Copyright © 2009 – The McGraw-Hill Companies srl

La distribuzione dei parametri

b XX Xy

1

y Xβ u

b XX X Xβ u

1

u

N (0, 2I)

b combinazione lineare di y e quindi di u: distribuzione normale

Dalla precedente espressione di b, poiché XX XX I si ha:

1

b β XX Xu

1

da cui, poiché E(u) = 0

E (b) β

Proprietà 1: lo stimatore OLS di b

è non distorto

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

26/85

Copyright © 2009 – The McGraw-Hill Companies srl

La distribuzione dei parametri

Matrice di varianza-covarianza di b:

E (b1 1 ) 2

E (b1 1 )(b2 2 ) ...

E (b β)(b β)' E (b2 2 )(b1 1 )

E(b2 2 ) 2 ...

....

....

....

(b β) XX Xu

1

(b β)(b β)' [ XX Xuu ' X XX ]

1

1

E (b β)(b β)' E[ XX Xuu ' X XX ] XX XE (uu ') X XX

1

Poiché E(uu’) = σ2I

1

E (b β)(b β)' 2 XX XX XX

E (b β)(b β)' 2 XX

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

1

1

1

1

Proprietà 2: non esistono altri

stimatori lineari non distorti con

varianza inferiore (più efficienti)

27/85

Copyright © 2009 – The McGraw-Hill Companies srl

1

La distribuzione dei parametri

b

N β, 2 XX

1

Distribuzione di bj ( j-imo elemento del vettore b):

bj

N j , 2 a jj ajj : j-esimo elemento sulla diagonale

principale della matrice ( XX) 1

Dalla distribuzione di bj segue che (per ogni j = 1, …k):

bj j

a jj

N 0,1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

28/85

Copyright © 2009 – The McGraw-Hill Companies srl

Test sui singoli parametri

Sostituito σ con la sua stima corretta

n

s [ ei2 / (n k )]1 2

i 1

si ha:

t

bj j

s a jj

t nk

Dove:

s a jj è l’errore standard della stima

t(n-k) è una distribuzione t di Student con (n-k) g.d.l.

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

29/85

Copyright © 2009 – The McGraw-Hill Companies srl

Test sui singoli parametri

Test di significatività per bj :

H0:

βj = 0

H1:

βj ≠ 0

(la variabile esplicativa Xj non

ha nessuna influenza sulla

variabile risposta)

La statistica test: rapporto tra stima e suo errore standard

bj

s a jj

sì

si respinge H0

βj =0

no

si accetta H0

βj =0

t 2, nk

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

30/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio - i dati

Variabile risposta:

volume delle vendite

Variabili esplicative:

- spesa settimanale per promozione

- superficie dello spazio espositivo

- densità di popolazione nella zona di ubicazione

Vendite

Spesa

prom

Spazio

espos.

Densità

43.2

48

95

55

132

134

144

77

155

122

210

88

76

13

156

66

100.9

80

188

68

187.4

99

321

156

185

77

250

90

60.7

50

115

25

82.9

44

178

99

61.3

25

105

44

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

31/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio – l’analisi dell’output

Sintesi dell’output dell’analisi di regressione

Stima

Errore

standard

t

Pr > |t|

-22.901

16.773

-1.365

0.221

Spesa prom

0.516

0.171

3.020

0.023

Spazio espos.

0.700

0.195

3.590

0.012

Densità

-0.361

0.382

-0.944

0.382

Intercetta

I parametri evidenziati risultano significativamente diversi da 0

perché il test t ha dato luogo a p-value piuttosto piccoli, se si

considera un livello di significatività dello 0,05

I test hanno prodotto risultati che si trovano sulle code della

distribuzione, ossia nella regione di rifiuto dell’ipotesi nulla

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

32/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio - interpretazione

Parametro b2 (0.52): all’aumentare della spesa per promozione di 10

Euro - a parità di altre condizioni - si ha un incremento delle vendite pari

a 0,52*100 Euro (52 Euro)

Parametro b3 (0.70): all’aumentare della superficie espositiva di un

metro quadrato si ha - a parità di altre condizioni - un incremento del

volume settimanale delle vendite pari a 0,70*100 Euro (70 Euro)

Parametro b4 – variabile non significativa: il test t ha prodotto un p-value

molto grande che fa cadere il risultato della verifica nella regione di

accettazione dell’ipotesi nulla il parametro considerato è assimilabile a

zero la variabile esplicativa corrispondente (densità della popolazione)

non influisce sulla variabile risposta (vendite settimanali)

Intercetta – non significativamente diversa da 0:

ai valori nulli di tutte le variabili esplicative corrisponderebbe un volume

di vendite pari a zero

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

33/85

Copyright © 2009 – The McGraw-Hill Companies srl

Esempio - interpretazione

L’effetto sulle vendite della spesa settimanale per la promozione :

- Regressione semplice: b = 0.94

- Regressione multipla: b2 = 0.52

Una volta controllato per altre variabili esplicative, l’effetto risulta molto

ridimensionato

Il modello a una sola variabile esplicativa non era correttamente

specificato

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

34/85

Copyright © 2009 – The McGraw-Hill Companies srl

L’adattamento del modello ai dati

La scomposizione della devianza della variabile Y in due

componenti additive:

- devianza spiegata dal modello di regressione

- devianza residua

Caso della regressione semplice:

V 250

o

l

200

u

m

e 150

v 100

e

n

50

d

i

0

t

0

e

Yˆi a bX i

Yˆi Y

50

100

150

200

250

300

350

Spazio espositivo

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

35/85

Copyright © 2009 – The McGraw-Hill Companies srl

La scomposizione della devianza

2

ˆ

ˆ

ˆ

Y

Y

Y

Y

Y

Y

[(

Y

Y

)

e

]

i

i i i i

i

n

2

i 1

n

2

i 1

n

i 1

Devianza totale - Total Sum of Squares (TSS)

2

ˆ

Y

Y

Y

Y

e

i

i i

n

i 1

2

n

i 1

2

n

i 1

Devianza spiegata detta anche

somma dei quadrati spiegata

(ESS, Explained Sum of Squares):

parte di variabilità di Y spiegata

dal modello di regressione

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

Devianza residua detta

anche somma dei quadrati

residua (RSS, Residual Sum of

Squares): parte di variabilità

totale di Y che il modello non è

in grado di spiegare

36/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il coefficiente di determinazione

Scomposizione della devianza :

TSS ESS RSS

Misura della bontà di adattamento del modello ai dati denominata

coefficiente di determinazione multiplo:

ESS

RSS

R

1

TSS

TSS

2

• R2 può assumere valori compresi nell’intervallo [0,1]

• Può essere interpretato come una misura della vicinanza

della nuvola dei punti campionari all’iperpiano stimato

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

37/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il coefficiente di determinazione

Casi limite:

Il modello si adatta perfettamente ai dati

la variabilità di Y è completamente spiegata dal modello tutti i

residui campionari sono nulli e nulla è la somma

dei loro quadrati (RSS) TSS = ESS R2 = 1

Il modello non si adatta per niente ai dati

il modello non riesce a spiegare nessuna parte della variabilità

di Y : Yˆi Y (Y non dipende da X) la devianza spiegata ESS

è pari a zero; tutta la variabilità di Y è nei residui R2 = 0

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

38/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il coefficiente di determinazione

multiplo corretto

Limite di R2: aumenta (migliora) quando nel modello si

inseriscono variabili aggiuntive (anche non significative)

Rimedio: correzione di R2 per tenere conto del numero di

variabili presenti nel modello

Tavola analisi varianza:

Origine

variabilità

Somma dei

quadrati

Gradi libertà

Media dei

quadrati

Modello

ESS

k–1

ESS / (k – 1)

Errore

RSS

n–k

RSS / (n – k)

In complesso

TSS

n–1

TSS / (n – 1)

R2 1

RSS (n k )

n 1

1

1 R2

TSS (n 1)

nk

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

39/85

Copyright © 2009 – The McGraw-Hill Companies srl

Il coefficiente di determinazione

multiplo corretto

Esempio:

k

Somma quadrati

TSS

100

4

RSS1

40

5

RSS2

39

RSS

R 1

TSS

2

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

R2

Media

quadrati

gdl

R2 corr

n-1 = 29

3.448

0.60

n-k = 26

1.538

0.554

0.61

n-k = 25

1.560

0.548

R2 1

RSS (n k )

TSS (n 1)

40/85

Copyright © 2009 – The McGraw-Hill Companies srl

Significatività del modello nel suo

complesso

R2 e R2 corretto sono misure descrittive della bontà di

adattamento, delle quali non è nota la distribuzione

non vi si può fare un test per verificare l’ipotesi di

significatività del modello nel suo complesso

Test per la significatività del modello nel suo complesso:

statistica F di Fisher calcolata sulla tavola della analisi della

varianza (ANOVA ANalysis Of VAriance)

ESS / (k 1)

RSS / (n k )

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

F k 1, nk

41/85

Copyright © 2009 – The McGraw-Hill Companies srl

Inferenza sui parametri considerati

congiuntamente – test F

Tavola dell’analisi della varianza:

Verifica dell’ipotesi nulla:

•H0: β2 = β3 = … = βk = 0

•H1: almeno un βj ≠ 0 j=2, …, k

ESS /(k 1)

F

F , k 1, nk

RSS /(n k )

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

sì

si respinge H0

β2 =…= βk= 0

no

si accetta H0

42/85

Copyright © 2009 – The McGraw-Hill Companies srl

Inferenza sui parametri considerati

congiuntamente - Esempio

Dati dell’esempio precedente: output della tavola ANOVA

GDL

Somma dei

quadrati

Media dei

quadrati

(1)

(2)

(3) = (2)/(1)

Modello

3

23348.940

7782.980

Errore

6

1989.124

331.521

Totale corretto

9

25338.064

Fonte

F

Pr > F

23.477

0.001

Il risultato del test F produce un valore piuttosto elevato al

quale corrisponde un p-value molto piccolo che porta a

respingere l’ipotesi nulla: parametri tutti pari a zero (tranne

l’intercetta)

Conclusione: il modello è significativo nel suo complesso

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

43/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Inserite come variabili dummy:

Di = 1 se il fenomeno è presente;

Di = 0 altrimenti

Variabili qualitative dicotomiche

Esempio: invece della densità della

popolazione nell’area di ubicazione,

si può inserire una variabile dummy

che distingua gli esercizi ubicati nel

centro urbano dagli altri:

Di = 1 se l’esercizio è in centro

Di = 0 altrimenti

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

Vendite

Spesa

prom

Spazio

esp

D

centro

43.2

48

95

0

132

134

144

0

155

122

210

1

76

13

156

0

100.9

80

188

1

187.4

99

321

1

185

77

250

1

60.7

50

115

0

82.9

44

178

1

61.3

25

105

0

44/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Modello con variabili indipendenti quantitative e dummy:

Yi 1 2 X i 3 Di ui

Di = 1 carattere presente

Di = 0 altrimenti

Per Di = 0 Yi 1 2 X i ui

Per Di = 1 Yi 1 2 X i 3 ui ( 1 3 ) 2 X i ui

Due rette di regressione parallele

- stessa pendenza: la variabile X ha lo stesso effetto sui due

sottocampioni (con carattere presente o assente), misurato da β2

- diversa intercetta: β3 è la differenza tra l’intercetta nel

sottocampione con carattere presente e quella del sottocampione

con carattere assente differenza nel valore di Y per X = 0

differenza nel valore di Y a parità di X

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

45/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Regressione di y da x (R²=0,983)

25

25

20

20

15

y

y

15

10

10

5

5

0

0

5

10

15

20

25

0

0

x

5

10

15

20

25

x

Modello(0)

Modello(1)

Regressione di y da x (R²=0,691)

Yi* = 2.24 + 0.71Xi + 7.06 Di

(R2=0.98)

35

30

25

y

20

15

10

5

0

0

5

10

15

20

-5

x

Attivo

Modello

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

25

Yi* = 4.8 + 0.78Xi

(R2=0.69)

46/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Esempio:

Vendit

e

Spesa

prom

Spazio

esp

D

centro

43.2

48

95

0

132

134

144

0

155

122

210

1

76

13

156

0

100.9

80

188

1

187.4

99

321

1

185

77

250

1

60.7

50

115

0

82.9

44

178

1

61.3

25

105

0

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

par.

Intercetta

St. err.

t

p-value

-43.2

35.2

-1.23

0.266

Spesa prom

0.51

0.17

2.89

0.028

Spazio espos.

0.62

0.15

4.08

0.007

-14.0

19.6

-0.71

0.504

D centro

R²

0.917

R² corretto

0.875

A parità di spesa per promozione e

spazio espositivo, le vendite negli

esercizi ubicati in centro sono

minori di 14.0 (centinaia di euro)

rispetto agli esercizi ubicati altrove

(ma differenza non signif. ≠ 0)

47/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Variabili qualitative politomiche

Esempio: invece di distinguere soltanto tra ubicazione in

centro e altrove, si possono considerare tre modalità: centro

storico, resto dell’area urbana, area non urbana

Si definiscono tante variabili

dummy quante sono le modalità

In caso di tre modalità a, b, c:

D1i = 1 se modalità = a

NB: nel modello se ne deve inserire

D1i = 0 altrimenti

una in meno (2 nel caso di 3

D2i = 1 se modalità = b

modalità): altrimenti nella matrice

D2i = 0 altrimenti

X si ha perfetta collinearità:

D1 = 1 – (D2 + D3)

D3i = 1 se modalità = c

D2 = 1 – (D1 + D3)

D3i = 0 altrimenti

D3 = 1 – (D1 + D2)

48/85

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Esempio: delle tre modalità si esclude la terza e si

inseriscono nel modello le due dummy seguenti:

D1i = 1 se l’esercizio è in centro storico

D1i = 0 altrimenti

D2i = 1 se l’esercizio è nel resto dell’area urbana

D2i = 0 altrimenti

La modalità relativa alla dummy esclusa è la modalità di

riferimento, in relazione alla quale si interpretano i parametri

relativi alle dummy incluse

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

49/85

Copyright © 2009 – The McGraw-Hill Companies srl

Variabili indipendenti qualitative

Variabili indipendenti quantitative

e qualitative politomiche

(caso di tre modalità)

Yi 1 2 X i 3 D1i 4 D2i ui

D1i = 1

D1i = 0

D2i = 1

D2i = 0

D1i = 0 e D2i = 0 (D3i = 1) Yi 1 2 X 1i ui

modalità a

altrimenti

modalità b

altrimenti

( modello base)

D1i = 1 (D2i = 0; D3i = 0)

Yi ( 1 3 ) 2 X i ui

D2i = 1 (D1i = 0; D3i = 0)

Yi ( 1 4 ) 2 X i ui

Tre rette di regressione parallele relative a tre sottocampioni:

β3: differenze, a parità di X, tra la Y nel sottocampione con

modalità a e la Y nel sottocampione con modalità c esclusa

[Es: differenza, a parità di spesa per promozione, tra vendite

esercizi centro storico e vendite esercizi area non urbana]

β4: idem per modalità b

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

50/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

Previsione puntuale di Y in corrispondenza di un determinato

valore di X (pari a X0)

Il valore vero:

Il valore atteso:

Y0 X 0 u0

E (Y0 X 0 ) X 0

La previsione corretta

del valore atteso:

Ŷ0 a bX 0

E’ anche la migliore previsione corretta (a varianza minima)

Esempio: previsione (puntuale) delle vendite settimanali in

corrispondenza a una spesa per promozione di 1500 euro:

Yˆ0 43.57 0.937 X 0

Yˆ 43.57 0.937 150 184.2

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

(184200 euro)

51/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

Intervallo di confidenza intorno al valore previsto Ŷ0 a bX 0

Occorre determinare la distribuzione dell’errore di previsione

Errore di previsione: e0 Y0 Yˆ0 ( a ) ( b) X 0 u0

a, b, u0 : variabili casuali normali a media nulla

errore di previsione: distribuzione normale e media nulla

E (e0 ) E (Yˆ0 Y0 ) E[(a ) (b ) X 0 u0 ] 0

Varianza dell’errore di previsione

E (e0 ) 2 E (Yˆ0 Y0 ) 2 E[(a ) (b ) X 0 u0 ]2

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

52/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

Due componenti della varianza dell’errore di previsione

E (e0 ) 2 E (Yˆ0 Y0 ) 2 E[(a ) (b ) X 0 u0 ]2

- dipendente dall’errore associato a ogni osservazione: E (u0 )

2

2

- dipendente dalla variabilità dei parametri: E[(a ) (b ) X 0 ]

Var (e0 ) E (e0 ) 2 E[(a ) (b ) X 0 ]2 E (u0 ) 2

Var (e0 ) Var (a) X 02Var (b) 2 X 0Cov(a, b) Var (u0 )

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

53/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

Var (e0 ) Var (a) X 02Var (b) 2 X 0Cov(a, b) Var (u0 )

2

1

X

Var (a) u2 (

)

2

n xi

i

Cov(a, b)

X

n

2

x

i

u2

Var (b)

u2

x

2

i

i

Var (u0 ) u2

i 1

2

(

X

X

)

1

Varianza errore di previsione: Var (e0 ) u2 1 0n

2

n

x

i

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

54/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

1 ( X X )2

2

Var (e0 ) u 1 0n

2

n

x

i

i 1

L’errore di previsione:

- diminuisce all’aumentare della numerosità campionaria

- aumenta all’aumentare della varianza del termine di errore

e quindi all’aumentare dei residui campionari elevato R2

per una buona previsione

- aumenta con la distanza dalla media di X

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

55/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione semplice

La distribuzione dell’errore di previsione

1/2

1 ( X X )2

(Y0 Yˆ0 ) / u 1 0n

2

n

x

i

i 1

Stima di σu: s [

N (0,1)

n

2

12

e

/

(

n

2)]

i

t(n-2)

i 1

Intervallo di confidenza intorno al valore previsto Ŷ0 a bX 0

1/2

1 ( X X )2

Yˆ0 t /2( n2) s 1 0n

2

n

x

i

i 1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

56/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Esempio:

Regressione di Vendite da Spesa_prom (R²=0,507)

X 69.2

300

250

s 39.51

Vendite

200

2

x

i 14617.6

150

100

50

t(0.025;8) 2.306

0

0

20

40

60

80

100

120

140

-50

Spesa_prom

X 0 150

Attivo

Modello

Int. di conf. (Oss. 95%)

[184.2 – 113.3; 184.2 + 113.3]

70.9 – 297.5

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

57/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Tramite il vettore dei parametri stimati b si possono

determinare i valori teorici ŷ in corrispondenza:

ˆ

- a ogni vettore riga x '0 di X (dal modello: y

Xb

)

'

x

- a ogni altro vettore ipotizzato di variabili esplicative 0

Vettore delle variabili esplicative: x 0 1, X 02 ,..., X 0 k

Previsione puntuale:

'

ŷ0 x0b

yˆ o b1 b2 X o 2 ... bk X ok

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

58/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Esempio: sulla base del modello stimato, quante vendite sono

prevedibili in un supermercato con uno spazio espositivo di 200

m2 e con una spesa settimanale di promozione di 1500 euro?

(modello con le sole variabili con parametri significativi)

ŷ0 21,34 0, 499 X 02 0,540 X 03

Previsione puntuale:

ŷ0 21,341 0, 499 150 0,540 200 161,5

(161.500 Euro)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

59/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Intervallo di confidenza intorno al valore previsto

Errore di previsione

ŷ0 x0b

e0 y0 yˆ0

'

y0: valore vero di Y associato a x0 1, X 02 ,..., X 0 k

Dal modello teorico: y Xβ u

y0 x0β u0

Errore di previsione:

e0 y0 yˆ0 x0β x0' b u0 x0 (β b) u0

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

60/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

e0 y0 yˆ 0

Distribuzione dell’errore di previsione

Media nulla: E (e0 ) E[x0 (β b) u0 ] 0

normale

E (b) β; E (u0 ) 0

Varianza errore di previsione

Due componenti:

- dipendente dal termine di errore associato a ogni osservazione

E (u0 )2 u2

- dipendente dai parametri:

E[x'0 (b β)(x'0 (b β))' ] x'0 E[(b β)(b β)']x0

u2 [x'0 XX x 0 ]

1

E (b β)(b β)' u2 XX

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

1

61/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Varianza errore previsione:

Var(e0 ) u2 [1 x'0 XX x0 ]

1

Distribuzione errore previsione:

( y0 yˆ 0 ) / u [1 x'0 XX x0 ]1 2

1

Stima di u : s [

N (0,1)

n

2

12

e

/

(

n

k

)]

i

i 1

( y0 yˆ 0 ) / s[1 x'0 XX x 0 ]1 2 t (n k )

1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

62/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla

Previsione intervallare per un prefissato livello di significatività α :

yˆ0 t 2,( nk ) s 1 x0 XX x0

1

dove s 1 x0 XX x 0 è l’errore standard della previsione

1

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

63/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla - Esempio

Previsione (vendite)

161.653

Errore std previsione

22.826

Limite inferiore 95%

107.642

Limite superiore 95%

215.664

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

64/85

Copyright © 2009 – The McGraw-Hill Companies srl

La previsione attraverso il modello

di regressione multipla - Esempio

Intervallo di confidenza: ŷ0 t 2 s 1 x0 XX x0

1

t0.025,(103) 2.36

n

s [ ei2 / (n k )]1 2

18,1

i 1

Errore Standard:

1

s 1 x0 X X x 0 22,8

Intervallo di confidenza: 161.5 2.36 22.8 161.5 53.8

[107.6; 215.7]

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

65/85

Copyright © 2009 – The McGraw-Hill Companies srl

La violazione delle ipotesi

Principali ipotesi di cui verificare la eventuale violazione:

caratteristiche del modello

- linearità della relazione tra le variabili

caratteristiche dell’errore u

- varianza costante (omoschedasticità)

caratteristiche della matrice X :

- non collinearità tra le variabili esplicative

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

66/85

Copyright © 2009 – The McGraw-Hill Companies srl

Analisi dei residui

Metodo per diagnosticare la maggior parte delle violazioni di

ipotesi

Residui: ei Yi Yˆi

sono a media nulla, ma a varianza non costante

Residui standardizzati (o “studentizzati”):

ei

eis

stima dell'errore standard di ei

a varianza costante (ma media non nulla)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

67/85

Copyright © 2009 – The McGraw-Hill Companies srl

Analisi dei residui

Diagramma di dispersione dei residui:

in ordinata: ei (o ei s)

2,5

in ascissa: Ŷi (o Xji )

2

1,5

1

0,5

es i0

-0,5 0

50

100

150

200

250

-1

-1,5

-2

Ŷi

Se le assunzioni sono verificate: nuvola di punti che non

presenta particolari strutture (i punti tendono a disporsi tra i

valori –2 e 2 e risultano distribuiti casualmente intorno allo 0)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

68/85

Copyright © 2009 – The McGraw-Hill Companies srl

Analisi dei residui

Residui che si dispongono secondo qualche struttura

riconoscibile: violazione di ipotesi

Esempi:

2,5

2

2

1,5

Residui stud.

1

0,5

0

-50

-0,5 0

50

100

-1

150

200

Residui studentizzati

1,5

1

0,5

0

-0,5

-1

-1,5

-2

-1,5

-2,5

-2

-3

Vendite (valori stimati)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

Variabile X

69/85

Copyright © 2009 – The McGraw-Hill Companies srl

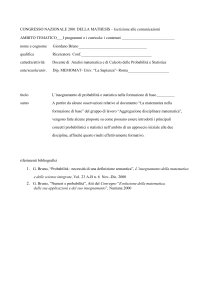

Violazione dell’ipotesi di linearità

Si diagnostica principalmente in due modi:

1. dalla struttura del diagramma

dei punti campionari (nel caso bivariato)

Esempio: Volume vendite in funzione

della durata pubblicità (Tab. 4.9)

250

Vendite * 1000€

200

150

100

50

0

0

2

4

6

8

10

Giorni di campagna pubblicitaria

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

12

14

16

Durata

pubblicità

(giorni)

Vendite

(migliaia

euro)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

20

23

34

37

40

56

60

106

107

143

166

198

211

70/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

Diagramma di dispersione dei punti campionari:

Si può stimare un modello

lineare

250

Vendite * 1000€

200

150

100

50

0

0

2

4

6

8

10

12

14

16

Ma il diagramma fa supporre

una relazione non lineare

(esponenziale)

Giorni di campagna pubblicitaria

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

71/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

2. dalla struttura del diagramma di dispersione dei residui

Diagramma di dispersione dei residui:

2

1,5

Residui stud.

1

0,5

0

-50

-0,5 0

50

100

-1

-1,5

-2

Vendite (valori stimati)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

150

200

mostra non una

disposizione casuale

intorno allo zero ma una

struttura curvilinea che

indica una relazione non

lineare

72/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

Si può risolvere con opportune trasformazioni di variabili

In particolare:

- trasformazione logaritmica della variabile esplicativa

(o di una o più delle variabili esplicative)

- trasformazione logaritmica della variabile dipendente

- trasformazione logaritmica di entrambe (dipendente ed esplicative)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

73/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

– Esempio di linearizzazione

Si ipotizza una relazione esponenziale del tipo

vendite e *gg_pubblicità u

Applicando il logaritmo naturale ad ambo i membri della

equazione di regressione si ottiene il modello linearizzato:

log(vendite) log *gg_pubblicità log u

vendite *gg_pubblicità u

Stima del modello linearizzato: regressione del logaritmo naturale

delle vendite sulla variabile esplicativa

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

74/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

– Esempio di linearizzazione

Durata

pubblicità

(giorni)

Vendite

(miliaia

euro)

Ln Vendite

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

20

23

34

37

40

56

60

106

107

143

166

198

211

2.708

2.996

3.135

3.526

3.611

3.689

4.025

4.094

4.663

4.673

4.963

5.112

5.288

5.353

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

75/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

– Esempio di linearizzazione

- Stima del modello linearizzato:

venditeSTIMA 2,553 0, 21 gg_pubblicità

(log(vendite) log * gg_pubblicità)

- Stima del modello esponenziale nella forma originaria:

venditeSTIMA 12,84 e0,21gg_pubblicità

(vendite e *gg_pubblicità )

(ln a 2.553 a e2.553 12.84)

Interpretazione di β: variazione relativa di Y in corrispondenza

a variazione unitaria di X (semielasticità di Y a X)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

76/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

– Altre trasformazioni

- Trasformazione logaritmica variabile indipendente:

Y log X

Interpretazione di β: variazione di Y in relazione ad una

variazione relativa unitaria di X

- Trasformazione logaritmica di entrambe le variabili:

Y X

logY log X

Modello a elasticità costante – interpretazione di β: misura la

variazione relativa di Y in relazione a una variazione relativa

unitaria di X (elasticità)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

77/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di linearità

Per avvalorare l’ipotesi che la relazione stimata sia lineare

nella trasformata di una o più variabili originarie si

esaminano i residui della nuova regressione e si verifica

che non presentino nessuna particolare struttura

Esempio- Diagrammi di dispersione (dopo trasformazione)

dei punti campionari:

dei residui:

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

78/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Omoschedasticità: varianza costante dei termini di errore

Var (uj) = σ2

Eteroschedasticità:

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

79/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Problemi derivanti dalla eteroschedasticità:

- le stime dei minimi quadrati sono ancora corrette

ma non sono più efficienti (a varianza minima)

- la stima della varianza, e quindi dell’errore standard,

è distorta può invalidare i test di significatività

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

80/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Diagnosticata attraverso l’analisi del diagramma di dispersione dei

residui:

- se la banda in cui giacciono i punti tende ad allargarsi

o a restringersi la varianza degli errori tende a crescere

o a decrescere al crescere della variabile esplicativa

2,5

2

2

1,5

1

0,5

0

-0,5

-1

presenza di eteroschedasticità

relazione crescente

-1,5

Residui studentizzati

Residui studentizzati

1,5

1

0,5

0

-0,5

presenza di eteroschedasticità

relazione decrescente

-1

-2

-1,5

-2,5

-2

-3

Variabile X

Variabile X

- se invece i punti giacciono tra due parallele non si

riscontra alcuna evidenza di violazione dell’assunzione

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

81/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Caso di varianza dell’errore legata a una var. esplicativa Xj

Diagnostica: Test di Goldfeld e Quandt

Fasi:

- si riordinano le osservazioni secondo i valori decrescenti di Xj

e si omettono c osservazioni centrali

- si effettuano due regressioni OLS separate sulle prime

e sulle ultime (n - c)/2 osservazioni

- si calcola il rapporto tra le due somme dei quadrati dei

residui R= RSS1/RSS2 (= rapporto tra le due varianze)

- si fa il test, considerando che sotto l’ipotesi di

omoschedasticità R si distribuisce come una F di Fisher

con (n – c – 2k)/2 e (n – c – 2k)/2 g.d.l.

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

82/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Rimedio: Metodo dei minimi quadrati ponderati (WLS)

n

f (b1 ,..., bk ) wi (Yi b1 b2 X i 2 ... bk X ik ) 2

i 1

Pesi decrescenti al crescere di σi

Se si può assumere σi proporzionale a una variabile esplicativa:

i X ij (i 1,..., n)

Trasformazione: divisione di tutti gli elementi della equazione di

regressione per Xij :

X ij

Yi

X i2

X ik ui

1

1

2

... j

...+ k

X ij

X ij

X ij

X ij

X ij X ij

Nella equazione trasformata la varianza del termine di errore

ui

'

ui

è costante: Var(u ' ) 1 2 1 2 X 2 2

i

i

ij

X ij

X2

X2

ij

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

ij

83/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

omoschedasticità

Modello teorico originario:

Yi 1 2 X i 2 ... k X ik ui

Modello teorico trasformato:

Yi

X

X

1

1

2 i 2 ... j ...+ k ik ui'

X ij

X ij

X ij

X ij

Stima OLS dei parametri:

Yi

X

X

1

b1

b2 i 2 ... b j ...+bk ik

X ij

X ij

X ij

X ij

Modello stimato nella forma originaria:

Yi b1 b2 X i 2 ... b j X ij ... bk X ik

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

84/85

Copyright © 2009 – The McGraw-Hill Companies srl

Violazione dell’ipotesi di

rango pieno della matrice X

Multicollinearità: dipendenza lineare o quasi dipendenza

lineare di due o più variabili esplicative

a.

Esatta multicollinearità: dipendenza perfetta tra due

o più variabili esplicative rango della matrice X minore

di k determinante nullo della matrice XX

impossibilità di calcolare il vettore delle stime b

1

(b XX Xy )

Soluzione:

eliminare dal modello la variabile esplicativa che risulta

esatta combinazione lineare delle altre

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

85/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità

b. Quasi multicollinearità: “quasi combinazione lineare” di una

variabile indipendente rispetto alle rimanenti o a un

sottoinsieme di esse determinante della matrice XX

prossimo allo zero notevole aumento della variabilità

delle stime

1

(b N β, 2 XX )

Spiegazione intuitiva:

- il coefficiente di regressione βj misura l’effetto di Xj su Y

a parità delle altre X

- se c’è stretta correlazione tra Xj e le altre X, quando vengono

tenute costanti queste ultime Xj varia poco

- è quindi difficile scindere l’effetto della sua variazione su Y

da quello delle altre variabili

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

86/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità

Conseguenze:

- viene meno la precisione delle stime;

- stime sensibili a piccoli cambiamenti nei dati campionari;

- si può essere indotti a scartare delle variabili non significative

che in realtà sono buone determinanti della variabile esplicativa

Diagnostica:

- Analisi matrice di correlazione tra le variabili esplicative:

valori molto elevati di rhj QM

- Regressioni ausiliarie tra ogni variabile esplicativa

e le altre k-2:

X ij b1 b2 X i 2 ... bk X ik (j = 2 ,..., k )

R2 molto elevati (es. > 0,7) QM

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

87/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità

VIF (Variance Inflation Factor)

1

VIF

1 R 2j

(R2j coefficiente di determinazione multiplo relativo alla

regressione della j-sima variabile esplicativa sulle altre k-2)

Dalla seguente espressione di Var(bj):

s2

1

Var (b j )

(n 1) Var ( X j ) 1 R 2j

Interpretazione di VIF1/2: fattore moltiplicativo dell’errore

standard di bj dovuto alla collinearità tra la variabile Xj e le

altre variabili esplicative

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

88/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità

VIF 1/ (1 R 2j )

Si sospetta Q.M. per valori del VIF > 3,5

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

89/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità

Soluzione quasi multicollinearità:

- individuare la variabile esplicativa quasi

combinazione lineare delle altre ed eliminarla dal modello

Se più di una: eliminarle progressivamente a partire

da quelle con VIF più elevato

NB: non eliminare contemporaneamente tutte le variabili

esplicative con VIF elevato (maggiore di 3.5)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

90/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità - Esempio

Campione di 22 aziende (Tab. 4.15):

Variabile risposta: volume delle vendite (Vend)

Variabili esplicative:

spese di pubblicità (Pubbli)

spese di promozione (Prom)

spese di promozionale anno passato (Prom_0)

spese di gestione (Spese)

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

91/85

Copyright © 2009 – The McGraw-Hill Companies srl

Quasi multicollinearità - Esempio

Buono l’adattamento generale del modello ai dati

Problemi di significatività per alcuni parametri

Problemi di multicollinearità per alcune variabili

Soluzione: eliminare progressivamente

dal modello le variabili “quasi

combinazione lineare” delle altre,

partendo da quella con indice VIF più

alto (Prom_0)

Nel nuovo modello:

non si riscontrano indici VIF >3,5

la variabile Pubbli è significativa

e senza problemi di collinearità

Statistica aziendale

Bruno Bracalente, Massimo Cossignani, Anna Mulas

92/85

Copyright © 2009 – The McGraw-Hill Companies srl