Gli errori nella verifica delle ipotesi

Nella statistica inferenziale si cerca di dire qualcosa di valido in generale, per la popolazione o

le popolazioni, attraverso l’analisi di uno o più campioni

E’ chiaro però che esiste comunque la possibilità di giungere a conclusioni errate, appunto

perché i miei dati rappresentano solo una parte dell’evento che sto analizzando

Formalizziamo brevemente il concetto, in parte già visto, di errore (di errori) nel processo di

verifica delle ipotesi

Premessa (riassunto di argomenti già trattati)

PRIMA di effettuare un test statistico viene scelto un livello di significatività, α

Questo livello di significatività determina i valori critici della statistica test (z, t, chi-quadro, ecc). I

valori critici definiscono nella distribuzione teorica della statistica, distribuzione attesa nel caso

sia vera l’ipotesi nulla (la distribuzione nulla, appunto), le regioni di accettazione e di rifiuto

Il livello di significatività prescelto viene anche utilizzato come confronto se si segue l’approccio

del p-value: il p-value calcolato viene confrontato con α

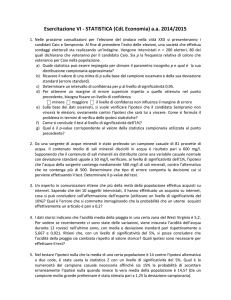

Supponiamo ora di aver scelto α =0.05 (scelta tipica), e supponiamo di condurre un test

bidirezionale (a due code)

La regione di rifiuto nella distribuzione nulla include il 5% dei valori più estremi della statistica

(2,5% dalla parte dei valori molto grandi, e 2,5% dalla parte dei valori molto piccoli)

Questi sono valori estremi che comunque possiamo otterremmo, con una probabilità del 5%,

anche se fosse vera l’ipotesi nulla

• Se ripetessimo tante volte il test su campioni diversi, e l’ipotesi nulla fosse sempre vera, il

5% dei test porterebbe ad un valore della statistica test all’interno della zona di rifiuto (e ad

un p-value inferiore a 0.05)

• Quindi, nel 5% di questi test, rifiuteremmo l’ipotesi nulla vera

Distribuzione nulla per la statistica test z.

Se è vera l’ipotesi nulla, e ripetessi il test molte volte su campioni diversi,

α x 100 delle volte quest’ipotesi vera verrebbe erroneamente rifiutata

In pratica, se la statistica calcolata in un singolo test cade nella regione di rifiuto, o il p-value <α,

la conclusione del test è quella di rifiutare l’ipotesi nulla.

• Ma, per quello che abbiamo appena detto, l’ipotesi nulla potrebbe anche essere vera ma

per puro effetto del caso (errore di campionamento) i dati portano ad una statistica test

significativa (che cade cioè nella regione di rifiuto e che ha un p-value <α)

L’errore che si compie rifiutando un’ipotesi nulla vera si chiama

Errore di primo tipo

o errore di prima specie, o errore do tipo I

La probabilità di compiere un errore di primo tipo è data dal livello di significatività α prescelto

E’ la frazione di volte che viene rifiutata un ipotesi nulla vera se ripetessi tante volte il test su

campioni diversi (presi dalla stessa, o dalle stesse, popolazione/i)

Scegliendo in anticipo α, definiamo il rischio che siamo disposti ad accettare di compiere un

errore di primo tipo

Alla fine del test, se le evidenze saranno a favore dell’ipotesi alternativa, non sapremo

ovviamente se avremo commesso un errore di primo tipo oppure no. Potremo solo dire che la

probabilità di averlo commesso, se fosse vera l’ipotesi nulla, sarebbe molto bassa (e pari ad α)

La probabilità complementare (1- α) viene chiamata livello di protezione di un test, ed è

appunto la probabilità di non rifiutare l’ipotesi nulla quando l’ipotesi nulla è vera. Un test con un

altro livello di protezione è detto conservativo

• Un test molto conservativo può essere visto come un test che vuole rischiare molto poco

di fare un errore di primo tipo, che sappiamo essere un errore molto grave perché rifiutare

l’ipotesi nulla è una decisione forte (come condannare un imputato) mentre non rifiutarla

non significa in realtà accettarla (ma solo dire che i dati sono compatibili con essa)

Da notare che nel calcolo degli intervalli di confidenza (utilizzati nella stima di un parametro,

non nella verifica di ipotesi), il termine 1- α prende il nome di grado di confidenza

Riassumendo, se l’ipotesi nulla è vera, può succedere che:

Vediamo ora un altro tipo di errore che si può commettere nella verifica delle ipotesi

Se l’ipotesi nulla è falsa, cioè per esempio la media nella popolazione 1 è diversa dalla media

nella popolazione 2, giungerò sempre al suo rifiuto analizzando due campioni?

• Ovviamente no, e anche intuitivamente è facile capirne un motivo: se le medie nelle due

popolazioni sono diverse ma molto vicine, è possibile che i dati non siano sufficienti a

escludere l’ipotesi nulla, visto che l’ipotesi nulla viene rifiutata solo in presenza di forti

evidenze

L’errore che si compie quando un’ipotesi alternativa è vera ma la conclusione del test è quella

che non è possibile escludere l’ipotesi nulla, ovvero, l’errore che si compie non rifiutando

un’ipotesi nulla falsa, si chiama

Errore di secondo tipo

o errore di seconda specie, o errore do tipo II

La probabilità di commettere un errore di secondo tipo viene generalmente indicato con il

simbolo β

La probabilità complementare, (1- β), ossia la probabilità di rifiutare correttamente un ipotesi

nulla falsa, si chiama potenza del test

• Maggiore è la potenza di un test, maggiore sarà la possibilità del test di identificare come

corretta l’ipotesi alternativa quando questa è effettivamente vera

La probabilità di fare un errore di secondo tipo, ovvero il rischio di non rifiutare un’ipotesi nulla

falsa, e di conseguenza la potenza di un test, non si può stabilire a priori

• Dipende infatti dalla distanza tra ipotesi nulla e alternativa (per esempio, la differenza tra

µ1 e µ2), distanza che è ignota

• Dipende dalla varianza delle variabili in gioco, che non può essere modificata

La probabilità di fare un errore di secondo tipo, però, dipende anche dal numero di osservazioni

e dal livello di significatività α prescelto. Quindi:

• è possibile ridurre l’errore di II tipo (e quindi aumentare la potenza) aumentando la

dimensione campionaria

• è possibile ridurre l’errore di II tipo (e quindi aumentare la potenza) aumentando il livello di

significatività α (ma questa scelta ci espone a maggiori rischi di errore di tipo I)

E’ possibile studiare la potenza di un test attraverso l’analisi della potenza

Completiamo intanto la tabella degli errori

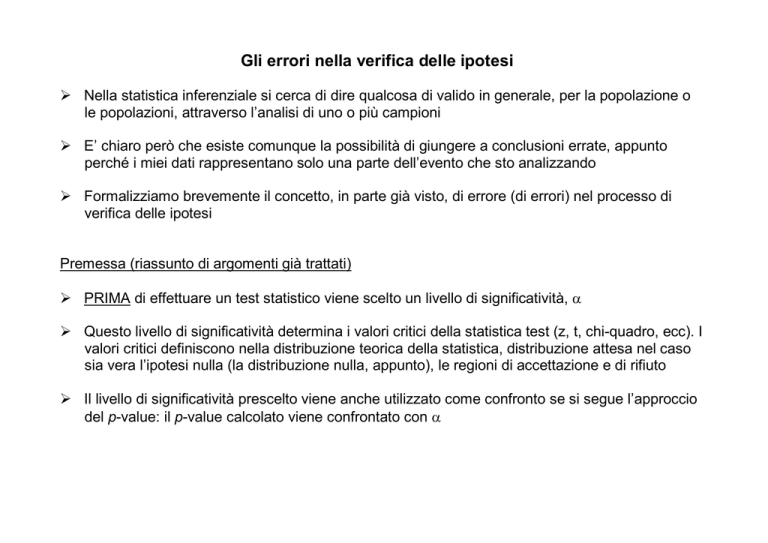

Cerchiamo ora di capire graficamente l’errore di secondo tipo

• Supponiamo di svolgere un test z a una coda per verificare le seguenti ipotesi

H0: µ = µ0 = 1.5

H1 : µ ≠ µ0

• Abbiamo già visto cosa succede quando l’ipotesi nulla è effettivamente vera (si rischia di

commettere un errore di primo tipo)

• Vediamo ora cosa succede quando l’ipotesi nulla non è vera

In questo caso, per capire e calcolare l’errore di secondo tipo è necessario

assumere che sia vera una ipotesi alternativa precisa. Assumiamo che sia vera

l’ipotesi alternativa µ = 1.45

Concentriamoci per ora sulla parte inferiore della figura, specifica per un campione con n = 36

osservazioni con σ =0.1 e α = 0.01

• Le due distribuzioni a campana rappresentano le distribuzioni delle medie campionarie

secondo l’ipotesi nulla (in viola) e secondo l’ipotesi alternativa (in blu)

• Le due linee rosse verticali rappresentano i limiti dell’intervallo all’interno del quale una

media campionaria verrebbe considerata compatibile con l’ipotesi nulla

Quei limiti, standardizzati, porterebbero ai valori critici nella tabella di z di - 2.576 e

2.576

L’area ombreggiata in giallo è la probabilità di commettere un errore di tipo II

• Infatti, quando è vera l’ipotesi alternativa, la media campionaria ha una probabilità pari

all’area in giallo di cadere nella regione di accettazione (stabilità ovviamente sulla base

della distribuzione nulla)

L’area ombreggiata in verde è quindi il potere del test, ovvero la probabilità di rifiutare

correttamente l’ipotesi nulla quando questa è falsa (come nel caso considerato)

E facile capire da questo grafico che

• 1. Maggiore è la distanza tra ipotesi alternativa (che stiamo considerando vera) e l’ipotesi

nulla (che stiamo considerando falsa), maggiore sarà la potenza del test

Logico: se l’ipotesi alternativa è molto diversa da quella nulla ipotizzata, sarà facile

scoprirlo

• 2. Minore è la dispersione della variabile, minore sarà la varianza della media

campionaria, più strette saranno le corrispondenti distribuzioni, e maggiore sarà la

potenza del test

Logico: se gli individui sono tutti molto simili, anche pochi sono sufficienti per

stimare bene la media della popolazione e verificare se è diversa da µ0

• 3. Maggiore è l’α prescelto, maggiore sarà la potenza del test

Logico: se per rifiutare l’ipotesi nulla mi accontento di moderate differenze tra i dati e

quanto predetto dall’ipotesi nulla, tenderò a rifiutarla maggiormente quando è vera

l’ipotesi nulla ma anche quando è vera l’ipotesi alternativa

• 4. Maggiore è la dimensione campionaria, minore sarà la varianza della media

campionaria, più strette saranno le corrispondenti distribuzioni, e maggiore sarà la

potenza del test

Logico: con molti dati “scovo” meglio un’ipotesi alternativa vera

Attenzione: per ogni dato test statistico, possiamo aumentare la potenza solo agendo su sul

punto 3 (ma ciò comporta un aumento del rischio di errore di tipo I) e sul punto 4. I punti 1 e 2

non sono sotto il nostro controllo

• In realtà, poiché per ogni tipo di problema statistico esistono generalmente più test

diversi a disposizione (con caratteristiche diverse), e i test che fanno più assunzioni (per

esempio sulla distribuzione della variabile) sono di solito più potenti, è anche possibile

aumentare la potenza di un test scegliendo il test più potente (ovviamente se le

condizioni imposte da quel test sono soddisfatte dai dati)

Provate voi stessi come varia il potere di semplice un test in funzione di α, n, σ, e la distanza tra

la µ vera e la µ0 ipotizzata dall’ipotesi nulla:

http://bcs.whfreeman.com/ips4e/cat_010/applets/power_ips.html

Cosa si poteva vedere nella parte superiore della figura discussa in precedenza?

L’analisi della potenza e la sua importanza

Fare un analisi della potenza significa essenzialmente determinare la potenza di un test in

diverse condizioni, ovvero in funzione di α, n, σ, e della distanza tra ipotesi alternativa e ipotesi

nulla

Nel test appena visto, il calcolo della potenza è semplice (si fa con il calcolatore ma si poteva

fare anche a mano). In altri casi è molto più complesso

E’ molto importante perché ci permette di capire quale probabilità abbiamo di accettare

erroneamente l’ipotesi nulla quando invece è vera una specifica ipotesi alternativa

Supponiamo per esempio di avere la possibilità di determinare una certa variabile fisiologica in

un gruppo di 5 pazienti, per poterne confrontare la media con l’ipotesi nulla che la media nella

popolazione sia pari ad un certo valore medio standard, diciamo 12 (sospettando per esempio

che la patologia dei pazienti possa aver alterato la variabile fisiologica che vogliamo

analizzare). Supponiamo anche di conoscere la deviazione standard della variabile (così che

sia possibile applicare un test z) e che questa sia pari a 3

Dopo aver fatto l’analisi in laboratorio e il test statistico, e aver trovato che l’ipotesi nulla non

può essere rifiutata, o meglio ancora prima di cominciare le analisi, potremo chiederci:

• qual è la probabilità di non accorgerci (con un certo α = 0.05) che la media della

popolazione da cui abbiamo estratto il campione non è quella specificata dall’ipotesi

nulla (µ0 = 12), ma é invece pari ad valore specifico di interesse, per esempio di

interesse perché indice di una grave patologia?

Ci interessa cioè capire se, nell’ipotesi che i pazienti abbiano per esempio un media della

variabile studiata alta in maniera preoccupante, per esempio µ = 14, tale differenza verrebbe

identificata con il campione a disposizione

• in generale, la scelta del valore di µ da analizzare nell’analisi della potenza dovrebbe

identificare un valore di media particolarmente anomalo, che se fosse veramente la

media della popolazione dalla quale abbiamo estratto il campione che stiamo

analizzando vorremmo che venisse evidenziata con alta probabilità

Utilizzando l’applet al calcolatore con

•

•

•

•

•

α = 0,05

n=5

σ=3

µ0 = 12 (valore standard previsto dall’ipotesi nulla)

µ = 14 (valore ipotizzato per l’ipotesi alternativa)

La potenza è pari a 0.316

Questo significa che se la media della popolazione fosse 14, avrei circa il 32% di probabilità di

identificare con un campione di 5 individui questa deviazione dall’ipotesi nulla. Ma avrei anche

una probabilità molto alta (il 68% circa) che pur con una notevole deviazione della popolazione

rispetto a quanto previsto dall’ipotesi nulla (14 rispetto a 12), questa deviazione non verrebbe

identificata

Una situazione pericolosa, quindi, ci potrebbe sfuggire con alta probabilità (il 68%),

suggerendoci per esempio di aumentare la dimensione campionaria (e aumentare quindi la

potenza del test)