Dove il p-value fallisce

Se dovessi essere qualcosa, mi piacerebbe essere un bayesiano, ma preferisco non essere

nulla.

Non mi è mai piaciuta l’idea di dover agire in modo predittibile, consistentemente con la

filosofia di qualcun altro. Molti anni fa mi divertivo a sfidare i miei studenti con i

“contro-esempi” alla idea diffusa di Neyman-Pearson-Wald sugli intervalli di confidenza

e sui test di ipotesi, aventi tutti un sapore Bayesiano, ovviamente. Ma mi sono sempre

rifiutato di trovare distribuzioni “a priori” per ogni cosa facessi e non sono mai sceso a

patti con le distribuzioni “a priori” oggettive. Inoltre, ho visto il fallimento del tentativo

di Fisher di mettere assieme una filosofia inferenziale omnicomprensiva usando i pvalues, probabilità fiduciarie, condizionamenti su opportune ancillari e così via. Bayes:

troppo preciso per essere usato. Fisher: troppo frammentato. NPW: risposte corrette a

domande sbagliate.

Meglio non essere in debito con alcuna filosofia, mi sono detto, fai solo ciò che ti sembra

ragionevole ad ogni istante prefissato. Naturalmente, questo mi espone al ridicolo

secondo le osservazioni scritte da Keynes “Gli uomini pratici che credono di essere

abbastanza esenti da qualsiasi influenza intellettuale, sono spesso schiavi di qualche

economista defunto.” Tutti questi pensieri mi sono venuti in mente recentemente,

quando sono stato coinvolto in una consulenza alquanto delicata.

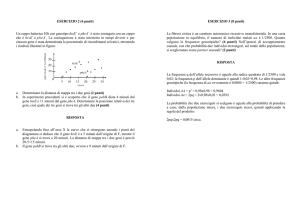

Un gruppo di ricerca stava effettuando l’analisi di diverse centinaia di geni in un

modello organismo C-elegans (un verme) per individuare quei geni la cui funzione era

determinante per una risposta neuronale. Lungo un periodo di circa due anni, hanno

cresciuto lotti di vermi settimanalmente, testando 5 geni in ogni lotto. Il test consisteva

nell’eliminare l’espressione di un gene in 10-15 vermi di un lotto per poi confrontare le

loro misure neuronali con quelle di 15-30 vermi scelti dallo stesso lotto, o da un altro

trattato all’incirca allo stesso modo di quello precedente. Il confronto è stato fatto con un

t-test per due campioni. La difficoltà è sopraggiunta allorquando i ricercatori hanno fatto

qualcosa di assolutamente ragionevole dal punto di vista di uno scienzato: si raccolgono

un maggior numero di dati su un sottoinsieme selezionato di gene, allo scopo di

rafforzare le conclusione per quei geni. Essi ripetevano il test con vermi di nuovi lotti se

il p-value era piccolo ma non troppo (ossia compreso tra 0.01 e 0.05) oppure se il gene era

di un qualche interesse e il valore del p-value era compreso tra 0.05 e 0.1. Se per qualche

motivo, non ritenevano ragionevoli i risultati provenienti dal gruppo di controllo in un

giorno particolare, ossia i valori erano troppo alti o troppo bassi o tutti gli esperimenti

avevano dato risultati o troppo alti o troppo bassi, allora erano maggiormente indotti a

ripetere l’esperimento. Un maggior numero di test è stato condotto su circa 100 geni, per

la maggior parte di questi il test è stato ripetuto solo una volta, ma per altri anche più di

una volta, per qualcuno anche fino a 10 volte.

Però non ritengo necessario riportare qui i dettagli precisi.

Ci terrei a sottolineare l'aspetto soggettivo delle decisioni prese dai ricercatori, nel senso

che la decisione di collezionare un maggior numero di dati su un certo gene dipendeva

dai dati acquisiti. Inoltre è impossibile simulare il processo assumendo un qualche

modello statistico, nullo o altro, per i dati. Il mio libro favorito di statistica dice: niente

modello, niente inferenza. La mia parafrasi è: niente simulazione, nessun p–value. Tutto

qui? Allora con questi dati non possiamo concludere nulla? Non voglio spiegare qui ciò

che eventualmente raccomando, ma questo esperimento mi riporta indietro a un piccolo

libro “The foundation of statistical inference”, che non ho più sfogliato da circa 40 anni,

memoria di un seminario di Savage sulla probabilità soggettiva e la statistica pratica.

Svoltosi a Londra alla fine di luglio del 1959, ad una platea selezionata di non–credenti,

con uno o due studenti credenti, il libro contiene la prima (e forse l’ultima) discussione

ad ampio raggio ed amichevole dei pro e contro nell’essere nella pratica un Bayesiano

soggettivo. Perché è rilevante qui? Perché la dipendenza delle analisi dei dati dal criterio

di arresto appare un paio di volte, e in quel contesto Savage fa una deliziosa confessione

pubblica che tutti coloro che hanno a che fare con l’inferenza statistica dovrebbero

leggere. A quel tempo si riteneva che un bayesiono avrebbero potuto ignorare i criteri di

arresto, come a dire la differenza tra una binomiale positiva e negativa, e analizzare i

dati disponibili alla fine. Solo più tardi si comprese che qualcuno dei criteri di stop

poteva essere informativo, cioè poteva aggiungere qualcosa circa il valore dei parametri

non noti. Credo che oggigiorno il consiglio recepito sia che i Bayesiani possono ignorare i

criteri di arresto non informativi, laddove io non tenterò di definire questo termine.

L’importanza di ciò in relazione al mio problema di consulenza dovrebbe essere chiaro,

ma allora mi chiedo i criteri di arresto degli scienziati sono non-informativi? Se è così,

allora noi possiamo (e dovremmo, se siamo bayesiani) solo collezionare i dati su un dato

gene, ignorare la natura di fine e di inizio dei dati collezionati e fare l’equivalente

Bayesiano di un t-test o di uno z-test.

Una cosa è chiara nella mia mente: non ci sono p-values per tutti questi dati.

(traduzione a cura di E. Di Nardo)