Simona Balbi

Professore Ordinario di Statistica

Università di Napoli “Federico II”

http://unina.academia.edu/SimonaBalbi/

Nuovi metodi di classificazione automatica

Obiettivo della lezione è illustrare alcune tecniche di classificazione particolarmente

interessanti per affrontare problemi di categorizzazione dei documenti, ponendo

attenzione, in particolare, all’ottica del co-clustering di termini e documenti. Si

illustrerà come, anche quando l’obiettivo della classificazione sia rivolto ad un’unica

dimensione (di solito i documenti), possa risultare vantaggioso procedere a

raggruppamenti di righe e di colonne, sulla base dell’ottimizzazione di un opportuno

criterio. La motivazione è prima di tutto di natura computazionale, ma nel caso

specifico di tabelle documenti x termini, l’identificazione di gruppi di parole, non

necessariamente contigue, risulta essere maggiormente informativo dal punto di vista

dell’analisi del contenuto. Nel corso della lezione si illustreranno alcuni algoritmi noti

in letteratura, spesso sviluppati nell’ambito dell’analisi di espressione genica, ma con

applicazioni anche di text mining, ed alcune proposte meno note nate nell’ambito

dell’analisi dei dati testuali. Alcuni casi studio correderanno la presentazione.

Introduzione di informazione esterna per la visualizzazione del contenuto di

tabelle lessicali

Nell’analisi di dati di questionari sovente l’attenzione viene posta al trattamento

congiunto di risposte a domande aperte e a domande chiuse. Il caso tipico è quello

dell’analisi di una tabella lessicale aggregata, quando vengono costruiti gruppi di

rispondenti, sulla base della risposta da loro fornita ad una domanda chiusa.

L’obiettivo è analizzare le risposte aperte fornite, ad esempio, dai “giovani” o dalle

“donne anziane”. In questi casi, il tipico trattamento è l’analisi delle corrispondenze

lessicali. Si discuterà l’opportunità del ricorso ad una variante quale l’analisi non

simmetrica delle corrispondenze, al fine di tenere conto della relazione di dipendenza,

ad esempio, del vocabolario dalla caratteristica socio-demografica considerata.

Ulteriori esempi di trattamento congiunto di dati numerici e testuali verranno

illustrati, tratti da problemi di ricerche di mercato, quali la definizione del

prodotto/servizio ideale, in un contesto di conjoint analysis o quando si voglia

introdurre informazione esterna, oltre che sugli individui, anche sulle parole.

Sergio Bolasco

Professore ordinario di Statistica

SAPIENZA Università di Roma

http://geostasto.eco.uniroma1.it/utenti/bolasco/

Strumenti per l'estrazione di informazione e analisi statistiche

multidimensionali

In questa lezione si integrano tecniche per la selezione dell’informazione a livello

lessicale con analoghi strumenti per l’estrazione di entità di interesse a livello

testuale. Queste attività, finalizzate a processi di ETL (trasformazione di dati non

strutturati in informazioni strutturate), permettono di arricchire la matrici di

dati da sottoporre ad analisi con tecniche multidimensionali.

1

Nella sessione si presentano in maniera intuitiva i fondamenti delle tecniche di

riduzione dei dati: processi di mapping e interpretazione degli assi fattoriali,

nonché i criteri per interpretare una cluster analysis di documenti, applicata a

tabelle lessicali.

Casi di studio sulla costruzione di risorse statistico-linguistiche, esempi di

linguistica dei corpora e individuazione di dimensioni semantiche latenti.

La lezione è incentrata sui fondamenti per la costruzione di risorse statisticolinguistiche (dai lessici di frequenza alle grammatiche locali), nonché su casi di

categorizzazione automatica di documenti sia in forma deterministica e univoca,

sia di tipo fuzzy e quindi plurima.

Si illustrano alcune applicazioni reali con l’uso della piattaforma Taltac 2.10, in

filiera con l’utilizzo di tecniche statistiche multidimensionali (software Spad) per

analisi di contenuto e individuazione di modelli di senso su raccolte di documenti

semi-strutturati (rassegne stampa), domande aperte in questionari, diari

individuali, recensioni, forum.

Domenica Fioredistella Iezzi

Professore Associato di Statistica Sociale

Università di Roma “Tor Vergata”

http://www.filosofia.uniroma2.it/docenti/iezzi/index.html

Analisi esplorative per la visualizzazione di dati testuali

La trasformazione di un’informazione non strutturata in un dato strutturato produce,

generalmente, matrici di dati sparse, che sono scarsamente maneggevoli e non

visualizzabili. Questo problema è noto in letteratura con il nome di “maledizione della

dimensionalità”. Per contrastarlo è possibile eseguire un’operazione di riduzione delle

dimensioni della matrice sparsa, cercando, contemporaneamente, di perdere il minor

contenuto informativo possibile. Tra i metodi più noti in letteratura troviamo l’Analisi

in Componenti Principali, l’Analisi delle Corrispondenze Lessicali e lo Scaling

Multidimensionale.

La lezione ha l’obiettivo di mostrare delle applicazioni con le tecniche citate,

presentando punti di contatto e differenze tra i diversi metodi proposti. Gli esempi

saranno sviluppati mediante l’ausilio del software R.

Introduzione al text clustering

La clusterizzazione dei documenti rappresenta un ambito rilevante di applicazioni nel

campo del text mining. La maggior parte degli algoritmi proposti in letteratura utilizza

un approccio vettoriale, impiegando, generalmente, la matrice “bag-of-words’” per

rappresentare i testi e classificarne i contenuti.

Obiettivo della lezione è illustrare le principali caratteristiche degli algoritmi di text

clustering più utilizzati in letteratura. Si impiegheranno vari sistemi di pesi (binario,

di frequenza e TFIDF) e diverse matrici di prossimità (euclidea e del coseno). I casi di

studio, sviluppati durante la lezione, consentiranno di mostrare le peculiarità di

ciascun approccio.

Gli esempi saranno sviluppati con l’ausilio del software R.

2

Ludovic Lebart

Telecom - Paris-Tech

Direttore di ricerche del CNRS

http://www.dtmvic.com/05_SoftwareI.html

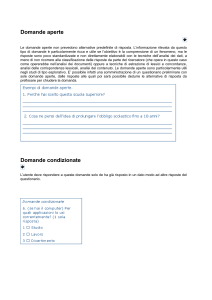

Il trattamento delle domande aperte nelle indagini campionarie e strumenti di

visualizzazione di base

Le domande aperte sono utilizzate in indagini socio-economiche, epidemiologiche,

marketing, ricerche di mercato. Esse rilevano aspetti essenziali per la ricerca,

soprattutto quando i temi trattati sono complessi o poco conosciuti. L’elaborazione di

risposte aperte è una sfida sia per gli statistici sia per gli specialisti che si occupano di

analisi del testo. La lezione avrà l’obiettivo di mostrare una serie di esempi di

trattamento di domande aperte e di discutere alcune varianti di pre-processing.

Si esamineranno, inoltre, gli strumenti di visualizzazione di base, come le analisi

fattoriali (analisi delle componenti principali e analisi delle corrispondenze) e i metodi

di clustering, che svolgono un ruolo importante nell'esplorazione informatizzata dei

corpora testuali. Queste tecniche, infatti, mostrano gruppi di parole e di individui,

evidenziano associazioni tra unità di senso; riescono a disambiguare un testo mediante

l'attribuzione dello stesso a una categoria di intervistati o ad un determinato periodo.

Altri strumenti di visualizzazione. Tecniche di validazione per ricampionamento

In questa lezione, saranno descritte altre tecniche di visualizzazione come il Self

Organizing Maps: SOM, minimum spanning tree e alcuni metodi di validazione di

risultati. In particolare, sarà illustrata la tecnica di ricampionamento bootstrap, che

permette di individuare delle aree di confidenza (ellissi o convex hulls) intorno ai

punti rappresentati sulle principali mappe, se i punti sono parole o testi. Si esaminano

in dettaglio diverse varianti di questa tecnica: il total bootstrap e il partial bootstrap

sia dal punto di vista teorico che applicativo.

Céline Poudat

Assistant professor of Linguistics- University of Paris 13

http://poudat.net/

A practice of textual data analysis with DtmVic and Lexico3.

This course is the practical application of Ludovic Lebart's conferences on

visualization and validation of textual data using DtmVic and Lexico3. The students

will develop skills in visualization tools (principal axes methods complemented with

clustering techniques, self organizing maps). Characteristic elements of partitions

(words, sentences) will also be presented both using the software DtmVic for the

computation of characteristic textual units, and Lexico3 for the computation of

chronological specificities. The course deals also with Lexico3 functionalities

regarding text sequentiality (section maps), and with the various validation techniques

available in DtmVic (bootstrap). A set of corpora will be provided together with the

software packages and the users guides.

3