Michael Skeide

Algebra

per

l’Informatica

Michael Skeide

Dipartimento S.E.G.e S.

Università degli Studi del Molise

Via de Sanctis, 86100 Campobasso, Italia

E-mail: [email protected]

Homepage: http://www.math.tu-cottbus.de/INSTITUT/lswas/ skeide.html

Prefazione

Questo testo contiene le lezioni del corso “algebra per l’informatica” di 6 crediti (48 ore), che

ho tenuto nel secondo semestre dell’anno academico 2003/04 alla Sede d’Isernia dell’Università degli Studi del Molise, e qualche supplemento per quale non ho trovato il tempo necessario.

Questi supplementi sono riconoscibili o dalla stampatura a caratteri piccoli o come sezioni

intere che portano “Appendice: ...” nel titolo, e non fano parte della materia che lo studente

dovrebbe avere presente all’esame. È, però, senz’altro possibile che la lettura dei supplementi

aiuterà di trovare qualche soluzione di un problema posto nell’esame. Spero, comunque, che i

supplementi facciano piacere a tutti quelli che vogliono approfondire la materia del corso e che

possano rispondere a qualche domanda che non abbiamo potuto trattare durante il corso.

Come libri di testo posso raccomandare i libri [Art97] di M. Artin, [Fac00] di A. Facchini,

[Her82] di N. Herstein ed i due libri [Lan70, Lan90] di S. Lang (di quali il secondo è più adatto

ma disponibile solo in inglese). Però nessuno di questi libri è adatto di sostituire il testo presente.

L’unico libro di livello adeguato è quello [Fac00] di Facchini, che tratta però molto di più che

si possa fare in un solo corso. Quello però che rimane da questo libro dopo la cancellazione

di qualche sezione o qualche capitolo, non è più abbastanza coerente per formare la base di un

corso autonomo.1

La risposta alla domanda se per passare l’esame si deva esguire anche qualche dimostrazione è un deciso “si!”. Quello che voglio insegnare non sono ricette per fare qualche calcolo

che non funzionano più quando le ipotesi sono variate minimamente. (Il peggio sarebbe se le

ricette siano applicate senza una verifica delle ipotesi, producendo un risultato che non valga

assolutamente nulla.) Piuttosto volgio mettere in grado quello che impara, di valutare in modo

autonomo se una procedura suggerita gli porti alla destinazione. La verifica che un’affermazione

sia vera è solo un altro modo di dire “fare una dimostrazione”, perciò non dovrebbe avere nulla di spaventoso. Piuttosto di specificare in che cosa consiste una dimostrazione matematica,

voglio quotare un passaggio del libro di M. Artin [Art97, pagina 691].

1

Inoltre vorrei raccomdandare il romanzo “Il Teorema del Papagallo” di Denis Guidj [Gue03]. Si tratta di un

compendio della storia della matematica fino agli inizi del ventesimo secolo nascosto in un giallo di notevole livello

di costruzione del plot (assai improbabile ma per niente impossibile). Spero che i tentativi di spiegare perché la

gente aveva iniziato a rispondere a domande matematiche possano trasportare un po del fascino che la matematica

ha per me.

i

ii

Ciò che i matematici considerano un modo approprio di presentare una dimostrazione non è definito con chiarezza. Di solito, non vengono date dimostrazioni

complete, nel senso che ogni passo consiste nell’applicare una regola di logica al

passo precedente. Una dimostrazione siffatta risulterebbe troppo lunga, e inoltre i

punti principali non sarebbero messi in evidenza. D’altra parte, tutte le difficoltà

nei passaggi dimostrativi sono certamente incluse. Chi legge la dimostrazione dovrebbe essere in grado di completare tutti i dettagli necessari per comprenderla.

L’abilità nello scrivere una dimostrazione si acquista soltanto con l’esperienza.

In questo spirito, quanto sia dettagliata una dimostrazione dipende dal livello su quale ci troviamo, ma anche dal livello del problema. Se chiedo una dimostrazione del fatto che 0x = 0 per

ogni vettore x, è chiaro che esigo una riduzione agli assiomi degli spazi vettoriali. In un’altra

dimostrazione tale formula sarà utilizzata (come piccolo passo intermedio) senza neanche menzionare che si tratta di un risultato che sia già stato dimostrato altrove. Come correttore, nella

primo caso voglio vedere se il candidato è in grado di verificare (cioè di dimostrare) la validità

di una formula, mentre nel secondo caso accetto tutte le formule usate finché non siano sbagliate

(o rispetto al livello del corso troppo ingiustificate).

Alla fine ho l’immenso piacere di ringraziare lo studente Bruno Maddalena per un lavoro

svolto con grande efficienza ed accuratezza eliminando qualche centinaia (o migliaia) di errori

linguistici dalle prime versioni di queste dispense. È chiaro però che la risponsabilità per gli

errori presenti (nouvi e vecchi, che ci sarano, come in tutti i libri, anche dopo la ennesima

revisione) rimane tutta mia.

Michael Skeide, estate 2004

Indice

Prefazione

i

Introduzione

1

1

Notazioni di base riviste

3

1.1

Insiemi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

1.2

Funzioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.3

I numeri naturali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

1.4

Appendice: Definizioni ricorsive . . . . . . . . . . . . . . . . . . . . . . . . .

19

2

3

4

Relazioni

23

2.1

Definizioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

23

2.2

Ordinamenti . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

2.3

Equivalenze . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

2.4

Classe di equivalenza . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

26

2.5

Appendice: Supplementi sulla cardinalità . . . . . . . . . . . . . . . . . . . .

27

Gruppi, monoidi e semigruppi

31

3.1

Definizioni e primi risultati . . . . . . . . . . . . . . . . . . . . . . . . . . . .

31

3.2

Monoidi e gruppi ciclici . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

3.3

Esempi di (semi)gruppi di matrici . . . . . . . . . . . . . . . . . . . . . . . .

39

3.4

Omomorfismi ed isomorfismi . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

3.5

Esempio: Permutazioni e gruppi finiti . . . . . . . . . . . . . . . . . . . . . .

49

3.6

Quozienti (semigruppi) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

3.7

Quozienti (gruppi) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

59

Cenni sugli anelli e campi

63

4.1

Campi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

4.2

Anelli . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

65

4.3

La formula del binomio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

4.4

Polinomi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

68

4.5

Appendice: Ideali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

72

iii

Indice

iv

5 Algebra lineare

73

5.1

Spazi vettoriali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

74

5.2

Funzioni lineari (operatori) . . . . . . . . . . . . . . . . . . . . . . . . . . . .

76

5.3

Sottospazi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

80

5.4

Quozienti (spazi vettoriali) . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

5.5

Somme dirette . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

82

5.6

Sottinsiemi generanti . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

84

5.7

Indipendenza lineare . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

5.8

Basi e dimensione . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

88

5.9

Appendice: Il lemma di Zorn e l’esistenza di basi . . . . . . . . . . . . . . . .

93

5.10 I numeri complessi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

95

5.11 Equazioni lineari . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

99

5.12 Appendice: Esempi di alcuni matrici particolari . . . . . . . . . . . . . . . . . 111

5.13 Il determinante . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

5.14 Appendice: Calcolo di qualche complessità . . . . . . . . . . . . . . . . . . . 118

5.15 Appendice: Cenni di autovalori e autovettori di matrici . . . . . . . . . . . . . 121

Bibliografia

127

Index

129

Introduzione

L’algebra può essere considerata la teoria delle strutture astratte. Per esempio l’insieme R di

tutti i numeri reali è dotato di tante strutture (addizione, moltiplicazione, potenze, ordinamento,

modulo, etc.). Guardandole tutte insieme corriamo il pericolo di perderci fra troppi dettagli.

Per esempio l’insieme R con le operazioni di addizione e moltiplicazione è quello che più

tardi chiameremo un campo. (La definizione di campo è proprio motivata dalle proprietà dei

numeri nei calcoli elementari.) Però queste sono già due operazioni e per non confondere le

proprietà che seguono da ogni operazione con quelle che possono essere dimostrate solo guardandole insieme, occorre di considerare prima le operazioni individualmente. Solo i risultati,

che non possono essere dimostrati in questo modo sono risultati propri sui campi.

Guardando l’insieme R con la sola operazione di addizione abbiamo quello che chiameremo un gruppo, addirittura un gruppo abeliano perché l’addizione è commutativa. Ma anche

l’insieme R senza lo 0 con la sola operazione di moltiplicazione è un gruppo (abeliano). Quindi

analizzando le proprietà dei gruppi abeliani astratti con ogni teorema su gruppi (per esempio

l’unicità dell’identità) non solo dimostriamo subito due teoremi su R o un qualsiasi altro campo,

ma su ogni insieme dotato di un’operazione che siamo in grado di indentificare come gruppo.

(In effetti, la notazione del gruppo non ha origine nella teoria dei campi ma nella teoria delle

trasformazioni di un insieme.)

Fare astrazioni è, quindi, un problema dell’economia dei pensieri. Più realizzazioni concrete

la struttura ha, più applicazioni hanno i risultati:

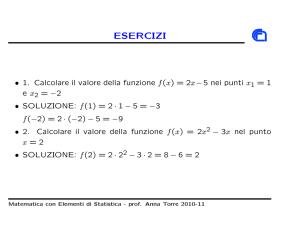

esempio

concreto

astrazione /

esempi

u:

uu

u

u

uu

uu

u

u

uu

/ teoremi uI

/ esempi

II

II

II

II

II

II

I$

struttura

astratta

esempi

Un altro aspetto consiste nel problema di descrivere proprio tutti gli esempi, diciamo di

1

2

Introduzione

classificare tutte le realizzazioni. Un esempio che vedremo più tardi sono le classificazioni

di matrici. Come dice la parola stessa, classificare significa suddividere in classi. Il fatto che

esiste più di una classificazione di matrici, dipende dal fatto che ci sono diverse possibilità di

decidere quando due matrici sono membri della stessa classe. Il concetto fondamentale della

classificazione è rappresentato dalle relazioni di equivalenza.

Capitolo 1

Notazioni di base riviste

Dopo l’introduzione dovrebbe essere chiaro che le strutture sono espresse con l’aiuto di funzioni

fra insiemi. Il primo obiettivo di questo capitolo è di fissare certe notazioni su insiemi e funzioni

e ripetere le loro proprietà basilari che stiamo usando in continuazione. L’altro obiettivo, però,

è di farlo in modo tale che siano più adatte per gli scopi di un corso di algebra. Quindi, anche se

il lettore conosce già le notazioni e sa usarle, conviene comunque di leggere attentamente come

intendiamo di farne uso in questo corso.

La presentazione nella Sezione 1.1 è completamente ripetitiva e può essere sostituita con la

sezione corrispondente di un qualsiasi testo standard di analisi o algebra. A partire dalla Sezione

1.2 inizia, però, una presentazione specifica sugli scopi del corso. La probabilità di trovarla in

un libro, esattamente nel modo in cui abbiamo bisogno, è diminuita considerevolmente.

1.1

Insiemi

La teoria rigorosa degli insiemi è decisamente fuori la portata di un qualsiasi corso introduttivo

che non abbia come tema la teoria degli insiemi. Però con un po di attenzione (s.v. Nota 1.1.4)

é possibile di limitarsi al concetto intuitivo di insiemi come viene introdotto da Cantor.

1 Un insieme è una “collezione” di “oggetti” di interesse.

Parlare di un insieme in questo senso non è nient’altro che un’abbreviazione per evitare di dover

sempre ripetere la specificazione degli oggetti. Tale specificazione può essere fatta tramite una

descrizione verbale, tramite una lista esplicita o tramite la formulazione di condizioni che gli

oggetti devono soddisfare.

3

Capitolo 1. Notazioni di base riviste

4

1.1.1 Esempio. Un esempio di una specificazione verbale è

“L’insieme A è l’insieme di di tutti i numeri interi compresi fra 3 e 8”.

La lista esplicita dello stesso insieme A sarebbe

A = 3, 4, 5, 6, 7, 8 ,

mentre la descrizione con l’aiuto di condizioni è

A = n ∈ Z: 3 ≤ n ≤ 8

oppure, ugualmente,

A = n∈Z|3≤n≤8 .

La seguente tabella contiene altri insieme che usiamo in continuazione.

numeri razionali

N = 1, 2, . . .

N0 = 0, 1, 2, . . .

Z = . . . , −2, −1, 0, 1, 2, . . .

Q = qp : p ∈ Z, n ∈ N (s.v. la Sezione 3.6)

numeri reali

R

numeri complessi

C (s.v. la Sedzione 5.10)

l’insieme vuoto

∅ (non contiene nessun oggetto)

numeri naturali

numeri interi

In qualche formula precedente abbiamo già fatto uso del simbolo ∈. Ciò significa:

a∈A

“a è elemento di A” oppure “a in A”,

a<A

“a non è elemento di A” oppure “a non in A”,

A3a

“A contiene l’elemento a”.

1.1.2 Esempio. Per ogni insieme A abbiamo la specificazione banale e tautologica dei suoi

elementi A = {a ∈ A}.

Come potenziali oggetti di insiemi ci possiamo proprio pensare a tutto. Per un insieme però

deve valere la seguente regola:

Sia A un insieme. Allora per ogni

oggetto a vale o a ∈ A o a < A.

1.1. Insiemi

5

1.1.3 Esempio. L’insieme vuoto ∅ è specificato dal fatto che a < ∅ per un oggetto qualsiasi a.

(La sua esistenza è uno degli assiomi della teoria rigorosa degli insiemi.)

Il prossimo esempio noto come l’antinomia di Russell dimostra che per soddisfare la precedente regola bisogna di fare attenzione alle definizioni riflessive di insiemi (cioè definizioni

dove per certi oggetti l’appartenenza all’insieme può essere decisa solo dopo che si conosca già

l’insieme).

1.1.4 Esempio. Il barbiere di un villaggio fa la barba a tutti gli uomini del villaggio che

non si fanno la barba da soli e solo a quelli. Allora il barbiere, come uomo del villaggio, è

o non è un elemento dell’insieme di tutti gli uomini del villaggio a quali faccia la barba?

Se il barbiere fosse un elemento dell’insieme, allora sarebbe proprio lui a farsi si

la barba e, quindi, non farebbe parte dell’insieme. Allora, il barbiere non può far parte

dell’insieme. Però, se non fa parte dell’insieme, allora non può essere lui a farsi la barba.

Quindi, non si fa la barba da solo e proprio per questo fa parte dell’insieme.

Come vediamo con questa definizione dell’insieme di tutti i clienti del barbiere, il povero oggetto “barbiere” non può esserne elemento ma nemmeno non può fare a meno di

esserlo. Quindi l’esempio viola la regola, perciò l’insieme in effetti nonè un insieme.

1.1.5 Definizione. Diciamo che A è un sottoinsieme di B (o A è contenuto in B, e scriviamo

A ⊂ B o B ⊃ A se

a ∈ A =⇒ a ∈ B.

Osserviamo che, in particolare, ∅ ⊂ B per ogni insieme B. (Un’implicazione è vera, se

quando è vera la prima condizione anche la seconda condizione è vera. E poiché la condizione

a ∈ ∅ non è vera proprio mai, non c’è proprio nulla da controllare. Alternativamente, basta anche

dimostrare l’equivalente contrapposizione a < B ⇒ a < ∅, osservando che qui la seconda

condizione sia sempre vera. Purtroppo non abbiamo abbastanza tempo per approfondire questi

concetti basilari della disciplina che si chiama logica.)

Ripetiamo ancora che come oggetto di un insieme possiamo pensare proprio a tutto. Quindi

anche insiemi possono essere elementi di un insieme. (Possibilmente di un altro insieme e non

di se stessi. L’insieme di tutti gli insiemi, che dovrebbe contenere anche se stesso, è un altro

esempio famosissimo di un insieme che non può esistere.)

1.1.6 Esempio. L’insieme delle parti P(Ω) di un insieme Ω è definito come

P(Ω) = A ⊂ Ω .

(Anche l’esistenza di P(Ω) è uno degli assiomi della teoria rigorosa degli insiemi.)

Capitolo 1. Notazioni di base riviste

6

1.1.7 Definizione. Il prodotto (o prodotto cartesiano) A × B di due insiemi A è B è l’insieme

A × B = (a, b) : a ∈ A, b ∈ B

di tutte le coppie ordinate (a, b), dove (a, b) = (a0 , b0 ) se e solo se a = a0 e b = b0 . Similmente,

il prodotto di n ∈ N insiemi A1 , . . . , An è l’insieme

A1 × . . . × An =

n

Ai = (a1 , . . . , an ) : a1 ∈ A1 , . . . , an ∈ An

i=1

di tutte le n–uple (a1 , . . . , an ). In particolare, An = ni=1 A.

Finalmente, se I è un insieme d’indice e Ai i∈I una famiglia di insiemi Ai (i ∈ I), allora il

prodotto della famiglia è l’insieme

Ai =

ai

i∈I :

ai ∈ Ai (i ∈ I)

i∈I

di tutte le famiglie ai

i∈I .

In particolare, AI =

i∈I

A è l’insieme di tutte le funzioni (s.v. sezione

1.2) da I in A.

1.1.8 Nota. Anche l’esistenza dei diversi tipi di prodotti fa parte degli assiomi della teoria

rigorosa degli insiemi. In particolare, il fatto che i∈I Ai sia non-vuoto è il famoso assioma

della scelta. Lo incontreremo in una delle tante forme equivalenti come lemma di Zorn

nella Sezione 5.9.

1.1.9 Esempio. L’insieme R2 = R × R è il solito piano bidimensionale. Gli elementi sono

indicati con (x, y) oppure (x1 , x2 ); s.v. Figura 1.1(a). Il prodotto di due intervalli [a, b] e [c, d] è

il sottoinsieme [a, b] × [c, d] del prodotto R × R = R2 come disegnato nella Figura 1.1(b), dove

per a, b ∈ R l’intervallo chiuso [a, b] è definito come [a, b] = {x ∈ R : a ≤ x ≤ b}.

(a)

(b)

R

6

(x, y) ∈ R2

y

R

6

d

[a, b] × [c, d]

⊂ R2

c

x

Figura 1.1:

-

R

(a) R2 e suoi elementi,

a

(b) prodotto di intervalli

-

b R

1.1. Insiemi

7

Altre notazioni di intervalli in R sono

[a, b) = x ∈ R : a ≤ x < b

(anche per b = ∞),

(a, b] = {x ∈ R : a < x ≤ b}

(anche per a = ∞),

(a, b) = {x ∈ R : a < x < b}

(anche per a, b = ∞).

Usiamo anche la notazione [a, b] × [c, d] =: [(a, c), (b, d)] e le sue analoghe multi-dimensionali.

Chiudiamo questa sezione con alcune regole di calcolo fra insiemi. L’intersezione A ∩ B e

l’unione A ∪ B di insiemi A e B sono definiti come

A ∩ B = c : c ∈ A, c ∈ B ,

A ∪ B = c: c ∈ A o c ∈ B .

La differenza A meno B è

A\B = a ∈ A : a < B .

Se A ∈ P(Ω), allora il complemento A{ di A (in Ω) è definito come

A{ = a ∈ Ω : Ω .

1.1.10 Esercizio. Dimostrare che, se A, B ∈ P(Ω), allora A\B = A ∩ B{ .

Le seguenti regole, che valgono per tutti gli A, B, C ∈ P(Ω), corrispondono una ad una a

regole della logica e sono dimostrate riducendole, tramite le definizioni, alle regole della logica.

A∩B = B∩A

A ∩ (B ∪ C) = (A ∩ B) ∪ (A ∩ C)

A ∩ (B ∪ B{ ) = A

A∪B = B∪A

(commutatività),

A ∪ (B ∩ C) = (A ∪ B) ∩ (A ∪ C) (distributività),

A ∪ (B ∩ B{ ) = A

(elementi neutrali),

(A ∩ B) ∩ C = A ∩ (B ∩ C)

(A ∪ B) ∪ C = A ∪ (B ∪ C)

(associatività),

(A ∩ B){ = A{ ∪ B{

(A ∪ B){ = A{ ∩ B{

(De Morgan),

A∩A = A

A ∩ (B ∩ B{ ) = B ∩ B{

A ⊂ B ⇐⇒ A ∩ B = A

A ∪ A = A,

A ∪ (B ∪ B{ ) = (B ∪ B{ ),

A ⊂ B ⇐⇒ A ∪ B = B.

Capitolo 1. Notazioni di base riviste

8

Le prime tre righe ci dicono che gli elementi P(Ω) formano un’algebra booleana. Tutte le altre

regole, eccetto l’ultima riga, possono essere dimostrate dalle prime tre. (L’ultima riga invece nel

caso astratto serve come definizione di A ⊂ B.) Inoltre si può dimostrare che gli insiemi B ∪ B{

e B ∩ B{ che soddisfano la terza riga sono già determinati univocamente. Visto che Ω e ∅ sono

insiemi che soddisfano queste condizioni, ne segue

B ∪ B{ = Ω

1.2

B ∩ B{ = ∅.

Funzioni

Ricordiamoci che un buon modo per avere un’idea di una funzione da R in R è di disegnarla.

2

Nella Figura 1.2(a) l’abbiamo fatto per la funzione x 7→ d − 4(d−c)

x − b+a

. Anche se non lo

2

(b−a)2

possiamo disegnare, supponiamo che la funzione sia definita su tutta la retta R e, teoricamente,

può assumere valori in tutta la retta R (anche se, effettivamente, non lo fa perché fa (x) ≤ d per

tutti gli x ∈ R).

(a)

(b)

R

6

(c)

R

6

R

d

0

6

d

c

c0

-

R

Figura 1.2:

(a) fa : R → R,

a

-

b R

(b) fb : [a, b] → [c, d],

a

-

b R

(c) fc : [a, b] → [c0 , d0 ].

I valori delle funzioni fb e fc nelle Figure 1.2(b) e (c) verranno calcolati secondo la stessa legge.

Però tutte e due sono definite solo sul dominio [a, b] ⊂ R. Mentre fb esaurisce tutto il suo

codominio [c, d] la funzione fc non lo fa, perché [c, d] ( [c0 , d0 ].

La definizione generale di una funzione f e del suo dominio e codominio si orienta proprio

all’idea di considerarla l’insieme di tutti i suoi punti, cioè come sottoinsieme di R × R (o di

[a, b] × [c, d] o di [a, b] × [c0 , d0 ]). Una funzione, fra altri sottoinsiemi di R × R, è distinto dal

fatto che a qualunque valore x corrisponde un valore y (la funzione è definita per x) ma non più

di un valore (il valore y per un x è ben definito).

1.2.1 Definizione. Siano A e B insiemi. Una funzione (o applicazione) f : A → B da A in B è

1.2. Funzioni

9

un sottoinsieme G f ⊂ A × B (il grafo di f ) tale che per ogni x ∈ A esiste un unico (cioè uno

e un solo) elemento y ∈ B che soddisfa (x, y) ∈ G f . Chiamiamo A il dominio di f e B il suo

codominio.

1.2.2 Osservazione. Sia x nel dominio A. Secondo la definizione esiste un unico valore y ∈ B

tale che (x, y) ∈ G f . Questo valore notiamo con f (x) = y. Il grafo di f è, quindi, l’insieme

x, f (x) : x ∈ A . Viceversa, se ad ogni valore x ∈ A assegniamo un valore f (x) ∈ B allora

l’insieme x, f (x) : x ∈ A è il grafo di un’unica funzione f : A → B. Siccome f trasforma x

in f (x), scriviamo anche f : x 7→ f (x) o solo x 7→ f (x).

1.2.3 Esempio. Su A × B definiamo due funzioni, le proiezioni canoniche, pA : A × B → A e

pB : A × B → B come pA ((a, b)) = a e pB ((a, b)) = b. Se A × B = R × R otteniamo cosı̀ le

proiezioni sugli assi delle coordinate.

Un’altra funzione definita su A × B è il flip F : A × B → B × A che “cambia le coordinate”:

F(a, b)

= (b, a).

1.2.4 Esempio. La funzione idA : A → A che trasforma a in idA (a) = a la chiamiamo l’identità

su A.

1.2.5 Esempio. Sia f : A → B una funzione e A0 ⊂ A. Definiamo la restrizione f |A0 : A0 → B

di f su A0 come ( f |A0 )(a) = f (a) (a ∈ A0 ). Similmente se A00 ⊃ A chiamiamo un’estensione di

f su A00 una qualsiasi funzione g : A00 → B tale che g|A = f . Mentre f |A0 è determinata da f ed

A0 ⊂ A, la restrizione g|A00 \A di un’estensione g di f è completamente arbitraria.

0

0

Se B0 ⊃ B definiamo la corestrizione f |B la funzione A → B0 definita come f |B (a) = f (a)

(a ∈ A).

0

0

0

Ovviamente, ( f |A0 )|B = ( f |B )|A0 . Indichiamo tutte e due con f |AB0 .

0

Ci chiediamo in quali casi la notazione f |B abbia senso anche se la condizione B0 ⊃ B non

0

0

è soddisfatta. Per definire f |B : A → B0 come f |B (a) = f (a), ovviamente, occorre e basta che

ogni valore f (a) (a ∈ A) sia un elemento di B0 . Serve, quindi, una definizione dell’insieme che

contenga tutti questi punti. Vicecersa, se non vogliamo cambiare B0 basta che ci limitiamo a

quei punti di A che f trafsorma in elementi di B0 . La seguente definizione copre, fra l’altro,

anche questi casi.

1.2.6 Definizione. Per una funzione f : A → B e sottoinsiemi A0 ⊂ A e B0 ⊂ B definiamo

l’immagine f (A0 ) di A0 ed la controimmagine f −1 (B0 ) di B0 come

f (A0 ) =

f (a) : a ∈ A0 ,

f −1 (B0 ) = a ∈ A : f (a) ∈ B0 .

Capitolo 1. Notazioni di base riviste

10

Per un insieme B0 arbitrario poniamo f −1 (B0 ) := f −1 (B0 ∩ B).

1.2.7 Esercizio. Sia A0 ⊂ A e sia B0 arbitrario. Dimostrare che:

(a) f −1 (B0 ) = {a ∈ A : f (a) ∈ B0 }.

(b) B0 ⊃ f (A0 ) ⇐⇒ f −1 (B0 ) ⊃ A0 .

Vale B0 = f (A0 ) ⇐⇒ f −1 (B0 ) = A0 ? (Consiglio: Verificare quando vale f −1 ( f (A0 )) = A0 e quando

f ( f −1 (B0 )) = B0 ?)

0

Quindi, infine, qualunque siano A0 ⊂ A e B, possiamo definire f |AB0 se e solo se A0 e B0

soddisfano una delle condizioni equivalenti dell’Esercizio 1.2.7

1.2.8 Esercizio. Siano fa , fb ed fc le funzioni come definite nella Figura 1.2. Poniamo A =

[a, b], B = [c, d] e B0 = [c0 , d0 ]. Indicare quale delle seguenti affermazioni è vera e quale è falsa.

(a) fa = fb |RR ,

(b) fa |A = fb ,

(d) fa |AB = fc ,

(c) fa |A = fc ,

(e) fa |AB = fc |B .

Per il resto della sezione ci occuperemo del problema quando una funzione può essere invertita. Osserviamo, come idea, che invertire una funzione x 7→ y significa semplicemente invertire

la direzione della freccia: x ← y oppure y 7→ x. Parlando dei grafi il grafo della funzione

inversa, se esiste, dovrebbe essere il grafo originale riflesso alla bisettrice.

(a) 6y

(b) 6R

y = x2

y = x2

x=

-

x

(c) 6x

√

y

x=

-

R

2

Figura 1.3: Riflessione di x 7→ x alla bisettrice.

√

y

-

y

Precisiamo l’idea.

Sia G f ⊂ A× B il grafo di una funzione f : A → B. Ci chiediamo in che caso anche l’insieme

trasposto F(G f ) ⊂ B × A è il grafo di una funzione g : B → A. La condizione è che per ogni

b ∈ B esista uno e un solo valore a ∈ A tale che (b, a) ∈ F(G f ) o, ugualmente, (a, b) ∈ G f .

L’esistenza di un a significa per ogni b ∈ B deve esistere un a ∈ A tale che f (a) = b. L’unicità,

invece, ci dice che non ci sono due a, a0 diverse che danno lo stesso f (a) = f (a0 ). Perciò:

1.2. Funzioni

11

1.2.9 Definizione. Una funzione f : A → B è surgettiva, se f (A) = B. È iniettiva, se per ogni

a, a0 ∈ A l’uguaglianza f (a) = f (a0 ) implica che a = a0 . Se f è surgettiva ed iniettiva allora

diciamo che f è biettiva.

Riassumiamo la definizione e la discussione che la precede:

1.2.10 Corollario. Il trasposto F(G f ) del grafo G f di una funzione f : A → B è il grafo di una

funzione g : B → A, se e solo se f è biettiva. In questo caso anche g è biettiva.

D. L’unica cosa rimasta da dimostrare è la biettività di g, che segue banalmente

dal fatto che il trasposto F(F(G f )) del grafo di g è il grafo G f e, quindi, dalla prima parte del

corollario g è biettiva.

Osserviamo che in tutto l’argomento non occorre di specificare come g agisce su B. Nel

Teorema 1.2.19 precisiamo anche questo.

1.2.11 Esempio. La proiezione canonica pa : A × B → A (s.v. Esempio 1.2.3) è surgettiva. È

iniettiva, se e solo se B ha esattamente un elemento.

L’identità idA (s.v. Esempio 1.2.4) è biettiva.

Sia A ⊂ B. L’immersione canonicaimmersione!canonica i : A → B definita come i(a) = a

(a ∈ A) è iniettiva. È surgettiva, se e solo B\A = ∅.

1.2.12 Esempio. Qualunque sia la funzione f : A → B, la funzione f | f (A) è sempre surgettiva.

E se per ogni b ∈ f (A) scegliamo un ab e poniamo A0 = {ab : b ∈ f (A)}, allora la funzione f |A0

è iniettiva e la funzione f |Af (A)

è biettiva. Approfondiremo la seconda parte di questo argomento

0

quando parleremo di classe di equivalenza nella Sezione 2.4.

1.2.13 Esercizio.

(a) Trovare tutti gli intervalli [a, b] (a, b ∈ R) tali che la funzione sin |[−1,1]

[a,b]

sia biettiva.

(b) Calcolare la controimmagine sin−1 − 21 , 12 .

1.2.14 Definizione. Siano date funzioni f : A → B ed g : B → C. Allora la funzione composta

g ◦ f : A → C è definita come g ◦ f (a) = g( f (a)). Più generalmente, se f (A) è contenuta nel

dominio di g, definiamo g ◦ f := g| f (A) ◦ f | f (A) .

Una funzione g : B → A si chiama inversa a sinistra della funzione f : A → B, se g◦ f = idA .

Si chiama inversa a destra, se f ◦ g = idB . Si chiama inversa se è inversa a sinistra ed inversa a

destra. Chiamiamo f invertibile, se esiste un’inversa a sinistra ed un’inversa a destra.

Capitolo 1. Notazioni di base riviste

12

1.2.15 Osservazione. f ◦ idA = idB ◦ f = f per ogni funzione f : A → B.

1.2.16 Esercizio. Dimostrare che per ogni A0 ⊂ A vale g ◦ f (A0 ) = g( f (A0 )) e per ogni C 0 vale

(g ◦ f )−1 (C 0 ) = f −1 (g−1 (C 0 )).

1.2.17 Proposizione. Per tutte le funzioni f : A → B, g : B → C ed h : C → D vale

(h ◦ g) ◦ f = h ◦ (g ◦ f ).

Indichiamo questa funzione con h ◦ g ◦ f .

D. Basta calcolare tutte e due le funzioni per ogni a ∈ A e paragonare i valori.

Secondo la definizione delle funzioni composte abbiamo

((h ◦ g) ◦ f )(a) = (h ◦ g)( f (a)) = h(g( f (a)))

ed

(h ◦ (g ◦ f ))(a) = h((g ◦ f )(a)) = h(g( f (a))).

1.2.18 Proposizione. La funzione f : A → B possiede una coppia (gl , gr ) di un’inversa a

sinistra gl ed un’inversa a destra gr . Allora gl = gr . Se (g0l , g0r ) è un’altra coppia, allora

(g0l , g0r ) = (gl , gr ). Quindi, se f è invertibile, esiste un’unica funzione f −1 , l’inversa di f , tale

che f −1 ◦ f = idA ed f ◦ f −1 = idB .

D. Abbiamo

gl = gl ◦ idB = gl ◦ f ◦ gr = idA ◦gr = gr ,

cioè gl = gr .

Se sostituiamo gr con g0r , ne segue che g0r = gl = gr . Allora, sostituendo anche gl con g0l , alla

fine vediamo che (gl , gr ) = (gl , g0r ) = (g0l , g0r ).

1.2.19 Teorema. Per una funzione f : A → B le seguenti affermazioni sono equivalenti:

1. f è invertibile ed il grafo dell’inversa G f −1 è il trasposto del grafo di f .

2. f è biettiva e la funzione definita dal trasposto F(G f ) del grafo di f è l’inversa f −1 .

1.2. Funzioni

13

D. 1 ⇒ 2. Sia f invertibile. Secondo la Proposizione 1.2.18 esiste la funzione

inversa f −1 . Inoltre, secondo l’Esercizio 1.2.16 f ( f −1 (B)) = ( f ◦ f −1 )(B) = idB (B) = B cosicché

f (A) non può fare a meno di essere uguale a B perché B ⊃ f (A) ⊃ f ( f −1 (B)) = B. Allora per il

grafo di f −1 otteniamo

G f −1 = (b, f −1 (b) : b ∈ B = (b, f −1 (b) : b = f (a), a ∈ A

= ( f (a), f −1 ( f (a)) : a ∈ A = ( f (a), a) : a ∈ A =

F(G f ).

Quindi, il trasposto del grafo di f definisce una funzione. Secondo il Corollario 1.2.10 f deve

essere biettiva.

2 ⇒ 1. Sia f biettiva. Secondo il Corollario 1.2.10 il trasposto del grafo di f definisce una

funzione g : B → A tale che Gg = F(G f ).

Prima vogliamo dimostrare che g ◦ f = idA . Sia a ∈ A. Il punto f (a), g( f (a)) fa parte del

grafo di g. Ma anche il punto ( f (a), a) fa parte di Gg perché il punto trasposto (a, f (a)) fa parte

di G f . Quindi, poichè Gg è un grafo, ne segue che g( f (a)) = a, cioè g ◦ f = idA .

Rimane da dimostrare che f ◦ g = idB . Sappiamo già che g ◦ f = idA , quindi, f ◦ g ◦ f =

f ◦ idA = f . Allora per ogni b = f (a) (a ∈ A) vale ( f ◦ g)(b) = f ◦ g ◦ f (a) = f (a) = b. Poiché f

è surgettiva, ogni b ∈ B può essere scritto come f (a). Quindi, ( f ◦ g)(b) = b vale per ogni b ∈ B

cosicché f ◦ g = idB .

1.2.20 Esercizio. Dimostrare che:

(a) Se f è invertibile allora lo è anche f −1 e ( f −1 )−1 = f .

(b) Se f e g sono invertibili e se esiste f ◦ g, allora anche g ◦ f è invertibile e la sua inversa è

(g ◦ f )−1 = f −1 ◦ g−1 .

1.2.21 Corollario. Sia f : A → B una funzione. Allora:

1. f è iniettiva, se e solo se esiste un’inversa g a sinistra. Nel caso affermativo g deve essere

surgettiva.

2. f è surgettiva, se e solo se esiste un’inversa g a destra. Nel caso affermativo g deve essere

iniettiva.

D. Qualunque sia f , secondo l’Esempio 1.2.12 la funzione f | f (A) è surgettiva e

possiamo costruire un sottoinsieme A0 ⊂ A tale che f |A0 sia iniettiva e f |A0 (A) = f (A).

1. f è iniettiva se e solo se f | f (A) è biettiva.

Capitolo 1. Notazioni di base riviste

14

Supponiamo prima che g sia un’inversa a sinistra, cioè g ◦ f = idA . Da g(B) ⊃ g ◦ f (A) = A

segue che g è surgettiva. Allora, anche g| f (A) è surgettiva, perché g| f (A) ◦ f | f (A) = g ◦ f = idA .

Siano f (a) ed f (a0 ) due punti diversi del dominio f (A) di g| f (A) . Allora a , a0 (perché anche f è

una funzione) e, quindi, g( f (a)) = a , a0 = g( f (a0 )), cioè g| f (A) è anche iniettiva. Dal Teorema

1.2.19 segue che g| f (A) è invertibile e, prendendo in considerazione g| f (A) ◦ f | f (A) = idA , dalla

Proposizione 1.2.18 segue che f | f (A) è l’inversa di g| f (A) e, quindi, biettiva. Perciò f non può

fare a meno di essere iniettiva.

Supponiamo adesso che f sia iniettiva. Allora f | f (A) è biettiva e, quindi, esiste ( f | f (A) )−1 . Se

poi scegliamo una qualsiasi estensione g di ( f | f (A) )−1 su tutto B, allora g ◦ f = ( f | f (A) )−1 ◦ f | f (A) =

idA .

2. f è surgettiva se e solo se f |A0 è biettiva, cioè se e solo se f |A0 = f |Af (A)

0 . Ricordiamoci che

f |Af (A)

ha l’inversa b 7→ ab dove ab (b ∈ f (A)) sono quegli elementi di A0 tali che f (ab ) = b

0

che abbiamo scelto nell’Esempio 1.2.12 per comporre l’insieme A0 . Quindi se f è surgettiva,

ha l’inversa definita su f (A) = B, e se poniamo g = ( f |A0 )−1 |A (cosicche

allora f |A0 = f |Af (A)

0

anche g è iniettiva) troviamo che f ◦ g = f |A0 ◦ ( f |A0 )−1 = id f (A) = idB . Viceversa, se f non

è surgettiva, allora per nessuna funzione g del mondo la funzione f ◦ g risulterebbe surgettiva

(perchè f (g(B)) ⊂ f (A). Quindi f ◦ g , idB per ogni g perchè idB è surgettiva.

1.3

I numeri naturali

Una delle scoperte più fondamentali sia per la vita umana di ogni giorno sia per quasi tutte le

scienze fu l’osservazione che cose, oggetti, elementi di un insieme, etc. possono essere contate.

(Esistono ancora delle tribù nell’Africa che non hanno il senso per la grandezza di un gruppo

di uomini, di animali, di frecce o altro, che sia più grande di 2. Loro contano uno, due, tanti.)

Gli oggetti con quali denotiamo il risultato del conteggio sono i numeri naturali 1, 2, 3, . . . .

(La scoperta dello 0 che simbolizza il niente sia come numero, sia come cifra, è un’altra grande

invenzione.) L’esistenza dei numeri per quanto sia plausibile non può essere dimostrata in nessun modo. Piuttosto si tratta dell’assioma fondamentale della matematica moderna. C’è gente

(e non poca) che discute sul fatto che la matematica si possa fare anche senza l’assioma della

scelta, e dedica tutta la vita a stabilire fino a che punto si possa arrivare. (Questi problemi sono

interessanti ma anche fastidiosi e a volte molto difficili. Noi non contribuiamo a questa discussione, ma prendiamo l’assioma della scelta come ipotesi standard di tutti i nostri teoremi.) Però

nessuno pensa seriamente di poter fare matematica senza i numeri naturali.

Un proverbio fra matematici dice: I numeri naturali provengono da Dio — tutto il resto è

opera umana. Perciò, anche se non abbiamo il tempo di derivare tutte le proprietà dei numeri

1.3. I numeri naturali

15

naturali, che usiamo in continuazione, dalla loro definizione, serve comunque di avere un’idea

di come si dovrebbe procedere, se lo volessimo fare veramente. È questo lo scopo della sezione

presente.

Prima presentiamo gli assiomi dei numeri naturali (più o meno) di Peano in una forma un

pò monosillabica usando strettamente i termini già introdotti.

1.3.1 Definizione. Una realizzazione dei numeri naturali è una terna (N, e, s) di un insieme

N, un elemento iniziale e ∈ N e una funzione del successore s : N → N, che soddisfano i

seguenti assiomi:

1. s è iniettiva.

2. e < s(N).

3. Sia M ⊂ N, tale che e ∈ M e n ∈ M =⇒ n + 1 ∈ M. Allora M = N.

Prima di preoccuparci degli assiomi, ci chiediamo il significato della parola un pò mistica “realizzazione”. Una terna come (N, e, s) che contiene insiemi (come N) elementi di

essi (come e) e funzioni fra gli insiemi (come s) soddisfacienti certi assiomi, è un esempio

di quello che chiameremo una struttura (o struttura matematica). Due incarnazioni, cioè

due realizzazioni, della stessa struttura sono considerate uguali, se — parlando vagamente

— non possono essere distinte servendosi solo dei mezzi inerenti alla struttura. In nostro

caso concreto diciamo, più precisamente, due realizzazioni (N, e, s) e (N 0 , e0 , s0 ) dei numeri

naturali sono isomorfe se fra di loro esiste un isomorfismo della struttura, cioè una biezione

i : N → N 0 , tale che i(e) = e0 e i(s(n)) = s0 (i(n)) (oppure i ◦ s = s0 ◦ i).

1.3.2 Nota. Gli isomorfismi li incontreremo più tardi per tante altre strutture. La definizione, quale biezione fra due realizzazioni della stessa struttura è anche un isomorfismo della

struttura, non è sempre unica. Perciò noi specificheremo sempre esplicitamente quando

consideriamo una biezione un isomorfismo.

Notiamo, però, che tutti i definizioni di isomorfismo devono assicurare che l’identità

è un isomorfismo, che la composizione i ◦ j di due isomorfismi è un isomorfismo e che

se i è un isomorfismo allora lo è anche i−1 . (Esercizio: Verificare che la definizione di

isomorfismo di realizzazioni dei numeri naturali soddisfa queste condizioni.) Anticipando

la terminologia della Sezione 2.3, possiamo dire che la notazione di isomorfismo determina

una relazione di equivalenza.

1.3.3 Esempio. I numeri naturali (N = {1, 2, . . .}, 1, s : n 7→ n + 1) sono una realizzazione

dei numeri naturali. Ma anche (N0 = {0, 1, 2, . . .}, 0, s0 : n 7→ n + 1) è una realizzazione.

Però le due realizzazioni sono isomorfe tramite l’isomorfismo i : N0 → N, i(n) = n + 1.

Con la struttura dell’elemento iniziale e della funzione del successore da soli non possiamo

stabilire una differenza fra le due realizzazioni.

L’esistenza di un isomorfismo nell’Esempio 1.3.3 non è casuale. In effetti, il teorema

seguente ci dice che (in un senso adeguato) la realizzazione dei numeri naturali è determinata unicamente dagli assiomi.

1.3.4 Teorema. Tutte le realizzazioni dei numeri naturali sono uguali a meno di un unico

isomorfismo.

Capitolo 1. Notazioni di base riviste

16

La frase “a meno di isomorfismo” significa che qualunque siano le realizzazioni (N, e,

s) e (N 0 , e0 , s0 ) dei numeri naturali, c’è sempre un isomorfismo N → N 0 . La parola “unico” significa che questo isomorfismo è unico. Per la dimostrazione vorremmo definire un

isomorfismo i : N → N 0 secondo la definizione ricorsiva i(e) = e0 e i(s(n)) = s0 (i(n)).

Intuitivamente questo dovrebbe definire una funzione N → N 0 , per quale possiamo poi tentare di dimostrare che sia un isomorfismo. Però, come ci insegna la dimostrazione difficile

del Teorema 1.3.9, che rimandiamo addirittura all’appendice nella Sezione 1.4, a volte ci

dobbiamo dare da fare per verificare che l’intuizione non ci frega. Rimandiamo anche la

dimostrazione del Teorema 1.3.4 alla Sezione 1.4 dopa la dimostrazione del Teorema 1.3.9.

Dopo l’unicità dei numeri naturali manca l’esistenza.

1.3.5 Assioma fondamentale della matematica. Esiste una realizzazione dei numeri naturali.

Raccogliamo le conoscenze e riformuliamole un pò:

1.3.6 Definizione. Esiste un insieme N con un elemento distinto 1 ed una funzione n 7→ n + 1

(il successore di n) tale che:

1. n + 1 = m + 1 =⇒ n = m.

2. 1 non è successore di nessun elemento di N.

3. Se N è un sottoinsieme di N, che contiene 1 (1 ∈ N) e con ogni n ∈ N anche il successore

di n (n ∈ N =⇒ n + 1 ∈ N), allora N = N.

Notiamo 2 = 1 + 1, 3 = 2 + 1, ... , cioè N = {1, 2, 3, . . .}.

La Proprietà 3 si chiama il principio dell’induzione. È equivalente al principio della dimostrazione induttiva:

1.3.7 Teorema. Sia A1 , A2 , . . . una successione di affermazioni. Per dimostrare la validità di

tutte le affermazioni An (n ∈ N) basta stabilire la validità delle seguenti due affermazioni:

1. Vale A1 . (Inizio dell’induzione)

2. Per ogni n ∈ N, se vale An vale anche An+1 . (Passo induttivo)

D. Sia N = {n ∈ N : vale An } l’insieme di tutti gli n per quali An è vera.

Dobbiamo dimostrare dalle Ipotesi 1 e 2 che N = N.

Secondo l’Ipotesi 1, A1 è vera, allora 1 ∈ N. Poi se n ∈ N allora An è vera e secondo

l’Ipotesi 2 anche An+1 è vera, cosicché n + 1 ∈ N. Abbiamo dimostrato cosı̀ che 1 ∈ N e se

n ∈ N allora anche n + 1 ∈ N. Secondo il principio dell’induzione abbiamo N = N.

1.3. I numeri naturali

17

1.3.8 Osservazione. Non è importante di iniziare l’induzione proprio con n = 1. Anche per

m ∈ N (o, più generale, m ∈ Z), gli elementi di una successione Am , Am+1 , . . . di affermazioni si

dimostrano tutte vere, se vale Am e se (dopo aver introdotto l’ordinamento di N o di Z) per ogni

n ≥ m la validità di An implica quella di An+1 .

Alla fine il principio dell’induzione ci permette di produrre definizioni ricorsivi, anche se la

dimostrazione (della prima parte) del seguente teorema è sorprendentemente difficile. Rimandiamo la sua dimostrazione alla Sezione 1.4.

1.3.9 Teorema. Siano X un insieme e f : X → X una funzione. Allora per ogni x0 ∈ S esiste

un’unica successione x1 , x2 , . . . che soddisfa

x1 = f (x0 )

xn+1 = f (xn )

e

(n ∈ N).

Per ogni n ∈ N indichiamo con f n : X → X la funzione x0 7→ xn . Poniamo f 0 = idX . Allora la

successione f 1 , f 2 , . . . di funzioni X → X soddisfa

f1 = f

f n+1 = f ◦ f n

e

(n ∈ N0 ).

Inoltre è l’unica successione che soddisfa queste due condizioni.

Non è difficile invece di generalizzare il teorema ancora di più. (La dimostrazione anche di

questo risultato rimandiamo alla Sezione 1.4.)

1.3.10 Corollario. Siano X0 , X1 , X2 , . . . insiemi e siano fn : Xn−1 → Xn (n ∈ N) funzioni.

Allora esiste un’unica successione F0 , F1 , F2 , . . . di funzioni Fn : X0 → Xn che soddisfano

X0 = idX0

e

Fn+1 = fn+1 ◦ Fn

(n ∈ N).

Scriviamo anche Fn = fn ◦ . . . ◦ f1 .

Concludiamo la sezione introducendo le operazioni di dase in N è in N0 . Denotiamo come prima

s(n) = n + 1. L’addizione in N è definita come m + n = sm (n) e soddisfa le seguenti proprietà:

n+m = m+n

(` + m) + n = ` + (m + n)

m + ` = n + ` =⇒ m = n

(commutatività),

(associatività),

(cancellatività).

Ricordiamoci per più tardi che (N, +) con tali proprietà è ciò che chiameremo un semigruppo

abeliano cancellativo.

Capitolo 1. Notazioni di base riviste

18

1.3.11 Esercizio. Estendiamo l’addizione su N0 come 0 + n = n + 0 = n. Dimostrare che

anche l’estensione dell’addizione su N0 è commutativa, associativa e cancellativa. (Quindi N0

è ciò che chiameremo un semigruppo abeliano cancellativo con identità 0 oppure un monoide

abeliano cancellativo.)

Un ordinamento di un insieme è un esempio di una relazione, della quale parliamo nel

Capitolo 2. Per adesso mettiamoci solo d’accordo sul dire che n < m (n, m ∈ N0 ) se esiste una

` ∈ N tale che n + ` = k. Diciamo che n ≤ m se n < m on = m e diciamo che n ≥ m (n > m)

se m ≤ n (m < n). Qualunque siano n ∈ N e m ∈ N, vale sempre una ed una sola delle tre

affermazioni o n < m o n = m o n > m. (Un tale ordinamento lo chiameremo ordinamento

totale.) Vale

n < m =⇒ n + ` < m + `

per ogni ` ∈ N0 , in particolare, per ` ≥ 0 perché ` ≥ 0 per ogni ` ∈ N0 . Allora N0 è che si

chiama un semigruppo totalmente ordinato, un termine che appare più in queste note.

Per ogni m ∈ N sia pm : N0 → N0 la funzione pm (n) = m + n. Definiamo il prodotto come

n · m = pnm (0). Di solito abbreviamo n · m = nm. Anche per (N, ·) vale

nm = mn

(commutatività),

(`m)n = `(mn)

(associatività),

m` = n` =⇒ m = n

(cancellatività).

Inoltre n1 = 1n = n e n > m implica che n` > m` per ogni ` ∈ N. Allora anche N con

la moltiplicazione è un semigruppo abeliano cancellativo ordinato (con identità 1), mentre N0

con l’estensione 0n = n0 = 0 della moltiplicazione è solo un semigruppo (né cancellativo né

ordinato).

Addizione e moltiplicazione soddisfano una regola fra di loro:

(n + m)` = m` + n`

(distributività).

Per ogni m ∈ N sia qm : N → N la funzione qm (n) = mn. Definiamo la potenza come

m = qnm (1).

n

1.3.12 Esercizio. Dimostrare che l’operazione (m, n) 7→ mn non è né commutativa né associativa.

Anche la potenza la estendiamo su N0 come 0n = 0 (n ∈ N) e m0 = 1 (m ∈ N0 ). Valgono le

seguenti regole miste per le tre operazioni:

`m+n = `m `n

(`m )n = `mn

(mn)` = m` n` .

1.4. Appendice: Definizioni ricorsive

19

n

Per altre espressioni come `m o (m + n)` non esistono formule semplici. Almeno l’ultima può

essere calcolata con l’aiuto della formula del binomio che incontreremo nella Sezione 4.3.

1.4

Appendice: Definizioni ricorsive

Vogliamo dimostrare il Teorema 1.3.9. Allora sia X , ∅ un insieme e f : X → X una funzione

su X.

Definiamo la funzione F : N0 × X → N0 × X su N0 × X come F(n, x) = (n + 1, f (x)).

1.4.1 Lemma. Per ogni x ∈ X esiste un unico sottinsieme A x ⊂ N0 × X che soddisfa:

1. (0, x) ∈ A x .

2. (n, y) ∈ A x =⇒ (n + 1, f (y)) ∈ A x , cioè F(A x ) ⊂ A x .

3. Se A ⊂ N0 × X è un altro sottoinsieme di X che soddisfa (0, x) ∈ A e F(A) ⊂ A allora

A ⊃ Ax .

In altre parole, A x è l’unico sottoinsieme più piccolo di N0 × X che sia invariante su F e che

contenga (0, x).

D. Si tratta di un argomento standard che incontreremo anche più tardi (Proposizione 3.2.1 e 5.6.1). A x è l’intersezione di tutti i sottoinsiemi di A ⊂ N0 × X che soddisfano 1 e 2.

(C’è almeno un insieme, N0 × X, che soddifa 1 e 2. L’intersezione A x di tutti questi insiemi soddisfa 1 e 2. Se A soddisfa 1 e 2, allora A ⊃ A x , quindi, vale 3. Si paragoni con la dimostrazione

della Proposizione 3.2.1.)

1.4.2 Lemma. A x = {(0, x)} ∪ F(A x ).

D. Vale A x ⊂ {(0, x)} ∪ F(A x ) ⊂ A x , dove la prima inclusione segue da 3 e dove la

seconda inclusione segue da 1 e 2.

1.4.3 Lemma. A x è il grafo di una funzione f x : N0 → X.

D. Dobbiamo dimostrare che per ogni n ∈ N0 esiste una e una sola coppia (n, y)

in A x .

Dimostriamo l’esistenza con induzione. Sia N l’insieme di tutti gli n ∈ N0 tali che esiste

y ∈ X tale che (n, y) ∈ A x . Per n = 0 c’è (0, x) ∈ A x . Sia n ∈ N, cioè sia y ∈ X tale che (n, y) ∈ A x

Capitolo 1. Notazioni di base riviste

20

allora (n + 1, f (y)) = F(n, y) ∈ A x , quindi, n + 1 ∈ N. Allora N = N0 , cioè per ogni n ∈ N0 esiste

almeno una coppia (n, y) ∈ A x .

Per dimostrare l’unicità definiamo il sottoinsieme

N = n ∈ N0 : (n, y) ∈ A x , (n, z) ∈ A x =⇒ y = z

di N0 che contiene tutti gli n per quali esista una sola coppia (n, y) ∈ A x . Abbiamo, quindi, finito

se dimostriamo N = N0 . Lo dimostriamo con induzione. (i) Sia (0, y) ∈ A x = {(0, x)} ∪ F(A x ).

Allora (0, y) ∈ {(0, x)} perché certamente (0, y) < F(A x ) ⊂ N × X. Quindi, (0, y) = (0, x), cioè

0 ∈ N. (ii) Supponiamo n ∈ N. Siano (n + 1, y) e (n + 1, z) in A x = {(0, x)} ∪ F(A x ). Certamente

(n+1, y) e (n+1, z) non sono in {(0, x)}, allora per forza devono essere in F(A x ). Perciò esistono

y0 , z0 ∈ X tali che (n, y0 ), (n, z0 ) ∈ A x e F(n, y0 ) = (n + 1, y), F(n, z0 ) = (n + 1, z). Dall’ipotesi

n ∈ N segue che y0 = z0 . Quindi, y = f (y0 ) = f (z0 ) = z, cioè n + 1 ∈ N. Infine, N = N0 .

Ponendo xn = f x0 (n ∈ N0 ) concludiamo la dimostrazione del Teorema 1.3.9.

S

D C 1.3.10. Definiamo il sottoinsieme X di N0 × n∈N0 Xn come

X = (n, x) : n ∈ N0 , x ∈ Xn .

Poi definiamo la funzione F : X → X come F(n, x) = (n + 1, xn+1 ). Secondo il Teorema esiste

un’unica successione F 0 , F 1 , F 2 , . . . di funzioni X → X che soddisfano F 0 = idX e F n+1 =

F ◦ F n . Osserviamo che F n (0, x) (x ∈ X0 !) ha la forma (n, y) dove y ∈ Xn . Allora le funzioni

Fn : X0 → Xn definite come Fn (x) = pX |Xn (F n (0, x)) (s.v. l’Esempio 1.2.3 per la definizione della

proiezione pX : N0 × X → X) soddisfanno

Fn+1 (x) = pX |Xn+1 ◦ F n+1 (0, x) = pX |Xn+1 ◦ F ◦ F n (0, x) = pX |Xn+1 ◦ F(n, Fn (x))

= pX |Xn+1 ◦ (n + 1, fn+1 ◦ Fn (x)) = fn+1 ◦ Fn (x).

D T 1.3.4.

Iniziamo con l’unicità. Allora siano i1 , i2 due isomorfismi

(N, e, s) → (N 0 , e0 , s0 ). Sia poi M ⊂ N l’insieme che contiene tutti gli n ∈ N tali che i1 (n) =

i2 (n). Da i1 (e) = e0 = i2 (e) segue che e ∈ M. Poi, se n ∈ M (cosicché i1 (n) = i2 (n)) allora

i1 (s(n)) = s0 (i1 (n)) = s0 (i2 (n)) = i2 (s(n)). Quindi, anche s(n) ∈ M. Conseguentemente, M = N,

cioè i1 (n) = i2 (m) per ogni n ∈ N.

Dimostriamo poi che una funzione i : N → N 0 che soddisfa i(e) = e0 e i ◦ s = s0 ◦ i è

automaticamente biettiva, quindi, un isomorfismo. In effetti, e0 = i(e) ∈ i(N) e se n0 = i(n) è

in i(N) allora lo è anche s0 (n0 ) = s0 (i(n)) = i(s(n)). Quindi, i(N) = N 0 cosicché i è surgettiva.

1.4. Appendice: Definizioni ricorsive

21

Poi sia M 0 ⊂ N 0 l’insieme di tutti gli n0 ∈ N 0 tali che i(n1 ) = n0 = i(n2 ) implica che n1 =

n2 . Dimostrando che M 0 = N 0 ne segue che i è anche iniettiva. Per verificare che e0 ∈ M 0

supponiamo che n sia un elemento di N tale che i(n) = e0 . Sappiamo che o n = e o n = s(m)

per un (unico) m ∈ N. Se n = s(m) allora i(n) = i(s(m)) = s0 (i(m)) , e0 . Quindi, e è l’unico

elemento di N tale che i(e) = e0 , cosicché e0 ∈ M 0 . Sia poi n0 ∈ M 0 . Siano n1 , n2 ∈ N tali che

i(n1 ) = s0 (n0 ) = i(n2 ). Sappiamo (perché?) che n1 , e , n2 perché i(n1 ) = i(m) = s0 (n2 ) , e0 .

Allora esistono (unici) m1 , m2 ∈ N tali che s(m1 ) = n1 e s(m2 ) = n2 . Quindi

s0 (i(m1 )) = i(s(m1 )) = i(n1 ) = s0 (n0 ) = i(n2 ) = i(s(m2 )) = s0 (i(m2 )).

s0 è iniettiva, quindi i(m1 ) = n0 = i(m2 ) e per l’ipotesi n0 ∈ M 0 segue che m1 = m2 oppure

n1 = n2 . In altre parole, anche s0 (n0 ) ∈ M 0 e, conseguentemente, M 0 = N 0 .

Per l’esistenza poniamo per semplificare le cose (N, e, s) = (N0 , 0, +). (Se dimostriamo che

ogni realizzazione è isomorfa a (N0 , 0, +) allora sono anche isomorfe tutte le realizzazioni tra

loro.) Secondo il teorema 1.3.9 per la funzione s0 : N 0 → N 0 sull’insieme N 0 e per e0 ∈ N 0 esiste

un’unica successione xn n∈N0 tale che x0 = e0 e s0 (xn ) = xn+1 . La funzione i : N0 → N 0 , n 7→ xn

soddisfa, quindi, i(0) = x0 = e0 e i(n + 1) = xn+1 = s0 (xn ) = s0 (i(n)) come da noi desiderato.

22

Capitolo 1. Notazioni di base riviste

Capitolo 2

Relazioni

Una relazione è semplicemente una regola che ci dice quando elementi a e b di A sono in

relazione: a è in relazione con b o a non è in relazione con b. Quindi la relazione la conosciamo

quando conosciamo l’insieme di tutte le coppie (a, b) tali che a sia in relazione con b e, in effetti,

sarà proprio questa la definizione.

Esempi tipici sono gli ordinamenti (a è in relazione con b se a ≤ b) e l’uguaglianza (a è in

relazione con b se a = b). In effetti tutte le relazioni rilevanti sono piccole generalizzazioni di

queste due, che vedremo in seguito.

2.1

Definizioni

Sia A un insieme. Una relazione su A è un sottoinsieme R ⊂ A × A. Siano a, b ∈ A. Diciamo che

R

a è in relazione con b, in formula a ∼ b (oppure a ∼ b quando vogliamo indicare il nome della

relazione), se la coppia (a, b) è in R.

Spesso usiamo simboli come =, ≡, , ≤, <, etc., per indicare relazioni. La relazione corrispondente è quindi l’insieme ∼= {(a, b) ∈ A2 : a ∼ b} e in questo caso parliamo della relazione

∼.

Elenchiamo qualche proprietà che una relazione può avere o non avere. Sia ∼ una relazione

su A.

1. La relazione ∼ è riflessiva se a ∼ a per ogni a ∈ A.

2. La relazione ∼ è transitiva se a ∼ b e b ∼ c implica che a ∼ c.

3. La relazione ∼ è hlsimmetrica se a ∼ b implica che b ∼ a.

4. La relazione ∼ è antisimmetrica se a ∼ b e b ∼ a implica che a = b.

23

Capitolo 2. Relazioni

24

2.2

Ordinamenti

2.2.1 Definizione. Un ordinamento!parziale su A è una relazione ∼ su A che è riflessiva, transitiva e antisimmetrica. Diciamo che (A, ∼) è un insieme parzialmente ordinato.

Un ordinamento totale su A è un ordinamento parziale ∼ tale che per ogni a, b ∈ A vale

a ∼ b o b ∼ a. Diciamo che (A, ∼) è un insieme totalmente ordinato.

2.2.2 Nota. Attenzione: Alcuni autori chiamano ordinamento quello che noi chiamiamo ordinamento parziale, altri chiamano ordinamento quello che noi chiamiamo ordinamento totale.

Quindi la scelta migliore è di specificare sempre di quale variante si tratti, come lo facciamo

noi.

2.2.3 Esempio. L’insieme R con la solita relazione ≤ è un insieme totalmente ordinato. Lo

stesso vale per tutti i suoi sottoinsiemi come per esempio Q, Z, N.

R2 diventa un insieme parzialmente ordinato se definiamo (x, y) ≤ (x0 , y0 ) ⇐⇒ x ≤ x0 e

y ≤ y0 . Però (R2 , ≤) non è un insieme totalmente ordinato, perché per esempio non vale né

(0, 1) ≤ (1, 0) né (1, 0) ≤ (0, 1).

Guardiamo brevemente la differenza fra ≤ e <.

2.2.4 Proposizione. Sia (A, ≤) un insieme ordinato. Definiamo la relazione < su A come

a < b se a ≤ b ma a , b. Allora < è una relazione transitiva su A tale che per ogni a, b ∈ A

vale o a < b o a = b o b < a.

D. < la possiamo definire anche se (A, ≤) è solo parzialmente ordinato. Vogliamo dimostrare che già in questo caso < è una relazione transitiva. Siano a, b, c ∈ A con

a < b e b < c. A fortiori vale a ≤ b e b ≤ c e quindi, a ≤ c. Dobbiamo solo escludere a = c.

Ma se fosse a = c avremmo a ≤ b e b ≤ c = a quindi, a = b a causa dell’antisimmetria, che

contraddirebbe a < b. Allora a , c e quindi, a < c, cioè < è una relazione transitiva.

Torniamo al caso in cui (A, ≤) è totalmente ordinato. Siano a, b ∈ A. Poiché A è totalmente ordinato, vale a ≤ b o b ≤ a. Se vale a ≤ b e b ≤ a, allora a causa dell’antisimmetria

ne segue a = b. Escludendo poi il caso a = b, ne segue che vale o a ≤ b (cioè a < b) o

b ≤ a (cioè b < a).

Facciamo qualche altro esempio.

2.2.5 Esempio. L’inclusione ⊂ sull’insieme P(Ω) delle parti di Ω è parzialmente ordinata. In

effetti A ⊂ A perché a ∈ A (quello destro) implica che a ∈ A (quello sinistro). A ⊂ B e B ⊂ C

implica che A ⊂ C perché a ∈ A ⇒ a ∈ B ⇒ a ∈ C. Infine, sia A ⊂ B (quindi a ∈ A ⇒ a ∈ B) e

B ⊂ A (quindi a ∈ B ⇒ a ∈ A). Allora a ∈ A ⇔ a ∈ B e quindi, A = B.

Se Ω ha almeno due elementi diversi, allora P(Ω) non è totalmente ordinato. In effetti se

a, b ∈ Ω e a , b, allora {a} e {b} non sono paragonabili.

2.3. Equivalenze

25

2.2.6 Esercizio. Diciamo che a ∈ Z divide b ∈ Z, in formula a|b, se esiste un c ∈ Z tale che

ac = b. Dimostrare che la relazione | è un ordinamento parziale, ma non è un ordinamento

totale.

2.3

Equivalenze

La relazione = di uguaglianza su un insieme A è riflessiva (a = a), transitiva (a = b e b = c

implica che a = c) e simmetrica (a = b implica che b = a). Evidentemente serve per paragonare

gli elementi di A. Ma spesso l’uguaglianza è troppo ristretta quando vogliamo paragonare due

elementi che differiscono tra loro di poche unità.

2.3.1 Esempio. Analizziamo i prezzi che i venditori di macchine usate di una città assegnano ad una Fiat Panda dell’anno 2000. I prezzi però ci interessano solo arrotondati a multipli

di 100 euro. Consideriamo quindi “uguali” due prezzi p1 e p2 , in formula p1 ≈ p2 , quando

c’è una differenza solo fra le ultime due cifre. Anche questa relazione è riflessiva, transitiva e

simmetrica.

2.3.2 Definizione. Una relazione ∼ su un insieme A è una relazione di equivalenza (o semplicemente equivalenza), se è riflessiva, transitiva e simmetrica.

2.3.3 Esempio. Due insiemi A e B sono equipotenti (cioè sono altrettanto grandi o hanno la

stessa cardinalitá), in formula A#B, se esiste una biezione f : A → B. La relazione # è una

relazione di equivalenza. In effetti A#A tramite idA . Se A#B tramite f : A → B e se B#C tramite

g : B → C, allora A#C tramite g ◦ f . Se A#B tramite f : A → B, allora B#A tramite f −1 .

2.3.4 Definizione. Diciamo che un insieme A è finito se A = ∅ o se esiste un (n ∈ N) tale che

A#{1, . . . , n}. In questo caso la cardinalità #A di A è #A = 0, e rispettivamente, #A = n. Se

A non è finito è infinito. A è numerabile se è finito o se A#N. Scriviamo #A = #B se A#B.

Vedremo nella Sezione 2.5 che la cardinalità di un insieme è unica.

2.3.5 Nota. Attenzione: Alcuni autori dicono che A è numerabile, solo se A#N.

2.3.6 Esempio. N, Z e Q sono numerabili. R o anche [0, 1] non sono numerabili.

2.3.7 Esercizio. Sia m ∈ N. Due numeri a, b ∈ Z sono congrui modulo m, in formule

a ≡ b mod m

o

a ≡m b,

se la differenza a − b è divisa da m, cioè se m|(a − b). Dimostrare che la relazione ≡m è una

relazione di equivalenza.

Capitolo 2. Relazioni

26

2.3.8 Esercizio. (∗) Sia C una relazione riflessiva e transitiva sull’insieme A.

1. Dimostrare che la relazione \ definita come a \ b, se a C b e b C a, è una relazione di

equivalenza.

2. Se C è un ordinamento parziale, qual’è \?

2.4

Classe di equivalenza

2.4.1 Esempio. Torniamo all’esempio 2.3.1 e guardiamo l’insieme A di tutti i prezzi che abbiamo trovato. Per un prezzo p ∈ A vogliamo sapere tutti i prezzi q ∈ A che cadano nella stessa

classe di p, cioè tutte le q con q ≈ p. L’insieme che otteniamo ha la forma

{q ∈ A : 100m ≤ q ≤ 100m + 99}

per un m ∈ N0 opportuno. Osserviamo che questa classe non cambierebbe se iniziassimo con

un altro suo elemento p0 ≈ p. La classe di un p00 0 p invece è descritta da un altro m00 , m.

Quindi tutti le q ≈ p e q00 ≈ p00 appartengono a classi diverse, cioè classi diverse sono disgiunte.

Alla fine ogni p è contenuto almeno nella propria classe. Otteniamo allora in questo modo una

suddivisione di A in classi disgiunte.

2.4.2 Definizione. Sia A un insieme. Una partizione di un insieme A , ∅ è una famiglia Ai

i∈I

di sottoinsiemi non vuoti ∅ , Ai ⊂ A, tale che

i , j =⇒ Ai ∩ A j = ∅

[

Ai = A.

i∈I

In altre parole, ogni a ∈ A appartiene ad uno ed uno solo degli insiemi Ai della partizione.

2.4.3 Definizione. Sia ∼ una relazione di equivalenza su A. Per ogni a ∈ A notiamo

[a]∼ = a0 ∈ A : a0 ∼ a

la sua classe di equivalenza (modulo ∼). Ogni elemento a0 ∈ [a]∼ si chiama rappresentante di

[a]∼ . (Cioè [a]∼ è l’insieme di tutti i suoi rappresentanti.) L’insieme quoziente di A (modulo ∼)

è

A/∼ = [a]∼ : a ∈ A ,

l’insieme di tutte le classi di equivalenza.

2.5. Appendice: Supplementi sulla cardinalità

27

2.4.4 Teorema. A/∼ è una partizione di A, cioè ogni a ∈ A appartiene ad esattamente una

classe di equivalenza.

D. Sia a ∈ A. Allora [a]∼ non è vuoto perché almeno a ∈ [a]∼ . Allo stesso modo,

ogni a appartiene almeno alla propria classe di equivalenza [a]∼ .

Rimane da dimostrare che [a]∼ , [b]∼ implica che [a]∼ ∩ [b]∼ = ∅. Dimostriamo invece

la contrapposizione [a]∼ ∩ [b]∼ , ∅ implica [a]∼ = [b]∼ . Secondo l’ipotesi [a]∼ e [b]∼ hanno

almeno un elemento c in comune, cioè a ∼ c ∼ b, cosicché a ∼ b. Quindi un qualsiasi elemento

d ∈ [a]∼ fa anche parte di [b]∼ , perché d ∼ a ∼ b, e viceversa.

2.4.5 Esempio. Sia f : A → B una funzione. La relazione a ∼ a0 se f (a) = f (a0 ) è una relazione

f

di equivalenza. (Esercizio!) La classe di equivalenza di a ∈ A è [a]∼f = {a0 ∈ A : f (a0 ) =

f (a)} = f −1 { f (a)} . La costruzione dell’insieme A0 nell’Esempio 1.2.12 corrisponde a scegliere

esattamente un elemento di ogni classe di equivalenza.

Consideriamo la funzione f∼ : [a]∼f 7→ f (a). Per calcolare f∼ ([a]∼f ) si procede cosı̀: scegli un

rappresentante a0 di [a]∼f e calcola f (a0 ). La funzione f∼ è ben definita perché f (a0 ) = f (a)

è lo stesso per tutte le a0 ∈ [a]∼f , cosicché il valore prescritto f∼ ([a]∼f ) non dipende dalla

scelta del rappresentante. Inoltre f∼ è iniettiva perchè secondo il teorema f (a) = f (a0 ) si ha

proprio che [a]∼f = [a0 ]∼f .

2.4.6 Esercizio.

1. Determinare Z/≡2 per la relazione ≡2 (congruenza modulo 2 su Z come

nell’Esercizio 2.3.7), cioè descrivere tutte le classi di equivalenza [n]≡2 .

f

2. Sia f : Z → Z definita come f (n) = (−1)n . Dimostrare che le relazioni ≡2 e ∼ sono uguali,

f

cioè (n ≡ m mod 2) se e solo se (n ∼ m).

2.4.7 Esercizio. (∗) Sia f : A → B una funzione. Dimostrare che (A/ f )#( f (A)). (Ciò signi∼

f

fica che esistono tante classi di equivalenza diverse (modulo ∼) quanti ci sono i valori di

f .)

2.5

Appendice: Supplementi sulla cardinalità

Concludiamo questo capitolo con qualche risultato sulla cardinalità degli insiemi. Tutti questi

risultati porteranno a risutati analoghi sulla dimensione di spazi vettoriali (essenzialmente la

cardinalità di basi; s.v. Sezione 5.8). Lo scopo è di stabilire che la cardinalità di un insieme è

unica.

Capitolo 2. Relazioni

28

2.5.1 Proposizione. Sia A , ∅ un insieme finito e B ⊂ A un suo sottoinsieme. Allora anche B è

finito.

D. Sia #A = n , 0. Allora tramite una biezione opportuna possiamo supporre che

A = {1, . . . , n} ⊃ B. Dopo avere applicata una permutazione opportuna, possiamo addiritura

supporre che B = {1, . . . , m} con m ≤ n. (Le permutazioni, che discuteremo nella Sezione 3.5,

sono esattamente le biezioni dell’insieme {1, . . . , n}. L’esistenza della permutazione opportuna che ci serve va dimostrata con l’induzione. Però non l’approfondiamo questo argomento.)

Quindi, anche B è finito.

2.5.2 Proposizione. Esiste un biezione {1, . . . , n} → {1, . . . , m} se e solo se n = m.

D. Chiaramente, se m = n esiste un biezione (l’idenitità di {1, . . . , n} = {1, . . . , m}).

Quindi, dobbiamo dimostrare che l’esistenza di una biezione implica n = m. Procediamo con

l’induzione per n ∈ N.

Sia n = 1. Sia poi m , 1. Allora nessuna funzione {1, . . . , m} → {1} può essere iniettiva,

perché tutti gli elementi di {1, . . . , m} sono posti sullo stesso elemento 1. Quindi, se esiste una

biezione allora m = 1.

Valga allora l’affermazione per un n ∈ N. Dobbiamo concludere che valga anche per n +

f ({1,...,n})

è una biezione sul

1. Sia f : {1, . . . , n, n + 1} → {1, . . . , m} una biezione. Quindi, f |{1,...,n}

sottoinsieme f ({1, . . . , n}) di {1, . . . , m} al quale manca l’elemento f (n + 1). Dopa l’applicazione

di una trasposizione opportuna (s.v. bene il Lemma 3.5.6) possiamo supporre che f ({1, . . . , n}) =

{1, . . . , m − 1}. Allora secondo l’ipotesi m − 1 = n, ossia n = m + 1.

2.5.3 Corollario. Sia A un insieme finito con #A = n ∈ N. Allora per ogni insieme B vale

B#A =⇒ B è finito e #B = m =⇒ m = n, cioè la cardinalità è unica.

Per definizione un insieme infinito non è equipotente con nessun insieme finito. Ci limitiamo

di dare qualche criterio dell’esistenza di insiemi infiniti.

2.5.4 Lemma. Se esiste una iniezione f : A → A su un sottoinsieme f (A) , A proprio, allora

A non è finito.

D. Supponiamo che A sia finito, quindi, possiamo anche supporre subito che A =

{1, . . . , n}. Come nella dimostrazione precedente possiamo inoltre anche supporre che f (A) =

{1, . . . , n − 1}. Allora f | f (A) sarebbe una biezione da un insieme con cardinalità #A = n su un

insieme con cardinalità # f (A) = n − 1. Contraddizione.

2.5. Appendice: Supplementi sulla cardinalità

2.5.5 Corollario.

29

1. L’insieme N non è finito.

2. Se esiste un’iniezione N → A, allora anche A non è finito.

3. In particolare, C ⊃ R ⊃ Q ⊃ Z ⊃ N0 ⊃ N non sono finiti, e se A#N allora A non è finito.

D. La terza affermazione è un corollario delle prime due. Le prime due seguono

dal lemma, perché in ogni case esiste una surgezione su un sottoinsieme proprio.

30

Capitolo 2. Relazioni

Capitolo 3

Gruppi, monoidi e semigruppi

Se X è un insieme, per esempio il nostro spazio “reale” tridimensionale R3 , possiamo guar

dare lo spazio Fbi (X) = f : X → X | f è biettiva di tutte le trasformazioni di questo spazio.

Riconoscere questo spazio con la composizione ( f, g) 7→ f ◦ g come gruppo è stato proprio

l’inizio della teoria dei gruppi. Le conseguenze sono tante. Per esempio dall’invarianza di una

teoria fisica su tutte le trasformazioni di un sottogruppo H ⊂ Fbi (R3 ) di trasformazioni scaturiscono leggi di conservazione di quantità fisiche (invarianza su traslazioni → conservazione del

momento, invarianza su rotazioni → conservazione del momento angolare).

Le proprietà principali del gruppo Fbi (X) sono: La composizione ◦ è associativa, cioè ( f ◦

g) ◦ h = f ◦ (g ◦ h) (s.v. Proposizione 1.2.17). Esiste la trasformazione identica idX ∈ Fbi (X) che

soddisfa idX ◦ f = f = f ◦ idX (s.v. Osservazione 1.2.15). E per ogni trasformazione f ∈ Fbi (X)

esiste la trasformazione inversa f −1 ∈ Fbi (X) tale che f −1 ◦ f = idX = f ◦ f −1 (s.v. Proposizione

1.2.18 e Teorema 1.2.19).

Alcune di queste proprietà valgono anche senza la restrizione che le funzioni siano biettive.

Per esempio la composizione ◦ sull’insieme F(X) = f : X → X di tutte le funzioni di X è

sempre associativa e F(X) contiene anche la trasformazione identica. Manca però l’inversa di

alcune funzioni. Per esempio se X ha almeno due elementi, allora per ogni x0 ∈ X la funzione

costante f x0 : x 7→ x0 non è né iniettiva né surgettiva. L’insieme di tutte queste funzioni costanti invece, è un sottosemigruppo al quale manca l’identità. In seguito definiremo tutte queste

strutture.

3.1

Definizioni e primi risultati

Un’operazione ∗ su un insieme G è semplicemente una funzione ∗ : G × G → G. (Più precisamente, si tratta di un’operazione binaria. Un’operazione unaria sarebbe una funzione G → G,

31

Capitolo 3. Gruppi, monoidi e semigruppi

32

mentre un’operazione n–aria sarebbe una funzione Gn → G.) La sola differenza rispetto ad una

funzione G × G → G riguarda la notazione nel senso che invece di ∗(a, b), scriveremo piuttosto

a ∗ b. Simboli soliti per indicare un’operazione sono ·, +, ◦, ?, e tanti altri. Per la struttura G con

l’operazione ∗ scriviamo anche la coppia (G, ∗).

3.1.1 Definizione. Una coppia (G, ∗) che consiste di un insieme G e di un’operazione binaria ∗

su G, è un semigruppo se l’operazione ∗ è associativa, cioè se

(a ∗ b) ∗ c = a ∗ (b ∗ c)

per ogni

a, b, c ∈ G.

In questo caso non usiamo più parentesi e denotiamo tutti e due gli elementi (a ∗ b) ∗ c =

a ∗ (b ∗ c) di G con a ∗ b ∗ c.

3.1.2 Definizione. Un monoide è un semigruppo (G, ∗) che possiede un elemento distinto e ∈ G

tale che

e∗a = a = a∗e

per ogni

a ∈ G.

Questo elemento e lo chiamiamo l’identità o l’elemento neutrale di G.

Vediamo subito che l’elemento neutrale è unico. In effetti, la seguente proposizione è leggermente più generale.

3.1.3 Proposizione. Sia (G, ∗) un semigruppo e siano e s , ed ∈ G rispettivamente un’identità a

sinistra e un’identità a destra (cioè e s ∗ a = a = a ∗ ed per ogni a ∈ G). Allora e s = ed e, quindi

e := e s = ed è un elemento neutrale. Se e0s , e0d ∈ G è un’altra coppia con queste proprietà e

quindi e0s = e0d = e0 è un altro elemento neutrale, allora e = e0 .

D. Vale e s = e s ∗ ed = ed . Sostituendo poi ed con e0d , troviamo e s = e0d . Secondo la

prima affermazione tutti e quattro e s , ed , e0s ed e0d , devono essere uguali.

3.1.4 Definizione. Un gruppo infine, è un monoide (G, ∗) (con identità e) tale che ogni a ∈ G

possiede un inverso a−1 ∈ G tale che

a−1 ∗ a = e = a ∗ a−1 .

Anche qui vale un’affermazione analoga alla Proposizione 1.2.18 (con dimostrazione analoga), cioè per trovare un inverso basta trovare un inverso a sinistra ed un inverso a destra che poi

si dimostra essere uguali e quindi, anche l’inverso e unico. Con questo dimostriamo facilmente

che b−1 ∗ a−1 è l’inverso di a ∗ b. (Eserciozio: Dimostrare che b−1 ∗ a−1 fornisce sia un inverso a

sinistra sia un inverso a destra.)

3.1. Definizioni e primi risultati

33

Raccogliamo queste tre definizioni per le proprietà di un’operazione ∗ su un insieme G in

un diagramma.

associatività di ∗

→

esistenza di e

semigruppo

esistenza di a−1

→

monoide

→

gruppo

3.1.5 Esempio. Abbiamo già visto che (Fbi (X), ◦) è un gruppo e (F(X), ◦) è un monoide (e se

X ha almeno due elementi non è un gruppo). Denotiamo con Fin (X) e F sur (X) rispettivamente lo

spazio delle funzioni iniettive e surgettive. Allora sia (Fin (X), ◦) che (F sur (X), ◦) sono monoidi,

mentre (F(X)\Fin (X), ◦) e (F(X)\F sur (X), ◦) sono semigruppi ma non monoidi. Basta osservare

(esercizio!) che la composta di due funzioni iniettive (surgettive) è iniettiva (surgettiva) mentre

la composta di due funzioni non iniettive (non surgettive) non può essere iniettiva (surgettiva).

3.1.6 Esempio. Un semigruppo che contiene un solo elemento e è automaticamente un gruppo.

(Perchè?) Lo chiamiamo il gruppo banale.

3.1.7 Esercizio. Trovare tutti i gruppi (monoidi) con due elementi.

3.1.8 Esempio. Sia Ω un insieme non vuoto. Allora (P(Ω), ∩) e (P(Ω), ∪) sono monoidi. (Quali

sono gli elementi neutrali?)

3.1.9 Esempio. (N, +) è un semigruppo ma non è un monoide. (N, ·) e (N0 , +) sono monoidi ma

non sono gruppi. (Z, +) è un gruppo, mentre (Z, ·) è un monoide ma non è un gruppo. (R, +) è un

gruppo. (R, ·) è un monoide ma non è un gruppo. Mentre (R∗ , ·) è un gruppo (dove R∗ := R\{0}).

Le stesse affermazioni valgono anche per (Q, +), (Q, ·) e (Q∗ , ·).

(Z, −) non è un semigruppo.

Nell’esempio 3.1.5 abbiamo considerato sottoinsiemi del semigruppo (F(X), ◦) che sono

ancora semigruppi sotto la stessa operazione ◦. Il punto decisivo era assicurarci che l’operazione ◦ lasciasse invariato il sottoinsieme, mentre l’associatività segue banalmente da quella

sull’insieme più grande F(X).

3.1.10 Definizione.

1. Un sottosemigruppo (H, ∗) di un semigruppo (G, ∗) è un sottoinsie-

me H ⊂ G tale che a ∗ b ∈ H per ogni a, b ∈ H.

2. Un sottomonoide di un monoide (G, ∗) è un sottosemigruppo (H, ∗) che contiene l’identità

eG di G.

Capitolo 3. Gruppi, monoidi e semigruppi

34

3. Un sottogruppo di un gruppo (G, ∗) è un sottomonoide (H, ∗) tale che a ∈ H implica

a−1 ∈ H.

3.1.11 Nota. Un sottosemigruppo di un monoide non è necessariamente un sottomonoide. Per

esempio, se Ω1 ! Ω2 , ∅ allora (P(Ω2 ), ∩) è un sottosemigruppo di (P(Ω1 ), ∩) ma non un sottomonoide, perché P(Ω2 ) non contiene l’identità Ω1 di P(Ω1 ). Però P(Ω2 ) è sempre un monoide

(con l’identità Ω2 diversa dall’identità Ω1 di P(Ω1 )).

Un sottosemigruppo di un semigruppo può essere un gruppo. Per esempio, sia X = {x1 , x2 }.

Consideriamo il sottosemigruppo F1 = { f1 : x 7→ x1 } del semigruppo F(X)\Fin = F(X)\F sur =

{x 7→ x1 , x 7→ x2 }. Il semigruppo F1 contiene un solo elemento e perciò, è sia un monoide sia

un gruppo. Ricordiamoci che {x 7→ x1 , x 7→ x2 } non è neanche un monoide.

Se (G, ∗) è un monoide, il sottoinsieme Ginv = {a ∈ G | ∃a−1 : a−1 ∗ a = e = a ∗ a−1 } di tutti

gli elementi invertibili è sia un sottomonoide sia un gruppo.

3.1.12 Esercizio. Consideriamo la coppia (R, ∗), dove a ∗ b := ab − a − b + 2.

1. Dimostrare che (R, ∗) è un monoide.

2. (∗) (R, ∗) non è un gruppo. (Perché?) Verificare se (R, ∗) contenga sottosemigruppi non

banali che sono gruppi.

e ∗˜ ) aumentando il

A volte è necessario trasformare un semigruppo (G, ∗) in un monoide (G,

semigruppo con un’identità artificiale ẽ. Attenzione però: Se G era già un monoide con identità

e Anche se G era un gruppo, G

e non lo è più.

e, allora e , ẽ, cosicché e non è più l’identità di G.

e che abbia un inverso è ẽ.) La dimostrazione della seguente

(In effetti, l’unico elemento di G

proposizione la lasciamo come esercizio.

e = G ∪ {ẽ} dove ẽ < G. Su G

e defi3.1.13 Proposizione. Sia (G, ∗) un semigruppo. Poniamo G

niamo l’operazione ∗˜ nel modo seguente: ẽ ∗˜ ẽ = ẽ, a ∗˜ ẽ = ẽ ∗˜ a = a, a ∗˜ b = a ∗ b se a, b ∈ G.

e ∗˜ ) è un monoide con identità ẽ.

Allora (G,

Ancora qualche notazione: Un semigruppo (monoide, gruppo) (G, ∗) si chiama abeliano se

la sua operazione è commutativa, cioè se a ∗ b = b ∗ a per ogni a, b ∈ G.

3.1.14 Esempio. I monoidi (R, +) e (R, ·) e con loro anche tutti i loro sottosemigruppi sono

abeliani. I monoidi (P(Ω), ∩) e (P(Ω), ∪) sono abeliani. Se #X ≥ 2 allora il monoide (F, X) e

tutti i suoi sottosemigruppi che abbiamo considerato finora non sono abeliani.

3.1.15 Esercizio. Trovare tutti i semigruppi non abeliani con due elementi.

3.1. Definizioni e primi risultati

35

Diciamo che un semigruppo (G, +) con l’operazione + è scritto additivo. Se un semigruppo

è scritto additivo, allora assumiamo sempre che sia abeliano. Diciamo che un semigruppo (G, ·)

con l’operazione · è scritto moltiplicativo. In questo caso scriviamo spesso ab invece di a · b. Un

semigruppo scritto moltiplicativo non è necessariamente abeliano (ma può esserlo come (R, ·)).

Se il semigruppo (il monoide, il gruppo) (G, ∗) non è abeliano possiamo anche pensare di

definire l’operazione opposta ∗op come a∗op b := b∗a. È facile verificare che anche l’operazione

∗op è associativa (esercizio!). Quindi (G, ∗op ) (o per brevità Gop ) è un semigruppo (un monoide con la stessa identità, un gruppo con gli stessi elementi inversi). Diciamo che (G, ∗op ) è il

semigruppo (il monoide, il gruppo) opposto di (G, ∗).

Chiudiamo questa sezione con qualche miglioramento che riguarda il numero di proprietà

che dobbiamo controllare per essere sicuri che un semigruppo (G, ∗) sia un gruppo.

3.1.16 Teorema. Sia (G, ∗) un semigruppo con le seguenti proprietà:

1. Esiste un elemento e s ∈ G tale che e s ∗ a = a per ogni a ∈ G.

2. Per ogni a ∈ G esiste un elemento a s ∈ G tale che a s ∗ a = e s .

Allora (G, ∗) è un gruppo con l’identità e = e s e per ogni a ∈ G l’inverso è a−1 = a s .

D. Prima dimostreremo che anche a ∗ a s = e s . (Attenzione però: Finché non

abbiamo dimostrato che e s sia l’identità, questo non implica ancora che a abbia un inverso,

perché senza l’identità non è definito che cosa sia un inverso.) Per un a ∈ G arbitrario

denotiamo con (a s ) s un inverso a sinistra di un suo inverso a sinistra a s (che esistono tutti e

due secondo le ipotesi del teorema). Allora

a ∗ a s = e s ∗ a ∗ a s = (a s ) s ∗ a s ∗ a ∗ a s = (a s ) s ∗ e s ∗ a s = (a s ) s ∗ a s = e s .

Poi da ciò segue facilmente che anche a ∗ e s = a ∗ a s ∗ a = e s ∗ a = a. Questo vale per ogni

a ∈ G e quindi e s è un’identità (cioè e s è l’unica identità). Secondo l’equazione precedente,

a s é l’unico inverso di a.

Evidentemente il teorema vale anche se supponiamo l’esistenza di un’identità a destra

ed e per ogni a ∈ G, l’esistenza di un inverso a destra ad ∈ G. Attenzione però: Notiamo che

il teorema non vale se supponiamo l’esistenza di un’identità a sinistra e s e per ogni a ∈ G,

l’esistenza di un inverso a destra ad ∈ G.

3.1.17 Esempio. Sia G = {a, b} un semigruppo con l’operazione ∗ definita secondo la

seguente tabella della moltiplicazione:

∗ a b

a a b

b a b