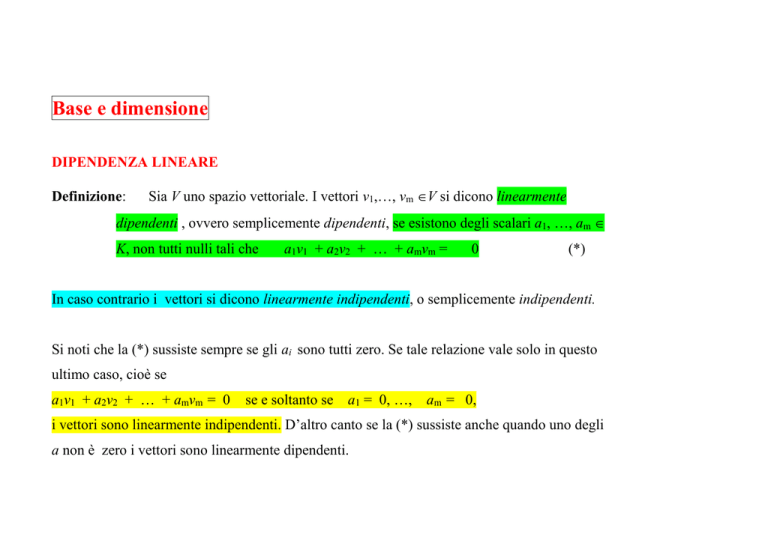

Base e dimensione

DIPENDENZA LINEARE

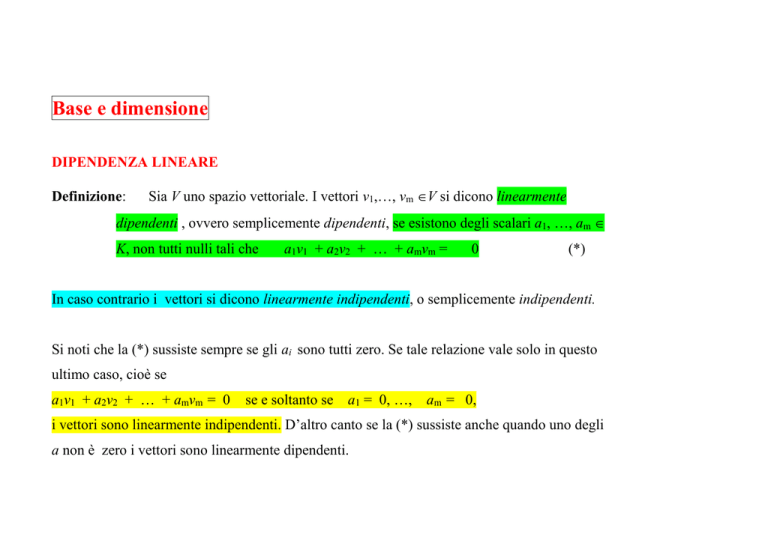

Definizione:

Sia V uno spazio vettoriale. I vettori v1,…, vm V si dicono linearmente

dipendenti , ovvero semplicemente dipendenti, se esistono degli scalari a1, …, am

K, non tutti nulli tali che

a1v1 + a2v2 + … + amvm =

0

(*)

In caso contrario i vettori si dicono linearmente indipendenti, o semplicemente indipendenti.

Si noti che la (*) sussiste sempre se gli ai sono tutti zero. Se tale relazione vale solo in questo

ultimo caso, cioè se

a1v1 + a2v2 + … + amvm = 0

se e soltanto se

a1 = 0, …,

am = 0,

i vettori sono linearmente indipendenti. D’altro canto se la (*) sussiste anche quando uno degli

a non è zero i vettori sono linearmente dipendenti.

Osserviamo che se 0 è uno dei vettori v1 , … ,vm diciamo v1 = 0, detti vettori debbono essere

dipendenti, perché

1v1 + 0v2 + … + 0vm = 1 0 + 0 + ... + 0 = 0

ed il coefficiente di v1 non è 0. D’altro canto ogni vettore v non zero è di per sé indipendente,

poiché

kv = 0 ,

v 0 implica k = 0

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio

I vettori u = (1, -1, 0), v = (1,3, -1) e w = (5, 3, -2) sono dipendenti, dato

che per 3u + 2v - w = 0 si ha:

3 (1, -1, 0) + 2 (1,3, -1) - (5, 3, -2) = (0,0,0)

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio

Dimostriamo che i vettori u = (6,2,3,4), v = (0,5,-3,1) e w = (0,0,7,-2)

sono indipendenti.Supponiamo infatti xu + yv + zw = 0, con x, y, z

incognite scalari. Allora

(0, 0, 0, 0) = x (6,2,3,4) + y (0,5,-3,1) +

z (0,0,7,-2)

= (6 x, 2 x + 5 y , 3 x – 3 y + 7 z , 4 x + y - 2 z)

e così, per uguaglianza delle componenti corrispondenti,

6x

= 0

2x+ 5y

= 0

3x–3y + 7z = 0

4x+y- 2z

= 0

La prima equazione porta x = 0 ; la seconda, con x = 0, ci dà y = 0 ; e la terza,

con x = 0, y = 0, dà z = 0. Così

xu + yv + zw = 0

implica

x = 0, y = 0,

z=0

E di conseguenza u, v, w sono indipendenti.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Osserviamo che i vettori dell’esempio precedente formano una matrice a gradini:

4

6 2 3

0 5 3 1

0 0 7 2

Così abbiamo dimostrato che le righe (non zero) della matrice a gradini suddetta sono

indipendenti. Questo risultato resta vero in generale; noi lo proponiamo formalmente come

teorema, dal momento che sarà usato con frequenza.

Teorema : Le righe non zero di una matrice a gradini sono linearmente indipendenti. Il

concetto di dipendenza può essere esteso a più di un vettore in modo equivalente:

I vettori v1, … , vm sono linearmente dipendenti solo ed esclusivamente se uno di essi è una

combinazione lineare degli altri.

Nota 1.

L’insieme (v1 , …, vm ) si chiama insieme dipendente, o indipendente, a seconda

che i vettori v1 , …, vm sono dipendenti o indipendenti. Definiamo inoltre come

indipendente l’insieme vuoto .

Nota 2.

Se due dei vettori v1 , …, vm sono uguali , diciamo v1 = v2 detti vettori sono

dipendenti. Infatti

v1 - v2 + 0 v3 + … + 0 vm

= 0 e il coefficiente di v1 non è

zero.

Nota 3.

Due vettori v1 e v2 sono dipendenti solo ed unicamente se uno di loro è multiplo

dell’altro.

Nota 4.

Un insieme che contenga un sottoinsieme dipendente è esso stesso dipendente.

Perciò qualsiasi sottoinsieme di un insieme indipendente è indipendente.

Nota 5.

Se l’insieme v1 , …, vm è indipendente, ogni diversa disposizione dei vettori

vi1 , vi2 , … , vim è ancora indipendente.

Nota 6.

Nello spazio reale R3 la dipendenza dei vettori può essere descritta geometricamente

nel modo che segue: due vettori u, v sono dipendenti solo ed esclusivamente se giacciono sulla

stessa retta per l’origine; tre qualsiasi vettori u, v, w sono dipendenti solo ed unicamente se

giacciono sullo stesso piano passante per l’origine:

BASE E DIMENSIONE

Definizione:

Uno spazio vettoriale V si dice di dimensione finita n, ovvero si dice ndimensionale, usando la notazione

dim V

= n, se esistono dei vettori

linearmente indipendenti e1, e2, … en che generano V. La sequenza {e1, e2, …

en } si chiama allora base di V.

Teorema:

Sia V uno spazio vettoriale di dimensioni finite. Allora ogni base di V ha lo

stesso numero di elementi.

Lo spazio vettoriale {0} ha dimensione zero per definizione. Quando uno spazio vettoriale non

è di dimensione finita, viene definito a dimensione infinita.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Consideriamo lo spazio vettoriale Rn, costituito da tante n-ple di elementi di R.

I vettori

e1 = (1,0,0, …, 0,0)

e2 = (0,1,0, …, 0,0)

………………………………..

en = (0,0,0, …, 0,1)

formano una base, chiamata base usuale, di Rn. Così Rn ha dimensione n.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Sia U lo spazio vettoriale di tutte matrici 2 x 3. Allora le matrici

1 0 0

0 0 0

0 1 0

0 0 0

0 0 1

0 0 0

0 0 0

1 0 0

0 0 0

0 1 0

0 0 0

0 0 1

costituiscono una base di U; quindi dim U = 6. Più generalmente poniamo che sia V lo spazio

vettoriale di tutte le matrici m x n su K, e sia Eij V la matrice che ha 1 come elemento

ij – esimo e zero per il resto. Allora l’insieme Eij è una base, detta base usuale, di V; di

conseguenza dim V = mn.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio 5.5: Sia W lo spazio vettoriale di polinomi (in t) di grado ≤ n.

L’insieme 1, t, t2, …, tn è linearmente indipendente, e genera W.

Esso è perciò una base di W, ed è dim W = n + 1.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Il precedente, fondamentale teorema sulle dimensioni è conseguenza del seguente importante

“lemma di sostituzione”:

Poniamo ora che S sia un sottoinsieme di uno spazio vettoriale V. Chiameremo v1, … , vm

sottoinsieme indipendente massimo di S se:

(i)

(ii)

esso è un sottoinsieme indipendente di S; e

v1, … , vm, w è indipendente per qualsiasi w S.

Vale il teorema seguente.

Teorema : Poniamo che S generi V e che v1,

… , vm sia un sottoinsieme indipendente

massimo di S. Allora v1, … , vm è una base di V.

La relazione principale tra dimensione di uno spazio vettoriale e i suoi sottoinsiemi

indipendenti è contenuta nel

Teorema: Sia V una dimensione finita di n. Allora:

(i)

ogni insieme di n + 1 o più vettori è linearmente dipendente.

(ii)

Ogni insieme linearmente indipendente è parte di una base, ovvero può essere esteso alla

suddetta.

(iii) Un insieme linearmente indipendente con n elementi è una base.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio I quattro vettori in R4

(1,1,1,1),

(0,1,1,1) ,

(0,0,1,1) ,

(0,0,0,1)

sono linearmente indipendenti, dato che costituiscono una matrice a gradini. Inoltre, essendo

dim R4 = 4, essi formano una base di R4 .

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: I quattro vettori in R3

(257, -132, 58)

(43, 0, -17), (521, -317, 94),

(328, -512, -731)

debbono essere linearmente dipendenti: essi derivano da uno spazio vettoriale di dimensione 3.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Teorema: Sia W un sottospazio dello spazio vettoriale V ad n dimensioni. Allora

dim W ≤

n. Se in particolare è dim W = n, allora W = V.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio : Sia per ipotesi W un sottospazio dello spazio reale R3. Ora dim R3 = 3. Quindi per

il teorema precedente la dimensione di W può solo essere 0, 1, 2 o 3.Si possono dare i

seguenti casi:

(i)

dim W = 0

e allora W = 0 , un punto

(ii) dim W = 1

e W è una retta per l’origine;

(iii) dim W = 2

e W è un piano per l’origine;

(iv) dim W = 3

e W è l’intero spazio R3.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Teorema: Siano U e W dei sottospazi a dimensioni finite di uno spazio vettoriale V. Allora U

+ W ha dimensione finita, e

dim (U + W) = dim U + dim W - dim (U ∩ W)

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio Poniamo che U e W siano rispettivamente il piano xy e il piano yz in

R3 : U = (a,b,0) , W = (0,b,c) . Dato che R3 = U + W, dim (U + W) = 3. Inoltre

dim U = 2 e dim W = 2. Per il teorema precedente,

3= 2 + 2 - dim (U ∩ W) ovvero dim (U ∩ W) = 1

Notare che ciò è in accordo col fatto che U ∩ W è l’asse y, cioè U ∩ W = (0,b,0) , ed ha

così dimensione 1.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

APPLICAZIONI

Siano A e B due insiemi arbitrari. Supponiamo che ad ogni a A venga associato un unico elemento di B; la

relazione che associa agli elementi di A quelli di B è chiamata funzione, o applicazione (o ancora, mappa) da

A in B e si scrive

f: A B

Scriviamo f(a), leggendo “f di a”, per quell’elemento di B che f assegna ad a A; esso si

chiama valore di f in a, o immagine di a attraverso f. Se A’ è un qualsiasi sottoinsieme di A,

f(A’) indica l’insieme di immagini di elementi di A’; se B’ è un sottoinsieme di B, f-1 (B’) indica

l’insieme di elementi di A, l’immagine dei quali giace in B’:

f(A’) = f(a) : a A’

e

f-1(B’) = a A : f(a) B’

Chiamiamo f(A’) l’immagine di A’, e

f-1 (B’)

l’immagine inversa, di B’. In particolare

l’insieme di tutte le immagini, ovvero f (A), si chiama immagine di f. Inoltre A viene chiamato

dominio dell’applicazione f:A B; B ne è il codominio.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio : Consideriamo la matrice 2 x 3 A =

1 3 5

2 4 1 .Se

scriviamo i vettori in R3 e

R2 come vettori colonna, A determina l’applicazione T : R3 R2

v -> Av , ovvero

Così se v =

3

1

2

T(v) = Av ,

, allora T(v) = Av =

definita da

v R3

1 3 5 3

2 4 1 . 1

2

10

.

12

=

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Osservazione: Ogni matrice A di ordine m x n determina l’applicazione T : Rn Rm

definita da v -> Av in cui i vettori Rn e Rm in sono scritti come vettori colonna. Per

convenzione indicheremo abitualmente con A la suddetta applicazione: lo stesso simbolo usato

per la matrice.

OPERATORI LINEARI

Siano U e V degli spazi vettoriali. Un’applicazione F : V U si chiamerà applicazione

lineare se soddisfa le seguenti due condizioni:

(1) Per ogni v, w V , F(v + w) = F(v) + F(w)

(2) Per ogni

k R ed ogni v V, F(kv) = kF(v)

In altri termini, F : V U è lineare se “conserva” le due operazioni basilari in uno spazio

vettoriale, addizione vettoriale e moltiplicazione per uno scalare.

Sostituendo k = 0 nella (2) si ottiene F(0) = 0. Come dire che ogni applicazione lineare

riduce il vettore zero al vettore zero.

Ora per qualsiasi scalare a, b K e vettore v, w V otteniamo, applicando entrambe le

condizioni di linearità:

F (av + bw) = F (av) + F (bw) = aF (v) + bF (w)

Più in generale, per ogni scalare ai K e ogni vettore vi V otteniamo la proprietà

fondamentale delle applicazioni lineari:

F (a1v1 + a2v2+ …+ anvn) = a1F (v1) + a2F (v2) + … + anF (vn)

Osserviamo che la condizione F (av + bw) = aF (v) + bF (w) caratterizza compiutamente

una applicazione lineare, ed è talvolta usata come sua definizione.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Sia A una matrice m x n su di un campo K. Come osservato in precedenza, con

l’associazione v -> Av.

A determina un’applicazione T : Rn Rm . T è lineare. Infatti, per le proprietà delle matrici

T(v + w) = A (v + w) = Av + Aw = T(v) + T(w)

e

T(kv) = A(kv) = kAv = kT(v)

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Sia F : R3 R3 l’applicazione “proiezione” nel piano xy: F(x,y,z) = (x,y,0).

Dimostriamo che F è lineare. Sia v = (a,b,c) e w = (a’, b’, c’). Quindi

F (v + w) = F ( a+ a’, b+ b’, c+ c’) =( a+ a’, b+ b’, 0)

= (a,b,0) + (a’, b’, 0) = F (v) + F (w)

e, per ogni k R,

F(kv) = F(ka, kb, kc) = (ka, kb, 0) = k(a,b,0) = kF(v)

Come dire che F è lineare.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Sia F : R2 R2 l’applicazione “traslazione” definita da F(x,y) = (x +1, y + 2).

Si noti che F(0) = F(0,0) = (1,2) ≠ 0. Cioè, il vettore zero non viene applicato verso il vettore

zero: F non è lineare.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio Sia F : V U l’applicazione che assegna 0 U ad ogni v V. Allora per ogni v ,

w V ed ogni k R, avremo

F (v + w) =

0 = 0 + 0 = F (v) + F (w)

= 0

=k0=

kF(v)

Così F è lineare. Chiameremo F applicazione zero e la indicheremo abitualmente con lo 0.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio Consideriamo l’applicazione identica I : V V che induce ogni v V in sé stesso.

Avremo allora per ogni v, w V ed ogni a, b K,

I(av + bw) = av + bw = aI(v) + bI(w)

Perciò I è lineare.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

NUCLEO ED IMMAGINE DI UN’APPLICAZIONE LINEARE

Definizione: Sia F : V U un’applicazione lineare. L’immagine di F, scritta Im F, è l’insieme

di elementi di U (punti immagine) per cui:

Im F = { u U : F(v) = u per alcuni v V}

il nucleo di F, scritto Ker F, è l’insieme di elementi di V che l’applicazione assegna a 0 U:

Ker F = { v V: F(v) = 0}

Teorema: Sia F : V U un’applicazione lineare. L’immagine di F è allora un sottospazio di

U, e il suo nucleo un sottospazio di V.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Sia F

: R3

R3 la proiezione applicata sul piano xy: F(x,y,z)

Evidentemente immagine di F è l’intero piano xy:

Im F = { (a,b,0) : a, b R}

= (x,y,0).

Notare che il nucleo di F è l’asse z:

Ker F ={ (0,0,c) :

c R}

poiché questi punti e solo questi vengono indotti dall’applicazione nel vettore zero 0 = (0,0,0)

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

MATRICI E APPLICAZIONI LINEARI

Consideriamo il caso generale di applicazioni lineari F: V U con dimV = m, dim U = n.

Siano inoltre { e1, …., em } e { f1 , …., fn } delle basi arbitrarie ma fissate di V ed U

rispettivamente.

Allora i vettori F(e1 ), …., F (e1 ) appartengono ad U e ciascuno è una combinazione degli fi .

F(e1 ) =

a11 f1 a12 f 2 a1n f n

F(e2 ) =

a21 f1 a22 f 2 a2n f n

……

F(em ) =

am1 f1 am 2 f 2 amn f n

La trasposta della matrice dei coefficienti è chiamata la rappresentazione matriciale di F in

relazione alle basi date.

a11

a12

a

1n

a 21

a 22

a2n

a m1

am2

a mn

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: Trovare la rappresentazione matriciale dell'operatore T(x,y) = (2y,3x-y)

relativamente alla base usuale (1,0), (0,1).

T(1,0)=(0,3)

T(0,1)=(2,-1)

A=

0 2

3 1

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

AUTOVALORI E AUTOVETTORI

Sia F: V V un operatore lineare. Chiediamoci se esistono vettori non nulli che vengono

trasformati in vettori paralleli: F(v) = av. Se questa equazione matriciale ammette soluzione

allora a si chiama autovalore e v autovetture.

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Esempio: trovare gli autovalori e gli autovettori non nulli della matrice A=

Cerchiamo uno scalare a e un vettore

x

y

1 2

.

3 2

tali che AX = aX cioè

1 2

3 2

x

y

=a

x

y

Questa equazione è equivalente al sistema

x + 2y = ax

(a-1)x - 2y = 0

3x + 2y = ay

-3x + (t-2) y = 0

Il secondo sistema è omogeneo e ammette una soluzione non nulla se e solo se il determinante

della matrice dei coefficienti è nullo.

a 1 2

a 2 3a 4 (a 4)( a 1) 0 a 4, a 1

det A =

3 a 2

Se a=4 il sistema si riduce alla equazione 3x-2y=0, Allora ad esempio (2,3) e ogni suo

multiplo è un autovetture. Se invece a=-1 allora il sistema si riduce a x+y=0 e dunque un

autovetture è (1, -1).

▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬▬

Più in generale se A è una matrice quadrata di ordine n

a11

a 21

a

nn

a12

a 22

a1n

a2n

a nn

chiamiamo matrice caratteristica di A la matrice tI - A

a12

a1n

t a11

t a 22 a 2 n

a

tI A 21

a

t

a

nn

nn

il suo determinante det(tI-A) si chiama il polinomio caratteristico di A.

Teorema Sia A una matrice quadrata di ordine n. Uno scalare a è un

autovalore di A se e solo se è una radice del polinomio caratteristico.

Nota 1. matrici simili hanno lo stesso polinomio caratteristico.

Nota 2. se le radici del polinomio caratteristico sono tutte reali allora la

matrice è diagonalizzabile.