SOMMARIO

INTRODUZIONE................................................................................................................................3

ABSTRACT.........................................................................................................................................4

1.

METAFORA E INTELLIGENZA ARTIFICIALE.....................................................................6

1.1

Cos’è la metafora? ...............................................................................................................6

1.2

Teorie contemporanee sulla metafora ..................................................................................7

1.2.1

Teorie letteraliste .........................................................................................................8

1.2.2

Teorie non letteraliste ..................................................................................................9

1.3

La metafora nell’ Intelligenza Artificiale...........................................................................11

1.3.1

Approcci letteralisti: Dan Fass e il Meta5.................................................................11

1.3.2

Approcci concettuali: James Martin e Midas ............................................................13

2. ELABORARE UN TESTO: SISTEMI CLASSICI E NUOVA IA..................................................15

2.1 Sistemi di IA (classica) e linguaggio ......................................................................................15

2.1.1 Analisi sintattica................................................................................................................16

2.1.2 Analisi semantica ..............................................................................................................20

2.2 Il connessionismo.....................................................................................................................21

2.3 “Nuova IA” e sistemi che apprendono.....................................................................................23

3. SISTEMI ARTIFICIALI DI ELABORAZIONE DI METAFORE BASATI

SULL’APPRENDIMENTO ANALOGICO......................................................................................28

3.1 Descrizione del sistema............................................................................................................29

3.1.1 Fase preliminare ...............................................................................................................29

3.1.2 Fase di apprendimento......................................................................................................31

3.1.3 Fase di valutazione ...........................................................................................................31

3.2 “Guidare” : risultati di un esperimento ....................................................................................32

3.3 Conclusioni ..............................................................................................................................33

BIBLIOGRAFIA ...............................................................................................................................35

2

INTRODUZIONE

Questo elaborato finale è frutto di domande che per lungo tempo mi sono posta circa la natura della

mente umana. Ciò che mi interessa, principalmente, è comprendere i meccanismi che stanno alla

base di alcuni particolari fenomeni cognitivi dell’individuo. In questa sede, mi sono occupata, nello

specifico, di uno dei comportamenti verbali più potenti ed efficaci dell’uomo, ovvero la

metaforizzazione.

Il quesito principale intorno al quale ruota il mio lavoro riguarda la possibilità che esistano sistemi

fisici diversi dall’uomo, e quindi artificiali, che siano in grado di riprodurre le fasi che portano alla

comprensione di una metafora. Il tentativo non è quello di comprendere l’intera natura della mente

umana, bensì quello di svelarne, almeno in linea di massima, alcune caratteristiche basilari. In

primo luogo, il tentativo è quello di avvalorare la tesi di un linguaggio “incorporato”, in cui le

metafore occupano un posto primario. Per lungo tempo e a torto, infatti, la metafora è stata svalutata

e considerata come qualcosa di secondario, un orpello retorico non rilevante dal punto di vista

dell’acquisizione di nuova conoscenza.

Successivamente ho tentato di dimostrare che esistono sistemi in grado di acquisire conoscenza

autonomamente, cioè senza che vi sia il bisogno di implementare appositi programmi costruiti al

calcolatore affinché abbia luogo l’apprendimento. Prima di descrivere questo tipo di sistemi ho

analizzato i tentativi di naturalizzazione della mente svolti in precedenza, con esempi di sistemi

costruiti per l’analisi del linguaggio naturale. Dopo aver dimostrato i loro punti deboli, ovvero il

fatto di essere sistemi o simbolici o capaci di apprendere, sono passata all’analisi di un sistema che

appaia, al tempo stesso, sia simbolico sia capace di apprendere. Per fare ciò non mi sono limitata

all’analisi di esperimenti già effettuati, ma, sulla base degli studi svolti da Elisabetta Gola sul verbo

vedere, ho dato luogo ad una verifica sperimentale, utilizzando come campo d’analisi il verbo

guidare. Nel corso dell’esperimento ho fornito al sistema un insieme di dati da apprendere, sulla

base dei quali ricavare delle regolarità che, pertanto, non vengono impartite al sistema ma vengono

letteralmente apprese. Sarà il sistema stesso ad autocrearsi regole, proiettando quanto già appreso

su contesti non noti, nel tentativo di disambiguarli. Grazie a ciò è stata smentita anche un’altra delle

false credenze che a lungo si sono avute sulla lingua: non vi sono semplicemente regole da seguire

rigidamente e sulla base delle quali costruire un testo, bensì i limiti entro i quali tali regole

sarebbero comprese vengono costantemente ridisegnati, ad opera del continuo imbattersi in nuove

situazioni alle quali noi parlanti dobbiamo, lingusticamente, adattarci. In tal modo i sistemi

3

artificiali e quelli biologici possono essere accomunati dalla loro dinamicità, in quanto entrambi

fronteggiano le situazioni nuove in un modo che è, contemporaneamente, controllato e creativo.

4

ABSTRACT

The aim of this work is the result of a series of question I had about the nature of human mind. I

want to understand, over all, some of the basic mechanism of individual cognition. Here I’m going

to analyze one of the most important verbal attitudes of the man: the way he understand metaphor.

The principal question is about the possibility of the existence of physical systems different from

man that are able to reproduce the same phases that take to the comprehension of a metaphor. I

don’t want to discover how the whole mind is done, I want to understand some of its basic

characteristics. At first, the tentative is that to prove the thesis of an “embodied” language, in which

metaphors take an important place. For long time, in fact, there has been a wrong theory about

metaphor, considered only for its aesthetic value in the language, not important for the acquisition

of new knowledge. Then I’ve tried to demonstrate that there are artificial systems that can acquire

knowledge by themselves, without the implementation of specific programs. Before this, I’ve

analyzed some earlier tentatives of naturalization of mind, with some examples of systems created

for the analysis of natural language. Their lack was to be either symbolic or able to learn, while the

right way is to analyze an artificial system that is both symbolic and able to learn. I’ve done this on

the basis of the studies that Elisabetta Gola has done on the verb “vedere”, but doing on my own an

analysis of another verb, “guidare”. During the experiment I’ve given to the system some data to

learn, on the basis of which it has to find regularities that are so not taught but literally learnt. It’s

the same system that creates its own rules, by casting how it has learnt on what it doesn’t know yet,

trying to disambiguate it. Thanks to this it has been denied another false believing about language:

there are not simply some rules we have to follow and on the basis of which to create texts, these

rules have always to face with the new linguistic situations to which man has to adapt himself. So,

the artificial systems and the biological ones are similar for their dynamicity, because they cope

with the new situations in a way that is controlled and creative at the same time.

5

1. METAFORA E INTELLIGENZA ARTIFICIALE

La storia della metafora ha origini molto lontane: è Aristotele il primo a darne una classificazione,

intuendo anche la sua capacità di creare nuova conoscenza.

La ragione per cui è più semplice comprendere qualcosa detto in modo metaforico è che la metafora

sfrutta due fattori: il “porre le cose sotto gli occhi” e il renderle piacevoli:

Le parole significano qualche cosa, così che tra le parole quelle che ci fanno

apprendere qualcosa sono le più piacevoli. Ora da una parte ci sono le

glosse che non comprendiamo, dall’altra i nomi familiari li abbiamo sotto

gli occhi; ma

è la metafora soprattutto che fa quello. Quando infatti

<Omero> chiama la vecchiaia “stoppia”, si realizza un apprendimento e una

conoscenza attraverso il genere. ( Aristotele, Retorica, III, 10, 1410 b)

Questa prima intuizione e teoria della metafora come modalità di pensiero ha conosciuto alterne

vicende nel corso della storia del pensiero filosofico e linguistico. Se in, un primo momento, la

metafora veniva definita come un trasferimento di significato, successivamente si è ritrovata a

rivestire il ruolo di “orpello retorico”. È intorno agli anni ’70 del XX secolo che l’uso non letterale

delle parole è tornato alla ribalta come quel meccanismo capace di generare nuova conoscenza sulla

base di conoscenze pregresse. La metafora, infatti, si è dimostrata particolarmente utile nella

formulazione di nuove teorie scientifiche: a partire dai domini più facilmente accessibili, si effettua

un trasferimento di senso che consente di comprendere domini altrimenti troppo complicati. In

questo capitolo cercheremo di dare una definizione di metafora e descriverne i principi di

funzionamento formulati nell’ambito delle teorie contemporanee della metafora, per poi mostrare

brevemente quali simulazioni, ispirate a tali teorie, sono state prodotte dall’IA.

1.1 Cos’è la metafora?

Il tentativo di definire la natura delle metafore ha occupato buona parte dei filosofi classici e

moderni, come anche il tentativo di stabilirne i diversi aspetti e le tipologie.

Qui ne parleremo seguendo una definizione ben precisa, ovvero quella che vede la metafora come

un’operazione cognitiva particolare, in cui diverse capacità della mente

umana vengono coinvolte […]. Il senso più frequente è infatti quello di

identificarla con una porzione di testo con caratteristiche particolari:

innanzitutto in esso si rileva la presenza contemporanea di due domini

semantici che interagiscono nel costituire un significato spesso nuovo, la cui

6

comprensione richiede un lavoro di interpretazione. Un testo metaforico

viene analizzato a scopi descrittivi ed esplicativi come composto da due

parti: la parte intesa metaforicamente (che qui chiameremo vehicle, ma che

viene indicata anche come focus o soggetto), e la parte in cui il significato

dei termini è letterale (cioè il tenor, o frame, o cornice) ( Gola E., 2005, p.

21-22).

La relazione tra i domini tenor e vehicle dipende dalla complessità degli stessi e dalla struttura del

dominio sorgente, ovvero il vehicle. Molte volte, tale dominio, proviene da esperienze sensoriali: la

metafora del “conoscere come vedere” (Gola E., 2005, pp 23) dipende dal fatto che il senso della

vista è quello ci da la sensazione più forte di aver conosciuto qualcosa.

Max Black (1983, 97-135) sostiene che la proiezione da un dominio all’altro genera delle similarità

che mutano in profondità i concetti, in modo tale che lo stesso pensiero, in termini letterali,

perderebbe gran parte della sua efficacia.

Una metafora può essere una singola frase o un testo di dimensioni maggiori, come una teoria

scientifica. I domini possono essere costituiti da qualsiasi campo semantico ma in genere si

preferisce attingere, nel caso del dominio sorgente, ad una sfera più sensoriale, mentre per il

dominio target ci si riferisce ad ambiti più ambigui, di cui risulterebbe difficile dare una

descrizione. Per quanto riguarda, poi, il meccanismo cognitivo che sta alla base della produzione

stessa della metafora, le ipotesi non mancano. Alcuni vedono alla base di tale capacità un

meccanismo di proiezione, altri un meccanismo capace di individuare le similarità, altri ancora un

meccanismo analogico. In ogni caso, ciò che consente di produrre metafore è alla base dei processi

di comprensione e di estensione della conoscenza.

1.2 Teorie contemporanee sulla metafora

Il linguaggio può essere visto sia come ciò che ci consente di accedere alla conoscenza, facoltà

autonoma indipendente dalle caratteristiche fisiche dell’uomo; sia come mezzo comunicativo, dove

il linguaggio è un codice che consente il passaggio da un emittente ad un ricevente (Ferretti, 2005).

Nel primo caso è possibile utilizzare il linguaggio anche per spiegare fenomeni complessi come le

metafore, nel secondo caso, invece, siamo di fronte ad una teoria letteralista in cui il significato è il

risultato di una combinazione di parole.

Gli orientamenti relativi allo studio della metafora si possono differenziare in base al tipo di

approccio che si vuole utilizzare: quello letteralista o quello non letteralista.

7

1.2.1

Teorie letteraliste

All’interno dell’approccio letteralista, la metafora viene vista come un fenomeno “scomodo” e

periferico: essa costituirebbe una violazione delle regole di composizionalità del significato. Le

posizioni letteralista più importanti sono due e considerano, rispettivamente, la metafora come:

•

una sostituzione;

•

una violazione di regole.

La teoria logica che identifica la metafora con una sostituzione considera il linguaggio uno specchio

della realtà: ogni parola corrisponde ad un oggetto ben preciso del mondo ed ogni proposizione

costituisce un evento di tale mondo. In una tale prospettiva la metafora rappresenta

un’imperfezione, un ornamento per dire qualcosa esprimibile tranquillamente attraverso il

linguaggio letterale. Secondo J. Van Genabith (1999, pp 6-9), autore che ha formulato basata sulla

logica classica, una metafora è una similitudine abbreviata: una frase come “John è una volpe” non

verrebbe compresa se non venisse fatta corrispondere alla similitudine “John è come una volpe”,

attribuendo a John delle caratteristiche non banali che caratterizzano la volpe e che potrebbero

essere trasferite anche ad un essere umano, come la furbizia. La proprietà da attribuire

correttamente a John sarebbe il risultato di un’inferenza: a partire da ciò che conosciamo di John,

deriviamo la caratteristica pertinente per l’interpretazione della metafora. Tali caratteristiche non

devono essere attribuibili ad ogni oggetto del mondo, altrimenti si perderebbe il valore conoscitivo

che risulta dalla metafora, riducendo la stessa ad un puro corredo espressivo. Il meccanismo

sostitutivo sarebbe composto da tre fasi: interpretazione letterale, rilevazione della violazione,

interpretazione metaforica. Il fatto che l’interpretazione della metafora necessiti di un ragionamento

inferenziale è indizio di come non basti una semplice corrispondenza significati/oggetti del mondo

per spiegare il valore conoscitivo che ne scaturisce. Anche se ciò sembra aprire le strade per

un’interpretazione migliore della stessa, l’utilizzo di inferenze rispetta il principio di corrispondenza

tra gli enunciati e gli eventi del mondo. Infatti, non solo gli approcci logici, che mirano a

formalizzare i criteri di verità, adottano questo tipo di corrispondenza; anche gli approcci cognitivi

utilizzano le corrispondenze proposizione/evento del mondo per spiegare i meccanismi di

comprensione delle frasi. Non a caso, infatti, i principi promossi dalla Grammatica Generativa di

Chomsky entrano in conflitto con la possibilità di includere i fenomeni metaforici nella sfera dl

linguaggio ordinario. Le regole di restrizione, quelle che prescrivono il modo corretto in cui il

significato di una frase si forma sulla base dei significati delle singole parole, impediscono la

formazione di frasi anomale. In questo senso, la metafora costituirebbe una violazione delle regole

8

di composizionalità (Fodor J., Katz J., 1963, pp 170-210), in quanto si verificherebbe una scollatura

tra le regole di restrizione del verbo e le proprietà dei rispettivi argomenti.

La possibilità di comprendere le metafore nell’ambito delle prospettive teoriche generativo1

composizionali richiede perciò una qualche forma di rilassamento delle regole .

1.2.2

Teorie non letteraliste

Nelle teorie non letteraliste, le metafore sono considerate un fenomeno centrale sia per la loro

2

frequenza che per la loro rilevanza. Il meccanismo creativo che le caratterizza è permeato dalla

regolarità e non, come si potrebbe pensare, dalla casualità. L’uso metaforico del linguaggio

consente di comprendere fenomeni altrimenti difficili da descrivere. La metafora non può costituire

una violazione dei principi di composizionalità che dovrebbero governare l’attribuzione di

significato, in quanto i tempi di reazione dell’interpretazione di una frase sono molto veloci e il

nostro cervello scarta subito le interpretazioni letterali per passare a quelle metaforiche (Gibbs,

1992).

A fare della metafora il fondamento del sistema concettuale che guida il pensiero e l’agire delle

persone sono G. Lakoff e M. Johnson (1999, pp 19), inaugurando il campo della Linguistica

Cognitiva. Secondo questo approccio, la metafora è la possibilità di connettere fenomeni separati.

Non vi è più una corrispondenza tra un simbolo e una realtà oggettiva, bensì una proiezione da un

dominio sorgente, più noto, ad un dominio target, nuovo, il cui codice è ancora indefinito. In tal

modo, una teoria sconosciuta viene spiegata nei termini di una teoria già nota, come nel caso

dell’atomo: la descrizione che ne è stata data in origine si rifaceva al modello del sistema solare.

I concetti vengono strutturati in base all’esperienza fisica dell’individuo, non in base ad una

corrispondenza con il mondo esterno. Essi riflettono il modo in cui i nostri corpi contribuiscono a

dare senso al reale. Il nostro modo di comprendere le metafore non è diverso dal modo in cui

comprendiamo le frasi espresse letteralmente. Non è necessaria una pre-comprensione perché noi

concettualizziamo metaforicamente.

Lakoff e Johnson suddividono le metafore in metafore primarie, metafore concettuali e metafore

complesse. Le metafore primarie vengono acquisite meccanicamente e sono universalmente

riconosciute dai parlanti, in quanto basate su schemi che precedono il linguaggio. Sono un modo per

ridurre il carico di informazioni, sensibilizzando il sistema a particolari aspetti del mondo. I concetti

di base sono frutto della nostra esperienza corporea e influenzano il nostro modo di pensare. I

1

Per approfondimenti consultare Moravcsik 2001

Vi sono diversi studi che dimostrano la elevata frequenza d’uso delle metafore. Questo dato è stato

verificato anche durante l’esperimento da noi condotto e riportato nel cap. 3.

2

9

pattern significativi emergono dalla nostra esperienza corporea attraverso schemi d’immagine

(image schemata). Sono schemi di natura percettiva e si formano in seguito all’interazione tra corpo

e ambiente. Sono delle strutture intermedie tra le proposizioni e le immagini (ne sono un esempio

schemi spaziali come basso/alto: è in base ad essi che vengono spiegati domini astratti come

male/bene, irrazionale/razionale, ecc.):

Le metafore concettuali costituiscono una proiezione di struttura (mapping) da un dominio sorgente

ad un domino target. Nel fare ciò si segue un principio d’invarianza (Lakoff, 1993, pp 215),

secondo il quale la proiezione da un dominio all’altro avviene nel rispetto delle compatibilità degli

schemi d’immagine sottostanti ai due domini. Infine, le metafore complesse si creano sulla base di

legami proiettivi tra i domini diversi cui danno luogo le metafore primarie. Il dominio sorgente, in

questo caso, non è necessariamente di tipo senso-motorio, bensì dipende da modelli culturali e dalle

credenze fatti proprio dalla società cui il parlante appartiene. Attraverso l’utilizzo di questi schemi,

si possono generalizzare fenomeni che altrimenti sembrerebbero a sé stanti.

In conclusione, le teorie letteraliste costituiscono un’ipotesi teorica basata su intuizioni ideali e non

sulla realtà empirica offerta da situazioni di comunicazione effettiva. Il modo in cui

quotidianamente usiamo le parole sottolinea l’importanza degli usi non letterali.

I modelli proposti dall’IA abbracciano usualmente le teorie composizionali del significato,

esiliando, pertanto, la metafora come un’imperfezione del linguaggio.

10

1.3 La metafora nell’ Intelligenza Artificiale

La maggior parte delle teorie sul linguaggio hanno un orientamento nettamente letteralistico. Anche

all’interno dell’IA la natura dei calcolatori si basa su procedimenti effettivi, pertanto

3

“composizionali” . Le simulazioni di IA tendono dunque ad assimilare il linguaggio naturale ad un

codice formale, in cui i fenomeni non letterali rappresentano elementi di disturbo. L’elaborazione

del linguaggio naturale ha perciò, per un certo periodo, prestato poca attenzione ad un fenomeno

che comunque viene avvertito come cruciale per la corretta interpretazione di un testo, nonché nella

formazione di idee, sistemi concettuali, ragionamenti. Il tentativo di elaborare le metafore

artificialmente ha come obbiettivo quello di stabilire se metafora e mente abbiano una natura

computazionale.

Nella storia dell’IA la metafora gioca un ruolo variabile. Se negli anni ’60 le simulazioni

riguardavano esclusivamente il ragionamento analogico, negli anni ’70 comparvero i primi

elaboratori di metafore linguistiche. Negli anni ’80, infine, i meccanismi non letterali di qualsiasi

natura si imposero nel campo delle simulazioni.

La difficoltà nel creare programmi capaci di gestire gli usi non letterali dipende dal contrasto che

sorge dal tentativo di stabilire regole di buona formazione semantica e il fatto che le metafore

sfuggano a tale regolamentazione. Anche nell’ambito dell’IA è viva la distinzione, precedentemente

fatta, tra teorie letteraliste e non. È possibile distinguere, pertanto, simulazioni di natura diversa, in

riferimento alla teoria di appartenenza.

1.3.1

Approcci letteralisti: Dan Fass e il Meta5

Nel panorama della Linguistica Computazionale, Dan Fass interpreta le selezioni di restrizione non

come vincoli, bensì come preferenze più o meno costrittive. Il programma che egli utilizza per

estendere le idee elaborate all’interno della teoria delle preferenze semantica prende il nome di

Meta5 (Fass D., 1991, pp 49-90). Il metodo utilizzato da tale programma è il met* , il cui scopo è

quello di discriminare metafore e metonimie. Secondo Fass, il piano linguistico e quello della

rappresentazione della conoscenza convergono nelle word-senses, ovvero gli oggetti che

rappresentano i diversi significati delle parole. Nel processo di interpretazione, Fass utilizza un

algoritmo che proietta i vincoli lessicali delle preferenze semantiche dal senso source al senso

target. Le parole possono intrattenere 7 diversi tipi di relazioni semantiche, tra cui la metaforicità.

3

Come vedremo più in dettaglio nel Cap.2.

11

Fass propone un esempio di come lavora Meta5 attraverso l’analisi della frase “The car drinks

gasoline” (Fass,1991).

Bisogna analizzare tutte le relazioni possibili tra “bere” e “benzina”, chiedendosi se:

•

uno dei termini è antenato dell’altro;

•

i termini sono uguali;

•

il primo termine include il secondo;

•

i due termini sono fratelli;

•

i termini sono esclusivi e fanno riferimento ad una relazione comune più generale.

Tramite questo processo si stabilisce se una relazione tra i termini è letterale o metaforica. Una

relazione metaforica è un’analogia rilevante, rintracciabile individuando un dominio source ed uno

target. Nell’esempio di Fass il dominio source, secondo le aspettative del verbo “bere”, è “animale”.

Queste aspettative vengono disattese, in quanto il dominio source descritto da “bere” è “auto”. Il

compito del programma è stabilire in virtù di quale analogia il termine “animale” sia stato sostituito

con “auto”. Ciò che li accomuna è il verbo “bere”:

“Bere” e “usare”, infatti, sono una forma di ‘consumo’; inoltre, sia i liquidi potabili che la benzina

appartengono alla categoria dei ‘liquidi’. É per questo che è possibile dire che la macchina beve

benzina. Il programma darebbe, invece, una risposta letterale nel caso in cui venisse rilevata una

relazione di antenato o di uguaglianza tra i termini source e target.

L’algoritmo utilizzato nella teoria di Fass è indipendente dal contenuto di conoscenza e pertanto una

metafora può essere individuata soltanto se c’è un concetto padre cui i termini della frase

rimandano. Anche se Fass non sostiene esplicitamente che l’analisi letterale precede quella

metaforica, di fatto la rete delle word-senses è letterale, quindi l’interpretazione metaforica subentra

quando si incontrano violazioni delle preferenze semantiche. Il programma risulta pertanto efficace

nel caso in cui sono state previste le estensioni non letterali possibili.

12

1.3.2

Approcci concettuali: James Martin e Midas

Sulla base della teoria cognitiva della metafora di Lakoff e Johnson, il sistema progettato da James

Martin si basa su una concezione della metafora come parte convenzionalizzata e ordinaria del

linguaggio. Attraverso il sistema MIDAS (Metaphor Interpretation, Denotation, and Acquisition

System), creato per aiutare gli utenti del sistema operativo Unix, Martin ha come intento quello di

costruire una robusta knowledge-base di metafore e metonimie convenzionali dell’Inglese (Martin,

1990), in modo tale che il riconoscimento di metafore e metonimie nei testi non risulti più

problematico. Il sistema sul quale si basa Midas è quello delle reti semantiche, dove l’informazione

è rappresentata da una serie di nodi messi in relazione da archi. Attraverso l’introduzione di

relazioni di tipo view, ovvero “vedere un concetto come un altro”, vengono introdotte anche le

metafore concettuali. Midas possiede un nucleo di “concetti-come” , che costituiscono la base per

comprendere metafore nuove. Un sistema del genere, ad esempio, è in grado di comprendere frasi

del tipo “How can I kill a process?”. Ciò avviene attraverso tre passaggi:

•

rappresentazione esplicita delle metafore convenzionali che servono da base per

comprenderne di nuove, attraverso un ponte di associazione tra i due domini concettuali;

•

interpretazione provvisoria della frase, specificando successivamente tale interpretazione per

renderla coerente;

•

capacità di apprendere metafore nuove estendendo la conoscenza su quelle precedenti.

La conoscenza del sistema Midas è costituita da una gerarchia di metafore, ovvero una

sovrapposizione di concetti metaforicamente interconnessi.

Ogni metafora concettuale mette in relazione due pezzi di rete. Lo scopo di esplicitare tali

corrispondenze è fare in modo che tra i domini collegati intercorrano relazioni che consentano

sostituzioni nel dominio di conoscenza che si sta analizzando in base al dominio di conoscenza

sorgente. La metafora convenzionale generale viene definita metaphor sense, le parti che vengono

messe in corrispondenza invece, sono le metaphor map rappresentate con relazioni del tipo view. La

metaphor sense deve contenere tutte le relazioni fondamentali che giustifichino la presenza di una

metafora convenzionale. Nell’esempio sopra citato, la metaphor sense mette in relazione il concetto

di “uccidere” con quello di “terminare”. Le metaphor map riguardano i vari aspetti della metafora

principale Kill-Terminate Result, che associa l’uccisione al finire in quanto atti finalizzati a

conseguire un risultato; il Killed- Process, che associa la vittima dell’uccisione al processo concluso

e il Killer-of-Process, che relaziona assassino e chi termina il processo.

13

Se il solo scopo di Midas fosse quello di stabilire quali pezzi di conoscenza possono essere

proiettati su altri, il sistema sarebbe troppo rigido. Benché un po’ lo sia, il tentativo è quello di dare

regole e condizioni che consentano di decidere non predeterminatamente le metaphor sense

possibili e di interpretare metafore nuove sulla base di quelle già conosciute.

Per esempio, a partire dalla capacità di comprendere la frase “How can I kill a process?” MIDAS

dovrebbe riuscire a interpretare la frase nuova “John killed the conversation by walking in the

room”, in base alla relazione che intercorre tra un processo e una conversazione: entrambi sono

eventi che si svolgono in un certo arco di tempo e possono essere interrotti.

I sistemi descritti, per quanto abbiano il pregio di aver tentato una simulazione dei processi di

comprensione di frasi non letterali, rimangono entrambi legati a un uso ideale del linguaggio e

richiedono una rappresentazione a priori del mondo concettuale necessario alla comprensione di

testi letterali.

Il programma di Fass, inoltre, è particolarmente semplificato, da questo punto di vista, in quanto

non si basa su una conoscenza dotata di fondamento empirico e, quindi, non è legata alla realtà

linguistica degli individui. I testi di cui si serve sono, dunque, “testi giocattolo”, costruiti ad hoc per

gli esperimenti.

14

2. ELABORARE UN TESTO: SISTEMI CLASSICI E NUOVA IA

La capacità di utilizzare un linguaggio naturale viene spesso considerata il segno distintivo

dell’essere umano. Uno degli obiettivi dell’Intelligenza Artificiale (IA) è la creazione di

programmi in grado di rendere un calcolatore capace di prestazioni linguistiche simili a quelle di

un qualsiasi individuo. Attualmente non è stato ancora creato alcun programma in grado di

consentire una tale performance. Comprendere il linguaggio naturale, infatti, è tutt’altro che

semplice: bisogna, innanzi tutto, avere una buona conoscenza del linguaggio utilizzato e del

mondo cui esso fa riferimento.

In questo capitolo ci proponiamo di indicare i principali passi del processo di elaborazione di un

testo e di illustrare alcuni dei metodi utilizzati dall’IA nel tentativo di darne un modello

computazionale.

2.1 Sistemi di IA (classica) e linguaggio

Quando si parla di elaborazione del linguaggio naturale ci si riferisce a un processo che ha come

obiettivo la comprensione di un testo (la maggior parte delle volte -e comunque in questo casoscritto), che comprende almeno i seguenti passi (Rich E., 1983, pp 329-330):

•

Capire la combinazione sintattica delle parole;

•

Sapere costruire una rappresentazione del significato di ogni frase, sulla base dei significati

delle parole;

•

Combinare i significati delle frasi in un tutto coerente.

La comprensione di un linguaggio scritto è ben più semplice di quella di un discorso, che per

essere compreso richiede la conoscenza relativa a quanto scritto e tutta una serie di informazioni in

più per trattare il rumore e le ambiguità del segnale acustico,nonché indicatori come l’intonazione

e la presenza di pause. La creazione di un programma atto alla comprensione del linguaggio

comporta per lo meno due tipi di analisi: sintattica e semantica .

15

2.1.1 Analisi sintattica

Per comprendere la combinazione sintattica delle parole, la macchina dovrà inizialmente

segmentare l’enunciato in unità, alle quali associare, successivamente, delle informazioni basilari

(Pianesi F., Stock O., 2001, pp 172). Il risultato può essere visto come una lista di “oggetti”

associati alla propria categoria grammaticale.

Il passo successivo comporterà il raggruppamento degli elementi in strutture più complesse dette

costituenti. Se, ad esempio, analizziamo l’enunciato “mia sorella ama i cani”, si ottiene la seguente

suddivisione:

Mia => Agg. Poss.

Sorella => Nome

Ama => Verbo

I => Preposizione

Cani =>Nome

la cui frammentazione in costituenti da luogo alla seguente struttura ad albero,detto albero d

parsing (ivi, pp 180):

Tale struttura ad albero da un’ idea dell’informazione categoriale (articoli, nomi…), della sequenza

lineare delle stringhe e della duplicazione delle informazioni (un equivale, ad esempio, ad un

16

articolo). Ciò che viene messo in evidenza, inoltre, è la strutturazione della frase in un Sintagma

Nominale e in un Sintagma Verbale.

Le categorie grammaticali, come N, V e Agg Poss, vengono definite simboli non terminali,mentre

gli oggetti lessicali, ovvero le parole, costituiscono i simboli terminali(ivi, pp 176). Un linguaggio,

così considerato, diventa un insieme di stringhe, concatenazione di simboli terminali e quindi

formale. Tali simboli vengono concatenati sulla base di regole di produzione, che danno luogo ad

una grammatica formale. Il linguaggio che ne deriva, dunque, è un linguaggio generato.

Immaginiamo una grammatica (G) costituita dall’insieme di simboli terminali (∑), l’insieme di

simboli non terminali (Ψ) e l’insieme di regole di riscrittura (P):

G = ∑ ( = ama,sorella, i , cani,pizza,la, mia, )

Ψ ( = Agg. Pos., N, V, Art, SN, SV)

P [ = (i) S→SN SV

(ii) SN→ Agg Poss N

(iii) SN→Art N

(iv) SV→V SN

(v) N→ cani

(vi) N→ pizza

(vii) N→ sorella

(viii) V→ ama

(ix) Art→ i

(x) Art→ la

(xi) Agg Poss→ mia]

Da questa grammatica possono essere generate sequenze diverse, tra cui la frase “mia sorella ama i

cani”. Le regole che ne determinano la composizione sono:

0) S

1) SN SV

2) Agg Poss N SV

3) mia N SV

4) mia sorella SV

5) mia sorella V SN

6) mia sorella ama SN

7) mia sorella ama Art N

17

8) mia sorella ama i N

9) mia sorella ama i cani.

La grammatica generativa G ha generato questa frase, così come avrebbe potuto generarne altre. Si

può definire ogni sequenza di simboli terminali e simboli non terminali come uno stato, rendendo

la computazione un insieme di stati associati da regole di produzione. Inoltre, la struttura sintattica

di una frase può essere calcolata tenendo una traccia, nel corso della computazione, anche degli

stati intermedi. Il vero e proprio processo di analisi sintattica, quindi, oltre ad associare stati e stati

tramite le regole di produzione, concatena tra loro le descrizioni strutturali e ne tiene traccia.

Se dal punto di vista sintattico la frase ha una struttura composizionale, lo stesso non si può dire

per il significato. Ciò è evidente osservando la stessa grammatica: si può notare, ad esempio, che N

corrisponde sia a “sorella” che a “pizza”. Come viene fatta la scelta giusta? F. Pianesi e O. Stock

(2001) ritengono necessario:

•

sfruttare adeguatamente l’informazione a disposizione;

•

considerare la computazione come una procedura per ipotesi, a partire dall’ipotesi iniziale

di una categoria S (la presenza di una proposizione).

Una rappresentazione di tale ipotesi è costruita presentando a sinistra la stringa e a destra la

categoria:

1. << (mia sorella ama i cani) (S) >>

Il secondo passo sostituisce tale ipotesi con quella secondo la quale tale stringa è analizzabile in

termini di combinazione tra un SN e un SV.:

2. << (mia sorella ama i cani) (SN SV) >>

Al terzo passo, l’ipotesi corretta diventa:

3. << (mia sorella ama i cani) (Agg Poss N SV) >>

Che sottolinea la concatenazione, all’interno del sintagma nominale, di un aggettivo possessivo e di

un nome. Al quarto passo, anziché espandere la categoria grammaticale Agg Poss, chiariamo se

18

“mia” è effettivamente un aggettivo possessivo e, di conseguenza, eliminiamo “mia” dalla stringa

dei terminali e Agg Poss dalla stringa dei non terminali.

4. << (sorella ama i cani) (N SV) >>

Al passo successivo si applicherà lo stesso metodo con il pre-terminale N, ottenendo:

5. << (ama i cani) (SV) >>

La nozione di stato, quindi, varia, in quanto non indica più la sola stringa di non-terminali ma anche

la stringa contenente i simboli terminali, che, secondo l’ipotesi, viene da essi classificata.

Quindi, durante il processo di riconoscimento o di parsing, la stringa in ingresso viene consumata e

l’elaborazione termina quando la stringa è vuota.

Il limite di una grammatica di questo tipo è quello di non poter evitare la generazione di frasi che

violino accordi del tipo soggetto/verbo o articolo/nome, consentendo, quindi, la produzione di frasi

come “i cani ama la pizza”. Un modo per risolvere questo problema sarebbe quello di arricchire il

lessico con i tratti di numero, persona e genere, insieme ai loro valori: singolare e plurale, prima

seconda e terza persona, femminile e maschile. Il risultato sarebbe un lessico in cui ogni parola

risulta costituita da una forma, una categoria grammaticale e una lista di coppie tratto-valore.

Questo tipo di grammatica prende il nome di Grammatica a tratti. Una grammatica del genere deve

avere una procedura che realizzi gli accordi ed un procedimento per trasmettere i tratti con i loro

valori ( ad esempio nell’enunciato “la signora dorme”, dovrà confrontare i tratti de “la signora” con

quelli di “dorme”).Ogni volta che l’applicazione fallisce si ricorre a produzioni alternative. Se non

si riesce a trovare una produzione soddisfacente, si torna a quella precedente tentando di soddisfarla

diversamente e così via. Il rischio corso utilizzando questo tipo di grammatiche è quello di ripetere

più volte la stessa computazione.

Data una grammatica ambigua, è necessario integrare le conoscenze facendo riferimento al contesto

e, quindi, ricorrendo ad informazioni non puramente grammatico-sintattiche. La soluzione a questa

necessità prende il nome di chart-parser (ivi, pp 188). È un metodo che consente di memorizzare le

analisi parziali già eseguite e di poter riutilizzare, quindi, i risultati già ottenuti. Ciò è possibile

conservando tali dati in una tabella, in cui i risultati precedenti vengono indicizzati, rendendoli così

riutilizzabili e rintracciabili.

Come sostiene Rich (1986), l’analisi sintattica è solo il primo passo verso la comprensione di una

frase. Il passo successivo è costituito da un’interpretazione semantica.

19

2.1.2 Analisi semantica

Il significato, nel senso che intenderemo, riguarda l’aspetto che può essere catturato da un processo

di elaborazione simbolica, quindi come qualcosa di calcolabile. L’idea di calcolabilità è stata

tradotta nelle teorie logiche e in IA in quella di composizionalità, secondo cui il significato stesso

va fatto coincidere con il valore di verità della frase. Il significato di un enunciato f, quindi,

corrisponde a determinate rappresentazioni formalizzate del mondo cui si fa riferimento. Se tale

conoscenza formalizzata sul mondo è rappresentata da una base di dati, il significato di una parola

come “cane” è dato dall’insieme di proprietà che in una base di conoscenza sono attribuite ai cani.

L’assegnazione del significato avviene attraverso due passaggi: una rappresentazione delle

condizioni di verità attraverso la forma logica dell’enunciato stesso e un calcolo del valore di verità,

dato dall’interpretazione della forma logica sulla base della rappresentazione che ci si è fatti del

mondo.

I sistemi che, in IA, sono deputati alla rappresentazione dei significati, hanno alcune caratteristiche

comuni rintracciabili nel formalismo delle reti semantiche (Frixione, 2001, pp 81) . Queste sono

costituite da un grafo i cui nodi rappresentano concetti e gli archi connessioni tra concetti. Una rete

semantica può contenere concetti generici (ad esempio “cane” e “mammifero”) o individuali ( come

“Fido” ed “Angela”). Gli archi possono essere di varia natura (ivi, pp 82):

•

di sussunzione, che collegano concetti generici (“cane” e “mammifero”);

•

possono rappresentare gli attributi di un concetto generico (come “padrone ed “essere

umano”);

•

archi di istazione, che collegano un concetto individuale ad un concetto generico (ad

esempio “Fido” e “cane domestico”);

•

Rappresentare attributi di un concetto individuale (come “padrone” ed “Angela”).

All’interno di una rete semantica, le caratteristiche di un concetto vengono acquisite da tutti i

sottoconcetti, secondo un principio di ereditarietà.

Quando si ha a che fare con la rete semantica di un enunciato, è opportuno analizzare le relazioni

che combinano i concetti in enunciati veri e propri. Un analisi del genere è quella che riguarda le

restrizioni o preferenze semantiche. In una frase come “Angela mangia la minestra”, ad esempio, il

verbo “mangiare” è visto come un oggetto logico che può combinarsi con un soggetto (Agente) ed

un oggetto (Tema). L’Agente ha come restrizione il fatto di dover appartenere alla classe degli

esseri viventi, il tema, invece, dovrà appartenere alla classe delle entità concrete.

20

In questo tipo di analisi, il problema sorge di fronte a frasi che possono essere interpretate

ambiguamente, come nel caso di frasi metaforiche quali “Luca divorò il libro in un giorno solo”.

Frasi del genere, infatti, verrebbero considerate anomale da un approccio classico alla semantica,

ma sono comprensibilissime da un qualsiasi parlante della lingua italiana. Si tratta di enunciati non

prevedibili.

Nel tentativo di costruire sistemi in grado di dialogare con un qualsiasi individuo, è necessario,

quindi, lavorare utilizzando approcci basati sull’apprendimento, o meglio sull’autoapprendimento,

di regole e rappresentazioni.

2.2 Il connessionismo

Il connessionismo è una tendenza all’interno dell’ I.A. che si propone di superare i limiti oltre i

quali questa non è riuscita ad andare. L’innovazione consiste nel non considerare più importante le

proprietà funzionali, la capacità di eseguire un determinato programma di istruzioni, bensì il

supporto fisico dell’intelligenza. Il connessionismo, infatti, si basa proprio su delle macchine

costruite seguendo i principi fisici del cervello. È un approccio basato su un livello microscopico di

analisi di stimoli e risposte, in cui la conoscenza è distribuita attraverso le connessioni tra le

microunità cognitive. Si appoggia su elaborazioni non simboliche, distribuite sottoforma di reti

neurali (Smolensky P., 1992, pp 26) e basate sull’apprendimento. Le reti neurali sono sistemi ad

alto parallelismo, ispirate alla struttura del sistema nervoso. Esse sono costituite da unità collegate

da connessioni unidirezionali che trasmettono attivazione o inibizione da un’unità all’altra. Ogni

unità è l’equivalente di un neurone. Ogni connessione è caratterizzata da un peso quantitativo,

misura della conduttività di quella connessione:

21

La somma di tutte la attivazioni e le inibizioni che arrivano all’unità viene chiamata input netto. La

quantità di attivazione o inibizione è determinata dal peso della connessione e dallo stato di

attivazione dell’unità da cui parte la connessione.

Un esempio di rete neurale è dato dal percettrone (Parisi D., 1989, pp 34) di F. Rosemblatt (1958):

Le unità di input hanno solo connessioni in partenza e il loro stato d’attivazione dipende

dall’esterno della rete. Le unità di output presentano solo connessioni in arrivo. Il loro stato di

attivazione viene letto dall’esterno e ci comunica come la rete ha reagito all’input ricevuto. Sono

connessioni di tipo feedforward, connessioni la cui direzione va dallo strato d’ingresso verso lo

strato d’uscita.

In seguito le reti neurali vennero modificate con l’inserimento di una rete di unità nascoste tra le

unità di input e quelle di output. Un esempio è il percettrone multistrato (Parisi D., 1989, pp 35) :

Nemmeno in queste reti vi è feedback e sono pertanto del tipo feedforward. L’attivazione delle

unità di input da parte dell’esterno determina l’attivazione delle unità nascoste e quindi, lo stato di

attivazione delle unità di output risponde all’attivazione esterna iniziale. I pesi delle connessioni

sono all’inizio, casuali e si modificano in seguito alle stimolazioni esterne. Una rete neurale, quindi,

apprende e non necessita di una rappresentazione esplicita di conoscenza. Per successive

modificazioni, le reti neurali trovano i giusti pesi che consentono la prestazione desiderata. Con una

serie di prove ed errori, le reti imparano ad auto organizzarsi.

Ogni processazione dei pattern esterni viene chiamato epoca. Anche se l’output è solo

approssimativamente corretto, ciò che conta è che la rete vada aldilà di quanto gli è stato

esplicitamente insegnato.

I sistemi connessionistici sono più vicini ai sistemi cognitivi umani, in quanto riescono a svolgere

compiti riguardanti, ad esempio, il riconoscimento di forme e l’analisi sintattica.

22

2.3 “Nuova IA” e sistemi che apprendono

In questo paragrafo mi occuperò dei cambiamenti, nella prospettiva dell’analisi del linguaggio

naturale, introdotti dall’adozione di sistemi che si collocano a metà strada tra l’I.A. classica e il

connessionismo. La differenza, rispetto a questo tipo di approcci, consiste nella capacità del sistema

di sfruttare l’evoluzione e l’apprendimento di cui sono capaci i sistemi connessionistici, sfruttando,

però, il potere simbolico dei sistemi classici.

I sistemi che apprendono differiscono dai sistemi classici per la loro capacità di acquisire e

riutilizzare in situazioni nuove conoscenza linguistica, attraverso l’esposizione ai dati linguistici, e

non passando per una totale rielaborazione da parte degli esperti. In generale, i sistemi che

apprendono sono strutturati in modo da poter supportare l’acquisizione automatica della

conoscenza, tolleranza dell’errore ed una plausibile induzione. Il sistema dovrebbe essere in grado

di costruire risposte per i casi non conosciuti sulla base di somiglianze con esempi pre-appresi.

I due approcci principali per la soluzione di un problema, come già descritto, sono l’approccio

computazionale subsimbolico e l’approccio simbolico.

L’approccio subsimbolico si basa sulle reti neurali. Questo tipo di apprendimento dipende dalla

modificazione dei pesi della stessa rete neurale, sulla base di opportune leggi di apprendimento.

Queste leggi dipendono da pattern di stimolazione esterna, i cui costituenti sono valori di

microcaratteristiche elementari. Si possono distinguere diversi tipi di apprendimento:

•

supervisionato;

•

non supervisionato;

•

basato sul rinforzo;

•

rote learning.

Apprendimento supervisionato. Questo tipo di apprendimento si basa su algoritmi supervisionati, in

cui ad ogni pattern di ingresso è associato un pattern d’uscita corretto o desiderato (Pessa ,2001, pp

105-107). La misura della differenza tra il pattern effettivamente emesso e quello desiderato viene

definita errore commesso in uscita, che determina la modifica dei pesi delle reti neurali. Sono reti

che apprendono da esempi pre-classificati, come ad esempio i percettroni multistrato. Questo tipo di

rete, a patto di conoscere con precisione il numero delle unità nascoste e il peso delle connessioni, è

in grado di approssimare, con qualunque livello prefissato di precisione, qualsiasi tipo di relazione

ingresso-uscita. Unità e pesi vengono calcolati con alcune leggi di apprendimento supervisionato,

come la regola di error-backpropagation. Questa regola si basa su una propagazione all’indietro

23

dell’errore mediante la modifica dei pesi delle connessioni interne. Modificando i pesi, l’errore si

riduce di volta in volta.

Apprendimento non supervisionato. Quando il sistema si basa su un apprendimento di tipo non

supervisionato, non vi è un’associazione tra ogni pattern di ingresso e ogni pattern di uscita e la

modifica dei pesi dipende dai pattern d’uscita attivati (ivi, pp 107-108). Questo tipo di

apprendimento crea spontaneamente delle categorie dai dati di partenza e dei prototipi delle stesse.

Sono utili in quanto evidenziano la natura statistica della relazione tra i dati stessi. Anche se ad un

livello rudimentale, quindi, queste reti realizzano un’astrazione dai dati di partenza. Le principali

reti di questa categoria sono due. Le reti di Kohonen risultano formate da uno strato di unità di

ingresso e uno strato di unità di categorizzazione, con connessioni di tipo feedforward. Il processo

di apprendimento rappresenta una modifica dei pesi sulla base dei pattern di ingresso, di modo che,

alla fine del processo, tali pesi rappresentino un prototipo della categoria associata all’unità stessa. I

modelli ART (Adaptive Resonance Theory) proposti da Grossberg, invece, mirano alla creazione di

categorizzatori che costituiscano il giusto compromesso tra plasticità e stabilità. Ogni volta che

viene presentato un certo dato di ingresso ad una determinata categoria, tale dato viene ricostruito

sulla base della categoria proposta e confrontato con l’ingresso inizialmente presentato. Se il grado

si sovrapposizione è abbastanza elevato, il categorizzatore va rinforzato positivamente, altrimenti la

proposta viene scartata e si va avanti con nuove proposte. Ripetendo più volte con opportuni

ingressi questa procedura, si ottiene uno stato di risonanza adattiva, vengono, cioè, fornite sempre

proposte di categorizzazione accettabili.

Apprendimento basato sul rinforzo. Una rete basata sul rinforzo si trova a gestire una sequenza

temporale ordinata di pattern di entrata, in corrispondenza ad ognuno dei quali emette pattern

d’uscita (ivi, pp108-109). Ogni uscita effettivamente prodotta da luogo ad un segnale di rinforzo,

detto rinforzo immediato. La modifica dei pesi tende a massimizzare i segnali di rinforzo ricevuti.

La regola reinforce, inoltre, permette di modificare i pesi delle connessioni in base al valore

momentaneo del rinforzo ricevuto, in modo da massimizzare il valore atteso. Questo tipo di

apprendimento è abbastanza utile quando si ha a che fare con ambienti esterni complessi e variabili.

Apprendimento rote learning. Questo tipo di apprendimento si ha quando non c’è una vera e

propria produzione d’uscita delle rete e quando i pesi vengono modificati sulla base dei pattern

d’ingresso da memorizzare, o eventualmente dei pattern di ingresso-uscita che si vogliono

modificare (ivi, pp 109-110). Tale approccio è molto usato nella progettazione di sistemi neurali che

fungano da memorie associative, in cui, cioè, il pattern richiamato dalla memoria dipende da pattern

di richiamo presentati per sondare la memoria stessa.

24

L’approccio simbolico si basa su una descrizione di stimoli e risposte accessibile sensorialmente.

Avviene, quindi, a livello macroscopico. La conoscenza è localizzata tramite simboli, ognuno

dotato di un significato autonomo e globale. Le più importanti forme di apprendimento negli

approcci simbolici sono:

•

induttivo ( concept learning);

•

basato sulla spiegazione;

•

per analogia.

Approccio induttivo. Attraverso questo tipo di approccio, il sistema apprende a classificare un input

in una certa categoria e come output costruisce un albero di decisione, cioè la traccia dell’algoritmo

impiegato per il raggruppamento dei concetti. Tale criterio ha avuto risultati soddisfacenti con

approcci altrimenti difficili, come la disambiguazione di una frase metaforica, ripensati in termini di

riclassificazione. Un esempio di sistema fisico che si avvale di un approccio simile è CHARADE,

un programma di categorizzazione di testi. Il punto di forza di questo programma è lo sfruttamento

della ridondanza nell’apprendimento effettivo di gruppi di regole. Il sistema acquisisce coppie

attributo/valore che risultano rilevanti di un testo rispetto alla categoria che gli si vorrebbe attribuire

( se, ad esempio, nel testo compaiono le parole bidello, aula, lezione, e insegnanti, una categoria

possibile è scuola). Gli algoritmi dell’apprendimento induttivo si dividono in:

•

supervisionati: si basa su esempi pre-classificati, dove, cioè, è nota a priori la categoria alla

quale deve appartenere ciascuno degli input;

•

non-supervisionati: nonostante la presenza di alcuni esempi la categoria non è nota a priori.

Questo tipo di algoritmi possono suddividersi ulteriormente in incrementali, in cui la

presentazione di anche un solo esempio permette di affinare la classificazione; e non

incrementali, in cui l’apprendimento richiede la presentazione di tutti gli esempi disponibili.

Approccio basato sulla spiegazione. Tramite questo approccio si cerca la soluzione a problemi

nuovi sulla base delle somiglianze con quelli risolti in precedenza. Si creano, quindi, esempi

generali riutilizzabili in futuro.

Entrambi questi approcci hanno come limite quello di presentare soltanto esempi positivi e regolari,

senza dare peso a quelli negativi che violano le regolarità.

Approccio per analogia. I sistemi basati sull’analogia danno molto peso ai vincoli imposti dal

contesto. Le informazioni che vengono ricavate dal contesto vengono usate paradigmaticamente.

Un esempio è quello relativo ad un sistema di trascrizione fonetica, detto PhoTEUS, realizzato da S.

25

Federici e V. Pirelli (1995, pp 7-9), il cui obiettivo era quello di realizzare una corrispondenza

automatica tra grafemi e fonemi. PhoTEUS acquisisce durante la fase d’istruzione esempi del

compito da svolgere, con coppie di partenza del tipo input, per esempio input “ghianda”/ output

/gjanda/ . Il sistema confronta le varie associazioni e ne ricava delle regolarità. Di fronte a casi mai

analizzati, il sistema applica tali regole soltanto se vengono riscontrate sufficienti somiglianze con

gli esempi input. Non si può, ovviamente, arrivare a stabilire generalizzazioni certe, valide per ogni

nuovo caso. Il sistema analogico cerca di evitare queste difficoltà facendo ricorso al contesto.

L’approccio analogico, dunque, è molto utile per l’elaborazione del linguaggio naturale, fatto di

false eccezioni. Un esempio è dato dagli usi non letterali, tutt’altro che eccezioni, bensì parte

importante e frequente delle lingue umane. I sistemi analogici elaborano le metafore sulla base del

contesto e delle concordanze, a destra e a sinistra (ovvero i contesti in cui occorrono), delle parole

(Gola E., 2005, pp 141):

contesto sinistro

forma/parola

contesto destro

“la immagini una vita senza di vedermi

più, per esempio”

me? Non..

“non vuole più

vedermi”

Le collocations sono le parole più prossime a quelle di cui si vuole studiare il comportamento. Ad

esempio, “vedere”, in base al contesto, può voler dire “incontrare” o “conoscere”, “esaminare”.

Queste metafore, però, non sono totalmente arbitrarie e causali: i diversi sensi del verbo vedere,

dice E. Gola (ivi, pp 147), sono legati tra di loro ed è ciò che fa emergere delle regolarità. La

capacità di “leggere” il contesto è il motivo per cui i sistemi analogici sono stati spesso usati nel

tentativo di disambiguare significati non letterali. I sistemi di questo tipo attraversano due fasi:

•

preparare i testi esempi da far apprendere al calcolatore. Nel caso del verbo vedere, ad

esempio, vengono usate co-occorrenze di soggetti e oggetti usati insieme a questo verbo,

associando il senso corretto dello stesso verbo in riferimento a quale soggetto e a quale

oggetto compaiono in quel contesto:

contesto sinistro

forma/parola

contesto destro

“La immagini una vita senza di vedermi

me? Non…

più,

(=INCONTRARE)

26

per

(=ME/OGGETTO)

esempio”

Non viene preso in considerazione tutto il contesto, ma solo gli elementi che vengono

considerati significativi. Quindi, a partire dalle associazioni contesto/verbo disambiguato, il

sistema dovrebbe riuscire a comprendere il significato corretto di un enunciato che ha un

contesto diverso ma simile a quelli di cui si ha già traccia.

•

apprendere delle associazioni contesto/disambiguazione sulle quali si vuole istruire il

sistema. Non si tratta di una semplice registrazione, ma di una organizzazione dei contesti

che garantisca un utilizzo ottimale degli stessi. Immaginiamo il verbo “vedere” nel senso di

“esaminare”. Tale verbo ha come propri oggetti entità come libri, prodotti, conti, pagine,

dizionari. Immaginiamo di sottoporre il sistema all’analisi di un contesto nuovo come

“vedere un articolo”. Come disambiguare tale frase? Il sistema controlla la parola articolo e i

verbi dei quali essa può essere oggetto. Il sistema può trovare, ad esempio, che uno dei verbi

con i quali la parola cooccorre è “redigere”. “Redigere” presuppone la scrittura e quindi una

lettura. In tal modo, “vedere” può essere inteso come un “esaminare attraverso la lettura”

(ivi, pp 147-150).

Nel prossimo capitolo verrà analizzato un sistema che opera sulla base di un approccio analogico.

Per fare ciò è stata ricreata la stessa situazione sperimentale analizzata da Elisabetta Gola in

Metafora e mente meccanica, scegliendo come soggetto dell’analisi un verbo, guidare, che non ha a

che fare con la sfera sensoriale dell’uomo ma con qualcosa che sembrerebbe mettere in secondo

piano la metaforicità, visto il suo carattere prettamente pratico.

27

3. SISTEMI ARTIFICIALI DI ELABORAZIONE DI METAFORE BASATI

SULL’APPRENDIMENTO ANALOGICO

Il sistema analogico che verrà utilizzato nell’esperimento esposto in questo capitolo tenterà di

soddisfare caratteristiche che i sistemi analizzati precedentemente non si sono dimostrati in grado di

simulare. Soprattutto, ciò che più interessa, è la possibilità di imparare direttamente dall’esperienza,

adattandosi a situazioni nuove, attraverso l’esperienza acquisita.

Benché il sistema sia soltanto una semplificazione di quanto il sistema neuronale di un essere

umano può fare, ciò che viene auspicato è la possibilità , attraverso i suoi costituenti di base, di

renderlo in grado di ampliare le sue capacità anche per quanto riguarda il pensiero non linguistico.

L’esperienza cui il sistema dovrà attingere, sarà un’esperienza limitata a testi. Il compito, pertanto,

sarà quello di disambiguare sensi letterali e non, sulla base di alcune tecniche e metodologie. Queste

tecniche consentono di acquisire dati da un insieme abbastanza ampio di testi detto corpora,

attraverso l’osservazione e lo studio di porzioni di testo chiamate contesti. Tali contesti sono

caratterizzati da concordanze con una certa parola e collocations. Attraverso questi strumenti è

perciò possibile studiare il significato delle parole per mezzo di un’analisi del contesto e delle

strutture in cui le parole occorrono.

Questo genere di informazioni può aiutare ad affrontare il problema del significato. I testi, infatti,

rendono disponibile una grande quantità di dati, sulla base dei quali è possibile individuare

regolarità. Questo permette di costruire la rete di conoscenze di cui necessitano a partire dai testi

stessi. Le regole, in questo modo, non verrebbero fornite meccanicamente dall’esterno, ma

sarebbero ricavate dai dati a disposizione, elaborate sulla base dei compiti da eseguire.

Pertanto, il sistema di elaborazione che potrebbe dimostrarsi più efficace, dev’essere non solo in

grado di modificare la sua conoscenza a seconda dell’input e del contesto, ma anche capace di

trovare autonomamente soluzioni efficaci in qualsiasi situazione linguistica. Questa proprietà si

rivela particolarmente utile nei casi di uso non letterale.

Il sistema ipotizzato deve essere in grado di utilizzare in maniera creativa i significati acquisiti,

attraverso la proiezione di questi ultimi nelle situazioni non note. Un caso tipico è dato dalla

comprensione delle metafore, in cui la macchina dev’essere in grado di ipotizzare, oltre alla

presenza di significati letterali, significati non letterali. Il sistema opera in base ad un principio di

similarità, raggruppando i vari esempi in gruppi più o meno omogenei e interpretando un nuovo

esempio sulla base di una qualche somiglianza con quanto già sa. Il sistema non necessita di

informazioni profonde, anche se per ottenere migliori risultati può usufruire di informazioni

aggiuntive riguardanti contesti percettivi ed esperienziali più globali.

28

La macchina acquisisce, insieme ai dati, anche il compito da svolgere, apprende, cioè, associazioni

del tipo contesto/compito di comprensione.

Una volta preparato il testo si passa alla fase di apprendimento, durante la quale il sistema apprende

le associazioni contesti/disambiguazione. Vengono, poi, organizzati i contesti per renderli

utilizzabili quando ci si troverà di fronte a contesti non conosciuti. Confrontando in seguito contesti

non noti con quelli già appresi, il sistema troverà il significato più plausibile della parola.

Sulla base di un esperimento già svolto da E. Gola (2005) sul verbo vedere, nei paragrafi successivi

dimostrerò che un sistema artificiale basato sull’apprendimento è in gradi di disambiguare sensi

metaforici in contesti non noti, sfruttando informazioni e contesti precedentemente acquisiti.

3.1 Descrizione del sistema

3.1.1 Fase preliminare

Il sistema utilizzato per eseguire l’esperimento attinge la sua conoscenza direttamente dalla propria

esperienza contestuale. Il contesto dal quale dovrà apprendere, come detto, è fatto di testi,

organizzati secondo alcune metodologie sviluppate negli anni ’90. Il corpora di riferimento, nel

nostro caso, è stato selezionato in relazione alla presenza del verbo guidare. Il motivo per il quale è

stato scelto dipende dalla sua natura in apparenza strettamente “materiale”: esso, in effetti, sembra

ricondurre ad un campo d’azione legato ad attività fisiche che, almeno in teoria, ridurrebbero

all’essenziale eventuali significati metaforici. La fase preparatoria ha pertanto comportato una

ricerca dei sensi principali di tale verbo, che possono essere ricondotti a quattro grandi nuclei di

4

significato :

SIGNIFICATO

CARATTERISTICHE

ESEMPIO

FAR DA GUIDA

Metaforica immateriale

“Suo padre lo aveva sempre

(sinonimi = condurre, dirigere,

guidato tra le intemperie della

ammaestrare)

sua vita”

COMANDARE

Metaforica conativa

(sinonimi = reggere)

“Il generale guidò con

coraggio l’esercito alla

conquista”

INDIRIZZARE

Metaforica materiale

(sinonimi = istradare,

4

“La mappa indica il percorso

che guida alla scoperta del

I significati utilizzati sono quelli riportati dal Dizionario Garzanti.

29

regolare)

PILOTARE

tesoro”

Letterale

(sinonimi = manovrare)

“Andre Lagache e Rene

Leonard guidarono per 1373

miglia la loro 3 litri”

Già da questa prima fase è interessante notare come, su quattro significati, ben tre siano di tipo

metaforico, mentre soltanto uno di essi è letterale. Questo risultato è un ulteriore colpo inflitto ai

fautori di teorie che relegano la metafora ad elemento periferico e di disturbo del linguaggio.

Il passo successivo è consistito nel preparare i testi (esempi) che si vogliono far apprendere al

5

calcolatore e sui quali effettuare la ricerca. Tale corpus è stato suddiviso in 15 categorie, sulla base

dell’argomento trattato, e su queste è stata effettuata, attraverso le cosiddette espressioni regolari,

una ricerca delle ricorrenze del verbo guidare. Gli esempi che sono stati considerati contengono

cooccorrenze di soggetti e oggetti utilizzati insieme al verbo guidare, associando allo stesso verbo il

senso adeguato, di volta in volta, al contesto. Di questo, in realtà, il sistema apprende solo una sua

semplificazione, memorizzando, cioè, alcuni elementi particolarmente significativi della frase,

come il soggetto, l’oggetto, le preposizioni, e alcune particelle (cue) che possono giocare un ruolo

importante nella corretta disambiguazione del verbo. Questa limitazione del contesto è un modo per

facilitare l’utilizzo dei dati, ma in linea di principio si può considerare il contesto nella sua totalità.

La seguente figura fornisce alcuni esempi di attribuzione del senso. La concordanza del verbo è

analizzata facendo riferimento sia al contesto destro che a quello sinistro e ciò costituisce l’input

che il sistema apprende in associazione con il senso del verbo disambiguato:

5

Il corpus utilizzato è costituito da testi pubblicati negli anni 2001-05 nel sito di “Repubblica”, per un totale

di 80 milioni di caratteri.

30

contesto sinistro

forma/parola

contesto destro

Mazzone ha

*guida*

al trionfo del Friuli

ricostruito il Bologna,

Nakata lo

Nakata/soggetto

Far da guida

contesto sinistro

forma/parola

contesto destro

Gollum lo

* guida *

verso l’antro di un

gigantesco ragno

Gollum/soggetto

Indirizzare

Verso/cue

Il sistema utilizza queste associazioni contesto/verbo disambiguato per individuare la corretta

lettura del verbo in presenza di contesti diversi ma simili a quelli appresi.

3.1.2 Fase di apprendimento

Una volta forniti al sistema gli esempi, viene attivata la fase di apprendimento, durante la quale il

sistema acquisisce tutte le associazioni tra i contesti e la relativa disambiguazione della

forma/parola sulla quale si vuole istruire il sistema.

In questa fase il sistema va ben oltre la semplice memorizzazione, in quanto organizza i contesti in

modo da favorire la corretta comprensione di esempi nuovi. Di fronte a contesti non appresi, il

calcolatore confronta i dati con quelli già memorizzati e individua il significato più plausibile del

verbo in quella occorrenza. I dati vengono organizzati a questo scopo fornendo una lista degli

oggetti che cooccorrono con quel verbo quando assume un determinato significato. Per esempio,

uno dei significati possibili del verbo guidare è “far da guida”. Il sistema, consultando la base di

conoscenza acquisita, ha appreso che gli oggetti che possono essere “guidati” in questo senso sono

persone, squadre, comunità di individui.

3.1.3 Fase di valutazione

Una volta fornita una lista di esempi noti, il verbo viene disambiguato utilizzando le informazioni

relative agli oggetti a con i quali cooccorre. Ma come si comporta il sistema quando gli si chiede di

31

disambiguare il significato del verbo guidare in un contesto nuovo, in cui cooccorre, ad esempio,

con l’oggetto non specificato “azienda”? Il sistema dovrà, innanzitutto, controllare se conosce la

parola “azienda” e con quali verbi viene usata. Per esempio tra ciò che il sistema ha acquisito è

contenuta la conoscenza che le aziende possono essere gestite da individui, così come accade, per

esempio, per le squadre. La presenza di questa intersezione tra gli oggetti del verbo “gestire” e

quelli del verbo “guidare” portano il sistema ad ipotizzare che il senso del verbo “guidare” in

riferimento all’oggetto “azienda” sia lo stesso senso di quando “guidare” si riferisce a “squadra” e

cioè “dirigere”.

Il sistema giunge a questo tipo di generalizzazioni semplicemente analizzando i dati. Nessuna

estensione di significato è concessa se essa non è giustificata dalla presenza di conoscenza

effettivamente contenuta nel corpus sul quale il sistema apprende. Tale corpus costituisce

l’ambiente di referenzialità semantica del calcolatore, cosicché se la base di conoscenza cambia,

cambiano anche le possibilità che il sistema ha di comprendere. Com’è stato mostrato da Federici

(1997) il sistema, a seconda degli input ai quali è stato esposto durante l’apprendimento, è in grado

o meno di trovare giustificazioni della disambiguazione fornita per gli esempi che gli vengono via

via proposti. In caso di mancato riconoscimento degli input il sistema non avrebbe ritenuto errata

una possibile attribuzione di significato, ma semplicemente non motivata. Pertanto questo tipo di

sistema computazionale è sensibile alla crescita e al cambiamento delle sue conoscenze.

3.2 “Guidare” : risultati di un esperimento

Le ricerche compiute sul verbo guidare sono state effettuate sulla base dei principi sopra analizzati.

I risultati ottenuti si sono dimostrati molto incoraggianti, in quanto hanno confermato la possibilità

che un sistema artificiale diverso dall’uomo sia in grado di comprendere il linguaggio umano e,

cosa ancor più sorprendente, il suo uso figurato.

L’esperimento è stato eseguito dieci volte, su sistemi di dati diversi. I contesti appresi ogni volta

sono stati 738, più i circa 9000 contesti contenuti nel dizionario; 38, invece, i contesti non noti da

testare. Quando il sistema non era in grado di individuare, in base a quanto appreso, il significato da

attribuire alla forma/parola, veniva assegnato automaticamente il senso più ricorrente, ovvero “far

da guida”. In media, il sistema è stato in grado di individuare il senso corretto nell’89,33% dei casi,

con un significativo incremento del 14% rispetto al senso più frequente (la cui percentuale di

ricorrenza è del 75%). Tale crescita è molto positiva, soprattutto se consideriamo le limitazioni di

questo esperimento, per il quale mi sono soffermata soltanto sulle concordanze con soggetto e

oggetto del verbo guidare. Nel momento in cui verranno analizzate anche parole legate da

32

preposizioni o da cue, il margine di correttezza subirà sicuramente un notevole incremento, a

conferma dell’effettiva comprensione da parte del sistema.

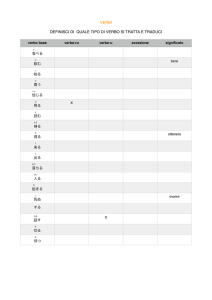

Nella tabella sono riportati i risultati relativi ad ogni fase dell’esperimento:

esperimento

Parole

Contesti per i Sensi

Percentuale

sconosciute

quali

correttezza

il

senso correttamente

di

“far da guida” è individuati

quello corretto

1

35

60

39

79,30%

2

29

74

45

91,50%

3

35

75

36

89,00%

4

34

61

42

95,10%

5

32

60

39

87,80%

6

46

58

27

95,10%

7

32

74

42

93,90%

8

24

58

37

87,80%

9

32

74

41

91,50%

10

42

74

36

82,30%

89,33%

media

75%

Frequenza senso

“far da guida”

3.3 Conclusioni

Per quanto il sistema analizzato possa risultare semplice, i risultati ottenuti nei compiti di

disambiguazione/comprensione dei sensi non letterali possono essere considerati ottimi. Un

approccio del genere comporta una rivalutazione degli assunti che vedono una lingua in base a

regole da seguire rigidamente, con le quali solamente si può costruire un testo. Il sistema utilizzato

ha dimostrato che la possibilità di estendere delle conoscenze apprese a contesti nuovi sulla base di

similarità è non solo possibile, ma una realtà linguistica nella quale gli stessi parlanti reali si calano

attraverso l’uso metaforico del linguaggio. Nell’approccio descritto, gli organismi artificiali

scoprono l’ambiente e imparano ad interagire con esso adattandosi alle possibilità che lo stesso

offre, senza fornire soltanto risposte deterministiche. Sulla base di quanto detto fino ad ora è

possibile effettuare un parallelo tra i sistemi di NLP e gli organismi viventi, in quanto dotati della

caratteristica di essere sistemi dinamici (Edelman, 1995) e tra testi e ambienti naturali, come luoghi

in cui tali sistemi devono apprendere e fare esperienze. Sia gli organismi che i sistemi artificiali

33

sfruttano l’ambiente per fronteggiare situazioni nuove, in modo sia creativo che controllato. Le

situazioni analizzate dal nostro sistema erano non note, ma omogenee rispetto a quelle conosciute.

La novità che emerge dagli esperimenti effettuati sugli usi non letterali attraverso calcolatori

consiste nel fatto che benché questo approccio, in linea di principio, sia computazionale e

simbolico, è in grado di stabilire connessioni tra fenomeni correlati, come fa un sistema neuronale.

Il sistema, ovviamente, non si propone di spiegare tutto il linguaggio, ma di sicuro avvalora la tesi

di un linguaggio “incorporato”, in cui le metafore costituiscono un fenomeno cognitivo tutt’altro

che secondario. Inoltre, emerge come il confronto dinamico tra le diverse conoscenze consenta, di

volta in volta, l’emergere di alcune caratteristiche che risulteranno, poi, pertinenti per l’attuazione

delle procedure decisionali. Significativo è anche il fatto che il sistema è in grado di affrontare

l’eventuale nuova acquisizione di conoscenza sfruttandola a suo vantaggio, attraverso la

combinazione di dati che consentono di facilitare il compito di comprensione e di tollerare eventuali

inesattezze, dal momento che la conoscenza non è depositata rigidamente nella base di dati, bensì è

distribuita nei rapporti relazionali tra le varie unità concettuali. Sicuramente i testi di cui facciamo

esperienza giornalmente sono molto più ricchi, da un punto di vista semantico, dei fenomeni

simulati dall’algoritmo analogico. Un passo avanti può essere quello di creare un sistema in grado

di gestire metafore a contatto più diretto con dati reali, come i testi di una lingua naturale.

Un aspetto sicuramente rilevante è che non viene effettuata una cesura tra letterale e metaforico. La

procedura analogica è in grado di individuare sensi figurati sia a partire da frasi letterali che da frasi

metaforiche, rendendo labile anche la distinzione tra metafore nuove e metafore istituzionalizzate,

considerate soltanto come metafore che si ha più probabilità di apprendere per prime. Uno degli

aspetti più creativi di questo sistema è proprio la possibilità che la risposta data non sia conforme ad

un uso metaforico, per così dire, già convezionalizzato, bensì una risposta nuova ma comunque

possibile e sensata. Questo consente, così, di far fronte sia a metafore fondate sulle metafore

concettuali, sia a metafore non legate all’aspetto più concreto e fisico del linguaggio, ma ad eventi

storico-culturali che in esso trovano spazio.

34

BIBLIOGRAFIA

Black M., 1962, Models about Metaphor. Studies in Language and Philosophy, Ithaca-London. (Tr.

It. parziale in [Black, 1983, 97-135])

Burattini E., Cordeschi R., 2001, pp. 48-62, Intelligenza Artificiale, Roma, Carocci

Federici S., Pirelli V., 1995, pp. 35-46, Analogia apprendimento automatico ed elaborazione del

linguaggio naturale, AI*IA notizie, periodico italiano dell’associazione per l’Intelligenza

Artificiale, n. 2,

Fodor J., Katz J., 1963, pp. 170-210, The structure of the Semantic Theory, Language 39

Frixione M., 2001, pp. 70-92, Rappresentazione della conoscenza, in Burattini E., Cordeschi R.,

Intelligenza Artificiale, Roma, Carocci

Gardner H., 1988, pp. 54-59, La nuova scienza della mente, Milano, Feltrinelli

Gola E., 2005, p .21-22, Metafora e mente meccanica. Creatività linguistica e processi cognitivi,

Cagliari, CUEC