RAPPORTO DI RICERCA PER SAP ITALIA

VELOCITA’ AZIENDALE E TECNOLOGIE

MEMORY: UNA PROSPETTIVA MANAGERIALE

A cura di

Paolo Pasini

Angela Perego

Rapporto di Ricerca per SAP Italia

Velocità aziendale e tecnologie In-Memory:

una prospettiva manageriale

a cura di

Paolo Pasini

Angela Perego

IN-

Pubblicato nel mese di Maggio 2012

© 2012 SDA Bocconi School of Management e SAP AG. Tutti i diritti riservati.

Indice

1

2

Le ICT e i nuovi orizzonti del management aziendale .............................................. 7

La velocità aziendale come elemento di competizione ......................................... 14

2.1

La velocità dell’innovazione ........................................................................... 15

2.2

La velocità dei processi aziendali.................................................................... 16

2.3

La velocità di reazione a eventi inattesi ......................................................... 18

3 Le tecnologie In-Memory: elementi distintivi e di innovazione ............................. 20

4 Gli ambiti di applicazione delle tecnologie In-Memory per la Velocità aziendale:

alcuni casi internazionali ................................................................................................ 25

5 I benefici e il valore aziendale dell’In-Memory ...................................................... 31

5.1

La velocità aziendale ....................................................................................... 31

5.2

L’informazione di ogni tipo, in ogni luogo, in ogni tempo ............................. 31

5.3

Il superamento della distinzione tra sistemi informativi transazionali e sistemi

di BI ........................................................................................................................ 32

5.4

Miglioramento della catena performance tecniche-performance aziendali: le

analisi alla “velocità del pensiero” ............................................................................. 33

5.5

Libertà di analisi .............................................................................................. 35

5.6

Minor Time-to-Delivery .................................................................................. 35

5.7

Maggiore “effetto esperienza” ....................................................................... 36

5.8

Ottimizzazione dei costi di gestione IT ........................................................... 37

5.9

Minor complessità di gestione IT ................................................................... 38

6 Conclusioni ............................................................................................................. 40

Bibliografia ...................................................................................................................... 42

© 2012 Divisione Ricerche “Claudio Demattè”

3

SAP Italia

4

SDA Bocconi School of Management

© 2012 Divisione Ricerche “Claudio Demattè”

Gruppo di Lavoro

SDA Bocconi School of Management

Paolo Pasini

Professore di IS Strategy e Management, senior lecturer e

direttore dell’Osservatorio Business Intelligence presso SDA

Bocconi. Professore a contratto presso l’Università

Commerciale Luigi Bocconi di Milano. Docente ufficiale del

Master universitario in Project and Information

Management.

Angela Perego

Lecturer di Sistemi Informativi presso SDA Bocconi. Docente

ufficiale del Master in Project and Information

Management e del Master in Economia e Management dei

Trasporti, della Logistica e delle Infrastrutture presso

l’Università Commerciale Luigi Bocconi di Milano.

© 2012 Divisione Ricerche “Claudio Demattè”

5

SAP Italia

6

SDA Bocconi School of Management

© 2012 Divisione Ricerche “Claudio Demattè”

Tutti questi fenomeni aziendali

hanno un denominatore comune, la

velocità, che è diventata una

condizione sempre più determinante

per:

1 Le ICT e i nuovi orizzonti

del

management

aziendale

svolgere i processi e le attività

aziendali

(es.

un

processo

commerciale, la creazione di un

nuovo concept di prodotto, la

produzione di un conto economico

Nel

campo

del

business

management il nuovo millennio si è

aperto con nuove suggestioni derivate

dall’impiego delle ICT che hanno dato

vita a filoni di pensiero e di ricerca

innovativi: Real Time Enterprise, Data

Explosion e oggi Big Data (dati

strutturati e non strutturati, social web

data, location data, dati da Internet

delle cose e M2M, etc.), Next

Generation Business Intelligence e

di prodotto o di cliente, la

comunicazione di marketing con

media digitali);

trattare in modo integrato grandi

volumi di dati eterogenei (es. dati di

vendita, reclami a un customer care

e commenti sui blog o nei social

network, dati di geo-localizzazione)

e

ottenere

un’informazione

rilevante (es. di insight nel

comportamento di acquisto di un

Analytics (inclusa la RealTime BI o la BI

embedded nei processi operativi

aziendali), In-Memory Computing,

Open Innovation (e Co-Innovation),

Global, Networked e Liquid Enterprise.

segmento di clientela e delle sue

percezioni di qualità verso il

prodotto), fenomeno che oggi viene

menzionato con l’espressione “Big

Data”;

Trattamento “integrato” di

grandi volumi di dati

eterogenei

Processi e attività

aziendali

Velocità

Gestione delle relazioni

digitali e della ubiquità dei

dati e delle persone

© 2012 Divisione Ricerche “Claudio Demattè”

Rilevazione, archiviazione,

elaborazione, distribuzione

e presentazione dei dati con

sistemi ICT

7

SAP Italia

SDA Bocconi School of Management

rilevare, archiviare, elaborare,

distribuire e presentare i dati

generati utilizzando i sistemi ICT;

gestire le relazioni digitali tra le

persone, le imprese e le istituzioni e

che permettono la “ubiquità” dei

dati e degli individui.

La velocità riguarda quindi, il tempo, il

ritmo delle cose, del lavoro, delle

persone, ma la velocità senza controllo,

senza finalità, non genera utilità, non

genera valore, soprattutto nel campo

economico-aziendale. E il controllo oggi

è sempre più esercitato da una

combinazione di persone e di sistemi

informatici che lo supportano.

La metafora delle auto di Formula 1

fornisce un buon esempio per capire

come si combinano in modo esemplare

queste due capacità di controllo (gli

strumenti ICT di bordo collegati in

RealTime a quelli di scuderia, la squadra

e il pilota).

Si può andare oltre. La velocità oggi

a disposizione delle aziende si

concretizza nella capacità potenziale di

ridurre il tempo necessario non solo

per l’esecuzione di un’attività, ma

anche per la sua finalizzazione, per il

cambiamento repentino e “in corsa”

dei suoi obiettivi o delle sue relazioni

con altri processi, e questa è la vera e

rivoluzionaria novità per la gestione

d’azienda. La metafora del navigatore

satellitare nel guidare il percorso verso

una destinazione può aiutare a

8

comprendere questo aspetto, nel caso

in cui la destinazione debba cambiare in

modo inaspettato: la reimpostazione

“in corsa”, durante il viaggio, in tempo

reale, della nuova località consente

velocemente di riprogrammare il

percorso e le risorse necessarie (tempo,

carburante,

pedaggi,

etc.)

per

raggiungere l’obiettivo, senza lunghe

attese dovute alla ricerca dei dati, alla

loro elaborazione, alla presentazione

delle informazioni rilevanti e alla loro

interpretazione. È chiaro che il

muoversi in un contesto dove si hanno

tutti i dati a disposizione, in un contesto

dove i tratti stradali sono definiti, le

distanze sono finite e calcolabili,

consente di affrontare un problema con

un margine di errore ridotto e

accettabile. Per riavvicinarsi al contesto

più reale e incerto in cui operano le

aziende è necessario menzionare il

fatto che i tratti stradali cambiano,

“lentamente” ma cambiano (e quindi i

dati delle mappe vanno aggiornati

frequentemente), i lavori in corso o gli

incidenti

possono

bloccare

la

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

circolazione (e questo rende necessario

disporre di un sistema di informazione

in tempo reale sulle condizioni del

traffico),

questi

eventi

incerti

condizionano lo svolgimento del

percorso, e quindi potrebbe essere

necessario

programmare

delle

deviazioni o scegliere un percorso non

ottimale; comunque il sistema di

informazione (il navigatore) è sempre

disponibile, a supporto continuo e in

tempo reale del “guidatore-decisore”,

elaborando sia dati storici disponibili (i

dati georeferenziati delle mappe

geografiche), sia i dati che sono resi

disponibili in tempo reale (i dati GPS dei

veicolo in movimento, i dati sul

traffico), sia i dati forniti dal “decisoreguidatore”

(le

destinazioni,

le

caratteristiche del percorso desiderato,

più veloce o più breve, etc.).

Quest’ultima metafora può aiutare

in modo semplice a comprendere cosa

significherebbe per le imprese disporre

di un simile sistema di “navigazione

aziendale” che le supportasse a

muoversi anche su terreni spesso

sconosciuti, imprevisti, incerti. La

complessità crescente della gestione

SAP Italia

aziendale di cui si parla spesso, di fatto

è generata da due fattori prevalenti:

la

crescente

velocità

dei

cambiamenti

(di

percorso)

necessari;

la crescente incertezza degli scenari

(cioè, dei terreni in cui muoversi) e

dei risultati generabili dalle scelte

possibili (in termini di performance,

cioè in termini di tempi e risorse

impiegate per raggiungere

destinazione desiderata).

la

Ora questo sistema di “navigazione

aziendale”

si

sta

velocemente

configurando all’orizzonte, facendo

leva sulla convergenza di strumenti

tecnologici

di

memorizzazione,

elaborazione e trasmissione di dati

digitali, di competenze delle persone, di

disponibilità tempestiva di elevati

volumi di dati di ogni natura, di

strumenti di scouting, ricerca, selezione

e interpretazione intelligenti, che

consentono di superare i tradizionali

ostacoli dell’”Information Overloading”

e dalla “Paralysis by Analysis”.

Questo

nuovo

sistema

da

configurare e personalizzare in ogni

impresa ha la capacità di superare molti

dei paradigmi manageriali oggi

conosciuti: ad esempio non avrà più

senso distinguere tra dati operativi e

dati direzionali, o tra sistemi

transazionali e sistemi di analisi e di

informazione; il dato che serve per

perfezionare un ordine online di un

© 2012 Divisione Ricerche “Claudio Demattè”

9

SAP Italia

SDA Bocconi School of Management

cliente, è immediatamente disponibile

per un’attività in tempo reale o quasi

reale, di profilazione del cliente, di upselling o di cross-selling, di promozione

di altri prodotti o di ricalcolo in tempo

reale della redditività del cliente stesso;

oppure il dato di geo-localizzazione di

un’auto di un cliente (che ha

autorizzato la sua geolocalizzazione!) di

un servizio di sorveglianza satellitare o

di un’assicurazione, può servire

avere queste situazioni di ricavi e costi

aggiornate in tempo quasi reale dopo

ogni operazione di vendita o di

acquisto.

Così

come

sarebbe

rivoluzionato pesantemente il processo

di pricing dei prodotti o dei servizi

potendo applicare concetti di revenue

management in tempo reale, non solo

nella vendita di una stanza di hotel o di

un posto aereo o treno man mano che

si avvicina la data di consumo, ma

immediatamente sia per attivare

interventi operativi (in caso di

soccorso), sia per effettuare azioni di

geo-promozione in operazioni di

location-marketing su device mobili, sia

per analizzare il comportamento di

guida del cliente al fine della

determinazione del prezzo della sua

polizza. Oppure più semplicemente non

sarà più necessario trasportare e

estendendo questa idea di Dynamic

Pricing anche a tutti i prodotti deperibili

di un retailer (non solo al pesce!) man

mano che si avvicina la data di

scadenza, oppure ai biglietti per uno

spettacolo,

alla

“distribuzione

temporale intelligente” dei saldi

nell’abbigliamento anche durante la

singola giornata di apertura di ogni

singolo punto vendita di proprietà,

manipolare i dati operativi contabili

delle aziende dai database transazionali

in

database

dedicati

all’analisi

(datawarehouse o datamart), dal

momento in cui tutti i dati operativi

elementari o intermedi possono essere

disponibili in strutture dati libere, in

ambienti ad altissima velocità di

accesso (tipicamente in memoria RAM,

e non su disco fisico). Altrettanto

potrebbe non avere più senso pensare

oppure alla vendita B2B o B2C di

macchine per il condizionamento,

oppure nel pricing di un progetto a

saturazione di risorse nel campo dei

servizi professionali, oppure nel pricing

orario dell’energia, e così via.

a livello gestionale, alle chiusure

contabili, ai conti economici di

prodotto, di cliente, di Business Unit o

aziendali come a situazioni di periodo,

quando potenzialmente si potrebbe

10

Altresì potrebbe trasformarsi un

altro dei grandi paradigmi del

management che contrappone il

“grande” al “piccolo”, le economie di

scala alle economie di flessibilità: se in

alcuni settori (ad es. nei consumer

package goods) non c’è dubbio che la

dimensione di impresa su scala globale

è vincente e indispensabile, in realtà

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

oggi è il “veloce” che vince contro il più

“lento” (economie di velocità).

Come in tutti i cambiamenti

generati dalle tecnologie, anche in

questo caso il change management

deve azionare leve che riguardano

anche le persone, la cultura:

nuovamente la velocità senza un

adeguato controllo non genera alcun

valore in azienda. Le persone, il

management aziendale devono saper

convivere con la velocità ed essere in

grado di governarla, per poterla

sfruttare

al

meglio,

generando

performance incrementali.

I seguenti punti possono aiutare a

riassumere i principali cambiamenti già

in atto e basati sulle ICT, che

prospettano alcuni nuovi orizzonti del

management aziendale:

1. Trasformare il modo in cui le

persone pensano, analizzano i fatti,

pianificano e agiscono: nuovi skill

sono necessari, ma soprattutto

nuovi atteggiamenti nei confronti

delle ICT, passando da molti

fenomeni

di

moda

e

di

“consumerization” (ad es. riguardo i

device mobili o il social web), ad un

reale impiego nella gestione

aziendale.

2. Velocizzare i processi di Innovation

Management,

sia

di

prodotto/servizio

(dall’idea

generation al concept al testing e

allo sviluppo), sia di processo

© 2012 Divisione Ricerche “Claudio Demattè”

SAP Italia

(interno esterno, operativo o

manageriale), generati dalle ICT.

3. Far funzionare in modo sincrono

elevati volumi di transazioni e

operazioni aziendali con veloci ed

evolute attività di analisi dei dati

strutturati (es. dati contabili) e non

strutturati (es. dati del social web,

di geolocalizzazione, di audio-video)

generati

da

questi processi

operativi online e offline.

4. Velocizzare le decisioni aziendali

con un numero maggiore di

informazioni rilevanti (e quindi

opportunamente selezionate) e con

sistemi di

comunicazione

e

collaborazione ad alta velocità, in

tempo reale, tra persone, tra team

di lavoro, tra imprese.

5. Aumentare

i

cicli/ritmi

di

misurazione, di monitoraggio e di

analisi dei fatti aziendali per

innescare veloci attività “trial and

error”, veloci cicli di “Analyze, Plan,

Act and Control”, piuttosto che

profondi e lenti processi di

decisione analitica:

Analyze

Plan

Control

Act

11

SAP Italia

SDA Bocconi School of Management

L’impiego di tecnologie di Business Intelligence (BI Tools e BI Analytics) in modalità

RealTime è ancora allo stato embrionale e sperimentale: ampi spazi di diffusione

esistono in tutti i settori economici rappresentati dal campione di 120 imprese indagate

nella ricerca.

Infatti il 49% del campione deve gestire processi decisionali strategici con frequenza

inferiore ai 3 mesi, un tempo decisamente “faticoso” per impostare e svolgere un tipico

progetto IT; la soluzione in queste imprese risiede nel creare le condizioni il più

“naturali” possibili per produrre e distribuire le informazioni necessarie a questi processi

decisionali , cioè una piattaforma aziendale di BI flessibile, usabile anche in modalità

“user self-service”, che possa gestire un’ampia e profonda base di dati aziendali di

qualità e aggiornati con tempestività differente, fino al tempo reale ove necessario e

opportuno.

Tuttavia la maggioranza (il 57% dei rispondenti IT e il 69% delle persone non IT)

dichiara un livello soddisfacente o perfettamente coerente nei tempi di produzione delle

informazioni critiche per la direzione aziendale: la percezione media sui tempi di attesa

non si presenta quindi particolarmente critica. Questo si spiega sicuramente in parte con

la presenza di sistemi di BI efficienti nei tempi di produzione delle informazioni, in parte

nell’ancora diffusa inconsapevolezza del significato e dell’utilità del Real Time nella

velocizzazione dei cicli di controllo e di decisione operativi e direzionali.

A sostegno dell’ultima affermazione, e a dimostrazione del fatto che i sistemi di BI

attuali sono insufficienti, interviene il giudizio sugli ostacoli principali nello svolgimento

dei processi decisionali strategici per l’impresa, dove al 2° posto, più di un terzo del

campione, cita la mancanza di informazioni di qualità, in termini di completezza,

affidabilità, aggiornamento e tempestività (mentre al primo posto si citano ostacoli di

carattere organizzativo che esaltano il ruolo che potrebbe svolgere oggi la c.d. “BI

collaborativa” e la “BI Mobile”).

In questo quadro però la funzione SI ha un ruolo riconosciuto di primo piano da parte

della proprietà e del top management delle imprese, ruolo tutto da giocare anche in

termini di spinta all’innovazione dei sistemi di BI finora realizzati e gestiti.

Da osservare come principali candidati delle tecnologie di BI RealTime, nel settore

Finance, i processi di gestione del rischio, della sicurezza on-line e dei Sistemi informativi;

nel settore Manifatturiero, i processi di Controllo di gestione, Produzione e Fatturazione;

nel settore dei Servizi in generale, Media, Utilities e GDO, i processi di Controllo di

gestione, Fatturazione e Sistemi Informativi. Stranamente più assenti sono i processi

Commerciali e di Marketing, soprattutto on-line, che sono tipicamente e storicamente

interessati da analisi in tempo reale dei fenomeni in corso.

Poco impiegati sono i sistemi di Alerting automatici all’interno dei sistemi di BI

RealTime e non RealTime, che potrebbero dare un impulso interessante al cd.

“management by exception”, attirando l’attenzione manageriale solo sui fenomeni che

superano certe soglie di sicurezza o di tolleranza o che deviano da modelli di

comportamento usuali.

Gli ostacoli percepiti come più forti nell’introduzione delle tecnologie di BI RealTime,

sono le ancora le classiche 3 “C”: costi, cultura e competenze!

SDA Bocconi - Ricerca sulle informazioni in RealTime in Italia, 2011.

12

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

meno capacità di “andare in

profondità” e più capacità di

“mettere in relazione” i fatti e di

reagire in modo esperto, deduttivo,

basando le decisioni su fatti

documentati in continuo, in tempo

sempre più reale.

6. Essere coscienti che il sogno della

“real time enterprise” può avverarsi

solo in alcuni business (es. le web

company) o in nicchie di

aprono nel campo delle analisi e

delle decisioni, ma solo se si

possiedono anche le capacità di

chiudere il cerchio, il loop “Analyze,

Plan, Act and Control”: in altri

termini, la più veloce e sofisticata

capacità di analizzare fatti e

decidere

(“insight”)

deve

necessariamente scaricarsi a terra

in azioni innovative, fattibili, veloci,

economicamente convenienti (nel

attività/processi aziendali fisici (es.

processi produttivi) o con particolari

caratteristiche (es. fraud detection,

trading finanziario), mentre nuove

opportunità di “Near RealTime” si

marketing,

nel

business

development, nella finanza, etc.),

diverse da prima, altrimenti resta

un potenziale inespresso e fine a sé

stesso.

© 2012 Divisione Ricerche “Claudio Demattè”

13

2 La velocità aziendale

come

elemento

di

competizione

Nel paragrafo precedente si è

velocemente i nuovi bisogni della

domanda contribuisce a velocizzare sia

il time to innovate che il time to

market, altrettanto chiaro è che

commettere errori in questa attività

può portare alla perdita di investimenti

di sviluppo e di marketing. Tutto ciò ha

portato negli ultimi anni a sviluppare

modelli di Open Innovation, e in

particolare di Co-Innovation con i clienti

attuali o potenziali, che permettono di

detto che la competizione oggi si gioca

soprattutto tra chi è “lento” e chi è

“veloce”: veloce nell’innovazione di

prodotto/servizio

(“time

to

innovation”), nel diversificarsi a livello

geografico, nei prodotti/servizi, veloce

nei processi aziendali, veloce nel

reagire a eventi imprevisti (“time to

market”), e infine veloce nel “time to

profit”.

ridurre i rischi di un Product o Service

Development errato e i rischi finanziari

collegati, non allungando i tempi di

sviluppo, anzi riducendoli con approcci

collaborativi.

La velocità aziendale assume quindi

molti significati.

pagamento di una fattura), con una

La velocità può indicare il “time to

innovation”, perseguito sia con la

riduzione dei leadtime dalla fase di idea

generation, alla fase di concept, alla

fase di testing, alla fase di sviluppo, sia

con l’aumento della frequenza di

presentazione al mercato di nuovi

prodotti o servizi. Oppure il “time to

market” dei prodotti/servizi, cioè il

tempo che intercorre dalla disponibilità

di un nuovo prodotto/servizio al suo

lancio sul mercato. È evidente che una

buona capacità di individuare e rilevare

14

Velocità può significare anche

puntualità, cioè rispetto degli impegni

(di tempo) assunti con un cliente (es.

nella consegna di una commessa o di

un ordine), con un fornitore (es. nel

Innovazione

Processi

aziendali

Reazione a

eventi

inattesi

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

funzione aziendale interna (es. nei

tempi di rilascio di un progetto IT

applicativo). Quest’ultimo aspetto

riguarda strettamente la capacità di

eseguire “velocemente” i processi

aziendali, operativi e direzionali.

Infine velocità è assimilabile al

concetto di tempestività di business,

cioè al fatto di essere i “primi” a

effettuare un’azione sul mercato o al

fatto di reagire prontamente a un

evento imprevisto che si è manifestato

sul mercato: una decisione sul pricing

dei prodotti è tempestiva se è presa

prima che avvenga un fatto esterno che

ne neutralizza o limita l’impatto e

l’efficacia

commerciale

(es.

un

riadeguamento

dei

prezzi

del

competitor principale); oppure la

decisione di lanciare un nuovo prodotto

sul mercato come reazione a un nuovo

prodotto del principale competitor, è

tempestiva se avviene in un arco di

tempo tale da non concedere rilevanti

vantaggi di posizione al concorrente

“first comer”.

2.1

La velocità dell’innovazione

L’innovazione è un processo molto

complesso, i cui effetti incidono in

maniera diffusa e pervasiva su tutti i

processi

dell’azienda,

da

quelli

produttivi e logistici, a quelli distributivi

e

commerciali,

a

quelli

di

comunicazione e di marketing, a quelli

amministrativi

e

L’innovazione può

di

controllo.

essere radicale,

casuale, saltuaria, oppure può essere

incrementale, può essere innovatività,

ossia la capacità di generare

continuamente prodotti nuovi e di

successo in misura sostenibile dalle

routine dei processi aziendali (Baglieri,

2012). L’innovatività consiste nella

costruzione di processi e competenze

che

consentano

di

mantenere

costantemente allineata la posizione

tecnologica dell’impresa alla sua

Una ricerca SDA Bocconi sul tema della Velocità aziendale, tra cui la velocità dell’Innovazione,

ha evidenziato (Baglieri, 2012) l’importanza dei seguenti aspetti:

Velocità. Non è un valore assoluto, ma relativo. Non è tuttavia la velocità a determinare

il successo della singola innovazione, ma il suo ritmo di manifestazione sul mercato ne

costituisce il fattore di successo competitivo.

Ascolto del cliente. È una determinante del successo dell’innovazione molto più efficace

della tecnologia.

Anticipazione del cliente. Ascoltare il cliente non significa “appiattirsi” nel miglioramento

incrementale, che pure è essenziale, ma avere la capacità di reinterpretare i feedback del

cliente in chiave originale e reinventare i prodotti e i servizi anticipando i bisogni dei

clienti.

Semplicità. L’innovazione veloce, ma complessa, fallisce. L’innovazione deve garantire al

cliente una risposta semplice ai propri problemi.

© 2011 SDA Bocconi – Forum Eccellenza Operativa.

© 2012 Divisione Ricerche “Claudio Demattè”

15

SAP Italia

SDA Bocconi School of Management

posizione competitiva e di sostenere e

accrescere il vantaggio competitivo

dell’azienda proprio attraverso la

transizione continua della tecnologia

sui prodotti e sui processi aziendali

(Baglieri, 2012). In entrambi i casi,

l’impiego delle ICT e l’esternalizzazione

a clienti, a fornitori o a comunità di

ricerca di consistenti attività di

innovazione, ha generato una forte

riduzione dei tempi di sviluppo

2.2

La velocità dei processi

aziendali

dell’innovazione.

Numerose esperienze di ricerca

sostengono che è significativa sotto il

profilo strategico la “cadenza” con la

quale si rilasciano le innovazioni sul

mercato. Se, ad esempio, si osserva la

strategia di innovazione di SMH, il

consorzio svizzero dei produttori dei

celebri orologi Swatch, si noterà che,

successivamente alla prima tiepida

standardizzazione. E questo vale per

ogni tipologia di processo. Per Ing

Direct anche il processo di acquisizione

del cliente e di attivazione del primo

contratto deve essere standard,

semplice, veloce, automatizzato e

tracciabile con un forte impiego di ICT.

Per BTicino la velocità dei processi

passa attraverso una revisione del

processo di consegna anche per quei

prodotti finiti di classe B e C che

accoglienza riservata dal mercato al

prodotto, si decise di introdurre quale

elemento

di

innovazione

e

differenziazione proprio il concetto

della collezione, ossia del ritmo

prefissato e scandito dalle stagioni nella

moda, settore al quale l’orologio al

quarzo con lancette si prefiggeva di

accostarsi come accessorio. Oppure

rilevanti sono i casi di Sisal nel settore

rappresentano il compendio di gamma

e per i quali a magazzino erano

detenuti minimi livelli di stock, con

l’obiettivo quindi di migliorare il livello

di

servizio

riducendo

contemporaneamente

le

scorte.

Passando da una gestione tradizionale

della domanda basata su sistemi MRP

su previsione, a una produzione “tirata”

dalle esigenze del cliente che richiedeva

del gioco con le continue varianti di

“Win for Life” o di Sky con SkyGo,

ennesima innovazione nelle modalità di

fruizione di contenuti televisivi.

frequenze di consegna

elevate, per quantità

sempre più ridotte e

tempo, la velocità

diventava cruciale.

16

La velocità dei processi aziendali ha

molti modi per esprimersi, e

considerando che sono il modo per le

aziende di costruire e svolgere routine,

cioè procedure e attività ripetitive e

strutturate in fasi, quasi sempre hanno

l’obiettivo di generare efficienza,

produttività,

trasparenza

e

sempre più

di prodotto

variabili nel

di processo

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

Ancora, velocità dei processi può

significare per le imprese di produzione

alimentare, come Illy nel comparto del

caffè o Mutti nel comparto del

pomodoro, automatizzare il processo di

raccolta, controllo e tracciamento dei

dati di qualità delle materie prime e dei

semilavorati,

per

poter

agire

tempestivamente nei casi in cui si

manifestino anomalie e fuori norma.

trasportatori di palmari su quali

registrare l’avvenuta consegna della

merce), dall’altra ha affidato in

outsourcing i processi amministrativi.

In DHL Supply Chain l’impiego delle

ICT per velocizzare i processi aziendali

non core ha agito su due fronti: da una

parte ha dematerializzato gran parte

dei processi documentali (es. dotando i

contraffazioni, ridurre i tempi di

attivazione e di consegna della polizza

al cliente e risparmiare quindi sui costi

di spedizione.

Sulla scia della de-materializzazione,

molte assicurazioni sono pronte a

migliorare e velocizzare il servizio al

cliente trasformando in elettronico

anche l’attuale contrassegno di

assicurazione, al fine di ridurre le

I risultati emersi da un focus group svolto in SDA Bocconi sulla velocità aziendale, e quindi sulla

velocità dei processi aziendali, porta a evidenziare i seguenti aspetti (Pozzoli, 2012).

I processi sui quali le aziende ripongono maggiore attenzione in termini di miglioramento della velocità sono quelli client-facing e quelli ad alta intensità documentale. Sui primi esiste una

esplicita richiesta di maggiore velocità e livello di servizio sia dall’interno dell’azienda, sia dal

cliente finale stesso; sui secondi, invece, che spesso sono processi interni, esiste una forte consapevolezza interna all’azienda che la presenza di documentazione cartacea è elemento di rallentamento del processo, e che una volta rimosso può produrre benefici che vanno oltre la

dematerializzazione arrivando fino al miglioramento della qualità interna, del prodotto e del

servizio al cliente finale.

In tutti i progetti di miglioramento e di velocità di processo si parla di ICT. Questo dimostra

come non sia possibile oggi modificare le modalità operative senza implementare l’ICT. Però,

l’ICT viene letta sotto diversi aspetti:

a. come facilitatore, ovvero come strumento per automatizzare il processo, per migliorare le

informazioni a disposizione su un determinato processo (es. previsione della domanda),

per controllare il processo, etc.;

b. come ostacolo, ovvero come elemento causa di scarsa integrazione tra attività svolte da

diverse unità organizzative (es. a causa della disomogeneità di sistemi informativi spesso

utilizzati dalle diverse unità coinvolte in un processo aziendale);

c. come repository di conoscenza sul funzionamento delle business operation (es. Zegna che

utilizza l’ICT come leva fondamentale per racchiudere la conoscenza implicita di prodotto

moda).

©2011 SDA Bocconi – Forum Eccellenza Operativa.

© 2012 Divisione Ricerche “Claudio Demattè”

17

SAP Italia

2.3

La velocità di reazione a

eventi inattesi

Crisi, instabilità, interdipendenza,

incertezza e complessità sono le parole

chiave che caratterizzano il contesto

attuale: di conseguenza, la capacità dei

nostri sistemi, intesi come paesi,

aziende e individui, di assorbire

“traumi” di vario genere e di adattarsi

al nuovo contesto e ri-organizzarsi

velocemente assume un’importanza

enorme.

L’espressione “Resilienza” è definita

come l’abilità di “reagire o ri-adattarsi

facilmente e velocemente a eventi

inattesi, spesso negativi”. La resilienza

può significare la “velocità di ripristino

della normalità, dopo un evento

traumatico”, oppure l’ampiezza del

“trauma” che può essere assorbito dal

sistema in quanto tale senza generare

impatti negativi sull’operatività, spesso

affrontato con la “ridondanza” delle

risorse (D’Amato, 2012).

Il classico esempio che viene citato

quando si parla di “resilienza” in ambito

supply chain è relativo all’incendio

avvenuto nella fabbrica di semiconduttori della Philips in New Mexico,

nel 2000. A causa dell’incendio, Philips

comunica un ritardo di una settimana

nella consegna dei suoi prodotti a due

dei suoi maggiori clienti, Nokia e LM

Ericsson. Nokia, immediatamente,

condivide la notizia del ritardo

all’interno della sua organizzazione,

18

SDA Bocconi School of Management

comprende l’eventuale impatto del

ritardo e della mancata fornitura dei

componenti sul suo business e si

adopera per cercare e acquisire al più

presto

fonti

alternative

per

l’approvvigionamento dei componenti

e per evitare di subire il ritardo, che si

rivelerà molto più lungo del previsto.

Per Ericsson, si tratta di un normale

ritardo di una settimana, la notizia

rimane nell’ambito della funzione

acquisti e, quando l’azienda realizza la

gravità del problema, è troppo tardi per

porvi rimedio.

La “mappatura delle vulnerabilità”è

il primo passo verso un’azienda

“resiliente”. Il secondo è di individuare

le azioni che possono ridurre la

probabilità che l’evento di rischio si

verifichi oppure quelle che possono

mitigare l’impatto dell’evento di rischio

sull’operatività e sulle performance

aziendali.

Tutte

le

aziende

hanno

generalmente procedure strutturate e

organizzate di “Disaster Recovery” per i

sistemi IT, per le comunicazioni, per i

sistemi produttivi o logistici.

Poche aziende hanno sistemi

decisionali basati su tecnologie di BI in

grado di “anticipare” e di migliorare la

capacità di “prevedere” gli eventi

inattesi della concorrenza e della

domanda di mercato, dei prezzi delle

materie prime, della fuoriuscita di

risorse umane chiave per l’azienda,

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

etc., e di essere in grado di sviluppare

scenari alternativi per far fronte

velocemente ad ogni situazione.

L’introduzione di sistemi di Alerting

tempestivi, basati su tecnologie di BI,

impostati su indici e misure significative

di performance di tipo financial (es.

margini operativi, fatturato) o non

financial (es. produttività, customer

retention, online reputation) può

contribuire a ridurre fortemente la

capacità di rilevare i “fuori norma”, le

eccezioni, le situazioni anomale o trend

che possono causare conseguenze

negative se non gestite, se non sono

attivate contromisure in tempi brevi. La

determinazione dei “range” entro cui

indici e misure possono essere

considerate in norma da sistemi

informatici non è facile, soprattutto in

tempi turbolenti e dinamici, ma la

continua rilevazione di queste misure e

indici può aiutare a migliorare

significativamente

(“continuous

organizational learning”) la propria

capacità di stabilire i range numerici da

considerare regolari, i limiti di

attenzione o gli intervalli di criticità.

Il Gruppo Zegna ha la capacità di

rilocalizzare in poche ore gli uffici di

sedi territoriali esposte a rischi di

SAP Italia

riallocando e spostando in tempo quasi

reale le consegne tra i paesi che hanno

avuto una domanda di prodotti

inferiore alle previsioni verso quelli che

hanno avuto una domanda superiore,

nonostante le grandi distanze, grazie

alla velocità e all’efficacia delle

operations, alla velocità di trasmissione

e condivisione delle informazioni e al

supporto delle tecnologie IT.

Anche l’esperienza di Sky sottolinea

come dotarsi di sistemi agili, scalabili e

ridondanti sia una necessità per essere

velocemente reattivi ad aumenti e

cambiamenti rapidi della domanda, ma

anche come, spesso, il grado di

controllo influisca sulla velocità di

reazione: infatti l’azienda è in grado di

gestire con efficacia e velocità le attività

gestite internamente mentre riscontra

maggiori difficoltà quando deve

intervenire su attività date in

outsourcing, a causa della complessità

dei procedimenti di escalation con il

fornitore. La ridondanza delle risorse

ricercata con l’esternalizzazione di

attività e processi, spesso si scontra con

la rigidità contrattuale e i modelli di

economicità dei fornitori.

catastrofi naturali, grazie a sistemi e

basi dati centralizzati e a reti di

comunicazione adeguate; altresì è in

grado di rispondere a cambiamenti

inattesi della domanda tra diversi paesi,

© 2012 Divisione Ricerche “Claudio Demattè”

19

in

possibilità, grazie all’IT, di poter

istantaneamente

rilevare

un

cambiamento aziendale o di contesto

competitivo e poterlo affrontare e

gestire senza ritardi nel modo più

efficace possibile. Sicuramente molto è

stato fatto verso questa direzione ma

molto deve essere ancora fatto. Come

introdotto nel paragrafo 2 la velocità è

un fattore determinante dell’agire

aziendale e l’IT ricopre un ruolo sempre

Information Technology hanno un

impatto determinante sulle prestazioni

delle aziende e sulla loro capacità di

essere profittevoli. L’IT, infatti, come è

noto, permette alle aziende di

semplificare e velocizzare i propri

processi operativi core e non ma

consente, soprattutto, alle aziende di

migliorare costantemente i propri

processi di analisi, comprensione dei

più

determinante

nel

suo

raggiungimento. Questo però comporta

l’implementazione di soluzioni sempre

più flessibili, che lascino liberi gli utenti

di svolgere le proprie attività di analisi

seguendo i propri percorsi logici,

cognitivi e associativi che non sempre

possono

essere

preventivamente

definiti e strutturati. Allo stesso tempo

queste soluzioni devono consentire

fenomeni aziendali più rilevanti, di

previsione, valutazione e presa della

decisione. Oggi si inizia a intravedere la

l’accesso all’intero patrimonio dei dati

aziendali senza alcuna necessità di

elaborazioni preparatorie (Estrazione,

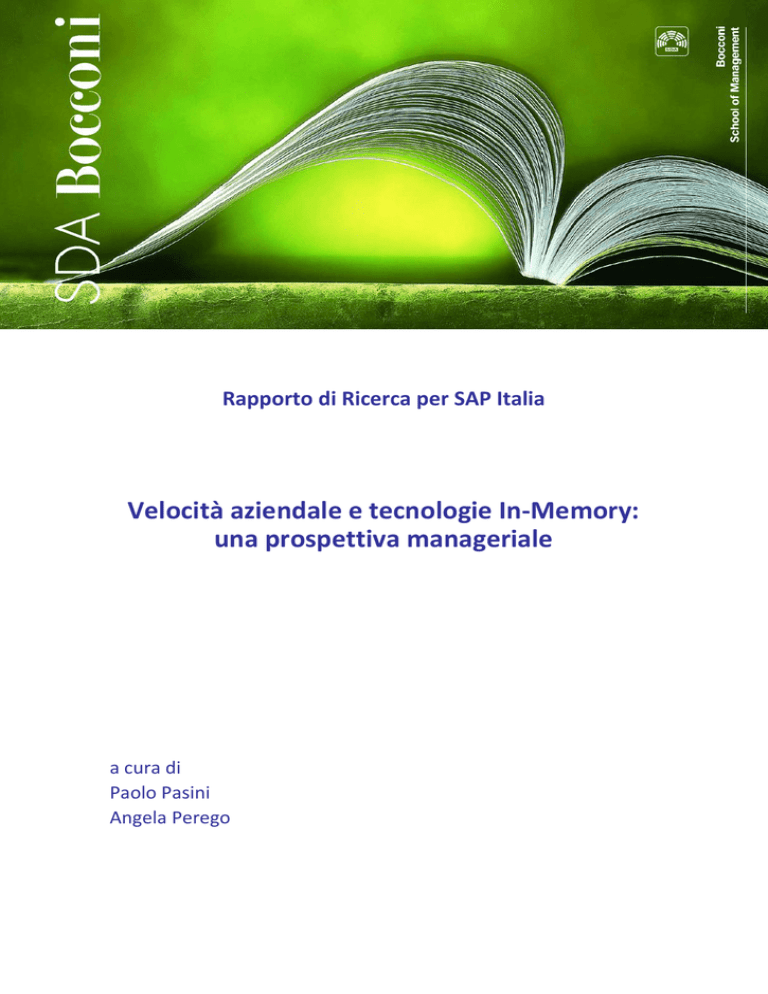

3 Le tecnologie In-Memory:

elementi distintivi e di

innovazione

Da

sempre,

le

innovazioni

Processori

Multi-core

Riduzione dei

costi della

memoria

Elaborazione

parallela

Database a

colonne

20

Tecnologie

InMemory

Memorie a

64 bit

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

Trasformazione e Caricamento) che

migliorano le prestazioni tecniche di

questi sistemi ma limitano gli ambiti di

azione e le possibilità di navigazione

degli utenti.

Gli sviluppi in campo tecnologico,

soprattutto

hardware,

stanno

mettendo le fondamenta perché lo

scenario prima descritto si concretizzi

in tempi brevi. Le tecnologie InMemory rappresentano sicuramente

un passo determinante in questa

direzione e il superamento di alcuni

limiti

imposti

dalle

tecnologie

precedenti, come ad esempio la netta

separazione tra ambiente transazionale

e di Business Intelligence che, sul fronte

tecnico, è dovuta solo ad esigenze

prestazionali.

Le tecnologie In-Memory, infatti,

coniugano le ultime innovazioni, come

© 2012 Divisione Ricerche “Claudio Demattè”

SAP Italia

la possibilità di utilizzare architetture

hardware

multiprocessore

e

la

possibilità di caricare grandi moli di dati

in memoria centrale, per abilitare un

circolo virtuoso e interattivo tra l’analisi

dei dati in tempo reale, le attività

previsionali dei fenomeni aziendali e di

analisi degli scenari, e la presa di

decisione tempestiva, senza ritardi

dovuti principalmente

alla non

immediata

accessibilità

ai

dati

necessari.

In particolare, le tecnologie InMemory

combinano

innovazioni

hardware (blade servers, architetture

multiprocessore e capacità di memoria

di terabytes) e software (In-Memory

database).

Le prime negli ultimi anni hanno

reso possibile ridurre se non superare

completamente alcuni limiti dei sistemi

21

SAP Italia

SDA Bocconi School of Management

Con la velocità di SAP HANA (SAP High-Performance Analytics Appliance) possibilità

prima impensabili.

SAP ha sviluppato soluzioni In-Memory che soddisfano specificatamente l'esigenza di

analizzare elevati volumi di dati riducendo al contempo i costi IT grazie all’introduzione

di SAP HANA (SAP High-Performance Analytic Appliance ), un'appliance In-Memory

flessibile, multifunzionale e compatibile con qualsiasi fonte di dati, che abbina

componenti software SAP ottimizzati per l'hardware fornito e distribuito dai principali

hardware vendor.

SAP HANA consente alle aziende di analizzare informazioni di business basate su elevati

volumi di dati di dettaglio man mano che questi si sviluppano. Le organizzazioni

possono esplorare ed analizzare immediatamente tutti i loro dati transazionali e

analitici da praticamente qualsiasi fonte di dati in tempo reale. I dati operativi vengono

acquisiti nella memoria mentre si verifica una determinata transazione e, grazie a viste

flessibili, le informazioni analitiche sono accessibili ad una velocità prima impensabile.

Dati esterni strutturati e non strutturati possono essere aggiunti ai modelli analitici per

estendere la capacità di analisi all'interno e all'esterno dell'organizzazione.

Ciò si traduce in:

informazioni reali e una migliore e più rapida capacità decisionale,

una collaborazione immediata tra le diverse strutture aziendali,

nuove applicazioni innovative che abbinano transazioni basate su un elevato

volume di informazioni, a funzionalità analitiche,

miglioramento dei processi esistenti o creazione di nuovi processi in qualsiasi

ambito, dalla pianificazione, alla previsione, all'ottimizzazione dei prezzi,

accelerazione delle performance aziendali,

riduzione del TCO grazie a un minor impiego di hardware, manutenzione e controlli.

© 2012 SAP AG. Tutti i diritti riservati

di accesso ai dati come i tempi di

accesso alle unità di memoria che

contengono i dati (CPU register, DRAM,

NAND Flash, etc.), la velocità di

elaborazione e la capacità delle unità di

storage utilizzate. Le seconde, invece,

mirano a una diversa organizzazione e

L’elemento più innovativo e

disruptive rispetto alle tecnologie

tradizionali è che l’elaborazione dei dati

avviene direttamente a livello del

database e non nel livello applicativo.

Solo i risultati delle query sono trasferiti

per essere visualizzati dagli utenti. Il

gestione dei dati all’interno del

database c.d. In-Memory (IMDB) che

risiede direttamente in memoria

centrale.

cuore delle

quindi il

Computing.

integrato di

consente di

22

tecnologie In-Memory è

motore di In-Memory

Esso è uno strumento

calcolo e di database che

elaborare grandi quantità

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

di dati in tempo reale nella memoria

centrale, per fornire istantaneamente i

risultati di analisi ed elaborazioni. Al

pari di un comune database, il motore

di In-Memory Computing supporta gli

standard di settore, come SQL e MDX,

ma include anche un motore per il

calcolo ad alte prestazioni che integra il

supporto del linguaggio procedurale

direttamente nel kernel del database.

Tale approccio elimina l’esigenza di

leggere i dati dal database, elaborarli e

quindi riscriverli nuovamente nel

database.

Il motore di In-Memory Computing

propone quindi significative innovazioni

SAP Italia

tecniche come l’utilizzo del nucleo della

CPU e la massiccia elaborazione

parallela. In particolare la velocità, la

scalabilità e la capacità di compressione

dei dati sono i suoi veri punti di forza

tecnici.

La Velocità di elaborazione è

conseguenza

della

capacità

di

memorizzare i dati per colonne al fine

di raggiungere elevate performance

nelle

operazioni

di

analisi,

classificazione e aggregazione alla base

delle BI Analytics e dei BI Tool. Infatti,

esso può esaminare 2 milioni di record

al milionesimo di secondo per core e

oltre 10 milioni di aggregazioni

Le tecnologie In-Memory nella loro applicazione in azienda possono seguire approcci differenti:

Modello Associativo. Esso carica e memorizza tutti i dati in un modello dati “associativo”utilizzato a livello di memoria centrale. Le associazioni sono basate sulle relazioni esistenti tra diversi dati. Questo permette agli utenti di interrogare tutti i dati considerati rilevanti senza gerarchie di dati o percorsi di analisi predefiniti. In questo modo l’utente non è

limitato a navigare e interrogare i dati secondo uno schema preordinato.

In-Memory OLAP. Esso opera primariamente caricando i dati in memoria centrale e permettendo l’elaborazione di query complesse on demand e di incroci multipli di dimensioni

di analisi dei dati con tempi di risposta ridotti.

Excel In-Memory Add-In. Esso permette agli utenti di caricare grandi moli di dati in Excel.

Una volta che i dati sono in Excel, le relazioni tra i dati sono automaticamente definite tra i

diversi dataset. Questo permette agli utenti di svolgere numerose attività (on the fly sorting, filtering, slicing and dicing, etc.) superando molti dei limiti tecnici di Excel. Questo approccio è disegnato per incrementare l’autonomia degli utenti e le forme self service di accesso ed elaborazione dei dati.

In-Memory Accelerator. Esso è studiato per incrementare le performance di analisi

all’interno di un esistente ambiente di Business Intelligence. Dopo aver caricato i dati

all’interno della memoria centrale, fa leva su un sistema di indici precostruiti per velocizzare i tempi di risposta del sistema. Questo approccio non vincola la navigazione e le analisi

dei dati a strutture particolari o gerarchie.

In-Memory VIsual Analytics. Esso combina un In-Memory Database con i tool di “visual data exploration” che permettono agli utenti di accedere velocemente ai dati, interrogarli e

raccogliere i risultati in report, sfruttando un ambiente grafico e interattivo.

© 2012 Divisione Ricerche “Claudio Demattè”

23

SAP Italia

SDA Bocconi School of Management

complesse calcolate dinamicamente al

secondo per core. Sono queste le

performance che possono trasformare i

processi aziendali operativi e di

produzione delle informazioni, di cui si

è parlato nei paragrafi precedenti: ad

esempio, un’azienda del settore dei

beni

di

largo

consumo,

ha

implementato uno scenario reale su

SAP HANA® che dimostra la capacità di

eseguire liberamente query complesse

La Scalabilità, invece, è garantita

dall’uso di un’architettura multi-core e

dal ricorso a parallelizzazioni e

partizioni dinamiche, per carichi di

lavoro sia OLAP (OnLine Analytical

Processing)

sia

OLTP

(OnLine

Transaction Processing), attraverso

sofisticati algoritmi che lavorano in

memoria cache. Di conseguenza le

performance scalano in modo lineare

non solo sui server blade, ma anche sul

su oltre 450 miliardi di record in pochi

secondi. Anche le performance di

aggiornamento,

inserimento

e

caricamento

dati

mostrano

un

significativo miglioramento rispetto ai

sistemi tradizionali, dal momento che

nessun dato aggregato o indicizzato è

mantenuto e tutte le operazioni a

runtime sono eseguite In-Memory, a

eccezione dell’attività di logging.

numero di core per blade.

24

La Compressione, infine, è possibile

grazie all’utilizzo di avanzati algoritmi di

compressione e strutture dati che

minimizzano

l’occupazione

della

memoria

richiesta dal

sistema,

mantenendo un completo supporto alla

fase di OLTP workload.

© 2012 Divisione Ricerche “Claudio Demattè”

Velocità dell’innovazione.

4 Gli ambiti di applicazione

delle

tecnologie

InMemory per la Velocità

aziendale: alcuni casi

internazionali

Le esperienze in questo ambito sono

per ora più rare, ma non per questo

meno interessanti. Due le categorie di

innovazione emergenti:

1. casi di Co-innovation con partner di

SAP, di diversa tipologia:

a. Deloitte

Consulting.

Sperimentazione, sviluppo e

pacchettizzazione di un nuovo

software dedicato al Dynamic

Cash Management, all’interno

delle soluzioni di Financial

Planning

di

prossima

generazione.

b. Cisco. Sviluppo di un nuovo

prodotto che integri SAP HANA

sui Cisco Unified Computing

Systems.

c. Intel. Sviluppo di una nuova

Le tecnologie In-Memory sono

enabler determinanti per incrementare

la velocità in azienda. Ciò emerge

chiaramente

dall’analisi

delle

esperienze

esistenti

di

implementazione di SAP HANA e dalla

conseguente mappatura dei casi

aziendali all’interno del modello della

Velocità aziendale nel paragrafo 2.

Innovazione

Velocità

Processi

aziendali

Reazione a

eventi

inattesi

© 2012 Divisione Ricerche “Claudio Demattè”

• Co-Innovation

• Innovazione dei prodotti e

servizi

• Processi operativi

transazionali

• Processi di controllo,

monitoring, forecast,

performance

management

• Alerting, predictive,

simulation, scenario

analysis

25

SAP Italia

SDA Bocconi School of Management

CoInnovation

• Deloitte (Consulting)

• Cisco (ICT)

• Intel(ICT)

Innovazione

Innovazione

dei prodotti

e servizi

versione

di

SAP

HANA

tipo operativo che analizzano dati

compatibile con i processori

Intel multi-core.

elementari e restituiscono risultati

in tempi molto veloci idonei a

svolgere e modificare processi di

produzione, di sperimentazione, di

intervento sul campo, di customer

service, etc.:

a. Medidata, azienda operante nei

servizi informativi di tipo clinico.

2. casi di innovazione dei prodotti o

dei servizi core business dei clienti

di SAP:

a. Charitè, azienda US operante

nell’Healthcare. La velocità di

analisi dei dati clinici ottenuta

operativi,

L’utilizzo di SAP HANA e di

RealTime

Analytics

ha

velocizzato in modo radicale i

processi dei test clinici con i

clienti, i medici e i centri di

ricerca migliorando il livello dei

servizi di patient care.

b. Nomura, istituto di ricerche. La

velocità ottenuta nell’analisi dei

dati del traffico di Tokio ha

transazionali, in termini sia di

velocità di esecuzione, sia di

velocità di cambiamento, abilitata

soprattutto da applicazioni di

Business Intelligence RealTime di

consentito di incrementare la

capacità di azione e di invio dei

messaggi pubblici per migliorare

la fluidità e la sicurezza della

circolazione stradale cittadina.

con SAP HANA ha consentito di

creare nuovi trattamenti sanitari

e nuovi servizi di patient care

più efficaci.

Velocità dei processi aziendali.

Le esperienze sono numerose e molto

varie. Le categorie individuate sono le

seguenti:

1. velocità

26

• Charitè (Healthcare)

dei

Processi

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

c. Bosch&Siemens,

gruppo

operante nel settore delle

tecnologie avanzate. SAP HANA

è stata impiegata in modo

estensivo per velocizzare le

simulazioni di redditività in più

aree aziendali, dal finance alle

vendite ai servizi interni, al fine

di prendere decisioni di

miglioramento dei processi

operativi interessati.

telecomunicazione. SAP HANA

ha consentito di gestire milioni

di interazioni e di messaggi

giornalieri ai clienti per renderli

sempre più personalizzati alle

loro

esigenze, sia come

contenuti promozionali, sia

come informazioni sui loro

profili di utilizzo.

f. NongFu Spring, azienda di beni

di largo consumo, CPG. SAP

d. Groupe Casino, azienda di retail.

SAP HANA ha velocizzato il

processo di gestione degli ordini

online dei clienti e reso possibile

un livello di servizio adeguato ai

clienti che possono ritirare i

propri prodotti ordinati entro

due ore presso un outlet

dedicato.

e. T-Mobile,

azienda

di

HANA ha sincronizzato in tempo

reale le velocità di esecuzione

dei processi operativi di

promozione e dei processi di

analisi di marketing.

g. Medtronic,

azienda

di

apparecchiature mediche. SAP

HANA ha permesso di analizzare

grandi quantità di dati non

strutturati provenienti dalla

Processi

Operativi e

transazionali

Processi

aziendali

Processi di

controllo,

monitoring,

forecast,

performance

management

© 2012 Divisione Ricerche “Claudio Demattè”

• Medidata (healthcare)

• Nomura research institute

(servizi)

• Centrica (utility)

• Surgutneftegas (energy)

• Bosch&Siemens (high-tech)

• Groupe Casino (retail)

• T-Mobile (Telco)

• Federal Mogul (automotive)

• NongFu Spring (CPG)

• Medtronic (Healthcare)

• Cisco (ICT)

• Adobe (ICT)

• BASF (chimica)

• P&G (CPG)

• Infosys (ICT)

• AOK (insurance)

• Colgate-Palmolive (CPG)

• Provimi (CPG)

• Lenovo (ICT)

27

SAP Italia

SDA Bocconi School of Management

gestione globale dei reclami e di

fornire in tempi brevi reporting

mirati di vendita ai venditori

affinché potessero spendere più

tempo

in

visita

dai

clienti/medici.

h. Cisco, azienda ICT. SAP HANA è

stata applicata nell’elaborazione

di oltre 700 milioni di record

gestiti da sistemi non SAP,

finalizzata a produrre in tempo

i.

j.

reale reporting operative selfservice per la forza vendita.

Federal

Mogul,

azienda

dell’automotive. SAP HANA

applicata ai processi di logistica

ha

generato

rilevanti

miglioramenti della gestione

degli magazzini.

Centrica,

azienda

utility.

L’analisi veloce delle grandi

quantità di dati provenienti

dagli strumenti di smart

metering ha permesso di

produrre

più

efficienti

programmi

di

risparmio

energetico personalizzato per i

clienti.

k. Adobe, azienda ICT. SAP HANA

ha consentito di analizzare i

milioni di dati strutturati di

vendita e i milioni di dati non

strutturati

del

supporto

prodotto per analizzare la

pirateria del software Adobe,

per monitorare il fenomeno e

28

l.

lanciare azioni preventive e di

recupero di ricavi persi.

Surgutneftegas,

azienda

energetica. SAP HANA a

supporto di applicazioni di

RealTime analysis dei dati

generati dai processi core

business

di

inventory

management e di material

movement.

2. Processi di controllo direzionale,

forecast,

Performance

management, processi di analisi di

dati più tipicamente rientranti

nell’ambito della BI tradizionale:

a. BASF, azienda chimica. SAP

HANA integrate con il modulo

CO-PA

ha

velocizzato

notevolmente le analisi di

redditività di prodotto e di

cliente.

b. P&G, azienda di beni di largo

consumo, CPG. SAP HANA è

stata applicata alla produzione

in tempo reale del Conto

economico gestionale per BU.

c. Infosys, azienda ICT. SAP HANA

è stata impiegata per ottenere

in tempi molto più veloci le

simulazioni dei margini a livello

aziendale, di centro di profitto e

di progetto cliente.

d. AOK, azienda assicurativa. SAP

HANA ha permesso di analizzare

con velocità coerente milioni di

casi di ospedalizzazione al fine

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

sia di migliorare la patient care,

sia di mantenere la redditività

attuale dei servizi di assistenza

sanitaria erogati.

e. Colgate-Palmolive, azienda di

beni di largo consumo, CPG. SAP

HANA è stata impiegata nel

velocizzare e rendere accettabili

come tempi di risposta le analisi

di profittabilità dei brand e dei

clienti

della

grande

distribuzione.

f. Provimi, azienda di beni del

largo consumo, CPG. SAP HANA

for business insights.

g. Lenovo, azienda ICT. SAP HANA

è stata applicata alle analisi dei

contratti dei clienti al fine di

rilevare comportamenti e “best

e worst” practice da segnalare.

Velocità di reazione a eventi inattesi.

I casi di impiego di SAP HANA in

questo ambito sono minori e spesso

embedded

in

casi

precedenti,

soprattutto nell’impiego di SAP HANA a

supporto della BI RealTime e operativa,

in applicazioni di Alerting (per ridurre il

Reazione a

eventi

inattesi

© 2012 Divisione Ricerche “Claudio Demattè”

tempo di reazione con segnalazioni

immediate, in tempo reale dell’evento

inatteso) o di predictive analysis e di

simulazioni di scenari (per anticipare e

prevedere eventuali eventi inattesi):

a. Booan, azienda di beni di largo

consumo. SAP HANA elabora grandi

quantità di dati di vendita, di

acquisto e di logistica e produce

dashboard in tempo reale per i

decisori aziendali coinvolti da questi

processi.

b. Dabor, azienda di beni di largo

consumo. SAP HANA elabora grandi

quantità di dati di vendita, di

acquisto e di logistica e produce

dashboard in tempo reale per i

decisori aziendali coinvolti da questi

processi.

c. Nomura research institute. L’analisi

in tempo reale dei dati di traffico

nella città di Tokio può consentire di

gestire in tempo reale eventuali

imprevisti

eccezionali

sulla

circolazione stradale.

d. Taiko Palm-Oleo, azienda chimica.

SAP HANA è stata impiegata per

realizzare un sistema di Alerting che

Alerting,

predictive,

simulation,

scenario

analysis

• Booan (CPG)

• Dabor (CPG)

• Nomura research institute

• Taiko Palm-Oleo (chimica)

• Hilti (engineering and

construction equipments)

29

SAP Italia

monitora una serie di indicatori di

redditività e induce azioni di

intervento in caso di fuori range.

e. Hilti, azienda di engineering e

construction equipment. SAP HANA

30

SDA Bocconi School of Management

ha velocizzato le analisi dei dati di

vendita e di cliente per poter

generare reazioni più veloci nel

lavoro sul campo con I clienti.

© 2012 Divisione Ricerche “Claudio Demattè”

L’obiettivo di questo paragrafo è

quello di delineare i possibili benefici

supporto della velocità aziendale, quale

fattore rilevante di competizione nel

contesto economico del nuovo

millennio, e scomponibile nelle sue tre

determinanti

della

velocità

dell’innovazione (di prodotto/servizio),

velocità di esecuzione dei processi

aziendali e velocità di reazione ad

eventi inattesi. Queste tre tipologie di

velocità aziendale sono per definizione i

primi benefici in termini di valore

dell’In-Memory in una prospettiva

trasversale e più completa, sia come

aziendale dell’In-Memory, descritti nel

paragrafo 2 e 4.

5 I benefici e il valore

aziendale dell’In-Memory

benefici

di

performance

del

management aziendale, sia come

benefici più di tipo IT. Le tecnologie InMemory, per quanto detto nel

paragrafo precedente, possono offrire

molteplici opportunità alle aziende

migliorando e modificando il loro modo

di svolgere i processi aziendali e le

decisioni che quotidianamente sono

chiamate a prendere per fronteggiare

la complessità e variabilità del contesto

competitivo in cui operano. Queste

tecnologie offrono dei vantaggi anche

da un punto di vista meramente tecnico

IT. Nel prosieguo verranno richiamati

tutti gli aspetti di particolare rilevanza

per le aziende che rappresentano

effettivamente

un

punto

di

discontinuità con il passato.

5.1

La velocità aziendale

Nel paragrafo precedente sono stati

inquadrati i possibili contributi di SAP

HANA, come tecnologia In-Memory, a

© 2012 Divisione Ricerche “Claudio Demattè”

5.2

L’informazione di ogni tipo,

in ogni luogo, in ogni tempo

Le possibilità offerte dalla ricerca

nel web hanno mostrato cosa significa

ricercare e analizzare grandi volumi di

dati in tempo reale e soprattutto hanno

evidenziato i vantaggi da essa derivanti

per le aziende. Naturale diventa quindi

ricercare e richiedere alle applicazioni

aziendali e ai database aziendali

funzionalità simili. Sfortunatamente ciò

è stato possibile solo in pochi casi,

nonostante il fatto che alcuni problemi,

come la consistenza e l’attendibilità dei

dati, sia molto più gestibile nei

database aziendali che non nel web

dove la qualità e l’affidabilità dei dati è

spesso molto discutibile. Ad esempio la

ricerca di informazioni da parte di un

operatore di call center dei prodotti

aziendali che rispondono meglio a una

richiesta pervenuta, raramente avviene

in tempi coerenti col fatto di avere un

31

SAP Italia

SDA Bocconi School of Management

cliente o un potenziale cliente al

telefono o in chat: nella migliore delle

ipotesi la ricerca è possibile all’interno

di un DB oppure all’interno di un DB

virtuale federato progettato ad hoc, ma

con tempi di risposta spesso non

accettabili per poter dare una risposta

in tempo reale. Oppure in un processo

decisionale manageriale la ricerca di

informazioni

sugli

ordini

di

riassortimento, sulla disponibilità a

motore di ricerca utilizzato e la

presentazione

dei

risultati

è

fondamentalmente un puro elenco di

contenuti di diversi formati ordinati a

seconda della rilevanza rispetto alla

ricerca fatta, senza alcun tipo di

rielaborazione e senza alcuna garanzia

di completezza. Alle applicazioni

aziendali, invece, non si richiede

soltanto la ricerca di dati rilevanti ed

esaustivi del fenomeno indagato ma

magazzino dei prodotti, sui lotti di

produzione in corso da parte dei

terzisti, per decidere quale punto

vendita servire per primo e con quale

livello di servizio, raramente ottiene

risposte in un tempo ragionevole (Near

RealTime) che consenta di simulare le

diverse opzioni possibili e quindi di

ottimizzarne

la

scelta.

Il

comportamento

dei

manager

anche la loro elaborazione e

aggregazione mediante algoritmi più o

meno complessi. Questo è, per

esempio, quello che fanno molte

applicazioni di pianificazione, di

previsione, di analisi di scenari, che

devono trattare i dati prima di poterli

essere

presentati

all’utente,

soprattutto se provenienti da fonti

diverse e tra loro eterogenee.

cambierebbe

certamente

se

l’informazione aziendale fosse “real

time Information” come nel web.

L’In-Memory sembra essere un

tassello fondamentale nel ravvicinare la

realtà della produzione di informazioni

in azienda alla metafora della ricerca su

Web.

Se la velocità è sicuramente un

elemento vincente della ricerca di

informazioni su web, non altrettanto

può essere detto in merito alla

completezza dei risultati ottenuti, che

rappresenta invece una caratteristica

irrinunciabile dei dati provenienti dalle

applicazioni aziendali e dalle fonti di

dati interne. La ricerca sul web, infatti,

si basa principalmente sul matching

“testuale e semantico” tra il dato

ricercato e i set di dati indicizzati dal

32

5.3

Il

superamento

della

distinzione

tra

sistemi

informativi transazionali e

sistemi di BI

La difficoltà di operare secondo i

tempi del web è determinata da

molteplici fattori; a esempio i sistemi

transazionali sono separati dai sistemi

di BI al fine di poter garantire sia la

capacità di analizzare i dati aziendali,

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

SAP Italia

sia adeguati tempi di risposta da parte

di sistemi specializzati a svolgere

attività diverse (eseguire azioni,

produrre informazioni). Inoltre solo una

parte dei dati aziendali è caricata nei

sistemi di BI, poiché generalmente si

procede a una aggregazione dei dati

transazionali che riduce la granularità e

quindi il loro potenziale informativo.

Questa operazione è molto critica

perché limita quindi le possibilità di

già presenti nel sistema, e le

caratteristiche delle Analytics, che

come loro dovrebbero elaborare grandi

volumi di dati per analizzare la

situazione aziendale corrente, scoprire

eventi o andamenti non previsti e

scegliere le opportune azioni. Queste

applicazioni potrebbero, per esempio,

fornire un valore aggiunto sensibile

all’azione aziendale se potessero

abilitare gli utenti alla conduzione di

analisi successive e la produzione di

report personalizzati. Il dover caricare i

dati dai sistemi transazionali ai sistemi

di BI seguendo i necessari step di data

cleaning ed elaborazione influenza

inoltre la durata dell’intervallo di

tempo che intercorre da quando i dati

sono immessi nel sistema transazionale

a quando essi sono disponibili per le

attività di analisi. Tale intervallo può

analisi degli scenari in modalità quasi

RealTime e in funzione di fatti

quotidiani che cambiano i risultati

aziendali. Oggi con le In-Memory ciò è

possibile.

essere di alcune ore o perfino di giorni.

Questo ritardo e separazione ha un

impatto rilevante soprattutto sulle

performance di quelle applicazioni che

dovrebbero avere sia un utilizzo

operativo sia direzionale (es. Availableto-Promise, demand planning). Molte

sono infatti le applicazioni aziendali

che, per rispondere efficacemente alle

esigenze degli utenti, dovrebbero

coniugare le caratteristiche delle

Un’altra caratteristica della ricerca

su web è la possibilità di utilizzare un

approccio “trial and error” alla ricerca.

Infatti, si parte utilizzando delle key

words e poi, sulla base dei risultati

ottenuti, si procede a un loro

affinamento. Allo stesso modo le

attività di analisi di un fenomeno

aziendale potrebbero seguire questo

approccio, a condizione che non ci

applicazioni transazionali, che come

loro dovrebbero operare su dati

operativi aggiornati con l’inserimento

manuale di nuovi dati, con la modifica

di dati esistenti o con l’utilizzo di dati

Per

poter

utilizzare

questo

approccio, i tempi di risposta delle

applicazioni

devono

diventare

paragonabili ai tempi di reazione e

© 2012 Divisione Ricerche “Claudio Demattè”

5.4

Miglioramento della catena

performance

tecnicheperformance aziendali: le

analisi alla “velocità del

pensiero”

siano tempi di attesa troppo lunghi.

33

SAP Italia

SDA Bocconi School of Management

comprensione del cervello umano, in

altre parole devono essere comparabili

con la “velocità del pensiero”. Se ciò

non avviene, gli utenti percepiscono il

sistema lento e sono portati a

“ingannare” il tempo di attesa iniziando

altre attività che deviano la loro

attenzione distraendola dall’attività

principale. Questa defocalizzazione,

apparentemente innocua, ha invece

degli

effetti

considerevoli

sulla

disporre di tutte le risorse necessarie

nel momento in cui sono richieste, c.d.

“real time information”. Ciò significa

che gli utenti possono accedere

all’intero patrimonio dati aziendale

senza vincoli tecnici e senza la necessità

di

elaborazioni

o

trattamenti

preparatori sui dati. Qualsiasi tipo di

elaborazione è fatta quindi “on the fly”,

fornendo la massima flessibilità e

libertà di accesso, utilizzo e analisi dei

produttività degli utenti e sulla loro

capacità di raggiungere il risultato

desiderato in termini anche qualitativi.

La concentrazione, infatti, permette di

ottimizzare l’analisi utilizzando i risultati

raggiunti nel percorso di indagine

intrapreso e di raggiungere gradi di

approfondimento elevati in tempi

brevi. La possibilità di avere

applicazioni che operano alla “velocità

dati aziendali agli utenti, superando

definitivamente

la

divisione

concettuale e fisica tra dati per le

transazioni e per le informazioni

manageriali.

del pensiero” ha quindi l’obiettivo di

aiutare gli utenti a concentrarsi su una

sola attività e a non sprecare energie

passando da un’attività all’altra. Inoltre

la riduzione dei tempi di risposta e di

elaborazione sicuramente rende molto

più coerente queste applicazioni con

l’utilizzo dei device mobili sempre più

diffusi e utilizzati in ambito aziendale.

Il confronto fatto tra ricerca web e

dei dati aziendali. Fino a questo

momento i forti limiti alla velocità di

analisi erano dovuti principalmente ai

tempi di accesso alle unità di

memorizzazione e alla banda dei canali

di comunicazione tra di esse e le CPU

utilizzati per scambiarsi ed elaborare

grandi volumi di dati. Per limitare il loro

effetto

sulle

prestazioni

delle

applicazioni,

tradizionalmente

le

applicazioni

aziendali

oggi

sta

diventando sempre meno futuribile

grazie alle tecnologie In-Memory. Il loro

fondamento, infatti, come visto nel

capitolo precedente, è la possibilità di

aziende avviavano importanti attività di

ottimizzazione dei database e delle

procedure di accesso. Le tecnologie InMemory, invece, come già presentato

nel paragrafo 3, superano questi

34

Si è già detto che il più rilevante

beneficio

derivante

dall’implementazione delle tecnologie

In-Memory risiede nell’impressionante

incremento delle performance di analisi

© 2012 Divisione Ricerche “Claudio Demattè”

SDA Bocconi School of Management

problemi portando tutti i dati e il carico

di lavoro nella memoria centrale. In

questo modo è possibile abbattere

definitivamente il principale collo di

bottiglia delle tecnologie tradizionali: i

tempi di accesso all’hard-disk e i tempi

richiesti per lo svolgimento di attività di

Input/Output.

Dare agli utenti la possibilità di

interagire con dati In-Memory,

piuttosto che con dati residenti in un

tradizionale database o in un

Datawarehouse, rende le loro attività di

analisi significativamente più veloci ed

esplorative.

La

velocità

nel

comprendere un fenomeno aziendale e

nel prendere la conseguente decisione

migliore sono, come è noto,

prerequisiti irrinunciabili per poter

migliorare costantemente le proprie

performance aziendali.

5.5

Libertà di analisi