L’evoluzione della Fusione Fredda in LENR

Giuseppe Quartieri, Giuseppe Quartieri, Dipartimento di Fisica, Scuola Superiore di Studi

Universitari e Ricerca "Santa Rita", via Trasaghis 18/E, 00188 Roma, Italy; CACR

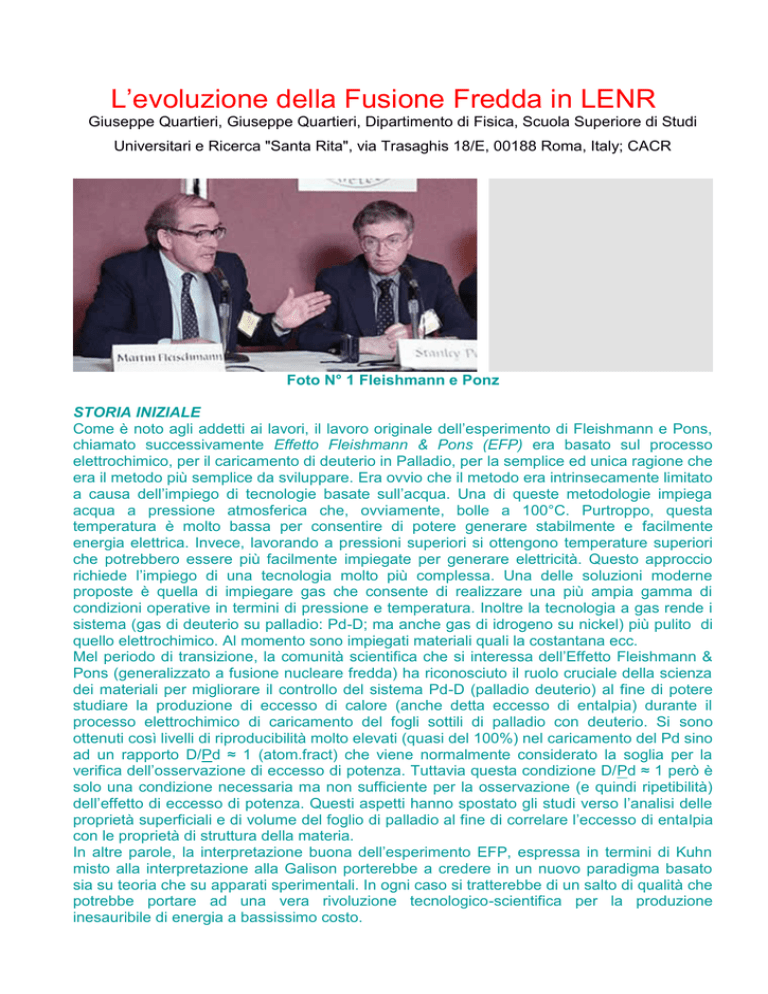

Foto N° 1 Fleishmann e Ponz

STORIA INIZIALE

Come è noto agli addetti ai lavori, il lavoro originale dell’esperimento di Fleishmann e Pons,

chiamato successivamente Effetto Fleishmann & Pons (EFP) era basato sul processo

elettrochimico, per il caricamento di deuterio in Palladio, per la semplice ed unica ragione che

era il metodo più semplice da sviluppare. Era ovvio che il metodo era intrinsecamente limitato

a causa dell’impiego di tecnologie basate sull’acqua. Una di queste metodologie impiega

acqua a pressione atmosferica che, ovviamente, bolle a 100°C. Purtroppo, questa

temperatura è molto bassa per consentire di potere generare stabilmente e facilmente

energia elettrica. Invece, lavorando a pressioni superiori si ottengono temperature superiori

che potrebbero essere più facilmente impiegate per generare elettricità. Questo approccio

richiede l’impiego di una tecnologia molto più complessa. Una delle soluzioni moderne

proposte è quella di impiegare gas che consente di realizzare una più ampia gamma di

condizioni operative in termini di pressione e temperatura. Inoltre la tecnologia a gas rende i

sistema (gas di deuterio su palladio: Pd-D; ma anche gas di idrogeno su nickel) più pulito di

quello elettrochimico. Al momento sono impiegati materiali quali la costantana ecc.

Mel periodo di transizione, la comunità scientifica che si interessa dell’Effetto Fleishmann &

Pons (generalizzato a fusione nucleare fredda) ha riconosciuto il ruolo cruciale della scienza

dei materiali per migliorare il controllo del sistema Pd-D (palladio deuterio) al fine di potere

studiare la produzione di eccesso di calore (anche detta eccesso di entalpia) durante il

processo elettrochimico di caricamento del fogli sottili di palladio con deuterio. Si sono

ottenuti così livelli di riproducibilità molto elevati (quasi del 100%) nel caricamento del Pd sino

ad un rapporto D/Pd ≈ 1 (atom.fract) che viene normalmente considerato la soglia per la

verifica dell’osservazione di eccesso di potenza. Tuttavia questa condizione D/Pd ≈ 1 però è

solo una condizione necessaria ma non sufficiente per la osservazione (e quindi ripetibilità)

dell’effetto di eccesso di potenza. Questi aspetti hanno spostato gli studi verso l’analisi delle

proprietà superficiali e di volume del foglio di palladio al fine di correlare l’eccesso di entalpia

con le proprietà di struttura della materia.

In altre parole, la interpretazione buona dell’esperimento EFP, espressa in termini di Kuhn

misto alla interpretazione alla Galison porterebbe a credere in un nuovo paradigma basato

sia su teoria che su apparati sperimentali. In ogni caso si tratterebbe di un salto di qualità che

potrebbe portare ad una vera rivoluzione tecnologico-scientifica per la produzione

inesauribile di energia a bassissimo costo.

L’IMPULSO GIAPPONESE

Da quanto detto si deduce che i fenomeni di fusione nucleare fredda in materia condensata o

stato solido avvengono in sistemi compositi con arrangiamento regolare di nuclei ospitanti (C,

Ti, Ni, Pd, ecc.) degli isotopi di idrogeno (H,D). Uno

dei filoni più interessanti di nano-strutture è stato

quello concepito dal Dr. Akito Takahashi come base

seme per la fusione di un “cluster” di deutoni in modo

da produrre calore con polvere di elio-4. Le strutture

impiegate

da

Takahashi

provengono

dalla

formazione di AD/TSC (tetrahedral symmetric

condensate) attorno al sito-T di un reticolo regolare

di PdD (palladio deuterato) sottoposto ad eccitazione

fotonica oppure su superfici topologicamente frattali

di nano strutture di PdDx e/o lungo le interfacce di un

composto nanometrico di metallo-ossido-metallo.

Il modo dinamico del condensato TSC è stato

studiato quantitativamente applicando la equazione

differenziale

stocastica

quanto-meccanica

di

Langevin ad un sistema costituito da un “cluster” a

molti corpi di deutoni e elettroni con simmetria

platonica. Proprio questa ultima proprietà è

contestata dai seguaci della Meccanica Adronica

Foto N° 2 Apparato di FNF

(di Ruggero Santilli) che considerano impossibile impiegare in reazioni di fusione nucleare il

modello a simmetria platonica e planetaria. Si tenga presente che sono state sviluppatte

quasi 150 teorie per dimostrare teoricamente il superamento della barriera di potenziale di

Coulomb.

Inoltre, il gruppo di Takahashi ha sviluppato una successiva variante interessante basata

sulla teoria dell’espansione dell’elettrone pesante e massivo, inteso come una quasi

particella in modo da potere trattare gli aspetti temporali del processo di fusione, stimando tra

l’altro le probabilità di penetrazione della barriera di Coulomb del “cluster” (grappolo) di 4d

(quattro deutoni).

Questo filone basato sull’impiego di nanotecnologie (nanoparticelle di palladio in atmosfera di

deuterio) è diventato, senz’altro, la via principale di ricerca in campo di FNF in materia

condensata o stato solido.

Nell’ambito di questa panoramica iniziale, molti gruppi di ricercatori hanno preferito dirigere le

loro ricerche in questa nuova direzione ottenendo risultati molto promettenti, con produzione

di eccesso di calore, elio e trasmutazioni.

Lungo queste direttive si è svolto il 14-simo Convegno Internazionale ICCF, “Exciting New

Science Potential Clean Energy”, allo “Hyatt Regency on Capitol Hill di Washington DC” dal

10 al 14 agosto 2008. Sostanzialmente si è fatto il punto sullo stato dell’arte della Fusione

Nucleare Fredda della materia condensata originata dal cosiddetto Effetto Fleishmann &

Pons (EFP).

Dopo le relazioni di apertura, gli argomenti trattati vanno dai risultati delle misure

calorimetriche negli esperimenti di Fusione Nucleare Fredda nella materia condensata, allo

studio dei materiali impiegati; quindi dal caricamento veloce d tipo di gas impiegati alle

onoranze a grandi ricercatori come Yoshiaki Arata e Stanislaus Szpak; dalle misure di

particelle alle opportunità e possibilità di replicazione e controllabilità dell’EFP; dalla

trasmutazioni e reazioni nucleari a bassa energia alle teorie avanzate sulla FNF; dagli

esperimenti con acceleratori che sfruttano l’effetto di schermaggio aumentato degli elettroni

nelle reazioni d-d sottoposte a ultravioletto sino alle misure ottiche e di materiali. Molto

interessante è stata la sessione dedicata alla storia dell’Effetto Fleishmann and Pons nei vari

Paesi del Mondo (Giappone, Inghilterra, Francia, Germania, Italia, India, Russia, Stati Uniti

ecc.).

Di fatto, tutta la storia dell’Effetto Fleishmann & Pons è costellata di problemi di natura

scientifica, tecnica, procedurale e quant’altro. Allo stato attuale, si osserva una serie

abbastanza consistente di fenomeni e problemi che rendono del tutto aperto gli studi sul EFP

nell’ambito del nuovo approccio LENR.

Tra questi problemi bisogna annoverare la imperfetta ripetibilità degli esperimenti EFP, la

mancanza di una teoria esaustiva e perfetta (rispetto al gran numero di molte decine di teorie

proposte), i risultati sperimentali alcune volte inadeguati, la limitazione delle comunicazioni

scientifiche solo entro un ambito ristretto dell’editoria scientifica a causa della inibizione di

canali scientifici preferenziali e consolidati, le difficoltà di ottenere il rilascio e riconoscimento

di brevetti ed altro. Bisogna rendersi conto che queste difficoltà nascono dalla natura

intrinseca dei fenomeni di FNF in materia condensata che sono di natura prettamente

interdisciplinare e intrinsecamente complessi. La cultura scientifica necessaria a

comprendere, controllare e gestire i fenomeni di FNF (LENR) che originano dall’EFP deve

essere molto varia poiché copre aspetti elettrochimici ed aspetti di fisica nucleare nella

materia condensata. Questi ultimi appaiono ormai completamente diversi dai fenomeni

analoghi che avvengono nel vuoto.

Tuttavia, contro tutte queste difficoltà le comunità scientifiche dei suddetti Paesi hanno

dedicato molti studi alla Fusione Nucleare Fredda raggiungendo mete e notevoli progressi,

negli ultimi venti anni. Così, la grande messe di esprimenti eseguiti in Russia, in Giappone, in

Italia, in Francia, in India, in Cina ed in altri Paesi piccoli si è dimostrata molto produttiva e

illuminante dei fenomeni che, galileianamente, avvengono nel mondo della materia

condensata del tipo matrici di palladio caricata con deutoni. In altre parole, i risultati

sperimentali raccolti in tutto il mondo consentono di comprendere molte caratteristiche

dell’Effetto Fleishmann & Pons (EFP). Come è costume in scienza questa conoscenza

empirica è la base della conoscenza tuttavia senza una teoria che spieghi e predica il

fenomeno la conoscenza è e rimane monca. Storicamente la teoria indirizza la

sperimentazione forzandola a verificare le leggi previste. In mancanza di una teoria capace di

predire il funzionamento, la sperimentazione consente di acquisire solo conoscenza

empirica, con tutta la sua galileiana verità.

Nell’ambito delle ultime conferenze ICCF, sono stati presentati molti lavori i cui risultati sono

stati convalidati con dati di alta qualità ossia con dati il cui rapporto segnale-rumore è molto

buono e tali da dimostrare, con alto livello di confidenza, che è possibile indurre reazioni

nucleari a temperatura ed energia ordinaria. La panoramica di reazioni nucleari indotte nella

materia condensata copre sia le reazioni nucleari e/o trasmutazioni di elementi pesanti che

reazioni di fusione di elementi leggeri del tipo deutoni ecc.

Sussistono forti evidenze [Iwamura (MHI) et alter] che le reazioni nucleari avvengono sulla

superficie dei materiali solidi. Nell’ultimo decennio la scuola giapponese facente capo al Prof.

Arata ha messo a punto matrici di dimensioni nanometriche introducendo così nel campo

della Fusione Nucleare Fredda la nanotecnologia da cui si spera di ottenere sconvolgenti

risultati. Purtroppo, gli strumenti di nanotecnologia sono abbastanza costosi e quindi non è

stato facile introdurli nella ricerca sull’Effetto Fleishmann & Pons (FNF) a causa dei

finanziamenti moto bassi erogati fino ad ora

I risultati e i dati dei vari esperimenti eseguiti sono ormai disponibili in varie forme che vanno

dai vari “proceedings” specifici, alle relazioni nella rete internet a diversi giornali scientifici.

Questa enorme disponibilità di dati ha convito e sta convincendo molti dubbiosi della validità

della ricerca nel campo della FNF.

ICCF: QUATTORDICESIMO CONGRESSO (Background)

In particolare, appare dall’analisi delle relazioni della suddetta quattordicesima conferenza

ICCF, dalle note, dalle presentazioni iniziali e dalla relazioni intermedie che è ormai chiaro ed

inequivocabile che il DoE, forse assieme con MoD, comunica al mondo che crede nell’Effetto

Fleishmann & Pons e quindi rilancia la ricerca applicata nel campo della Fusione Nucleare

Fredda. [Al momento è stato da poco concluso il diciannovesimo Congresso: estremamente

interessante e foriero di moltissimi eventi!]

Nessuno si perita di sconfessare e/o scomunicare il verdetto negativo emesso, nel 1990,

dalla commissione instaurata dal DoE guidata dal noto fisico nucleare classico Huigenza.

Questa commissione decretò che i fenomeni comunicati pubblicamente da Fleishmann &

Pons non avrebbero potuto accadere poiché erano contro la fisica nucleare allora

conosciuta. In sintesi rivolgendosi alla Commissione di Huigenza i nostri avi avrebbero solo

detto “… non ti curar di lor ma guarda e passa”!

In poche parole, la ricerca sulla Fusione Nucleare Fredda (FNF) o l’Effetto Fleishmann &

Pons è diventata un campo legittimo della scienza (Scienza Nucleare nella Materia

Condensata) e non solo una collezione di errori, come alcuni denigratori sono andati dicendo

per quasi due decenni.

Foto N° 3 ESPERIMENTO DI FUSIONE FREDDA (INFN)

Molti suggerimenti sono stati e continuano ad essere erogati da vari gruppi di ricercatori, che,

tra l’altro, hanno studiato a fondo tutte le critiche ed i risultati negativi pubblicati al punto da

sostenere chele analisi statistiche e Bayesiane mostrano che le osservazioni dell’Effetto

Fleishmann & Pons presentano criteri e dati di produzione di eccesso di calore che devono

essere considerati un effetto fisico reale “al di là di ogni dubbio razionale”. I quattro criteri

caldamente suggeriti per la esecuzione di esperimenti alla F & P che risultino “ripetibili” sono

della seguente specie:

Eseguire gli esprimenti con molta attenzione e cura nel caricare il Palladio molto

lentamente in modo da garantire condizioni tali da fornire rapporto di caricamento

D/Pd superiore a 0.85.

Porre molta attenzione e cura nel rispettare la chimica del sistema in modo da creare

condizioni superficiali favorevoli dei materiali impiegati.

Fare attenzione a caricare con densità di corrente al di sotto di 25 mA/cm 2, quindi

continuare l’esperimento con densità di corrente al di sopra di 250 mA/cm 2 per

aumentare il flusso di D (deutoni) al catodo.

Porre attenzione a stabilire condizioni di non equilibrio per innescare l’inserimento di

deutoni D in posizioni non statiche all’interno del catodo.

L’IMPORTANZA DELLA BUONA ELETTRONICA

In molte esperienze recenti di EFP sono state impiegate tutte le tecniche ben note di sviluppo

di sistemi elettronici quali il campionamento alla Nyquist, l’integrazione nel tempo, il controllo

ohmico termico, la ricostruzione delle onde termiche, e altre tecniche moderne ed avanzate

per ottenere lo spettro di potenza termica. Inoltre, ormai si impiegano tecniche più precise di

misurazione e controllo [ad esempio migliori calorimetri ecc.], di riconoscimento dei guasti e

dei modi di funzionamento, di misure calorimetriche veloci oltre che ridondate, e di misure di

flusso di calore tracciabili ed altro. In particolare, attualmente vengono normalmente eseguite

misure migliorate con cinque o più metodi calorimetrici indipendenti, ed altre tecniche di

misura e di rilevazione in modo che ciascuna potenza di ingesso viene normalizzata per

valutare e controllare l’eccesso di calore e la potenza termica erogata successivamente.

Per altri versi, i processi di miglioramento delle misure di eccesso di calore vengono

attualmente eseguiti con calorimetri moderni molto elaborati rispetto al primo calorimetro di

Antoine Lavoisier (1783); dal calorimetro a ghiaccio, al calorimetro a flusso di calore costate,

al calorimetro a flusso di massa, al calorimetro a misure iperboliche, dalla calorimetria che

impiega l’effetto Seebeck (per a misura di eccessi di entalpia anche per ampi campi di

temperatura),

Conviene e si ritiene giusto ricordare che il compito primario della ricerca nel campo dell’EFP

e quindi nella FNF in materia condensata è quello di migliorare la riproducibilità della

generazione di eccesso di calore e quindi di amplificare la potenza ottenibile ed il guadagno

di energia. Le tante convalide di importanza del rapporto di caricamento per il controllo del

sistema Pd-D al fine della riproducibilità conducono a ritenere estremamente importante il

ruolo cruciale delle scienze dei materiali da focalizzarsi sullo studio delle proprietà superficiali

e volumetriche di fogli di palladio.

Un esempio interessante è quello di impiego dei metodi di eccitazione dell’elettrolisi con

ultrasuoni ossia con brevi cicli di cavitazione indotti da ultrasuoni con bassa densità di

corrente di caricamento del Palladio si sono osservati i seguenti fenomeni interessanti dal

punto di vista della teoria dei guasti superficiali:

La pulizia chimico-meccanica della superficie produce il risultato di un miglioramento della

attivazione superficiale.

Le deformazioni meccaniche dello strato più superficiale della catodo di Palladio Pd

dovute all’impulso d’onda prodotto dal fascio di deutoni accelerati. Si ottiene

come risultato la distorsione dello stato superiore superficiale del reticolo cristallino di Pd.

La generazione di dislocazioni massive e di lacune volumetriche. Questi difetti prodotti

rappresentano delle vere e proprie trappole per i deutoni immersi nelle zone profonde

della matrice del catodo di Pd. Questo processo di intrappolamento favorisce la capacità

di carico del deuterio nel palladio.

Come risultato globale di questo metodo con ultrasuoni si ottiene un rapporto di caricamento

molto elevato che ha di conseguenza il miglioramento della riproducibilità della generazione

di eccesso di calore.

Continuando ad esaminare i nuovi processi proposti durante la suddetta conferenza, diviene

essenziale osservare l’importanza delle investigazioni di sistemi Pd-D costruiti a

nanoparticelle in zeoliti [Zeolita-Y (Na)] o altre strutture (idrati, polveri ecc.) in atmosfera di

deuterio.

In effetti, gli studi sperimentali e teorici hanno indicato che le nanoparticelle di palladio

possono rendere più facile l’evento dell’Effetto Fleishmann & Pons. Il metodo consiste

normalmente nel caricare un substrato complesso di palladio organico e quindi bruciare i

costituenti organici del composto in modo da lasciare solo palladio empiricamente puro

all’interno delle cavità del zeolita. La presenza di palladio nel zeolita viene confermata

usualmente con analisi che impiegano il microscopio elettronico e la spettroscopia a raggi X

della dispersione dell’energia. I risultati sperimentali preliminari mostrano che dopo avere

interrotto il flusso di gas di deuterio, la temperature della matrice di nanoparticelle di

palladio aumenta di parecchi gradi al di sopra della temperatura ambiente. L’effetto è stato

osservato due volte con gas di deuterio, mentre impiegando, come terzo caso sperimentale

impiegando un flusso di gas d’idrogeno al posto del deuterio non si ottiene alcun aumento di

temperatura. Questo tipo di zeolita presenta piccoli fori e pori con carica elettrostatica

abbastanza forte (0,3 V/A) che gli consente di operare come un reattore quasi-nano.

Sono state sviluppate varianti anche consistenti del complesso matrice a nanoparticelle. Uno

dei processi più interessanti è quello della deposizione elettrochimica di metalli da fase

cristallina liquida liotropica esagonale. Molti altri progetti di verifica dell’EFP sono in fase di

conduzione in tutto il mondo, ma la loro trattazione è molto lunga e non può essere affrontata

in questa sede. Tuttavia, prima di passare alle conseguenze in campo italiano è il caso di

accennare al problema della possibilità che la fisica nucleare classica, ossia le leggi fisiche

fondamentali possano spiegare l’Effetto Fleishmann e Pons e più in generale la fusione

nucleare fredda (FNF) e la LENR (Low Energy Nuclear Reactions) le Reazioni Nucleare a

Bassa Energia nella materia condensata. Dopo lunga ed attenta analisi rimangono ancora

evidenze della impossibilità delle leggi classiche di spiegare l’accoppiamento fra deutoni e la

mancanza di alcuni prodotti nucleari che dovrebbero, secondo le leggi classiche, svilupparsi

dalla reazione stessa.

Il concetto che elettroni (fermioni e pseudo particelle) sono capaci di schermare i deutoni

(Barriera di Coulomb) viene studiato in molte maniere poiché è il primo dei fenomeni che

secondo la fisica nucleare classica pone il veto al verificarsi della fusione nucleare a

temperatura ambiente. Esistono molte teorie che spiegano la possibilità di superamento della

barriera di Coulomb da parte di deutoni, ma la maggior parte richiedono ed impongono

alcune variazioni o generalizzazione di alcune leggi fondamentali (ad es. per la secondo la

spiegazione della Meccanica Adronica bisogna aggiornare l’equazione di Fermi per la

creazione del decadimento del neutrone e produzione del neutrino) per potere spiegare il

fenomeno.

Senza spingere l’analisi fino a fondo ed in maniera più dettagliata dai risultati della 14-sima

Conferenza ICCF gestita dagli americani si evince un forte messaggio di alto livello

scientifico e strategico: la FNF va considerata una branca della scienza con tutti i sacri

crismi. Negli ultimi 20 anni, in Europa sono stati negati finanziamenti alla ricerca sulla

Fusione Nucleare Fredda, preferendo a questa la classica e mai riuscita Fusione Nucleare

Calda che viene eseguita da quasi cinquant’anni con enormi sforzi economici senza condurre

ad alcun dato positivo. Peraltro, è stato finanziato da un congruo numero di Paesi europei

oltre agli stati Uniti e il Giappone il grande progetto ITER di fusione nucleare calda che deve

essere realizzato nella Francia meridionale a Caradache entro i prossimi 50 anni. Il sogno di

imbrigliare la energia termonucleare da fusione calda nasce con la invenzione da parte del

grande fisico israelita-magiaro-americano Teller agli inizio degli anni ’50 del secolo scorso.

Nell’ambito del mondo scientifico filo fusione nucleare calda, il progetto della FNF venne

definito la “pulce”.

In Italia, così, la visione corta e poco aperta degli addetti alla valutazione dei progetti

scientifici ed energetici hanno da decenni bocciato la “pulce” solo e soltanto a favore del

grande progetto ITER, che, ad onore del vero, dovrebbe portare lavoro a oltre 10 persone.

In questa panoramica di grandi sforzi e sacrifici nati solo dal grande amore per la scienza e la

conoscenza gli sparuti gruppi di ricercatori (sperimentali come Scaramuzzi, Celani, Violante,

Mastromatteo e teorici come Preparata, Larsen, Widom, Santilli e il sottoscritto e tanti altri)

dedicati alla FNF hanno proceduto con coraggio ed abnegazione.

In particolare, nel laboratorio N° 25 dei Laboratori Nazionali di Frascati (INFN), diretto da

Francesco Celani, sono eseguiti dal nostro gruppo esperimenti di FNF per dimostrare la

ripetibilità e controllabilità dei fenomeni di FNF. Così, dopo il primo grande impulso mondiale

alla ripetizione dell’esperimento di Fleischmann & Ponz, vari gruppi di ricerca hanno

concepito nuove esperimenti e varianti interessanti dell’Effetto Fleischmann & Pons. Tra i vari

filoni seguiti dai vari gruppi di ricerca distribuiti al mondo, è stato reputato interessante il

filone determinato dal Prof. Arata giapponese .seguito da Francesco Celani, che iniziò alcune

esprimenti di elettrochimica del palladio già nel 1955. Nell’ambito di questo flusso di ricerca

giapponese si collocano i vari tentativi di Iwamura (MHI) di superare l’approccio

elettrochimico alla FNF ricorrendo a tecnologie di “sputtering” della microelettronica

impiegate per generare diodi semiconduttori e in generale transistori e circuiti integrati

(microprocessori ecc.). Inoltre, il gruppo suddetto ha tentato una collaborazione con la scuola

di Arata, per la realizzazione di un progetto JI in comune italo-giapponese sulla FNF che non

è andato in porto e non è stato finanziato.

Per concludere questa semplice sintesi di stato dell’arte della FNF in materia condensata

centrata sulla ripetibilità e controllabilità dei fenomeno si notano i seguenti fatti:

1. La ricerca sulla FNF in materia condensata ha diritto, con tutti i sacri crismi scientifici,

di fare parte del flusso della scienza moderna convenzionale e classica, anzi qualcuno

parla di un nuovo paradigma alla Kuhn e Galison.

2. I metodi di ripetibilità dell’Effetto Fleishmann e Pons sono molteplici spaziando dalla

classica metodologia elettrolitica alla nuove tecniche a nanoparticelle, dalla fusione a

bolle a

3. Nell’ambito della messe di teorie si possono individuare alcuni filoni di ricerca basilari:

le teorie basate sulla Elettrodinamica Quantistica Coerente di cui è capostipite

Giuliano Preparata, le teorie basate sulla Meccanica Quantistica (applicazione del

principio di Heisemberg con il confinamento dell’energia, ipotesi di fusione quantistica

ecc.), secondo il Modello Standard (Larsen, Widom et alter) e teoria dei campi, le

teorie basate sulla Meccanica Adronica di cui è originatore primario Ruggero Santilli (e

seguite dal sottoscritto) e tanti altri filoni minori quali la teoria dei Meccanismi Dinamici

della moto in stato di condensazione TSC, teorie di Identificazione empirica dei sistemi

e controllo ottimale delle reazioni nucleari assistite dal reticolo cristallino, il modello

teorico della dinamica dell’idrogeno in esperimenti di scienza nucleare in materia

condensata (CMNS), teoria delle interazioni fra nuclei positivi inclusi in strutture solide

ecc.

4. Le proiezioni temporali di realizzazione di campioni di celle elettrolitiche per la fusione

nucleare fredda che possa avere un senso industriale concreto, non hanno coefficienti

di confidenza elevati e non si può prevedere alcun tempo di possibile realizzazione

pratica. Riferendosi alla fusione Nucleare Calda, che ottimisticamente prevede

realizzazioni nel giro di 50 anni, si potrebbe solo dedurre di potere realizzare

dispositivi a fusione nucleare fredda operativi a livello industriale solo in periodi

paragonabili a quelli della fusione calda.

5. Le prospettive concrete di potere risolvere il problema delle scorie radioattive con

trasmutazioni nucleari a bassa energia (LENR, LENT ecc.) sono attività di ricerca

abbastanza seguite in tutto il mondo.

L

QuiQuindi, bando alle grandi speranze di ottenere apparati di produzione di energia elettrica

mediante processi di reazioni nucleari di bassa energia, sino a quando gli sviluppi produttivi

non diventeranno molto vicini ai livelli di almeno 80% della curva di accrescimento della

maturità produttiva.

Da queste considerazioni si deduce che bisogna avere grande fiducia della Fusione Nucleare

Fredda in materia condensata, ormai parte integrante della scienza, ma a causa della forte

indeterminazione temporale, non si può pensare di ottenere da questa fonte pulita e a basso

costo una soluzione o un apporto energetico immediato. A ciò si aggiunga il fatto

incontestabile e incontrovertibile che la Meccanica Quantistica, anche nelle sue forme più

avanzate di Elettrodinamica Quantistica e Teoria dei Campi, e nonostante tutti gli sforzi di

Preparata ed altri fisici teorici, non ancora riesce a spiegare in modo univoco i fenomeni di

fusione nucleare fredda in materia condensata mentre, ad onore del vero, tali fenomeni sono

invece galileianamente del tutto appurati e dimostrati. Dimostrato quindi che l’Effetto

Fleishmann e Pons, che ha originato la FNF in Materia Condensata è parte integrante della

scienza comune, anche se con una nuovo paradigma (alla Kuhn e Galison), nell’osservare le

limitazioni temporali per la realizzazione industriale, diviene spontaneo porsi la domanda di

quando, come ed in quale proporzioni la FNF in MC potrà dare un contributo concreto alla

risoluzione dei problemi energetici che attanagliano l’Italia ed in mondo intero. Così si è

imposto il nuovo salto, forse solo linguistico del passaggio dalla Materia Condensata alle

Reazioni Nucleari di Bassa Energia.

I problemi irrisolti sono ancora moltissimi e, come appare anche dai risultati del 19-simo

Congresso ICCP, sussistono anche moltissimi problemi di organizzazione sia a livello italiano

che a livello Internazionale.

Forse il grande Gino Bartali avrebbe detto: “gli è tutto da rifare!”, ma non è proprio così; tanto

è stato fatto e molto deve essere ancora da fare. La teoria dei LENR comunque deve essere

affinata se no proprio rivista daccapo!

Alcuni problemi tecnici ancora in via di soluzione sono i seguenti ma non possono

assolutamente limitarsi ad essi.

1. Sono necessari ancora alcuni dati accurati di carico/scarico per l'evoluzione della

temperatura del processo di carico/scarico: molti laboratori al mondo stanno lavorando

per raccoglierli.

2. Devono essere eseguite ancora alcune analisi dei campioni di gas raccolti per

verificare l'esistenza di trizio o elio, in ogni tipo di esperimento eseguito.

3. Analisi dello spettro -Mass e l'analisi dello spettro di emissione ottica dovrebbero

essere in grado di identificare le specie di gas nei campioni.

4. Esistenza di entrambi i tipi nel campione indica un'origine nucleare non criticabile per il

riscaldamento anomalo.

5. Un esame ulteriore della termodinamica dell’assorbimento dell'idrogeno in palladio

(successivamente costantana) dovrebbe essere perseguito per quantificare appieno la

portata degli effetti osservati riscaldamento'

6. migliorare i controlli esperimento:

Controllo del riscaldatore “Purifier-Upgrade”

Migliorare Carico / scarico del processo di sincronizzazione

Fabbricare Campioni palladio in-“house”

Neutroni -Migliorare e rilevazione delle radiazioni gamma.

Questa piccola serie di problemi in via di risoluzione o forse anche già risolti serve solo a

dare una pallida idea delle difficoltà alal quali si va incontro. Non bisogna inoltre dimenticare

che questo nuovo campo delal ricerca LENR è diventato estremamente interessante pr

diverse forse e poteri di interesse per cui molto lavoro ormai è coperto da “segreto

industriale”. In particolare, alcune soluzioni moderne prevedono per la FNF una sorta di

innesco delal reazione nucleare di bassa energia. Fino ad ora questo processo è stato

mantenuto coperto da segreto industriale anche se la maggioranza dei ricercatori crede che

si tratti di un processo abbastanza standard il cui unico segreto è il materiale o polvere di

innesco della reazione nucleare. In ogni caso, questo approccio in concreto dimostra una

grave lacuna: la limitazione temporale e la aleatorietà della durata della reazione nucleare. In

altri termini, ammesso che si tratti di una reazione nucleare di bassa energia, i progettisti e/o

costruttori non riescono a mantenere sotto controllo il processo di produzione di energia,

indipendentemente dal livello di rendimento energetico.

L’APPROCCIO TEORICO

Come detto anche altrove, sono stati sviluppati molti (almeno 150) approcci teorici per la

spiegazione dell’EFP ma pochi sono credibili o appaiono affidabili con alto livello di

confidenza. Quello in cui il sottoscritto crede è l’approccio teorico di Giuliano Preparata

modificato e completato (dal sottoscritto e da altri) con la elaborazione della suddivisione

energetica del campo elettromagnetico di interazione fra di due protoni (di singoletto) che si

avvicinano.

Nel suo libro “QED COHERENCE IN MATTER” Giuliano Preparata, deceduto nel 2000, ha

proposto un’interpretazione teorica dell’EFP basata sul calcolo del campo quantico prodotto

dalla materia condensata ossia dal reticolo cristallino del Palladio sui nuclei dell’idrogeno

avente diametro di un Fermi (10-13 cm). Naturalmente, dai calcoli statistici degli effetti dei

campi periodici prodotti dal cristallo del Palladio, Preparata deduce che la distanza media

avvicinamento di due protoni, particelle dello stesso segno elettrico positivo, è pari a circa 10

Fermi ossia dieci volte il diametro del protone. Preparata non va oltre ma sostiene che

l’avvicinamento dei due protoni è sufficiente ad innescare la loro interazione di fusione. In

realtà, bisogna sviluppare il passo successivo o almeno chiarirlo in modo diretto. I due

protoni, sottoposti al campo periodico cristallino, si avvicinano in media a10 Fermi e tra di

loro si esercita, istante per istante, un campo elettromagnetico di scambio di energia. La

componente elettrica repulsiva del campo, proporzionale a ½ ε E 2 e la componente

magnetica proporzionale a ½ μ H2 di tipo attrattiva. Fino a quando la distanza fra le due

cariche non raggiunge valori di scala dell’odine del diametro del protone, la componente di

densità di energia elettrica repulsiva è sempre molto più grande della densità di energia

magnetica attrattiva. A circa 10 diametri di distanza le due componenti cominciano ad avere

intensità d forze paragonabili sempre che i due protoni abbiano la configurazione di

singoletto (Fig. N° 1) con spin opposti come da figura..

In altre parole, in figura è rappresentata la visione schematica di due accoppiamenti stabili

permessi dai meccanismi della chimica adronica, lo “accoppiamento planare di singoletto” (a

sinistra) e lo “accoppiamento assiale di tripletto” (a destra).

Gli studi e le esperienze hanno dimostrato che tutte le altre configurazioni di “spin”

producono forze “fortemente repulsive fra le particelle (protoni) in modo che la Fusione

Nucleare Fredda (e Controllata) (FNF) diventa impossibile. La maggior parte degli studi

eseguiti fino ad ora sono polarizzate su configurazioni “assiali” poiché sembra essere più

efficiente dal punto di vista energetico.

Fig : N° 1 Atomi (o protoni) con spin di singoletto (A) e tripletto (B)

Sempre nell’accoppiamento di singoletto, si dimostra con calcoli elementari che la repulsione

elettrostatica equivale all’attrazione magnetica alla distanza mutua dell’ordine di 1 Fm,

mentre a distanze inferiori la forza d’attrazione magnetica diventa anche più grande. IN

questa maniera, i due protoni possono compenetrarsi dando luogo alla fusione fredda. Non s

reputa necessario scrivere le equazioni classiche della fusione fredda in questo articolo.

In maniera leggermente più approfondita si riporta qui di seguito la seguente procedura di

calcolo.

1. Si introduce il potenziale di Hulten nell’equazione di Shrodinger.

2. Interazioni adroniche non Hamiltoniane di corto raggio.

3. Accoppiamento magnetico (spin dei protoni) supera la repulsione elettrostatica.

4. Accoppiamento planare (a sinistra) di singoletto

5. Accoppiamento assiale (a destra) di tripletto.

6. Tutti gli studi classici sono limitati a accoppiamento assiale di tripletto e quindi

finiscono con la repulsione elettrostatica così la CNF diventa impossibile

La spiegazione del fenomeno stesso data da Emilio del Giudice è leggermente diversa ed è

riporta schematicamente nella seguente Fig. N° 3 autodescrittiva:

LA SCUOLA ANERICANA

Non si può trattare a fondo il discorso della scuola americana per ragioni di spazio, va

comunque accennato all’enorme interesse dimostrato, dopo vent’anni ed oltre dagli Istituti di

Ricerca americani all’Effetto FLISHMANN & Ponz. A parte singoli ricercatori quali Widom,

Larsen, Scrivastava, Stanley Mayer, Eugene Mallove a tanti altri, nell’ultimo decennio il forte

interesse alla Fusione Nucleare Fredda è stato mostrato soprattutto dalla NASA e dal Navy

Lab che hanno prodotto lavori molto pregiati in campo delal fusione fredda.

LA SVOLTA: ICCF ed il diciannovesimo Congresso a Padova

Come risulta dagli atti del 19-simo Congresso, tenuto a Padova nel 2014, l’affluenza è stata

grande e ci sono stati molti interventi tecnocratici e manageriali di uomini dei vari Ministeri

interessati. Come risulta da ”links” di Wikipedia era presente anche il famoso Bill Gates, con

un grande fisico consulente. La presenza di Bill Gate che ha mostrato estremo interesse

continuato visitando i lavoratori di ENEA e di INFN sulla “Fusione Nucleare Fredda”, ora

nota come LENR, ha ravvivato i poveri spiriti del “top management” o “Establishment” dei

suddetti due Enti ed altri. In meno di sei mesi i grandi avversari della Fusione Nucleare

Fredda (Ora nota LENR) hanno cambiato idea nei confronti della FNF. Velocemente, questi

uomini hanno creato nuove divisioni per la ricerca in campo della Materia Condensata.

Eureka! La potenza del Dio denaro conquista tutto!

Finalmente il continuo e perdurante lavorio di intralcio ai LENR e disinformazione operato

dalla classe dei fisici particellari è stato, almeno in parte, arginato.

Sembrerebbe che si siano resi conto che la più moderna energia di natura generale

dovrebbe essere invece l’energia che inizialmente si chiamava da “Fusione Nucleare

Fredda”, capace di produrre energia libera e infinita per tutti i popoli de mondo. Questa nuova

fonte è stata assoggettata a tutta una serie di critiche negative che durano da almeno un

trentennio. Purtroppo anche i fisici particellari, che avrebbero dovuto essere di visione ampia

e, forse, illuminata si sono schierati contro la fusione nucleare fredda prendendo delle grandi

cantonate. Per decenni hanno avversato la ricerca sulla fusione fredda negandone la validità

empirica sperimentale e soprattutto la validità teorica del superamento della barriera di

potenziale elettrico columbiano. Le opposizioni sono state eseguite in modo capillare

negando persino la possibilità di tenere dei congressi ad hoc nelle facoltà di fisica e chimica.

Questo atteggiamento inverecondo ed antiscientifico è stato recentemente sconfessato dalla

situazione internazionale come anche si accennato. Durante la storia delle fisica degli ultimi

secoli casi del gnenere ne sono avvenuti molti quindi non c’è da meravigliarsi affatto.

Tuttavia, l’atteggiamento dei cosiddetti fisici particellari delle alte energie è stato e rimane

vergognoso e antiscientifico, di mentalità chiusa e di un conservatorismo inutile e deleterio

per la scienza italiana.

Così, in questa riferimento condizionato, i fisici delal fusione fredda hanno pensato bene ad

allargare la dizione di “fusione fredda”. In altre parole, la prima correzione apportata è

avvenuta con il cambiamento del nome da FNF a LENR (Low Energy Nuclear Reactions) e

quindi allargandone il significato e inserendo la fusione fredda nel grande capitolo della

materia condensata che è abbastanza rappresentativa della realtà fisica ossia questa nuova

fonte di energia a basso livello d’intensità non produce effetti e pericoli eventualmente

prodotti dalla energia nucleare classica poiché basata sull’impiego di livelli energetici bassi e

sullo sfruttamento dei fenomeni fisici della coerenza dei comportamenti di grandi numeri di

particelle e dell’aiuto dei campi di potenziale di “gauge” che consentono di sfruttare le energie

intrinseche dei campi (e del vuoto).

In Italia, nell’ultimo decennio un gruppo di fisici, chimici ed ingegneri di buona volontà, senza

mezzi economici, ma solo per amore della scienza anzi delle cosiddetta “open science” ha

tentato di continuare le attività di ricerca e di rappresentazione dei risultati mediante appositi

convegni definiti “Coherence”

Comunque, lo sviluppo di questi eventuali apparati di produzione d’energia LENR è ancora

molto lontano dall’inizializzazione della fase produttiva. Le visioni interessanti ma, appunto,

leggermente visionarie sulla pronta realizzabilità delle applicazioni di LENR appartiene a tutta

una serie di fisici, scienziati che nel recente passato ha dimostrato una enorme carenza di

conoscenza del grande lavoro di conversione da apparato di ricerca in un apparato di

produzione ripetibile ed affidabile. Purtroppo l’esperienza insegna che quest’anello del

processo di realizzazione di apparati concreti ed operativi assume una enorme importanza

nel mondo moderno industriale e la realizzazione del passaggio ad un apparato di impiego

maturo in campo richiede del tempo, non sempre facilmente prevedibile.

Al momento quindi, il laboratorio di ricerca all’INFN – dopo otto interrogazioni parlamentari

non è stato chiuso – e all’ENEA è stato aperto una nuova divisione sulla materia condensata

e le reazioni nucleari a bassa energia (LENR).

In qualche maniera la battaglia è stata vinta. Tuttavia, il prezzo del ritardo e le ragioni delle

scelte finalmente fatte a favore delle LENR sono ancora tutte le vagliare. Esistevano una

decina di lavoratori di ricerca in materia, adesso si vuole tentare una sorta di integrazione,

Mulla di male anzi si tratta di una scelta positiva, anche se frattanto, negli ultimi due anni, un

certo numero di ricercatori e operatori avevano tentato di organizzare un altro tipo di

assemblaggio di sistema di ricerca integrata, con il supporto di alcuni enti disposti ad

investire in materia.

CONCLUSIONI

Per ora ancora nessuno sa quando gli apparati operanti in base a reazioni nucleari di bassa

energia cominceranno ad essere veramente operativi e non un “bluff” come alcuni di quelli

proposti e forse commercializzati.

La risposta sui tempi produttivi rimane estremamente dubitativa e non si possono fare

previsioni temporali di qualsiasi genere se non azzardare a pensare in termini di molti

decenni a venire. I problemi scientifici e tecnologici devono essere affrontati con maggiore

capacità organizzativa e superiore potere economico e decisionale. Questo problema è stato

avversato, almeno in Italia negli ultimi tre decenni dal grande sovra-potere della scienza

particellare, antico retaggio culturale scientifico italiano della suola di Enrico Fermi. Purtroppo

l’Italia ed, in particolare, gli ambienti scientifici dotati, per inerzia conoscitiva e scientifica, di

maggiore potere economico, hanno avversato in modo profondo e vergognoso l’avvento

delle reazioni nucleari a bassa energia. Quest’atteggiamento continua a relegare la ricerca

italiana nell’ambito dei Paesi quasi sottosviluppati e/o delle Colonie della super potenza

statunitense ma, in parte ed in modo ridicolo, dell’Europa.

Frattanto la ricerca di biofisica e di biologia diretta (si faccia riferimento ai risultati delle

ricerche di Greig Venter e suoi collaboratori) continua a ritrovare esempi di reazioni nucleari

di bassa energia in complessi biologici sottomarini elementari e non.

In questo panorama, piuttosto scialbo e inverecondo, fra superiorità incommensurabile della

ricerca di alta energia nucleare rispetto alla ricerca di bassa energia, si erge la posizione

“vagante, fluttuante e aleatoria” dei movimenti ambientalisti italiani tutti dediti all’impiego di

solo bassa energia che hanno definito alternativa e rinnovabile. Questi signori ecologi

catastrofisti non sanno ancora, però, quale è la fonte di energia classica verso la

quale le nuove fonti di energia sarebbero “alternative”!

Queste vare interpretazioni vanno analizzate molto a fondo anche a livello internazionale per

osservare i veri dati, fatti ed eventi energetici che portano avanti il mondo intero e non solo gli

aspetti provinciali e superficiali degli italiani impauriti da tutta una serie di anatemi, di dogmi,

e di enunciati che hanno tutte le caratteristiche della stregoneria contraria alla vera scienza.

Di conseguenza, la unica soluzione concreta che rimane agli enormi e seri problemi di

energia che l’Italia, gli altri Paesi europei ed il Mondo intero hanno è quella di perseguire la

via della generazione di energia elettrica da centrali nucleari a fissione della terza

generazione avanzata. Solo in questa maniera, pur preferendo la FNF o LENR, il suo basso

costo e propugnando la necessità di forti finanziamenti, si può ritenere di giungere ad una

suddivisione di approvvigionamenti di energia dalle diverse fonti (petrolio, gas, carbone,

nucleare, solare, vento e geotermia ecc.) che sia razionale, armonizzata e ben bilanciata per

il bene di tutto il popolo.

GGMQ (16 Agosto 2015)

RIFERIMENTI (preliminari)

1. Gustave C. Fralick John D. Wrbanek, Susan Y. Wrbanek, Janis M. Niedra (ASRC) and

Marc G. Millis: Investigation of Anomalous Heat Observed in Bulk Palladium, NASA

2. http://fusionefredda3.com/novita/a-padova-la-19ma-international-conference-oncondensed-matter-nuclear-science-iccf19