UNIVERSITÀ POLITECNICA DELLE MARCHE

FACOLTÀ DI INGEGNERIA

Corso di Laurea Specialistica in Ingegneria Informatica

ESTRAZIONE E RICONOSCIMENTO

DI VOLTI DA FILMATI

Candidato:

Gianluca Dolcini

Relatore:

Prof. Aldo Franco Dragoni

Correlatore:

Ing. Andrea Claudi

Anno Accademico 2010-2011

Indice generale

Indice Generale............................................................................................................................I

Indice delle Illustrazioni.............................................................................................................II

Indice delle Tabelle....................................................................................................................V

Introduzione................................................................................................................................1

Capitolo1 -Stato dell'arte.............................................................................................................3

1.1 Localizzazione e identificazione di volti..........................................................................3

1.2 Face Detection..................................................................................................................7

1.2.1 Skin-segmentation....................................................................................................7

1.2.2 Algoritmo Viola-Jones............................................................................................16

1.3 Face Recognition............................................................................................................25

1.3.1 Principal Component Analysis...............................................................................26

1.3.2 Elastic Bunch Graph Matching..............................................................................30

1.3.3 Scale Invariant Feature Trasform...........................................................................33

1.3.4 Approccio Ibrido.....................................................................................................39

1.4 Algoritmi di Classificazione...........................................................................................41

1.4.1 Algoritmo di classificazione AdaBoost..................................................................43

1.4.2 Algoritmo di classificazione SVM..........................................................................46

Capitolo2 -Sviluppo del Software.............................................................................................52

2.1 Ambiente Sviluppo.........................................................................................................52

2.2 Realizzazione Sistema....................................................................................................53

2.2.1 Procedura di face detection.....................................................................................54

2.2.2 Procedura di Face Recognition...............................................................................64

Capitolo3 -Testing.....................................................................................................................70

3.1 Sistema e risorse ............................................................................................................70

3.2 Valutazione Face Detection su Video.............................................................................71

3.3 Valutazione Face Recognition su Database....................................................................75

3.4 Valutazione Face Recognition su video..........................................................................81

3.5 Prestazioni del sistema nel complesso............................................................................84

Conclusione...............................................................................................................................88

Bibliografia...............................................................................................................................90

I

Indice delle illustrazioni

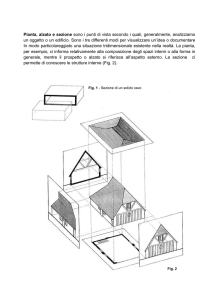

Fig. 1.1: Esempio di skin-map....................................................................................................8

Fig. 1.2: Esempio di fusione di più skin-map[2].......................................................................10

Fig. 1.3: Esempio di skin-map ottenute utilizzando 3 differenti modelli si skin color.............11

Fig. 1.4: Esempio di istogrammi di Cr e Cb ottenuti da tre volti con pigmentazione della pelle

differente...................................................................................................................................12

Fig. 1.5: Esempio di sottospazio delimitato da 4 rette (in nero) oppure da 5 rette (in rosso)...13

Fig. 1.6: Esempio di due funzioni gaussiane e della GMM ottenuta come somma pesata delle

due.............................................................................................................................................15

Fig. 1.7: Skin map ottenuta assegnando ai pixel il valore di probabilità condizionata............15

Fig. 1.8: Esempio di Summed Area Tablet e della versione ruotata.........................................17

Fig. 1.9: Immagine che esemplifica come avviene il calcolo della sotto area evidenziata.......18

Fig. 1.10: Esempio di rettangolo verticale e del corrispondente rettangolo ruotato di 45 gradi

...................................................................................................................................................19

Fig. 1.11: Esempio delle tre haar fondamentali........................................................................19

Fig. 1.12: Immagine dei coefficienti ottenuti applicando le wavelet sull'immagine in alto a

sinistra.......................................................................................................................................20

Fig. 1.13: Esempio di haar like feature verticali e ruotate. ......................................................21

Fig. 1.14: Esempio della cascata di classificatori. Ogni nodo uno stage della cascata.............24

Fig. 1.15: Haar feature usate per l'apprendimento dei primi 3 stage della cascata di

classificatori..............................................................................................................................24

Fig. 1.16: Esempio di come avviene la riduzione di dimensione dello spazio tramite l'utilizzo

della tecnica di analisi delle componenti principali..................................................................27

Fig. 1.17: Esempio di immagini di volti che compongono un database (a) e insieme delle

eigenfaces ricavate dal database (b)..........................................................................................28

Fig. 1.18: Esempio di adattamento del grafo su volti in pose differenti...................................30

Fig. 1.19: Esempio di FBG che fornisce una rappresentazione generale di un volto. Gli stack

di dischi rappresentano i jet.......................................................................................................31

Fig. 1.20: Rappresentazione grafica del calcolo della differenza gaussiana.............................34

Fig. 1.21: Punti che vengono utilizzati per determinare massimo e minimo della differenza

Gaussiana. Il pixel analizzato è quello identificato con la X, gli altri evidenziati sono quelli

presi in considerazione per il calcolo........................................................................................35

Fig. 1.22: Immagini rappresentative del processo di estrazione dei keypoint. La figura (a)

II

rappresenta l'immagine originale, la (b) rappresenta i keypoint estratti nella prima fase e la (c)

rappresenta i keypoint che sono stati selezionati perché più stabili..........................................35

Fig. 1.23: Esempio del posizionamento e orientamento di due differenti keypoint.................37

Fig. 1.24: Istogramma che rappresenta il numero di voti ricevuti dai diversi soggetti del

database.....................................................................................................................................38

Fig. 1.25: Struttura grafica del funzionamento dell'algoritmo di face recognition che prevede

fusione di feature locali e globali..............................................................................................39

Fig. 1.26: Dataset di apprendimento D.....................................................................................43

Fig. 1.27: Dataset ottenuti da D, rispettivamente D1, D2 e D3................................................44

Fig. 1.28: Classificatore finale..................................................................................................44

Fig. 1.29: Andamento dell'errore all'aumentare delle iterazioni...............................................46

Fig. 1.30: Due differenti iperpiani di separazione nel caso di dati linearmente separabili.......48

Fig. 1.31: Iperpiano di separazione nel caso di dati linearmente non separabili......................49

Fig. 1.32: Caso di dati non linearmente separabili che richiedono una funzione di mapping.. 50

Fig. 2.1: Immagine che descrive come funziona il processo di erosione..................................56

Fig. 2.2: (a) Skin-map ottenuta dalla procedura di classificazione dei pixel, (b) skin-map

ottenuta dopo il processo di erosione con kernel 3x3...............................................................57

Fig. 2.3: Immagine di un frame dove in rosso sono riquadrate le aree identificate con la

procedura di skin-segmentation. Le aree in blu sono le sotto aree di ricerca per occhio sinistro

e bocca. I riquadri verdi indicano gli elementi individuati con algoritmo Viola-Jones............58

Fig. 2.4: Metodologia di Shiqi Yu [27] per l'estrazione delle aree oculari per apprendimento.59

Fig. 2.5: Schema di ricerca delle componenti fondamentali del volto. In verde le uscite

positive, in rosso le situazioni che generano un rigetto della sotto area. .................................62

Fig. 2.6: Dieci immagini raffiguranti il mio volto inserite nel database...................................65

Fig. 2.7: Esempio di aree limitrofe ad occhi e bocca che hanno un maggiore peso per la

decisione....................................................................................................................................67

Fig. 2.8: Sotto aree contenenti occhi e bocca ricavate dalle immagini raffiguranti il mio volto

inserite nel database..................................................................................................................68

Fig. 3.1: Confronto tra fotogrammi acquisiti con webcam differenti. (a) frame acquisito con

webcam Hp, (b) frame acquisito con webcam Toshiba............................................................70

Fig. 3.2: Fotogramma estratto dal video 4 rappresentante l'area di minori dimensioni che

contiene un volto 50x52 pixel...................................................................................................72

Fig. 3.3: Parte di frame estratti dal video 4 che raffigurano diverse posizioni del volto.......73

Fig. 3.4: Fotogrammi tratti dai video 2, 3 e 4. Si noti come varia la skin-map al variare della

III

sistema di acquisizione..............................................................................................................74

Fig. 3.5: Grafico riferito alla percentuale di riconoscimenti corretti su tutti i volti del

database.....................................................................................................................................77

Fig. 3.6: Grafico riferito alla percentuale di riconoscimenti corretti su tutto il database tranne

i volti di apprendimento............................................................................................................77

Fig. 3.7: Grafico riferito alla percentuale di classificazioni unknown su tutti i volti del

database.....................................................................................................................................78

Fig. 3.8: Grafico riferito alla percentuale di classificazioni unknown su tutti i volti del

database tranne quelli usati per l'apprendimento......................................................................78

Fig. 3.9: Grafico riferito alla percentuale di classificazioni errate su tutto il database.............79

Fig. 3.10: Grafico riferito alla percentuale di classificazioni errate su tutto il database tranne i

volti di apprendimento..............................................................................................................80

Fig. 3.11: Percentuali di identificazioni ottenute al variare dei livelli di soglia e al punteggio

da attribuire ai keypoint localizzati nei pressi degli occhi e della bocca..................................82

Fig. 3.12: Percentuale di volti identificati come sconosciuti al variare della soglia e del peso

dei keypoint localizzati vicino a occhi e bocca.........................................................................83

Fig. 3.13: Percentuale di volti identificati come sconosciuti o classificati in maniera errata al

variare della soglia e del peso dei keypoint localizzati vicino a occhi e bocca........................83

Fig. 3.14: Test eseguiti per valutare le prestazioni del sistema. ...............................................85

IV

Indice delle tabelle

Tabella 1.1: Calcolo del numero delle feature estratte da un'immagine di dimensioni 24x24

pixel...........................................................................................................................................22

Tabella 1.2: Percentuali di corretta identificazione al variare del numero di immagini usate per

l'apprendimento.........................................................................................................................37

Tabella 1.3: Tabella che riporta il tasso medio di successo riferito all'applicazione di diverse

tecniche su ORL database.........................................................................................................41

Tabella 2.1: Cardinalità degli insiemi di colori che appartengono alla classe pelle in base alle

soglie riferite a due differenti spazi di colore............................................................................55

Tabella 3.1: Sono riportati il numero di volte che è stato estratto un volto dai diversi video e la

percentuale in riferimento al numero totale di frame del video................................................75

Tabella 3.2: Tabella riassuntiva che contiene le percentuali di corretta identificazione con

valore di soglia fissato a 0,14....................................................................................................80

Tabella 3.3: Test eseguiti utilizzando il meccanismo di riduzione del numero di riquadri da

analizzare. Con parametro di soglia impostato a 0,0 e peso dei keyipoint, localizzati nelle aree

vicino agli occhi e alla bocca, pari a 2. ....................................................................................86

V

Introduzione

Introduzione

Il mio lavoro si incentra sullo sviluppo di un software in grado di estrarre ed identificare volti

umani all'interno di un flusso video. I flussi video possono essere acquisiti direttamente da

una webcam oppure da file precedentemente salvati.

Per la creazione del software è necessario prendere in considerazione due differenti aspetti. Il

primo è quello che rintraccia ed estrae un'area contenente un volto all'interno di un video,

prende il nome di face detection. Il secondo è quello che identifica l'appartenenza del volto

confrontandolo con i soggetti presenti in un database, prende il nome di face recognition.

Per poter scegliere l'approccio migliore è stato prima necessario approfondire entrambi gli

aspetti, ricercando quelle metodologie che meglio si combinavano per consentire una corretta

realizzazione del software.

Le tecniche scelte per la fase di face detection sono:

•

la Skin-Segmentation: utilizzata per estrarre da un frame tutte le sotto aree che

contengono dei pixel classificabili come colore della pelle. Il suo ruolo è dunque

quello di limitare il numero di aree all'interno del frame dove ricercare la presenza del

volto;

•

la procedura Viola-Jones: fa uso di un algoritmo di classificazione di tipo AdaBoost

abbinato ad una tecnica di estrazione delle feature chiamata Haar. L'algoritmo,

pensato inizialmente come tecnica di ricerca dei volti, è stato esteso anche per la

localizzazione di componenti come occhi e bocca. Viene utilizzato per ricercare la

bocca e gli occhi nelle sotto aree ottenute dalla skin-segmentation.

La tecnica di skin-segmentation è stata presa in considerazione poiché è molto semplice da

realizzare ed al contempo estremamente efficace nel ridurre le aree dove effettuare successive

elaborazioni.

La procedura Viola-Jones, invece, è stata scelta poiché è molto affermata ed è in grado di

garantire la localizzazione dei componenti del volto con tempistiche real-time e con buona

efficacia.

Per quanto riguarda invece la fase di face recognition si è scelto di utilizzare queste tecniche:

•

Scale Invariant Feature Transform (SIFT): per l'estrazione delle feature

caratteristiche delle immagini raffiguranti il volto;

1

Introduzione

•

Support Vector Machine (SVM): algoritmo di machine learning in grado di definire i

confini tra i diversi soggetti che compongono il database a partire da un set di

campioni di apprendimento.

La scelta delle Scale Invariant Feature Transform è stata fatta poiché esse garantiscono una

rappresentazione dei punti caratteristi di un'immagine, invarianti a scala e rotazione. Dunque,

in un contesto in cui il volto può apparire in posizione e pose differenti, questa tecnica

dovrebbe garantire una maggiore tolleranza. Inoltre, poiché queste metodologie danno una

rappresentazione locale dell'immagine, sono completamente svincolate dalla morfologia del

volto consentendo di estrarre feature confrontabili anche in presenza di parziali occlusioni.

La scelta del Support Vector Machine come algoritmo di apprendimento supervisionato è

motivata dalla sua capacità di operare in multiclasse, cioè distinguere tra un numero finito N

di soggetti. Nel caso specifico ciascuna classe è rappresentata da un individuo del database.

Altri algoritmi non potendo operare in contesti multiclasse sono stati scartati anche se

avrebbero potuto garantire migliori velocità di risposta.

La tesi si compone di tre capitoli:

•

Stato dell'Arte.

Verranno presentate le più importanti tecniche di estrazione ed identificazione del

volto, separando la trattazione dell'una e dell'altra. Si presterà particolare attenzione

alle diverse tecniche per il face recognition poiché questo aspetto è ancora dibattuto.

Inoltre si farà una breve descrizione di due algoritmi di machine learning.

•

Sviluppo del Software.

Verrà presentato il funzionamento del software di estrazione e identificazione,

descrivendo separatamente la parte di face detection e quella di face recognition.

•

Test.

Questo capitolo sarà dedicato alla verifica delle prestazioni del sistema realizzato,

concentrando l'attenzione sulla capacità di estrazione ed identificazione. Si

verificheranno quali condizioni generano il maggior numero di errori di classificazione

e come porvi rimedio. Inoltre si cercherà di analizzare le prestazioni in termini di

tempi di computazione.

2

Stato dell'arte

Capitolo1 - Stato dell'arte

In questo capitolo saranno presentate separatamente tecniche di localizzazione e tecniche di

riconoscimento di volti. Inoltre alla fine del capitolo verranno presentati due algoritmi di

classificazioni menzionati nei paragrafi precedenti.

1.1 Localizzazione e identificazione di volti.

La localizzazione e l'identificazione di volti attraverso l'analisi di immagini, e più in generale

attraverso l'analisi dei frame dei flussi video, è molto interessante nell'ambito informatico allo

scopo di produrre applicazioni in grado di automatizzare processi molto onerosi.

I differenti ambiti a cui si possono rivolgere tali applicazioni sono:

•

la sicurezza: video sorveglianza, monitoraggio di accessi e identificazione per

accesso. Il monitoraggio di accesi potrebbe ad esempio essere usato per verificare se

un individuo non autorizzato è presente in una determinata area. Se ciò dovesse

accadere l'operatore si metterà in allerta e potrà agire in maniera opportuna;

•

i media: catalogazione automatica di risorse multimediali. Un software per

identificare i volti sarebbe in grado di rintracciare la presenza di individui specifici

all'interno di un video e annotare in tempo reale quando ciò accade. In tal modo si

faciliterebbe la catalogazione del contenuto per una successiva ricerca.

Le applicazioni sono svariate e hanno lo scopo di diminuire o addirittura eliminare il carico di

lavoro di un individuo.

Risolvere tale problema richiede l'attuazione di due differenti operazioni:

•

localizzazione di un volto all'interno dell'immagine (face detection);

•

identificazione del volto verificando se è presente o meno all'interno del database

(face recognition).

Queste due classi di algoritmi possono presentare similarità ma sono fondamentalmente

differenti. Sicuramente una caratteristica comune che le coinvolge entrambe sono le

problematiche riguardanti l'acquisizione dell'immagine.

Anche se tale problema dovrebbe influenzare principalmente la fase di face detection, poiché

3

Stato dell'arte

essa viene svolta a monte della fase di face recognition, in realtà anche se siamo in grado di

riconoscere la presenza di un volto non si può essere certi che questo possa essere identificato

con successo.

Possiamo distinguere tre tipologie di problematiche che si possono riscontrare:

•

le condizioni ambientali in cui viene acquisita la scena. Se l'acquisizione avviene

sempre con lo stesso background e la stessa illuminazione è possibile eliminare

parzialmente tale interferenza;

•

la morfologia e la posa del volto. Il volto può essere in posizioni non ottimali per

l'acquisizione oppure potrebbe essere parzialmente coperto;

•

le caratteristiche fisiche dell'hardware di acquisizione della scena. Ovvero le

caratteristiche del sensore e delle lenti, la posizione del sistema di acquisizione rispetto

alla scena.

Analizziamo più specificatamente questi tre gruppi di problematiche, vediamo quali sono i

principali aspetti che possono portare a malfunzionamenti di un sistema di localizzazione e

identificazione.

Partiamo dall'analisi delle condizioni ambientali.

Il problema maggiore che si manifesta è la variazione dell'illuminazione[1][2] poiché

influisce negativamente sulla possibilità di comparare immagini ottenute dalla medesima

scena e che hanno luminosità differente. Non è sufficiente che il sistema conosca solamente

come appare il volto di un individuo in condizione di luminosità ideale, ne deve apprendere i

tratti caratteristici anche in condizioni differenti.

La morfologia e la posa del volto sono legati a da due aspetti fondamentali: la posizione del

sistema di acquisizione e l'espressione dell'individuo.

Possiamo dunque distinguere i seguenti fattori:

•

la posa [1]: il volto può essere orientato in diversi modi. La migliore condizione di

analisi è con volto perfettamente frontale;

•

la presenza di componenti strutturali [1]: la presenza o l'assenza di elementi come

barba, baffi o occhiali cambia l'aspetto del volto acquisito;

•

le espressioni facciali [1]: il volto ha un differente aspetto a seconda dell'espressione

assunta dal soggetto;

•

le occlusioni [1]: il volto può essere parzialmente coperto da altri elementi presenti

nell'ambiente. Anche gli occhiali possono essere considerati come occlusione, seppur

4

Stato dell'arte

vengono trattati come componenti strutturali;

•

la rotazione dell'immagine [1]: il volto appare differente in base alla diversa

rotazione del soggetto rispetto agli assi del sistema di acquisizione. Mentre la posa

dipende dal soggetto che viene inquadrato, la rotazione dell'immagine dipende dal

montaggio del sistema che potrebbe non essere ottimale.

Il terzo aspetto che dobbiamo prendere in considerazione è relativo all'hardware che verrà

utilizzato. La scelta della periferica di acquisizione è fondamentale, ma per determinate

applicazioni è molto importante anche il sistema hardware che compirà le operazioni di

analisi. Le caratteristiche del sensore e delle lenti[1] del sistema di acquisizione influiscono

sulla qualità dell'immagine che verrà processata. Il sistema hardware che compirà le

operazioni di elaborazione dell'immagine determinerà la prontezza della risposta del software.

Tutti i fattori fin qui descritti, se non controllati, influenzano negativamente le prestazioni di

un sistema di localizzazione e identificazione. Infatti quando non è possibile controllare

l'ambiente in cui si cercherà di identificare i soggetti, tutti i fattori esaminati in precedenza

determineranno un notevole aumento della complessità degli algoritmi.

Differente è la situazione quando si vuole realizzare un sistema dove il volto è utilizzato come

meccanismo per l'autorizzazione di accesso.

Tutti i fattori che possono determinare variabilità vengono limitati ponendosi in un ambiente

ottimale. Inoltre il soggetto che intende accedere si posizionerà in maniera tale da aumentare

la possibilità di identificazione.

Concentrandoci sulla componente del face detection possiamo distinguere quattro differenti

tipologie di algoritmi [1]:

•

Knowledge-based methods: si basa sulla definizione di regole per stabilire quali aree

dell'immagine rappresentino un volto. Le regole vengono utilizzate per codificare il

concetto di volto;

•

Feature invariant approaches: estrazione di feature che caratterizzano il volto umano.

Esse sono tali da non variare al mutare di condizioni come la luminosità o la posa. Di

queste fa parte la tecnica basata sullo skin-color;

•

Template matching methods: vengono definiti dei template pattern di feature che

descrivono il prototipo di un volto, vengono utilizzati per scandagliare un'immagine

alla ricerca di un'area che presenti dei pattern di feature similari;

•

Apparence based methods: i pattern che descrivono il prototipo di un volto vengono

5

Stato dell'arte

ricavati da un set di immagini di apprendimento realizzato in base alle finalità che si

cerca di ottenere. Ad esempio si porrà come condizione la ricerca di volti di profilo se

si intende rilevarli solo con questa caratteristica. Il metodo più importante

appartenente a questa categoria è l'algoritmo proposto da Viola-Jones [3].

Prendendo in considerazione il face recognition, esistono svariati tipi di approcci. In questa

procedura un ruolo importantissimo viene svolto dal meccanismo utilizzato per l'estrazione

delle feature che caratterizzano il volto umano. Migliore è il sistema di estrazione delle

feature più facile sarà per l'algoritmo apprendere i confini che dividono un volto da un altro.

Di conseguenza sarà in grado di generalizzare tali informazioni allo scopo di predire in

maniera corretta la classe di appartenenza di un volto rilevato.

Molte sono le tecniche che hanno il compito di estrarre dalle immagini di volti le feature

caratteristiche. Nello specifico ne prendiamo in considerazione due: Eigenfaces e Fisherfaces

[11].

La metodologia Eigenfaces è basata sulla proiezione delle immagini in uno spazio delle

feature ridotto, che viene ulteriormente ridimensionato attraverso l'uso delle tecniche basate

sull'analisi delle componenti principali (principal component analisis – PCA) [16]. A partire

dall'algoritmo PCA si sono evolute diverse varianti tra cui two-dimensional PCA [15].

La metodologia Fisherfaces è invece un procedimento derivato dalla tecnica Fisher's linear

discriminate (FLD)

[16] in cui, analogamente a quanto accade per il PCA, si proietta

l'immagine in uno spazio delle feature che viene poi ridotto. Anche tale tecnica ha subito

modifiche e miglioramenti, tra le tipologie esistenti se ne ricordano due: two-dimensional

FLD e generalized two-dimensional FLD [15].

Tra i meccanismi di estrazione delle feature possiamo inserire una tecnica più recente

chiamata Scale Invariant Feature Transform. Tale tecnica estrae da un'immagine un insieme

di punti caratteristici, chiamati keypoint che sono invarianti a scala, rotazione e parzialmente

anche ai cambiamenti di luminosità [14].

Tutte le tecniche sopra citate necessitano di un meccanismo di confronto che può variare dalla

semplice distanza euclidea a più complessi algoritmi di classificazione supervisionata come

support vector machine, alberi binari o reti neurali.

Altre tecniche di estrazione delle feature si basano sulle proprietà del volto come distanze e

angoli di punti ben definiti. Confrontando le informazioni geometriche estratte con quelle

precedentemente calcolate si cerca di ottenere l'identificazione.

6

Stato dell'arte

Una tecnica che fa molto uso di un approccio di questo tipo è l'Elastic Bunch Graph

Matching (EBGM) dove il volto viene rappresentato tramite un grafo in cui i nodi sono

posizionati in punti prestabiliti del volto e i lati sono etichettati con il vettore delle distanze.

Inoltre ogni nodo contiene un insieme di coefficienti delle Gabor Wavelet [13].

1.2 Face Detection

Come precedentemente affermato, il problema di estrazione dei volti presenti in un'immagine

viene chiamato con il nome di face detection. Tale procedura sta a monte rispetto a operazioni

di riconoscimento o altre tipologie di elaborazioni che possono richiedere la conoscenza della

presenza di un volto in un'immagine.

Le classi in cui possono essere raggruppati questi algoritmi sono quattro.

Ora ci concentreremo sull'analisi di due differenti tecniche che rappresentano quelle

maggiormente usate.

La prima, molto semplice da realizzare, fa parte dei feature invariant approaches ed è basata

sulla determinazione delle aree che contengono pixel con colore del volto. Possiamo riferirci a

tali tecniche con il nome di skin-segmentation [4].

L'altra tecnica molto diffusa e con ottime prestazioni, anche per applicazioni di tipo real-time,

è quella proposta da Viola-Jones [3], si basa sulla estrazione delle wavelet haar e sul loro uso

come informazioni per l'apprendimento di un algoritmo di classificazione di tipo AdaBoost.

1.2.1 Skin-segmentation

La skin-segmentation è una tecnica che prevede la ricerca delle aree di un'immagine

contenenti colori simili a quelli della pelle del volto umano. Come è facile intuire è molto

semplice da implementare ma richiede dei meccanismi di validazione dell'area trovata che

solitamente sono basati sulla determinazione della presenza di elementi come occhi, naso,

orecchie e bocca.

7

Stato dell'arte

Fig. 1.1: Esempio di skin-map.

Il passo fondamentale di questa tecnica è quello di produrre, a partire da un'immagine a

colori, una skin-map, cioè un'immagine in scala di grigi, o addirittura solamente a due colori,

che distingua le aree identificate come colore della pelle da quelle con colorazioni differenti.

Il primo aspetto da prendere in considerazione quando si tratta dell'estrazione delle aree

contenenti colorazioni della pelle è proprio la rappresentazione del colore. Gli spazi di colori a

nostra disposizione sono differenti ma vanno comunque tenute in considerazione le

caratteristiche del sistema di acquisizione. Se questo lavora solamente in scala di grigi è

impossibile utilizzare una tecnica del tipo skin-segmentation.

Nonostante esistano molte rappresentazioni del colore, quelle più comunemente usate sono le

seguenti:

•

RGB (red, green, blue): standard per la rappresentazione di immagini in strumenti

elettronici come schermi e sensori di fotocamere [1]. Lo standard non è valido per i

sistemi di stampa. Rappresenta la decomposizione del colore nelle sue componenti

primarie rosso, verde e blu;

•

HSV (Hue Saturation Value): standard basato sulla percezione del colore da parte

dell' uomo. Il colore viene descritto attraverso la tonalità (H), la saturazione (S) e

l'intensità luminosa (V). Si ottiene da una trasformazione non lineare dell' RGB [4][5].

Uno spazio di colore simile è HSI [2] e HLS;

8

Stato dell'arte

•

YCrCb: si rappresenta il colore come composizione di intensità luminosa (Y) e di due

segnali differenti di crominanza (Cr Cb) [5]. Il passaggio da RGB avviene con una

trasformazione di tipo lineare [4].

1

∗(65.738∗R+129.057∗G+25.064∗B)

256

1

Cb=128+

∗(−37.945∗R−74.494∗G+112.439∗B)

256

1

Cr =128+

∗(112.439∗R−94.154∗G −18.285∗B)

256

Y =16+

Indipendentemente dal tipo di codifica del colore che abbiamo a disposizione è sempre

possibile passare da una rappresentazione all'altra. La scelta più logica da effettuare è

utilizzare come spazio di colori l'RGB poiché utilizzata per le più comuni apparecchiature

elettroniche.

Il problema che però ci si trova ad affrontare scegliendo questo spazio di colori è l'influenza

di cambiamenti di luminosità. Infatti gli altri due spazi di colori, anche se in modalità

differenti, hanno una rappresentazione esplicita della componente luminosa (Y e V).

In realtà si può ovviare a ciò escludendo tali canali in fase di analisi, così da ottenere una

rappresentazione non influenzata dai cambiamenti di luminosità.

Nel caso RGB è possibile attenuare l'effetto della luminosità utilizzando la normalizzazione

del colore e sfruttando solamente i canali rosso (r) e verde (v) normalizzati [6]. Le formule per

effettuare tale normalizzazione sono le seguenti:

r=

R

R+G+B

g=

9

G

R+G+ B

Stato dell'arte

In alcuni casi è possibile combinare l'uso dei differenti spazi di colore con la finalità di

ottenere delle regioni più accurate.

Una proposta in questa ottica viene presentata nell'articolo “A Robust Skin Color Based Face

Detection Algorithm” [2]. I risultati ottenuti dalla procedura di skin-segmentation applicata a

RGB normalizzato, a HSI e a YCrCb vengono fusi per ottenere una skin-map unica con

migliore precisione rispetto alle skin-map ottenute nei singoli spazi di colore.

Fig. 1.2: Esempio di fusione di più skin-map[2]

Per svolgere la procedura di skin-segmentation possono essere utilizzati differenti approcci:

•

Limite di decisione lineare a tratti: vengono definiti dei valori di soglia con tecniche

che possono essere più o meno complesse [4]. Un esempio è quello di analizzare gli

istogrammi generati da una regione classificata come colore del volto e verificare

come si concentrano i valori dei pixel;

•

Classificatore bayesiano: il ruolo degli istogrammi, anche in questo caso, è

fondamentale per determinare la probabilità condizionata che un pixel appartenga o

meno al modello del colore della pelle;

p( x∣skin)

≥soglia

p( x∣noskin)

•

Classificatore di tipo Gaussiano: vengono creati dei modelli gaussiani che

descrivono lo skin color.

◦ Unimodali: una sola funzione di densità di probabilità condizionata (p(x|skin) che

10

Stato dell'arte

caratterizza il modello;

◦ Mixture [7]: la densità di probabilità viene descritta da una combinazione pesata

di più funzioni di tipo gaussiano unimodali, chiamati Gaussian Mixture Model

(GMM).

•

Multilayer Perceptron: vengono utilizzate delle reti neurali per definire il confine tra

skin e noskin color.

Più in generale possiamo però usare un qualsiasi algoritmo di classificazione al fine di

apprendere il confine tra colore delle pelle e non. Tali classificatori dovranno avere un set di

apprendimento tale da garantire la copertura di tutte le possibili casistiche. Quindi la pelle

umana dovrà essere rappresentata in contesti di illuminazione differenti e dovrà riguardare

tutte le possibili tipologie di pigmentazione.

Solitamente si cerca di generare un modello unico per descrivere tutte le differenti razze che si

potrebbero incontrare. In alcuni casi potrebbe essere necessario utilizzare un modello per ogni

razza. Nell'approccio proposto da Li Zuo e Kamata [7] si realizzano tre differenti Gaussian

Mixture Model per rappresentare le tre colorazioni della carnagione: bianca, scura e olivastra.

Lo spazio di colore utilizzato in questo caso è YCrCb che, con l'esclusione dell'analisi del

canale Y, dovrebbe garantire una buona tolleranza alle variazioni di luminosità.

Fig. 1.3: Esempio di skin-map

ottenute utilizzando 3 differenti

modelli si skin color

Nell'immagine riportata precedentemente (Fig. 1.3), che fa riferimento alla ricerca di pixel

con modelli diversi per le tre differenti carnagioni, possiamo vedere come il confine tra esse

non sia così netto. Infatti alcuni pixel del volto con carnagione bianca vengono classificati in

maniera corretta come appartenenti alla carnagione bianca, ma anche come appartenenti alla

11

Stato dell'arte

carnagione scura ed olivastra. Questo accade principalmente nelle zone in ombra oppure in

quelle sottoposte ad una forte illuminazione. Ciò implica che la scelta di un unico modello per

tutte le carnagioni non dovrebbe portare a problemi di classificazione dei singoli pixel.

Di seguito (Fig. 1.4) possiamo vedere gli istogrammi dei canali Cr e Cb di tre diversi volti,

uno per ogni carnagione. Come si può notare, la maggioranza dei pixel ricadono all'interno di

limiti superiori e inferiori molto simili per le differenti tipologie di carnagione. Invece la

distribuzione all'interno di tali limiti risulta essere diversa.

Fig. 1.4: Esempio di istogrammi di Cr e Cb ottenuti da tre volti

con pigmentazione della pelle differente.

Analizziamo quindi più attentamente come funzionano i limiti di decisione lineari a tratti.

Il modo più semplice per classificare un pixel è quello di definire dei valori di soglia per i

differenti canali dello spazio di colori. Solitamente se ne prendono in considerazione due,

quelli che rappresentano le crominanze.

L'obiettivo è quello di creare un sottospazio dello spazio di colori che contiene tutti i pixel di

tipo pelle. Se il pixel analizzato ricade all'interno di questo sottospazio si classifica come pelle

altrimenti no. Tale sottospazio può essere più o meno preciso, dipende dal metodo di

delimitazione dei confini scelto. Il modo più semplice è definire un limite superiore ed un

limite inferiore per ogni canale del colore. Ad esempio se usassimo solamente i canali Cr e

Cb, definendo i limiti superiori ed inferiori, si otterrebbe un sottospazio di forma rettangolare.

Se invece si includesse anche il canale Y, lavorando in uno spazio tridimensionale, si

12

Stato dell'arte

creerebbe un sottospazio di forma parallelepipeda.

Ponendo il limite superiore e quello inferiore è come se considerassimo un sottospazio

definito da 4 rette. É ovvio che se volessimo ottenere un sottospazio più accurato potremmo

utilizzare un numero maggiore di rette per delimitare lo spazio. Nel caso però volessimo

prendere in considerazione tutti e tre i canali di uno spazio di colori dovremmo definire dei

piani di separazione e non delle rette.

Fig. 1.5: Esempio di sottospazio delimitato da 4 rette

(in nero) oppure da 5 rette (in rosso)

La determinazione dei limiti viene fatta analizzando gli istogrammi di immagini raffiguranti

volti. Per i differenti spazi di colore esistono dei limiti ben precisi:

•

RGB normalizzato: 0,335 ≤ r ≤ 0,465 e 0,27 ≤ g ≤ 0,363 [6];

•

YCrCb: 77 ≤ Cb ≤ 127 e 133 ≤ Cr ≤ 173 [4] in cui è escluso il canale Y;

•

HSV: 0,23 ≤ S ≤ 0,68 e 0° ≤ H ≤ 50° [4] in cui è escluso il canale V.

Il metodo che fa uso di limiti di decisione di tipo lineare a tratti risulta essere molto semplice

da realizzare e computazionalmente poco oneroso.

Tra i modelli per descrivere il colore in maniera più accurata vi è sicuramente il classificatore

di tipo gaussiano. In questo caso, a partire da esempi di pixel del colore della pelle, si genera

una funzione gaussiana che descrive la probabilità condizionata che esso appartenga alla

classe pelle. Possiamo perciò assegnargli il valore ottenuto da questa funzione di probabilità.

La skin-map che otterremo in questo caso sarà in scala di grigi dove la colorazione bianca

corrisponderà alla massima probabilità che il pixel sia di tipo pelle, mentre una colorazione

nera corrisponderà alla probabilità minima.

Occorre precisare che tale metodo di classificazione dei pixel è più complesso rispetto a

13

Stato dell'arte

quello dei classificatori lineari a tratti. La maggiore complessità sta nel dover memorizzare

una o più funzioni di tipo gaussiano per descrivere il modello del colore della pelle. Di contro

però, le informazioni aggiuntive ottenute con questo metodo potrebbero risultare importanti ai

fini della validazione dell'area che presumibilmente contiene un volto umano.

Possiamo distinguere due differenti tipi di modelli gaussiani: quelli unimodali, in cui la

funzione di densità di probabilità condizionata è rappresentata da una sola funzione gaussiana;

quelli misti, dove la funzione di densità di probabilità è descritta da una somma pesata di

funzioni gaussiane.

La funzione di densità di probabilità gaussiana nel caso di modello unimodale ha la seguente

forma:

−d / 2

p ( x∣skin)= g (x ; ms , C s)=(2 π)

−1/ 2

∣C s∣

1

− ( x−m s)T C −1

s ( x−m s )

2

exp

.

Dove d rappresenta la dimensione del vettore delle feature e, in base agli spazi di colore presi

in considerazione in precedenza, solitamente prende il valore 2. Nel caso in cui invece si

includa anche la componete relativa alla luminosità, d prenderebbe il valore 3. Il parametro ms

rappresenta il vettore delle medie e Cs la matrice di covarianza, entrambi sono relativi alla

classe pelle. La formula utilizzata per definire se un pixel appartiene ad una classe è quella del

classificatore bayesiano:

p( x∣skin)

≥soglia .

p( x∣noskin)

Se invece consideriamo una distribuzione gaussiana unimodale per p(x|skin) e una

distribuzione uniforme della classe non pelle, è possibile ridurre la formula nel seguente

modo:

( x−ms )T C−1

s ( x−m s)≤soglia .

L'elemento a sinistra della disuguaglianza è il quadrato della distanza di Mahalanobis,

descrive una misura di similarità tra un campione dato e descritto da media e covarianza ed un

campione ignoto.

Nel caso invece si decidesse di descrivere anche la funzione di densità di probabilità p(x|

noskin) con una funzione gaussiana unimodale, definiti Cns e mns rispettivamente covarianza e

media della classe non pelle, la formula precedente diventa:

T

−1

( x−ms )T C−1

s ( x−m s)−( x−m ns ) C ns (x−m ns )≤soglia .

14

Stato dell'arte

Tale semplificazione non è valida se si prendono in considerazione le funzioni di densità di

probabilità descritte dai modelli gaussiani misti (GMM). In questo caso le due funzioni

sarebbero le seguenti:

Ns

p ( x∣skin)=∑ w s , i g ( x ; ms , i , C s ,i ) ,

i =1

N ns

p ( x∣noskin)=∑ wns , i g ( x ; m ns ,i ,C ns ,i ) .

i=1

Nelle formule precedenti il parametro w rappresenta i pesi assegnati ad ogni funzione

gaussiana. Solitamente i valori dei pesi, delle medie e delle covarianze vengono determinati

con l'utilizzo dell'algoritmo Expectation–maximization.

Nell'immagine seguente (Fig. 1.6) possiamo vedere un esempio di modello gaussiano misto e

delle due funzioni gaussiane che ne determinano l'andamento.

0 .1 6

0 .1 4

0 .1 2

0 .1

0 .0 8

0 .0 6

0 .0 4

0 .0 2

0

0

1

2

3

4

5

6

7

8

9

10

Fig. 1.6: Esempio di due funzioni

gaussiane e della GMM ottenuta

come somma pesata delle due.

Le differenti tecniche di classificazione dei singoli pixel possono essere utilizzate per la

produzione della skin-map. Però essa non è sufficiente per garantire che un'area rappresenti

effettivamente un volto. Vanno quindi attuate delle tecniche di validazione che confermino se

l'area contiene o non contiene un volto. Le tecniche

utilizzate possono essere molto differenti ma nella

maggioranza dei casi si basano sulla ricerca di elementi

caratteristici di un volto: occhi, orecchie, naso e bocca.

Alcuni approcci come quello proposto da Li Zou e

Kamata [7] prevedono l'utilizzo di modelli gaussiani

misti per rintracciare le aree dell'immagine che

Fig. 1.7: Skin map ottenuta

contengono pixel con colorazione similare a quelli della assegnando ai pixel il valore di

pelle. Estratte tutte le sotto aree dell'immagine probabilità condizionata.

15

Stato dell'arte

compatibili con la presenza di un volto, queste vengono analizzate con l'algoritmo Viola-Jones

per determinare se lo contengono. Le immagini in scala di grigi rappresentano la probabilità

che il pixel appartenga al colore pelle mentre nella formulazione originale sono la

trasposizione in scala di grigi dell'immagine a colori.

Di seguito viene riportato un esempio di tre volti codificati in scala di grigi in base alla

probabilità che il pixel sia di tipo pelle.

1.2.2 Algoritmo Viola-Jones

L'algoritmo proposto da Viola e Jones [3] e modificato successivamente da Lienhart e Meydt

[10] propone un framework basato su tecniche di machine learning. Risulta essere un sistema

molto robusto ed estremamente rapido per il rilevamento di volti e più in generale di oggetti.

L'algoritmo è caratterizzato da tre componenti fondamentali:

•

Integral Image: è una elaborazione dell'immagine di input finalizzata al

miglioramento della velocità di calcolo delle Haar like feature. Questa ricodifica delle

informazioni consente un tempo costante per il calcolo delle feature.

•

Haar like feature: è un meccanismo di estrazione delle feature da un'immagine basato

sulle Haar wavelet, viene proposto per un generico sistema di object detection [9].

•

AdaBoost: si tratta di un algoritmo di machine learning che, correttamente addestrato,

è in grado di determinare il confine tra due differenti classi. Nel caso dell'algoritmo

Viola-Jones, per aumentarne le prestazioni, ne viene proposta una variante.

L'approccio proposto da Viola-Jones risulta avere delle prestazioni molto valide per uso anche

in contesti di tipo real-time.

Le immagini di input per tale algoritmo possono essere a colori o in scala di grigi. Nel caso di

immagini a colori si dovrà provvedere ad una conversione in scala di grigi. Se utilizzassimo lo

spazio di colori YCrCb sarebbe sufficiente prendere in considerazione esclusivamente il

canale Y, che rappresenta la componente relativa alla luminosità, ed escludere gli altri due

canali.

L'immagine in scala di grigi di input subisce una trasformazione che ricodifica le

informazioni dei singoli pixel per creare la Integral Image, anche chiamata Summed Area

Tablet.

Le modifiche all'algoritmo invece fatte da Lienhart e Meydt portano all'introduzione del

16

Stato dell'arte

concetto di Rotated Summed Area Tablet. Ovvero una seconda codifica dell'immagine, da

affiancare alla Integral Image, finalizzata ad incrementare le prestazioni dell'algoritmo con

l'uso di particolari haar-like feature, ruotate rispetto a quelle originariamente proposte da

Viola-Jones.

La formula per il calcolo della Integral Image è la seguente:

∑

sat ( x , y)=ii( x , y)=

i( x ' , y ' ) [3][10 ].

x ' ≤x , y '≤ y

Mentre la formula per il calcolo della Rotated Summed Area Tablet è:

rsat (x , y)=

∑

i( x ' , y ' ) [10].

x '≤x , y' ≤ y−∣x−x '∣

Con le variabili x e y si indicano le coordinate di un pixel all'interno dell'immagine da

elaborare, indicata con la lettera i. Come è facile comprendere, ogni pixel della nuova

immagine conterrà la somma di tutti i pixel con valori di x ed y inferiori a quelli del punto da

calcolare. La matrice che ne risulterà avrà dunque le stesse dimensioni dell'immagine di

partenza ma l'informazione verrà espressa in maniera differente.

Nell'immagine seguente (Fig. 1.8) è riportata una rappresentazione grafica della Integral

Image e della Rotated Summed Area Tablet. L'area evidenziata rappresenta la sotto area

dell'immagine originale che contribuisce a determinare il valore di ii(x,y) e rsat(x,y).

Fig. 1.8: Esempio di Summed Area Tablet e della versione

ruotata.

Per rendere più efficiente il calcolo della Integral Image è possibile utilizzare le seguenti

espressioni ricorsive:

s (x , y)=s ( x , y−1)+i ( x , y) ;

ii( x , y)=ii( x−1, y)+ s(x , y) ;

con condizioni iniziali:

s (x ,−1)=0 ;ii (−1, y)=0 ;

deve s(x,y) è la somma cumulativa delle righe.

17

Stato dell'arte

Sono disponibili delle formule analoghe che consentono di calcolare la Rotated Summed Area

Tablet solamente con due passaggi sopra ogni pixel.

Il primo passaggio viene eseguito da sinistra a destra e dall'alto verso il basso, la formula

corrispondente è:

rsat (x , y)=rsat ( x−1, y−1)+rsat (x−1, y )+i ( x , y)+rsat (x−2, y−1) ;

il secondo passaggio viene eseguito da destra verso sinistra e dal basso verso l'alto, la formula

è:

rsat (x , y)=rsat ( x , y)+rsat (x−1, y+1)−rsat ( x−2, y) ;

le condizioni iniziali sono:

rsat (−1, y)=rsat (−2, y )=rsat (x ,−1)=0 .

La Integral Image e la Rotated Summed Area Tablet sono necessarie per calcolare in maniera

rapida la somma dei pixel contenuti in un rettangolo all'interno dell'immagine. Nel caso di

Rotated Summed Area Tablet i rettangoli da calcolare sono ruotati di 45°. Nell'immagine

seguente è riportata una rappresentazione grafica di come avviene il calcolo del rettangolo

scuro.

Fig. 1.9: Immagine che esemplifica come avviene il calcolo

della sotto area evidenziata.

La formula per il calcolo della somma dei pixel del rettangolo per Integral Image è:

RSum( x , y , w , h)=ii (x−1, y−1)+ii( x+w−1, y+h−1)

−ii( x−1, y+h−1)−ii( x+w−1, y−1) .

Mentre la formula per Rotated Summed Area Tablet è:

RSum( x , y , w , h)=rsat ( x+w , y+w)+rsat (x−h , y+h)

−rsat (x , y)−rsat ( x+w−h , y+w+h) .

I rettangoli sono descritti da x e y che rappresentano le coordinate del vertice alto del

rettangolo e da h e w che rappresentano altezza e larghezza del rettangolo nel caso della

Integral Image. Mentre per la Rotated Summed Area Tablet h e w sono le proiezioni di altezza

e larghezza del rettangolo. Nell'immagine seguente è possibile vedere graficamente cosa

18

Stato dell'arte

rappresentano i diversi parametri.

Fig. 1.10: Esempio di rettangolo verticale e del corrispondente

rettangolo ruotato di 45 gradi

La rappresentazione dell'immagine come Integral Image e Rotated Summed Area Tablet

consente una maggior rapidità di calcolo delle haar-like feature. Infatti per poter calcolare le

feature sarebbe stato necessario determinare ad ogni passo la somma di pixel di aree

dell'immagine, processo computazionalmente molto oneroso se ripetuto a diversa scala e

posizione, come nel caso delle haar-like feature.

Nodo fondamentale per l'algoritmo è il meccanismo di estrazione delle feature. La tecnica

adottata prende il nome di haar-like feature e deriva dal filtro haar [9]. In questo filtro sono

presenti tre tipi di wavelet che hanno un significato molto preciso:

•

la wavelet verticale, che codifica la differenza di intensità media di due regioni

verticali adiacenti, è quindi è in grado di estrarre i bordi verticali presenti in

un'immagine;

•

la wavelet orizzontale, che codifica la differenza di intensità media di due regioni

orizzontali adiacenti, estrae perciò i bordi orizzontali presenti nell'immagine;

•

la wavelet diagonale, che è invece il risultato della combinazione delle altre due

wavelet in quanto estrae i bordi diagonali da un'immagine.

Fig. 1.11: Esempio delle tre haar

fondamentali.

19

Stato dell'arte

Le ragioni fondamentali che determinano la scelta delle Haar wavelet sono:

•

la codificazione delle differenze di intensità media tra regioni con diversi orientamenti,

consentendo un'analisi con più scale [9]. Tali differenze dovrebbero essere invariabili e

quindi identiche per tutte le immagini rappresentanti volti.

Nell'algoritmo Viola-Jones si usano immagini di volti di 20x20 e si generano tutti i

possibili coefficienti modificando le dimensioni delle wavelet dalla dimensione

minima alla massima contenibile nell'immagine.

•

l'uso di un insieme di coefficienti haar che permette di propagare i vincoli tra le

regioni confinanti e descrivere modelli complessi [9]. I coefficienti haar vengono

calcolati in tutte le possibili posizioni e dimensioni all'interno di un'immagine

generando una quantità elevata di feature.

Nella figura riportata a fianco (Fig. 1.12) sono rappresentate quattro immagini in scala di

grigi. La prima in alto a sinistra contenente l'immagine

originale, le altre tre rappresentano i coefficienti haar

calcolati sull'immagine originale.

Per ottenere le immagini dei coefficienti sono state applicate

le wavelet haar con dimensione 2x2 pixel in tutte le possibili

posizioni all'interno dell'immagine originale. Quelle così

ottenute sono state rappresentate in scala di grigi dove il

colore nero rappresenta un coefficiente negativo, il colore

bianco un coefficiente positivo e il grigio il valore zero.

Fig. 1.12: Immagine dei

coefficienti ottenuti

In questa figura le immagini sono relative a:

applicando le wavelet

• la wavelet verticale (in alto a destra), marca sull'immagine in alto a

sinistra.

nettamente la riga verticale e meno intensamente

quella obliqua, tralasciando completamente la riga orizzontale;

•

la wavelet orizzontale (in basso a sinistra), marca nettamente la retta orizzontale e

meno intensamente quella obliqua, tralasciando completamente la riga verticale;

•

la wavelet diagonale (in basso a destra), marca nettamente la riga obliqua tralasciando

le altre due righe. In oltre evidenzia il punto di incontro tra la riga orizzontale e quella

verticale.

Le wavelet basilari sono solamente tre, mentre le haar-like proposte da Viola e Jones sono in

numero superiore per codificare un maggior numero di situazioni.

20

Stato dell'arte

Il set ha subito poi un'estensione ulteriore de parte di Lienhart e Meydt con l'introduzione di

haar-like ruotate di 45° rispetto alle originarie. Questa estensione ulteriore ha richiesto

l'impiego della Rotated Summed Area Tablet descritta in precedenza.

Nell'immagine seguente (Fig. 1.13) sono raffigurati tutti i possibili prototipi del set esteso di

haar-like. L'algoritmo Viola-Jones faceva uso esclusivamente delle feature 1a, 1b, 2a, 2b, 2c,

2d e 4.

Fig. 1.13: Esempio di haar like feature verticali e ruotate.

Il set di haar-like è scelto per codificare al meglio tutte le possibili feature presenti all'interno

di un volto umano. Con delle semplici formule è possibile valutare quante ne possono essere

estratte da un'immagine campione di dimensioni WxH. Le formule sono le seguenti:

XY ∗(W +1−w∗(

XY ∗(W +1− z∗(

X +1

Y +1

))∗( H +1−h∗(

)) .

2

2

X +1

Y +1

))∗( H +1− z∗(

)) con z =w+h.

2

2

La prima è la generica formula per haar-like normali mentre la seconda è la formula per il

caso delle haar-like ruotate di 45°. Con i valori w e h si intendono le dimensioni minime di

altezza e larghezza della haar-like presa in considerazione. Il termine X rappresenta il

rapporto tra larghezza dell'immagine e larghezza minima della haar-like (X= W/w).

Analogamente Y rappresenta il rapporto tra altezza dell'immagine e altezza minima della

21

Stato dell'arte

haar-like (Y=H/h).

Nella tabella riportata di seguito ci sono tutte le informazioni per calcolare le cardinalità delle

feature estraibili da un'immagine di dimensione 24x24 pixel utilizzando tutte le haar-like

descritte in precedenza.

Feature

w/h

X/Y

#

1a : 1b

2/1 : 1/2

12/24 :24/12 43200

1c : 1d

2/1 : 1/2

8/8

8464

2a : 2c

3/1: 1/3

8/24 : 24/8

27600

2b : 2d

4/1 : 1/4

6/24 : 24/6

20736

2e : 2g

3/1: 1/3

6/6

4356

2f : 2h

4/1 : 1/4

4/4

3600

3a

3/3

8/8

8464

3b

3/3

3/3

1521

4

2/2

12/12

69696

Type

Somma

187637

Tabella 1.1: Calcolo del numero delle feature estratte da un'immagine di

dimensioni 24x24 pixel.

Dunque da un'immagine di dimensioni 24x24 pixel è possibile estrarre un totale di 187637

feature. Tra tutte le feature estratte, verranno selezionate dall'algoritmo di apprendimento

solamente quelle che garantiscono una maggior capacità di discriminare tra due classi.

La parte fondamentale dell'approccio Viola-Jones è proprio quella dell'algoritmo utilizzato per

distinguere tra le classi volti e non volti.

L'algoritmo scelto è AdaBoost ma ne viene elaborata una versione che consenta, in fase di

apprendimento, di selezionare l'insieme delle feature che garantiscono la massima

discriminazione tra le due classi. Infatti sarebbe proibitivo scegliere di discriminare un volto

da un non volto apprendendo per intero più di 180000 feature per ogni immagine campione

usata.

L'algoritmo proposto si basa sull'ipotesi di costruire una combinazione lineare pesata di

classificatori deboli. Ogni classificatore debole si limita ad utilizzare una singola feature.

Dunque verrà selezionato ad ogni passo il classificatore debole che garantisce la maggiore

discriminazione tra le due classi.

22

Stato dell'arte

La formula che esprime il classificatore debole è:

h j ( x)= 1

0

p j f j (x)< p j θ j .

altrimenti

Dove fj rappresenta la feature, θj rappresenta la soglia e pj la direzione della disuguaglianza.

La formulazione dell'algoritmo di apprendimento è la seguente:

•

Dato un training set (x1,y1),...,(xn,yn) con yi = 0,1 rispettivamente per esempi negativi e

positivi.

•

Inizializzare i pesi w 1, j =1/2 m

per gli esempi negativi, dove m rappresenta la

cardinalità degli esempi negativi e w 1, j =1/2 l per gli esempi positivi, dove l

rappresenta la cardinalità degli esempi positivi.

•

Per t = 1,...,T dove T è il numero di classificatori deboli

1. Normalizzare i pesi,

w t , j=

wt , i

n

∑ wt, j

j=1

2. Selezionare il miglior classificatore debole in base all'errore pesato

ϵt =min f , p , θ ∑ w i∣h(x i , f , p ,θ)− y i∣

i

3. ht(x) = h(x,ft,pt,θt) sarà quello con il minor errore ϵt

4. Aggiornare i pesi

ϵt 1−e

w t+1, j =w t , i +(

)

1−ϵt

i

Dove ei = 0 se l'esempio xi è stato classificato correttamente altrimenti ei = 1.

•

Il classificatore finale è:

C ( x)= 1

0

dove α t=log (

T

T

∑ α t ht (x)≥12 ∑ αt

t=1

t=1

altrimenti

1−ϵt

)

ϵt

23

Stato dell'arte

La procedura di apprendimento appena descritta è solamente una parte dell'algoritmo

completo. Infatti l'algoritmo di apprendimento prevede una cascata di classificatori pesati con

lo scopo di rendere il procedimento decisionale incrementale.

Ad ogni stage della cascata di classificatori aumenta il numero delle feature che vengono

valutate. Per passare da uno stage al successivo è necessario che nello stage a monte si sia

ottenuto un responso positivo dal classificatore pesato, cioè che le feature valutate in quello

stage sono classificabili come appartenenti ad un volto.

Se il responso del classificatore pesato è negativo si interrompe la cascata e si respinge la

sotto area dell'immagine perché non contiene un volto.

Se invece si termina la cascata di classificatori ottenendo un responso positivo in tutti gli

stage, la sotto area dell'immagine viene classificata come volto.

Fig. 1.14: Esempio della cascata di classificatori. Ogni nodo uno stage

della cascata.

Nella figura seguente (Fig. 1.15) possiamo vedere le feature che sono state prescelte per i

primi tre stage della cascata di classificatori, tendono ad aumentare ad ogni passaggio.

Fig. 1.15: Haar feature usate per l'apprendimento

dei primi 3 stage della cascata di classificatori.

24

Stato dell'arte

Il numero degli stage che devono essere attraversati prima di ottenere il responso definitivo

dipende dal livello di accuratezza che si richiede all'algoritmo. Infatti ad ogni stage si

mantiene invariata la percentuale di riconoscimenti corretti mentre si diminuisce la possibilità

che si verifichi un falso positivo.

La cascata di classificatori viene eseguita in tutte le possibili finestre contenute nell'immagine.

Si sposta la finestra all'interno dell'immagine partendo dall'angolo in alto a destra e

spostandosi dall'alto verso il basso e da destra verso sinistra. Inoltre si parte dalla minima

dimensione possibile e si scala la finestra di ricerca fino alla massima contenibile

nell'immagine. La minima grandezza della finestra di ricerca è data dalla dimensione delle

immagini di volti e di background che vengono utilizzati per l'apprendimento. Solitamente le

dimensioni sono di 20x20 o di 24x24 pixel.

1.3 Face Recognition

Riconoscere un individuo significa confrontare il volto estratto da un'immagine con un

insieme di volti campione che fanno parte di un database. Se si verifica tale corrispondenza si

deve indicare l'individuo altrimenti si dichiara che è sconosciuto.

É evidente che il costo per identificare un volto cresce all'aumentare del numero dei soggetti

presenti nel database. Alcuni metodi possono funzionare semplicemente con un'immagine

campione per ogni individuo mentre altri richiedono che un soggetto sia rappresentato da un

maggior numero di volti.

Possiamo dividere gli approcci atti a riconoscere un volto in due classi [17]:

•

Holistic Method: considera il volto umano come un segnale unico. Quindi lo

interpreta e lo elabora nella sua interezza. Fanno parte di questa metodologia le

tecniche derivate principal component analysis (PCA) e Fisher's linear disciminate

(FLD).

•

Local Method: il volto umano viene elaborato e vengono estratte delle feature locali

che vengono utilizzate per riconoscerlo. In questa categoria possiamo inserire le

tecniche basate sulle Scale Invariant Feature Trasform (SIFT) e Elastic Bunch Graph

Matching (EBGM).

In realtà esiste un terza classe di metodologie derivata dalla fusione delle feature di tipo locale

e di quelle di tipo globale. Tale metodologia dovrebbe garantire migliori prestazioni. Un

25

Stato dell'arte

esempio di utilizzo di feature globali e locali è proposto da Chowdhury, Sing, Basu e Nasipuri

[18].

Di seguito verranno presentate le tecniche PCA, SIFT, EBGM e quella ibrida proposta da

Chowdhury, Sing, Basu e Nasipuri.

1.3.1 Principal Component Analysis

L'analisi delle componenti principali (PCA) è uno strumento della statistica multivariata

proposto da Karl Pearson nel 1901 e sviluppato da Harold Hotelling nel 1933. E' una tecnica

utilizzata in ambiti economici, sociali, matematici e ingegneristici, prende anche il nome di

“trasformata di Karhunen-Loève” (KLT).

Lo scopo di tale tecnica è quello di ridurre le dimensioni di un fenomeno tramite l'estrazione

di

una

ristretta

quantità

di

informazioni

che,

se

ricostruite,

devono

garantire

un'approssimazione valida del fenomeno di partenza.

L'obiettivo è dunque quello di passare da uno spazio N-dimensionale ad uno spazio Mdimensionale con M < N. Questa riduzione di dimensioni determina una riduzione della

complessità del problema.

In termini di statistica multivariata significa che, partendo da dati con matrice di covarianza

non diagonale e in uno spazio N-dimensionale, si cerca uno spazio di dimensione inferiore ad

N in cui la matrice di covarianza è diagonale. In tal caso significa che non ci sono correlazioni

tra le variabili che descrivono il fenomeno. Per ottenere la diagonalizzazione è necessario

ruotare le coordinate in base agli autovettori. Se le variabili originarie sono correlate, alcuni

autovalori avranno un valore trascurabile e quindi gli autovettori associati a questi potranno

essere scartati [22].

26

Stato dell'arte

Fig. 1.16: Esempio di come avviene la riduzione di dimensione dello spazio

tramite l'utilizzo della tecnica di analisi delle componenti principali.

Come possiamo intuire, si tratta di una tecnica del tutto generale che può essere applicata in

qualsiasi contesto per ridurre la complessità delle informazioni legate ad un fenomeno.

E' largamente usata per l'identificazione di volti è può essere combinata a altre tecniche di

estrazione di feature[18] o come tecnica principale [20] [21].

L'applicazione diretta della tecnica PCA prende il nome di eigenface [20] [21]. Cerca di

estrarre e valutare le differenze tra i volti appartenenti a un gruppo per poterli codificare e

comparare con altri esterni attraverso meccanismi olistici.

La metodologia si propone di trovare un insieme di immagini, chiamate eigenfaces, che

consenta di rappresentare tutto il database di volti. Ognuno sarà rappresentato, in maniera

approssimata, da una combinazione lineare pesata di più eigenfaces. In termini di analisi dei

componenti principali si vogliono trovare gli autovettori dominanti, cioè quelli legati agli

autovalori maggiori, della popolazione di volti contenuti nel database.

Un nuovo volto rilevato sarà dunque codificato come combinazione lineare di eigenfaces e i

pesi potranno esser utilizzati per identificare il soggetto. Questo può avvenire semplicemente

con l'uso di una funzione che calcola la distanza geometrica.

Nella figura seguente (Fig. 1.17) l'immagine di destra rappresenta l'insieme delle eigenfaces

che sono state selezionate a partire dal database rappresentato nell'immagine di sinistra.

27

Stato dell'arte

Fig. 1.17: Esempio di immagini di volti che compongono un database (a) e

insieme delle eigenfaces ricavate dal database (b).

La procedura per effettuare un riconoscimento può dunque essere schematizzata nel seguente

modo:

•

a partire da un database di immagini di apprendimento vengono calcolate le

eigenfaces che costituiranno lo spazio dei volti;

•

il volto da identificare viene proiettato nello spazio dei volti e viene calcolato il vettore

dei pesi;

•

usando il vettore dei pesi si definisce se il soggetto appartiene al database e a che

identità corrisponde.

La parte fondamentale di questa metodologia è quella del calcolo delle eigenfaces, vediamo

come ciò avviene.

Per prima cosa dobbiamo considerare un'immagine di NxM pixel come un vettore di

dimensioni (N*M). Tale vettore si ottiene come concatenazione di tutte le righe di

un'immagine. Dunque una di dimensione 256x256 pixel darà luogo ad un vettore di 65536

elementi, ovvero ad un punto in uno spazio (MxN)-dimensionale.

Poiché tutti i volti presentano caratteristiche simili, si andranno a concentrare in un

sottospazio limitato. Il PCA si occuperà appunto di ridurre la dimensione di tale spazio.

Il primo passo per l'individuazione delle eigenfaces è il calcolo del volto medio. Questo

passaggio è fondamentale perché, come abbiamo già detto, l'obiettivo è quello di codificare le

differenze tra i volti. La formula è:

28

Stato dell'arte

Ψ=

1

M

M

∑ Γn

n= 1

dove Γ 1 , Γ2,... , Γ M sono gli M volti che compongono il training set. Ogni volto differirà

dunque dal volto medio del valore Φ n=Ψ−Γn .

A partire dalle informazioni così codificate sarà necessario calcolare la matrice di covarianza

al fine di estrarre gli autovettori e gli autovalori. La formula è la seguente:

1

C=

M

dove

M

∑ Φn ΦTn = AAT

n=1

A=[ Φ1 ,Φ 2 , ... ,Φ n ] .

Dalla matrice di covarianza è possibile calcolare gli autovettori

(μ k )

utilizzando il metodo

Jacobiano [20]. Dunque la formula è la seguente:

1

λ k=

M

M

∑ (μTk Φn)2

n=1

che è massimizzata quando:

T

l

μ μk=

{

1

0

se l=k

alrimenti

Si sceglierà quindi un sottoinsieme di autovettori che massimizza gli autovalori. In questo

modo si approssima la rappresentazione di ogni singolo volto ma al contempo si riduce la

complessità del problema. Dunque se il set completo di immagini di apprendimento è

composto da M=115 volti, si è stimato che M' = 40 determina un errore del 2%. M' è il

numero di autovettori selezionati.

Una volta definite le eigenfaces è possibile utilizzare il sistema per classificare un nuovo

volto. Esso deve essere proiettato nello spazio generale calcolando il vettore di pesi associato.

Il calcolo di ogni peso si effettua con la seguente formula:

ωn =μ n (Γ−Ψ )

n=1,..., M'

dove Γ rappresenta il volto da identificare. Il vettore dei pesi sarà dunque:

Ω=[ ω1 , ω2 ,... , ω M ' ]

Un volta ottenuto il vettore dei pesi è possibile classificare il volto di input. Per fare questo è

necessario confrontare tutti i vettori dei pesi, associati ai volti nel database, con il vettore

appena estratto. Si calcola la distanza euclidea tra i due vettori e si determina l'appartenenza

29

Stato dell'arte

ad un soggetto solo quando questa distanza è al di sotto di una soglia prefissata.

La formula per il calcolo è la seguente:

ε2k =∥Ω−Ωk∥2

k =1, ..., M

dunque se εk ⩽θϵ è classificato come la faccia k-esima.

Può inoltre essere definita una distanza dal sottospazio dei volti. Questa indicherà se

l'immagine di input contiene effettivamente un volto. Dobbiamo quindi calcolare un vettore

dei pesi del volto medio, e la formula è:

M'

Φ f = ∑ ω n μn .

n=1

Il calcolo della distanza è:

ε=∥Ω−Ω f ∥2 .

Come nel caso precedente si fissa una soglia θ che definisce se un'immagine di input

appartiene o meno allo spazio dei volti.

Il vettore dei pesi di un volto può essere visto come un punto in uno spazio M'-dimensionale.

Dunque un insieme di vettori peso possono essere utilizzati come set di apprendimento per

algoritmi di classificazioni, ad esempio SVM [18].

1.3.2 Elastic Bunch Graph Matching

Si tratta di una tecnica basata sulla ricerca di corrispondenza tra grafi rappresentativi di un

volto. Tale tecnica proposta da Wiskott, Fellous, Kuiger, e von der Malsburg [19] fa uso di un

grafo composto da archi e nodi. Ogni nodo è etichettato da un jet: l'insieme di coefficienti di

filtri di Gabor, con diversa scala e orientamento, applicati alla parte di immagine individuata

dal nodo. Gli archi a loro volta sono etichettati con la distanza tra due nodi.

Fig. 1.18: Esempio di adattamento del grafo su volti in pose

differenti.

30

Stato dell'arte

La proprietà principale dei grafi è rappresentata dalla facilità di manipolazione, difatti essi

possono essere traslati, ruotati, ridimensionati e deformati elasticamente. Nella figura

precedente si può notare che possono essere acquisiti in condizioni di posa differenti, così da

risultare diversi per geometria e per le feature locali.

Per mappare un grafico è necessario prendere in considerazione alcuni punti caratteristici che

prendono il nome di fiducial point. Generalmente questi punti sono le pupille, gli angoli della

bocca, le estremità del naso e tutte le possibili aree di particolare interesse.

Inoltre l'uso dei grafi consente la definizione di relazioni tra nodi appartenenti a grafi in pose

del volto differenti. In questo modo si aumenta la possibilità di identificazione corretta.

Poiché può risultare computazionalmente molto costoso rappresentare ogni combinazione di

feature attraverso grafi separati, si introduce il face bunch graph (FBG). E' una struttura

similare ad uno stack dove tutti i modelli di un grafo hanno la stessa struttura e i nodi si

riferiscono agli stessi fiducial point. Un insieme di jet riferiti ad un fiducial point prende il

nome di bunch. Ad esempio quello riferito al fiducial point di un occhio conterrà jet riferiti

agli occhi chiusi, aperti, maschili e femminili, al fine di coprire tutte le possibili casistiche.

Nella figura seguente è possibile osservare il grafo FBG. Ad ogni nodo è assegnato un bunch

composto da 6 differenti jet. In grigio sono evidenzianti quelli che sono stati selezionati

durante l'analisi di un'immagine sconosciuta.

Fig. 1.19: Esempio di FBG che fornisce

una rappresentazione generale di un

volto. Gli stack di dischi rappresentano i

jet.

31

Stato dell'arte

L'etichettatura iniziale dei fiducial point deve essere eseguita manualmente finché non si ha

un campione di grafi abbastanza grande. Quando FBG conterrà all'incirca 70 grafi non sarà

più necessario aggiungerne di nuovi. Infatti con un'etichettatura manuale di 6 grafi si ha che,

se il grafo contiene 9 nodi come nella figura precedente, FBG sarebbe potenzialmente in

grado di rappresentare 69 volti differenti. Viene così creato un FBG per ogni possibile posa.

Gli archi che compongono il modello FBG vengono etichettati con i valori medi ottenuti dai

grafi delle immagini campione utilizzate.

La procedura per il riconoscimento di una nuova immagine è la seguente:

•

Sul volto incognito vengono posizionati i fiducial point in modo che:

1. corrispondano a particolari feature;

2. sia massimizzata la similarità del grafo con un FBG. Per valutare la similarità tra

due grafi si utilizza la seguente formula:

1

S (G , B)=

N

G

B 2

( Δ ⃗x e −Δ ⃗x e )

(S ϕ ( J , J ))− λ ∑

∑ max

E e

m

( ⃗x eB )2

n

G

n

Bm

n

m=1,... , M

con n=1,... , N

e=1,... , E

Dove con B si indica un FBG che contiene M esempi con N nodi ed E archi. Con

G si indica il grafo rilevato dall'immagine da identificare. La prima parte della

formula descrive la similarità tra jet mentre la seconda parte è il termine che fa

riferimento alla topografia del grafo. Il termine λ indica l'importanza da attribuire

al temine che compara le topografie dei grafi.

La formula che descrive la similarità tra due jet è la seguente:

∑ a j a j ' cos(ϕ j −ϕ j ' − ⃗d k⃗j )

S ϕ ( J , J ' )=

j

√∑ a ∑ a '

2

j

j

j

j

2

()

a 1 ei ϕ

...

J = a j ei ϕ

...

iϕ

a 40 e

1

j

40