NIHIL SUB ASTRIS NOVUM

N.

13

– 09 NOVEMBRE 1997

a cura di Cristina Bernasconi, Elia Cozzi e Massimo Zoggia

–––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––

A Newsletter of

Gruppo Astrofili “Giovanni e Angelo Bernasconi”

Via S. Giuseppe, 34–36

21047 Saronno (VA)

Italy

http://www.pangea.va.it/Bernasconi

–––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––

ALTEZZA E AZIMUT DI PRIMA VISIBILITÀ DELLE STELLE

di A. Gaspani ([email protected])

Nel campo dell’Archeoastronomia la letteratura relativa all’esistenza vera o presunta, in taluni siti, di allineamenti diretti verso il

punto di levata o di tramonto di oggetti astronomici è abbondante. Capita spesso di leggere che talune linee di pietre o buche di palo

sarebbero orientate verso il punto di sorgere o di tramonto del Sole, della Luna o di qualche stella luminosa in corrispondenza di qualche

data o posizione particolare. Il Sole e la Luna sono astri molto luminosi che possono essere osservati non appena il loro lembo superiore fa

capolino al limite dell’orizzonte locale apparente o di quello fisico se nel luogo considerato esistono dei rilievi che si elevano di alcuni

gradi sopra l’orizzonte astronomico. Talvolta si legge anche di orientazioni stellari e generalmente nella letteratura viene preso in

considerazione, dopo le debite correzioni per la rifrazione atmosferica, l’azimut di levata della stella all’orizzonte astronomico locale.

In realtà un simile approccio non è metodologicamente corretto in quanto non vengono quasi mai presi in considerazione gli effetti

dell’estinzione atmosferica la quale gioca un ruolo determinante facendo si che la stella diventi visibile solamente quando la sua altezza

rispetto all’orizzonte astronomico locale abbia già raggiunto un consistente valore, che chiameremo in questa sede “altezza di prima

visibilità”, abbreviata in HPV. La HPV dipende grosso modo dalla trasparenza dell’atmosfera in prossimità dell’orizzonte in direzione

della stella che sorge e dalla sua magnitudine visuale apparente.

In letteratura possiamo trovare il termine “angolo di estinzione” per designare HPV e qualche studio relativamente ad esso è stato fatto

in passato. L’archeoastronomo A. Thom (1967) propose una semplice regola messa a punto da O. Neugebauer sulla base di antiche

osservazioni stellari registrate su tavolette babilonesi. La regola di Thom–Neugebauer ci dice che una stella di magnitudine visuale “m”

diverrà visibile nel cielo mattutino ad un’altezza sull’orizzonte approssimativamente pari alla sua magnitudine visuale. In questo modo una

stella di prima magnitudine diverrà visibile a 1 grado di altezza sull’orizzonte astronomico locale. Una di seconda magnitudine sarà

visibile a due gradi e cosi via. Al tramonto le cose si invertono nel senso che la stella di seconda magnitudine sparirà al tramonto a due

gradi dall’orizzonte, quella di prima grandezza ad un grado e così via.

La dipendenza di HPV dalla trasparenza atmosferica può essere tecnicamente quantificata mediante il coefficiente di estinzione

atmosferica K nella banda visuale, ben noto a chi lavora nel campo della fotometria fotoelettrica. I fotometristi sanno determinare

sperimentalmente notte per notte il valore di K, per le lunghezze d’onda di osservazione, ma volendo stimare l’azimut di prima visibilità di

una stella ad esempio 3000 anni fa, nessuna determinazione sperimentale è ovviamente possibile.

Gli effetti dell’estinzione atmosferica agiscono grosso modo sul cammino dei fotoni provenienti dalla stella attraverso tre differenti

strati all’interno dell’atmosfera terrestre. Il primo strato importante è quello della fascia di ozono a circa 20 Km di altezza dal suolo, il

secondo è quello che si stende a circa 8.2 Km di quota e contribuisce al cosiddetto “Rayleigh scattering” e il terzo è lo strato degli aerosol,

posizionato a circa 1500 metri di altezza e in cui possiamo trovare particelle di acqua nebulizzata, polveri portate dal vento, pollini degli

alberi e altre particelle solide che interagiscono con la luce che giunge dalla stella.

In letteratura è possibile reperire alcuni modelli utili alla quantificazione degli effetti di estinzione attraverso i vari strati. Ad esempio

Hayes e Latham (1975) si sono occupati di tutte e tre le zone, Bower e Ward (1982) si sono occupati dello strato di ozono e vari autori, tra

i quali Shafer (1993) si sono occupati dello strato in cui predominano gli aerosol.

Una formula rigorosa e chiusa per mettere in relazione “m” e “Kv” non esiste, ma esistono dati sperimentali e dati di simulazione al

computer ottenuti da Schafer e Liller (1990) a cui è possibile fare riferimento. Al fine di stabilire un algoritmo di calcolo pratico

sufficientemente semplice risulta molto utile applicare una rete neuronale artificiale e addestrarla sui dati sperimentali disponibili sia

derivanti dalle simulazioni che dalle osservazioni chiedendo ad essa di ottimizzare una forma funzionale approssimata, ma

sufficientemente accurata. Esaminando i modelli messi a punto da questi autori siamo in grado di estrarre le informazioni che ci

permettono di mettere a punto la topologia iniziale (mesostruttura) della rete neuronale artificiale da addestrare in modo che

l’approssimazione ottenuta permetta di predire con un buon margine di affidabilità l’altezza di prima visibilità delle stelle in funzione

della loro magnitudine e di alcuni parametri atmosferici locali e dell’incertezza con cui la valutazione di HPV è possibile. Nota HPV la sua

conversione nell’“azimut di prima visibilità” ad una data latitudine geografica diventa solamente una questione di semplice calcolo

trigonometrico.

Impiegando le funzioni che descrivono la “massa d’aria” pertinenti a ciascun strato, è stato possibile mettere a punto un modello

numerico capace di fornire la HPV di una stella in funzione della sua magnitudine visuale apparente, della latitudine geografica e della

quota sul livello del mare del luogo e del tasso di umidità relativa dell’aria.

Il problema è comunque mal determinato e il grado di incertezza insito in esso è molto elevato, tale da richiedere l’utilizzo di

particolari tecniche matematiche di valutazione quali sono le reti neuronali artificiali dette a Link Funzionale, sviluppate per la prima volta

da Pao (1989) al fine di migliorare la potenza di calcolo delle reti neuronali artificiali, aumentandone la capacità di approssimare il

comportamento di sistemi nonlineari, diminuendone nel contempo il tempo richiesto dalla fase di apprendimento. Tornando al presente

problema, la mesostruttura ritenuta più efficiente per permettere alla rete neuronale artificiale di stimare HPV è stata la seguente:

1

a(1)

-1 o-----------[>-------------------------+

____

|

w(1)

| 1 |

c(1)

|

+----[>------| x |--[>-+

|

|

:

|____|

|

|

: . :

:

.

|

|

| . :

:

. _|___

__|__

|/

:

:

\|

| n(1) |

|

m o-- :

:

--| Σ |---[>--| Σ |-----> HPV

|\

:

:

/|_____|

|_____|

: . :

_:__ .

|

|||

|

:

| 5 |

|

||| F{z}=max(Ho,z)

+----[>------| x |--[>-+

|||

w(5)

|____|

c(5)

|||

|||

b(1)

|||

K o-----[>------------------------------+||

r(1)

||

-1 o-------------[>-----------------------+|

______

|

| 1/2 |

u(1)

|

H o----| x

|------[>-------------------+

|______|

Formata da una sottorete FLN a cinque link funzionali non lineari più un elemento sommatore e da un neurone addizionale con

attivazione a rampa capace di aggiungere gli effetti dovuti alla rifrazione atmosferica e alla quota del sito.

La fase di apprendimento ha permesso di arrivare alla determinazioni del seguente insieme ottimale di pesi:

a(1) = -2.01

b(1) = 0.36

c(1) = 1.2

c(2) = 0.36

n(1) = (K+0.35)

r(1) = R

u(1) = -0.95

c(3) = 0.072

c(4) = 0.0108

c(5) = 0.001296

w ( j) = (K − 0.4833) j

(j=1,...,5)

ottenuti minimizzando l’energia complessiva della rete.

Il modello proposto è quindi il seguente:

5

1

HPV = max H 0 , a (1) + b(1) ⋅K + n (1) ⋅∑ c( j) ⋅w ( j) ⋅m j − r(1) + u (1) ⋅H 2

j=1

in cui il peso sinaptico r(1) è il contributo R della rifrazione atmosferica, calcolato analiticamente più avanti, H è la quota del sito rispetto

al livello del mare (in Km), K è il coefficiente di estinzione atmosferica che misura il cammino ottico totale verso lo zenith e che è

misurato in magnitudini per unità di massa d’aria, H 0 è l’altezza apparente dell’orizzonte fisico rispetto a quello astronomico.

Il contributo dovuto alla rifrazione astronomica può essere valutato mediante la seguente relazione:

−

H

0.00467 ⋅P ⋅e 8.4

R=

7.31

(273 + T ) ⋅tan

H m + H + 4.4

m

in funzione della pressione atmosferica P (in millibar), della temperatura dell’aria T in °C, della quota dell’osservatore H (in Km) e

dell’elevazione H m che vale:

Hm

H

= max H 0 ,− 2.71 + 11.7 ⋅K + (2 ⋅K + 0.7) ⋅e (0.6⋅K + 0.29 )⋅m −

H p

1

2

che rappresenta l’altezza di prima visibilità, ottenuta trascurando la rifrazione atmosferica, in cui H p = 1.1 Km.

Il coefficiente di estinzione è legato alla profondità ottica “q” nel modo seguente:

2

K = 1.086 q

e al grado di trasmissione atmosferica T come segue:

K = –2.5 Log(T)

Il coefficiente K dipende dalla lunghezza d’onda della luce incidente e dai materiali predominanti nei vari strati di atmosfera

attraversati dalla luce della stella. Esso consta di tre distinte componenti, vale a dire: una componente che dipende dalla scattering di

Rayleigh ( K r ) che può essere facilmente determinato in funzione della lunghezza d’onda ( λ ) della luce incidente, della quota H

dell’osservatore e dell’indice di rifrazione dell’aria secondo quanto indicato da Hayes and Latham (1975):

K r = 113700 ⋅(n − 1) ⋅e

2

H

Hr

−

⋅λ4

che per le osservazioni visuali diventa ( λ =0.55 micron (V-band)):

K r = 0.1066 ⋅e

−

H

Hr

in cui H r =8.2 Km

La componente dovuta agli effetti dell’ozono stratosferico è determinabile in base ala modello di Bower and Ward (1982):

K 0 = 0.031 + 0.0041 ⋅[

f ⋅cos( A s ) − cos(3 ⋅f )]

dove “f” è latitudine geografica del sito e A s è l’Ascensione Retta del Sole la quale codifica le variazioni stagionali dello strato di Ozono.

L’ultima componente è quella dipendente dal contenuto di aerosol nella bassa atmosfera. Questo è di gran lunga il termine più

difficoltoso da valutare in quanto dipende da numerosissimi fattori quali la concentrazione delle polveri, dei pollini degli alberi dispersi

dal vento nell’atmosfera, dalle goccioline di acqua di mare nebulizzata nella bassa atmosfera e così via. Al contrario di oggi

l’inquinamento atmosferico può essere trascurato per quanto riguarda l’antichità. Nonostante queste difficoltà è possibile eseguire una

stima conveniente anche di questo fattore:

0.55

K a = 0.12 ⋅

λ

1

3

⋅e

−

H

Ha

4

0.32

⋅

1 − ln(S)

3

⋅(1 + 0.33 ⋅sin (A s ))

in cui S è il grado di umidità relativa dell’aria e H a vale 1.5 Km.

L’incertezza sulla valutazione di K a può essere stimata mediante la seguente semplice approssimazione:

e[

k (a )]= 0.01 + 0.4 ⋅K a

Il coefficiente di estinzione totale K vale quindi approssimativamente:

K = Kr + K0 + Ka

che tutto sommato rappresenta comunque un’approssimazione molto grossolana.

L’azimut di prima visibilità, FVA, sarà facilmente determinato mediante la seguente relazione trigonometrica:

sin(D ) − sin(f ) ⋅sin(HPV )

FVA = ar cos

cos(f ) ⋅cos( HPV )

dove D è la declinazione della stella che sorge.

L’Archeoastronomia si occupa prevalentemente di allineamenti diretti verso taluni punti dell’orizzonte, quindi gli oggetti celesti

interessati hanno generalmente altezze molto ridotte, qualche grado al massimo. È quindi facile rilevare che per astri bassi sull’orizzonte

l’effetto dello strato di aerosol a 1.5 Km di altezza è quello determinante e quindi il valore del coefficiente di estinzione generale K è

prevalentemente dominato dalle particelle solide disperse nell’atmosfera attraversata dai fotoni provenienti dall’astro che sta sorgendo o

tramontando.

L’intensità di luminosità di un astro osservato attraverso l’atmosfera è esprimibile mediante la seguente relazione matematica:

I = I 0 ⋅10− 0.4⋅Dm

In cui I 0 è la luminosità extraatmosfrica e Dm è la perdita di magnitudine causata dell’estinzione.

3

Per un astro molto basso sull’orizzonte, abbiamo una variazione della luminosità apparente proporzionale grosso modo a:

10 − 0.4⋅K⋅X

con un valore di massa d’aria X~40.

L’intensità di luminosità di un astro osservato molto basso sull’orizzonte è quindi approssimativamente calcolabile mediante la

seguente relazione matematica:

I = I 0 ⋅10 − 16⋅K

da cui appare chiaro che variando, ad esempio, K da 0.24 a 0.25 si ottengono variazioni di intensità di luminosità osservata visualmente

dell’ordine del 45%, quindi la sorgente più consistente di “fuzziness” sulle altezze (e quindi sugli azimut) di prima e ultima visibilità

proviene proprio dall’incertezza relativa a quello che succede nei primi 1500 metri di altezza dal suolo, dove il contributo degli aerosol è

dominante.

Bibliografia

Bower, F. A., Ward, R. B., 1982, “Stratospheric Ozone and Man”, CRC Press.

Hayes, D. S., Latham, D. W., 1975, Astrophys. J., Vol. 197, 593-601.

Pao Y. H., 1989, “Adaptive Pattern Recognition and Neural Networks” Addison Wesley, Reading, MA.

Shafer B. E., 1993, Vistas in Astronomy, Vol.36, pp. 311-361.

Thom, A., 1967, “Megalithic Sites in Britain”, Clarendon Press, Oxford.

UN POKER D’ASSI: UFO, CIARLATANI, CACCIA

ALLE STREGHE E FORMULA 1

Molto spesso (troppo spesso) mi chiedo se alle soglie del

Terzo Millennio il livello culturale degli italiani sia rimasto

quello di 65 milioni di anni fa (Stupidaurus Rex) o sia

peggiorato. E’ praticamente impossibile elencare gli

innumerevoli argomenti che giustificano questa mia

affermazione, mi limiterò ad una breve digressione lasciando ad

ognuno di Voi il dovere di meditare sulla reale situazione dei

fatti, che probabilmente è ancora più grave di quanto appare a

prima vista.

Il primo argomento di discussione trae spunto da un

comunicato del Comitato Italiano per il Controllo delle

Affermazioni sul Paranormale (CICAP) che riporto

testualmente.

PSEUDOSCIENZA ALL’UNIVERSITÀ

All’Istituto di Igiene dell’Università di Padova sta per

iniziare un corso di bioarchitettura che prevede l’insegnamento

di alcune discipline totalmente prive di fondamento scientifico.

L’Università apre così le porte alla superstizione.

Gli scienziati aderenti al CICAP (Comitato Italiano per il

Controllo delle Affermazioni sul Paranormale), di cui fanno

parte tra gli altri i fisici Tullio Regge, Adalberto Piazzoli e

Giuliano Toraldo di Francia, il farmacologo Silvio Garattini,

l’astrofisica Margherita Hack e i premi Nobel Rita Levi

Montalcini e Carlo Rubbia, sono rimasti allibiti

nell’apprendere che dal mese di ottobre l’Università di Padova

ospiterà un corso di bioarchitettura in cui, mescolate a serie

ricerche sul binomio ambiente–architettura, verranno spacciate

per scientifiche delle assurdità quali i “nodi di Hartmann”, le

“geopatie” e il “Feng–Shui”, tre invenzioni del tutto prive di

credibilità scientifica. “La rilevazione dei cosiddetti nodi di

Hartmann”, spiega il fisico Roberto Vanzetto, “sembra possa

essere effettuata tramite le millantate capacità sensitive di un

“rabdomante”: nessun altro strumento scientifico, infatti, è in

grado di rilevare tali “nodi”. Tuttavia, tale rilevazione sarebbe

necessaria perché, a dire dei rabdomanti, la sosta prolungata

sopra uno di questi nodi provocherebbe una serie di malattie

gravissime. Il Feng–Shui, invece, è l’arte di arredare tenendo

4

conto delle “energie positive e negative” che si

sprigionerebbero dalla mobilia: secondo Stewart Park (un

luminare del Feng–Shui) una scrivania “disturbata”’ porta a

“problemi di lavoro e disaccordi familiari”. Le prove

dell’esistenza dei nodi di Hartmann, delle geopatie e degli

influssi dei mobili, tuttavia, sono del tutto inesistenti. Dal punto

di vista epistemologico queste trovate hanno la stessa dignità di

una discussione sulla pericolosità degli “stormi di mucche

volanti”. Una delle cose più negative del corso, che vanta la

collaborazione dell’Università di Padova”, continua il dr.

Vanzetto, “è che queste credenze pseudoscientifiche e

irrazionali vengono propinate assieme a temi di tutt’altra

caratura, tenuti da professori e ricercatori universitari che

probabilmente nulla sanno dei moduli didattici adiacenti ai

propri. Il rischio che si corre mettendo sullo stesso piano i nodi

di Hartmann e il piombo nell’aria, il Feng–Shui e la

radioattività del radon, è quello da una parte di legittimare le

pseudoscienze (ponendole a livello delle scienze) e dall’altra di

delegittimare le scienze (mescolandole con fantasie e

superstizioni assurde). Oltre a ciò si spingono le associazioni

ambientaliste (e i cittadini) a spendere denaro ed energie a

causa di allarmismi insensati, distogliendo così l’attenzione da

reali problemi di inquinamento e da reali pericoli per la

salute”. Il CICAP ha già inoltrato una protesta ufficiale presso

il magnifico Rettore dell’Università di Padova, presso il

direttore dell’Istituto di Igiene e presso il Preside della facoltà

di medicina.

Dopo un lungo periodo di “astinenza” per vari motivi, in

queste ultime sere ho ripreso a guardare le trasmissioni

televisive e, con profondo rammarico, devo constatare che il

livello culturale dei programmi è riuscito ad abbassarsi ancora

notevolmente; evidentemente una volta raggiunto il fondo si può

sempre scavare!! Non mi riferisco, in questo contesto, alle

normali trasmissioni demenziali, ma a quelle che dovrebbero

portare gli italiani ad una conoscenza più approfondita dei fatti

quotidiani. Ebbene, sembra che non ci sia sera senza una

trasmissione in cui si parli di nodi di hartmann (lo scrivo

minuscolo perché non meritano di più), di UFO, che, chissà

perché vengono associati esclusivamente ad esseri extraterrestri

trascurando completamente il vero significato della sigla, di

rabdomanti e di oroscopi.

Qualunque persona che abbia visto una bussola sa che le

linee del campo magnetico terrestre non escono

perpendicolarmente (come sostengono gli hartmanniani) dalla

superficie del pianeta (se si esclude la zona dei poli magnetici),

questo lo sapevano già i vichinghi!

Vi ricordate telescemenze? Il noto programma televisivo

trasmesso a reti unificate in ogni telegiornale ai tempi della

Hale–Bopp? La cometa che si allontanerà dalla Galassia (!) per

tornare tra 2000 anni? Ebbene, la Formula 1 era arrivata

all’ultima gara della stagione e così, per sapere in anticipo chi

avrebbe vinto, qualcuno ha ben pensato di rivolgersi agli

astrologi (vedi Tg2 delle 20:30 di giovedì 23 ottobre u.s.):

computer, ascendenti, pianeti, stelle, ecc., ed ecco la previsione:

“Il favorito è Schumacher”. Ops! E’ andata diversamente! Questi

astrologi non sono nemmeno fortunati perché non indovinano

neanche quando hanno il 50% di probabilità di non sbagliare.

Evidentemente le leggi fisiche che dominano le forze occulte

conosciute solo da loro non hanno molta conferma sperimentale.

Ognuno pianga se stesso.

galassie sono situate ad una distanza di 63 milioni di anni luce

nella costellazione meridionale del Corvo.

ASTRONOMIA PER TUTTI

L’immagine ripresa dal Telescopio Spaziale Hubble si

concentra sulla regione centrale delle due galassie in collisione

in cui è possibile vedere i due nuclei ben separati (le due

concentrazioni più scure in questa immagine in negativo)

attraversati da filamenti di polvere. Una vasta regione di polvere

si estende tra i nuclei delle due galassie, mentre nei bracci

deformati si evidenzia un’intensa attività di formazione stellare

incrementata dalla collisione.

L’immagine è una sovrapposizione di quattro immagini

riprese in altrettanti filtri il 20 gennaio 1996 mediante la Wide

Field and Planetary Camera. La risoluzione dell’immagine

originaria è di circa 15 anni luce per pixel.

di Gianfranco Bonfiglio

L’uomo da sempre è stato attratto dal cielo notturno. I primi

osservatori non sapevano nulla della natura delle stelle e su

come è sconfinato l’universo, eppure i nostri antenati iniziarono

a studiare le meraviglie astronomiche usando solo i propri occhi

e ne traevano grande soddisfazione; con questo sistema ottico

naturale osservavano il cielo con grande successo. Questo

proseguì fino al periodo di Galileo; con l’arrivo dello strumento

ottico si ebbe un cambiamento drastico, ma legittimo, del

sistema di osservare. Da quel momento le scoperte si sono

susseguite a catena e gli strumenti sono diventati sempre più

grandi e sofisticati.

Ai nostri giorni, in commercio per noi astrofili, c’è una

grande scelta di telescopi: si parte dai piccoli 6 cm per arrivare

tranquillamente ai 30 cm e oltre.

Per l’astrofilo che segue un programma osservativo serio,

scientifico e continuativo, la scelta di strumenti costosi è

giustificata, ma per quelle persone che pensano di usare il

telescopio poche volte durante l’anno e poi lasciare lo strumento

in cantina, è assurdo investire capitali; a questo tipo di persone è

bene ricordare che per hobby si possono trarre molte

soddisfazioni anche con strumenti modesti, l’importante è amare

l’astronomia e poi le grandi gioie arriveranno.

Prendiamo per esempio le osservazioni che eseguiva Walter

Ferreri negli anni Settanta; sono stupefacenti perché sfruttava al

massimo il suo 6 cm di diametro ed era spinto da grande

entusiasmo. Oggi invece c’è tendenza a pensare che grossi

strumenti diano grossi risultati; in parte è vero ma solo per le

persone che hanno una preparazione specifica ed eseguono

programmi di ricerca.

Per dare un’occhiata saltuariamente al cielo non serve

investire molto per avere poco, è meglio un piccolo telescopio,

ma conoscere bene il cielo e soprattutto non stancarsi di

osservare sempre con l’entusiasmo della prima volta.

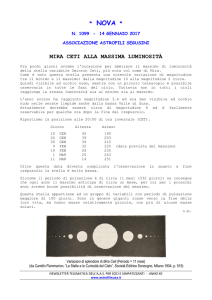

GALASSIE IN COLLISIONE

A sinistra

Un’immagine ripresa da terra delle Antenne (conosciute

anche come NGC 4038 e NGC 4039) così denominate a causa

della loro forma generata dalle interazioni gravitazionali

reciproche che le fa assomigliare alle antenne di un insetto. Le

A destra

NOTE DI RADIOASTRONOMIA

Associazione Astrofili Trentini

Nel 1931 l’ingegnere americano Jansky aprì una nuova

finestra sull’universo, conosciuto sino ad allora solo attraverso

la finestra della radiazione visibile. Perché si parla di

“finestre”? Perché l’atmosfera che avvolge la terra è opaca a

quasi tutte le radiazioni elettromagnetiche esistenti

nell’universo. Infatti le radiazioni di grande energia e

piccolissima lunghezza d’onda (i raggi gamma ed X) che pure

sono capaci di attraversare corpi solidi, sono arrestati dallo

spessore dell’atmosfera, equivalente a circa 10 metri d’acqua.

Anche le radiazioni con lunghezza d’onda al di sotto dei 10 µm

(infrarosso) sono per la maggior parte assorbite dall’atmosfera

insieme a quelle di pochi millimetri. Le onde radio più lunghe,

dalle onde chilometriche a quelle di circa 15 m di lunghezza

sono assorbite o riflesse da quegli strati superiori dell’atmosfera

rarefatti che chiamiamo ionosfera.

Esistono solo tre “finestre”, cioè tre campi di lunghezza

d’onda, in cui l’atmosfera nel suo complesso è trasparente o

quasi: la finestra ottica, da 1 micron a qualche decimo di micron,

comprendente la luce visibile e piccole porzioni di infrarosso e

ultravioletto; la finestra infrarossa intorno a 10 micron; la

finestra “radio”, tra 15 metri e qualche millimetro di lunghezza

d’onda. I confini delle finestre non sono ben definiti perché

dipendono dalle condizioni meteorologiche e dal grado di

ionizzazione della ionosfera legato all’attività solare. Solo la

finestra radio tra 3 m e 3 cm è praticamente sempre aperta, in

qualunque ora, stagione o fase del ciclo solare.

5

La Croce del Nord di Medicina (BO)

La scoperta di Jansky ci ha dato perciò la possibilità di

osservare l’universo giorno e notte, col sereno e con la pioggia,

senza bisogno di entrare in orbita con osservatori spaziali.

Un radioamatore americano, Reber, proseguì gli esperimenti

interrotti da Jansky nel 1935, e riuscì con un radiotelescopio

fatto in casa a disegnare nel 1940 la prima mappa radio della

galassia.

Solo dopo la seconda guerra mondiale le esperienze di

Jansky, di Reber e di alcuni “radaristi”, che avevano riscontrato

disturbi ai loro apparati provocati dalla radiazione del sole,

spinsero l’astronomia ufficiale a interessarsi di questo nuovo

canale di comunicazione con l’universo. I progressi tecnici degli

anni ‘50 e ‘60 hanno sconvolto poi l’astronomia tradizionale

fornendo un’immagine nuova e diversa dell’universo.

altro per effetto della loro propria temperatura. Ma perché un

corpo celeste emetta una radiazione misurabile deve avere delle

determinate caratteristiche:

1) essere relativamente vicino

2) essere molto grande

3) essere molto efficiente.

A tale proposito cercherò di fare alcuni esempi. La Luna è

relativamente vicina ma piccola e pochissimo efficiente. Il Sole

è meno vicino della Luna ma più grande e discretamente

efficiente ne deriva quindi una fortissima radiosorgente. Alpha

Centauri, è più grande del Sole, probabilmente altrettanto

efficiente ma molto difficilmente ricevibile perché troppo

lontana. Le pulsar sono piccolissime e almeno cento volte più

lontane, ma sono così efficienti che alcune di esse sono

radiosorgenti di media intensità.

Le Galassie sono miliardi di volte più grandi del Sole:

alcune, anche se relativamente vicine sono debolissime

radiosorgenti mentre tra le più lontane troviamo qualche forte

emettitrice. Infine alcune Quasar anche se all’estremo

dell’universo sono ricevibili con facilità.

L’antenna parabolica del radiotelescopio di Noto (SR)

Il Sole

La nostra stella, come si sa, è formata in realtà da diverse

“bucce” concentriche ad ognuna delle quali è associata una radio

emissione a diversa lunghezza d’onda via via crescente mano a

mano che ci allontaniamo dal centro. Il Sole quindi nella sua

totalità è una stella con discreta efficienza. Ma mentre nel

visibile emette in maniera quasi costante, nel campo radio, si

comporta in maniera piuttosto bizzarra: la radiazione non scende

mai al di sotto di un determinato livello ma talvolta aumenta in

maniera graduale anche di cento volte rispetto al valore di

fondo, ogni tanto poi emette “scoppi” o “tempeste” di radiazioni

variabili da qualche secondo a qualche giorno. Da notare che

queste stranezze non sono in via teorica un’esclusività della

nostra stella, ma molto probabilmente questi fenomeni

appartengono a qualsiasi stella dell’universo solo che date le

distanze in gioco noi con i nostri radiotelescopi non le possiamo

percepire.

L’antenna parabolica del radiotelescopio di Medicina

L’importanza definitiva della radioastronomia è stata

definitivamente sanzionata nel 1974 con l’attribuzione al

radioastronomo inglese Martin Ryle del Premio Nobel per la

fisica.

Le radiosorgenti

Chiamiamo “radiosorgenti una serie di oggetti di varia

natura e dimensione che hanno però in comune una importante

caratteristica: emettono una radiazione ricevibile con gli attuali

radiotelescopi. In realtà tutti i corpi emettono onde radio se non

6

La Galassia

La nostra galassia se fosse vista dall’esterno non sarebbe

classificata come radiosorgente apprezzabile, ma per noi che la

abitiamo, l’emissione di radioonde è stata e sarà sicuramente di

grande importanza per capire i segreti nascosti all’interno di

essa. Il nucleo galattico ad esempio non è osservabile

otticamente in quanto velato da nubi di polveri e gas, nubi che

però permettono il passaggio delle onde radio, cosicché con uno

strumento di adeguate proporzioni possiamo stimarne molto

precisamente la posizione.

STORIA DELLA RICERCA DI SUPERNOVAE

Un astrofilo australiano

A cura dell’Associazione Astrofili Trentini

(1ª parte)

Ricerca Visuale

La prima SN ad essere scoperta visualmente in tempi

moderni è stata SN 1885A in M31. È stata anche la più

luminosa fino alla scoperta di SN 1987A. C’è un po’ di

incertezza sul vero scopritore; si ritiene, tuttavia, che sia stato

Hartwig dell’osservatorio di Dorpat. Egli era un astronomo

professionista e la sua scoperta è avvenuta per caso, non essendo

parte di alcun programma sistematico di ricerca. La prima

scoperta di un amatore è anch’essa avvenuta per caso. Si trattava

di una SN di magnitudine 11 trovata in prossimità del nucleo di

M83 dall’astrofilo sudafricano Jack Bennet, nel luglio 1968.

Egli stava usando un rifrattore da 15cm per la ricerca di comete.

SN così luminose sono alquanto rare e fortunatamente Jack si

accorse subito che la galassia “non appariva normale”. La SN

risultò essere di tipo II (plateau) e fu studiata dagli astronomi

professionisti per circa due mesi, dopodiché la sua luminosità

diminuì a tal punto da non essere più discernibile dalla

nebulosità della galassia.

La Supernova 1987A ripresa dall’HST

Negli anni ‘70 l’AAVSO iniziò un programma di ricerca di

SN all’interno della sezione di ricerca novae, ed osservatori

come Ernst Mayer e Tom Fetterman fecero alcune osservazioni

di galassie finalizzate alla scoperta di SN. Furono preparate

anche un piccolo numero di carte galattiche.

La seconda scoperta di un astrofilo avvenne nell’aprile 1979,

ed anche in questo caso è da considerarsi un evento fortuito.

Certamente Gus Johnson, Maryland, USA, svolgeva un po’ di

ricerca di SN. Ma questa era solo uno dei suoi molteplici

interessi. Gus scoprì la SN nella zona periferica di M100,

usando un riflettore newtoniano da 20cm. Fu trovata poco prima

che raggiungesse il massimo, di magnitudine 11. E’ considerata

oggi, una dei prototipi di SN di tipo II “lineare”. Fu studiata

intensamente anche nelle onde radio e nell’ultra–violetto.

Usando le tecniche radio della VLBI (“very large base

interferometry”), questa SN è un “metro” misuratore della

distanza delle galassie dell’ammasso della Vergine.

Fu poco prima di questa data che James Bryan del Texas

incominciò a formalizzare alcune carte galattiche di galassie a

spirale “face–on”, pubblicando due articoli. Come molti

astrofili, viveva e lavorava in città e non poteva osservare con

molta regolarità. Egli fece una scoperta indipendente della SN

del 1980 in NGC 6946, pochi giorni dopo la scoperta di

astronomi professionisti. Anche questa SN raggiunse la

magnitudine 11 e fu di tipo II “lineare”.

Analogamente, prima del 1981, Gregg Thompson di

Brisbane, Australia, incominciò a lavorare su una raccolta di

230 carte di galassie luminose. Steve Lee, un assistente presso il

telescopio Anglo–Australiano, aveva fatto ingrandimenti da foto

di survey e le carte vennero disegnate da queste foto, mostrando

tuttavia le stelle con la magnitudine visuale. Nel corso del 1980

alcune di queste carte divennero disponibili in una forma

alquanto “rozza”, ad uso dei suoi amici. Lo scopo ultimo era di

pubblicarle, cosa che effettivamente avvenne nel 1990 in una

veste grafica di gran lunga superiore a quella originale.

Sul finire del 1979, quando il numero di Sky and Telescope

contenente notizia della SN in M100 arrivò in Australia, cercai

ancora una volta di superare i numerosi ostacoli che avevo

incontrato nei miei primi tentativi di ricerca. Una telefonata in

cerca d’aiuto cambiò radicalmente le mie possibilità. Arthur

Page era il coordinatore della sezione stelle variabili

dell’Associazione Astronomica del Queensland. Mi mise in

contatto con Gregg, il quale mi inviò alcune carte da lui

preparate. Mi suggerì, inoltre, di contattare Tom Cragg a Siding

Spring. Tom era disponibile a controllare i miei numerosi falsi

allarmi e mi diede l’opportunità di preparare gli ingrandimenti

delle galassie dalle foto di survey. Incominciai, quindi, a

costruirmi un grande archivio di fotografie, sia delle galassie già

coperte dalle carte di Gregg, sia di altre galassie che desideravo

osservare. Naturalmente, tutto ciò fu dispendioso sia per il

tempo dedicatovi che per il suo costo. L’archivio non venne fatto

né in una notte né in due anni.

Nel corso del 1980 incominciai lentamente a sviluppare la

sistematicità della mia ricerca di SN, migliorando anche

l’efficienza del mio 25cm. L’anno culminò con la scoperta

indipendente della SN 1980N in NGC 1316, scoperta qualche

giorno prima da professionisti cileni. Il 1981 fu l’anno di svolta.

In solo 15 giorni, a partire dal 24 febbraio, feci due scoperte,

perdendo l’opportunità di una terza. Queste furono SN 1981A in

NGC 1532, una stella di magnitudine 13.0 tipo II “plateau”, e

SN 1981D in NGC 1316, una SN di magnitudine 12.0 tipo I

classico. Quella che mi sfuggì fu la SN 1981B in NGC 4536.

Dato che Tom era molto preoccupato sulla possibilità di

commettere un errore annunciando la mia prima scoperta,

passarono parecchi giorni prima che effettuasse la

comunicazione sulla SN 1981A. Inoltre, la stella si comportava

in un modo anomalo, con variazioni impreviste della sua

luminosità. SN 1981D fu un caso totalmente diverso. Fu trovata

con il 25cm di fronte al garage di Tom nella sua casa di Siding

Spring; la stella fu scoperta, verificata e comunicata al Central

Bureau nel giro di poche ore. Caso volle che gli astronomi cileni

avessero fatto nelle notti precedenti fotografie della SN 1980N

esplosa nella stessa galassia, e non si fossero accorti della salita

di luminosità della nuova SN dalla magnitudine 20.5 alla 15.0. I

mesi rimanenti del 1981 e tutto il 1982 non produssero alcuna

SN sufficientemente luminosa, anche se tentai varie volte di

osservare la SN in NGC 1187.

Tuttavia, ulteriori migliorie al telescopio, ed un

ampliamento del mio programma osservativo spianarono la

strada a nuovi successi. Otto nuove scoperte seguirono nel 1983

e 1984. Tre di queste SN risultarono di particolare interesse,

perché permisero di riconoscere una nuova tipologia di SN,

inizialmente Tipo I peculiare, poi Tipo Ib. Alcuni, addirittura,

ritengono che questo gruppo includa anche la classe Tipo Ic. La

7

prima di queste tre, SN 1983N in M83, fu scoperta una

settimana prima che raggiungesse il massimo. Sfiorò la

magnitudine 11.0 e venne studiata intensamente. Gli astronomi

con il Very Large Array Radio Telescope registrarono una curva

radio diversa da qualsiasi altro caso precedente. La scoperta di

un’identica SN, l’anno successivo, SN 1984L in NGC 991,

mostrò che queste SN formano una classe a sé e non erano

semplicemente oggetti peculiari. Furono le analisi

spettroscopiche condotte continuativamente per sei mesi dopo il

massimo a chiarire che si trattava di una tipologia a sé stante di

SN. Le SN 1983N e 1984L sono i due prototipi di questa nuova

classe Tipo Ib. La SN 1983V in NGC 1365 divenne un esempio

di Tipo Ic, assieme ad altre scoperte minori effettuate dai

professionisti. Da allora le opinioni divergono sul fatto che le

SN di Tipo Ib e Ic debbano essere considerate due classi

separate o varianti di una stessa classe. Il Tipo Ib è scarso in

elio, al contrario del Tipo Ic.

I grandi osservatori eseguono programmi di osservazioni che

vengono fissati con vari mesi di anticipo, e non è affatto facile

per un astronomo cambiare questi piani per poter osservare un

fenomeno transiente come una SN. Spesso, la strumentazione

utilizzata con uno strumento può non essere idonea allo studio di

SN. Ci sono, tuttavia, casi dove coincidenze conducono a grosse

opportunità, favorendo l’avanzamento della conoscenza.

L’astronomo Marshall McCall stava usando il telescopio Anglo–

Australiano proprio in durante una esplosione di SN. Riuscì ad

effettuare spettropolarimetria su due delle SN citate in

precedenza, al fine di determinare se i gusci stellari esplosi

fossero sferici o meno (un punto importante in alcuni studi

teorici). I gusci del Tipo Ia risultavano sferici, mentre quelli del

Tipo Ib non lo erano. Un altro studio condotto a seguito di

scoperte fatte da astrofili, fu la misurazione della presenza di

ferro in spettri avanzati di SN. Tale misurazione fu eseguita

osservando le righe spettrali nell’infrarosso di una SN di Tipo Ib

dopo circa un anno dal suo massimo. Molte altre SN mostrarono

inusuali caratteristiche spettrali che devono essere ancora

spiegate.

Negli anni ‘60, l’astrofilo giapponese Kaoru Ikeya si rese

famoso per la scoperta di una cometa alquanto luminosa. Negli

anni ‘80 i suoi interessi si spostarono alla ricerca di SN. La sua

prima scoperta fu fatta sul finire del 1984, quando trovò SN

1984R in NGC 3675. Sfortunatamente, nessun astronomo riuscì,

o volle, ottenere uno spettro di questo oggetto, per cui si sa ben

poco sulla natura di questa SN. La sua seconda scoperta, SN

1988A in M58, ottenne un trattamento decisamente migliore.

Ikeya usava un 25cm da casa sua, un sito con parecchio

inquinamento luminoso; le sue scoperte sono, quindi, un grosso

successo. Un’altra interessantissima scoperta fu quella di SN

1986G nella banda di polveri di NGC 5128, conosciuta come

Centaurus A. Questa fu una SN Tipo I classico che raggiunse la

magnitudine 11.0, nonostante il notevole oscuramento della

polveri. Se non fosse stata oscurata probabilmente avrebbe

raggiunto la magnitudine 8.5, rendendola una delle SN più

luminose in età moderna. La luminosità massima fu raggiunta

dopo una settimana dalla scoperta.

Anche la SN 1987A nella Grande Nube di Magellano

dovrebbe essere classificata, almeno in parte, come una scoperta

amatoriale. Sicuramente fu trovata per caso, non essendo oggetto

di alcun programma sistematico di ricerca. Ma due dei tre

scopritori ufficiali la videro visualmente, ed uno è un astrofilo.

In questo caso, l’astrofilo Albert Jones della Nuova Zelanda

avrebbe meritato maggiore attenzione per la sua scoperta. Albert

esegue annualmente un numero altissimo di osservazioni di

stelle variabili, e ne stava osservando una quando ha notato la

SN. La 1987A è stata studiata intensamente, e questo ha aiutato

a riscrivere molti aspetti delle nostra conoscenza su queste

stelle.

Si giunge poi all’agosto del 1987, quando Dana Patchick, di

Culver City, California, ha scoperto SN 1987L in NGC 2336,

8

con un dobsoniano da 45cm, nell’ambito di un programma

ristretto di osservazioni di galassie. Si trattava di una SN di

Tipo I, trovata alcune settimane dopo il massimo.

Un’altra SN di eccezionale luminosità fu SN 1989B in NGC

3627, ossia M66. Fu scoperta circa una settimana prima del

massimo e raggiunse magnitudine 11.8 nonostante

l’assorbimento delle polveri della galassia. Anche questa SN

venne studiata intensamente dagli astronomi, ed è classificata

Tipo Ia.

La SN 1991T in NGC 4527 è una scoperta che

probabilmente segna l’inizio di una nuova epoca nella ricerca

visuale di questi oggetti. Fu trovata ufficialmente da ben cinque

astrofili situati in quattro punti diversi della Terra. Tra questi

Stephen Knight e Wayne Johnson degli USA, Mirko Villi e

Giancarlo Cortini dell’Italia. Un’altra astrofila giapponese,

Reiki Kushida, ha fatto la sua prima scoperta visuale nel

dicembre 1991, trovando una SN di magnitudine 14.5 in M84.

Si trattava di una SN di tipo Ia, tre magnitudini più debole del

solito. N. Brown, di Perth, Australia, è indicato come co–

scopritore visuale di NGC 1380. Infine, SN 1992H in NGC 5377

è stata scoperta in febbraio da William Wren, usando il più

piccolo dei telescopi dell’Osservatorio McDonald. Lavora

all’osservatorio presso il centro visitatori, e nel suo tempo libero

si dedica alla ricerca di SN, di solito con il suo telescopio. Lo

stesso Wren, nell’agosto del 1994 scopriva la sua seconda

supernova della galassia NGC 5371.

Il 28 marzo 1993 un astrofilo spagnolo, Francisco Garcia

Diaz trovava una delle supernovae più luminose degli ultimi

anni: la SN 1993I nella galassia M81. La supernova raggiunse la

magnitudine 10.5 e risultò essere di tipo II.

Un’altra scoperta di Cortini e Villi è avvenuta il 31 luglio

1994 con la supernova 1994W in NGC 4041, una galassia

nell’Orsa Maggiore. La stella fu trovata con un 28cm e venne

confermata dall’osservatorio astronomico di Loiano, vicino a

Bologna.

Se ci riferiamo solamente al periodo dal 1983 alla metà del

1988, su un totale di 99 SN scoperte con ogni mezzo, 18 sono

state trovate visualmente da astrofili. Il 18% rappresenta un

enorme contributo a questo tipo di ricerca. Con le tecniche

automatiche di ricerca che molti osservatori astronomici stanno

sviluppando, tale percentuale potrà declinare nel futuro. Ma se

si esamina in dettaglio le SN scoperte dagli astrofili, notiamo

che si tratta nella maggior parte dei casi delle stelle più

luminose e, quindi, di maggiore importanza per una loro analisi.

(continua)

For further information about this paper please

contact:

Elia Cozzi

Via Borghi 14

22076 Mozzate (CO)

Italy

Phone and Fax: +39–331–830704

Fidonet: 2:331/101

E–mail: [email protected]