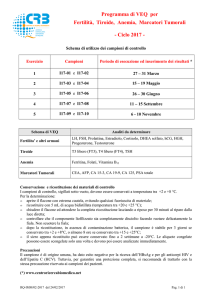

METODI DI CLASSIFICAZIONE

Federico Marini

Introduzione

• Nella parte introduttiva dell’analisi multivariata abbiamo

descritto la possibilità di riconoscere l’origine di alcuni campioni

come uno dei campi di applicazione dell’analisi multivariata

• In termini più rigorosi il problema poteva essere riformulato nei

seguenti termini: si vogliono usare i campioni di origine nota

(campioni di training) per derivare una regola di classificazione

che permetta di classificare nuovi oggetti di origine incognita in

una delle categorie studiate sulla base dei valori delle misur

sperimentali.

• Metodi che sfruttino attivamente l’informazione sui campioni

noti si chiamano supervisionati

Classificazione

• Matematicamente questo significa che è necessario

assegnare porzioni dello spazio a k dimensioni a ciascuna

delle classi in studio.

• Un campione è quindi assegnato alla classe che occupa la

porzione si spazio in cui esso si trova

• I metodi supervisionati si differenziano dai metodi non

supervisionati (clustering) perché nei secondi le categorie on

sono note a priori.

• Nei metodi supervisionati, le classi sono note e bisogna

decidere a quale classe il campione vada assegnato.

A

C

B

B

D

Classificazione, gli step

• La messa a punto di un metodo di classificazione si basa sui

seguenti passaggi:

– Selezione di un training set, ovvero di oggetti la cui classificazione si a

nota, sui quali viene misurato un certo numero di variabili

– Selezione delle variabili, in maniera da mantenere quelle che possono

risultare significative per la classificazione ed eliminare quelle non utili

– Costruzione di una regola di classificazione utilizzando i campioni del

training set

– Validazione della regola di classificazione così messa a punto

utilizzando un set di dati indipendente

Le regole di classificazione

• Ci sono diversi tipi di metodi di classificazione in letteratura

• Essenzialmente si differenziano tra di loro sulla base della

modo in cui si definiscono le regole di classificazione

• Una prima e importante differenziazione è tra i metodi che si

concentrano sulla discriminazione tra le classi e quelli che

invece cercano di modellare le classi stesse.

• La prima classe di metodi – detti di classificazione pura o

discriminanti – cercano in maniera implicita o esplicita di

trovare i confini che separano le differenti classi nello spazio

multidimensionale.

• In questi casi la risposta che si ottiene in termini di

classificazione è sempre l’assegnazione ad una delle G

classi disponibili.

I metodi di modellamento di classe

• La seconda tipologia di metodi – detti di classificazione

modellante o di modellamento di classe – si concentrano

invece sul cercare somiglianze tra campioni appartenenti alla

stessa classe.

• Si modella una categoria alla volta.

• Un campione può essere assegnato ad una sola classe, a più

classi o a nessuna.

I metodi discriminanti

• I metodi discriminanti, come detto, si concentrano sul trovare

dei confini ottimali tra le classi da discriminare

• Un esempio è quello fatto nella parte introduttiva, per la

discriminazione di pazienti eu-, iper- e ipotiroidei.

• In quel caso, la classificazione dei campioni poteva essere

fatta misurando alcune variabili (5 nella fattispecie) sui

campioni in esame, identificando i baricentri delle

distribuzioni ei campioni, e tracciando delle superfici a metà

strada tra i diversi baricentri.

Esempio

Considerazioni

• Se si considera il grafico riportato al lucido precedente, si

vede come i pazienti normali si trovino ben raggruppati al

centro del grafico, mentre i pazienti con disturbi formino

classi relativamente disperse.

• Questi casi non sono infrequenti nei problemi di

classificazione.

• In casi come questi, utilizzare delle superfici lineari per

separare le classi può non essere sufficiente perché alcuni

campioni potrebbero essere classificati in maniera erronea.

• Si potrebbero ottenere quindi risultati migliori considerando

superfici quadratiche o addirittura maggiormente nonlineari

Esempio (quadratico)

Esempio (maggiore nonlinearità)

Metodi discriminanti – prime considerazioni

• Uno dei principali problemi dei metodi di classificazione

discriminanti è che bisogna per forza assegnare il campione

ad una delle G classi disponibili

• È tuttavia possibile che un campione non debba essere

assegnato a nessuna di queste classi

• Pensando all’esempio dei vini, dove si prendeva in

considerazione vini di tre origini differenti, ci si potrebbe

trovare ad analizzare un campione che provenga da una

quarta origine – non contemplata nel training set.

• Per questo tipo di problemi è migliore un altro approccio.

L’approccio modellante

• Come detto, consiste nel fare un modello separato di

ciascuna categoria

• Gli oggetti che “fittano” il modello di quella categoria ne sono

riconosciuti come membri, mentre gli altri vengono classificati

come non membri.

• In termini discriminanti si potrebbe dire che i metodi di

modellamento di classe discriminano tra essere membro e

non essere membro della classe.

• In termini statistici, si può dire che i metodi di modellamento

non sono altro che test per l’identificazione di outliers.

Parametrici o non parametrici

• Un’altra distinzione che si può operare tra i metodi di

classificazione è quella tra tecniche parametriche e non

parametriche.

• Le prime assumono che i dati seguano una particolare

distribuzione statistica, per cui il calcolo del modello diventa il

calcolo dei parametri di queste distribuzioni.

• Lo svantaggio delle tecniche parametriche è che possono

portare a grandi errori quando le assunzioni di partenza non

siano verificate.

• Il vantaggio è che permettono di ottenere più facilmente la

probabilità di ottenere una classificazione corretta.

• D’altro canto, i metodi non parametrici non assumono

esplicitamente alcuna distribuzione statistica.

Metodi discriminanti

• Come detto, i metodi discriminanti procedono alla

classificazione dei campioni in una di G classi disponibili.

• Per costruire il modello di classificazione, in tutti i casi si parte

dalla Regola di Bayes:

“un campione va assegnato alla classe per la quale sia maggiore la

sua probabilità di appartenenza”

• Il processo di classificazione è quindi un processo a due

stadi:

1. Calcolo della probabilità che un campione incognito appartenga a

ciascuna delle G classi (o di una qualsiasi funzione monotona di

questa probabilità – detta funzione di classificazione)

2. Assegnazione del campione alla classe corrispondente alla probabilità

più alta.

Analisi discriminante lineare (LDA)

• Il metodo di classificazione discriminante più vecchio (e più

semplice) è la cosiddetta analisi discriminante lineare.

• Come suggerisce il nome, è un metodo per cui le superfici

che separano le regioni di spazio corrispondenti a ciascuna

classe sono lineari (rette in 2D, piani in 3D, iperpiani in nD).

• Statisticamente, l’analisi discriminante assume che, per

ciascuna categoria, la probabilità che il campione appartenga

alla classe segua una distribuzione normale

p(g x i ) ∝

1

(2π ) 2 Sg

n

e

−

(

1

x −x g

2 i

)

T

(

S g x i −x g

)

• e che la matrice di covarianza sia la stessa per tutte le classi:

∑ (n

G

Si = S j = S =

g =1

g

)

−1 Sg

N −G

Analisi discriminante lineare - 2

• Sotto queste ipotesi, se per ciascuna classe si calcola il

logaritmo della probabilità descritta in precedenza si ottiene una

funzione quadratica delle variabili misurate:

1 T

1 T

T

f (g) = ln( p(g x i )) ∝ − x i Sx i + x g Sx i − x g Sx g

2

2

• A partire da questa espressione è possibile calcolare le

equazioni che definiscono le superfici che separano le classi.

• Queste superfici sono caratterizzate dal fatto che la probabilità

che un campione appartenga all’una o l’altra classe è uguale

f (classe1) = f (classe2)

1 T

1 T

1 T

1 T

T

T

c1 − x i Sx i + x1 Sx i − x1 Sx1 = c 2 − x i Sx i + x 2 Sx i − x 2 Sx 2

2

2

2

2

Analisi discriminante lineare - 3

• Dal momento che i termini quadratici, per ciascun campione,

sono uguali per tutte le classi, le superfici di separazione che

si ottengono sono lineari nelle variabili misurate.

(c1 − c 2 ) + (x1 − x 2 )

T

T

1

Sx i − ( x1 − x 2 ) S( x1 − x 2 ) = 0

2

Analisi discriminante lineare - Considerazioni

• Assumendo che i dati siano distribuiti in maniera gaussiana,

LDA è un metodo parametrico.

• È necessario avere a disposizione un certo numero di

campioni per i quali la classificazione sia nota.

• I dati misurati su questi campioni vengono utilizzati per

calcolare i valori dei centroidi e della matrice di covarianza

cumulata.

• Questi parametri rappresentano i coefficienti nelle funzioni di

classificazione, come rappresentato nelle equazioni descritte

in precedenza.

La matrice di confusione

• I risultati dell’applicazione di un metodo di classificazione

possono essere raccolti in una matrice detta “matrice di

confusione”.

• Questa matrice riassume le previsioni (corrette ed errate) che

vengono effettuate per i campioni.

• Può essere data sia in maniera assoluta che relativa.

osservati

predetti

classe1

classe2

classe3

classe1

40 (95.24%)

2 (4.76%)

0 (0.00%)

classe2

1 (2.63%)

35 (92.11%)

2 (5.26%)

classe3

0 (0.00%)

3 (10.71%)

25 (89.29%)

• Allo stesso modo si può dare l’errore complessivo:

• Classificazioni corrette: 100 (92.59%)

• Classificazioni errate: 8 (7.41%)

Analisi discriminante quadratica (QDA)

• Se superfici lineari di separazione tra le classi non sono

sufficienti a garantire buone previsioni, è possibile complicare

il sistema è QDA.

• Infatti, la QDA parte dalle stesse ipotesi statistiche dell’LDA

(distribuzione gaussiana), ma mantiene una matrice di

covarianza diversa per ciascuna classe.

• Sotto queste assunzioni, le funzioni di classificazione

1 T

1 T

diventano:

T

f (g) = ln( p(g x i )) ∝ − x i Sg x i + x g Sg x i − x g Sg x g

2

2

• In questo modo, dal momento che il termine quadratico è

differente per ciascuna classe, le superfici di separazione

saranno quadratiche anch’esse:

–

–

–

–

Iperboloidi

Iperparaboloidi

Iperellissoidi

Ipersfere

QDA - 2

• Basandosi sull’ipotesi di distribuzione gaussiana, anche la

QDA è un metodo parametrico.

• I campioni di classificazione nota vengono utilizzati per

stimare i centroidi e le matrici di covarianza per le varie

classi.

• Dal momento che per ogni classe deve essere stimata una

matrice di covarianza differente, il numero di campioni

necessari aumenta significativamente:

– Ntot >Nvar 3 per LDA

– Ng >Nvar 3 per ogni classe per QDA

Un altro approccio alla classificazione - PLSDA

• I requisiti in termini di numero di campioni necessari visti nel

lucido precedente rendono quei metodi inapplicabili ai risultati

di molte delle moderne tecniche strumentali.

• Infatti, in quei casi il numero delle variabili eccede di gran

lunga quello dei campioni.

• Inoltre, queste variabili sono molto correlate, rendendo la

stima delle matrici di covarianza ancora meno stabile.

• Per ovviare a questi inconvenienti si può applicare alla

classificazione un algoritmo usato con successo per risolvere

gli stessi problemi in ambito della regressione, l’algoritmo

PLS.

Classificare attraverso la regressione

• È possibile trasformare un problema di classificazione in un

problema di regressione, introducendo come variabili

dipendenti un vettore che contenga informazioni

sull’appartenenza alla classe.

• Ad esempio, per un problema dove ci siano 3 categorie, il

vettore Y sarà codificato come:

– [1 0 0]

– [0 1 0]

– [0 0 1]

per i campioni della classe 1

per i campioni della classe 2

per i campioni della classe 3

• In questo modo, statisticamente la Y rappresenta un vettore

contenente le probabilità che il campione appartenga alle

diverse classi in esame

• Il modello di classificazione viene quindi calcolato come un

modello di regressione a partire da questi valori delle Y

PLS-DA

• Una volta capito come trasformare un problema di

classificazione in uno di regressione, è possibile utilizzare per

risolverlo algoritmi in grado di lavorare con molte variabili,

come l’algoritmo PLS.

• PLS sfrutta una proiezione dei campioni su un sottospazio a

bassa dimensionalità (come la PCA).

• A differenza di PCA, questo spazio non è quello per cui è

massima la percentuale di informazione mantenuta

(varianza).

• PLS ricerca le sue direzioni come quelle per cui è massima la

covarianza con la Y

• statistica classica

vs

metodi basati su variabili latenti (astratte)

PLS-DA

LDA

v Variabili indipendenti

v Variabili X con minimo errore

v Residui gaussiani

Molti più campioni che variabili!

v Variabili correlate

v Le variabili X possono

contenere rumore

v Può esserci struttura nei residui

Non importa

Metodi non parametrici - kNN

• Come esempio di metodo di classificazione non parametrico,

descriviamo rapidamente il più semplice: kNN.

• kNN non assume alcuna distribuzione di probabilità in

maniera esplicita.

• La distribuzione di probabilità è assunta in maniera implicita

dalla regola di classificazione.

• Questa regola di classificazione si basa sulla distanza.

• La regola è molto semplice:

“Il campione incognito va assegnato alla classe a cui appartiene la

maggioranza dei sui k vicini nello spazio”

• Per questo motivo k di solito si sceglie dispari

kNN - 2

Metodi di modellamento di classe

• Da ultimo saranno descritte le caratteristiche dei principali

metodi di classificazione modellante (o modellamento di

classe).

– SIMCA

– UNEQ

SIMCA

• Ogni categoria è modellata separatamente

• Il modello è basato sull’analisi delle componenti principali.

• La distanza dei campioni dal modello è una combinazione

della distanza nello spazio delle PC (leverage) e dallo spazio

delle PC (residui)

SIMCA

• La distanza totale dal modello della categoria viene calcolata

come una combinazione delle statistiche T2 e Q:

• Ci possono essere diversi modi per combinare queste

distanze

2

2 2

dij = (Qr ) + Tr

• Il più utilizzato è:

( )

Q

dove: Qr =

Q0.95

2

T

Tr2 = 2

T0.95

• Sulla base di questo criterio lo spazio di classe è definito

come :

d ij < 2

• In alternativa, si può prendere come

spazio della classe quello definito dai

limiti di Q e T2:

UNEQ

• È la versione modellante della QDA

• Il modello di classe si basa quindi sulla distribuzione normale

multidimensionale.

• La distanza di un campione dalla classe è definita come la

distanza di Mahalanobis dal centroide della classe stessa.

• Lo spazio della classe è definito dall’iperellissoide

corrispondente al 95% di confidenza

Coomans plot

• Con tutti i metodi di modellamento, quando si abbia più di

una classe, i risultati possono essere visualizzati in un

cosiddetto grafico di Coomans