Approfondimento 4.8

La “pulitura” dei dati

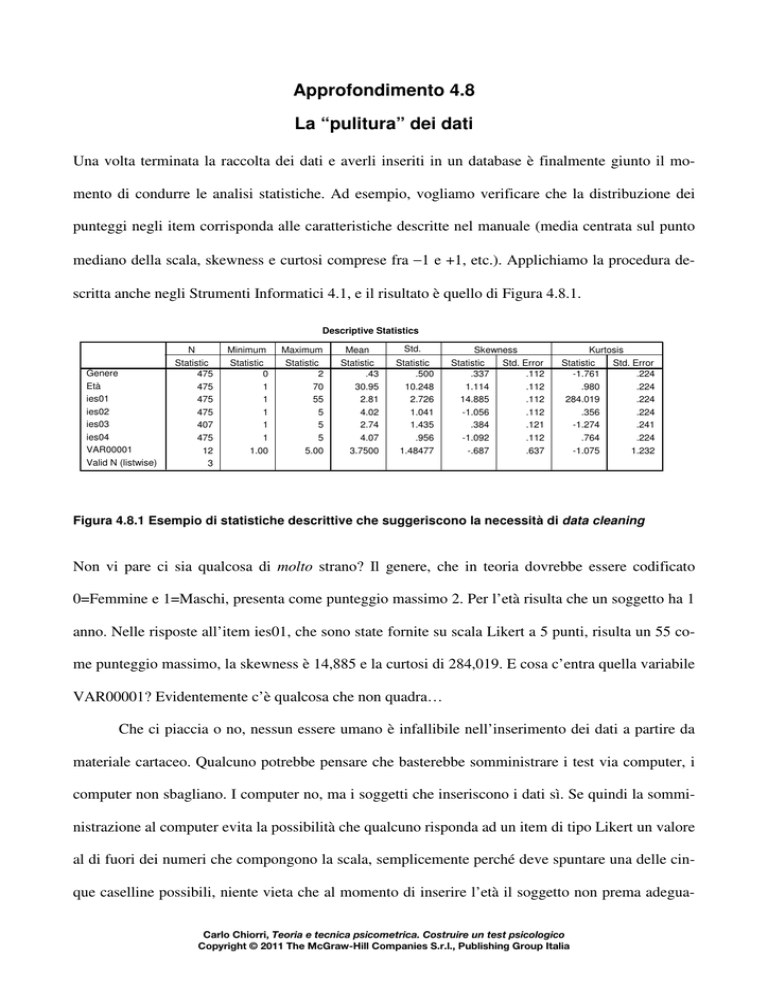

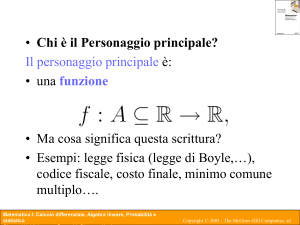

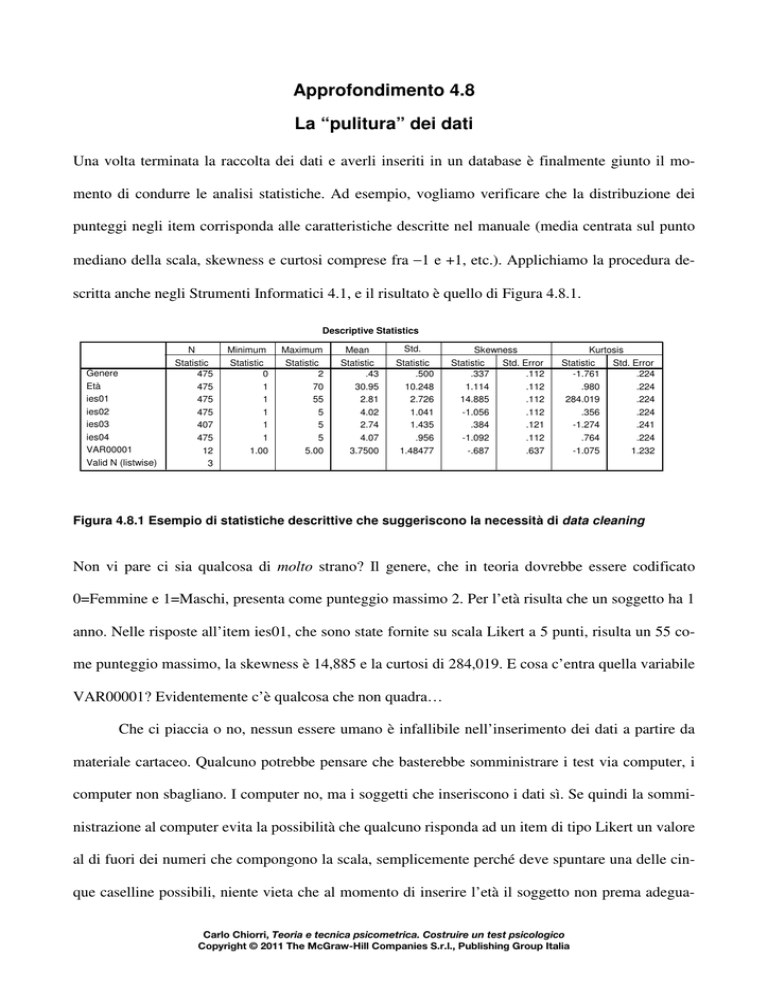

Una volta terminata la raccolta dei dati e averli inseriti in un database è finalmente giunto il momento di condurre le analisi statistiche. Ad esempio, vogliamo verificare che la distribuzione dei

punteggi negli item corrisponda alle caratteristiche descritte nel manuale (media centrata sul punto

mediano della scala, skewness e curtosi comprese fra −1 e +1, etc.). Applichiamo la procedura descritta anche negli Strumenti Informatici 4.1, e il risultato è quello di Figura 4.8.1.

Descriptive Statistics

Genere

Età

ies01

ies02

ies03

ies04

VAR00001

Valid N (listwise)

N

Statistic

475

475

475

475

407

475

12

3

Minimum

Statistic

0

1

1

1

1

1

1.00

Maximum

Statistic

2

70

55

5

5

5

5.00

Mean

Statistic

.43

30.95

2.81

4.02

2.74

4.07

3.7500

Std.

Deviation

Statistic

.500

10.248

2.726

1.041

1.435

.956

1.48477

Skewness

Statistic

Std. Error

.337

.112

1.114

.112

14.885

.112

-1.056

.112

.384

.121

-1.092

.112

-.687

.637

Kurtosis

Statistic

Std. Error

-1.761

.224

.980

.224

284.019

.224

.356

.224

-1.274

.241

.764

.224

-1.075

1.232

Figura 4.8.1 Esempio di statistiche descrittive che suggeriscono la necessità di data cleaning

Non vi pare ci sia qualcosa di molto strano? Il genere, che in teoria dovrebbe essere codificato

0=Femmine e 1=Maschi, presenta come punteggio massimo 2. Per l’età risulta che un soggetto ha 1

anno. Nelle risposte all’item ies01, che sono state fornite su scala Likert a 5 punti, risulta un 55 come punteggio massimo, la skewness è 14,885 e la curtosi di 284,019. E cosa c’entra quella variabile

VAR00001? Evidentemente c’è qualcosa che non quadra…

Che ci piaccia o no, nessun essere umano è infallibile nell’inserimento dei dati a partire da

materiale cartaceo. Qualcuno potrebbe pensare che basterebbe somministrare i test via computer, i

computer non sbagliano. I computer no, ma i soggetti che inseriscono i dati sì. Se quindi la somministrazione al computer evita la possibilità che qualcuno risponda ad un item di tipo Likert un valore

al di fuori dei numeri che compongono la scala, semplicemente perché deve spuntare una delle cinque caselline possibili, niente vieta che al momento di inserire l’età il soggetto non prema adeguaCarlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

2

tamente uno dei tasti (magari l’1 di Figura 4.8.1 è in realtà un errore di inserimento di un 19 o di un

31), oppure, se la deve scegliere in un menu a tendina, sbagli a selezionarla, o lo scorrere lo schermo con la rotellina del mouse non modifichi la sua scelta perché il menu è rimasto selezionato. In

ogni caso, mi spiace informarvi che quando ricevete un database non è praticamente mai già pronto

per le analisi statistiche, in quanto i database, soprattutto se contengono informazioni riguardanti

molti soggetti e/o molte variabili, qualche difetto ce l’hanno sempre. Ecco allora che entra in gioco

il data cleaning, che è quella procedura di individuazione, valutazione e gestione dei dati “non validi” e degli outliers. Un dato non valido è un valore o una categoria che non rientra fra quelli possibili per una certa variabile. È il punteggio 55 ad una scala Likert a 5 punti da 0 a 4, è la categoria 2

di una variabile dicotomica in cui le due modalità sono codificate 0 e 1, è numero di figli negativo,

e così via. Il riconoscimento dei dati non validi, fortunatamente, è abbastanza agevole, dato che si

tratta di valori che non possono essersi verificati. Inoltre, in questi casi dovrebbe essere possibile

risalire al questionario cartaceo originale (da cui la necessità di aver numerato ogni singolo questionario e averli conservati in ordine) e controllare. La questione, però, si complica quando si vanno ad

incrociare le informazioni provenienti da due diverse variabili. Ad esempio, un soggetto potrebbe

riferire di avere 18 anni e titolo di studio “laurea”. A meno che non sia un genio particolarmente

precoce, c’è qualcosa che non quadra. Così come nel caso di qualcuno che dichiara di avere come

titolo di studio la licenza media e di fare il medico. Questi tipi di dati non validi sono più difficili da

individuare, perché non basta esaminare le statistiche descrittive di un solo item, ma occorre realizzare analisi di contingenza e sapere quali particolari incroci di categorie e/o valori sono impossibili.

Il punto, però, è che andando a recuperare il dato cartaceo potremmo trovare esattamente gli stessi

dati: il soggetto, quindi, o ha voluto fare lo spiritoso, o ha sbagliato. Non importa quale sia la verità.

Adesso abbiamo un problema, e anche se avessimo somministrato il questionario online le cose non

sarebbero cambiate.

L’altro problema riguarda gli outlier. Un outlier è un dato che rientra fra quelli possibili, ma

si discosta più o meno notevolmente dall’insieme degli altri. Ad esempio, un’età di 1 anno è un dato

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

3

valido per l’età. Solo, nel contesto di un test autosomministrato è impossibile che un bambino di 1

anno abbia compilato un questionario. Sì, ma se il valore fosse stato 8? A 8 anni i bambini sanno

leggere e scrivere, e per quanto in modo in parte inaffidabile, potrebbero compilare un test. Eppure

voi avevate raccomandato ai vostri collaboratori di somministrare il test solo a maggiorenni! Certo,

anche in questo caso potete controllare sul cartaceo, ma se il dato proviene da una indagine condotta

online, nuovamente, non sapete se la persona in questione ha voluto prendervi in giro o ha sbagliato

ad inserire il dato in buona fede. Un’occhiata alle risposte alle altre variabili potrebbe risolvere la

questione: se nella riga del soggetto in esame abbiamo che l’età risulta 8, ma il titolo di studio è

specializzazione, la professione medico, lo stato civile coniugato, è (quasi) certo che il dato dell’età

sia stato mal digitato o inserito.

In questo approfondimento non verrà affrontato il problema di un’errata trascrizione dei dati

dal cartaceo al foglio elettronico, dato che la soluzione è molto semplice. Tratteremo invece la procedura da utilizzare quando non ci sia modo di rivolgersi ad una fonte esterna per controllare le informazioni presenti nel database.

Come suggeriscono van den Broeck e collaboratori (2005), il data cleaning in nessun caso

risulterà essere un rimedio per uno studio progettato e/o condotto male, e, aggiungiamo noi, per una

somministrazione dei test realizzata in modo frettoloso e inappropriato. Anche nel caso in cui la ricerca sia stata eseguita a regola d’arte, però, i problemi con i dati possono verificarsi comunque. Un

aspetto che spesso viene omesso negli articoli scientifici, nonostante alcune raccomandazioni (ad

esempio, American Statistical Association, 1999), è quello di come sono stati “puliti” i dati, e questo è tanto più imperdonabile nel caso delle ricerche sui test psicologici. Sapendo per esperienza che

è impossibile somministrare un test ad un numero molto ampio di soggetti e ottenere tutti dati validi, senza dati mancanti o outlier, sono sempre molto sorpreso di leggere nella sezione del metodo

dedicata alla descrizione dei partecipanti che il test è stato somministrato, poniamo, a 450 persone

(nessuna si è rifiutata di compilarlo, o lo ha lasciato a metà, o non l’ha restituito?), senza alcuna descrizione di come possono essere stati gestiti i dati mancanti o anomali. Fortunatamente non sempre

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

4

questo è il caso, e i referee stanno diventando più esigenti in questo senso. Come fanno notare van

den Broeck e collaboratori (2005), il problema non è solo la gestione dei dati mancanti e degli outlier, per la quale esiste una letteratura molto ampia, ma qualcosa di più ampio che riguardi la valutazione del modo in cui si cerca di prevenire gli errori nei dati, il modo in cui il processo di raccolta

viene monitorato, i dati “puliti” prima delle analisi, e, non per ultima, la documentazione di questo

processo. L’importanza di questa fase è testimoniata dalla cura che le organizzazioni che svolgono

ricerche su vasta scala pongono nella descrizione del modo in cui è stato preparato il database. Ad

esempio, il National Center for Education Statistics (NCES) nel 2002 ha iniziato una monumentale

indagine,

chiamata

Educational

Longitudinal

Study-2002

(ELS-2002,

http://nces.ed.gov/surveys/els2002/index.asp), che aveva lo scopo di monitorare la transizione di un

campione rappresentativo di adolescenti dal secondo anno di scuola superiore fino all’entrata nel

mondo del lavoro o ai primi anni di università. La ricerca ha previsto una raccolta di informazioni

su oltre sedicimila teen-agers, eseguita mediante questionari cartacei: immaginate quindi cosa ha significato realizzare il solo inserimento dei dati − per quanto questo sia avvenuto mediante un lettore

ottico computerizzato. Il NCES fornisce una sorta di manuale intitolato Data File Documentation in

cui viene descritto nel dettaglio il modo in cui è stato preparato il file coi dati. Un capitolo è dedicato al Data Processing and File Preparation. In questa sezione viene spiegato come, una volta scannerizzati tutti i questionari, è stato preparato il database che, peraltro, è a disposizione, previa registrazione sul sito Internet dello studio, di chiunque sia interessato ad eseguire studi su questi dati. In

particolare, viene spiegato che i dati anomali sono stati “puliti” andando a riesaminare i cartacei

(perché anche lo scanner non è infallibile), oppure con interventi basati sul pattern dei dati quando il

cartaceo non avesse aiutato a chiarire l’ambiguità, oppure con una decisione basata sul consenso di

esperti (ad esempio, se veniva richiesto di inserire una percentuale e invece era stata inserita una

frequenza).

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

5

Van der Broeck e collaboratori (2005) descrivono una procedura di data cleaning a tre stadi

che prevede cicli ripetuti di screening, diagnosi e correzione di anomalie nei dati. La Figura 4.8.2

illustra il processo.

Figura 4.8.2 Il processo di data cleaning in relazione all’avanzamento della ricerca (adattato da van

der Broeck et al., 2005, con modifiche)

Gli errori nei dati non necessariamente possono essere individuati alla fine della ricerca, ma, come

mostra la Figura 4.8.2, possono emergere anche nel corso della ricerca. Nondimeno, il fatto di individuarli è spesso più frutto del caso che di una strategia precisa, per cui è preferibile possedere una

procedura che consenta una ricerca sistematica. Infatti, non sempre è perfettamente chiaro che un

certo dato è un errore: se una persona riferisce di essere un medico, potrebbe non venire in mente

che c’è un errore (tale risposta è presente tra quelle previste per la variabile “occupazione”), ma lo è

nel momento in cui, ad un esame più attento dei dati, risulta che quella persona ha 18 anni o riferisce come titolo di studio il diploma di scuola media superiore. Allo stesso modo, se un dato è mancante, come spiegato nel manuale, può esserlo per molti motivi diversi: ad esempio, supponiamo

che una persona abbia risposto “Sì” alla domanda “Pratichi uno sport (se no salta la prossima domanda)”, ma poi non abbia indicato nella domanda successiva quale. Non vuole dichiarare quale

sport pratica? Si è dimenticata? Oppure ha sbagliato a rispondere alla domanda precedente, per cui

avrebbe dovuto dire “No”, per sbaglio e senza accorgersene ha indicato “Sì”, ma ha correttamente

saltato la domanda di specifica dell’attività sportiva praticata? In breve, non lo possiamo sapere.

Quale che sia la verità, e posto che siamo mai in grado di conoscerla, rimane il problema di gestire

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

6

questo tipo di dati. E non possiamo certo farlo semplicemente cancellando la riga corrispondente a

quel soggetto, dato che se il campione è rappresentativo di una qualche popolazione target con quel

soggetto, escluderlo significherebbe modificare tale caratteristica del campione. In generale, quindi,

occorre avere delle regole predefinite per controllare errori, missing e outlier all’interno del proprio

database, in modo da limitare il più possibile la perdita di soggetti e il mantenimento di dati non validi.

La diagnosi e il trattamento degli errori nei dati richiedono la conoscenza dei vari tipi di errore che possono verificarsi in una qualunque fase dello studio, data cleaning compreso. Le fasi della ricerca più a rischio di errori sono comunque quelle relative alla somministrazione del questionario, alla costruzione del database e alla fasi di analisi dei dati.

Nel caso della somministrazione dei questionari gli errori più comuni riguardano lo smarrimento del questionario stesso, la sua erronea doppia somministrazione allo stesso soggetto, il fatto

che il soggetto non risponda ad alcune domande, oppure risponda in modo indecifrabile (ad esempio, nella risposta su scala di tipo Likert segna due diversi numeri, oppure c’è una risposta cancellata a nessuna altra risposta), oppure sbagli a rispondere (ad esempio, segna la casella sbagliata), oppure produca incoerenza, come, ad esempio, riferire di non praticare nessuno sport, ma poi indicare

di farlo per due ore alla settimana.

A livello di costruzione del database gli errori possono verificarsi non solo perché il valore

inserito è errato, ma anche perché si i dati sono stati inseriti in modo impreciso, nel senso che non

sono stati inseriti dati effettivamente presenti, oppure che sono stati inseriti dati in eccesso (ad esempio, nella stessa cella del database sono state inserite le risposte a due item), oppure che un dato

è stato inserito nella colonna sbagliata (ad esempio, il valore dell’età è stato inserito nella colonna

del titolo di studio), oppure è stato commesso un errore di trascrizione dovuto ad una ricodifica dal

questionario cartaceo al foglio elettronico (ad esempio, si sa che il genere verrà ricodificato

0=Femmina, 1=Maschio, per cui, invece di F o M viene inserito nel database direttamente il valore

numerico, però sbagliato).

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

7

Infine, poiché quasi mai il database viene utilizzato per intero nell’analisi dei dati, possono

essere stati commessi degli errori nel costruire il file sul quale effettivamente verranno realizzate le

procedure statistiche. Per cui è possibile eliminare o duplicare erroneamente alcune colonne o righe,

ordinare in senso crescente una sola colonna invece che tutte, da cui la perdita del corretto appaiamento soggetto-risposte, oppure può capitare che nell’importazione o nell’esportazione del file i

cambiamenti di formato producano trasformazioni non volute nei dati, come ad esempio la perdita

del formato della data a favore di un altro formato.

Il data cleaning si propone di risolvere questo tipo di problemi in tre fasi: la fase di

screening, quella diagnostica e quella di trattamento degli errori.

La fase di screening consiste principalmente nell’individuazione di dati in eccesso o in difetto, outlier, incroci incoerenti fra valori o categorie di variabili diverse, risultati delle analisi dei

dati inattesi o senza senso. In tutti questi casi la statistica può essere d’aiuto, ma solo fino ad un certo punto. Ad esempio, in alcuni casi si può anche decidere che un dato è un outlier perché il punteggio è, poniamo, più di tre deviazioni standard lontano dalla media, ma potrebbe nondimeno essere

un caso perfettamente valido, ancorché insolito (ad esempio, un soggetto che risponde correttamente a tutti gli item di un test di prestazione massima particolarmente difficile). In altri casi, però, la

statistica è inutile: un soggetto che risponde il punteggio massimo della scala di risposta di tipo Likert a tutti gli item di un test di personalità che comprenda item reverse ha chiaramente compilato il

test in modo inaccurato, ma non verrà mai individuato da una procedura statistica che si basi solo

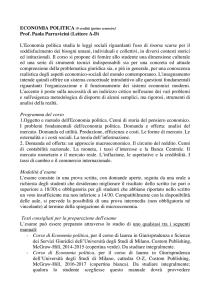

sulla presunta rarità del punteggio ottenuto. In questa fase si possono utilizzare i software per le analisi statistiche, come ad esempio SPSS, oppure un semplice foglio di calcolo. Ad esempio, in

SPSS si può chiedere di produrre, per tutte le variabili del database, la distribuzione di frequenza.

La procedura è semplicissima, perché basta seguire Analyze→Descriptive Statistics→Frequencies.

A quel punto si inseriscono tutte le variabili nel campo Variable(s) e si clicka OK. Il risultato è una

serie, spesso molto lunga, di tabelle come quella di Figura 4.8.3.

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

8

Titolo di studio

Valid

Licenza Media

Diploma

Laurea specialistica

Laurea triennale

Master / Dottorato /

Specializzazione

9

Total

Frequency

15

218

75

126

Percent

3.2

45.9

15.8

26.5

Valid Percent

3.2

45.9

15.8

26.5

Cumulative

Percent

3.2

49.1

64.8

91.4

40

8.4

8.4

99.8

1

475

.2

100.0

.2

100.0

100.0

Figura 4.8.3 Esempio di tabella di frequenza di SPSS

Nel file TIPICA2.sav per il titolo di studio è prevista un’etichetta verbale per ogni valore numerico

corrispondente al titolo di studio. Il problema è che in questo esempio compare un valore, 9, che

non corrisponde a nessuna categoria di titolo di studio. Peraltro, compare una volta sola, per cui le

possibilità che sia un errore di inserimento sono molto alte. A questo punto, per individuare il soggetto col valore sospetto, occorre tornare al file dei dati (foglio Data View), selezionare la colonna

del titolo di studio, clickando sul nome della variabile, Edit→Find, e inserire nel campo di ricerca il

valore 9. A quel punto il software andrà automaticamente a selezionare il dato in esame, permettendoci di individuare il codice identificativo del soggetto, così da indirizzarci alla copia cartacea dei

dati, se presente, oppure permetterci si esaminare tutte le risposte di quel soggetto. Il problema di

questa procedura è che va eseguita variabile per variabile, e nel caso di un dataset di un test le variabili da esaminare possono essere molte.

Un’altra procedura da realizzare in SPSS è costruire tavole di contingenza Età × Titolo di

studio e Titolo di studio × Professione (o altri incroci di variabili “a rischio”) e Età × Professione.

Lo scopo è quello di individuare incroci impossibili, come una persona di 18 anni con la specializzazione in medicina. Seguiamo allora Analyze→Descriptive Statistics→Crosstabs, inseriamo una

variabile nel campo Row(s) e una nel campo Column(s) e controllare le frequenze dei vari incroci.

In questi casi non occorre controllare tutti i possibili incroci, ma solo quelli “a rischio”. Ad esempio, se tutti i vostri soggetti sono maggiorenni, incrociate l’età col titolo di studio e controllate solo

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

9

se nelle categorie Laurea e Master/Dottorato/Specializzazione compaiono persone con meno di 22

anni. Oppure, se incrociate il titolo di studio con la professione, controllare se, fra quelle professioni

che richiedono la laurea, non vi siano persone con titolo di studio inferiore. La stessa logica può essere applicata a qualunque altro incrocio di variabili che presentino delle criticità, come ad esempio

il genere e la sede di un intervento chirurgico (gli uomini non possono aver subito isterectomia, così

come le donne non possono aver subito vasectomia).

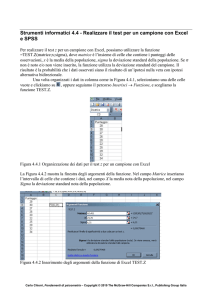

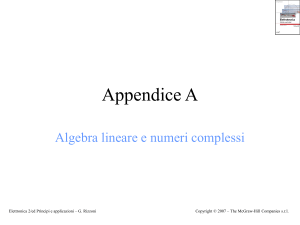

Se utilizzate un foglio elettronico, non potete eseguire gli incroci di diverse variabili, ma potete sfruttare la funzione filtro. Ad esempio, in Excel, selezionate tutte le colonne del foglio elettronico, poi seguite Dati→Filtro→Filtro automatico. A quel punto su ogni colonna comparirà un piccolo tasto con una freccia rivolta verso il basso. Se clickate sul tasto, si apre un menu come quello

in Figura 4.8.4 per la variabile titstu.

Figura 4.8.4 Esempio di funzione Filtro di Excel per la variabile titstu

La piccola finestra che si apre mostra tutti i valori presenti nella colonna che si sta filtrando.

Nell’esempio in Figura 4.8.4, si vede che non compare mai il valore 1 e che vi sono celle vuote [altrimenti non sarebbe comparsa la dicitura (Vuote)]. Se selezionate (Personalizza…) si apre una nuova finestra nella quale potete impostare un vincolo a vostro piacimento, come uguale, diverso, maggiore, inizia/finisce con, non inizia/finisce con, contiene/non contiene (queste tre ultime opzioni

possono essere molto utili con dati testuali). Se selezionate un valore, Excel filtra il database mostrando solo i casi che presentano quel valore o col vincolo personalizzato che avete impostato. In

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

10

questo modo è facile, per quanto un po’ lungo, esaminare variabile per variabile se tutti i valori che

compaiono nella colonna in esame possono essere considerati validi.

Il problema principale delle due procedure descritte è che richiedono tempo, pazienza e attenzione. Naturalmente con l’esperienza potete sviluppare il vostro modo personalizzato di individuare i dati anomali perché imparate quali errori possono essere più frequenti, ma capita sempre un

errore imprevisto, e questo può essere individuato solo con l’esame variabile per variabile.

Nel momento in cui avete individuato i casi critici, comincia la fase diagnostica. Lo scopo

di questa fase è chiarire la natura dei dati sospetti. A cosa sono dovuti? Sono dati impossibili? Dati

estremi? Dati validi ma incoerenti con altri dati dello stesso soggetto? La risposta a queste domande

determinerà il da farsi nella fase di trattamento. Le opzioni, sostanzialmente sono tre: correggere il

dato, eliminarlo o lasciarlo immutato. I dati impossibili non possono essere lasciati immutati, ma

occorre eliminarli o correggerli (sempre che naturalmente non sia possibile risalire al valore corretto

riesaminando il soggetto o consultando il cartaceo, se disponibile). L’eliminazione significa rendere

il valore un dato mancante, da trattare poi come illustrato nell’Approfondimento 4.9, e forse rappresenta la scelta più sicura, anche perché, se il dato in esame è rappresentato da un incrocio impossibile di due variabili, come fate a stabilire se l’errore è nell’una o nell’altra (o in tutte e due?). Rendendo il dato mancante, e realizzando una procedura di imputation (ossia, di stima statistica del valore

mancante in base alle informazioni sulle altre variabili) come quella descritta nell’Approfondimento

4.9, avete perlomeno la possibilità di ottenere un dato che, per quanto non sia necessariamente quello reale, ha comunque buone probabilità di essere plausibile − per quanto tale probabilità non sia del

100%, per cui occorrerà una nuova fase di screening al termine dell’imputation.

Se i dati sospetti sono outlier, quindi dati non impossibili ma estremi, non esiste una soluzione che vada bene sempre, perché occorre valutare quanto il valore o i valori estremi influiscono

sui risultati delle analisi statistica − ma in questo caso dipenderà anche dal tipo di analisi. Una procedura abbastanza comune è quella di ordinare i dati, individuare i valori estremi e sostituirli con un

valore che mantenga il loro ordine di rango, ma li avvicini agli altri. Ad esempio, poniamo il caso in

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

11

cui i valori di età più alti siano 62, 65, 68, 96 e 97 anni. I due ultimi di valori potrebbero risultare

outlier rispetto alla distribuzione dei punteggi di età. Non necessariamente sono valori impossibili,

ma potrebbero creare qualche problema a livello di analisi dei dati, perché allungano la distribuzione dell’età in modo importante. In questi casi si può sostituire a 96 e 97 un valore sempre superiore

ma più vicino all’ultimo valore accettabile (in questo esempio, 68), come ad esempio 69 e 70. Il

punto, però, è che stiamo “creando” un dato che non abbiamo osservato, e per il fenomeno in esame

potrebbe essere una distorsione ancora peggiore, dato che, ad esempio, una persona di 70 anni potrebbe non rispondere al test come una di 97. Inoltre, in alcuni casi gli outlier potrebbero essere dati

derivanti da errori di inserimento, quindi dati non validi, che ma che cadono all’interno dei valori

accettabili, per cui se, fra le età degli studenti universitari abbiamo come coda della distribuzione i

valori 34, 35 e 62, e 62 è un errore di inserimento del valore vero 26, inserire 36 non aiuterà di certo

a risolvere il problema. Se non c’è modo di risalire al valore vero, anche in questi casi forse

l’opzione migliore è rendere il dato mancante e provare a stimarlo con l’imputation.

Inoltre occorre stare attenti a non commettere errori come quelli di utilizzare come codice

missing, ad esempio, il valore 999, e non segnalarlo a SPSS (vedi Approfondimento 4.4). Questo è

il classico caso in cui, ad esempio, l’età vi risulta compresa fra 18 e 999, con media 33,04 (che può

essere) e deviazione standard 45,56 (che è molto sospetto).

In conclusione, il data cleaning è un processo complesso e allo stesso tempo decisivo per i

risultati della ricerca. È sostanzialmente impossibile stilare delle linee guida che vadano bene in tutte le situazioni, dato che ogni ricerca presenta le sue peculiarità a livello di dati raccolti. Sta quindi

alla coscienziosità, pazienza, competenza e, non ultima, onestà intellettuale del ricercatore occuparsi di esaminare attentamente i dati prima di procedere con le analisi. Soprattutto nel caso dei test

psicologici, infatti, i soggetti sbagliano, mentono, fanno gli spiritosi, si distraggono, così come possono sbagliare e distrarsi coloro che inseriscono e gestiscono i dati. Il risultato di tutto questo sono

errori nei dati. Tali errori possono tradursi in dati impossibili o incoerenti, e in questi casi forse la

procedura migliore è rendere il dato mancante e sottoporlo ad imputation − sempre che non possa

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia

Approfondimento 4.8 – La “pulitura” dei dati

12

essere corretto in qualche modo ricontattando il soggetto (eventualità spesso molto improbabile) o

consultando il cartaceo (impossibile con dati raccolti online). Se il dato è un valore estremo, può valer la pena provare a lasciarlo immutato nel database ed eseguire le analisi con e senza quel/quei valori, in modo da verificare l’impatto di quel/quei dato sui risultati. Se i risultati sono enormemente

diversi (ad esempio, un coefficiente di correlazione che con gli outlier risulta ,91 e senza ,07), forse

è meglio rendere il dato mancante e sottoporlo ad imputation. Si noti come in queste righe sia occorsa spesso la parola “forse”: questo significa che quanto affermato può essere una soluzione accettabile in alcuni casi, ma non in tutti, per cui il lettore è invitato a riflettere bene sulle decisioni

che prenderà, e a consultare la letteratura scientifica relativa al suo caso, perché probabilmente altri

si saranno trovati nella medesima situazione e avranno proposto delle soluzioni.

Carlo Chiorri, Teoria e tecnica psicometrica. Costruire un test psicologico

Copyright © 2011 The McGraw-Hill Companies S.r.l., Publishing Group Italia