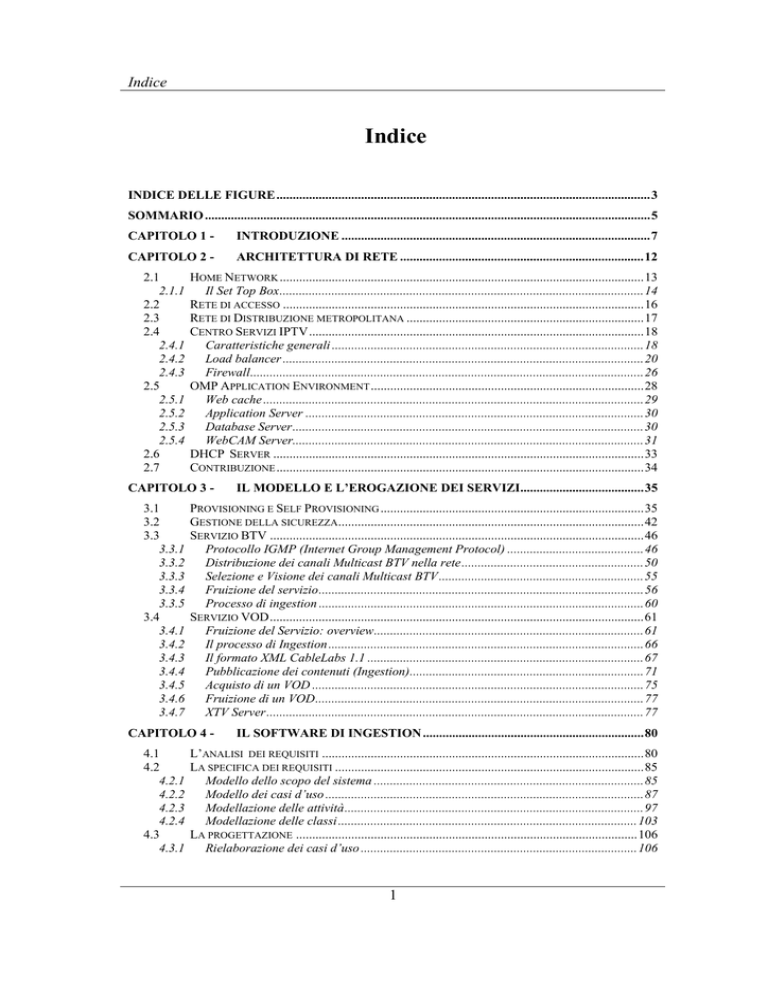

Indice

Indice

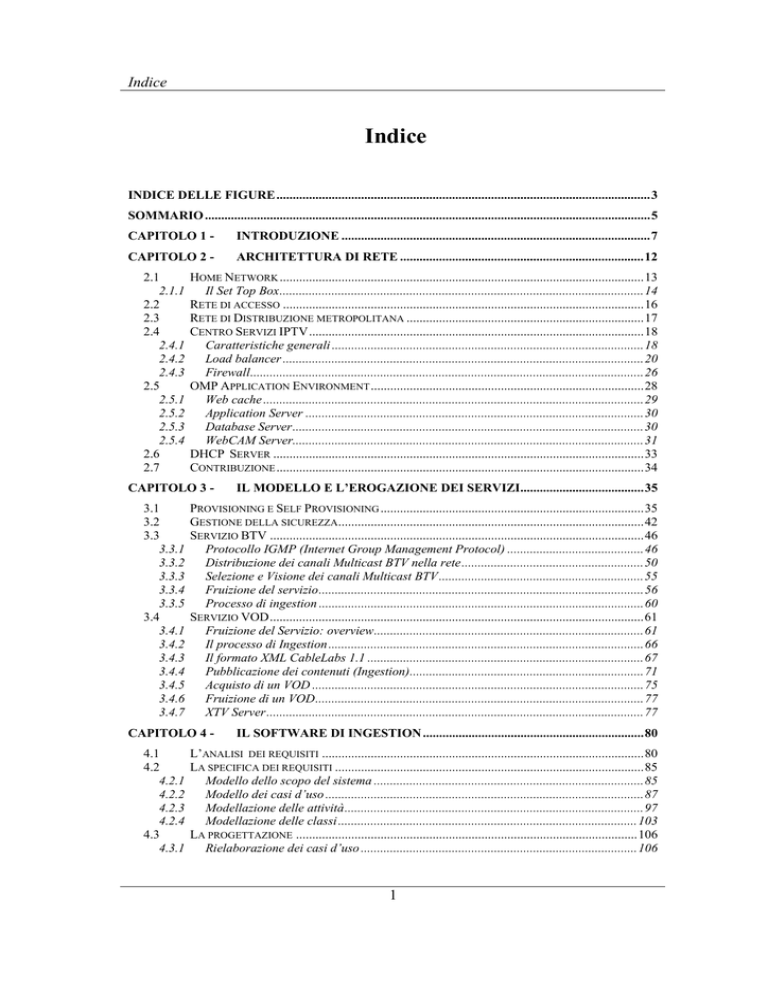

INDICE DELLE FIGURE...................................................................................................................3

SOMMARIO .........................................................................................................................................5

CAPITOLO 1 -

INTRODUZIONE ...............................................................................................7

CAPITOLO 2 -

ARCHITETTURA DI RETE ...........................................................................12

2.1

2.1.1

2.2

2.3

2.4

2.4.1

2.4.2

2.4.3

2.5

2.5.1

2.5.2

2.5.3

2.5.4

2.6

2.7

HOME NETWORK ................................................................................................................13

Il Set Top Box................................................................................................................14

RETE DI ACCESSO ...............................................................................................................16

RETE DI DISTRIBUZIONE METROPOLITANA .........................................................................17

CENTRO SERVIZI IPTV.......................................................................................................18

Caratteristiche generali ................................................................................................18

Load balancer ...............................................................................................................20

Firewall.........................................................................................................................26

OMP APPLICATION ENVIRONMENT ....................................................................................28

Web cache .....................................................................................................................29

Application Server ........................................................................................................30

Database Server............................................................................................................30

WebCAM Server............................................................................................................31

DHCP SERVER ..................................................................................................................33

CONTRIBUZIONE .................................................................................................................34

CAPITOLO 3 3.1

3.2

3.3

3.3.1

3.3.2

3.3.3

3.3.4

3.3.5

3.4

3.4.1

3.4.2

3.4.3

3.4.4

3.4.5

3.4.6

3.4.7

IL MODELLO E L’EROGAZIONE DEI SERVIZI......................................35

PROVISIONING E SELF PROVISIONING .................................................................................35

GESTIONE DELLA SICUREZZA..............................................................................................42

SERVIZIO BTV ...................................................................................................................46

Protocollo IGMP (Internet Group Management Protocol) ..........................................46

Distribuzione dei canali Multicast BTV nella rete........................................................50

Selezione e Visione dei canali Multicast BTV...............................................................55

Fruizione del servizio....................................................................................................56

Processo di ingestion ....................................................................................................60

SERVIZIO VOD...................................................................................................................61

Fruizione del Servizio: overview...................................................................................61

Il processo di Ingestion .................................................................................................66

Il formato XML CableLabs 1.1 .....................................................................................67

Pubblicazione dei contenuti (Ingestion)........................................................................71

Acquisto di un VOD ......................................................................................................75

Fruizione di un VOD.....................................................................................................77

XTV Server....................................................................................................................77

CAPITOLO 4 -

IL SOFTWARE DI INGESTION ....................................................................80

4.1

L’ANALISI DEI REQUISITI ...................................................................................................80

4.2

LA SPECIFICA DEI REQUISITI ...............................................................................................85

4.2.1

Modello dello scopo del sistema ...................................................................................85

4.2.2

Modello dei casi d’uso ..................................................................................................87

4.2.3

Modellazione delle attività............................................................................................97

4.2.4

Modellazione delle classi ............................................................................................103

4.3

LA PROGETTAZIONE .........................................................................................................106

4.3.1

Rielaborazione dei casi d’uso .....................................................................................106

1

Indice

4.3.2

La struttura delle classi progetto ................................................................................108

4.3.3

Il modello delle classi di progetto...............................................................................109

4.3.4

Diagrammi di collaborazione .....................................................................................113

4.3.5

Statechart Diagram.....................................................................................................120

4.3.6

Progetto della struttura dati .......................................................................................124

4.3.7

Il progetto dell’interfaccia utente ...............................................................................125

4.4

L’IMPLEMENTAZIONE .......................................................................................................130

4.4.1

Algoritmo generale .....................................................................................................131

4.4.2

La gestione della persistenza ......................................................................................133

4.4.3

Init del sistema ............................................................................................................134

4.4.4

La lettura dati checkInbox ..........................................................................................136

4.4.5

Il parsing dei metadati: checkMetadata .....................................................................136

4.4.6

La distribuzione in sottodirectory: moveAsset ............................................................137

4.4.7

Il gestore della coda....................................................................................................138

4.4.8

La pubblicazione nel database OMP ..........................................................................142

4.5

IL DEPLOYMENT ...............................................................................................................145

4.6

IL TESTING .......................................................................................................................145

CAPITOLO 5 -

CONCLUSONI................................................................................................148

BIBLIOGRAFIA ..............................................................................................................................150

ELENCO DI SIGLE ED ACRONIMI ............................................................................................153

2

Indice delle figure

Indice delle figure

Figura 1 - Architettura Generale ...........................................................................................................13

Figura 2 - Home Network.....................................................................................................................14

Figura 3 - Il STB AmiNET 110 AMINO..............................................................................................15

Figura 4 - Access Network ...................................................................................................................16

Figura 5 - Rete di distribuzione ............................................................................................................17

Figura 6 - Centro Servizi IPTV.............................................................................................................18

Figura 7 - Layout di rete .......................................................................................................................19

Figura 8 - Schema architetturale stadio esterno ....................................................................................21

Figura 9 - Virtual Server and Nodes - Network Map...........................................................................22

Figura 10 - Stralcio Schema architetturale LB3....................................................................................23

Figura 11 - Virtual Server e Pool..........................................................................................................25

Figura 12 - stralcio layout di rete comprendente i firewall ..................................................................26

Figura 13 - Firewall GUI e stralcio delle policy ...................................................................................28

Figura 14 - Environment applicativo della piattaforma ........................................................................29

Figura 15 - Componenti del tool Web Cam..........................................................................................31

Figura 16 - Rappresentazione logica delle connessioni ........................................................................33

Figura 17 - Colloquio di Provisioning ..................................................................................................35

Figura 18 - Assegnazione Indirizzo IP..................................................................................................37

Figura 19 - Self provisioning automatico (primo accesso dell’utente) .................................................41

Figura 20 - Richiesta servizio (accessi successivi al primo).................................................................42

Figura 21 - CA NDS: Distribuzione delle EMM ..................................................................................44

Figura 22 - Algorithm Based System - Distribuzione ECM .................................................................45

Figura 23 - Struttura dei messaggi IGMP .............................................................................................49

Figura 24 - StreamShaper .....................................................................................................................51

Figura 25 - BTV: StreamShaper in clear service ..................................................................................52

Figura 26 - BTV: Scrambled Service....................................................................................................53

Figura 27 - BTV: flusso ricevuto alla Home Network..........................................................................53

Figura 28 - BTV: Componenti dello StreamShaper..............................................................................54

Figura 29 - IGMP: Esempio di General Query .....................................................................................57

Figura 30 - IGMP: Messaggio di Membership Report .........................................................................58

Figura 31 - IGMP: Traccia di uno "zapping"........................................................................................59

Figura 32 - Fruizione di un contenuto VOD .........................................................................................62

Figura 33 - RTSP Redirect....................................................................................................................65

Figura 34 - Distriuzione attraverso Asset Distribution Interface (ADI)................................................67

Figura 35 - Diagramma UML per gli Assset ........................................................................................69

Figura 36 - Struttura dell'Asset CableLabs ...........................................................................................70

Figura 37 - Stralcio della specifica CableLas: Package ........................................................................71

Figura 38 - VOD Pre-Encryption..........................................................................................................74

Figura 39 - VOD Pre-Encryption in dettaglio.......................................................................................74

Figura 40 - Distribuzione dei file..........................................................................................................75

Figura 41 - Richiesta di Acquisto VOD................................................................................................76

Figura 42 - Preparazione VOD dopo acquisto ......................................................................................76

Figura 43 - Struttura di XTV Server .....................................................................................................77

Figura 44 - Esempio di colloquio di acquisto VOD..............................................................................78

Figura 45 - Scopo del sistema - Diagramma di contesto......................................................................86

Figura 46 - Component diagram ...........................................................................................................87

Figura 47 - Modello dei casi d'uso di business .....................................................................................88

Figura 48 - Casi d’uso...........................................................................................................................90

Figura 49 - Caso d'uso "Get Inbox" ......................................................................................................96

Figura 50 - Diagramma delle attività per il caso d'uso Check Inbox ....................................................98

3

Indice delle figure

Figura 51 - Diagramma di Attività per il caso d'uso "Publish Content" .............................................100

Figura 52 - Activity Diagram Pubblicazione VOD Insert...................................................................101

Figura 53 - Activity per Movie File_Update = False.........................................................................102

Figura 54 - Activity Diagram per la pubblicazione di soli metadati ...................................................102

Figura 55 - Diagramma delle classi ....................................................................................................105

Figura 56 - diagramma dei casi d'uso .................................................................................................107

Figura 57 - Package Classi del sistema...............................................................................................109

Figura 58 - Diagramma delle classi di progetto ..................................................................................111

Figura 59 - Pubblicazione manuale: Collaboration diagram...............................................................114

Figura 60 - Sequence diagram pubblicazione manuale.......................................................................116

Figura 61 - Pubblicazione automatica: diagramma di collaborazione ................................................117

Figura 62 - Sequence diagram ............................................................................................................119

Figura 63 - Ticket: Statechart diagram ...............................................................................................120

Figura 64 - Statechart con maggiore granularità.................................................................................121

Figura 65 - Diagramma esteso degli stati ticket..................................................................................122

Figura 66 - Gestione coda dei trasferimenti........................................................................................123

Figura 67 - Diagramma ER.................................................................................................................125

Figura 68 - Interfaccia utente: scheda Main Panel..............................................................................127

Figura 69 - Interfaccia utente: scheda Tools .......................................................................................128

Figura 70 - Interfaccia utente: scheda Service Group .........................................................................129

Figura 71 - Interfaccia utente: scheda Settings ...................................................................................129

Figura 72 - Interfaccia utente: scheda Log..........................................................................................130

Figura 73 - Algoritmo generale...........................................................................................................132

Figura 74 - Modello ad oggetti ADO - stralcio...................................................................................134

Figura 75 - Gestore della coda ............................................................................................................138

Figura 76 - Diagramma di deployment ...............................................................................................145

4

Sommario

Sommario

Questa tesi riporta un’esperienza di progetto di reti di calcolatori e di sviluppo

software svolta nell’ambito di un operatore di telecomunicazioni nazionale e relativa

ad una piattaforma nata per la distribuzione di servizi TV su reti IP su ADSL

(Asymmetric Digital Subscriber Line).

Avendo avuto la possibilità di partecipare al progetto fin dalle sue prime fasi, gli

aspetti affrontati sono molteplici e variegati. I servizi erogati sono Broadcast

TeleVision (BTV), Video On Demand (VOD), Pay Per View, Voice over IP (VoIP),

Fast Internet.

Questo lavoro ha richiesto alcuni periodi di lavoro in Belgio, in cui sono state

studiate questioni di configurazioni network, load balancing e gestione della

sicurezza a livello IP. Ma anche in UK, dove sono state affrontate problematiche di

livello applicativo relative sia all’acquisizione dei video da parte dei content provider

sia alla loro successiva trasformazione per essere poi erogati alla clientela.

Oltre a presentare la soluzione adottata in termini di architetture di rete e servizi,

vengono messe in rilievo alcune problematiche comuni alle piattaforme IPTV.

Per tale scopo sono stati separati e messi a fuoco i due principali servizi: VOD e

BTV. Per ognuno di questi sono stati affrontati gli aspetti di erogazione del servizio

con contenuti sia in chiaro (“clear service”) che sottoposti a encrypting (“scrambled

service”).

A seconda della tipologia di servizio, vengono coinvolti apparati e protocolli di rete

diversi. Infatti, relativamente ai servizi BTV, si fa ricorso a protocolli di Multicast e

tecniche di encrypting in linea, mentre per i servizi VOD si ricorre a protocolli

Unicast e si adotta un pre-processing che sottopone i contenuti prima ad encrypting e

poi alla diffusione verso server dislocati su tutto il territorio italiano.

5

Sommario

In questo processo si colloca un software, sviluppato nell’ambito di questo lavoro,

che facilita ed assiste tutte le fasi di preliminari alla pubblicazione di un content.

L’applicativo, dovendo comunicare con i diversi sistemi, interni ed esterni alla

piattaforma IPTV, è XML based, nel senso che tutte le comunicazioni tra gli enti

conivolti avvengono con protocolli e regole basati su questo linguaggio. Lo standard

“de facto”, adottato anche in questa piattaforma, è rappresentato dalla specifica XML

redatta dai tecnici dei laboratori CableLabs. Attraverso questo set di regole, infatti,

vengono inviati dati e informazioni di controllo che vengono interpretati, dando

luogo a corrispondenti azioni che si propagano dai content provider fino alla user

interface visualizzata sugli apparecchi TV nelle case dei clienti.

Il software rappresenta anche un utile strumento di workflow a disposizione degli

addetti ai lavori, che possono seguire i processi di pubblicazione e gestire eventuali e

particolari problematiche di disservizio. La reportistica fornita, e i log proposti a

diversi livelli di dettaglio, completano le funzionalità del prodotto che ormai è

indispensabile strumento che completa le attività di gestione della piattaforma.

6

Introduzione

Capitolo 1

Capitolo 1

Introduzione

Con servizi IPTV, si intende la distribuzione di flussi audio e video verso gli utenti

che sono raggiunti dal servizio ADSL e che sono quindi collegati ad una rete IP.

Il collegamento tra rete IP e televisore è ottenuto a mezzo di un apparecchio, detto

Set Top Box. Si tratta di un client IP dotato di particolari processori che trattano il

flusso in ingresso ed inviano il segnale video al televisore attraverso un comune cavo

audio video o SCART. Dal momento che i contenuti TV, prima di essere trasmessi

in rete, subiscono un processo di encrypting, I Set Top Box sono equipaggiati di una

smart card, attraverso la quale si realizza l’operazione di decrypting che consente la

fruibilità dei contenuti.

Fondamentalmente le tipologie di flussi video sono distinguibili in due categorie:

Broadcast TV (BTV)

Video on Demand (VOD)

Pay Per View (PPV)

Nel primo caso, il segnale video proviene tipicamente da un canale televisivo

broadcast. La piattaforma ha quindi il compito di sottoporlo alla codifica desiderata,

di trasformarlo con il processo di encrypting e di convogliarlo verso la rete IP che lo

distribuirà ai clienti in modalità Multicast.

7

Introduzione

Capitolo 1

Nel secondo caso, invece, è il cliente a scegliere il contenuto da vedere. Attraverso

il telecomando fornito a corredo del Set Top Box, infatti, accede ad un catalogo di

film dal quale è possibile acquistarne la visione. In tal caso, la piattaforma eroga un

flusso audio video in modalità unicast. Durante la visione il cliente ha a disposizione

i comandi interattivi di un comune videoregistratore (Pause, Rewind, Fast-Forward,

Stop). Il valore aggiunto che fornisce la piattaforma, rispetto al tradizionale modo di

concepire i servizi TV, risiede proprio nella libertà che ha il cliente nell’accesso ai

contenuti multimediali. È il cliente a scegliere cosa guardare e quando guardare.

Nel servizio PPV, l’utente, utilizzando un telecomando, interagisce con il STB per

visualizzare la programmazione TV. Alla scelta di un programma televisivo, la

piattaforma ne consente l’acquisto. Il costo del contenuto PPV sarà addebitato sul

conto telefonico del cliente ed una voce che confermerà l’avvenuto acquisto di un

contenuto in modalità PPV. Una volta acquisito il diritto alla visione del contenuto

PPV il cliente sarà avvertito quando il programma è in corso di inizio. A differenza

del servizio VOD, l’utente è ora tenuto a sincronizzarsi con l’evento che viene

trasmesso con modalità multicast. Allo scopo di agevolare la sincronizzazione con il

cliente, nell’ambito di alcuni giorni, l’evento viene proposto più volte. Anche per tale

ragione, questo servizio viene chiamato Near VOD (NVOD).

Naturalmente, affinché i clienti possano selezionare i vari contenuti tramite

telecomando, è necessario meccanismo che li visualizzi sul televisore, ovvero di una

GUI popolata con i vari contenuti disponibili. Per ottemperare a tale necessità, la

piattaforma dispone di un database che contiene tutte queste informazioni, dette

metadati, e di un sistema che le rende fruibili al Set Top Box. Tale sistema è

realizzato con un Web server che risponde dinamicamente alle richieste del STB che

è dotato di un comune Web browser.

Ma questi non sono gli unici servizi che una piattaforma di questo genere offre. In

generale, infatti, tali servizi si inseriscono nella cosiddetta offerta “Triple Play” per il

Cliente.

8

Introduzione

Capitolo 1

Il modello di questo servizio prevede di offrire al cliente, attraverso la piattaforma

trasmissiva ADSL, l’insieme dei servizi IPTV, di telefonia Voice over IP (VoIP) e di

accesso Internet.

Le prestazioni offerte sono in generale caratterizzate da una diversa priorità. In

particolare:

•

VoIP: alta priorità

•

IPTV: media priorità

•

Fast Internet: bassa priorità (servizio offerto in modalità best effort)

Il controllo di accesso da parte dell’utentza alla rete è effettuato mediante un

sofisticato sistema di controllo degli accessi, fornito da NDS, leader mondiale di

sistemi di protezione. Per prevenire la visione non autorizzata, anche qualora l’utente

abbia effettuato con successo l’accesso alla rete, è previsto un meccanismo di

autenticazione dell’utente e codifica dei contenuti detto Conditional Access. Questi

aspetti si differenziano a seconda della tipologia di servizio BTV o VOD e

impiegano meccanismi che verranno presentati in seguito. Naturalmente, è stata

prevista anche la possibilità di trasmettere video non soggetti a processo di

encrypting. È il caso dei canali cosiddetti “clear service”, ma anche dei trailer dei

film e dei messaggi promozionali.

La piattaforma di gestione è stata fornita ad un operatore di telefonia fissa che

intende lanciarsi sul mercato nazionale dei servizi televisivi. Il lavoro svolto si

colloca quindi sia nell’ambito della messa in opera dell’infrastruttura di rete che, nel

livello applicativo, con lo sviluppo del software descritto in questa tesi.

In particolare, il contributo al livello rete è stato nel seguire le attività di deployment

e testing dell’infrastuttura di rete stessa,

impegno che ha richiesto corsi di

formazione specialistici presso le strutture del fornitore della piattaforma, site in

9

Introduzione

Capitolo 1

Belgio (Anversa). La formazione è stata soprattutto orientata alla conoscenza dei

modi operativi e delle configurazioni di apparati di rete, quali video server, switch

IP, load balancer, firewall. Queste attività, pur non investendo direttamente il piano

applicativo è stata preziosa per l’apprendimento del funzionamento di diversi

apparati ed ha consentito l’approfondimento di problematiche che sono tornate utili

in momenti successivi, specie in fase di gestione delle anomalie del servizio.

Altra attività formativa è stata effettuata presso UK, dove sono stati approfonditi

aspetti relativi ai meccanismi di sicurezza, conditional access, ed alla struttura del

database della piattaforma.

Il carattere trasversale dell’attività formativa è stato il presupposto per lo sviluppo di

un software che svolge una integrazione tra sottosistemi della piattaforma e

l’ambiente esterno, costituito dai fornitori di contenuti, ovvero i content provider. Il

contributo, fornito dal software sviluppato in questo lavoro, si colloca infatti a

cavallo di due sistemi distinti, realizzando così una interfaccia tra essi.

Da un lato ci sono i content provider che forniscono i contenuti in chiaro. Dall’altra

parte c’è la piattaforma stessa che acquisisce il materiale costituito da video,

immagini e metadati, per renderlo fruibile. Il software garantisce che la parte dati,

ovvero i video contenuti multimediali veri e propri vengano eventualmente sottoposti

ad encrypting e poi distribuiti nei server che si occuperanno dello streaming. La parte

metadati di tale materiale dovrà invece popolare il database che gli utenti andranno a

consultare con il telecomando, per la fruizione dei video. Il processo descritto va

sotto il nome di “processo di ingestion” e la tesi ne riporta tutte le fasi.

È stata condotta una analisi dei requisiti secondo tecniche formali e con l’uso di

strumenti ormai tipici dell’ Ingegneria del Software. Le specifiche sono state studiate

e raffinare allo scopo di pervenire ad un modello che rappresentasse il sistema da

realizzare. A questo modello sono state applicati analisi approfondite tese ad

ottimizzare i flussi di lavoro. La specifica dei requisiti si è andata raffinando

10

Introduzione

Capitolo 1

trasformandosi in una specifica di progetto e da questo il “software di ingestion” che

rappresenta il punto di arrivo del lavoro svolto.

Il sistema realizzato è stato sottoposto a test di accettazione ed a stress test, poi

messo in esercizio, dove ormai è diventato un sistema “h24” ormai indispensabile

anello della catena di elementi che offre servizi.

11

Architettura di Rete

Capitolo 2

Capitolo 2

Architettura di Rete

L’infrastruttura predisposta, comprensiva del centro servizi, della rete di

distribuzione a livello nazionale e a livello metropolitano, della rete d’accesso e

dell’home network, è stata progettata per essere idonea, come dimensionamento,

grado di diffusione, livelli di sicurezza e qualità del servizio, alla distribuzione del

segnale video agli utenti potenziali esistenti su tutto il territorio italiano.

L’offerta IPTV si rivolge all’utenza dotata di un collegamento ADSL con banda di

circa 3 Mbit/sec. Tale caratteristica è necessaria per poter fruire video con Transport

Stream (TS) pari Mbit/s. La codifica utilizzata, infatti, prevede l’adozione del

formato MPEG-2 con TS di 2750 Kb/s per il video ai quali si aggiungono 128kb/s

per l’audio. L’eventuale futura l’introduzione della codifica MPEG-4 consentirebbe

di utilizzare bit rate inferiori senza perdita di qualità. La piattaforma adottata impiega

un sistema per la gestione dell’accesso condizionato che differisce a seconda del

servizio richiesto dall’utente [4]. Per tale ragione, le problematiche di accesso

condizionato verranno descritte insieme ai servizi cui esse stesse sono legate.

La realizzazione e la distribuzione dei servizi descritti in precedenza è incentrata

sull’architettura End-To-End, descritta in Figura 1:

12

Architettura di Rete

Capitolo 2

M edi a M a n a ger 5950

DB a nd Apps ser ver s

Sun Fi r eV240

S TB

unicast MW , dhcp, tftp

Th o m so n

ST610 &

D SL 1500

m tftp, LP, C G, PG

AA

SSAA

M

M

S TB

ASAM V5

igmp@ nt

M anag e m e nt NW

Th o m so n

ST610 &

D SL 1500

GE

Acce ntu r e

IP - GBE

O ptical Ring

(DW DM )

VO D & nP VR HP Cl u ster G 3

GE

O PB

BTV Hea dEnd T a nd ber g

SD I ?

Satellite dis h

S TB

A SI ?

QPSK ?

IR D 1..10

MPEG-2

encoders

1..10

IP encapsulator

1.. ?

Th o m so n

ST610 &

D SL 1500

AA

SSAA

M

M

GE

GE

igm p@ nt

Centro Servizi

Rete di

Distribuzione

S

STB

TB

ASAM V5

Rete

d'A ccesso

Th o m so n

ST610 &

D SL 1500

Hom e

Network

Figura 1 - Architettura Generale

Dal layout architetturale è possibile distinguere:

Rete d’accesso:

Rete di distribuzione

Centro Servizi: costituisce l’Head-End a livello nazionale e ospita i

dispositivi BTV, i moduli della piattaforma IPTV quali VOD server, servizi

IP (DHCP, DNS,...) e AS (Application Server). Il Centro Servizi, dopo aver

acquisito i flussi audio/video e informazioni di programmazione, li

ridistribuisce opportunamente attraverso il backbone IP.

2.1 Home Network

La fornitura dei servizi IPTV implica la predisposizione di alcuni apparati a casa

cliente e la soluzione adottata per realizzare l’impianto domestico si basa sulla

tipologia di splitter distribuito, come descritto in Figura 2.

13

Architettura di Rete

Capitolo 2

Rete Telecom

ADSL + POTS

NTR

(Borchia con POTS

Splitter distribuito)

Rete domestica

ADSL + POTS

POTS Splitter

POTS Splitter

ADSL+

POTS

AG

STB

Eth.

Eth.

Figura 2 - Home Network

Il doppino telefonico, proveniente dalla centrale è terminato, attraverso la borchia in

sede cliente, sull’Access Gateway (AG) ADSL.

Il STB è connesso all’AG attraverso un cavo UTP Cat. 5.

Il collegamento fra il STB ed il televisore è realizzato mediante un cavo SCART.

L’utilizzo di POTS Splitter separa le frequenze di fonia da quelle dati. Può essere

valutata anche la possibilità di connettere il STB all’ Access Gateway in modalità

wireless, il che comporterebbe l’introduzione dei moduli Wi-Fi sull’Access Gateway

e sul STB [4].

2.1.1 Il Set Top Box

IL STB utilizzato durante il lavoro è l’AmiNET110 di AMINO, mostrato in Figura 3.

14

Architettura di Rete

Capitolo 2

Figura 3 - Il STB AmiNET 110 AMINO

Di seguito sono indicate le caratteristiche principali dell’apparato.

•

•

•

•

•

•

•

•

•

•

•

•

•

•

•

La

OS: LINUX

Java Based

Browser: ANT Fresco

Supporto della release OMP utilizzata e certificazione NDS

Output: sono possibili le seguenti opzioni cavo per l’audio/video:

o Composito, RGB, S-Video, Stereo Audio

o PAL and NTSC

o formati 4:3 and 16:9

o Digital Audio via S/P-DIF

Input: 10/100BaseT Ethernet

USB 1.1

IR Remote Control ( gestione Set-Top e TV )

MPEG1 & 2 MP@ML at up to 10 Mbps

Grafica colori a 24 bit con alpha-blending e picture in graphics

Protocollo per ricezione canali: Multicast IPTV (IGMP control)

Protocollo DHCP per richiesta indirizzo IP

Multicast boot optino

Gestione da remoto e software upgrade da rete

Protezione Macrovision

piattaforma è dipendente dal particolare Set Top Box. Questo perché il firmware

dello stesso deve essere in grado di effettuare la navigazione delle EPG. Quelle

elencate, sono le caratteristiche minime richieste ad ogni Set Top Box che si intenda

usare [4].

15

Architettura di Rete

Capitolo 2

2.2 Rete di accesso

La rete di accesso è costituita dai DSLAM (DSL Access Multiplexer) Alcatel

ASAM. E’ mostrata in Figura 4. L’interconnessione con Gb Ethernet degli ASAM

all’infrastruttura DWDM avviene direttamente tramite Gb Ethernet Feeder, attestati

sull’anello ottico per il trasporto del traffico verso il Centro Servizi.

Figura 4 - Access Network

La diversità dei servizi richiede la differenziazione delle caratteristiche di traffico

sulla rete d’accesso così da poter ottimizzarne il trasporto. In particolare, ad ogni

utenza sono stati associati due PVC, tramite i quali, l’Access Gateway è connesso

alle seguenti tipologie di traffico:

1. PVC 8/35 per High Speed Internet;

2. PVC 8/36 per IPTV

Il DSLAM ASAM è configurato per il supporto del Residential Bridging,

funzionalità che permette di associare i differenti PVC alle VLAN metropolitane

definite sull’anello DWDM. In particolare, sull’anello ottico è prevista la definizione

delle seguenti VLAN:

1. VLAN High Speed Internet: convoglia a livello metropolitano il traffico

High Speed Internet di tutti gli utenti;

2. VLAN VOD / BTV / Controllo convoglia a livello metropolitano il traffico

VOD, BTV e di controllo per di tutti gli utenti.

16

Architettura di Rete

Capitolo 2

2.3 Rete di Distribuzione metropolitana

La rete di distribuzione a livello metropolitano, in Figura 5, è basata su tecnologia

Gigabit Ethernet. La gerarchia degli apparati utilizzati prevede un livello Metro, che

acquisisce i flussi Video provenienti dal Centro Servizi IPTV attraverso OPB, ed un

livello Feeder che distribuisce ai DSLAM il bouquet dei canali multicast. Il traffico

Video, che viaggia criptato su tutta l’infrastruttura di rete fra il Centro Servizi IPTV e

il STB, è segregato a livello logico da altri tipi di traffico che potrebbero essere

presenti in rete sulla rete di distribuzione metropolitana. La qualità del servizio è

garantita dalla priorità con cui sono marcati i pacchetti video inviati [4].

Figura 5 - Rete di distribuzione

Gli Edge Router costituiscono il confine tra il Centro Servizio IPTV e la rete esterna.

Si interfacciano, lato rete di distribuzione, con gli apparati Metro MAN GbE di

Roma [4].

17

Architettura di Rete

Capitolo 2

2.4 Centro Servizi IPTV

Il Centro Servizi IPTV è costituito dagli apparati necessari al rilascio dei flussi video

da distribuire in rete, oltre a database, sistemi di bilanciamento del carico di lavoro.

Sono presenti anche firewall, nonché l’hardware ed il software di NDS che

garantiscono l’accesso condizionato.

L’insieme di tutte queste apparecchiature è collocato all’interno di una struttura

progettata per ospitare apparati che forniscono servizi di pubblica utilità, strategici,

quindi in grado di garantire adeguati livelli di sicurezza e di controllo [4].

2.4.1 Caratteristiche generali

Il Centro Servizi IPTV si basa sulla piattaforma di erogazione dei servizi video OMP

integrata, relativamente agli aspetti di security, con il Conditional Access (CA). La

Figura 6, ne descrive sinteticamente la struttura.

Figura 6 - Centro Servizi IPTV

18

Architettura di Rete

Capitolo 2

I flussi video, già codificati al bit rate che deve essere distribuito in rete e provenienti

dalla rete di contribuzione, sono convogliati in ingresso a due Ethernet Switch. Da

questi, i flussi sono stati trasferiti agli encryptor [14] e agli IP encapsulator [13].

Le uscite degli encryptor sono nuovamente convogliate attraverso due ulteriori

switch collegati agli Edge Router, che quindi forniscono connettività verso la

piattaforma di rete utilizzata per la connessione con Il STB.

Nel centro servizi sono installati l’hardware ed il software della piattaforma IP TV

nonché i sistemi di DHCP per assegnazione degli indirizzi dinamici dei STB.

Tutte le macchine utilizzate sono in cluster per la gestione della ridondanza. La

protezione del Centro Sevizi IPTV è garantita dai Firewall (FW) e la distribuzione

del traffico dai Load Balancer (LB). La Figura 7 mostra la struttura dell’ head-end.

19

Switch 5

20

trunk

20

11

20

Switch 3

1.11

21

trunk

19

2.2

DHCP

OMP

DB

Web Caches

192.168.67.11

192.168,66.121

192.168.66.51

192.168.65.201

VIP 192.168.67.14 VIP 192.168.66.127 VIP 192.168.66.63 VIP 192.168.65.254

Vlan 130

Vlan 127

Vlan 126

Vlan 125

SC

192.168.67.37

VIP 192.168.67.38

Vlan 131

.3

1.16

sync

2.1

1.11

DHCP

OMP

DB

Web Caches

OVS

OMCM

192.168.67.12

192.168,66.122

192.168.66.52

192.168.65.202

192.168.66.182

192.168.66.252

VIP 192.168.67.14 VIP 192.168.66.127 VIP 192.168.66.63 VIP 192.168.65.254 VIP 192.168.66.191 VIP 192.168.66.254

Vlan 130

Vlan 127

Vlan 126

Vlan 125

Vlan 128

Vlan 129

.4

1.16

LB3

.129

Vlan 122

11

Switch 4

21

19

2.2

OVS

OMCM

SC

192.168.66.181

192.168.66.251

192.168.67.36

VIP 192.168.66.191 VIP 192.168.66.254 VIP 192.168.67.38

Vlan 128

Vlan 129

Vlan 131

2.1

.130

10.10.35.0/24

VIP .142

22

22

82.54.192.128/28

3

.131

.132

eth3

eth1

FW1

20

eth3

10.10.25.0/24

.10

.20

eth1

19

FW2

management

20

management

eth0

eth 2

eth 2

.147

Trunk

To

Switch 1

eth0

.148

1

1

82.54.192.144/28

Vlan 120

Vlan 120

VIP .158

21

Switch 1

Vlan 122

3

19

Trunk

To

Switch 2

Switch 6

Text

20

21

.146

.145

2.2

LB1

1.16

2.1

.1

sync

Switch 2

2.2

10.10.15.0/24

.2

LB2

1.16

2.1

.193

.194

.195

.196

VIP .206

Edge routers

Figura 7 - Layout di rete

19

82.54.192.192/28

Architettura di Rete

Capitolo 2

2.4.2 Load balancer

Il load balancing viene introdotto per cercare assicurare variazione lineare dei tempi

di risposta al variare delle richieste. In altri termini, contribuisce alla scalabilità del

sistema. L’apparato adottato è il BIG IP 2400 prodotto dalla F5 Networks [15].

Sono stati introdotti due livelli di load balancing, a monte ed a valle dei firewall.

Chiameremo Stadio Esterno la coppia di load balancer che si interfaccia con gli edge

routers, quindi, lato utente (STB). Questo assicura la scalabilità verso i firewall.

Chiameremo Stadio Interno la coppia di load balancers che regola il flusso di

informazioni tra head-end (server) e i firewall. Questo assicura la scalabilità verso la

piattaforma.

Ad ogni stadio, i load balancers sono stati ridondati con tecnica di active/stand-by.

Per tale ragione, sono stati interconnessi tra loro ad ogni stadio per la condivisione

dello stato. Sono anche dotati di un indirizzo IP virtuale che fa sì che essi siano visti

come unica entità di load balancing.

Tutti i load balancer sono dotati di interfaccia ethernet e di indirizzo IP. Sono

configurabili via browser tramite protocollo HTTPS e via SSH.

I due load balancer, LB1 ed LB2, sono connessi attraverso due interfacce ethernet

all’ingresso dei firewall: una connessa verso il lato utente (via access router), l’altra

verso l’ingresso del sistema (attraverso il firewall).

Un’ulteriore interfaccia su ciascun load balancer viene utilizzata per scopi di

gestione. Inoltre, essi sono interconnessi per scambiare informazioni sullo stato. Un

indirizzo IP virtuale (VIP) viene utilizzato dai load balancer per rispondere agli

utenti. In altre parole, piuttosto che utilizzare l’indirizzo fisico di ogni singolo load

balancer, si è preferito virtualizzare la risorsa. Questo per assicurare che, a fronte di

un disservizio di un load balancer, si continui ad avere la possibilità di comunicare

con il sistema passando per l’altro load balancer. Analogamente, un altro VIP viene

utilizzato dai load balancer per rispondere al sistema. Ovvero, piuttosto che

connettersi direttamente all’indirizzo fisico di ogni singolo load balancer, il sistema

potrà comunicare con l’indirizzo virtuale. Questo per garantire che a fronte della

caduta del load balancer, il sistema potrà continuare a funzionare utilizzando l’altro

20

Architettura di Rete

Capitolo 2

load balancer. È possibile, attraverso l’interfaccia di gestione via HTTPS, lanciare

una sessione di console basata su OpenSSH.

Figura 8 - Schema architetturale stadio esterno

La Figura 8 illustra quanto esposto.

La configurazione del Load Balancer 1 (LB1) prevede 4 interfacce corrispondenti ad

altrettante vlan:

•

FW_ext (vlan0): è esposta lato head-end

•

Admin (vlan1): destinata all’amministrazione

•

External (vlan2): è esposta lato utente

•

Sync_failover (vlan4): per la condivisione dello stato tra i 2 load

balancer

Nello stadio esterno, essendo le richieste dell’utenza uniformi per tipologia di

servizio invocato, non sono state adottate particolari regole di load balancing.

L’unica politica adottata è quella di round robin verso i firewall (82.54.192.147 e

.148). Per verificare la disponibilità dei firewall, viene eseguito un polling via ping.

In caso di mancata risposta di uno dei firewall, il pool di destinazione si restringe

all’unico rimasto disponibile. In Figura 9 è visibile la parte della GUI che mostra la

gestione della Network Map.

21

Architettura di Rete

Capitolo 2

Figura 9 - Virtual Server and Nodes - Network Map

La configurazione del secondo Load Balancer (LB2) è identica a quella già

descritta per LB1. La GUI che consente l’amministrazione dei load balancer

prevede numerose funzioni, tra cui:

•

Implementazione di regole definibili dall’utente

•

NAT

•

Statistiche

•

Consultazione di Log con uso di filtri

Come accennato, lo stadio interno provvede alla scalabilità tra livello dei firewall e

lato head-end.

Ogni load balancer dispone di un’interfaccia di configurazione e management via

HTTPS e SSH. Anche a questo stadio, i load balancer sono interconnessi per

scambiare informazioni sullo stato. Sono ridondati in modalità active/stand-by.

Lo stadio interno utilizza un unico indirizzo VIP con il quale viene “visto” dal lato

head-end. Analoga configurazione è stata adottata per l’interfaccia verso i firewall.

22

Architettura di Rete

Capitolo 2

Questo assicura che, a fronte di malfunzionamenti di uno dei load balancer, l’altro

entra in funzione senza provocare disservizio.

Figura 10 - Stralcio Schema architetturale LB3

Nella Figura 10, il load balancer LB4 è stato omesso in quanto simmetrico.

Analogamente a quanto accade per lo stadio esterno, anche qui, allo scopo di

verificare la disponibilità delle destinazioni, viene eseguito un polling su tutti gli

elementi dei pool. In caso di mancata risposta da parte di un host, questo viene

escluso dalla lista di possibili destinazioni, per poi ritornarvi quando si renderà

disponibile. Il polling è stato customizzato per ogni tipologia di servizio o protocollo.

Lo stadio di Load Balancing interno dispone di diverse interfacce atte a distribuire il

traffico su differenti VLAN.

Descrizione della configurazione delle VLAN

•

FW_int: (vlan0)

82.54.192.129

23

Verso

Architettura di Rete

Capitolo 2

Firewall

•

82.54.192.142

VIP Switch

82.54.192.139

DNS

82.54.192.136

HTTP MTA

82.54.192.138

HTTP SKY

82.54.192.140

DHCP SKY

82.54.192.135

RTSP

82.54.192.137

NTP

admin: (vlan1)

192.168.65.153 interfaccia management LB3

192.168.65.156 VIP

•

sync_failover: (vlan2) Collegamento tra i due load balancer 10.10.35.3

LB3

10.10.35.4 LB4

•

int_WC: (vlan3) VLAN Web Cache

192.168.65.201 indirizzo interfaccia verso WC

192.168.65.254 VIP WC

•

int_DB: (vlan4) VLAN DB

192.168.66.51 indirizzo interfaccia verso il DB

192.168.66.62 VIP

•

int_OMP: (vlan5)

192.168.66.121 indirizzo interfaccia verso OMP

192.168.66.126 VIP

•

int_DHCP: (vlan6) VLAN DHCP

192.168.67.11 indirizzo interfaccia verso DHCP

192.168.67.30 VIP

24

Architettura di Rete

•

Capitolo 2

int_SC: (vlan7) VLAN Service Control

192.168.67.36 indirizzo interfaccia verso SC

192.168.67.38 VIP

192.168.67.39

192.168.67.50

192.168.67.51

•

int_OVS: (vlan8) VLAN OVS

192.168.66.181 - indirizzo interfaccia verso OVS

192.168.66.190 – VIP

•

int_CMDM: (vlan9)

192.168.66.251 – indirizzo interfaccia verso CMDM/OVS/XTV-Enc

192.168.66.254 - VIP

192.168.66.250

Il load balancer dispone di Virtual Server. Questi rispondono alle richieste

provenienti dall’esterno e distribuiscono il traffico su appositi Pool con politica

round robin, come mostrato in Figura 11 :

Figura 11 - Virtual Server e Pool

25

Architettura di Rete

Capitolo 2

Ad esempio, per il virtual server DNS, si ha

82.54.192.139:53

0 Pool: Pool_DNS

Ovvero, il traffico in ingresso verso 82.54.192.139:53 viene distribuito al Pool_DNS

e cioè verso gli indirizzi 192.168.66.101 e .102, con politica round robin, sulla porta

53.

La configurazione del Load balancer LB4 è identica a quella di LB3.

2.4.3 Firewall

La protezione della piattaforma è affidata a due firewall montati in configurazione

cluster. l firewall sono stati posizionati tra i due stadi di load balancing visti in

precedenza. In tal modo, il carico in ingresso al blocco firewall risulta bilanciato

dallo stadio esterno ed è possibile mantenere la scalabilità complessiva

semplicemente aggiungendo altri firewall in cluster, come mostra la Figura 12.

Figura 12 - stralcio layout di rete comprendente i firewall

I due firewall, FW1 ed FW2 sono connessi a:

•

stadio interno del load balancing (lato head-end, indirizzato con VIP

82.54.192.142)

26

Architettura di Rete

Capitolo 2

VLAN 120: 82.54.192.128/28

FW1: 82.54.192.131

FW2: 82.54.192.132

•

stadio esterno di load balancing (lato utente, indirizzato con VIP

82.54.192.158)

VLAN 122: 82.54.192.144/28

FW1: 82.54.192.147

FW2: 82.54.192.148

•

interconnessione FW1 – FW2

VLAN 10.10.25.0/24

FW1: 10.10.25.10

FW2: 10.10.25.20

I firewall non proteggono gli streaming server per motivi di performance (essendo

costoso utilizzare firewall capaci di gestire centinaia di strem di molteplici Mbps

ciascuno). Comunque, la soluzione realizzata per questo progetto prevede che i video

server abbiano abilitati appropriati meccanismi di packet filter, in modo che solo le

porte RTSP risultino aperte per la comunicazione con i STB dei clienti, mentre le

altre porte risultino sbarrate.La configurazione del firewall è stata condotta definendo

Network, Nodi e Gruppi ed associando le relative policy. In questo modo, si

definiscono le action da adottare (accept / drop) quando un host / network / group

tenta di accedere ad un service loalizzato in una destination. La destination può

essere host/network/group. Naturalmente, l’host può essere anche identificato da un

VIP (virtual IP address).

Il sistema Firewall adottato è

il NG with Application Intelligence, prodotto

Checckpoint Software Technologies [16]. In Figura 13 e visibile una parte della

GUI.

27

Architettura di Rete

Capitolo 2

Figura 13 - Firewall GUI e stralcio delle policy

2.5 OMP Application Environment

L’ambiente applicativo OMP [7] può essere rappresentato graficamente dalla Figura

14, che ne descrive un’implementazione a livello logico. È possibile riconoscere

blocchi già descritti in precedenza, quali load balancer e firewall, ma si nota la

presenza di altri elementi che andremo ad analizzare in questo paragrafo. In

particolare, si trovano:

Web Cache

Application Server

DataBase Server

Datastore

Gli altri elementi, OVS (Open Video Server) Central ed Edge verranno descritti in

seguito.

28

Architettura di Rete

Capitolo 2

Content Files from

studio providers

OVS Edge

Distributed Servers

OVS Central

Content Library

OMP Server Cluster

IE6 web

browser

platform

App Server

for OMP

Manager

Oracle 9i

RAC

Load

balancers

Load

balancers

DataStore

OMP DB

Servers

OSS API

OMP

OMP ++ OMDM

OMDM ++ OVS

OVS

Schemas

Schemas installed

installed in

in one

one 9i

9i

RAC

RAC implementation

implementation for

for

resilient

storage

&

per

resilient storage & per

formant

formant subscriber

subscriber

transactions

transactions

Web Caches

OMP App

Servers

“Stateless”

“Stateless” App

App Servers

Servers field

field

user

user transactions

transactions related

related to

to

applications

applications and

and account

account

services,

using

clustering

for

services, using clustering for

scalability

scalability and

and highhighavailability

availability

Firewalls

Web

Web caches

caches

service

service user

user

requests

requests for

for

content

content which

which is

is

not

personalized

not personalized or

or

fast

fast changing

changing in

in

time

time (e.g.

(e.g. EPG,

EPG,

images,

images, VoD

VoD titles)

titles)

Firewalls

Firewalls filter

filter all

all

user

user requests

requests

which

which do

do not

not

comply

comply to

to the

the

applicable

rules

applicable rules

(telnet,

(telnet, access

access

to

to other

other hosts,

hosts,

...)

...)

Figura 14 - Environment applicativo della piattaforma

2.5.1 Web cache

I Web Cache sono sistemi software hanno lo scopo di contenere le pagine che più

frequentemente sono richieste da parte dei STB, riducendo così la quantità di

richieste che devono giungere fino agli Application Server .

Come per i firewall, l’impiego di web cache multiple offre ridondanza e scalabilità. I

load balancer assicurano che il totale carico dai STB utenti venga distribuito tra le

web cache disponibili.

In questa particolare architettura ciascun web cache è connesso con una singola

interfaccia ethernet su di una VLAN ridondata per ricevere e rispondere alle richieste

utente.

A fronte della rottura di un singolo web cache, il load balancer sposterebbe il traffico

direttamente dal web cache al server che è logicamente associato con il web server

non utilizzabile.

Una seconda interfaccia ethernet in ciascun web cache è connessa ad una VLAN

ridondata ed utilizzata come relay per le richieste di oggetti non memorizzabili da

parte degli application server.

29

Architettura di Rete

Capitolo 2

Una terza interfaccia Ethernet presente sui web cache è utilizzata per scopi di

gestione.

Esiste una relazione uno-a-uno fra i web cache e gli application server. In altri

termini, il web cache 1 si collega all’application server 1, mentre il web cache 2 si

collega all’application server 2.

In caso di mancanza di servizio del web cache, il load balancer ruoterebbe il traffico

direttamente al corrispondente application server.

2.5.2 Application Server

L’Application Server utilizza il Middleware di OMP [7], ed è costituito dalle

applicazioni client-server della piattaforma IPTV e per organizzare i processi interni

alla piattaforma chiamati durante le diverse fasi del servizio.

Quando oggetti non memorizzabili in cache sono richiesti dai STB utenti, le web

cache effettuano richiesta agli application server.

Come per i firewall e le web cache, gli application server forniscono ridondanza e

scalabilità. Il carico totale dai STB utenti è distribuito tra i web application server

disponibili, passando per le web cache come intermediari logici.

2.5.3 Database Server

Il Database Server contiene le informazioni sui clienti presenti ed il Middleware di

OMP. Così come per i firewall, le web cache e gli application server, i database

server multipli forniscono ridondanza e scalabilità.

In questa particolare soluzione, i database server sono organizzati in un cluster.

Entrambi i database server sono connessi, attraverso una singola interfaccia Ethernet,

ad uno switch ridondato per ricevere e rispondere alle richieste provenienti dagli

application server. Il completo guasto di un singolo switch causerebbe la redirezione

di tutto il traffico sulla web cache ancora raggiungibile.

Inoltre entrambi i database server sono interconnessi da collegamenti Ethernet con

banda a 4 Gb/s, a supporto del cluster.

Un interfaccia Fast Ethernet aggiuntiva è fornita su ciascun database server per scopi

di gestione.

30

Architettura di Rete

Capitolo 2

Lo storage array è interconnesso attraverso una coppia di canali in fibra ottica ai

database server.

2.5.4 WebCAM Server

Il WebCam server è un software per la gestione dei Customer Account. Mediante

tale tool si può attuare:

–

Account management and monitoring

–

Gestione dei Set Top Box

–

ECM Manager (per il conditional access)

–

Reporting

–

System configuration management

–

VOD New Entry

–

EPG Manager Control and Monitoring

–

SKYREP Control and Monitoring

La Figura 15 sintetizza l’architettura funzionale del tool:

Figura 15 - Componenti del tool Web Cam

Le funzionalità che tale strumento mette a disposizione sono molteplici, ma si

riportano le più significative.

Customer Maintenance

•

Create/Edit (Account/User/Inventory)

31

Architettura di Rete

•

Edit subscription

•

VOD status

•

•

–

Verifica di cosa ha comprato/visto un cliente

–

Abilitare l’accesso a un VOD content

Pay per View status

–

Verifica di cosa ha comprato/visto un cliente

–

Abilitare l’accesso a un PPV event

BTV status

–

•

Capitolo 2

Verifica di cosa ha comprato un cliente

Billing status

Provisioning

•

Provisioning status (gestione utenze)

Set Top Box Maintenance

•

Edit/View configuration details

•

Firmware upgrade

•

Remote control (reboot, ping, etc.)

Report

•

VOD (by tile, by period)

•

Pay per View (by event, by period)

•

Subscriptions (by package, by period)

•

BTV (by event, by title)

•

Content provider report (by title, by bundle, etc.)

32

Architettura di Rete

Capitolo 2

SC SERVERS¨ACCENTURE

Service Control

192.168.25.64/26

DATA CENTER

.111

R1

R2

vlan 131

192.168.67.16/27

OMP SERVERS

OMP1

vlan 131

192.168.67.42

DHCP Server

vlan 130

192.168.67.0/27

OMP2

vlan 131

192.168.67.43

SWITCH 4

WEBCAM

172.16.251.4/30

.6

.5

802.1Q

.2

.1

172.16.251.0/30

GE

.22

FTP SERVER

FTP1

vlan mgmt_server 123

192.168.65.98

16-port Sun

StorEdge

2 Gb FC Switch 1

vlan 126

192.168.66.0/26

Cluster

Sun

StorEdg

e 3510

FC

Array

6x73GB

ISDN

.3

802.1Q

TRUNK

16-port Sun

StorEdge

2 Gb FC Switch 2

10.10.35.0/24

.4

GE

802.1Q

SWITCH 3

DB CLUSTER OMP

FIREWALL-ACCENTURE

traffic flow of the ACN devices

Figura 16 - Rappresentazione logica delle connessioni

2.6 DHCP Server

Il DHCP Server assegna gli indirizzi IP che saranno utilizzati dai STB dei clienti una

volta che si siano presentati in rete [31]. È protetto dai Firewall di piattaforma in

modo da accettare solo richieste (DHCP Discovery e Request) provenienti dalle linee

dei STB su cui è stato fatto provisioning dei clienti IPTV.

Il DHCP Server assegna gli IP secondo un criterio geografico: ai STB di un

determinato DSLAM in rete sono assegnati indirizzi appartenenti alla medesima

subnet.

La Figura 16 riporta uno schema logica delle connessioni all’interno dell’head-end.

33

Architettura di Rete

Capitolo 2

2.7 Contribuzione

Il segnale audio/video, prelevato dai broadcaster, viene encodato e incapsulato in IP,

per essere successivamente critptato, mediante uno stadio che viene comunemente

chiamato “di contribuzione”.

All’interno del Centro Servizi IPTV sono presenti tutti i sistemi di compressione,

transcondifica e scrambling dei flussi, provenienti dallo stadio di contribuzione, per

la distribuzione verso l’utenza finale.

La compressione, effettuata in conformità con lo standard MPEG-2, è implementata

con una soluzione composta da una batteria di encoder (uno per canale) in

ridondanza N+1 con commutazione automatica ed immediata sul backup in caso di

guasto [4].

La tecnologia scelta è allo stato dell’arte ed assicura un efficiente livello di

compressione associato alla migliore qualità video possibile per la banda disponibile.

Le caratteristiche delle varie componenti compresse facenti parte del segnale

trasmesso sono le seguenti e sono comunque modificabili.

larghezza di banda del canale IP di trasporto:3.5 Mbit/s

codifica video MPEG2 2750Kb/s

risoluzione video: 480x576

aspect ratio: 4/3

codifica audio 128Kb/s (+128 Kb/s opzionale)

34

Il modello e l’erogazione dei servizi

Capitolo 3

Capitolo 3

Il modello e l’erogazione dei servizi

In questo capitolo vengono descritti in dettaglio i servizi della piattaforma. Viene

descritta la modalità di funzionamento dei servizi Provisioning e Self Provisioning

intendendo, con questi termini, rispettivamente le operazioni necessarie ad ottenere il

primo ed i successivi accessi alla piattaforma. Verrà illustrato il sistema di sicurezza

adottato e verranno descritti i servizi BTV e VOD, anche qui, con i dettagli relativi

alle rispettive problematiche in termini di sicurezza.

3.1 Provisioning e Self Provisioning

Prima di descrivere il flusso di dettaglio delle informazioni, vengono

sinteticamente, in Figura 17, gli apparati coinvolti durante questa fase.

Figura 17 - Colloquio di Provisioning

35

riportati

Il modello e l’erogazione dei servizi

Capitolo 3

L’ architettura in figura mostra che sono stati utilizzati due PVC. Il primo (PVC1 –

VPI/VCI 8/36) per il traffico video, mentre il secondo (PVC2 – VPI/VCI 8/35) è

dedicato Fast Internet, VoIP.

La porta LAN utilizzata per raccogliere i flussi video è cablata sul PVC ATM 8/36.

Questa è configurata come

“DHCP transparent” [31] nel senso che il traffico

upstream dei messaggi DHCP (DHCP Discovery e DHCP Request) provenienti dal

STB non è intercettato dal DHCP Server dell’Access Gateway ma inoltrato verso il

DSLAM.

Per il servizio IPTV, il cliente utilizzerà, quindi, il PVC 8/36. Su questo PVC viaggia

sia il traffico multicast relativo ai canali di BTV, sia quello unicast relativo alla

fruizione di contenuti VOD. Infatti, la natura del servizio di tipo BTV (trasmissione

broadcast di tutti i canali disponibili), richiede il trasporto in rete mediante protocolli

multicast. Tutti i canali saranno, quindi, trasportati fino al singolo DSLAM.

All’accensione del Set Top Box, dopo il completamento delle procedure di

caricamento del software e attivazione, il STB stesso si sintonizza sul gruppo di

multicast relativo al primo canale BTV del pacchetto sottoscritto dal cliente.

Attraverso l’utilizzo del telecomando il cliente potrà quindi selezionare un ulteriore

canale o accedere alla Home Page del servizio IPTV.

Per permettere l’espletamento del servizio di IPTV si assume che i dati del cliente

siano caricati nella piattaforma OMP dagli operatori del Service Control (SC) all’atto

del primo accesso al servizio da parte dell’utente. Di seguito è descritto più in

dettaglio l’accesso dell’utente al servizio. Verranno distinti casi in cui si tratti di

primo accesso o di un accesso successivo.Gli apparati coinvolti in questo scambio di

messaggi sono

Set Top Box

DSLAM della rete di distribuzione

DHCP Server

Service Control (SC)

Il sistema di sicurezza per l’accesso condizionale (NDS Conditional Access)

36

Il modello e l’erogazione dei servizi

Capitolo 3

Il SC è il sistema di gestione clienti che detiene le informazioni relative gli account e

svolge ruoli di Customer Relationship Management (CRM). Il Conditional Access

di NDS [11] verrà invece descritto nel prossimo paragrafo e, contestualmente ai

servizi VOD e BTV, ne verranno descritte le interazioni con la piattaforma IPTV.

STB

DSLAM

DHCP

Service Control

DHCP Discover

DHCP Disc. completo

Richiesta Verifica TK

DHCP Offer

Esito Check

Reject

{OR}

DHCP Request

DHCP Request

Update Network Presence

NP Updated

DHCP ACK

Figura 18 - Assegnazione Indirizzo IP

Vediamo le fasi nel dettaglio [4], riportate anche in Figura 18.

1. All’accensione il STB effettua una richiesta broadcast DHCP (DHCP

Discover) per ottenere dal DHCP Server l’inizializzazione dello stack IP

(assegnazione dell’indirizzo IP, della Subnet Mask, del Gateway e

dell’indirizzo IP del Server DNS).

2. Il DSLAM, a cui è connesso il CPE dell’utente e che funge da DHCP relay

agent, dopo aver ricevuto il pacchetto DHCP effettua le seguenti operazioni:

a. Aggiunge le informazioni dell’opzione 82 suboption 2 (DSLAM IP,

DSLAM MAC, Porta, Slot, VPI, VCI); le informazioni aggiunte

costituiranno la chiave tecnica (TK) da passare a Service Control. La

37

Il modello e l’erogazione dei servizi

Capitolo 3

TK contiene le informazioni necessarie il riconoscimento della linea

cliente che richiede l’indirizzo IP.

b. Aggiorna il campo Relay IP Address nell’header;

c. Cambia l’IP sorgente del messaggio DHCP, ponendolo uguale

all’indirizzo IP dell’interfaccia su cui era stato ricevuto il messaggio;

d. Cambia l’IP di destinazione del messaggio DHCP, ponendolo uguale

all’indirizzo di unicast configurato per il DHCP server (situato

all’interno del Centro Servizi).

3. Quando il DHCP server riceve il pacchetto di DHCP DISCOVER, deve

interagire con il SC per stabilire se il STB è autorizzato ad accedere ai servizi.

A tal fine, controlla il campo option del pacchetto e cattura le informazioni

relative all’opzione 82 (DSLAM IP, DSLAM MAC, Porta, Slot, VPI, VCI) e

le invia al SC. Questi confronta i dati ricevuti con i corrispondenti campi

memorizzati nel proprio DB:

a. se il confronto ha esito negativo, il SC respinge la richiesta e invia un

messaggio di errore al DHCP server;

b. se il confronto ha esito positivo, il SC assegna i parametri di rete

(Subnet mask, Default gateway, DNS e Time Server) relativi alla TK

ricevuta.

4. Il pacchetto è inviato al DHCP Server, che aggiunge l’IP e le informazioni di

lease time e infine invia il pacchetto di DHCP OFFER al STB

5. Il STB riceve il pacchetto DHCP OFFER e risponde con un pacchetto

broadcast di DHCP REQUEST;

6. Il DSLAM, dopo aver ricevuto il pacchetto DHCP, esegue le seguenti

operazioni:

a. Aggiunge le informazioni dell’opzione 82 suboption 2 (DSLAM IP,

DSLAM MAC, Porta, Slot, VPI, VCI);

b. Aggiorna il campo Relay IP Address nell’header del DHCP;

c. Cambia l’IP sorgente del messaggio DHCP, ponendolo uguale

all’indirizzo IP dell’interfaccia su cui era stato ricevuto il messaggio;

38

Il modello e l’erogazione dei servizi

Capitolo 3

d. Cambia l’IP di destinazione del messaggio DHCP, ponendolo uguale

all’indirizzo di unicast configurato per il DHCP server.

7. Il DHCP Server riceve il pacchetto di REQUEST, estrae le informazioni

relative all’opzione 82 e l’indirizzo IP richiesto e li invia al SC per aggiornare

la Network Presence (NP);

8. In questa fase, se il SC invia un messaggio di conferma (NP aggiornata), il

server invia un DHCP ACK al STB; altrimenti invia un pacchetto di DHCP

NACK. Le opzioni 60 e 43 del protocollo DHCP [32] contengono anche

l’indicazione del tipo di Client che ha effettuato la richiesta (es.

“Aminoaminet110”): in base all’analisi di questo campo il DHCP Server può

assegnare l’IP solo ai modelli di STB previsti da Telecom Italia.

Di seguito sono descritti in dettaglio le fasi del processo nei casi di prima attivazione

del servizio e nel caso di attivazioni successive.

Caso di prima attivazione

Se si tratta di una prima attivazione, i passi procedono come di seguito descritto. In

caso di accessi successivi al primo, i passi procedono come descritto nel paragrafo

successivo e sono descritti in Figura 19.

9. STB richiede la URL di accesso al servizio IPTV. In realtà quella che gli

verrà proposta, poiché si tratta della prima attivazione, sarà una pagina di

“sign-on page”.

10. OMP richiede l’autenticazione dell’utente attraverso il meccanismo HTTP

Digest (RCF 2617): OMP invia al STB una HTTP Response con codice 401

(Unauthorized).

11. STB invia una ulteriore HTTP Request (Digest RFC 2617) con i parametri

della smartcard (SCID) e STB ID (MAC address).

12. OMP inoltra la HTTP Request a NDS.

13. NDS CA autorizza la smartcard e invia un OK a OMP.

39

Il modello e l’erogazione dei servizi

Capitolo 3

14. OMP controlla se il cliente si è già registrato in precedenza sulla piattaforma,

controllando lo user account e le informazioni utente nella piattaforma. In

questo caso è la prima volta che il cliente accede al servizio ed è invocato il

processo di registrazione. È stato ha realizzato un meccanismo che consente

alla piattaforma OMP di ottenere i dati per l’attivazione dell’utente (dati di

account, provisioning, etc.) direttamente da Service Control.

OMP richiede dunque al Service Control i dati relativi al Cliente.

15. Service Control invia tutti i dati del Cliente ottenuti durante la fase di preprovisioning.

16. OMP riceve queste informazioni, aggiunge un nuovo account nel sistema e

invia la “Welcome page” al STB per comunicare all’utente la corretta

registrazione.

17. L’utente preme il tasto OK per attivare il suo account in OMP.

18. OMP riceve la richiesta, attiva lo user account e notifica a NDS di attivare la

smartcard dell’utente.

19. NDS invia EMMs alla smartcard dell’utente.

20. Il STB richiede in HTTP la pagina di accesso al servizio IPTV con tutte le

componenti del framework ed i componenti della User Interface (HTML,

Javascript)

21. OMP invia al STB una HTTP Response con codice 401 (Unauthorized).

22. STB invia una HTTP Request con i parametri della smartcard (SC ID) e STB

ID (MAC Address).

23. OMP procede dunque all'invio della HTTP Request a NDS.

24. NDS autorizza l'utente e invia un OK a OMP.

25. OMP invia le pagine di framework e di applicazione al cliente.

40

Il modello e l’erogazione dei servizi

Capitolo 3

Figura 19 - Self provisioning automatico (primo accesso dell’utente)

Di seguito, invece, è descritto il processo di connessione del STB, autenticazione e

risoluzione dei diritti nel caso di un accesso al servizio successivo al primo, da parte

dell’utente [4], [11].

Caso di attivazioni successive

9. Il STB richiede in http la pagina di accesso al servizio IPTV

10. OMP invia al STB una HTTP Response con codice 401 (Unauthorized).

11. STB invia una HTTP Request con i parametri della smart card (SCID) e

STBID (MAC Address).

41

Il modello e l’erogazione dei servizi

Capitolo 3

12. OMP invia un messaggio HTTP Request a NDS.

13. NDS autorizza l'utente e invia un segnale di conferma ad OMP.

14. OMP controlla se il cliente si è già registrato in precedenza sulla piattaforma,

controllando lo user account e le informazioni utente nella piattaforma. Nel

caso che il cliente sia stato già registrato su OMP invia le pagine di

framework e di applicazione al cliente.

La Figura 20 riassume queste fasi. Per brevità, si omette la parte di assegnazione

dell’ indirizzo IP. Si assume cioè che il STB ne sia già provvisto.

STB

OMP

NDS CA

HTTP Request Home Page

HTTP Response Code 401

HTTP Request (SC ID + MAC)

Verify CA

OK

HTTP Home Page

Figura 20 - Richiesta servizio (accessi successivi al primo)

3.2 Gestione della sicurezza

Nei paragrafi precedenti si è parlato di Conditional Access NDS quale sistema per il

controllo degli accessi. In questo paragrafo vengono descritte le scelte ed i sistemi

adottati.

42

Il modello e l’erogazione dei servizi

Capitolo 3

Il sistema NDS CA [11] implica l’utilizzo di una Smart Card (SC) inserita nel Set

Top Box. Tuttavia, il funzionamento si discosta da quello tradizionale dei sistemi di

encrypting. Il sistema NDS è stato progettato proprio per l’industria del broadcast.

Generalmente, i sistemi di conditional access sono basati sul principio della

condivisione, da parte di entrambe le parti, di chiave pubblica / privata. Proprio

questa concezione non si adatta bene al mondo della trasmissione broadcast. In

questo scenario, infatti, solo l’operatore ha l’interesse di mantenere la comunicazione

sicura. All’utente finale non ha interesse nel mantenere segreti i contenuti e, nella

peggiore delle ipotesi, si potrebbe trattare di soggetti intenti a cercare modi per

aggirare la sicurezza

I sistemi basati su chiavi richiedono la trasmissione di chiavi private, anche se in

forma encryptata, ma è proprio questa trasmissione che rappresenta un punto debole

nei sistemi broadcast. Il sistema alla base di NDS parte da un principio diverso. NDS

ha adottato un approccio basato su un algoritmo che non richiede la trasmissione di

“segreti”. Anzi, sia nell’head-end che nel STB esistono algoritmi in grado di ricavare

tali codici.

Inoltre, per i sistemi tradizionali basati sullo scambio di chiavi si possono generare

problemi di gestione della eventuale distribuzione di codici. In altri termini, la

spedizione di chiavi in grado di assicurare ai subscriber la corretta fruizione dei video

richiede una larghezza di banda abbastanza grande. L’approccio basato su algoritmi

memorizzati non si basa sulla diffusione delle chiavi e quindi c’è un evidente

risparmio di banda. Nei sistemi cosiddetti “Key-Based”, quindi, i “segreti” risiedono

nelle coppie public/private key [10].

In un sistema “Algorithm-based”, il “segreto” risiede in un algoritmo. Lo stesso

algoritmo risiede sia in head-end che nella smart card ed è lo stesso per tutti gli

utenti.

Nel sistema CA NDS, per quanto appena esposto, un singolo messaggio di

autorizzazione al servizio, detto Entitlement Management Message (EMM) [11] può