Computazione per l’interazione naturale:

Regressione probabilistica

Corso di Interazione Naturale Prof. Giuseppe Boccignone

Dipartimento di Informatica

Università di Milano

[email protected]

boccignone.di.unimi.it/IN_2016.html

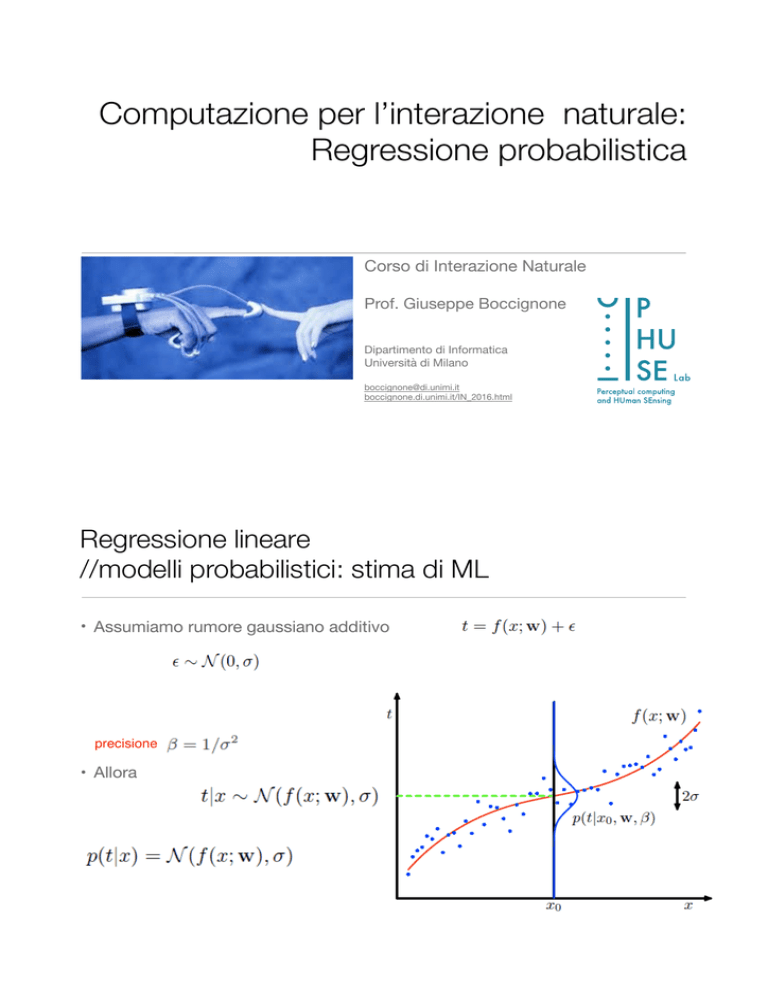

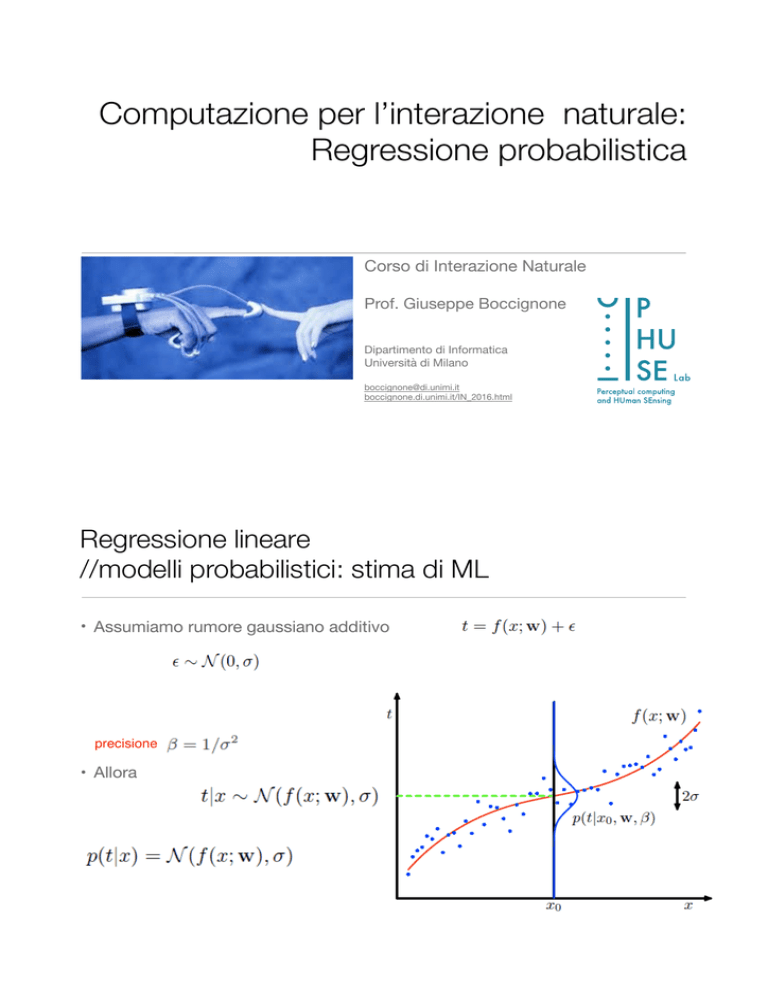

Regressione lineare

//modelli probabilistici: stima di ML

• Assumiamo rumore gaussiano additivo

precisione

• Allora

Regressione lineare

//modelli probabilistici: stima di ML

• Abbiamo N osservazioni nel

training set

• Considerando la probabilità

congiunta dei target

• Vogliamo stimare i parametri

w

Introduzione alla Statistica Bayesiana

//metodologia generale

• Obiettivo: predire un dato x sulla base di n osservazioni

S = {x1, . . . , xn}

• Tre step:

• Specifica del modello h con parametri di tuning

generazione dei dati in S

• Inferenza (learning dei parametri)

• Predizione

per la

Modello o

ipotesi h

Statistica Bayesiana

//stime puntuali

• Rinunciando ad un approccio completamente Bayesiano, si possono ottenere

stime puntuali dei parametri (ovvero i parametri diventano “numeri” e non VA)

• Stima Maximum A Posteriori (MAP)

• Stima di massima verosimiglianza (Maximum Likelihood, ML)

Esempio: stima di massima verosimiglianza

//caso Gaussiano

• Insieme di campioni x1, . . . , xn da distribuzione Gaussiana di parametri

ignoti (identicamente distribuiti)

• Campioni estratti indipendentemente:

• allora

• oppure usando la log-verosimiglianza

L’ipotesi

i.i.d

Esempio: stima di massima verosimiglianza

//caso Gaussiano

• Un vettore aleatorio

forma quadratica di x

• per il singolo campione

Esempio: stima di massima verosimiglianza

//

della Gaussiana

• Se

con covarianza nota e media da stimare

• per il singolo campione

• derivando il secondo termine rispetto a

(il primo è costante rispetto a teta)

• per tutti i campioni

• ponendo uguale a 0

media empirica

Esempio: stima di massima verosimiglianza

// Parametri della Gaussiana

• Se

con covarianza e media da stimare

• per il singolo campione

• derivando il secondo termine rispetto a

prima

e

ripetendo il procedimento di

media empirica

covarianza empirica

Regressione lineare

//stima di ML dei parametri

• Training set

• La likelihood è

L’ipotesi

i.i.d

funzione di costo

Regressione lineare

//modelli probabilistici: stima di ML

Funzione di

loss (errore)

quadratica

Regressione lineare

//modelli probabilistici: stima di ML

• Abbiamo che

max

min

punto stazionario

Regressione lineare

//modelli probabilistici: stima di ML

• Abbiamo che

max

min

punto stazionario

negativa

il punto stazionario è un max

soluzione di ML

=

equazioni normali

per i minimi quadrati

Regressione lineare

//modelli probabilistici: stima di ML

• Relazione tra parametri del modello e parametri stimati:

la curva deterministica

• ML è stimatore unbiased!

Regressione lineare

REGRESSIONE PROBABILISTICA

//modelli probabilistici: stima di ML

THE AUTHOR

• Analogamente possiamo anche fornire una stima ML della varianza del rumore,

!

Assumendo w = w

assumendo

N

∂L

N

1 "

! 2=0

=− + 2

(tn − xT w)

∂σ

σ

σ

(1)

n=1

(2)

N

1

1 "

! T (t − Xw)

!

! 2 = (t − Xw)

(tn − xT w)

σ

! =

N n=1

N

2

negativa

il punto stazionario è un max

Regressione lineare

//predizione e incertezza

•Possiamo effettuare la predizione sui dati nuovi (test set)

•Qual è l’incertezza sulle predizioni del modello?

1

Regressione lineare

//predizione e incertezza

•Possiamo effettuare la predizione sui dati nuovi (test set)

•Qual è l’incertezza sulle predizioni del nostro modello?

•Usiamo la covarianza...

l’incertezza è legata alla covarianza dei parametri stimati !!

Regressione lineare

//modelli probabilistici: stima di ML

• Qual è l’incertezza sulle predizioni del nostro modello?

Regressione lineare

//modelli probabilistici: stima di ML

• Qual è l’incertezza sui parametri stimati?

• E’ legata alla covarianza dei parametri stimati...

• Poichè ML è stimatore unbiased:

rumore a media 0

Regressione lineare

//modelli probabilistici: stima di ML

• Qual è l’incertezza sulle stime del nostro modello?

• E’ legata alla covarianza dei parametri stimati...

• Si ottiene

piccola curvatura

=

elevata varianza

=

parametri poco significativi

Regressione lineare

//modelli probabilistici: stima di ML

• Qual è l’incertezza sulle stime del nostro modello?

REGRESSIONE PROBABILISTICA

THE AUTHOR

!

sumendo w = w

N

∂L

N

1 "

! 2=0

=− + 2

(tn − xT w)

∂σ

σ

σ

n=1

σ

!2 =

!

lazione tra w e w

N

1

1 "

! T (t − Xw)

!

! 2 = (t − Xw)

(tn − xT w)

N n=1

N

#

!

wp(t|X,

w, σ)dt

Regressione

lineare

#

= (X X) della

X

tp(t|X,

w, σ)dt

//andamento

funzione

di log-likelihood

! =

Ep(t|X,w,σ) [w]

−1

T

T

= (XT X)−1 XT Ep(t|X,w,σ) [t]

= (XT X)−1 XT Xw

= w

edizione:

elihood:

! T xnew

tnew = w

$

%

2

σnew

= var{tnew } = Ep(t|X,w,σ) t2new − (Ep(t|X,w,σ) [tnew ])2

= σ 2 xTnew (XT X)−1 xnew

! new

= xTnew cov{w}x

N

N

&2

&2 − 1 N σ

log 2π −

log σ

&

2

2

2

2σ

N

N

&2

= − (1 + 2 log 2π) −

log σ

2

2

log L = −

1

Regressione lineare

//stima di ML dei parametri di generiche funzioni di x

• La likelihood è • Dove la funzione di costo o di errore è

Regressione lineare

//stima di ML dei parametri di generiche funzioni di x

max

min

equazioni normali

per i minimi quadrati

Regressione lineare

//modelli probabilistici: stima di ML

• Abbiamo generalizzato il risultato già ottenuto per la retta

equazioni normali

per i minimi quadrati

design

matrix

Regressione lineare

//modelli probabilistici: stima di ML

• Possiamo computare il Minimo di ED(w) anche in modo non analitico: metodo

di discesa del gradiente (procedura iterativa)

• Inizializzazione

• while ( ~ condizioneTerminazione)

i = i+1;

Regressione lineare

//modelli probabilistici: stima di ML

• Possiamo computare il Minimo di ED(w) anche in modo non analitico: metodo

di discesa del gradiente (procedura iterativa)

• Inizializzazione

• while ( ~ condizioneTerminazione)

i = i+1;