“Sapienza” Università di Roma

FACOLTÀ DI SCIENZE MATEMATICHE, FISICHE E NATURALI

Corso di Laurea Specialistica in Fisica

Ricerca del bosone di Higgs

nel canale di decadimento in due fotoni

all’esperimento CMS

Tesi di Laurea Specialistica

Relatore

Candidato

Prof. Giovanni Corrado Organtini

Anno Accademico 2007/2008

Francesco Pandolfi

matr. 698373

Come l’araba Fenice

che vi sia ciascun lo dice

ove sia nessun lo sa.

Cosı̀ fan tutte

Indice

1 La fisica del bosone di Higgs

1.1 Il Modello Standard . . . . . . . . . . . .

1.1.1 Il meccanismo di Higgs . . . . . .

1.1.2 Oltre il Modello Standard . . . . .

1.2 Limiti sperimentali sulla massa del bosone

1.3 Il bosone di Higgs a LHC . . . . . . . . .

. . . . .

. . . . .

. . . . .

di Higgs

. . . . .

2 Il Large Hadron Collider e l’esperimento CMS

2.1 Il Large Hadron Collider . . . . . . . . . . . . . .

2.2 L’esperimento CMS . . . . . . . . . . . . . . . .

2.3 Sistema di tracciamento interno . . . . . . . . . .

2.4 Calorimetro elettromagnetico . . . . . . . . . . .

2.4.1 I cristalli di P bW O4 . . . . . . . . . . . .

2.4.2 Fotorivelatori . . . . . . . . . . . . . . . .

2.4.3 Geometria . . . . . . . . . . . . . . . . . .

2.4.4 Catena di lettura . . . . . . . . . . . . . .

2.4.5 Risoluzione in energia . . . . . . . . . . .

2.5 Calorimetro adronico . . . . . . . . . . . . . . . .

2.6 Rivelatore per muoni . . . . . . . . . . . . . . . .

3 Il canale H → γγ

3.1 Studio delle caratteristiche del segnale .

3.2 Studio dei fondi . . . . . . . . . . . . . .

3.3 Misura della massa del bosone di Higgs

3.4 Ricostruzione di fotoni in ECAL . . . .

3.4.1 Algoritmi ad apertura dinamica .

3.5 Correzioni energetiche . . . . . . . . . .

3.6 Ricostruzione dei fotoni convertiti . . . .

3.6.1 Algoritmo di ricostruzione . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

5

8

13

16

19

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

23

23

27

29

32

32

35

38

40

41

42

43

.

.

.

.

.

.

.

.

45

45

47

48

49

51

53

54

55

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ii

4 Genetica e fisica delle alte energie

4.1 L’evoluzione naturale . . . . . . . . . . . . .

4.1.1 Geni, cromosomi e riproduzione . . .

4.2 Algoritmi genetici in fisica delle alte energie

4.2.1 Evoluzione . . . . . . . . . . . . . .

4.2.2 Potere del metodo . . . . . . . . . .

INDICE

.

.

.

.

.

5 Analisi del canale H → γγ con ottimizzazione

5.1 Preselezione degli eventi . . . . . . . . . . . .

5.1.1 Campioni Monte Carlo . . . . . . . . .

5.1.2 Trigger . . . . . . . . . . . . . . . . .

5.1.3 Strumenti di ricostruzione . . . . . . .

5.1.4 Preselezione e ordinamento . . . . . .

5.2 Definizione dei criteri di isolamento . . . . . .

5.2.1 Isolamento da tracce . . . . . . . . . .

5.2.2 Isolamento elettromagnetico . . . . . .

5.2.3 Isolamento adronico . . . . . . . . . .

5.3 Altri criteri di selezione . . . . . . . . . . . .

5.3.1 Studio della forma del deposito . . . .

5.3.2 Studio delle variabili cinematiche . . .

5.4 Ottimizzazione genetica dei tagli . . . . . . .

5.5 Recupero dei fotoni convertiti . . . . . . . . .

5.6 Risultati . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

genetica

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

57

57

59

59

60

62

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

63

63

63

67

67

69

70

72

73

75

77

78

82

87

96

102

Introduzione

Il Modello Standard della fisica delle particelle elementari è una delle teorie scientifiche di

maggior successo che l’uomo sia stato in grado di formulare. Nel corso del secolo passato le

sue predizioni sono state confermate con elevatissima precisione da numerosi esperimenti,

in ambiti concettualmente distanti e sfruttando tecniche molto diverse. La sua fondazione

teorica, tuttavia, necessita dell’esistenza di una particella che non è stata ancora osservata:

il bosone di Higgs.

La massa del bosone di Higgs è un parametro libero della teoria. I numerosi esperimenti

dedicati alla sua ricerca fino a oggi sono riusciti solamente ad escluderne l’esistenza in

alcuni intervalli di massa. L’acceleratore LEP ha posto un limite inferiore alla massa pari

a 114.4 GeV/c2 al 95% di confidenza, mentre il Tevatron sta fornendo i primi risultati

nella regione 160 ÷ 170 GeV/c2 .

La ricerca del bosone di Higgs si basa sulla rivelazione dei suoi prodotti di decadimento,

i quali a loro volta dipendono dal valore della sua massa. Per masse leggere, compatibili

con i limiti sperimentali, nell’intervallo cioè che si estende fra 114.4 e circa 140 GeV/c2 ,

la sua rivelazione risulta essere particolarmente difficoltosa dal momento che è necessario

sfruttare un canale di decadimento molto raro: il decadimento in due fotoni.

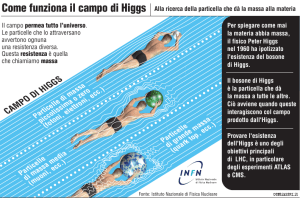

Il Large Hadron Collider del CERN è l’acceleratore che è stato progettato con l’obiettivo di appurare definitivamente l’esistenza del bosone di Higgs. È un collisore protonico

a fasci simmetrici, con un’energia nel centro di massa di 14 TeV. Permetterà di esplorare

estensivamente la scala energetica del TeV.

L’esperimento Compact Muon Solenoid (CMS) è uno dei quattro principali esperimenti che studieranno le interazioni prodotte al Large Hadron Collider. È un rivelatore ad

uso generale, che fa uso di un calorimetro elettromagnetico omogeneo di grande precisione, progettato con lo scopo di poter rivelare il bosone di Higgs sfruttando il canale di

decadimento in due fotoni.

Nell’ambiente sperimentale di un collisore protonico, le fonti di fondo sono abbondanti.

La sezione d’urto di eventi con jet adronici è molto elevata, dunque nella ricerca dei fotoni

di decadimento del bosone di Higgs il contributo principale al fondo proviene da fotoni

prodotti all’interno di jet. Un’analisi che intende studiare questo canale di decadimento

deve quindi essere molto efficiente nella discriminazione dei jet. Le importanti differenze

fra gli eventi di segnale e quelli composti da jet sono l’isolamento dei fotoni e la forma del

deposito energetico rilasciato nel calorimetro elettromagnetico.

In generale, una selezione, in fisica delle particelle, è costituita da una serie di tagli

su altrettante variabili. Per individuare la configurazione ottimale delle soglie dei tagli

è necessario studiare la variazione del potere discriminante della selezione nello spazio

multidimensionale delle variabili considerate. Questo problema può essere affidato a un

computer.

È stato sviluppato dunque un metodo che si ispira al principio di selezione naturale

darwiniano, il quale, selezionando di volta in volta le configurazioni migliori, riesce a

ottimizzare i valori dei tagli. Algoritmi di questo tipo sono chiamati algoritmi genetici.

In questa tesi si presenta un’analisi che permette di scoprire il bosone di Higgs con il

rivelatore CMS mediante il suo decadimento in due fotoni. L’analisi utilizza una selezione

ottimizzata grazie a un algoritmo genetico.

Nel primo capitolo si fornisce una contestualizzazione teorica del Modello Standard e

delle motivazioni che portano alla postulazione dell’esistenza del bosone di Higgs. Vengono

quindi forniti i vincoli teorici e i limiti sperimentali sul valore della sua massa e descritto

lo scenario previsto al Large Hadron Collider per quel che riguarda la sua produzione e il

suo decadimento.

Nel capitolo secondo sono descritti l’acceleratore Large Hadron Collider e l’esperimento CMS, di cui verranno mostrati il principio di funzionamento e le prestazioni di ogni

singolo sottorivelatore. Particolare enfasi sarà dedicata al suo calorimetro elettromagnetico (ECAL), fondamentale ai fini di quest’analisi.

Il terzo capitolo offre una panoramica delle caratteristiche sperimentali del canale di

decadimento in due fotoni e, a confronto, le caratteristiche dei principali fondi. Dopo

aver spiegato il metodo con cui si misura la massa del bosone di Higgs, sono descritti i

procedimenti con cui è ricostruita l’energia dei fotoni in ECAL.

Nel quarto capitolo, dopo una breve introduzione sull’evoluzionismo darwiniano, è

descritto il metodo di ottimizzazione con algoritmi genetici.

Nel quinto e ultimo capitolo è infine presentata l’analisi del canale di decadimento in

due fotoni del bosone di Higgs. La definizione di una selezione si suddivide nell’individuzione dell’insieme di variabili su cui tagliare e nella scelta delle soglie dei tagli. La selezione

delle variabili è stata effettuata confrontando le prestazioni di variabili diverse in grado di

fornire selezioni concettualmente simili. La scelta dei valori dei tagli è stata invece affidata

a un algoritmo genetico.

Capitolo 1

La fisica del bosone di Higgs

Dopo la scoperta del quark top al Tevatron di Chicago, avvenuta nel 1995, il bosone di

Higgs costituisce l’ultimo tassello mancante del Modello Standard. Alla sua ricerca si sono

dedicati, senza successo, gli acceleratori LEP e Tevatron.

La massa del bosone di Higgs è un parametro libero del Modello Standard, dunque

un acceleratore capace di esplorare ampi intervalli di massa è fondamentale per la sua

scoperta. Il Large Hadron Collider è stato progettato in modo da avere come obiettivo

primario nel breve termine la scoperta di questa particella.

Questo capitolo si propone di fornire una rapida ma accurata introduzione al contesto

teorico attuale della fisica delle particelle elementari. Verranno descritti il Modello Standard, le motivazioni che hanno portato alla formulazione del meccanismo di Higgs e le

sue conseguenze. Verranno quindi riassunti gli attuali limiti sperimentali alla massa del

bosone di Higgs e si fornirà infine una panoramica sui meccanismi previsti di produzione

ed eventuale scoperta a LHC.

1.1

Il Modello Standard

Il Modello Standard della fisica delle particelle elementari è la teoria che attualmente

viene adoperata per ottenere una descrizione quantitativa a livello microscopico di tre delle

quattro forze fondamentali: l’elettromagnetismo, la forza debole e la forza forte. È stato

elaborato verso la fine degli anni ’60 da Glashow, Weinberg e Salam [1]. È una teoria

di campo rinormalizzabile, compatibile con la relatività speciale. La sua Lagrangiana

obbedisce a una simmetria di gauge non Abeliana che fa riferimento al gruppo di simmetria

6

La fisica del bosone di Higgs

SU (3)×SU (2)×U (1). Nel corso degli ultimi decenni le sue previsioni sono state confermate

con straordinaria accuratezza da un gran numero di esperimenti [2].

Si può suddividere il Modello Standard in due settori: la Cromodinamica Quantistica

(spesso chiamata QCD, dall’acronimo del nome anglosassone) e il settore elettrodebole.

In altre parole la Lagrangiana del Modello Standard si può esprimere esprimere come:

LMS = LQCD + LElettrodebole

La Cromodinamica Quantistica descrive le interazioni di quark e gluoni, mediate dalla

forza forte attraverso la carica di colore. È descritta dalla Lagrangiana

LQCD = −

X

1 X g g µν

α β

qr

Fµν F

+i

q̄rα γ µ Dµβ

4 g

r

(1.1)

che soddisfa la simmetria di colore SU (3)C . Nell’espressione di LQCD compaiono i tensori

g

Fµν

degli otto campi gluonici (g = 1, ..., 8), definiti da

i

Fµν

= ∂µ Giν − gF fijk Gjµ Gkν

ove gF è la costante di accoppiamento della forza forte e fijk sono le costanti di struttura

del gruppo SU (3). Nel secondo termine della (1.1), con qr si è indicato il campo del quark

α è definita da

di sapore r, gli indici α, β sono indici di colore, e la derivata covariante Dµβ

X

i

α

= ∂µ δβα + gF

Dµβ

Giµ λiαβ

2

i

ove λi sono le matrici dei generatori di SU (3).

Il settore elettrodebole è invece descritto da una Lagrangiana invariante sotto trasformazioni di gauge del gruppo di simmetria SU (2)L × U (1)Y . Il gruppo SU (2)L si riferisce

alla carica di isospin debole (I), mentre U (1)Y all’ipercarica debole (Y ). Le componenti sinistrorse dei fermioni sono organizzate in doppietti con I = 1/2, mentre le loro componenti

1.1 Il Modello Standard

7

destrorse in singoletti di I = 0:

I=0:

I = 1/2 :

νe

e

!

L

!

u

d

L

νµ

µ

c

s

!

L

!

L

ντ

τ

e

!

R

µ

τ

R

R

L

u

R

d

!

t

b

L

R

c

R

s

t

R

b

R

R

L’imposizione di queste simmetrie di gauge locali introduce 4 bosoni vettori: 3 per il

gruppo SU (2), i campi W i (i = 1, 2, 3), e uno per U (1), il campo B. I campi fisici si

ricavano come combinazioni lineari di questi ultimi:

Aµ = sin θ Wµ3 + cos θBµ

Zµ = cos θ Wµ3 − sin θBµ

Wµ± =

Wµ1 ∓ iWµ2

√

2

Le precedenti equazioni rappresentano due particelle neutre, il fotone (descritto dal campo Aµ ) e il bosone Z, e due particelle cariche, i bosoni W + e W − . Si è inoltre introdotto

l’angolo θ che viene detto angolo di interazione debole.

Si delinea cosı̀ una teoria quantistica simmetrica sotto trasformazioni locali di gauge,

la cui lagrangiana è espressa come

LElettrodebole = Lfermioni + Lgauge ≡ i

X

f

1 X µν

f¯Dµ γ µ f −

FG FG,µν

4

G

Le somme sono estese rispettivamente a tutti i campi fermionici (leptoni e quark) e a

tutti i campi vettoriali. I campi fermionici (f ) possono essere doppietti sinistrorsi (ψL ) o

singoletti destrorsi (ψR ). Nel primo termine compare la derivata covariante

Dµ ≡ ∂µ − igG (λα Gα )µ

8

La fisica del bosone di Higgs

ove gG è la generica costante di accoppiamento del fermione al campo G e λα sono i

generatori del gruppo di simmetria cui fa riferimento G.

Questa teoria ha però un problema: tutte le particelle descritte da essa hanno massa

nulla, contraddicendo clamorosamente i risultati sperimentali. D’altra parte la simmetria di gauge della Lagrangiana sembra impedire l’introduzione di termini di massa. La

teoria rischia di divenire un elegante artifizio matematico incapace di descrivere la realtà

osservata.

La proposta di Higgs [3] risolve questo problema rompendo spontaneamente la simmetria della Lagrangiana, come vedremo nel prossimo paragrafo.

1.1.1

Il meccanismo di Higgs

Per introdurre il concetto di rottura spontanea della simmetria, consideriamo un sistema

la cui Lagrangiana possegga una certa simmetria. Nel classificare i livelli energetici del

sistema, bisogna tenere conto delle degenerazioni. Se un dato livello di energia è non

degenere, il corrispondente autostato è unico e invariante sotto trasformazioni del gruppo

di simmetria della Lagrangiana. Al contrario, nel caso degenere, i vari autostati non sono

invarianti ma vengono trasformati in una generica combinazione lineare degli altri.

Consideriamo quindi il caso del livello energetico più basso. Se presenta degenerazione,

non esiste un autostato che descriva univocamente lo stato fondamentale del sistema: ne

deve essere scelto arbitrariamente uno, ma cosı̀ facendo lo stato scelto non condivide

più la simmetria della Lagrangiana. Questa maniera di ottenere uno stato fondamentale

asimmetrico viene detta rottura spontanea della simmetria.

Il modo più semplice per rompere spontaneamente la simmetria SU (2)L × U (1)Y

consiste nell’introdurre un campo scalare Φ che sia un doppietto di isospin:

Φ=

Φ+

Φ0

!

=

√ !

(Φ1 + iΦ2 )/ 2

√

(Φ3 + iΦ4 )/ 2

ove sono stati introdotti i quattro campi reali Φi (i = 1, 2, 3, 4) per esplicitare che i campi

Φ+ e Φ0 sono complessi.

La più semplice Lagrangiana di un campo scalare autointeragente ha la forma

LHiggs = (Dµ Φ)† (Dµ Φ) − V (Φ)

1.1 Il Modello Standard

9

ove

V (Φ) = µ2 Φ† Φ + λ(Φ† Φ)2

e la derivata covariante Dµ Φ è definita dall’uguaglianza operatoriale

i

Dµ ≡ ∂ µ + gσj Wjµ + ig 0 Y B µ

2

ove si è sottintesa la somma sull’indice ripetuto j = 1, 2, 3, con g e g 0 si sono indicate

rispettivamente le costanti di accoppiamento dei fermioni ai campi Wjµ e B µ , con σj si

sono indicate le matrici di Pauli e infine con Y l’ipercarica debole.

Il potenziale V (Φ) dipende da due parametri: µ e λ. La condizione λ > 0 assicura

che lo spettro di energia sia limitato inferiormente. Se il parametro µ viene scelto tale che

µ2 < 0, la simmetria del potenziale può essere rotta. Si ha infatti che in corrispondenza

di

Φ† Φ = −

v2

µ2

≡

2λ

2

(1.2)

il potenziale ha un minimo. Il che implica che il campo Φ ha un valore d’aspettazione

√

Φ0 = v/ 2 non nullo sul vuoto.

La teoria delle perturbazioni richiede uno sviluppo di Φ attorno al suo stato fondamentale. Quest’ultimo, d’altra parte, dovrà essere scelto fra tutti quelli che soddisfano

l’equazione (1.2), ma ognuno di essi romperà almeno una simmetria della Lagrangiana.

Si può inoltre verificare che ciò implica l’assegnazione, ad ogni bosone connesso con una

simmetria rotta, di una massa pari a |qv|, se con q si intende la carica del bosone di Higgs

nel campo mediato dal bosone in questione.

La Lagrangiana elettrodebole possiede una simmetria SU (2) × U (1). Per evitare di

conferire una massa al fotone, dunque, dobbiamo scegliere uno stato fondamentale che

conservi la simmetria U (1) di carica elettrica. Dalla relazione di Gell-Mann e Nishijima [4]

Q = I3 +

Y

2

si vede bene che otteniamo il risultato desiderato se scegliamo uno stato fondamentale Φ0

10

La fisica del bosone di Higgs

di isospin debole I = 1/2, I3 = −1/2 e ipercarica debole Y = 1:

1

Φ0 = √

2

0

v

!

Di conseguenza il campo Φ sarà espresso come

1

Φ(x) = √

2

!

0

v + h(x)

In questo modo i campi bosonici W ± e Z, relativi al gruppo di simmetria rotta SU (2),

acquistano massa

mW =

v

g

2

mZ =

vp 2

g + g 02

2

Viene inoltre introdotta una particella fisica, il bosone di Higgs, descritto dal campo h(x),

di massa

mH =

√

√

2µ =

2λv

(1.3)

Possiamo adesso conferire massa ai fermioni introducendo un termine di interazione di

Yukawa, accoppiando un doppietto sinistrorso fermionico (ψ L ), un singoletto destrorso e

il doppietto di Higgs (Φ). Considereremo il caso dei quark: il caso leptonico è analogo.

Chiameremo genericamente u (d) i campi relativi ai quark di tipo up (down). Un

termine di accoppiamento della forma

g d ψ̄ L dR Φ + hermitiano coniugato

√

assegna una massa md = g d v/ 2 al quark d. Allo stesso modo, se chiamiamo Φ̃ =

−i[Φ† σ2 ]T , ove σ2 è la seconda matrice di Pauli, un termine della forma g u ψ̄ L uR Φ̃ fornisce

√

una massa mu = g u v/ 2 al quark u.

Complessivamente, quindi, estendendo il ragionamento alle tre famiglie, la Lagrangiana

di interazione fra quark e campo di Higgs sarà della forma

LqΦ =

X

ik

d L R

gik

ψ̄i dk Φ +

X

ik

u L R

gik

ψ̄i uk Φ̃ + h.c.

1.1 Il Modello Standard

11

I termini di massa di questa Lagrangiana sono tuttavia non diagonali nei campi u e d. Per

ottenere i campi fisici (massivi) bisogna diagonalizzarli. Questo è fatto introducendo delle

matrici unitarie V che trasformano i campi

uL = VuL u0L

uR = VuR u0R

dL = VdL d0L

dR = VdR d0R

Dal momento che i campi uL e dL sono trasformati in maniera differente, l’accoppiamento ai bosoni W ± non è più diagonale. Si ha infatti

LqW = g

X

µ 0L

†

ū0L

i Vij γ dj Wµ + h.c.

ij

ove si è introdotta la matrice unitaria V, detta di Cabibbo, Kobayashi e Maskawa [5][6],

definita come

Vud Vus Vub

†

VdL ≡ Vcd Vcs Vcb

V = VuL

Vtd Vts Vtb

Al contrario, si verifica facilmente che l’accoppiamento al fotone e al bosone Z rimangono diagonali, grazie all’unitarietà delle matrici V :

† µ

γ VuL u0L Wµ3 = gū0L γ µ u0L Wµ3

gūL γ µ uL Wµ3 = gū0L VuL

Bisogna infine osservare che le matrici VuL , VuR , VdL , VdR sono determinate a meno

di una fase complessiva ineliminabile. La presenza di questa fase permette la violazione

della simmetria CP del Modello Standard.

Diagonalizzate le matrici M̃ , i campi fermionici acquistano masse pari a

v

mf = √ g f

2

ovvero l’accoppiamento del bosone di Higgs a un dato fermione è proporzionale alla massa

12

La fisica del bosone di Higgs

del fermione stesso:

gf =

√ mf

2

v

Come si vede nella relazione (1.3), la massa del bosone di Higgs dipende dal parametro di accoppiamento λ e dal valore di aspettazione sullo stato di vuoto v. Il valore di

quest’ultimo è fissato dalla costante di Fermi (GF ), dal momento che è facile verificare che

sussiste la seguente uguaglianza

v=

√

2mW

= ( 2GF )−1/2

g

L’attuale stima di GF , ricavata dalla misura della vita media dei muoni [7], permette di

porre v ' 247 GeV . Il modello non offre però alcuna predizione sul valore del parametro λ,

rendendo la massa del bosone di Higgs un parametro libero.

Tuttavia, si può sfruttare la natura perturbativa della teoria per porre dei limiti teorici

approssimativi su mH [8]. Un primo limite si ottiene richiedendo che la rottura della

simmetria effettivamente avvenga:

V (v) < V (0)

(1.4)

Questa condizione è equivalente a richiedere che λ rimanga positivo a ogni scala di energia,

dal momento che in caso contrario lo spettro di energia non sarebbe limitato inferiormente. Vicino a questo limite, ovvero per piccoli valori di λ, e quindi per un bosone di Higgs

leggero, le correzioni radiative del quark top e gli accoppiamenti di gauge diventano importanti e la condizione (1.4) può essere trasformata in un limite inferiore per la massa

dell’Higgs:

mH

3v

>

(16gt4 − g 4 − 2g 2 g 02 − 3g 04 ) log

32π 2

Λ

mH

ove gt è la costante di accoppiamento del campo di Higgs al quark top. Si è qui introdotta

una scala di energia Λ, oltre la quale si suppone che il Modello Standard non sia più valido.

Facendo riferimento alla Figura (1.1), questo limite corrisponde alla curva inferiore [9].

D’altro canto, la richiesta che il parametro λ rimanga finito fino a una scala Λ, ovvero

richiedere la validità dell’approccio perturbativo fino a tale scala, si traduce in un limite

1.1 Il Modello Standard

Figura 1.1

13

Limiti sulla massa del bosone di Higgs (MH ) in funzione della scala energetica Λ alla

quale è necessario introdurre nuova fisica. Il calcolo è stato effettuato ponendo la massa

del quark top (mt ) pari a 175 GeV/c2 .

superiore sulla massa:

m2H <

8π 2 v 2

3 log(Λ/v 2 )

che corrisponde alla curva superiore nella Figura (1.1). Come si vede, questi limiti implicano che se il Modello Standard fosse una teoria perturbativa fino alla scala della grande

unificazione ΛGUT ≈ 1016 GeV, la massa del bosone di Higgs dovrebbe essere compresa

approssimativamente fra i 130 e i 190 GeV/c2 . In altre parole, un bosone di Higgs con

massa inferiore a 130 GeV/c2 suggerirebe l’esistenza di nuova fisica a partire da una scala

minore di ΛGUT .

1.1.2

Oltre il Modello Standard

Nonostante lo straordinario accordo fra le misure di precisione nel settore elettrodebole e

le predizioni del Modello Standard, ci sono delle forti indicazioni teoriche che quest’ultimo

non sia la teoria definitiva nella descrizione delle interazioni fra particelle fondamentali.

Ha circa 20 parametri liberi, che possono sembrare troppi per una teoria fondamentale,

e varie domande senza risposta, riguardanti argomenti come l’unificazione delle forze, la

massa dei neutrini, il problema della gerarchia e della naturalezza. Per questo motivo si

tende a considerare il Modello Standard alla stregua di una teoria quantistica dei campi

efficace, valida sino a una scala energetica Λ, detta di cut-off.

14

La fisica del bosone di Higgs

Il cosiddetto problema gerarchico [10] sembra essere il cancro che più profondamente

mina le fondamenta teoriche del Modello Standard. In generale si ha una problema di

gerarchia quando i parametri misurati di una teoria sono di numerosi ordini di grandezza

più piccoli della scala di energia fondamentale della teoria stessa. Ciò può avvenire nel caso

in cui i parametri misurati siano connessi a quelli fondamentali attraverso procedimenti

di rinormalizzazione, tuttavia se il divario energetico è estremamente vasto si dovrebbe

supporre una delicatissima cancellazione fra il valore fondamentale del parametro e la sua

correzione radiativa.

Nel Modello Standard, le correzioni radiative alla massa del bosone di Higgs hanno una

dipendenza quadratica dalla scala di cut-off. Si può calcolare ad esempio che i contributi

radiativi dei loop fermionici possono essere espressi come

δmHf ∝

X

−gf (Λ2 + m2f )

f

con ovvio significato dei simboli. Se indichiamo con mH0 la massa “nuda” dell’Higgs, la

massa effettiva mH è ottenuta da

m2H = m2H0 + δm2H

ove in δm2H sono raccolti i contributi di tutte le correzioni radiative. Si capisce quindi che

se Λ ' ΛGUT , per avere un bosone di Higgs di massa . TeV si dovrebbe supporre una

cancellazione di precisione incredibile fra i due contributi.

Sostanzialmente tutti i modelli che intendono superare il Modello Standard tentano di

risolvere il problema della gerarchia. Una soluzione è proposta dal modello supersimmetrico. La supersimmetria pone fermioni e bosoni in multipletti, accoppiando ogni fermione

con un “super partner” bosonico, e viceversa. Il superpartner di una particella condivide

la sua massa e i suoi numeri quantici, eccetto ovviamente lo spin. Dato che le correzioni radiative di fermioni e bosoni hanno segno opposto, i due contributi si cancellano

perfettamente.

Il modo più semplice per rompere la simmetria nel modello supersimmetrico è di

introdurre due doppietti SU (2) di Higgs:

H1 =

H1+

H10

!

H2 =

H20

H2−

!

1.1 Il Modello Standard

Figura 1.2

15

Valori assunti dalle masse dei bosoni di Higgs nel modello supersimmetrico MSSM in

funzione di mA per due valori di tan β. Sono stati considerati due casi di mescolamento

del super partner del quark top (lo squark stop): nessun mescolamento (a sinistra) e

mescolamento massimale (a destra).

Dal momento che i campi sono complessi, ci sono 8 gradi di libertà. Questo è detto Modello

Standard Supersimmetrico Minimale (MSSM).

La simmetria è rotta se le componenti neutre dei doppietti acquistano dei valori di

aspettazione sullo stato di vuoto:

H1 (0) =

0

v1

!

H2 (0) =

v2

0

!

Esattamente come nel caso del Modello Standard, i bosoni W ± e Z acquistano massa

assorbendo 3 gradi di libertà. I rimanenti gradi di libertà introducono 5 bosoni di Higgs:

due carichi (H ± ), uno neutro pseudoscalare (A), due neutri scalari (h e H).

I valori delle masse di questi bosoni dipendono a livello albero da due parametri, che

sono in genere scelti essere

tan β ≡

v1

v2

e

mA

ove mA è la massa del bosone A. In Figura (1.2) si possono vedere i valori assunti dalle

masse in funzione di questi parametri [11].

Addentrarsi in particolari esulerebbe dai fini di questa tesi. Sembra tuttavia interessante mettere in luce che questo modello predice l’esistenza di un bosone di Higgs neutro

16

La fisica del bosone di Higgs

Figura 1.3

Risultati combinati dei quattro esperimenti di LEP nella ricerca del bosone di Higgs.

È riportato il valore di −2 ln Q in funzione della massa dell’Higgs per un’ipotesi di

solo fondo (linea tratteggiata) e per l’ipotesi di segnale e fondo (linea puntinata). La

linea continua rappresenta il valore assunto sui dati degli esperimenti. Le due bande

rappresentano le fluttuazioni dell’ipotesi di solo fondo entro una probabilità del 68%

(banda scura) e 95% (banda chiara).

di massa . 130 GeV/c2 per ogni scelta di questi parametri.

1.2

Limiti sperimentali sulla massa del bosone di Higgs

La ricerca del bosone di Higgs ha condizionato i principali esperimenti di fisica delle alte

energie degli ultimi vent’anni. I limiti sperimentali sulla sua massa sono di due tipi: limiti

diretti, derivanti dalle ricerche effettuate agli acceleratori LEP a Ginevra e Tevatron a

Chicago, e limiti indiretti, provenienti principalmente da misure di precisione del settore

elettrodebole del Modello Standard.

Il Large Electron Positron Collider (LEP) è un acceleratore e+ e− che è stato messo

in funzione al CERN nel 1989. Il suo programma scientifico era suddiviso in due fasi: la

√

prima (LEP I), ha preso dati attorno alla risonanza del bosone Z (89 < s < 93 GeV);

nella seconda (LEP II), durata dal 1996 al 2000, l’energia del centro di massa è stata

1.2 Limiti sperimentali sulla massa del bosone di Higgs

17

gradualmente aumentata fino a 209 GeV. Da questa seconda fase deriva il limite diretto

attualmente più importante alla massa del bosone di Higgs.

Il principale meccanismo per produrre il bosone di Higgs a un collisore e+ e− alle energie

di LEP II è la cosiddetta “Higgs-strahlung” nel canale s (e+ e− → Z ∗ → ZH), nella quale

un bosone Z irradia un bosone di Higgs. Questo stato finale produce nella maggior parte

dei casi eventi a quattro jet, con il bosone di Higgs che decade in due quark b e il bosone

Z in due quark qualunque

e+ e− → (H → bb̄)(Z → q q̄)

Per un bosone di Higgs con una massa di 115 GeV/c2 , ad esempio, la frazione di decadimento di questo processo è circa 60%.

Eventi a quattro jet con topologia compatibile con queste ipotesi sono stati studiati dai

quattro esperimenti attivi a LEP (ALEPH, DELPHI, L3, OPAL). È stata osservata una

singolare abbondanza di eventi [12], non compatibile tuttavia con una scoperta, che ha

permesso di porre un limite inferiore diretto sulla massa del bosone di Higgs pari a 114.4

GeV/c2 al 95% di confidenza. I risultati combinati dei quattro esperimenti sono mostrati

in Figura (1.3), nella quale è riportato l’andamento della quantità

−2 ln Q = −2 ln

Λs

Λb

ove Λs e Λb sono rispettivamente le verosimiglianze dell’ipotesi di segnale in presenza di

fondo e di solo fondo. Il grafico mostra il valore aspettato di tale variabile, in funzione di

mH , nelle due ipotesi (la linea puntinata in basso nel caso di presenza di segnale, quella

tratteggiata in alto nel caso di solo fondo). Il valore della medesima variabile calcolata

sui dati è rappresentato da una linea continua. Come si vede, fino a una massa di 114.4

GeV/c2 i dati sono compatibili, entro una deviazione standard, con l’ipotesi di assenza di

segnale.

Il Tevatron è invece un acceleratore protone-antiprotone (pp̄), con energia nel centro di

√

massa pari a s = 1.96 TeV. La ricerca del bosone di Higgs al Tevatron si concentra sulla

sua produzione associata a bosoni vettori intermedi, pp̄ → V H (V ≡ W ± , Z), con questi

ultimi che decadono in canali leptonici. Per mH < 130 GeV/c2 il canale di decadimento

H → bb̄ è il più proficuo per la sua ricerca, mentre per masse maggiori diventa rilevante il

canale H → W + W − (con uno dei due W che può essere virtuale).

In Figura (1.4) sono riportati i più recenti risultati combinati dei due rivelatori attivi

18

La fisica del bosone di Higgs

Figura 1.4

Andamento previsto (linea tratteggiata) e osservato (linea continua) al Tevatron del

rapporto fra la sezione d’urto misurata e sezione d’urto prevista dal Modello Standard.

Il grafico combina i risultati dei due esperimenti CDF e D∅ e di numerosi canali di

ricerca.

al Tevatron, CDF e D∅ [13]. Nel grafico è mostrato l’andamento del rapporto fra la sezione d’urto misurata e quella calcolata dal Modello Standard, in funzione della massa del

bosone di Higgs. Un valore < 1 di questo rapporto comporterebbe l’esclusione al 95% di

confidenza dei relativi valori di mH . In Figura sono riportati l’andamento aspettato di questa quantità (linea tratteggiata) e l’andamento misurato (linea continua). Questo studio

combina numerosi canali di ricerca e l’analisi è effettuata su 3 fb−1 di dati accumulati.

Come si vede, allo stato attuale il Tevatron è in grado di escludere solamente un

intervallo di massa molto stretto attorno al valore mH = 170 GeV/c2 . Bisogna tuttavia

considerare che questo studio non fa uso di tutta la statistica attualmente accumulata

(oltre 4 fb−1 ). È dunque presumibile che prima dell’arrivo dei primi risultati di LHC il

Tevatron possa essere in grado di ampliare l’intervallo di esclusione.

I limiti indiretti al valore della massa del bosone di Higgs provengono invece da un fit

effettuato sui risultati di misure di precisione nel settore elettrodebole del Modello Standard. Questi osservabili sono infatti sensibili al valore di mH dal momento che quest’ultimo

contribuisce, attraverso correzioni a loop, alla polarizzazione del vuoto dei bosoni W ± e

Z, dando luogo a termini proporzionali a log(mH ).

Attualmente il miglior fit ai dati raccolti da esperimenti quali LEP, Tevatron e SLC

1.3 Il bosone di Higgs a LHC

Figura 1.5

19

Produzione del bosone di Higgs. A sinistra: sezione d’urto di produzione del bosone di

Higgs in funzione della sua massa, per acceleratori protone-protone a 14 TeV nel centro

di massa. Sono evidenziati i contributi dei diversi canali di produzione. A destra: grafici

di Feynman dei principali processi di produzione: (a) fusione di gluoni; (b) fusione di

bosoni vettori; (c) produzione associata a coppie tt̄; (d) Higgs-strahlung.

permette di definire [14], entro una deviazione standard, l’intervallo di massa

2

mH = 76+33

−24 GeV/c

ovvero mH < 144 GeV/c2 al 95% di confidenza.

1.3

Il bosone di Higgs a LHC

Il Large Hadron Collider (LHC) del CERN è l’acceleratore che intende chiarire definitivamente il settore di Higgs del Modello Standard. È un collisore protone-protone a 14 TeV

nel centro di massa. Delle sue caratteristiche si parlerà con maggior dettaglio nel prossimo capitolo; per il momento verrà mostrato lo scenario atteso, a tali energie, per quanto

riguarda la produzione e l’eventuale rivelazione di un bosone di Higgs non supersimmetrico.

In Figura (1.5), a sinistra, sono riportate le sezioni d’urto dei vari processi di produzione

del bosone di Higgs a un acceleratore protone-protone di 14 TeV nel centro di massa in

funzione del valore della massa del bosone stesso [15]. A destra sono invece visibili i

grafici di Feynman relativi ai canali principali. Come si vede, nell’intervallo di massa

considerato, la produzione mediante fusione di gluoni (gg → H) è dominante (si noti la

20

La fisica del bosone di Higgs

Tabella 1.1

Sezioni d’urto dei principali processi di produzione del bosone di Higgs per alcuni valori

della sua massa. Sono mostrati anche i branching ratio del canale di decadimento in

due fotoni, e il prodotto inclusivo fra la sezione d’urto totale di produzione e il suddetto

branching ratio.

mH

115 GeV

120 GeV

130 GeV

140 GeV

150 GeV

σ (fusione di g)

39.2 pb

36.4 pb

31.6 pb

27.7 pb

24.5 pb

σ (fusione di W, Z)

4.7 pb

4.5 pb

4.1 pb

3.8 pb

3.6 pb

σ (tt̄ + Higgs-strahlung)

3.8 pb

3.3 pb

2.6 pb

2.1 pb

1.7 pb

σ totale

47.6 pb

44.2 pb

38.3 pb

33.6 pb

29.7 pb

H → γγ B.R.

0.00208

0.00220

0.00224

0.00195

0.00140

σ × B.R.

99.3 fb

97.5 fb

86.0 fb

65.5 fb

41.5 fb

scala logaritmica delle ordinate). Facendo riferimento alla Tabella (1.1), si vede ad esempio

che per mH = 120 GeV, la sezione d’urto di questo processo è almeno 8 volte maggiore di

qualunque altro, rendendolo il canale di produzione più importante a LHC [16].

Un contributo interessante è dato inoltre dalla fusione di bosoni vettori (q q̄ → Hq q̄).

Sono eventi che, anche se di sezione d’urto minore del caso precedente, producono una

topologia facilmente riconoscibile. Essendo un processo di canale t, infatti, i quark dello

stato finale verranno emessi prevalentemente lungo la direzione del fascio. Si verranno cosı̀

a formare due jet a piccolo angolo, che possono essere usati per identificare l’evento.

In Figura (1.6) sono riportati i tassi percentuali di decadimento (branching ratio) del

bosone di Higgs, in funzione della sua massa [17] (a sinistra) e l’andamento dell’ampiezza

totale di decadimento in funzione della massa (a destra). Per mH . 300 GeV la larghezza naturale del decadimento è molto piccola, rendendo dominante, in fase di misura, la

risoluzione del rivelatore.

A partire da mH ≈ 150 GeV divengono dominanti i canali di decadimento in coppie di

bosoni vettori (W, Z). A partire da quei valori di massa, infatti, diventa cinematicamente

possibile la produzione di bosoni vettori reali. I canali di decadimento in bosoni vettori

deboli sono considerati i canali “aurei” per la scoperta del bosone di Higgs a LHC. Queste

particelle possono essere infatti facilmente riconosciute dai loro prodotti di decadimento:

i canali leptonici, in particolare, sfruttando il vincolo cinematico costituito dalla massa

del bosone in decadimento, risultano in topologie facilmente rivelabili e riconoscibili. Gli

1.3 Il bosone di Higgs a LHC

Figura 1.6

21

Decadimento del bosone di Higgs. A sinistra: branching ratio dei principali canali

di decadimento del bosone di Higgs previsto dal Modello Standard in funzione del

valore della sua massa. A destra: ampiezza totale di decadimento del bosone di Higgs

(hSM , linea continua) in funzione della sua massa. Sono riportati anche gli andamenti

delle ampiezze dei bosoni di Higgs neutri scalari del modello MSSM per due valori del

parametro tan β (linee tratteggiate).

elevati valori di branching ratio, inoltre, aumentano il tasso di questi eventi.

Per masse minori di 150 GeV, invece, risulta essere dominante il canale di decadimento

in una coppia di quark bottom (bb̄). La topologia di questi eventi risulterà quindi in una

coppia di jet. Tuttavia, a un collisore adronico quale LHC, è quasi impossibile distinguere

questi eventi dal fondo, data l’elevatissima sezione d’urto di eventi di QCD che presentano

identica topologia.

Se il bosone di Higgs ha una massa minore di 150 GeV, quindi, è necessario sfruttare il decadimento in due fotoni (γγ) per la sua scoperta. Nello stato finale di questo

canale di decadimento si trovano due fotoni molto energetici, che sono ben identificabili

sperimentalmente. Tuttavia, come si vede in figura, il branching ratio di questo canale è

di quasi tre ordini di grandezza inferiore a quelli appena citati, vale circa 0.002 in quasi

tutto l’intervallo importante di massa (vedi Tabella (1.1)). La frequenza di questi eventi

sarà molto piccola, specialmente se confrontata con la frequenza di eventi di fondo con

topologia simile (se non identica).

Il canale di decadimento in due fotoni è stato studiato fin dal progetto iniziale di LHC

come un canale fondamentale per la scoperta di un bosone di Higgs leggero. Rappresenta

un’importante sfida sperimentale e ha posto dei requisiti stringenti nella progettazione dei

rivelatori.

22

La fisica del bosone di Higgs

Capitolo 2

Il Large Hadron Collider e

l’esperimento CMS

Entro la fine del 2008 entrerà in funzione il collisore adronico Large Hadron Collider

(LHC) al CERN. Diversi esperimenti sono stati progettati e costruiti per studiare le collisioni prodotte a LHC, e allargare le frontiere della fisica. In questo capitolo descriverò le

caratteristiche di LHC e dell’esperimento CMS.

2.1

Il Large Hadron Collider

Il Large Hadron Collider è un acceleratore in cui verranno fatti collidere fasci di protoni

√

a un’energia nel centro di massa ( s) di 14 TeV1 . Allo stato attuale, l’acceleratore più

energetico mai costruito è il Tevatron a Fermilab, che dispone di quasi 2 TeV nel centro

di massa. Le energie raggiunte da LHC saranno 7 volte maggiori, e permetteranno di

scandagliare una regione energetica mai lambita.

A differenza di acceleratori elettronici, quale ad esempio il Large Electron-Positron

Collider (LEP), un acceleratore adronico permette di produrre reazioni a energie variabili.

Dato che le interazioni avvengono a livello partonico, infatti, il centro di massa effettivo

è quello fra i partoni interagenti, e dipende dalle loro funzioni di densità di probabilità

energetiche. Di conseguenza le reazioni avvengono a energie inferiori all’energia nel centro

1

LHC attuerà anche un programma di ricerca basato su collisioni di ioni pesanti (nuclei di piombo).

Non essendo rilevante ai fini di questa tesi, non ne verrà fatta menzione.

24

Il Large Hadron Collider e l’esperimento CMS

Tabella 2.1

Caratteristiche principali di LHC. I valori contrassegnati da un asterisco (*) si

riferiscono alla prestazione attesa a pieno regime.

Circonferenza

√

s

26.7 km

14 TeV

Luminosità (L)

1034 cm−2 s−1

Numero di protoni per pacchetto

1.15 · 1011

(∗)

(∗)

(∗)

Lunghezza dei pacchetti (σz )

56 mm

Raggio dei pacchetti (σx = σy )

16 µm

Numero di pacchetti

2808

Spazio fra i pacchetti

7.48 m = 25 ns

di massa dei protoni incidenti. Tuttavia 14 TeV sono sufficienti per avere accesso, per la

prima volta, alla scala energetica del TeV.

A tali energie, inoltre, il contributo dei partoni del mare diventa importante, rendendo sostanzialmente equivalenti gli schemi di collisione protone-protone (pp) e protoneantiprotone (pp̄). Quest’ultima opzione, tuttavia, avrebbe l’inconveniente di dover produrre antimateria, il che comporterebbe inefficienze e comprometerebbe la luminosità della

macchina.

A un acceleratore elettronico, inoltre, la precisione con cui si conosce l’energia di

interazione e i valori bassi di sezione d’urto permettono di fare misure di precisione anche

con un numero relativamente esiguo di eventi. A un acceleratore adronico, invece, le sezioni

d’urto di interazione sono molto più elevate, rendendo fondamentale accumulare un gran

numero di eventi per effettuare misure in cui si riesca a limitare il ruolo del fondo. Per

questo motivo, oltre ad avere un’elevata energia nel centro di massa, una caratteristica

importante di LHC è l’alta luminosità.

La luminosità (L) di un acceleratore circolare è definita come:

L=

Np2 f k

4πσx σy

ove Np è il numero di protoni in un pacchetto, f è la frequenza di rivoluzione dei protoni

nell’anello, k è il numero di pacchetti circolanti contemporaneamente nell’anello e σx e σy

2.1 Il Large Hadron Collider

25

sono le dispersioni medie del pacchetto nelle direzioni (x e y) ortogonali all’orbita.

Si prevede che LHC entrerà in funzione entro il 2008. Le sue caratteristiche principali

sono riportate nella Tabella (2.1). La sua attività sarà distinta in diverse fasi:

• una prima fase di collaudo a

√

s = 10 TeV;

√

• una seconda fase all’energia nel centro di massa nominale ( s = 14 TeV) e bassa

luminosità (L ≈ 1033 cm−2 s−1 );

√

• una fase a pieno regime ( s = 14 TeV, L = 1034 cm−2 s−1 )

La prima fase dovrebbe estendersi solamente per l’anno 2008, in cui ci si aspetta di

R

raccogliere una luminosità integrata pari a circa L dt = 40-50 pb−1 di dati. L’energia

nel centro di massa dovrebbe raggiungere i valori di progetto già a partire dal 2009. Con

una luminosità dell’ordine di 1033 cm−2 s−1 ci si aspetta di raccogliere ogni anno una

luminosità integrata di 10 fb−1 , mentre ad alta luminosità un totale annuo di 100 fb−1 .

Il programma scientifico di LHC è vasto e ambizioso. Il principale obiettivo nel breve

termine, come già detto, è di chiarire definitivamente il fenomeno che causa la rottura

spontanea della simmetria elettrodebole, andando alla ricerca di un bosone di Higgs compatibile con il Modello Standard o con il MSSM. Si propone inoltre di fornire le prime

evidenze sperimentali di fisica oltre il Modello Standard, come ad esempio la Supersimmetria o le extra-dimensioni, e cercherà di spiegare, fra le altre, la natura della materia oscura

e del plasma quark-gluonico. Si potrà inoltre mettere alla prova il Modello Standard con

misure di precisione e verrà indagato a fondo il fenomeno della violazione della simmetria

CP .

In Figura (2.1) sono riportati gli andamenti delle sezioni d’urto di alcuni processi in

collisioni protone-protone, oltre all’andamento della sezione d’urto totale. Confrontando i

valori previsti per LHC con quelli del Tevatron, si vede che le sezioni d’urto a LHC saranno

almeno di un ordine di grandezza maggiori per quanto riguarda tutti i processi considerati

[17].

Il valore atteso per la sezione d’urto di interazioni inelastiche protone-protone è di circa

60 mb, mentre la sezione d’urto totale sarà intorno ai 100 mb. Con LHC a pieno regime

ci si aspettano dunque almeno 20 interazioni per incrocio dei pacchetti, il che risulterà in

una grande molteplicità di particelle prodotte, sia cariche che neutre. Combinato con il

tasso di incrocio di 25 ns, ciò comporta dei requisiti molto stringenti per i rivelatori che

intendono prendere parte al progetto:

• una granularità fine, per risolvere il gran numero di particelle;

26

Il Large Hadron Collider e l’esperimento CMS

Figura 2.1

Sezioni d’urto in collisioni protone-protone in funzione dell’energia del centro di massa.

Sono evidenziate le energie di LEP (“CERN”), del Tevatron (“Fermilab”) e di LHC.

• un’elevata velocità di risposta, per minimizzare la sovrapposizione di eventi (pile

up);

• un sistema di selezione e acquisizione degli eventi rapido ed efficiente;

• una buona resistenza alla radiazione.

Quattro rivelatori studieranno le interazioni prodotte a LHC: due rivelatori a uso

generale, CMS (Compact Muon Solenoid) [19] e ATLAS (A Toroidal LHC ApparatuS)

[20], un rivelatore dedicato alla fisica del quark bottom (LHCb) [21], e un rivelatore per

collisioni di ioni pesanti, ALICE (A Large Ion Collider Experiment) [22].

2.2 L’esperimento CMS

Figura 2.2

2.2

27

Il rivelatore Compact Muon Solenoid.

L’esperimento CMS

L’esperimento CMS è stato progettato specificamente per scoprire il bosone di Higgs, anche

con basse luminosità, nonché per cercare indizi di nuova fisica a LHC. Per ottenere questi

risultati nell’ambiente sperimentalmente impegnativo previsto a LHC, la collaborazione si

è posta i seguenti obiettivi:

• un sistema ottimale per l’identificazione e la misura dei muoni. Questo ha portato

alla scelta di un magnete superconduttore solenoidale capace di produrre un campo

magnetico di 4 T, con i rivelatori per muoni immersi nel ferro di ritorno, permettendo

quindi un sistema muonico compatto;

• il miglior calorimetro elettromagnetico possibile compatibile con le dimensioni del

magnete;

• un sistema tracciante centrale efficiente e preciso nella misura dell’impulso e nella

ricostruzione delle tracce di particelle cariche;

28

Il Large Hadron Collider e l’esperimento CMS

Figura 2.3

Valori assunti dalla pseudorapidità (η) in corrispondenza di alcuni angoli polari (θ).

• un calorimetro adronico adeguato e altamente ermetico per avere una buona misura

dell’energia trasversa mancante.

La struttura del rivelatore CMS è presentata in Figura (2.2). Ha una forma cilindrica

di raggio 7.5 m e lunghezza 22 m, e pesa circa 12 500 tonnellate. È suddiviso in una regione

centrale (barrel ), chiusa da ambo i lati da due endcap identici. Al suo interno è visibile

il magnete superconduttore, lungo 13 m e con un raggio di 3 m. Il magnete è abbastanza

largo da poter ospitare al suo interno il sistema tracciante interno e i calorimetri.

Alla costruzione di CMS hanno partecipato migliaia di fisici provenienti da 159 istituti

di 36 paesi diversi. Il rivelatore è attualmente installato nel punto di interazione 5 di

LHC, a circa 80 m di profondità, vicino a Cessy, in Francia. La sua costruzione è ormai

completata: l’esperimento è pronto per analizzare le prime collisioni.

Il sistema di assi coordinati adottato da CMS ha l’origine posta nel punto di interazione

nominale dei fasci, con l’asse y che punta verso l’alto e l’asse x radialmente verso il centro

geometrico di LHC. L’asse z punta quindi lungo la direzione dei fasci di protoni. L’angolo

azimutale φ è misurato dall’asse x sul piano xy, mentre quello polare (θ) è misurato

dall’asse z.

La pseudorapidità (η), definita come

η = − ln tan

θ

2

risulta essere una quantità utile dal momento che per energie elevate è una buona approssimazione della rapidità (y) di una particella, definita come

1

y = ln

2

E + pL

E − pL

2.3 Sistema di tracciamento interno

Tabella 2.2

29

Dose di radiazione e flusso di particelle cariche attesi per diversi strati radiali del barrel

del sistema tracciante di CMS, per una luminosità integrata di 500 fb−1 .

Raggio

Dose di radiazione

Flusso di particelle cariche

(cm)

(kGy)

(cm−2 s−1 )

4

840

108

22

70

6 · 106

115

1.8

3 · 105

ove con pL si è indicata la componente dell’impulso parallela alla linea dei fasci. La

rapidità è una quantità le cui differenze sono invarianti relativistici per trasformazioni di

Lorentz lungo la direzione dei fasci. In Figura (2.3) sono riportati i valori assunti da η in

corrispondenza di alcuni angoli θ.

Verranno infine denotati rispettivamente con pT e ET l’impulso e l’energia misurati

nel piano trasverso (xy) al fascio. La componente trasversa dell’energia è definita come

ET = E · sin θ, ove E è l’energia depositata in una cella calorimetrica e θ è l’angolo polare

della posizione della cella.

Descriveremo ora nel dettaglio i vari sottorivelatori che costituiscono CMS. Maggior

attenzione sarà posta sul calorimetro elettromagnetico (ECAL), fondamentale per il lavoro

svolto in questa tesi.

2.3

Sistema di tracciamento interno

Il sistema di tracciamento interno serve a ricostruire le tracce delle particelle cariche e

misurarne l’impulso. Per la prima volta in un esperimento in fisica delle particelle, il

sistema tracciante è interamente affidato all’utilizzo del silicio.

Il principale obiettivo del sistema tracciante è quello di ricostruire elettroni e muoni

isolati e di elevato impulso trasverso con efficienza maggiore di 95%, e tracce di alto pT

entro jet con efficienza maggiore di 90% nell’intero intervallo di pseudorapidità |η| < 2.5.

Il tutto in un ambiente altamente radioattivo e con alta molteplicità di particelle, come

si vede in Tabella (2.2), ove sono riportati i flussi di particelle attesi per la luminosità di

progetto [23].

Facendo sempre riferimento alla Tabella (2.2), si possono identificare 3 regioni:

30

Il Large Hadron Collider e l’esperimento CMS

Figura 2.4

Sezione di un quarto del sistema tracciante interno di CMS. Sono segnati alcuni valori

di pseudorapidità.

• in prossimità del vertice di interazione, ove il flusso di particelle è maggiore, sono

presenti dei rivelatori a pixel. La dimensione del pixel è di circa 100 × 150 µm2 ,

ottenendo un’occupanza di circa 10−4 per pixel a ogni incrocio dei fasci;

• nella regione intermedia (20 < r < 55 cm), il flusso è abbastanza basso da permettere

l’uso di microstrisce di silicio, con celle di dimensione minima di 10 cm × 80 µm, il

che comporta un’occupanza di circa 0.2 - 0.3 per incrocio;

• nella regione esterna (r > 55 cm), il flusso diminuisce talmente da rendere possibile

l’utilizzo di strisce di silicio più larghe, con celle di dimensione massima pari a 25

cm × 180 µm, mantenendo l’occupanza intorno al percento;

Una sezione del sistema di tracciamento interno di CMS è visibile in Figura (2.4).

Vicino al vertice di interazione sono stati posti 3 strati di pixel di silicio, rispettivamente

a distanze radiali di 4.7, 7.3 e 10.2 cm. Nel barrel sono poi poste le microstrisce di

silicio, a r fra 20 e 110 cm. La regione in avanti ha invece 2 strati di pixel, e 9 strati di

microstrisce in ogni endcap. La regione di microstrisce del barrel è separata in due regioni,

una interna e una esterna. Per evitare che le particelle incidano sui rivelatori ad angoli

troppo piccoli, la regione interna del barrel è più corta di quella esterna, e sono stati posti

3 strati addizionali, a forma di disco (Inner Discs) nello spazio compreso fra il bordo della

regione interna e l’endcap, su entrambi i lati del barrel. Complessivamente il sistema di

tracciamento interno conta 66 milioni di pixel e 9.6 milioni di strisce di silicio. Fornisce

una copertura fino a |η| < 2.4.

2.3 Sistema di tracciamento interno

31

Figura 2.5

Spettro in pseudorapidità della risoluzione in impulso trasverso ottenuta con il sistema

tracciante di CMS. Le curve fanno riferimento a muoni di impulsi trasversi di 1, 10 e

100 GeV.

Figura 2.6

Efficienza di ricostruzione di traccia del sistema tracciante interno di CMS. Risultati

ottenuti per muoni (a sinistra) e pioni carichi (a destra) di impulsi trasversi di 1, 10 e

100 GeV.

32

Il Large Hadron Collider e l’esperimento CMS

I pixel di silicio forniscono una precisione di misura di 10 µm per le coordinate nel piano

trasverso (xy), e di 20 µm per la coordinata z. Le microstrisce forniscono una risoluzione

che dipende dallo spessore della cella, ma risulta comunque migliore di 55 µm nel piano

trasverso [23]. Complessivamente, la risoluzione sull’impulso trasverso ottenuta con il

sistema tracciante interno di CMS è riportata in Figura (2.5). L’efficienza di ricostruzione,

per muoni e pioni carichi, è invece riportata in Figura (2.6).

2.4

Calorimetro elettromagnetico

Il calorimetro elettromagnetico (ECAL) di CMS è un calorimetro ermetico e omogeneo,

costituito da 61 200 cristalli di tungstato di piombo (PbWO4 ) nella regione del barrel e

chiuso da 7324 cristalli in ognuno dei due endcap. L’obiettivo del calorimetro elettromagnetico è misurare con alta precisione l’energia di particelle eletromagnetiche, oltre che,

in combinazione con il calorimetro adronico, fornire una ricostruzione dell’energia dei jet

adronici.

Il calorimetro elettromagnetico svolge un ruolo fondamentale nella ricerca del bosone

di Higgs, specialmente nei canali di decadimento H → γγ e H → ZZ (∗) → 4e± /2e± 2µ± .

Come visto nel capitolo precedente, infatti, negli intervalli di massa in cui verrebbero

sfruttati questi canali di decadimento per la sua scoperta, la larghezza intrinseca dell’Higgs

è piccola e la risoluzione sperimentale è dominante per l’incertezza sulla misura della massa.

Il canale di decadimento in due fotoni, in particolare, è stato usato come punto di riferimento cardinale nell’ottimizzazione della progettazione del calorimetro elettromagnetico

di CMS. Le difficoltà sperimentali di questo canale hanno portato la collaborazione alla

scelta di un calorimetro elettromagnetico di eccellente risoluzione energetica e granularità

fine per massimizzare la risoluzione nella misura della massa invariante di due fotoni. Per

questo motivo si è optato per un calorimetro omogeneo, di grande precisione, con una

massa sensibile formata di cristalli scintillanti.

Nei paragrafi seguenti verranno descritte nel dettaglio le principali caratteristiche del

calorimetro elettromagnetico di CMS.

2.4.1

I cristalli di P bW O4

La scelta del tungstato di piombo (PbWO4 , più semplicemente PWO) è stata motivata

dalla compattezza, rapidità di risposta e resistenza alla radiazione di questo materiale.

2.4 Calorimetro elettromagnetico

Tabella 2.3

33

Principali caratteristiche dei cristalli di PWO e confronto con altri cristalli scintillanti.

Gli apici f e s corrispondono rispettivamente alle componenti di emissione principale

(fast) e secondaria (slow).

NaI(Tl)

BGO

CeF3

BaF2

PWO

X0 (cm)

2.57

1.12

1.68

2.05

0.89

ρ (g cm−2 )

3.67

7.13

6.16

4.89

8.18

4.5

2.4

2.6

3.4

2.2

1.85

2.20

1.68

1.56

2.29

1

0.15

0.10

0.05f

0.01

RM (cm)

n

LY (a.u.)

0.20s

τ (ns)

λ (nm)

250

410

300

480

10f

0.7f

5f

30s

620s

15s

310f

220f

440f

340s

310s

480s

Le principali caratteristiche del PWO, confrontate con quelle di altri cristalli scintillanti,

sono riportate in Tabella (2.3) [24].

La lunghezza di radiazione (X0 ) rappresenta la distanza longitudinale nella quale un

elettrone, attraversando il materiale, perde in media 1/e della sua energia attraverso processi di diffusione. Il calorimetro elettromagnetico deve assicurare il completo contenimento dello sciamo elettromagnetico fino a energie dell’ordine del TeV. Per tali energie il 98%

dello sviluppo longitudinale dello sciame è contenuto in 25 X0 .

Il raggio di Molière (RM ) è invece una grandezza usata nella descrizione dello sviluppo

trasversale dello sciame. È definita come

RM =

21.2 MeV × X0

EC (MeV)

ove EC è detta energia critica e rappresenta l’energia alla quale la perdita media di energia

per ionizzazione eguaglia quella persa per bremsstrahlung. In media, il 90% dell’energia

34

Il Large Hadron Collider e l’esperimento CMS

di uno sciame elettromagnetico è depositata in un cilindro di raggio RM costruito attorno

all’asse dello sciame.

Le principali caratteristiche di scintillazione di un cristallo utilizzato in calorimetria

sono la quantità di luce di scintillazione emessa (light yield ) e il tempo di emissione (τ ). Il

light yield (LY) viene generalmente misurato come il numero di fotoni emessi per MeV di

energia depositata all’interno del cristallo. In tabella è riportato il light yield normalizzato

a quello dello ioduro di sodio drogato con tallio (NaI(Tl)). Per completezza, in tabella

sono riportate quantità addizionali: la densità (ρ), l’indice di rifrazione (n) e la lunghezza

d’onda di emissione della luce (λ).

Il PWO è stato scelto per i seguenti motivi:

• la piccola lunghezza di radiazione (0.89 cm) permette la costruzione di un calorimetro

estremamente compatto: con cristalli lunghi 23 cm si ottengono 25.8 X0 , assicurando

un ottimo contenimento longitudinale degli sciami fino a grandi energie;

• il piccolo raggio di Molière consente un efficace contenimento laterale degli sciami e

contemporaneamente una buona granularità;

• la velocità di risposta elevata permette di raccogliere gran parte della luce di scintillazione fra due incroci successivi (l’80% della luce è emessa entro 25 ns), minimizzando

gli effetti del pile up;

• la sua buona resistenza alla radiazione lo rende utilizzabile per decine di anni di

attività a LHC ad alta luminosità.

Il PWO è insensibile alla radiazione di neutroni, ma l’irraggiamento da fotoni induce la

formazione di centri di colore nel cristallo che possono degradare la trasparenza, e quindi

in ultima analisi la resa di luce. Studi accurati [25] hanno evidenziato una correlazione fra

la resistenza alla radiazione e la trasmissione ottica dei cristalli. È stato inoltre osservato

che un particolare tipo di drogaggio a base di niobio (Nb) rende lo spettro di trasmissione

ottimale e contemporaneamente massimizza la resistenza alla radiazione del cristallo.

Il tungstato di piombo presenta tuttavia degli inconvenenti. Innanzitutto, gran parte

dell’energia immagazzinata nel cristalli viene dissipata in emissioni termiche da parte del

reticolo cristallino. Di conseguenza il light yield risulta essere molto basso (circa 30 fotoni/MeV), rendendo necessario l’utilizzo di fotorivelatori con un sistema di amplificazione.

In CMS si utilizzano fotodiodi a valanga (APD) nel barrel e fototriodi a vuoto (VPT)

negli endcap. La scelta di questo tipo di amplificatori è stata motivata dalla loro buo-

2.4 Calorimetro elettromagnetico

(a)

Figura 2.7

35

(b)

(a) Struttura di un APD; (b) Profilo del campo elettrico di un APD in funzione della

distanza dallo strato p++ .

na efficienza quantica per lunghezze d’onda nella regione dell’emissione del PWO, dalla

sostanziale insensibilità alla presenza del campo magnetico e dalla loro compattezza.

Un secondo problema connesso alla dissipazione termica dell’energia assorbita è la

dipendenza della quantità di luce emessa dalla temperatura del cristallo. Il PWO presenta

una variazione percentuale pari a −2%/◦ C a 18◦ C. Per assicurare una risposta costante

e affidabile del rivelatore è necessario quindi mantenere stabile la sua temperatura, il che

ha motivato la costruzione di un sistema di raffreddamento idraulico in grado di garantire

una temperatura operativa di (18 ± 0.05) ◦ C.

2.4.2

Fotorivelatori

Nel barrel i fotorivelatori sono fotodiodi a valanga (APD) a struttura invertita (ovvero

con il silicio di tipo n dietro alla giunzione p-n), sviluppate dalla ditta Hamamatsu specificatamente per il calorimetro di CMS. Uno schema della struttura degli APD è riportato

in Figura (2.7a) [26].

I fotoni di scintillazione prodotti nel cristallo entrano nel fotodiodo dallo strato p++

(in figura, dall’alto) per essere assorbiti nel successivo strato p+ , creando una coppia

elettrone-lacuna. L’elettrone formatosi, a sua volta, è accelerato dal forte campo elettrico

prodotto dalla giunzione p-n (l’andamento del profilo del campo è riportato in Figura

(2.7b)), liberando altri elettroni per ionizzazione. Gli elettroni liberati migrano verso lo

36

Il Large Hadron Collider e l’esperimento CMS

Tabella 2.4

Principali caratteristiche degli APD Hamamatsu.

Area sensibile

5 × 5 mm2

Voltaggio operativo

340-430 V

Efficienza quantica a 430 nm

(75 ± 2) %

Capacità

Dipendenza del guadagno dal voltaggio

Dipendenza del guadagno dalla temperatura

Corrente oscura

(80 ± 2) pF

(3.1 ± 0.1) %/V

(−2.4 ± 0.2) %/◦ C

< 50 nA

Corrente oscura tipica

3 nA

Corrente oscura dopo irraggiamento con 2 × 1012 n/cm

5 µA

strato n++ dove vengono raccolti.

Le principali caratteristiche degli APD Hamamatsu sono riportate in Tabella (2.4) [23].

Le motivazioni che hanno portato alla loro scelta sono:

• elevato guadagno interno, regolabile fino a 200 (il valore operativo è 50);

• buona efficienza quantica;

• bassa capacità e bassa corrente di saturazione inversa;

• resistenza alle radiazioni sufficiente per lavorare nella regione centrale di ECAL;

• compattezza;

• insensibilità al campo magnetico;

• ridotta risposta alle particelle cariche grazie al piccolo spessore della regione di

moltiplicazione (' 5 µm).

Gli APD hanno un’area attiva di 5 × 5 mm2 . Per migliorare la raccolta di luce sono

stati incollati due APD sulla faccia posteriore di ogni cristallo del barrel.

La resistenza alle radiazioni degli APD è stata verificata, facendo particolare attenzione alla resistenza all’irraggiamento da neutroni [27]. Non è stata riscontrata variazione

apprezzabile nel guadagno fino a flussi di neutroni di circa 1013 neutroni/cm2 , mentre è

2.4 Calorimetro elettromagnetico

Figura 2.8

37

Struttura di un VPT. Le distanze sono espresse in mm.

stato osservato un aumento lineare della corrente oscura, fino a valori di qualche µA per

le massime dosi aspettate.

Negli endcap si ha bisogno di fotorivelatori in grado di operare in condizioni di elevata

radioattività e in presenza di un forte campo magnetico assiale. La quantità di radiazione

prevista è infatti notevolmente maggiore di quella del barrel: il flusso di neutroni può

raggiungere valori dell’ordine di 1015 neutroni/cm2 nelle regioni più vicine ai fasci. Per

questo motivo non possono essere utilizzati gli APD.

Si è deciso di utilizzare dei fototriodi a vuoto (VPT), la cui struttura è schematizzata

in Figura (2.8) [26]. Il fototriodo è composto da un fotocatodo di vetro resistente alle

radiazioni, un anodo a griglia posizionato a 4-5 mm dal fotocatodo, e un dinodo posto 2-3

mm dopo l’anodo. Tipicamente il fotocatodo è collegato a terra, l’anodo è a una differenza

di potenziale rispetto a questo di circa 1000 V e il dinodo a una differenza di potenziale

di circa 800 V.

I fotoni di scintillazione provenienti dal cristallo colpiscono il fotocatodo, dove sono

convertiti in fotoelettroni per effetto fotoelettrico. I fotoelettroni sono accelerati dal forte

campo elettrico in direzione dell’anodo. Una larga parte di essi attraversa la griglia dell’anodo e colpisce il dinodo, dove vengono prodotti numerosi elettroni secondari (il fattore di

emissione secondaria può arrivare a 20). Gli elettroni secondari cosı̀ creati sono di nuovo

accelerati verso l’anodo, dove ne viene raccolta un’ampia frazione.

Le principali caratteristiche dei VPT sono riportate in Tabella (2.5) [26].

38

Il Large Hadron Collider e l’esperimento CMS

Tabella 2.5

Principali caratteristiche dei VPT.

Diametro esterno

22 mm

Diametro utile del fotocatodo

15 mm

Lunghezza complessiva

50 mm

Corrente oscura

Dipendenza del guadagno dal voltaggio

Dipendenza del guadagno dalla temperatura

Efficienza quantica a 450 nm

2.4.3

1-10 nA

< 0.1 %/V

< 1 %/◦ C

> 15 %

Guadagno effettivo a B = 0 T

12

Guadagno effettivo a B = 4 T

7

Geometria

Il calorimetro elettromagnetico ha una struttura cilindrica. La parte centrale del cilindro,

detta barrel, copre la regione di pseudorapidità corrispondente a |η| < 1.479; il barrel

è chiuso a entrambe le estremità da due strutture identiche laterali, detti endcap, che

raggiungono |η| = 3. Di fronte a quasi tutta la regione fiduciale degli endcap (1.653 <

|η| < 2.6) è posto un rivelatore che fornisce informazioni sullo sviluppo trasversale dello

sciame (preshower). La Figura (2.9a) mostra una prospettiva della struttura di ECAL. In

Figura (2.9b) si vede invece una sezione di un quarto del calorimetro.

Il barrel ha un raggio interno di 129 cm. È costituito da 61 200 cristalli, corrispondenti

a una granularità di 360 cristalli in φ e di (2 × 85) cristalli in η. I cristalli hanno forma

troncopiramidale e sono montati in una geometria quasi proiettiva di modo che i loro assi

formano un angolo di 3◦ con la congiungente al vertice di interazione nominale. Un singolo

cristallo corrisponde approssimativamente a un passo di 0.0174 × 0.0174 nel piano η −

φ (quest’ultimo misurato in radianti), corrispondente a 22 × 22 mm2 all’estremità frontale

e 26 × 26 mm2 all’estremità posteriore. Sono lunghi 23 cm, corrispondenti a 25.8 X0 .

Un cristallo e i due APD incollati sulla sua faccia posteriore costituiscono una sottounità. Le sottounità sono montate in strutture alveolari fatte di sottili lamine di fibra di

vetro, detti sottomoduli (vedi Figura (2.10a)), costituiti da 5 paia di sottounità. I sottomoduli sono quindi assemblati a formare moduli (Figura (2.10b)), e 4 moduli formano un

supermodulo (Figura (2.10c)). Il barrel è costituito di 36 supermoduli identici, ognuno dei

2.4 Calorimetro elettromagnetico

(a)

Figura 2.9

39

(b)

(a) Visione prospettica della struttura di ECAL; (b) Sezione di un quarto di ECAL.

Sono evidenziati alcuni valori di pseudorapidità e il preshower.

quali copre metà della sua lunghezza.

Gli endcap sono posti a una distanza longitudinale di 3 144 mm dal punto di interazione,

tenendo conto dello spostamento di circa 2.6 cm verso il centro causata dall’accensione

del campo magnetico. Sono formati da cristalli identici, di faccia anteriore di dimensioni

28.62 × 28.62 mm2 , lunghezza pari a 220 mm (24.7X0 ), e faccia posteriore di 30 × 30 mm2 .

I cristalli sono raggruppati in unità meccaniche di 5 × 5 cristalli, dette supercristalli (SC),

fatte con una struttura alveolare in fibra di carbonio.

A valori di pseudorapidità maggiori di 2.5, il livello di radiazione e l’elevata molteplicità

di particelle rendono impossibili misure di precisione. I cristalli più vicini ai fasci si usano

solamente per misurare l’energia trasversa dell’evento e congiuntamente al calorimetro

adronico per ricostruire i jet.

Nell’intervallo di pseudorapidità 1.653 < |η| < 2.6 si impiega un rivelatore, detto

preshower, a forma di corona circolare di raggio interno pari a 45.7 cm e raggio esterno

di 1.23 m. È un calorimetro a campionamento con 2 strati, e utilizza un campionatore

di piombo e un rivelatore a strisce di silicio. Gli strati di piombo (rispettivamente di 2

e 1 X0 ) provocano lo sviluppo di sciami elettromagnetici da parte di elettroni e fotoni

entranti, e i rivelatori a strisce di silicio posti fra gli strati di piombo misurano l’energia

depositata e il profilo laterale degli sciami stessi.

L’obiettivo principale del rivelatore preshower è la distinzione fra fotoni e pioni neutri