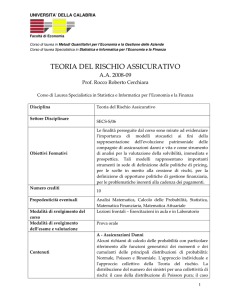

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

Capitolo 8

La valutazione ex-post: selezione del gruppo di controllo,

modelli di durata

Introduzione

L’obiettivo principale del presente lavoro è quello di illustrare un insieme di

metodologie statistiche utili per valutare l’impatto sull’occupazione dei Fondi Strutturali nella

Regione Calabria. Prima di descrivere le principali tecniche e metodologie statistiche,

pensiamo sia necessario chiarire, in un contesto generale, quali siano i termini del problema e

le difficoltà intrinseche connesse alla valutazione ex-post degli interventi pubblici, introdurre

la simbologia necessaria e definire il concetto stesso di effetto nell’ambito degli studi di tipo

economico-sociali.

Le domande cruciali a cui siamo chiamati a rispondere sono del tipo seguente:

il miglioramento osservato è merito dell’intervento o si sarebbe verificato comunque ?

il peggioramento osservato sarebbe stato più grave in assenza di intervento ?

Da queste domande si evince la sottostante incertezza dell’attribuzione all’intervento

(causa) dell’effetto osservato. Tale incertezza rende necessario il ricorso a procedure di

valutazione dell’impatto dell’intervento.

Più precisamente, nell’ambito della valutazione degli interventi pubblici – in

particolare i FSE - l’obiettivo principale è quello di valutare l’impatto dell’intervento stesso

sui soggetti destinatari (nel caso specifico potrebbero essere, ad esempio, i disoccupati di una

particolare area geografica della Calabria). Assumendo che l’intervento sia costituito da un

insieme di azioni rivolte a specifici soggetti con l’obiettivo di modificare, in una direzione

desiderata, la loro condizione, l’impatto è inteso come contributo dell’intervento alla

modificazione di tale condizione (ad esempio, il passaggio dallo stato di disoccupato a quello

di occupato).

Al fine di valutare l’impatto dell’intervento sui destinatari è necessario confrontare la

condizione osservata che i soggetti esposti presentano dopo l’intervento con la condizione

ipotetica, detta situazione controfattuale, che si sarebbe osservata, per gli stessi soggetti nello

stesso periodo, in assenza di intervento. Evidentemente, tale confronto è impossibile perché

non è dato di osservare ciò che sarebbe successo, ai soggetti esposti, in assenza

dell’intervento. Da quanto detto, il problema centrale nella valutazione d’impatto, nell’ambito

delle scienze economico sociali, consiste nel fornire una adeguata approssimazione della

situazione controfattuale. La tecnica più ricorrente, presente in letteratura, per ottenere detta

approssimazione, è quella di osservare la condizione per un gruppo di soggetti non-esposti

all’intervento (detto gruppo di confronto o di controllo). Nell’individuare il gruppo di

confronto bisogna fare particolare attenzione in quanto i soggetti non esposti potrebbe essere

diversi dai soggetti esposti per ragioni che non dipendono dall’intervento, ma dal processo

stesso di selezione (o di autoselezione). Questa differenza nelle condizioni di partenza viene

indicata con il termine di selection bias [distorsione da (auto)-selezione]. In altri termini, tale

distorsione deriva dal fatto che, nell’ambito degli studi sulla valutazione d’impatto degli

interventi pubblici, i dati disponibili non sono sperimentali, cioè ottenuti con assegnazione

casuale dei soggetti all’intervento, come avviene negli esperimenti randomizzati, bensì sono

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

176

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

generati da decisioni individuali o da un selettore esterno o da altri meccanismi che

determinano l’appartenenza al gruppo degli esposti piuttosto che al gruppo di confronto.

Per formalizzare il concetto di effetto dell’intervento è necessario che la situazione

osservata sia rappresentabile tramite una variabile statistica Y, detta variabile risultato.

Supponiamo di osservare un campione di individui estratto dalla popolazione e che

ciascuno di essi sia caratterizzato dalle variabili (Y0 , Y1 , K, x), dove Y0 e Y1 rappresentano

rispettivamente il valore che la variabile risultato avrebbe in presenza di trattamento (o

intervento) e quello che assumerebbe in assenza di trattamento (o intervento), x è un vettore di

caratteristiche individuali osservabile prima dell’intervento; infine, K è una variabile binaria

che assume valore 1 se l’individuo è esposto all’intervento e 0 se se non risulta esposto.

Evidentemente, per l’individuo i-esimo riusciamo ad osservare solo una delle due variabili Y0

o Y1 . Per ogni individuo la variabile risultato osservata Y sarà

Y = Y1 K + Y0 (1 − K) .

Banalmente, l’effetto dell’intervento per un individuo è definito dalla seguente

differenza

Y1 − Y0

tuttavia, la realizzazione dell’intervento preclude la possibilità di osservare la

situazione controfattuale (questo è il problema fondamentale dell’inferenza causale, Holland,

1986).

Tra i diversi metodi utilizzati in letteratura per individuare il gruppo di controllo si

ricordano: l’esperimento naturale (chiamato difference-in-differences), i metodi di matching, i

metodi di selezione e i metodi di simulazione strutturale. Alcune di queste tecniche verranno

descritte nel paragrafo successivo e nella Parte IV del Rapporto.

In letteratura si classificano sinteticamente le strategie per la valutazione del

controfattuale utilizzando come discriminante la tipologia di informazioni disponibili (dati

cross-section o longitudinali), di informazioni sul processo di selezione degli individui e di

informazioni sulle unità escluse dal programma di interventi [Carlucci e Pellegrini (2001),

pag. 259- 7 ]. Nel caso di assenza di informazioni relative sia al processo di selezione che alle

unità escluse dal programma, ed avendo almeno due momenti di osservazioni su tutti i

soggetti, l’una precedente e l’altra successiva all’intervento, la strategia utilizzata è il disegno

senza il gruppo di controllo, nel quale si mette a confronto la performance delle unità trattate

in due momenti a cavallo dell’intervento, controllando l’effetto di variabili esogene al

programma. Se, invece, siano disponibili dati relativi ad un singolo anno sia per le unità

trattate dall’intervento che per quelle escluse (cross-section), si possono considerare due

stimatori: instrumental variable estimator (IV) e Heckman selection estimator. Nel caso in

cui si disponga di informazioni sulle unità escluse ma non sul processo di selezione il

modello che fornisce stime d’impatto più robuste è il modello difference in differences, per la

cui applicazione tuttavia sono necessarie almeno due informazioni, pre e post intervento. Se,

infine, si dispone di informazioni relative sia alle unità escluse sia alle modalità si

assegnazione del beneficio, nonché di informazioni su più anni, la strategia più indicata

utilizza tecniche i matching. Nella sua formulazione generale il metodo consiste

nell’associare ciascun partecipante al programma di interventi con un non partecipante sulla

base di caratteristiche osservabili, in modo tale da rendere simili il gruppo delle unità trattate

7

C. Carlucci e G. Pellegrino (2001), La valutazione degli aiuti alle imprese: modelli e metodi statistici. In Atti

del Convegno Intermedio della Società Italiana di Statistica “Processi e Metodi Statistici di Valutazione” , Roma

2001, pag. 253-262.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

177

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

con il gruppo di controllo (nel senso che tra i due gruppi una parte della differenza sia

controllata mediante le variabili osservabili riducendo in tal modo l’effetto della selection

bias). Quando le caratteristiche osservabili sono numerose, un modo per rendere più

semplice l’associazione tra unità partecipanti e non all’intervento è quello di utilizzare una

loro funzione. Normalmente la funzione utilizzata è la probabilità partecipazione al

programma (propensity score) in quanto si dimostra che l’uso di tale funzione mantiene

inalterata l’indipendenza condizionata. Si evidenzia, infine, che nell’utilizzare il metodo

matching, si può seguire un approccio parametrico, cioè si possono utilizzare specifiche

forme funzionali per stimare la relazione tra la variabile outcome8 e le variabili osservabili.

1.

Selezione del gruppo di controllo

1.1

Introduzione

In questo lavoro, dopo aver richiamato gli elementi del disegno sperimentale

descrivendo i problemi connessi con l’eventuale adozione dell’approccio sperimentale,

espongo la metodologia statistica che, nella logica dei disegni quasi-sperimentali, si propone

di ricostruire opportunamente il gruppo di controllo, individuando i soggetti che ne entreranno

a far parte da una lista ampia di soggetti potenzialmente candidati ad essere esposti

all’intervento.

Il metodo esposto prevede di selezionare il gruppo di controllo mediante una tecnica di

matching basata sul propensity score, la probabilità che un soggetto ha di essere sottoposto al

trattamento. I soggetti selezionati da questa procedura saranno per quanto possibile simili ai

soggetti effettivamente trattati, di conseguenza il gruppo dei soggetti sottoposti all’intervento

e il gruppo dei soggetti di controllo potranno essere correttamente confrontati per valutare

statisticamente l’effetto del trattamento, ovvero valutare l’impatto netto dell’intervento

pubblico.

1.2

Cenni all’approccio sperimentale

Nella fase della valutazione di impatto, assume un ruolo centrale la definizione di un

appropriato disegno (piano) sperimentale, in grado di suggerire una opportuna osservazione di

dati da utilizzare, con metodi appropriati di analisi statistica, nelle valutazioni di impatto.

Il piano sperimentale prevede essenzialmente tre aspetti:

Ø

Ø

Ø

la ripartizione dei soggetti interessati all’intervento in due gruppi, uno costituito

da soggetti sottoposti all’intervento o trattamento (gruppo sperimentale), l’altro

costituito da soggetti non sottoposti al trattamento (gruppo di controllo);

l’assegnazione casuale dei vari soggetti ai due gruppi (randomizzazione);

il confronto tra opportune misurazioni effettuate sui due gruppi.

L’obiettivo è naturalmente quello di valutare statisticamente l’effetto del trattamento

(l’intervento pubblico), attraverso il confronto tra i dati osservati per il gruppo sperimentale e

i dati osservati per il gruppo di controllo. Grazie al meccanismo casuale generato dalla

randomizzazione, i soggetti appartenenti ai due gruppi dovrebbero risultare assolutamente

simili in tutto, tranne che nel fatto di essere stati sottoposti o meno al trattamento.

I piani sperimentali sono stati intensamente utilizzati a partire dagli anni sessanta, in

particolare negli Stati Uniti, tuttavia l’esperienza ha posto in luce diversi limiti dei disegni

8

La letteratura specializzata utilizza il termine outcome per fare specifico riferimento ai risultati finali ( cioè alle

“risultanze”) ultime dell’intervento direttamente collegate e collegabili con le sue stesse finalità.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

178

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

sperimentali che ne sconsigliano l’impiego nella loro forma originale per la valutazione

dell’impatto di interventi sociali; va comunque segnalato che i piani sperimentali contano

ancora su alcuni sostenitori, e il dibattito sulla validità del loro uso è ancora aperto (v. Rettore

et altri, 2001).

Uno dei principali problemi sollevati nell’applicazione del disegno sperimentale è da

ricercare nella dubbia validità etica dello stesso, con riferimento alla procedura di

randomizzazione. Infatti, tenendo conto della particolare delicatezza delle politiche pubbliche

e sociali, rendere casuale l’assegnazione di un intervento a un soggetto piuttosto che ad un

altro, entrambi bisognosi dello stesso, in quanto i due gruppi devono essere per definizione

simili, mal si coniuga con le necessità di uguaglianza ed imparzialità che dovrebbero

caratterizzare le politiche pubbliche. Inoltre, in un regime di scarsità di risorse che sembra

caratterizzare gran parte dei paesi occidentali, risulta di dubbia eticità negare uno dei pochi

interventi disponibili a soggetti che avrebbero titolo a riceverli.

Anche quando ciò possa sembrare etico, la randomizzazione e la conseguente

creazione del gruppo di controllo risultano nella pratica difficili, se non impossibili, da

realizzare. Gli interventi pubblici si caratterizzano per una molteplicità di aspetti, legati ai

diversi livelli di gestione degli interventi, all’intensità degli stessi, alla risposta da parte dei

soggetti cui l’intervento è rivolto. Randomizzare in presenza di tale molteplicità di aspetti

risulta complesso e spesso, in pratica, impossibile.

D’altra parte, il piano sperimentale di per sé può non assicurare una convincente

evidenza al processo di causa-effetto indagato, per l’impossibilità di generalizzare i risultati

ottenuti negli esperimenti, circostanza quest’ultima che caratterizza in alcuni casi gli studi

sperimentali.

Per superare i limiti legati all’impiego dell’approccio sperimentale, sono stati

sviluppati diversi metodi e tecniche di valutazione che consentono di ovviare all’assenza della

randomizzazione (v. Campostrini, 1995).

Una possibilità metodologica, seguita in questo lavoro, è quella di ricostruire il gruppo

di controllo con opportune tecniche di selezione non casuale, nel tentativo di avvicinarsi, per

quanto possibile, alla ipotetica situazione sperimentale, con due gruppi essenzialmente simili,

diversi solamente per il fatto di essere stati sottoposti al trattamento o meno, tenendo anche

conto, nella fase di analisi dei dati, di eventuali allontanamenti dalla condizione sperimentale.

I piani costruiti in tal modo sono noti come disegni quasi-sperimentali9 .

Va segnalato come in alcuni casi risulti utile impiegare i cosiddetti piani non

sperimentali, i quali non prevedono una osservazione separata per un gruppo di controllo. Si

pensi agli interventi rivolti a tutta la popolazione, i cosiddetti interventi a copertura totale –

full coverage – per i quali, naturalmente, non si può pensare di isolare un gruppo di soggetti

non sottoposti al trattamento. L’idea alla base dei disegni non sperimentali è di valutare il

trattamento contando solamente sui soggetti sottoposti allo stesso; in tal senso questo

approccio è detto anche “di controllo riflessivo” – reflexive control – per sottolineare il fatto

che il confronto per la valutazione dell’impatto avviene sempre all’interno del gruppo

sperimentale. La procedura più semplice di analisi consiste nella misurazione pre e post

trattamento, sullo stesso gruppo di soggetti sottoposti all’intervento, prima e dopo averlo

effettuato.

Tornando all’approccio quasi-sperimentale, presentiamo nei successivi paragrafi la

metodologia che, ovviando alla mancanza di randomizzazione, consente di selezionare il

gruppo di controllo mediante la cosiddetta tecnica del matching, basata su un opportuno

abbinamento dei soggetti interessati all’intervento.

9

In una accezione più ampia del termine, nella letteratura valutativa, i piani quasi-sperimentali sono tutti quei

disegni che in qualche maniera si discostano dai piani sperimentali propriamente detti.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

179

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

1.3

Balancing score e propensity score

Come già sottolineato, per i disegni sperimentali i risultati ottenuti nei due gruppi

possono essere direttamente confrontati in quanto i soggetti che ne fanno parte, grazie al

meccanismo casuale sottostante, sono da ritenersi sostanzialmente simili. Discostandosi dalla

logica sperimentale, quindi in assenza della randomizzazione, si può ricostruire il gruppo di

controllo, utilizzando opportune funzioni dei dati disponibili, in modo tale che i soggetti

appartenenti ai due gruppi siano direttamente confrontabili.

Sia Z una variabile indicatrice che assume valore 1 se il soggetto è sottoposto al

trattamento, e valore 0 se il soggetto non vi è sottoposto, ovvero appartiene al gruppo di

controllo.

Sia inoltre X un vettore di covariate, cioè un vettore di variabili aggiuntive i cui valori

sono osservati su ciascuno dei soggetti interessati all’intervento. Indichiamo con x il vettore

osservato delle covariate.

Un balancing score, b(x ) , è una funzione delle covariate osservate tale che la

distribuzione condizionata di X , dato b(x ) , è la stessa per i soggetti sottoposti all’intervento

( Z = 1 ) e i soggetti di controllo ( Z = 0 ). In simboli (v. Rosenbaum-Rubin, 1983):

X ⊥ Z b(x )

(1.1)

Introduciamo ora il cosiddetto propensity score, e(x ) , definito come:

e(x ) = Pr [Z = 1 x] .

(1.2)

La funzione e(x ) non è altro che la probabilità condizionata, per un determinato

soggetto, di essere sottoposto all’intervento (Z = 1 ), dato il vettore osservato di covariate. Va

intesa come la propensione all’esposizione al trattamento, avendo osservato il vettore di

covariate.

Nel caso di disegni sperimentali, ovvero nel caso in cui si faccia uso della

randomizzazione, il propensity score è una funzione nota, in quanto Z ha una particolare

distribuzione determinata dal meccanismo casuale operato.

Nel caso invece dei piani quasi-sperimentali, per i quali non si fa uso della

randomizzazione, il propensity score è quasi sempre una funzione ignota, che non può dunque

essere specificata. Tuttavia, come vedremo in seguito, essa può essere opportunamente

stimata a partire dai dati osservati.

Per i disegni basati sull’uso della randomizzazione è noto che, date le covariate

osservate, l’assegnazione del trattamento è condizionatamente indipendente dai risultati

ottenuti, in simboli:

Y ⊥Zx

(1.3)

dove Y è la variabile di risposta negli esperimenti.

Nei disegni che non prevedono l’uso della randomizzazione, per i quali la condizione

(1.3) può non essere verificata, se potremo ritenere tuttavia plausibile il suo verificarsi,

diremo che l’assegnazione del trattamento è strongly ignorable, dato il vettore x di covariate.

In tale ipotesi, mostreremo nel prossimo paragrafo che una particolare tecnica di matching

(abbinamento) dei soggetti interessati all’intervento secondo un particolare balancing score

produce stime non distorte dell’effetto del trattamento.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

180

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

1.4

Uso del propensity score per la selezione del gruppo di controllo

Il matching è una tecnica che, partendo da una riserva di individui candidati a far parte

del gruppo di controllo, consente di ricavare quest’ultimo selezionando in modo appropriato

un certo numero di soggetti per i quali la distribuzione delle covariate è simile alla

distribuzione delle covariate nel gruppo dei trattati; in tal modo, sulla base delle covariate

disponibili, si cerca di rendere i due gruppi il più possibile simili e, quindi, confrontabili.

Presentiamo ora alcuni risultati teorici utili per ricavare la procedura di matching (per i

dettagli si veda Rosenbaum-Rubin, 1983).

Avendo osservato il valore del propensity score, l’assegnazione del trattamento è

condizionatamente indipendente dal vettore delle covariate, , cioè:

X ⊥ Z e(x ) .

(1.4)

Questo risultato mostra che il propensity score è un particolare balancing score

(scalare), secondo la definizione (1.1). Inoltre assicura che per una coppia di soggetti, inseriti

ciascuno in uno dei due gruppi, che presentano lo stesso valore del propensity score, si ottiene

la medesima distribuzione del vettore di covariate X .

Inoltre, se l’assegnazione del trattamento è strongly ignorable dato X , allora è anche

strongly ignorable dato un qualunque balancing score b(X ) , ovvero:

Y ⊥Zx

se

allora

Y ⊥ Z b(x )

per ogni b(x )

(1.5)

Il risultato vale naturalmente anche nel caso particolare in cui b(x ) = e(x) .

L’ipotesi di assegnazione del trattamento strongly ignorable, associata alla

disponibilità di un balancing score, consente di ottenere la stima dell’effetto di trattamento.

Indichiamo con Y1 la variabile di risposta nel caso in cui il soggetto avesse ricevuto

l’intervento e con Y0 la variabile di risposta nel caso in cui non l’avesse ricevuto. L’effetto

(medio) del trattamento è definito come:

E (Y1 ) − E (Y0 )

(1.6)

dove E (⋅) denota l’operatore aspettativa (valore atteso, o media).

Nell’ipotesi di assegnazione del trattamento strongly ignorable, sia b(x ) un balancing

score. Allora, si può mostrare che:

E (Y1 b(x ), Z = 1) − E (Y0 b(x ), Z = 0 ) = E (Y1 b(x )) − E (Y0 b(x ))

(1.7)

Inoltre:

Eb ( X ) (E (Y1 b( X)) − E(Y0 b (X)))

(1.8)

La (1.7) esprime il fatto che la differenza attesa tra i risultati osservati nei due gruppi

con lo stesso valore b(x ) , è uguale all’effetto (medio) di trattamento dato il medesimo valore

b(x ) . In altri termini, sotto l’ipotesi di assegnazione del trattamento strongly ignorable, per i

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

181

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

soggetti con lo stesso valore b(x ) ma appartenenti a gruppi diversi (trattati/non trattati), la

differenze attesa tra i risultati nei due gruppi coincide con l’effetto (medio) di trattamento per

il particolare valore b(x ) .

La (1.8) evidenzia che, mediando la (1.7) rispetto a tutti i possibili valori b(x ) , si

ottiene una stima non distorta per l’effetto (medio) di trattamento definito nella (1.6).

Idealmente, i soggetti sottoposti all’intervento e i soggetti di controllo dovrebbero

essere abbinati esattamente secondo il valore di tutte le covariate, in tal modo le distribuzioni

di X nei due gruppi sarebbero identiche. La (1.4) mostra che è sufficiente abbinare secondo il

valore del propensity score per ottenere le medesime distribuzioni di X per i soggetti trattati

e quelli non trattati. Inoltre, la (1.8) mostra che, nell’ipotesi di assegnazione del trattamento

strongly ignorable, l’abbinamento (il matching) secondo un qualsiasi balancing score, quindi

anche secondo il propensity score, porta ad una stima non distorta dell’effetto di trattamento.

Naturalmente, come già anticipato, l’assenza della randomizzazione non consente di

conoscere la forma della funzione e(x ) (il propensity score), di conseguenza per poter operare

l’abbinamento dei soggetti è indispensabile ottenere preventivamente le stime e′(x) di e(x )

per ogni soggetto interessato potenzialmente all’intervento, a partire dai dati disponibili, cioè i

valori delle covariate.

L’approccio comunemente utilizzato per stimare il propensity score è quello di

ricorrere ad un opportuno modello logit per e(x ) , dipendente dal valore delle covariate, e

ottenere le stime e′(x) in funzione delle stime dei parametri del modello (v. Bellio, 2001).

Ottenute le stime del propensity score, queste sono utilizzate per affiancare (abbinare) ai

soggetti che hanno ricevuto effettivamente il trattamento (gruppo dei trattati) i soggetti, dalla

lista dei candidati ad entrare nel gruppo di controllo, che presentano le medesime stime del

propensity score, e questi ultimi andranno a costituire il gruppo di controllo.

1.5

Conclusioni

I limiti alla validità dei disegni sperimentali, soprattutto quelli etici, particolarmente

rilevanti nel contesto delle politiche pubbliche, suggeriscono di adottare un disegno quasisperimentale che prevede la costruzione di un gruppo di controllo, costituito da soggetti che

abbiano caratteristiche il più possibile simili ai soggetti che hanno ricevuto l’intervento, e che

possano essere confrontati con i trattati per valutare correttamente l’impatto dell’intervento.

La tecnica del matching descritta in questo contributo risulta particolarmente efficace

per risolvere il problema della selezione, anche in considerazione della relativa semplicità del

metodo che, sulla base della somiglianza dei due gruppi ottenuta, consente di effettuare

semplici confronti basati sulle coppie di soggetti abbinati.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

182

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

Riferimenti Bibliografici

Bellio R. (2001), “La valutazione d’impatto attraverso modelli multilivello”, Atti del

convegno “Processi e Metodi Statistici di Valutazione, SIS 2001”, Roma, Giugno 2001,

Società Italiana di Statistica.

Campostrini S. (1995), “Disegni sperimentali, quasi-sperimentali, non sperimentali per

la valutazione nelle politiche sociali”, in: G. Bertin (ed.), Valutazione e sapere sociologico,

279-299, F. Angeli, Milano.

Campostrini S. (2001), “Metodi e tecniche nella valutazione di politiche e programmi

nella realtà del nuovo millennio”, Atti del convegno “Processi e Metodi Statistici di

Valutazione, SIS 2001”, Roma, Giugno 2001, Società Italiana di Statistica.

Rettore E., Trivellato U., Martini A. (2001), “Valutare gli effetti di interventi sociali in

presenza di selezione”, Atti del convegno “Processi e Metodi Statistici di Valutazione, SIS

2001”, Roma, Giugno 2001, Società Italiana di Statistica.

Rosenbaum P. R., Rubin D. B., “The central role of the propensity score in

observational studies for causal effects”, Biometrika, 70, 1, 41-55.

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

183

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

2.

Modelli di durata

L’obiettivo della presente sezione è quello di descrivere le metodologie più

appropriate per interpretare e descrivere il tempo che un individuo trascorre nello stato di

disoccupazione. E’ evidente che uno degli obiettivi finali di un intervento pubblico è

certamente quello di ridurre i tempi di attesa, degli individui sottoposti all’intervento, prima di

trovare una occupazione. Per valutare la durata della disoccupazione degli individui

seguiremo un approccio basato sul modello e, di conseguenza, per stimare i parametri

d’interesse utilizzeremo il metodo della massima verosimiglianza.

Si evidenzia che ogni studio di valutazione di impatto parte dal considerare una

riserva di individui eleggibili per il gruppo di controllo, che dovrebbe idealmente essere del

tutto confrontabile con i soggetti trattati. In ciò che segue, ipotizziamo di aver individuato il

gruppo dei soggetti sottoposti (trattati) all’intervento e, con le tecniche descritte in

precedenza, il gruppo dei soggetti non sottoposti (non-trattati).

2.1

Richiami Metodologici sui Modelli di Durata

L’obiettivo principale della presente ricerca consiste nella specificazione e nella

descrizione dei metodi di stima di un modello che fornisca la rappresentazione del tempo

trascorso in un particolare stato e delle transizioni tra stati. Gli stati vengono generalmente

definiti dai valori assunti da una variabile qualitativa durante un periodo di osservazione,

l’insieme di tutti i possibili valori di questa variabile viene chiamato insieme (spazio) degli

stati.

Così, ad esempio, volendo studiare la “demografia” delle aziende in una particolare

zona geografica e/o nell’intera Regione, possiamo definire la variabile qualitativa “situazione

dell’azienda”; seguendo l’indagine dell’INPS, nel periodo di osservazione (t0 ,tN), le aziende

possono assumere uno dei seguenti stati: “attiva” diciamo A, “sospesa” diciamo S e “cessata”

diciamo C. La variabile qualitativa può così assumere un attributo nel seguente spazio degli

stati {A,S,C}. Con riferimento al mercato del lavoro possiamo definire la variabile qualitativa

“condizione occupazionale” del soggetto i-esimo; evidentemente, l’individuo può trovarsi in

uno dei seguenti stati: disoccupato, occupato, non appartenente alla Forza Lavoro. A

seconda degli obiettivi dell’analisi, gli stati possono essere maggiormente disaggregati, ad

esempio, lo stato di “occupato” può essere scisso in “occupato a tempo determinato” e

“occupato a tempo indeterminato”. In entrambi gli esempio l’evento di interesse è

ovviamente il passaggio (cambio) da uno stato all’altro.

La variabile tempo è qui considerata una variabile casuale continua, in seguito

prenderemo in considerazione il caso in cui la durata è interpretata da una variabile casule

discreta.

Se la lunghezza degli intervalli di tempo (o le durate degli episodi) possono essere

misurati con esattezza, si è in presenza di un processo stocastico a parametro continuo. I tempi

in cui avvengono le transizioni sono rappresentate da una serie di variabili casuali nonnegative 0 = T0 ≤ T1 ≤ T2 ≤ ..... .

Poniamo, inoltre, che la variabile qualitativa che descrive gli stati possa assumere un

numero finito di categorie, in modo tale che lo spazio degli stati sia finito

{Yk ; k = 0,1,2,...., m} .

Il processo stocastico corrispondente (Y, T ) = {( Yk , Tk ) : k = 1,2,...} può essere descritto

come segue

Z = {Z( t ) : t ≥ 0}

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

184

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

con Z( t ) = Yk −1 per Tk −1 ≤ t < Tk , k=1,2,…il quale viene a descrivere un processo

stocastico discreto a parametro continuo, in quanto l’insieme degli stati è discreto mentre il

parametro (tempo) è continuo [si veda, ad esempio, Blossfeld et al. (1989)]. E’ importante

sottolineare che l’evento di interesse corrisponde sempre alla variazione in Z(t), cioè alla

transizione da uno stato all’altro.

Si evidenzia che la scelta dello spazio degli stati è legato al particolare problema che

si analizza; essa è cruciale in quanto influenza il tipo di modello statistico da utilizzare e

l’interpretazione dei risultati. Dato che gli stati sono le categorie di una variabile qualitativa,

devono essere esaustivi ed incompatibili.

Il termine episode o spell descrive il periodo di tempo che intercorre tra successivi

eventi. Un interesse particolare è assunto dalla durata degli intervalli

Vk = Tk − Tk −1

k=1,2,…

chiamato tempo di attesa (tempo di permanenza o durata). L’obiettivo principale è

quello di studiare le determinanti della durata in ogni stato e lo stato di destinazione quando si

verifica una variazione di stato.

Un caso particolare, ma molto diffuso in diversi contesti, si ottiene ipotizzando un

processo con un episodio, uno stato iniziale e uno stato di destinazione (single spell – stato

singolo con eventi non-ripetibili). Tale situazione è stata sviluppata soprattutto in ciò che

viene chiamata analisi di sopravvivenza (survival analysis) in cui il ricercatore focalizza

l’attenzione sui lifetimes. In particolare, per un generico “individuo” (o impresa o componente

meccanica di un sistema …..) l’evento di interesse è spesso denominato failure (cioè guasto,

dalle applicazioni di tipo ingegneristico) il quale si verifica dopo un certo periodo di tempo

(failure time). Indicato con ti il momento in cui si verifica il failure per l’individuo in esame, e

con t0 il tempo in cui è iniziata l’osservazione, si definisce durata la differenza (ti-t0 ).

Ovviamente durata e failure time coincidono se t0 =0. Verificatosi l’evento di interesse,

l’individuo esce dall’osservazione. L’obiettivo principale dei modelli si sopravvivenza è la

durata (ossia il tempo trascorso nello stato iniziale prima che si verifichi un evento – un

cambio di stato) e le cause che la determinano.

Si possono avere situazioni in cui lo stato occupato da un individuo può essere

abbandonato per più di uno stato (multistate model), gli stati di uscita sono ipotizzati

incompatibili ed esaustivi (nelle applicazioni di tipo biometrico tali modelli vengono

denominati competing risk models); si suppone che l’individuo abbia diverse possibilità di

uscita dalla stato iniziale (ad esempio, un individuo può essere occupato o disoccupato oppure

non appartenere alla forza lavoro).

Si possono avere, infine, modelli caratterizzati dal fatto che le transizioni da uno stato

ad un altro possono essere ripetute e l’evento d’interesse può verificarsi ripetutamente

(multiepisode model).

Consideriamo, inizialmente, il caso più semplice in cui si ha un unico episodio, uno

stato iniziale ed uno stato finale (single spell). Supponiamo, quindi, che l’individuo -i esimo, al

tempo t0 , entra nello stato iniziale (inizio attività dell’impresa, entrata nello status di

disoccupazione,..), da questo momento in poi inizia l’episodio; quest’ultimo ha termine nel

momento in cui l’individuo passa allo stato finale, ovvero si realizza l’evento d’interesse

(cessazione dell’impresa, occupazione,…), poniamo che questo avvenga al tempo t. In tale

contesto, l’interesse principale risiede nella durata dell’episodio (t-t0 ). La durata dell’episodio

può essere rappresentata da una variabile casuale non negativa, indicata con T. Se il tempo

può essere misurato con esattezza allora la variabile casuale T può essere considerata

continua, mentre se possiamo individuare solo l’intervallo entro cui cade l’evento d’interesse

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

185

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

allora la variabile casuale T è discreta, in tal caso T=t ci indica che nell’intervallo t-esimo è

avvenuto un cambio di stato [Blossfeld et al. (1989), pag.31].

Di seguito esporremo la metodologia statistica utilizzata per l’analisi della durata di un

evento nel caso di popolazioni omogenee, cioè consideriamo la variabile casuale T in assenza

di fattori sistematici o repressori (altre variabili) che possono influenzare la distribuzione di T.

2.2.

Modelli a Tempo Continuo per Popolazioni Omogenee

In questo paragrafo introduciamo la simbologia essenziale e gli strumenti di base per

descrivere i modelli di durata.

Sia T una variabile casuale continua e non-negativa, con valori in [ 0, ∞ ) , interprete

della durata di un generico episodio. Indichiamo con f(t;θ

θ ), con è ∈È ⊂ ℜ r , la funzione di

densità (fd) della variabile introdotta (si evidenzia che tale funzione, al variare di t, descrive il

modo come si distribuiscono i valori della variabile T; in altri termini e con riferimento al

mercato del lavoro, tale funzione fornisce indicazioni circa la distribuzione del durata nello

stato di disoccupazione). Indichiamo, inoltre, con F(t;θ

θ ) la funzione di ripartizione definita

dalla seguente

t

F( t ; è ) = Pr (T ≤ t ) = ∫ f ( u; è ) du

0

la quale indica la probabilità che la durata di un episodio sia al più uguale a t. Di

contro, la probabilità che la durata sia maggiore di t, detta funzione di sopravvivenza

(survivor function oppure reliability function ), è

∞

S( t ; è ) = Pr (T ≥ t ) = 1 − F( t ; è ) = ∫ f ( u; è )du .

(2.1)

t

In altri termini, la (2.1) esprime la probabilità di uscita dallo stato di disoccupazione

dal periodo t in poi. Si osservi che, per ogni è ∈È ⊂ ℜ r , S(t;θ

θ ) è monotona decrescente10 [in

quanto F(t;θ

θ ) è monotona crescente] ed, inoltre, si ha S(0;θ

θ )=1 e lim S( t; è ) = 0 . Tale funzione

t →∞

è spesso utilizzata per effettuare confronti di permanenza nello stato di disoccupato tra gruppi

(o sottogruppi) della popolazione analizzata.

Un’altra importante funzione è la cosiddetta hazard function h(t;θ

θ ), definita dalla

seguente

Pr [t ≤ T < + ∆t / T ≥ t ] f ( t; è )

=

∆ t →∞

∆t

S( t; è )

h ( t ; è ) = lim

(2.2)

10

Si evidenzia che in alcuni contesti, ad esempio nelle applicazioni di tipo economico, si

potrebbe avere lim S( t ; è ) = K > 0 , ovvero potrebbe esistere una probabilità di sopravvivenza

t →∞

ad un tempo infinito, ad esempio, un individuo potrebbe scegliere di restare disoccupato a vita

pur restando sempre all’interno della forza lavoro; in altri termini, non vi è una uscita dallo

stato di disoccupato. In tali casi, la funzione di sopravvivenza è detta defctive [Lancaster,

1990].

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

186

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

indica il tasso istantaneo che l’episodio termini nell’intervallo [ t , t + ∆t ) dato che

l’evento di interesse non si è verificato fino a t. Utilizzando la terminologia diffusa nei

modelli di sopravvivenza la (2.2) fornisce indicazioni sul tasso istantaneo di morte o failure al

tempo t, dato che l’individuo è sopravvissuto fino a t. In particolare, h ( t ; è ) ∆t è la probabilità

(approssimata) di morire nell’intervallo [ t , t + ∆t ) , data che l’individuo è sopravvissuto fino a

t. La hazard function è indicata anche con altri nomi, a seconda del campo applicativo, tra i

quali hazard rate, failure rate e force of mortality. In termini di mercato del lavoro la hazard

function fornisce indicazioni circa il tasso istantaneo di uscita dallo stato di disoccupato

nell’intervallo [ t , t + ∆t ) per un individuo che risulti essere disoccupato fino a t.

La relazione che intercorre tra h(t;θ

θ ) e t è chiamata dipendenza dalla durata; se

∂h ( t ; θ )

è maggiore di zero allora tale dipendenza è positiva, ciò significa che la probabilità

∂t

di uscita dallo stato di disoccupazione aumenta con l’allungarsi della permanenza nello stato

∂h ( t ; θ )

stesso. Se

<0 la dipendenza dalla durata è negativa e l’uscita dallo stato diventa meno

∂t

probabile nel tempo [si veda, ad esempio, Kiefer (1988)].

Si dimostra [Lawless, 1982] che tra le funzioni f(t;θ

θ ), F(t;θ

θ ), S(t;θ

θ ) e h(t; θ ) esistono

delle relazioni matematicamente equivalenti che forniscono le diverse specificazioni della

distribuzione di T. In particolare, si ha:

∂S( t; è )

= −S' ( t; è )

∂t

f (t; è )

∂ ln S( t ; è )

2) h ( t : è ) =

=−

S( t ; è )

∂t

t

3) S( t ; è ) = exp − ∫ h (u ; è )du = exp (− H( t; è ) )

0

1) f ( t ; è ) = −

(2.3)

(2.4)

(2.5)

t

dove con H( t ; è ) = ∫ h ( x; è ) dx si è indicata la hazard function cumulata. Inoltre,

0

(

poiché S( ∞; è ) = 0 si ha 0 = lim S( t ; è ) = exp − lim H( t; è )

t→ ∞

t →∞

)

⇔ lim H( t ; è ) = ∞ .

t →∞

Questo ci

consente di dire che la hazard function, per variabile casuali continue possiede le seguenti

proprietà

∞

h (t; è ) ≥ 0 e

∫ h(t; è )dt = ∞

(2.6)

0

e, quindi, non è una funzione di densità.

t

4) f ( t ; è ) = h ( t; è ) × exp − ∫ h ( u; è ) du

0

(2.7)

quest’ultima risulta essere molto importante in quanto data una hazard function è

possibile risalire alla funzione di densità della variabile casuale T. Ciò evidenzia uno degli

aspetti più importanti della funzione h(t;θ

θ ). Infatti, in quest’ambito di studi, spesso si hanno

delle informazioni qualitative sull’andamento di tale funzione (del tipo: monotona

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

187

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

decrescente, crescente; non-monotona, ecc.) del fenomeno in analisi, quindi ipotizzando una

particolare forma funzionale per h(t;θ

θ ) si può determinare, tramite la (5.7), la funzione di

densità della variabile casuale T.

In letteratura usualmente si indica con IFR, DFR, BT e UBT, rispettivamente, hazard

function strettamente crescenti (increasing failure rate), strettamente decrescenti (decreasing

failure rate), con un minimo (Bathtub) e con un massimo (upside-down bathtub).

Un’altra interessante caratteristica della durata di un episodio, utilizzata in particolare

modo nei modelli di sopravvivenza, è la durata attesa residua al tempo t

∞

f ( u; è )

r ( t ; è ) = E[T − t / T ≥ t ] = ∫ ( u − t )

du

t

S( t; è )

(2.8)

per 0 ≤ t < ∞ , (Kalbfleisch e Prentice (1980), pag.7). Con riferimento al mercato del

lavoro la (2.8) può essere interpretata come il tempo medio residuo prima di trovare una

occupazione per un soggetto che risulta essere disoccupato fino al tempo t. Si osservi che nel

contesto dei modelli di durata con singolo stato, se t=0 si ottiene la durata attesa dell’episodio.

La (2.8) può essere utilizzata per valutare l’impatto di un intervento pubblico

sull’occupazione; infatti, l’intervento risulterà essere positivo se riduce il tempo medio

residuo di permanenza nello stato di disoccupazione degli individui sottoposti all’intervento

stesso rispetto all’analoga quantità calcolata per gli individui non sottoposti.

Nell’ambito dell’inferenza parametrica il metodo di stima usualmente utilizzato è

quello di verosimiglianza, il motivo principale deriva dal fatto che gli stimatori di massima

verosimiglianza, sotto opportune condizioni di regolarità, godono di proprietà ottimali (si

rinvia alla letteratura specialistica per ulteriori approfondimenti). Supponiamo di estrarre un

campione casuale indipendente ed identicamente distribuito (iid) dalla popolazione in esame

di dimensione n, indicato con ( t 1 , t 2 ,..., t n ) ; con riferimento alla simbologia introdotta in

precedenza, la funzione di verosimiglianza risulta essere:

n

L( è ; t 1 ,..., t n ) = ∏ f ( t i ; è )

(2.9)

i =1

si osservi che tale quantità è funzione del vettore di parametri θ ed è l’unica quantità

sconosciuta del problema in esame (dato che abbiamo ipotizzato di conoscere la forma

funzionale della densità). La (2.9), al variare di θ in Θ , descrive la plausibilità (ovvero la

verosimiglianza) che il campione osservato si stato estratto dalla funzione di densità

parametrizzata da θ . Evidentemente, il valore di θ che massimizza la (2.9) individuerà la

funzione di densità che con maggiore verosimiglianza ha generato il campione. Usualmente,

per semplificare i calcoli della massimizzazione della funzione di verosimiglianza, si utilizza

il logaritmo della (2.9) ottenendo così quella che viene chiamata la funzione di logverosimiglianza

n

l( è ; t 1 ,..., t n ) = ln L(è ; t 1 ,..., t n ) = ∑ ln f ( t i ; è ) .

i =1

Sotto le note condizioni di differenziabilità, lo stimatore di massima verosimiglianza

è̂ di θ può essere ottenuto risolvendo il sistema formato dalle derivate parziali della logverosimiglianza rispetto alle singole componenti del vettore θ , cioè

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

188

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

∂l (è )

∂θ = 0

1

∂l (è )

=0

∂θ 2

.........

∂l (è )

∂θ = 0

r

(2.10)

Spesso per risolvere il sistema (2.10) è necessario ricorrere a procedure iterative di

analisi numerica, quali ad esempio il Newton-Raphson o il Fisher-scoring, i quali

garantiscono, alla convergenza, una buona approssimazione della soluzione del sistema in

esame. Al fine di valutare le proprietà degli stimatori ottenuti possiamo ricorrere alla matrice

di varianze e di covarianze asintotica degli stimatori di massima verosimiglianza, la quale si

ricorda essere uguale all’inverso della matrice di informazione di Fisher attesa, indicata con

I(θ

θ ), il cui ij-esimo elemento è uguale all’aspettativa della derivata seconda mista della logverosimiglianza presa con il segno negativo, cioè

∂ 2 l(θ )

i ij (θ ) = −E

per i,j=1,…,k.

∂θ i ∂θ j

Si evidenzia che la matrice hessiana delle derivate seconde presa con il segno negativo

(denominata informazione di Fisher osservata), in diversi contesti, risulta essere una valida

approssimazione della matrice di informazione di Fisher attesa.

2.3.

Dati censurati

Una caratteristica peculiare, fonte di ulteriori complicazioni nella fase di stima, dei

dati relativi alla durata di un episodio è l’eventualità di avere informazioni parziali sulla

realizzazione dell’evento di interesse, tale situazione viene tecnicamente denominata censura.

In parole povere, si è in una situazione di dati censurati quando solo per alcuni

individui si conosce il tempo di realizzazione dell’evento di interesse, per tutti gli altri si sa

solo che esso eccede un certo valore (che spesso coincide con la data di rilevazione). Così, ad

esempio, supponiamo di osservare l’attività (la “vita”) di un gruppo di aziende in un intervallo

di tempo (o,L]. Per le aziende che cesseranno la loro attività prima del limite L, la nostra

informazione sarà completa in quanto l’evento di interesse (la cessazione) si realizza prima

del limite L. Per tutte le altre aziende siamo in possesso solo di una informazione parziale

perché sappiamo solo che la loro attività va oltre il limite di tempo fissato, L (se dovessero

cessare la loro attività avverrà certamente dopo il limite L).

Nel caso di transizione dallo stato di disoccupato a quello di occupato, fissata una data

di osservazione pari ad L, si dispone di durate complete per tutti gli individui che transitano

nello stato di occupato prima del tempo di osservazione L, per tutti gli altri soggetti sotto

osservazione si dispone della informazione censurata, costituita dal fatto che alla data di

osservazione gli individui permangono ancora nello stato di disoccupazione.

In altre parole, una osservazione è censurata a destra se la durata dell’episodio è

maggiore di L. Analogamente, una osservazione è censurata a sinistra se l’inizio dell’episodio

è minore o uguale ad L.

Per analizzare i dati censurati è necessario conoscere il meccanismo effettivo che

genera la censura. In questa sede ci limitiamo a descrivere la censura di I tipo che è quello

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

189

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

usualmente utilizzato nell’ambito degli studi osservazionali (per la descrizione di altri schemi

di censura si rinvia, ad esempio, Lawless, 1982). L’obiettivo principale è quello di

determinare la distribuzione campionaria e, quindi, la funzione di verosimiglianza nel caso di

presenza nel campione osservato di dati censurati.

Supponiamo, ad esempio, di osservare nel tempo l’attività di n aziende, indichiamo

con Ti la durata della azienda i- esima e per ognuna di queste stabiliamo un tempo massimo di

osservazione (tempo prefissato di osservazione) pari a Li. Per la i- esima azienda, osserveremo

la durata Ti se Ti ≤ L i altrimenti la durata è censurata a destra in Li. I dati in questione

possono essere rappresentati da n coppie di variabili casuali ( t i , δ i ) , dove

1 se Ti ≤ L i

t i = min( Ti , L i ) e δ i =

.

0 se Ti > L i

Posto che la durata Ti abbia funzione di densità e di sopravvivenza, rispettivamente,

date da f(t;θ

θ ) e S(t; θ ), si dimostra che [si veda, ad esempio, Lawless (1982), pag. 37] la

funzione di densità congiunta di della coppia di variabili casuali ( t i , δ i ) è data da

[f ( t i ; θ )]δ × [S( L i ; θ) ]1−δ .

i

i

(2.11)

Se le n coppie ( t i , δ i ) sono indipendenti allora la verosimiglianza risulta essere la

seguente

L(θ; t , δ ) = ∏ [f ( t i ; θ) ]δ i × [S( L i ; θ )]1− δ i .

n

(2.12)

i =1

Una questione particolarmente rilevante connessa al meccanismo di censura è relativa

alle procedure inferenziali in presenza di dati censurati. Per quanto riguarda il caso della

censura di I tipo le procedure esatte sono particolarmente difficili da trattare e, quindi,

assumo rilevanza le procedure asintotiche, per la discussione su questo punto si veda, ad

esempio, Kalbfleisch e Prentice (1980, sez. 3.4).

Nel seguito saranno richiamate alcune stime non parametriche di quantità descritte in

precedenza, in particolare della funzione di sopravvivenza e della hazard function. L’utilità di

queste stime si rilevano nella fase di scelta del modello parametrico in quanto forniscono sotto

l’ipotesi di omogeneità delle osservazioni, ad esempio, l’andamento osservato della funzione

di sopravvivenza e/o della hazard function. A tal fine, suddividiamo l’asse temporale in

intervalli ( t i−1 , t i ) , dove i=1,2,…,k+1, t0 =0 e t k +1 = ∞ . In ogni intervallo così costruito si

trovano sia osservazioni non-censurate (l’individuo abbandona lo stato di disoccupazione) che

censurate. Siano ni il numero di individui osservati nell’intervallo ( t i−1 , t i ) , e siano di il

numero di individui che trovano un’occupazione (cioè lasciano lo stato di disoccupato) e ci il

numero di osservazioni censurate (cioè individui di cui non sappiamo quando lasceranno lo

stato di disoccupazione). Indichiamo, inoltre, con tmi e bi, rispettivamente, il valore centrale e

l’ampiezza dell’intervallo i-esimo e con n 'i = n i − c2i l’effettiva misura del campione

nell’intervallo i-esimo. In tale contesto, la stima della probabilità condizionata di transizione

nello stato di occupato nell’intervallo ( t i−1 , t i ) per un individuo disoccupato fino al tempo ti-1

è data da

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

190

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

di

.

n 'i

Si dimostra che le stime della funzione di sopravvivenza al tempo ti, della funzione di

densità e della hazard function al tempo tmi sono, rispettivamente, date dalle seguenti:

q̂ i =

i

Ŝ( t i ) = ∏ (1 − q̂ j ) ;

j =1

f̂ ( t mi ) =

Ŝ( t i −1 ) q̂ i

bi

e ĥ ( t mi ) =

2q̂ i

b i (1 + p̂ i )

(2.13)

dove p̂ i = 1 − q̂ i .

2.4

Alcuni modelli parametrici

In letteratura esistono diversi sono i modelli parametrici utilizzati per descrivere ed

interpretare la durata degli individui nello stato di disoccupazione. In questa sezione,

descriviamo le caratteristiche principali di alcuni modelli, già applicati con buoni risultati in

altri contesti, tra le quali la forma della funzione di densità, i momenti – in particolare media e

varianza – il comportamento della hazard function al variare dei parametri che caratterizzano

la funzione di densità. Si vedrà in seguito che hazard function gioca un ruolo cruciale sia

nell’interpretazione della durata di disoccupazione (perché, ricordiamo, essa fornisce

indicazioni circa la probabilità istantanea di uscita dallo stato di disoccupazione) sia nella

stessa scelta del modello parametrico da adattare ai dati osservati.

La funzione di densità storicamente utilizzata nell’analisi dei dati di durata è la

Weibull, la quale può essere vista come una generalizzazione della esponenziale negativa.

L’intenso utilizzo di tale modello è certamente giustificato dalla semplicità sia in termini di

interpretazione che di stima del fenomeno analizzato – quasi tutti i software statistici

presentano procedure di stima dei parametri della Weibull sia nel caso di popolazioni

omogenee che in quelle eterogenee ma anche dal fatto che soddisfa alcune importanti

proprietà teoriche (in particolare, si vedrà in seguito, la tale modello, in connessione con il

modello Gamma, forniscono una semplice interpretazione dell’eterogeneità non osservata).

D’altra parte, diversi autori negli ultimi due decenni, hanno fortemente criticato l’utilizzo di

modello (in particolare modo nel caso di studi di tipo economico) perché la hazard function

corrispondente non presenta una sufficiente flessibilità e, quindi, capacità di adattarsi a

fenomeni con hazard non monotoni.

La hazard function della variabile casuale di Weibull è data da

h ( t ; β, λ) = λβ(λt )β−1

(2.14)

con λ>0 e β>0. Si può verificare che se β>1 allora la (2.14) è sempre decrescente per

ogni t; se β<1 è sempre crescente, infine, se β=1 è costantemente pari a λ. Da queste prime

osservazioni è evidente che il modello in analisi descrive in modo appropriato i fenomeni che

presentano hazard function con andamento monotono (cioè o crescente o decrescente oppure

costante). In altre parole, tale modello descrive situazioni in cui la probabilità di uscita dallo

stato di disoccupazione aumenta (diminuisce) con l’allungarsi del tempo, perché la

dipendenza dalla durata è positiva (negativa). Si osserva che molti studi empirici sulla durata

della disoccupazione [ tra i quali, ricordiamo, Addison e Portugal (1998); Caruso (2001);

Lalla e Pattarin (2001) ] evidenziano che, al variare del tempo, vi è una contemporanea

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

191

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

presenza positiva e negativa della dipendenza dalla durata, cioè la hazard function empirica

presenta andamento non-monotono ( UBT ).

Utilizzando la relazione descritta dalla (2.7) è immediato determinare la funzione di

densità di una variabile casuale di Weibull

f ( t ; λ, β) = λβ(λt )β −1 exp (− ( λt ) β ) .

(2.15)

La relazione utilizzata suggerisce uno dei metodi, presenti in letteratura, per

individuare il modello parametrico più appropriato per la descrizione dei dati di durata; infatti,

la (2.15) è stata ottenuta a partire dalla hazard function (questo metodo ed altri verranno

descritti più dettagliatamente nel paragrafo relativo alla scelta del modello).

In modo analogo, tramite la (2.5) possiamo calcolare la funzione di sopravvivenza

(

)

S( t ; λ, β) = exp − ( λt ) β .

Si dimostra, inoltre, che il momento di ordine r è dato da

[ ]

( )

E T r = λ−r Γ 1 + βr

dove con Γ(.) è stata indicata la funzione matematica Gamma.

Si evidenzia che il parametro β governa la forma della funzione di densità di una

Weibull; in particolare, per β>1 la (2.15) è unimodale asimmetrica a destra, per β=1 è zero

modale asimmetrica a destra ed interseca l’asse delle ordinate per t=0 in f(0)=1 ed, infine, per

β<1 è zero modale asimmetrica a destra con asintoto verticale in t=0. Il parametro λ è un

parametro di scala cioè al suo variare cambia la scala sull’asse delle ascisse, ma non influenza

la forma funzionale della funzione di densità.

In tutti i contesti in cui i dati di durata osservati presentano una hazard function

empirico non monotono e/o considerazioni di tipo qualitativo (teorico) sul fenomeno oggetto

di studio suggeriscono modelli più flessibili di quello esposto in precedenza, è evidente che il

modello di Weibull non può essere utilizzato. La scelta del modello parametrico dovrà

ricadere su modelli che presentano hazard function particolarmente flessibili e andamenti

non-monotoni. Tra le diverse funzioni di densità che godono di queste caratteristiche

ricordiamo la distribuzione Burr XII [Burr (1942)], la quale presenta la seguente hazard

function

µα(µt )α −1

.

(2.16)

1 + γ(µt )α

E’ semplice verificare che la (2.16) presenta un massimo per α>1 nel punto

h ( t ; µ, γ, α) =

[

]

1

α −1 α

t* =

; ciò significa che il modello parametrico in esame è capace di descrivere, per

γ

α>1, la seguente situazione: la probabilità istantanea di uscita dallo stato di disoccupato è

crescente per tutti i periodi t<t* per gli individui che risultano essere disoccupati fino al tempo

t, raggiunge un massimo in t=t* e, per tempi maggiori di t*, decresce [tale situazione è stata

riscontrata in diversi lavori empirici si veda, ad esempio, Addison e Portugal (1998); Caruso

(2001); Lalla e Pattarin (2001)]. Per α ≤ 1 la hazard function è sempre decrescente per ogni

t>0; in tal caso, il modello di Burr descrive una dipendenza durata negativa.

Utilizzando la relazione tra densità ed hazard descritta dalla (2.7), otteniamo la

funzione di densità del modello di Burr, cioè

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

192

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

f ( t ; µ , γ, α) = αµ t

α α −1

[1 + γ (µt ) ]

α

−1 − γ

γ

.

Si osserva, infine, che γ=1 nella distribuzione Burr XII si ottiene il noto modello loglogistico utilizzato in diversi contesti per rappresentare dati di durata con hazard non

monotoni.

In letteratura, diversi autori hanno evidenziato la necessità di costruire modelli di

durata ancora più flessibili dei modelli sopra descritti, in modo tale ottenere descrizioni della

realtà più verosimili [si veda, ad esempio, tra i più recenti Xie a Lai (1995), Wang (2000),

Jang, Murthy e Ji (2001), Al-Mutari e Agarwal (1999); Xie, Tang e Goh (2002), Hampt e

Schabe (1997); Chen (2000), Wang, Hsu e Liu (2002); Mudholkar, Srivastava e Freimer

(1995), Mudholkar, Srivastava e Kollia (1996), Saha e Hilton (1997); Louzado-Neto [1999(a)

e (b)] e Louzado-Neto, Mazucheli e Achcar (2002)]. All’interno di questo filone di ricerca, al

fine di individuare modelli parametrici per l’analisi dei dati di durata che possano descrivere

situazioni diverse, Domma (2002) studia il modello di Dagum (1977, 1980), intensamente

utilizzato nell’ambito dell’analisi dei redditi, ed evidenzia che la hazard function di detto

modello, al variare dei parametri nello spazio parametrico, descrive oltre alle situazioni viste

per il modello di Burr XII ( cioè sempre decrescente o con un massimo) anche la situazioni di

contemporanea presenza di un minimo ed un massimo. In altri termini, per un particolare

sottoinsieme dello spazio parametrico, la hazard function è prima decrescente, raggiunge un

minimo per poi crescere, raggiunge un massimo per poi decrescere. Tale andamento è stato

osservato da Caruso (2001) analizzando la durata di permanenza nelle liste di mobilità della

Regione Umbria di un insieme di disoccupati con e senza indennità.

Alcune osservazioni sulla scelta del modello parametrico

Un problema rilevante connesso con l’approccio qui descritto è rappresentato dalla

scelta del modello parametrico più idoneo a rappresentare, descrivere e interpretare la durata

del fenomeno in esame. La domanda fondamentale a cui bisogna dare una risposta è la

seguente:

quale tra i molteplici modelli parametrici esistenti in letteratura bisogna scegliere per

interpretare e descrivere (e, successivamente, stimare) la durata di permanenza nello stato di

disoccupazione degli individui in esame?

La risposta a tale domanda non è né semplice né immediata anche perché ogni

modello presente in letteratura rappresenta una particolare situazione teorica e gode,

generalmente, di un insieme di proprietà utili ai fini della spiegazione della durata, alcune

specifiche del modello stesso le restanti comuni ad altri modelli parametrici.

La letteratura concorda sul fatto che un primissimo criterio di scelta del modello è

basato sulla flessibilità dello stesso a descrivere situazioni diverse al variare dei parametri

nello spazio parametrico. E’ evidente che aumentando il numero dei parametri, cioè la

dimensione del vettore θ , aumenta la flessibilità. Ma ciò si contrappone, in qualche modo, al

criterio della parsimonia dei modelli in cui si richiede, sia per motivi di semplicità di

interpretazione sia per motivi di efficienza nelle stime, di utilizzare modelli con un numero

limitato di parametri e che siano di chiara interpretazione.

Al fine di chiarire il problema, supponiamo di voler studiare la durata di permanenza

nello stato di disoccupazione di un insieme di giovani neo-laureati. Considerazioni di tipo

qualitativo ed evidenze empiriche ci portano a concludere che la probabilità di uscire dallo

stato di disoccupazione, per questi soggetti, aumenta col passare del tempo; in altri termini,

siamo in una situazione di dipendenza positiva dalla durata. In tale contesto, il modello

parametrico teorico utile per rappresentare e descrivere tale situazione dovrà presentare, tra le

sue caratteristiche, una hazard function sempre crescente al crescere di t. Una scelta

appropriata sembra essere, ad esempio, il modello di Weibull il quale, come detto in

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

193

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

precedenza, per β>1 presenta una hazard function sempre crescente. Sempre con lo stesso

obiettivo supponiamo, ora, che gli individui di cui vogliamo studiare la durata di permanenza

nello stato di disoccupazione sia costituito da un insieme di individui appartenenti a classi di

età avanzate (evidentemente, questa è una situazione molto realistica e coinvolge, spesso, gli

individui in cerca di occupazione dopo uno o più licenziamenti). Analogamente a quanto fatto

prima, possiamo concludere, sulla base di considerazioni sia di tipo qualitativo che da

evidenze empiriche, che la probabilità di uscire dallo stato di disoccupazione diminuisce

all’aumentare del tempo; tecnicamente, diremo che siamo in una situazione di dipendenza

negativa dalla durata. Il modello parametrico da utilizzare in questo contesto dovrà presentare

una hazard function sempre decrescente; anche in tal caso, un modello appropriato potrebbe

essere quello di Weibull. Da quanto detto, si evince che se volessimo analizzare la durata di

permanenza nello stato di disoccupazione di un insieme di individui composto sia da giovani

neo-laureati che di persone con età compresa, diciamo, tra 45 e 55 anni dovremmo utilizzare,

necessariamente, un modello con hazard function crescente per tempi di attesa non molto

elevate e decrescente per tempi di attesa elevati; cioè siamo in una situazione di

contemporanea presenza di dipendenza positiva e negativa dalla durata. In questo caso non

possiamo proporre di descrivere la situazione reale, ad esempio, con il modello di Weibull ni

quanto la hazard function di tale modello non presenta la situazione descritta. Evidentemente,

modelli appropriati per descrivere una hazard function con forma UBT sono, ad esempio, il

modello di Burr XII e quello di Dagum.

Da quanto suddetto, si evince che la scelta del modello parametrico deve avvenire

sulla base sia di considerazioni di tipo qualitativo, derivanti dalla conoscenza del fenomeno da

analizzare, sia da valutazione empiriche, ad esempio, utilizzando i metodi non-parametrici

descritti in precedenza per avere una idea dell’andamento della hazard function.

Specificata la hazard function per mezzo dell’equivalenza matematica con la funzione

di densità descritta dalla (2.7) possiamo individuare il modello parametrico. Ad esempio, se

per un determinato fenomeno è noto, da informazioni empiriche e/o valutazioni qualitative,

che h(t;θ

θ ) ha un andamento sempre crescente (decrescente) allora o si specifica una hazard

function IFR (DFR) e, successivamente, tramite la (2.7) si individua la funzione di densità

della variabile casuale T, oppure si sceglie un modello parametrico che presenta una hazard

function IFR (DFR). E’ evidente che nel primo caso è necessario individuare una funzione

che soddisfi i vincoli sulla funzione h(t;θ

θ ) visti in precedenza (relazioni (2.6)) e,

contemporaneamente, deve soddisfare l’andamento della hazard osservato e/o ipotizzato;

così, ad esempio, se ipotizziamo una hazard function BT allora dobbiamo scegliere una

funzione che presenta un minimo per qualche valore di t, in modo tale che soddisfi le

condizioni richieste dalla h(t;θ

θ ). Nel secondo caso, è necessario conoscere a priori le

caratteristiche delle hazard function associati a diversi modelli. Così, ad esempio, se la hazard

function osservata e/o ipotizzata è UBT allora dobbiamo individuare quel modello

parametrico che presenta una hazard function UBT.

2.5

Eterogeneità Osservata

L’ipotesi di omogeneità delle osservazioni nella realtà raramente può essere mantenuta

(a meno che non si è in un contesto di studi sperimentali in cui è possibile controllare tutte le

condizioni sub-sperimentali e, quindi, confrontare items omogenei); negli studi osservazionali

i soggetti in esame differiscono, oltre che per la durata (ad esempio, della permanenza nello

stato di disoccupazione), per tutto un insieme di caratteristiche osserevabili e/o nonosservabili che influenzano la durata stessa della permanenza nello stato. Si pensi, ad

esempio, alle differenze esistenti, relativamente alla durata di permanenza nello stato di

disoccupazione, tra donne ed uomini, tra individui con livelli di istruzione diversi, tra

individui appartenenti ad aree geografiche differenti, ecc.. Tali caratteristiche specifiche di

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

194

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

ogni individuo sono osservabili e quantificabili, e possono essere introdotte nei modelli

parametrici con relativa semplicità; tuttavia, gli individui differiscono tra di loro anche per

altre specifiche caratteristiche che non sono osservabili di cui in qualche modo bisogna tenere

conto. Nel primo caso, si parla di eterogeneità osservabile, nel secondo di eterogeneità non

osservabile. In questa sezione descriviamo le proposte metodologiche presenti in letteratura

che incorporano nei modelli parametrici visti in precedenza la eterogeneità osservata. Nella

sezione successiva descriviamo le tecniche ed i metodi statistici per tenere conto della

eterogeneità non osservata.

Constatato che la durata può essere influenzata da un insieme di altre variabili

(chiamate covariate o regressori o variabili esogene), è necessario esprimere la durata T

condizionatamente all’insieme delle p covariate scelte per ogni individuo, indicate con il

vettore x = ( x 1 ,..., x p ) . In altri termini, si ipotizza che le differenze sistematiche

(eterogeneità) presenti nella popolazione possano essere spiegate tramite un insieme di

covariate osservabili.

Per evidenziare tale condizionamento le funzioni di densità, ripartizione,

sopravvivenza e la hazard function verranno indicate, rispettivamente, nel seguente modo:

f ( t / x; ã) , F( t / x; ã) , S( t / x; ã ) e h ( t / x; ã) .

E’ importante osservare che nel vettore delle covariate x, possono coesistere sia

variabili di tipo quantitativo - in tal cosa il loro trattamento è analogo al caso del modelli di

regressione multipla – che variabili di tipo qualitativo. In quest’ultimo caso le diverse

categorie della variabile qualitativa, diciamo A, devono essere codificate con delle variabili

dummy. Così, ad esempio, se la variabile qualitativa A presenta J categorie, allora si

utilizzeranno J-1 variabili binarie del tipo

1 se la j - esima categoria è presente

x Aj =

0 altrimenti

j=1,…,J-1. In tal modo, x Aj fornisce la presenza o meno della j-esima categoria. La

categoria J-esima, in tal caso, ha la funzione di categoria di riferimento (anche se la scelta è

del tutto arbitraria). Ciò significa che la J-esima categoria è implicitamente codificata

0 se j = 1,...., J - 1

x AJ =

. In termini di interpretazione, la categoria di riferimento in modo

1 altrimenti

tale da facilitare il confronto con le altre, in quanto i coefficienti β j fornisco la “distanza” tra

la categoria j-esima e quella di riferimento (Blossfeld et al. (1989), pag.48).

Ad esempio, negli studi sulla sopravvivenza delle aziende, si possono riscontrare delle

differenze sistematiche nella distribuzione della durata tra aziende appartenenti a settori

produttivi diversi, ad aree geografiche diverse, a regimi legislativi diversi ecc.. Nella durata

del periodo di disoccupazione le differenze sistematiche sono da imputate all’età, al sesso,

all’area geografica di residenza, alla tipologia di lavoro, al livello di istruzione ecc. Negli

esempio riportati sono state evidenziate alcune covariate che rendono la popolazione in analisi

come composta da sotto-popolazioni (strati) ognuna delle quali identificata dal valore che

assume la covariata d’interesse.

In ciò che segue l’obiettivo principale sarà quello di modellare l’influenza di un

insieme di covariate x sulla durata di permanenza nello stato, indicata dalla variabile casuale

T, oppure direttamente sulla probabilità istantanea di lasciare lo stato di disoccupato (cioè

sulla hazard function). Seguendo la letteratura, l’influenza di x sulla durata può essere

specificata assumendo che le covariate abbiano un effetto moltiplicativo sulla hazard function

[Proportional Hazard Model, PHM, proposto da Cox (1972)] oppure ipotizzando un effetto

moltiplicativo direttamente sulla variabile casuale T (Accelerated Failure Time Model,

AFTM).

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

195

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

Proportional Hazard Model

L’idea su cui si basano tali modelli è che individui diversi abbiano fra di loro hazard

function proporzionale. In altri termini, per due individui (o aziende), caratterizzati dalle

h( t / x1 ; ã)

covariate x1 e x2 , se il rapporto

non dipende da t allora il modello sottostante è un

h ( t / x 2 ; ã)

PHM. Nella sua versione generale un PHM presenta la seguente hazard function:

h ( t / x; ã) = h 0 ( t; è ) × g( x; â )

(2.17)

con γ =(θ

θ ,β

β ), dove h 0 ( t ; è ) viene denominata baseline hazard function, rappresenta il

rischio istantaneo per gli individui per i quali g(x;β

β )=1 (spesso tale valore della funzione g(.,.)

si ottiene per x=0 ); la funzione g(x;β

β ) dipende dall’insieme delle covariate e da un vettore di

parametri sconosciuti ma non dipende da t. Tale funzione deve essere scelta in modo tale che

h ( t / x; ã) ≥ 0 .

Si evidenzia che i PHM assumono che le covariate hanno un effetto moltiplicativo

sulla hazard function. Un caso particolare della (2.17), molto utilizzato in letteratura per la sua

flessibilità, è il seguente

h ( t / x; ã ) = h 0 ( t ; è ) × exp{x' â}

(2.18)

p

ottenuto evidentemente ponendo g (x; â ) = exp{x' â} nella (2.18), dove x 'â = ∑ x j β j è

j =1

un predittore lineare nei coefficienti β . Si evidenzia che la scelta g (x; â ) = exp{x' â} garantisce

la non-negatività della hazard function per ogni x e β .

A partire dalla (2.17) possiamo determinare le altre funzioni di interesse nel caso di

popolazioni eterogenee; infatti, si dimostra che dalla (2.5) la funzione di sopravvivenza è data

da

t

S( t / x; ã) = exp − ∫ h (u / x; ã) du = [S 0 ( t ; è )]g ( x ;â )

0

(2.19)

t

dove S0 ( t ; θ) = exp − ∫ h 0 ( u; è ) du è la funzione di sopravvivenza di base per

0

l’individuo tale per cui g(x;β

β )=1. Dalla (2.19) è immediato verificare che nell’ambito dei

PHM le funzioni di sopravvivenza sono ordinate, cioè per due individui con covariate x1 e x2

si ha S( t / x1 ; ã ) ≤ S(t / x 2 ; ã ) oppure S( t / x1 ; ã ) ≥ S(t / x 2 ; ã ) per ogni t.

La funzione di densità di t dato x, utilizzando le relazione descritte in precedenza,

risulta essere

f ( t / x; ã) = g( x; â ) × h 0 ( t ; è ) × [S0 ( t ; è ) ]

g( x;â)

.

(2.20)

Accelerated Failure Time Model (AFTM)

Si è visto che nei PHM le covariate hanno un effetto moltiplicativo sulla hazard

function, ma non stabiliscono un legame diretto con la variabile T. Un effetto moltiplicativo

delle covariate direttamente sulla variabile T viene considerato nei modelli AFT, tale effetto

Dipartimento di Economia e Statistica, Università della Calabria, Arcavacata di Rende (CS)

196

Primo rapporto di ricerca sul sistema di monitoraggio del mercato del lavoro e di valutazione degli effetti occupazionali del POR Calabria

risulta particolarmente importante in quanto può essere interpretato come un cambio di scala

nella variabile T. In particolare, indicata con T0 la variabile casuale durata di permanenza

nello stato prima di effettuare la trasformazione di scala, l’AFTM prevede la seguente

trasformazione di T

T = k ( x; β) − 1 T0

dove k(.;.) è una funzione strettamente positiva per ogni x e per ogni β . E’ semplice

verificare che la hazard function corrispondente alla trasformazione effettuata è

[

]

h T ( t; x, γ ) = k ( x; β) × h T0 k ( x; β) −1 × t ; θ

dove h T0 (.;.) è la hazard function della durata prima della trasformazione di scala.

Diversi autori hanno evidenziato la necessità di modellare oltre che la scala anche la

forma della durata di permanenza nello stato di disoccupazione. Tale specificazione può

essere ottenuta da una

generalizzazione del modello AFT, effettuando la seguente

trasformazione della durata

ln( T) = µ ( x1 ; β1 ) + [g(x 2 ; β 2 )] ln( T0 ) .

−1

(2.21)

E’ evidente che la trasformazione effettuata ipotizza l’esistenza di un insieme di

covariate x1 che influenzano la locazione della variabile casuale logaritmo della durata (lnT)

e, quindi, esercitano una influenza sulla scala della variabile casuale durata (T); l’insieme

delle covariate x2 influenzano la scala del logaritmo della durata e, quindi, la forma della

durata. Le funzioni µ(.;.) e g(.;.) sono note mentre i parametri β 1 e β 2 sono parametri

sconosciuti da stimare.

Si evidenzia che dalla (2.21) le funzioni di sopravvivenza e di densità, rispettivamente,

sono:

g ( x ;ββ )

2 2

t

ST ( t / x; γ ) = ST0

/ θ

exp[ µ( x1 ; β 1 ]

g (x ;ββ )