I SEGNALI GAUSSIANI

1 - Variabili aleatorie normali o gaussiane.

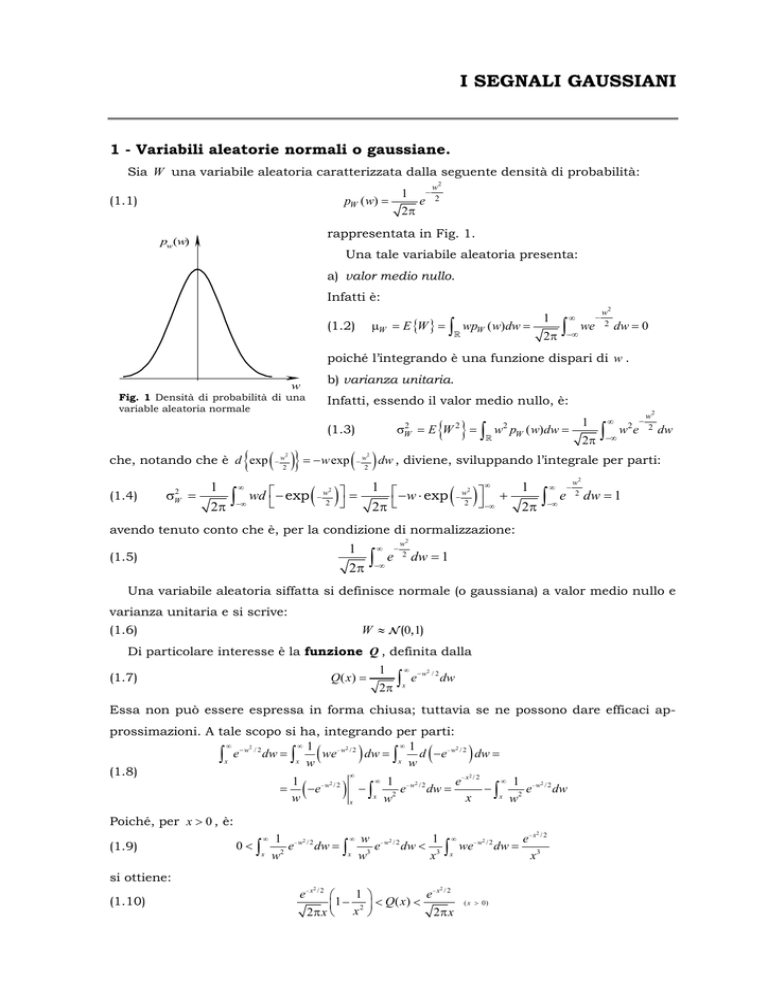

Sia W una variabile aleatoria caratterizzata dalla seguente densità di probabilità:

1

pW ( w) =

(1.1)

2π

e

−

w2

2

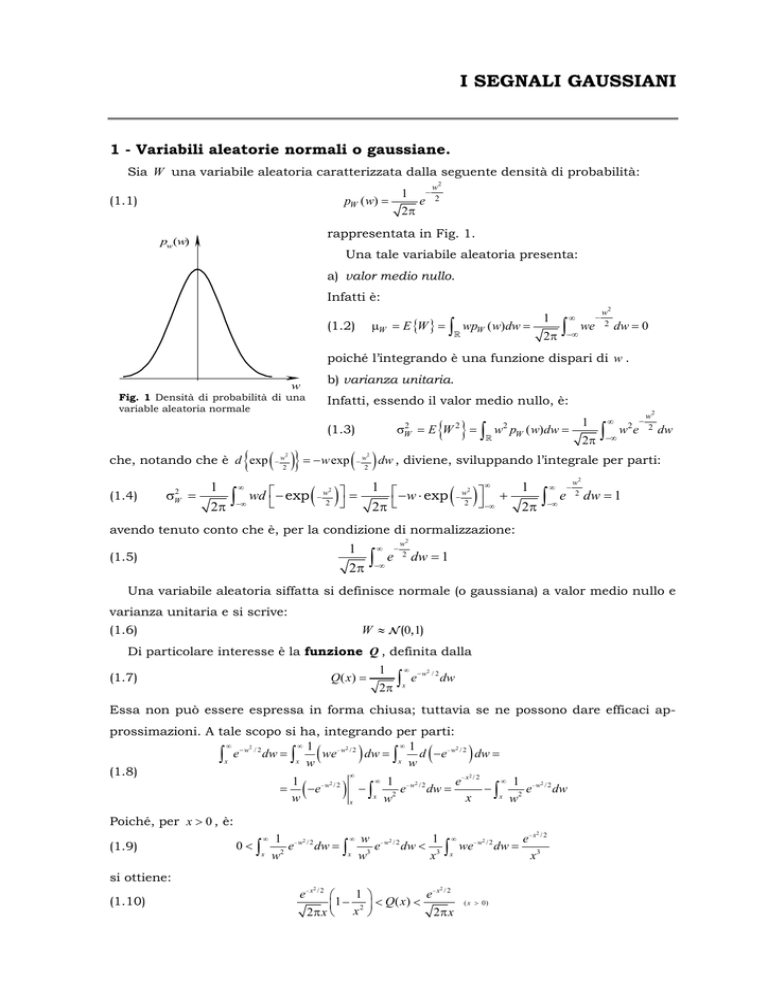

rappresentata in Fig. 1.

pw(w)

Una tale variabile aleatoria presenta:

a) valor medio nullo.

Infatti è:

μW = E {W } =

(1.2)

∫

1

wpW ( w)dw =

2π

∞

∫−∞ we

−

w2

2

dw = 0

poiché l’integrando è una funzione dispari di w .

b) varianza unitaria.

w

Fig. 1 Densità di probabilità di una

variable aleatoria normale

Infatti, essendo il valor medio nullo, è:

2

σW

(1.3)

σW2 =

1

w pW ( w)dw =

2

2π

∞

∫−∞ w e

2

−

w2

2

dw

{ ( )} = −w exp ( ) dw , diviene, sviluppando l’integrale per parti:

1

1 ⎡

1

wd ⎡ − exp ( ) ⎤ =

− w ⋅ exp ( ) ⎤ +

∫

∫ e dw = 1

⎣

⎦

⎣

⎦

2π

2π

2π

che, notando che è d exp

(1.4)

{ }=∫

=E W

2

−

w2

2

−

∞

−

−∞

w2

2

w2

2

−

w2

2

∞

∞

−∞

−∞

−

w2

2

avendo tenuto conto che è, per la condizione di normalizzazione:

1

2π

(1.5)

∫

∞

−∞

e

−

w2

2

dw = 1

Una variabile aleatoria siffatta si definisce normale (o gaussiana) a valor medio nullo e

varianza unitaria e si scrive:

W ≈ N (0,1)

(1.6)

Di particolare interesse è la funzione Q , definita dalla

Q( x) =

(1.7)

1

∫

2π

∞

x

e− w

2

/2

dw

Essa non può essere espressa in forma chiusa; tuttavia se ne possono dare efficaci approssimazioni. A tale scopo si ha, integrando per parti:

∞

∞ 1

∞ 1

− w2 / 2

− w2 / 2

− w2 / 2

∫x e dw = ∫x w we dw = ∫x w d −e dw =

(1.8)

2

∞

∞ 1

∞ 1

1

e− x / 2

2

2

2

=

−e − w / 2 − ∫ 2 e− w / 2 dw =

− ∫ 2 e− w / 2 dw

x w

x w

w

x

x

(

(

)

(

)

)

Poiché, per x > 0 , è:

(1.9)

0<∫

∞

x

∞ w

2

1 − w2 / 2

1

e

dw = ∫ 3 e − w / 2 dw < 3

2

x

w

w

x

∫

∞

x

2

we

− w2 / 2

si ottiene:

(1.10)

1 ⎞

e− x / 2

⎛

⎜1 − 2 ⎟ < Q( x) <

2π x ⎝ x ⎠

2π x

e− x

2 /2

2

( x > 0)

e− x / 2

dw = 3

x

-2-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

1

Nella Fig.2 sono riportati i diagrammi dei

Q( x)

limiti inferiore e superiore, forniti dalla (1.10),

2

1

unitamente a quello della funzione Q( x) .

10−1

2π

Sia X una variabile aleatoria definita dalla

−x / 2

x

X = aW + b

(1.11)

con a

e

(a ≠ 0)

e b costanti reali. Per determinare

10−2

la densità di probabilità di X , basta osservare

che

la

probabilità

che

all’intervallo I x ≡ ⎡⎣ x −

probabilità che W

I w ≡ ⎡⎣ w −

Δw

2

,w +

Δw

2

Δx

2

,x +

appartenga

X

Δx

2

2

1

10−3

⎤ è eguale alla

⎦

e

−x / 2

2π

x

⎛1 − 1 ⎞

⎝ x2 ⎠

appartenga all’intervallo

⎤ (v. Fig. 3). In altre parole si

⎦

0,5

1

1,5

2

x

3

Fig. 2 – Funzione Q(x) e suoi limiti.

deve avere:

p X ( x) Δx = pW ( w) Δw

(1.12)

X

dove si è tenuto conto del fatto che le probabilità

interessate sono quantità positive. La (1.12), essendo

w = x −a b , può essere riscritta come segue:

x

Δx

Δw

w

pX ( x) =

(1.13)

X = aW + b

W

Fig. 3 – Determinazione della

d.d.p. della v.a. X .

( )

x −b

a

pW

dx

dw

e cioè:

pX ( x) =

(1.14)

−

1

2πa

2

e

( x − b )2

2 a2

Dalla (1.11) si ricava il valore medio:

(1.15)

μ X = E { X } = aE {W } + b = b

e la varianza;

(1.16)

σ X2 = E {( X − μ X ) 2 } = E {( X − b) 2 } = E {(aW ) 2 } = a 2

per cui la (1.14) assume la forma:

(1.17)

pX ( x) =

−

1

2πσ

2

x

e

( x −μ x )2

2 σ 2x

che costituisce la più generale espressione delle densità di probabilità di una variabile

aleatoria gaussiana caratterizzata da un valor medio μ x e da una varianza σ 2x . Si scrive:

(1.18)

X ≈ N (μ x , σ 2X )

2 – Vettori aleatori a valori reali, normali o gaussiani.

Le considerazioni sopra esposte possono essere facilmente estese ai vettori aleatori.

Sia:

(2.1)

W = [W1 W2

Wn ]

T

un vettore aleatorio a valori reali, ad n dimensioni caratterizzato da una densità di probabilità congiunta delle sue componenti data dalla:

I segnali gaussiani

pW (w ) =

(2.2)

n

⎛

⎞

exp ⎜ − 12 ∑ wi2 ⎟ =

n

i =1

⎝

⎠

(2 π )

1

È facile verificare che le quantità Wi

- 3-

1

(2 π )

n

(

exp − 12 w T w

)

sono variabili aleatorie gaussiane, stati-

(i = 1, 2… n)

sticamente indipendenti, con valor medio nullo e varianza unitaria. Infatti, integrando la

(2.2) rispetto a tutte le W j (con j ≠ i ) si deduce la densità di probabilità del primo ordine

della variabile aleatoria Wi :

pWi (wi ) =

(2.3)

1

2π

e

−

wi2

2

n

∏∫

∞

1

−∞

j =1

( j ≠i )

e quindi:

(2π)( n −1)

{ }

E {wi } = 0 ; E wi2 = 1

(2.4)

e

−

w2j

2

dw j =

1

2π

e

−

wi2

2

i = 1, 2, … , n

In modo analogo, dalla (2.2), si ottiene la densità di probabilità congiunta delle variabili

aleatorie Wr e Ws :

pWrWs ( wr , ws ) =

(2.5)

1

2π

e

−

wr2

2

1

2π

e

−

ws2

2

= pWr (wr ) ⋅ pWs (ws )

dalla quale si deduce che le variabili aleatorie Wr e Ws sono statisticamente indipendenti. Ciò comporta:

⎧1

E {wr ws } = ⎨

⎩0

(2.6)

r = s

r ≠ s

Le (2.4) e (2.6) sono riassunte nelle:

E {W } = 0

(2.7)

{

; ΣW = E WW T

}

⎡1

⎢0

=⎢

⎢

⎢

⎣0

0

1

0

0⎤

0 ⎥⎥

=I

⎥

⎥

1⎦

Un vettore aleatorio di questo tipo è pertanto caratterizzato da un vettore dei valori medi

nullo e da una matrice di correlazione ΣW unitaria. Esso si dice normale (o gaussiano) e

si denota con:

W ≈ N (0, I )

(2.8)

Sia ora

X = AW + b

(2.9)

un vettore aleatorio a valori reali ottenuto da W per trasformazione affine la cui matrice

A , di dimensioni n × n , si suppone non singolare. Per dedurre la densità di probabilità

congiunta p X ( x ) delle componenti del vettore X in funzione della analoga densità pW (w )

delle componenti del vettore W , basta osservare che, detto Δx un elemento infinitesimo

dello spazio

(2.10)

n

, si deve avere:

p X ( x ) Δx = pW (w ) Δw

dove Δw denota l’elemento dello spazio

n

che porta a Δx per effetto della trasformazio-

ne (2.9). È noto dalla Geometria che è

(2.11)

Δx = det( J ) Δw

essendo J la matrice jacobiana della trasformazione, il cui generico elemento è definito

dalla J ij =

∂xi

. Si ha J = A . Pertanto, ricordando la (2.2) è:

∂w j

-4-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

pX ( x ) =

(2.12)

=

pW ⎡⎣ A−1 ( x − b)⎤⎦

=

det( A)

1

(2π) det( A)

n

1

(2π) det( A)

n

exp ⎡⎣ − 12 ( x − b)T ( AT )−1 A−1 ( x − b)⎤⎦ =

exp ⎡⎣ − 12 ( x − b )T ( AAT )−1 ( x − b)⎤⎦

Dalla (2.9), tenendo conto delle (2.7), si deducono le espressioni del vettore dei valori

medi e della matrice di covarianza del vettore aleatorio X .

(2.13)

{

μ X = E{X } = AE{W} + b = b

}

{

}

Σ X = E ( x − μ X )( x − μ X )T = E Aww T AT = AAT

(2.14)

e di conseguenza la (2.12) può essere riscritta nella forma:

1

(2.15)

pX (x ) =

exp − 12 ( x − μ X ) T (Σ X ) −1 (x − μ X )

n

(2π) det(Σ X )

[

]

essendo det(Σ X ) = det( AAT ) = det( A )det( AT ) = [det( A )] .

2

Generalizzando un vettore aleatorio è definito gaussiano quando la sua densità di probabilità congiunta è della forma espressa dalla (2.15) purché il determinante della matrice di covarianza è non negativo o, che è lo stesso, quando la matrice di covarianza è definita positiva. La statistica di un vettore gaussiano è completamente determinata se si conosce il vettore dei valori medi μ X e la matrice di covarianza Σ X . Poiché è:

(2.16)

{

}

{

}

{ }

Σ X = E ( x − μ X )( x − μ X )T = E xx T − xμTX − μ X x T + μ X μTX = E xx T − μ X μTX

tale statistica è anche definita dal vettore dei valori medi μ X e dalla matrice di correlazio-

{

}

ne RX = E ( xx T .

Si scrive:

X ≈

(2.17)

N (μ X , Σ X

)

Un’utile grandezza associata ad un vettore aleatorio X è la cosiddetta funzione caratteristica. Essa è definita dalla:

(2.18)

{ }=∫

FX (u) = E e ju

T

T

x

n

e ju x p X ( x ) d x

T

cioè come la media della funzione e ju x , essendo u un vettore ad n dimensioni.

La (2.18) può essere invertita per dare luogo alla:

T

1

(2.19)

pX ( x ) =

FX (u)e − ju x dx

n

(2π) n ∫

per cui la statistica di un vettore aleatorio può essere individuata o assegnando la densità di probabilità congiunta delle sue componenti o la funzione caratteristica di ordine n .

È possibile dimostrare (v. Appendice A) che la funzione caratteristica di un vettore

gaussiano si può esprimere nella forma:

(2.20)

FX (u) = exp ⎡⎣ juT μ X − 12 uT Σ X u ⎤⎦

3. - Proprietà dei vettori aleatori gaussiani.

I vettori aleatori gaussiani godono delle seguenti proprietà:

a) Ogni trasformazione lineare di un vettore gaussiano

(3.1)

Y = HX + h

I segnali gaussiani

in cui

X ≈

e Y

X

N (μ X , Σ X

- 5-

denotano due vettori di dimensioni n e m rispettivamente con

) e dove H è una matrice di dimensioni (m × n) e h un vettore non aleatorio

anch’esso di dimensioni m , conduce ad un vettore anch’esso gaussiano.

DIM. La funzione caratteristica del vettore Y vale

(3.2)

{ } = E {e

FY (u) = E e ju

T

y

juT ( Hx + h )

}=e

juT l

{

T

E e ju

Hx

}=e

juT l

{

E e j(H

T

u )T x

}=e

juT h

FX ( H T u)

Poiché X obbedisce ad una statistica di tipo gaussiano, la sua funzione caratteristica è

espressa dalla (2.20) che sostituita nella (3.2) conduce alla:

FY (u) = e ju h e

T

(3.3)

juT H μ X − 12 uT H Σ X H T u

=e

juT ( H μ X + h ) − 12 uT H Σ X H T u

Notando infine che dalla (3.1) si deducono: il vettore dei valori medi

(3.4)

μY = E {Y } = H μ X + h

e la matrice di covarianza

{

}

{

}

{

}

(3.5) ΣY = E ( y − μY )( y − μY )T = E H ( x − μ X )( x − μ X )T H T = HE ( x − μ X )( x − μ X )T H T = H Σ X H T

la (3.3) può essere riscritta come segue

(3.6)

FY (u) = exp ⎡⎣ juT μY − 12 uT ΣY u ⎤⎦

che confrontata con la (2.20) permette di concludere che il vettore Y è un vettore gaussiano caratterizzato dal vettore dei valori medi e dalla matrice di covarianza date dalle

(3.4) e (3.5) rispettivamente.

In particolare se si pone H = [ k1

k2

kn ] , e h = 0 , la proprietà di cui sopra assicura

che la combinazione lineare di un insieme di n variabili aleatorie congiuntamente gaussiane produce una variabile aleatoria anch’essa gaussiana.

b) Un qualunque sottovettore X k di dimensioni k estratto da un vettore aleatorio X

gaussiano è anche gaussiano.

DIM. Basti osservare che il vettore X k può essere ottenuto a mezzo di una trasformazione lineare del tipo X k = H k X . Ad esempio se da un vettore X tridimensionale si vuole

estrarre un vettore che contiene solo le prime due componenti, si deve porre

⎡1 0 0 ⎤

H3 = ⎢

⎥ e h = 0.

⎣0 1 0⎦

c) Se le componenti di un vettore aleatorio X gaussiano sono a due a due incorrelate,

esse sono anche statisticamente indipendenti.

DIM. La matrice di covarianza del vettore X vale:

⎡σ12 0

0⎤

⎢

⎥

2

0

0

σ

2

⎥

(3.7)

ΣX = ⎢

⎢

⎥

⎢

⎥

2

σ n ⎥⎦

⎢⎣ 0 0

per cui la funzione caratteristica è:

⎡ n

⎤

FX (u) = exp ⎡⎣ juT μ X − 12 uT Σ X u ⎤⎦ = exp ⎢ ∑ jui μ Xi − 12 σi2 ui2 ⎥ =

⎣ i =1

⎦

(

(3.8)

n

)

n

= ∏ exp ⎡⎣ jui μ Xi − 12 σi2 ui2 ⎤⎦ = ∏ FXi (ui )

i =1

i =1

essendo FXi (ui ) = exp ⎡⎣ jui μ Xi − σ u ⎤⎦ . La funzione caratteristica si fattorizza nel prodotto

1

2

2 2

i i

delle funzioni caratteristiche delle componenti del vettore e ciò comporta che la densità di

-6-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

probabilità congiunta delle componenti del vettore X è fattorizzata nel prodotto delle

densità di probabilità delle singole componenti.

4 – Vettori aleatori a valori complessi, normali o gaussiani.

Un vettore aleatorio di n dimensioni a valori complessi X = X R + jX I si dice normale o

gaussiano quando il vettore

⎡X ⎤

⎢ R⎥

⎢⎣ X I ⎥⎦

composto dalla parte reale e dal coefficiente della parte

immaginaria del vettore X costituisce un vettore gaussiano e pertanto definito da una

densità di probabilità di ordine 2n come quella data dalla (2.15). Ciò comporta che, per

caratterizzare un vettore gaussiano a valori complessi è necessario conoscere il vettore

dei valori medi

⎡ E { X R }⎤

μ=⎢

⎥

⎣⎢ E { X I } ⎦⎥

(4.1)

e la matrice di correlazione:

(4.2)

{

{

⎡ E X R X RT

⎪⎫

X IT ⎤⎦ ⎬ = ⎢

T

⎭⎪ ⎢⎣ E X I X R

⎧⎪ ⎡ X ⎤ ⎡ X ⎤T ⎫⎪

⎪⎧ ⎡ X ⎤

R = E ⎨ ⎢ R ⎥ ⎢ R ⎥ ⎬ = E ⎨ ⎢ R ⎥ ⎡⎣ X RT

⎪⎩ ⎣ X I ⎦ ⎣ X I ⎦ ⎪⎭

⎩⎪ ⎣ X I ⎦

}

}

{

{

}

}

E X R X IT ⎤ ⎡ R

⎥=⎢ R

T ⎥

RIR

E XI XI

⎦ ⎣

RRI ⎤

RI ⎦⎥

dove si sono denotate con RR , RI le matrici di correlazione associate ai vettori X R e X I

rispettivamente e con RRI e RIR le matrici di correlazione mutua fra X R e X I . Si noti che

T

è RRI = RIR

.

È da osservare che mentre per caratterizzare un vettore aleatorio gaussiano a valori

reali occorre conoscere il vettore dei valori medi e la matrice di correlazione, per la determinazione della statistica di un vettore aleatorio gaussiano a valori complessi non basta

conoscere, oltre il vettore dei valori medi, la sua matrice di correlazione; infatti

quest’ultima è:

(4.3)

{ } {

= E { X X + X X } + jE { X

}

{

}

RX = E XX H = E ( X R + jX I )( X R + jX I ) H = E ( X R + jX I )( X RT − jX IT ) =

R

T

R

I

T

I

I

X − XR X

T

R

T

I

} = (R

R

+ RI ) + j ( RIR − RRI )

Per definire completamente la statistica del vettore X occorre aggiungere un’ulteriore

condizione. Di norma è introdotta la cosiddetta matrice di pseudo correlazione definita

dalla:

(4.4)

{ } {

= E { X X − X X } + jE { X

}

{

}

RX = E XX T = E ( X R + jX I )( X R + jX I )T = E ( X R + jX I )( X RT + jX IT ) =

R

T

R

I

T

I

I

X + XR X

T

R

T

I

} = (R

R

− RI ) + j ( RIR + RRI )

Dalle (4.3) e (4.4) si deduce:

RR = 12 Re ⎡⎣ RX + RX ⎤⎦ , RI = 12 Re ⎡⎣ RX − RX ⎤⎦

(4.5)

RRI = 12 Im ⎡⎣ − RX + RX ⎤⎦ , RIR = 12 Im ⎡⎣ RX + RX ⎤⎦

Una particolare classe di vettori aleatori gaussiani a valori complessi è costituita dai

cosiddetti vettori gaussiani propri. Essi sono definiti dalla condizione:

(4.6)

RX = 0

che comporta:

(4.7)

RR = RI

RIR = − RRI

I segnali gaussiani

- 7-

T

È da notare che, poiché è RRI = RIR

, dalla seconda delle (4.7) si ha:

T

RRI = − RRI

(4.8)

e cioè le parti reali e i coefficienti delle parti immaginarie X R e X I di un vettore gaussiano proprio hanno identiche matrici di correlazione e la matrice di correlazione incrociata

è antisimmetrica e, in particolare, la diagonale principale è costituita da valori tutti nulli.

Per determinare la statistica di un vettore gaussiano proprio occorre quindi conoscere

il vettore dei valori medi μ X e la sola matrice di correlazione RX .

Un’ulteriore particolare classe di vettori gaussiani è costituita dai vettori che godono

della cosiddetta proprietà di simmetria circolare. Un vettore gaussiano X è circolarmente simmetrico (o a simmetria circolare) se per ogni ϑ ∈ [ 0, 2π ) la statistica di X è la stessa di quella di e jϑ X . Devono perciò coincidere il vettore dei valori medi e le funzioni di

correlazione e di pseudo correlazione. Basta, in particolare, che risulti, per ogni ϑ :

{

}

E e jϑ X

)( e

E e jϑ X = e jϑ E { X } = E { X }

(4.9)

e

{(

(4.10)

Le (4.9) e (4.10) comportano:

(4.11)

jϑ

XT

)} = e

j 2ϑ

RX = RX

E {X} = 0

e

RX = 0

(4.12)

È opportuno osservare che un vettore gaussiano proprio a valor medio nullo è circolarmente simmetrico e ciò si esprime scrivendo:

(4.13)

X ≈ CN ( 0, Σ X )

5 – Segnali gaussiani.

Un segnale aleatorio s (t, ζ ) , a valore reale, si dice normale o gaussiano se l’insieme

dei suoi campioni presi in corrispondenza ad una generica n -upla d’istanti t1, t2 , …, tn ,

costituisce un vettore aleatorio gaussiano. In altri termini se, detto x = [ x1

x2

xn ]

T

risulta:

(5.1)

ps1 , s2 …, sn ( x ) =

1

( 2π )

n

dove μ s = [ ms (t1 ), ms (t2 ), …, ms (tn ) ]

T

Σs

exp ⎡⎣ − 12 ( x − μ s )T Σ −s 1 ( x − μ s ) ⎤⎦

∀n ∈

, ∀ (t1 , t 2 , … , t n ) ∈

n

è un vettore la cui i -esima componente è pari al valore

medio ms (t ) = E {s (t , ζ )} del segnale nell’istante ti , e il generico elemento della matrice Σ s

(5.2)

{

{

}}

σ s (ti , t j ) = E ⎡⎣ s (ti , ζ ) − E {s (ti , ζ )}⎤⎦ ⎡ s (t j , ζ ) − E s (t j , ζ ) ⎤

⎣

⎦

è la covarianza delle variabili aleatorie individuate dal segnale agli istanti ti e t j .

Ci si rende facilmente conto del fatto che un segnale gaussiano stazionario in senso

lato lo è anche in senso stretto. Infatti, se il segnale è stazionario in senso lato, almeno

fino al secondo ordine, gli elementi della sua matrice di covarianza dipendono soltanto

dalle differenze tra gli istanti di tempo ti e t j e il valore medio del segnale è indipendente

dal tempo, quindi tale è anche il vettore μ s che compare nella sua densità di probabilità.

-8-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

La statistica del segnale è allora invariante rispetto a qualsiasi traslazione dell’origine dei

tempi.

Poiché dalla (5.2) discende:

(5.3)

σ s (ti , t j ) = Rs (ti , t j ) − E {s (ti , ζ )} E s (t j , ζ ) = Rs (ti , t j ) − ms (ti )ms (t j )

{

}

la funzione di covarianza può essere espressa in termini della funzione di autocorrelazione e del valore medio; la statistica di un segnale gaussiano, quindi, risulta perfettamente

nota se si conosce il valore medio e la funzione di autocorrelazione.

Un segnale s( t, ζ) a valore complesso

s (t , ζ ) = sR (t , ζ ) + jsI (t , ζ )

(5.4)

si dirà gaussiano se un qualsiasi insieme di campioni presi sulla parte reale e sulla parte

immaginaria costituisce un vettore di variabili aleatorie congiuntamente gaussiane. Questo significa che per caratterizzare la statistica del segnale s (t , ζ ) occorre definire i valori

medi delle parti reali ed immaginarie

(5.5)

e le funzioni di correlazione:

μ R (t ) = E {sR (t , ζ )}

μ I (t ) = E {sI (t , ζ )}

{

}

R (t , t ) = E {s (t , ζ ) s (t , ζ )}

R (t , t ) = E {s (t , ζ ) s (t , ζ )}

R (t , t ) = E {s (t , ζ ) s (t , ζ )} = R

RR (ti , t j ) = E sR (ti , ζ ) sR (t j , ζ )

(5.6)

I

i

j

I

i

RI

i

j

R

IR

i

j

I

I

i

i

j

I

j

R

j

RI

(t j , ti )

Se i valori medi, definiti dalle (5.5) non dipendono dal tempo e le funzioni di autocorrelazione, date dalle (5.6) dipendono dalla differenza fra gli istanti ti e t j , il segnale s(t , ζ ) è

stazionario in senso stretto poiché la sua statistica è invariante rispetto a qualsiasi traslazione dell’origine dei tempi.

È interessante osservare che la conoscenza della funzione di correlazione data dalla:

R (ti , t j ) = E s* (ti , ζ ) s(t j , ζ ) =

{

(5.7)

{

}

}

= E [ sR (ti , ζ ) − jsI (ti , ζ ) ] ⎡⎣ sR (t j , ζ ) + jsI (t j , ζ ) ⎤⎦ =

= ⎡⎣ RR (ti , t j ) + RI (ti , t j ) ⎤⎦ + j ⎡⎣ RRI (ti , t j ) − RIR (ti , t j ) ⎤⎦

non consente di definire completamente le funzioni RR (ti , t j ) , RI (ti , t j ) e RRI (ti , t j ) che intervengono nella definizione della statistica del segnale. Per definire quindi la statistica di

un segnale gaussiano a valori complessi occorre, analogamente a quanto proposto a proposito del vettore aleatorio gaussiano a valori complessi, introdurre la cosiddetta funzione

di pseudo correlazione definita dalla:

R (ti , t j ) = E s(ti , ζ ) s (t j , ζ ) =

{

(5.8)

{

}

}

= E [ sR (ti , ζ ) + jsI (ti , ζ ) ] ⎡⎣ sR (t j , ζ ) + jsI (t j , ζ ) ⎤⎦ =

= ⎡⎣ RR (ti , t j ) − RI (ti , t j ) ⎤⎦ + j ⎡⎣ RRI (ti , t j ) + RIR (ti , t j ) ⎤⎦

Dalle (5.7) e (5.8) si deduce facilmente:

I segnali gaussiani

- 9-

RR (ti , t j ) = 2! Re ⎡⎣ R (ti , t j ) + R (ti , t j ) ⎤⎦

RI (ti , t j ) = 2! Re ⎡⎣ R (ti , t j ) − R (ti , t j ) ⎤⎦

(5.9)

RRI (ti , t j ) = 12 Im ⎡⎣ R (ti , t j ) + R (ti , t j ) ⎤⎦

RIR (ti , t j ) = 12 Im ⎡⎣ − R (ti , t j ) + R (ti , t j ) ⎤⎦

Una classe particolarmente interessante di segnali gaussiani a valori complessi è costituita dai cosiddetti segnali gaussiani propri. Essi sono caratterizzati dalla condizione

che, per ogni valore di ti e t j , si ha:

R (ti , t j ) = 0

(5.10)

per cui risulta:

RR (ti , t j ) = RI (ti , t j ) = 2! Re ⎡⎣ R(ti , t j ) ⎤⎦

(5.11)

RRI (ti , t j ) = 12 Im ⎡⎣ R(ti , t j ) ⎤⎦ = − RIR (ti , t j )

La statistica di un segnale gaussiano proprio pertanto è completamente determinata se si

conosce la sua funzione di autocorrelazione.

È da osservare che dalla seconda delle (5.11) si deduce che è RRI (t , t ) = RIR (t , t ) = 0 . Le

parti reali ed immaginarie di un segnale gaussiano proprio sono incorrelate in ti = t j = t .

Come nel caso di vettore aleatorio a valori complessi gaussiano a simmetria circolare,

un segnale gaussiano si dice circolarmente simmetrico (o a simmetria circolare) se

per ogni valore di ϑ ∈ [ 0, 2π ) la statistica del segnale s(t, ζ ) è uguale a quella di e jϑ s(t, ζ ) .

Ciò comporta che, per ogni ϑ , si deve avere:

{

}

E e jϑ s(t, ζ ) = e jϑ E {s(t, ζ )} = E {s(t, ζ )}

(5.12)

e questo comporta E {s(t, ζ )} = 0 . Inoltre, sempre per ogni ϑ , basta che si abbia:

(5.13)

{

}

{

}

{

}

E ⎡⎣ e jϑ s(ti , ζ )⎤⎦ ⎡⎣ e jϑ s(t j , ζ )⎤⎦ = e 2 jϑ E s(ti , ζ )s(t j , ζ ) = E s(ti , ζ )s(t j , ζ )

e questo comporta

(5.14)

R(ti , t j ) = 0

Un segnale gaussiano proprio a valor medio nullo è a simmetria circolare.

6 - Trasformazioni lineari di segnali gaussiani.

Sia y (t , ζ ) un segnale aleatorio dipendente dal segnale x(t , ζ ) mediante una trasformazione lineare del tipo:

(6.1)

∞

y (t , ζ ) = ∫ h(t , τ) x(τ, ζ )d τ

−∞

in cui h(t , τ) denota una funzione peso dipendente dalle variabili t e τ .

Dividendo il dominio d’integrazione nella (6.1) in intervalli disgiunti di ampiezza Δ ,

l’integrale può essere calcolato mediante la:

(6.2)

N

y (t , ζ ) = lim Δ ∑ h(t , iΔ ) x(iΔ, ζ )

N →∞

Δ→ 0

Valutando la precedente in t = jΔ , con j ∈

(6.3)

i =− N

, si ha:

N

y ( j Δ, ζ ) = lim Δ ∑ h( j Δ, iΔ ) x(iΔ, ζ )

N →∞

Δ→ 0

i =− N

j∈

-10-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

L’argomento del limite nella (6.3) può essere interpretato per fissati N e Δ come la

N

∑ h( j Δ, iΔ) x(iΔ, ζ )

componente j -esima y j =

di un vettore aleatorio Y ottenuto dal pro-

i =− N

dotto tra una matrice H il cui generico elemento è Δ ⋅ h( j Δ, iΔ ) e un 2N + 1 vettore aleatorio gaussiano la cui i -esima componente vale x (iΔ, ζ ) . Y è pertanto, indipendentemente

dai valori di N e Δ , un vettore aleatorio gaussiano e tale resta passando al limite per

N → ∞ e Δ → 0 . Quindi y( t, ζ) è un segnale gaussiano, la sua densità di probabilità, a

qualunque ordine, dipende soltanto dal valor medio e dalla funzione di autocorrelazione.

Dalla (6.1), prendendo il valore medio statistico di ambo i membri, si ha, con ovvio significato dei simboli:

∞

∞

−∞

−∞

my (t ) = E { y (t , ζ )} = ∫ h(t , τ) E { x(τ, ζ )} d τ = ∫ h(t , τ)mx (τ)d τ

(6.4)

La funzione di autocovarianza vale:

σ y (t1 , t2 ) = E

=E

(6.5)

=∫

{( y(t , ζ) − m (t ) )( y(t , ζ) − m (t ) )} =

{∫

∫

=∫ ∫

y

2

2

}

∞

−∞

∞

−∞ −∞

∞

1

h(t1 , τ1 ) ( x(τ1 , ζ ) − mx (τ1 ) ) d τ1 ∫ h(t2 , τ2 ) ( x(τ2 , ζ ) − mx (τ2 ) ) d τ 2 =

−∞

∞

y

1

∞

∞

−∞ −∞

E {[ x(τ1 , ζ ) − mx (τ1 )][ x(τ2 , ζ ) − mx (τ2 ) ]} h(t1 , τ1 )h(t2 , τ2 )d τ1d τ 2 =

σ x (τ1 , τ2 )h(t1 , τ1 )h(t2 , τ2 )d τ1d τ 2

avendo denotato con σ x (t1, t2 ) la funzione di autocovarianza di x(t,ζ ) .

Sia a(ζ ) una variabile aleatoria dedotta da un segnale x (t, ζ ) gaussiano mediante una

trasformazione lineare della forma:

∞

a(ζ ) = ∫ h(τ) x(τ, ζ )d τ

(6.6)

−∞

essendo h(τ) una funzione peso. Procedendo come prima e cioè dividendo il dominio

d’integrazione nella (6.6) in intervalli disgiunti di ampiezza Δ , l’integrale può essere calcolato mediante la:

N

a(ζ ) = lim Δ ∑ h(iΔ ) x(iΔ, ζ )

(6.7)

N →∞

Δ→ 0

i =− N

Per fissati N e Δ fissati è immediato riconoscere che la quantità a(ζ ) , in quanto combinazione lineare di quantità congiuntamente gaussiane, è una variabile aleatoria gaussiana la cui densità di probabilità del primo ordine dipende dal valor medio e dalla funzione

di autocorrelazione.

Dalla (6.6), prendendo il valore medio statistico di ambo i membri, si ha, con ovvio significato dei simboli:

e:

{

σ 2a = E ( a (ζ ) − μ a )

(6.9)

∞

∞

−∞

−∞

μ a = E {a (ζ )} = ∫ h(τ) E { x(t , ζ )} d τ = ∫ h(τ)mx (τ)d τ

(6.8)

=E

=∫

{∫

∞

∞

−∞

∫

=∫ ∫

∞

−∞ −∞

∞

∞

−∞ −∞

2

}=

∞

}

h(τ1 ) ( x(τ1 , ζ ) − mx (τ1 ) ) d τ1 ∫ h(τ2 ) ( x(τ2 , ζ ) − mx (τ2 ) ) d τ2 =

−∞

E {[ x(τ1 , ζ ) − mx (τ1 ) ][ x(τ2 , ζ ) − mx (τ2 ) ]} h(τ1 )h(τ2 )d τ1d τ2 =

σ x (τ1 , τ2 )h(τ1 )h(τ2 )d τ1d τ2

I segnali gaussiani

- 11-

APPENDICE

FUNZIONE CARATTERISTICA

DI UN VETTORE ALEATORIO GAUSSIANO

1 – Premessa.

La funzione caratteristica associata ad un vettore aleatorio gaussiano di n dimensioni

X si ottiene dal seguente integrale:

FX (u) = ∫ n e ju x p X ( x )dx

T

(1)

in cui

1

pX ( x) =

(2)

(2π) det(Σ )

n

exp ⎡⎣ − 12 x T Σ −1 x ⎤⎦

L’integrale (1) diventa:

FX (u) =

(3)

1

(2π) det(Σ )

n

∫

n

exp ⎡⎣ juT x − 12 ( x − μ )T Σ −1 ( x − μ ) ⎤⎦ dx

Introducendo la trasformazione x − μ → x si ottiene:

T

FX (u) =

(4)

e ju

μX

(2π) det(Σ )

n

∫

n

exp ⎡⎣ juT x − 12 x T Σ −1 x ⎤⎦ dx

Per risolvere l’integrale (4) è conveniente ricorrere all’ortogonalizzazione della matrice

di covarianza.

2 – Ortogonalizzazione della matrice di covarianza.

Sia

{λi }i =1

n

l’insieme degli autovalori (supposti distinti) della matrice di covarianza Σ .

Se u( i ) denota il corrispondente autovettore (supposto normalizzato) si ha:

Σu ( i ) = λ i u ( i )

(5)

Si definisca con T la matrice composta da tutti gli autovettori e cioè

⎡ ⎡u1(1) ⎤ ⎡u1(2) ⎤

⎡u1( n ) ⎤ ⎤

⎢ ⎢ (1) ⎥ ⎢ (2) ⎥

⎢ (n) ⎥ ⎥

u2 ⎥ ⎢u2 ⎥

(1)

(2)

(n)

⎢

⎢

⎢u2 ⎥ ⎥

T = ⎡⎣ u

u

u ⎤⎦ =

(6)

⎢⎢ ⎥ ⎢

⎥

⎢

⎥⎥

⎢ ⎢ (1) ⎥ ⎢ (2) ⎥

⎢ (n) ⎥ ⎥

⎢⎣un ⎥⎦ ⎦⎥

⎣⎢ ⎣⎢un ⎦⎥ ⎣⎢un ⎦⎥

Sia ha:

ΣT = ⎡⎣ Σu(1)

(7)

⎡ ⎡ λ1u1(1) ⎤

⎢ ⎢ (1) ⎥

λu

= ⎢⎢ 1 2 ⎥

⎢⎢

⎥

⎢ ⎢ (1) ⎥

⎢⎣ ⎢⎣ λ1un ⎥⎦

⎡ ⎡u1(1) ⎤

⎢ ⎢ (1) ⎥

u

= ⎢⎢ 2 ⎥

⎢⎢ ⎥

⎢ ⎢ (1) ⎥

⎣⎢ ⎢⎣un ⎦⎥

e cioè:

Σu(2)

⎡λ 2 u1(2) ⎤

⎢

(2) ⎥

⎢ λ 2 u2 ⎥

⎢

⎥

⎢

⎥

(2)

⎢⎣λ 2 un ⎥⎦

⎡u1(2) ⎤

⎢ (2) ⎥

⎢u2 ⎥

⎢

⎥

⎢ (2) ⎥

⎢⎣un ⎥⎦

Σu( n ) ⎤⎦ = ⎡⎣ λ1u(1)

λ n u( n ) ⎤⎦ =

λ 2 u(2)

⎡λ n u1( n ) ⎤ ⎤

⎢

( n) ⎥ ⎥

⎢ λ n u2 ⎥ ⎥

⎢

⎥⎥

⎢

⎥⎥

( n)

⎢⎣λ n un ⎥⎦ ⎥⎦

⎡u1( n ) ⎤ ⎤ ⎡ λ1

⎢ (n) ⎥ ⎥ ⎢

⎢u2 ⎥ ⎥ ⎢ 0

⎢

⎥⎥ ⎢

⎢ (n) ⎥ ⎥ ⎢

⎢⎣un ⎥⎦ ⎦⎥ ⎣ 0

0

λ2

0

0⎤

0 ⎥⎥

=

⎥

⎥

λn ⎦

-12-

G. Mamola: Lezioni di Complementi di Comunicazioni Elettriche

ΣT = T diag(λ1 , λ 2 ,

(8)

dove diag(λ1 , λ 2 ,

, λn

, λ n ) rappresenta la matrice diagonale

⎡ λ1

⎢0

, λn ) = ⎢

⎢

⎢

⎣0

diag(λ1 , λ 2 ,

(9)

0⎤

0 ⎥⎥

⎥

⎥

λn ⎦

0

λ2

0

Dalla (8) si deduce, premoltiplicando per T −1 :

T −1ΣT = diag(λ1 , λ 2 ,

(10)

, λn )

Prendendo la trasposta della precedente si ha:

(11)

T T ΣT (T −1 )T = [ diag(λ1 , λ 2 ,

, λ n ) ] = diag(λ1 , λ 2 ,

T

, λ n ) = T −1 Σ T

dove si è tenuto conto della (10). Osservando che la matrice di correlazione è simmetrica

( Σ = ΣT ), dalla precedente si deduce premoltiplicando per T e postmoltiplicando per T T :

TT T Σ (T −1 )T T T = TT −1ΣTT T

(12)

da cui:

(TT T )Σ = Σ(TT T )

(13)

e cioè la matrice di covarianza commuta con la matrice TT T . Questo comporta che la matrice TT T deve essere proporzionale alla matrice unitaria di ordine n . Ma poiché gli autovettori si sono supposti normalizzati e cioè tali che si abbia:

⎧1 i = j

(14)

u ( i ) u ( j )T = ⎨

⎩0 i ≠ j

la matrice TT T coincide con la matrice unitaria e quindi

T −1 = T T

(15)

La matrice T è pertanto una matrice ortogonale ed è caratterizzata dal fatto che il suo

determinante vale ±1 . La (10) in questo caso diventa:

T T ΣT = diag(λ1 , λ 2 ,

(16)

, λn )

Dalla predente, tenendo conto della (15), si ricava:

(17)

(T T ΣT ) −1 = T T Σ −1T = [ diag(λ1 , λ 2 ,

⎛1 1

−1

, λ n ) ] = diag ⎜ , ,

⎝ λ1 λ 2

,

1 ⎞

⎟

λn ⎠

3 - Trasformazione di variabili

Introducendo la seguente trasformazione di variabili:

x = Ty

(18)

l’argomento dell’esponenziale che interviene nell’espressione della funzione integranda

che compare nella (4), tenendo conto della (17), diventa:

(19)

⎛1 1

juT x − 12 x T Σ −1 x = juT Ty − 12 yT T T Σ −1Ty = jv T y − 12 yT diag ⎜ , ,

⎝ λ1 λ 2

1

λn

dove si è posto:

v T = uT T

(20)

4 - Funzione caratteristica

Con la posizione (18) la (4) si scrive:

T

(21)

FX (u) =

e ju

μX

(2π) det(Σ )

n

∫

n

⎡

⎛ 1 1

exp ⎢ jv T y − 12 yT diag ⎜ , ,

⎢⎣

⎝ λ1 λ 2

1 ⎞ ⎤

⎟ y ⎥ dy

λ n ⎠ ⎥⎦

⎞

⎟y

⎠

I segnali gaussiani

- 13-

poiché lo jacobiano della trasformazione (18) è unitario.

Si ottiene infine:

T

FX (u) =

(22)

e ju

∞

(2π) det(Σ )

n

T

=

μX

e ju

μX

−∞ −∞

⎡ n ⎛

y2

exp ⎢ ∑ ⎜ jvi yi − 12 i

−∞

λ1

⎢⎣ i =1 ⎝

∫

∞

⎞⎤

⎟ ⎥ dy1dy2

⎠ ⎥⎦

⎡

y2 ⎤

exp ⎢ jvi yi − 12 i ⎥ dyi

−∞

λ1 ⎦

⎣

n

(2π) n det(Σ )

∞

∫ ∫

∏∫

i =1

∞

È facile riconoscere che si ha:

(23)

∞

⎡

⎡ v2 ⎤

y2 ⎤

2π

exp ⎢ − 12 i ⎥

I i = ∫ exp ⎢ jvi yi − 12 i ⎥ dyi =

−∞

λ1 ⎦

λi

⎣

⎣ λ1 ⎦

Per cui risulta:

T

FX (u) =

(24)

e ju

(2π) n det(Σ )

n

∏

i =1

⎡ v2 ⎤

2π

exp ⎢ − 12 i ⎥ =

λi

⎣ λ1 ⎦

n

⎡

v2 ⎤

exp ⎢ − 12 ∑ i ⎥ =

i =1 λ i ⎦

⎣

T

μX

= e ju

T

μX

exp ⎡ − 12 v T [ diag(λ1 , λ 2 ,

⎣

= e ju

μX

exp ⎣⎡ uT Σ − !u ⎦⎤

= e ju

T

Si ha pertanto:

(25)

μX

λ n )] v ⎤ =

⎦

FX (u) = exp ⎡⎣ juT μ X + uT Σ − !u ⎤⎦

−1

dyn =