“Caos”, Monica Castaldelli

Filippo Risi IV G 1\8

Entropia

Etimologia e origine del termine

Il concetto di entropia venne introdotto agli inizi del XIX secolo, nell'ambito della termodinamica,

per descrivere una caratteristica (la cui estrema generalità venne osservata per la prima volta da

Sadi Carnot nel 1824) di tutti i sistemi allora conosciuti nei quali si osservava che le trasformazioni

avvenivano invariabilmente in una direzione sola, ovvero quella verso il maggior disordine.

La parola entropia venne introdotta per la prima volta dal fisico tedesco Rudolf Julius Emanuel

Clausius (1822-1888) nel suo Abhandlungen über die mechanische Wärmetheorie (Trattato sulla

teoria meccanica del calore), pubblicato nel 1864. In tedesco, Entropie, deriva dal greco εν,

"dentro", e da τροπή, "cambiamento", "punto di svolta", "rivolgimento" (sul modello di Energie,

"energia"). Il termine entropia fu usato con la seguente motivazione:

“Possiamo dire che S [l'entropia] indica il contenuto di trasformazione del corpo, così come diciamo che U [l'energia

interna] è il contenuto di calore e lavoro del corpo stesso. Tuttavia, poiché sono dell'opinione che i nomi di quantità di

questo tipo – che sono così importanti per la scienza – debbano essere derivati dai linguaggi antichi, propongo di

chiamare la grandezza S con il nome di entropia del corpo, partendo dalla parola greca tropè che significa

trasformazione. Intenzionalmente ho formato il termine entropia in modo da renderlo il più possibile simile al termine

energia: infatti entrambe queste quantità sono così strettamente connesse l'una all'altra dal punto di vista del

significato fisico, che mi pare utile una certa analogia anche nei loro nomi."

Entropia nella termodinamica

In termodinamica l’entropia si configura come una funzione di stato legata al II Principio. Viene

detta funzione di stato una quantità fisica dipendente solo dalle condizioni in cui si trova in sistema.

Esempi di funzioni di stato sono la pressione, la temperatura, il volume, l’entalpia e l’energia

interna.

Su scala macroscopica essa fu definita per la prima volta nel 1865 da Clausius. Considerando una

trasformazione infinitesima reversibile (e quindi ideale) tra due stati di equilibrio, detto ∆Q il calore

assorbito o ceduto dal sistema durante un infinitesimo intervallo del processo, T la temperatura del

sistema in questo intervallo (che consideriamo costante in un intervallo infinitesimo), la variazione

di entropia ∆S è uguale a:

Quando il calore è assorbito dal sistema ∆Q è positivo, e l’entropia aumenta, quando invece il

calore è ceduto al sistema, ∆Q è negativo e quindi l’entropia diminuisce.

E’ importante notare come tale equazione non definisca l’entropia del sistema, ma la variazione di

entropia dello stesso. Nelle considerazioni termodinamiche, infatti, l’entropia viene sempre definita

partendo da un riferimento arbitrario che si ammette uguale a zero; ciò equivale all’introduzione di

una costante incognita che scompare qualora si prendano in considerazione differenze di entropia,

ma non permette di conoscere il valore assoluto dell’entropia di uno stato. Questa difficoltà venne

superata dal teorema di Nerst (noto anche come III Principio della Termodinamica) che ammette

l’esistenza di uno stato in cui l’entropia ha effettivamente valore nullo. Quest’ultimo si può quindi

assumere come riferimento assoluto, e, per un sistema isolato, è quello la cui temperatura coincide

con lo zero assoluto. Temperatura non raggiungibile per limiti teorici.

Trasformazioni termodinamiche reversibili e irreversibili e calcolo

dell’entropia

Le trasformazioni reversibili sono quelle che avvengono in un tempo al limite infinito e in cui non

sono presenti effetti dissipativi (attrito, anelasticità, ecc). Una trasformazione reversibile, pertanto,

si svolge in maniera tale per cui, alla fine, sia il sistema che l’ambiente circostante possono essere

Filippo Risi IV G 2\8

riportati ciascuno nel proprio stato iniziale, senza che nell’universo resti alcuna traccia. Tutto ciò

che avviene in un senso durante una trasformazione reversibile, accade nel senso opposto se si

cambia il verso di percorrenza della trasformazione. Così, ad esempio, se il sistema durante una

trasformazione reversibile assorbe calore da un altro corpo, invertendo la trasformazione restituisce

a quel corpo la stessa quantità di calore che gli aveva sottratto. Nelle trasformazioni reversibili non

esistono effetti dissipativi per definizione. In natura, tuttavia, è impossibile una totale assenza di

effetti dissipativi. Questi, semmai, possono essere ridotti considerando piccole trasformazioni, in

sistemi in cui le coordinate termodinamiche cambiano molto lentamente sono stati ridotti al

massimo gli attriti.

Un tuffo in acqua è un tipico esempio di fenomeno meccanico non reversibile. Nessuno ha mai

visto un nuotatore uscire dalla piscina con un balzo e giungere sui blocchi di partenza asciutto

e pettinato come era prima dello slancio in acqua.

E' abbastanza facile calcolare le variazioni di entropia nelle trasformazioni reversibili. Si può

calcolare, ad esempio, la variazione di entropia durante la fusione reversibile di un cubetto di

ghiaccio a contatto con una sorgente di calore che si trova alla stessa temperatura (273 K) del

cubetto. Se la trasformazione è reversibile deve essere possibile invertire il processo aumentando o

diminuendo leggermente la temperatura della sorgente. In questo caso la variazione totale di

entropia del sistema isolato, cubetto più sorgente di calore, è uguale a zero.

Le trasformazioni irreversibili,al contrario, avvengono in un tempo finito e presentano effetti

dissipativi. Esse sono caratterizzate non tanto dal fatto che il sistema non possa essere ricondotto

allo stato iniziale, ma dal fatto che ciò non può avvenire senza che nell’ambiente circostante ne

rimanga traccia. Un tipico esempio di trasformazione irreversibile è l’espansione libera di un gas.

Durante un’ espansione libera (cioè non contrastata da nessuna forza esterna), il gas non compie

lavoro sull’ambiente, mentre per riportare il gas al suo stato iniziale, l’ambiente deve compiere

lavoro sul gas, che non tornerebbe mai ad occupare spontaneamente il volume di partenza. In una

trasformazione irreversibile la "traccia" che rimane nell’ ambiente è l’energia che si è dovuta

spendere per riportare il gas al suo stato iniziale.

Un esplosione è un fenomeno chimico-fisico evidentemente non reversibile

Per calcolare le variazioni di entropia nelle trasformazioni irreversibili, dobbiamo in generale,

utilizzare la proprietà dell'entropia di essere una funzione di stato e calcolare la variazione di

entropia in una trasformazione reversibile opportuna che colleghi gli stessi stati (iniziale e finale).

Ad esempio possiamo calcolare la variazione di entropia nell'espansione libera adiabatica di un gas

sostituendo all'espansione adiabatica (irreversibile) un'espansione isoterma (reversibile), che operi

tra gli stessi stati, iniziale e finale. Il risultato che si ottiene in questo caso è un aumento

dell'entropia totale del sistema. E' importante le trasformazioni reali irreversibili, e le

Filippo Risi IV G 3\8

trasformazioni reversibili utilizzate solamente per poter calcolare la variazione di entropia. Si

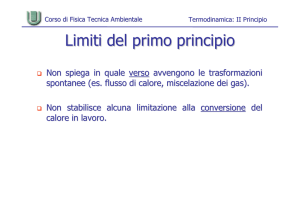

giunge così all'enunciazione del secondo principio come generalizzazione degli esempi presentati:

nelle trasformazioni reali, irreversibili, l'entropia totale, sistema + ambiente, aumenta sempre.

Il termine entropia in altri contesti

Il concetto di entropia ha conosciuto grandissima popolarità nell'800 e nel '900, grazie proprio alla

grande quantità di fenomeni che aiuta a descrivere, fino ad uscire dall'ambito prettamente fisico ed

essere adottato anche dalle scienze sociali, nella teoria dei segnali e nell'informatica teorica. È

tuttavia bene notare che esiste tutta una classe di fenomeni, detti fenomeni non lineari (ad esempio i

fenomeni caotici) per i quali le leggi della termodinamica (e quindi anche l'entropia) devono essere

profondamente riviste e non hanno più validità generale.

Entropia nella teoria dell'informazione

Nella teoria dell'informazione - e in rapporto alla teoria

dei segnali - l'entropia misura la quantità di incertezza o

informazione presente in un segnale aleatorio (un

fenomeno aleatorio è un fenomeno non deterministico) .

Da un altro punto di vista l'entropia è la minima

complessità descrittiva di una variabile aleatoria, ovvero il

limite inferiore della compressione dei dati. La

connessione con l'entropia termodinamica sta nel rapporto

di compressione: al diminuire della temperatura

corrisponde la riduzione della ridondanza del segnale, e

quindi l'aumento della compressione. L'entropia

dell'informazione raggiunge un minimo che, in generale è

diverso da zero, al contrario dell'entropia termodinamica

(vedi terzo principio della termodinamica). Si deve a Claude Shannon lo studio dell'entropia nella

teoria dell'informazione, il suo primo lavoro sull'argomento si trova nell'articolo “Una teoria

matematica della comunicazione” del 1948. Nel primo teorema di Shannon, o teorema di Shannon

sulla codifica di sorgente, egli dimostrò che una sorgente casuale d'informazione non può essere

rappresentata con un numero di bit inferiore alla sua entropia, cioè alla sua autoinformazione media.

Dalla definizione statistica dell'entropia si intuisce che l'informazione e questa grandezza

termodinamica siano in qualche modo correlati.

L'entropia nel contesto dello sviluppo economico e sociale

Per il secondo principio della termodinamica un sistema in entropia è un sistema in cui,

progressivamente e naturalmente, si crea una perdita di energia, in assenza di apporto esterno

positivo, tale da generare il caos. Seguendo questa immagine, l'economia aziendale ha fatto propria

questa rappresentazione, intendendola applicabile ad un sistema aziendale che, senza un governo

efficiente, tende inesorabilmente al caos ed alla disorganizzazione. Limitare l'entropia quindi,

significa influenzare positivamente l'organizzazione aziendale nell'attuare il processo decisionale.

Decidere, quindi fornire energia al sistema-azienda, significa aumentare il livello di coesione

all'interno dell'organizzazione e quindi le situazioni di conflitto tendono a diminuire, ristabilendo

l'ordine. Entropia genera disorganizzazione, quindi maggiori costi e sforzi per ottenere minori

risultati, in pratica una perdita di potenza dell'intero sistema, proprio come nella realtà della fisica

termodinamica.

La difficoltà di combattere l'entropia in azienda dipende dal livello di caos accumulato. Un sistema

poco sotto controllo è soggetto a deteriorarsi, ma un sistema senza alcun controllo può avere già in

sé ingenerati fattori esplosivi che lo collassano, rendendo difficoltoso e faticoso riportarlo

nell'ordine.

Filippo Risi IV G 4\8

Entropia e tempo

Quotidianamente assistiamo a infiniti esempi della trasformazione dell'ordine in disordine e mai

assistiamo a uno spontaneo processo opposto. Vediamo la luce di una lampada diffondersi in una

stanza, animali ed alberi nascere crescere morire ma non abbiamo mai visto il suo contrario, né

nessuno risorgere, decrescere ed entrare nel grembo materno. Sembrerebbe dunque esistere una

direzione del tempo univocamente orientata dal tempo passato al tempo che deve venire. Una

freccia, la freccia del tempo, sembra attraversare i fenomeni e la materia che ci sta attorno.

Eppure né la meccanica classica, né la relativistica, né la quantistica distinguono tra un passato e un

futuro.

Il secondo principio della termodinamica riconosce però una freccia del tempo: l'entropia aumenta

con l'avanzare del tempo.

La termodinamica è la scienza che dà ragione al senso comune, alla percezione?

Una nuova disciplina, la meccanica statistica, dà una risposta che consente di superare la

contraddizione tra i risultati definiti fenomenologici della termodinamica e i risultati, definiti

fondamentali della meccanica.

Nulla vieta che tra i miliardi e miliardi di casi in cui si possono venire a disporre i frammenti di un

vetro infranto si possa verificare lo stato in cui essi si trovino ricomposti a costituire l'ordine

iniziale. Solo che la situazione di ordine è meno probabile del disordine.

Tuttavia il problema della freccia del tempo resta tuttora aperto, né è scontata per tutti la tendenza

indicata dall'entropia.

Qualcuno ritiene che la forza di gravità contrasta un'omogenea distribuzione dell'energia: il flusso di

energia delle stelle tiene lontano dall'equilibrio intere regioni dell'universo e tra queste la nostra, che

procede in controtendenza, com'è dimostrato da quell'elevato grado di ordine e informazione che ha

reso possibile la nascita della vita.

Altri vorrebbero elevare al rango di leggi fondamentali i principi della termodinamica e vedere la

freccia del tempo e l'entropia iscritte nell'origine stessa dell'universo, alcuni ponendola come

fenomeno iniziale e quindi con tendenza decrescente, altri crescente. Tuttora il dibattito è

quantomai aperto.

Filippo Risi IV G 5\8

Entropia nell’astrofisica – L’universo e i buchi neri

L’universo

Assumendo che l'intero universo sia un sistema isolato - ovvero un sistema per il quale è

impossibile scambiare materia ed energia con l'esterno - il primo ed il secondo principio della

termodinamica possono essere riassunti da un'unica frase:

“l'energia totale dell'universo è costante e l'entropia totale è in continuo aumento”

valida per qualsiasi sistema isolato. In altre parole ciò significa che non solo non si può né creare né

distruggere l'energia, ma nemmeno la si può completamente trasformare da una forma in un'altra

senza che una parte venga dissipata sotto forma di calore. Ogni volta che una certa quantità di

energia viene convertita da uno stato ad un altro si ha una penalizzazione che consiste nella

degradazione di una parte dell'energia stessa in forma di calore, in particolare questa parte non sarà

più utilizzabile per produrre lavoro. Lo stato in cui l'entropia raggiunge il massimo livello e non vi

è più energia libera disponibile per compiere ulteriore lavoro è detto stato di equilibrio. La

seconda legge della termodinamica è quindi - per certi versi - una sorta di verdetto di condanna a

morte per il nostro universo. Un sistema termodinamico tenderà allo stato di equilibrio, cioè quello

di massima entropia e per l'intero universo, concepito come sistema isolato, ciò significa che la

progressiva conversione di lavoro in calore (per il principio di aumento dell'entropia totale), a fronte

di una massa dell'universo finita, porterà ad uno stato in cui l'intero universo si troverà in condizioni

di temperatura uniforme; la cosiddetta morte termica dell'Universo (o morte entropica), nel quale

non c'è energia libera per creare e sostenere lavoro o la vita.

Curiosità: i buchi neri e l’entropia

La teoria quantistica dei buchi neri sembra condurre a un nuovo livello di imprevedibilità in fisica,

oltre all'indeterminazione abitualmente associata alla meccanica quantistica. Ciò si deve al fatto che

i buchi neri sembrano avere un entropia intrinseca e perdere informazioni dalla nostra regione

dell'universo. Secondo la teoria della relatività generale di Einstein i buchi neri sono oggetti

semplici in quanto caratterizzati da tre soli

parametri: la massa, la carica e il momento

angolare. In tutti i processi fisici che

possiamo immaginare (collisione di buchi

neri, estrazione di energia da buchi neri

rotanti) le leggi che regolano la variazione

di questi parametri mostrano una

sorprendente analogia con le leggi della

termodinamica. In particolare, l'area

dell'orizzonte degli eventi - la superficie di

non ritorno, al di là della quale il campo

gravitazionale è talmente intenso che

neanche la luce è capace di riemergere non può mai diminuire, e in questo senso si

comporta esattamente come l'entropia di un

sistema termodinamico.

Perché l'analogia termodinamica sia completa, però, oltre che identificare l'entropia con l'area

dell'orizzonte degli eventi bisognerebbe anche assegnare al buco nero una temperatura, in evidente

contrasto con la definizione stessa di buco nero, visto che non potendo emettere nulla, il buco nero

ha, formalmente, temperatura zero. Fu Stephen Hawking nel '74 a mostrare, utilizzando le leggi

della meccanica quantistica, che in realtà il buco nero non è nero, ma sorprendentemente emette

Filippo Risi IV G 6\8

particelle sotto forma di radiazione termica a una temperatura ben determinata, la cosiddetta

temperatura di Hawkin. Questo effetto inizialmente è molto piccolo, ma diventa sempre più grande

col passare del tempo.

Conclusione: Entropia e l’uomo (il mistero della vita..)

Dal principio di aumento di entropia dell’Universo possiamo ricavare anche la nozione dello

scorrere del tempo. L’evoluzione dell’Universo, infatti, è una conseguenza dell’irreversibilità che

caratterizza intrinsecamente tutte le trasformazioni naturali, cioè spontanee. Un fiammifero che

brucia, un gas che si espande liberamente, una goccia di inchiostro che si diffonde in acqua, sono

tutti fenomeni che ci fanno capire come l’evoluzione di un sistema avvenga di solito in un verso ben

preciso: il fatto che un sistema isolato possa evolvere soltanto verso stati caratterizzati da una

maggiore entropia implica l’esistenza di una sequenza temporale degli eventi, una sequenza che può

dare significato alle parole “passato” e “futuro”, che ci fa distinguere ciò che precede da ciò che

segue. Un sistema complesso, cioè formato da molti costituenti, lasciato a se stesso tende ad

evolvere dall’ordine verso il disordine. E poiché non avviene mai il contrario (o meglio esiste una

probabilità incredibilmente piccola che avvenga il contrario), possiamo definire il passaggio

dall’ordine al disordine un processo irreversibile. Il disordine è lo stato verso cui ogni sistema

evolve spontaneamente. Tuttavia, in apparente contraddizione con tale affermazione (che potrebbe

essere benissimo l’ennesimo enunciato del II Principio della Termodinamica) l’esperienza

quotidiana ci offre sempre esempi di sistemi che

evolvono verso stati di ordine maggiore: la

pioggia che si tramuta in neve quando la

temperatura scende al di sotto di una certa soglia,

o le molecole di acqua che si dispongono in

maniera molto ordinata formando cristalli di

ghiaccio. L'entropia cui l'universo inteso nel suo

insieme - sistema chiuso - andrebbe incontro non

esclude la possibilità di sistemi locali aperti che

possano aumentare il loro grado di ordine a spese

dell'universo, come nel caso della Terra che

trasformando il costante flusso di energia solare

ha potuto aumentare il suo grado di ordine e di

informazione per originare la più “sconvolgente

contraddizione della termodinamica dell'universo”: la nascita della vita. L’esempio più

significativo ed emblematico, è l’uomo stesso, così come qualsiasi essere vivente: la struttura con la

quale si organizzano le molecole in un essere vivente per farlo nascere e per mantenerlo in vita è

una struttura fortemente ordinata, ed è incredibile che materia inanimata possa diventare cellule,

organi, strutture complesse. Si ha un passaggio spontaneo dal disordine all’ ordine: nel sistema

"essere vivente", cioè, l’entropia può diminuire! In realtà tutto ciò non viola il II Principio della

Termodinamica: non è l’entropia dell’Universo a diminuire, ma solo quella del sistema chiuso

"essere vivente", quindi la variazione di entropia interna diminuisce nella creazione di strutture

biologiche ma tale variazione è ampiamente compensata da un aumento dell'entropia esterna alla

struttura biologica. Si devono considerare, infatti, il lavoro compiuto da un essere vivente, il calore

scambiato con l’esterno; insomma, tutte le interazioni che esso ha con l’ambiente che lo circonda.

Resta straordinario, comunque, il fatto che all’interno del sistema chiuso "essere vivente" l’entropia

diminuisca "spontaneamente", non per un calcolo studiato nei dettagli e meticolosamente

perseguito, ma "per natura". Erwin Schroedinger afferma che "gli esseri viventi possono

sopravvivere soltanto se si nutrono di entropia negativa, traendola dall’ ambiente circostante". Egli,

tuttavia, si muove ancora in ambito termodinamico, in quanto considera l’entropia e l’informazione

come attributi oggettivi del sistema. Non bisogna dimenticare, infatti, che i sistemi complessi (gli

Filippo Risi IV G 7\8

orologi chimici, gli esseri viventi, ecc) hanno in comune il fatto di produrre essi stessi le proprie

caratteristiche spazio-temporali, ossia di presentare livelli di auto-organizzazione che non sono

riconducibili al livello dei costituenti microscopici. La stessa comparsa della vita, forse, potrebbe

essere considerata come una inspiegabile "inversione di entropia": da una materia "disordinata" si è

sviluppato qualcosa di incredibilmente complesso. Sembra come un’eccezione alla regola, ma come

disse il musicista Frank Zappa: “Without deviation from the norm, progress is not possibile”, solo

discostandosi dalla “normalità”, ci può essere il progresso, un’evoluzione. Chissà se in futuro sarà

possibile spiegare dettagliatamente le modalità attraverso le quali tutto ciò è avvenuto, o resterà un

mistero il perché.....

“La nostra esistenza è un segreto che sta nel breve attimo in cui l’occhio si apre al mondo e si

chiude sull’eternità (Romano Battaglia)”

Filippo Risi IV G

Filippo Risi IV G 8\8