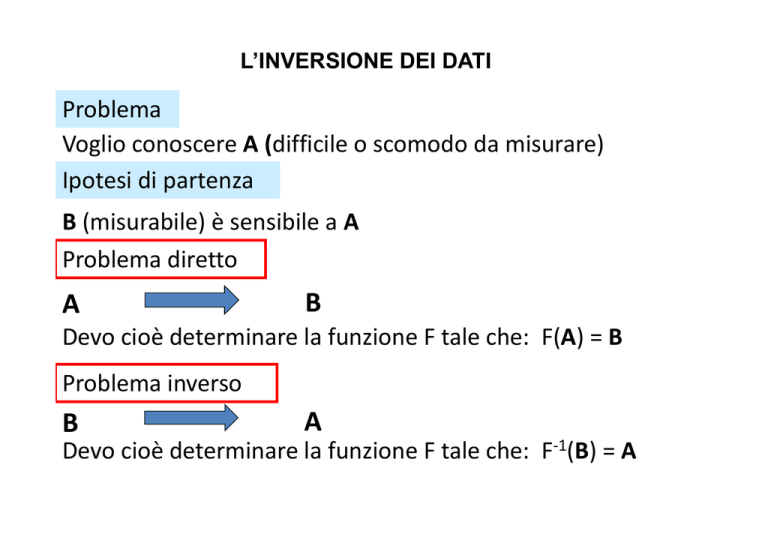

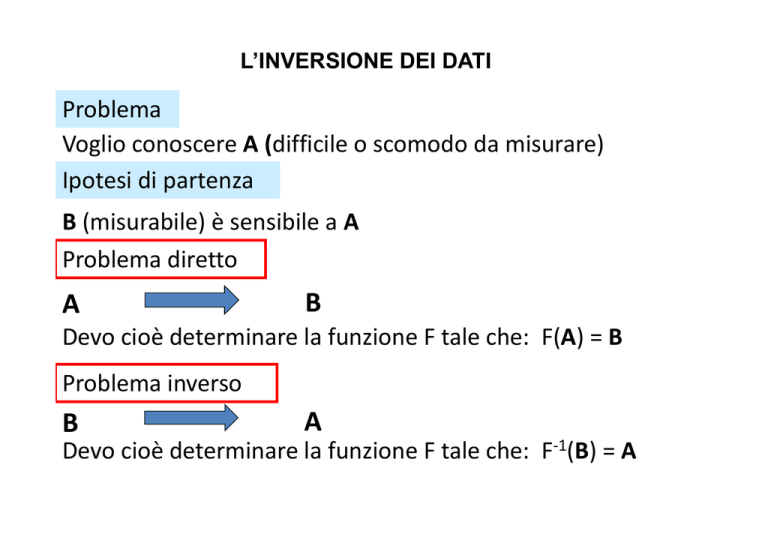

L’INVERSIONE DEI DATI

Problema

Voglio conoscere A (difficile o scomodo da misurare)

Voglio conoscere A (difficile o scomodo da misurare)

Ipotesi di partenza

B (misurabile) è sensibile a A

Problema diretto A

B

D

Devo cioè determinare la funzione F tale che: F(A) = B

i èd t

i

l f i

F t l h F(A) B

Problema inverso B

A

Devo cioè determinare la funzione F tale che: F

Devo

cioè determinare la funzione F tale che: F‐1(B) (B) = A

A

IL PROBLEMA DELL’INVERSIONE

Un sistema di telerilevamento misura le quantità

elettromagnetiche che quantificano l’attitudine

l attitudine del mezzo a

riflettere, emettere o assorbire

Tali quantità sono funzioni dei parametri che rivestono interesse

applicativo, i cui valori vanno determinati a partire dalle quantità

elettromagnetiche primarie mediante un’inversione dei dati

σ°

variabile

Problema:

P

bl

σ°° è iinfluenzata

fl

t d

da variabili

i bili diff

differenti

ti (e

( spesso

indipendenti) simultaneamente (è difficile separare gli effetti delle

singole variabili).

variabili)

APPROCCI PER L’INVERSIONE DEI DATI

Empirico-statistico

Nell’approccio

Nell

approccio empirico

empirico-statistico

statistico vengono effettuati

contemporaneamente misure in sito e di telerilevamento; si

stabiliscono poi le relazioni empiriche, generalmente a partire da

regressioni statistiche, che consentano di passare dai dati rilevati

ai parametri del mezzo

Teorico modellistico

Nell’approccio teorico si procede a determinare il legame tra

parametri e dati mediante modelli di simulazione,

simulazione che possono

costituire la base dell’inversione delle misure

Ibrido

Utilizzo il modello di simulazione per generare/integrare i dati

necessari p

per individuare le relazioni statistiche

DUE TIPOLOGIE DI PROBLEMI DI INVERSIONE

Problema di stima di parametro

La quantità da determinare è un numero reale che esprime il

valore quantitativo del parametro bio-geofisico di interesse. Il

parametro può essere a più componenti e quindi in questo

caso occorre determinare una quantità vettoriale

Problema di classificazione

Occorre associare alla misura effettuata una tra più classe

predeterminate. Rientrano in questa tipologia i problemi di

detection (per es. change detection)

STIMA DI PARAMETRO: APPROCCIO MODELLISTICO

[Astim]

Modello fisico

(risolve il pb. diretto)

[Bteo]

‐

Astim al passo 0 è determinato dalle

informazioni a priori (statistica del problema)

[Bmis]

Termino quando la differenza tra Bteo e Bmis non cambia

più continuando le iterazioni

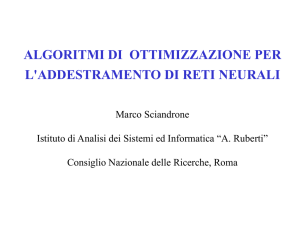

INTRODUZIONE RETI NEURALI

¾ Il cervello umano è un calcolatore

complesso, non lineare e parallelo

¾ I suoii elementi

l

ti di elaborazione,

l b

i

i

neuroni, sono molto semplici

¾ Il cervello

ll è iin grado

d di modificare

difi

le connessioni tra i neuroni in base

all’esperienza

all

esperienza acquisita

acquisita, cioè è in

grado di imparare

¾ Nel cervello non esiste un controllo centralizzato.

centralizzato Il cervello è

fault tolerant, cioè se un neurone o una delle sue connessioni

sono danneggiati, il cervello continua a funzionare, anche se con

prestazioni leggermente degradate

Negli anni 40 nell’area

nell area di Boston (MIT

(MIT, Harward) nasce

l’idea di provare a simulare il comportamento del

cervello

IL NEURONE

Funzione Gradino F ( Y ) =

Funzione Gradino: F

)

0

{ 1 Y >

0 Y ≤0

0 Y 0

Threshold

X

1

θ

W1

X

2

W2

Wn

X

Σ

‐

F(Y)

F ( Y )

Y

Activation function

n

Una rete formata da tali unità è, con la scelta degli opportuni

coefficienti in linea di principio capace di rappresentare qualsiasi

coefficienti,

funzione logica

IL MULTI-LAYER PERCEPTRON

OFF

ON

IL MULTI-LAYER PERCEPTRON

Osserviamo che una rete di questo tipo è adatta per un tipico

problema di classificazione. A sinistra (strato di ingresso) entrano

le quantità misurate

misurate, a destra (strato di uscita) abbiamo i valori da

stimare della variabile (n-dimensionale)

Quando il mapping desiderato è complesso e prevede la

presenza di diverse unità neuronali trovare i coefficienti

moltiplicativi delle connessioni non è banale

Principio della regola di addestramento: presentare degli esempi

alla rete e modificare i pesi delle connessioni per ottenere un

miglioramento del risultato, così da avvicinarsi alle uscite

desiderate

CONCETTO DI SUPERVISIONE

XOR NETWORK

INPUT

HIDDEN

1

Input 1

Input 2

Output

0

0

0

1

1

0

0

1

1

1

0

1

1

-11

OUTPUT

-11

1

1

THRESHOLD = .01

NEURAL NETWORKS EVOLUTION

Rosenblatt

R

bl tt shows

h

(

(perceptron

t

convergence procedure)

d ) how

h

it was

possible to train a net of neurons able to recognise a set of patterns

chosen beforehand.

Essence of the training rule: to present the net with examples and

change those connection weights which led to an improvement of the

results, so as to be closer to the desired values. The procedure did not,

however, indicate how to train hidden elements

(F. Rosenblatt, Principles of Neurodynamics, Spartan, 1962)

Minsky e Papert show Rosenblatt

Rosenblatt’ss procedure to be valid only for single

layer perceptrons. Big problem: there was a large class of problems,

even rather simple, that the single layer perceptron was not able to

solve.

l

A typical

t i l example

l was the

th exclusive

l i

OR

OR.

At this point the procedure able to train the internal connections

was missing: credit assignment problem (M.L. Minsky, S.A. Papert,

Perceptrons, MIT Press, 1969).

LA BACK-PROPAGATION

¾ Risolve la difficoltà dell’addestramento,

dell addestramento, soprattutto per quanto

riguarda i pesi dei neuroni interni. Infatti l’errore sull’uscita viene

retropropagato verso l’interno

¾ Si considera una rete con funzioni di attivazione differenziabili,

cosicché le funzioni di attivazione dell’uscita

dell uscita diventano funzioni

differenziabili sia delle variabili di ingresso che dei pesi e dei valori

di soglia.

¾ Le derivate possono essere utilizzate per trovare i valori dei

coefficienti che minimizzano la funzione errore

1

E =

2

∑

p

Noutput

∑

k =1

(y k

− tk

)2

LA BACK-PROPAGATION

¾ La back-propagation è un algoritmo iterativo dove all’inizio il

valore dei coefficienti è definito in modo casuale

¾ L’iterazione consiste nel presentare alla rete il set degli esempi

selezionati

l i

ti più

iù volte,

lt fifinché

hé l’l’errore ttotale

t l commesso d

dalla

ll rete

t è

inferiore a una certa soglia

¾ Ogni ciclo di ripetizione viene chiamato epoca di addestramento

Nel 1989 Hornik et al. dimostrano che il perceptron multistrato è in

grado di approssimare

g

pp

q

qualsiasi funzione continua a valori reali: le

reti perceptron multistrato costituiscono una classe di

approssimatori universali

VARI TIPI DI RETI NEURALI

Possiamo distinguere 3 elementi fondamentali di distinzione:

1. Topologia della rete:

Feedforward ricorsiva,

Feedforward,

ricorsiva completamente connessa

2. Caratteristiche del neurone:

Funzione di attivazione sigmoidale, a gradino, gaussiana

3. Regola di apprendimento:

Con supervisione

Senza supervisione

Scelta dell’input p

e dell’output

Generazione dei d ti di

dati di addestramento

Definizione della topologia

Rete Neurale

PROGETTAZIONE

Input Definizione dei coefficienti via ffi i ti i

addestramento

Pre‐

Elaborazione

Elaborazione Neurale

Post‐

Elaborazione

O t t

Output

MODALITÀ OPERATIVA REAL‐TIME

ASPETTI PROGETTUALI

SCELTA DELL’INPUT E DELL’OUTPUT

Identificare le migliori tra le informazioni disponibili da usare come

ingresso alla rete, per esempio quelle con più alto rapporto

segnale

g

rumore,, e definire precisamente

p

l’uscita della rete.

GENERAZIONE DATI DI ADDESTRAMENTO

Fornire alla rete un insieme di esempi statisticamente significativo

e rappresentativo dello scenario in cui andrò ad operare.

Nella modalità operativa la rete dovrà essere in grado di associare

a quello che gli viene presentato qualche esempio memorizzato

nella

ll ffase di addestramento

dd t

t

RETI NEURALI

RETI A MEMORIA ASSOCIATIVA

PROBLEMA: Riconoscimento automatico di un individuo

automatico di un individuo Generazione dai dati di Generazione

dai dati di

addestramento

DIMENSIONALITY ISSUES

Increasing

g the number of features should lead to an improvement

p

of the performance, but…..

if we are forced to a limited quantity of data, as we are in practice,

then increasing the dimensionality of the space rapidly leads to

the point where the data is very sparse, in which case it provides

a very poor representation of the mapping

The predictive power reduces as the dimensionality

i

increases,

also

l kknown as th

the Hughes

H h effect

ff t or Hughes

H h

phenomenon

Moreover:

¾ A network with fewer inputs has fewer adaptive parameters to

be determined, and these are more likely to be properly

constrained by a data set of limited size, leading to a network with

b tt generalization

better

li ti properties.

ti

¾ A network with fewer weights may be faster to train

Generate a statisticallyy significant

g

set of p

patterns

ALL PATTERNS

TEST

TRAINING

VALIDATION

The training subset include all the data belonging to the problem

domain and is used in the training phase to update the weights of

the network.

The test subset is used during the learning process to check the

network response for untrained data. The data used in the test

subset

b

should

h ld b

be di

distinct

i

ffrom those

h

used

d iin the

h training,

i i

h

however

they should lie within the training data boundaries. Based on the

performance of the ANN on the test subset

subset, the architecture may

be changed and/or more training cycles applied.

The validation subset should include examples different from

those in the other two subsets. This subset is used after selecting

the best network to further examine the network or confirm its

accuracy before being implemented in the neural system and/or

delivered to the end user

It is difficult to give specific mathematical rules for the determination of the

required sizes of the various data subsets For database partitioning a large

test subset may highlight the generalization capability better; however, the

remaining smaller training subset may not be adequate to train the network

satisfactorily Looney (1996) recommends 65% of the parent database to be

satisfactorily.

used for training, 25% for testing, and 10% for validation

POSSIBLE USE OF A FORWARD

(ELECTROMAGNETIC) MODEL

¾ Input and output are swapped

¾ Set suitable variability ranges for the input

(geophysical) parameters also checking crossconsistency

¾ Additional noise may be considered in the output

values

ASPETTI PROGETTUALI

Il resto della progettazione è soprattutto dedicato ad evitare il

problema dell’overfitting:

dell overfitting:

La rete funziona sull’insieme di addestramento ma non è in grado

di generalizzare correttamente su dati fuori da questo insieme.

Per non cadere in overfitting occorre:

¾ Non eccedere nel numero di epoche di addestramento

¾ Non eccedere nella complessità topologica, cioè nel

numero di unità di processamento (neuroni)

COME SI FA ??

ESEMPIO

PROBLEMA DI CLASSIFICAZIONE

y

x

RETRIEVAL PROBLEM

Underfitting

Overfitting

Correct fitting

g

SCELTA DEL TEMPO DI ADDESTRAMENTO: EARLY STOPPING

E

TEST

TRAINING

t

t’

We might say that we are in presence of a regulator

where the penalty function is represented by the error

function calculated over the validation set

NUMERO DI NEURONI OTTIMO

Tecniche per tentativi

Si provano numeri differenti di unità nascoste e si seleziona la

rete che dà l’errore minore sul test set

Tecniche di pruning

Si allena una rete inizialmente sovradimensionata. I pesi meno

importanti vengono eliminati

eliminati. La rete ottenuta viene poi

nuovamente riaddestrata

Tecniche di growing

Si p

parte con una rete sottodimensionata e man mano durante

l’addestramento vengono aggiunte nuove unità o strati

congelando i coefficienti determinati nelle fasi precedenti.

(Basheer and Hajmeerb, 2000)

Nella modalità operativa l’implementazione della rete neurale richiede

rete neurale richiede solo l’inserimento di p

poche righe di codice

g

Note

A linear regression may be seen as a very particular neural

networks

k with

i h no hidden

hidd layers

l

a11

x1

y1

a12

x2

a21

a22

a13

a23

x3

If the activation function are the Identity function

y1 =

1 a11 11 x1 +

1 + a12 12 x2 +

2 + a13 13 x3

y2 = a21 x1 + a22 x2 + a23 x3

y2

ULTERIORI CONSIDERAZIONI

¾ COSTRUISCONO LE REGOLE DI DECISIONE INTERNE

DIRETTAMENTE DAI DATI E NON NECESSITANO

ASSUNZIONI A-PRIORI

A PRIORI DI TIPO STATISTICO

¾

ATTENZIONE AL PROBLEMA DEI MINIMI SECONDARI

¾ NELLA FASE DI ADDESTRAMENTO POSSIBILI SINERGIE

TRA DATI SIMULATI E DATI SPERIMENTALI

¾

CAPACITÀ NEL DATA FUSION

CLASSIFICAZIONE DI IMMAGINI SATELLITARI

CLASSIFICAZIONE DI IMMAGINI SATELLITARI

Hard decision

0.75

0.12

0.10

0.08

Possibilità di unmixing

1

0

0

0

CLASSIFICAZIONE DI IMMAGINI SATELLITARI

CLASSIFICAZIONE DI IMMAGINI SATELLITARI

La scelta dell’insieme di addestramento