RECUPERO

AMBIENTALE

Tecnologie, bioremediation e biotecnologie

Professore di Biologia marina ed Ecologia applicata

Istituto di Scienze del Mare

Universita degli Studi di Ancona

Contributi di

Paolo Battistoni, Giorgio Bavestrello, Claudio Bertini

Raffaella Boccadoro, Pietro Canepa, Marco Cardinali

Oliana Carnevali, Riccardo Cattaneo Vietti, Carlo Cerrano

Rita Colantonio Venturelli, Roberto Danovaro, Antonio Dell' Anno

Anna Rita Delle Vergini, Mauro Fabiano, Gabriele Fava, Simonetta Fraschetti

Anna Maria Lantero, Giovanni Latini, Paolo Madoni, Giorgio Passerini

Silvia Pezzoli, Mirco Pieroni, Raffaello Pompei, Carla Pruzzo

Antonio Pusceddu, Ivo Rancich, Francesco Regoli, Aniello Russo

Daniela Sani, Alessandro Segale, Attilio Solazzi

Antonio Terlizzi, Cecilia Maria Totti, Silvana Vanucci

UTET

Capitolo 2

Analisi dei dati ecologici e impatto

ambientale

Simonetta Fraschetti, Antonio Terlizzi

2.1

Premessa

Lo studio dei processi biologici richiede, per la loro comprensione, tecniche rigorose di analisi statistica. É per questo che vi è una crescita di interesse nei confronti

delle procedure utilizzate per i disegni sperimentali, per l’analisi e l’interpretazione

di dati complessi, unitamente ad un grande sviluppo nella teoria e nella pratica statistica [35]. Pensare di non conformarsi ad una struttura logica coerente o il non

fornire una giustificazione razionale al modo in cui viene condotto il proprio studio

aggiunge solo confusione a quella già molto diffusa nella scienza dell’ecologia

[25]. Traendo spunto da alcuni casi di studio, il presente contributo si sofferma

sull’impostazione di disegni sperimentali in lavori d’impatto ambientale, sottolineando i vantaggi di un corretto disegno di campionamento. È da sottolineare che nel

corso della trattazione si farà riferimento alle comunità marine bentoniche di substrato duro. Molti dei principi trattati, tuttavia

, possono essere ritenuti validi anche per altri comparti ecologici. Si dà ovviamente

per scontato che siano noti al lettore le basi della statistica uni- e multivariata. In

caso contrario, si rimanda alla fine del contributo per alcuni testi consigliati.

2.2

La nascita dell’ecologia quantitativa: primi approcci

Sino a tutto il 1800, la maggior parte di zoologi e botanici ha concentrato la propria

attività di ricerca nella raccolta di specie nuove, con il fine di stilare liste tassonomiche sempre più dettagliate. I biogeografi tradizionali dedicarono la loro attenzione ad esaminare la distribuzione delle varie unità tassonomiche, per esempio piante, uccelli o mammiferi di una determinata area, ma senza aspirare a confronti di

nessun tipo. Nonostante i limiti di tali ricerche, la maggior parte di quelle osservazioni risulta ancora essenziale per una completa comprensione di importanti fenomeni biologici. Alcuni biogeografi del diciannovesimo secolo tentarono di seguire i

dettami di Humbolt, primo a parlare di associazione, e diedero origine a quella che

lui stesso definì la botanica aritmetica [21].

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

121

Questa tecnica mappava una griglia di aree all’interno di un paesaggio e individuava le specie presenti in ciascun’area. Per paragonare due aree qualsiasi, venivano confrontate le liste di specie e contato il numero di specie in comune o calcolato il rapporto fra il numero di specie (oppure di famiglie) in comune sul numero

totale. Come si può notare, questo modo di procedere concettualmente non è molto

lontano da quello utilizzato per calcolare una qualsiasi matrice di similarità. Un

ulteriore passo verso un’ecologia quantitativa fu condotto da Watson, fitogeografo

britannico, che si oppose strenuamente al semplice atto di raccogliere e catalogare.

Watson si dimostrò molto attento ai problemi legati al campionamento ed agli effetti dell’area del campionamento stesso sulle differenze numeriche nel valutare

l’incidenza di una specie all’interno del suo areale di distribuzione. “Prima riusciamo a ridurre lo “spazio” in “luoghi”, aumentando il loro numero e diminuendo

la loro estensione, più esatto sarà il test” [40].

In biologia marina, il concetto di comunità bentonica intesa come “unità statistica” è stato attribuito a Petersen, un biologo danese che nel 1896 utilizzò un campionatore di fondo con il fine di contare il numero effettivo di animali all’interno di

un volume noto di sedimento. Da allora, sebbene con le difficoltà relative

all’identificazione di metodi appropriati a valutare la presenza e la quantità degli

organismi in un’area o volume noti, i metodi quantitativi per lo studio della distribuzione degli organismi marini hanno contribuito a differenziare l’ecologia dalla

storia naturale [6].

Più recentemente Tobey [31] ha descritto l’introduzione dei quadrati ed il

conteggio delle forme vegetali al loro interno, come qualcosa in grado di rivoluzionare l’ecologia. Ancora oggi, lo studio per la definizione di tecniche di campionamento che permettano di descrivere precisamente ed in tempi ragionevoli la distribuzione e l’abbondanza degli organismi, rappresenta una linea di ricerca attuale ed

in continua crescita [2, 10, 14, 26].

I primi dati quantitativi misero in luce il fatto che le comunità marine, così

come quelle terrestri, sono intrinsecamente variabili, nel tempo e nello spazio. Già

negli anni trenta, MacGinitie [23] aveva rilevato l’importanza di tali variazioni anche tenendo conto di brevi intervalli di tempo fra le occasioni di campionamento, o

di uno spazio limitato fra i siti campionati in un ambiente apparentemente costante.

Successivamente si cominciò a ritenere lo studio di tali fluttuazioni come un “imperativo del lavoro futuro” [30, 37].

Attualmente, lo studio della variabilità nella distribuzione e nell’abbondanza

degli organismi su diverse scale spaziali e temporali si sta rivelando uno dei campi

più promettenti dell’ecologia [24]. Tuttavia, questa variabilità è vista spesso come

un impedimento alle generalizzazioni di modelli ecologici, sia perché questi modelli sono diventati popolari senza che vi fosse un’analisi sufficiente alla scala appropriata, sia perché nessun modello semplice può essere in grado di prevedere effettivamente modelli spaziali e temporali complessi. Poiché modelli differenti sono

il risultato di processi differenti, la documentazione della variabilità naturale nella

distribuzione dei popolamenti è un passaggio fondamentale prima che possano essere proposti modelli esplicativi appropriati [32].

122

Monitoraggio e modellistica ambientale

_________________________________________________________________________

Lo studio della variabilità dei popolamenti non è importante solo da un punto

di vista prettamente teorico. Esso infatti rappresenta un pre-requisito essenziale per

comprendere i processi ecologici prima che il disturbo antropico possa essere identificato e si possa pensare ad una gestione appropriata dell’ambiente. Per sintetizzare le difficoltà incontrate nella ricerca ecologica, potenzialmente capaci di limitare

fortemente una corretta gestione dell’ambiente, è bene ricordare quello che di recente hanno affermato alcuni autori [20]: gli esperimenti condotti in ambito ecologico prendono troppo tempo, la necessità di randomizzazione, di repliche (tema

critico nel metodo scientifico) e di siti di controllo sono difficili da raggiungere ed

infine, i sistemi ecologici hanno l’antipatica caratteristica di essere variabili nello

spazio e nel tempo.

2.3

La statistica univariata: la necessità e l’utilità di esplicitare le ipotesi

Il passaggio da osservazioni qualitative ad osservazioni quantitative si è verificato

in tutti i campi della scienza. In biologia, in particolare, l’importanza della statistica

nasce dalla necessità di giungere a quantificazioni nonostante il carattere di intrinseca variabilità del materiale biologico. Tuttavia, non è responsabilità dei metodi

statistici occuparsi di studiare le cause di tale variabilità e, inoltre, la statistica non

ha neppure il potere di rendere validi quei dati che sono stati raccolti senza alcun

costrutto. È importante che tutti gli esperimenti siano visti come una sequenza di

passaggi logici. Lo sperimentatore deve avere chiara tale sequenza in modo che le

conclusioni raggiunte durante l’esperimento possano essere giustificate in termini

di struttura logica nella quale sono state condotte. È dunque necessario definire alcune procedure che permettano la discriminazione fra spiegazioni alternative (o teorie) per i fenomeni osservati. Le procedure sperimentali sono test formali per le

richieste (previsioni o ipotesi) derivate da spiegazioni alternative. È necessario, iniziando un qualsiasi esperimento, procedere seguendo una scaletta precisa. Il primo

passo riguarda l’osservazione di determinati pattern di variabilità nello spazio e nel

tempo. L’osservazione porta alla definizione di un modello. Il modello viene testato sperimentalmente per convalidare o corroborare quantitativamente le osservazione fatte precedentemente. Consideriamo ad esempio l’osservazione che una determinata spugna si trovi solo oltre una certa profondità. A profondità inferiori ci

sono altri organismi ma non questa spugna. Questa è un’osservazione. Ci possono

essere vari modelli che spiegano questa distribuzione: un modello basato sulla

competizione (a profondità inferiori questa specie non è presente perché poco

competitiva rispetto ad altre), modello di stress fisiologico (fattori come la luce o

l’idrodinamismo ne prevengono l’insediamento). Ovviamente ce ne potrebbero essere molti altri.

A questo punto, per discriminare fra modelli alternativi, si possono proporre

differenti ipotesi logiche. Esse devono avere la proprietà di poter essere logicamente derivabili dal modello e devono essere relative a qualche osservazione che

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

123

non è stata ancora fatta. Cioè, non deve essere ancora stato osservato (nel caso si

voglia testare il modello basato sulla competizione) che in mancanza della specie

supposta essere competitivamente superiore, tale spugna cresca anche al di sopra

della profondità a cui sembra essere apparentemente relegata. Infatti, nel caso in

cui l’evento previsto sia già noto, devono già esistere le osservazioni per dimostrarlo.

Un’ipotesi non è altro che una previsione relativamente ad un evento non conosciuto, basato (o derivato da) un modello per spiegare le osservazioni fatte inizialmente. Avendo stabilito una previsione ipotetica relativamente a quello che potrebbe accadere sotto alcune condizioni sperimentali come conseguenza di un determinato modello, è essenziale testarla. Questo comporta il creare le condizioni

richieste dall’ipotesi e osservare i risultati. C’è ovviamente un problema nella logica che riguarda la natura delle prove. Provare che una previsione è vera richiede

quello che è conosciuto come argomento induttivo. Tecnicamente, le prove richiedono che sia disponibile ogni possibile osservazione. Oppure esse richiedono

l’assunzione che quanto accade in tutte le possibili circostanze non osservate possa

essere dedotto dai casi attualmente disponibili nell’esperimento. Il risultato non è

sempre praticabile e non è sempre possibile provare che qualche cosa si sia verificata. C’è sempre la possibilità che non ci sia sufficiente evidenza e che

l’osservazione contraria non si sia ancora manifestata. Per ovviare a questo problema si utilizza una procedura che viene definita di falsificazione, nella quale

un’ipotesi deve essere confutata, cosa che ovviamente risulta assai più diretta. Una

volta confutata, non c’è pericolo che ulteriori osservazioni possano alterare le conclusioni.

Nel nostro caso, l’ipotesi da confutare (ipotesi nulla) è che non vi siano differenze nella distribuzione della nostra spugna alle diverse profondità in presenza

della specie con cui si suppone che la nostra spugna competa. Non c’è la necessità

di fare alcuna assunzione relativamente ad osservazioni che non sono ancora state

fatte. Una volta che un’osservazione confuta qualche cosa, quella cosa rimane confutata. Il “trucco” consiste nel costruire quello che viene chiamata appunto ipotesi

nulla, affermazione opposta all’ipotesi e poi tentare di confutarla. La confutazione

dell’ipotesi nulla, per definizione, lascia l’ipotesi originale come unica alternativa.

Una volta che l’ipotesi nulla è stata proposta, deve essere testata da un esperimento. Una volta che si è concluso l’esperimento, dovrebbe essere possibile arrivare ad

una sola delle due possibili conclusioni. Una è che l’ipotesi nulla sia falsa (la spugna in effetti cresce alle profondità dove non sia presente l’altra specie che compete); l’altra è che l’ipotesi nulla sia vera (la spugna è uniformemente distribuita

alle diverse profondità). Il rifiuto dell’ipotesi nulla supporta l’ipotesi e, di conseguenza, il modello su cui è basato. Così il solo risultato appropriato di un esperimento è confutare l’ipotesi nulla o l’ipotesi alternativa. Nell’ambito della statistica

univariata, che si basa sulla serie di passaggi logici sopra descritti, uno degli strumenti più potenti e versatili nei disegni sperimentali è il set di procedure chiamato

analisi della varianza. Essa è caratterizzata da una base concettuale molto semplice

ma può essere utilizzata per analizzare molti aspetti della ricerca dei sistemi biolo-

124

Monitoraggio e modellistica ambientale

_________________________________________________________________________

gici. L’analisi della varianza è stata espressamente impostata per risolvere il problema di testare differenze fra medie di popolazioni. Essa è molto utilizzata sia negli esperimenti di tipo descrittivo (es. analizzare i pattern di distribuzione spaziale

di una popolazione) sia negli esperimenti che prevedono manipolazione delle variabili (es. esclusione dei brucatori da un’area e valutazione della risposta da parte

della componente algale). L’ipotesi nulla è che non vi sia nessuna differenza fra le

popolazioni, che quindi devono avere la stessa media nel parametro considerato.

Ogni allontanamento dall’ipotesi nulla può rappresentare un’alternativa valida, che

va dalla possibilità che solo una popolazione differisca dalle altre a quella che tutte

possano differire tra loro. Scostarsi dall’ipotesi nulla non vuol dire, infatti, che tutte

le popolazioni differiscano. Si tratta comunque di una serie complessa di passaggi,

ed è fuori dubbio che molti ricercatori abbiano risposto a questa complessità facendo esperimenti molto semplificati. Al contrario l’analisi della varianza rappresenta

uno strumento molto potente per identificare processi interattivi. Questi includono

variabilità nell’esito di processi quali la predazione, la competizione o il reclutamento che spesso variano marcatamente da sito a sito e nel tempo.

2.4

Il potere del test

Decidere quanto remota possa essere la possibilità di rigettare l’ipotesi nulla quando, in realtà, questa è vera è una scelta che spetta allo sperimentatore. Generalmente, per convenzione, si tende a scegliere una probabilità di 0,05, uno su venti.

Essa, come detto, viene scelta prima di procedere con il test statistico. Questa probabilità di 0,05 definisce la ragione di rifiuto dell’ipotesi nulla ed è generalmente

considerata una possibilità di errore accettabile. In altre parole, è convenzione essere preparati a rifiutare l’ipotesi nulla con meno di una possibilità su venti di farlo

scorrettamente. Infatti, il rifiuto dell’ipotesi nulla, anche avendo stabilito correttamente la regione del rifiuto in base alla probabilità selezionata, non è una conclusione certa. In statistica, si definisce errore di I Tipo la possibilità di rifiutare

l’ipotesi nulla quando questa è vera. Questa probabilità è comunemente conosciuta

come probabilità a. Il rifiuto dell’ipotesi nulla quando questa è vera avviene ogni

volta che un campione dei parametri della popolazione genera un test statistico

nella regione del rifiuto. Si tiene a bassa in modo da evitare questa situazione. Ma

può accadere di fare l’errore opposto, che si verifica quando l’ipotesi nulla dovrebbe essere rifiutata perché falsa ma viene invece accettata come vera. Questo viene

definito errore di II Tipo. Questa probabilità prende il nome di b. Di conseguenza

la probabilità di trattenere scorrettamente l’ipotesi nulla quando è vera l’ipotesi alternativa prende il nome di b. Il potere del test di rifiutare l’ipotesi nulla quando

l’ipotesi alternativa è vera rappresenta, di conseguenza, la probabilità di rigettare

correttamente l’ipotesi nulla in favore dell’alternativa. Il potere di un test può di

conseguenza essere definito nel seguente modo:

potere = 1 - probabilità di errore del II Tipo = 1 – b

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

125

La capacità da parte dei programmi di monitoraggio di individuare l’impatto

dipende in larga misura dal potere del test. Le componenti del potere dell’analisi

includono la percentuale di probabilità scelta per definire l’errore di I Tipo (in genere 0,05), le dimensioni del campionamento (il numero delle repliche e la loro distribuzione spaziale) e la variabilità intrinseca della variabile che si sta studiando.

Di queste ovviamente le prime due sono completamente sotto il controllo dello sperimentatore.

È da sottolineare che il presente capitolo è stato inserito perché un problema

con i disegni sperimentali di tipo univariato è legato al fatto che non è facile decidere il potere del test per individuare casi di impatto ambientale. Il potere del test

(1 – b), in questi casi, è la probabilità che l’impatto (se esiste) venga individuato e

rappresenta la probabilità che l’ipotesi nulla (nessun impatto) venga, correttamente,

rigettata. Nel caso più semplice, l’ipotesi ambientale che dovrebbe essere testata è

che esista un differente modello di cambiamento da prima a dopo il verificarsi di

un disturbo rispetto alle possibili variazioni rilevabili nei controlli. L’ipotesi nulla è

che vi sia un simile cambiamento fra aree disturbate e aree di controllo. Se si fallisce nell’individuazione dell’impatto quando questo, di fatto, esiste, si commette un

errore di II Tipo perché si arriva alla conclusione che l’ipotesi nulla sia vera. Può

però anche accadere di compiere un errore di I Tipo quando il risultato di un programma di monitoraggio suggerisca la presenza di un impatto quando questo, di

fatto, non esiste. Le conseguenze di questi due tipi di errori sono molto diverse:

l’errore di I Tipo potrebbe significare necessità di studi ulteriori e maggiore attenzione al problema. Ci potrebbe essere certamente come conseguenza una perdita di

tempo e di denaro. Ma incorrere nell’errore di II Tipo porterà ad un ulteriore deterioramento ambientale. In questo caso il costo è in termini ambientali [27, 35].

2.5

Dall’analisi univariata alla multivariata

Vi è una differenza di base fra l’analisi univariata e l’analisi multivariata. Nel primo caso, l’analisi va a testare un’ipotesi che deve essere verificata o falsificata.

L’analisi multivariata, a parte rare eccezioni, non prevede la possibilità di testare

un’ipotesi. Si potrebbe quindi dire che l’analisi multivariata, per certi aspetti, è meno rigorosa nell’analisi dei dati. Tuttavia, la complessità dei sistemi ecologici, con

il loro elevato numero di specie e con differenti variazioni temporali di cambiamento nelle popolazioni, ha richiesto nuovi approcci di studio che possono essere

soddisfatti dall’analisi multivariata. Il migliore approccio, soprattutto nei lavori di

impatto, vede l’utilizzo di entrambi gli strumenti di analisi. L’analisi multivariata si

basa su tecniche di classificazione e di ordinamento dei dati. La classificazione dei

dati (o cluster analysis) ha il fine di trovare gruppi naturali per cui campioni

all’interno di un gruppo sono più simili fra di loro di campioni che provengono da

gruppi differenti. La cluster analysis può essere condotta sulle specie campionate in

diversi siti in più di una occasione di campionamento, per definire quei taxa che

tendono ad essere presenti insieme in modo simile.

126

Monitoraggio e modellistica ambientale

_________________________________________________________________________

Un ordinamento è una mappa dei campioni di solito in due o tre dimensioni,

in cui il posizionamento dei campioni riflette la similarità delle comunità biologiche. Alle distanze fra campioni sull’ordinamento tentano di corrispondere le similarità o dissimilarità della struttura di comunità. Le tecniche di ordinamento sono

molto numerose e sono utilizzate per visualizzare rapporti spaziali e/o temporali fra

campioni di organismi. Fra le altre, è possibile citare: Principal Components Analysis (PCA), la Principal Co-ordinates Analysis (PcoA), la Correspondence Analysis (CA) e la Detrended Correspondence Analysis (DECORANA), il non-metric

Multidimensional Scaling (nMDS).

Attualmente, la tecnica del non-metric Multi Dimensional Scaling è molto utilizzata nei lavori di impatto. Alla base, vi è un algoritmo numericamente piuttosto

complesso anche se concettualmente molto semplice che ha potuto affermarsi negli

ultimi anni perché facilitato dallo sviluppo della tecnologia informatica. Questa

tecnica di ordinamento dei campioni è associata a nuove tecniche di analisi statistica che hanno come fine quello di aiutare ad identificare differenze fra i campioni

[8]. I vari passaggi sono descritti in dettaglio nella review di Clarke [8].

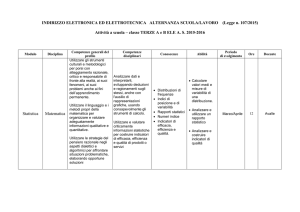

I dati sono organizzati all’interno di una matrice caratterizzata da p righe (le

specie) ed n colonne (i campioni). È necessario avere campioni replicati in corrispondenza dei siti rilevanti a valutare un impatto, possibilmente seguiti nel tempo.

Le similarità di ogni possibile coppia di repliche nell’intero set di campioni viene

poi trasformata nel proprio ordine di rango. Se esiste una qualsiasi forma di impatto

ambientale che agisce sulla comunità nell’area impattata, l’MDS dovrebbe isolare i

campioni presi nell’area impattata rispetto a quelli presi nell’area dei controlli (figura 2.1).

Anche l’analisi delle similarità (ANOSIM) si sta rivelando molto utile

nell’ambito dell’analisi multivariata [8]. In questo caso si può esplicitare

un’ipotesi: ad esempio che non ci siano differenze nella composizione della struttura di comunità in tre siti campionati. L’analisi delle similarità valuta le differenze

fra gruppi di campioni che siano stati definiti a priori usando tecniche di permutazione/randomizzazione sulla matrice di similarità prodotta con il cluster, e ottenendo inoltre anche una percentuale di significatività. Tutte queste tecniche di analisi

si sono rivelate molto utili nel valutare cambiamenti ambientali, quando le tecniche

univariate si siano rivelate incapaci di farlo perché i campioni da analizzare sono

troppo differenti fra loro (è corretto dire a causa di varianze troppo elevate). In

termini ecologici, inoltre, l’analisi di un’intera comunità è uno strumento molto robusto per valutare se si sia verificato qualche cambiamento nel sistema.

2.6

La statistica e la valutazione di impatto ambientale

È stato fatto molto lavoro per migliorare la struttura, la logica e le tecniche di procedure analitiche per valutare i cambiamenti che possono verificarsi nell’ambiente

[18, 19].

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

127

L’impatto è stato definito come un fenomeno in grado di produrre

un’interazione di tipo statistico nelle differenze di abbondanza nel confronto fra il

sito disturbato ed i siti di controllo da prima a dopo il verificarsi di un disturbo.

Questa definizione sottolinea la necessità di analizzare un impatto ambientale

quantificando come le differenze temporali (da prima a dopo il disturbo [9]), non

dovrebbero essere le stesse nell’area soggetta a disturbo e in un’area indisturbata

ma con simili caratteristiche (area controllo o riferimento). Si tratta di un importante progresso concettuale per due ragioni.

Primo, focalizza l’attenzione sul fatto che è necessario aspettarsi naturali cambiamenti temporali nei popolamenti e di conseguenza non essere fuorviati dal pensiero che tutti i cambiamenti siano per forza dovuti al disturbo indotto dall’uomo.

Inoltre, le analisi delle interazioni permettono di valutare un ampio spettro di ipotesi relativamente a differenti tipi di impatto. Tali riflessioni, inizialmente proposte

da da Green [18] furono successivamente sviluppate da Berstein e Zalinski [3] e da

Stewart-Oaten et alii [28] per le analisi di un unico sito di controllo da confrontare

con quello disturbato (e potenzialmente impattato). Più recentemente, vi è stato un

crescendo di attenzione sulla necessità di analizzare le variabili scelte in più di

un’area di controllo [33].

Questo ove vi siano nella variabile scelta prima del disturbo differenti pattern

spazio-temporali tra il sito controllo e il sito disturbato [28].

Tali interazioni precludono possibili interpretazioni. Dove vi siano differenti

siti di controllo, invece, l’ampiezza delle interazioni può essere valutata e può essere esaminata la “variazione” in più dovuta al disturbo [33, 34].

Questi disegni sperimentali richiedono che i dati vengano raccolti con lo stesso

criterio prima e dopo che si sia verificato l’impatto e prendono il nome di “beyond

BACI experiments” (che si potrebbe tradurre come “evoluzione degli esperimenti

Prima-Dopo”) perché prevedono controlli multipli [33]. Molto spesso, tuttavia non

è possibile disporre di dati precedenti l’impatto stesso. In questo caso, l’impatto

può essere valutato solo se i controlli sono abbastanza numerosi da consentire un

confronto “asimmetrico” con il sito protetto. Solo utilizzando controlli multipli, infatti, gli effetti dell’impatto saranno distinti dalla variabilità naturale fra i differenti

siti (ACI, After Control Impact [16]).

I controlli devono essere scelti randomicamente da un set di siti simili fra di

loro. La variabilità naturale fa sì che sia quasi impossibile che i siti di controllo siano identici a quello impattato. Tuttavia, l’opera di monitoraggio fornirà prove di

evidenza causale diretta solo se saranno trovati controlli adatti.

La scelta dei controlli deve sottostare ai seguenti criteri [7, 17, 33]:

•

•

•

•

non devono essere influenzati dall’impatto;

devono avere lo stesso tipo di comunità dell’area impattata;

devono avere le stesse caratteristiche di habitat di quelle dell’area impattata;

devono essere scelte in base ad una scala spaziale in grado di coprire le potenzialità di dispersione delle popolazioni campionate;

128

Monitoraggio e modellistica ambientale

_________________________________________________________________________

•

devono infine tenere conto di differenti scale spaziali nel caso in cui non sia

conosciuta la scala spaziale interessata dall’impatto.

FREQUENZA DI CAMPIONAMENTO. Il disegno sperimentale deve tenere in considerazione il turnover degli organismi. Questo aspetto è spesso sottovalutato e la scelta

della frequenza del campionamento è molte volte arbitraria (ad esempio mensile o

stagionale) e non adeguata alle ipotesi testate dal disegno di campionamento. In

molti casi è importante identificare la variabilità intra-stagionale [34].

Nel caso di alta variabilità, infatti, un singolo campionamento stagionale, anche ottenuto con un numero adeguato di unità di campionamento, può condurre

all’ottenimento di valori poco realistici. In questo modo, la variabilità a breve termine può confondere le differenze fra stagioni. La migliore soluzione è scegliere

randomicamente diverse occasioni di campionamento (che devono essere le stesse

per tutti i siti) per ciascuna stagione. Questo è in grado di mettere in evidenza come

i trend osservati non sono dovuti a fluttuazioni a breve termine.

I disegni sperimentali sopra descritti sono stati concepiti per testare ipotesi con

tecniche di analisi univariata ma possono essere impostati su studi di comunità in

modo che tali analisi possano essere integrate da tecniche di analisi multivariata.

La maggior parte dei metodi di analisi multivarata, tuttavia, come accennato in precedenza, non è in grado di verificare la presenza di interazioni e non misura

l’ampiezza di tali interazioni fra differenze spaziali e temporali [8, 38].

_____________________________________________________________

I

C1

C2

_____________________________________________________________

Fig. 2.1. Un esempio di MDS condotto su dati provenienti da uno studio di impatto

ambientale: è evidente la separazione fra l’impatto ed i controlli. Da notare

anche la maggiore variabilità fra repliche presente nel sito impattato (I = sito

impattato, C1 e C2 = siti di controllo)

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

129

Tali disegni di campionamento, inoltre, sono appropriati per le valutazioni di

cambiamento ambientale ad ogni livello di organizzazione biologica (cellulare, fisiologica, ecc.) dove siano necessarie analisi univariate.

VARIABILITÀ E STRESS. Nonostante si stiano accumulando molti dati sulla variabilità delle popolazioni, molto meno conosciute sono le cause di tale variabilità. Alcuni autori hanno costruito un modello per studiare le interazioni fra disturbo, dispersione degli organismi ed esclusione competitiva in un ambiente a mosaico il

quale, fra le altre cose, prevede un aumento nell’eterogeneità spaziale dei popolamenti con l’aumento del disturbo [5].

Prendendo in analisi una serie di studi di impatto ambientale, alcuni autori,

hanno messo in evidenza che la variabilità fra repliche in aree impattate era molto

maggiore di quella osservata nei siti di controllo [39] (figura 2.1).

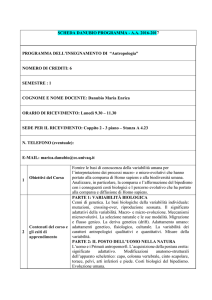

___________________________________________________________________

___________________________________________________________________

Fig. 2.2. Rapporto fra variabilità e stress in una comunità di substrato duro subtidale.

In ascissa vengono riportati i valori relativi alla valutazione del danno al substrato roccioso causato dall’opera di smantellamento della roccia stessa da

parte dei pescatori di datteri di mare. In ordinata vengono riportati i valori di

dissimilarità fra repliche (n=3) calcolati per ciascun sito di campionamento.

Alti valori di dissimilarità sono indice di alta variabilità fra repliche. La relazione fra le variabili è descritta da una regressione polinomiale (modificato

da [12]). La dimensione dei martelli simboleggia l’entità del disturbo

130

Monitoraggio e modellistica ambientale

_________________________________________________________________________

Essi suggeriscono che vi sono due cause potenziali nel determinare l’aumento

di variabilità fra repliche: quella dovuta ad un aumento nella variabilità di abbondanza dello stesso gruppo di specie e quella dovuta ai cambiamenti nell’identità

delle specie. L’analisi univariata, che tiene conto dell’abbondanza relativa delle

specie ha messo in evidenza differenze significative solo per il macrobenthos,

mentre ha dato risposte piuttosto equivoche per gli altri comparti ecologici su cui è

stata condotta. L’analisi multivariata che tiene conto dell’intero set delle specie,

mostra chiaramente un aumento della variabilità con un aumento della perturbazione per tutti i comparti analizzati. Tuttavia, il rapporto fra variabilità a piccola scala

e il disturbo continua ad essere oggetto di studio spesso con risultati discordanti.

Ad esempio, in uno studio di impatto da scarico fognario nel subtidale di fondo duro nel sud dell’Australia, i popolamenti dei siti di controllo erano tanto variabili

quanto nei siti inquinati [7]. In Puglia, il disturbo alle comunità di substrato duro

subtidale dovuto all’opera di smantellamento della roccia da parte dei pescatori di

datteri di mare Lithophaga lithophaga [11] è legato alla variabilità a piccola scala

da una relazione a campana (figura 2.2) [12]. In questo caso, la variabilità tra repliche è maggiore a livelli intermedi di disturbo e decresce all’aumentare del disturbo

o in assenza dello stesso. Andamenti simili sembrano verificarsi anche in comunità

di substrato duro soggette allo sversamento di acque di scarico fognario [29].

2.7

L’istituzione di Aree Marine Protette come impatto ambientale

Il recente riconoscimento del profondo impatto antropico sugli ecosistemi marini

ha portato ad un forte sviluppo della politica di salvaguardia di tali sistemi. Negli

ultimi anni, uno dei mezzi di protezione che ha ricevuto maggiore attenzione è

quello delle riserve marine. L’utilità delle riserve marine, oggi è generalmente riconosciuta sia negli ambienti politici che in quelli scientifici poiché le riserve possono offrire un tipo di protezione non previsto da altre strategie di gestione: specifica protezione di aree critiche, prevenzione dei fenomeni di sovrasfruttamento degli stock ittici, miglioramento della resa di pesca di tipo artigianale, possibilità di

sviluppo socio-economico-culturale compatibile con le esigenze di protezione e

salvaguardia dei patrimoni naturali [1, 4].

Sino ad oggi la progettazione di AMP e la valutazione della loro eventuale efficacia non è stata supportata da rigorosi ed appropriati programmi di campionamento [13, 22].

La maggior parte dei programmi di monitoraggio è stata sviluppata per testare

il possibile impatto (negativo) di attività antropiche quali la presenza di porticcioli,

fogne e centrali termoelettriche [34]. Tuttavia, non esiste alcuna ragione logica per

non estendere queste procedure nella valutazione dell’efficacia delle Aree Marine

Protette. In questo caso l’impatto è rappresentato dalla misura dell’efficacia dei

vincoli di protezione cui l’AMP è soggetta. Sviluppare una strategia di monitorag-

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

131

gio, comunque, sottintende che venga chiaramente esplicitato il fine che

l’istituzione della riserva si prefigge (massimizzare la biodiversità nelle riserve e la

densità delle popolazioni, mantenere la produzione anche all’esterno delle riserve

stesse).

Gli effetti di impatto antropico possono essere rilevati molto bene tramite il disegno di campionamento “beyond BACI” [36]. Raramente, tuttavia, le Aree Marine Protette future vengono monitorate prima dell’istituzione dell’AMP stessa. In

questo caso, l’impatto determinato dall’istituzione di una riserva può essere valutato attraverso il confronto tra area “impattata” e controlli multipli. Solo utilizzando

controlli multipli, infatti, gli effetti della protezione saranno distinti dalla variabilità

“naturale”. È da considerare che le Aree Marine Protette sono scelte per le loro caratteristiche di unicità (ad esempio la presenza di particolari specie, “hot spot”

(punti arricchiti) di diversità, aree di riproduzione) e l’individuazione di controlli è

una procedura piuttosto difficoltosa [15]. Tuttavia, l’opera di monitoraggio fornirà

prove di evidenza causale diretta solo se saranno trovati controlli adatti, a discriminare tra variabilità naturale e variabilità indotta dall’istituzione dell’AMP.

BIBLIOGRAFIA

1.

ALLISON G.W., LUBCHENCO J., CARR M.H., 1998, Marine reserves are necessary but

not sufficient for marine conservation, «Ecological Applications», 8, pp. 79-92.

2. BENEDETTI-C ECCHI L., A IROLDI L., A BBIATI M., CINELLI F., 1996, Estimating the

abundance of benthic invertebrates: a comparison of procedures and variability between observers, «Marine Ecology Progress Series», 138, pp. 93-101.

3. BERNSTEIN B.B., ZALINSKI J., 1983, An optimum sampling design and power test for

environmental biologists, «Journal of Environmental Management», 16, pp. 335-343.

4. BOERO F., BRIAN F., MICHELI F., 1999, Scientific design and monitoring of Mediterranean Marine Protected Areas. «CIESM Workshop Series», 8, pp. 64.

5. CASWELL H., COHEN J.E., 1991, Communities in patchy environments: a model of disturbance, competition, and heterogeneity, in «Ecological heterogeneity», a cura di

Kolasawa J. & Pickett S.T.A., Springer-Verlag, New York, pp. 97-122.

6. CHAPMAN R. N., 1931, Animal ecology, with especial reference to the insects, New

York: McGraw-Hill.

7. C HAPMAN M.G., UNDERWOOD A.J., SKILLETER G.A., 1995, Variability at different

spatial scales between a subtidal assemblage exposed to the discharge of sewage and

two control assemblages, «Journal of Experimental Marine Biology and Ecology»,

189, pp. 103-122.

8. CLARKE K.R., 1993, Non parametric multivariate analyses of changes in community

structure, «Australian Journal of Ecology», 18, pp. 117-143.

9. CONNELL J.H., 1978, Diversity in tropical rain forests and coral reefs, «Science», 199,

pp. 1302-1310.

10. D ETHIER M.N., GRAHAM E.S., COHEN S., TEAR L.M., 1993, Visual versus randompoint percent cover estimations: ‘objective’ is not always better, «Marine Ecology

Progress Series», 96, pp. 93-100.

132

Monitoraggio e modellistica ambientale

_________________________________________________________________________

11. FANELLI G., PIRAINO S., BELMONTE G., GERACI S., BOERO F., 1994, Human predation

along Apulian rocky coasts (SE Italy): desertification caused by Lithophaga lithophaga

(Mollusca) fisheries, «Marine Ecology Progress Series», 110, pp. 1-8.

12. FRASCHETTI S., BIANCHI C.N., TERLIZZI A., FANELLI G., MORRI C., BOERO F., 2001,

Spatial variability and human disturbance in shallow subtidal hard substrate assemblages: a regional approach, «Marine Ecology Progress Series», 212, pp. 1-12.

13. GARCÍA-CHARTON J.A., PÉREZ-RUZAFA A., 1999, Ecological heterogeneity and the

evaluation of the effects of marine reserves, «Fisheries Research», 42, pp. 1-20.

14. G ILI J.M., ROS J., 1985, Study and cartography of the benthic communities of the

Medes Islands (NE Spain), «PSZN, Marine Ecology», 6, pp. 219-238.

15. G LASBY T.M., 1997, Analysing data from post-impact studies using asymmetrical

analyses of variance: a case study of epibiota on marinas, «Australian Journal of Ecology», 22, pp. 448-459.

16. GLASBY T.M., 1998, Estimating spatial variability in developing assemblages of epibiota on subtidal hard substrata, «Marine and Freshwater Research», 49, pp. 429-437.

17. GLASBY T.M., UNDERWOOD A.J., 1998, Determining position for control locations in

environmental studies of estuarine marinas, «Marine Ecology Progress Series», 171,

pp. 1-14.

18. GREEN R.H., 1979, Sampling design and Statistical methods for environmental biologists, Wiley, Chichester.

19. GREEN R.H., 1993, Application of repeated measure designs in environmental impact

and monitoring studies, «Australian Journal of Ecology», 18, pp. 81-98.

20. HILBORN R., LUDWIG D., 1993, The limits of applied ecological research, «Ecological

Application», 3, pp. 550-552.

21. H UMBOLT A., B ONPLAND A., 1807, Essai sur le Geographie des Plantes, Paris, Librarie Lebrault Schoell.

22. LASIAK T., 1999, The putative impact of exploitation on rocky infratidal macrofaunal

assemblage: a multiple-area comparison, «Journal of the Marine Biological Association of the UK», 79, pp. 23-34.

23. M ACGINITIE G.E., 1939, Littoral marine communities, «American Midland Naturalist», 21, pp. 28-55.

24. MENCONI M., BENEDETTI-CECCHI L., CINELLI F., 1999, Spatial and temporal variability in the distribution of algae and invertebrates on rocky shores in the Northwest

Mediterranean, «Journal of Experimental Marine Biology and Ecology», 233, pp. 123.

25. PETERS R.H., 1991, A critique for ecology, Cambridge, Cambridge University Press.

26. R OBERTS D.E., FITZHENRY S.R., KENNELLY S.J., 1994, Quantifying subtidal macrobenthic assemblages on hard substrata using a jump camera method, «Journal of Experimental Marine Biology and Ecology», 177, pp. 157-170.

27. SCHRADER-FRECHETTE K.S., MC C OY E.D., 1992, Statistics, costs and rationality in

ecological inference, «Trends in Ecology and Evolution», 7, pp. 96-99.

28. STEWART-OATEN A., MURDOCH W.M., PARKER K.R., 1986, Environmental impact assessment ‘pseudoreplication’ in time?, «Ecology», 67, pp. 929-940.

29. TERLIZZI A., FRASCHETTI S., GUIDETTI P., BOERO F., 2001, The effects of a sewage

discharge on a shallow hard-substrate sessile assemblages, «Marine Pollution Bulletin», in stampa

30. T HORSON G., 1957, Bottom communities (sublittoral or shallow shelf), «Geological

Society of American Memoir», 67, pp. 461-534.

Analisi dei dati ecologici e impatto ambientale

_________________________________________________________________________

133

31. TOBEY R., 1981, Theoretical sciences and technology in American ecology, «Technology and Culture», 17, pp. 718-728.

32. UNDERWOOD A.J., 1990, Experiments in ecology and management: their logics, functions and interpretations, «Australian Journal of Ecology», 15, pp. 365-389.

33. UNDERWOOD A.J., 1992, Beyond BACI: the detection of environmental impacts on

populations in the real, but variable, world, «Journal of Experimental Marine Biology

and Ecology», 161, pp. 145-178.

34. UNDERWOOD A.J., 1993, The mechanism of spatially replicated sampling programmes

to detect environmental impacts in a variable world, «Australian Journal of Ecology»,

18, pp. 99-116.

35. UNDERWOOD A.J., 1996, Detection, interpretation, prediction and management of environmental disturbances: some roles for experimental marine ecology, «Journal of

Experimental Marine Biology and Ecology», 200, pp. 1-27.

36. UNDERWOOD A.J., 1996, On beyond BACI: sampling designs that might reliably detect

environmental disturbances, in «Detecting ecological impacts, concepts and applications in coastal habitats», a cura di R. J. Smith, C. W. Osenberg, Academic Press, pp.

151-175.

37. UNDERWOOD A.J., 1997, Experiments in ecology. Their logical design and interpretation using analysis of variance, Cambridge University Press, Cambridge.

38. UNDERWOOD A.J., CHAPMAN M.G., 1998, Spatial analyses of intertidal assemblages

on sheltered rocky shores, «Australian Journal of Ecology», 23, pp. 138-157.

39. WARWICK R.M., CLARKE K.R., 1993, Increased variability as a symptom of stress in

marine communities, «Journal of Experimental Marine Biology and Ecology», 172, pp.

215-226.

40. WATSON H.G., 1874, Cybele Britannica; or, British Plants and their geographical relations, London, Longman.