Il Data Quality a supporto dei sistemi

di reporting

Metodologia ed esperienze Bip.

AIEA – Sessione di Studio

Torino, 28 novembre 2013

Agenda

Obiettivi di governo del dato e approccio alla data governance

Un Framework per la data governance

Introduzione e approccio al Data Quality

Requisiti normativi del settore finanziario da Basilea II a Solvency II

La declinazione dei requisiti normativi in categorie di controlli IT

La reportistica sui controlli nell’ambito del “sistema dei controlli interni”

Potenziali implicazioni funzionali per le soluzioni applicative di reporting

Governance sulla struttura dei dati a supporto dei sistemi di reporting integrato

© Bip. 2013

- 1-

Obiettivi di governo del dato

Confrontati con altri asset IT, i dati presentano alcune peculiarità che rendono necessario identificare

degli obiettivi specifici per il loro governo, garantendone così manutenzione ed evoluzione nel tempo

coerenti alle esigenze aziendali

CARATTERISTICHE FONDAMENTALI DEL DATO

• I dati sono un asset trasversale rispetto a:

sistemi, processi, organizzazione, etc.

• I dati vengono continuamente modificati e

trasformati nel tempo, sia in modo

automatico che manuale

• I dati hanno “memoria” (una volta creati,

perdurano mantenendo i pregi e difetti

iniziali)

• I dati hanno quindi un impatto rilevante

avendo conseguenze dirette su:

• La modellazione dei processi di

business

• Il disegno delle soluzioni lato IT

• Le attività operative dei gruppi di

lavoro

OBIETTIVI DI GOVERNO DEL DATO

• Stabilire un linguaggio comune (IT,

Business e terze parti) di riferimento per il

dato

• Identificare e ridurre le criticità in

essere legate ai dati in termini di: :

• Controllo e comprensione della loro

creazione/ trasformazione

• Mastership

• Qualità dell’informazione

• Affidabilità dei dati di reporting

• Etc.

• Condividere la visione sull’evoluzione

attesa dei dati ed anticipare il

cambiamento

• Guidare l’evoluzione dei dati

• Etc.

© Bip. 2013

- 2-

Un framework per la data governance

L’approccio

La Data Governance nasce dall’esigenza di avere un approccio strutturato per indirizzare gli obiettivi

specifici inerenti il governo del dato

Clienti

MACRO-ATTIVITA’

Fornitori

Terze

Parti

1• Creazione di un layer comune (Data

Model) in grado di incrementare la

comprensione sui dati e uniformare la

comunicazione tra gli attori, sia interni

che esterni, al perimetro aziendale

2• Impostazione delle attività di analisi

1

2

3

dell’esistente (AS IS), supportate dal

Data Model, per l’individuazione delle

criticità

3• Disegno del modello target (TO BE) e

realizzazione di un programma di

interventi per indirizzare le criticità e

abilitare il miglioramento continuo

(Roadmap)

Gruppi operativi

Gruppi direzionali

Criticità

Enterprise

Mitigazioni

© Bip. 2013

- 3-

Un framework per la data governance

Benefici attesi

Business Units

Demand

Architetture

Sviluppo

Business

Intelligence e

Reporting

Terze Parti

• Requisitazione guidata da modello condiviso con l’IT

• Trasparenza dell’IT

• Allineamento tra evoluzione dei dati aziendali e Business Plan di medio – lungo termine

• Analisi e disegno della soluzione guidata dal modello condiviso con sviluppo e business

• Riduzione dell’effort di analisi grazie alla disponibilità di una visione aggiornata dei dati e

della ownership / mastership

• Disegno di soluzioni architetturali coerenti con la visione di medio lungo termine

sull’evoluzione dei dati

• Sviluppo guidato da disegno condiviso con i gruppi di analisi e con gli altri sistemi

• Miglioramento della soluzione tecnica in termini di modello dati fisico sui singoli sistemi e

progettazione delle interfacce

• Visione sulla evoluzione attesa dei dati e predisposizione al cambiamento

• Chiarezza sulle fonti alimentanti (dato ricevuto dai sistemi) (back-end)

• Terminologia comune con gli utenti nel disegno e realizzazione degli ambienti di analisi e di

reporting (front-end)

• Condivisione di una terminologia comune sui dati scambiati tra le parti, e conseguente

agevolazione nella definizione di linee guida di Data Quality / disegno Interfacce / etc.

© Bip. 2013

- 4-

Framework per la Data Governance

Visione d’insieme

Per affrontare in modo strutturato le problematiche e le iniziative connesse alla data governance, e

guidare l’individuazione delle attività di dettaglio, Bip. ha sviluppato un framework che schematizza gli

ambiti di azione e i concetti chiave

DATA GOVERNANCE - FRAMEWORK

Linee guida

Azioni di

mitigazione

Roadmap evolutiva

Modello operativo

Data Governance

Catalogo e Modello

logico di

riferimento dei

dati (as is e to be)

Data Framework

Identificazione azioni di

mitigazione

Identificazione

Criticità/

Ottimizzazioni

Warning

Definizione modello to-be

Mapping dei dati di sistema

sul modello (as-is e to-be)

Mapping del

modello logico sui

sistemi

Sistemi e dati applicativi

Censimento

issue, punti di

attenzione e

possibilità di

ottimizzazione

Identificazione

Criticità/

Ottimizzazioni

Deliverable di area

© Bip. 2013

- 5-

Introduzione e approccio al Data Quality

Introduzione e aree di intervento

Nell’esperienza Bip. un progetto di Data Quality richiede da un lato la realizzazione di interventi puntuali

su modello organizzativo, processi e strumenti, dall’altro l’evoluzione dell’architettura applicativa con

l’obiettivo di garantire la qualità, l’affidabilità e la coerenza interna dei dati

AREE DI INTERVENTO

PRINCIPALI BENEFICI

MODELLO E PROCESSI

Macro Processo DQ:

trattamento dei dati nel loro

ciclo di vita

Definizione di controlli ex-ante

ed ex-post

Norme e standard a supporto

della qualità dei dati (es.

dizionario dati)

Aumento della qualità e dell’affidabilità del

patrimonio informativo aziendale

Maggiore diffusione della conoscenza del

patrimonio informativo aziendale

Compliance con requisiti normativi in tema DQ

(validazione)

Riduzione dei rischi derivanti dal mancato

rispetto di normative e policy vigenti

AMBITI DI

INTERVENTO

DATA QUALITY

SISTEMI

Strumenti di analisi qualità dati

Strumenti di reporting e

monitoraggio delle anomalie

Strumenti di aggiornamento e

correzione delle anomalie

ORGANIZZAZIONE

Struttura del presidio di DQ

Comitato di DQ

Interazione fra strutture e

individuazione di Focal Point

Definizione di ruoli e

responsabilità nel processo

Maggiore adeguatezza della reportistica

gestionale/direzionale (supporto ai processi

decisionali e all’attuazione delle strategie di

business) e regolamentare

Migliorare stabilità e predittività dei modelli

interni di misurazione dei rischi

Benefici in termini di assorbimento di capitale

a fronte dei rischi assunti

Riduzione del time-to-market di nuove

applicazioni e dei relativi costi

© Bip. 2013

- 6-

Introduzione e approccio al Data Quality

Approccio al DQ

A tal fine, l’approccio adottato da Bip. in diverse esperienze progettuali del settore bancario e assicurativo

parte da un Modello di DQ che integra in modo strutturato le diverse aree di intervento

SCHEMA LOGICO

DESCRIZIONE

1

GOVERNANCE DQ

3

2

MACRO PROCESSO DQ

Implementazion

e del (meta)dato

e delle regole

nei sistemi

Definizione,

Aggiornamento,

Estinzione del

(meta)dato

Creazione

Aggiornamento

CICLO

DI VITA

DIZIONARIO

DATI

Controllo

sistematico del

rispetto delle regole

e risoluzione

anomalie

4

PROCESSI

TRASVERSALI

Reporting Risk

Management

Riconciliazion

e Rischio /

Contabilità

Monitoraggio

PROCEDURE E APPLICAZIONI IT

Strumenti di Controllo, Monitoraggio e Reporting

5

Perimetro di Dati: Interventi DQ

…

•1 Insieme delle attività di

coordinamento e gestione del

DQ per tutte le strutture ed i

ruoli coinvolti

2 Insieme di regole, processi e

strumenti standard di controllo,

validazione e certificazione del

dato che devono integrarsi in

tutte le fasi del ciclo di vita

3 Elenco dei dati rientranti

nell’ambito del DQ per i quali

ciascuna informazione risulta

univocamente definita in termini

di codifica, semantica, domini,

formati e ownership

4 Tool di analisi e reporting a

supporto del processo di DQ

che consente l’applicazione delle

regole di controllo ex-ante e expost sulle basi dati e sugli

applicativi nei differenti step del

ciclo di vita del dato

5 Il Framework di DQ viene

applicato al set di dati

individuati come “key” e si

sostanzia in interventi volti a

sanare e prevenire anomalie sui

dati con un processo strutturato

© Bip. 2013

- 7-

Requisiti normativi del settore assicurativo (Solvency II) …

Classificazione normativa e classificazione di uso corrente

Si riportano, a titolo esemplificativo, i requisiti normativi per il settore assicurativo previste sui controlli

della qualità dei dati previsti dalla Direttiva 2009/138/CE Solvency II e da proposte di normative di

secondo livello correlate

ESEMPIO REQUISITI DI QUALITA’ DEL DATO IN

AMBITO ASSICURATIVO (SOLVENCY II) *

CLASSIFICAZIONE DEI CONTROLLI IT: CATEGORIE

DI USO CORRENTE

Appropriatezza - il dato è considerato appropriato se:

• adatto per gli obiettivi desiderati (ad esempio la

valutazione delle riserve tecniche, stabilire delle

assunzioni);

• rilevante in relazione al portafoglio di rischi in analisi

(cioè direttamente legato ai risk drivers sottostanti).

• Formali: Osservanza caratteristiche formali del dato

rispetto al dizionario dati

Completezza - Il dato è considerato completo se:

• è riconducibile ai principali gruppi omogenei di rischio

presenti nel portafoglio assicurativo;

• è sufficientemente granulare per identificare trend di

comportamento dei rischi sottostanti

• è riferito a periodi storici sufficientemente lunghi, dei

quali è possibile ottenere informazione storica

•

Accuratezza – Il dato è considerato accurato se:

• è esente da errori materiali e omissioni;

• la registrazione delle informazioni è adeguata,

effettuata in modo continuo nel tempo e mantenuta

coerente nel tempo;

• viene stabilito un alto livello di confidenza sui dati;

• la compagnia è in grado di dimostrare che considera il

dataset credibile utilizzandolo nel contesto delle

operazioni aziendali e dei processi di decision making.

NOTE: * IMPLEMENTING MEASURE LEVEL II (ex CP 43)

• Congruenza: Comparazione con altre informazioni

con cui vi è un legame di coerenza.

• Integrità Referenziale: Confronto presenza dello

stesso dato in sistemi diversi fra loro in relazione.

• Quadratura: Completezza flussi di alimentazione

• Significatività: Individuazione anomalie rispetto

confronto con trend storici

© Bip. 2013

- 8-

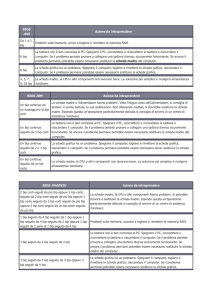

… e la declinazione dei requisiti normativi in categorie di controlli IT

la creazione di un linguaggio comune

Una possibile soluzione è quella di creare una trascodifica tra terminologia corrente e classificazione

dettata dalle normative del Data Quality

Riportiamo, a titolo

esemplificativo, una tabella

tratta dall’approccio Bip.

applicato in progetti che

coinvolgono le aree IT di

primari gruppi assicurativi,

per facilitare il dialogo tra

l’IT e le aree funzionali

(Risk Management,

Amministrazione e

Bilancio, … ). Nello

specifico, le cinque

categorie di controllo

facilmente comprensibili da

referenti IT sono state

ricondotte ai tre criteri

Solvency II secondo la

tabella di seguito riportata.

© Bip. 2013

- 9-

La reportistica sui controlli nell’ambito del

“sistema dei controlli interni”

Ai fini del corretto presidio della Data Quality e in linea con quanto stabilito dalla vigente normativa

nazionale e internazionale, il sistema di Data Quality dovrà essere integrato nel più ampio sistema di

controlli interni che si basa su tre livelli

• Controlli di primo livello, quale insieme di

controlli di linea, in larga parte integrati nei

sistemi informatici aziendali attuati da tutti

gli utenti che partecipano ai diversi

processi operativi, anche sulla base dei

livelli gerarchici e del meccanismo di poteri

e deleghe

• Controlli di secondo livello, effettuati da

altre funzioni aziendali nel rispetto del

principio di separazione dei compiti e da

strutture specialistiche, quali il controllo di

gestione, il dirigente preposto, l'attuario, la

funzione controllo reti, il risk management,

la compliance

• Controlli di terzo livello, ovvero i controlli

e le verifiche effettuati dall’Audit di Gruppo,

preposta al monitoraggio del

funzionamento del sistema di controllo nel

suo complesso ed alla valutazione della sua

adeguatezza e dei processi di decision

making.

© Bip. 2013

- 10-

Potenziali implicazioni funzionali per

le soluzioni applicative di reporting

Si riportano, a titolo esemplificativo, i requisiti di alcuni requirement della normativa Solvency II e le

possibili implicazioni nell’ambito di applicazione ai sistemi di reporting

REQUIREMENT NORMATIVI (ESEMPIO SOLVENCY II)

IMPLICAZIONI FUNZIONALI

RACCOLTA E ARCHIVIAZIONE

• registrati e conservati nel loro complesso

• I dati storici conservati

• Ogni modifica ai dati originali deve essere

documentata

• conservare traccia delle correzioni a fronte di errori

o omissioni .

• Audit dati di origine dei report

• Audit trasformazione dei dati di origine dei

report

• Archiviazione dati inseriti manualmente:

• Controlli di validità / coerenza dei dati inseriti e

gestione delle

• Tracciatura ed archiviazione dei risultati

intermedi di elaborazione

• Audit trail azioni eseguite

• Analisi storica elaborazioni/ variazioni dati:

DIZIONARIO DATI

• directory di ogni dato usato

CONTROLLO DEI DATI

• check di data quality

DATA POLICY

• policy sul data quality e sul data update

REPORTING

• descrivere in sintesi i processi e gli standard

© Bip. 2013

- 11-

Governance sulla struttura dei dati a supporto dei sistemi di

reporting integrato

Nell’ambito di reporting soggetti a recenti normative, viene posta una particolare attenzione ai

requisiti di Governance della struttura dei dati sia in area finance sia nelle altre industry

REQUISITI NORMATIVI VALIDI PER TUTTI I SETTORI

ALTRI REQUIREMENT NORMATIVI PER IL

SETTORE FINANCE

Tra le norme che richiedono implicitamente o

esplicitamente un processo di Data Quality si ricordano a

titolo esemplificativo ma non esaustivo:

• le norme inerenti la trasparenza dei mercati finanziari

e, in particolare, le norme CONSOB relative alla

comunicazione ai mercati finanziari di informazioni

“sensibili” anche in occasione di incontri con la comunità

finanziaria

In tutti gli ambiti sopra evidenziati, sarà opportuno

analizzare e valutare gli impatti del sistema di reporting

per organizzare e pianificare sia gli interventi volti

all’auditabilità e riconciliabilità dei dati prodotti, sia

inerenti i controlli effettuati dal sistema di reporting nelle

varie fasi di aggregazione, caricamento, elaborazione e

produzione di report.

• I dati dei controlli dovranno essere pianificati in linea e in

coerenza con:

• le normative internazionali

• le normative nazionali europee dei diversi regulator

• le linee guida interne all’eventuale gruppo

• le linee guida nazionali applicate dalle sub-holding

• Il sistema di reporting in ambito normativo di

area finanza dovrà inserirsi all’interno dei

sistemi di controllo interni avrà alcune linee

guida di Gruppo che verranno implementate

o aggiornate alla luce dell’evoluzione

normativa

• In particolare, ci si riferisce alle norme di

Governance previste da Solvency II e Basel

II nel Pillar 2 per il rispetto dei requisiti

qualitativi relativi alla gestione interna

(governance, controllo interno e

organizzazione) dell'impresa finanziaria.

• Sono, inoltre, indicate anche le norme relative

al processo di autovalutazione periodica

delle esigenze di solvibilità, e

all’identificazione e valutazione dei rischi non

quantificabili cui l’impresa è esposta.

• le norme in corso di emanazione inerenti i

conglomerati finanziari

• le norme inerenti i processi di governo in aree

finanza (ICAAP e ORSA)

© Bip. 2013

- 12-

Allegato

Metodologia DQ applicata ai sistemi di reporting

© Bip. 2013

- 13-

Framework Data Quality Management

Il nostro approccio al Data Quality Management prevede due pilastri principali: la definizione del

modello di Data Quality e la definizione di processi e architettura di CdG

L’obiettivo è definire,

implementare e monitorare le

regole e i processi necessari a

garantire la qualità dei dati del

reporting, dei sistemi di sintesi

del CdG e del DWH

Interventi di

Data Quality

Data Quality

Management

Accounting

Analisi dei dati, individuazione anomalie e

pianificazione interventi per eliminazione

anomalie

Attivazione interventi crash (bonifiche) e

strutturali

Attivazione processo strutturato di

monitoraggio dei dati, prevedendo controlli ex

ante ed ex post sui dati

Razionalizzazione del “ciclo di vita” dei dati

critici

Interventi di

processo

e sui sistemi

di CdG e DWH

Analisi e revisione della

reportistica di CdG prevendo

interventi di razionalizzazione

sul sistema di CdG, sui motori

di applicazione delle regole

gestionali e sul DWH (approccio

bottom up nell’audit trail del

dato)

Analisi della reportistica e del processo di

produzione del dato

Gap analysis e analisi delle criticità e

categorizzazione per ambito funzionale per

identificarne impatto e priorità di intervento

Analisi dell’architettura funzionale e

applicativa (e dei sistemi a supporto) del

management accounting (flussi di

input/output, restitution, golden rules del

CdG, ...)

Definizione del processo di audit trail del dato

e monitoraggio anomalie

© Bip. 2013

- 14-

Interventi di Data Quality

Vista di sintesi

In primo passo consiste nella definizione di un framework, immediatamente applicabile, costituito da

un insieme strutturato di processi, regole e strumenti a supporto delle attività di controllo e

certificazione dei dati e al presidio del ciclo di vita del dato, dalla nascita del bisogno informativo alla

certificazione della qualità del dato

Ambito

WORKFLOW

Principali Interventi

Asset Bip.

Definizione del macro processo di Data Quality con l’obiettivo di presidiare il ciclo di vita del dato,

Macro

processi e

processi di

dettaglio

dalla nascita del bisogno informativo alla certificazione della qualità del dato, stabilendo ownership,

attività e tempistiche di intervento in relazione alle fasi di:

Definizione: nascita esigenza di un nuovo dato, definizione e valutazione degli impatti

CICLO

DI

VITA

Implementazione del dato e delle regole nelle procedure applicative della banca e

consolidamento delle informazioni (es. aggiornamento manuali utente)

Gestione operativa: Inserimento, aggiornamento ed eventuale cancellazione del dato nelle

procedure, in modo manuale o automatico (in base alle regole di alimentazione)

Monitoraggio

Monitoraggio: Verifica anomalie ed errori e indirizzamento per la risoluzione delle stesse,

risoluzione anomalie e validazione dell’intervento

Certificazione: validazione finale del dato e rimozione dell’anomalia

CODIFICA e

SEMANTICA DEI DATI

Costruzione di un dizionario dati finalizzato ad agevolare il controllo dei dati e a garantire:

univocità di definizione

Dizionario

Dati

codifica e semantica del dato

Owner del dato

REGOLE DI

CONTROLLO

Censimento, classificazione e codifica delle regole ex ante da applicare nei sistemi di origine del dato

ed ex post da applicare nei sistemi di destinazione del dato, dei dati soggetti a controllo e delle

Check List

regole

tipologie di warning che rappresentano gli elementi di base su cui costruire il sistema di

monitoraggio della qualità

© Bip. 2013

- 15-

Interventi di Data Quality

Dizionario Dati

Per agevolare il controllo dei dati può essere utile definire un “Dizionario Dati” con l’obiettivo di

garantire univocità di definizione, codifica e responsabilità delle informazioni che impattano sul

controllo di gestione

O

ATIV

C

I

F

I

MPL

ESE

Struttura

Struttura del

del Dizionario

Dizionario Dati

Dati

Principali caratteristiche

Definizione univoca dei dati oggetto di

monitoraggio in termini di codifica, semantica,

domini, formati e ownership

Creazione, gestione e manutenzione del Dizionario

Dati con l’obiettivo di aggiornare il Dizionario con

cadenza periodica oppure “on demand “laddove

intervengano modifiche significative nella

semantica o nella codifica delle informazioni

Definizione insieme delle regole, processi e

strumenti standard di controllo, validazione e

certificazione del dato

Nuovi requisiti di business oppure richieste di

modifiche dei dati devono essere evidenziate

dall’owner del dato e prevedono una nuova

codifica/ semantica del dato

La richiesta di modifica della scheda Dizionario

Dati attiva il processo di analisi di impatto

© Bip. 2013

- 16-

Interventi di Data Quality

Tipologie di Controlli

La rilevazione delle anomalie può essere effettuata introducendo due momenti di controllo: controlli

ex ante sui sistemi origine del dato(es. legacy, motori di CdG) e controlli ex post sui sistemi destinatari

del dato (es. Management Information System, DWH…)

FAMIGLIA DI

CONTROLLI

TIPOLOGIA CONTROLLO

DESCRIZIONE

CONTROLLI DI PRIMO LIVELLO (FLUSSI)

CONTROLLI

EX ANTE

PRESENZA FLUSSI ATTESI

Verifica della avvenuta produzione dei flussi di input ed output attesi

NUMEROSITA’ RECORD

Verifica numerosità dei record caricati rispetto ai record presenti nei flussi di origine

NUMEROSITA’ CAMPI

Verifica numerosità dei campi caricati rispetto ai campi presenti nei flussi di origine

CONTROLLI DI SECONDO LIVELLO (CAMPI)

VALORIZZAZIONE CAMPI

Verifica della presenza dei dati obbligatori

COERENZA FORMALE CAMPI

Verifica del rispetto dei vincoli di codifica, semantica e di dominio del dizionario dati

COERENZA SOSTANZIALE CAMPI

Verifica di consistenza dei dati tra le diverse fonti e di coerenza della valorizzazione

delle informazioni destinate a diversi sistemi

QUADRATURE/RICONCILIAZIONI

QUADRATURE SISTEMI ALIMENTANTI SISTEMI DI SINTESI

QUADRATURE TRA SISTEMI DI SINTESI

CONTROLLI

EX POST

Quadrature di periodo (giornaliere, decadali, mensili) tra stok dei sistemi origine del

dato (es. partitari) e stock dei sistemi destinatari (es. stock contabili)

Quadratura dei dati appartenenti al patrimonio informativo comune dei sistemi di

sintesi (es. Contabilità vs CdG, CdG vs ALM e vs CRM, CdG vs Marketing)

MONITORAGGIO ANOMALIE

RILEVAZIONE ANOMALIE

RICORRENZA FENOMENO ANOMALO

VERIFICHE ANDAMENTALI

Intercettazione dei fenomeni anomali attraverso l’impostazione di range di tolleranza,

valori minimi e massimi del dato

Verifica numerosità e diffusione dell’anomalia (nuova anomalia, anomalia già

riscontrata e corretta con bonifica, anomalia già riscontrata ma non ancora corretta…)

Verifica degli scostamenti dei fenomeni anomali avvenuti tra elaborazioni successive

(es. confronti year to date, month to date , daily..)

© Bip. 2013

- 17-

Interventi di Data Quality

Dati di Management Accounting oggetto di controllo

Nella nostra esperienza, i dati di management accounting di natura economica oggetto di controllo e

riconciliazioni mensili appartengono a due cluster principali: dati contabili e dati extracontabili

Cluster

1

DATI CONTABILI

Dati

Margine di Interesse (interessi reali attivi e passivi)

Commissioni Nette (commissioni attive e passive)

Altri Oneri e Proventi (Utile/perdita da negoziazione)

Costi Operativi (personale, ASA)

2a

Mercato/Segmento Commerciale di appartenenza del

DATI

EXTRACONTABILI

Cliente

Portafoglio Commerciale di appartenenza del Cliente

REFERENZIALI

EFFETTI FIGURATIVI (interessi figurativi attivi e passivi

2b

DATI

EXTRACONTABILI

IMPORTI

calcolati al TIT)

Tasso Interno di Trasferimento (TIT) e Volumi

Punti di Attenzione

Necessità di quadrare i dati gestionali con i dati contabili

sulla base della riclassificazione gestionale del Bilancio

mediante il raccordo:

Contabilità e CdG a livello di singolo rapporto

Piano dei Conti vs Catalogo Prodotti Gestionale

Difficoltà nel riconciliare le informazioni gestite nei

sistemi referenziali con le informazioni acquisite nei

sistemi di CdG finalizzate al breakdown dei dati:

CdG vs archivi anagrafici per allineamento Customer

Segmentation e calcolo revenue allocation

Allineamento CdG vs Marketing per riconciliazione

portafogliazione clientela e monitoraggio clientela

non portafogliata (es. Mercato “Non Attribuito”)

Difficoltà nel riconciliare la componente figurativa a causa di:

Tempi diversi di elaborazione del dato nei sistemi di CdG

(mensile) e ALM/Tesoreria (giornaliera)

Differente base di calcolo utilizzata per il calcolo dei

volumi (es. 360 vs 365)

Differente modalità di rilevazione del TIT (assegnazione

giornaliera, nei sistemi di ALM vs calcolo media mensile nei

sistemi di CdG

La presenza di uno strato centralizzato di applicazione delle regole e arricchimento delle informazioni semplifica le attività di

quadratura/riconciliazione con conseguente riduzione delle attività manuali dedicate ad adjustment del dato

© Bip. 2013

- 18-

Interventi di Data Quality

Riconciliazione Contabilità vs CdG

Tutti i dati di ricavo/costo sono quadrati alla fonte o riconciliabili con la contabilità attraverso livelli di

aggregazione del catalogo prodotti che riproducono le voci di Conto Economico

Margine Intermediazione

Raccordo contabile (Voci di CE) – gestionale (Prodotti Gestionali)

10

Interessi attivi e proventi ass.

20

Interessi passivi e oneri ass.

Raccolta Diretta/Impieghi

(es.: Conti Correnti, Depositi Risparmio, Mutui ).

Commissioni nette

Raccolta Indiretta/Servizi Transazionali

(es.: Risparmio gestito, Previdenza, Cash Management)

80

Profitti da operazioni finanziarie

Profitti su Derivati, profitti su equity e fixed income

90, 100,

110

Altri proventi e oneri gestionali

Recupero bolli e spese

(es.: recupero bolli su C/C passivi)

Dividendi e altri proventi

Dividendi da partecipazioni e investimenti

40,50

70

Il catalogo prodotti gestionali deve essere strutturato per poter essere raccordato alla contabilità e allo stesso tempo per

consentire l’analisi dei fenomeni gestionali

Per ogni prodotto è disponibile un set differenziato di misure che rendono possibile il calcolo di tassi, spread e pricing

© Bip. 2013

- 19-

Interventi di Data Quality

Mappatura Prodotti – Misure CdG

L’incrocio di prodotti e misure consente l’analisi di tassi, mark-up/mark-down e pricing tipica dell’ottica

gestionale

Mappatura Prodotti - Misure

Volumi

medi

10

20

40,50

Interessi attivi e proventi ass.

(Impieghi clientela)

Interessi passivi e oneri ass.

(Raccolta clientela)

Commissioni nette

(Raccolta clientela)

80

Profitti operazioni finanziarie

90, 100,

110

Altri prov. e oneri di gest.

70

Dividendi e altri proventi

Interessi

reali

Interessi di Interessi

Commissioni

mora

figurativi

Flussi

Entrata/

uscita

Analisi

tassi e

spread

Analisi

pricing

La misura, dimensione che si affianca al prodotto, consente di acquisire ed analizzare diverse tipologie di informazioni per lo

stesso prodotto (es.: per la raccolta diretta sono acquisiti volumi medi, interessi passivi e ricavi figurativi; per i fondi comuni

vengono acquisite le diverse tipologie di commissione, i volumi medi e diverse misure di flusso come conferimenti, piani di

accumulo)…

© Bip. 2013

- 20-

Interventi di Processo e sui Sistemi

Linee Guida EVolutive

Un modello avanzato di certificazione dei dati prevede alcuni interventi sui processi e sui sistemi (in

particolare sistemi di sintesi e DWH), definiti nell’ottica arricchire il patrimonio informativo e la

profondità di analisi a supporto delle strategie decisionali e snellire i processi di di riconduzione/audit

trail del dato

Linee guida

Convergenza dell’architettura verso un unico punto di consistenza e aggregazione dei dati nel DWH

Definizione di un modello dati unico integrato per tutta la reportistica gestionale

Razionalizzazione delle alimentazioni in un’ottica di controllo della qualità dei dati:

• Individuazione delle fonti di alimentazione corrette per ciascun dato

• Bonifica di flussi ridondanti in termini di contenuto informativo, di flussi duplicati (flussi identici con periodicità e

latenza differenti) e correzione dei dati anomali (carenze informative, valori di dominio errati…)

Dismissione dei report e dei flussi ridondanti

Creazione tool automatici a supporto dei processi di quadratura/riconciliazione/verifiche o adjustment manuali

Creazione di datamart tematici e viste verticali specializzate per aree di business

Arricchimento del patrimonio informativo e della profondità di analisi a supporto delle strategie decisionali, sulla base

requisiti espressi dagli utenti

Proponiamo una prima fase progettuale finalizzata al perseguimento di specifici obiettivi conseguibili in ottica quick win su

un perimetro circoscritto di dati da definire in ottica:

- Riduzione manualità

- Riduzione tempi di elaborazione e produzione reportistica (fast close)

- Miglioramento qualità del dato

© Bip. 2013

- 21-

Interventi di Processo e sui Sistemi

Impatti Architetturali

Il miglioramento della qualità dei dati genera impatti su tutti i layer architetturali (in particolare sui

sistemi di sintesi e storage) prevedendo attività di analisi e sviluppo sulle fonti alimentanti, motori, data

storage e applicazioni di sviluppo della reportistica

Fonti

alimentanti

Schema concettuale architettura

Sistemi

Operazionali

Sistemi

Referenziali

Highlights

Altre fonti

Motori

contabili

Data

Storage

Motori di calcolo

Disaccoppiamento

applicativo

Motori

gestionali

Motori

commerciali

Motori di

rischio

Data Storage

• Analisi dati per arricchimento

set informativo

• Introduzione di controlli a

monte sui dati (controlli ex ante

nei flussi di output dei sistemi

legacy)

• Accentramento e

razionalizzazione delle

alimentazioni vs il DWH

• Definizione di un modello dati

unico integrato per tutta la

reportistica gestionale

• Introduzione controlli di qualità

dei dati sui diversi livelli di ETL

di DWH

• Evoluzione/arricchimento flussi

di alimentazione

Reporting

Disaccoppiamento

tecnologico

DM

DM

Rischio

DM

Gestionale

riconciliazioni

Commerciale

riconciliazioni

• Evoluzione attuale reportistica

CFO sulla base delle nuove

alimentazioni da DWH

• Implementazione controlli di

qualità dei dati su sistemi di

reporting (controlli ex post)

© Bip. 2013

- 22-

Interventi di Processo e sui Sistemi

Tool di Data Quality

Alcuni Clienti, per rilevare, monitorare e indirizzare le anomalie sui dati, hanno implementato un tool di

DQ in grado di centralizzare le anomalie, effettuare controlli di qualità sui dati, memorizzarne i risultati

in un database centralizzato ed elaborare report di sintesi

Schema logico

Principali caratteristiche

Sistemi in ambito

CRM

CdG

COGE

Basilea II

...

TBD

L’interfaccia con i sistemi applicativi ha il compito di

richiedere al componente Motore la lista dei controlli da

effettuare, di eseguirli sul sottosistema interessato, di

rilevare le eventuali anomalie e di inviarle al modulo Motore

per la memorizzazione accentrata

Interfaccia sistemi di sintesi

Motore controlli

Gestione

regole

Il componente Motore consente di effettuare il censimento,

la classificazione e la codifica delle regole, degli oggetti di

controllo e dei controlli che costituiscono gli elementi di

base su cui è costruito il sistema di monitoraggio della

qualità

DB anomalie

DB regole

Cruscotti

Reporting

Ipercubo

Utenti

Report

Il componente Reporting mette a disposizione dell’Utente

un set di report, suddivisi in diverse categorie (Cruscotti,

Analitici, Documentali, Operativi, Scorecard, ecc.), attraverso

i quali è possibile analizzare e comprendere rapidamente i

fenomeni relativi alla Qualità dei Dati, individuare le criticità

più rilevanti e definire le azioni da intraprendere

Il database centralizzato consente di archiviare sia le regole

di controllo che le anomalie riscontrate

La strategia di realizzazione della soluzione a regime può essere “make or buy”, di conseguenza la scelta del tool di Data

Quality richiede la valutazione dell’opportunità di un’implementazione custom a fronte della scelta di acquisire un

pacchetto software presente sul mercato

© Bip. 2013

- 23-

Luca D’Onofrio

e-mail [email protected]

tel +39 02 454 1521

cell +39 348 3959947

www.businessintegrationpartners.com

Milano

Roma

Madrid

Lisbona

Buenos Aires

Tunisi

San Paolo

Santiago