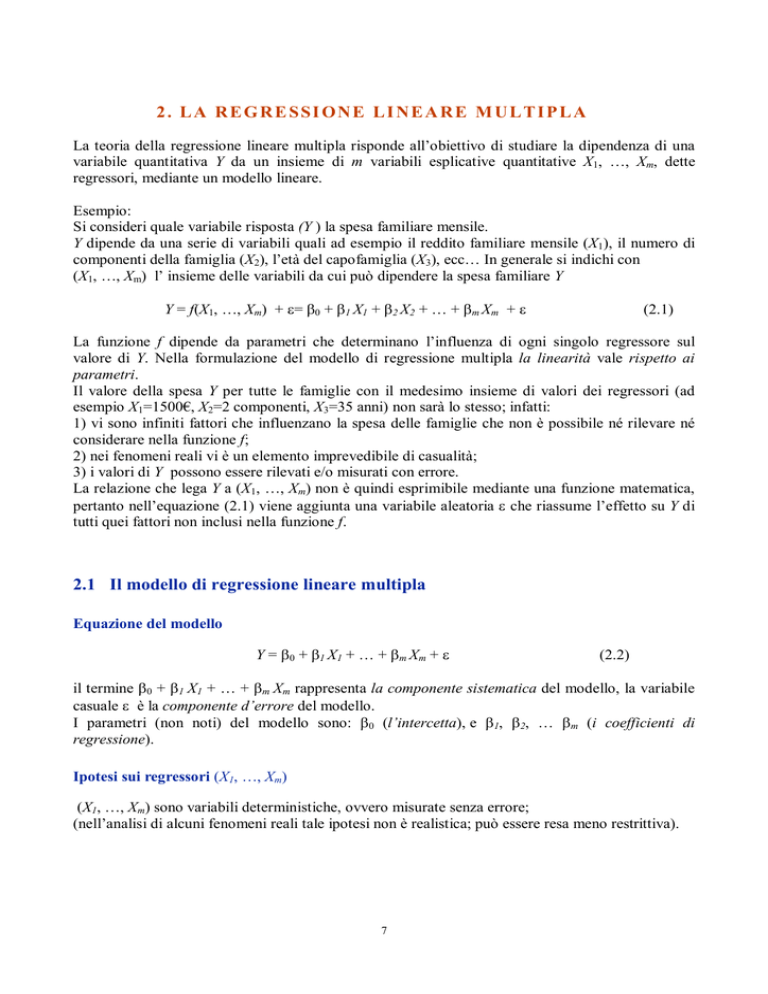

2 . L A R E G R E SSI O N E L I N E A R E M U L T I P L A

La teoria della regressione lineare multipla risponde all’obiettivo di studiare la dipendenza di una

variabile quantitativa Y da un insieme di m variabili esplicative quantitative X1, …, Xm, dette

regressori, mediante un modello lineare.

Esempio:

Si consideri quale variabile risposta (Y ) la spesa familiare mensile.

Y dipende da una serie di variabili quali ad esempio il reddito familiare mensile (X1), il numero di

componenti della famiglia (X2), l’età del capofamiglia (X3), ecc… In generale si indichi con

(X1, …, Xm) l’ insieme delle variabili da cui può dipendere la spesa familiare Y

Y = f(X1, …, Xm) + ε= β0 + β1 X1 + β2 X2 + … + βm Xm + ε

(2.1)

La funzione f dipende da parametri che determinano l’influenza di ogni singolo regressore sul

valore di Y. Nella formulazione del modello di regressione multipla la linearità vale rispetto ai

parametri.

Il valore della spesa Y per tutte le famiglie con il medesimo insieme di valori dei regressori (ad

esempio X1=1500€, X2=2 componenti, X3=35 anni) non sarà lo stesso; infatti:

1) vi sono infiniti fattori che influenzano la spesa delle famiglie che non è possibile né rilevare né

considerare nella funzione f;

2) nei fenomeni reali vi è un elemento imprevedibile di casualità;

3) i valori di Y possono essere rilevati e/o misurati con errore.

La relazione che lega Y a (X1, …, Xm) non è quindi esprimibile mediante una funzione matematica,

pertanto nell’equazione (2.1) viene aggiunta una variabile aleatoria ε che riassume l’effetto su Y di

tutti quei fattori non inclusi nella funzione f.

2.1 Il modello di regressione lineare multipla

Equazione del modello

Y = β0 + β1 X1 + … + βm Xm + ε

(2.2)

il termine β0 + β1 X1 + … + βm Xm rappresenta la componente sistematica del modello, la variabile

casuale ε è la componente d’errore del modello.

I parametri (non noti) del modello sono: β0 (l’intercetta), e β1, β2, … βm (i coefficienti di

regressione).

Ipotesi sui regressori (X1, …, Xm)

(X1, …, Xm) sono variabili deterministiche, ovvero misurate senza errore;

(nell’analisi di alcuni fenomeni reali tale ipotesi non è realistica; può essere resa meno restrittiva).

7

Ipotesi su ε

1. L’effetto su Y di tutti i fattori non rilevati e/o non rilevabili può essere positivo o negativo; e

non dipende dai valori dei regressori;

ad es.: il valore della spesa Y per le famiglie con X1=1500€ di reddito, X2=2 componenti,

X3=35 anni potrà essere per alcune di esse esattamente pari a f(X1, X2, X3), per altre inferiore,

per altre ancora superiore.

E(ε|X1, …, Xm) = E(ε) = 0

E(Y|X1, …, Xm) = β0 + β1X1 + … + βmXm

∂E(Y | X 1 , ..., X m )

= βk

∂X k

βk rappresenta la variazione attesa di Y per una variazione unitaria positiva di Xk quando gli

altri regressori restano costanti (qualunque sia il loro valore).

da cui

2. La variabilità dell’effetto di tutti i fattori non rilevati e/o non rilevabili non dipende dai

valori dei regressori;

V(ε|X1, …, Xm) = V(ε) = σ2

(ipotesi di omoschedasticità).

V(Y|X1, …, Xm) = σ2

3. Gli effetti sulla spesa Y dei fattori non rilevati per la famiglia i non dipendono da quelli

relativi alla famiglia j:

Cov (εi, εj) = 0

∀i≠j

dove εi ed εj sono il valore della variabile aleatoria per le due famiglie

(ipotesi di incorrelazione).

4. (ipotesi non essenziale al modello lineare classico, ma necessaria per la stima intervallare e

il controllo di ipotesi sui parametri)

ε ∼ N(0, σ2)

2.2 Lo stimatore dei minimi quadrati ordinari dei parametri del modello

Si suppone che il modello (2.2) valga nella popolazione oggetto di interesse. Poiché nella maggior

parte dei casi la popolazione nel suo complesso non è direttamente rilevabile, al fine di stimare i

parametri del modello (2.2) ci si deve basare sulle informazioni contenute su un campione causale

di n unità, su ciascuna delle quali vengono rilevati i valori della variabile Y e degli m regressori:

(Yi, Xi1, …, Xim)

per i = 1,…, n.

(2.3)

Se il campione viene estratto con criterio casuale semplice allora gli n vettori di variabili

dell’equazione (2.3) sono indipendenti.

Posto il modello (2.2), per la generica osservazione campionaria vale la seguente relazione:

8

Yi = β0 + β1 Xi1 + … + βm Xim + εi

(2.4)

che, formulata per ciascuna delle n unità del campione, dà luogo al seguente sistema di n equazioni

in m+1 incognite:

Y1 = β0 + β1 X11 + … + βm X1m + ε1

…

Yi = β0 + β1 Xi1 + … + βm Xim + εi

…

Yn = β0 + β1 Xn1 + … + βm Xnm + εn

Indicando con:

y il vettore n×1 dei valori della variabile dipendente per le n unità del campione;

X la matrice n×(m+1) dei valori degli m regressori per le n unità del campione. La matrice

contiene, oltre ai valori dei regressori, una colonna supplementare composta da n valori tutti pari

a 1 in corrispondenza dell’intercetta del modello.

β il vettore (m+1)×1 dei parametri del modello;

ε il vettore n×1 dei termini d’errore;

il sistema può essere riscritto in maniera compatta e semplificata nella forma di un’equazione

matriciale:

y = Xβ + ε

(2.5)

Poiché ciascuna osservazione del campione può essere interpretata come una realizzazione empirica

delle corrispondenti variabili in popolazione, le condizioni ipotizzate sui termini del modello

possono quindi essere formulate in maniera compatta rispetto ai termini dell’equazione (2.5).

1)

E(εε) = 0

vettore nullo di n elementi da cui E(y|X) = Xβ;

2+3) V(εε) = E(εε ε’)

dove In indica la matrice identità di ordine n

ε = Σ =σ2In

(ipotesi di sfericità dei termini d’errore)

da cui V(y|X) = E[(y − E(y|X))(y − E(y|X))T] = E[(y − Xβ) (y − Xβ)T] = E(εε εT) = Σ = σ2In

4)

ε ∼ NMV(0, σ2In)

da cui y|X ∼ NMV(Xβ, σ2In). Cioè i residui si distribuiscono come una normale multivariata di

parametri 0 e σ2In. Questa ipotesi non necessaria nella fase di stima puntuale riveste un ruolo

fondamentale per la stima intervallare e la verifica di ipotesi.

Oltre agli m+1 parametri incogniti presenti nell’equazione del modello dovrà essere stimato anche il

parametro σ2.

Il metodo dei minimi quadrati può essere utilizzato per stimare il vettore di parametri incogniti β.

A partire dal vettore delle stime b calcolate rispetto a un campione di n unità è possibile

determinare il vettore y* dei valori TEORICI della variabile dipendente per le n unità del campione

nell’ipotesi di perfetta dipendenza lineare tra Y e gli m regressori:

9

y* = Xb

yi* = b0 + b1 xi1 + … + bm xim

(2.6)

per i = 1, …, n.

La differenza tra gli n valori EMPIRICI ed i corrispondenti valori TEORICI di Y definisce il vettore

dei residui campionari:

e = y − y* = y − Xb

(2.7)

ei = (yi − yi*) = (yi − b0 − b1 xi1 − … − bm xim) per i = 1, …, n.

Gli n valori di ei sono n determinazioni campionarie del termine d’errore ε del modello.

Come è noto il metodo dei minimi quadrati ricerca il vettore di coefficienti b in modo da rendere

minima la somma dei quadrati degli scarti tra ordinate empiriche e ordinate teoriche, o

equivalentemente, la somma dei residui al quadrato:

Φ(b) =

n

i =1

n

( y i − y i* ) 2 =

i =1

ei2 = eT e = (y − Xb) T (y − Xb) =

= y y − b X y − y X b + bT X T X b = y Ty − 2 bT X T y + bT X T X b

T

T

T

T

(*)

Uguagliando a zero la derivata di Φ(b) calcolata rispetto al vettore di parametri incogniti

∂Φ (b)

= − 2X T y + 2X T X b = 0

∂b

e semplificando si ottiene un sistema di m+1 equazioni in m+1 incognite:

XT X b = XT y

(equazioni normali)

In forma esplicita:

n

n

n

i =1

n

n

i =1

n

xi1

...

i =1

xim

i =1

n

i =1

xi1

xi21

...

xim xi1

n

xi2

...

xi1 xi2

...

...

...

i =1

n

i =1

n

i =1

xim xi2

n

i =1

n

i =1

n

xim

xi1 xim

...

...

x

i =1

2

im

b0

b1

...

bm

i =1

n

=

i =1

n

i =1

yi

xi1 yi

...

xim yi

Nel caso particolare m = 1 si ha il modello di regressione lineare semplice.

Proprietà della matrice XTX:

1) quadrata (m+1)×(m+1);

2) simmetrica;

3) i termini sulla diagonale principale sono le somme dei quadrati dei valori delle colonne di X;

4) i termini fuori dalla diagonale principale sono i prodotti scalari tra le coppie di colonne di X.

10

Allo stesso sistema di equazioni normali si perviene rileggendo il problema da un punto di vista

geometrico. La funzione (*) che si vuole minimizzare può infatti essere interpretata come la

distanza del vettore y dal vettore Xb che, al variare di b descrive lo spazio colonna della matrice X.

Quindi minimizzare eT e equivale a trovare min d (y , Xb) .

b

Poiché la distanza di un vettore da un sottospazio è minima se si valuta la distanza del vettore dalla

sua proiezione ortogonale sul sottospazio, si tratta di trovare quel vettore b* che definisce la

proiezione ortogonale di y sullo spazio colonna di X.

Poiché il vettore y- Xb* è ortogonale a ogni vettore dello spazio colonna di X, ovvero

Xb, y − Xb * = 0 ∀ b

che equivale a scrivere

(Xb )T (y − Xb *) = 0

da cui si ricava

bT XT (y − Xb *) = 0 .

[

]

Essendo bT diverso dal vettore nullo dovrà essere

XT (y − Xb *) = 0

o equivalentemente

XT Xb* = XT y

(sistema normale)

Se XT X è invertibile il sistema ammette una sola soluzione

(

)

−1

b* = XT X XT y

(2.8)

Se le colonne di X sono linearmente dipendenti la matrice XT X è singolare e il sistema normale ha

infinite soluzioni.

Dalla prima delle m equazioni normali si ha:

b0 = y − b1 x1 − b2 x 2 − … bm x m .

da ciò si evince che il punto di coordinate (x, y ) soddisfa l’equazione di regressione. Inoltre poiché

nb0 + b1

n

i =1

xi1 + ... + bm

n

i =1

xim =

n

i =1

yi

n

dove il primo membro equivale a

i =1

y i* si ricava

n

i =1

y i* =

n

i =1

yi

da cui

n

i =1

(y

*

i

− yi ) =

n

i =1

ei = 0

ad indicare che i residui dei minimi quadrati hanno media nulla. Inoltre, per costruzione

11

X T (y − Xb ) = 0

XT e = 0

o equivalentemente

ovvero il vettore dei residui dei minimi quadrati e è ortogonale (o normale) allo spazio colonna di

T

X, da cui il nome di equazioni normali, e per la relazione (Xb ) (y − Xb *) = 0 esso è ortogonale

anche al vettore y*.

Sostituendo la (2.8) nella relazione y* = Xb che descrive le ordinate teoriche si ottiene:

(

y* = X X T X

e quindi

(

e = y − X XT X

(

)

−1

)

−1

X T y = Hy .

(2.9)

X T y = (I − H )y = My

)

−1

La matrice X X T X X T , solitamente indicata con la lettera H e denominata matrice cappello1 è la

matrice di proiezione di y sullo spazio generato dalle colonne di X. Per essa e per la corrispondente

matrice M=I-H valgono le seguenti proprietà:

H è una matrice nxn simmetrica

(

HX=X infatti X X T X

(

)

−1

M è una matrice nxn simmetrica

MX = (I − H ) X = 0 infatti IX-HX=X-X=0

XT X = X

H è idempotente HH=H2=H infatti

X XT X

)

−1

(

XT X XT X

)

−1

(

XT = X XT X

)

−1

M = (I − H ) è idempotente infatti

(I − H )(I − H ) = I − H − H + H = (I − H)

XT = H

Le matrici H e M sono inoltre fra loro ortogonali: H ⋅ (I − H) = H − H = 0

2.3 La stima dei parametri a partire dalle variabili scarto dalla media

Si considerino le variabili in forma di scarti dalla media:

1

1

~

X = X − 1n x T = X − 1 n 1Tn X = I n − 1 n1Tn X = AX

n

n

A=

1 0

0 1

0

0

1 1

1 1 1

−

n

1

1 1

~

dove X è una matrice n×m

1

1

1

1

1

Questa denominazione è mutuata dalla letteratura anglosassone in cui i valori teorici vengono indicati con ŷ . Il

simbolo ^ “hat” viene tradotto in italiano come “cappello” da cui il nome di “matrice cappello” perché è la matrice che

trasforma i valori osservati y nei valori teorici ŷ .

12

La matrice di centering A è simmetrica e idempotente A=A2

Vale in particolare:

A1 n = 0

Ae = e (dove e è il vettore dei residui OLS a media nulla)

Indicato con b il vettore delle stime OLS e con e il vettore dei residui vale y=Xb+e.

Se si opera sulla matrice X la partizione X = [x1 X 2 ] , dove x1 = 1 n , si può scrivere

y = x1b0 + X 2 b1 + e . Premoltiplicando per A si ottiene:

Ay = AX 2 b1 + e

poiché Ax1 = A1 n = 0 e Ae = e .

Premoltiplicando per X T2 si ricava:

X T2 Ay = X T2 AX 2 b 1

poiché X T2 e = 0 in quanto i residui OLS sono ortogonali alle colonne di X. Poiché A è simmetrica e

idempotente

(AX 2 )T (Ay ) = (AX 2 )T (AX 2 )b1

~

~ ~

XT ~

y = X T Xb

(2.10)

1

cioè b1 che è soluzione del sistema di equazioni normali originario è anche soluzione della (2.10).

~ ~

Inoltre poiché X T X = nS Txx è la matrice delle devianze-codevianze tra gli m regressori e

~

XT ~

y = ns è il vettore delle codevianze tra Y e gli m regressori si ha:

xy

b1 = S −xx1s xy

ns xy = nS Txx b1

Per comprendere la relazione che intercorre tra i coefficienti di un modello di regressione multiplo e

quello delle stesse variabili in altrettanti modelli di regressione semplice si consideri il seguente

semplice esempio riferito a due soli regressori espressi in forma di scarti dalla media. Siano:

S xx =

s12

s12

s12

s22

e

s yx =

s y1

sy2

da cui

b=

s12

1

s12 s22 − s122 − s12

s y1s22 − s12 s y 2

b=

− s12

s

2

2

s y1

sy 2

=

by1 − by 2b21

s12 s22 − s122

1 − b21b12

2 =

− s12 s y1 + s y 2 s1

by 2 − by1b12

2 2

2

s1 s2 − s12

1 − b21b12

13

E’ quindi facile verificare come i coefficienti di regressione nel modello multiplo siano funzione dei

coefficienti di regressione delle medesime variabili in un modello semplice, ma tengono anche

conto dell’interdipendenza tra i regressori e della dipendenza della variabile dipendente anche da

tutti gli altri regressori inclusi nel modello. Per questa ragione i coefficienti di regressione in un

modello di regressione multiplo si dicono “coefficienti di regressione parziale”. Ciascuno di essi, di

cui il generico sarà bj, esprime la variazione media della variabile dipendente, per ogni variazione

unitaria della corrispondente variabile indipendente, a parità di valori assunti rispetto agli altri

regressori nel modello. Essendo dotati di unità di misura i valori dei diversi coefficienti di

regressione non possono essere tra loro confrontati e quindi in nessun modo possono essere assunti

quali indicatori dell’importanza della componente variabile indipendente nella spiegazione della

variabilità della y.

I coefficienti di regressione del modello multiplo coincidono con quelli di altrettanti modelli

semplici qualora i regressori siano fra loro incorrelati o, in termini geometrici, qualora le colonne

della matrice X siano tra loro ortogonali.

2.4 La stima dei parametri a partire dalle variabili standardizzate

Se si considerano le variabili standardizzate, poiché la matrice di varianze e covarianze di variabili

standardizzate è la matrice di correlazione delle variabili generiche, lo stimatore dei minimi quadrati

assume la forma:

-1

b̂ = Rxx rxy

dove Rxx è la matrice delle correlazioni tra gli m regressori e rxy è il vettore delle correlazioni tra Y

e gli m regressori.

Poiché R xx = D −xx1 2 S xx D −xx1 2 e rxy = D −xx1 2 s xy

1

sy

1

1

bˆ = D1xx2 S −xx1 D1xx2 D −xx1 2 s xy

= D1xx2 S −xx1s xy

≠ b1

sy

sy

Il generico coefficiente b̂ k , misura la variazione media della variabile Y standardizzata per una

variazione unitaria positiva della variabile Xk standardizzata, quando gli altri regressori restano

costanti. I coefficienti di regressione così determinati possono essere confrontati per stabilire quali

regressori hanno un effetto maggiore su Y.

2.5 L’indice di determinazione lineare R2

La devianza totale di Y nel modello di regressione lineare multipla può essere scomposta come

segue:

Dev(Y) = DevReg(Y) + DevDisp(Y)

dove

14

(2.11)

n

Dev(Y) =

i =1

(y

−y

i

n

DevReg(Y)=

i =1

(y

n

DevDisp(Y) =

i =1

*

i

(y

)

2

è la devianza totale di Y

)

2

− y è la devianza di regressione di Y

i

− y i*

)

2

è la devianza residua o di dispersione di Y.

Indice di determinazione lineare nel modello di regressione lineare semplice

L’indice è definito come:

R2 =

DevReg 1 − DevDisp

=

Dev(Y )

Dev(Y )

(2.12)

In un modello di regressione lineare semplice la devianza di regressione risulta:

DevReg(Y) =

n

i =1

(y

*

i

− y) =

2

n

i =1

(b0 + b1 xi − b0 − b1 x )2

= b12 Dev( X ) = b1 Codev ( X , Y )

= b12

n

i =1

poiché b12 =

(xi − x )2

Codev ( X , Y ) 2

Dev( X ) 2

Quindi

b12 Dev( X ) b1Codev ( X , Y )

R =

=

Dev (Y )

Dev(Y )

2

(2.13)

Dividendo l’espressione (2.13) per (n-1):

R2 =

b1Codev ( X , Y ) (n − 1) b1 s xy

=

Dev(Y ) (n − 1)

s yy

(2.14)

sy

Inoltre poiché b1 = bˆ1

si ha:

sx

R 2 = bˆ1

s y s xy

sx sy sy

= bˆ1

s xy

sx s y

= bˆ1rxy

(2.15)

Indice di determinazione lineare nel modello di regressione lineare multiplo

Partendo dalla espressione (2.12) e osservando che in un modello di regressione lineare multiplo le

tre devianze sono definite come:

n

DevDisp(Y) =

i =1

Dev(Y)= y y − ny

T

(y

i

− y i*

)

2

=

n

i =1

ei2 = eTe

2

15

DevReg(Y)= b T (X T X )b − ny 2

(La devianza di regressione è infatti

DevReg(Y) = y T y − ny 2 − e T e = y T y − ny 2 − (y − Xb ) (y − Xb ) =

T

= y T y − ny 2 − y T y + y T Xb + b T X T y − b T X T Xb = 2b T X T y − b T X T Xb − ny 2 =

= 2b T X T (Xb + e ) − b T X T Xb − ny 2 = 2b T X T Xb + 2b T X T e − b T X T Xb − ny 2 =

= b T (X T X )b − ny 2

poiché 2b T X T e = 0 per la proprietà dei residui)

l’indice di determinazione lineare è allora

eT e

b T (X T X )b − ny 2

=

R =1− T

y y − ny 2

y T y − ny 2

Se si ragiona su variabili scarto:

2

(

)

~ ~

~

~

~

~

b T X T X b b T X T (~

b T XT ~

y

eT e

y + e) bT XT ~

y + bT XT e

R = 1 − ~T ~ =

=

= ~T ~

=

T~

T~

T~

~

~

~

y y

y y

y y

y y

y y

2

(2.16)

(2.17)

dove nella espressioni evidenziate è facile riconoscere l’analogo delle (2.13).

Se il modello è riferito a variabili standardizzate, R 2 rimane invariato

R 2 = bˆ T R xx bˆ

perché y T y = 1

= r T R −1 R bˆ = r T bˆ

xy

per esteso

xx

xx

xy

bˆ1ry1 + bˆ2 ry 2 + ... + bˆm rym

Poiché bˆ = R −xx1rxy , se le X sono incorrelate R xx = I e quindi bˆ = rxy . Pertanto per regressori

incorrelati vale

2

R 2 = rxyT rxy = ry21 + ry22 + ... + rym

(2.18)

Così in tal caso, e solo in tal caso, l’R2 del modello multiplo si può esprimere come somma degli R2

di modelli semplici.

L’indice di determinazione lineare varia fra 0 e 1 poiché 0 DevReg(Y) Dev(Y). R2 misura la

frazione della variabilità di Y dovuta alla sua dipendenza lineare dai regressori.

Presenta però alcuni inconvenienti. L’indice può assumere valori elevati anche quando la relazione

non è di tipo lineare. Inoltre R 2 cresce sempre al crescere del numero dei regressori, pertanto non è

un indicatore adeguato per il confronto tra modelli con un diverso numero di regressori. Si

considerino ad esempio due distinti modelli rispettivamente con due e un regressore:

Modello I

y j = b0 + b1 x j1 + b2 x j 2 + e j

Modello II

y j = b0 + b y1 x j1 + e j

Si vuole verificare che RI2 ≥ RII2 . Le devianze di regressione dei due modelli risultano:

16

DevReg I = b1Codev (Y , X 1 ) + b2 Codev(Y , X 2 ) =

=

ry1 − ry 2 r12 s y

1− r

2

12

s1

Codev (Y , X 1 ) +

ry 2 − ry1r12 s y

DevReg II = b y1Codev (Y , X 1 ) = ry1

1 − r122

sy

s1

s2

Codev (Y , X 2 )

Codev (Y , X 1 )

Si ottiene quindi

RI2 − RII2 =

ry1 − ry 2 r12

ry 2 − ry1r12 s y

1 sy

Codev (Y , X 1 )

− ry1 +

Codev(Y , X 2 ) =

2

2

ns y s1

1 − r12

1 − r122 s 2

ry1 − ry 2 r12 − ry1 + ry1r122

ry 2 − ry1r12 s y

1 sy

= 2

Codev (Y , X 1 )

+

Codev (Y , X 2 ) =

ns y s1

1 − r122

1 − r122 s 2

= r y1

(r

=

ry1r122 − ry 2 r12

y2

1 − r122

− ry1 r12

1 − r122

)

+ ry 2

ry 2 − ry1r12

1 − r122

=

ry21r122 + ry22 − 2ry1ry 2 r12

1 − r122

=

2

≥0

da cui RI2 − RII2 ≥ 0 .2

La scomposizione delle devianze vale anche rispetto ai corrispondenti gradi di libertà:

Dev(Y)

DevDisp(Y)

DevReg(Y)

g.d.l.

n−1

n−(m+1)

m

Dal rapporto tra le devianze ed i gradi di libertà corrispondenti si ottengono le varianze:

1) la varianza totale di Y

s 2Y = Dev(Y)/(n−1)

2) la varianza residua (o di dispersione) di Y

s 2e = DevDisp(Y)/(n−m−1) = e’e/(n−m−1)

2

Dall’ultima espressione si evince che la differenza fra i due indici è anche pari al quadrato del coefficiente di

correlazione semiparziale fra Y e X2 una volta eliminato l’effetto della variabile X1 su X2:

RI2 − RII2 =

(r

y2

− ry1 r12

1− r

2

12

)

2

= ry22|1

L’indice di correlazione semiparziale ry22|1 è nullo quando ry 2 = ry1r12 .

Dalla (2.18) si ricava inoltre:

RI2 = RII2 + ry22|1 = ry21 + ry22|1

da cui si osserva che se le variabili X1 e X2 sono incorrelate, ovvero r12 = 0 , si ritrova la scomposizione (2.18).

17

3) la varianza di regressione di Y

s 2regr = DevReg(Y)/m

2.6 Proprietà dello stimatore dei minimi quadrati ordinari

(

Lo stimatore dei minimi quadrati b = X T X

)

−1

X T y gode delle seguenti proprietà:

1) b è una funzione lineare dei valori di Y;

2) b è uno stimatore corretto di β :

{(

E (b ) = E X T X

)

−1

} {(

XT y = E XT X

)

X T (X +

−1

)}=

(

+ XT X

)

−1

XT E ( ) =

3) V(b) = σ2 (XTX)-1

{(

) X (X + )}= V { + (X X ) X }=

= 0 + (X X ) X V ( )X (X X ) = (X X ) X σ I X (X X ) = σ (X X )

V (b ) = V X T X

T

−1

)

−1

} {(

XT y = V XT X

T

T

−1

−1

T

T

T

−1

T

2

T

−1

−1

T

2

T

−1

n

I termini sulla diagonale principale di V(b) determinano le varianze degli elementi di b, quelli fuori

dalla diagonale principale ne determinano le covarianze. In particolare si è soliti indicare

V (b j ) = σ 2 c jj dove c jj è il j-esimo elemento sulla diagonale principale di (XTX)-1. Una espressione

equivalente per V (b j ) è data da

V (b j ) =

σ2

1

Dev( X j ) 1 − R 2j 0

(2.19)

dove R 2j 0 è l’indice di determinazione lineare multiplo della regressione di Xj sugli altri regressori.

Il termine 1 (1 − R 2j 0 ) è noto come VIFj, dove la sigla VIF è l’acronimo dell’espressione inglese

Variance Inflation Factor (in italiano fattore di incremento della varianza).

4) Se Y|X ∼ NMV(Xβ

β, σ2In) allora b ∼ NMV(β

β, σ2(XTX)-1)

−Markov, che con riferimento

5) Per gli stimatori dei minimi quadrati vale il Teorema di Gauss−

alle stime dei parametri di un modello di regressione lineare si può enunciare come segue: lo

stimatore dei minimi quadrati b è il più efficiente nella classe degli stimatori lineari corretti di β.

b è BLUE (Best Linear Unbiased Estimator):

* Unbiased = corretto

* Linear = lineare rispetto a Y

* Best = il più efficiente nella classe degli stimatori lineari corretti.

Dimostrazione del Teorema di Gauss-Markov

Si consideri uno stimatore lineare

18

b * = Cy + d

Affinché b * risulti corretto è necessario che E (b * ) = CE (y ) + d = C(X ) + d =

verificata se d=0 e CX=I.

(

Senza perdita di generalità si definisca una matrice D tale che C = X T X

(

CX=I impone che CX = X T X

è pertanto

{(

b * = XT X

)

−1

)

−1

)

−1

che risulta

X T + D . La condizione

X T X + DX = I + DX ovvero DX = 0 . Uno stimatore lineare per β

} {(

XT + D y = X T X

)

−1

}

X T + D (X +

)=

{(

+ XT X

)

−1

}

XT + D

Si valuti la varianza di b * :

( )

{(

V b * = V ( ) + XT X

)

−1

} ) {X(X X)

XT + D V (

−1

T

}

(

+ DT = 0 + σ 2 X T X

)

−1

+ σ 2 DD T

Essa risulta dalla somma delle varianze dello stimatore dei minimi quadrati (si veda proprietà 3) e

della quantità σ 2 DD T .

Poiché DDT è una forma quadratica semidefinita positiva V (b * ) ≥ V (b ) dove l’uguaglianza vale

solo per b * = b .

2.7 Lo stimatore del parametro σ2

Poiché la funzione Φ(β) minimizzata mediante il metodo dei minimi quadrati non dipende da σ2,

non è possibile derivare nello stesso tempo anche lo stimatore di σ2.

Poiché σ2 rappresenta la varianza del termine d’errore ε di cui conosciamo n determinazioni

campionarie {ei, i =1, …, n} è plausibile basare la stima di σ2 su una misura della variabilità dei

residui campionari.

Lo stimatore viene definito in modo da risultare corretto per σ2.

(

Considerando la (2.9) si ricava e = y − X X T X

e = M (X +

)

−1

X T y = (I − H )y = My da cui

) = MX

+M =M

poiché MX=0

Essendo M una matrice simmetrica e idempotente:

eT e =

T

M

Il valore attesto della devianza di dispersione è:

( )

E eT e = E

(

T

M ) = E (tr ( T M

19

))

poiché

T

M è uno scalare

= E (tr (M

T

)) = tr (ME ( )) = σ tr (M ⋅ I ) = σ

La traccia della matrice M risulta:

[(

trM = trI n − tr X X T X

)

−1

]

[

2

T

(

X T = trI n − tr X T X X T X

)

−1

] = trI

n

2

trM

− trI m +1 = n − (m + 1) = n − m − 1

Quindi E (e T e ) = σ 2 (n − m − 1)

Una stima corretta di σ 2 è quindi rappresentata dalla varianza di dispersione:

eT e

s e2 =

n − m −1

Il valore atteso della varianza di regressione è invece maggiore di σ2:

E(

) = mσ2 + g(β, X)

dove g(β, X) ≥ 0.

Se β1 = β2 = … = βm = 0 allora g(β, X) = 0; in tal caso anche la varianza di regressione rappresenta

uno stimatore corretto di σ2.

2.8 Controllo di ipotesi sui parametri

In questo contesto risulta necessario avvalersi dell’ipotesi di normalità (4) formulata sui residui. Da

essa discende infatti la normalità distributiva dello stimatore dei minimi quadrati e la distribuzione

delle devianze di regressione e di dispersione secondo variabili aleatorie χ 2 con m e n-m-1 gradi di

libertà rispettivamente.

1) Ipotesi di indipendenza lineare di Y dagli m regressori (ipotesi di significatività del modello):

H0: β1 = β2 = … = βm = 0

F=

s 2reg

s

2

e

=

DevReg(Y )/m

∼ Fm, (n-m-1)

DevDisp(Y )/(n-m-1)

(2.20)

Fissato un livello di significatività α, se F > Fα allora il test è significativo al livello α, e H0 va

rifiutata.

Ciò significa che:

* la variabilità di Y spiegata dal modello è significativamente più elevata della variabilità residua;

* ad almeno uno degli m regressori corrisponde in popolazione un coefficiente di regressione

significativamente diverso da 0.

20

Se invece F ≤ Fα allora il test NON è significativo al livello α, e H0 non viene rifiutata; in tal caso il

modello non è adeguato, tra Y e gli m regressori non vi è alcuna relazione di dipendenza lineare.

DevReg(Y)= R2 Dev(Y)

DevDisp(Y)= (1−R2) Dev(Y)

Poiché

si ha:

F=

R2 / m

(1 − R 2 ) / (n − m − 1)

(2.21)

2) Ipotesi di indipendenza lineare di Y da Xj (dato l’effetto degli altri m−1 regressori)

H0: βj = 0

Poiché b ∼ NMV(β

β, σ2(X’X)-1)

si ha bj ∼ N(βj, σ2cjj)

dove cjj è il j-esimo elemento della diagonale principale di (XTX)-1;

quindi z =

bj −

2

j

∼ N(0, 1).

(2.22)

c jj

Supponendo che H0 sia vera e stimando la varianza incognita con la varianza di dispersione si ha:

t=

bj

s e2 c jj

=

bj

s e c jj

∼ t(n-m-1)

Fissato un livello di significatività α, se t > +tα/2 oppure t < −tα/2 allora il test è significativo al

livello α, e H0 va rifiutata; il contributo di Xj nel modello in cui vi sono gli altri regressori è

significativo.

Come emerge dalla (2.22) il ricorso alla statistica z o, qualora σ2 sia stimata con la varianza di

dispersione, alla corrispondente statistica t, consente il controllo dell’ipotesi nulla più generale

H0: βj = k

dove k è un valore non necessariamente nullo.

Un metodo formalmente diverso, ma del tutto equivalente a quello precedentemente illustrato per il

controllo dell’ipotesi nulla di indipendenza, si basa sull’analisi della varianza . Il test dell’ipotesi

H0: βj = 0 si può infatti pensare come un confronto fra un modello a m regressori in cui il regressore

Xj è incluso:

I)

Y = β0 + β1 X1 + … + βj Xj +…+ βm Xm + ε

e un modello a m-1 regressori da cui il regressore Xj è escluso

II)

Y = β0 + β1 X1 + … + βj-1 Xj-1 + βj+1 Xj+1 +…+ βm Xm + ε

21

Per la proprietà di R2 e quindi delle devianze di regressione DevReg(Y)I DevReg(Y)II.

DevReg(Y)I - DevReg(Y)II misura dunque la riduzione nella devianza di regressione conseguente

all’esclusione del regressore Xj. E’ dunque ancora una devianza di regressione a cui corrispondono

m-(m-1)=1 gradi di libertà. L’ipotesi nulla

H0: βj = 0

può dunque essere controllata ricorrendo alla statistica test

F=

DevReg (Y ) I − DevReg (Y )II

DevDisp (Y )I (n − m − 1)

(detta test F parziale) che si distribuisce come una F con 1 e (n-m-1) gradi di libertà. (La ragione

per cui a denominatore si pone la DevDisp(Y) del modello che contiene il maggior numero di

regressori saranno chiarite nel seguito).

E’ facile verificare come questa statistica test F non sia altro che il quadrato della statistica test t

illustrata in precedenza. Il ricorso al test F parziale consente comunque il controllo di ipotesi di

indipendenza più complesse relative non solo ad un coefficiente di regressione ma ad insiemi di

coefficienti.

2.9 Intervallo di confidenza per β j

A partire dalla (2.22) e stimando σ2 con la varianza di dispersione è possibile costruire un intervallo

di confidenza per βj a un livello di confidenza dell’ 1-α. Gli estremi di tale intervallo sono:

b j ± tα 2,n.m.1 s e2 c jj

2.10 Diagnostica

Con il termine “diagnostica”, nell’ambito della regressione, ci si riferisce a un insieme di tecniche

volte all’individuazione di eventuali problemi rispetto al modello o rispetto ai dati. A questo fine

particolare rilievo assumono i residui.

L’analisi dei residui permette di:

* stabilire se le ipotesi formulate sul termine d’errore del modello di regressione sono valide

rispetto al fenomeno analizzato;

* identificare l’eventuale presenza di outlier (osservazioni anomale rispetto alla variabile

dipendente Y), punti di leverage (osservazioni anomale rispetto alle X), osservazioni influenti

(osservazioni la cui esclusione modifica le stime dei minimi quadrati).

Per la (2.9) i residui possono essere espressi come e = (I − H )y = My

Poiché i residui sono gli scarti tra i valori osservati e quelli stimati dal modello, costituiscono la

base per misurare la variabilità di Y non spiegata dal modello di regressione.

22

Inoltre, poiché sono le determinazioni campionarie della componente d’errore ε del modello,

qualunque allontanamento dalle assunzioni formulate su ε si ripercuote sui valori dei residui.

La loro somma (media aritmetica) è nulla (per le proprietà dei minimi quadrati), inoltre

Var (e) = (I − H )σ 2 (I − H ) = (I − H )σ 2

cioè i residui stimati hanno varianze diverse e sono tra loro correlati.

In particolare la varianza dell’i-esimo residuo è

V(ei) = σ2(1 − hii)

(2.23)

(

dove hii è l’i-esimo elemento della diagonale principale della matrice H = X X T X

chiamato valore di leverage:

(

hii = x i X T X

Nel modello di regressione semplice

1

hii = +

n

)

−1

)

−1

X T ed è

x Ti

(xi − x )2

n

i =1

(xi − x )2

una espressione che mostra come hii sia una misura della distanza dell’ascissa dell’unità i-esima dal

baricentro della X.

Inoltre dalla (2.23) si deduce che unità con hii elevato avranno valori piccoli per V(ei).

All’avvicinarsi di hii a 1 la varianza dei residui tenderà a 0. Per tali osservazioni, indipendentemente

dal valore che l’unità assume rispetto alla Y si è certi di avere un residuo nullo. Le osservazioni cui

corrisponde un hii ≥ 2(m+1)/n vengono riconosciuti come punti di leverage.

Poiché hii non coinvolge la Y non è detto che una unità a cui corrisponde un valore hii elevato sia un

dato anomalo rispetto al modello di regressione. D’altra parte, se l’obiettivo è l’identificazione di

dati anomali l’esame dei soli residui non è sufficiente.

Per tenere conto congiuntamente dei residui e della loro variabilità è opportuno riscalare i residui

dividendoli per una stima del loro scarto quadratico medio. Si ottengono così i residui studentizzati

internamente:

ri =

ei

i = 1, …, n

s e ( 1 − hii )

Gli ri sono detti residui studentizzati internamente perché σ è stimato con s e , la radice della

varianza di dispersione calcolata su tutte le unità statistiche.

La media aritmetica dei residui studentizzati è nulla e la loro varianza è 1, ma sono ancora

moderatamente correlati. Una eventuale osservazione anomala influenzerà inevitabilmente la

varianza di dispersione e quindi anche i residui studentizzati internamente. Per ovviare a ciò alcuni

autori suggeriscono di stimare la varianza del residuo i-esimo omettendo l’i-esima unità statistica

dal calcolo della varianza di dispersione. Si ottengono cosi i residui studentizzati esternamente:

ti =

ei

i = 1, …, n

s e (i ) ( 1 − hii )

23

dove s e (i ) indica che, nel calcolo della varianza di dispersione, l’i-esima osservazione è stata

esclusa. Le osservazioni per cui |ti|≥ 2 rappresentano potenziali outlier.

Osservazioni influenti

Se un valore di yi è particolarmente inusuale rispetto a tutti gli altri allora la stima del modello di

regressione può essere notevolmente influenzata da tale osservazione. Per valutare la presenza di

valori influenti si elimina una osservazione alla volta e si stima nuovamente il modello. Quelle

osservazioni che producono variazioni rilevanti sono dette influenti.

Si indichi con b(i) la stima OLS di β ottenuta omettendo l’i-esima unità. Una possibile misura di

influenza è rappresentata dalla distanza di Cook secondo la quale la distanza fra b(i) e b è data da

Di =

(b

(

)

− b ) XT X (b(i) − b )

T

(i)

i = 1, …, n

(m + 1) se2

Essendo Xb(i) – Xb= y*(i) − y* la distanza di Cook può essere anche formulata come:

(y

Di =

*

(i )

− y*

) (y

T

*

(i )

2

e

(m + 1) s

− y*

)

Si dimostra che Di si può anche scrivere in modo alternativo come:

ri 2

hii

i = 1, …, n;

Di =

(m + 1) (1 − hii )

è quindi composta da una componente che misura l’adattamento (in quanto funzione dei residui) e

da una componente che misura la distanza delle X dal baricentro (essendo una misura del livello di

leverage dell’i-esima osservazione). Si distribuisce come una F con m+1 e n-m-1 gradi di libertà.

Le unità per cui Di > 1 sono potenziali osservazioni influenti.

2.11 La multicollinearità

Vi è multicollinearità nei dati quando si presentano relazioni lineari tra i regressori.

Esempi (m = 2):

1) regressori incorrelati e ortogonali

1 0

~ ~

~ ~

XT X =

XT X

0 1

(

)

−1

=

1 0

0 1

2) regressori correlati

24

(

)

~ ~

det X T X =1

~ ~

XT X =

3) regressori correlati

~ ~

XT X =

1 0,9

0,9 1

1

0,99

0,99

1

(X~ X~ )

T

−1

=

5,26 − 4,74

− 4,74

5,26

(X~ X~ )

T

−1

=

(

)

~ ~

det X T X = 0,19

50 − 49,5

− 49,5

50

(

)

~ ~

det X T X = 0,02

Effetti della presenza di correlazione (e quindi di multicollinearità) tra i regressori:

poiché V(b) = σ2(XTX)-1 le varianze degli stimatori crescono al crescere della multicollinearità;

cala la precisione delle stime puntuali;

gli intervalli di confidenza si allargano;

crescono le covarianze campionarie tra gli stimatori;

i test t tendono a segnalare coefficienti non significativi anche con valori elevati di R2.

Inoltre le stime b sono molto sensibili a variazioni anche molto piccole dei valori osservati di Y e/o

dei regressori.

Tra gli m regressori vi è multicollinearità esatta se le colonne di X sono linearmente dipendenti,

ovvero se esiste una loro combinazione lineare non banale che dà il vettore nullo:

c1X1 + c2X2 + …+ cmXm = 0

con almeno uno dei ck ≠ 0.

Tra gli m regressori vi è multicollinearità se esiste una combinazione lineare non banale delle

colonne di X la cui norma è un numero “piccolo”:

c1X1 + c2X2 + …+ cmXm = d

dove c = c12 + c22 + ... + c m2 .

con d < q c

In base al valore di q = d / c è possibile definire il “grado” di multicollinearità.

Cause della multicollinearità

1) Errata specificazione del modello

2) Multicollinearità inerenti alla popolazione

3) Multicollinearità inerenti al campione

Diagnosi della multicollinearità

Sulla base della correlazione esistente fra i regressori è possibile definire diverse misure di

multicollinearità.

1) L’indice di determinazione lineare Rk20 del modello di regressione in cui Xk dipende dagli altri

m−1 regressori.

Rk20 > 0,9 segnalano la presenza di possibili relazioni di multicollinearità.

25

1

1 − Rk20

VIFk > 10 segnalano la presenza di possibili relazioni di multicollinearità.

2) I fattori di incremento della varianza VIFk =

3) Tolleranza

Tk = 1/VIFk = 1 − Rk20

La correlazione tuttavia è una condizione sufficiente ma non necessaria alla multicollinearità. Per

strumenti di diagnosi della multicollinearità più completi si rimanda ad altri appunti.

2.12 Lo stimatore dei minimi quadrati generalizzati

Tra le ipotesi classiche formulate per il modello di regressione lineare multipla vi è quella di

sfericità dei termini d’errore:

V(ε) = E(ε εT) = Σ = σ2In.

Vi sono situazioni in cui tale ipotesi può non essere vera.

Esempi.

1) Con dati regionali di tipo cross-section, i valori di Y relativi a regioni geograficamente vicine

sono correlati condizionatamente ai regressori; in tal caso si ha:

Cov (εi, εj) ≠ 0

∀ i ≠ j.

2) Con dati microeconomici sulle famiglie, la variabilità di Y intorno alla media condizionata può

cambiare al variare dei regressori; in tal caso si ha:

Var(εi) ≠ Var(εj)

∀ i ≠ j.

La matrice delle varianze e delle covarianze dei termini d’errore non è più diagonale, e gli elementi

della diagonale possono essere diversi:

V(ε) = E(ε εT) = Σ = σ2V.

Conseguenze sulle proprietà dello stimatore dei minimi quadrati ordinari

y = Xβ + ε

(2.24)

bOLS = (XTX)-1XT y

(2.25)

dove E(ε) = 0 V(ε)= σ2V

E(bOLS)= β;

26

V(bOLS) = σ2(XTX)-1XT V X(XTX)-1

bOLS è ancora uno stimatore corretto di β ma non è più lo stimatore a minima varianza. Poiché le

procedure di stima intervallare e controllo di ipotesi basate sullo stimatore dei minimi quadrati

ordinari bOLS sono derivate in ipotesi di omoschedasticità e indipendenza quando queste condizioni

vengono a cadere esse risultano inadeguate.

Come conseguenza del teorema spettrale, poiché V è una matrice non singolare, simmetrica e

definita positiva, esiste una matrice K non singolare n×n tale che KTK = KK = V V-1 = K-1K-1

K-1y = K-1Xβ + K-1ε

Premoltiplichiamo la (2.24) per K-1:

Se poniamo Z=K-1y;

F=K-1X;

η=K-1ε

(2.26)

la (2.26) può essere riscritta:

Z = Fβ + η

(2.27)

La (2.27) è l’equazione matriciale di un modello di regressione, funzione dei parametri β, rispetto al

quale valgono le seguenti condizioni

E(η) = 0

V(η)= σ2In

che giustificano il ricorso al metodo dei minimi quadrati.

Lo stimatore corretto e a minima varianza di β è quello che rende minima la devianza di dispersione

del modello (2.27):

Φ(β) = ηTη = (Z − Fβ )T (Z − Fβ )

bGLS= (FTF)-1FTZ = (XT K-1 T K-1X)-1XT K-1 T K-1y = (XT V-1X)-1XT V-1y

bGLS è lo stimatore dei minimi quadrati generalizzati.

E(bGLS) = β

V(bGLS) = σ2(XT V-1X)-1

2.13 Criteri per la scelta dei regressori

Specificazione del modello

La scelta dei regressori da includere nel modello rappresenta una fase cruciale nell’analisi della

regressione multipla.

In fase di costruzione del modello, si possono commettere due tipi di errori (errori di specificazione

del modello):

1) omissione di regressori rilevanti;

2) inclusione di regressori irrilevanti.

27

Si ipotizzi che, in popolazione, gli m regressori considerati siano tutti e soli i regressori che danno

un contributo significativo alla spiegazione della variabilità della Y. Il modello completo (m

regressori) è allora:

y = Xβ + ε = Xpβp + Xm-pβm-p + ε

(2.28)

dove la matrice X n×(m+1) è stata scomposta in Xp n×(p+1) e Xm-p n×(m-p):

X=

Xp

X m− p

Questa partizione nella matrice dei regressori genera una analoga partizione nei coefficienti di

regressione β e nel vettore delle stime b dei minimi quadrati:

bp

p

b=

=

b m− p

m− p

Si ipotizzi poi di rilevare soltanto p di tali m regressori e di avere omesso erroneamente i restanti

k=m-p. Si definisce così un modello ridotto (p < m regressori):

y = Xpβp + ξ

(2.29)

rispetto al quale lo stimatore dei minimi quadrati è:

stimatore di βp

bp* = (XpTXp)-1XpTy

Tuttavia:

E(bp*) = E[(XpTXp)-1XpTy] = E[(XpTXp)-1XpT(Xpβp + Xkβk + ε)] =

= E[(XpTXp)-1XpTXpβp] + E[(XpTXp)-1XpTXkβk]= βp + (XpTXp)-1XpTXkβk

Pertanto bp* è uno stimatore di βp distorto a meno che non sia XpTXk = 0 e/o βk = 0. La distorsione è

una combinazione lineare delle variabili escluse e dei coefficienti veri.

Inoltre

E (DevDisp (n − p − 1)) ≠ σ 2

Infatti, se il modello stimato è

y = Xpbp + e

sarà

(

e = (y − X p b p ) = y − X p X Tp X p

(

(

= I − X p X Tp X p

)

−1

)

)

−1

X Tp y =

X Tp y = (I − H p )y = M p y

La devianza di dispersione è

DevDisp = e T e = y T M p y

poiché Mp è idempotente.

Ma y = X p p + X k k + e quindi

28

DevDisp = (X p

=

[

T

p

p

+ Xk

)

+

k

X Tp M p + (X k

T

k

M p (X p

p

+ Xk

)T M p ](X p

+

p

)

+

k

+ Xk

k

)

+

da cui, considerando che X Tp M p = 0 e M p X p = 0 per le proprietà della matrice M p

DevDisp = (X k

=

T

k

X Tk M p X k

k

k

+

)T M p (X k

+2

T

k

k

X Tk M p +

+

T

)=

T

k

X Tk M p X k

k

+

T

M p Xk

k

+

T

k

X Tk M p +

T

p

p

Calcolandone il valore atteso:

E (DevDisp ) =

T

k

X Tk M p X k

k

+ 0 + σ 2 (n − p − 1)

Quindi

DevDisp

E

=

n − p −1

T

k

X Tk M p X k

n − p −1

k

+σ 2 ≠ σ 2

La matrice Mp è semidefinita positiva e quindi la distorsione introdotta nella varianza è positiva.

Nel modello ridotto la varianza di Y viene quindi sovrastimata dalla varianza di dispersione. (Ecco

perché a denominatore del test F si mette la devianza di dispersione del modello completo).

Risultano verificate tutte le procedure inferenziali, in particolare il test t e il test F.

Se invece il modello “vero” in popolazione è il modello ridotto (2.29) a p variabili e si includono le

restanti m-p che sono irrilevanti, naturalmente, per quanto appena visto, sia le stime dei minimi

quadrati, sia la stima di σ2 attraverso la varianza di dispersione risultano corrette. Tuttavia:

1

1

nel modello (2.28)

Var(bj)= σ2

dev(X j ) 1 − R 2j 0

Var(bj*) = σ2

1

1

dev(X j ) 1 − R 2j0*

R 2j 0 ≥ R 2j 0*

nel modello (2.29)

1 − R 2j 0 ≤ 1 − R 2j 0 *

1

1

≥

2

1 − R j0

1 − R 2j 0*

Var(bj) ≥ Var(bj*)

cioè le stime dei parametri βp ottenute col modello (2.28) sono più variabili di quelle ottenute col

modello (2.29).

Criteri per il confronto tra modelli alternativi

R2 misura la bontà dell’adattamento del modello ai dati.

In precedenza si è dimostrato che aggiungendo regressori nel modello il valore di R2 aumenta;

l’andamento dei valori di R2 al crescere di m è quindi monotono crescente. L’aumento del numero

di regressori nel modello induce cioè un progressivo aumento della quota di variabilità di Y spiegata

dal modello lineare.

29

Può capitare però, come si è visto, che a questo si accompagni un peggioramento della precisione

delle stime.

Pertanto R2 non è un indicatore adeguato per confrontare modelli con un diverso numero di

regressori. Nel caso di indipendenza lineare di Y dagli m regressori (cioè quando vale H0: β1 = β2 =

… = βm = 0) sia la varianza di regressione di Y che quella totale sono stime corrette di σ2.

E

DevReg(Y)/m

≅1

DevTot(Y)/(n − 1 )

n − 1 DevReg(Y)

≅1

E

m

DevTot(Y)

E(R2) ≅

m

n −1

mentre ci si aspetterebbe che E(R2) fosse uguale a 0. Si può allora correggere l’R2

R2c = R2 −

m

n −1

Tuttavia nel caso di perfetta dipendenza lineare di Y dagli m regressori si avrà ora:

R2 c = 1 −

m

n − m −1

=

<1

n −1

n −1

che dovrà essere nuovamente corretto per far sì che assuma valori nell’intervallo [0,1]:

R2cc = R2c

m

n −1

n −1

= R2 −

n − m −1

n −1 n − m −1

s e2

.

sY2

Questo indicatore non ha, diversamente da R2, un andamento monotono crescente all’aumentare del

numero di regressori e quindi può utilmente essere impiegato per il confronto di modelli che

contengono un numero diverso di regressori.

Sviluppando il prodotto e semplificando si ha R2cc = 1 −

Criteri automatici per la scelta dei regressori

Con questi criteri viene esaminato un numero ridotto di sottoinsiemi di possibili variabili

esplicative, in base ad un procedimento di scelta sequenziale in cui i singoli regressori sono

progressivamente aggiunti o eliminati dal modello.

1) Forward selection.

2) Backward elimination.

3) Stepwise.

30

Forward selection

I singoli regressori vengono aggiunti in maniera sequenziale al modello.

Punto di partenza:

Y = β0 + ε

Passo 1.

Viene scelto quel regressore che, qualora venga inserito nel modello specificato inizialmente,

determina il più elevato aumento di R2, ovvero la più elevata diminuzione di DevDisp(Y); sarà il

regressore con la più alta correlazione semplice con Y. Poniamo che sia X1.

X1 verrà inserito nel modello specificato inizialmente solo se il suo contributo originale alla

spiegazione della variabilità di Y è significativo; ovvero se l’ipotesi H0: β1 = 0 viene rifiutata

mediante il test

b1

t=

∼ t(n-2)

(2.30)

n

i =1

(y i − y *i )2

(n − 2 )dev(X 1 )

per un prefissato livello di significatività αin.

Se il test è significativo e l’ipotesi viene rifiutata, allora X1 viene inserito nel modello:

Y = β0 + β1X1 + ε.

Viceversa il processo di selezione ha termine. Se la variabile che dà luogo al valore di R2 più

elevato non merita di entrare nel modello nessun’altra può.

Passo 2.

Se X1 entra nel modello viene poi scelto un nuovo regressore: quello che, se inserito nel modello

specificato al termine del passo 1, determina il più elevato aumento di R2, ovvero la più elevata

diminuzione di DevDisp(Y). Poniamo che sia X2.

X2 verrà inserito nel modello specificato al termine del passo 1 solo se il suo contributo originale

alla spiegazione della variabilità di Y è significativo, cioè se la statistica test t per saggiare l’ipotesi

H0: β2 = 0 risulta significativa. In tal caso X2 viene inserito nel modello:

Y = β0 + β1X1 + β2X2 + ε.

In generale:

dato un modello con i−1 regressori, l’i-esimo regressore candidato ad entrare nel modello verrà

inserito se risulta significativo il test t per il controllo dell’ipotesi H0: βi = 0 nel modello di

regressione multipla.

La procedura si arresta quando per la prima volta si ottiene un test NON significativo, oppure

quando tutte le variabili esplicative sono state inserite nel modello. Una volta inserita nel modello,

una variabile vi rimane per sempre anche se, in seguito all’ingresso di ulteriori regressori il suo

coefficiente risulta non significativamente diverso da 0.

Il metodo forward non è rigoroso dal punto di vista metodologico perché i modelli che vengono

costruiti ai vari passi risentono dell’errore di errata specificazione in termini di esclusione di

regressori rilevanti, ma presenta il vantaggio di consentire la selezione di regressori in quelle

31

situazioni in cui il numero delle variabili osservate è maggiore del numero delle unità e le stime dei

minimi quadrati del modello completo non esistono.

Backward elimination

I singoli regressori vengono eliminati in maniera sequenziale dal modello.

Punto di partenza:

Y = β0 + β1X1 + β2X2 + … + βmXm +ε

Passo 1.

Viene scelto quel regressore che, qualora venga eliminato dal modello specificato inizialmente,

determina la più piccola diminuzione di R2, ovvero il più piccolo aumento di DevDisp(Y). Poniamo

che sia X1.

X1 verrà eliminato dal modello specificato inizialmente solo se il suo contributo originale alla

spiegazione della variabilità di Y è NON significativo; ovvero se il test t per saggiare H0: β1 = 0 nel

modello completo è non significativo per un prefissato livello di significatività αout.

Il modello diventa allora

Y = β0 + β2X2 + … + βmXm +ε

e si ripete il passo 1.

In generale: dato un modello con m–i regressori, il successivo regressore candidato ad uscire dal

modello verrà eliminato se il suo coefficiente non risulta significativamente diverso da 0.

La procedura si arresta quando per la prima volta si ottiene un test SIGNIFICATIVO, oppure

quando tutte le variabili esplicative sono state eliminate dal modello.

Una volta esclusa dal modello , una variabile non vi può più rientrare. Per rendere più dinamico il

processo di ingresso e di uscita dei regressori dal modello è stato proposto il metodo stepwise

convenzionale.

Stepwise

I passi 1 e 2 coincidono con quelli della forward selection:

Y = β0 + β1X1 + β2X2 + ε.

Prima del terzo passo forward viene realizzato un passo backward rispetto alla variabile X1 inserita

nel modello al passo 1, con cui si controlla mediante il test se l’eliminazione di X1 dal modello

contenente X2 induce un aumento non significativo della devianza di dispersione.

In generale, dopo ogni inserimento nel modello del regressore che induce la più elevata

diminuzione significativa della devianza di dispersione (al livello di significatività αin), tutti i

regressori inclusi nel modello ai passi precedenti vengono considerati, uno alla volta, come

candidati alla rimozione.

La procedura si arresta quando nessun regressore escluso può essere inserito (in base al valore di

αin) e nessun regressore incluso può essere eliminato (in base al valore di αout).

32

Con questo criterio la decisione di includere un regressore non è irreversibile. Una variabile già

inclusa può essere rimossa in seguito all’inserimento di altri regressori che rendono non più

significativo il suo contributo originale alla spiegazione della Y.

Osservazioni sulla scelta dei valori αin e αout.

1) Se si sceglie αin>αout, un regressore inserito nel modello in base al valore di αin verrà

probabilmente eliminato in seguito.

2) Se si sceglie αin<αout, un regressore inserito nel modello in base al valore di αin probabilmente

non verrà più eliminato.

Conviene scegliere αin = αout, maggiori degli usuali livelli di significatività.

E’ opportuno sottolineare come i modelli di regressione costruiti mediante i metodi di selezione

automatici appena illustrati non rappresentino i migliori modelli in senso assoluto. Essi sono i

migliori modelli che si possono costruire dati i diversi passi che sono stati compiuti. Questo

significa che piccole perturbazioni nei dati possono portare a modelli sensibilmente diversi e che

eventuali “errori ” di selezione nelle fasi iniziali si ripercuotono sul modello complessivo.

33