POLITECNICO DI TORINO

III Facoltà di Ingegneria

Corso di Laurea Specialistica in Ingegneria Informatica

Tesi di Laurea Specialistica

Individuazione di situazioni di rischio

in dati clinici rilevati da sensori

Relatrice

Prof.ssa Elena Baralis

Candidati

Daniele Apiletti

Giulia Bruno

Settembre 2005

Desideriamo ringraziare

Tania, per l’aiuto e la disponibilità

e Raffaele, per il prezioso supporto medico.

Indice

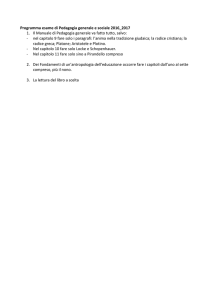

CAPITOLO 1 – INTRODUZIONE .........................................................................1

CAPITOLO 2 – ANALISI DI DATI CLINICI ..........................................................3

2.1 Esigenze delle persone anziane ..................................................................3

2.2 Apparecchiature per la misura dei segnali fisiologici..............................4

2.2.1 Battito cardiaco .....................................................................................4

2.2.2 Pressione arteriosa.................................................................................5

2.2.3 Saturazione di ossigeno.........................................................................6

2.3 Progetti .........................................................................................................7

2.4 Discussione .................................................................................................11

CAPITOLO 3 – TECNICHE DI ANALISI DEI DATI..............................................12

3.1 Introduzione ..............................................................................................12

3.2 Data mining e knowledge discovery ........................................................13

3.3 Applicazioni di data mining .....................................................................15

3.4 Fasi del processo di data mining..............................................................15

3.4.1 Preparazione dei dati ...........................................................................15

3.4.2 Data mining.........................................................................................18

3.4.3 Visualizzazione, interpretazione e previsione.....................................18

3.5 Data mining ...............................................................................................18

3.5.1 Funzionalità di data mining.................................................................19

3.6 Clustering...................................................................................................23

3.6.1 Descrizione generale ...........................................................................23

3.6.2 Misure di distanza ...............................................................................24

3.6.3 Principali metodi di clustering ............................................................25

3.7 Sequenze temporali ...................................................................................31

3.8 Discussione .................................................................................................31

3.8.1 Scelta della funzionalità di data mining ..............................................31

3.8.2 Scelta dell’algoritmo di clustering ......................................................33

CAPITOLO 4 – IGUANA – IDEA .....................................................................35

4.1 Introduzione ..............................................................................................35

Indice

4.2 Creazione del modello...............................................................................37

4.2.1 Evoluzione ..........................................................................................37

4.2.2 Funzione di rischio..............................................................................38

4.2.3 Ipotesi sulla frequenza.........................................................................42

4.2.4 Clustering ............................................................................................43

4.3 Classificazione ...........................................................................................43

4.4 Rischio totale .............................................................................................47

CAPITOLO 5 – IGUANA – IMPLEMENTAZIONE ............................................49

5.1 Introduzione ..............................................................................................49

5.2 Introduzione a R........................................................................................49

5.3 Main............................................................................................................52

5.4 Lettura dei dati..........................................................................................53

5.5 Pre-elaborazione dei dati..........................................................................54

5.6 Calcolo della media mobile.......................................................................57

5.7 Creazione del modello...............................................................................60

5.7.1 Modello 1 ............................................................................................60

5.7.2 Modello 2 ............................................................................................61

5.7.3 Modello 3 ............................................................................................63

5.8 Classificazione dei dati..............................................................................64

5.8.1 Classificatore 1....................................................................................65

5.8.2 Classificatore 2....................................................................................67

5.8.3 Classificatore 3....................................................................................71

CAPITOLO 6 – BASI DI DATI MEDICHE ...........................................................75

6.1 Introduzione ..............................................................................................75

6.2 La base di dati MIMIC .............................................................................76

6.2.1 Research Resource for Complex Physiologic Signals ........................76

6.2.2 Descrizione..........................................................................................78

6.2.3 Scelta dei dati ......................................................................................79

6.3 La base di dati Fantasia............................................................................81

6.4 Pre-elaborazione dei dati..........................................................................82

6.4.1 PhysioToolkit ......................................................................................82

6.4.2 Conversione di formato.......................................................................83

6.4.3 Elaborazione........................................................................................85

Indice

CAPITOLO 7 – ANALISI DEI RISULTATI ..........................................................94

7.1 Introduzione ..............................................................................................94

7.2 Modelli generati con IGUANA per MIMIC ...........................................95

7.2.1 Pazienti scelti ......................................................................................95

7.2.2 Parametri impostati .............................................................................97

7.3 Modello generato con IGUANA per Fantasia ........................................99

7.4 Esperimenti con MIMIC ........................................................................100

7.4.1 Campione di pazienti ........................................................................101

7.4.2 Numero di cluster..............................................................................107

7.4.3 Ampiezza della sliding window ........................................................113

7.4.4 Frequenza di campionamento ...........................................................116

7.4.5 Soglie di normalità ............................................................................119

7.4.6 Algoritmo di clustering .....................................................................124

7.4.7 Distanza inter-cluster ........................................................................134

7.4.8 Pesi ....................................................................................................141

7.4.9 Livelli di rischio ................................................................................152

7.5 Esperimenti con Fantasia .......................................................................158

7.5.1 Confronto tra pazienti sani ................................................................158

7.5.2 Confronto tra pazienti in diverso stato di salute................................161

7.6 Prestazioni del classificatore ..................................................................164

7.6.1 Risorse di calcolo ..............................................................................164

7.6.2 Risorse di memoria ...........................................................................166

7.7 Commenti generali ..................................................................................168

CAPITOLO 8 – CONCLUSIONI .......................................................................169

8.1 Obiettivi raggiunti...................................................................................169

8.2 Sviluppi futuri .........................................................................................170

8.2.1 Studio delle correlazioni ...................................................................170

8.2.2 Funzione di rischio totale ..................................................................171

8.2.3 Macchina a stati.................................................................................171

8.2.4 Frequenza di misurazione .................................................................171

8.2.5 Creazione del modello bilanciata ......................................................171

INDICE DELLE FIGURE ...................................................................................... 172

INDICE DELLE TABELLE .................................................................................... 175

BIBLIOGRAFIA................................................................................................... 176

Capitolo 1

Introduzione

Un insieme relativamente vasto di persone è affetto da patologie o presenta

disturbi di coscienza tali da non poter formulare richieste di aiuto al di fuori di contesti

perimetralmente definiti. Spesso l’assistenza permanente o il ricovero in ospedale non

sono indispensabili, ma richiesti ugualmente dal paziente per avere un soccorso

immediato in caso di necessità (ad esempio un malore improvviso o un’alterazione

pericolosa di valori fisiologici).

Grazie ai recenti sviluppi tecnologici nell’area delle reti di sensori è possibile

monitorare continuamente i segnali fisiologici dei soggetti sotto osservazione,

indipendentemente dalle attività da loro svolte e dai luoghi in cui si trovano. Diversi

segnali vitali possono essere rilevati attraverso una piccola rete di sensori, integrati in

oggetti poco invasivi come orologi o bracciali, distribuiti sul corpo umano. In caso di

malessere o di alterazione significativa di uno o più segnali vitali, è possibile

identificare una situazione di rischio e richiedere un intervento adeguato. Recentemente

si stanno sviluppando progetti per realizzare sia dispositivi tecnologici adatti alla

raccolta e alla ritrasmissione dei dati, sia algoritmi per il trattamento dei dati misurati e

la loro interpretazione, allo scopo di individuare situazioni di rischio in tempo reale e

inviare immediatamente in modo automatico richieste di aiuto. La nostra tesi si

concentra su questo secondo punto.

L’obiettivo che ci siamo prefissati riguarda la definizione e la realizzazione di

algoritmi di analisi dei dati volti alla caratterizzazione e all’individuazione tempestiva di

situazioni rischiose a partire dai flussi di dati inviati dai sensori.

Ci siamo concentrati sull’analisi di situazioni di emergenza e abbiamo

considerato solo flussi di dati relativi a segnali fisiologici vitali. Tali segnali devono

permettere di riconoscere gravi alterazioni dello stato di salute del paziente e devono

poter essere misurati tramite sensori indossabili e non invasivi, senza limitare i

movimenti dei pazienti ad un ambiente chiuso, per considerare anche le situazioni di

rischio all’esterno dell’abitazione. Abbiamo scelto di considerare i segnali di battito

cardiaco, pressione arteriosa sistolica e diastolica, saturazione arteriosa di ossigeno.

Abbiamo studiato un algoritmo di classificazione in grado di riconoscere il

profilo di una situazione a rischio per il paziente, a partire dai dati rilevati dai sensori e

valutati entro appropriate finestre temporali. Ad ogni profilo può essere associato, se

1

Capitolo 1 - Introduzione

necessario, un particolare soccorso o intervento richiesto automaticamente al centro

medico più vicino. Un aspetto innovativo del classificatore, che sarà installato a bordo

di un dispositivo mobile alimentato a batterie, sarà il contenimento del suo consumo

energetico.

Analizzando l’andamento dei segnali fisiologici di persone anziane, abbiamo

ideato una funzione di calcolo del rischio del paziente ad ogni istante. Attraverso

tecniche di clustering abbiamo diviso i valori del rischio in classi corrispondenti a

diversi livelli di pericolosità, dalla normalità all’emergenza, in modo che ad ogni istante

il paziente si trovi in una determinata classe. Le classi con livello di rischio più elevato

possono avere associato un allarme da inviare al medico o all’ospedale.

Abbiamo realizzato un prototipo in grado di creare un modello e di utilizzarlo

per classificare i nuovi dati. Per mantenere una maggiore flessibilità abbiamo introdotto

alcuni parametri e abbiamo confrontato i risultati ottenuti variandone uno per volta.

Il documento è organizzato nel modo seguente.

Nel Capitolo 2 presentiamo lo stato dell’arte della ricerca ad oggi, in particolare

le apparecchiature esistenti da poter utilizzare per le misure di pressione arteriosa,

battito cardiaco e saturazione di ossigeno e i progetti in corso o previsti, con relativi

pregi e difetti. Infine discutiamo brevemente le differenze di tali progetti dal nostro

approccio e le motivazioni che ci hanno portato a svilupparlo.

Nel Capitolo 3 forniamo una panoramica sul data mining, spiegando le fasi che

caratterizzano questo processo. Ci concentriamo principalmente sulle tecniche di

clustering, che abbiamo deciso di utilizzare, ritenendole migliori per la risoluzione del

nostro problema.

Nel Capitolo 4 illustriamo il nostro framework, denominato IGUANA

(Individuation of Global Unsafe ANomalies and activation of Alarms), spiegando i

concetti fondamentali. Descriviamo il funzionamento generale e i meccanismi di

interazione tra i vari moduli, in modo indipendente dall’implementazione sottostante. In

particolare motiviamo la funzione di calcolo del rischio che abbiamo ideato, illustriamo

la fase di creazione del modello e quella della sua applicazione in tempo reale ai nuovi

dati rilevati dai sensori.

Nel Capitolo 5 ci soffermiamo sui dettagli implementativi del prototipo di

IGUANA. Descriviamo la struttura del programma, che abbiamo scritto in R, riportando

le parti di codice più significative.

Nel Capitolo 6 descriviamo i dati analizzati, che abbiamo prelevato da database

disponibili in Internet, data l’enorme difficoltà di reperirli in forma diretta. In questo

capitolo descriviamo anche la fase di pre-elaborazione dei dati, perché concettualmente

è più inerente ad essi che all’algoritmo di analisi.

Nel Capitolo 7 analizziamo i risultati ottenuti e il diverso comportamento

dell’algoritmo al variare dei parametri impostabili. Assegniamo di volta in volta un

valore diverso ad ogni parametro, riportiamo i grafici relativi in modo da visualizzare i

diversi risultati, e motiviamo le nostre scelte dove necessario.

Nel Capitolo 8, infine, riportiamo le conclusioni e le idee per eventuali sviluppi

futuri.

2

Capitolo 2

Analisi di dati clinici

2.1 Esigenze delle persone anziane

La salute e la qualità della vita degli anziani costituiscono un tema di grande

rilevanza che ancora non si riflette appieno nell’azione dei servizi di prevenzione.

La popolazione italiana ha subito un progressivo invecchiamento nel corso degli

ultimi decenni (circa il 18% ha un’età superiore ai 65 anni1), dovuto ai profondi

mutamenti demografici derivati dal calo della natalità e dalla consistente riduzione della

mortalità. Spesso però all’allungamento della vita non corrisponde un effettivo

miglioramento della sua qualità: la diminuzione dell’autosufficienza, la presenza di

patologie multiple e l’isolamento sociale sono problemi che aumentano e si aggravano

con l’età.

L’aumento del numero degli anziani con problemi di salute, la diminuzione del

numero dei membri della famiglia che possono prendersi cura di loro, l’aumento del

fabbisogno di servizi sanitari, inclusa l’assistenza a domicilio, e l’aumento dei costi

sono i problemi principali cui si deve far fronte quando la popolazione invecchia.

Tra le patologie più diffuse negli anziani si registrano l’insufficienza cardiaca e

l’ipertensione arteriosa come riportato in [1, 2]. In particolare appartengono al primo

gruppo le seguenti malattie:

l’angina pectoris, dal latino “dolore di petto”, dovuta ad un’improvvisa

riduzione dell’apporto di sangue al cuore, o a parte di esso, quando la

presenza di restringimenti nelle arterie coronarie non consente l’afflusso

regolare di sangue;

la fibrillazione atriale, un’aritmia, o anomalia del ritmo cardiaco,

caratterizzata da un aumento della frequenza con battiti non regolari; può

impedire al cuore di pompare la quantità di sangue e ossigeno sufficiente a

soddisfare i bisogni del corpo;

l’attacco ischemico transitorio, detto anche TIA, che consiste in

un’interruzione di breve durata del flusso di sangue in una parte del cervello

e spesso rappresenta un campanello di allarme per un ictus.

1

http://www.ministerosalute.it

3

Capitolo 2 - Analisi di dati clinici

L’ipertensione arteriosa invece è un aumento eccessivo della pressione arteriosa,

cioè della forza con cui il cuore pompa il sangue nelle arterie. La parete delle arterie

reagisce a questo aumento accumulando sostanze grasse (colesterolo), ispessendosi e

indurendosi. Queste alterazioni pericolose della parete delle arterie vengono definite con

il nome di arteriosclerosi (calcificazione dell’arteria). Un’arteria ristretta è un buon

terreno per la formazione di coaguli, che possono portare a un’occlusione improvvisa e

totale del vaso.

L’ipertensione ha conseguenze devastanti per i reni, compromettendo

progressivamente la loro funzione escretoria. Il cuore, nel tentativo di vincere la

resistenza maggiore delle arterie, reagisce con l’ingrossamento della parete muscolare

(ipertrofia). Tuttavia, se questo sforzo eccessivo non viene alleggerito abbassando la

pressione, con il tempo la parete cardiaca si trasforma, la cavità si dilata e la capacità di

pompare sangue diventa inadeguata (insufficienza cardiaca).

Gli obiettivi verso i quali si sta muovendo la medicina contemporanea, in

particolare quella rivolta all’assistenza delle persone anziane ma ancora autosufficienti,

sono:

il monitoraggio continuo dei segnali fisiologici, attraverso apparecchiature

non invasive (non ingombranti e che non limitino i movimenti del paziente);

l’analisi dei dati raccolti per individuare tempestivamente situazioni di

rischio, riducendo l’assistenza a domicilio, i periodi di osservazione in

strutture ospedaliere e i ricoveri in case di cura.

2.2 Apparecchiature per la misura dei segnali fisiologici

Non ci siamo occupati direttamente della parte di rilevazione delle misure

tramite sensori; per dimostrare però che esistono in commercio strumenti adatti,

forniamo una breve panoramica sul funzionamento di quelli che ci sarebbero utili per i

parametri che abbiamo preso in considerazione in questa tesi, ossia battito cardiaco,

pressione arteriosa e saturazione periferica di ossigeno nel sangue.

2.2.1 Battito cardiaco

Il battito cardiaco è generato dagli impulsi elettrici provenienti dalle

terminazioni nervose nell’atrio, i quali attivano i muscoli del cuore affinché inizino il

movimento meccanico per pompare il sangue nelle arterie.

La frequenza può variare nel corso della giornata, diminuendo durante il sonno e

aumentando durante le attività fisiche. È importante rilevare le aritmie, cioè i movimenti

non ritmici del cuore, dovuti a impulsi elettrici anomali o provenienti da altre aree che

di solito non li originano. Un’aritmia può manifestarsi come battiti rapidi e regolari

(tachicardia), battiti rapidi e irregolari (fibrillazione), battiti troppo lenti (bradicardia) o

battiti straordinari (contrazioni premature), come descritto in [3].

4

Capitolo 2 - Analisi di dati clinici

I dispositivi in commercio, provenienti da diverse case produttrici, in particolare

nella forma di orologi o bracciali come quelli riportati in Figura 2.1, in vendita al costo

di qualche centinaio di euro [4, 5], misurano l’intervallo di tempo in millisecondi tra un

battito e il successivo, o più precisamente l’intervallo tra i due punti R della forma

d’onda di esempio riportata nella Figura 2.2.

Figura 2.1 Esempi di orologi per la misura del battito cardiaco

Figura 2.2 Intervallo tra due punti R

2.2.2 Pressione arteriosa

La pressione nella circolazione sanguigna viene generata dall’azione ritmica di

pompaggio del cuore, che è un potente muscolo cavo (come descritto in [1]).

Contrariamente ai tubi rigidi delle canalizzazioni, le arterie hanno pareti elastiche e

muscolari che fanno in modo che nell’intervallo tra un battito e l’altro la pressione non

crolli e arrivi ossigeno agli organi che ne hanno maggior bisogno.

Quando il muscolo cardiaco si contrae, espelle con forza il sangue nelle arterie,

generando un picco di pressione. Questo picco viene rilevato nella misurazione sotto

forma di pressione massima o sistolica. Il termine sistolico indica che è determinato dal

cuore che si contrae (sistole = contrazione).

Nella fase di rilasciamento del cuore (diastole), le sue cavità si riempiono di

sangue, mentre nelle arterie cala moderatamente la pressione. Quando il cuore si rilassa,

la misurazione registra il valore minimo (diastolico), che corrisponde alla resistenza che

5

Capitolo 2 - Analisi di dati clinici

trova il flusso sanguigno nello scorrere nelle piccole biforcazioni delle arterie a livello

degli organi e dei tessuti.

La pressione arteriosa è misurabile nei suoi valori di massima e minima tramite

l’uso di appositi bracciali, come quelli riportati in Figura 2.3.

Figura 2.3 Esempi di bracciali per la misura della pressione arteriosa

2.2.3 Saturazione di ossigeno

Il puls-ossimetro (SpO2) misura in modo continuo e non invasivo la saturazione

arteriosa di ossigeno (percentuale di ossiemoglobina) su un sito periferico (ad esempio

un dito del piede o della mano, o il lobo dell’orecchio), come spiegato in [6, 7, 8].

Il monitoraggio della SpO2 offre informazioni generali sul sistema

cardiorespiratorio e particolari sul trasporto di ossigeno nel corpo. Viene usato per il

monitoraggio di pazienti a rischio di ipossiemia. È utile perché indolore, facile da

applicare, continuo e non invasivo.

Il sensore per ossimetria (Figura 2.4) contiene due diodi a emissione luminosa

(LED) che trasmettono luce rossa e infrarossa attraverso le estremità. La luce trasmessa

viene quindi ricevuta da un rivelatore ottico. Il sangue saturo di ossigeno assorbe la luce

in modo diverso dal sangue non saturo. Pertanto, la quantità di luce rossa e infrarossa

assorbita dal sangue che scorre attraverso una zona periferica del corpo adatta, in genere

un dito negli adulti e un piede nei neonati, può essere usata per calcolare il rapporto fra

l’emoglobina ossigenata e l’emoglobina totale nel sangue arterioso. Un monitor

visualizza tale rapporto come percentuale di SpO2. In alternativa al sensore a pinza è

possibile usare anche un cerotto (Figura 2.5).

Figura 2.4 Sensore a pinza per la misura della saturazione di ossigeno

6

Capitolo 2 - Analisi di dati clinici

Figura 2.5 Cerotto per la misura della saturazione di ossigeno

2.3 Progetti

La ricerca a livello europeo ed italiano sull’industria dei sensori indossabili è

uno dei temi caldi del momento.

La comunità europea ha già finanziato progetti di ricerca nel V progetto quadro,

in particolare il progetto MobiHealth [9]. Tale progetto, come tutti quelli attivi in questo

settore, ha favorito lo sviluppo di nuovi servizi mobili nell’area della salute,

permettendo al paziente di stare in movimento durante il processo di monitoraggio. La

diversa dislocazione dei sensori che acquisiscono i dati spinge verso la ricerca di

dispositivi capaci di operare all’interno di BAN (Body Area Network) e trasmettere ad

un sistema di monitoraggio centrale. In tale progetto, però, la parte di analisi e

correlazione dei segnali vitali avviene soltanto in ospedale ed è automatizzata solo per

poche e specifiche combinazioni di segnali; in tutti gli altri casi richiede l’intervento di

un operatore medico per la diagnosi.

Attualmente sono in corso, o previsti, parecchi progetti di monitoraggio a

distanza di persone anziane, in collaborazione con ospedali o case di riposo.

Le componenti dei progetti sono in genere tre:

uso di dispositivi mobili da parte dei pazienti per il monitoraggio di alcuni

parametri (battito cardiaco, pressione, respirazione, inclinazione e

accelerazione lungo gli assi),

ricezione dei dati dei sensori da parte di una stazione base in modalità

wireless (senza fili),

raccolta dei dati di tutte le stazioni in un centro di monitoraggio.

A tale proposito si possono citare in particolare due progetti italiani, entrambi

presentati nel 2005.

7

Capitolo 2 - Analisi di dati clinici

Il primo, il progetto Aditech [10], riguarda la sperimentazione su venti anziani

piemontesi di un innovativo sistema di monitoraggio a distanza per migliorare la qualità

della vita delle persone con problemi di autonomia ed ottimizzare i percorsi di

assistenza. La sperimentazione, voluta dalla Regione Piemonte e realizzata dal CETAD

(Centro Eccellenze Tecnologie per Anziani e Disabili) e dall’Istituto Superiore Mario

Boella (ISMB), è stata presentata alla casa di riposo Città di Asti dall’assessore

regionale alle Politiche Sociali Mariangela Cotto, dal presidente dell’ISMB Rodolfo

Zich e dal presidente del CETAD Carlo Poggio, che hanno dato dimostrazione pratica

del funzionamento del sistema di telemonitoraggio.

Il progetto Aditech è costituito da tre componenti:

un dispositivo mobile da indossare al polso, come un normale orologio,

una stazione base che riceve in modalità wireless i dati dell’orologio,

un centro di monitoraggio che raccoglie e gestisce i dati provenienti dalle

diverse stazioni.

Il prototipo dell’orologio, attraverso appositi sensori, è in grado di rilevare i

seguenti parametri:

ambientali (temperatura, luminosità),

fisiologici (temperatura cutanea, mobilità della persona e quindi movimenti

bruschi o immobilità, battito cardiaco),

di funzionamento (rimozione dal polso, guasto, copertura radio, livello

batteria).

La prima sperimentazione partirà su venti anziani, nella casa di riposo Città di

Asti e all’Istituto di Riposo per la Vecchiaia di Torino, con la collaborazione degli

operatori e degli anziani: il metodo di lavoro sarà centrato sulla persona anziana,

considerata nell’insieme delle sue caratteristiche, delle sue esigenze e dell’ambiente in

cui vive. Tenendo conto di questi aspetti sarà possibile migliorare la funzionalità,

l’efficienza, la semplicità d’uso e la sicurezza dell’intero sistema di telemonitoraggio.

Il secondo progetto, descritto in [11] e realizzato dalla SOGIT ONLUS - Sezione

di Lignano Sabbiadoro - con la collaborazione del Comune di Lignano Sabbiadoro,

riguarda il telemonitoraggio dei segnali fisiologici per la popolazione anziana residente

e turistica della città di Lignano Sabbiadoro. Prevede l’utilizzo di MEMS (MicroElectro-Mechanical Systems), sensori micro-elettro-meccanici intelligenti, che abbinano

funzioni elettriche, di gestione di fluidi, ottiche, biologiche, chimiche e meccaniche in

uno spazio estremamente ridotto. Tali sensori possono essere impiegati per il

monitoraggio continuo delle funzioni vitali attraverso il loro interfacciamento con

ricevitori domestici e territoriali a radiofrequenze collegati ad una centrale operativa

sanitaria.

La ditta Wireless Sensor Networks di Monza ha recentemente perfezionato un

particolare registratore di dati biomedici, basato su sensori MEMS e dotato di scheda

flash di raccolta dei dati.

Nell’ambito di tale progetto, si svilupperanno le seguenti azioni:

posizionamento di stazioni riceventi automatiche in tre punti ad alta densità

di popolazione all’interno della città di Lignano Sabbiadoro;

8

Capitolo 2 - Analisi di dati clinici

predisposizione e fornitura di sensori ai pazienti con scheda di memoria e

scaricamento wireless automatico dei dati in prossimità delle colonnine

riceventi (“BIOTOTEM wireless”);

progettazione ed attivazione di un sito internet gestito da server protetto per

la consultazione e gestione di dati e referti da parte di personale medico

locale e non (medici di fiducia nazionali ed internazionali dei vari pazienti,

con password d’accesso; specialisti sempre con password);

creazione di una rete di assistenza locale ed eventualmente convenzione con

un call center specializzato.

Si è scelta la città di Lignano Sabbiadoro perché è una località turistica

internazionale che durante il periodo estivo presenta due peculiari problematiche:

i familiari anziani dei lavoratori stagionali lamentano notevole difficoltà ad

eseguire molte attività, tra cui le visite di controllo, soprattutto a causa della

mancanza dell’accompagnatore;

i pazienti non residenti, in particolar modo quelli stranieri, che svolgono

alcuni controlli medici di routine riferiscono difficoltà a trasmettere

velocemente i referti grafici e testuali al proprio medico di fiducia nel paese

d’origine.

Con questa iniziativa si desidera facilitare l’applicazione di protocolli di

prevenzione ed assistenza medica continuativa a favore delle categorie più deboli. Gli

obiettivi prefissati sono la diffusione di protocolli di prevenzione basati su nuove

tecnologie a favore della popolazione anziana carente in accompagnatori, mezzi di

trasporto o lontana da strutture sanitarie (esclusa l’emergenza), e la gestione elettronica

della documentazione sanitaria dei pazienti semi e non autosufficienti non residenti.

Non solo in Italia si assiste all’avanzamento della ricerca nel campo del

monitoraggio continuo di anziani, disabili o pazienti di malattie croniche nelle loro

abitazioni, per evitare il ricovero in una casa di cura.

Un sistema simile è stato progettato nell’Università nazionale coreana di

Hankyong dal prof. Yong Tae-Kim. Come descritto in [12], i dati medici del paziente, o

biosegnali, raccolti con sensori applicati sulle zone di interesse del corpo, vengono

automaticamente elaborati in un palmare, a cui l’intero sistema è collegato. Questo

dispositivo trasmette a sua volta le informazioni via web usando una rete senza fili da

casa direttamente all’ospedale o al medico curante. L’eventuale emergenza viene

segnalata via SMS tramite un sistema di telefonia collegato. Lo stato di salute è

continuamente monitorato e quindi è possibile prevenire o intervenire in tempo. Il

prototipo, presentato a Sidney al convegno organizzato dal Korea Advanced Institute of

Science and Technology e dalla University of New South Wales, è già in

sperimentazione in alcuni ospedali coreani.

Nell’ambito del data mining i ricercatori si sono dedicati alla scoperta di profili

comportamentali analizzando le variazioni temporali di parametri qualitativi e

quantitativi registrati da sensori. In particolare Florence Duchene, come spiegato in [13,

14], ha sviluppato un metodo per trovare strutture ed estrarre regolarità nelle sequenze

dei dati registrati, per individuare i comportamenti frequenti e definire un pattern

9

Capitolo 2 - Analisi di dati clinici

comportamentale di una persona nella propria abitazione. Ogni deviazione da questo

profilo è considerata come una possibile situazione critica. L’attività di una persona,

direttamente legata al suo stato di salute, è spesso descrivibile intuitivamente in termini

di azioni semplici (alzarsi, chiudere una porta, ecc.) e poi di attività (mangiare, dormire,

vestirsi, ecc.). Un deterioramento nello stato di salute di solito causa disordini

comportamentali, osservabili come aumento del rischio di cadute, lentezza nell’eseguire

semplici operazioni e in generale incapacità di eseguire attività quotidiane.

In [14] Florence Duchene prende in considerazione, per un certo periodo di

tempo, i dati di battito cardiaco, livello di attività (tramite un accelerometro), postura

(persona sdraiata, seduta o in piedi) e quelli relativi alla casa (come l’occupazione delle

stanze). Individua quindi le fasi di astrazione e di data mining; la prima permette di

ottenere una rappresentazione sintetica dei dati come sequenze di simboli, ognuno dei

quali denota l’esecuzione di un’attività per un certo tempo, la seconda seleziona le

sottosequenze temporali più frequenti (chiamate tentative motifs) e poi applica su di esse

un algoritmo di clustering (le sequenze rappresentative delle classi sono chiamate timeseries motifs).

La maggior parte dei ricercatori si concentra sul monitoraggio all’interno di

edifici, in particolare la casa dei pazienti [15, 25, 26, 27, 28, 29, 30, 31].

Ad esempio in [15] viene descritta una Smart Home, ovvero un ambiente

intelligente in grado di acquisire conoscenza sui suoi abitanti e di gestire

automaticamente il controllo di parecchi aspetti come la climatizzazione e

l’illuminazione della casa, oltre alle emergenze.

Lo scenario illustrato, che vede come protagonista un ragazzo chiamato Bob, è il

seguente. Per minimizzare il consumo energetico, la Smart Home spegne il

riscaldamento durante la notte; alle 6:45 lo accende, perché sa che la casa impiega un

quarto d’ora a riscaldarsi. Alle 7 fa suonare la sveglia, accende la luce in camera da letto

e mette in moto la macchinetta del caffè. Quando Bob entra in bagno accende

automaticamente la luce, la spegne quando esce, e trasmette le ultime notizie su uno

schermo, ricordandogli le medicine da prendere a colazione.

Durante il funzionamento la Smart Home registra e analizza i dati e se rileva una

situazione anomala, ad esempio il fatto che Bob non esce più dal bagno (magari perché

si è addormentato sotto la doccia), se ne accorge e prende provvedimenti.

In altri casi l’interesse è rivolto ad aspetti molto specifici, ad esempio l’analisi

dei dati relativi ai malati di diabete, come descritto in [16].

Per quanto riguarda le tecniche di analisi dei dati, il problema dell’approccio

classico di ricerca delle regole di associazione è limitato all’individuazione dei

comportamenti più frequenti (si pensi ad esempio ai numerosi studi sul cosiddetto caso

del “carrello della spesa”, in cui si individuano regole del tipo “se il cliente compra un

certo prodotto x all’istante t1, è probabile che compri il prodotto y all’istante t2”). Nel

nostro caso, però, questi approcci non sono adeguati, perché le situazioni di rischio sono

per definizione quelle meno frequenti, e non vengono rilevate dagli algoritmi classici,

come Apriori [18], GSP [19], SPIRIT [20], SPADE [21] e PrefixSpan [22], che

individuano regole basate su un numero minimo di casi. Non si può risolvere il

10

Capitolo 2 - Analisi di dati clinici

problema riducendo la soglia oltre la quale una sequenza è considerata frequente

altrimenti si rischia di estrarre troppe regole e associazioni casuali.

Un’altra soluzione può essere quella di utilizzare dati già classificati, ovvero una

sequenza di valori con i relativi allarmi che sono stati lanciati. Come descritto in [23],

l’algoritmo proposto scopre i comportamenti frequenti prima che si verifichi un guasto

(il campo di applicazione è la meccanica idraulica). Nel nostro caso, però, abbiamo

dovuto escludere questo approccio in quanto non avevamo a disposizione dati già

classificati.

Il testo [17] presenta una buona panoramica sulle tecniche di analisi delle

sequenze temporali, il testo [24] fornisce un riassunto dettagliato dei problemi e delle

soluzioni nello stesso ambito.

2.4 Discussione

La ricerca in questo campo è ancora agli inizi, soprattutto per la mancanza di

dati adeguati. Il principale difetto che hanno le soluzioni citate è di limitare il

monitoraggio all’interno di edifici (in genere la casa del paziente, l’ospedale o strutture

residenziali sociosanitarie), lasciando scoperte le situazioni di rischio all’esterno. Inoltre

non bisogna dimenticare che il nostro obiettivo è individuare tempestivamente le

situazioni di rischio, quindi, a differenza del lavoro descritto in [14], siamo interessati al

riconoscimento di situazioni anomale istantanee e non a lungo termine.

A differenza del progetto descritto in [9], il nostro obiettivo è un’analisi

completamente automatica, eseguita direttamente su un dispositivo mobile, senza

l’intervento di un operatore medico per la diagnosi; la richiesta del collegamento con un

centro di soccorso avviene solo per situazioni a rischio. In tal caso si può inviare un

codice di allarme che indica la gravità dell’evento fisiologico verificatosi nel paziente.

Il lavoro presentato in [13] ha richiesto lo sviluppo di un simulatore di dati

clinici, data la grande difficoltà nel reperimento di dati reali. Noi invece abbiamo

utilizzato due database disponibili in Internet di pazienti monitorati per diverse ore,

come spieghiamo meglio nel Capitolo 6.

Parecchi lavori prendono in considerazione la correlazione tra le sequenze; la

prassi medica, invece, sembra più orientata a valutare i valori assoluti assunti dai singoli

segnali e la loro comparazione con soglie determinate dall’esperienza e dalle

conoscenze del medico. Inoltre, per intervenire in emergenza, basta che un solo segnale

fisiologico raggiunga una soglia di rischio per lanciare l’allarme: non ci siamo quindi

occupati dello studio delle correlazioni tra i segnali.

Rispetto agli obiettivi di Smart Home ci siamo concentrati solo sull’analisi dei

segnali fisiologici, senza prendere in considerazione altre rilevazioni: il riconoscimento

di pattern di comportamento esula infatti dal nostro obiettivo.

11

Capitolo 3

Tecniche di analisi dei dati

3.1 Introduzione

La crescita della quantità di informazione disponibile e l’aumentata disponibilità

della stessa hanno portato allo sviluppo di metodologie e strumenti in grado di elaborare

i dati e ricavarne informazioni non ovvie e di grande importanza per l’utilizzatore finale.

I sistemi di gestione delle basi di dati (Data Base Management System, DBMS)

hanno certamente permesso di manipolare i dati in maniera efficace, ma non hanno

risolto il problema di come supportare l’uomo nell’interpretazione e nell’analisi dei dati

stessi. Storicamente, lo sviluppo dei metodi statistici ha prodotto un certo numero di

tecniche di analisi dei dati utili nel caso in cui si debbano confermare delle ipotesi

predefinite. Tali tecniche risultano però inadeguate nel processo di scoperta di nuove

correlazioni e dipendenze tra i dati, che crescono in quantità, dimensione e complessità.

Come spiegato in [32], possiamo individuare tre fattori che hanno cambiato il

panorama dell’analisi dei dati:

1. la disponibilità di grande potenza di calcolo a basso costo;

2. l’introduzione di dispositivi di raccolta automatica dei dati, insieme alla

disponibilità di vaste memorie di massa a basso costo;

3. l’introduzione di un nuovo insieme di metodi sviluppati nell’ultima decade

dalla comunità dei ricercatori di intelligenza artificiale; questi metodi

permettono l’analisi e l’esplorazione dei dati, consentendo una più efficace

rappresentazione della conoscenza.

Il processo globale di analisi ed elaborazione dell’informazione, allo scopo di

estrarne della conoscenza di supporto alle decisioni, è noto come knowledge discovery.

Si vuole introdurre, in questo capitolo, la definizione di data mining e, più in

generale, di Knowledge Discovery in Databases (KDD), senza fare particolare

riferimento ad uno specifico dominio di applicazione.

12

Capitolo 3 - Tecniche di analisi dei dati

3.2 Data mining e knowledge discovery

Il processo di KDD è caratterizzato dalle seguenti fasi:

1. selezione – partendo dai dati contenuti nelle basi di dati, i “dati grezzi”, si

estrae l’insieme dei dati che si ritengono maggiormente significativi per il

tipo di analisi che si vuole effettuare;

2. pre-elaborazione – in questa fase viene effettuata l’integrazione dei dati, se

provengono da diverse fonti e presentano delle incongruenze, l’eliminazione

di eventuali errori ed il trattamento dei dati mancanti;

3. data mining – questo processo ha lo scopo di fornire all’utente finale una

rappresentazione della conoscenza che ha acquisito, applicando uno o più

metodi di data mining, partendo dai dati ottenuti dalla fase di preelaborazione.

Il data mining si presenta come il punto di confluenza dei risultati della ricerca

di settori come l’intelligenza artificiale ed il machine learning, la statistica inferenziale,

le basi di dati ed il data warehousing. La difficoltà nell’esporre una visione unificata ed

omogenea è dovuta alla vastità del settore ed in molti casi la stessa definizione di data

mining è oggetto di discussione.

In ogni caso, è possibile individuare due elementi tipici che caratterizzano il

processo del KDD: la grande dimensione degli archivi di dati utilizzati e

l’automatizzazione del processo di acquisizione della conoscenza. Questo settore è

attualmente in fase di grande sviluppo e la sua importanza aumenta nel corso degli anni.

È possibile evidenziare una serie di fattori di natura tecnologica ed economica

che sono alla base di questo fenomeno. Tra questi vi è l’importanza di valorizzare il

patrimonio informativo, cioè le informazioni che si hanno a disposizione. Questa

necessità viene particolarmente sentita nelle organizzazioni a scopo commerciale, basti

pensare alle molteplici iniziative di raccolta delle informazioni dei clienti, fatte in modo

più o meno occulto dalle organizzazioni commerciali.

Un tipico esempio è quello della “tessera sconto”: l’organizzazione propone la

compilazione di una scheda, che permette all’organizzazione di ottenere un profilo

informativo di ogni cliente. Il cliente, che compila la scheda credendo di ottenerne un

beneficio (lo sconto), in realtà sta fornendo all’organizzazione qualcosa di infinitamente

più prezioso, l’informazione.

Chi saprà valorizzare meglio l’informazione che ha a disposizione, anche grazie

ai metodi di data mining, probabilmente sarà in grado di prevedere, e quindi guidare, o

perlomeno non subire, il comportamento del mercato.

Un’ applicazione di data mining è l’attuazione del processo di data mining su un

caso specifico, utilizzando programmi ad hoc che implementano algoritmi specifici o

sfruttano strumenti generali in maniera opportuna.

In Figura 3.1 si fornisce una schematizzazione dell’intero processo di KDD.

13

Capitolo 3 - Tecniche di analisi dei dati

dati grezzi

SELEZIONE

1.

estrazione dati significativi per l’analisi

dati target

PRE-ELABORAZIONE

1.

2.

3.

dati pre-elaborati

pulizia dei dati (eliminazione errori)

trattamento dati mancanti

integrazione dati (trattamento incongruenze su

dati provenienti da fonti diverse)

TRASFORMAZIONE

1.

2.

dati pronti

3.

4.

deduzione nuovi attributi (elaborazione sugli

attributi esistenti)

trasformazione dati per adattamento al mining

usato (conversione di tipo, …)

campionamento (o partizionamento)

discretizzazione

DATA MINING

1.

scelta dei metodi (o algoritmi) di data mining

Percorsi (pattern) e/o

regole tra i dati

(conoscenza indotta)

INTERPRETAZIONE,

VISUALIZZAZIONE E

PREVISIONE

1.

verifica sul significato dell’informazione prodotta

dal mining

knowledge

Figura 3.1 Il processo di knowledge discovery nelle basi di dati

14

Capitolo 3 - Tecniche di analisi dei dati

3.3 Applicazioni di data mining

Si possono individuare almeno due tipologie di applicazioni di data mining, a

seconda dell’obiettivo che l’applicazione intende raggiungere:

1. applicazioni di interpretazione;

2. applicazioni di predizione.

Un’applicazione di interpretazione ha l’obiettivo di produrre conoscenza che sia

il più facilmente interpretabile dall’utente. In particolare si può richiedere la produzione

di regole secondo un determinato formalismo oppure l’utilizzo di rappresentazioni

grafiche. In ogni caso l’attenzione è posta sull’aspetto conoscitivo. Appare evidente che

esiste una problematica riguardante la valutazione automatica della “bontà”

dell’informazione acquisita, non solo dal punto di vista dell’accuratezza e della

rilevanza, ma anche della novità rispetto ad una conoscenza pre-esistente.

Un’applicazioni di predizione, invece, ha come obiettivo la costruzione di un

modello predittivo che sia il più accurato possibile. In questo caso si può anche

rinunciare, del tutto o in parte, all’interpretabilità del modello medesimo (che è

denominato opaco), purché quest’ultimo sia efficace (ossia accurato) ed efficiente (ossia

richieda risorse limitate) nell’applicazione su nuovi dati.

3.4 Fasi del processo di data mining

Il processo di data mining si può suddividere in tre fasi principali:

1. trasformazione o preparazione dei dati;

2. data mining;

3. interpretazione, visualizzazione e previsione.

3.4.1 Preparazione dei dati

La fase di preparazione dei dati dipende dal metodo di data mining che verrà

utilizzato nell’applicazione.

Le attività tipiche di questa fase sono:

1. l’introduzione di nuovi attributi mediante l’applicazione di operatori logici e

matematici, aumentando così la quantità di informazioni utili disponibili;

2. la trasformazione dei dati per essere adattati al metodo di data mining che

verrà applicato;

3. il campionamento o partizionamento dei dati;

4. la discretizzazione dei dati.

Le operazioni di trasformazione dei dati sono, in genere, associate a particolari

limitazioni dei metodi di data mining che si vogliono utilizzare, ad esempio incapacità

di gestire contemporaneamente informazione numerica e categorica o di gestire valori

mancanti. Nel seguito descriviamo le principali tecniche delle attività di

discretizzazione e campionamento.

15

Capitolo 3 - Tecniche di analisi dei dati

Discretizzazione

Il processo di discretizzazione di attributi numerici è una fase fondamentale per

la maggior parte degli algoritmi di apprendimento che trattano l’informazione

simbolica. È importante sottolineare come tale processo sia critico dal punto di vista

della qualità della conoscenza acquisita dall’algoritmo di data mining, infatti la semplice

scelta del numero di intervalli di discretizzazione per un attributo può avere

conseguenze considerevoli:

1. se il numero di intervalli è troppo piccolo si potrebbero perdere

informazioni utili (tanto varrebbe eliminare l’attributo);

2. se il numero di intervalli è troppo grande, al contrario, si potrebbe ricadere

in un problema di sovra-addestramento e l’algoritmo potrebbe non essere in

grado di estrarre conoscenza significativa, o quanto meno interpretabile, dai

dati.

Purtroppo non esistono delle regole generali valide per guidare questa fase. Gli

algoritmi più utilizzati per la discretizzazione degli attributi, che meglio si adattano alle

situazioni in cui la quantità dei dati da processare è notevole, sono:

1. EWD (Equal Width Discretization) – genera intervalli di uguale ampiezza;

2. EFD (Equal Frequency Discretization) – genera intervalli che contengono

approssimativamente lo stesso numero di elementi;

3. discretizzazione mediante clustering – usa un algoritmo di clustering per

raggruppare i valori numerici, quindi desume gli intervalli dalle estensioni

dei vari cluster;

4. 1RD (One Rule Discretization) – suddivide inizialmente l’insieme dei valori

dell’attributo in intervalli tali che ciascuno contenga almeno un numero

predeterminato di elementi, quindi procede ad accrescere gli intervalli in

modo tale che ognuno di essi contenga elementi compresi, per la maggior

parte, nella stessa classe.

Campionamento

La fase di campionamento ha lo scopo di estrarre dalla totalità dei dati a

disposizione un sottoinsieme (campione) sul quale verrà eseguito l’algoritmo di data

mining. Sebbene il processo di data mining valorizzi la conoscenza latente contenuta nei

dati, in certe situazioni un approccio poco oculato può comportare costi tali da renderlo

addirittura sconveniente. In particolare bisogna tenere in considerazione il processo di

data cleaning, il cui costo è proporzionale alla massa di dati trattati.

Inoltre, è opportuno ridurre il numero di esempi da analizzare affinché

l’algoritmo di apprendimento non sia sovra-addestrato o confuso dal rumore dei dati al

punto di non essere in grado di produrre informazione facilmente interpretabile. Si

consideri che tutti gli algoritmi di apprendimento sono sensibili a questi aspetti, sebbene

alcuni lo siano in misura minore, ma in genere questi ultimi sono quelli con il minore

potere espressivo.

16

Capitolo 3 - Tecniche di analisi dei dati

Infine, si può pensare che un’opera di selezione dei dati sia utile al fine di evitare

la scoperta di un numero eccessivo di regole di bassa qualità.

Per evitare che venga prodotta della conoscenza già nota o per indirizzare la

sensibilità del modello in una certa direzione, si possono usare le seguenti tecniche di

campionamento.

1. Campionamento casuale

Ogni elemento dell’insieme ha la stessa probabilità di essere estratto e

considerato nel processo di creazione del modello. Garantisce delle buone

prestazioni sia dal punto di vista delle risorse computazionali necessarie, sia dal

punto di vista della qualità del campione estratto.

2. Campionamento mediante clustering

Si procede con un pre-raggruppamento dei dati in base ad un opportuno criterio,

ricadendo così nel problema più generale del clustering. Quindi si estraggono,

sempre casualmente, da ogni cluster un numero di campioni proporzionale alla

dimensione del cluster sull’insieme di partenza. All’interno di ogni cluster ogni

campione ha la stessa probabilità di essere estratto.

Se il clustering viene effettuato in modo opportuno, ossia scegliendo in modo

oculato l’algoritmo e la metrica, vi è la possibilità di ridurre sostanzialmente il

rumore dei dati, in quanto esempi anomali e poco significativi possono venire

esclusi dall’algoritmo di clustering e pertanto avranno una probabilità nulla di

essere estratti. Rispetto al campionamento casuale, vi è ovviamente, un maggiore

costo computazionale.

3. Campionamento stratificato

In presenza di attributi non numerici gli algoritmi di clustering possono risultare

inadeguati; per migliorare la qualità del campionamento si può ricorrere alla

stratificazione. Si selezionano una serie di attributi nominali di particolare

interesse e si raggruppano i dati rispetto ad essi. Ogni gruppo viene denominato

strato e si procede in modo analogo a quanto fatto per il campionamento

mediante clustering; ogni elemento all’interno di uno strato ha la medesima

probabilità di essere estratto e ogni strato contribuisce con un numero di

campioni proporzionali al suo peso. Se uno strato ha un peso troppo basso, può

essere scartato in quanto assimilabile a rumore nei dati. Alla fine si ottiene un

campione in cui le frequenze degli attributi utilizzati per la stratificazione sono

simili a quelle dell’insieme originario. Gli attributi utilizzati per la stratificazione

devono assumere pochi valori distinti e ogni strato deve contenere un numero

minimo di valori.

17

Capitolo 3 - Tecniche di analisi dei dati

3.4.2 Data mining

In questa fase si determinano i percorsi, le eventuali regole e le caratteristiche

dei dati mediante l’applicazione di uno o più metodi. Se il risultato ottenuto non è

soddisfacente, si può operare una nuova trasformazione, tornando alla fase precedente e

applicando nuovamente la fase di data mining, utilizzando lo stesso metodo o uno

diverso. Questa fase può essere indicata anche come fase di apprendimento o di

esplorazione e modellazione, in base alle denominazioni correntemente in uso del

campo dell’intelligenza artificiale e della statistica, rispettivamente.

3.4.3 Visualizzazione, interpretazione e previsione

Il risultato della fase di data mining è costituito da conoscenza indotta dai dati

rappresentata secondo un dato formalismo. Tuttavia, prima di utilizzare ai fini pratici

tali informazioni, è necessario che queste ultime siano opportunamente validate, ossia si

deve verificare che il processo di data mining abbia prodotto risultati significativi.

Verificato questo aspetto, a seconda della tipologia di applicazione, si presentano

almeno due possibili alternative:

1. se l’applicazione di data mining è destinata alla previsione, il risultato passa,

come si è soliti dire, “in produzione”, ovvero viene utilizzato per analizzare

nuove situazioni;

2. se l’applicazione è di tipo interpretativo, la conoscenza acquisita dal sistema

di data mining deve essere opportunamente trattata al fine di poter essere

visualizzata ed interpretata da un analista, per ottenere le informazioni

necessarie in fase di supporto alle decisioni.

Si osservi che in entrambi i casi il risultato del data mining è sfruttato per

guidare un processo decisionale. La differenza è costituita dal livello e dalle modalità

con cui ciò avviene.

3.5 Data mining

Un sistema di data mining è formato da un insieme di programmi ad hoc o da

uno strumento generico che permette di eseguire una applicazione di data mining. In

letteratura non esiste una visione unificata dei sistemi di data mining, ma è possibile

evidenziare due aspetti comuni a tutte le classificazioni:

1. le funzionalità offerte dal sistema all’utente;

2. i metodi impiegati per realizzare le funzionalità.

Quando si parla di funzionalità, si intende tutto ciò che un sistema di data mining

mette a disposizione dell’utente, affinché possa ottenere nuova conoscenza dai dati. Il

termine metodo, invece, si riferisce a come la funzionalità viene offerta. Si può

distinguere il concetto di metodo tra formalismo e tecnica: a volte un metodo di data

18

Capitolo 3 - Tecniche di analisi dei dati

mining (o tecnica) non determina direttamente la funzionalità, ma produce un

formalismo che viene utilizzato dall’utente per realizzare la funzionalità.

Riportiamo in Tabella 3.1 una suddivisione delle funzionalità in base al

formalismo o alla tecnica che la genera; di seguito le descriviamo dettagliatamente.

Tecnica

Metodi ad hoc per reti

Neurali

Algoritmi di Clustering

Metodi ad hoc per regole

di associazione

Metodi ad hoc per pattern

sequenziali

Metodi ad hoc per alberi di

decisione

Formalismo

Cluster

Funzionalità

Classificazione/Regressione

Clustering

Clustering

Regole di Associazione

Associazioni

Pattern sequenziali

Sequenze

Alberi di decisione

Classificazione

Analisi esplorativa

*

Associazioni

Sequenze

Clustering

Reti Neurali

Tabella 3.1 Tecniche, formalismi e funzionalità di data mining

3.5.1 Funzionalità di data mining

Descriviamo in questo paragrafo le principali funzionalità di un sistema di data

mining.

Scoperta di Regole

Questa funzionalità permette di individuare delle correlazioni tra i record di una

base di dati. Le regole possono essere di due tipi:

1. associazioni – si collegano (associano) tra loro più eventi elementari in un

unico evento globale, quando tali eventi elementari hanno una certa

probabilità di verificarsi in concomitanza. Ad esempio se consideriamo

come fatti elementari “il robot riconosce un ostacolo” e “il robot è fermo”,

potremmo scoprire la regola “nel 30% dei casi, se il robot vede un ostacolo,

si ferma”;

2. sequenze (o associazioni sequenziali) – gli eventi elementari si collegano

non se si verificano in concomitanza, ma se hanno una certa probabilità di

verificarsi progressivamente nel tempo (in sequenza). Ad esempio se

consideriamo come eventi elementari “il robot vede la palla vicina” e “il

robot prende la palla”, la regola scoperta potrebbe essere “nel 60% dei casi,

se il robot vede la palla vicina, dopo 2 secondi prende la palla”.

La regola di associazione è una relazione che lega fra loro un insieme di oggetti

(rule body) che precedono un altro oggetto (rule head); la regola contiene sia

19

Capitolo 3 - Tecniche di analisi dei dati

informazioni statistiche circa la frequenza di occorrenza dei gruppi di oggetti (itemset),

sia l’attendibilità dei dati considerati, sia l’importanza della relazione stessa.

Formalmente la regola associativa appare in questo modo:

rule body → rule head [supporto, confidenza, lift]

Le tre misure tipiche delle regole di associazione sono:

supporto;

confidenza;

lift.

Il supporto è il rapporto fra il numero di transazioni che soddisfano la regola di

associazione (la transazione deve contenere sia il rule body che il rule head) ed il

numero totale di transazioni contenute nel database.

La confidenza è la percentuale di transazioni che soddisfano la regola tra tutte

quelle che soddisfano il rule body. Una transazione soddisfa il rule body se contiene

tutti gli oggetti del rule body. La confidenza indica l’attendibilità della regola di

associazione.

Il lift è il fattore per il quale una regola supera il valore di confidenza atteso. E’

espresso come il rapporto fra la confidenza della regola ed il supporto associato alla rule

head. Ad esempio, data la regola A→B, e indicando con P(A) il supporto di A e P(B|A)

la confidenza della regola, il lift è pari al rapporto:

lift = P(B|A) / P(A).

Un elevato lift equivale ad una stretta correlazione fra rule body e rule head.

Classificazione e Regressione

La classificazione e la regressione fanno parte dell’apprendimento

supervisionato (supervised learning), ossia il processo che porta a classificare un record

di una base di dati a partire dal valore assunto dai suoi attributi: da un insieme di record

già classificati si determinano certe regolarità che permettono di predire il valore di un

nuovo attributo del record, la classe.

Si parla di:

classificazione quando la variabile da predire può assumere valori in un

insieme discreto,

regressione quando deve essere predetto un valore continuo.

La classificazione individua un modello: spesso si parla di regole di

classificazione intendendo dire che il modello prodotto dalla classificazione può essere

tradotto in una serie di regole.

L’utente assiste parzialmente il classificatore nella creazione del modello

fornendo un database di prova per la costruzione del modello dove i dati sono già

associati ad etichette di classe, ed un database di test per verificare la bontà del modello

creato. L’apprendimento supervisionato viene utilizzato per costruire modelli di

classificazione a partire da insiemi di dati e, una volta che il modello di classificazione è

stato creato, viene utilizzato per classificare nuovi casi.

20

Capitolo 3 - Tecniche di analisi dei dati

L’albero decisionale su cui si basa la classificazione è una semplice struttura in

cui i nodi non terminali rappresentano i test di uno o più attributi sui record considerati

ed i nodi terminali (foglie) riflettono le decisioni risultanti.

Lo scopo della classificazione è quello di poter inserire i record in classi a

seconda del valore di determinati attributi in esso presente, in modo da poterli

classificare secondo alcune caratteristiche.

L’albero decisionale generalizza i dati e ci offre una sintesi degli attributi e delle

loro relazioni, che sono importanti per effettuare una diagnosi accurata. I casi utilizzati

per creare l’albero decisionale sono detti dati di training; tali casi sono gli unici

conosciuti per essere classificati correttamente, ma il modello sarà in grado di

classificare nuovi casi per i quali la classificazione non è nota a priori.

È bene che il training set ed il test set siano differenti altrimenti si otterrebbe

sempre una perfetta classificazione dei casi di test, dato che il modello è stato costruito

sugli stessi.

La classificazione è quindi un processo a due passi.

Costruzione del modello:

à

ogni tupla campione appartiene ad una classe predeterminata come

determinato dall’attributo dell’etichetta di classe;

à

gli insieme di tuple utilizzati nel modello prendono il nome di training

set;

à

il modello è rappresentato da regole di classificazione, alberi

decisionali, formule matematiche;

à

per stimare la bontà del modello creato (percentuale di predizioni esatte

per un determinato dataset) si utilizza un test set e si verifica quanti casi

vengono classificati correttamente;

Utilizzo del modello:

à

classificazione di nuovi oggetti.

Nell’albero decisionale i rami rappresentano l’uscita da un test.

Anche la regressione è una tecnica di previsione, in quanto prevede un risultato

futuro analizzando il passato. A differenza della classificazione il risultato è numerico:

continuo (ad esempio il reddito annuale di una persona);

discreto (ad esempio la scelta tra due valori: 1 per indicare che si è

verificato un evento, 0 per indicare che non si è verificato).

Si può usare la regressione anche per problemi di classificazione che contengono

solo due categorie ad esempio SI e NO: mappando il SI con il numero 1 e il NO con lo

0, se i valori previsti dal modello sono vicini a 1, allora ricadono nella categoria dei SI,

altrimenti in quella dei NO.

Dato un record, il processo di regressione serve a predire il valore di un campo

numerico (target field) conoscendo il valore degli altri campi dello stesso record (input

field). I campi di input possono essere numerici o categorici.

La regressione può essere usata per creare modelli e per testarli. Un modello è

costruito a partire da un dataset di record, di cui sono noti i target field; poi può essere

applicato sia a record di cui si conoscono solo gli input field, sia a quelli di cui si

21

Capitolo 3 - Tecniche di analisi dei dati

conoscono tutti i campi (il cosiddetto test mode, per valutare la qualità del modello).

Anche in questo caso bisogna dividere i dati e tenerne una parte per validare il modello

corrente (validation mode). La differenza tra validation e test mode è che il primo è

eseguito durante la costruzione del modello e può causare delle modifiche, invece il

secondo è eseguito dopo la costruzione del modello e lo lascia invariato.

Clustering (o raggruppamento)

È un processo che porta a risultati simili a quelli della classificazione. A

differenza della classificazione, però, è in grado di produrre una suddivisione dei record

in gruppi (cluster) in maniera del tutto autonoma: si tratta di una classificazione non

addestrata. Il raggruppamento è fatto in modo tale che i record in ogni cluster siano

simili secondo certi criteri o metriche. Il clustering è anche detto unsupervised learning

(apprendimento non supervisionato).

Vista l’importanza del clustering nella nostra tesi, abbiamo deciso di dedicargli

un paragrafo a parte.

Considerazioni

Nella letteratura statistica si usa riferirsi ai problemi di classificazione e

regressione come modellazione predittiva, in quanto il risultato dell’analisi è un

modello, rappresentato secondo un opportuno formalismo. Ricevuti in input i dati

relativi a un nuovo caso, il modello è in grado di fornire la classificazione più probabile,

oppure il valore stimato della variabile obiettivo nel caso di una regressione. Per

estensione si usa la denominazione di modello per indicare il risultato del processo di

data mining.

Un’altra distinzione molto diffusa, derivante dall’ambito dell’apprendimento

automatico, è tra algoritmi di apprendimento supervisionato e non supervisionato.

Infatti, dal punto di vista della ricerca in intelligenza artificiale, il data mining è

riconducibile ad un problema di apprendimento, pertanto si parla di apprendimento

supervisionato nei casi di classificazione e regressione, dal momento che durante

l’addestramento il sistema conosce l’esatta classificazione degli esempi analizzati.

L’obiettivo dell’apprendimento è individuare la legge secondo cui i vari esempi sono

classificati. Il clustering, invece, rappresenta un tipico esempio di apprendimento non

supervisionato, in quanto il sistema non conosce a priori la suddivisione degli esempi,

ma ha il compito di proporne una che sia, in qualche modo, particolarmente

significativa. Anche la scoperta di regole di associazione e sequenza sono da

considerarsi come un caso di apprendimento non supervisionato.

22

Capitolo 3 - Tecniche di analisi dei dati

3.6 Clustering

3.6.1 Descrizione generale

Il clustering, come descritto in [33, 34], è un metodo attraverso il quale grandi

insiemi di dati vengono partizionati in gruppi più piccoli, detti cluster (letteralmente

“grappolo”). Eseguire il clustering di un dataset assegnato, contenente oggetti descritti

da un insieme di attributi, significa individuare gruppi di oggetti tali che:

1. elementi appartenenti ad un cluster siano più simili l’uno all’altro (alta

similarità intra-classe);

2. elementi appartenenti a cluster diversi siano meno simili l’uno all’altro

(bassa similarità inter-classe).

La discriminazione degli oggetti avviene valutandone gli attributi in base ad una

prestabilita misura di similarità.

Il clustering è una classificazione non supervisionata, per la quale non ci sono

classi predefinite. Esso viene generalmente utilizzato come mezzo per verificare ipotesi

intuitive relative a distribuzioni di dati, o come passo di pre-elaborazione in altri

algoritmi di data mining. In generale si utilizza il cluster detection quando si sospetta

che nei dati da analizzare esistano raggruppamenti naturali rappresentativi di classi (per

esempio clienti o prodotti con molte caratteristiche comuni), oppure per ridurre la

complessità dell’analisi ed aumentare così le probabilità di successo di una tecnica di

data mining, nel caso in cui la coesistenza di diversi pattern nell’insieme dei dati renda

altrimenti difficile l’identificazione di un singolo schema.

I settori applicativi nei quali si fa uso di metodi di clustering sono numerosi e

molto diversi fra loro. Per esempio, nell’ambito del marketing si ricercano insiemi di

clienti simili nelle basi di dati, per favorire lo sviluppo di programmi mirati; in

urbanistica è di interesse l’identificazione di gruppi di edifici in base a tipo, valore e

locazione geografica; nello studio dei fenomeni tellurici si mira all’individuazione delle

fratture continentali a partire dagli epicentri dei terremoti.

La variabilità dei campi di applicazione e le differenti caratteristiche dei

problemi specifici da affrontare comportano, per la scelta di un metodo di clustering

appropriato, l’utilizzo di uno o più criteri discriminativi. Tra i requisiti generalmente

richiesti in problemi di data mining figurano:

1. scalabilità;

2. possibilità di trattare differenti tipi di attributi;

3. individuazione di cluster con forma arbitraria;

4. necessità di minima conoscenza del dominio per determinare i parametri;

5. robustezza rispetto al rumore e agli outlier;

6. insensibilità all’ordine dei record in input;

7. capacità di operare su dati ad alta dimensionalità;

8. incorporazione di vincoli specificati dall’utente;

9. interpretabilità ed usabilità dei risultati.

23

Capitolo 3 - Tecniche di analisi dei dati

3.6.2 Misure di distanza

Generalità.

I coefficienti di distanza (o dissimilarità) forniscono una misura del grado di

associazione fra due osservazioni, restituendo un valore nullo per osservazioni identiche

ed un valore variabile da coefficiente a coefficiente per osservazioni totalmente

differenti. Le proprietà che devono essere soddisfatte affinché un coefficiente di

distanza sia di tipo metrico (ossia consenta di ordinare le osservazioni in uno spazio

metrico) sono le seguenti:

1. D jk = 0 se j = k;

2.

D jk > 0 se j ≠ k;

3.

D jk = Dkj ;

D jk + Dkh ≥ D jh (assioma della disuguaglianza triangolare).

In generale è la quarta ed ultima proprietà quella che risulta discriminante ed il

fatto che sia o meno soddisfatta distingue le misure metriche da quelle cosiddette

semimetriche.

4.

Distanze metriche

I coefficienti di distanza metrici sono stati sviluppati per trattare dati di tipo

quantitativo e, con poche eccezioni, trattano lo zero come una misura e non come una

mancanza di informazione.

La più familiare fra le misure di distanza è certamente quella euclidea, che

corrisponde esattamente a quella che si può calcolare o misurare nello spazio fra due

oggetti fisici:

D jk =

p

∑(x

− xik ) 2

ij

i =1

È importante rilevare il fatto che il quadrato della distanza euclidea, che non di

rado viene utilizzato al posto di quest’ultima, è una semimetrica.

È evidente che la scala dei singoli descrittori è molto influente nel determinare

una distanza euclidea fra due osservazioni; è dunque necessario riservare questa scelta

ai casi in cui i descrittori sono dimensionalmente omogenei o a quelli in cui essi

vengono centrati e standardizzati, al fine di eliminare l’effetto di eventuali differenze di

scala.

Una soluzione molto flessibile è costituita dalla metrica di Minkowski:

p

D jk = r ⋅

∑x

ij

i =1

24

− xik

r

Capitolo 3 - Tecniche di analisi dei dati

dove r può essere assegnato in maniera teoricamente arbitraria. In realtà il caso

r=2 corrisponde ad una distanza euclidea ed un valore di r maggiore di questo, in

generale, non è desiderabile per non enfatizzare l’effetto della diversa scala dei

descrittori.

Più interessanti sono i valori di r inferiori a questa soglia e, fra questi, un caso

particolare è quello che si verifica per r=1. In questo caso la distanza che si ottiene è

nota come metrica di Manhattan:

p

D jk = ∑ xij − xik

i =1

Il nome di questa misura di distanza è dovuto al fatto che la distanza fra due

punti è data dalla somma della distanza in ascissa e di quella in ordinata e corrisponde al

percorso più breve che unisce due punti in una città le cui strade si incrociano ad angolo

retto, come, per l’appunto, a Manhattan. La metrica di Manhattan presenta gli stessi

problemi legati all’influenza della scala dei descrittori di cui si è detto a proposito della

metrica euclidea.

Una delle varianti che, laddove necessario, la correggono in questo senso è

quella proposta da Lance & Williams (1966) con il nome di metrica di Canberra:

p

xij − xik

D jk = ∑

i =1 ( xij + xik )

I doppi zeri devono essere esclusi dal calcolo per evitare problemi di

indeterminazione. Pur senza normalizzare i dati, questa distanza assegna alla differenza

fra i valori che un descrittore assume in due osservazioni un peso inversamente

proporzionale alla somma dei valori stessi: la medesima differenza ha un peso maggiore

se è osservata fra due valori piccoli.

Uno degli inconvenienti di questa soluzione è costituito dal fatto che, se uno dei

due valori relativi ad un dato descrittore è uguale a zero, allora il contributo alla distanza

totale è pari a 1, cioè il massimo possibile. La metrica di Canberra, dunque, si presta

meglio a trattare serie di dati in cui esista eterogeneità di scala fra i descrittori senza,

però, che siano presenti molti valori nulli.

3.6.3 Principali metodi di clustering

Dal punto di vista dell’approccio al problema, le tecniche di clustering possono

essere suddivise in alcune grandi categorie:

1. algoritmi di partizionamento: eseguono la costruzione di un numero

variabile di cluster, per poi valutarli e selezionare quelli definitivi;

2. algoritmi gerarchici: creano una decomposizione gerarchica del dataset;

possono essere di tipo top down o bottom up, a seconda che partano da un

cluster principale che comprende tutti i punti e poi man mano lo

suddividano secondo un certo criterio, o viceversa, partano da tanti cluster

25

Capitolo 3 - Tecniche di analisi dei dati

quanti sono i punti e poi man mano li accorpano fino ad arrivare ad un unico

cluster;

3. metodi density-based: basandosi su connettività e funzioni di densità, fanno

“crescere” i cluster finché la densità di punti nel vicinato non supera un

prefissato limite; sono in grado di trovare cluster di forma arbitraria;

4. metodi grid-based: sono basati su una struttura a livelli multipli di

granularità, che forma una griglia sulla quale vengono eseguite tutte le

operazioni; le prestazioni dipendono solo dal numero di celle della griglia;

5. metodi model-based: ipotizzano un modello per ciascun cluster cercando il

miglior adattamento di quel modello con ciascun altro.

In particolare esaminiamo le prime due categorie, visto che sono quelle prese in

considerazione nella nostra tesi.

Algoritmi di partizionamento

Prevedono la costruzione di k cluster a partire da un database D di n oggetti. Il

parametro k è un dato di input del problema e il risultato è un partizionamento che

ottimizza il criterio di ripartizione scelto. Due noti metodi euristici sono il k-means e il

k-medoids: sono rilevanti da esaminare perché spesso costituiscono la base per varianti

più o meno sofisticate.

1. Il metodo k-means