CAPITOLO I

STATISTICA DESCRITTIVA

1.1 _ Concetti introduttivi

La statistica, in termine originale Staatsmerkwudigkeiten, è sorta come scienza

descrittiva degli Stati, come pura e semplice descrizione di cose. Come insegnamento

(Staatkunde) fu introdotta nell'Università di Helmstadt da Herman Conring (1606-1681),

mentre in Italia il termine per la prima volta figura nel ristretto di scienza civile, politica e

militare "Teatro d'homini letterati" (1647) del Gerolamo Ghislini. Grande merito nel 1800

ebbero Melchiorre Gioia e Giandomenico Romagnosi che intuirono la sua trasformazione

da disciplina descrittiva a disciplina investigativa.

Oggetto della statistica sono i fenomeni collettivi o di massa, lo studio dei quali

comporta l'acquisizione di un complesso di osservazioni sulle singole unità di un

determinato insieme detto collettivo statistico. Il Giardina (Manuale di statistica, 1962) la

definisce come l'applicazione dei metodi scientifici alla programmazione della raccolta dei

dati, loro classificazione, elaborazione, analisi, presentazione ed alla inferenza su

conclusioni attendibili da essi.

Al contrario delle scienze fisiche che si riassumono in un metodo di osservazione

della realtà ed analisi dei dati da cui elaborare leggi che possono essere facilmente

riprodotte e verificate in laboratorio, le scienze statistiche sono solo un metodo di

osservazione di fenomeni comunque non riproducibili in laboratorio.

La statistica può anche essere definita come metodo di osservazione di fatti

individualmente atipici, ma collettivamente tipici. Un fenomeno è tipico se, in circostanze

analoghe, si manifesta con le stesse caratteristiche. Molti dei fenomeni fisici possono

essere considerati tipici quando avvengono in condizioni ideali: la caduta dei gravi nel

vuoto è tipico, mentre nell'aria non può considerarsi tale, dato che due oggetti piuma e

sasso, pur soggiacendo alla stessa legge di gravità, si comportano diversamente. Altro

fenomeno atipico della fisica è il comportamento del gas rispetto al calore: il movimento di

ogni particella avviene in modo casuale, perché imprevedibile e quindi non determinabile

2

attraverso le leggi della meccanica classica. Nella misura di una grandezza la atipicità a

volte è però imputabile alla imperfezione dei nostri sensi e dei nostri strumenti di misura.

Nella realtà vi sono moltissimi fenomeni dello stesso tipo che, confrontati l'uno con

l'altro, si manifestano così dissimili, da sembrare dovuti alle bizzarrie del caso. Possono

essere essi fenomeni biologici, economici, sociali, metereologici, biometrici, sanitari,

giudiziari,

antropometrici,

demografici,

aziendali.

Tali

fenomeni

osservati

non

singolarmente, ma nel loro insieme collettivo, presentano delle regolarità; ad esempio il

rapporto costante nel tempo delle nascite maschi/femmine, il rapporto tra aumento del

benessere ed aumento dei consumi, o diminuzione della natalità, oppure aumento

dell'altezza degli individui. Possiamo dire che se osservati uno alla volta, gli elementi di un

collettivo presentano grande variabilità, mentre nel loro insieme rivelano presenza di

regolarità ed uniformità di comportamento.

Lo scopo della indagine statistica consiste nel ricercare tali regolarità o uniformità

nella variabilità di situazioni, cioè ricercare il quanto più probabile nella apparente

casualità. Il fine è quello di scoprire le leggi alla base dei fenomeni per risalire alle cause di

cui sono il risultato, oppure per trarne previsioni relative al comportamento futuro..

Per analizzare alcuni problemi statistici, oltre ai vari strumenti matematici, spesso si

ricorre sistematicamente alla comparazione fra dati. Un dato di per se stesso è poco

significativo se non confrontato con un altro, rilevato in altro luogo o tempo diverso.

La statistica si può dividere in tre parti:

La statistica descrittiva o deduttiva, che ha come obiettivo la descrizione ed

interpretazione dei dati; essa riguarda sia la produzione dei dati statistici, cioè della

documentazione quantitativa relativa a fenomeni di massa, che l'elaborazione dei metodi

statistici per l'analisi quantitativa dei fenomeni collettivi, onde desumere dalla massa di

informazioni i tratti essenziali del fenomeno studiato.

La statistica induttiva o inferente: da una popolazione di caratteri ignoti si estrae un

campione di dati e su di esso si prova (accetta o respinge) una certa ipotesi, ad esempio la

percentuale dei pezzi difettosi.

La teoria delle decisioni statistiche che, tra diverse alternative in condizioni di

incertezza tenta di decidere l'alternativa per raggiungere il risultato ottimo desiderato.

3

Definiamo universo o popolazione statistica o collettivo statistico, di dimensione N,

l'insieme omogeneo definito rispetto al fenomeno in osservazione, cioè la totalità degli

elementi che sono oggetto di studio e riguardo ai quali si desidera la conoscenza di una o

più caratteristiche. Se per ogni elemento si determinano una o più caratteristiche, si parla

rispettivamente di popolazione uni-variata o pluri-variata.

Per unità statistica intendiamo il più piccolo elemento osservato. Può essere

semplice, se consiste in una singola persona od oggetto, oppure composta, come ad

esempio un nucleo familiare.

Per dato statistico intendiamo il risultato di un rilevamento su una unità statistica. Un

insieme di dati può avere il significato di una

frequenza, come numero delle volte per cui si è manifestata una modalità di un

carattere, oppure di una

intensità, quando si parla di misura della modalità.

Per campione1 intendiamo una porzione di una popolazione, quindi la scelta di n

(<N) unità statistiche allo scopo di avere indicazioni sull'intera popolazione (non solo in

numerosità, ma anche in grandezza, ad esempio un pezzo di stoffa). Un campione è

rappresentativo quando la distribuzione statistica dei dati rilevati sulle sue unità, riproduce

in scala ridotta, ma non deformata, la distribuzione statistica relativa alla popolazione

intera. Esso può essere: sistematico, se estratto con una determinata legge, stratificato,

quando ad esempio da ognuna fra più urne si estrae un certo numero di palline, a due stadi

o cluster, quando si estraggono prima alcune fra più urne e poi da queste alcune palline ed

infine casuale, quando la scelta è affidata al caso, alla sorte e quindi non determinata da

leggi fisiche o matematiche, né da influenze oggettive.

Un parametro che descrive il carattere della popolazione è spesso sconosciuto,

quindi viene utilizzata una statistica, cioè un numero che descrive quel carattere nel

campione; diciamo allora che la statistica sta al campione come il parametro alla

popolazione.

Per rilevazione statistica si intende la raccolta sistematica dei dati statistici

informativi del fenomeno in oggetto. Una rilevazione può essere totale o parziale, a

seconda se fatta su tutto l'universo statistico, oppure su un campione. La rilevazione, in

generale, è sempre incompleta, in quanto quello completa, a meno del censimento, è

4

praticante impossibile (pesci del lago, fiale, durata delle pile, lavatrici dopo dieci anni già

invecchiate). La rilevazione può essere classificata rispetto alle caratteristiche qualitative o

quantitative da associare al fenomeno; avremo

a) mutabile statistica, insieme delle modalità osservate di un carattere qualitativo e

delle frequenze ad esso associate; riguarda rilevazioni di fenomeni non ordinabili, es.

colori, professioni. Il dato statistico è espresso in forma verbale spesso con attributi,

aggettivi, caratteri che possono differire per diverse manifestazioni dette modalità del

carattere: occhi, stato civile, titolo di studio. Esse sono sempre discrete e sono semplici se

si rivela un solo attributo, multiple se più attributi. Una successione di dati di tal tipo è

detta anche serie statistica

b) variabile statistica, insieme dei valori osservati su un carattere quantitativo e delle

frequenze ad esso associate; riguarda rilevazioni espresse da numeri associati a fenomeni

ordinabili e misurabili. Le modalità del carattere quantitativo sono i "valori" del carattere.

Le successioni dei dati di tal tipo sono dette anche seriazioni statistiche. Possono essere sia

discrete, se dedotte da caratteri ordinabili in senso discreto, finito o numerabile, oppure

continue, se dedotte da caratteri ordinabili e continui, cioè valori reali compresi in intervalli

(pesi, misure, costi).

1.2 _ Caratteristiche di una distribuzione

L’insieme di determinazioni (x1, x2,…xn) della variabile statistica, raggruppati o

meno in k classi, formano i dati grezzi, i quali possono essere subito ordinati in un array

(tabella ordinata) in senso crescente o decrescente, in modo da rendere evidente il range o

campo di variazione. Per riassumere le caratteristiche di una rilevazione statistica si ricorre

a tabelle che riportano le unità o intensità corrispondenti ai diversi caratteri o modalità

considerate.

Si ricavano poi le distribuzioni di frequenze associando ad ogni carattere xi, ad

esempio età, la distribuzione delle frequenze assolute hi, cioè il numero delle volte che

quel carattere figura.

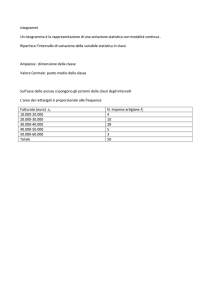

Suddividendo i dati in k classi e registrando il numero di osservazioni che ricadono

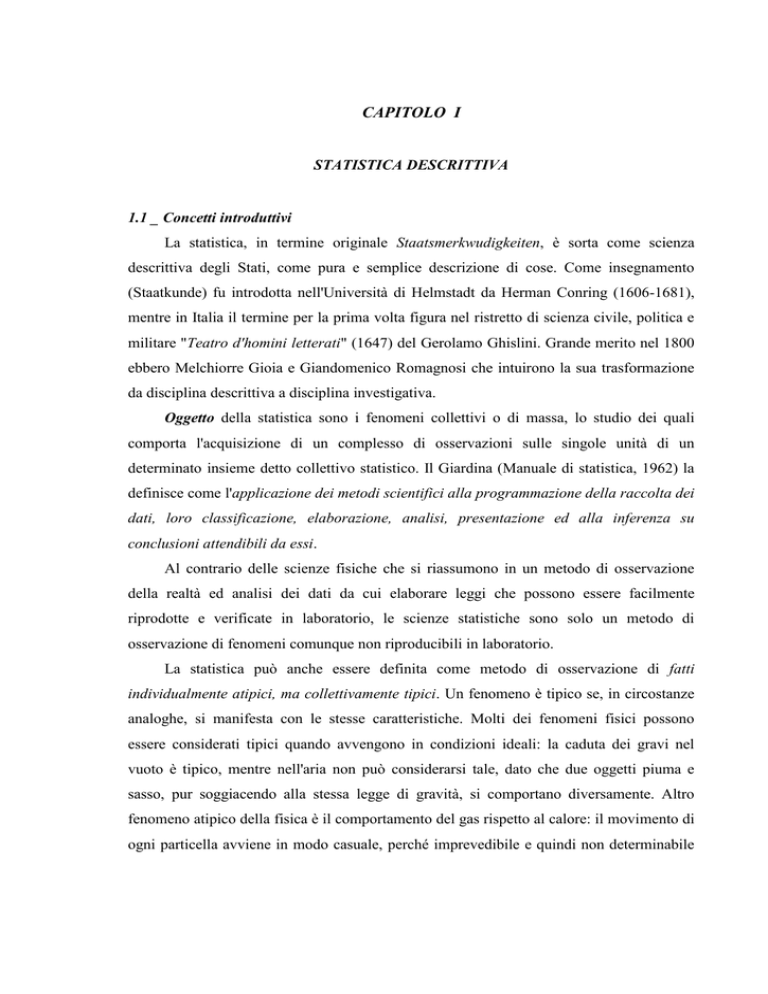

in ciascuna classe; si può costruire un grafico che rappresenta la distribuzione di frequenza.

Le frequenze assolute di due distribuzioni, anche se della stessa specie, non sono in genere

5

confrontabili in quanto si riferiscono ad un diverso numero di osservazioni. Piuttosto che il

numero, è più utile a volte conoscere la proporzione (intesa come quota parte), delle

osservazioni che appartengono ad una determinata classe. Abbiamo allora la frequenza

relativa

fi =

hi

, (0fi1),

N

ottenuta come rapporto delle frequenze assolute sul numero totale dei dati statistici

rilevati. Vale la relazione i fi =1. Le frequenze relative, essendo percentuali, sono numeri

puri di facile interpretazione ed utili per confronti.

La distribuzione di frequenze può rappresentarsi con

diagrammi a segmenti o di frequenza, cioè grafici cartesiani del tipo (xi, fi), o con

istogrammi (istos= trama) o bar charts: insieme di rettangoli accostati con basi di

uguale larghezza (xi=xi-xi-1) e altezze proporzionali alla frequenze assolute (o relative), la

differenza sta solo nella diversa scala sull’asse Y.

Se negli istogrammi le classi vengono continuamente ridotte in ampiezza e se il

numero delle osservazioni viene aumentato, il poligono si approssimerà sempre più ad una

curva di frequenza f(x). Una curva di frequenza continua che in varie scienze descrive le

distribuzioni di molte variabili statistiche è la cosiddetta normale o gaussiana.

Per caratterizzare una variabile statistica, sia continua che discreta, si definisce allora

in maniera assiomatica la funzione cumulativa di frequenza F(x)1. Essa riassume le

frequenze cumulate, assolute o relative, cioè la somma delle frequenze corrispondenti alle

determinazioni della variabile statistica X che sono inferiori od uguali ad un prefissato

valore x:

F(x) =

f (X x )

xi x

i

i

In corrispondenza di ogni valore discreto xi si ha un salto, pari alla frequenza che il

nuovo valore aggiunge. Chiaramente più i valori sono vicini fra loro, più i salti saranno

piccoli fino al punto di essere così infinitamente prossimi da identificarsi in una funzione

continua (fig. 1.1b), il cui grafico è comunque un diagramma di frequenza. Curve molto

regolari si hanno con variabili statistiche con alto numero di determinazioni e frequenze

costanti per ciascuna di esse. Quindi, nel continuo si ha:

6

F(x) = fr(X<x) = fr(-<X<x)

1.3 _ Indici di posizione

Per sintetizzare, condensare e confrontare distribuzioni statistiche occorre individuare

indici descrittivi che ne riassumono alcune caratteristiche quantitative. Tra questi abbiamo

in primis gli indici di posizione, che tendono a localizzare la distribuzione, individuandone

la "tendenza centrale del fenomeno che essa descrive"; è in realtà quel valore Cr, detto

anche centro di ordine r, che è rappresentativo dell'intera distribuzione stessa.

Va rilevato che la sintesi spesso porta erroneamente ad assumere identiche due

distribuzioni completamente diverse. Gli indici di posizione si dividono in medie

analitiche e medie lasche a seconda che siano o meno esprimibili mediante formule che

coinvolgano tutti i valori statistici.

Tra le medie analitiche abbiamo:

a) Media aritmetica

(1.1)

M(X) =

i xi hi

N

= i xi f i

in cui le frequenze hi rappresentano in realtà dei pesi; infatti spesso si parla di media

semplice ponderata. Nel caso di dati raggruppati in classi, xi è il valore centrale della

classe, preso come rappresentante di tutti i dati in essa inclusi.

Per hi=1, fi=1/N, risulta M(X) =

x

i i

/N

Per una variabile statistica discreta e finita, il valor medio esiste sicuramente; ma se è

discreta infinita, oppure continua finita o infinita, non è detto che esista; infatti per

variabile discrete infinite la somma si traduce in una serie e questa potrebbe non

convergere. Per variabili statistiche continue, poi, l'integrale potrebbe non esistere o

divergere.

Dato che coinvolge tutti i valori, può essere distorta da valori molto estremi o

anomali e non può essere calcolata per distribuzioni open-ended; è comunque un indice

molto affidabile per fare inferenze sulla popolazione.

b) Media geometrica

Usata principalmente per calcolare i tassi medi di variazione, è data da:

1

Od anche c.d.f (cumulative distribution function)

7

(1.2)

0 = n ik1 xi hi

d) Media quadratica

(2) =

i xi2 hi

N

= i xi2 f i

è la media aritmetica dei quadrati delle modalità ed è applicabile a variabili

statistiche con valori negativi

Si ha la sequenza di medie:

x1 (-1) 0 1 (2) xn.

Tra le medie lasche, che corrispondono ad un concetto non prettamente matematico,

ma di rappresentazione statistica, abbiamo le seguenti.

La moda o norma Mo, o valore prevalente, è il punteggio che avviene più spesso, e

quindi a cui corrisponde la massima frequenza (non estremo, perché si possono avere

frequenze sempre crescenti o decrescenti). Può non esistere o essercene più di una. Se

nessun dato risulta più di una volta, non c'è moda; se ci sono due valori l'insieme dei dati è

detto bimodale; comunque coincide sempre con uno dei dati.

La mediana Me è il termine centrale della successione dei dati disposti in ordine

crescente o decrescente; cioè il termine equidistante dagli estremi, se il numero n dei valori

è dispari, o qualunque valore compreso fra i due centrali se n è pari, quindi, può o non

appartenere ai dati. Come M0 non dipende dalle osservazioni della distribuzione, ma dal

numero di esse. Indicata con C1, è chiamata anche centro di ordine 1. Viene molto usata per

osservazioni non simmetriche (skewed) e può anche essere calcolata per distribuzioni

open-ended.

La Me è quel valore che divide una distribuzione in due gruppi di uguali frequenze

cumulate e quindi la cui frequenza cumulata è 0.5

Me : x / F(x) = 0.5;

xi Me

fi =

xi Me

f i = 0.5;

Considerati i dati disposti in ordine crescente, per quantili, si intendono quei valori

che dividono la frequenza totale in n parti uguali; abbiamo quartili, decili, ...; ad esempio il

2° quartile, x0,5, corrisponde alla mediana.

Per i quartili abbiamo

q1/4 = x(n+1)/4; q1/2= x(n+1)/2; q3/4= x3(n+1)/4;

8

cioè sono quei valori xi della distribuzione che raccolgono frequenza relativa

cumulata pari ad 1/4, ½ e ¾.

I quantili sono molto utili per esplicitare la distribuzione dei redditi in un collettivo.

Ad esempio nel 1960 il quintile più ricco rispetto al quintile più povero della popolazione

mondiale era di 30:1, mentre nel 2002 è diventato di 90:1.

Nei grafici scatola e baffi, riportati su un asse orizzontale, l'estremo sinistro (destro)

della scatola coincide il primo (terzo) quartile, mentre la divisione interna della scatola

coincide con la mediana. Lateralmente due linee orizzontali (baffi) vanno a raggiungere il

valore più piccolo e più grande dell'insieme di dati.

Fig. 1.3

x

1

q

1

q

2

q

3

x

n

1.4 _ Momenti semplici e momenti centrali

Essi possono essere semplici cioè rispetto all'origine, oppure rispetto ad un centro

(media o qualsiasi altro valore caratteristico). I momenti di ordine r rispetto all'origine sono

i valor medi di funzioni potenza r-ma g(X)=Xr della variabile statistica X:

m( r ) M ( X r ) i xir f i

dove gli xi sono i singoli valori o i valori centrali delle classi, a seconda di variabile

discreta o divisa per intervalli.

Portando l'origine nel punto , ovvero traslando tutti i dati di , si ottiene la variabile

statistica centralizzata Y=g(X) = (X-) chiamata scarto della distribuzione dalla propria

media. Però, invece del semplice scarto consideriamo una sua trasformata tramite una

potenza r-ma qualsiasi, Yr=(X-µ)r; la generica determinazione risulta in tal modo yri=(xiµ)r; il valor medio di tale nuova variabile statistica è chiamato momento centrale r-mo:

m ( r ) M (Y r ) i ( xi ) r f i

formula che per µ=0 si riduce ai momenti r-mi rispetto all'origine.

Per r = 0 abbiamo m(0)=1;

per r = 1 si ha m(1)=M(Y)=0;

per r = 2 abbiamo m(2)= ² cioè la varianza, per il cui calcolo si ha anche:

9

m(2)= ² = M ( Y 2 ) =i (xi-µ)² fi = m(2)-µ².

Cioè il momento secondo centrale è uguale al momento secondo rispetto all'origine

meno il quadrato del valor medio.

La varianza in termini fisici rappresenta il momento d'inerzia della distribuzione

rispetto al baricentro della stessa rappresentato dalla media aritmetica.

1.5 _ Indici di variabilità

La variabilità è un concetto primitivo intrinseco di una variabile statistica; chiamata

anche mutabilità, si può definire anche l'attitudine della variabile ad assumere diverse

modalità. Gli indici di variabilità misurano l'ammontare della diffusione o dispersione dei

dati e permettono di comprendere meglio il riassunto statistico trilussiano secondo cui,

date due persone della quali una prima ha mangiato due polli ed una seconda nessuno,

risulta che ciascuna ha mangiato un pollo a testa.

Tali indici possono essere assoluti o relativi a seconda se dipendenti o meno

dall'unità di misura del fenomeno osservato. Tra gli assoluti abbiamo:

i) campo di variazione, è la differenza fra il valore massimo ed il minimo delle

modalità

=max(xi)-min(xi)

Facile da calcolare, enfatizza le modalità estreme e non le diversità interne; è

insensibile alle variazioni dei valori interni

v) scarto quadratico medio o standard deviation (sqm) = σ 2 e varianza, media

quadratica degli scarti, già introdotta tra i momenti. Mentre l'unità di misura della varianza

è il quadrato di quella del fenomeno e in particolare della media, il calcolo dello sqm

risolve questo inconveniente avendo la stessa unità di misura della media e quindi più

idoneo per la misura della variabilità. È la più usata misura di dispersione; affetto da tutte

le osservazioni, può essere distorto molto da osservazioni relativamente estreme e non può

essere calcolato per distribuzioni aperte a meno di informazioni addizionali.

1

I parametri della popolazione vengono denotati con lettere greche, mentre quelli dei campioni con i caratteri

italici