Introduzione alle catene di Markov finite

seminario di Jacopo D’Aurizio per il corso di Ricerca Operativa

testo di riferimento: Finite Markov Chains, John G. Kemeny & J. Laurie Snell, Van Nostrand Company, 1960

Giugno 2005

1)

Definizione

Un processo di Markov finito è un processo stocastico finito

dove la probabilità di un evento al passo n-esimo dipende

unicamente dallo stato del sistema al passo (n-1)-esimo

e da una fissata matrice di transizione.

2)

Matrici di adiacenza e di transizione

Come per un grafo era possibile studiare i percorsi in arrivo in un nodo

attraverso le potenze della matrice di adiacenza, per una catena di Markov finita

è possibile definire la matrice di transizione P come

P[i,j] = (probabilità che il sistema passi dallo stato s[i] allo stato s[j])

In particolare, se pi(n) è il vettore riga che rappresenta

lo stato del sistema al passo n-esimo, si ha

pi(n) = pi(n-1) P = pi(0) P^n

3)

Criteri di classificazione

Definiamo preliminarmente una relazione di ordine (parziale)

tra gli stati della nostra catena di Markov.

Se esiste un percorso che conduce dallo stato s[i] allo stato s[j]

con probabilità non-nulla poniamo i@j = 1, altrimenti i@j = 0, ed

in tal caso stabiliamo che C[i] < C[j]. Se due stati s[p] ed s[q]

sono tali che p@q = q@p li consideriamo appartenenti alla stessa

classe di equivalenza. L’ ordinamento parziale delle classi di

equivalenza ammetterà uno o più minimi; ognuna di queste classi

sarà un “set ergodico”, le altre “set transienti”.

Se un set ergodico è costituito da un solo stato (o “nodo”,

in riferimento al grafo pesato associato), quest’ultimo viene

detto “assorbente”.

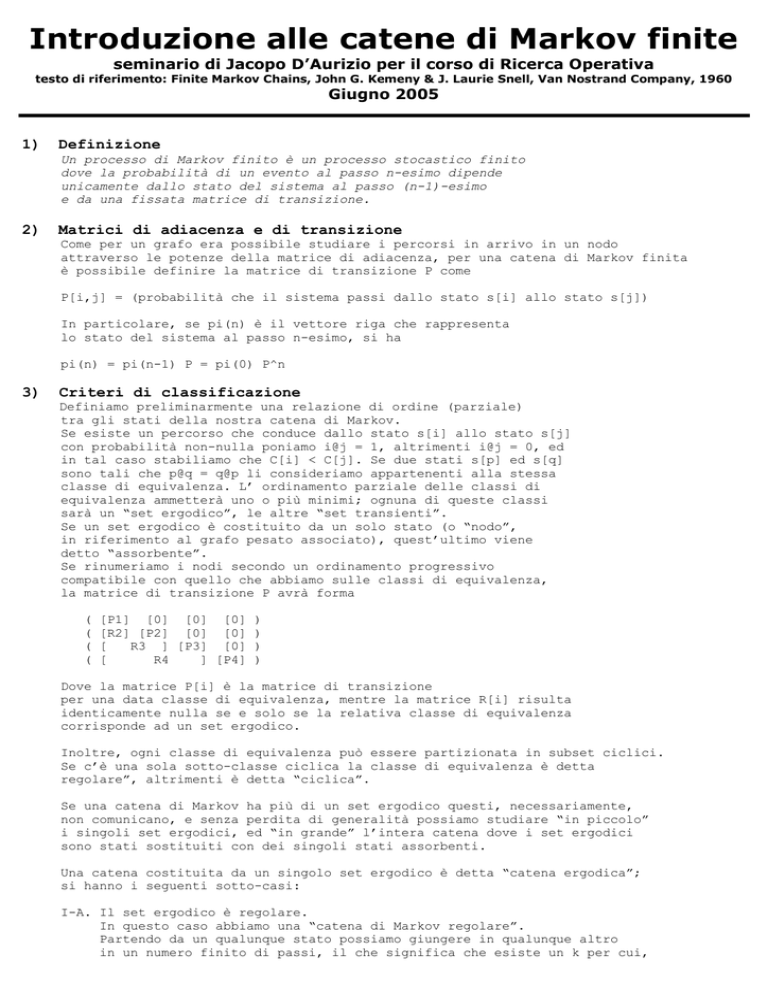

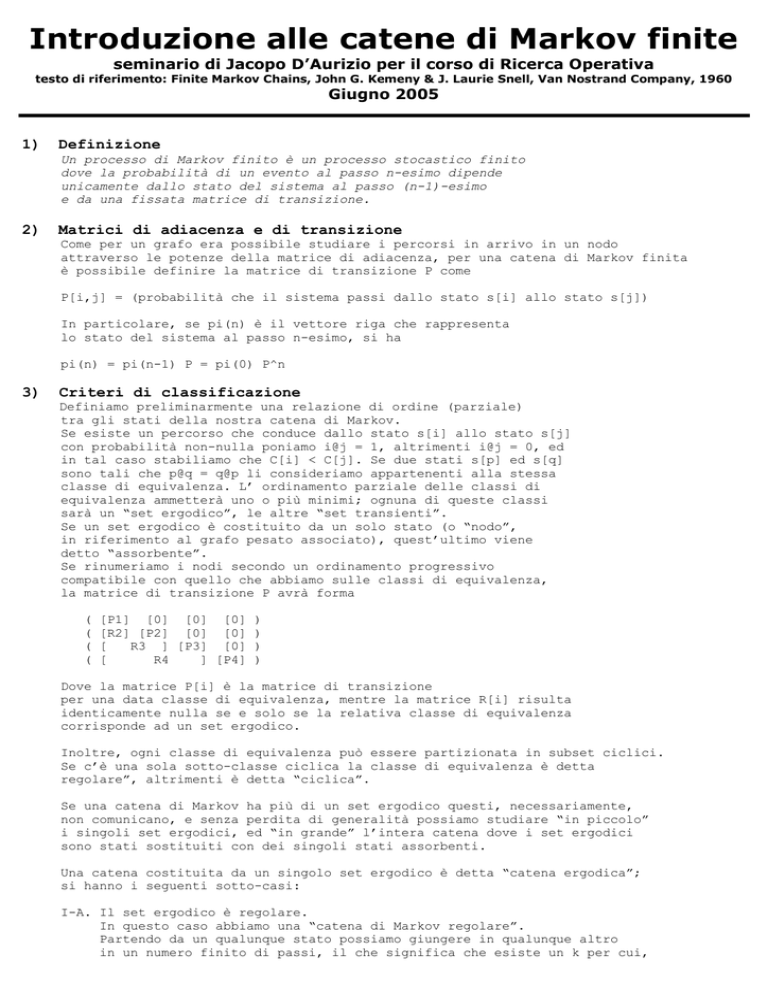

Se rinumeriamo i nodi secondo un ordinamento progressivo

compatibile con quello che abbiamo sulle classi di equivalenza,

la matrice di transizione P avrà forma

(

(

(

(

[P1] [0] [0] [0]

[R2] [P2] [0] [0]

[

R3 ] [P3] [0]

[

R4

] [P4]

)

)

)

)

Dove la matrice P[i] è la matrice di transizione

per una data classe di equivalenza, mentre la matrice R[i] risulta

identicamente nulla se e solo se la relativa classe di equivalenza

corrisponde ad un set ergodico.

Inoltre, ogni classe di equivalenza può essere partizionata in subset ciclici.

Se c’è una sola sotto-classe ciclica la classe di equivalenza è detta

regolare”, altrimenti è detta “ciclica”.

Se una catena di Markov ha più di un set ergodico questi, necessariamente,

non comunicano, e senza perdita di generalità possiamo studiare “in piccolo”

i singoli set ergodici, ed “in grande” l’intera catena dove i set ergodici

sono stati sostituiti con dei singoli stati assorbenti.

Una catena costituita da un singolo set ergodico è detta “catena ergodica”;

si hanno i seguenti sotto-casi:

I-A. Il set ergodico è regolare.

In questo caso abbiamo una “catena di Markov regolare”.

Partendo da un qualunque stato possiamo giungere in qualunque altro

in un numero finito di passi, il che significa che esiste un k per cui,

per ogni n>k, P^n è una matrice ad elementi strettamente positivi.

I-B. Il set ergodico è ciclico.

In questo caso la catena è chiamata “catena di Markov ciclica”.

Una siffatta catena ha periodo d, ed i suoi stati sono divisi in d set ciclici.

Assegnata una posizione iniziale il processo si evolverà secondo un ordine

predefinito attraverso i subset ciclici e ritornerà nel subset iniziale

dopo d passi.

Sappiamo che dopo sufficiente tempo il processo può essere in uno qualunque

degli stati del subset ciclico appropriato (di indice congruo al tempo modulo d)

In un catena con set transienti il processo muove verso i set ergodici.

La probabilità di trovarsi in uno stato ergodico tende ad 1.

Un set transiente, infatti, non può essere minimo secondo l’ordinamento parziale

definito in inizio paragrafo. Esiste dunque una certa probabilità p di giungere

in un set ergodico dopo n passi. La probabilità di restare nel set transiente

è dunque al più (1-p), ed in k iterazioni (kn passi) al più (1-p)^k ;

che tende a 0 dato che p è strettamente compreso tra 0 e 1.

Da qui è facile congetturare che l’evoluzione di un processo di Markov

sia controllata da una legge di tipo geometrico: dimostreremo la fondatezza

di questa congettura nei prossimi paragrafi.

Una catena con set transienti può appartenere ad una di queste quattro categorie:

II-A tutti i set ergodici sono unitari (stati assorbenti)

Questa è detta “catena assorbente”.

II-B tutti i set ergodici sono regolari, ma hanno cardinalità maggiore di 1

II-C tutti i set ergodici sono ciclici

II-D ci sono sia set ergodici regolari che set ergodici ciclici

4)

Proprietà particolari.

In questo paragrafo dimostreremo alcune proprietà delle catene assorbenti

ed altre delle catene regolari.

4A) La matrice di transizione di una catena assorbente (in forma canonica) è

( I | 0 )

P = ( --+-- )

( R | Q )

cioè diagonale inferiore a blocchi. Poichè, per quanto visto nel paragrafo 3,

il processo muove verso gli stati assorbenti, Q^n tende alla matrice

identicamente nulla. Inoltre è vero che (I-Q) è invertibile.

Prefiggiamoci lo scopo di calcolare il tempo medio impiegato dal sistema

per giungere in uno stato assorbente, a partire da uno stato appartenente

al subset transiente. Dato che la probabilità q[k] di arrivare in uno stato

assorbente in esattamente k passi è espressa dal vettore

pi(0) Q^(k-1) (I-Q)

il tempo medio che cerchiamo sarà espresso dal vettore

pi(0) sum[j=0..+inf] (j+1) Q^j (I-Q)

la serie converge in quanto Q^k tende a 0,

dunque Q ha raggio spettrale minore di 1, e converge a

pi(0) (I-Q)^(-1)

4B) Una catena di Markov è regolare se e solo se esiste un qualche K per cui

P^K è una matrice interamente costituita da elementi strettamente positivi.

Prendiamo Z = P^K e m come il minimo elemento di Z. Siano e[i] ed e[j]

vettori riga della base canonica. Sia sum(v) la somma degli elementi del

vettore v. E’ immediato verificare che

sum(v) = sum(vZ)

dato che le righe di Z sono vettori di probabilità

Ora, posto che |w| sia la norma-1 del vettore w

|(e[i]-e[j]) Z^n| <= (1-m) |(e[i]-e[j]) Z^(n-1)| <= 2 (1-m)^n

Questa disuguaglianza ci dice che, se esiste il limite per n tendente a infinito

di Z^n (cioè se esistono distintamente i limiti e[j] Z^n), questa matrice-limite A

ha tutte le righe uguali (pari ad un vettore di probabilità alpha).

D’altronde, poichè

T[n] = e[j] Z^(n+1) - e[j] Z^(n) = e[j] (Z - I) Z^n

e il vettore v = e[j] (Z - I) ha sum(v)=0, in analogia al caso precedente abbiamo

|T[n]| <= C (1-m)^n

da cui deduciamo che gli H[n] = e[j] Z^n convergono, e dunque anche Z^n converge (ad A).

La matrice A coincide pure con il limite di P^m con m che tende all’infinito,

dato che la norma-1 della matrice P è pari ad 1.

Deduciamo immediatamente che

A P = A

alpha P = alpha

Alpha è dunque autovettore di autovalore 1 per P, ed è unico per unicità

del limite. Ammettiamo che Beta sia autovalore per P di autovalore Lambda

diverso da 1: allora

Beta P = Lambda Beta

sum (Beta) = sum( Beta P ) = Lambda sum( Beta )

Dunque, necessariamente, sum(Beta)=0.

Inoltre Lambda, in modulo, dev’essere strettamente minore di 1

(in caso contrario esisterebbe un elemento di P^n ad evoluzione esponenziale

crescente, in contrasto con il fatto che gli elementi di P^n sono positivi

e hanno somma fissata)

5) Evoluzione in piccolo di una catena di Markov regolare

Supponiamo che P sia la matrice di transizione associata ad una catena

di Markov regolare con n nodi, e di volere ricavare esplicitamente la probabilità

accumulatasi sul nodo s[1] al tempo k, che definiamo come s[1,k].

(s[1,k+1], s[2,k+1] , ... , s[n,k+1]) =

(s[1,k], s[2,k+1] , ... , s[n,k+1]) P

Sia ora C[i,k] la i-esima colonna della matrice P^k. Segue

s[1,k+1] = (s[1,k], s[2,k] , ... , s[n,k]) ° C[1,1]

e, analogamente

s[1,k+1] = (s[1,1], s[2,1], ... , s[n,1]) ° C[1,k]

s[1,k]

= (s[1,1], s[2,1], ... , s[n,1]) ° C[1,k-1]

s[1,w]

= (s[1,1], s[2,1], ... , s[n,1]) ° C[1,w-1]

1<=w<=(k+1)

Ora, preso k=n, tramite una riduzione di Gauss sul sistema appena scritto

possiamo facilmente ricavare la relazione di ricorrenza relativa al nodo s[1]

(poniamo A[i] = s[1,i])

A[n+1] = sum[j=1..n] k[j] A[n+1-j]

dove k[j] sono i coefficienti che abbiamo ricavato tramite eliminazione di Gauss.

Tale relazione di ricorrenza lineare può essere resa esplicita facendo uso della

teoria delle funzioni generatrici: supponiamo che il polinomio caratteristico

p(x) = x^n - sum[j=1..n] k[j] x^(n-j)

abbia radici z[1]...z[m] (eventualmente con molteplicità maggiore di 1)

Allora è vero che

A[n+1] = sum[j=1..m] a[j] z[j]^n + sum[j=1..m] n b[j] z[j]^(n-1) + ...

La congettura che un processo di Markov abbia evoluzione “geometricamente dominata”

risulta dunque provata, ma restano da approfondire le questioni legate

alla ricerca delle radici z[j] e alle loro molteplicità. Nel prossimo paragrafo

dimostraremo che le radici z[j] appartengono all’insieme degli autovalori

della matrice P.

6) Forma di Jordan della matrice di transizione di una catena regolare

Possiamo portare P nella forma J^(-1) R J, dove J è la matrice associata alla

base di Jordan di P ed R è la matrice diagonale a blocchi, dove ogni blocco

ha sulla diagonale un autovalore di P e sulla sotto-diagonale soltanto 1.

Segue Z = P^k = J^(-1) R^k J.

Se volessimo calcolare la probabilità accumulatasi sul nodo s[i], dopo k passi,

a partire dal nodo s[j], non dovremmo far altro che moltiplicare Z a destra e a

sinistra per i vettori della base canonica e[i] ed e[j] (rispettivamente

vettore-colonna e vettore-riga).

A meno di una combinazione lineare predeterminata (quella data dal cambiamento

di base individuato da J) abbiamo dunque che il sistema si evolve con le

potenze della matrice R, facilmente studiabili.

Un’ immediata conseguenza è che le radici dei polinomi caratteristici ottenuti

tramite studio “in piccolo” (Jordanizzazione indiretta) del sistema viaggiano

all’interno degli autovalori di P, e che la loro molteplicità è pari alla

molteplicità algebrica dell’autovalore associato.

Il teorema di stabilizzazione di una catena di Markov regolare può, a questo punto,

essere dimostrato in maniera alternativa. Dato che la matrice P ha un solo autovettore

di autovalore 1, ed altri autovettori di autovalori minori (in modulo) di 1,

la probabilità accumulatasi al nodo s[i] al passo n è nella forma

s[i,n] = C + C[1] (z[1])^n + C[2] (z[2])^n + ... + C[M] n(z[1])^(n-1) + ...

dunque s[i,n] tende a C, ed è facile dimostrare che questa costante non dipende

da quale nodo abbiamo scelto come origine del processo.

7) Esempi ed applicazioni

In questo paragrafo presentiamo due esempi: lo studio di una catena di Markov

regolare (“in grande” ed “in piccolo”) e quello di una catena assorbente

(in relazione con il celebre gioco “gambler’s ruin”)

7A)

D---C

/ \ / \

E---A---B

\ / \ /

F---G

Matrice di transizione P (catena regolare):

A

B

C

D

E

F

G

A

O

1/3

1/3

1/3

1/3

1/3

1/3

B

1/6

0

1/3

0

0

0

1/3

C

1/6

1/3

0

1/3

0

0

0

D

1/6

0

1/3

0

1/3

0

0

E

1/6

0

0

1/3

0

1/3

0

F

1/6

0

0

0

1/3

0

1/3

G

1/6

1/3

0

0

0

1/3

0

Lumping process:

set (1) anello esterno BCDEFG

set (2) centro A

(1)

(2)

(1)

2/3

1

(2)

1/3

0

catena regolare

Evoluzione a partire dal centro:

Tempo

Config

0

(0

1

2

3

4

5

1) -> (1 0) -> (2/3 1/3) -> (7/9 2/9) -> (20/27 7/27) -> (61/81 20/81)

Forma esplicita della ricorrenza vettoriale

(a[n+1] , b[n+1]) = (2/3 a[n] + b[n] , 1/3 a[n])

Studio “in piccolo” (Jordanizzazione indiretta)

a[n+1] = 2/3 a[n] + b[n] = 2/3 a[n] + 1/3 a[n-1]

a[0] = 0

a[1] = 1

Polinomio caratteristico associato alla ricorrenza:

3x^2 - 2x - 1 = (x - 1)(3x + 1)

a[n] = a + b (-1/3)^n

Metto a sistema le condizioni iniziali (tratte dalla configurazione ai tempi 0 e 1)

{ a + b = 0

{3a - b = 3

segue

{ a = +3/4

{ b = -3/4

a[n] = 3/4 (1+(-1/3)^(n+1)) ---> 3/4

b[n] = 1/4 (1-(-1/3)^(n))

---> 1/4

densità sull’anello esterno

densità al centro

Studio “in grande”: ricerco l’autovettore di autovalore 1

(normalizzato a vettore di probabilità)

a + b

3b

= 1

= a

-->

-->

a = 3/4

b = 1/4

componenti che giustamente coincidono con

le densità calcolate “in piccolo”

7B) Gambler’s ruin

Due giocatori A e B dispongono rispettivamente di m ed n monete.

Lanciano una moneta: se esce testa A cede a B una moneta, altrimenti l’opposto.

Il gioco termina quando uno dei due giocatori esaurisce le sue disponibilità.

Vogliamo determinare la probabilità che A esca vittorioso dal gioco

(cioè la probabilità che B esaurisca i suoi fondi).

Possiamo matematizzare il gioco con una catena di Markov assorbente

ad (m+n+1) stati, così fatta

A:0

A:1

A:m+n-1

B:m+n

B:m+n-1

B:1

X

----- O ----- ... ----- O ----(1)

(3)

(m+n-1)

( I | 0 )

P = (---+---)

( R | Q )

I

R

e

Q

e

A:m+n

B:0

X

(2)

possibili stati

O transiente X ergodico

etichette degli stati

è la matrice identità 2x2

è una matrice interamente nulla eccetto per la prima

l’ultima riga, rispettivamente (1/2 0) e (0 1/2)

è una matrice interamente nulla eccetto per la sopraper la sotto-diagonale, costituite interamente da (1/2).

Q^k tende a 0 per quanto visto nel quarto paragrafo.

Poniamo T[k] = sum[j=0..k] Q^k

(poniamo convenzionalmente Q^0 = I )

(

I

|

0 )

P^k = ( ------+------)

( T[k]R | Q^k )

prendendo il limite per k che tende all’infinito

A

(

I

|

0 )

= ( -------------+------)

( (I-Q)^(-1) R |

0 )

L’unica difficoltà di calcolo è ora il calcolo dell’inversa di (I-Q).

Per fortuna, dato che (I-Q) è una matrice tridiagonale, il calcolo

dell’inversa è ricondotto ad una semplice eliminazione di Gauss progressiva.

In particolare abbiamo che, se

( 2 -1 0 0 0 )

( -1 2 -1 0 0 )

A = ( 0 -1 2 -1 0 )

( 0 0 -1 2 -1 )

( 0 0 0 -1 2 )

(

(

====> A^(-1) = (

(

(

5

4

3

2

1

4

8

6

4

2

3

6

9

6

3

2

4

6

8

4

1

2

3

4

5

)

)

)

)

)

/6

in generale, se C è una matrice tridiagonale strutturata come A ma di dimensione n,

la sua inversa B è interamente descritta da

se j<=i B[i,j] =

se j>i B[i,j] =

j - (ij)/(n+1)

B[j,i] (matrice simmetrica)

Da facile algebra segue che la probabilità di vittoria di A è pari a m/(n+m)

e la probabilità di vittoria di B è pari a n/(n+m).

Jacopo D’Aurizio, matricola #270732, 2°anno Matematica, giugno 2005