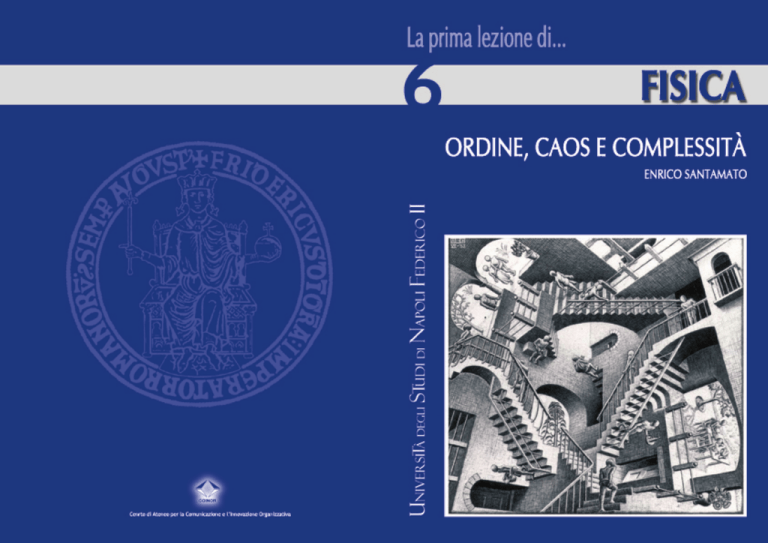

ORDINE, CAOS E COMPLESSITÀ

ENRICO SANTAMATO

1. INTRODUZIONE ......................................................... 2

2. DETERMINISMO E SEMPLICITÀ

...................................... 3

3. IMPREDICIBILITÀ E CAOS ............................................ 10

4. LA COMPLESSITÀ ..................................................... 22

5. CONCLUSIONI .......................................................... 40

6. APPENDICE ............................................................. 43

COME CONTINUANO GLI STUDI ....................................... 46

INTERVISTE AI LAUREATI ................................................ 50

Enrico Santamato è professore ordinario di Ottica Quantistica presso

l'Università degli Studi di Napoli Federico II

[email protected]

Tel. 081 67 63 59

2.

DETERMINISMO E SEMPLICITÀ

La convinzione di una Natura semplice nasce dal fatto che

sembrano esistere "leggi" della Natura. Queste leggi sono la base di

una concezione ordinata e deterministica del mondo. Per comprendere l'essenza delle leggi di Natura in un contesto leggermente più

ampio che le scienze naturali, è conveniente utilizzare alcune idee

tratte dalla recente matematica e scienza dei computer.

Consideriamo le due sequenze numeriche

1.

INTRODUZIONE

Se conversando con un fisico delle particelle elementari vi

trovate a parlare della natura del mondo, egli vi racconterà ben presto come semplice e simmetrico sia in realtà il mondo fisico, purché

lo si guardi dalla giusta prospettiva. Ma se si osserva la realtà che ci

sta intorno, ci si accorge che essa non è affatto semplice. Anche tra

gli stessi scienziati, pochi saranno d'accordo con il giudizio del fisico

delle particelle elementari. Per il chimico, il fisiologo, l'economista,

lo zoologo il mondo è tutt'altro che semplice. La realtà fenomenica

appare come un'accozzaglia di eventi la cui natura sembra essere più

che altro la loro mera esistenza in competizione con altri eventi,

senza alcuna tendenza verso la simmetria e la semplicità. Chi ha

ragione, dunque? Il mondo è veramente semplice come afferma il

fisico delle particelle o, viceversa, è complesso e spesso imprevedibile come appare a chiunque altro?

2

a)

0123012301230123…

b)

012002130220120320130…

e chiediamoci se queste due sequenze sono ordinate o no. È

evidente che la prima sequenza è ordinata per la semplice ragione

che noi vediamo in essa una struttura regolare; cioè, noi possiamo

sostituire la sequenza a) con una regola (o legge) che ci permette di

ricordarla facilmente o di comunicarla ad altri usando un messaggio

molto più corto che la sequenza stessa. Diremo che una sequenza di

simboli è ordinata o deterministica se essa può essere abbreviata in

una formula o regola molto più corta della sequenza stessa. Diremo

anche che una tal sequenza è "comprimibile". Viceversa, non esiste

alcuna formula o legge che permetta di ricostruire la sequenza b):

l'unico modo di trasmettere questa sequenza a una terza persona è

trasmetterla integralmente così com'è. La sequenza b) è impredicibile e, pertanto, è anche incomprimibile. In effetti, la sequenza a)

è stata generata designando con le cifre da 0 a 3 i successivi passaggi dell'orbita di un pianeta attraverso quattro punti prefissati lungo

la sua orbita e la sequenza b) è stata generata gettando ripetuta3

mente un dado a quattro facce. È ovvio che la sequenza a) è il prototipo di qualunque fenomeno periodico regolare e che la sequenza

b) è il prototipo di qualunque fenomeno caotico.

È possibile esprimere quanto detto in modo quantitativo calcolando quanti bit è necessario trasmettere a una terza persona perché questi possa ricostruire senza errori una qualunque sottosequenza di m cifre delle sequenze a) o b). Per effettuare il calcolo, esprimiamo le due sequenze in cifre binarie:

a')

00011011000110110001101100011011…

b')

00011000001001110010100001100011…

dove N è il numero di sottosequenze distinte a n bit che possono

essere trasmesse, troviamo che l'informazione necessaria per ricostruire un messaggio di n bit dalla sequenza b') è i = log22n = n bit,

pari alla lunghezza del messaggio stesso. Nel caso della sequenza a')

si ha N = 4 e l'informazione da trasmettere è molto minore e vale

i=log24 = 2 bit, come già detto. In questo calcolo abbiamo considerato l'estrazione delle sottosequenze a n bit sia da a') che da b') completamente a caso. Se si assume, invece, che ciascuna delle 2n sottosequenze possibili abbia probabilità pi di essere trasmessa, possiamo definire l'informazione media da trasmettere come

Eq. 2

Consideriamo poi tutte le possibili sottosequenze distinte di

lunghezza n = 2m di a') e b'). Siccome a') è periodica con periodo di

otto posizioni, il numero N di sottosequenze distinte è sempre quattro, qualunque sia n: si tratta delle quattro sottosequenze di n cifre

binarie che iniziano con 00, 01, 10, 11, corrispondenti ai numeri 0,

1, 2, 3, rispettivamente. Per permettere a una terza persona di ricostruire l'intera sottosequenza di n cifre binarie è sufficiente trasmettergli solo i primi due bit. L'informazione contenuta in un messaggio

di n bit preso a caso dalla sequenza a') può essere compressa in due

bit soltanto. Questo è dovuto alle regolarità e periodicità di tale

sequenza. Ma se passiamo a considerare un messaggio di n bit tratto dalla sequenza b'), che è del tutto casuale, ci accorgiamo che il

numero di sottosequenze distinte possibili di lunghezza n è N = 2n (le

sottosequenze a n bit possono essere poste in corrispondenza biunivoca con i numeri naturali da 0 a 2n - 1). Se ora definiamo l'informazione i (in bit) come

Nel caso di equiprobabilità, pi = 1/N e si riottene la formula

precedente. Per messaggi molto lunghi, la quantità K è piccola per

la serie ordinata a') ed è molto grande per la serie casuale b').

Seguendo Kolmogorov, possiamo prendere K come misura del grado

di ordine di una sequenza. Nella trattazione statistica dei sistemi

termodinamici si introduce l'entropia con una formula identica alla

Eq. 2, in cui le probabilità pi si riferiscono alla realizzazione di un

particolare stato microscopico del sistema per un numero fissato di

molecole e un dato valore dell'energia totale. Appare quindi logico

assegnare a K il nome di "entropia di Kolmogorov". Le sequenze ordinate sono molto compressibili e hanno un'entropia di Kolmogorov

piccola, che, inoltre, non varia o varia poco al variare della loro lunghezza. Le sequenze disordinate sono poco compressibili e hanno, in

genere, un'entropia di Kolmogorov grande, che cresce linearmente

con la loro lunghezza. L'entropia di Kolmogorov, ci mette in grado di

misurare quantitativamente il grado di ordine di un sistema.

Eq. 1

4

5

Questo semplice esempio ci può insegnare alcune cose circa

la natura della ricerca scientifica. Si può considerare infatti la scienza come la ricerca della massima compressione dell'informazione. La

semplice osservazione del mondo e la registrazione quantitativa dei

fatti che in esso avvengono non fanno scienza. Noi cerchiamo invece delle regolarità in questi fatti, regolarità che noi diciamo essere

le leggi della Natura e che ci permettono di condensare in poche

proposizioni o formule una grande quantità di informazioni riguardo

ai fenomeni naturali. Le grandi tappe della storia della Fisica sono,

in fondo, momenti di grande sintesi. La prima grande sintesi di questo tipo è stata concepita da Newton con la sua legge di gravitazione universale e i suoi principi sul moto. Tutti i fenomeni meccanici,

dal moto dei pianeti alla caduta della mela dall'albero possono essere "compressi" in una semplice legge di forza inversamente proporzionale al quadrato della distanza e a un semplice legame lineare tra

le accelerazioni dei corpi e le forze loro applicate. Una seconda

grande sintesi è stata portata a termine da Maxwell, che in poche

equazioni è riuscito a comprimere tutti i fenomeni elettromagnetici

dalla legge di Faraday sull'induzione magnetica alla propagazione

delle onde radio, della luce e dei raggi X e gamma.

Anche la teoria della relatività ristretta fu proposta da

Einstein nello spirito di un'ulteriore compressione delle leggi fisiche,

al fine di includere in un'unica teoria le leggi della meccanica e quelle dell'elettromagnetismo. È significativo il fatto che l'esigenza di

sintesi è stata in questo caso così forte da far rinunciare alle stesse

categorie aristoteliche di spazio e tempo assoluti. Si è preferito

affermare che lo scorrere del tempo è influenzato dal moto dei corpi

pur di unificare meccanica e elettromagnetismo. La teoria generale

della relatività è stata anch'essa un ulteriore momento di sintesi: in

questa teoria le cosiddette forze apparenti che si osservano nei

sistemi di riferimento accelerati sono unificate alla forza gravitazionale, per cui viene a cadere la distinzione tra sistemi di riferimento

inerziali e non inerziali. Il prezzo da pagare per raggiungere questa

nuova "compressione" è stato rinunciare alla struttura piatta dello

spazio Euclideo. al teorema di Pitagora e al principio delle rette

parallele che a noi appaiono così evidenti. La sintesi operata dalla

teoria generale della relatività è così grande da render possibile scrivere un'equazione di evoluzione per l'universo intero. I modelli

cosmologici come quello del big bang sono basati sulle equazioni

della relatività generale1. A partire dagli anni '70, l'unione dei concetti geometrici propri della relatività generale con quelli provenienti dalla meccanica quantistica ha permesso di fare ulteriori passi

in avanti verso quella che è chiamata la "grande unificazione" ovvero la "teoria del tutto" (Barrow91). In queste teorie le forze elettromagnetiche e deboli2 appaiono come aspetti di un unico tipo d'inte-

Fig. 1. La via all'unificazione delle interazioni fondamentali.

6

1 L'equazione fondamentale della relatività generale stabilisce semplicemente che la curvatura

dello spazio tempo in un punto è proporzionale al contenuto di energia e quantità di moto nello

stesso punto.

2 Le forze deboli sono responsabili di alcuni decadimenti radioattivi.

7

razione e ci sono buone possibilità che anche le interazioni forti3

possano essere incluse. Molto più problematica appare la possibilità

di includere le forze gravitazionali (Fig. 1).

Quanto si potrà andare avanti in questo processo di unificazione o "compressione" delle scienze fisiche? È abbastanza interessante, a questo proposito, la dimostrazione di Chaitin (Chaitin80),

basata sul teorema d'incompletezza di Gödel4, dell'impossibilità di

dimostrare se una sequenza di simboli è o no incompressibile. Non

potremo mai essere sicuri che la compressione raggiunta in una data

epoca storica è quella ultima: è sempre aperta la possibilità di una

unificazione ancora più profonda e, in ultima analisi, più semplice.

La sequenza "semplice" a) mostra una successione ripetitiva

di simboli che si mantiene costante nel tempo: la sequenza mostra

cioè una simmetria, nel senso che essa è invariante per una traslazione di due posti. Questa invarianza per traslazione è una "legge"

cui la sequenza a) obbedisce. D'altra parte, la stessa ripetitività

della sequenza ci permette di determinare univocamente tutte le

cifre successive a partire da una cifra qualunque assegnata. In altre

parole, il futuro della sequenza è univocamente determinato dal suo

presente. È questa l'essenza del determinismo: l'evoluzione futura di

un sistema è univocamente determinata dal suo stato presente.

L'esempio della sequenza a) mostra che il concetto (essenzialmente

dinamico) di evoluzione deterministica è strettamente collegato al

concetto (essenzialmente statico) di invarianza (o simmetria). Da

Newiton a Einstein, le leggi della Natura sono state viste sempre in

una prospettiva dinamica, come leggi deterministiche di evoluzione

3 Le interazioni forti rendono i nuclei atomici stabili a dispetto della forte repulsione elettrostatica tra i protoni carchi positivamente.

4 Questo teorema afferma che ogni teoria formale assiomatica o è incoerente o è in-completa,

nel senso che esistono infinite proposizioni la cui verità o falsità è indimo-strabile nell'ambito

della teoria stessa.

8

di un sistema, anche se è sempre stata ben chiara agli scienziati l'importanza delle leggi di conservazione, quali la conservazione dell'energia, della quantità di moto, ecc. e il loro stretto legame con le

proprietà di invarianza o di simmetria del sistema considerato. Le

leggi di Newton, ad esempio, fissano l'accelerazione di un corpo ad

un dato istante, il che permette di calcolare, noto lo stato del corpo

(cioè la sua posizione e velocità) in quel medesimo istante la sua

posizione e velocità (cioè il suo stato) ad un istante immediatamente successivo. La conoscenza delle leggi evolutive e dello stato oggi

permette di calcolare univocamente lo stato domani. È, questo, ciò

che chiamiamo determinismo. Durante l'evoluzione temporale di un

sistema meccanico, comunque, alcune quantità, come l'energia,

restano invariate. Nella visione newtoniana del mondo, l'esistenza di

quantità conservate era vista come mera conseguenza delle leggi

evolutive del moto. Questo è vero anche per le teorie della relatività ristretta e generale. A partire dagli anni '70, con la formulazione

delle cosiddette teorie di gauge5, che hanno portato verso la grande unificazione, le nozioni di invarianza e di simmetria hanno preso

via via il sopravvento sulla nozione di evoluzione, fino a diventare il

fondamento principale degli studi sulle particelle elementari e le

interazioni fondamentali della Natura. È evidente che più vincoli di

simmetria si impongono a una teoria, meno gradi di libertà restano

alla formulazione della teoria stessa. Estremizzando questo punto di

vista, alcuni scienziati hanno ipotizzato che la grande unificazione

delle interazioni fondamentali (gravitazione inclusa) possa essere

raggiunta nell'ambito di una teoria "supersimmetrica" come la

moderna teoria delle "superstringhe"6. Tale teoria dovrebbe racchiu5 Letteralmente gauge significa calibrazione. Le teorie di gauge esigono l'invarianza delle leggi

della Natura rispetto ai cambiamenti di gauge. Un semplice cambiamento di gauge è per esempio

quello di alterare (ricalibrare) le unità di misura di lunghezza e tempo in modo differente da punto

a punto nello spazio e al variare del tempo. La ricalibrazione può essere fatta in modo arbitrario

e le leggi della Natura non ne devono risentire.

6 Per una descrizione elementare del funzionamento delle teorie supersimmetriche si veda, ad

esempio, Green86, Bailin89.

9

dere tante di quelle simmetrie da renderla pressoché unica. Una

teoria di questo genere avrebbe raggiunto la massima compressione

possibile delle leggi della natura e, nel contempo, la massima semplicità. Anche se allo stato odierno le teorie del tutto sono più che

altro speculazioni, è innegabile che l'aver adottato il punto di vista

delle simmetrie piuttosto che quello precedente dell'evoluzione

deterministica ha prodotto risultati incoraggianti, verificati sperimentalmente, quali l'unificazione elettrodebole. È proprio la possibilità di concepire un piccolo insieme di leggi che governano le forze

fondamentali della Natura e che possano convergere, a loro volta, in

una singola legge unificata il cuore della percezione del mondo come

qualcosa di semplice (Fig. 1).

3.

Fig. 2. Rottura della simmetria. a) buca di potenziale singola; b) buca di

potenziale doppia.

La figura a sinistra mostra un corpo che si muove nella buca

di potenziale V1(x) = x2 + x4. La figura a destra mostra lo stesso

corpo che si muove nel potenziale V2(x) =- x2 + x4. I due potenziali

differiscono solo per il segno del termine in x2. La forza agente sul

IMPREDICIBILITA’ E CAOS

Come si giustifica, allora. l'evidente complessità e imprevedibilità dei fenomeni che osserviamo? Le sequenze del tipo b) non

hanno forse licenza di esistere in Natura? Il determinismo insito nelle

leggi naturali è sì o no compatibile con l'evidente impredicibilità di

molti eventi quotidiani? Il punto fondamentale che spesso sfugge

quando si affronta questo genere di problemi è che le simmetrie

delle leggi non implicano affatto la simmetria (e, quindi, la "semplicità") dei fenomeni che esse descrivono. È infatti possibile avere un

mondo che mostra strutture complicate e non simmetriche, ma che

tuttavia continui ad essere governato da leggi simmetriche. La simmetria presente nelle leggi viene rotta nei fenomeni. Per comprendere questo concetto si faccia riferimento alla Fig. 2.

10

corpo nei due casi è, come è noto, F1,2(x)=-dV1,2/dx. Quando il

corpo si trova nelle posizioni mostrate in figura dV/dx = 0 e la forza

si annulla. Le due posizioni sono quindi posizioni di equilibrio.

I potenziali V1(x) e V2(x) hanno la stessa simmetria speculare rispetto all'asse verticale mostrato nelle figure. Supponiamo ora di dare un

piccolo colpo al corpo mostrato in Fig. 2a. Il corpo inizierà ad oscillare intorno al minimo della curva di potenziale. Se non ci sono attriti o altri effetti dissipativi, il corpo continuerà le sue oscillazioni

indefinitamente in modo simmetrico rispetto all'asse di simmetria

del potenziale. La simmetria dell'equazione della dinamica che

governa il moto è rispecchiata nel moto stesso. Nel caso della doppia buca di potenziale, invece, un piccolo colpo fa sì che il corpo

cada in una delle due buche. Una volta caduto, il corpo inizia ad

oscillare attorno al nuovo minimo di potenziale per un tempo indefinito. Il moto non rispecchia più la simmetria assiale della legge che

l'ha generato e non potrà mai più rispecchiarla. Si dice, in tal caso,

che la simmetria della legge fisica è stata rotta. La rottura della sim11

metria, una volta avvenuta, è irreversibile. Il corpo in Fig. 2a è in

una posizione di equilibrio stabile, il corpo in Fig. 2b è in un punto

di equilibrio instabile. Quando un sistema fisico durante la sua evo-

che apparivano nei giochi d'azzardo. Pascal fu tra i primi a chiedersi se esistesse o no un "regolarità del caso" e a porsi problemi anche

pratici quali, ad esempio, come dividere le poste quando un gioco

luzione si trova in prossimità di una doppia buca di potenziale (o,

come si dice, di un punto di biforcazione) esso diviene instabile e

deve effettuare una scelta. Tale scelta avviene sotto l'azione di piccole perturbazioni casuali, per cui è impossibile sapere a priori verso

quale ramo della biforcazione il sistema evolverà. Se poi il sistema

d'azzardo viene interrotto. L'esperienza mostra che un processo

casuale o stocastico ha due caratteristiche principali: da un lato i

singoli eventi (ad esempio, il risultato del lancio di due dadi o l'estrazione di un numero al lotto) hanno un modo di presentarsi che è irregolare e imprevedibile; dall'altro, alla lunga, emerge qualche tipo di

incontra un numero molto grande di biforcazioni non sarà più possibile prevedere il suo comportamento a lungo termine. Si capisce così

che non solo la simmetria, ma anche il determinismo delle leggi fisi-

regolarità. Questa regolarità, che si osserva in un gran numero di

eventi ripetuti nelle medesime condizioni, permette di calcolare

opportuni valori medi, di assegnare opportune probabilità ai singoli

che viene perduto quando si osservano i fenomeni che da tali leggi

scaturiscono. I fenomeni sono complessi a dispetto della semplicità

eventi e di fare anche delle previsioni. La teoria matematica delle

probabilità è stata sviluppata dapprima da Pascal e Laplace e, in

delle leggi. Gli scienziati che studiano i fenomeni hanno la percezione di un mondo complesso. Della complessità si parlerà più avanti.

Qui accenneremo al caso limite dei sistemi il cui comportamento è

tempi più recenti, da Bayes e poi, in connessione con la teoria dell'informazione, da Shannon e, soprattutto, da Kolmogorov. Senza

entrare nei dettagli della teoria delle probabilità, basterà dire qui

del tutto imprevedibile, cioè casuale o, come si dice, stocastico.

che questa teoria trova il suo fondamento nella cosiddetta "legge

empirica del caso" o "legge dei grandi numeri". Questa "legge" afferma che se n è il numero di volte in cui l'evento scelto si è realizzato (ad esempio è venuto un doppio sei) su un numero N di tentativi

(di lanci dei due dadi), allora il limite

Eq. 3

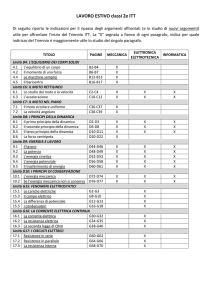

Fig. 3. Simulazione di 26 (a sinistra) e 1717 (a destra) lanci di due dadi a

sei facce. Le barre rosse sono le frequenze n/N osservate.

Le barre azzurre sono le probabilità calcolate.

L'attenzione verso i fenomeni casuali comincia molto dopo

quella dedicata a scoprire le leggi deterministiche della Natura,

quando verso il '600 si cominciarono a notare certe strane regolarità

12

tende a un valore finito che chiamiamo "probabilità" dell' evento

considerato. Il calcolo delle probabilità insegna come manipolare

matematicamente le probabilità. L'Eq. 3 connette le probabilità calcolate per via teorica con le "frequenze" n/N misurate sperimentalmente. La legge dei grandi numeri ha un fondamento empirico. Il

lettore può verificarla di persona lanciando una coppia di dadi un

gran numero di volte oppure facendo girare la macro in Excel in

Appendice A. La Fig. 3 mostra l'istogramma dei risultati della macro

13

di simulazione di 26 e di 1717 lanci, rispettivamente. Come si vede

l'accordo tra frequenze (barre rosse) e le probabilità (barre azzurre)

migliora con l'aumentare del numero N di lanci. Il sette è il risultato più probabile.

Nell'ambito della fisica, la teoria delle probabilità ha assunto via via una sempre maggiore rilevanza. Infatti, l'esperienza

mostra che, al di là del determinismo delle leggi naturali, tutti i

fenomeni fisici sono accompagnati da un grado maggiore o minore di

impredicibilità, che chiameremo genericamente "rumore". L'origine

del rumore è, di solito, l'interazione del sistema considerato con il

mondo esterno che viene chiamato "il bagno termico". In altri casi,

l'origine del rumore è la "granularità" stessa del sistema che è formato da moltissimi individui (persone nel caso delle scienze statistiche

e demografiche, molecole ed atomi nel caso dei sistemi materiali).

Per meglio studiare le regolarità (leggi) soggiacenti ai fenomeni, gli

scienziati, nei loro esperimenti, pongono particolare cura nell'eliminare ogni fonte di "rumore". L'eliminazione totale del rumore è

impossibile, comunque, se non altro per la presenza del "rumore

quantistico"7. La fonte più comune di rumore è la cosiddetta "agitazione termica", che dipende dalla temperatura del sistema considerato8. Abbassare la temperatura è di solito la via maestra per diminuire il rumore. Fenomeni quantistici particolari come la superconduttività, la superfluidità e la condensazione di Bose-Einstein sono

osservabili solo a bassissima temperatura, in un ambiente, cioè, a

bassissimo rumore. Per questi motivi, lo studio del "rumore" o,

meglio, dei processi stocastici è uno dei capitoli più importanti della

fisica. Un modello meccanico di un processo stocastico è quello di un

moto a caso (moto dell'ubriaco). Un moto casuale di questo tipo si

osserva in pratica nel cosiddetto moto browniano.

7 Il rumore quantistico ha caratteristiche molto peculiari e obbedisce a regole diverse da quelle

postulate nella teoria delle probabilità.

8 La stretta connessione tra "rumore termico" e temperatura è dovuta a Boltzmann.

14

3.1

IL MOTO BROWNIANO

Per ironia della sorte, il moto browniano fu scoperto casualmente dal naturalista Robert Brown nel 1828. Osservando al microscopio alcuni granelli di polline sospesi in acqua, Brown notò che i

granelli si muovevano continuamente avanti e indietro come se fossero vivi9. In effetti, Brown li scambiò per microorganismi viventi. Il

fenomeno fu spiegato molto tempo dopo (1905) da Einstein, il quale

dimostrò che tale moto era dovuto ai continui urti delle molecole

dell'acqua sui granelli. Gli urti avvengono da tutti i lati, per cui il

loro effetto medio è zero. Talvolta, però, gli urti si combinano in

modo da produrre una forza sufficiente a spingere il granello da un

lato o dall'altro, da cui il moto "danzante" dei granelli osservato sperimentalmente. Il moto di una particella browniana genera sequenze casuali ad alta entropia K simili alle sequenze b) e b') considerate nel paragrafo 2. Il moto browniano, però, non è completamente

casuale come il risultato del lancio di un dado, ma presenta un certo

grado di correlazione, ovvero di determinismo. Nei moti deterministici, la posizione e velocità all'istante t determinano univocamente

la posizione e velocità all'istante immediatamente successivo t+dt.

Nel moto browniano, invece, la posizione a t determina la probabilità di avere un'altra posizione al tempo t+dt. Sebbene la posizione

x(t+dt) della particella al tempo t+dt sia casuale, la sua probabilità

dipende dalla posizione x(t) all'istante precedente t, che, quindi,

mantiene una certa influenza sul futuro. In particolare, la posizione

x(t+dt) deve essere necessariamente molto vicina alla posizione

x(t), perché la particella non può scomparire da un punto e riapparire istantaneamente in un punto distante.

9 Un filmato del moto Browniano di alcune goccioline di grasso nel latte può essere visto nel sito

http://www.pik-potsdam.de/~tillk/brown.html

15

La probabilità10 P(x(t+dt);x(I)) di trovare la particella in

x(t+dt) deve decrescere a zero molto rapidamente al crescere dello

spostamento Δx = x(t+dt)- x(t).

In effetti, nella teoria del moto browniano si assume una

distribuzione gaussiana P(x(t+dt);x(t))=P(Δ)=A exp(-Δ2/σ2), dove A

e σ sono costanti. La variabile casuale non è la posizione, bensì lo

spostamento Δ della particella; inoltre, l'evento più probabile è Δ =

0, cioè che la particella non si sposti affatto. Ma, dove appare, allora la "regolarità" del caso? Esitono leggi che governano il moto browniano? La risposta è sì. Il punto cruciale è che le leggi, ora, non si

riferiscono direttamente al moto della particella, che è impredicibile, ma all'evoluzione temporale della probabilità P(x,t) di trovare la

particella in x all'istante t. Infatti la legge che governa il moto brow-

sarà molto più alta di quella del moto del pianeta, ma un po' più

bassa di quella del lancio di un dado. Essendo comunque un processo stocastico, ci aspettiamo che l'entropia del moto browniano cresca man mano che esso evolve dalla posizione iniziale

(Santamato82). La crescita di entropia è sempre accompagnata da

dissipazione di energia, energia che nel caso del moto browniano è

ceduta al fluido circostante tramite le forze viscose. Esiste, infatti,

una stretta connessione tra dissipazione di energia e forze (o moti)

fluttuanti (teorema di fluttuazione-dissipazione): questa connessione è stata dimostrata da Einstein, che ha trovato la celebre relazione tra la viscosità del mezzo η, la costante di diffusione D e la temperatura assoluta T

niano è (D è la cosiddetta costante di diffusione)

Eq. 5

Eq. 4

conosciuta come l'equazione di Fokker-Planck o equazione

della diffusione. Questa equazione è deterministica, perché si può

dimostrare che la funzione P(x,t) è univocamente determinata dalla

funzione P(x,t0) arbitrariamente assegnata all'istante t0.

L'esempio del moto browniano mostra come possa esistere

una gradualità nel caos: la posizione x(t) di una particella browniana è un processo meno casuale del lancio di un dado o dell'estrazione di un numero al lotto, ma certamente più casuale dell'orbita di

un pianeta. L'entropia di Kolmogorov K associata al moto browniano

dove k = 1,38 10-16 erg/°K è la costante universale di

Boltzmann e r è il raggio della particella, che supponiamo sferica. La

Eq. 5 mostra che la costante di diffusione D e, quindi, il moto caotico browniano, è tanto più grande quanto più cresce la temperatura

e quanto più è piccola la particella in sospensione nel fluido.

Quest'ultimo fatto permette di comprendere come il moto browniano ostacoli il funzionamento di meccanismi e motori a livello nanometrico. Esistono comunque metodi molto astuti11 messi in opera sia

dall'intelligenza umana sia dalla stessa Natura per aggirare questo

problema e permettere il funzionamento dei cosiddetti motori molecolari (Sauvage01). I motori molecolari costituiscono uno dei più

interessanti campi di ricerca applicata della nostra epoca e sono alla

11 Il più comune di questi metodi è simile al meccanismo a ruota dentata che si trova in alcuni

10 Più esattamente, essendo x una variabile casuale continua, si dovrebbe parlare di densità (o

orologi che non necessitano di carica o di batteria: questo meccanismo converte il moto casuale

distribuzione) di probabilità.

(browniano) del braccio in un moto ordinato (motore) che mantiene carico l'orologio.

16

17

base di molti fenomeni sia fisici che biologici12. Purtroppo, discutere il loro funzionamento ci porterebbe troppo lontano dal filo principale del nostro discorso.

Il moto browniano ha avuto e continua ad avere un ruolo primario in molti settori della fisica e viene usato per trattare sistemi

che vanno dalle dimensioni degli atomi a quelle delle stelle. Infine,

occorre tener presente che l'evoluzione dei "sistemi complessi dissipativi", di cui si parlerà più avanti, è sempre innescata dal rumore di

fondo prodotto dall'onnipresente moto browniano dovuto all'interazione tra le diverse parti del sistema stesso o con l'ambiente circostante.

nica quantistica, una teoria inizialmente concepita per includere

pochi fenomeni abbastanza marginali, quali il problema del corpo

nero, dei calori specifici dei gas, dell'effetto fotoelettrico e degli

spettri di righe dei gas, che restavano inspiegati sulla base della

meccanica newtoniana e dell'elettromagnetismo maxwelliano. Ben

presto, però, la meccanica quantistica, con la sua estensione

all'elettrodinamica quantistica, mostrò una capacità di previsione di

un numero talmente grande di fenomeni atomici, nucleari e subnucleari, fin nei minimi dettagli, che oggi essa è una delle teorie più

accreditate e confermate della fisica, nonostante i seri problemi che

tale teoria presenta nei suoi fondamenti e nell'interpretazione fisica

del suo formalismo. Della meccanica quantistica si parlerà altrove in

questo libro. I soli aspetti della meccanica quantistica che esamineremo qui sono quelli concernenti la sua interpretazione statistica.

3.2

IL MOTO QUANTISTICO

La possibilità di processi casuali come il moto browniano,

non è in reale contrasto con l'idea che la Natura segua leggi deterministiche. Laplace, uno dei più grandi studiosi del calcolo delle probabilità, dichiarò che una Mente suprema avrebbe sempre conosciuto tutto il passato e tutto il futuro dell'universo, conoscendone lo

stato in un istante e che il fatto che gli uomini non potessero fare

altrettanto dipendeva da una sorta di ignoranza parziale. Secondo

questa visione, la teoria delle probabilità e la fisica statistica si giu-

Abbiamo già detto che lo stato dinamico di una particella

classica è determinato univocamente dalla sua posizione e velocità

e che le leggi della meccanica governano in modo deterministico

l'evoluzione temporale dello stato. Nella formulazione più semplice,

non relativistica, della meccanica quantistica, lo stato di una particella all'istante t è determinato da una funzione complessa ψ(x, t)

della sua posizione, chiamata funzione d'onda. L'evoluzione temporale dello stato è governata da una legge deterministica, che permette la determinazione univoca di ψ(x, t), noto lo stato ψ(x, t0)

all'istante iniziale t0. Questa legge è condensata nell'equazione di

Schrödinger, che qui riportiamo

stificano come mezzi per creare modelli matematici di fenomeni, di

per sé deterministici, ma conosciuti solo parzialmente. Il positivismo

deterministico, che pareva così evidente nell'Ottocento, fu messo in

seria crisi negli anni '20 del secolo scorso dall'avvento della mecca12 Un esempio è il motore biochimico molecolare che permette la contrazione dei muscoli.

18

Eq. 6

dove m è la massa della particella,

erg s è la costante di Planck (divisa 2 pi greco) e V(x) è il potenziale in cui si muove

19

la particella. Il potenziale V(x) potrebbe essere, ad esempio uno dei

due riportati in Fig. 2. Il punto cruciale è l'interpretazione fisica

della funzione d'onda ψ(x, t). L'interpretazione fino ad oggi più

accreditata è quella statistica, proposta da Born.

La cosiddetta "regola di Born", infatti, stabilisce che la quan-

ψ (x, t)*ψ(x, t), dove l'asterisco indica la coniugazione complessa, è proporzionale alla probabilità13 di

trovare la particella nella posizione x all'istante t. Secondo questa

interpretazione, tutto ciò che le leggi della fisica (Eq. 6) possono

tità reale e positiva P(x, t) =

prevedere è la probabilità che si realizzi l'evento di trovare la particella in x all'istante t. La posizione x della particella è forzatamente una variabile casuale e non può mai assumere un valore ben definito. Possiamo anche pensare che, invece di descrivere una singola

particella, la funzione d'onda descriva un insieme statistico di particelle (che, individualmente, possono assumere posizioni ben definite) preparate in modo identico. In ogni caso, la posizione di una singola particella non può essere prevista se non statisticamente ed è

quindi soggetta a una sorta di indeterminazione14. È da notare che

tutte le teorie di unificazione delle interazioni fondamentali citate

nel §2 si basano sulla meccanica quantistica e prevedono un'evoluzione deterministica per lo stato del sistema, ma probabilistica per

i valori delle grandezze fisiche osservabili sperimentalmente.

Apparentemente siamo in una situazione molto simile al

moto browniano. Il determinismo è stato trasferito dalle quantità

osservabili sperimentalmente, come la posizione della particella,

13 Anche qui, come nel moto browniano, sarebbe più corretto parlare di densità di probabilità.

14 Il celebre "principio d'indeterminazione" di Heisenberg deriva direttamente dall'Eq. 6. Se si

cerca di localizzare la particella stringendo il "pacchetto d'onda" P(x,t) = ψ(x, t)* ψ(x, t) attorno

ad un punto fissato x , la rapida salita e discesa dei fronti del profilo a campana di P(x,t) porta

0

a derivate spaziali molto grandi, per cui il primo termine sulla destra nell'Eq. 6 cresce indefinitamente, impedendo, di fatto, una perfetta localizzazione.

20

alla probabilità di realizzazione dei loro valori, che, singolarmente,

sono impredicibili. Ma è veramente possibile ricondurre la meccanica quantistica a una sorta di processo caotico? In effetti, ci sono stati

tentativi di riportare la meccanica quantistica nell'ambito di un

modello classico simile al moto browniano (Nelson67), ma senza

effettivo successo. Il motivo è che la meccanica quantistica, anche

nella sua formulazione più semplice, differisce in modo sostanziale

da un processo stocastico per due ragioni fondamentali impossibili

da eliminare. La prima è che la meccanica quantistica non prevede

traiettorie, ma solo posizioni casuali per la particella. In altre parole, mentre osservando il moto browniano di una particella classica

possiamo associare ad essa una sequenza di numeri casuali del tipo

delle sequenze b) e b') del §2, esattamente come faremmo, del

resto, per un pianeta, nel caso quantistico questo è impossibile per

principio. Sarebbe vano associare al moto "caotico" della particella

quantistica una qualche informazione o entropia K alla

Kolmogorov15. La seconda ragione è che ogni processo stocastico

produce, come visto, un aumento dell'entropia nel tempo con conseguente dissipazione d'energia. I processi stocastici sono processi

essenzialmente irreversibili, rispetto ai quali passato e futuro non

sono simmetrici. Questo è rispecchiato dal fatto che l'Eq. 4 cambia

se si inverte il segno del tempo; non gode, cioè, della simmetria d'invarianza rispetto al cambiamento del segno della freccia del tempo.

Viceversa, la meccanica quantistica è pur sempre una teoria "meccanica", che conserva l'energia e per la quale passato e futuro sono

indistinguibili. Infatti, se si cambia il segno di t nella Eq. 6, l'equazione si trasforma nella complessa coniugata, cioè ψ(x,-t) = ψ*(x, t),

lasciando invariata la probabilità P(x,t). Le equazioni della meccani15 È possibile, viceversa, associare dell'informazione (detta qu-bit) alla funzione d'onda ψ, perché essa obbedisce a una legge deterministica. La informazione quantistica ha assunto in tempi

recenti una notevole importanza, perché potrebbe aprire la strada a computer superveloci di

nuova concezione.

21

ca quantistica sono simmetriche rispetto al cambiamento del segno

della freccia del tempo16. Nel suo approccio stocastico alla meccanica quantistica, infatti, Nelson è stato costretto a considerare due

moti browniani sovrapposti e simmetrici, il primo normale e il secondo che procede dal futuro verso il passato. È evidente che l'intera

costruzione appare alquanto improbabile e bizzarra. In verità, fino

ad oggi, non si è trovata nessun’interpretazione fisica della meccanica quantistica più soddisfacente di quella, pur insoddisfacente,

basata sulla regola di Born.

il DNA è un codice in grado di organizzare la materia circostante in

modo tale da creare un organismo vivente? La stessa cosa si può dire

per la sequenza

4D 5A 90 00 03 00 00 00 04 00 00 00 FF FF 00 00 B8 00 00 00

00 00 00 00 40 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00

C8 00 00 00 0E 1F BA 0E 00 B4 09 CD 21 B8 01 4C CD 21 54 68

69 73 20 70 72 6F 67 72 61 6D 20 63 61 6E 6E 6F 74 20 62 65

20 72 75 6E 20 69 6E 20 44 4F 53 20 6D 6F 64 65 2E 0D 0D 0A

24 00 00 00 00 00 00 00 EF 12 18 FB AB 73 76 A8 AB 73 76 A8

apparentemente sembra senza significato, ma, in realtà, è la

sequenza iniziale in cifre esadecimali del programma del PC con cui

questo articolo è stato scritto. La cosa che interessa qui non è tanto

4.

se la sequenza è più o meno ordinata, ma piuttosto il fatto che proprio quella sequenza, unita al resto del programma e inserita in un

ambiente appropriato (il PC), è in grado di produrre effetti osserva-

LA COMPLESSITÀ

Si consideri la seguente sequenza numerica

c)

023011003332…

A prima vista non sembra dire molto, eppure si tratta di una sequenza molto importante…infatti è un piccolo pezzo della sequenza del

nostro DNA, con 0,1,2,3 corrispondenti alle quattro basi adenina,

guanina, citosina, timina. Potremmo associare all'intera sequenza

del DNA umano un valore K dell'entropia di Kolmogorov. Come è

noto, la sequenza del DNA non è periodica, ma, d'altra parte, non è

nemmeno completamente casuale. Troveremo quindi un valore di K

abbastanza alto, ma minore della lunghezza dell'intera sequenza. Ma

il valore più o meno alto dell'informazione o dell'entropia K del DNA

è così rilevante? O non è, piuttosto, molto più rilevante il fatto che

16 In realtà, se si considerano particelle dotate di carica elettrica, l'invarianza delle equazioni è

preservata se, insieme al segno del tempo (T) si cambia simultaneamente il segno della carica (C).

Si dice che l'invarianza delle leggi quantistiche è per CT. Se si includono, poi, le interazioni deboli, l'invarianza si restringe a CPT, dove P, detta parità, corrisponde all'inversione simultanea delle

tre coordinate spaziali.

22

bili e, soprattutto, utili. Diremo che una sequenza di questo tipo è

complessa. L'aver dato un nome, però, non significa aver colto il

significato della parola "complessità" nell'accezione che ci interessa.

La sequenza del DNA così come la sequenza di cifre esadecimali di

un programma di computer acquistano rilevanza non per le singoli

parti che le compongono (nucleotidi in un caso, bit nell'altro), ma

per come queste parti si combinano tra loro in modo da produrre una

o più funzioni specifiche che agiscono sull'ambiente circostante.

Possiamo dire che, in questi casi, il tutto è molto più importante che

la semplice somma delle parti e che è proprio il tutto che segue,

eventualmente, comportamenti le cui leggi occorre comprendere e

studiare. Quando usiamo un editor di testo al PC, ci interessa conoscere le funzioni che può eseguire e la logica di tali funzioni.

Similmente, quando il fisiologo studia un essere vivente, ciò che

interessa sono le reazioni del soggetto agli stimoli ambientali e le

logiche che a tali reazioni soggiacciono. Queste logiche e queste rea23

zioni agli stimoli esterni sono le caratteristiche precipue dei sistemi

complessi e hanno ben poco in comune con le leggi fondamentali

della Natura. Per comprendere il comportamento dei sistemi com-

glio indifferenziato di materia (principalmente elettroni e neutrini

con le rispettive antiparticelle) e radiazione (fotoni) in perfetto

equilibrio termodinamico: in questo stato l'Universo è un sistema

plessi occorre un approccio olistico e non riduzionistico, occorre trovare le leggi che governano il tutto mentre le leggi elementari che

governano le singole parti assumono un ruolo secondario e, a volte,

assolutamente irrilevante.

molto simmetrico e, perciò, semplice. Via via che l'Universo, espandendosi, diminuisce la sua temperatura cominciano ad apparire i

protoni e i neutroni (1 secondo dal big bang) e, poi, successivamente, i primi atomi leggeri di elio (10 secondi dal big bang), poi di trizio, quindi di deuterio fino ad arrivare alla formazione dei nuclei

Abbiamo considerato due esempi di sistemi complessi, uno

atomici pesanti (circa tre minuti dal big bang) e alla completa annichilazione tra elettroni e positoni, tranne quella piccola quantità di

elettroni in eccesso (uno su un miliardo) necessaria a controbilancia-

tratto dalla biologia e uno tratto dalla cibernetica. Ma è altrettanto

facile trovare esempi tratti dal mondo fisico. Un cristallo, un pendolo e un pianeta sono esempi di sistemi molto ordinati (l'entropia K è

bassa), mentre un liquido o un gas sono sistemi molto disordinati

(l'entropia K è alta), ma nessuno dei due sistemi può dirsi complesso. Il comportamento di questi sistemi, infatti, può essere dedotto

conoscendo le leggi della meccanica nel primo caso e della fisica statistica nel secondo. Ma consideriamo, invece, un materiale super-

re la carica dei protoni. Dopo questi primi minuti, l'Universo continuerà ad espandersi, gli atomi, ormai stabili, cominceranno ad

aggregarsi per attrazione gravitazionale, fino a formare le galassie,

le stelle, i pianeti finché, "dopo altri 10 miliardi di anni, alcuni esseri viventi (in verità molto complessi) inizieranno a ricostruire questa

storia" (Weinberg77).

conduttore ad alta temperatura critica (Gough91). Materiali di questo genere non esistono in natura, né si formano per caso: la loro

proprietà interessante, la superconduttività, si basa su una miscela

molto particolare creata in condizioni particolari che non avrebbe

mai potuto manifestarsi nell'universo prima che sulla Terra si fosse

realizzata la miscela giusta nel 1987. Possiamo dire che la complessità che chiamiamo "superconduttività ad alta temperatura critica" è

basata su di un'altra complessità, che chiamiamo "intelligenza", che

Si può dire che la moderna scienza dei materiali basata sulle

nanotecnologie non sia altro che l'applicazione pratica della complessità. L'idea di fondo è che un'intelligente strutturazione dei

materiali a livello nanometrico, resa tecnologicamente possibile solo

di recente, può conferire ad essi caratteristiche molto diverse da

quelle associate alle singole molecole di cui sono costituiti. Al di là

della sfida tecnologica posta dalla realizzazione pratica delle nano-

ha agito come una sorta di catalizzatore per la sua creazione.

L'intelligenza, a sua volta, ha richiesto miliardi di anni di evoluzione

dal caotico brodo primordiale fino alla "semplice" complessità delle

prime cellule protozoiche e su su verso organismi sempre più differenziati e complessi. Anche l'Universo ha subito un simile processo

strutture, progettare le strutture stesse e prevedere le proprietà che

esse potranno conferire al materiale è una sfida anche intellettuale,

perché, come detto, gli effetti legati alla complessità generata dalla

strutturazione obbediscono a leggi non derivabili dalle leggi note

della fisica e ancora in gran parte da scoprire. L'evidenza sperimen-

evolutivo (Weinberg77). Un centesimo di secondo dopo il big bang ad

una temperatura di 100 miliardi di gradi Kelvin l'Universo è un miscu-

tale mostra, infatti, che i sistemi complessi esibiscono, nel loro comportamento d'insieme, regolarità che possono essere sintetizzate in

24

25

"leggi" , che tali leggi assumono spesso un carattere di "universalità",

nel senso che la successione di stati e di processi che hanno luogo in

alcune classi di sistemi complessi non dipendono dai dettagli del

sistema considerato e seguono leggi di scala ben definite17. La

determinazione di queste nuove "leggi" (che possiamo chiamare a

buon titolo olistiche) ha stimolato un'intensa attività teorica nell'ambito della struttura della materia, un'intensa attività sperimentale

nel campo delle nanotecnologie, lo sviluppo di tecniche di calcolo e

di simulazione numerica sempre più potenti e veloci e, infine, la

creazione di materiali e dispositivi di nuova concezione con grande

impatto anche in settori scientifici molto lontani, quali l'ingegneria,

la biologia, la medicina, ecc.

Laplace sulla Mente superiore in chiave ottusamente deterministica

e riduzionistica è superficiale. Già Poincaré, contemporaneo di

Laplace, fece notare subito che l'esistenza delle biforcazioni e della

instabilità poteva portare a quei comportamenti che oggi noi chiamiamo complessi. Solo negli ultimi 20-30 anni, con l'avvento dei

moderni sistemi di calcolo, è stato possibile introdurre la "matematica sperimentale". Il computer può essere programmato per simulare l'evoluzione di un sistema complicato, il cui comportamento a

lungo termine può essere studiato, modificato e ripetuto come in un

sofisticato gioco virtuale. Lo studio dei problemi semplici e affrontabili per via analitica è stato affiancato da quello di sistemi complessi in interazione con ambienti altrettanto complessi. Un esempio

è quello dei sistemi ecologici che evolvono nel loro ambiente per

Sembra quindi lecito speculare sull'esistenza di nuove "leggi"

o "principi" che governano l'esistenza e l'evoluzione della complessità, definita in qualche senso astratto (Lloyd88). Queste leggi potreb-

selezione naturale e che, nel far questo, modificano l'ambiente stesso in modo complicato. Va detto, comunque, che la stessa definizione di "complessità" è sfuggente e, finora, non si è trovato alcun

bero essere molto diverse dalle leggi del fisico delle particelle e non

essere basate sulla simmetria e l'invarianza, ma, piuttosto, su principi di logica e di elaborazione dell'informazione. Fino a tempi

modo soddisfacente di misurare quantitativamente il grado di complessità di un sistema (anche se ad ognuno è evidente che un mam-

recenti, i fisici hanno focalizzato la loro attenzione principalmente

sullo studio delle leggi fondamentali più che sulla complessità delle

conseguenze di quelle leggi. Questo non deve stupire: lo studio delle

conseguenze delle leggi (ovvero delle possibili soluzioni delle equazioni che esprimono quelle leggi) è un problema molto più difficile,

che richiede la disponibilità di computer molto potenti, dotati di una

grafica veloce ed interattiva. Non è una coincidenza che lo studio

della complessità e del caos che compaiono nelle soluzioni delle

equazioni è cresciuta enormemente con lo sviluppo di PC a basso

costo. Non bisogna però credere che i fisici non fossero consapevoli

di tale complessità anche in passato: la lettura delle parole di

17 L'individuazione teorica di questi caratteri di universalità richiede tecniche matematiche sofisticate quale l'uso del cosiddetto "gruppo di rinormalizzazione".

26

mifero è più complesso di un batterio). Nel caso dell'informatica,

una possibile via potrebbe essere quella di misurare non tanto il contenuto di informazione di una sequenza di bit, quanto piuttosto il

tempo di calcolo necessario per generare quella sequenza. Generare

una sequenza periodica o una sequenza casuale richiede un codice

molto breve e di rapida esecuzione. Generare il codice dell'editor di

testo usato per scrivere questo articolo è costato anni di lavoro di

diverse persone. Generare il genoma umano è costato miliardi di

anni di evoluzione e di selezione. Nonostante la difficoltà di una precisa definizione, è possibile definire alcune proprietà e alcuni comportamenti tipici che sono comuni a tutti i sistemi complessi. In

molti casi, come già detto, è possibile scrivere perfino leggi matematiche universali che governano questi sistemi. Di questo parleremo brevemente nell'ultima parte di questo articolo.

27

4.1

LE LEGGI DEI SISTEMI COMPLESSI

Perché un sistema fisico possa definirsi complesso è necessario che il tutto sia più che la semplice somma delle singole parti. Per

questo motivo, i sistemi complessi sono detti anche sistemi cooperativi. In fisica esistono sistemi complessi basati sulla meccanica classica e sistemi complessi basati sulla meccanica quantistica (la superconduttività ad alta Tc appartiene a quest'ultimo tipo di sistemi).

Nel seguito, accenneremo solo ai sistemi complessi basati sulla meccanica classica e, quindi, su equazioni di evoluzione deterministiche.

Inoltre, possiamo distinguere i sistemi complessi in sistemi dissipativi, in cui l'energia del sistema viene dissipata nell'interazione con un

"bagno termico" e in sistemi "hamiltoniani" in cui gli attriti e gli

effetti dissipativi sono trascurabili e l'energia si conserva. I sistemi

complessi sono

- multistabilità

- auto-organizzazione

- presenza di caos deterministico

4.1.1

MULTISTABILITÀ

La presenza di dissipazione, fa sì che il sistema tenda a fermarsi in uno stato di minima energia. Lo stato di energia minima

assoluta è lo stato di equilibrio termodinamico.

hamiltoniani osservabili in natura sono molto rari. Gli esempi più

importanti si riferiscono al moto dei pianeti18, la progettazione di

acceleratori di particelle, in cui deboli fasci di particelle cariche si

muovono in intensi campi magnetici e la fisica dei plasmi confinati

magneticamente, quali si riscontrano nei dispositivi per la fusione

nucleare. Sebbene questi esempi siano rilevanti, nel seguito considereremo solo i sistemi dissipativi.

Quali caratteristiche hanno i sistemi complessi? Dal punto di

vista costitutivo, tali sistemi sono caratterizzati da una forte nonlinearità e, spesso, da sistemi di controreazione (in inglese, feedback)

o incorporati nel sistema stesso o aggiunti esternamente. La nonlinearità e la controreazione servono a far interagire le diverse parti

del sistema in modo non semplicemente additivo, ma cooperativo.

Dal punto di vista dinamico, le principali caratteristiche dei sistemi

18 Un esempio è il moto irregolare di Iperone, una luna di Saturno.

28

Fig. 4. Curva di energia potenziale V(x) che mostra la metastabilità. Il punto

A è il punto di equilibrio termodinamico stabile. I punti B, C, B', C' sono punti

di equilibrio metastabile. Una fluttuazione abbastanza forte potrebbe far

cadere lo stato del sistema da C a B e, infine ad A. Nel punto A, l'energia

non può diminuire ulteriormente, per cui questo stato è stabile.

Se questo stato è unico come in Fig. 2a, il sistema va certamente all'equilibrio termodinamico. Lo stato di equilibrio termodinamico è sempre stabile e, di solito, ben ordinato e simmetrico. In presenza di altri minimi relativi dell'energia, però, il sistema potrebbe

collocarsi in uno di essi, fissandosi in uno stato metastabile (Fig. 4).

La metastabilità è dovuta al fatto che l'inevitabile rumore dovuto al

29

bagno termico (teorema di fluttuazione-dissipazione) potrebbe fornire al sistema una spinta sufficiente per uscire dal minimo di energia in cui ritrova e cadere successivamente in un altro minimo più

basso dell'energia. Anzi, in un tempo infinto questo certamente

accadrà e il sistema cambierà continuamente stato fino ad arrivare

all'equilibrio termodinamico, che è l'unico stato veramente stabile.

Azioni esterne, come campi applicati od altro, possono far transire

di nuovo il sistema in un suo stato metastabile. Questa proprietà è

detta "multistabilità". Le plastiche, ad esempio, sembrano solidi, ma

sono in realtà sistemi metastabili. Esse sono costituite da polimeri,

molecole formate da lunghe catene atomiche in forma di filamenti.

Lo stato di equilibrio termodinamico corrisponde a tutti questi filamenti allineati in un'unica direzione. Ma questo non succede mai:

infatti, durante il processo di polimerizzazione, i filamenti molecolari si aggrovigliano tra loro formando stati metastabili di minimo

relativo dell'energia. Nel tempo, il polimero cambia continuamente

stato (i filamenti tendono ad allinearsi) passando da un minimo relativo di energia all'altro. Ma i minimi sono talmente tanti e i tempi di

transizione sono così lunghi che questo processo richiede, in certi

casi, molti millenni. Il fenomeno è analogo a quanto ciascuno di noi

vede quotidianamente dietro il proprio PC. I fili che collegano il PC

alla stampante, al monitor e alle altre periferiche hanno un minimo

di energia gravitazionale quando poggiano tutti sul tavolo senza

sovrapporsi l'un l'altro. Eppure sappiamo bene che questi cavi sono

perennemente intrecciati e quanta fatica ci vuole per districarli. Il

motivo per cui i fili tendono ad intrecciarsi è che l'insieme degli stati

a fili intrecciati è molto più numeroso (tali stati intrecciati sono

molto più probabili) che l'insieme degli stati, di minima energia con

tutti i fili posti a contatto del tavolo. Poiché gli stati a fili intrecciati non corrispondono al minimo assoluto dell'energia gravitazionale,

essi sono stati di equilibrio metastabile. Se si facesse vibrare il tavolo con intensità sufficiente, i fili tenderebbero a cadere man mano

30

verso il tavolo fino a districarsi19. Questo principio è lo stesso che

usiamo quando agitiamo un sacco, poniamo, di noci per meglio assestarle. Nell'assestamento, le noci cadono mediamente verso il basso,

diminuendo la loro energia potenziale gravitazionale. Queste considerazioni, se rese quantitative, possono trovare utilissime applicazioni in molti problemi pratici, come, ad esempio, l'immagazzinamento di materiali granulari (grano, polveri, ecc.) e la loro separazione mediante opportune vibrazioni applicate al contenitore

(Fierro03). I dispositivi multistabili, inoltre, sono alla base di tutti i

sistemi di immagazzinamento dell'informazione. Non si deve pensare, però, che lo stato su cui un sistema dissipativo si porta debba

essere necessariamente uno stato di equilibrio in cui le proprietà del

sistema restino costanti nel tempo. Al contrario, il sistema complesso può evolvere verso uno stato stabile dinamico, detto moto di regime, che può essere periodico (si parla allora di ciclo limite) o aperiodico (si parla allora di caos deterministico). Del caos deterministico si parlerà più avanti in maggiore dettaglio. Un aspetto comune a

tutti i sistemi dissipativi è che lo stato stabile di equilibrio o metastabile di regime che essi raggiungono asintoticamente nel tempo

dipende molto poco dalle condizioni iniziali. Con linguaggio antropologico, possiamo dire che i sistemi dissipativi hanno "memoria corta",

nel senso che si dimenticano presto della sollecitazione esterna che

ha iniziato la loro evoluzione e si portano in uno stato stazionario o

dinamico fissato dal sistema stesso. Questo stato ha di solito caratteristiche di grande stabilità e di resistenza alle perturbazioni esterne. Ad esempio, un ecosistema mantiene un bilancio complessivo al

di là dell'impatto costante di estinzioni, variazioni di habitat, epidemie, calamità naturali, ecc. In linguaggio tecnico si dice che il regime raggiunto dal sistema costituisce un attrattore stabile, nel senso

che tutte le possibili traiettorie evolutive del sistema nelle vicinan19 A meno che, ovviamente, non ci siano impedimenti "topologici" come, ad esempio, l'esistenza

di nodi.

31

ze dell'attrattore stabile tendono asintoticamente verso l'attrattore

stesso. Le traiettorie, cioè le modalità con cui il sistema raggiunge

lo stato finale dipendono dalle condizioni iniziali e possono essere

ta come un processo di formazione di strutture sempre più complesse e differenziate sotto l'azione della selezione naturale e di altre

influenze ambientali. Il fatto che questi processi conducono a confi-

ogni volta diverse, ma lo stato finale è sempre il medesimo. Ad

esempio, tecniche ottiche sofisticate oggi disponibili permettono la

registrazione simultanea dello stato di attività di ogni singolo neurone che fa parte di un determinato circuito nervoso. Ebbene, studi

recenti hanno mostrato che il sistema nervoso lavora in modo molto

gurazioni stabili ordinate a partire dalle fluttuazioni interne al sistema è stato chiamato "ordine dal caos" e "ordine tramite le fluttuazioni" da Ilya Prigogone, premio Nobel per la chimica nel 1977).

meno deterministico di quanto si pensi (cioè della relazione univoca

tra stimolo e risposta) anche nel caso di riflessi molto semplici. Un

riflesso molto studiato in neurofisiologia è quello della retrazione

della branchia in seguito a stimoli tattili nell'invertebrato marino

Aplysia. Utilizzando stimoli ripetuti, è stato scoperto che ogni stimolo, anche se di intensità e durata uguale agli altri, porta all'attivazione di insiemi molto differenti di neuroni. Malgrado ciò, la risposta del circuito neuronico è sempre la stessa (contrazione della branchia) (Wu94). È questo un comportamento tipico dei sistemi complessi multistabili. Il sistema stesso sviluppa al suo interno meccanismi di controreazione (feedback) che stabilizzano lo stato finale. La

presenza di controreazione è un'altra caratteristica peculiare dei

sistemi complessi, che porta a fenomeni interessantissimi come l'au-

L'auto-organizzazione porta a maggiore ordine e, quindi, a

una diminuzione di entropia. Non c'è contraddizione con il secondo

principio della termodinamica, perché i sistemi auto-organizzanti

sono sempre sistemi aperti, in contatto con l'ambiente esterno.

Durante il processo di auto-organizzazione l'entropia dell'ambiente

cresce di più di quanto diminuisca quella del sistema. In molti casi,

i processi di auto-organizzazione possono essere considerati come

processi di rottura spontanea della simmetria: il sistema passa da

uno stato più simmetrico (meno ordinato) ad uno meno simmetrico

(più ordinato).

Il più classico degli esempi di auto-organizzazione è il fenomeno di Bénard, la formazione, cioè, di caratteristiche strutture a

forma di celle quando un fluido viene scaldato dall'alto (Fig. 5).

to-organizzazione.

4.1.2

AUTO-ORGANIZZAZIONE

Una proprietà estremamente interessante dei sistemi complessi è la possibilità di auto-organizzazione. Con questo termine

s'intende lo sviluppo spontaneo di nuove strutture ordinate. La transizione verso queste strutture, che possono essere anche molto stabili, avviene sotto l'azione delle fluttuazioni sia esterne che interne

al sistema dissipativo. L'evoluzione delle specie può essere concepi32

Fig. 5. Il fenomeno di Bénard.

33

Un altro esempio importante, sono le strutture che si osservano durante l'evoluzione di alcune reazioni chimiche autocatalitiche, che hanno grande rilevanza in biochimica. Queste reazioni

hanno la proprietà di produrre, tra i prodotti di reazione, i catalizzatori necessari per far procedere la reazione stessa. Si tratta di un

tipico esempio di controreazione positiva. Più la reazione accelera,

più catalizzatore si produce e la reazione va ancora più veloce. In

opportune condizioni, le reazioni autocatalitiche avanzano lungo

fronti d'onda, che assumono strutture particolari. Un esempio di un

fronte di reazione a forma di spirale è mostrato in Fig. 6. Per effetto dell'autocatalisi, le reazioni chimiche autocatalitiche avvengono a

velocità molto maggiore delle altre. Per questo motivo, si ritiene che

gli enzimi, ovvero i catalizzatori delle reazioni biochimiche, abbiano

avuto un ruolo determinante nello sviluppo delle forme viventi a

partire dal caos molecolare del brodo primordiale. Senza di essi,

infatti, si calcola che lo sviluppo della vita avrebbe richiesto molto

più tempo per evolversi di quanto effettivamente impiegato (qualche miliardo di anni).

deve credere che questo sia necessario per l'auto-organizzazione:

sistemi molto semplici possono auto-organizzarsi in opportune condizioni. Un esempio è la formazione spontanea di pattern regolari

nei sistemi ottici, un fenomeno che apre interessanti prospettive nel

campo dell'eleborazione tutt'ottica delle immagini e dell'informazione parallela. Il sistema è particolarmente semplice: supponiamo di

avere un materiale trasparente il cui indice di rifrazione n possa

cambiare proporzionalmente all'intensità I della luce che lo attraversa, secondo la legge

Eq. 7

dove n0 è l'indice di rifrazione del materiale in assenza di luce e n2

è una costante. Materiali di questo tipo sono detti otticamente nonlineari (l'intensità I è proporzionale al quadrato del campo elettrico

ottico) e sono, ad esempio, i cristalli fotorifrattivi e i cristalli liquidi. Ebbene, facendo passare un fascio di luce abbastanza intenso

attraverso il materiale e retroriflettendo con uno specchio la luce

verso la zona illuminata del campione, si osserva nel fascio retroriflesso la formazione spontanea di una caratteristica figura con simmetria esagonale, come mostrato in Fig. 7. Questo fenomeno mostra

come gli ingredienti minimali per avere auto-organizzzione siano i)

la nonlinearità (Eq. 7) e ii) la controreazione, fornita dallo specchio

retroriflettente.

Fig. 6. Il fronte a spirale di una reazione autocatalitica (Zykov04).

Il fenomeno di Bénard e le reazioni autocatalitiche si riferiscono a sistemi in cui si attuano meccanismi abbastanza complicati

quali i moti convettivi idrodinamici e le reazioni chimiche. Ma non si

34

Fig. 7. Pattern esagonale generato dalla retroriflessione di un fascio laser in

un film di cristallo liquido (Tamburrini93).

35

4.1.3

CAOS DETERMINISTICO

Come detto in precedenza, i sistemi complessi, durante la

loro evoluzione temporale possono incontrare molti punti di biforcazione (Fig. 2b). La scelta tra i rami evolutivi che partono da un punto

di biforcazione è innescata dal rumore browniano di fondo e, pertanto, è casuale. Si comprende quindi come, in assenza di forti meccanismi interni di stabilizzazione e in presenza di moltissimi punti di

biforcazione successivi, un sistema complesso possa evolvere verso

un regime caotico, caratterizzato da un comportamento imprevedibile. A tale comportamento si dà il nome di "caos deterministico".

L'ossimoro deriva dal fatto che il comportamento del sistema è

impredicibile malgrado il perfetto determinismo delle leggi che lo

governano. Occorre chiarire subito, che il caos non si riferisce al

modo, spesso imprevedibile, con cui il sistema si porta in uno stato

di regime (si veda l'esempio dell'Alypsia), quanto piuttosto alle

modalità impredicibili dell'evoluzione dinamica dello stesso stato di

regime. Come detto in precedenza, gli stati di regime verso cui

tende il sistema sono attrattori dinamici. Ebbene, può succedere,

che l'attrattore corrisponda non a uno stato stazionario, né a un

moto ripetitivo (ciclo limite), ma a uno stato caotico. In tal caso,

l'attrattore si dice "strano".

L'esistenza di attrattori strani è una peculiarità dei sistemi

complessi. Molti sistemi complessi hanno un numero grande di gradi

di libertà e richiedono la soluzione simultanea di un grande numero

di equazioni. Un esempio, è la turbolenza nella fluidodinamica. Non

crea stupore che sistemi di questo tipo portino a comportamenti

caotici e turbolenti. Ma non si deve credere che la complessità di un

sistema sia legata necessariamente all'esistenza di molti gradi di

libertà. È celebre il cosiddetto modello di Lorenz, descritto dalle

seguenti tre equazioni differenziali accoppiate

36

Eq. 8

Queste equazioni furono introdotte nel 1963 da Edward

Lorenz, un meteorologo, per descrivere in modo semplice i moti convettivi dell'atmosfera. Assegnate le condizioni iniziali a t=0, il moto

del sistema è univocamente determinato (determinismo). Le Eq. 8

possono essere risolte con semplicissime procedure numeriche in

grado di girare su un comune PC. Se però si traccia la traiettoria

seguita dal punto P di coordinate (x,y,z), si trova qualcosa di simile

a quanto mostrato in Fig. 8. A regime, la traiettoria del punto P si

avvolge intorno a due superfici a forma di ali di farfalla, saltando da

un'ala all'altra in modo irregolare. La traiettoria non si chiude mai su

se stessa, ma si avvolge su se stessa un numero infinito di volte. Se

si prova guardare la traiettoria con una lente d'ingrandimento, si

trova che ad ogni scala essa mostra la stessa specie di struttura intricata, sempre simile a se stessa.

Strutture con queste caratteristiche di autosimilarità sono

note in geometria col nome di frattali. L'attrattore di Lorentz riempie una zona di spazio che è più di una superficie e meno di un volume, e può essere caratterizzato da una dimensione frattale tra due

e tre. Il valore della dimensionalità dell'attrattore di Lorentz dipende dai valori dei parametri r, a, b, nelle Eq. 8. Nel caso della Fig. 8,

la dimensionalità frattale dell'attrattore è 2.05.

37

con una certa attendibilità solo a tempi brevi (uno-due giorni).

Previsioni del tempo a lungo termine sono in principio impossibili.

Che sistemi complicati come l'atmosfera e le sue turbolenze possano avere comportamenti complessi e anche caotici non desta molto

stupore. Ma la semplicità delle equazioni di Lorenz suggerisce che il

caos deterministico può essere osservato anche in sistemi molto

semplici21.

Fig. 8. Una traiettoria a regime della soluzione delle Eq. 8. La curva è stata

calcolata per r=28, a=10,b=8/3 e per le condizioni iniziali x = y =z =1. La

figura mostra soltanto il moto di regime del sistema e non la parte iniziale

della traiettoria.

Non si deve pensare che l'attrattore strano di Lorenz sia un

caso particolare: anzi, come già accennato in precedenza, uno dei

più importanti risultati dello sforzo di ricerca sui sistemi complessi

ha portato alla scoperta del carattere universale delle leggi che guidano la "via al caos"20. Queste leggi hanno un carattere di invarianza (o, se si preferisce, di simmetria) rispetto alle trasformazioni di

scala e sono quindi "semplici".

Il modello di Lorenz mostra, tra l'altro, che l'atmosfera è un

sistema intrinsecamente caotico e che è impossibile predire il suo

comportamento a lungo termine. Ma nello stesso tempo esso è anche

un modello deterministico e che quindi è possibile predirne il comportamento a breve termine. Questo è il motivo per cui, nonostante

l'enorme numero di dati oggi disponibili dai satelliti artificiali e

nonostante l'enorme potenza dei calcolatori impiegati per le simulazioni numeriche, le previsioni meteorologiche possono essere fatte

Fig. 9. Un esempio d'intermittenza. La figura mostra la velocità angolare

delle molecole di un film sottile di cristallo liquido sul quale viene fatto incidere un fascio laser polarizzato circolarmente e con sezione ellittica.

Questo tipo d'intermittenza è detto intermittenza on-off (Vella03).

La Fig. 9 mostra l'intermittenza caotica della velocità angolare di rotazione delle molecole di un cristallo liquido sotto l'azione

di un fascio di luce laser a sezione ellittica polarizzato circolarmente a incidenza normale (Vella03). In questo caso, il sistema si trova

per la maggior parte del tempo lungo un ciclo limite in cui esso ruota

a velocità angolare costante ω0, ma, di quando in quando, effettua

brevi escursioni intermittenti e imprevedibili, verso un attrattore

caotico. Un altro semplicissimo sistema che può mostrare moto caotico e che può essere costruito facilmente è il pendolo a molla o pen-

20 Le vie al caos più comuni sono due: il raddoppiamento di periodo in cui un moto periodico di

frequenza f genera una serie di sub-armoniche f/n e la cosiddetta “rottura di simmetria del toro”,

21 Si dimostra, che per raggiungere il caos deterministico un sistema autonomo di equazioni dif-

in cui un moto periodico di frequenza f genera una frequenza f' incommensurabile con f.

ferenziali del prim'ordine come le Eq. 8, deve avere almeno tre gradi di libertà.

38

39

dolo elastico. Si tratta di un corpo di massa m appeso ad una molla

elastica di massa trascurabile e libero di muoversi in tutte le direzioni. Questo sistema conserva l'energia meccanica ed è quindi un

esempio di sistema complesso non dissipativo. Per energia meccanica abbastanza bassa il moto del pendolo è regolare (Fig. 10a) , ma

diventa caotico ad alta energia (Fig. 10b)22.

grand'unificazione. Ma la complessità non è cosi semplice. Solo negli

ultimi trent'anni, grazie anche allo sviluppo delle nuove tecnologie

informatiche multimediali, l'attenzione dei fisici si è spostata verso

lo studio del complesso, al fine di spiegare la diversità, l'asimmetria

e l'irregolarità. Nonostante la relativa giovinezza di questo nuovo

campo d'indagine, i risultati sono stati notevoli e hanno aperto la

strada verso la comprensione delle "leggi" e "regolarità", spesso universali, che guidano i sistemi complessi, cooperativi e persino caotici. Questo nuovo sviluppo ha avuto, tra l'altro, il grande pregio di

mettere in contatto la comunità dei fisici, sia sperimentali che teorici, con discipline lontane dalla fisica più tradizionale quali l'informatica, la biologia, la zoologia, l'economia, le scienze sociali, aprendo nuove vie alla interdisciplinarietà. Lo sforzo verso la comprensio-

Fig. 10. Proiezione nel piano orizzontale del moto di un pendolo a molla. a)

a bassa energia la traiettoria è chiusa con la caratteristica forma di stella.

b) ad energia più alta la traiettoria evolve caoticamente ricoprendo il piano

orizzontale in modo frattale.

ne quantitativa delle leggi che governano i sistemi complessi deve

comunque considerarsi in una fase iniziale: è facilmente prevedibile

che nei prossimi anni questo sforzo di ricerca si estenderà ad altre

discipline, anche umanistiche, e produrrà nuove eccitanti scoperte.

RIFERIMENTI

5.

CONCLUSIONI

- Bailin D., Why Superstrings?, Contemporary Physics, vol. 30, 237

Questa breve escursione tra determinismo e caos ha mostrato il cambiamento avvenuto recentemente nelle percezioni scientifiche del mondo, che per un tempo lunghissimo hanno sottolineato

le sue regolarità al di là delle apparenze. Questa ricerca di semplicità e ordine, con l'assunto di leggi universali che connettono il passato al futuro, ha diretto la ricerca scientifica durante gli ultimi trecento anni, culminando nelle moderne teorie supersimmetriche di

40

(1989).

- Barrow J. D., Theories of Everithing: the quest for ultimate explanation, Oxford UP 1991 and Vintage pbk 1992.

- Chaitin G., Randomness in arithmetics, Scientific American, p. 80,

July 1980; Gödel Theorem and Information, Int. J. Th. Phys., 22, 941

(1982).

- Fierro A., Nicodemi M., Coniglio A., Edwards' approach to horizontal and vertical segregation in a mixture of hard spheres under gravity, J. Phys. Cond. Mat. 15, S1095 (2003).

41

- Gough J., Challenges if high-Tc, Physics World, p. 26, dec. 1991.

- Green M., Superstrings, Scientific American, p. 48, Sept. 1986.

6.

APPENDICE

- Lloyd S. e Pagels H., Complexity as thermodynamic depth, Annals

of Physics (N.Y.) 188, 186 (1988)

- Nelson E., Dynamical theories of Brownian motion, Princeton Univ.

Press, Princeton, 1967.

- Santamato E., Lavenda B. H., The Stochastic H-Theorem, J. Math.

Phys., 23, 2452 (1982).

- Sauvage J.P., ed., Molecular machines and motors, Springer, Berlin,

2001.

- Tamburrini M., Bonavita M., Wabnitz S., and Santamato E.,

Hexagonally-patterned beam filamentation in a thin liquid crystal

film with a single feed-back mirror, Opt. Lett., 18, 855 (1993).

- Vella A., Setaro A., Piccirillo B., and Santamato E., On-off intermittency in chaotic rotation induced in liquid crystals by competition

between spin and orbital angular momentum of light, Phys. Rev. E,

67, 051704 (2003).

- Weinberg S., I primi tre minuti, Arnoldo Mondatori ed., 1997

- Wu J. Y. et al., Consistency in nervous systems : trial-to-trial and

animal-to-animal variations in the responses to repeated applications of a sensory stimulus in Alypsia, J. Neurosci. 14, 1366 (1994).

- Zykov V. S. et al., Global Control of Spiral Wave Dynamics in an

Excitable Domain of Circular and Elliptical Shape, Phys. Rev. Lett.,

92, 018304 (2004).

La seguente macro di Excel simula i lanci successivi di due

dadi a sei facce e produce l'istogramma dei possibili risultati, da 2 a

12. Per avviare la macro, creare nell'editor di Visual Basic incorporato in Excel un modulo di nome Dices e un form di nome frmDices.

Nel form di nome frmDices aggiungere tre pulsanti di nome

cmdStart, cmdStop, cmdPause e una etichetta di nome lblStatus.

Copiare nel modulo Dices il seguente codice

Sub Dices()

If ActiveWorkbook Is Nothing Then Exit Sub

frmDices.Show

End Sub

Copiare nel form frmDices tutte le subroutine seguenti.

Dim fPause As Boolean

Dim fRun As Boolean

Dim fStop As Boolean

Private Sub UserForm_Initialize()

InitializeForm

End Sub

Private Sub cmdPause_Click()

lblStatus.Caption = "Lancio dadi interrotto"

cmdPause.Enabled = False

cmdStop.Enabled = False

cmdStart.Enabled = True

fRun = Not fRun

42

43

End Sub

Private Sub cmdStop_Click()

lblStatus.Caption = "Lancio dadi concluso"

cmdPause.Enabled = False

cmdStop.Enabled = False

cmdStart.Enabled = True

fRun = False

fStop = True

Cells.Clear

Cells(1, 1).Font.Bold = True

Cells(1, 3).Font.Bold = True

Cells(1, 4).Font.Bold = True

Cells(1, 5).Font.Bold = True

Cells(13, 4).Font.Bold = True

Cells(13, 5).Font.Bold = True

Cells(1, 1).HorizontalAlignment = xlRight

End Sub

Private Sub Throw()

Do

Cells(1, 3).HorizontalAlignment = xlCenter

Cells(1, 4).HorizontalAlignment = xlCenter

Cells(1, 5).HorizontalAlignment = xlCenter

' Genera un valore casuale compreso tra 1 e 6 per i due dadi.

Dice1 = Int((6 * Rnd) + 1)

Cells(13, 4).HorizontalAlignment = xlRight

Cells(1, 3) = "Evento"

Dice2 = Int((6 * Rnd) + 1)

' Somma i due valori

Result = Dice1 + Dice2

Cells(1, 4) = "Frequenza"

Cells(1, 5) = "Probabilità"

Cells(13, 4) = "Totale"

' incrementa i contatori nelle celle del foglio

Cells(Result, 1) = Cells(Result, 1) + 1

Cells(1, 1).Select

For n = 2 To 12

' incrementa il contatore totale nelle cella (1,1)

Cells(1, 1) = Cells(1, 1) + 1

For n = 2 To 12

' scrive gli eventi

Cells(n, 3) = n

Next n