Appunti per il corso di

Meccanica quantistica

Corso di Laurea in Fisica Computazionale

Università di Udine

Anno accademico 2009/2010

Paolo Giannozzi1

sulla base del software e delle note scritte da

Furio Ercolessi1 e Stefano de Gironcoli2

1 Università

di Udine - Dipartimento di Fisica

2 SISSA - Trieste

Versione del: October 28, 2010

Contents

Prefazione

1

1 Meccanica classica

1.1 Formulazione Lagrangiana e Hamiltoniana della meccanica

1.2 Un’applicazione classica: moto di un punto materiale . . . .

1.2.1 L’algoritmo di Størmer-Verlet . . . . . . . . . . . . .

1.3 Programma: newton . . . . . . . . . . . . . . . . . . . . . .

1.3.1 Struttura del programma . . . . . . . . . . . . . . .

1.3.2 Laboratorio . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

5

6

6

7

8

2 Introduzione all’equazione di Schrödinger

2.1 Verso la Meccanica Quantistica . . . . . . . .

2.1.1 Dualismo onda-particella: fotoni . . .

2.1.2 Quantizzazione dei livelli di energia . .

2.1.3 Dualismo onda-particella: elettroni . .

2.1.4 Principio di indeterminazione . . . . .

2.2 L’equazione di Schrödinger per una particella

2.2.1 L’equazione di Schrödinger dipendente

2.3 La particella libera . . . . . . . . . . . . . . .

2.4 Pacchetti d’onda . . . . . . . . . . . . . . . .

2.5 Potenziali modello . . . . . . . . . . . . . . .

2.5.1 Gradino di potentiale . . . . . . . . .

2.5.2 Barriera di potenziale . . . . . . . . .

2.5.3 Buca di potenziale . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

10

10

11

11

12

12

13

15

16

18

18

19

20

. .

. .

. .

. .

. .

. .

dal

. .

. .

. .

. .

. .

. .

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

tempo

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 L’equazione di Schrödinger unidimensionale: soluzione analitica e numerica

3.1 L’oscillatore armonico . . . . . . . . . . . . . . . . . . . . . . . .

3.1.1 Unità . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.1.2 Soluzione e livelli energetici . . . . . . . . . . . . . . . . .

3.1.3 Energia di punto zero . . . . . . . . . . . . . . . . . . . .

3.1.4 Simmetria e parità . . . . . . . . . . . . . . . . . . . . . .

3.1.5 Confronto con la densità di probabilità classica . . . . . .

3.2 Meccanica quantistica e codici numerici: alcune considerazioni .

3.2.1 Energie cinetiche negative . . . . . . . . . . . . . . . . . .

3.2.2 Effetti della quantizzazione . . . . . . . . . . . . . . . . .

i

23

23

24

24

26

26

27

28

28

28

3.3

Il metodo di Numerov . . . . .

3.3.1 Programma: harmonic0

3.3.2 Programma: harmonic1

3.3.3 Laboratorio . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

29

31

32

33

4 Proprietà dell’equazione di Schrödinger

4.1 Ortonormalità delle funzioni d’onda . .

4.2 Sviluppo di una soluzione generica . . .

4.3 Valori medi . . . . . . . . . . . . . . . .

4.4 La formulazione matriciale . . . . . . . .

4.5 Regole di commutazione . . . . . . . . .

4.6 Quantità conservate . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

35

35

37

38

39

41

42

5 Atomi con un elettrone

5.1 Equazione di Schrödinger in un campo centrale .

5.2 Il momento angolare . . . . . . . . . . . . . . . .

5.3 Autofunzioni del momento angolare . . . . . . . .

5.4 Separazione in parte radiale e angolare . . . . . .

5.4.1 Funzioni d’onda angolari . . . . . . . . . .

5.5 Il potenziale coulombiano . . . . . . . . . . . . .

5.6 La funzione d’onda radiale per atomi idrogenoidi

5.6.1 Densità radiale . . . . . . . . . . . . . . .

5.6.2 Stato fondamentale . . . . . . . . . . . . .

5.6.3 Comportamento vicino al nucleo . . . . .

5.6.4 Comportamento lontano dal nucleo . . . .

5.6.5 Numero di nodi . . . . . . . . . . . . . . .

5.7 Degenerazione accidentale e simmetria dinamica

5.8 Programma: hydrogen . . . . . . . . . . . . . . .

5.8.1 Griglia logaritmica . . . . . . . . . . . . .

5.8.2 Applicazione della teoria perturbativa . .

5.8.3 Laboratorio . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

45

45

46

47

49

51

51

52

54

54

54

55

55

55

56

56

57

59

6 Metodi approssimati

6.1 Metodo perturbativo . . . . . . . . . . . . . . . . . . . . . . . . .

6.1.1 Perturbazioni con autovalori degeneri . . . . . . . . . . .

6.2 Perturbazioni dipendenti dal tempo: transizioni elettromagnetiche

6.2.1 Transizioni di dipolo . . . . . . . . . . . . . . . . . . . . .

6.3 Metodo variazionale . . . . . . . . . . . . . . . . . . . . . . . . .

6.3.1 Dimostrazione del principio variazionale (I) . . . . . . . .

6.3.2 Dimostrazione del principio variazionale (II) . . . . . . . .

6.3.3 Energia dello stato fondamentale . . . . . . . . . . . . . .

6.3.4 Il metodo variazionale in pratica . . . . . . . . . . . . . .

6.4 Problema secolare . . . . . . . . . . . . . . . . . . . . . . . . . .

6.4.1 Sviluppo in funzioni ortonormali . . . . . . . . . . . . . .

6.4.2 Sviluppo in funzioni non ortonormali . . . . . . . . . . . .

6.5 Programma: hydrogen gauss . . . . . . . . . . . . . . . . . . . .

6.5.1 Laboratorio . . . . . . . . . . . . . . . . . . . . . . . . . .

ii

60

60

62

62

64

65

66

67

67

68

68

69

71

73

74

6.6

6.7

Base di onde piane . . . . . . . . . . . . . . . . . . . . . . . . . . 75

Programma: pwell . . . . . . . . . . . . . . . . . . . . . . . . . . 76

6.7.1 Laboratorio . . . . . . . . . . . . . . . . . . . . . . . . . . 76

7 Atomi a più elettroni

7.1 Lo spin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.2 Composizione di momenti angolari: la rappresentazione accoppiata

7.2.1 Esempio: singoletti e tripletti . . . . . . . . . . . . . . . .

7.2.2 Presenza di accoppiamento . . . . . . . . . . . . . . . . .

7.3 Particelle identiche: principio di indistinguibilità . . . . . . . . .

7.4 Operatori di permutazione . . . . . . . . . . . . . . . . . . . . . .

7.5 Caso di più particelle e sistemi composti . . . . . . . . . . . . . .

7.6 Determinanti di Slater . . . . . . . . . . . . . . . . . . . . . . . .

7.7 Atomi a due elettroni . . . . . . . . . . . . . . . . . . . . . . . .

7.8 Trattamento perturbativo dell’atomo di elio . . . . . . . . . . . .

7.9 Trattamento variazionale dell’atomo di elio . . . . . . . . . . . .

7.10 Programma: helium gauss . . . . . . . . . . . . . . . . . . . . . .

7.10.1 Laboratorio . . . . . . . . . . . . . . . . . . . . . . . . . .

8 Metodo di Hartree-Fock

8.1 Il metodo di Hartree . . . . . . . . . . . . .

8.1.1 Definizioni . . . . . . . . . . . . . . .

8.1.2 Equazioni di Hartree . . . . . . . . .

8.1.3 Significato del potenziale di Hartree

8.1.4 Campo autoconsistente . . . . . . .

8.1.5 Autovalori ed Energia di Hartree . .

8.2 Il metodo di Hartree-Fock . . . . . . . . . .

8.2.1 Potenziale colombiano e di scambio .

8.2.2 La densità di scambio . . . . . . . .

8.2.3 L’atomo di elio . . . . . . . . . . . .

8.3 L’energia di correlazione . . . . . . . . . . .

8.4 Programma: helium hf radial . . . . . . . .

8.4.1 Laboratorio . . . . . . . . . . . . . .

8.5 Programma: helium hf gauss . . . . . . . .

8.5.1 Laboratorio . . . . . . . . . . . . . .

9 Interazioni tra atomi

9.1 Approssimazione di Born-Oppenheimer . .

9.2 Superficie di Energia Potenziale . . . . . . .

9.3 Molecole biatomiche . . . . . . . . . . . . .

9.4 Solidi cristallini . . . . . . . . . . . . . . . .

9.4.1 Condizioni al Bordo Periodiche . . .

9.4.2 Teorema di Bloch . . . . . . . . . . .

9.4.3 Il potenziale vuoto . . . . . . . . . .

9.4.4 Soluzione per ll potenziale cristallino

9.4.5 Base di onde piane . . . . . . . . . .

9.5 Programma: periodicwell . . . . . . . . . .

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

78

78

79

80

80

80

82

82

83

84

85

86

88

90

91

91

91

92

94

94

95

95

97

98

99

100

101

102

102

103

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

104

. 104

. 105

. 106

. 107

. 108

. 108

. 109

. 110

. 111

. 111

9.5.1

Laboratorio . . . . . . . . . . . . . . . . . . . . . . . . . . 112

A Postulati e formalismo della meccanica quantistica

A.1 Stato del sistema . . . . . . . . . . . . . . . . . . . .

A.2 Osservabili e misura . . . . . . . . . . . . . . . . . .

A.3 Osservabili compatibili e non . . . . . . . . . . . . .

A.4 Rappresentazioni . . . . . . . . . . . . . . . . . . . .

A.5 Rappresentazione di Schrödinger . . . . . . . . . . .

A.6 Evoluzione temporale . . . . . . . . . . . . . . . . .

A.7 Definizione generale di momento angolare . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

113

. 113

. 113

. 115

. 115

. 116

. 118

. 119

B Formule utili

121

B.1 Trasformate di Legendre . . . . . . . . . . . . . . . . . . . . . . . 121

B.2 Gaussiane . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

B.3 Esponenziali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122

C Algoritmi utili

C.1 Ricerca degli zeri . . . . . . . . . .

C.1.1 Metodo di bisezione . . . .

C.1.2 Metodo di Newton-Raphson

C.1.3 Metodo della secante . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

123

123

123

124

124

D Software utile

125

D.1 Compilatori . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 125

D.2 Gnuplot . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 125

D.3 BLAS e LAPACK . . . . . . . . . . . . . . . . . . . . . . . . . . 126

iv

Prefazione

Lo scopo del corso di Meccanica Quantistica nell’ambito del Corso di Laurea

in Fisica Computazionale è quello di trasmettere gli elementi di base necessari

alla risoluzione numerica di semplici problemi di meccanica quantistica (non

relativistica). E’ in pratica una sorta di laboratorio computazionale della fisica

della materia, in cui vengono delineati gli ingredienti di base utilizzati nei grossi

calcoli delle proprietà di materiali, sia statici che dinamici (ossia con nuclei in

movimento), che costituiscono una delle branche più importanti della fisica

computazionale di oggi, e con notevole rilevanza per applicazioni di interesse

tecnologico e industriale.

I programmi forniti nell’ambito del corso sono degli spunti. Ci si aspetta che

lo studente li analizzi, li faccia girare sotto varie condizioni, studi il loro comportamento al variare dell’input, e soprattutto cerchi sempre di interpretare il loro

output dal punto di vista fisico. Molti homeworks chiederanno di modificare

questi programmi, aggiungendo o modificando determinate funzionalità.

Il software fornito è scritto in Fortran 90. Questo linguaggio sofisticato e

complesso offre gestione dinamica della memoria, operazioni su array (vettori e

matrici), possibilità di modularizzazione dei codici, pur mantenendo una larga

compatibilità con il Fortran 77 e senza comprometterne l’efficienza. E’ bene

ricordare che la fisica computazionale è nata ben prima che fossero inventati

C, Pascal e altri linguaggi, per cui esiste una enorme mole di codici e librerie

scritte in Fortran 77. Dato che il Fortran 90 non è molto noto, non ci sono

obiezioni all’uso da parte dello studente di un altro linguaggio come il C se vi

si sente più a suo agio. Una versione C di tutti i programmi è disponibile.

Per eventuali approfondimenti sulla teoria della Meccanica Quantistica, esistono molti buoni libri di testo: per esempio il Griffith, lo Schiff, o i grandi

classici Landau e Dirac. Per approfondimenti sull’aspetto più prettamente computazionale, si rimanda a testi quali il Thijssen, il Vesely, il Koonin.

1

Bibliografia

D. J. Griffiths, Introduction to Quantum Mechanics, Cummings, 2004.

L. I. Schiff, Quantum mechanics, McGraw-Hill, 1968.

L. D. Landau e L. Lifšic, Fisica Teorica, vol.3: Meccanica Quantistica non

Relativistica, Editori Riuniti, 1974.

J. M. Thijssen, Computational Physics, Cambridge University Press, Cambridge, 1999. Vedere anche la pagina web dell’autore:

http://www.tn.tudelft.nl/tn/People/Staff/Thijssen/comphy.html.

F. J. Vesely, Computational Physics - An Introduction: Second Edition, Kluwer,

2001. Vedere anche le pagine dell’autore:

http://www.ap.univie.ac.at/users/Franz.Vesely/cp0102/serious.html, contenenti

parti del materiale del libro.

S. E. Koonin e D. C. Meredith, Computational physics - Fortran Version,

Addison-Wesley, 1990. Vedere anche la pagina web di Dawn Meredith:

http://pubpages.unh.edu/˜dawnm/.

2

Chapter 1

Meccanica classica

Questo capitolo contiene un breve richiamo della formulazione Lagrangiana e

Hamiltoniana della meccanica, seguita da una semplice applicazione numerica

della meccanica classica. La prima parte ha lo scopo di richiamare dei concetti

di meccanica analitica che risultano assai utili in meccanica quantistica. La

seconda parte vuole mostrare come si risolvono in pratica le equazioni del moto

della meccanica classica con un algoritmo di integrazione numerica.

Per approfondire l’argomento, in particolare la prima parte, si consiglia:

H. Goldstein, Meccanica Classica, Zanichelli, 1980

L. D. Landau e L. Lifšic, Fisica Teorica, vol.1: Meccanica, Editori Riuniti, 1974.

1.1

Formulazione Lagrangiana e Hamiltoniana della

meccanica

La meccanica classica può essere riformulata in modi alternativi, perfettamente

equivalenti alla formulazione ”tradizionale” basata sull’equazione di Newton,

ma più comodi, eleganti e potenti. In particolare, la formulazione Hamiltoniana della meccanica introduce metodi e concetti che hanno un corrispettivo

ed un’estensione naturale in meccanica quantistica.

Il principio di Hamilton afferma che il moto del sistema, fra gli istanti t1 e

t2 è tale per cui l’integrale di linea

Z t2

I=

Ldt

(1.1)

t1

assume un valore estremo (minimo o massimo) in corrispondenza della traiettoria del moto. La funzione L ≡ L(qi , q̇i ) è detta Lagrangiana ed è funzione

delle coordinate generalizzate qi e delle rispettive derivate rispetto al tempo

q̇i . Le coordinate generalizzate descrivono il sistema e sono legate alle normali

coordinate spaziali da una legge di trasformazione:

ri ≡ ri (q1 , .., qn , t),

ṙi ≡

X ∂ri

j

∂qj

q̇j +

∂ri

.

∂t

(1.2)

La Lagrangiana può in generale dipendere esplicitamente dal tempo ma nel

seguito assumiamo che non lo faccia.

3

Per un sistema conservativo (in cui cioè le forze derivano da un potenziale)

vale L = T − V , dove T e V sono l’energia cinetica e potenziale rispettivamente.

Le qi e q̇i insieme determinano lo spazio delle fasi, ovvero tutti i possibili stati del

sistema. Le coordinate generalizzate in molti casi coincidono con le coordinate

usuali, e le loro derivate con le velocità usuali. Dal principio di Hamilton

derivano le equazioni di Lagrange (e viceversa):

d

dt

∂L

∂ q̇i

−

∂L

= 0,

∂qi

(1.3)

che determinano il moto del sistema. Ovviamente queste sono equivalenti alle

equazioni di Newton.

Nella formulazione Hamiltoniana si preferisce esprimere il moto del sistema

in termini delle qi e dei corrispondenti momenti generalizzati, pi , definiti come

∂L

.

∂ q̇i

pi =

(1.4)

Tramite una trasformazione matematica nota come trasformazione di Legendre

(vedi appendice) si introduce l’Hamiltoniana del sistema H ≡ H(pi , qi ):

H(pi , qi ) =

X

q̇i pi − L(qi , q̇i ),

(1.5)

i

che determina il moto tramite le equazioni di Hamilton:

ṗi = −

∂H(pi , qi )

.

∂qi

q̇i =

∂H(pi , qi )

∂pi

(1.6)

L’Hamiltoniana altri non è che l’energia del sistema: H = T +V . In particolare,

per un sistema unidimensionale, l’Hamiltoniana è

H(p, x) =

p2

+ V (x) ≡ T + V,

2m

(1.7)

il momento p altri non è che la quantità di moto (spesso chiamata anche impulso): p = mq̇. E’ facile verificare che le equazioni di Hamilton coincidono con

quelle di Lagrange e di Newton. Da notare come coordinate e momenti (collettivamente indicate come variabili canoniche) siano considerate come variabili

indipendenti, legate fra di loro solo tramite le equazioni di Hamilton.

Meno usata della formulazione Lagrangiana in meccanica classica, la formulazione Hamiltoniana ha preso la sua rivincita in meccanica quantistica.

In quest’ultima, l’Hamiltoniana da funzione che era diventa un onnipresente

operatore e di conseguenza cambia sesso e perde la maiuscola, diventando semplicemente ”l’hamiltoniano”. Inoltre, il formalismo hamiltoniano introduce in

meccanica classica una quantità, le parentesi di Poisson, il cui corrispettivo

quanto-meccanico (il commutatore) è di importanza fondamentale. Le parentesi

di Poisson [f, g] fra due funzioni f (qi , pi ) e g(qi , pi ) delle variabili canoniche sono

definite come

X ∂f ∂g

∂g ∂f

−

(1.8)

[f, g] ≡

∂qi ∂pi ∂qi ∂pi

i

4

(la notazione è ovviamente mirata a mettere in evidenza la parentela con i

commutatori) e godono delle seguenti proprietà:

[f, f ] = 0,

[g, f ] = −[f, g]

[f, c] = 0,

(1.9)

(dove c è un numero che non dipende dalle qi e pi )

[qi , qj ] = [pi , pj ] = 0,

[f, qi ] = −

∂f

,

∂pi

[qi , pj ] = δij

[f, pi ] =

∂f

.

∂qi

(1.10)

(1.11)

Le equazioni di Hamilton possono essere espresse tramite le parentesi di Poisson:

q̇i = [qi , H] ,

ṗi = − [pi , H] ,

(1.12)

come pure la derivata temporale di una funzione delle variabili canoniche:

df

= [f, H]

dt

(1.13)

Notare che questa esprime la dipendenza temporale tramite le equazioni del

moto, da non confondersi con la dipendenza esplicita dal tempo (assente in

questo caso nella funzione f ).

1.2

Un’applicazione classica: moto di un punto materiale

Prima di iniziare a discutere applicazioni di meccanica quantistica, vogliamo

presentare un esempio di risoluzione per via numerica di un semplice problema

di meccanica classica. Lo scopo di questo esercizio è iniziare a familiarizzarci

fin da subito con le tecniche per tradurre equazioni differenziali in codici di

calcolo, appoggiandoci su di un esempio la cui teoria senz’altro conosciamo

bene. Vogliamo ottenere la legge del moto di un punto materiale di massa m

in una dimensione, soggetto ad un potenziale V (x).

L’equazione differenziale che governa il moto del punto (ossia fornisce x(t))

date la posizione e la velocità iniziali, è la seconda legge di Newton

−

d2 x

dV

=m 2

dx

dt

(1.14)

La soluzione di questa equazione è facile da ottenere analiticamente per speciali forme di V (x), come ad esempio nel caso dell’oscillatore armonico; ma in

generale ottenere una soluzione analitica potrebbe risultare assai laborioso, o

impossibile. Ad esempio, V (x) stesso potrebbe non essere dato in forma analitica, ma solo in forma di una tabella numerica.

Ma, soprattutto, una volta che siamo in grado di sviluppare un metodo

numerico, potremo estenderlo senza troppa difficoltà a casi più complessi e di

interesse pratico molto maggiore, come ad esempio un sistema di molti punti

materiali interagenti in tre dimensioni attraverso interazioni di coppia, o interazioni più complicate.

5

1.2.1

L’algoritmo di Størmer-Verlet

La strategia generale per integrare la (1.14) è quella di suddividere l’intervallo

temporale di interesse [0, T ] in N intervallini di ampiezza ∆t, sufficientemente

piccoli da non commettere grossi errori approssimando la soluzione x(t) con il

suo sviluppo in serie di Taylor fino ad un ordine relativamente basso, e integrare

una equazione alle differenze finite per ottenere xn = x(tn ), dove tn = n∆t,

n = 0 . . . N.

Sviluppando in serie di Taylor attorno a xn in entrambe le direzioni:

xn−1 = xn − ẋn ∆t + (1/2)ẍn (∆t)2 − (1/6)ẍ˙ n (∆t)3 + O[(∆t)4 ]

xn+1 = xn + ẋn ∆t + (1/2)ẍn (∆t)2 + (1/6)ẍ˙ n (∆t)3 + O[(∆t)4 ]

(1.15)

(la notazione ẋ indica la derivazione rispetto al tempo) e sommandole fra loro

si ottiene

(1.16)

xn+1 = 2xn − xn−1 + ẍn (∆t)2 + O[(∆t)4 ]

Ora utilizziamo la legge di Newton (1.14), o

1 dV ẍn = −

≡ fn

m dx x=xn

(1.17)

xn+1 = 2xn − xn−1 + fn (∆t)2 + O[(∆t)4 ].

(1.18)

ottenendo

Questa equazione ci permette, nota la posizione ai tempi n − 1 e n e la forza al

tempo n, di ottenere una stima della posizione al tempo n + 1, e quindi fornisce

un algoritmo (detto algoritmo di Størmer-Verlet) per ottenere iterativamente

la traiettoria x(t) del punto sotto forma di una tabella numerica.

1.3

Programma: newton

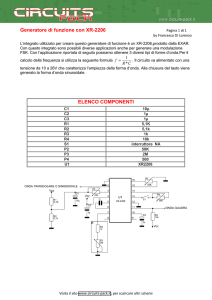

Il programma newton.f901 (oppure la sua versione C, newton.c2 ) implementa

l’algoritmo di Størmer-Verlet per un punto materiale soggetto ad un potenziale

V (x). Nel programma è definito in particolare

2π

(1.19)

5

il cui andamento nella regione |x| ≤ 6 è indicato in fig. 1.1.

Si tratta di un potenziale parabolico (come se fosse quello di un oscillatore

armonico), ma ”modulato” attraverso un termine oscillante con una periodicità

pari a 5 unità di lunghezza. Non è un potenziale famoso! È solo un esempio,

scelto in modo assolutamente arbitrario, di un potenziale con più posizioni di

equilibrio, per rendere le simulazioni più interessanti. Il potenziale è definito in

una subroutine separata nel programma, e può essere variato facilmente senza

dover modificare il corpo principale contenente l’algoritmo di integrazione.

Per semplicità si assume inoltre una massa unitaria. E’ facile vedere che

definire una massa diversa è equivalente a moltiplicare il time step ∆t per un

√

fattore m, e quindi tale assunzione non comporta alcuna perdita di generalità.

V (x) = x2 [2 − cos(kx)]

1

2

,

k=

http://www.fisica.uniud.it/˜giannozz/Corsi/MQ/Software/F90/newton.f90

http://www.fisica.uniud.it/˜giannozz/Corsi/MQ/Software/C/newton.c

6

70

V(x)

60

50

40

30

20

10

0

-6

-4

-2

0

2

4

6

Figure 1.1: Potenziale V(x) definito in newton.

1.3.1

Struttura del programma

Come indicato sopra, il potenziale V (x) è definito dalla subroutine potential

separata, e quindi è in un certo senso esterno al programma principale. Per un

dato x, potential ritorna il potenziale V (x) e la corrispondente forza F (x) =

−dV /dx. Solo quest’ultima è, strettamente parlando, necessaria per portare

avanti l’integrazione; ma conoscere anche il potenziale permette di verificare la

legge di conservazione dell’energia passo per passo.

Il programma chiede i seguenti dati di input: time step ∆t, posizione iniziale

x1 , energia totale E1 , numero di time steps (verrà seguita l’evoluzione temporale

per un tempo totale N ∆t), e nome del file di uscita (è anche possibile convogliare

l’output sullo standard output).

L’energia totale serve a calcolare la velocità iniziale v1 , secondo

1

E1 = mv12 + V (x1 )

2

(1.20)

Naturalmente è necessario che sia E1 ≥ V (x1 ) (se cosı̀ non è il programma si

arresta). È stato scelto di usare l’energia, piuttosto che direttamente la velocità

iniziale, perchè cosı̀ è immediatamente chiaro quale regione del potenziale verrà

esplorata nel corso della simulazione: quella in cui V (x) ≤ E1 . I punti in cui

V = E1 sono i punti di inversione, in cui la velocità è nulla e la particella inverte

la sua direzione di moto. Inoltre, come ben noto l’energia totale

1

E = mv 2 + V (x)

2

(1.21)

è supposta essere una costante del moto. La conservazione dell’energia costituisce per questi problemi un eccellente strumento di verifica che non vi siano

errori grossolani o siano stati dati input errati, come un ∆t troppo grande.

Assegnare la velocità iniziale significa, nell’ottica dell’algoritmo di StørmerVerlet, assegnare la posizione al ”tempo precedente”. Tale algoritmo però opera

su posizioni ed accelerazioni. La velocità alla posizione n può essere in generale

7

ottenuta come

vn =

xn+1 − xn−1

2∆t

(1.22)

con un errore dell’ordine di (∆t)2 (come subito si vede dalle (1.15), sottraendo

un’equazione dall’altra). Tuttavia, questa formula coinvolge tre punti e come

condizioni iniziali noi abbiamo a disposizione la sola posizione e velocità iniziali

al medesimo punto x1 . Si è allora scelto di utilizzare l’espressione

v1 '

x1 − x0

∆t

(1.23)

per definire la ”posizione precedente” x0 a partire da x1 e v1 . Se x0 e x1 fossero

dati, ad una tale formula sarebbe associato un errore dell’ordine di ∆t nella

velocità, quindi non si tratta di una buona stima. Tuttavia, quello che al più

succede è che una volta che la simulazione è partita, l’energia totale si assesterà

ad un valore lievemente diverso da quello da noi richiesto. In uno schema più

raffinato, si potrebbe pensare di effettuare una correzione al secondo passo di

integrazione per ottenere una migliore corrispondenza fra energia richiesta e

energia effettiva.

La velocità iniziale è sempre definita positiva dal programma, ossia il punto

inizia a muoversi verso gli x positivi. Data la simmetria del potenziale, questa

non è una limitazione (invertire la velocità è equivalente a lasciarla invariata e

cambiare il segno della coordinata di posizione iniziale).

Il loop sul numero di time steps è la parte centrale del programma. Il punto

su cui va posta particolare attenzione è il trasferimento dell’informazione della

”posizione precedente” da una iterazione alla successiva, effettuato usando tre

variabili x, xprev, xprevsav.

A fini di controllo sulla conservazione dell’energia, viene calcolata anche la

velocità e l’energia cinetica. Per ottenere una precisione accettabile, le velocità

vengono definite utilizzando la (1.22). Questo però comporta che per definire

vn è necessario conoscere xn+1 , e quindi che alla conclusione di ogni iterazione

le velocità calcolate sono riferite all’iterazione precedente, ossia alla posizione

che aveva la particella all’inizio dell’iterazione, prima di essere spostata.

I dati emessi sul file di output sono, nell’ordine, il numero dell’iterazione, la

posizione, la velocità, la forza, l’energia cinetica, l’energia potenziale e l’energia

totale: tutte riferite alla posizione che aveva la particella all’inizio dell’iterazione.

1.3.2

Laboratorio

Ecco alcuni spunti per esperimenti numerici che si possono fare con questo

codice. Un valore ”sicuro” per il time step è attorno a 0.01.

• Graficare le varie quantità in funzione del tempo ed interpretarle.

• Graficare le quantità tra loro (molto semplice con gnuplot) (vedere Appendice D.2), ad esempio la velocità in funzione della posizione (è una

vista nello spazio delle fasi).

8

• Confrontare il risultato di un input 0.005/0/28.36/3000 con un input

0.005/0/28.35/3000 (un’ispezione del potenziale può anticipare il risultato...)

• Provare ad aumentare il ∆t. Tenere sotto controllo la conservazione

dell’energia e le traiettorie nello spazio delle fasi. Discutere i risultati

con l’input 0.2/0/27/10000.

Ed ecco inoltre spunti per modifiche del codice:

• Definire altri potenziali.

• Immagazzinare il potenziale in una tabella numerica, e effettuare interpolazione in questa tabella durante l’integrazione (molto utile nel caso in

cui il calcolo del potenziale sia dispendioso: in questo modo basta farlo

una volta per tutte).

• Introdurre una forza di attrito (F = −γ ẋ).

• Introdurre una seconda massa identica alla prima, ed assumere che le due

masse siano accoppiate tra loro, ad esempio in modo armonico: V (x2 −

x1 ) = (1/2)k(x2 − x1 )2 , e che possano ”incrociarsi”.

• Introdurre una seconda massa identica alla prima, e lasciare che si muovano indipendentemente, facendole tuttavia collidere elasticamente quando

entrano in contatto.

9

Chapter 2

Introduzione all’equazione di

Schrödinger

Questo capitolo ci darà una prima presa di contatto con la meccanica quantistica

”vera”, e in particolare introdurrà l’oggetto matematico che il più delle volte

finiremo con il calcolare per ottenere le proprietà di un sistema microscopico:

la funzione d’onda, soluzione dell’equazione di Schrödinger.

2.1

Verso la Meccanica Quantistica

Ricapitoliamo qui, senza nessuna pretesa di accuratezza storica, i principali

risultati che portarono fra il 1900 e il 1930 all’introduzione della Meccanica

Quantistica nella forma che conosciamo adesso.

2.1.1

Dualismo onda-particella: fotoni

L’effetto fotoelettrico, lo spettro di radiazione del corpo nero e l’effetto Compton

dimostrano che la radiazione elettromagnetica di frequenza ν si comporta come

se fosse costituita da fotoni, particelle di massa nulla, energia E = hν e quantità

di moto p = E/c; la costante h ha le dimensioni di un’azione (energia per tempo,

o quantità di moto per posizione) ed è detta costante di Planck. Tuttavia

queste particelle continuano a comportarsi sotto certi aspetti come onde, da

cui il cosidetto dualismo onda-particella. Entrambe gli aspetti, corpuscolare

e ondulatorio, sembrano presenti allo stesso tempo ed entrambe necessari per

spiegare il comportamento della radiazione.

Esperimenti di interferenza con fenditure sono particolarmente istruttivi e

sorprendenti a questo riguardo. In un tipico setup sperimentale, una sorgente

luminosa monocromatica emette un fascio di luce che colpisce uno schermo con

due fenditure; la luce attraversa le fenditure e colpisce un altro schermo piazzato

ad una certa distanza dietro al primo. Su questo si osservano le cosidette

frange di interferenza. La spiegazione del fenomeno in termini di onde è banale:

a seconda della differenza di cammino ottico, le onde provenienti dalle due

fenditure si sommano in fase o in controfase, dando origine a zone chiare e

scure alternate. La spiegazione in termini di fotoni è quantomeno problematica,

10

tanto più che si possono mostrare (sperimentalmente!) due aspetti notevoli del

problema:

• l’interferenza si realizza anche se l’intensità della luce è cosı̀ debole da

avere (in media) un solo fotone presente sul percorso fra la sorgente e lo

schermo su cui si osservano le frange di interferenza;

• l’interferenza sparisce se si tappa una delle due fenditure, o anche se si

cerca in qualunque modo di misurare ”da quali delle due fenditure è passato il fotone”.

E’ quindi necessario assumere che un fotone ”interferisca con se stesso”, ma solo

se non lo costringiamo a rivelare la sua natura corpuscolare con una ”misura”

che ci dica ”da dove è passato”. Ovvero: natura ondulatoria e corpuscolare del

fotone sembrano inestricabilmente legate.

2.1.2

Quantizzazione dei livelli di energia

Il problema della stabilità dell’atomo e della forma degli spettri atomici ricevettero una prima soluzione con la cosiddetta ”vecchia meccanica quantistica” di

Niels Bohr. Bohr postulò che l’atomo fosse stabile solo per certi valori discreti

dell’energia; l’assorbimento o l’emissione di un fotone di frequenza ν potevano

avvenire solo in seguito ad una transizione fra tali valori discreti (livelli di energia) in cui la differenza di energia fosse pari ad hν. Nel modello di Bohr, le

orbite permesse nell’atomo sono quelle per cui vale la relazione

Z

l=

pdq = nh

(2.1)

orbita

ovvero il momento angolare ha solo valori discreti, multiplo della costante di

Planck. Tale idea può essere estesa ad altri problemi semplici: l’oscillatore

armonico, la buca di potenziale, etc. Il concetto di quantizzazione dei livelli

di energia e la presenza di livelli discreti risolve inoltre anche molti enigmi sui

calori specifici (un altro vecchio problema della meccanica classica). La vecchia

meccanica quantistica si dimostrò quindi un’intuizione vincente, ma rimaneva

una teoria basata su assunzioni ad hoc e di difficile estensione a sistemi un

minimo complicati.

2.1.3

Dualismo onda-particella: elettroni

La presenza della costante di Planck sia nella relazione energia-frequenza dei

fotoni che nella condizione di Bohr suggerisce che h sia una costante universale

e fondamentale non solo per i fotoni ma anche per le particelle. Inoltre la

condizione di Bohr può essere riscritta sotto una forma che è molto suggestiva

della presenza di un carattere ondulatorio anche nelle particelle: per orbite

circolari di circonferenza L, pL = nh, ovvero L = nh/p = nλ. La lunghezza λ

ha la stessa definizione della lunghezza d’onda di un fotone di quantità di moto

p. La condizione di Bohr diventa quindi come la condizione di risonanza per

le onde: il numero di ”lunghezze d’onda” che stanno su di una circonferenza è

11

intero. De Broglie suggerı̀ che in generale si può associare un’onda di lunghezza

d’onda λ = h/p ad una particella di quantità di moto p. Il significato preciso di

tale ”associazione” sarà chiarito in seguito. Il dualismo onda-particella prende

cosı̀ un aspetto ”simmetrico”: non solo le onde hanno un carattere di particella,

ma anche le particelle hanno un carattere di onda.

La prova finale del carattere ondulatorio associato alle particelle è data

dall’osservazione di un fenomeno tipicamente ondulatorio quale la diffrazione

di Bragg in fasci di particelle. Questo fu realizzato nel 1927 da Davisson e

Gerner con fasci di elettroni. Adesso sappiamo che la diffrazione di Bragg di

particelle è osservabile persino con fasci di atomi di Elio.

2.1.4

Principio di indeterminazione

Una conseguenza del dualismo onda-particella è una limitazione intrinseca alla

precisione delle misure, in particolare alla possibilità di misurare contemporaneamente quantità di moto e posizione di una particella con precisione arbitraria. Per determinare la seconda serve osservare la particella con luce di

lunghezza d’onda sempre più piccola; ma questa avrà un’energia associata sempre più grande e perturberà la quantità di moto della particella. Visto in un

altro modo: se le particelle hanno anche un carattere ondulatorio, le si possono

pensare come dei ”pacchetti d’onda”, sovrapposizione di onde monocromatiche;

ma un pacchetto d’onda tanto più è localizzato nello spazio, tanto più ampio è

nello spazio reciproco (che è poi quello delle quantità di moto, come vedremo).

Heisenberg formalizzò questo aspetto nel principio, o pi`‘u esattamente, relazione

di indeterminazione: per il prodotto fra l’incertezza, sulla posizione ∆x e sulla

quantità di moto ∆px , vale la diseguaglianza ∆x∆px ≥ h̄/2, dove h̄ = h/2π.

2.2

L’equazione di Schrödinger per una particella

Abbiamo visto nella sezione precedente quale fenomenologia la Meccanica Quantistica debba poter spiegare. Un passo avanti decisivo fu compiuto da Schrödinger, che estese e formalizzò l’idea di ”onda associata ad una particella” con

l’introduzione della funzione d’onda. La funzione d’onda è determinata come

soluzione di un’equazione differenziale, l’equazione di Schrödinger, che ammette

soluzione solo per determinati valori dell’energia, corrispondenti ai livelli energetici della particella. Il quadrato della funzione d’onda determina la probabilità

di trovare la particella in una determinata posizione, in seguito ad una misura.

La posizione della particella è quindi descritta in modo probabilistico: data una

funzione d’onda, sappiamo qual è la probabilità che la particella sia in un certo

punto, ma non ”dove sta esattamente”.

Consideriamo per prima l’equazione di Schrödinger indipendente dal tempo

per un sistema particolarmente semplice: una particella in un potenziale unidimensionale V (x). L’equazione ha la forma seguente:

−

h̄2 d2 ψ

+ V (x)ψ(x) = Eψ(x),

2m dx2

12

(2.2)

dove ψ(x) è la funzione d’onda (in generale complessa). Da dove scappa fuori?

Uno dei postulati della meccanica quantistica è che la quantità di moto lungo

la direzione x è rappresentata dall’operatore differenziale:

p = −ih̄

d

dx

(2.3)

Possiamo quindi riscrivere la (2.2) come

"

#

p2

+ V (x) ψ(x) = Eψ(x).

2m

(2.4)

L’operatore fra parentesi quadre a sinistra rappresenta quindi una vecchia conoscenza: è l’Hamiltoniano del sistema, H = p2 /2m + V . Ciò ci permette di identificare E come l’energia totale (cinetica+potenziale) del sistema. L’equazione

non ha necessariamente soluzioni fisicamente accettabili (ovvero non divergenti)

per qualunque valore di E: i valori di di E per i quali una soluzione esiste rappresentano quindi i livelli di energia ammessi.

Notiamo come nella (2.4) l’operatore H applicato alla soluzione ψ(x) produce la ψ(x) medesima, moltiplicata per una costante. Questo si riflette nella

seguente terminologia: la soluzione dell’Eq.(2.2) è detta autofunzione dell’Hamiltoniano, il corrispondente valore di E è detto autovalore. Nei prossimi capitoli vedremo in modo più chiaro il perché di questa terminologia proveniente

dall’algebra lineare.

La funzione d’onda è definita a meno di una costante arbitraria. Si usano

di solito funzioni d’onda normalizzate:

Z

|ψ(x)|2 dx = 1.

(2.5)

L’energia E è il valore di aspettazione dell’operatore H sullo stato definito da

ψ, cioè:

Z

E=

"

#

p2

ψ (x)

+ V (x) ψ(x)dx =

2m

∗

Z

ψ ∗ (x)Hψ(x)dx.

(2.6)

Per funzioni d’onda non normalizzate:

R

E=

ψ ∗ (x)Hψ(x)dx

R

.

|ψ(x)|2 dx

(2.7)

In generale, quanto sopra si applica a qualunque operatore f (x, p), in cui p è

sostituito dall’operatore differenziale (refqdm). Si noti che H è un operatore:

un oggetto che agisce su di una funzione e ha come risultato un’altra funzione,

in questo caso. Non è lecito spostare la ψ da destra a sinistra di H o viceversa

!!

2.2.1

L’equazione di Schrödinger dipendente dal tempo

In generale, l’equazione di Schrödinger deve tenere conto anche della dipendenza

temporale. L’equazione dipendente dal tempo ha la forma:

−

h̄2 ∂ 2 Ψ(x, t)

∂Ψ(x, t)

+ V (x, t)Ψ(x, t) = ih̄

2

2m ∂x

∂t

13

(2.8)

dove Ψ(x, t) è la funzione d’onda. Nel caso importante in cui il potenziale

non dipenda esplicitamente dal tempo: V (x, t) = V (x), ci si può ricondurre

alle soluzioni dell’equazione indipendente dal tempo, Eq.(2.2): vediamo come.

Scriviamo la Ψ(x, t) come prodotto di una funzione di solo x e una di solo t:

Ψ(x, t) = ψ(x)f (t)

(2.9)

Sostituendo la (2.9) nella (2.8) e dividendo per ψ(x)f (t) si trova

−

1 h̄2 d2 ψ(x)

ih̄ df

+ V (x) =

2

ψ(x) 2m dx

f (t) dt

(2.10)

In questa equazione il membro sinistro dipende solo da x, e quello destro solo

da t. Entrambi i membri devono allora essere uguali ad una costante, che

chiamiamo E. Otteniamo cosı̀ due equazioni: quella spaziale è appunto la

(2.2), mentre quella temporale è

iE

df

= − f (t)

dt

h̄

(2.11)

f (t) = Ce−iEt/h̄

(2.12)

la cui soluzione è banalmente

dove C è una costante (determinata dalla normalizzazione). Si tratta di un

punto nello spazio complesso in rotazione attorno all’origine con frequenza angolare E/h̄.

Abbiamo quindi trovato che ad ogni soluzione ψn (x) della (2.2), corrispondente a un certo valore di En , corrisponde anche una soluzione della (2.8)

Ψn (x, t) = ψn (x)e−iEn t/h̄

(2.13)

Questa soluzione è uno stato stazionario, perchè |Ψn (x, t)|2 = |ψn (x)|2 non

dipende dal tempo.

Ψn (x, t) data dalla (2.13) non è una soluzione generale dell’equazione di

Schrödinger dipendente dal tempo (2.8). Tuttavia, si può dimostrare che l’insieme

di tutte le soluzioni possibili è costituito dalle combinazioni lineari delle autofunzioni dell’energia, ossia qualsiasi soluzione Ψ(x, t) è sempre esprimibile come

una sovrapposizione di stati stazionari:

Ψ(x, t) =

X

cn Ψn (x, t).

(2.14)

n

Questo è un risultato importante: data una funzione d’onda Ψ(x, t0 ) che si sa

essere una soluzione valida ad un certo istante t0 , la sua evoluzione temporale

può essere ottenuta facilmente se si riesce a svilupparla in stati stazionari al

tempo t0 secondo la (2.14).

La soluzione numerica diretta [ossia operando nello spazio (x, t)] dell’equazione

(2.8) è in generale un problema difficile, che porta spesso a instabilità numeriche.

Quasi sempre l’evoluzione temporale di una funzione d’onda non corrispondente

ad uno stato stazionario viene perciò studiata decomponendola in autofunzioni

dell’energia—la cui evoluzione temporale è data dalla (2.13)—secondo la (2.14).

Tuttavia, nel caso generale in cui il potenziale dipende dal tempo la separazione delle variabili non è possibile, e il problema va quindi affrontato risolvendo direttamente la (2.8).

14

2.3

La particella libera

Consideriamo una particella libera in una dimensione, la cui equazione di Schrödinger dipendente dal tempo è (dalla (2.8) per V (x) = 0):

∂Ψ(x, t)

h̄2 ∂ 2 Ψ(x, t)

= ih̄

(2.15)

2m ∂x2

∂t

La soluzione di questa equazione, come facilmente si vede, sono le onde piane:

−

Ψ(x, t) = Cei(±kx−ωt)

(2.16)

dove C è una costante (scelta in modo da normalizzare la funzione correttamente), e k e ω sono fra loro legati dalla relazione

h̄2 k 2

= h̄ω

(2.17)

2m

E può assumere qualsiasi valore reale positivo. Non vi è quantizzazione: l’energia

di una particella libera può avere qualsiasi valore. Notare come esistano due

diverse funzioni d’onda per ogni valore di E: nel gergo della Meccanica Quantistica, si dice che ogni autovalore è due volte degenere.

Come sappiamo, potevamo anche considerare l’equazione di Schrödinger

indipendente dal tempo per lo stesso problema

E=

−

h̄2 d2 ψ

= Eψ(x)

2m dx2

(2.18)

ψ(x) = Ce±ikx

(2.19)

e ottenere una soluzione

dove E =

h̄2 k 2 /2m,

e poi dire, applicando la (2.13), che

Ψ(x, t) = ψ(x)e−iEt/h̄

(2.20)

Il risultato è chiaramente identico.

La (2.16) e la (2.20) rappresentano un’onda che si propaga con velocità

v = ω/k = h̄k/2m. La loro forma può lasciare perplessi. In primo luogo, la

funzione è delocalizzata in modo uniforme su tutto lo spazio: |Ψ(x, t)| = 1.

Osserviamo però che la (2.16), di cui scegliamo la soluzione con segno positvo.

è un’autofunzione dell’operatore quantità di moto, definito in (2.3), con autovalore h̄k:

d

(2.21)

pΨ(x, t) ≡ −ih̄ Ψ(x, t) = h̄kΨ(x, t).

dx

Per analogia con l’equazione di Schrödinger, ciò implica che con questa funzione

d’onda la quantità di moto ha un valore ben definito h̄k, e che quindi la sua

indeterminazione è nulla: ∆p = 0. Torneremo nel Cap.A su questo aspetto. La

relazione di indeterminazione ci dice allora che la posizione è completamente

indeterminata: ∆x = ∞. Non è quindi preoccupante che la nostra funzione

d’onda Rsia uniformemente delocalizzata; tuttavia ciò la rende non normalizzabile: |Ψ(x, t)|dx → ∞. Dovremo abituarci a convivere con oggetti la cui

corretta definizione matematica passa per una procedura di limite. In questo

caso, potremmo considerare la particella libera come limite per L → ∞ di una

particella in una scatola di dimensioni L, con la condizione ψ(x + L) = ψ(x)

(condizioni periodiche ai bordi).

15

2.4

Pacchetti d’onda

Come abbiamo visto, la soluzione (2.16) per la particella libera non somiglia

molto al moto di una particella libera classica, in quanto:

1. l’ampiezza della (2.16) è costante;

2. se la quantità di moto classica p deve corrispondere a h̄k, la velocità

dell’onda sembra essere la metà di ciò che ci si aspetterebbe.

Per poter ottenere un limite classico sensato, dobbiamo introdurre il concetto

di pacchetto d’onde, e assumere che il moto classico si ottenga sommando fra

loro molte onde piane del tipo (2.16), anzichè considerando un’onda sola.

Proviamo a considerare per un momento la sola parte spaziale (non è una

limitazione: è la soluzione della corrispondente equazione di Schrödinger indipendente dal tempo, e conosciamo il suo legame (2.13) con la soluzione completa), e ipotizziamo una soluzione oscillante come un’onda piana con un certo

vettore d’onda k0 , ma localizzata nello spazio in una regione di lunghezza L:

ψ(x) = eik0 x se |x| ≤ L/2

= 0

se |x| > L/2

(2.22)

Ci chiediamo se la (2.22) è una soluzione dell’equazione (2.18). Per fare questo,

appoggiamoci sulla teoria delle trasformate di Fourier, secondo cui qualunque

ψ(x) può essere espressa in termini di uno sviluppo in onde:

Z +∞

ψ(x) =

F (k)eikx dk

(2.23)

−∞

dove le ampiezze F (k) si possono ottenere da una ψ(x) mediante una trasformata inversa,

Z

1 +∞

F (k) =

ψ(x)e−ikx dx

(2.24)

2π −∞

Nel nostro caso, la forma particolare (2.22) che abbiamo ipotizzato dà

F (k) =

1

2π

Z L/2

e−i(k−k0 )x dx =

−L/2

L sin[(k − k0 )L/2]

2π (k − k0 )L/2

(2.25)

Come noto, la funzione sin y/y ha un picco di ampiezza 1 a y = 0, si annulla

per y = ±π, e presenta altre oscillazioni di ampiezza molto inferiore al picco

principale, che decadono come 1/y al crescere di y. Pertanto F (k) ha un picco

di altezza massima L/2π e larghezza a metà altezza approssimativamente ∆k ∼

2π/L. Abbiamo quindi trovato che è possibile costruire una soluzione localizzata

e oscillante con numero d’onda k0 , ma per fare questo dobbiamo sovrapporre

un insieme di onde piane con numero d’onda centrato attorno a k0 ma con una

dispersione ∆k.

La (2.22) descrive pertanto una particella quantistica la cui posizione è

determinata con una incertezza ∆x ∼ L, e la cui quantità di moto è determinata

con una incertezza ∆p = h̄∆k ∼ h/L. Abbiamo quindi ∆x∆p ∼ h, che è

l’espressione del principio di indeterminazione. Il problema di una singola onda

16

piana è che la sua quantità di moto è determinata esattamente, e questo rende

la posizione totalmente indefinita.

Analoghe considerazioni possono essere effettuate per quanto riguarda la

variabile temporale. In questo caso si effettuano trasformate di Fourier tra la

variabile temporale e lo spazio delle frequenze. Se un treno d’onde ha una

durata finita complessiva T (che sarà quindi il ∆t) ed effettua N oscillazioni, la

precisione nella determinazione della sua frequenza è circa pari a 1 oscillazione,

ossia

1

2π/ω0

∆ω

∼

(2.26)

=

ω0

N

T

da cui

∆t∆ω ∼ 2π

(2.27)

ovvero l’indeterminazione nel tempo e quella nell’energia sono legate da ∆t∆E ∼

h.

Il limite classico della meccanica quantistica passa quindi necessariamente

attraverso i pacchetti d’onda per poter confinare la particella in una regione

finita. Va notato che alla dispersione in k corrisponderà anche una dispersione in

energia. Ogni componente k soddisfa all’equazione di Schrödinger indipendente

dal tempo per l’energia E = h̄2 k 2 /2m. Le componenti si sommano solo dopo

aver moltiplicato ciascuna di esse per il fattore di fase dipendente dal tempo,

secondo la (2.20). Questo fa sı̀ che l’aspetto del pacchetto possa in generale

variare nel tempo.

Occupiamoci allora della seconda questione relativa alla velocità. Immaginiamo di costruire un semplice pacchetto costituito da due sole onde, una di

numero d’onda k0 − δk e una di numero d’onda k0 + δk, dove δk è piccolo. Le

frequenze angolari corrispondenti (attraverso la 2.17) saranno ω0 −δω e ω0 +δω.

Ψ(x, t) = ei(k0 −δk)x e−i(ω0 −δω)t + ei(k0 +δk)x e−i(ω0 +δω)t

= ei(k0 x−ω0 t) [2 cos(δkx − δωt)]

(2.28)

ossia un’onda piana di numero d’onda k0 modulata da un fattore oscillante con

un numero d’onda assai più piccolo, ossia con una lunghezza d’onda molto più

grande. Questo è un inviluppo analogo a quello che dà luogo ai battimenti in

acustica. L’inviluppo si muove con una velocità diversa da quella dell’onda che

contiene. Possiamo trovare la sua velocità seguendo ad esempio lo spostamento

nel tempo del massimo corrispondente a un argomento nullo del coseno:

δkx − δωt = 0

ossia

(2.29)

dω

(2.30)

dk

La quantità vg è detta velocità di gruppo. Dato un pacchetto d’onde qualsiasi,

per ogni coppia di componenti vicine si può pensare che valga la (2.30), che

quindi rappresenta la velocità del pacchetto stesso. Nel limite classico, è la

velocità di gruppo che diventa la velocità della particella classica. Dalla (2.17)

si ha subito infatti

h̄k

vg =

(2.31)

m

x = vg t

,

17

vg =

che è quanto ci si aspetta. Nel caso di una particella libera, la velocità del

pacchetto è quindi doppia rispetto a quella dell’onda, e corrisponde al limite

classico.

Da notare infine che il pacchetto si delocalizza nel tempo perchè ciascuna

delle sue componenti k si propaga con una velocità ω/k diversa da quella delle

altre componenti. Affinchè il pacchetto non si degradi, occorrerebbe che ω/k

fosse una costante. Questo è in effetti il caso delle onde elettromagnetiche nel

vuoto, ma non delle onde associate a particelle con massa finita.

2.5

Potenziali modello

Consideriamo qualche caso di potenziale semplice. I casi seguenti potranno

sembrare artificiosi e di dubbio interesse, ma in realtà molti sistemi fisici sono

descrivibili in modo approssimato con potenziali molto semplici.

2.5.1

Gradino di potentiale

Consideriamo il seguente potenziale a gradino: V (x) = 0 per x < 0, V (x) = W

per x > 0 (W > 0). Si presenta subito una difficoltà: cosa succede alla funzione

d’onda nel punto di discontinuità, x = 0, del potenziale? La risposta è nota dalla

teoria matematica, ma possiamo darne una ”fisica” considerando il potenziale

discontinuo come limite di potenziali continui che passano da V (0) = 0 a V () =

W per → 0. Riscriviamo l’equazione di Schrödinger come:

ψ 00 (x) =

2m

(V (x) − E) ψ(x)

h̄2

(2.32)

da cui si ricava l’ovvio risultato che la derivata seconda della funzione d’onda è

discontinua in x = 0. Integriamo fra x = 0 e x = :

ψ 0 () − ψ 0 (0) =

2m

h̄2

Z (V (x) − E) ψ(x)dx.

(2.33)

0

Siccome sia V (x) che ψ(x) sono finiti nell’intervallo (0, ), il secondo membro

tende a 0 per → 0. Quindi ψ 0 () → ψ 0 (0). Analogamente si dimostra la

continuità di ψ(x) intorno a x = 0. Queste sono le condizioni da imporre

ovunque sia presente un gradino (finito) di potenziale.

Per risolvere il problema, si devono distinguere tre intervalli di energia:

0) E < 0: non esistono soluzioni, o più esattamente, le sole soluzioni sono

esponenziali reali, che divergono e quindi non sono fisiche.

1) E > W : le soluzioni sono onde piane,

ψ(x) = Aeikl x + Be−ikl x ,

√

x < 0,

kl =

ψ(x) = Ceikr x + De−ikr x , x > 0, kr =

2mE/h̄;

(2.34)

q

2m(E − W )/h̄.(2.35)

Le condizioni di continuità a x = 0 ci danno

A+B = C +D

(2.36)

kr (A − B) = kl (C − D).

(2.37)

18

Abbiamo quindi quattro incognite e due condizioni, più la normalizzazione

(nel nostro caso, arbitraria). Rimane quindi una costante indeterminata.

In effetti, ci sono due soluzioni per ogni valore di energia e quindi ogni

combinazione lineare delle due è una soluzione accettabile. Possiamo per

esempio selezionale la soluzione corrispondente ad un’onda incidente da

sinistra e trasmessa a destra (D = 0). In questo caso, si trova

√

√

B

E− E−W

C

B

√

=√

=1+ .

,

(2.38)

A

A

A

E+ E−W

2) 0 < E < W : le soluzioni sono onde piane per x < 0, onde evanescenti per

x > 0:

√

ψ(x) = Aeikl x + Be−ikl x , x < 0, kl = 2mE/h̄;

(2.39)

ψ(x) = Ce−kr x ,

x > 0,

kr =

q

2m(W − E)/h̄.

(2.40)

L’esponenziale con il segno opposto per x > 0 è ovviamente non accettabile! Le condizioni di continuità a x = 0 ci danno

kr (A − B) = −kl C

A + B = C,

da cui

√

√

B

E−i W −E

√

= √

,

A

E+i W −e

B

C

=1+ .

A

A

(2.41)

(2.42)

In questo caso c’è una sola soluzione per ogni valore di E: l’autovalore è

non degenere (cosa prevista dal teorema di non degenerazione, valido in

sistemi unidimensionali).

Da notare come nell’intervallo 2 la funzione d’onda nella regione x > 0, classicamente inaccessibile, è evanescente e rapidamente tendente a zero, ma comunque

non nulla: esiste una probabilità piccola ma finita di trovare la particella in una

zona dove ”non dovrebbe stare”. E’ un fenomeno intrinsecamente quantomeccanico, di grande rilevanza.

2.5.2

Barriera di potenziale

Consideriamo ora una barriera di potenziale: V (x) = W per |x| < a/2, V (x) = 0

per x < −a/2 e x > a/2. In questo caso si richiedono due operazioni di

”matching” della funzione d’onda, a x = −a/2 e x = a/2. Per gli intervalli

di energie 0 e 1 sopra introdotti, i risultati sono del tutto analoghi al caso del

gradino: nessuna soluzione e due soluzioni degeneri per ogni E, rispettivamente.

Più interessante il caso dell’intervallo 2. Consideriamo una soluzione che si

propaga verso destra nella regione x < −a/2. Tale soluzione diventerà un’onda

evanescente nella regione classicamente proibita |x| < a/2. Tuttavia in x =

a/2 sopravviverà una componente piccola di onda evanescente che avrà come

corrispettivo un’onda propagantesi nella regione x > a/2. Esistono quindi

soluzioni che ”scavalcano” la barriera: è il cosiddetto effetto tunnel.

19

Scriviamo la funzione d’onda per il caso come quello descritto sopra, assumendo per semplicità il coefficiente dell’onda incidente uguale a 1:

√

(2.43)

ψ(x) = eikx + Ae−ikx , x < −a/2, k = 2mE/h̄;

0

0

ψ(x) = Be−k x + B 0 e−k x ,

ikx

ψ(x) = Ce

,

|x| < a/2,

k0 =

q

2m(W − E)/h̄; (2.44)

x > a/2.

(2.45)

Notare la presenza di una componente di onda crescente nella funzione d’onda

per |x| < a/2: in effetti, non abbiamo il diritto di escluderlo a priori! Il calcolo,

relativamente semplice ma un po’ laborioso, dà il seguente risultato:

4E(W − E)

4E(W − E) + W 2 sinh2 (k 0 a)

W 2 sinh(k 0 a)

= 1 − |C|2 =

.

4E(W − E) + W 2 sinh2 (k 0 a)

|C|2 =

(2.46)

|A|2

(2.47)

Il caso E > W si può ottenere con la sostituzione

0

p

k −→ ik1 = i

2m(E − W )

h̄

(2.48)

e dà il seguente risultato:

4E(E − W )

4E(E − W ) + W 2 sin2 (k1 a)

W 2 sin(k1 a)

= 1 − |C|2 =

.

4E(E − W ) + W 2 sin2 (k1 a)

|C|2 =

(2.49)

|A|2

(2.50)

|C|2 è detto coefficiente di trasmissione, mentre |A|2 è il coefficiente di riflessione. In generale, essi dipendono dall’energia e dalla forma del potenziale.

2.5.3

Buca di potenziale

La buca di potenziale è una schematizzazione molto semplice di un potenziale

attrattivo o vincolante: V (x) = −W per |x| < a/2, V (x) = 0 per x < −a/2

e x > a/2. Consideriamo l’intervallo di energia interessante: −W < E < 0.

Scriviamo la soluzione sotto la forma

0

k0 =

ψ(x) = Aek x ,

ψ(x) = B cos(kx − α),

−k0 x

ψ(x) = Ce

,

k=

q

2m|E|/h̄,

q

2m(W + E)/h̄,

x ≥ a/2,

x ≤ a/2

|x| ≤ a/2

(2.51)

(2.52)

(2.53)

più conveniente per i calcoli (scrivere la soluzione come coseno + fase è del tutto

equivalente a scrivere come somma di esponenziali complessi: possiamo sempre

ricondurci a soluzioni reali). Le condizioni di continuità a x = −a/2 e x = a/2

sono:

0

Ae−k a/2 = B cos(−ka/2 − α),

0

k 0 Ae−k a/2 = −kB sin(−ka/2 − α), (2.54)

20

0

0

Ce−k a/2 = B cos(ka/2 − α),

−k 0 Ce−k a/2 = −kB sin(ka/2 − α),

(2.55)

ovvero, dividendo membro a membro,

k tan(ka/2 + α) = k 0 ,

k tan(ka/2 − α) = k 0 .

(2.56)

Queste due condizioni possono essere soddisfatte contemporaneamente solo se

α = 0 o se α = π/2. Distinguiamo i due casi:

• Soluzioni pari (α = 0): esistono solo a energie per cui k tan(ka/2) = k 0 .

Introduciamo le variabili ausiliarie ζ = ka/2 e η = k 0 a/2. Le soluzioni si

possono trovare graficamente dall’intersezione delle due curve:

η2 + ζ 2 =

2m W a2

,

h̄2 4

η = ζ tan ζ

(2.57)

• Soluzioni dispari (α = π/2), per le quali k/ tan(ka/2) = −k 0 . Si procede

come sopra, cercando le intersezioni delle curve

η2 + ζ 2 =

2m W a2

,

h̄2 4

10

η = −ζ/ tan ζ

(2.58)

x tan x

-x/tan x

sqrt(1-x^2)

sqrt(9-x^2)

sqrt(36-x^2)

8

6

4

2

0

0

1.5708

3.1416

4.7124

6.2832

Si trova uno spettro (ovverosia l’insieme delle soluzioni) discreto, ovvero

formato da valori isolati di E. C’e’ sempre almeno una soluzione (è una caratteristica del potenziale considerato che non vale per altre forme di potenziale).

Lo spettro discreto è una caratteristica degli stati legati, ovvero confinati in una

zona di spazio. Notiamo anche che:

• Le soluzioni sono non degeneri; Questa è una caratteristica dello spettro

discreto nei sistemi unidimensionali (teorema di non degenerazione).

• Le soluzioni sono o pari: ψ(x) = ψ(−x), o dispari: ψ(x) = −ψ(−x),

rispetto all’operazione di inversione, x → −x. Questa è una conseguenza

della simmetria del potenziale, V (x) = V (−x).

• La soluzione di più bassa energia (lo stato fondamentale) è pari, quella di

energia subito sopra è dispari, e cosı̀ via. Questa è una proprietà generale

dei potenziali unidimensionali simmetrici per inversione.

21

• Lo stato fondamentale non ha nodi (ovverosia non passa mai per lo zero:

per nessun x, ψ(x) = 0); le soluzioni di energia crescente hanno un numero

crescente di nodi (1,2,3,...). Anche questa è una proprietà generale dei

potenziali unidimensionali.

Ovviamente non dobbiamo dimenticare che esiste anche uno spettro continuo

di soluzioni non legate e due volte degeneri per E > 0.

E‘ utile il confronto con il caso della buca infinita, le cui soluzioni si ottengono banalmente imponendo che la funzione d’onda sia nulla cove il potenziale

diventa infinito. Si tratta di condizioni diverse da quelle imposte per discontinuità finite del potenziale; ci se ne può convincere con una procedura di limite.

Conviene traslare l’origine rispetto al caso precedente e consideraro un

potenziale V (x) = 0 fra x = 0 e x = a, V (x) = ∞ al di fuori di tale intervallo. Imponiamo la condizione ψ(0) = ψ(a) = 0 sulle soluzioni per la particella

libera. Si ottiene

ψn (x) = sin(kn x),

kn =

nπ

a

En =

h̄2 k 2

n 2 h2

=

,

2m

8ma2

n = 1, ..., ∞ (2.59)

Si ritrovano tutte le caratteristiche del caso della barriera finita, salvo il numero

di soluzioni (infinito per la barriera infinita) e lo spettro continuo (qui assente).

Si notano inoltre due aspetti molto importanti:

• le funzioni d’onda sono ortogonali fra di loro:

Z

ψn∗ (x)ψm (x) = 0

se

n 6= m,

(2.60)

• le funzioni d’onda formano un insieme completo, ovvero qualunque funzione d’onda può essere espressa come somma, in generale infinita, delle

soluzioni dell’equazione di Schrödinger.

Tali aspetti sono presenti anche nel caso della buca finita, in quanto derivano

da proprietà generali dell’equazioni di Schrödinger, ma sono in questo caso

particolarmente visibili.

22

Chapter 3

L’equazione di Schrödinger

unidimensionale: soluzione

analitica e numerica

In questo capitolo verrà descritta una metodologia per risolvere sia analiticamente che numericamente l’equazione di Schrödinger indipendente dal tempo

in una dimensione per un oscillatore armonico; l’estensione dei metodi numerici

ad altri tipi di potenziali non comporta particolari difficoltà.

3.1

L’oscillatore armonico

L’oscillatore armonico è uno dei problemi fondamentali della dinamica classica, e anche della meccanica quantistica. Rappresenta il più semplice sistema

modello in cui sono presenti delle forze attrattive, quindi è un importante riferimento per tutti i fenomeni vibrazionali. Ad esempio, le vibrazioni di un sistema

di particelle fra loro interagenti può essere descritto, con una opportuna trasformazione di coordinate, in termini di modi normali di vibrazione, ciascuno dei

quali è in pratica un oscillatore armonico indipendente dagli altri.

Lo stesso vale in meccanica quantistica, dove per un sistema con stati legati

le frequenze vibrazionali non sono altro (a meno della costante di Planck) le

energie associate ai livelli energetici permessi. Attraverso lo studio quantistico

dell’oscillatore armonico si possono quindi capire diverse cose relative alla quantizzazione, e alle funzioni d’onda degli stati legati.

In questo capitolo esporremo i risultati principali della teoria dell’oscillatore

armonico, e cercheremo di mostrare come impostare un codice di calcolo che

permetta di risolvere numericamente la relativa equazione di Schrödinger. Il

programma risultante potrà poi facilmente essere modificato per inserire un

potenziale di interazione diverso da quello quadratico, e permettere cosı̀ lo studio di problemi che invece possono essere molto difficili da attaccare dal punto

di vista analitico.

23

3.1.1

Unità

L’equazione di Schrödinger di un oscillatore armonico unidimensionale è [utilizzando una notazione simile alla (2.4)]

1

d2 ψ

2m

= − 2 E − Kx2 ψ(x)

2

dx

2

h̄

(3.1)

dove m è la massa e K la costante di forza (la forza a cui è soggetta la massa

è cioè F = −Kx, proporzionale allo spostamento e diretta verso l’origine).

Classicamente a un tale oscillatore corrisponde una frequenza (angolare)

s

ω=

K

m

(3.2)

È conveniente passare ad unità adimensionali (in cui lavorano i due programmi

presentati in seguito): poniamo

ξ=

mK

h̄2

1/4

x

,

ε=

E

h̄ω

(3.3)

[usando la definizione (3.2) per ω] ottenendo l’equazione equivalente

d2 ψ

ξ2

=

−2

ε

−

dξ 2

2

!

ψ(ξ)

(3.4)

che è espressa in unità adimensionali.

3.1.2

Soluzione e livelli energetici

Come si può facilmente verificare, per grandi ξ (tali da poter trascurare ε) le

soluzioni della (3.4) devono avere l’andamento asintotico

ψ(ξ) ∼ ξ n e±ξ

2 /2

(3.5)

dove n ha un qualsiasi valore finito. Il segno + nell’esponente deve però essere scartato a priori perchè darebbe luogo a soluzioni divergenti e quindi non

normalizzabili (inoltre, l’intuizione stessa ci dice che la particella non dovrebbe

tendere ad allontanarsi da ξ = 0, punto verso cui è diretta la forza). Sembra quindi conveniente provare a scorporare l’andamento asintotico desiderato

ponendo

2

(3.6)

ψ(ξ) = H(ξ)e−ξ /2

dove H(ξ) è una funzione che a grandi ξ si deve comportare in modo che

2

l’andamento sia determinato dal secondo fattore e−ξ /2 . H(ξ) non deve, in

2

particolare, crescere come eξ , altrimenti saremmo in presenza di una delle

soluzioni che non desideriamo.

Con la posizione (3.6) la (3.4) diventa, per la nuova funzione incognita H(ξ),

H 00 (ξ) − 2ξH 0 (ξ) + (2ε − 1)H(ξ) = 0

24

(3.7)

Vediamo subito che ε0 = 1/2, H0 (ξ) = 1 è la soluzione più semplice. Come tra

poco si vedrà, questa è la soluzione che rappresenta lo stato fondamentale, cioè

quello ad energia più bassa.

Per ottenere le soluzioni generali sviluppiamo H(ξ) in una serie (in principio

infinita):

H(ξ) =

∞

X

An ξ n ,

(3.8)

n=0

deriviamo la serie per ottenere le derivate e riscriviamo la (3.7) combinando i

termini con la stessa potenza di ξ:

∞

X

[(n + 2)(n + 1)An+2 + (2ε − 2n − 1)An ] ξ n = 0

(3.9)

n=0

Affinchè ciò sia soddisfatto per qualsiasi valore di ξ è necessario che tutti i

coefficienti siano nulli:

(n + 2)(n + 1)An+2 + (2ε − 2n − 1)An = 0

(3.10)

Cosı̀, una volta dati A0 e A1 , la (3.10) permette di determinare per ricursione

l’intera soluzione in forma di serie di potenze.

Supponiamo che la serie sia veramente una serie infinita. A grandi n i

termini si comportano quindi come

An+2

2

→

An

n

(3.11)

2n

Ma, ricordando che exp(ξ 2 ) =

n ξ /n!, i cui coefficienti soddisfano pure

alla (3.11), vediamo che questa relazione tra i coefficienti fa crescere H(ξ) come

exp(ξ 2 ), ossia ci fornisce delle soluzioni divergenti indesiderate. L’unica maniera

per evitare che questo accada è fare in modo che, nella (3.10), tutti i coefficienti

da un certo punto in poi siano nulli, in modo che la serie si riduca in realtà ad

un polinomio di grado finito. Questo avviene se e solo se

P

ε=n+

1

2

(3.12)

dove n è un intero positivo o nullo.

Corrispondentemente, le energie possibili per l’oscillatore armonico sono

quantizzate:

1

En = n +

h̄ω n = 0, 1, 2, . . .

(3.13)

2

I corrispondenti polinomi Hn (ξ) sono detti polinomi di Hermite. Hn (ξ) è di

grado n in ξ, ha n nodi, ed è pari [Hn (−ξ) = Hn (ξ)] o dispari [Hn (−ξ) =

2

−Hn (ξ)] a seconda che n sia pari o dispari. Poichè e−ξ /2 non ha nodi ed è pari,

anche l’intera autofunzione corrispondente all’autovalore dell’energia En

ψn (ξ) = Hn (ξ)e−ξ

2 /2

(3.14)

ha n nodi e la parità di n. Più sotto si mostra come una parità definita è una

conseguenza della simmetria del problema rispetto all’inversione dell’asse x.

25

Figure 3.1: Funzioni d’onda e densità di probabilità dell’oscillatore armonico

quantistico.

I polinomi di Hermite di ordine più basso sono

H0 (ξ) = 1 ,

H1 (ξ) = 2ξ ,

H2 (ξ) = 4ξ 2 − 2 ,

H3 (ξ) = 8ξ 3 − 12ξ (3.15)

Un grafico delle corrispondenti funzioni d’onda e densità di probabilità è riportato in fig. 3.1.

3.1.3

Energia di punto zero

Una nota conseguenza della soluzione (3.13) è che il livello energetico più

basso—lo stato fondamentale—ha una energia finita h̄ω/2, chiamata energia

di punto zero e tipica dei sistemi quantistici. La sua esistenza è legata al

principio di indeterminazione di Heisenberg. Assumiamo infatti—in un’ottica

semiclassica—che l’energia totale sia dell’ordine di (∆p)2 /2m+K(∆x)2 /2, dove

∆p e ∆x sono misure della dispersione tipica della quantità di moto e della posizione della particella. Il principio di indeterminazione ci dice che ∆x∆p ≥ h̄/2,

da cui possiamo estrarre

√ ∆x ' h̄/2∆p e minimizzare l’energia rispetto a ∆p.

Si ottiene (∆p)2 ' h̄ Km/2, da cui E ' h̄ω/2.

Dunque vediamo che l’energia minima non può essere nulla. Se lo fosse,

avremmo determinato esattamente sia la posizione che la quantità di moto, in

contraddizione col principio di indeterminazione. Le conseguenze dell’energia

di punto zero possono essere importanti: ad esempio, He4 (a pressione atmosferica) resta allo stato liquido fino a temperature arbitrariamente piccole a causa

dell’energia di punto zero.

3.1.4

Simmetria e parità

Tutte le autofunzioni dell’oscillatore armonico con n pari sono funzioni pari, e

quelle con n dispari sono funzioni dispari. È facile dimostrare che in casi come

questo in cui il potenziale è simmetrico, ossia V (−x) = V (x), una soluzione