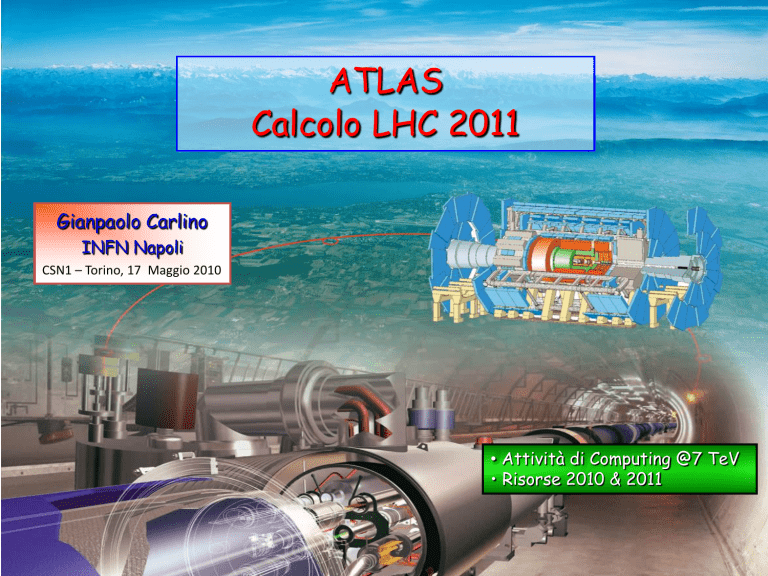

ATLAS

Calcolo LHC 2011

Gianpaolo Carlino

INFN Napoli

CSN1 – Torino, 17 Maggio 2010

• Attività di Computing @7 TeV

• Risorse 2010 & 2011

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

1

Attività di computing 2010

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

2

LHC 2010 – primo nb-1

Al 16 Maggio si sono raccolti 5.2 nb-1 (~300 M ev)

Le attività e le performance mostrate di seguito,

relative al primo nb-1 (~ 50 M ev) raccolto prima

del technical stop di fine aprile, sono pienamente

rappresentative del comportamento del

computing di ATLAS.

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

3

2010 LHC – Data taking

Physical Volume Size

3000

Dati raccolti e prodotti da ATLAS

per il primo nb-1 di luminosità

2500

other

2000

Raw Data Event size = 1.6 MB

NTUP

DESD

1500

AOD

1000

ESD

500

RAW

0

28-03-06

Logical Volume Size

04-04-06

11-04-06

18-04-06

25-04-06

700

600

500

other

400

NTUP

300

DESD

200

AOD

100

ESD

RAW

CSN1 – Torino, 17 Maggio 2010

• Physical Data (comprende tutte le

repliche distribuite in Grid) = 2.5 PB

(*2.5 vs 2009)

29-04-06

27-04-06

25-04-06

23-04-06

21-04-06

19-04-06

17-04-06

15-04-06

13-04-06

11-04-06

09-04-06

07-04-06

05-04-06

03-04-06

01-04-06

30-03-06

28-03-06

0

• Logical Data = 650 TB (*3 vs 2009)

G. Carlino – ATLAS: Calcolo 2011

4

Computing Model – Distribuzione dei dati

• RAW: 1 piano distribuita sull’insieme dei Tier1

• ESD: 2 copie sull’insieme dei Tier1. Replica nei Tier2 della cloud per i primi mesi

di run

• AOD: 2 copie sull’insieme dei Tier1. 10 copie sull’insieme dei Tier2 (~ 1 per

cloud)

• dESD: non replicati ai Tier1. 10 copie sull’insieme dei Tier2 (~ 1 per cloud)

• Distribuzione nei Tier1 in base al “Tier1 ratio”

Il “Tier1 ratio“ è quello reale, non

quello nelle tabelle WLCG: CNAF 5%

Sistema di repliche basato su un sistema di cancellazione

• i siti devono fornire un buffer per le attività pianificate nei successivi 3 mesi

• replicazione di tutti i dati nelle cloud come previsto dal CM

• determinazione dei dati “da custodire” nella cloud non cancellabili

• riduzione delle repliche in base al principi di popolarità dei dati

L’esperienza del primo anno e le performance della rete ci permetteranno

di modificare il CM allo scopo di ridurre il numero di repliche nella griglia

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

5

2010 LHC – Data Distribution

> 3 volte del throughput run 2009

• In media i dati sono disponibili ai Tier2 per l’analisi in circa 4 ore

• Efficienza 100%. Nessuno problema con la distribuzione dei dati

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

6

2010 LHC – Data Distribution in IT

CSN1 – Torino, 17 Maggio 2010

100

other

80

NTUP

60

DESD

40

AOD

ESD

20

RAW

G. Carlino – ATLAS: Calcolo 2011

29-04-06

27-04-06

25-04-06

23-04-06

21-04-06

19-04-06

17-04-06

15-04-06

13-04-06

11-04-06

09-04-06

07-04-06

05-04-06

03-04-06

01-04-06

0

30-03-06

ESD = 50 TB

• 10% al CNAF (5% custodial + 5% primario) e 10%

ai Tier2

120

28-03-06

RAW = 1 TB

1. CNAF Down per 2 giorni per migrazione cataloghi

2. Disco del CNAF in blacklist alcuni giorni perché

completo in attesa di cancellazioni forzate di dati

3. Scherzi della statistica: del 5% dei dataset nessun

MinBias

7

Reprocessing ai Tier1

3 campagne di reprocessing nel 2010:

• Febbraio: dati 2009 e cosmici

• Aprile: dati 2009 e 2010

• Maggio: dati 2009 e 2010 e MC (in corso)

CSN1 – Torino, 17 Maggio 2010

Reprocessamento del 100 % dei dati

• RAW ESD

• ESD merge

• ESD AOD, dESD

• Distribuzione nuovi dati nella Grid

G. Carlino – ATLAS: Calcolo 2011

8

Reprocessing ai Tier1

Attività di routine nei Tier1

• RAW data su disco nel 2010. Non è necessario il pre-stage da tape

• Efficienza richiesta 100%. Ok ma ancora con troppi interventi manuali

• Prevalidazione dei siti molto rigorosa

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

9

Uso risorse al CNAF

Risorse ATLAS al CNAF:

Attualmente: 8700 HS06

Pledge 2010: 16000 HS06

Monitor CNAF

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

10

Uso risorse nei Tier2 - CPU

Nota. Accounting non corretto per il Tier2 di Milano fino a inizio Marzo. Accounting

parziale a Roma per 1 mese (aprile) per la perdita di dati di un CE

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

11

Analisi Distribuita

Dati

• distribuzione organizza centralmente con DDM/DQ2 in base al Computing Model

• il formato dati utilizzato utilizzato per l’analisi dipende dalle necessità dei gruppi (fisica o locali)

User jobs

• Modello: “i job vanno dove sono i dati”. I siti devono garantire stabilità e affidabilità

• La banda passante disponibile potrà permettere di modificare il modello spostando i dati dove

sono disponibili le CPU riducendo il numero di repliche sulla griglia

Scelta del Frontend e del Backend

• con la reale attività di analisi gli utenti utilizzano gli strumenti che garantiscono la migliore

efficienza, velocità, semplicità d’uso e stabilità

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

12

Analisi Distribuita

Uso significativo della Grid per l’analisi

• 2.2 milioni di job completati

• 16.6 miliardi di eventi analizzati

• 705 utenti (350 runnano più di 1000 job)

(valori relativi al primo nb inverso)

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

13

Analisi Distribuita

• Al momento il formato più popolare è l’ESD, più completo e adatto per lo studio delle

performance, il 5% è in Italia

⇒ Gli utenti italiani mandano i loro job nelle altre cloud dove sono i dati

• Fase iniziale per tunare la composizione dei dESD (ESD skimmati e slimmati) replicati

completamente in ogni cloud

⇒ E’ necessario passare al più presto all’utilizzo di dESD e AOD. Le risorse disponibili

in altre cloud sono limitate.

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

14

Analisi Distribuita

Job di Analisi con Panda in Italia

• non viene riportato l’uso del

WMS comunque significativo in

Italia

• Frascati è da poco rientrato

tra i siti cui vengono replicati i

dati (10%)

Esempio di job su un

Tier2 ultima settimana

• Produzione

• Analisi Panda

• Analisi WMS

Buchi dovuti alla mancanza di produzione a causa del ridottissimo spazio disco libero al CNAF

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

15

Analisi Distribuita – Accesso ai dati

Popular Sites: Analisi dell’accesso ai dati per sito, area di storage e formato dati

• Alla base del sistema di cancellazione delle repliche

• Fornisce una statistica dell’uso dei siti

Popular Sites (LOCALGROUPDISK)

LOCALGROUPDISK - Area di Storage locale dedicata agli output dei job prodotti in Grid

• Indipendentemente dalla cloud dove girano i job, l’output viene trasportato nel proprio

Tier2 e opportunamente catalogato per l’uso successivo nella Griglia (non Tier3)

• Spazio disco non pledged. E’ necessario garantire agli utenti italiani uno spazio sufficiente

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

16

Analisi Distribuita – Accesso ai dati

Popular Sites (ESD)

Popular Sites (dESD)

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

17

Group Analysis

Attività di skimming e slimming dei gruppi di Fisica e Performance di ATLAS

Selezione dei siti (faticosa) in base alle performance determinate dai test periodici

di analisi (Hammer Cloud), all’affidabilità e alla disponibilità di spazio disco.

Milano, Napoli e Roma hanno superato senza problemi la selezione. Frascati

supera le metriche di performance e affidabilità ma non ha lo spazio disco

necessario. Faremo richiesta dopo l’installazione delle risorse 2010

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

18

Risorse Computing ATLAS

CSN1 – Torino, 17 Maggio 2010

Risorse Tier1 e Tier2 2010

Previsione Risorse 2011

Tier3

G. Carlino – ATLAS: Calcolo 2011

19

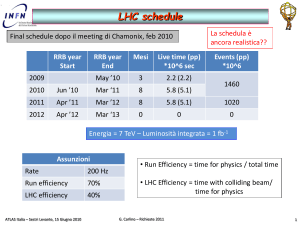

LHC schedule

Final schedule dopo il meeting di Chamonix, feb 2010

RRB year

Start

2009

RRB year

End

Mesi

Live time (pp)

*10^6 sec

May ’10

3

2.2 (2.2)

Events (pp)

*10^6

1460

2010

Jun ’10

Mar ‘11

8

5.8 (5.1)

2011

Apr ’11

Mar ’12

8

5.8 (5.1)

1020

2012

Apr ’12

Mar ‘13

0

0

0

Energia = 7 TeV – Luminosità integrata = 1 fb-1

Assunzioni

Rate

200 Hz

Run efficiency

70%

LHC efficiency

40%

CSN1 – Torino, 17 Maggio 2010

• Run Efficiency = time for physics / total time

• LHC Efficiency = time with colliding beam/

time for physics

G. Carlino – ATLAS: Calcolo 2011

20

Computing Model – Input parameters

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

21

Computing Model – Input parameters

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

22

Risorse ATLAS – Tier1

Attività principali:

Reprocessing dati reali e simulati,

simulazione e analisi di gruppo.

Attività asincrone con il data taking,

scalano con il volume dei dati

2010. riduzione (CPU) o non variazione

(Disco) delle risorse nonostante la

schedula LHC più lunga

2011. moderato aumento risorse

(~27% CPU e ~14% Disco) nonostante

il raddoppio dei dati raccolti

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

23

Risorse ATLAS al CNAF 2010

Gare 2009

CNAF - 2010

Gara

Opzione base

CPU (kHS06)

8.7

Disco (PBn)

1.3

E’ importante esercitare il più presto

possibile le opzioni delle gare

• installazione CPU in tempo per il 1° Giugno

• installazione disco settembre/ottobre

CSN1 – Torino, 17 Maggio 2010

Gara

Opzione 1

Gara

Opzione 2

16

1.8

Share CNAF = 8%

G. Carlino – ATLAS: Calcolo 2011

24

Risorse ATLAS 2010 “normalizzate” (TW=0)

Canada

Triumf

(5%)

Germany

FZK

(11%)

NDGF

(4%)

UK

RAL

(13%)

Spain

PIC

(5%)

100%

France

CCIN2P3

(13%)

Netherlands

SARA/NIKHEF

(15%)

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

Italy

CNAF

(9%)

USA

BNL

(25%)

25

Previsione Risorse ATLAS al CNAF 2011

2010

2011

CNAF

ATLAS

CNAF 10%

Δ

k€

CPU

(kHS06)

16

226

22.6

6.6

165

Disco

(PBn)

1.8

25

2.5

0.7

455

1.3

30

3

1.7

Tape

(PB)

• 10% è lo share corretto per un Tier1 di una cloud con il

9% di autori

• I numeri vanno armonizzati con le richieste degli altri

esperimenti LHC per conservare al CNAF le usuali

percentuali basate sul numero di autori italiani

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

CPU = 25 €/HS

Disco = 650 €/TBn

Tape = 75 €/TB

Questi costi andranno

valutati criticamente in

seguito alle veloci

variazioni del rate con il

dollaro

26

Risorse ATLAS – Tier2

Attività principali:

Simulazione e analisi di gruppo e di

utente.

Simulazione e analisi di gruppo

condivise con i Tier1. Analisi di

utenti solo ai Tier2

2010. riduzione (CPU) o moderato

aumento (Disco) delle risorse

nonostante la schedula LHC più lunga

• diminuzione tempo simulazione

• cancellazione vecchie simulazioni

obsolete o a energie ≠ 7 TeV

2011. aumento significativo risorse

(~20% CPU e ~60% Disco) a causa del

raddoppio dei dati raccolti

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

27

Risorse 2010 nei Tier2

2010

T2 Italia

T2 ATLAS

T2 It/ATLAS

Pledges

Uso IT

CPU

(kHS06)

16

226

7,1%

12 (5%)

25%

1.0 (4%)

43%

1.3 (5%)

26%

Disco

(PBn)

1.76

24

7,3%

Uso IT: risorse “non pledged” da dedicare

agli utenti italiani (LOCALGROUPDISK).

~25% delle risorse dei Tier2 nel 2010

Le risorse disponibili nel 2010 nei Tier2 Italiani sono solo una stima

• numeri presentati al referaggio di marzo

• cambio con il dollaro notevolmente peggiorato: al momento costo superiore del 15 o 20%

Gare: tempistica per l’acquisizione notevolmente cambiata

• richiesta dell’amministrazione INFN di effettuare gare pubbliche raggruppando le gare

• messa in produzione probabile solo a dicembre

• le gare ai Tier2, lunghe come quelle del CNAF, vanno programmate in tempo per le

scadenze WLCG

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

28

Previsione risorse 2011 nei Tier2

CPU = 25 €/HS

Disco = 600 €/TBn

2010

2011

T2 Italia

ATLAS

T2 Italia 7%

Δ

K€

T2 Italia 9%

Δ

k€

16

278

19,5

3.5

87

25

9

225

1.76

38

2.7

0.9

540

3,4

1,7

996

CPU

(kHS06)

Disco

(PBn)

Totale

Rete

Server

Gran tot.

Share Tier2:

• ~ 7% attuale (5% pledged)

• ~ 9% corrisponde al numero di autori

italiani. Auspicabile!

Questa tabella fornisce i possibili ordini

di grandezza delle richieste

CSN1 – Torino, 17 Maggio 2010

627

1221

34

85

63

152

30

50

724

1458

691

1356

(Bozzi – CSN1 09/09)

Stime per la rete suff. corrette, eccessive per i server

G. Carlino – ATLAS: Calcolo 2011

29

Tier3

Modello ATLAS per i Tier3

• Task force in ATLAS e in Italia per definire funzionalità e testare tool specifici

• Analisi interattiva (Root, Proof) e sviluppo di codice. Storage locale (ntuple)

• siti molto importanti per l’attività locale

• Molti siti già attivi

• in tutto il mondo e soprattutto in America

• in Italia alcuni siti di test (Genova, Roma3, Trieste/Udine)

• Tipologia Tier3:

• sito pienamente “grigliato” (in Italia p.es. farm INFN-GRID)

• Tier3 @Tier2 (tipologia più diffusa in ATLAS)

• piccola farm locale non “grigliata”

• Discussione in Italia

• primo incontro con i referee al Workshop congiunto INFN-GRID & CCR

• Richieste finanziarie

• richieste minime verranno presentate nei preventivi (trascurabili rispetto ai

Tier2) per dotare alcune farm dello spazio disco base (pochi TB) e/o server

necessari per UI o “interfaccia” con la Griglia

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

30

Conclusioni

Aspetti positivi:

• la griglia sembra funzionare sufficientemente bene (giudizio degli utenti)

• distribuzione dati efficiente e veloce

• la riduzione del numero di repliche previste dal CM dopo il referaggio dell’anno scorso

non ha penalizzato le attività

• l’analisi dei dati è stata possibile sin dal primo momento nella griglia

• size degli eventi sotto controllo

• riduzione dei tempi di simulazione degli eventi

• modello dei Tier3 sufficientemente maturo. Siti molto importanti a livello locale

Aspetti da verificare o negativi:

• Sistema di diminuzione delle repliche basato sulla cancellazione dei dati meno popolari

• Analisi distribuita

• da dimostrare che scali al crescere dei dati

• limitatezza delle risorse. Le risorse a disposizione all’estero sono sempre più ridotte e

bisogna poter contare sulle risorse italiane

• migliorare la stabilità e l’efficienza di alcuni tool di analisi distribuita

• Reprocessing da disco. Nel 2011 dovrà essere fatto da tape

• Spazio disco al CNAF veramente ridotto e fonte di grandi sofferenze

• Gare pubbliche ai Tier2. Le risorse 2010 saranno disponibili solo a fine anno. Attenzione per

l’acquisizione delle risorse 2011

CSN1 – Torino, 17 Maggio 2010

G. Carlino – ATLAS: Calcolo 2011

31