ATLAS

Computing Model

Lamberto Luminari

CSN1 - 31 Gennaio, 2005

Sommario

Introduzione

Event Data Model

Tempo di processamento

Infrastruttura di calcolo a tier

Tier0, Tier1, Tier2, Tier3

Infrastruttura di calcolo

Event data flow:

Streaming, EF -> Tier0, ESD, AOD, TAG

Catalogazione, replica e distribuzione dei dati

Modelli di analisi

Risorse

Tier1, Tier2

Timeline

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

2

Introduzione

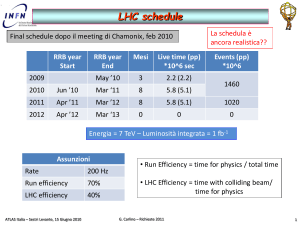

Il modello di calcolo attuale presenta ancora margini di indeterminazione

si cerca di mantenere flessibilità ovunque possibile

Le risorse presentate come necessarie derivano dal modello attuale e si basano

sulle seguenti condizioni di operazione:

Luminosità:

Frequenza di trigger:

Frequenza di collisioni:

Tempo di data-taking:

Numero di eventi reali:

Numero di ev. simulati:

2007: 100 giorni a 0.5 x 1033 cm-2s-1

2008-2009: 200 giorni/anno a 2 x 1033 cm-2s-1

2010 e oltre: 1034 cm-2s-1 (luminosità di disegno)

200 Hz (indipendentemente dalla luminosità)

109 Hz alla luminosità di disegno

50k sec/giorno

107 eventi/giorno -> 2 x 109 eventi/anno

20% eventi reali -> 4 x 108 eventi/anno

Rimangono molte incognite, e in particolare:

La strategia per la calibrazione e l’allineamento è ancora in evoluzione

Si inizierà a testare lo schema completo di accesso ai dati tra qualche mese

improbabile uno schema stabile prima del 2007

La dimensione dei vari tipi di dati e il tempo di processamento relativo sono solo stime

E’ possibile che il modello debba adeguarsi a una disponibilità di risorse diversa da

quella ipotizzata

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

3

Event Data Model

Raw Data:

Event Summary Data (ESD):

Analysis Object Data (AOD):

Tag Data (TAG):

Derived Physics Data (DPD):

Simulated Event Data (SIM):

–

–

–

–

–

–

eventi in formato “ByteStream” prodotti dalla catena di TDAQ; in genere costruiti dagli Event Builders e

trasmessi in output dall’Event Filter (l’ultimo stadio degli High Level Trigger):

1.6 MB/evento nominali

l’output completo della ricostruzione in formato POOL ROOT; sufficiente per quasi ogni applicazione (eccetto

che per calibrazioni e sviluppo algoritmi di ricostruzione):

obiettivo: 500 KB/evento

rappresentazione dell’evento ridotta, derivata dagli ESD, conveniente per l’analisi, in formato POOL ROOT;

contiene gli oggetti fisici e altri elementi di interesse per l’analisi:

obiettivo: 100 KB/evento

informazioni essenziali sugli eventi per permettere un’efficiente identificazione e selezione degli eventi di

interesse per una data analisi; per facilitarne ed ottimizzarne l’accesso sono memorizzati in un database

relazionale:

obiettivo: 1 KB/evento

rappresentazione tipo n-tupla dei dati dell’evento per l’analisi e la istogrammazione dell’utente finale; inclusa nel

data model per permettere un’analisi immediata e la visualizzazione dei risultati con i tanti tool standard di

analisi (PAW, ROOT, JAS, …)

una gamma di tipi di dati, a cominciare dagli eventi generati (ad es., con Pythia o programmi simili) alla

simulazione delle interazioni con l’apparato (ad es., hits di Geant4) e della risposta dei rivelatori

(digitizzazione); possono anche includere il pileup e il fondo di caverna; memorizzati come file POOL ROOT (in

genere) o in formato bytestream per studi di trigger:

spesso 2 MB/evento

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

4

Tempi di processamento

Simulazione (includendo generazione dell’ evento, tracciamento con Geant4,

digitizzazione):

– 100 kSI2k•sec/evento nominali

Ricostruzione:

– 15 kSI2k•sec/evento nominali a tutte le luminosità:

attualmente 2-4 volte maggiore, a seconda dalla fisica, ma:

– si assume di poter guadagnare un fattore 2 dal lavoro di ottimizzazione nel 2005-2006

(questa è la prima reale implementazione con Geant4 della simulazione ATLAS)

– si assume di poter guadagnare un ulteriore fattore 2 limitando il tracciamento a |η|< 3 invece

che |η|< 6 quando non strettamente necessario

attualmente 4 volte maggiore, ma:

– si assume di poter guadagnare un fattore 2 dal lavoro di ottimizzazione nel 2005-2006;

– attualmente si utilizzano 2 algoritmi in parallelo per Inner e Muon Detector;

– le soglie possono essere accordate con la luminosità per compensare l’aumento dei tempi

necessari per il pattern recognition

Analisi:

– 0.5 kSI2k•sec/evento nominali per analisi sugli AOD

stima basata sui tempi di accesso attuali agli AOD

– 0.5 kSI2k•sec totali per analisi su collezioni complete (tutti i dati di un anno) di DPD; (nella

vita reale saranno piu’ frequenti analisi su campioni ridotti (1-10% dei dati) ma ripetute molte volte)

stima basata sui tempi di accesso attuali alle n-tuple

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

5

Infrastruttura di calcolo a tier

~PB/sec

Il modello di calcolo di ATLAS presenta un elevato grado di

decentramento e fa essenziale affidamento sulle risorse esterne al

CERN e sulla loro condivisione.

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k – 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Pur essendo basato in modo sostanziale sul paradigma Grid, il modello

mantiene ruoli ben definiti e distinti ai diversi elementi che compongono

l’infrastruttura di calcolo, secondo il modello gerarchico a tier

sviluppato nell’ambito del progetto MONARC.

Ai centri ai vari livelli sono assegnati compiti primari e compiti di

sussidiarietà, da svolgere qualora i centri deputati siano

temporaneamente impossibilitati.

Accanto alla struttura primaria (gerarchica), esistono strutture

orizzontali che legano tra di loro centri dello stesso livello, con funzioni

sia complementari che sussidiarie.

Il modello fissa essenzialmente la tipologia e la qualità delle risorse e

dei servizi che le facility ai vari livelli devono fornire: centri dello

stesso rango possono differire in dimensione (compatibilmente con gli

impegni contrattati con la Collaborazione).

Lamberto Luminari - ATLAS Computing Model

6

Ruolo del Tier0

~PB/sec

Event Builder

Il Tier0 è responsabile dell’archiviazione e della distribuzione ai

Tier1 (e Tier2) dei dati RAW, ricevuti dalla catena di TDAQ.

10 GB/sec

Event Filter

Processa velocemente gli stream di calibrazione e espressi.

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

Ricostruisce gli eventi (utilizzando le costanti di calibrazione

calcolate) e produce i dataset derivati (ESD, AOD e TAG

“primari”).

Distribuisce i dataset derivati ai Tier1.

In caso di problemi di processamento o trasmissione, memorizza

i dati in un disk buffer che corrisponde a ~ 5 giorni di presa dati.

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

7

Ruolo dei Tier1

Il modello prevede circa 10 Tier1.

~PB/sec

Ogni Tier1 tiene in archivio 1/10 dei RAW data e ne garantisce

l’accesso a lungo termine.

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Ogni Tier1 tiene copia di 1/5 degli ESD e di tutti gli AOD e TAG

(la versione più recente su disco, le precedenti eventualmente su

mass storage a più lento accesso).

I Tier1 ospitano e rendono velocemente accedibili i campioni di

eventi simulati prodotti nei Tier2 che a loro fanno riferimento.

I Tier1 devono garantire la capacità ci calcolo necessaria a

riprocessare ed analizzare tutti i dati ivi residenti (Grid!).

Le risorse dichiarate devono essere disponibili a tutta la

Collaborazione (ancora Grid!).

Il livello dei servizi, in termini di affidabilità e tempi di risposta,

deve essere elevato; non dovrebbero verificarsi interruzioni

superiori alle 12 ore e, in caso di periodi più lunghi, è previsto che

un altro dato Tier1 fornisca almeno accesso agli stessi dati.

Lamberto Luminari - ATLAS Computing Model

8

Ruolo dei Tier2

I Tier2 assumono un ampio spettro di ruoli e funzioni, in particolare

per le calibrazioni, la simulazione e l’analisi.

~PB/sec

Event Builder

La loro dimensione e il tipo di risorse può variare sensibilmente a

seconda delle attività e della dimensione dei gruppi di fisica che vi

fanno riferimento.

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Un Tier2 ospiterà tipicamente 1/3 degli AOD correnti e tutti i TAG.

Ospiterà anche i DPD di interesse locale e campioni di RAW data e

ESD per analisi e sviluppo algoritmi.

I Tier2 forniscono tutta la capacità di simulazione necessaria alla

collaborazione; a meno che un Tier2 non riesca a garantirne esso

stesso l’accesso in modo veloce e affidabile, i dati simulati saranno

migrati al Tier1 di riferimento (si ipotizzano circa 4 Tier2 per ogni

Tier1).

Alcuni centri, a seguito del coinvolgimento della comunità locale in

un rivelatore, potranno avere un ruolo rilevante nelle procedure di

calibrazione e allineamento.

Lamberto Luminari - ATLAS Computing Model

9

Ruolo dei Tier3

~PB/sec

Il ruolo dei Tier3 è meno definito di quello dei centri di rango

superiore, comunque nel modello attuale essi assumono una

importanza rilevante nella simulazione e l’analisi degli utenti

singoli.

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

La loro dimensione e il tipo di risorse può variare sensibilmente a

seconda delle attività e del numero degli utenti che vi fanno

riferimento.

Contengono DPD e campioni di AOD e ESD per analisi specifiche

e sviluppo algoritmi.

Il controllo delle risorse (allocazione, priorità, condivisione, …) è

completamente sotto controllo locale.

I Tier3 costituiscono un importante buffer di risorse per

fronteggiare tutte le inefficienze o gli imprevisti non

esplicitamente considerati nel modello di calcolo.

Tier3

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

10

Data Flow: Streaming

~PB/sec

Stream di dati principali dagli High Level Trigger (LV2 + EF):

Event Builder

10 GB/sec

LV2

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

Stream primario, contenente tutti gli eventi di fisica

Express line

Eventi di calibrazione:

processamento veloce (risorse dedicate in situ)

calibrazione fine (Tier2)

Stream per debugging e diagnostica

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Obiettivi principali dello streaming:

Ridurre la latenza per un sottoinsieme di eventi (in particolare

quelli di calibrazione)

Processare lo stream primario con i risultati ottenuti dallo stream

di calibrazione

Risorse necessarie:

La calibrazione veloce e la express line dovrebbero occupare

~20% di bandwidth e CPU

Lamberto Luminari - ATLAS Computing Model

11

Data Flow: EF -> T0

~PB/sec

Assunzioni:

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

5 PB/anno

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

200 Hz * 1.6 MB/evento

320 MB/second

~30-50 manager di subfarm dell’EF riempiono file con eventi in

formato bytestream

I file di eventi sono statisticamente equivalenti nella miscela di

eventi che contengono (cioè, le subfarm EF sono identiche, non

specializzate per processare certi tipi di eventi)

Modello:

I file sono riempiti fino a 2 GB e poi subito inviati al Tier0

Ogni manager di subfarm dell’EF chiude un file

approssimativamente ogni 200-350 secondi

I file contengono eventi di un solo run

alcuni file corti ma gestione dati semplificata

Gli eventi non possono essere scritti su più file

La dimensione degli eventi, anche i più complessi, è piccola

rispetto a quella del file

gestione dati semplificata senza imporre condizioni

gravose

Lamberto Luminari - ATLAS Computing Model

12

Produzione di dati primari derivati

ESD:

~PB/sec

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

AOD:

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

La produzione degli ESD primari è fatta su una farm al Tier0

Il flusso di dati primario della ricostruzione è: file bytestream -> ESD

I processi di ricostruzione operano su file completi, non eventi singoli

Ogni processo di ricostruzione scrive gli ESD su persistent storage indipendentemente

Ogni processo scrive un singolo stream di ESD in output

nessuna suddivisione iniziale in base al trigger o al canale di fisica; streaming

possibile successivamente

La produzione degli AOD primari è fatta al Tier0

Gli AOD devono poter essere prodotti a partire dai soli ESD

Ogni processo di produzione scrive gli AOD su persistent storage indipendentemente

A differenza di quanto avviene per gli ESD (almeno inizialmente), un singolo processo

scrive eventi AOD su stream differenti per differenti physics working group

Gli stream di AOD primari sono limitati in numero a O(10), a seconda del tipo

di trigger o del canale di fisica o del physics working group o…: la scelta

dipende dal coordinamento per la fisica

Altri stream di AOD saranno possibili in fase di ricostruzioni successive ai

Tier1

Ogni evento è scritto su un solo stream primario

Tutti gli stream primari formano una partizione disgiunta del run

Tutti gli stream primari condividono esattamente la stessa definizione di AOD

Piu’ semplice accedere a eventi su stream separati

Le liste di file AOD non sono previste essere l’interfaccia primaria ai dati per il fisico medio

Lamberto Luminari - ATLAS Computing Model

13

Collezioni di eventi

~PB/sec

Modello:

Event Builder

10 GB/sec

Ogni processo che produce AOD inserisce anche i riferimenti agli eventi

(insieme ai meta-dati relativi) in collezioni di eventi

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

Un gruppo di analisi che non ha il suo stream primario di AOD può in linea di

principio avere la sua collezione, che gli permette di accedere agli eventi di

interesse con efficienza

Ogni processo scrive la sua collezione su un file, per evitare problemi di

accesso concorrente al database

Un processamento successivo concatena le varie collezioni, che sono su file, in

collezioni residenti su database, opportunamente indicizzate per velocizzare

l’accesso alle informazioni

vengono popolati i database di TAG

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Le collezioni risultanti costituiscono la base per la produzione di collezioni

secondarie e altri dati derivati in fasi successive di processamento

opportune query ai database permettono di estrarre sottocampioni di

eventi con relativi riferimenti

Lamberto Luminari - ATLAS Computing Model

14

Replica e distribuzione dei dati

RAW:

~PB/sec

Una replica completa dei raw data risiede nei Tier1 (~1/10 per Tier1)

Campioni di eventi sono memorizzati anche nei Tier2 e, in misura minore, nei

Tier3

Event Builder

10 GB/sec

ESD:

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

Tutte le versioni degli ESD sono replicate e risiedono in almeno due dei Tier1

Gli ESD primari sono spediti dal Tier0 a un Tier1; in caso di successo, possono

essere cancellati dal Tier0 (riprocessing solo ai Tier1)

Gli ESD primari e i RAW data asswociati sono assegnati ai ~10 Tier1 con un

meccanismo di roundrobin

La replica degli ESD su un secondo Tier1 è un compito Tier1 -> Tier1 che può

essere eseguito con comodo (ad es., quando non c’è data taking?); in ogni caso, il

Tier0 non è coinvolto.

Campioni di eventi sono memorizzati anche nei Tier2 e, in misura minore, nei

Tier3

AOD:

Sono replicati completamente in ogni Tier1 e parzialmente nei Tier2 (~1/3 – 1/4).

Alcune stream possono essere memorizzate nei Tier3

TAG:

I database dei TAG sono replicati in tutti i Tier1 e Tier2

DPD:

Nei Tier1, Tier2 e Tier3

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

15

Modelli di analisi

Produzione centrale schedulata di AOD, n-tuple e TAG dagli ESD:

~PB/sec

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

Si assume che ci saranno ~20 gruppi di analisi

Ogni canale di analisi può richiedere varie iterazioni, accedendo a:

TAG di tutti gli eventi

sottocampioni di AOD

eventuali (pochi) ESD

pochissimi eventi RAW

Una riduzione al 10% di tutti gli AOD per gruppo, 2 versioni

125 TB ad ogni Tier1

Produzione in quasi real time di DPD

13 MSI2k

Analisi caotica di singoli utenti di AOD e n-tuple, nuove selezioni,

simulazioni particolari, etc.:

Si assume che ci siano 600 utenti offsite (+100 al CERN), ciascuno dei quali

analizza il 10% dei campioni dei gruppi di analisi (quindi 1% del totale

degli AOD + pochissimi ESD)

tiene su disco due versioni dei suoi DPD

15 kSI2k and 2.1 Tb per utente

Uno scenario di analisi:

Si invia una query a un dataset di TAG (es., l’ultimo) residente su DB

Il risultato della query serve ad individuare gli AOD relativi agli eventi

selezionati

Un ulteriore algoritmo di selezione può essere applicato agli eventi e il

risultato puo’ essere un dataset ridotto di AOD o DPD (piu’ raramente di

ESD o RAW) o direttamente una n-tupla.

L’analisi di grandi campioni di eventi sarà distribuita (Grid)!

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

16

Risorse necessarie al Tier0

~PB/sec

Event Builder

2008 data Tier 0 requirements

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

Disk (TB)

5. MSI2k - 5 PB/y

CPU (MSI2k)

Raw

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

Shelf.Tape (TB)

ESD

0

3040

0

1000

Buffer

127

0

Calibration

240

168

Total

354

4208

Reconstruction

3.5

Calibration

0.5

An alysis

0.0

Total

4.1

622Mb/s links

Tier3

RWL Jones, Lancaster University

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

17

Evoluzione risorse al Tier0

~PB/sec

Event Builder

10 GB/sec

35000

Event Filter

30000

~7.5 MSI2k

320 MB/sec

25000

Tier0

5. MSI2k - 5 PB/y

Total Disk (TB)

20000

Total Tape (TB)

~ 75MB/s

Total CPU (kSI2k)

15000

Tier1

~10

2. MSI2k - 2 PB/y

10000

622Mb/s links

5000

Tier2

~4/Tier1

~.5 MSI2k

0

622Mb/s links

Total Disk (TB)

Tier3

Total Tape (TB)

Total CPU (kSI2k)

CSN1 - 31/01/2005

2007

2008

2009

2010

164.692 354.1764 354.1764 495.847

2011

2012

660.539 850.0234

1956.684 6164.608 10372.53 16263.62 22154.72 30002.49

1826

4058

4058

8239

Lamberto Luminari - ATLAS Computing Model

10471

10471

18

Risorse necessarie alla

CERN Analysis Facility (CAF)

~PB/sec

Event Builder

10 GB/sec

CERN Analysis Facility

Event Filter

Disk (TB)

Tape (TB)

Raw

241

0

ESD (current)

229

0

0

18

257

0

AOD (previous)

0

4

TAG (current)

3

0

TAG (previous)

0

2

286

0

MC ESD (previous)

0

4

MC AOD (current)

57

0

0

40

0.6

0

0

0.4

Calibration

240

168

User Data

303

212

1615

448

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

Tier1

ESD (previous)

CAF

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

AOD (current)

MC ESD (current)

MC AOD (previous)

MC Tag (current)

MC Tag (previous)

Total

CPU (MSI2k)

Reconstruction

0.2

Calibration

0.5

Analysis

1.5

Total

2.2

•The analysis is mainly chaotic

•The calibration role is vital

•The role in commissioning is also central

especially refining reconstruction,

developing calibration etc

RWL Jones, Lancaster University

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

19

Evoluzione risorse alla CAF

~PB/sec

Event Builder

10 GB/sec

18000

Event Filter

16000

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

14000

12000

CAF

Total Disk (TB)

10000

Total Tape (TB)

Total CPU (kSI2k)

8000

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

6000

4000

2000

622Mb/s links

Tier3

0

2008

2009

2010

2011

2012

Total Disk (TB)

751.1699 1812.943 2342.153 3463.75 4955.813 6758.48

Total Tape (TB)

208.0896 567.2796 824.8605 1261.443 1622.057 2190.76

Total CPU (kSI2k)

CSN1 - 31/01/2005

2007

974

2822

4286

8117

Lamberto Luminari - ATLAS Computing Model

12279

16055

20

Risorse necessarie ai Tier1

~PB/sec

Event Builder

2008 data Combined Tier 1

Requirements

10 GB/sec

Event Filter

Disk (TB)

Tape (TB)

430

3040

ESD (current)

2570

900

Reconstruction

4.5

ESD (previous)

1290

900

Calibration

0.5

AOD

2830

360

An alysis

12.9

TAG

30

0

2400

0

Total

18.0

MC R AW

0

800

MC ESD

(current)

570

200

MC ESD

(previous)

290

200

AOD

Simulation

630

80

10

0

1260

0

12300

6480

~7.5 MSI2k

320 MB/sec

Tier0

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

Raw

Calibration

Tag Simulation

Group User

Data

Total

CPU (MSI2k)

This includes a ‘1year, 1 pass’ buffer

required to maintain coherent datasets

for current analysis while reprocessing

RWL Jones, Lancaster University

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

21

Evoluzione risorse ai Tier1

~PB/sec

Event Builder

200000

10 GB/sec

180000

Event Filter

160000

~7.5 MSI2k

320 MB/sec

5. MSI2k - 5 PB/y

Total Tape (TB)

100000

~ 75MB/s

Tier1

Total Disk (TB)

120000

Tier0

~10

2. MSI2k - 2 PB/y

140000

622Mb/s links

Total CPU (kSI2k)

80000

60000

40000

20000

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

0

2007

2009

2010

2011

2012

Total Disk (TB)

5541.362 15464.46 23093.6 41872.46 56997.26 72122.06

Total Tape (TB)

3015.246 10114.47 18535.89 30873.28 45061.74 61101.28

Total CPU (kSI2k)

CSN1 - 31/01/2005

2008

7899

26502

47600

81332

Lamberto Luminari - ATLAS Computing Model

123827

172427

22

Risorse necessarie ai Tier2

~PB/sec

Event Builder

2008 Data Combined Tier-2

10 GB/sec

Event Filter

~7.5 MSI2k

Disk (TB)

320 MB/sec

Raw

Tier0

General ESD (curr.)

5. MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

2. MSI2k - 2 PB/y

General ESD (prev..)

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

385.7

0.0

AOD

2571.4

TAG

77.1

R AW Sim

622Mb/s links

CPU (MSI2k)

43.4

171.4

ESD Sim (prev.)

0.0

AOD Sim

571.4

Tag Sim

17.1

User Group

1257.1

User Data

1815.3

Total

6910.1

2.0

Simulation

5.4

An alysis

8.8

Total

0.0

ESD Sim (curr.)

Reconstruction

16.2

User

User activity

activity includes

includes some

some

reconstruction

reconstruction (algorithm

(algorithm development

development

etc)

etc)

Al

Al so

so includes

includes user

user simulation

simulation

(increased)

(increased)

Tier

Tier 2s

2s also

also share

share the

the event

event simulation

simulation

load,

load, but

but not

not the

the output

output data

data storage

storage

RWL Jones, Lancaster University

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

23

Risorse ai Tier0/1/2 + CAF

necessarie per il solo 2008

~PB/sec

Event Builder

CPU (MSI2k)

10 GB/sec

~7.5 MSI2k

320 MB/sec

Tier0

~ 75MB/s

~10

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

0

0.0

0.0

Other

4

4.2

0.4

Simulation

0

0.1

0.4

Other

2

0.4

1.3

Simulation

2.8

1.3

1.7

Other

15.2

5.2

10.6

Simulation

5.6

0.0

1.0

Other

10.6

0.0

5.9

Tier 1

622Mb/s links

Tier2

Simulation

CERN AF

5. MSI2k - 5 PB/y

2. MSI2k - 2 PB/y

Disk (PB)

CERN T0

Event Filter

Tier1

Tape (PB)

Tier 2

Se i Tier2 devono supportare anche analisi “private”, aggiungere circa 1 TB e 1 kSI2 per utente

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

24

~PB/sec

Event Builder

10 GB/sec

Event Filter

~7.5 MSI2k

320 MB/sec

Tier0

7.5 MSI2k - 5 PB/y

~ 75MB/s

Tier1

~10

~2. MSI2k

622Mb/s links

Tier2

~4/Tier1

~.5 MSI2k

622Mb/s links

Tier3

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

25

Materiale di backup

CSN1 - 31/01/2005

Lamberto Luminari - ATLAS Computing Model

26