Il Computing di ATLAS

Gianpaolo Carlino

CSN1

Roma, 2 Luglio 2008

•

Il Computing Challenge

• I Tier2

• Attività e Risorse per il 2008

Attività di Commissioning del

Computing in ATLAS

CCRC08 – Fase 2 (maggio 2008)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

2

Attività Computing ATLAS

ATLAS ha svolto un’intensa attività di test nel 2008 sia nell’ambito del

CCRC08 (combinato con gli altri esperimenti) che indipendentemente:

FDR e Pre CCRC08-2

Febbraio 2008:

FDR-1: simulazione dell’intera catena di software & computing

CCRC08–1: test della distribuzione dei dati T0 T1 T2

sosprattutto un test delle operazioni al Tier0, di funzionalità del sistema e di

installazione e configurazione di SRM 2.2 e canali FTS

Esercizio molto utile per Atlas, metriche (di carattere qualitativo) rispettate

Marzo-Aprile 2008:

Pre CCRC08-2: test di computing preparatori per il CCRC08-2

ripetizione test di funzionalità e configurazione canali Tier1 Tier1

Maggio 2008

CCRC08-2: test intensivo di DDM, T0 T1 T2 e T1 T1

test di funzionalità e throughput

metriche molto esigenti

4 settimane di test con incremento graduale delle complessità dei test

impossibilità a svolgere test di lunga durata; durante il weekend priorità per

cosmici e commissioning dei rivelatori.

Giugno 2008

FDR-2

test delle procedure di validazione, ricostruzione e analisi distribuita dei dati

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

3

CCRC08 – Fase 2

Durata 4 settimane. Attività durante la settimana (mar-ven.) per consentire la presa dati

con i cosmici e il commissioning dei rivelatori nei fine settimana (attività prioritarie)

Week 1

Functional Test: Trasferimenti Tier0 Tier1s

Studio dell’efficienza del sistema di trasferimento dei dati

Week 2

Tier1-Tier1 Test: Trasferimenti Tier1 Tier1

Studio dell’efficienza del sistema di distribuzione dei dati prodotti nel reprocessing

(Tier1-Tier1 transfer matrix). Sottoscrizioni contemporanee !

18 TB corrispondente a 90 MBps di import rate per ogni Tier1 (superiore al rate nominale)

Week 3

Throughput Test: Trasferimenti Tier0 Tier1 Tier2

Simulazione dell’export dal Tier0 per 24h/day @ 200 Hz (150% del rate nominale)

Week 4

Full Exercise:

Trasferimenti contemporanei Tier0 Tier1 Tier2 e Tier1 Tier1

In aggiunta intensa simulazione ai Tier2 con aggiunta di trasferimenti ai Tier1

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

4

CCRC08 – Fase 2

Le Metriche stabilite con un crescendo di complessità nelle 4 settimane

Functional Tests

Replica completa al 90% dei dataset dal momento della sottoscrizione in

• 48h (week 1)

• 6h (week 4)

Tier1 – Tier1 Test

Per ogni canale (Tier1-Tier1 pair) il 90% dei dataset deve essere

completamente replicato in

• 52 h (week2)

• 6h, mantenendo il rate del reprocessing con il Tier1 gemello per tutta la

durata del test (al CNAF: 10 MBps di ESD e 20 MBps di AOD) (week 4)

Throughput Tests

Ogni sito deve essere in grado di sostenere

• il peak rate per almeno 24 ore e il nominal rate per 3 giorni (week 3)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

5

CCRC08 – Fase2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

L

M

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

G

V

S

D

W

L

E

M

E

K

IV

Functional Test

CNAF

(97% complete)

Test superato da

tutti i Tier1 Atlas e

dal CNAF

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

6

CCRC08 - Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

L

M

M

G

V

S

D

M

M

G

V

S

D

L

M

M

G

V

S

D

L

E

M

K

IV

Tier1 – Tier1

Test

L

W

E

Attività concorrente con CMS sebbene non visualizzata in GridView!!!

I trasferimenti nei canali Tier1-Tier1 non erano ancora monitorati

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

7

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

L

M

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

G

V

S

L

E

M

K

IV

All days

All days (errors)

D

W

E

DAY1

Tier1 – Tier1

Test

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

8

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

L

M

G

V

S

0%

M

M

20%

G

V

S

D

40%

L

M

M

G

60%

V

S

D

E

M

IV

= Not Relevant

L

L

K

FROM

D

W

E

Frazione di dataset completati

M

80%

M

100%

G

V

S

TO

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

9

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

M

M

G

V

S

D

M

M

G

D

L

M

M

G

V

S

Problemi individuati:

Alto carico sui server GridFTP dovuto a una non completa compatibilità

con i sever GPFS (file system usato da Storm): traffico in uscita dai

server doppio di quello in ingresso dovuto alla riscrittura dello stesso dato.

Ciò limita le efficienze e il traffico in ingresso.

D

E

M

IV

Al CNAF: bassa efficienza e throughput nell’import da molti siti !

Efficienza media 45% e throughput medio 40 MBps

V

S

L

K

Il test è stato superato dalla gran parte dei canali dei Tier1

efficienze ~ 99% e picchi di throughput di 500 MBps (bulk of data,

16 TB, trasferito in sole 4 ore) in alcuni siti

L

W

E

Analisi dei Risultati:

L

M

G

V

Problemi parzialmente risolti alla fine della settimana:

Alta efficienza ma ancora basso throughput verificato in test successivi

durante il weekend.

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

10

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

L

Throughput Test

Data transfer complessivo

M

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

E

G

K

V

S

III

W

E

E

K

D

L

M

M

G

V

S

IV

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

11

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

L

M

M

G

PEAK

V

S

D

NOMINAL

L

M

M

G

V

S

D

L

M

M

E

G

K

V

ERRORS

S

III

W

E

E

K

D

L

M

M

G

V

S

IV

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

12

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

L

G

V

L

M

M

G

V

S

L

M

M

S

K

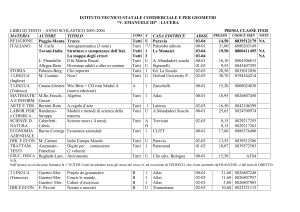

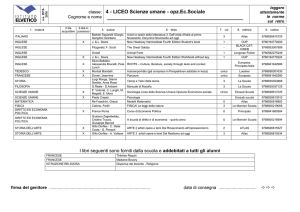

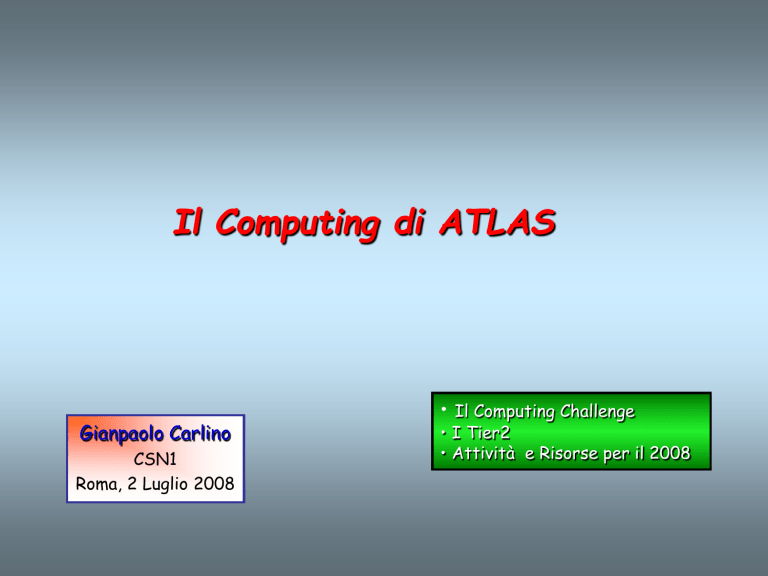

Total

BNL

79.63

218.98

298.61

IN2P3

47.78

79.63

127.41

SARA

47.78

79.63

127.41

RAL

31.85

59.72

91.57

FZK

31.85

59.72

91.57

CNAF

15.93

39.81

55.74

ASGC

15.93

39.81

55.74

PIC

15.93

39.81

55.74

NDGF

15.93

39.81

55.74

TRIUMF

15.93

39.81

55.74

Sum

318.5

696.8

1015.3

D

V

E

DISK

D

G

E

Rates(MB/s) TAPE

S

K

W

D

L

M

M

G

V

S

IV

Throughput

Test

M

E

III

Rate Attesi

M

CNAF share del 5%

corrispondente a 56 MBps

Test parzialmente superato

• Rate nominale raggiunto ma non

superato in caso di backlog

determinato da periodi di

inefficienze alla sorgente o alla

destinazione.

• Non si riusciva ad “accelerare” i

trasferimenti.

Problema causato da un

banalissimo errore di installazione

di un nuovo pool di storage in cui

venivano scritti i dati del test da

parte degli installatori

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

13

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

W

E

E

K

IV

Tier0 Tier1

L

M

M

G

V

S

Test di backlog recovery

Primi dati generati in 12 ore

e sottoscritti in bulk

D

L

M

M

G

V

S

12h di backlog

recuperati in 90 minuti

in tutti i siti!

D

L

M

M

G

Risolti problemi di

throughput per

trasferimenti dal Tier0:

~ 200 MBps per 2h

V

S

D

L

M

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

14

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

W

E

E

K

IV

L

M

M

Expected Rate

G

V

Trasferimenti

complessivi

S

D

Blocco trasferimenti

per 12 h il 27

L

M

M

G

Power-cut il 30

V

S

D

L

M

M

G

V

S

D

L

M

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

15

CCRC08 – Fase 2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

W

E

E

K

IV

L

Tier1 - Tier1 transfer matrix

M

M

G

V

S

YELLOW boxes

Effetto del power-cut

DARK GREEN boxes

Double Registration problem

D

L

M

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

Grande miglioramento rispetto a Week2

G. Carlino: Il Computing di ATLAS

16

CCRC08 – Fase 2

Considerazioni finali sul CCRC

Il sistema di distribuzione dei dati era un item critico di Atlas. Preoccupazione negli

utenti (scarsa fiducia sulla possibilità di reperire i dati con velocità ed efficienza). Il

commissioning di questo sistema ha focalizzato l’attenzione durante il CCRC.

Grande collaboriazione tra il gruppo ADC e le clouds. Delocalizzazione delle attività

Il giudizio finale è positivo: efficienze e throughput molto alti !

È stato effettuto un debugging approfondito delle configurazioni di tutte le parti del

sistema testando, ben oltre gli use cases previsti per il data taking 2008, tutti i tipi di

trasferimenti previsti dal CM

Al CNAF alcuni aspetti del sistema di storage non erano perfettamente compresi e i

testi effettuati in precedenza non erano stati sufficientemente accurati da evidenziarli.

Operations e support: la stretta collaborazione tra esperimento e Tier1 ha permesso di

migliorare le strategie di supporto alle attività. Necessità di automatizzare le procedure di

controllo. Il sistema è ancora poco robusto e richiede attenzione continua.

Vero problema per i prossimi mesi: IL DISCO!!! Il ritardo dell’acquisizione dei pledge

2008 mette l’esperimento in seria difficoltà. Necessità di spostare alcune attività e dati ai

Tier2.

Attività principali dei prossimi mesi: Reprocessing ai Tier1 e uso del tape

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

17

i Tier2

• partecipazione ai test CCRC e FDR-2

• utilizzo delle risorse

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

18

Attività di Computing nei Tier2

Partecipazione dei Tier2 italiani al CCRC e al FDR

Il Computing Model di ATLAS prevede che i Tier2 “interagiscano”

essenzialmente con il Tier1 della propria cloud dei quali sono satelliti.

pro: modello molto agile e poco caotico

contro: il Tier1 è un single point of failure

CCRC08 – Fase 2: test di distribuzione dei dati

i Tier2 hanno partecipato al test replicando i dati trasmessi al CNAF dal

Tier0

studio dell’efficienza dei trasferimenti

studio del timing dei trasferimenti

FDR: test dell’intera catena di computing e in particolare, per i

Tier2, del sistema di analisi distribuita

studio dell’efficienza delle repliche dei dati necessari per l’analisi: AOD

e DPD

studio della possibilità di accesso ai dati da parte degli utenti e

dell’utilizzo dei tool di analisi distribuita

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

19

CCRC08 – Fase 2. I Tier2

W

E

E

K

I

W

E

E

K

II

W

E

E

K

III

W

E

E

K

IV

L

M

Tier0 Tier1 Tier2

Oversubscription a Na e Rm: 100% AOD

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

G

Files

LNF

86

169

100%

2.64

MI

88

180

100%

2.88

NA

395

794

100%

12,02

RM

395

794

100%

12,02

S

D

L

M

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

Thr.

Dataset

V

G. Carlino: Il Computing di ATLAS

Eff

MB/s

20

CCRC08 – Fase 2. I Tier2

E

E

K

I

W

E

E

K

II

W

E

E

K

III

W

E

E

K

IV

M

Throughput: Time structure nei trasferimenti.

I Dataset vengono sottoscritti dopo che la replica completa al Tier1, ogni 4h.

M

MB/s

W

L

G

V

S

D

L

M

M

G

V

S

D

L

I Tier2 acquisiscono i dati molto velocemente: max 1.5h dalla richiesta di

sottoscrizione e max 0.5h per completare un dataset

M

M

G

V

S

D

L

M

M

G

V

S

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

21

CCRC08 – Fase 2. I Tier2

E

E

K

I

W

E

E

K

II

W

E

M

M

G

V

S

D

L

M

M

G

V

S

D

L

M

M

E

G

K

V

S

III

W

E

E

K

Affidabilità del Tier2: Recupero immediato del backlog

• Esempio: interruzione dei trasferimenti a NA per la scadenza del

certificato del DPM.

• Recupero dei dati in 30 min con un throughput di 100 MBps

D

Errori

W

L

L

M

M

G

V

S

IV

D

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

22

Final Dress Rehearsal

Lo scopo è testare l’intero computing system come se si trattasse di dati reali per

trovare in tempo i problemi che si potrebbero verificare durante il data taking

Esercizio completo dell’intera catena, dall’on-line/trigger all’analisi distribuita,

per integrare i test svolti fino ad ora in modo indipendente:

Simulazione di 1 fill di presa dati

4 Run di 1 hr a 1032 e 250 Hz, 350 nb-1, con configurazioni diverse, ripetuti più volte

Dati MC pesati con le corrette sezioni d’urto

Immissione dei dati nel TDAQ e running a partire dagli SFO

5 physics stream: mu, e/gamma, multijets, Bphys, minbias + Express stream e

calibrazioni

Completo utilizzo del Tier-0

merging, scrittura su tape, ricostruzione, calibrazione, validazione etc

i dati vengono ricostruiti e validati sulla ES per verificare la qualità dei dati. Meeting

di sign-off alle 4 pm per autorizzare la replica dei dati

Bulk reconstruction sulle physics stream

vari problemi di merging e ricostruzione,

Esecuzione del Computing Model in maniera completa

distribuzione dei dati e analisi distribuita

Simulazione MC completa in parallelo

running ai Tier-2, trasferimento dati e ricostruzione ai Tier-1

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

23

Final Dress Rehearsal

Distribuzione dei dati:

Dati correttamente

ricostruiti pronti solo il

15-6 e trasferiti ai Tier1

e Tier2

Richiesti 100% AOD e

DPD a NA e RM, 25% a

MI e LNF

Efficienza 100%

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

24

Final Dress Rehearsal

Analisi nei Tier2:

Utilizzo esclusivo dei Tier2 italiani

Test di accesso ai dati e running dei job di analisi con Ganga

contributo fondamentale degli utenti italiani per debuggare Ganga e renderlo

utilizzabile su dpm (primo srm ad essere funzionante con le nuove release)

possibilità di definire i siti o la cloud sui cui runnare

soddisfazione degli utenti per la facilità e la velocità di utilizzo dopo il primo periodo

di training e configurazione.

max 2h tra l’invio dei job, il recupero dell’output e l’analisi locale, nonostante la forte

competizione con la produzione MC

efficienza dei job > 95%

Strategie di analisi:

produzione in grid di DPD di gruppo o utente con i DPDMaker dagli AOD e DPD primari

prodotti centralmente

analisi dei DPD localmente nei Tier2 di riferimento (ARANA)

Gruppi di analisi coinvolti

Susy, Top, Higgs, MS, Minimum Bias, Trigger

Analisi preliminari

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

25

Final Dress Rehearsal

Analisi del trigger nella muon stream:

Trigger

decision

@ EF

minbias

m10

jets

m20

m6 + Bphy

t25i

+

m40

m10

2m(10)(4)(6)

L1

L2

LVL1 selection

barrel + endcaps

EF

totalE

+

EtMiss

offline muon

(Muid)

MU6

MU10

MU11

MU20

MU40

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

muon pT (MeV)

26

Final Dress Rehearsal

Tutte le analisi studiano preliminarmente la ricostruzione di Z

Di-m

invariant mass

Di-electron

invariant mass

Di-electron

invariant mass

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

eventi calibrati

eventi scalibrati

27

Final Dress Rehearsal

Opposite Sign

(OS) e Same Sign (SS) dileptons

J/y

J/y

Y

Mmm(MeV) Z

Mmm(MeV)

Y

Z

Mmm(MeV)

Mmm(MeV)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

28

Final Dress Rehearsal

Analisi Susy nella stream e/gamma

ETMISS

PT 1ST jet

muon pT (MeV)

GeV/c

Lepton-neutrino

transverse mass

CSN1, Roma 2 Luglio 2008

GeV

G. Carlino: Il Computing di ATLAS

29

Final Dress Rehearsal

Molteplicità di particelle cariche nella stream Minimum Bias

Etmiss Etsum

nella stream

e/gamma:

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

30

Stream di calibrazione dei m

100 Mm/day

40 Mm/day

Calibration center

CERN

Stream dal LVL2 (10 kHz). Distribuzione in Italia a Roma, sito ufficiale per la

calibrazione degli MDT, e a Napoli per l’analisi, off-line, degli RPC

Canali FTS dedicati con il Tier0 per diminuire la latenza (non appesantisce la banda passante)

100 M ev/giorno, Event Size = 1 kB, Max bandwidth = 10 MBps

Spazio disco: 3 TB nel 2008 e 10 TB nel 2009

CPU: ~150 kSI2k

Calibrazione entro 24h dalla presa dati

Accesso e scrittura su DB Oracle. Replica del DB al Cern

Risorse necessarie:

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

31

Stream di calibrazione dei m

FDR:

43 M eventi analizzati al giorno

(equivalenti a 6h di presa dati al

giorno)

Durata del test: 3 giorni

Distribuzione dei dati:

Trasferimento rapidissimo

Pochi minuti dalla registrazione in DDM

Lunghi tempi di attesa per le registrazioni dei

file nei cataloghi

Problemi con i cataloghi centrali ora

risolti

Ritardo nelle registrazioni fino a 5h

Soluzioni in fase di implementazione

Processamento dei dati:

Splitting dei dati e produzione di ntuple max

2h dopo il completamento dei dataset

Calibrazione dalle ntuple max 3h

Filling del DB locale e replica al Cern

Replica dei dati:

Replica in linea dei dati al Tier0

I dati arrivati sono stati processati e i risultati

trasmessi al Cern entro il termine di 24h a partire

dalla presa dati.

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

32

Sistema di benchmark

La suite di benchmark di ATLAS

Definizione di un sistema di benchmark per ATLAS basato

sull’esecuzione delle applicazioni del software di esperimento

Misura realistica della CPU utilizzata attraverso l’utilizzo di task reali

Possibilità di utilizzare questo benchmark per la determinazione dei

processori più adatti da acquistare

Basato su una infrastruttura già esistente, potenziata per raccogliere le

informazioni di benchmark e presentarle in modo interattivo agli utenti

Kit Validation

sviluppato per validare le installazioni del software (installazioni Grid e utente)

Invia i risultati dei test (informazioni sulle macchine: CPU type, CPU speed,

Memory size …) a un Web service

Global Kit Validation portal

I risultati dei test sono ottenuti effettuando un parsing dinamico dei

logfile

I tempi di processamento sono ottenuti dai servizi del framework di ATLAS

I test vengono effettuati tramite uno script che installa le release del

software di ATLAS ed è in grado di inviare più test concorrenti (utile

per test su macchine multi-CPU e multi-core)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

33

Sistema di benchmark

Applicazioni eseguite: Generazione, Simulazione, Digitizzazione e Ricostruzione.

Si determina il power factor di vari processori confrontando i tempi di esecuzione

rispetto ad una macchina di riferimento

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

34

i Tier2

• partecipazione ai test CCRC e FDR-2

• utilizzo delle risorse

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

35

Reliability e Availability dei Tier2

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

36

Tier-2 Napoli

Tier2 Napoli - Wall Time

Altre VO

Utilizzo Risorse

ATLAS

160

2008

140

120

Usage (d)

100

80

60 core (fino al 21-3)

60

72 core (fino 3-6)

40

160 core

20

0

1/1

0/ 0

7

1/9

/0 7

1/1

1/ 0

7

1/1

2/ 0

7

1/1

/0 8

1/2

/0 8

1/3

/0 8

1/4

/0 8

1/5

/0 8

1/6

/0 8

Tier2 Napoli - Wall Time

Altre VO

ATLAS

100

90

80

Usage (%)

70

60

50

40

30

20

10

0

1/9

/0 7

CSN1, Roma 2 Luglio 2008

1/1

0/ 0

7

1/1

1/ 0

7

1/1

2/ 0

7

1/1

/0 8

1/2

/0 8

1/3

/0 8

1/4

/0 8

G. Carlino: Il Computing di ATLAS IV – Test e Commissioning

1/5

/0 8

1/6

/0 8

37

Tier-2 Roma I

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS IV – Test e Commissioning

38

I Tier2 Italiani

Considerazioni sui Tier2 italiani

Affidabilità e robustezza

Efficienza del 100% e velocità nel trasferimento dei dati dal CNAF

garanzia di reperibilità dei dati per l’analisi

I momenti di bassa attività sono legati soprattutto al rallentamento delle

attività dell’esperimento o a problemi nei servizi della cloud

l’utilizzo da parte degli utenti italiani per l’analisi distribuita è in

significativa crescita

Qualche difficoltà si è avuta nel passato negli upgrade del middleware. Per il

CCRC:

SRM: passaggio alla v2.2 senza difficoltà

SLC4: nessun problema nell’upgrade dei WN e dei server DPM

SRM:

DPM estremamente affidabile e facile da gestire

STORM, dubbi sul futuro del supporto e la capacità di scalare di DPM

(verificata in atlas almeno fino a 100 TB) consigliano di testarlo anche nei Tier2

Test di STORM al Tier2 di Milano

Tutorial al CNAF il 2 e 3 luglio con gli sviluppatori di STORM e gli esperti

di GPFS

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

39

Risorse nei Tier2 e

Richieste 2008

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

40

Risorse necessarie - dati

LHC data taking

50.000 sec @ 200 Hz 107 eventi/giorno

con 14h di data taking

3·106 sec (6·108 eventi), corrispondenti a 2

mesi di data taking

Stima rivedibile in seguito alla reale durata

della presa dati

Cosmics data taking

presa dati complementare a LHC

(~ 10 settimane)

fino ad ora dati trasferiti al Tier1

su disco e on demand ai Tier2 ma

analisi su Castor soprattutto.

Messa a punto recente di Ganga per

runnare sui RAW data su pressione

italiana Analisi solo sui Tier2 (No

Tier1!!)

LHC - Storage @ Tier2

1.

2.

3.

4.

2 versioni complete di AOD

5 versioni di DPD primari

Frazione di RAW (metà della quota

CNAF del 5%)

Frazione di ESD (metà della quota

CNAF del 10%)

Totale = ~350 TBn

Cosmics - Storage @ Tier2

1.

2.

RAW e ESD (replica per l’analisi

dei dati inviati al CNAF)

No AOD e DPD

Totale = ~80 TBn

3. e 4. per studi di performance dei rivelatori

RAW = 1.6 MB - AOD = 0.2 MB

ESD = 1 MB

- DPD = 0.02 MB

CSN1, Roma 2 Luglio 2008

Stima effettutata in base ai dati raccolti nelle

week M6 e M7 supponendo circa il 10% in italia

G. Carlino: Il Computing di ATLAS

41

Risorse necessarie - Analisi

Uso delle risorse per gli utenti italiani

Bisogna trovare un modo per garantire l’uso delle risorse dei Tier-2 italiani alla

comunità italiana impedendo che le attività centrali di ATLAS o gli utenti non italiani le

usino in maniera predominante

1. Creazione di un gruppo atlas/it a livello di VO

Gennaio 08

2. Job Priority Mechanism:

• definizione di quote dedicate per le varie attività (p.es. produzione 50% e analisi 50%)

e i vari gruppi (atlas e atlas/it)

3. Fair-Share Mechanism per ottimizzare l’uso delle risorse

• bilanciamento temporale dell’uso delle risorse per impedire che rimangano inutilizzate

quando non viene utilizzata completamente la quota dedicata ad una precisa attività o a

un gruppo

Stato attule:

CPU: Il gruppo atlas/it è stato creato e sarà operativo nei prossimi giorni perché si è

attesa un unpgrade del WMS per la pubblicazione del sistema di priorità dei job

nell’information system. È ora possibile inserire il gruppo italiano nel sistema

fornendogli i privilegi nell’uso delle risorse dei Tier2

Disco: Spazio disco dedicato agli utenti italiani (Local Group Disk)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

42

Risorse necessarie - Analisi

Analisi nei Tier2

analisi caotica da parte degli utenti

produzione di DDPn

analisi di gruppo: prevista al Tier1. Utilizzo delle risorse dei Tier2

anche per analisi di gruppo

presenza importante di italiani nei gruppi di fisica

replica completa di AOD e DPD nei Tier2

Stato attuale:

fino al 2007 uso marginale dei Tier2 per l’analisi

distribuita (ampia attività locale)

grande collaborazione della comunità italiana con gli

sviluppatori per aumentare la semplicità di utilizzo,

l’efficienza, l’individuazione dei siti sui cui runnare con

GANGA

risoluzione di problemi tecnici:

accesso allo storage con srm Storm e DPM

accesso ai RAW data e alla stream di calibrazione

FDR: partecipazione di molti gruppi italiani

13 gruppi (Higgs, SUSY, MS, Top, Tau, Etmiss, Trigger)

analisi nei Tier2 e uso di GANGA

Alta efficienza (>95%), velocità di esecuzione e recupero

degli output

CSN1, Roma 2 Luglio 2008

Utenti @ Tier2

1.

2.

3.

gruppi di analisi: 13

Disco per gruppo: ~7 TBn

CPU per gruppo: ~80 kSI2k

Totale = 100 TBn

e 1000 kSI2k

La stima delle risorse necessarie per gli

utenti espresse in termini di numero di

gruppi di analisi piuttosto che di numero

di utenti appare piu’ realistica

G. Carlino: Il Computing di ATLAS

43

Risorse necessarie - MC

June-Sept 08

10 TeV

Sept-Dec 08

10 TeV

Dec-Mar 09

14 TeV

total

Geant4

20M

25M

25M

70M

ATLFAST

70M

70M

70M

210M

total

90M

95M

95M

280M

Il piano di produzione MC si basa sulla disponibilità delle risorse. Non tutte le nazioni

hanno soddisfatto i pledges ai Tier1 e Tier2. Spostare la produzione quasi totalmente ai

Tier2 per dedicare le risorse del CNAF soprattutto al reprocessing

Simulazione @ Tier2

Simulation time

kSI2k·s

Minimum Bias

300

1.

QCD

700

3.

W/Z, WH, Top

600

SuSy

1100

Higgs

700

B-physics

600

CSN1, Roma 2 Luglio 2008

2.

2 versioni di AOD

5 versioni di DPD

Tier2 buffer per il MC

per 2 settimane

Storage = ~ 150 TBn

CPU = ~ 500 kSI2k

G. Carlino: Il Computing di ATLAS

HITS = 4 MB

RDO = 2 MB

ESD = 1 MB

AOD = 0.2 MB

44

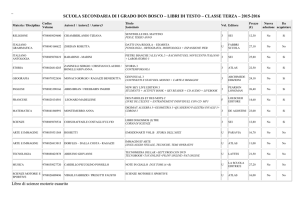

Risorse necessarie - riepilogo

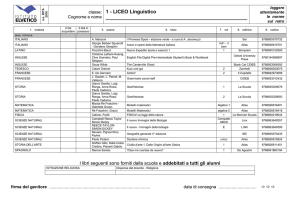

Attività

CSN1, Roma 2 Luglio 2008

CPU

Disco

(kSI2k)

(TBn)

LHC data taking

350

Cosmics data taking

80

Simulazione

500

150

Utenti

1000

100

Totale

1500

680

G. Carlino: Il Computing di ATLAS

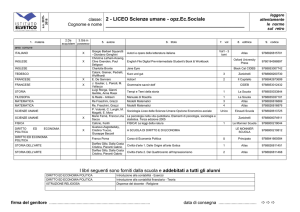

45

Risorse disponibili nei Tier2

CPU (kSI2k)

Disco (TBr)

Sep 07

Gen 08

Giu 08

Sep 07

Gen 08

Giu 08

LNF

41

101

169

16

48

63

Milano

128

214

343

34

84

140

Napoli

112

210

330

40

40

152

Roma

156

383

383

30

66

133

Tot

437

908

1225

120

238

488

100 (TBn)

198 (TBn)

407 (TBn)

Sep 07 indica le risorse disponibili nella prima parte del 2007, Gen 08 indica le

risorse acquisite nella seconda parte del 2007 con lo sblocco del sub judice 2007,

Giu 08 indica le risorse acquisite o in fase di acquisizione con lo sblocco del primo

sub judice 2008

1 CInt06_Rate = 0,2 kSI2k - 1 kSI2k = 5 CInt06_Rate

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

46

Richieste 2008

Costi

CPU: 0.16 K€/kSI2k

Disco: 1.1 K€/TBn

(kSI2k)

Nuove necessità 2008

1500

Risorse a Giugno 2008

1225

hp1

Richieste

300

50

hp2

Richieste

300

50

CPU

Disco

K€

Totale

TBn

K€

K€

470

520

570

300

330

380

680

200 (occupato)

210 (disponibile)

Gli ultimi acquisti di storage sono in fase di installazione, vanno quindi considerati

totalmente disponibili per le nuove attività e sottratti alle richieste

hp1 : richiesta della totalità dello storage necessario = 470 TBn

Si eccede il budget potenzialmente disponibile per Atlas (metà della tasca indivisa)

L’esperimento richiede che una parte delle risorse disponibili per il computing venga

destinata per l’acquisto di spare PS degli MDT

hp2: richiesta di una frazione dello storage necessario = 300 TBn

Liberazione di gran parte dello spazio disco attualmente disponibile cancellando

gradualmente i dati attuali e conservando solo cosmici e dati FDR utili per l’analisi

La quota di 300 TBn corrisponde precisamente all’acquisto nei Tier2 di Mi, Na e RM1 di un

sistema di storage di 110 TBr e 4 disk server, simile a quello appena acquistato

Margine per la richiesta di 100 k€ per gli spare PS degli MDT

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

47

Backup slides

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

48

Attività Computing ATLAS

~PB/s

Event Builder

10 GB/s

Event Filter

320 MB/s

Tier0

L’attività “sul campo” ha permesse di definire meglio molti

aspetti del Computing Model

Attività nei Tier

Tier0: Prompt Reconstruction

Tier1: Reprocessing e Group Analysis

parte significativa della Group Analysis puà essere spostata

nei Tier2 in caso di necessità

Tier2: Simulazione, Group e User Analysis

Tier1

Tier2

Definizione dei sistemi di storage

Pool di Storage per le specifiche attività

lo spazio da assegnare ad ogni pool dovrà essere definito con

precisione durante il periodo di data taking

Flussi di dati

Tier3

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

49

All other T1’s

TAPE

Pile-up

digitization

reconstruction

H

I

TMC

DPD1

AOD

DPD1

making

DPD2

MC

DISK

DPD1

TAPE

HITS

ESD

AOD

CPUs

CPUs

CPUs

CPUs

AOD

GROUP

DISK

AOD

HITS

RDO

ESD

AOD

DPD1

AOD

HITS

HITS from

G4

@Tier-1

DPD

AOD from

ATLFAST

@Tier-2

AOD

HITS from

G4

MC

Buffer

HITS from

G4

DPD1

DPD2

EVNT

PROD

DISK

EVNT

AOD

AOD from

ATLFAST

MC

DISK

GROUP

DISK

AOD

DPD

AOD from

ATLFAST

CPUs

CPUs

CPUs

CPUs

LOCAL

GROUPDISK

G4 / ATLFAST

Simulation

CSN1, Roma 2 Luglio 2008

DPD

User files

(IT)

USERDISK

DPD

User analysis

User files

(Atlas)

G. Carlino: Il Computing di ATLAS

CPUs

CPUs

CPUs

CPUs

50

TAPE

STAGED

ISK

RAW

re-processing

H

I

T

DATATA

All other T1’s

AOD

RAW

ESD

DPD

DPD

RAW

PE

RAW

AOD

DPD making

AOD

CPUs

CPUs

CPUs

CPUs

DATADISK

GROUP

DISK

AOD

ESD

AOD

RAW

RAW

ESD

AOD

DPD

AOD

@Tier-1

RAW

ESD

DPD

RAW

AOD

t0atlas

@Tier-0

ESD

DATADI

SK

RAW

RAW

On request

AOD

LOCAL

GROUPDISK

DPD

User files

(IT)

CSN1, Roma 2 Luglio 2008

@Tier-2

USERDISK

DPD

User files

(Atlas)

User

analysis

CPUs

CPUs

CPUs

CPUs

G. Carlino: Il Computing di ATLAS

GROUP

DISK

Group analysis

DPD

51

CCRC08 – Fase 2

Fake data generati al Tier0 con il Load

Generator e trasmessi ai Tier1 e Tier2 in

base

• al tipo di esercizio da svolgere

• lo share della cloud

• il MoU

File da 300 MB e 3 GB in

accordo con le dimensioni

dei file reali

T0

T1

T1

15% ESD, 15% AOD

10% ESD, 10% AOD

Dati cancellati solo alla

fine dell CCRC

T2

CSN1, Roma 2 Luglio 2008

T2

G. Carlino: Il Computing di ATLAS

T2

T2

52

Il Tier-2 di Milano

La

Sala Macchine e gli spazi per il Tier-2

8 Rack per ATLAS, 5 parzialmente occupati

4 rack (2 per ogni sala) connessi con fibra a 10 Gbps

Spazio e risorse per altri rack eventualmente necessari

LOCALE

NON

DISPONIBILE

ZONA DI

PERTINENZA

TIER 2

CSN1, Roma 2 Luglio 2008

LOCALE

UPS E

QUADRO

PARALLELO

CENTRALE

TERMICA

ZONA DI

PERTINENZA

TIER 2

LOCALE

IN FASE

DI ALL.

ZONA DI

PERTINENZA

TIER 2

G. Carlino: Il Computing di ATLAS

53

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

07/06/2008

24/05/2008

10/05/2008

26/04/2008

12/04/2008

29/03/2008

15/03/2008

01/03/2008

16/02/2008

02/02/2008

2008

19/01/2008

Utilizzo Risorse

05/01/2008

22/12/2007

08/12/2007

24/11/2007

10/11/2007

27/10/2007

13/10/2007

29/09/2007

15/09/2007

01/09/2007

Usage (%)

Tier-2 Milano

Tier2 Milano Wall Time

Altre VO

Atlas

100

90

80

70

60

50

40

30

20

10

0

54

Tier-2 Milano

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

55

Il Tier-2 di Napoli

La strategia è di

suddividere il Tier2 nelle

due sale con connessioni

dirette a 10 Gbps

Sala ATLAS INFN

Superficie 44 m2

4 Rack installati attualmente:

Connessione tra i rack a 10 Gbps con

switch in cascata

Espansione fino a 10 Rack

Impianti dimensionati per tale capacità

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

56

Il Tier-2 di Napoli

Sala PON SCoPE

Superficie 120 m2

Capacità 120 Rack. 10 Tier-2 a disposizione del Tier-2

Il Tier-2 di ATLAS verrà ospitato in questa struttura usufruendo di

tutte le facilities di monitoraggio e intervento previste dal progetto

In fase di installazione una connessione di rete costituita da 6 coppie

di fibre monomodali a 10 Gbps tra la sala SCoPE e il Tier2

Stato di avanzamento dei

lavori (Giugno 2008)

Disponibilità autunno 2008

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

57

Tier-2 Napoli

CPU - WALL Time Ratio

ATLAS

Utilizzo Risorse

100

90

80

2008

70

(%)

60

50

40

Miglioramento del

30

20

rapporto CPU/Wall Time

10

08

01

/0

6/

20

08

01

/0

5/

20

08

01

/0

4/

20

08

01

/0

3/

20

08

01

/0

2/

20

08

01

/0

1/

20

07

01

/1

2/

20

07

01

/1

1/

20

07

01

/1

0/

20

01

/0

9/

20

07

0

Tier2 Napoli - CPU Time

Altre VO

ATLAS

100

90

80

Usage

70

60

50

40

30

20

10

0

1/9

/0 7

1/1

0/ 0

7

CSN1, Roma 2 Luglio 2008

1/1

1/ 0

7

1/1

2/ 0

7

1/1

/0 8

1/2

/0 8

1/3

/0 8

G. Carlino: Il Computing di ATLAS

1/4

/0 8

1/5

/0 8

1/6

/0 8

58

Tier-2 Napoli

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

59

Tier-2 Roma I

Utilizzo Risorse

2008

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

60

Il proto Tier-2 di Frascati

La sala che ospita attualmente il proto-Tier2 è situata al pian terreno di un edificio

a due piani che ospita il servizio di calcolo dei LNF, una libreria a nastro

dell’esperimento Kloe, il sistema informativo dell’INFN ed il POP GARR dell’area di

Frascati

Superficie 97 m2.

Il Tier-2 occupa attualmente due rack e può essere espanso con altri tre rack

Può ospitare tranquillamente tutte le risorse previste per il 2008

Altri

experim

Sistema

Informativ

o

CALCOLO

Tier 2

Nastri

utenti

CSN1, Roma 2 Luglio 2008

Kloe

Garr

G. Carlino: Il Computing di ATLAS

61

Proto Tier-2 Frascati

Wall time

Utilizzo Risorse

Usage (%)

2008

CPU Time

120.00

100.00

80.00

Usage (%)

60.00

CSN1, Roma 2 Luglio 2008

40.00

Atlas

20.00

Altre VO

0.00

G. Carlino: Il Computing di ATLAS

62

Proto Tier-2 Frascati

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

63

Attività di Computing in Italia

• Nuovo sistema di produzione

• Benchmarking CPU

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

64

Produzione in Italia

Modifica del sistema di produzione nella cloud Italiana

Sottomissione con i Pilot Job

Utilizzo di PANDA, il tool usato per la produzione in OSG

ultima cloud a “resistere” alla migrazione

Pilot job:

sottomessione alla Grid di piccoli job (pilot job), praticamente equivalenti a

quelli da runnare

invio attraverso un server centrale (Panda server) dei job reali ai pilot

Sistema utilizzato solo per la produzione e non per l’analisi

Vantaggi:

controllo maggiore sull’ordine di esecuzione dei job

job con priorità maggiore vengono processati prima anche se arrivati dopo

maggiore efficienza: non vengono inviati job verso nodi mal configurati. Solo il

pilot job muore

1.

2.

Installazione di un Panda Server al Cern

Attivazione di una pilot factory al CNAF che rimpiazza lo scheduler dei pilot con un

sistema più modulare interfacciato ai tool di LCG come WMS per la sottomissione

dei job (sviluppata soprattutto in Italia) e la Dashboard

Sistema operativo da aprile per la produzione MC e il reprocessing al CNAF

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

65

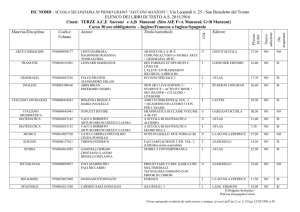

Produzione in Italia

Produzione in LCG

4,20%

4,20%

CNAF

LYON

RAL

FZK

TRIUMF

PIC

ASGC

SARA

NDGF

Dettaglio Produzione nelle tre griglie

grid

Success

failure

efficiency

LCG

3062205

1182560

72.1%

OSG

1559546

358364

81.3%

None

164476

254263

39.3%

Nordugrid

427524

45134

90.5%

total

5213751

1840321

73.9%

Quota produzione LCG ~ 65%

Produzione in Italia

BARI

CNAF

FRASCATI

LEGNARO

MILANO

NAPOLI

ROMA

17,97%

12,22%

48,91%

10,76%

4,64%

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

5,44%

66

Produzione in Italia

number of jobs

walltime

CSN1, Roma 2 Luglio 2008

grid

success

failure

efficiency

LCG

3062205

1182560

72.1%

OSG

1559546

358364

81.3%

None

164476

254263

39.3%

Nordugrid

427524

45134

90.5%

total

5213751

1840321

73.9%

G. Carlino: Il Computing di ATLAS

67

Sistema di benchmark

Test della memoria

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

68

Sistema di benchmark

Scaling tests (Intel 2 x dual-core)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

Tutti i task, eccetto per la

simulazione , peggiorano quando

si incrementa il numero di task

concorrenti nella stessa

macchina

Peggior valore a full load

-10.9% in ricostruzione

69

Sistema di benchmark

Scaling tests (AMD 2 x dual-core)

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

Tutti i task, eccetto per la

simulazione , peggiorano quando

si incrementa il numero di task

concorrenti nella stessa

macchina

Peggior valore a full load

-3.5% in ricostruzione

70

Acquisti - Mercato Elettronico

Esperienze con il MEPA

Atlas ha effettuato nel 2008 acquisti in comune tra 3 Tier2 con il Mercato Elettronico

Storage: gara con fatturazione separata

Switch: gara con fatturazione unica a Na e consegna nelle varie sedi

Problemi con il grey market. Sarebbe utile chiarire le procedure nell’INFN

Esperienza:

Difficoltà iniziale a comprendere le nuove regole del MEPA anche a causa di

conoscenze ancora non diffuse nell’ente

Difficoltà a definire contemporaneamente la precisa quantità di materiale da

acquistare e il relativo prezzo massimo

Richiede un’indagine di mercato molto accurata

Rischio che le gare vadano deserte

Ritardi dovuti all’arbitrarietà con cui la Consip annulla gare in corso

Gara switch annullata per inserire nuovo categoria di metaprodotto

Facilità a definire metaprodotti anche complicati

Velocizzazione delle procedure

Aumento dei fornitori iscritti

Grande aiuto e disponibiltà da parte dell’amministrazione di Napoli

CSN1, Roma 2 Luglio 2008

G. Carlino: Il Computing di ATLAS

71