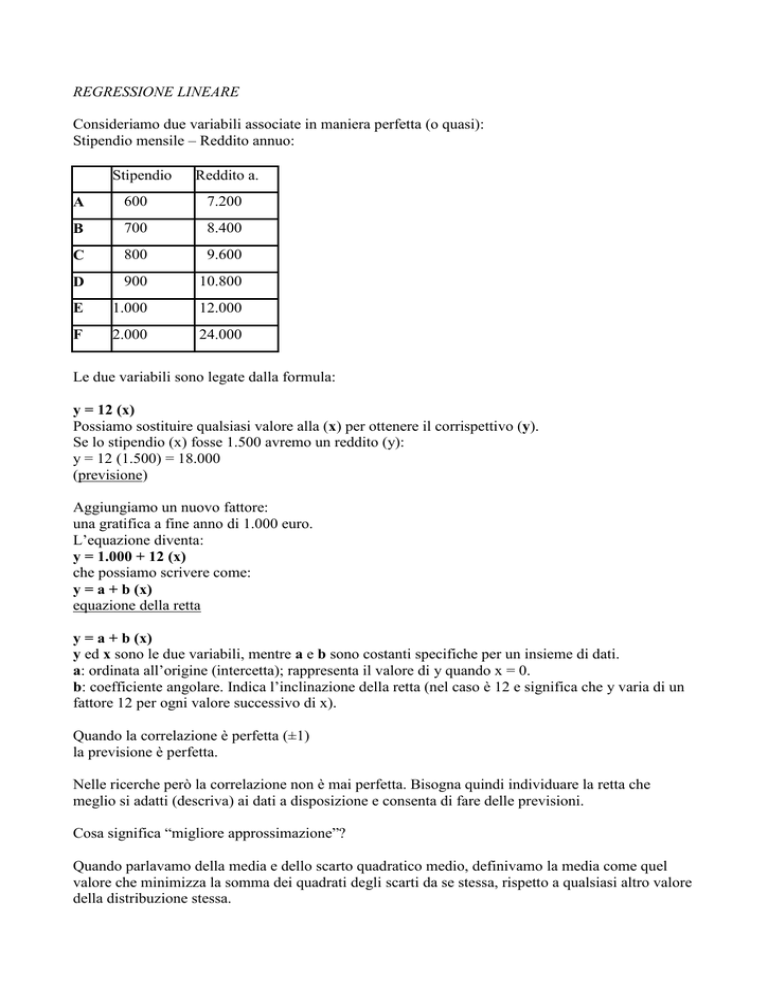

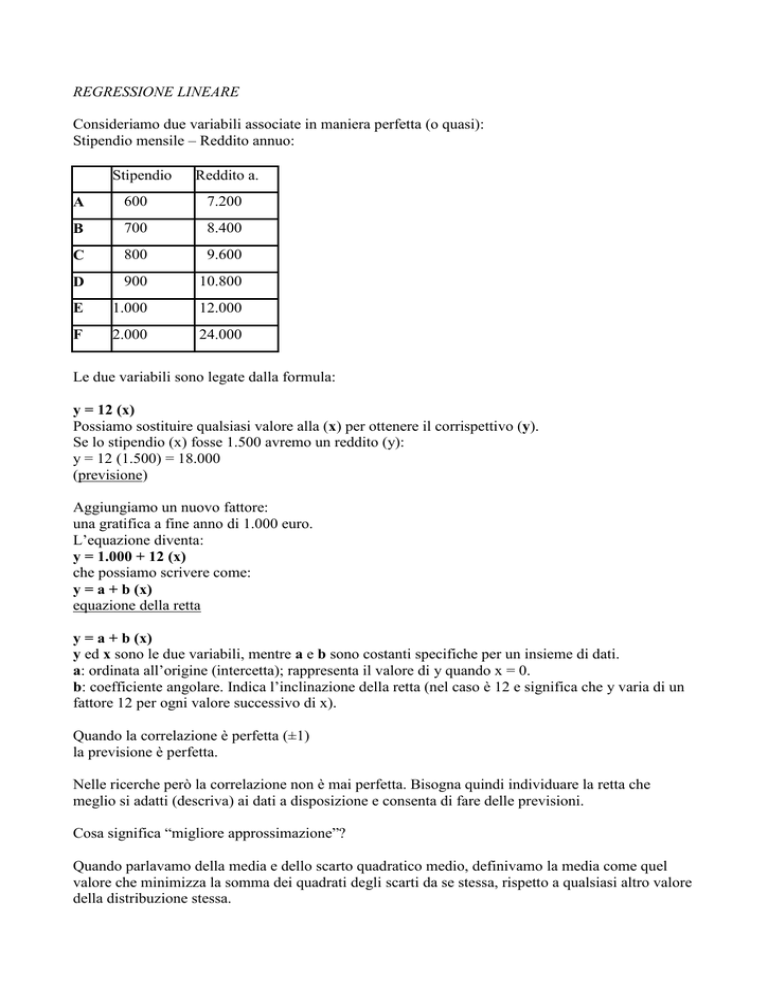

REGRESSIONE LINEARE

Consideriamo due variabili associate in maniera perfetta (o quasi):

Stipendio mensile – Reddito annuo:

Stipendio

Reddito a.

A

600

7.200

B

700

8.400

C

800

9.600

D

900

10.800

E

1.000

12.000

F

2.000

24.000

Le due variabili sono legate dalla formula:

y = 12 (x)

Possiamo sostituire qualsiasi valore alla (x) per ottenere il corrispettivo (y).

Se lo stipendio (x) fosse 1.500 avremo un reddito (y):

y = 12 (1.500) = 18.000

(previsione)

Aggiungiamo un nuovo fattore:

una gratifica a fine anno di 1.000 euro.

L’equazione diventa:

y = 1.000 + 12 (x)

che possiamo scrivere come:

y = a + b (x)

equazione della retta

y = a + b (x)

y ed x sono le due variabili, mentre a e b sono costanti specifiche per un insieme di dati.

a: ordinata all’origine (intercetta); rappresenta il valore di y quando x = 0.

b: coefficiente angolare. Indica l’inclinazione della retta (nel caso è 12 e significa che y varia di un

fattore 12 per ogni valore successivo di x).

Quando la correlazione è perfetta (±1)

la previsione è perfetta.

Nelle ricerche però la correlazione non è mai perfetta. Bisogna quindi individuare la retta che

meglio si adatti (descriva) ai dati a disposizione e consenta di fare delle previsioni.

Cosa significa “migliore approssimazione”?

Quando parlavamo della media e dello scarto quadratico medio, definivamo la media come quel

valore che minimizza la somma dei quadrati degli scarti da se stessa, rispetto a qualsiasi altro valore

della distribuzione stessa.

Quando applichiamo il metodo dei minimi quadrati alla correlazione ed alla regressione, si definisce

come migliore linea di regressione

la retta che rende minima la somma dei quadrati degli scostamenti dei dati dalla retta stessa.

Le due rette si incrociano nei punti medi di x e di y (baricentro della nube).

Concettualmente si può osservare la relazione tra le rette e la grandezza di r, pensando le due rette

rotanti intorno al baricentro.

Quando r ± 1 le rette avranno la stessa inclinazione e saranno perfettamente sovrapposte e i

punteggi si distribuiranno sull’unica retta risultante.

Man mano che diminuisce r le rette ruotano verso gli assi allontanandosi tra di loro fino ad arrivare

ad r = 0 dove saranno perpendicolari.

A questo punto la migliore previsione per x ed y saranno i rispettivi valori medi.

Se r = ± 1

tutti i punteggi cadono sulla retta, quindi possiamo spiegare tutta la variazione di y in termini di

variazione di x.

Nel caso di correlazione perfetta non esiste variabilità non spiegata.

Non ci sono errori nella previsione.

Se invece

r=0

gli errori sono massimi.

Quindi se:

r=0

var. Spiegata = var Non Spiegata

r=±1

var. totale = var. Spiegata

Quindi tutta la variabilità è spiegata se

r=±1

Coefficiente di Determinazione

È dato dal rapporto tra la variabilità spiegata e la variabilità totale:

Indica la porzione di variabilità totale che risulta “spiegata” in funzione di r.

Se r = 0, r2 = 0; se r = 0,5, r2 = 0,25 quindi il 25% della variabilità totale risulta spiegata

dall’associazione tra le variabili.

In una relazione causale esprime la proporzione di varianza della V.D. che viene “spiegata” dalla

V.I.

Rappresentando r2 la porzione di variabilità spiegata (1 – r2) rappresenterà la porzione di variabilità

non spiegata dalla correlazione di x ed y e si indica come:

coefficiente di non determinazione (k2)

E rappresenta quella parte di variabilità di y spiegabile dalla variabilità di altre variabili diverse da x

k2 + r2 = 1 quindi k2 = 1 – r2

CAMPIONAMENTO

una distribuzione campionaria rappresenta la distribuzione probabilistica (astratta) di tutti i

valori di una statistica campionaria, che possiamo ricavare studiando l'insieme dei possibili

campioni di numerosità n estraibili da una popolazione.

Il numero totale di campioni di numerosità n, estraibili da una popolazione di ampiezza N, è dato

dalla elevazione di N alla n (campionamento Con Reimmissione):

Universo Campionario = Nn

In un campionamento Senza Reimmissione avremo:

Universo Campionario = N!/ n!(N-n)!

per sapere quanti saranno tutti i possibili campioni senza considerare però gli avvenimenti inversi

Regolarità che legano la distribuzione campionaria alla popolazione:

A) la media delle medie campionarie è sempre uguale alla media di popolazione (vale sia per un

campionamento con reimmissione che per uno senza).

B) la varianza dell'universo campionario delle medie è uguale alla varianza della popolazione diviso

n ( campionamento con reimmissione).

STIMA DEI PARAMETRI

Uno dei problemi fondamentali della inferenza statistica è quello della stima dei parametri di una

popolazione, partendo dalle statistiche calcolate sui campioni.

Possiamo avere due tipi di stima:

stima puntuale; stima per intervallo

Stima puntuale

E' quel tipo di stima costituita da un solo valore. Una stima puntuale viene definita corretta quando

la media di tutte le stime corrisponde al parametro da stimare (come esempio basti pensare alla

media del campione).

Viene definita distorta la stima che non risponde alla relazione succitata (es. la varianza del

campione).

Tra due stime puntuali, ugualmente corrette, viene considerata più efficiente quella calcolata su una

distribuzione con variabilità minore.

Stima per Intervallo

E' quel tipo di stima che ci permette di stabilire un intervallo di valori entro il quale pensiamo cada

con una certa probabilità il parametro.

Si ottiene calcolando nelle due direzioni dalla stima puntuale (es. dalla media del campione) un

certo numero di volte l'ammontare dell'errore standard (a seconda del livello di significatività

scelto).

Prende nome di Intervallo di Fiducia (o di Confidenza).

VERIFICA DELLE IPOTESI

H0 : ipotesi nulla, specifica i valori teorici di un parametro della popolazione.

H1 : ipotesi alternativa, stabilisce per il parametro indicato in Ho valori diversi da quello

ipotizzato.

H1 stabilisce la direzionalità o meno di un test:

H1 : P # Q (ipotesi non direzionale);

H1 : P > Q (ipotesi monodirezionale destra);

H1 : P < Q (ipotesi monodirezionale sinistra).

Errore di prima specie :

consiste nel rifiuto di H0 quando questa è vera. Viene indicato con alfa ().

Errore di seconda specie :

consiste nell'accettare H0 quando questa è falsa. Viene indicato con beta ().

TEST DELLA MEDIA

test statistico che utilizziamo per verificare l'ipotesi che un campione con una determinata media e

numerosità derivi da una popolazione con media µ.

Per risolvere il problema occorre standardizzare la media del campione considerato e posizionarla

in una distribuzione teorica di riferimento (in base ad H0), una volta stabilito un valore critico.

Se si conosce la varianza della popolazione è possibile risolvere mediante la trasformazione in

punteggi z, altrimenti mediante la trasformazione in punteggi t.

TEST DI DIFFERENZA TRA MEDIE

Test statistico atto a determinare la significatività della differenza tra due medie (caso di due

campioni a confronto).

In base all’ipotesi nulla si stabilisce che tra le popolazioni da cui sono stati estratti i due campioni

non vi sono differenze statisticamente significative. Le differenze riscontrate nei due campioni

esaminati sono dovute SOLO al caso.

campioni indipendenti

Nella situazione di due campioni indipendenti bisogna stabilire se i due campioni sono stati estratti

da due popolazioni con varianza uguale o diversa.

Per sapere se i due campioni sono stati estratti da popolazioni aventi varianza uguale o diversa,

dovremo applicare prima del test di differenza tra medie il test di

Omogeneità delle varianze (omoschedasticità)

che consiste nel rapporto delle stime delle varianze delle popolazioni, calcolate sulle varianze dei

campioni.

La distribuzione di riferimento sarà la distribuzione della F di Fisher.

TEST BINOMIALE

test che utilizziamo per stabilire se le proporzioni osservate in un campione possano appartenere ad

una popolazione avente un valore specifico di P (sotto H0).

a) per piccoli campioni:

si risolve calcolando la probabilità del risultato ottenuto o dei risultati più estremi (regola della

somma) mediante l'applicazione della espressione generica della distribuzione binomiale:

b) per campioni con numerosità elevata :

possiamo approssimarci alla distribuzione normale mediante la trasformazione:

z = nP/(nPQ)0,5

TEST DI McNEMAR

test utilizzato per lo studio dei cambiamenti osservati su un gruppo di soggetti a seguito della

somministrazione di un trattamento.

La misurazione è su scala nominale o ordinale a due alternative.

I risultati Prima-Dopo l'intervento vengono riportati su una tabella 2x2

Dopo

+

____________________

+

a

c

a+c

Prima

b

d

b+d

____________________

a+b

c+d

n

nelle caselle b e c vengono riportati i casi che hanno "cambiato" le risposte da - a + e da + a -.

Il totale dei soggetti che hanno cambiato le risposte è quindi (b+c). L'ipotesi nulla prevede che

indifferentemente 1/2(b+c) cambi in una direzione, mentre l'altro 1/2(b+c) cambi nell'altra.

Per risolvere il test possiamo riferirci alla distribuzione del X² con gl = 1; o alla binomiale

(preferibile nel caso 1/2(b+c) < 5).

c b 1

2

2

cb

Per il calcolo con la binomiale avremo:

n = c+b;

na = frequenza più bassa tra c e b.

TEST Q DI COCHRAN:

Può essere considerato una estensione del test di McNemar e rappresenta un metodo per stabilire se

tre o più serie di frequenze o proporzioni appaiate differiscono significativamente tra loro.

L’appaiamento può basarsi sulle caratteristiche rilevanti dei differenti soggetti, o sul fatto che gli

stessi soggetti sono utilizzati per differenti trattamenti. Il test di Cochran è indicato quando i dati

sono rappresentati da misure nominali o da misure ordinali dicotomizzate.

2

k

k

2

k 1k G j G j

j 1

j 1

Q

n

n

i 1

i 1

k Li L2i

La statistica Q, per una ipotesi nulla di distribuzione delle frequenze delle risposte uguale in ogni

colonna della tabella, si distribuisce approssimativamente come il chi quadro, con gl = k - 1. Il

valore critico andrà cercato quindi sulla tavola del χ ²

TEST DEL X²

serve per verificare la significatività della differenza tra le frequenze osservate

nel (nei) campione(i).

Può essere utilizzato su una sola variabile (test di bontà di adattamento)

o su più mutabili

(test di indifferenza o indipendenza).

a) test del X² come "bontà di adattamento:

1) calcolo delle fe:

le fe vengono determinate mediante il rapporto n/k; quindi il totale delle osservazioni

diviso il numero dei gruppi: fe = n/k

2) valore critico:

si trova sulle tavole del X² in base al livello di significatività () e ai gl = k - 1.

3) decisione:

se il valore sperimentale è uguale o maggiore del valore critico possiamo rifiutare Ho.

b) test del X² su due gruppi indipendenti

(Test di indifferenza o indipendenza):

1) calcolo delle fe:

per ottenere le fe per la tabella di indifferenza bisogna moltiplicare i totali marginali

corrispondenti alla casella della quale bisogna calcolare fe e dividere il valore ottenuto per il Totale

generale.

2) valore critico:

il X²c viene letto sulle tavole in base ai

gl = (righe-1) x (colonne-1)

ed al livello di significatività scelto.

N.B. per tabelle 2x2 apportare alla formula la correzione di - 0,5.

Analisi della varianza bivalente per ranghi di Friedman

Quando le osservazioni di k campioni appaiati sono misurate almeno su scala ordinale, il test di

Friedman può risultare utile per analizzare l’ipotesi nulla che i k campioni provengano dalla stessa

popolazione. Poiché i k campioni sono appaiati, il numero dei casi è lo stesso in ogni campione.

Con il test di Friedman i dati vengono posti in una tabella a doppia entrata formata da N righe e k

colonne.

Le righe rappresentano i vari soggetti (o le varie serie appaiate di soggetti) mentre le colonne

rappresentano i vari trattamenti.

I dati del test sono rappresentati da ranghi. I punteggi di ogni riga sono convertiti in ranghi

separatamente. Essendo applicati k trattamenti, i ranghi di ogni riga andranno da 1 a k.

Il test di Friedman stabilisce se è vero che le differenti colonne di ranghi (campioni) appartengano

alla stessa popolazione.

Lo stimatore del test viene indicato da Friedman χ²r e si distribuisce approssimativamente come il

chi quadro, con gl = k - 1.

L'ipotesi nulla afferma che i totali dei ranghi per colonna dovrebbero essere all'incirca uguali

(quindi i valori ottenuti dai soggetti sarebbero indipendenti dalla situazione).

Formula per il calcolo:

r2

k

12

R j 2 3nk 1

nk k 1 j 1

dove:

n = numero delle righe;

k = numero delle colonne;

Rj = somma dei ranghi della j-esima colonna.