DALL’ANALOGICO AL DIGITALE.

CAUSE, NATURA E CONSEGUENZE DEL CAMBIAMENTO NELL’ERA DI INTERNET

La relazione è divisa in due parti. La prima riguarda la filosofia digitale, mentre la seconda esplora il

cosiddetto mondo post-umano.

Prima parte.

La filosofia digitale: l’informazione principio primo?

di

Giuseppe O. Longo

"Pubblicato sulla rivista Prometeo, 34, n. 134, giugno 2016, Mondadori, Milano, pagg 6-13"

1. La ricerca del principio primo

Uno dei primi problemi affrontati dalla filosofia occidentale fu la ricerca di un elemento unificante, di un

principio primo che costituisse l’origine e il fondamento dei fenomeni variegati e delle sostanze e forme

diverse che si presentano in natura. Talete (VII-VI sec. a. C.) indicò il principio primo, o arché, nell’acqua,

forse per la sua presenza ubiquitaria in natura e per la capacità di assumere tre stati diversi. Altri filosofi

greci identificarono l’arché in altre sostanze, dall’aria al fuoco. Si distinse tra questi pensatori Pitagora, che

indicò l’arché in un principio astratto, il numero: ciò costituì una novità importante, non essendo il numero

né materiale né spirituale, bensì presentandosi come una immaterialità logica e concettuale, capace

tuttavia di sostanziare il cosmo. Se a ‘numero’ si sostituisce ‘informazione’ si passa agevolmente, come

vedremo, dalla filosofia pitagorica alla filosofia digitale.

Molti secoli dopo, Galileo (1564-1642) affermò che l’Universo non si può intendere se non se ne intende la

lingua, che è la matematica: e pensava a triangoli, cerchi e simili. Anche in questo caso c’è il tentativo di

individuare, sotto la congerie eterogenea delle sostanze e dei fenomeni che ci circondano, un principio

unificante. La ricerca dell’arché continua anche oggi: i fisici si sforzano di dare un quadro unitario della

realtà sia cercando la grande unificazione delle quattro forze fondamentali sia cercando di costruire le

teorie del tutto. È forse un’esigenza di carattere psicologico che si perpetua nei secoli e obbedisce al nostro

bisogno di esorcizzare la complessità del reale riducendola a una congetturale semplicità soggiacente: si

tratta di una congettura di carattere non fisico, bensì metafisico.

E a questo proposito conviene nominare il grande filosofo e insigne matematico cui più di ogni altro si

richiamano i sostenitori della filosofia digitale, Gottfried Wilhelm von Leibniz (1646-1716), il quale, tra

l’altro, formulò la proposta di una mathesis universalis, inventò l’aritmetica binaria e formulò il concetto di

‘migliore dei mondi possibili’: quello che è a un tempo il più scarso di ipotesi e il più ricco di fenomeni. È

interessante notare che questa duplice caratteristica si riscontra nelle teorie matematiche (pochi assiomi e

molti teoremi), in biologia (un genoma che è più o meno lo stesso per tutti i diversissimi fenotipi), nel

dominio dei frattali (poche regole semplicissime per una profusione straordinaria di forme). In particolare

ciò vale per gli automi cellulari, algoritmi che sono alla base della filosofia digitale: pur essendo generati da

regole semplicissime, essi manifestano una varietà stupefacente di esiti evolutivi e sono per esempio capaci

di imitare, sia pure alla lontana, il comportamento di certi organismi viventi.

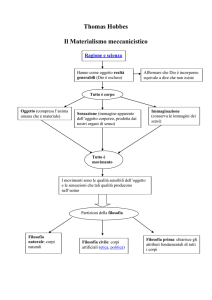

2. Il computer macchina filosofica

L’invenzione del calcolatore elettronico ha inaugurato un’era nuova sotto molti profili. Questa macchina

straordinaria ha molti impieghi e molte virtù: esegue calcoli, gestisce impianti e banche di dati, simula

processi, è protagonista delle ricerche di intelligenza artificiale, ha consentito di inaugurare teorie

matematiche nuove, è l’elemento base di internet e di tutto ciò che da internet è scaturito. In più è una

macchina filosofica, essendo l’ispiratore della filosofia digitale. Senza il computer non si sarebbe mai

manifestata la potenza della computazione, non sarebbe mai stato esplorato il dominio degli automi

cellulari, non sarebbe mai affiorata l’idea che la realtà sia, al suo fondo, un tessuto o struttura di

informazioni. Esso dunque ha contribuito in modo essenziale al passaggio da una visione materialisticaenergetica a una visione informazionale della realtà. In questo senso il computer ha segnato il ritorno ad

una filosofia in senso forte, cioè a una metafisica e a un’ontologia, allontanandosi da una serie di

incarnazioni deboli e parziali sviluppatesi negli ultimi tempi (filosofia del linguaggio, epistemologia, filosofia

del diritto, filosofia della scienza e via enumerando). Sotto questo profilo, alcuni hanno parlato di un ritorno

alla filosofia presocratica, con le sue grandi domande sull’arché e sulla natura profonda della realtà.

3. Continuo e discreto

Nel corso dei secoli la matematica si è presentata secondo due fisionomie, per lo più contrapposte, a volte

invece intrecciate. Queste due forme corrispondono a due concezioni della realtà: per la prima l’Universo e

i suoi fenomeni hanno natura continua, per la seconda tutto è discreto. Grosso modo, la visione continua è

alla base dell’analisi, della meccanica classica, dello spazio-tempo relativistico. Dalla visione discreta sono

fiorite l’algebra, la teoria dei numeri, il calcolo combinatorio. Inoltre sul discreto è basato l’edificio della

meccanica quantistica, anche se vi si annidano territori all’insegna del continuo, come le distribuzioni di

probabilità. Le due concezioni si rispecchiano negli strumenti rispettivamente analogici e digitali e, sotto

questo profilo, la semplicità concettuale, la facilità di costruzione e la comodità d’uso delle apparecchiature

digitali nell’informatica e nelle telecomunicazioni hanno impresso un impulso fortissimo alla matematica

discreta e alla visione discreta della realtà.

Come ho anticipato, il protagonista di questa svolta è stato il computer: uno strumento ha dunque

condizionato le concezioni teoriche, filosofiche e metafisiche, confutando certi pregiudizi di tipo idealistico.

Un impulso gagliardo ha subìto l’aspetto computazionale della matematica: ai grandi teoremi di esistenza e

unicità tipici dell’analisi si è sostituita la ricerca concreta delle soluzioni: sono quindi diventate importanti la

valutazione delle risorse di calcolo, la precisione dei risultati, la ricerca degli algoritmi migliori. Ma anche

sotto il profilo teorico si sono aperti vasti spazi: la teoria della calcolabilità, la ricorsività, le macchine di

Turing. Alcuni matematici e informatici contemporanei, come Gregory Chaitin, rifiutano la continuità in

nome di affilate argomentazioni sull’irrealtà dei numeri ‘reali’, sui quali si basa per intero l’analisi classica, e

si fanno promotori di una concezione discreta e operativa della matematica, in cui signoreggiano i

programmi per computer, le operazioni logiche discrete e gli automi cellulari. Gli automi cellulari furono

introdotti nel 1968 da John Conway col suo gioco Life, che in realtà è un solitario. L’unico giocatore,

partendo da una configurazione arbitraria di celle su una scacchiera e applicando semplici regole di nascita,

sopravvivenza e morte delle celle, vede fiorire una successione di configurazioni la cui dinamica, aperta o

periodica, ricorda l’andamento di certi fenomeni biologici, come il comportamento degli stormi di uccelli o

delle colonie di insetti sociali.

4. L’informazione

Il computer e le apparecchiature per la trasmissione dei segnali hanno impresso un forte impulso al

concetto di informazione, che, recessivo fino a qualche decennio fa rispetto a quelli di materia ed energia, si

sta prendendo oggi una rivincita clamorosa. I fisici teorici parlano ormai di universo informato e di universo

bello, introducendo qualificazioni finora estranee alla loro solida e rigorosa disciplina. Il fisico John

Archibald Wheeler (1911-2008) scrisse:

Il tempo che ho dedicato alla fisica durante la mia vita mi appare diviso in tre periodi. Nel primo, che va dagli inizi della

mia carriera fino ai primi anni Cinquanta, ero tutto preso dall’idea secondo cui “Tutto è particelle”. Tentavo di

costruire tutte le entità di base – neutroni, protoni, mesoni, e così via – a partire dalle particelle più fondamentali e

leggere: elettroni e fotoni.

Il secondo periodo si potrebbe chiamare “Tutto è campi”. Dal momento in cui m’innamorai della gravità e della

relatività generale, nel 1952, fino alla mia tarda carriera perseguii la visione di un mondo fatto di campi, in cui quelle

che si presentavano come particelle erano in realtà manifestazioni di campi elettrici, magnetici e gravitazionali.

Ora sono tutto preso da una nuova visione: “Tutto è informazione”. Più rifletto sul mistero dei quanti e sulla nostra

singolare capacità di comprendere il mondo in cui viviamo, più mi persuado che la logica e l’informazione possono

avere un ruolo basilare nelle fondamenta della teoria fisica … E continuo a cercare.

E giunse a riassumere la primazia dell’informazione rispetto alla materia con la locuzione It from bit (Cioè

“la materia deriva dall’informazione”, di cui il bit rappresenta l’unità). Un altro grande fisico, Richard

Feynman (1918-1988), premio Nobel (1965), scriveva

Mi lascia sempre perplesso il fatto che, secondo le leggi della fisica come le comprendiamo oggi, sia necessaria una

macchina calcolatrice e un numero infinito di operazioni logiche per individuare ciò che accade in una regione dello

spazio o in un intervallo di tempo piccoli a piacere... Così ho fatto spesso l’ipotesi che, alla fine, la fisica non avrà più

bisogno di un’enunciazione matematica, e si scoprirà che le sue leggi sono semplici come una scacchiera di automi

cellulari. Si tratta, tuttavia, di una speculazione come un’altra.

Konrad Zuse (1910-1995), cui si deve il primo computer programmabile della storia, lo Z-3, e il primo

linguaggio di programmazione di alto livello, il Plankalkül, nel 1967 scrisse un importante saggio intitolato

Rechnender Raum (Spazio calcolante), in cui, dopo aver costatato

l’inspiegabile ma evidente corrispondenza tra il comportamento delle particelle digitali (bit) e quello delle particelle

subatomiche; la quantizzazione sempre più convalidata delle grandezze fisiche, con il conseguente abbandono del

“dogma” del continuum in natura; la progressiva coincidenza, nella terminologia e nei concetti, della teoria

dell'informazione e della fisica; il ruolo degli automi cellulari, già in grado di risolvere equazioni differenziali

nell'esplorazione dell'Universo,

concludeva che l’Universo doveva essere, appunto, un grande calcolatore. Naturalmente, di fronte a questa

potente suggestione ispirata dal computer, e visto che la realtà ci è inaccessibile, ci si può chiedere se

questa macchina riveli davvero la natura profonda della natura, ci assicuri cioè che tutto è informazione,

computazione, algoritmo. Insomma, il computer è davvero una sonda che pesca nell’inconscio del mondo

rivelandocelo? Oppure si tratta di una metafora, di una suggestione attraente ma ingannevole?

5. Il Convegno del 1981

Nel maggio 1981 si tenne al Massachusetts Institute of Technology un convegno su “Fisica e

computazione”, cui parteciparono Feynman, Wheeler, Zuse e tanti altri studiosi, tutti interessati a gettare

un ponte tra fisica e informazione. L’organizzatore del convegno, Edward Fredkin, aveva partecipato nei

primi anni Sessanta all’allestimento del famoso Computer Science and Artificial Intelligence Laboratory del

MIT ed è a lui che si deve la locuzione “filosofia digitale”. Nel suo contributo, intitolato The Computing

Universe, Zuse riferì ai convegnisti la genesi dell’idea dell’Universo come Grande Computer e sottolineò il

ruolo del concetto di informazione, nuova grandezza fisica capace di prendere il posto delle vecchie

grandezze quali energia, massa, quantità di moto. Anche Wheeler e Feynman si posero sulla stessa linea. Il

contributo di quest’ultimo, Simulating Physics with Computers, non solo sottolineava la capacità del

computer di simulare perfettamente la realtà fisica, prevedendone l’evoluzione, ma anche indicava nella

computazione il minimo comun denominatore del mondo e del computer. La natura dinamica della

computazione distingue queste impostazioni dalle antiche visioni di Pitagora e di Galileo, per i quali il

numero e in genere la matematica sono principi essenzialmente statici. Merita di essere ricordato il

contributo Physics and Computation del coorganizzatore del convegno, Tommaso Toffoli, le cui frasi iniziali

sono ancor oggi ampiamente citate:

In un certo senso la Natura da miliardi di anni sta continuamente computando il proprio stato successivo: tutto quello

che noi dobbiamo fare – e in effetti possiamo fare – è farci dare un passaggio da questa enorme computazione in

corso e cercare di scoprire in quali punti essa si avvicina al luogo dove vogliamo andare noi.

Al termine del convegno del MIT, erano tutti piuttosto convinti che l’asserzione “il Cosmo è un Grande

Computer” non fosse da intendere come una semplice metafora, bensì come un valido strumento euristico.

Non è possibile seguire qui gli innumerevoli sentieri e incroci che, prima e dopo il convegno del 1981, sono

confluiti nella grande corrente della filosofia digitale. Basti ricordare alcuni contributi: le reti neurali, la vita

artificiale, l’intelligenza artificiale, la cibernetica di Norbert Wiener, la teoria dell’informazione di Claude

Shannon, la scoperta della doppia elica di Watson e Crick; inoltre, come ho accennato, molti aspetti

fondamentali della meccanica quantistica. Devo ora dedicare un po’ di spazio a tre figure fondamentali

nello sviluppo della filosofia digitale.

6. I tre grandi: Edward Fredkin, Gregory Chaitin, Stephen Wolfram

6.1. Edward Fredkin e la prospettiva digitale

Nelle note autobiografiche contenute nella prefazione del suo libro Digital Mechanics, intitolata Il dono

stupendo e glorioso, Fredkin narra come fin da bambino sentisse di essere diverso dagli altri, nel senso che,

come riuscì a capire nel corso del tempo, vedeva il mondo in modo particolare. Ciò gli causò seri problemi

di identità e un triste senso di emarginazione rispetto agli altri bambini:

Non so quando esattamente capii per la prima volta che il mio modo di pensare era differente. Da ragazzo temevo che

queste differenze dipendessero da qualcosa di sbagliato in me. Mi sembrava di non poter accettare certe cose con cui

tutti gli altri si trovavano a loro agio. Non riuscivo a capire cose che gli altri capivano facilmente. La mia mente mi

sembrava in qualche modo difettosa, anche se sapevo di essere intelligente.

E si sentiva come se fosse l’unica persona capace di vedere in un mondo dove tutti gli altri erano ciechi. Il

“dono” di cui parla Fredkin è la capacità di vedere il mondo, in modo affatto naturale, sotto una prospettiva

digitale, cioè formato da unità discrete, intere e a sé stanti. All’opposto, la visione del continuo e

dell’infinitesimale è illusoria. In A New Cosmogony egli scrive che molte cose un tempo considerate

continue adesso sono riconosciute discrete: gli atomi, l’elettricità, i fotoni e così via. Il passo che resta da

compiere è giungere a concepire come discrete le due forme ritenute continue per eccellenza: il tempo e lo

spazio. Fondamentale nella formazione intellettuale di Fredkin fu l’incontro, avvenuto al MIT nel 1956, con

il computer, da lui atteso per tutta la vita e definito la cosa perfetta, che gli consentì di trovare la via

dell’algoritmo e il linguaggio per comunicare un pensiero fin lì inespresso. “Informazione” e “bit” assunsero

valore ontologico e la computazione divenne la Legge del Tutto.

Avviene dunque un passaggio dalla metafora all’ontologia, e si deve affrontare la domanda metafisica

sull’identità del Grande Programmatore che avrebbe lanciato il “programma Universo”. Secondo Fredkin

deve esistere un Creatore-Programmatore: “questo nostro Universo è una conseguenza di qualcosa che

chiamerei intelligente,” il cui luogo, le cui leggi e la cui dimensione è altrove rispetto a questo Universo.

Inoltre tutta la realtà obbedisce alle sue regole di programmazione, anche se si tratta di un determinismo

sui generis, poiché l’affiorare continuo di fenomeni emergenti lascia intatta la forza creatrice iniziale. La

posizione fondamentale occupata dal concetto di informazione è così espressa da Fredkin:

Esistono tre grandi domande filosofiche: Che cos’è la vita? Che cosa sono la coscienza, il pensiero, la memoria e simili?

Come funziona l’Universo? Il punto di vista informazionale le concerne tutte e tre.

Quanto alla natura dell’informazione, essa non è indagabile poiché è il principio primo. Il principio primo

non sarebbe tale se rimandasse a qualcos’altro.

6.2. Gregory Chaitin: tutto è algoritmo

La personalità multiforme di Chaitin, matematico, informatico, filosofo digitale, ruota intorno alla sua

inesauribili curiosità:

In realtà m’interessa tutto: che cos’è la vita? che cos’è l’intelligenza? che cos’è la coscienza? vi è causalità

nell’Universo? lo spazio e il tempo sono continui o discreti?

Nell’ambito matematico, la grande scoperta di Chaitin, che colloca il suo nome accanto a quelli di Gödel e di

Turing, è un teorema relativo alla probabilità Omega che un programma informatico prima o poi si arresti.

Omega, il “numero di Chaitin”, è perfettamente definito ma non può essere calcolato ed è al centro di una

dimostrazione innovativa del teorema di incompletezza di Gödel, di cui Turing aveva fornito una

dimostrazione alternativa basata sul problema della fermata di un dispositivo concettuale poi chiamato

“macchina di Turing”. Qui m’interessa soprattutto mettere in evidenza le riflessioni di Chaitin sulla filosofia

digitale, che muovono dal valore epocale dell’avvento del computer. Ho accennato in precedenza alla

natura filosofica di questa macchina: ebbene è a Chaitin che si deve questa valutazione: il computer cambia

l’epistemologia e modifica il significato del verbo “comprendere” e, aggiunge Chaitin con una certa

perentorietà informatica, si capisce qualcosa solo se si è capaci di scriverne il programma. Esiste insomma

un linguaggio capace di rispecchiare la realtà molto meglio delle parole e dei numeri: il linguaggio della

programmazione, che è lo stesso linguaggio con cui si esprime la Natura.

Galileo è stato il profeta della rivoluzione scientifica che ha segnato il passaggio da un paesaggio di eventi

qualitativi con interrelazioni labili a un panorama di fenomeni quantitativi legati da rigorose concatenazioni

causali all’insegna del linguaggio matematico. Ebbene, ora assistiamo a un altro cambiamento di

prospettiva: la distanza che separa le “sostanze” dai “numeri” è la stessa che separa i “numeri” dai “bit”.

Chaitin chiama in causa anche Platone, che nel Timeo definisce il Demiurgo come il Gran Matematico, che

opera con le forme geometriche, e Pitagora, per il quale l’Universo è fatto di numeri. Secondo questa

tradizione, tutto è numero e Dio è un matematico. Adesso possiamo dire che tutto è algoritmo e Dio è un

programmatore. Non più 1, 2, 3, 4... bensì 0 e 1. Inoltre nell’algoritmo è implicita la dinamicità, che manca

nella formula matematica, la cui legge è sempre uguale a sé stessa e vale in un Universo privo di novità. Ma

il nostro mondo ci sorprende e ci affascina perché fa emergere sempre il nuovo e si dimostra

immancabilmente creativo. Tutto ciò, secondo Chaitin, segna una svolta epistemologica basilare: il

computer modifica il significato del verbo “comprendere”.

Secondo Chaitin non si può parlare di fisica in senso profondo senza trapassare nella metafisica:

Stiamo assistendo a un ritorno della filosofia presocratica, col suo accento sull’ontologia più che sull’epistemologia. È

un ritorno della metafisica, forse morta nella filosofia contemporanea ma viva e vegeta nella fisica fondamentale e

nella cosmologia contemporanee. Nel Novecento è avvenuta una grande esaltazione della filosofia del linguaggio e la

metafisica è stata trascurata. Ma ora è tempo di ricominciare: si profila una nuova metafisica associata ai nomi di

Edward Fredkin e Stephen Wolfram e di altri studiosi tra i quali includo anche me stesso.

La metafisica, oggi trascurata dai filosofi, è viva e vegeta nella fisica teorica, che ricerca la vera natura della

realtà. Chaitin ritiene di sapere che cos’è la verità scientifica e che cos’è l’essenza metafisica di un oggetto:

dato un qualsiasi fenomeno, la legge del suo divenire è il programma informatico più breve in grado di

simulare la sua evoluzione e l’essenza di quell’oggetto è il suo contenuto d’informazione algoritmica, cioè la

lunghezza del programma di computer più conciso che restituisca quell’oggetto. Il filosofo guida di Chaitin è

Leibniz, inventore, come si è visto, del calcolo binario e sostenitore del migliore dei mondi possibili.

Concludo questo rapido profilo di Gregory Chaitin con un’ultima citazione:

La teoria migliore è il più piccolo programma per computer che riproduca esattamente i dati empirici. Questo è il

detto di Leibniz secondo cui la scienza è possibile e il mondo è comprensibile precisamente perché Dio minimizza la

complessità delle leggi di natura e insieme massimizza la ricchezza e la diversità dell’Universo determinate da queste

leggi. Nel mio modello, sia le leggi di natura sia l’Universo che ne risulta sono rappresentati come stringhe finite di

bit... Le leggi sono un programma e l’Universo è il suo output.

6.3. Stephen Wolfram: un nuovo tipo di scienza

Stephen Wolfram rappresenta attualmente la punta più avanzata della filosofia digitale. È stato un enfant

prodige che non ha tradito le attese e, da grande, è diventato un homme prodige. A sedici-diciassette anni

pubblica articoli di fisica subatomica su riviste autorevoli come “Nuclear Physics” e, intorno ai quaranta, nel

2002, pubblica in proprio il monumentale A New Kind of Science. Nel frattempo fonda un'azienda

multimilionaria che ruota intorno a Mathematica, un software di sua invenzione diventato strumento

imprescindibile di ogni istituzione scientifica e didattica di alto livello. All’inizio della sua opera scrive:

Circa tre secoli fa la scienza fu trasformata da un’idea nuova e fondamentale, secondo cui per descrivere il mondo

naturale si potevano usare regole espresse da equazioni matematiche. Il mio scopo in questo libro è dare avvio ad

un'altra trasformazione di portata simile.

Il dogma galileiano secondo cui la Natura sarebbe un libro scritto in un linguaggio matematico che la mente

umana può comprendere comincia a incrinarsi. Wolfram sospetta che sia necessario un codice nuovo,

quello binario, e un cervello diverso, quello elettronico, e collauda queste ipotesi con ricerche ed

esperimenti che pubblica via via, attirando l’attenzione generale, tanto che a soli ventun anni gli viene

conferito il Genius Award della Fondazione MacArthur per i suoi lavori sulla fisica e sulla computazione. Nei

suoi lavori, egli cerca di sviluppare un software che, a partire da operazioni elementari, sviluppi programmi

in grado di simulare i vari sistemi naturali che manifestano complessità. La sua attenzione è decisamente

passata dalla materia (le particelle elementari) alla forma (i bit).

La scienza nuova che Wolfram inaugura è basata su un tipo di regole molto generali, incorporabili in

programmi per computer piuttosto semplici. Non c'è ragione per credere – osserva Wolfram – che i sistemi

che osserviamo in natura debbano seguire soltanto le regole della matematica tradizionale; l'unica ragione

per cui finora è sopravvissuta tale convinzione è il limite dell'intelligenza umana: la nostra capacità di

calcolo (il nostro cervello) non può spingersi oltre una determinata soglia. Questa stessa soglia, però, non

delimita affatto le potenzialità dei computer, i cui programmi possono attuare varietà enormi di esiti,

generando forme sempre più complesse a partire da regole semplicissime: le regole restano semplici, ma la

loro iterazione ripetuta dà luogo a comportamenti sempre più complessi. È un po’ quello che accade nel

caso dei frattali e si conforma al concetto leibniziano del migliore dei mondi possibili. Si sfata dunque il

pregiudizio che da input semplici si ottengano output semplici e che fenomeni complessi siano retti da

meccanismi soggiacenti altrettanto complessi, espressi da equazioni matematiche complicate.

È vero che in certi settori il metodo tradizionale della scienza ha funzionato bene, conseguendo notevoli

successi teorici e pratici: quando ha affrontato fenomeni dal comportamento piuttosto semplice, come i

moti planetari, l’impostazione tradizionale ha dato buon esito, tanto che ai primi del secolo scorso era

diffusa la convinzione che quel metodo potesse spigare tutto e che gli ostacoli alla comprensione dei

fenomeni più complessi consistessero solo nelle difficoltà di calcolo. In realtà, afferma Wolfram, la vera

causa dei limiti che incontra la conoscenza scientifica tradizionale sta nell’insufficienza della mente umana,

che non riesce a concepire regole più generali. I computer non soffrono di queste limitazioni e,

opportunamente programmati, suggeriscono che il comportamento dei sistemi naturali si basa su regole

molto più generali. La cosa più sorprendente è che queste regole ruotano intorno a programmi

semplicissimi

Wolfram, procedendo a una verifica sistematica, vede che sono proprio i programmi più semplici a rendere

ragione dei fenomeni complessi della natura. Ecco la scoperta che conduce alla necessità di ripensare il

funzionamento dei processi naturali, ecco la soluzione del mistero più inavvicinabile del mondo naturale:

come esso faccia a produrre, senza sforzo apparente, realtà tanto complesse. La necessità di un nuovo tipo

di scienza è giustificato da una serie di ragioni. Per qualche tempo – osserva Wolfram – la scienza (la

matematica) tradizionale ci ha illuso di poterci misurare con l'enigma della complessità, ma ciò che funziona

nella spiegazione e previsione dei moti planetari non funziona per comportamenti enormemente più

complessi, quali i regimi di turbolenza dei fluidi o i meccanismi di crescita di varie specie di piante. La nuova

scienza (e la nuova matematica) invece – a giudizio del suo autore – può affrontare anche fenomeni di

complessità enorme. Non solo. La scienza tradizionale ha affrontato i problemi con un metodo

rigorosamente riduzionista (da molti considerato l'unico metodo davvero scientifico), secondo cui le

proprietà di un sistema derivano dalle proprietà dei suoi componenti: ma il passaggio dal comportamento

di questi al comportamento del sistema rimane spesso un problema insolubile, soprattutto per la presenza

di proprietà emergenti, dovute alle interazioni tra i componenti. La nuova scienza affronta con successo

anche questo passaggio.

I programmi semplici, a cui il testo rimanda costantemente, sono gli automi cellulari, al cui studio Wolfram

ha dedicato dieci anni di vita, per poterne scandagliare tutti i segreti e tutte le prerogative. E tra tutti i 256

automi cellulari unidimensionali di tre celle da lui studiati ve n’è uno, identificato dalla regola di

trasformazione numero 30, che è assurto ad emblema della scienza nuova perché, pur non seguendo una

legge più complicata degli altri 255, produce senza sosta schemi estremamente irregolari e complessi. La

sensazionale scoperta di Wolfram consiste in sostanza in questo: partendo da programmi e da condizioni

iniziali decisamente semplici, senza inserire alcun elemento di complessità, emerge spontaneamente un

comportamento altamente complesso: l’evoluzione degli automi cellulari porta alla comparsa di figure

identiche alle strutture microscopiche delle venature delle foglie, ai disegni sulle conchiglie o alle forme di

gorghi, vortici, esplosioni e nebulose in via di formazione (si noti ancora una volta che vi è una certa

analogia con i frattali, strutture molto complesse anch’esse generate da regole ricorsive semplicissime).

Le conseguenze di tale scoperta trovano applicazione non solo nei sistemi fisici, ma anche in quelli biologici.

Infatti il mondo è uno e una sola dev’essere la legge del suo divenire: la computazione; mentre la scienza

tradizionale è costretta a formulare leggi diverse per ogni diverso dominio della realtà. Anche il quadro

dell'evoluzione rimane profondamente coinvolto da queste idee rivoluzionarie, che offrono una spiegazione

alternativa a quella darwiniana tradizionale: e tutto, si potrebbe dire, a causa dello stupefacente automa

cellulare numero 30 che qualcuno ha asserito essere per Wolfram “l'equivalente del fringuello di Darwin e

del pisello dolce di Mendel”. Insomma, il mondo è uno e la computazione è la sua legge. Non è questo il

luogo per approfondire il concetto di automa cellulare, per il quale si rimanda alla bibliografia; basti qui

riportare i primi passi dell’evoluzione dell’automa cellulare lineare di tre celle n. 30 (il trentesimo dei 256

possibili):

7. Il paradigma pancomputazionale

Come si è visto, la filosofia digitale pone a principio primo l’informazione, un’informazione dinamica,

animata dalla computazione, e compendia questa visione in tre asserzioni perentorie:

Tutto computa

Tutto è frutto di computazione

Tutto può essere trasformato in un dispositivo computante

Qui “tutto” significa ogni parte della realtà, dall’Universo fino alle sue più piccole porzioni. Più

esplicitamente, i sostenitori della filosofia digitale riassumono le loro convinzioni nel “paradigma

pancomputazionale”, di cui esistono tre versioni, forte, debole, metaforica:

• Versione forte (ontologica): Tutti i processi sono processi computazionali. L’Universo è un computer.

• Versione debole (epistemologica): Tutti i processi possono essere descritti come processi computazionali.

• Versione metaforica: Tutti i processi possono essere descritti come se fossero processi computazionali.

8. Sette possibili obiezioni alla filosofia digitale

Concludo questa breve sintesi della filosofia digitale enunciando alcune obiezioni a tale visione:

1) L’ipotesi che il bit sia l’unità fondamentale della realtà dev’essere ancora verificata scientificamente.

È vero: i filosofi digitali accettano questa obiezione, che è basata sulla natura metafisica di questa filosofia.

2) L’ipotesi che l’informazione sia il fondamento della realtà è metafisica e non scienza.

In parte è vero: i filosofi digitali ammettono che la teoria contenga una componente metafisica, ma

sostengono che essa presenta un alto tasso euristico ed esplicativo nei confronti del mondo fisico. Del

resto, ogni teoria poggia su basi metafisiche (chi sostiene di non avere una metafisica, in realtà ne ha una

sbagliata).

3) Per esistere e per propagarsi, l’informazione ha sempre bisogno di un supporto materiale o energetico.

Quindi non può essere il principio primo.

A questo proposito i filosofi digitali si dividono: alcuni si limitano ad assegnare all’informazione lo stesso

statuto di principio primo attribuito nella tradizione fisica alla materia e all’energia, istituendo una sorta di

arché trinitaria e paritaria. Per altri, più radicali, l’informazione è l’unico principio primo. Ma se

l’informazione non può essere ridotta al suo supporto, essa non può neppure prescinderne. La posizione

moderata, trinitaria, sembra più accettabile di quella radicale.

4) La filosofia digitale pone l’immateriale a fondamento della realtà, quindi è una nuova forma di

spiritualismo.

I filosofi digitali accettano la prima parte dell’affermazione, ma non la seconda. Essi sostengono di aver

individuato una terza dimensione ontologica, che si colloca nel mezzo del tradizionale dualismo tra Spirito e

Materia. Oggi i fisici parlano di “universo informato”: l’universo sarebbe una rete cosmica di relazioni (la

relazione è un concetto informazionale). La fisica teorica afferma che le proprietà della realtà ultima sono

rispecchiate nelle strutture matematiche, immateriali, cui la filosofia digitale aggiunge la dinamica della

computazione. Immaterialità non spirituale, dunque, bensì matematica e info-computazionale.

5) La filosofia digitale contraddice il “rasoio di Occam”.

Tutt’altro, ribattono i filosofi digitali. Il rasoio si applica non all’esuberanza delle forme naturali, bensì alle

leggi fondamentali che le producono e che, stando alla visione di Wolfram, si riducono a un piccolo numero

di programmi semplici (automi cellulari).

6) La filosofia digitale contraddice il senso comune.

Che l’universo sia un Grande Computer urta in effetti contro il senso comune. Ma il progresso della scienza

è sempre avvenuto all’insegna di un allontanamento progressivo dal senso comune e dalla percezione

immediata.

7) La filosofia digitale implica che il mondo sia solo una simulazione.

Non è vero: per la filosofia digitale non viviamo dentro una simulazione, ma dentro una computazione. Non

esiste nulla di cui la realtà sarebbe una simulazione: l’Universo non ha modelli da replicare, semplicemente

esegue il suo programma. Quanto alla simulazione, è proprio la natura computante comune all’Universo e

al computer che consente di simulare (riprodurre) in quest’ultimo un numero crescente di fenomeni del

primo.

Bibliografia essenziale

Longo G. O., A. Vaccaro (2013). Bit Bang. La nascita della filosofia digitale, Apogeo

Longo G. O., A. Vaccaro (2014). La nascita della filosofia digitale, Mondo

pagg. 1-19.

Education, Milano.

Digitale, XIII, n. 52, luglio,

Bibliografia supplementare

Chaitin, G. (2010). Metabiology: Life as Evolving Software, Course Notes, chapter 3: Is

the world built of information? Is Everything software?, Lecture, The Technion, Haifa.

http://www.cs.auckland.ac.nz/~chaitin/metabiology.pdf

Chalmers, D. (1995). “Facing up to the Hard Problem of Consciousness”, Journal of

Consciousness Studies, 2, (3), 200-219.

Dawkins, R. (1986). The Blind Watchmaker, Norton; t. i., L’orologiaio cieco. Creazione o

evoluzione?, Mondadori, 2003.

Dodig-Crnkovic, G., Muller, V. (2011). “A Dialogue Concerning Two World Systems: Infocomputational vs Mechanicistic” in Dodig-Crnkovic, G., Burgin, M. (eds.) Information

and Computation, World Scientific.

Feynman, R. (1965). The Character of Physical Law, Mit Press; t. i., La legge fisica,

Boringhieri, 1971.

Feynman, R. (1982). “Simulating Physics with Computers”, International Journal of

Theoretical Physics, v. 21, nn. 6/7, June, 467-488.

Fredkin, E. (1990). “Digital Mechanics: An Informational Process Based on Reversible

Universal

Cellular

Automata”,

Physica

D,

45,

254-270.

http://www.digitalphilosophy.org/dm_paper.htm

Malone, M. S. (2000). “God, Wolfram and Everything Else”, Forbes ASAP, 27 Nov., 162180.

Negroponte, N., (1995). Being Digital, Alfred A. Knopf; t. i., Essere digitali, Sperling &

Kupfer, 2004.

Toffoli, T. (1982). “Physics and Computation”, International Journal of Theoretical

Physics, v. 21, nn. 3/4, April, 165-175.

Wheeler J. A., Ford, K. W. (1998). Geons, Black Holes & Quantum Foam: A Life in Physics,

W. W. Norton & Co.

Wolfram, S. (2002). A New Kind of Science, Wolfram Media Inc.

Zuse, K. (1982). “The Computing Universe”, International Journal of Theoretical Physics,

v. 21, nn. 6/7, June,589-600.

Seconda parte.

Tecnologie cognitive e post-umano

di

Giuseppe O. Longo

"Relazione presentata al Convegno su 'Progresso scientifico e progresso umano' organizzato dall'area di

ricerca interdisciplinare SEFIR, 'Scienza e Fede sull'Interpretazione del Reale', Roma 22-24 gennaio 2015"

Il tema del post-umano, che alcuni considerano ancora appartenente alla fantascienza e che secondo altri invece si

affaccia prepotente alla scena della realtà, è di grande e urgente rilievo sociopolitico, oltre che tecnico e scientifico, e

lo dimostra, tra l’altro, l’attenzione che gli ha riservato l’Unione Europea in un rapporto che esamina prospettive,

benefici e rischi del post-umanesimo.

Vorrei cominciare con alcune citazioni:

Per gli esseri umani è naturale superare continuamente i propri limiti.

La spinta a trasformare sé stesso e il proprio ambiente fa parte dell’essenza dell’uomo.

– Max More

Tutti gli esseri hanno creato qualcosa al di sopra di sé: e voi volete essere il riflusso di questa grande marea e retrocedere alla bestia

piuttosto che superare l'uomo?

– Friedrich Nietzsche

Si apre una nuova era, dove l’evoluzione stessa è soggetta all’autorità dell’uomo.

– Jeremy Rifkin

Non è irrealistico pensare che la specie umana possa, a breve termine,

prendere nelle sue mani la propria evoluzione.

– Jürgen Habermas

L'evoluzione umana è un capitolo pressoché chiuso della storia della vita.

Possiamo attenderci che dall'uomo nasca una nuova specie, che andrà oltre i

suoi risultati così come egli ha superato quelli del suo predecessore homo erectus.

E' probabile che questa nuova forma di vita intelligente sarà fatta di silicio.

– Robert Jastrow

Madre natura, ti siamo riconoscenti per ciò che ci hai fatto diventare.

Indubbiamente hai fatto del tuo meglio [...], ma ci hai creati vulnerabili

alle malattie e ai difetti e ci obblighi a invecchiare e a morire

proprio quando cominciamo a raggiungere la saggezza.

– Max More

Se vorremo costruire macchine capaci di apprendere e di modificare il comportamento in base all’esperienza, dovremo accettare il

fatto che ogni grado di indipendenza fornito ad esse potrebbe produrre un ugual grado di ribellione nei nostri confronti. Una volta

uscito dalla bottiglia, il genio non avrà alcuna voglia di ritornarci, e non c’è motivo di aspettarsi che le macchine siano ben disposte

verso di noi. In breve, solo un’umanità capace di rispetto e deferenza sarà capace di dominare le nuove potenzialità che ci si aprono

davanti. Possiamo adottare un atteggiamento umile e condurre una vita buona con l’ausilio delle macchine, oppure possiamo

adottare un atteggiamento arrogante e perire.

– Norbert Wiener

La natura non poteva correre un rischio maggiore di quello

di far nascere l’uomo. [...] Nell’uomo la natura ha distrutto sé stessa.

– Hans Jonas

La paura più profonda è che alla fine la tecnologia ci faccia perdere la nostra umanità, cioè l’imprecisata qualità essenziale che ha

sempre costituito la base della nostra autocoscienza e dell’individuazione dei nostri scopi esistenziali, nonostante tutti i cambiamenti

della condizione umana che hanno avuto luogo nel corso della storia.

– Francis Fukuyama

Da queste citazioni traspare la forte coloritura emotiva che accompagna la possibilità che l’uomo prenda in mano le

redini della propria evoluzione trasformandosi in un post-uomo.

Come tutte le grandi conquiste della tecnologia, anche questa suscita entusiasmo o all’opposto viva preoccupazione:

ciò dimostra che la tecnologia non è neutra, ma suscita sentimenti ed emozioni profonde. Essa ha forti connotati

magici e una forte valenza mitopoietica.

Le tecnologie più avanzate, dalla genomica alla robotica, dall’informatica alle nanotecnologie, ci promettono (o ci

illudono di) onniscienza, onnipotenza e perfino immortalità. Ma la tecnologia eredita dal suo inventore Prometeo,

abile truffatore e insieme sommo artefice, un’ambivalenza di fondo.

Essa suscita un entusiasmo illuministico e positivistico per la prospettiva che offre di liberarci dai nostri limiti, ma

insieme preoccupa per i nuovi vincoli che impone: è affrancamento e schiavitù. Fin dall’antichità la tecnica ha questo

volto duplice: offre grandi opportunità ma nasconde insidie pericolose

La punizione di Prometeo è il segno della gelosia degli dèi e allude a una sorta di sacralità della natura: l’uomo non

deve valicare le Colonne d’Ercole poste a limite della sua hybris.

Se la natura dell’uomo lo spinge sempre a superarsi, egli nutre anche l’oscuro timore che la sua audacia sia punita.

La spinta verso il post-umano si colloca nel solco di una tradizione millenaria, quella della creazione del second’ordine.

Da tempi antichissimi l’uomo ha tentato di imitare l’opera creatrice attribuita agli dèi, fantasticando e narrando di

esseri artificiali, ma anche costruendo meccanismi (automi) di meravigliosa fattura a imitazione delle forme e delle

funzioni degli organismi naturali

Le opere narrative (si pensi alla leggenda del Golem, al mostro di Frankenstein e alle numerosissime opere della

fantascienza letteraria e cinematografica contemporanea), non si devono cimentare con le difficoltà costruttive,

quindi sono molto più suggestive, ma anche i fabbricatori di automi hanno prodotto in passato manufatti mirabili:

dagli Alessandrini, attraverso gli Arabi fino alla grande tradizione europea, gli automi hanno popolato le corti e i

palazzi dei potenti, suscitando meraviglia e stupore per la loro raffinatezza.

Ma i prodotti di questa meccanica onirica restavano lontanissimi dal loro modello, l’uomo.

Fu solo nel secolo scorso che con l’invenzione del calcolatore elettronico si ebbe la sensazione di aver colmato il

divario, almeno per ciò che riguardava le capacità cognitive. Il computer, opportunamente programmato, poteva

pensare, emulando dunque la caratteristica più importante dell’uomo.

La nascita dell’intelligenza artificiale fu accompagnata, come al solito, da entusiasmo e scetticismo: affermare che il

calcolatore pensa a molti sembrava e ancora sembra destituito di fondamento, e comunque richiede una definizione

precisa, e molto problematica, del termine pensare.

Tornando al post-umano, le forme in cui si esso può presentare oggi sono: i nativi digitali, il robot, il ciborg (o cyborg),

l’uomo OGM, la Creatura Planetaria, l’uomo in codice…

Le sue svariate declinazioni fanno tutte capo al corpo, alla mente e alla dimensione evolutiva.

Le tecnologie (nell’accezione più generale) da sempre interagiscono con Homo sapiens trasformandolo in Homo

technologicus: se è vero che l’uomo costruisce gli strumenti tecnici, questi a loro volta retroagiscono sull’uomo,

circondandolo e perfino invadendolo, e trasformandolo in un simbionte ciborganico in cui la parte biologica e la parte

artificiale convivono più o meno felicemente.

Oggi questa trasformazione in simbionte biotecnologico è molto visibile: è evidente che l’uomo (tecnologico) è una

creatura in continuo divenire (e ciò confuta il fissismo).

Inoltre la trasformazione ha assunto carattere volontario, programmatico e consapevole, poiché è diretta a due ordini

di finalità:

Da una parte finalità terapeutiche, per recuperare in tutto o in parte facoltà compromesse o perdute o per porre

rimedio a patologie più o meno gravi.

Dall’altra finalità migliorative, per potenziare e accrescere facoltà naturali o per generare capacità inedite.

Gli effetti migliorativi riguardano l’individuo ma anche, se sono ottenuti attraverso la manipolazione del genoma, la

specie.

Ciò che così si prospetta è una vasta rivoluzione teorica e pratica, che coinvolge e stravolge molti dei concetti che la

tradizione ci ha consegnato e molti aspetti della nostra società e della nostra cultura. Sul piano teorico sfumano molte

distinzioni consolidate, in primo luogo quella tra naturale e artificiale, e viene messa in discussione la cosiddetta

“sacralità della natura”.

Ormai l’uomo, armato delle sue tecnologie, cessa di riprodursi secondo i meccanismi della lotteria cromosomica e

comincia a prodursi in base alle specifiche progettuali che più gli piacciono.

Un altro baluardo etico-culturale che viene scosso dalla prospettiva post-umanista riguarda la definizione di persona:

poiché le pratiche genomiche, nanotecniche, informatiche e robotiche incidono radicalmente sul corpo e poiché il

corpo è fondamentale nella definizione di persona, di identità personale e di tutte le caratteristiche che si riferiscono

alla persona (libertà, responsabilità, giudizi di valore), ecco che le tecnologie del post-umano incidono in misura

decisiva sulla nozione di persona.

Specie nel loro aspetto migliorativo e non terapeutico, le modificazioni non avvengono soltanto attraverso metodi e

attività praticate da tempo e più o meno esplicitamente riconducibili alla tradizione naturale, come esercizi fisici,

alimentazione, droghe e simili, ma li travalica per sconfinare nell’artificialità più genuina.

Operate sul (corpo del)l’uomo, tali pratiche rendono dunque problematica la definizione di identità umana.

Si apre qui il problema se esista nell’uomo qualche caratteristica essenziale, o tratto assoluto o “indisponibile”, cioè

non assoggettabile a manipolazione pena lo snaturamento o la disumanizzazione; un tratto insomma che consenta di

distinguere ciò che è prodotto per via chiaramente tecnica da ciò che è derivato dall’evoluzione non compromessa o

inquinata dall’intervento umano.

Se questo tratto indisponibile esistesse, il rapporto tra naturale e artificiale corrisponderebbe al rapporto tra umano e

non umano.

Se all’opposto si ammettessero senza riserve nella categoria dell’umano i prodotti delle manipolazioni tecnologiche,

equiparandoli agli esiti dell’evoluzione naturale, si aprirebbe la strada all’avvento del post-umano sintetico: ciò

segnerebbe la totale confusione tra l’uomo e il non uomo, tra l’uomo e l’altro e si innescherebbe un’evoluzione in cui

natura e cultura (intesa soprattutto come tecnologia) sarebbero indistinguibili.

Tali considerazioni fanno sorgere una domanda di fondo: si deve accettare come inevitabile questa evoluzione

biotecnologica verso il post-umano?

Oppure si deve considerare la specie umana nota fin qui come una sorta di patrimonio inalienabile (e patrimonio di

chi? dell’umanità stessa?)?

E in nome di che cosa dovremmo optare per l’una o per l’altra scelta?

Se l’uomo, com’è stato affermato, è un essere naturalmente artificiale, come si può pensare di snaturarlo arrestando il

suo sviluppo verso il post-umano, che, in questa visione, sarebbe un esito, appunto, naturale? Infatti, si può

argomentare, se l’uomo fa parte della natura, anche tutti i suoi prodotti ne fanno parte a buon diritto, anche quando

dovessero comprendere forme nuove di umanità.

In questo senso l’uomo sarebbe il mezzo di cui la natura si servirebbe per accelerare e arricchire l’evoluzione: la

natura delegherebbe all’uomo l’invenzione e la pratica ulteriori dell’evoluzione, abdicando a una funzione ormai

stanca o esaurita.

All’opposto, se si ritiene che l’umanità (come si è sviluppata fin qui) sia un valore, il passaggio al post-umano

segnerebbe la scomparsa o almeno l’atrofizzazione dell’umanità, della biologia umana e della cultura umana.

A quest’ultima visione si può controbattere ponendo la questione del momento di passaggio o del punto di non

ritorno: quando, esattamente, l’umano cede o cederebbe il passo al post-umano? L’uomo non è forse sempre stato

post-umano, nel senso di essere sempre stato ibridato con l’altro – piante, animali, cibo, farmaci, droghe e, oggi, le

macchine – e modificato, aumentato e migliorato dalle pratiche artificiali?

Insomma, il passaggio, al post-umano non è forse sempre esistito nella nostra storia, graduale e progressivo anche se

sempre più veloce, piuttosto che brusco? Siamo sicuri che esista un momento in cui (o una tecnologia per cui) si può o

si potrebbe dire: qui cessa l’umano e comincia il post-umano?

Questo punto di vista da una parte renderebbe meno traumatico il concetto di post-umano, inserendolo in uno

sviluppo evolutivo continuo e naturale (o natural-culturale), ma dall’altra conferirebbe all’uomo, di qui in avanti, la

piena responsabilità della propria evoluzione, mettendo in luce una discontinuità, questa sì radicale: se è vero che

l’uomo è sempre stato post-umano, è anche vero che soltanto oggi se ne rende conto, grazie alla potenza smisurata

acquisita dalla tecnica.

Questa nuova consapevolezza pone in tutta la sua drammaticità il problema etico.

I post-umanisti più radicali, specie americani, non hanno troppi dubbi e adottano il punto di vista della continuità tra

natura e uomo, anzi ritengono che la tecnologia sia ormai la “vera” natura: e alcuni si spingono fino ad affermare che,

poiché credono profondamente nella tecnologia, non possono continuare a credere nella natura.

Più cauti e preoccupati sono gli europei, tra i quali alcuni filosofi (Hans Jonas, Jean Baudrillard) credono ancora in una

sorta di sacralità della natura e nell’esistenza di tratti umani essenziali, scomparsi o alterati i quali l’umanità non

esisterebbe più.

Resta comunque stabilito che il fissismo, cioè l’idea che la persona sia data e definita una volta per tutte, è un

concetto superato: da sempre l’uomo fa la tecnologia e allo stesso tempo la tecnologia retroagisce sull’uomo,

modificandolo in profondità. Oggi, grazie alle tecnologie più avanzate, questa retroazione è diventata estrema, tanto

da rendere manifesto ciò che prima era nascosto:

in primo luogo, come si è detto, il carattere inerentemente post-umano dell’uomo e,

in secondo luogo, l’estensione all’uomo della manipolazione volontaria e consapevole da tempo praticata sulla natura.

Tramonta così la dicotomia classica tra uomo e natura, per cui l’uomo era soggetto e la natura oggetto.

Applicando in modo esplicito, finalistico e consapevole anche a sé stesso le tecnologie trasformative e interferendo

con i meccanismi evolutivi, anche l’uomo diventa oggetto oltre che soggetto, consacrando un’altra (con)fusione tra

due concetti che fino a tempi recentissimi erano stati rigorosamente distinti. L’uomo ormai rientra a pieno titolo nella

natura, cioè nel dominio dei propri interventi trasformativi. Non siamo più solo un prodotto dell’evoluzione, ora siamo

anche agenti della nostra evoluzione.

In entrambi i loro aspetti, terapeutico e migliorativo, le tecnologie che stanno alla base delle versioni presenti e

prossime del post-umano, alludono al desiderio di longevità e di sanità fisica e mentale. Una delle spinte più potenti

verso il post-umano è quella di promettere e permettere una vita lunga e piacevole, priva di infermità e di

deterioramento psicofisico (spinta inestricabilmente connessa a quella dei profitti derivanti all’industria del postumano). Questo desiderio e questa promessa sfociano facilmente in un miraggio insostenibile, quello dell’immortalità:

vorremmo che la pienezza della vita durasse per sempre, avviandoci – giovani, belli, vigorosi – sulle strade

dell’esistenza infinita.

Ma apparteniamo al regno della biologia, dove l’immortalità non ha cittadinanza: essa resta un miraggio, che vive

soltanto nei miti e nei sogni. O negli incubi.

Tuttavia, molti ricercatori del post-umano parlano di immortalità e teorizzano una durata illimitata della vita ottenuta

con gli espedienti più vari: ibridazione con le macchine, costruzione di corpi artificiali e rinnovabili, riversamento della

mente in supporti inalterabili...

Tra i potenziamenti contemplati dalla prospettiva post-umanista sono in prima linea quelli mentali, volti

all’incremento delle capacità cignitive e alla conseguente possibilità di rispondere alle domande fondamentali della

scienza.

Alla base della ricerca scientifica e del potenziamento mentale sta un principio in apparenza semplice: la conoscenza è

un bene, l’ignoranza è un male.

E sulla base di questo principio gli scienziati continuano a cercare risposte agli assillanti interrogativi concernenti il

cosmo e l’uomo, a cominciare dall’inquietante domanda di Leibniz: perché c’è qualcosa piuttosto del nulla?

Sulla strada di queste risposte si frappone un ostacolo secondo alcuni insuperabile, legato alle limitazioni dei nostri

sensi e delle nostre capacità intellettive.

Poiché siamo frutto dell’evoluzione, dobbiamo accettare che, come ogni altra specie, anche noi non potremo mai

risolvere certi problemi: non solo vi sono cose che non sappiamo e forse non sapremo mai, ma anche cose che non

sappiamo neppure di non sapere.

Tuttavia, come noi rileviamo i limiti delle altre specie e le superiamo quanto a intelligenza, così possiamo ipotizzare

che, potenziandoci a sufficienza e diventando esseri superumani o transumani, potremmo trascendere i nostri limiti e

conoscere le verità ultime sul cosmo e su noi stessi.

I termini “superumano” e “transumano” sono in sostanza sinonimi di “post-umano”, ma alludono esplicitamente al

superamento dell’umano e alle caratteristiche mentali superiori che avrebbero i nostri successori. La prospettiva

transumana è sostenuta da parecchi ricercatori, da Stephen Hawking a Daniel Dennett, che contemplano la possibilità

che gli uomini si fondano con sistemi di intelligenza artificiale.

Su questa linea di pensiero si pone anche Marvin Minsky: persuaso che vivere più a lungo, incrementare l’intelligenza

e accrescere il sapere siano obiettivi desiderabili e in sé positivi, Minsky ha speculato sulle possibilità che la tecnologia

offre di modificare sia il corpo umano, facendolo vivere indefinitamente, sia il cervello, facendogli apprendere una

quantità illimitata di cose.

L’uomo attuale, a tecnologia limitata, sarebbe via via sostituito dall’uomo ad alta tecnologia, un homo technologicus in

cui la simbiosi biologico-artificiale sarebbe sempre più sbilanciata verso il secondo termine, conferendogli poteri e

capacità enormi. Il futuro immaginato per queste nuove creature non potrà essere attuato mediante la biologia,

perché nonostante i progressi della medicina, dell'igiene e dell'alimentazione la durata massima della nostra vita è

inscritta nel nostro patrimonio genetico e non può valicare certi limiti.

Lo stesso per le nostre capacità mentali. Per superare queste limitazioni, bisognerà ricorrere a protesi e a sostituzioni

parziali o totali di organi biologici con apparati artificiali, cosa che la tecnologia odierna ci consente di fare. A questo

proposito scrive Minsky:

Non occorre dire che ricorrendo alla tecnologia ci trasformeremo pian piano in macchine. Ciò significa che le macchine si

sostituiranno a noi? Credo che non abbia molto senso esprimersi in termini di "noi" e "loro": preferisco di gran lunga considerare

queste macchine intelligenti del futuro come "figli della nostra mente".

Le protesi saranno applicate anche al cervello, con conseguenze di portata enorme. I "figli della mente" saranno

creature nuove, per le quali sarà necessaria anche un'etica nuova, che, secondo Minsky dovrebbe concernere

il nostro diritto di avere figli, di modificare i nostri geni e di morire, se ci garba. Nessuna delle etiche più diffuse, umanistica o

religiosa, si è dimostrata capace di affrontare i problemi che già incombono su di noi. Quanti uomini dovrebbero stare sulla terra?

Che tipo di uomini dovrebbero essere? Come dovremmo dividerci lo spazio a disposizione? E' evidente che dovremo modificare le

nostre idee sulla procreazione. Oggi i figli sono concepiti per caso, un domani essi dovranno invece essere "composti" secondo

desideri e progetti ben ponderati. Inoltre, quando costruiremo i nuovi cervelli, non sarà obbligatorio che essi comincino a

funzionare, come i nostri, con conoscenze tanto scarse sul mondo. Quali cose dovrebbero sapere i "figli della mente"? Quanti

dovremmo produrne e chi dovrà decidere i loro attributi?

Si tratta di un’etica utilitaristica e progressista, basata sul rafforzamento cognitivo, piuttosto lontana dalle concezioni

solidaristiche ed ecumenistiche che si sono sviluppate, e con tanta fatica, di recente.

E non si può non sottolineare che dietro questo tipo di etica spunta l’immagine inquietante dell’eugenetica.

Conclude Minsky:

Una volta liberati dalle limitazioni della biologia, saremo in grado di decidere la durata della nostra vita – compresa l’opzione

dell’immortalità – e di scegliere altre capacità inimmaginabili. [...] Saranno i robot a ereditare la terra? Sì, ma essi saranno figli

nostri. Noi dobbiamo la nostra mente alla vita e alla morte di tutte le creature che in passato hanno affrontato quella lotta che si

chiama evoluzione. E' nostro compito vigilare perché tutta questa fatica non vada sprecata senza costrutto.

Al di là della domanda se questa prospettiva ci piaccia o ci sgomenti, resta naturalmente da vedere quale sia il senso

(per noi, uomini di oggi) di tutto ciò. Ma forse il problema del senso è uno di quegli antiquati problemi filosofici che

riguardano l'uomo vecchio e non avranno più senso, appunto, per il post-umano.

A chi dimostra perplessità nei confronti di questo scenario, Minsky risponde che è nostro preciso dovere morale

impegnarci a favore dello sviluppo della scienza e non della conservazione della situazione attuale.

Il sogno di Minsky è quello di tradurre la personalità dell’uomo in programmi da far girare su computer (non per nulla

egli è stato uno dei massimi esponenti dell’intelligenza artificiale), con la possibilità di potenziarli e aggiornarli

continuamente e, inoltre, di farne più copie.

Anche per il roboticista Hans Moravec il futuro dell’umanità sarà caratterizzato dall’abbandono del corpo e

dall’emigrazione nel ciberspazio, una realtà virtuale e insieme reale che offre possibilità illimitate di longevità e di

conoscenza. Questi ibridi superdotati si dedicherebbero alla ricerca e alla soluzione degli enigmi dell’universo. La

scienza pura sarà per Moravec l’unico scopo degno dell’esistenza degli uomini (o delle macchine?) superintelligenti, il

resto sarà insignificante:

Questo è il nucleo della mia fantasia: che i nostri discendenti non-biologici, senza la maggior parte delle nostre limitazioni, potranno

riprogettare se stessi, potranno perseguire la conoscenza basilare delle cose… Le cose come l’arte non sembrano molto profonde,

giacché sono primariamente modi di auto-stimolazione.

Queste considerazione si prestano naturalmente a valutazioni molto critiche da parte di chi ama l’arte, come molti di

noi.

Il passaggio dalla speculazione astratta alle possibilità pratiche di intervento ha acceso il dibattito, senza che vi sia un

prevalere assoluto del punto di vista razionale e scientifico.

La conoscenza è diventata azione, quindi siamo posti di fronte al rischio e alla responsabilità.

Per riassumere, le ambizioni dei post-umanisti sono:

• Superare i limiti fisici legati alla corporeità, alla senescenza e alle malattie

• Potenziare le capacità e le funzioni corpo-mentali e magari scoprirne di nuove

• (Ri)progettare la specie umana

• Attraverso tutto ciò attuare l’aspirazione alla felicità che da sempre anima

l’uomo.

È forse intorno al concetto sfuggente di felicità che si misura la portata rivoluzionaria del post-umano tecnologico più

spinto.

Un tempo si perseguiva la felicità cercando di condurre una vita buona e virtuosa accettando la fragilità e i limiti

dell’umano, in primo luogo la finitezza della vita terrena, salvo poi rinviare l’immortalità alla vita ultraterrena.

Nella prospettiva post-umana, la felicità si perseguirebbe tramite la realizzazione completa di ciascun individuo, cioè

tramite il superamento di tutte le limitazioni, la sconfitta di tutte le patologie e, alla fine, della morte stessa.

Questo percorso di miglioramento condurrebbe l’uomo alla vita e alla felicità perfette, prolungando così l’opera della

natura o, in chiave religiosa, collaborando fattivamente al compimento della creazione: la Creatura aiuta il Creatore.

Mi limiterò ad accennare alla costruzione del post-umano individuale, che può seguire due strade, quella che porta

alle creature ciborganiche e quella che porta ai robot.

In altri termini: o s’interferisce con la natura, correggendola e potenziandola (ciborg), oppure si imita la natura per via

affatto artificiale (robot).

La parola ciborg deriva dalla crasi di cibernetico e organico e indica gli esseri che scaturiscono dall’inserzione in un

organismo animale o, soprattutto, umano, di protesi artificiali: organi di senso, organi effettori e addirittura inserzioni

cerebrali e interfacce cervello-computer.

Il ciborg segna il passaggio dalla tecnologia diffusa intorno al corpo alla tecnologia insinuata nel corpo.

Il ciborg è una creatura mista, un simbionte di cibernetico e organico: si parte da un corpo e lo si inzeppa di protesi e

dispositivi artificiali: fino a che punto resta un essere umano e in base a quale criterio?

Viceversa il robot è creatura tutta artificiale: in un corpo artificiale si inserisce un’intelligenza artificiale e, un domani,

si collocheranno emozioni artificiali e magari una coscienza artificiale.

Il robot inoltre è caratterizzato, già ora, da una certa autonomia e da una certa capacità di apprendimento, che lo

rendono un candidato plausibile a un’evoluzione corpo-mentale di tipo sia umanoide sia alternativo all’umano.

L’evoluzione imitativa dell’umano potrebbe portare a macchine indistinguibili da noi per le funzioni (intellettuali,

attive, percettive, emotive...) anche se distinguibili per i materiali e in parte per la struttura e l'aspetto.

Si tratta comunque di precisare i meccanismi dell’evoluzione, che, almeno all’inizio, si presenterebbe eterodiretta e

fortemente finalizzata, a differenza di quella biologica e, in parte, anche di quella culturale, che sono intrise di

aleatorietà e contingenza. Mediante il riversamento delle nostre menti nelle intelligenze artificiali dei robot, secondo

la prospettiva dei “figli della mente” delineata da Minsky, i robot potrebbero raccogliere la nostra eredità e rientrare a

pieno titolo nella visione post-umana.

In conclusione, la vastità e la profondità delle implicazioni dell’avvento del post-umano ci obbligano a una riflessione

trasparente e non ideologica sul futuro prossimo e lontano dell’umanità, tenendo conto che le decisioni prese ora

potranno influire sul nostro destino, indirizzandolo verso direzioni che siamo in grado di controllare solo in piccola

parte.

Infatti la complessità del reale, in interazione con la complessità dei prodotti tecnologici, rende difficile se non

impossibile prevedere gli esiti a lunga scadenza delle nostre innovazioni.

La nostra capacità di agire ha superato di gran lunga la nostra capacità di prevedere le conseguenze delle nostre

azioni, che potrebbero essere diverse da (o addirittura contrarie a)le nostre intenzioni (eterogenesi dei fini).

Da ultimo accenno alla necessità che le innovazioni tecno-scientifiche non siano guidate solo dall’inventiva e

dall’ambizione dei ricercatori e dalla ricerca del profitto da parte delle aziende, ma siano vagliate anche alla luce dei

valori e delle aspirazioni della popolazione, evitando sia l’euforia tecnologica sia il rifiuto programmatico delle novità.

Bibliografia

1. Bonifati N. e Longo G. O., Homo immortalis, Springer, Milano, 2012.

2. Caronia A., Il cyborg, ShaKe edizioni, Milano, 2001.

3. Fukuyama F., L’uomo oltre l’uomo, Mondadori, Milano, 2002.

4. Haraway D., Manifesto cyborg, Feltrinelli, Milano, 1995.

5. Longo G. O., Homo technologicus, Ledizioni, Milano, 2012.

6. Longo G. O., L’etica al tempo dei robot, Mondo Digitale, VI, 1, n. 21, pagg. 3 –

20, marzo 2007.

7. Marchesini R., Post-human, Bollati Boringhieri, Torino, 2002.

8. Minsky M., Will Robots Inherit the Earth?, Scientific American, 271, 4, 1994.

9. Nowotny H. e Testa G., Geni a nudo, Codice edizioni, Torino, 2012.

10. Vaccaro A., L’ultimo esorcismo, EDB, Bologna, 2009.

11. Viola F., Umano e post-umano: la questione dell’identità, in Natura, cultura, libertà, a cura di F. Russo, Armando,

Roma, pagg. 89-98, 2010.

12. Human Enhancement. A Study, European Union, Directorate General for Internal Policies, Science and Technology

Options Assessment, 2009.