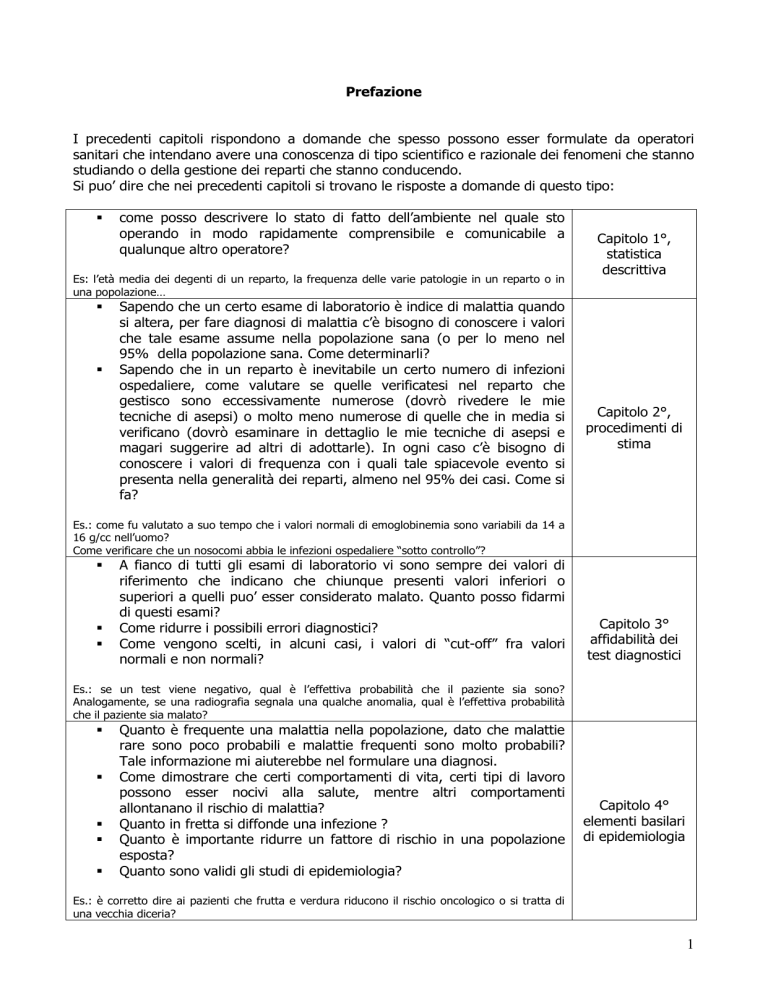

Prefazione

I precedenti capitoli rispondono a domande che spesso possono esser formulate da operatori

sanitari che intendano avere una conoscenza di tipo scientifico e razionale dei fenomeni che stanno

studiando o della gestione dei reparti che stanno conducendo.

Si puo’ dire che nei precedenti capitoli si trovano le risposte a domande di questo tipo:

come posso descrivere lo stato di fatto dell’ambiente nel quale sto

operando in modo rapidamente comprensibile e comunicabile a

qualunque altro operatore?

Es: l’età media dei degenti di un reparto, la frequenza delle varie patologie in un reparto o in

una popolazione…

Sapendo che un certo esame di laboratorio è indice di malattia quando

si altera, per fare diagnosi di malattia c’è bisogno di conoscere i valori

che tale esame assume nella popolazione sana (o per lo meno nel

95% della popolazione sana. Come determinarli?

Sapendo che in un reparto è inevitabile un certo numero di infezioni

ospedaliere, come valutare se quelle verificatesi nel reparto che

gestisco sono eccessivamente numerose (dovrò rivedere le mie

tecniche di asepsi) o molto meno numerose di quelle che in media si

verificano (dovrò esaminare in dettaglio le mie tecniche di asepsi e

magari suggerire ad altri di adottarle). In ogni caso c’è bisogno di

conoscere i valori di frequenza con i quali tale spiacevole evento si

presenta nella generalità dei reparti, almeno nel 95% dei casi. Come si

fa?

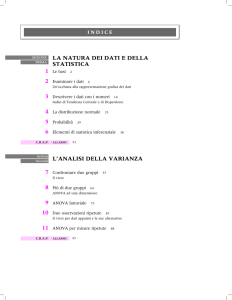

Capitolo 1°,

statistica

descrittiva

Capitolo 2°,

procedimenti di

stima

Es.: come fu valutato a suo tempo che i valori normali di emoglobinemia sono variabili da 14 a

16 g/cc nell’uomo?

Come verificare che un nosocomi abbia le infezioni ospedaliere “sotto controllo”?

A fianco di tutti gli esami di laboratorio vi sono sempre dei valori di

riferimento che indicano che chiunque presenti valori inferiori o

superiori a quelli puo’ esser considerato malato. Quanto posso fidarmi

di questi esami?

Come ridurre i possibili errori diagnostici?

Come vengono scelti, in alcuni casi, i valori di “cut-off” fra valori

normali e non normali?

Capitolo 3°

affidabilità dei

test diagnostici

Es.: se un test viene negativo, qual è l’effettiva probabilità che il paziente sia sono?

Analogamente, se una radiografia segnala una qualche anomalia, qual è l’effettiva probabilità

che il paziente sia malato?

Quanto è frequente una malattia nella popolazione, dato che malattie

rare sono poco probabili e malattie frequenti sono molto probabili?

Tale informazione mi aiuterebbe nel formulare una diagnosi.

Come dimostrare che certi comportamenti di vita, certi tipi di lavoro

possono esser nocivi alla salute, mentre altri comportamenti

allontanano il rischio di malattia?

Quanto in fretta si diffonde una infezione ?

Quanto è importante ridurre un fattore di rischio in una popolazione

esposta?

Quanto sono validi gli studi di epidemiologia?

Capitolo 4°

elementi basilari

di epidemiologia

Es.: è corretto dire ai pazienti che frutta e verdura riducono il rischio oncologico o si tratta di

una vecchia diceria?

1

Si tratta quindi di un primo nucleo di informazioni che doverosamente debbono far parte delle

competenze di tutti coloro che si occupano di salute.

Certamente queste informazioni non esauriscono la statistica medica né l’epidemiologia. Molte altre

sono le domande che un medico, giovane o anziano che sia, potrà porsi durante la sua carriera, sia

che si occupi di ricerca (e tutti i medici dovrebbero essere anche ricercatori almeno come

atteggiamento mentale, altrimenti si corre il rischio di diventare aridi burocrati) sia che si limiti a

aggiornare le proprie competenze sulla letteratura scientifica (che deve esser sempre letta non con

un atteggiamento acritico e fideistico nella carta stampata ma con l’occhio critico e attento di un

“addetto ai lavori”).

Nei capitoli che seguono si troverà l’aiuto per rispondere ad altre, non meno importanti domande:

Come esser ragionevolmente sicuri (almeno al 95%) del fatto che una

terapia riesca a salvare più pazienti di un’altra?

Come esser ragionevolmente sicuri (almeno al 95%) del fatto che una

popolazione esposta a certi rischi si ammali più di un’altra?

Come esser ragionevolmente sicuri (almeno al 95%) del fatto che una

terapia sia miglior di altre due o tre terapie possibili?

Es.: L’antibiotico A fa guarire più spesso dalla polmonite batterica rispetto all’antibiotico B?

In epidemiologia si studia spesso l’OR tra esposti e non esposti per

comprendere quanto un fattore di rischio sia patogeno. L’esito della

malattia però spesso non dipende soltanto da quel solo fattore di

rischio ma anche dalle condizioni del paziente (età giovane, media o

avanzata… lavoro sedentario o lavoro di fatica…)

Tavole di

contingenza

(oltre che OR,

RR, Rattribuibile,

tassi, già

esaminati al

capitolo 4)

OR secondo

Mantel Haenszel

Es.: Come depurare l’OR “grezzo” da questi fattori confondenti?

Come esser ragionevolmente sicuri (almeno al 95%) che la differenza

di variazioni di un certo esame di laboratorio indice di malattia che si

hanno con due terapie diverse siano imputabili ai diversi effetti

terapeutici e non al campionamento?

Come confrontare gli effetti positivi o gli effetti collaterali più di due

terapie?

Es.: l’antidiabetico X in media fa diminuire la glicemia di 30 mg%cc, mentre l’antidiabetico Y la

fa diminuire in media di 10. Pertanto X va usato nei diabetici più gravi e Y in quelli lievi?

Come esser ragionevolmente sicuri (almeno al 95%) che la differenza

di variazioni di un certo esame di laboratorio indice di malattia che si

hanno con una terapia nel corso di due controlli in tempi diversi siano

dovuti alla terapia e non al caso?

Come fare più di due confronti nel tempo?

Es.: la diminuzione di glicemia ottenibile con il farmaco Y è totalmente imputabile alla maggiore

efficacia del farmaco o, per errore, durante la precedente sperimentazione Y fu somministrato

ai diabetici meno gravi e più reattivi a una qualsiasi terapia?

Dimostrata l’efficacia di un farmaco, come si deve modulare la

posologia in funzione della gravità della malattia?

Es. quali dosaggi dare per ottenere un aumento di Hb di 2 gr: quali invece sono consigliati se è

necessario un aumento di 4 gr…

Spesso l’effetto di un farmaco non dipende soltanto dalla posologia ma

T di student per

dati non appaiati

o anova fattoriale

Mann Witney U

test o Kruskall

Wallis test

T di student per

dati appaiati o

anova per misure

ripetute

Wilcoxon test

Friedman test

Correlazione di

Pearson

Correlazioni non

parametriche

regressione

lineare semplice

Correlazione e

2

anche da altre variabili (ad es. l’età del paziente, il livello di linfociti,

….). Questa situazione si verifica sempre nella realtà in medicina.

Occorre valutare come si modifica l’effetto del farmaco anche in

presenza di variabili indipendenti dalla malattia.

regressione

lineare multipla

Correlazione

multipla di

Kendall

Es.: il tempo di guarigione da una malattia dipende dal dosaggio del farmaco, ma anche dall’età

del paziente, dalla misura della sua clearance renale, dal dosaggio degli enzimi epatici….?

Ci sono malattie non guaribili ma curabili. Tante volte in medicina il

successo è semplicemente un prolungamento della sopravvivenza o un

miglioramento della qualità di vita (più lunghi spazi di tempo liberi dal

dolore o dalle metastasi). Sotto questo importante aspetto, come

paragonare tra loro gli effetti di due o più diverse terapie?

Come depurare tali risultati da effetti confondenti quali età,

funzionalità epatica o renale ecc.?

Analisi di

sopravvivenza

Regressione di

Cox

Es.: nonostante due antiblastici differenti si verifica comunque una mortalità del 20%. Il fatto

che con l’antiblastico W la morte si verifichi dopo 3 anni di terapia e con l’antiblastico Z si

verifichi dopo 6 dipende soltanto dal tipo di tumore o dalla stadiazione o dall’età del paziente?

Nella realtà la presenza di una malattia o la sua assenza dipendono da

moltissimi fattori (alcuni si esprimono con scale di misura, altri con

scale ordinali e altri ancora con semplici modalità) Come capire quale

dei vari fattori è il più importante nel determinismo della malattia?

(significherebbe capire la eziopatogenesi della malattia nella sua

interezza!!!!)

Regressione

logistica

Es.: per prevenire, in un certo paziente, la cardiopatia ischemica è più importante abolire il

fumo o abbassare il livello di colesterolo?

Le variabili che possono influire su un evento clinico sono veramente

troppo numerose. Molte di loro interagiscono (esempio: consumo di

fumo e alcol spesso vanno di pari passo) Come sintetizzare alcuni di

questi fenomeni (esempio: eccesso di fumo + eccesso di alcool =

errato stile di vita)?

Analisi fattoriale

Es.: come comprendere meglio le interazioni tra i vari determinanti delle malattie?

Spesso gli studi clinici su nuovi farmaci portano a risultati contradditori

(questo è dovuto al fatto che raramente i nuovi farmaci sono così

potenti quanto lo fu all’epoca la penicillina e per scoprire piccole

differenze di esito occorrono enormi numerosità campionarie. Resta il

fatto che magari per una decina di anni i medici devono decidere se

utilizzare o meno un dato farmaco e spesso sono nel dubbio né

possono passare tutto il loro tempo a leggere tutti i lavori

sull’argomento (ivi inclusi quelli scritti in giapponese, in tedesco, in

spagnolo, in cinese….). Esiste il modo di avere una sorta di “riassunto”

dei dati della letteratura che serva almeno temporaneamente a non

perdere la bussola… ovviamente senza avere una fede cieca nei

risultati e accettandoli salvo prova contraria?

Metanalisi

Es.: Il grande clinico Tizio asserisce che il farmaco Q è inutile. L’altrettanto illustre clinico Caio

asserisce il contrario. Come si deve comportare un meno illustre ma altrettanto importante (per

i suoi pazienti) medico di base?

Naturalmente non si esaurisce con questo lo strumentario possibile in statistica medica ed

epidemiologia! Tanti altri strumenti verranno messi a punto nei prossimi anni. Ci si augura che

questo testo possa essere almeno propedeutico a comprendere anche tutti gli altri metodi che

verranno o che sono attualmente impiegati.

3

Capitolo 1: Test di ipotesi tra informazioni in scala nominale o ordinale

Uno dei problemi che più facilmente il medico si trova a dover affrontare è valutare se

un certo trattamento migliora le condizioni dei malati che vi si sottopongono in

maniera statisticamente significativa.

È importante che tale differenza sia basata sull'evidenza (evidence based), cioè sull'esperienza

effettuata da altri e valutata in base all'esame sistematico della letteratura scientifica o in base alla

propria esperienza parimenti valutata in maniera statisticamente ineccepibile.

A tale problema si puo' trovare soluzione impostando una sperimentazione sui pazienti ammalati di

una data patologia trattati con diverse tecniche terapeutiche (qualsiasi esse siano: chirurgiche,

farmacologiche, psicologiche) o sottoposti a diversi iter diagnostici (per verificare quale di essi dia

risultati più soddisfacenti) o a diversi programmi di follow up (per verificare in quale caso si

abbiano minor recidive). Generalmente si paragonano una nuova e una vecchia tecnica o una

nuova tecnica e un placebo, quando è eticamente possibile.

Un esempio pratico puo' essere dato dalla comparazione dell'effetto di un antibiotico nuovo (A)

rispetto a un vecchio farmaco (B) su pazienti ammalati di broncopolmonite di origine batterica

Ecco i passi principali da compiere:

trovare un campione sufficientemente numeroso di pazienti disponibili a dare il loro

consenso informato alla sperimentazione

stabilire a priori con chiarezza l'obiettivo della sperimentazione:

ottenere la guarigione clinica (guariti/non guariti), ottenere un miglioramento (ottimo,

buono, discreto, lieve, sufficiente, invariato), ottenere la risoluzione radiologica della

broncopolmonite (sì/no)…..

stabilire la probabilità ritenuta accettabile di sbagliare dicendo che A non è uguale a B

(ma è migliore o peggiore). Questo tipo di errore viene detto errore alfa e di solito lo

si accetta al 5%=0,05 di probabilità.

stabilire la probabilità ritenuta accettabile di sbagliare dicendo che A non è né migliore

né peggiore di B nel particolare contesto. Questo tipo di errore viene detto errore beta

e di solito lo si accetta al 10%=0,10. Un errore beta di 0,10 corrisponde a una potenza

dello studio del 90%=0,9.

Potenza dello studio o del test è la probabilità di rilevare differenze quando vi sono.

nell'ambito del campione che ha dato il consenso informato si deve assegnare in modo

probabilistico (casualmente) il trattamento con il nuovo antibiotico (A) o con il vecchio

antibiotico (B) a due gruppi più o meno equivalenti di pazienti.

nell'essere umano sono spesso molto sfumati i confini tra reazioni biologiche e psichiche, per

tale motivo, al fine di evitare influenze inconsce sugli esiti del trattamento, si applica il

trattamento in modo che né il medico né il paziente sappiano con esattezza si sta usando il

farmaco A o il B: le scatole dei farmaci infatti sono contrassegnate soltanto da un numero di

codice. Questo metodo viene detto "in doppio cieco".

In un apposito registro, che né il medico né il paziente devono vedere fino alla fine

dell'esperimento, è indicato il tipo di farmaco che corrisponde a quel numero, il momento in cui

è stato prodotto, la scadenza ecc.

Si effettua la terapia per il tempo prescritto

4

Si constata l'effetto avuto nei vari pazienti e soltanto a questo punto si puo' consultare il

registro e sapere quale paziente ha preso il farmaco A e quale ha preso il farmaco B

Verosimilmente sia con il farmaco A che con il B alcuni pazienti saranno guariti e altri no.

Si costruisce una tabella di contingenza.

In italiano contingenza significa possibilità di essere o di non essere (Devoto Oli). Quando

si parla di quota contingente in termini giuridici si intende la quota spettante (senza ingiustizie,

cioè senza differenze) a ciascun individuo o gruppo …

Uno schema di questo tipo: due trattamenti con due diversi possibili esiti puo’ esser raffigurato in

questa maniera:

A

C

B

D

Se non vi fosse differenza tra i due trattamenti riguardo i loro risultati, dovremmo aspettarci che i

pazienti fossero quasi equidistribuiti nei vari gruppi in questo modo (tutti grigi):

A

C

B

D

Se invece uno dei due trattamenti fosse notevolmente più efficace dell’altro. dovremmo aspettarci

che i pazienti non fossero affatto equidistribuiti, così come schematizzato qui sotto (una casella

nero intenso e per compensazione, una bianca):

A

C

B

D

Perché i due trattamenti si possano definire “non uguali” occorre:

1. che vi sia differenza

2. che tale differenza sia tanto grande da divenire statisticamente significativa

Per prima cosa si riporta la situazione effettivamente accaduta, cioè le quote osservate.

Trattamento

A

B

Totale

Non guariti

60

40

100

Guariti

40

60

100

Totale

100

100

200

I termini del problema devono esser posti in maniera chiara e univoca a priori (prima ancora di

iniziare la ricerca).

5

Sono possibili teoricamente due situazioni:

effetti di A = effetti di B

effetti di A<effetti di B in modo

non significativo

effetti di B<effetti di A in modo

non significativo

effetti di A<effetti di B in

modo significativo

effetti di B<effetti di A in

modo significativo

quindi

quindi

ipotesi nulla molto probabile

ipotesi alternativa poco probabile

ipotesi alternativa molto probabile

ipotesi nulla poco probabile

Differenza non significativa sta per differenza che puo' essersi verificata anche

soltanto per effetto del campionamento e che erroneamente possa venire attribuita

all'effetto del farmaco.

TUTTI I PIÙ COMUNI TEST STATISTICI MISURANO

IL LIVELLO DI PROBABILITÀ DELL'IPOTESI NULLA.

QUANTO TALE PROBABILITÀ SIA BASSA (p<0,05),

ALLORA SI è AUTORIZZATI AD ACCETTARE L’IPOTESI ALTERNATIVA

Osservando i dati raccolti nell’esempio, la prima impressione è che il trattamento B sia il migliore,

ma la statistica richiede una valutazione non impression based, ma evidence based.

Nell'assegnare random i trattamenti, potrebbe esser capitato per caso che abbiano preso il

farmaco A tutte le persone più gravi o più defedate. In altri termini, potrebbe esser stato

soltanto il caso a dare l'impressione di una maggior efficacia dell'antibiotico B.

6

Chi quadro di Pearson

Come misurare la probabilità che la differenza osservata sia dovuta soltanto al caso, cioè la

p(H0)?

Con un test inventato da Pearson a metà del secolo scorso e che è alla base di numerosissime

altre valutazioni statistiche: il chi quadro (2).

Data questa situazione osservata sperimentalmente:

Trattamento

A

B

Totale

Non guariti

60

40

100

Guariti

40

60

100

Totale

100

100

200

Se i due farmaci fossero equivalenti, le quote contingenti dovrebbero essere ripartite

in modo equivalente!

Nell'esperimento sopradescritto la probabilità di esser ancora malato dopo aver preso l'antibiotico

(qualunque esso sia) è:

Pmalato

60 40 100

0,5

200

200

La frequenza, cioè la probabilità empirica di aver preso l'antibiotico A è:

PA

60 40 100

0,5

200

200

La probabilità di essere e non guarito e trattato con antibiotico A è pari alla intersezione delle due

probabilità:

Pmalato

PtrattatoA 0,5 0,5 0,25

La quota contingente (spettante quando non vi sono differenze) per i non guariti trattati con

antibiotico A dovrebbe essere pari al 25%=0,25 del campione di 200 persone esaminate.

Analogo procedimento per:

guariti con antibiotico A

non guariti trattati con antibiotico B

guariti con antibiotico B.

Le quote contingenti attese sotto ipotesi che i due farmaci non siano diversi tra loro

sono:

7

Trattamento

A

B

Totale

Non guariti

50

50

100

Guariti

50

50

100

Totale

100

100

200

Quanto è grande la differenza tra le due tabelle di contingenza, quella osservata

nell'esperimento e quella ipotizzata sotto condizione che i due farmaci non abbiano

diversi effetti?

Secondo Pearson si puo' misurare tale differenza con questa formula:

2

( f osservat e fattese )2

f attese

Ove per frequenze (assolute) attese e osservate si intendono le frequenze (assolute) contingenti

osservate e attese nelle 4 caselle corrispondenti a:

ancora malati trattati con antibiotico A

guariti con antibiotico A

ancora malati trattati con antibiotico B

guariti con antibiotico B.

Nel nostro caso:

2

60 502

50

40 502

50

60 502

50

40 502

50

4

100

8

50

2=8 che è secondo Pearson la misura della differenza tra la tavola di contingenza ‘osservata’ e

quella ‘attesa’ se i due farmaci sono equivalenti. Puo' ritenersi una grande differenza o no?

Si puo' stabilire se è grande o no soltanto se si ha una misura di riferimento.

In questo caso la misura di riferimento è la distribuzione di probabilità del chi quadro di

seguito riportata:

8

La curva tende asintoticamente sia all'asse delle y che all’asse delle x. Sono riportati tutti i possibili

valori che il chi quadro puo' assumere per caso in un disegno di ricerca analogo a quello sopra

indicato (due trattamenti e due esiti).

L'area sottesa dalla curva, ovviamente, vale 1=100% di probabilità, perché comprende tutti i valori

che teoricamente si posson verificare per caso. Vale la pena di notare che il massimo di probabilità

si ha per 2=0, quando i valori osservati siano identici ai valori attesi.

Man mano che il valore del chi quadro cresce, la probabilità che quel valore si verifichi per caso

(ipotesi nulla) diminuisce.

Il valore 3,84 del 2 viene detto valore critico della funzione discriminante, perché in un

disegno sperimentale come quello sopra descritto, un valore di chi quadro > 3,84 ha una

probabilità di verificarsi per puro caso < 5% che è come dire: p <0,05.

Un valore di chi quadro >6,63 si ottiene per caso in un disegno di quel tipo con una probabilità

inferiore all'1%, come dire p <0,01

In questo studio, avendo scelto un livello di probabilità di errore alfa = 0,05 si puo' dire che il

farmaco B è migliore di A in modo s.s. (=statisticamente significativo), con p<0,05, cioè probabilità

di affermare il falso inferiore al 5%.

9

Tavole di contingenza

Non sempre gli studi sono così semplici: molte volte si cerca di paragonare 3 diversi farmaci (A, B

e C) e,magari, di considerare 3 diversi esiti (guarito, migliorato, invariato).

Non cambia però l’intimo meccanismo del test: uno schema di questo tipo: due trattamenti con tre

diversi possibili esiti puo’ esser raffigurato in questa maniera:

A

D

G

B

E

H

C

F

I

Se non vi fosse differenza tra i due trattamenti riguardo i loro risultati, dovremmo aspettarci che i

pazienti fossero quasi equidistribuiti nei vari gruppi in questo modo:

A

D

G

B

E

H

C

F

I

Se invece uno dei due trattamenti fosse notevolmente più efficace dell’altro. dovremmo aspettarci

che i pazienti non fossero affatto equidistribuiti, così come schematizzato qui sotto:

A

D

G

B

E

H

C

F

I

Per dire che i trattamenti non sono uguali occorre:

che vi sia differenza in almeno un trattamento

che tale differenza sia tanto grande da divenire statisticamente significativa

Siano, ad esempio, queste le quote contingenti osservate:

Trattamento

A

B

C

Totale

Invariati

100

50

75

225

Migliorati

150

200

200

550

Guariti

50

50

25

125

Totale

300

300

300

900

Il modello è più complesso del precedente, ma il metodo è identico. Si calcolino:

300

0, 3

900

225

0,25

Probabilità di esser rimasti invariati dopo una qualsiasi terapia: pin variati

900

550

0,61

Probabilità di esser migliorati dopo una qualsiasi terapia: pmi gl iorat i

900

125

0,138

Probabilità di esser guariti dopo una qualsiasi terapia: pguari ti

900

Probabilità di aver effettuato il trattamento A o B o C: p A p B pC

10

Con le opportune intersezioni, si riempiano le caselle del disegno dello studio:

Trattamento

Invariati

Migliorati

Guariti

A

0, 3 0,25

0, 3 0,6 1

0, 3 0,138

B

0, 3 0,25

0, 3 0,6 1

0, 3 0,138

C

0, 3 0,25

0, 3 0,6 1

0, 3 0,138

Basta moltiplicare i prodotti delle probabilità qui sopra indicate per 900 e si ottengono le quote

contingenti attese sotto ipotesi che i tre farmaci non agiscano in modo diverso (le cifre sono

approssimate per via dei decimali):

Trattamento

A

B

C

Totale

Invariati

75,0

75,0

75,0

225

Migliorati

183,2

183,2

183,2

549,6 550

Guariti

41,8

41,8

41,8

125,4 125

Totale

300

300

300

900

Si applica la solita formula, ma gli addendi non sono più 4 come nell'esempio precedente, sono

tanti quante le caselle, cioè 9.

2

75 100 2

75

183,2 1502

183,2

41,8 502

41,8

75 50 2

75

75 752

183,2 2002

183,2

41,8 50 2

41,8

75

183,2 2002

183,2

41,8 252

41,8

8, 3 8,3 0 6,02 1,5 1,5 0,4 0,4 6,8 33,22

Il tipo di studio appena descritto è differente dal primo illustrato in questo capitolo.

Nel primo, avevamo 2 trattamenti e 2 esiti: si trattava quindi di una tabella di contingenza

cosiddetta 2 2 ; nel secondo studio, abbiamo a confronto 3 trattamenti con 3 possibili esiti: si

tratta di una tabella di contingenza cosiddetta 3 3 .

Il valore 33,22 di chi quadro va confrontato con una distribuzione leggermente diversa (non deve

meravigliare più di tanto che si utilizzi uno strumento di misura: il peso dei neonati, degli adulti,

dei carichi dei camion o dei carichi delle navi non si valutano certamente con le stesse bilance!).

Questa sotto indicata è una curva distributiva del chi quadro adatta a una tavola di contingenza

3 3 .

11

In un disegno 3 esiti e 3 trattamenti, infatti, i possibili valori del chi quadro che si verificano per

caso sono differenti da quelli che si hanno nel modello due esiti e due trattamenti.

La curva della probabilità cumulativa si modifica e diventa sempre più gaussiana man mano che

aumentano i trattamenti e i possibili esiti.

La forma della curva distributiva e i valori critici della funzione discriminante (chi quadro) cambiano

a seconda dei gradi di libertà. Nell'esempio appena citato (tre trattamenti e tre esiti) i gradi di

libertà sono 3 1 3 1 4 .

12

I gradi di libertà sono il numero di variazioni indipendenti che puo' avere un insieme di

misure o di modalità. Il motivo non è banale, ma si puo’ dare la seguente spiegazione intuitiva:

Trattamento Invariati Migliorati Guariti

A

0, 3

B

0, 3

C

?????

0,25

0,61

?????

Nelle nove caselle qui sopra, i casi si possono disporre in moltissimi modi diversi, fintanto

che non si utilizzano i valori osservati per fare una stima della probabilità di subire il

trattamento A o B o C.

Dato che si stima che il trattamento A abbia probabilità di essere applicato =

0, 3 e il

Soltanto 0, 3 …

trattamento B = 0, 3 , quale sarà la probabilità di subire il trattamento C?

altrimenti la somma non farebbe 1.

La libertà di variazioni indipendenti tra i tre trattamenti, quindi non è 3, ma 2!

Analogo il discorso per gli esiti: avendo stimato gli invariati al 25%, cioè 0,25 di probabilità,

che per i migliorati sale allo 0,61 , quale potrà mai essere la probabilità di guarire, se non il

complemento a 1 della somma di queste due? Anche in questo caso la libertà di variazioni

indipendenti fra i tre esiti non è 3, ma 2.

In generali, i gradi di libertà (GL) di un test del chi quadro sono sempre così

calcolati:

GL = (N° colonne tabella di contingenza -1) (N° righe tabella di contingenza 1)

Il motivo di quel segno di moltiplicazione, invece, non dovrebbe esser difficile da ricordare:

essere trattato con un certo farmaco e, contemporaneamente, ottenere un certo esito, non

dà forse luogo a una intersezione di probabilità (regola del prodotto)?

Il test ci permette di stabilire che non vi è una uguaglianza tra i tre trattamenti

riguardo l'esito.

Più complesso è stabilire quale sia il trattamento migliore: per individuarlo, bisogna

considerare quale è la casella che ha la massima differenza tra valori osservati e valori

attesi.

Nel caso in esame, il farmaco C appare il meno soddisfacente, infatti fa guarire soltanto 25 pazienti

contro i 42 attesi.

I farmaci A e B fanno guarire molti più pazienti di quanti ci si aspetterebbe, infatti sono 50 pazienti

ognuno rispetto ai 42 attesi

Tra A e B pare migliore il B, perché fa migliorare 200 pazienti contro i 183 attesi (contrariamente al

farmaco A che fa migliorare meno persone di quante ci si aspetterebbe, cioè 150 contro 183)

Di seguito sono riportati alcuni valori critici della funzione discriminante del chi quadro per p<0,05

e p<0,01 a seconda dei gradi di libertà:

13

Gradi di libertà P<0,05 P<0,01

1

3,84

6,63

2

5,99

9,21

3

7,81

11,34

4

9,49

13,28

5

11,07

15,09

6

12,57

16,81

CONTROINDICAZIONI ALL’USO

Vi sono alcune avvertenze da tener presente per l’utilizzo del test 2, legate soprattutto alla

numerosità campionaria.

Quando n<20, e GL <2, è opportuno applicare la correzione di Yates.

2

( f osservate f attese 0,5) 2

f attese

Da un punto di vista strettamente matematico non sarebbe corretto indicare il valore assoluto

f osservate f attese , perché il teorema di Yates prevede una correzione fissa (sia che le frequenze

osservate siano maggiori delle attese sia che siano inferiori alle attese). In biologia e in medicina,

però, si preferisce utilizzare questo accorgimento , che è un banale accorgimento per rendere più

conservativo (meno facilmente s.s.) il test, proprio in considerazione della scarsa numerosità:

riducendo il numeratore in tutti gli addendi logicamente il valore del chi quadro si abbassa.

Quando in una casella vi è anche un solo valore atteso <5, conviene usare un test ben più

difficile da spiegare, il test esatto di Fisher.

Generalmente i software statistici riportano la correzione di Yates ed il calcolo del test di Fisher in

modo automatico in caso di tabelle 2x2.

14

Test esatto di Fisher

Il test di Fisher si basa sulla distribuzione binomiale e sulla probabilità condizionata di

avere una certa situazione di frequenze osservate "dati costanti i valori marginali di

una tavola di contingenza", secondo questa formula:

P

R1!R2 !C1!C2 !

N!a!b!c!d!

Gli elementi della formula sono indicati nella tavola di contingenza qui sotto riportata.

Evento +

Evento -

Trattamento +

a

c

C1

Trattamento B

D

C2

R1

R2

N

Eseguire manualmente il test esatto di Fisher non è proprio cosa semplice, comunque:

Si calcola una volta per tutte

R1!R2 !C1 !C2 !

, che è costante.

N!

Sperando di non complicare inutilmente il discorso, si ricorda che il numero di combinazioni

(cioè dei gruppi di n elementi che si possono combinare in modo che siano diversi almeno

per un elemento considerando che ci debbano esser determinati marginali di riga e di

colonna) sarebbe

N!

R1 ! R2 !C1!C2 !

Si sceglie la casella con la numerosità minore (poniamo sia a)

Si considerano tante tavole di contingenza:

con a = 0

con a = 1

………..

con a = a, valore osservato nella realtà

con a sempre crescente, fino a che diventi a=C1 , che è il massimo valore possibile

(visto che C1 deve essere costante, per a = C1 si avrà c=0)

Per ogni tavola di contingenza si calcola la probabilità che si verifichi casualmente la situazione

osservata in funzione delle possibili variazioni di a (che puo’ esser al minimo =0 e, al massimo

= C1, quando c sia =0)

Per ogni combinazione si calcola il corrispondente valore di probabilità

La somma delle varie probabilità deve fare ovviamente 1, se si sono considerati tutti i valori di

a teoricamente possibili.

15

Poniamo siano questi i valori di probabilità ritrovati con C1=9, “a” potrà variare tra 0 e 9 e nei

vari casi l’ipotesi nulla avrà questa probabilità:

possibili valori di a

Probabilità della combinazione Probabilità cumulativa code

a=0, quindi c= C1

0,0046

a=1

0,0339

a=2

0,1110

a=3

0,2119

a=4

0,2600

a=5

0,2128

a=6

0,1160

a=7

0,0407

a=8

0,0083

a=9, quindi c=0

0,0008

Probabilità cumulativa

1

0,0385

0,0091

0,0476

Si valuta, per tentativi (fatti dal calcolatore) il limite delle due code con p cumulativa simile a

0,05 (area grigia)

Se la nostra particolare combinazione si trova all'esterno dei limiti, è significativa, altrimenti no

Per semplificare ulteriormente, di potrà accettare l’ipotesi alternativa quando: a=0, a=1, a=8 o

a=9

Questo tipo di test è più conservativo del chi quadro, ma è il solo idoneo a piccoli campioni.

0,3

0,25

0,2

0,15

0,1

0,05

0

a=0

a=1

a=2

a=3

a=4

a=5

a=6

a=7

a=8

a=9

16

Calcolo della numerosità campionaria richiesta

Vale la pena di soffermarsi un momento su questa situazione generale, che vale per tutti i test

statistici.

I test statistici sono un tentativo di misura della probabilità di eventi, non danno certezze.

Sono sempre possibili teoricamente due situazioni:

NEL CASO CHE L’IPOTESI ALTERNATIVA SI RIVELI FALSA

test con p<0,05

test con p>0,05

Errore di 1° tipo o errore

alfa accettato con

p<0,05 e lo si commette

Errore di 1° tipo o errore

Confidenza

nell'ipotesi

alfa accettato con p<0,05 e

alternativa p<0,95

non lo si commette

Ipotesi alternativa Confidenza

nell'ipotesi

accettata

alternativa p>0,95

Ipotesi nulla

accettata

L'errore alfa o errore di primo tipo è quello che si commette credendo vera l'ipotesi

alternativa, che invece è falsa

NEL CASO CHE L’IPOTESI ALTERNATIVA SI RIVELI VERA

test con p<0,05

test con p>0,05

Errore di 1° tipo o

Confidenza

nell'ipotesi errore alfa accettato

Ipotesi alternativa accettata

alternativa p>0,95

<0,05 e non lo si

commette

Errore di 1° tipo

non si commette,

Confidenza

nell'ipotesi

Ipotesi nulla accettata

ma si commette

alternativa p<0,95

l'errore di 2° tipo

o errore beta

n

L'errore beta o errore di secondo tipo è quello che si commette credendo vera l'ipotesi

nulla, che invece è falsa

Qualsiasi decisione si prenda, dunque, si puo' sempre sbagliare.

Gli errori più frequenti sono imputabili a

un campione scelto in maniera "viziata"

un campione non sufficientemente numeroso

La numerosità minima indispensabile del campione va valutata di volta in volta e stabilita in

funzione:

a. del tipo di fenomeno che si valuta

17

b.

c.

d.

e.

della minima differenza che abbia una qualche rilevanza clinica

della variabilità del fenomeno in relazione ad eventuali errori di stima

dell'errore di 1° tipo che si accetta in funzione dell'importanza della ricerca

dell'errore di 2° tipo che si accetta in funzione dell'importanza della ricerca

Si devono fare le seguenti considerazioni, punto per punto:

a.

Il tipo di fenomeno che si valuta in un chi quadro è sempre una modalità o categoria

(guarito/non guarito).

b.

Se finora con i vecchi trattamenti guarivano circa il 40% delle persone, quando ci si dichiara

soddisfatti della differenza con nuovi trattamenti? Per una guarigione di almeno il 50% dei

trattati, di almeno il 51%, di almeno il 55% dei trattati? È il ricercatore medico a stabilire

questo sulla base delle sue competenze. Poniamo che si consideri significativo un

miglioramento in termini di guarigioni del 2%=0,02

c.

Quanto puo' essere imprecisa la stima del fenomeno? Dipende dall'errore standard della

stima della frequenza media. Se finora erano guariti circa il 40% dei pazienti (limiti di

confidenza compresi tra 35% e 45%).

Questo significa che l'errore standard di tale frequenza (dal 35 al 45%) sarà:

e.s. f

d.

e.

LCS 95% LCI 95% 0,45 0,35

2 1,96

2 1,96

0,1

0,0255

2 1,96

L'errore alfa che si accetta ha di solito p=0,05, ma puo' variare a giudizio del ricercatore

medico

L'errore beta che si accetta ha di solito p=0,1, che corrisponde a una potenza dello studio

di 0,9, cioè del 90%, ma puo' variare a giudizio del ricercatore medico. Se una ricerca fosse

molto costosa o anche pericolosa (a volte si prevede per tutti i pazienti arruolati una

angiografia o una biopsia!), occorrerebbe prevedere una potenza molto alta.

A questo punto si è in grado di prevedere il numero minimo indispensabile di persone da

coinvolgere nello studio utilizzando questi valori fissi in funzione di alfa e beta scelti:

f ,

10,8

13,5

15,8

17,8

8,6

10,5

13

14,9

6,2

7,9

10

11,7

2,7

3,8

5,4

6,6

Basta applicare questa formula:

e.s.2f

0,0255 2

n 2 2 f , 2

10,5 2 1,6255 10,5 34,1355 36

0,02 2

Con circa 36 persone suddivise tra due gruppi, si è certi di avere una numerosità sufficiente per

prendere una decisione utilizzando il minor numero di dosi di farmaco, di risorse umane e

strumentali.

18

Volendo discriminare una differenza di effetto più piccola, ad esempio dell'1%, si avrebbe:

n 2

e.s.2f

2

f , 2

0,0255 2

10,5 2 6.502 10,5 136,542 138

0,012

Volendo discriminare una differenza di effetto più grande, ad esempio del 4%, si avrebbe:

n 2

e.s.2f

2

f , 2

0,0225 2

10,5 2 0,406 10,5 8,53 10

0,04 2

In fondo è logico: è più facile vedere una montagna che un sassolino!

Da tale impostazione si puo’ rilevare a priori il numero minimo di soggetti da inserire

nello studio (ed è importantissimo per motivi di economia di tempo, denaro, risorse

umane, stress ai pazienti). Esistono comunque programmi o siti internet che

consentono di calcolare il numero minimo indispensabile fornendo le informazioni

predette.

I soggetti dovranno poi esser scelti in modo da non inficiare la ricerca, specificando quali criteri

hanno portato alla loro inclusione nello studio e evitando di poter influire sui risultati dello studio

stesso, ad esempio assegnando i farmaci in doppio cieco.

Generalmente i programmi di statistica in commercio applicano automaticamente la correzione di

Yates se necessaria e avvertono se in una delle caselle della tavola di contingenza si ha un valore

atteso <5. Qualora ciò accadesse,

se biologicamente, clinicamente razionalmente possibile senza modificare gli scopi e

l’impostazione della ricerca, conviene raggruppare i casi in modo meno dettagliato,

aumentando così la loro numerosità (gli statistici puri non sarebbero d’accordo: ogni

decisione presa a posteriori è un arbitrio)

applicare il test esatto di Fisher

19

Riassumendo, quando si debba verificare il diverso effetto di due o più terapie (dati non appaiati)

su parametri espressi in scala nominale o ordinale, occorre:

A PRIORI

Impostare il quesito (ipotesi nulla e ipotesi alternativa)

Valutare la differenza (di frequenza di guarigioni, ad esempio) definita come clinicamente

significativa, l’errore alfa e l’errore beta che si accetta (potenza dello studio)

Calcolare il numero minimo di soggetti da campionare

Decidere i criteri di inclusione e di esclusione dallo studio (eccessiva gravità della situazione

clinica, età…)

Ottenere il consenso informato dai pazienti selezionati

Assegnare in modo randomizzato e, ove possibile, in doppio cieco, i vari trattamenti

Effettuare le misure

A POSTERIORI

Verificare se, dati i valori marginali osservati, anche in una sola casella della tavola di

contingenza si abbia una frequenza attesa <5

Studio per dati non

appaiati

Modalità o valutazione ordinale

Con frequenze assolute >5

nelle varie caselle

2 di Pearson

Modalità o valutazione ordinale

Con frequenze assolute < 5 anche in

una sola casella

Test esatto di Fisher

20

Chi quadro di Mc Nemar

Meno frequentemente puo’ capitare di effettuare valutazioni di modalità o valutazioni ordinali per

dati appaiati.

Immaginiamo ad esempio di effettuare un intervento di educazione sanitaria in una popolazione

con determinate abitudini di vita (ad esempio con un 25% di fumatori cronici).

Dopo

qualche tempo dall’intervento potranno accadere le seguenti situazioni:

alcuni fumatori continueranno a fumare nonostante l’intervento

alcuni fumatori smetteranno di fumare (segno di grande successo dell’intervento)

alcuni non fumatori, disturbati da un intervento espresso in termini poco accattivanti

potranno iniziare a fumare (segno di grande insuccesso dell’intervento)

alcuni non fumatori continueranno a non fumare.

L’efficacia o meno dell’intervento effettuato non va misurata su coloro che non hanno mutato le

proprie abitudini, ma sulle persone che dopo il nostro intervento si sono comportati diversamente

da come facevano prima (proprio per verificare se siano di più coloro che hanno seguito i buoni

consigli rispetto a quelli che, per reazioni, hanno iniziato ad avere comportamenti nocivi alla

propria salute).

Della tavola di contingenza che si puo’ costruire con i dati osservati, quindi, interessano soltanto

due caselle su quattro:

PRIMA

DOPO

Non fumatori

Fumatori

Fumatori

18000

2000

20000

Non fumatori

7000

73000

75000

80000

100000

25000

E precisamente le caselle che indicano che 7000 persone delle 250000 che prima fumavano hanno

smesso di fumare, mentre 2000 che precedentemente non fumavano si sono messe a fumare.

Pare che si sia avuto un guadagno verso le buone abitudini di vita… ma è un guadagno

sufficientemente grande per poter dire che il cambiamento di abitudini sia imputabile all’intervento

e non rientri nella variabilità del caso?

Se l’intervento fosse stato del tutto inutile (non efficace né in positivo né in negativo), le 9000

persone che hanno cambiato abitudine dovrebbero esser distribuite equamente nei due gruppi

(9000/2=4500). Il che significa che i valori attesi sotto ipotesi nulla sono in questo caso:

PRIMA

Fumatori

DOPO

4500

Fumatori

Non fumatori

Non fumatori

4500

A questo punto si applica la solita formula del chi quadro (con correzione di Yates) soltanto alle

caselle delle coppie “discordi” (coloro che hanno cambiato abitudine):

21

2

McNemar

2

2

2000 4500 0,5 7000 4500 0,5

1388,9 1388,9 2777,8

4500

4500

Per un grado di libertà, la distribuzione del chi quadro indica una significatività elevatissima.

Qualora i controlli fossero più di 2, è possibile con alcuni software calcolare il cosiddetto chi quadro

per trend, che consente di valutare se in più tempi diversi la variazione della prevalenza di

determinate abitudini o di certe malattia cambi in modo statisticamente significativo.

Il test per trend è una applicazione dell’OR secondo Mantel Haenszel e si puo’ trovare qui

l’occasione per approfondire questo argomento a completamento del capitolo 4° della prima parte

del testo.

L’OR secondo Mantel Haenszel è stato studiato per “depurare” un OR grezzo da

eventuali fattori confondenti

Pare accertato che il rischio di cardiopatia ischemica sia maggiore in chi abbia un livello sierico di

catecolamine superiore alla norma. Immaginiamo dei dati di fantasia:

Cardiopatia

ischemica

Non cardiopatia

ischemica

Catecolamine alte

Catecolamine

basse

27

44

71

95

443

538

122

487

609

Una simile situazione prevede: OR=2,86 e 2=14,98 con p<0,001

È verosimile che tale rischio non sia influenzato anche dall’età del paziente (superiore o inferiore a 55

anni, ad esempio) o dalla presenza di una qualche alterazione della ripolarizzazione verificabile all’ECG?

Il sospetto che l’età e pregresse alterazioni dell’ECG influenzino il rischio è del tutto giustificato e

verosimile. La tecnica di Mantel Haenszel consiste nel valutare l’OR grezzo nei 4 possibili sottogruppi:

età <55 a.; ECG normale

età < 55 a.; ECG alterato

età >=55 a.; ECG normale

età >= 55 a.; ECG alterato

Nel gruppo teoricamente più “a rischio”, quello con età >= 55 a. ed ECG alterato immaginiamo che si

abbia una numerosità ovviamente inferiore e una situazione di questo tipo:

Catecolamine alte

Catecolamine basse

Cardiopatia ischemica

14

5

19

Non cardiopatia ischemica

44

27

71

58

32

90

Una simile situazione prevede: OR=1,72 e 2=0,46 con p<0,5 quindi non significativo (probabilmente

per errore beta da ridotta numerosità campionaria)

Qualora i 4 OR grezzi fossero molto diversi tra loro, si puo’ supporre che età e ECG pregresso siano

fattori confondenti molto importanti e la tecnica di Mantel Haenszel si imporrebbe… ma la si puo’

comunque adottare per amore di precisione e per evitare errori alfa e beta.

L’aggiustamento dei dati secondo Mantel Haenszel si ottiene con una modifica del 2di Pearson.

Mentre nel Pearson si fa lo somma di tanti rapporti fra scarti quadratici tra valori osservati e valori attesi

sotto ipotesi nulla rapportati ai valori attesi quante sono le caselle della tavola di contingenza, nel

Mantel Haenszel ci si focalizza sui casi patologici osservati negli esposti al rischio, cioè sulla sola casella

A così come si presenta nei vari strati considerati (nel nostro esempio g=4)

22

2

Pearson

O A2

A

g

2

MantelHaen

szel

O

AA

2

A

1

g

var A

1

Immaginando di costruire una tavola di contingenza per ognuno dei g possibili strati, si otterrebbe per

ogni strato questa tabella:

Non

esposti

Bg

Dg

n0g

Esposti

Malati

Non malati

Ag

Cg

n1g

m1g

m0g

ng

Il chi quadro verrebbe calcolato dallo strato 1 allo strato G in questo modo:

g

2

MantelHaen

szel

O

A

AA

1

g

var A

2

n1g m1g

A

1 g

n

g

g

n1g n0 g m1g m0 g

g

2

1

n g2 n g 1

1

Il denominatore rispecchia le leggi della distribuzione di probabilità binomiale, mentre a numeratore la frazione

n1g m1g

ng

non è altro che il modo per calcolare i valori attesi della casella esposti e malati nei vari strati

possibili.

Il vantaggio di procedere in questo modo è l’ottenere un chi quadro aggiustato per fattori confondenti.

In modo analogo è stato possibile aggiustare anche l’odd ratio, ottenendo un valore che è depurato da eventuali

fattori confondenti.

OR

ad

cb

g

OR MantelHaenszel

1

g

1

ag d g

ng

c g bg

ng

Ovviamente anche l’OR secondo Mantel Haenszel prevede i soliti limiti di confidenza (calcolati in modo

ancora più complesso, con l’ausilio degli esponenziali). Vale sempre la regola che un tale OR è

significativo se i due limiti di confidenza sono entrambe maggiori o minori dell’unità.

Il test del chi quadro per trend prevede di seguire una coorte di persone esposte per un certo

periodo di tempo a intervalli regolari. Questo gruppo si dividerà “eventi” e “non eventi”, cioè in

malati e non malati. Al tempo 0 si ha ovviamente la condizione basale che, per convenzione, ha un

OR = 1. Gli altri OR vengono calcolati come segue:

23

tempo

0

1

2

3

4

5

Malati

a

c

e

g

i

m

Non malati

b

d

f

h

l

n

OR

1 per convenzione

ad/bc

af/eb

ah/gb

al/ib

an/mb

Dopo di che si valuta se gli OR vanno calando o crescendo regolarmente in funzione lineare con il

passare del tempo. Se hanno variazioni irregolari, sopra e sotto l’unità, il fenomeno appare del

tutto casuale e non statisticamente significativo. Non si puo’ in tal caso rifiutare l’ipotesi nulla.

24

Riassumendo, quando si debba verificare nel tempo l’effetto di una terapia (dati appaiati)

parametri espressi in scala nominale, occorre:

su

A PRIORI

Impostare il quesito (ipotesi nulla e ipotesi alternativa)

Valutare la differenza (di frequenza di guarigioni, ad esempio) definita come clinicamente

significativa, l’errore alfa e l’errore beta che si accetta (potenza dello studio)

Calcolare il numero minimo di soggetti da campionare

Decidere i criteri di inclusione e di esclusione dallo studio (eccessiva gravità della situazione

clinica, età…)

Ottenere il consenso informato dai pazienti selezionati

Effettuare le valutazioni

Studio per dati

appaiati

2 valutazioni

2 di Mc Nemar

>2 valutazioni

2 per trend

25

Capitolo 2: I test di ipotesi per misure non appaiate

Spesso in medicina ci si pone il problema di valutare “di quanto” un trattamento sia in

grado di modificare uno dei tanti parametri che si utilizzano per valutare lo stato di

salute o di malattia dei pazienti.

In questo caso non si utilizzano più le categorie “guarito, migliorato, ammalato, deceduto…”, ma ci

si porta ad un più sofisticato livello di conoscenza utilizzando misure che servono quali indicatori di

esito (ad esempio tutte le valutazioni laboratoristiche, le misure antropometriche, gli esiti valutati

considerando il tempo di guarigione o di ricaduta…)

Lo schema intuitivo di questo tipo di studi puo’ essere così rappresentato, essendo il gruppo A

studiato e valutato contemporaneamente al gruppo B e, ove i test statistici lo consentano, al gruppo

C o D…

I 2 o 3 o più gruppi, costituiti da campioni provenienti dal medesimo universo vengono sottoposti a

trattamenti diversi.

26

A trattamento concluso, si verificano i risultati nei tre campioni. È possibile trarre

conclusioni sull’efficacia dei diversi trattamenti utilizzando ad esempio le variazioni di

altezza di un certo parametro clinico come indicatore di esito della terapia (nelle figure

rappresentato come altezza dei vari ometti).

Se poi l’indicatore scelto sia il più adatto per valutare l’esito della terapia… è problema più medico

che statistico! Certo che la scelta di un indicatore inadatto inficia tutto il lavoro statistico.

27

t di Student per dati non appaiati

Differenze s.s. tra misure di due popolazioni differenti secondo Gosset

La sperimentazione si può impostare nel modo già visto precedentemente. Se dosiamo la

clearance renale a un campione numeroso (500 persone con lievi problemi renali) che seguono

però una dieta appropriata, otteniamo questa curva di distribuzione dei valori del test:

Valutando la clearance renale a 500 nefropatici che seguono una dieta squilibrata e

troppo ricca di proteine, otteniamo questa curva spostata verso i valori più bassi:

Riportandole insieme sugli assi cartesiani si puo’ verificare se vi è differenza tra i 500

nefropatici che seguono una dieta corretta e gli altri 500.

28

dieta scorretta

dieta corretta

Confrontando le medie, cioè i vertici delle due curve pare certamente che la dieta

corretta sia efficace nel migliorare la clearance, ma se si osservano le basi, possono

sorgere dei dubbi. Alcuni pazienti che seguono dieta incongrua hanno valori superiori

(più “normali”) rispetto ad alcuni pazienti che si alimentano in maniera corretta!!!

Per rispondere al quesito: "la dieta prescritta fa migliorare la clearance dei

nefropatici?” è assolutamente importante vedere il fenomeno nel suo insieme:

rappresentando le due curve contemporaneamente sugli assi cartesiani

tenendo presenti i limiti di confidenza al 95% delle due popolazioni, che sono 90-110 cc. per

chi segue la dieta corretta e 25-95 cc. per gli altri. I limiti si intersecano, anche se la differenza

tra le medie è rilevante (100cc.-60cc.=40cc.).

La situazione è qui schematizzata in modo diverso:

i punti centrali più scuri sono le medie e appaiono ben distanti

le aree grigie comprendono i limiti di confidenza al 95%, quelle bianche i limiti di

confidenza al 99%

Le aree bianche si intersecano e si sovrappongono, quindi la differenza puo’ esser più

apparente che reale

A

B

Poniamo che

29

l’obiettivo dello studio sia valutare se vi è una differenza tra le misure della clearance di chi

segue una dieta appropriata e quelle di chi segue una dieta incongrua

si sia precedentemente valutata la differenza minima clinicamente significativa (ad es.

una clearance che sia superiore di almeno 15 cc/minuto) per cui la numerosità dei due gruppi

sia congrua a quanto si va cercando

si accetti di sbagliare affermando che la dieta è efficace con una probabilità pari a 0,05 (errore

alfa)

si accetti di sbagliare affermando che la dieta è inefficace con una probabilità pari a 0,10

(errore beta), quindi una potenza della studio di 0.9=90%

Per rispondere alla domanda sull’efficacia della dieta è necessario:

misurare la differenza tra le clearance dei pazienti dei due gruppi

valutare se la misura di tale differenza è tanto grande da rendere improbabile (p<0,05) il fatto

che si sia potuta verificare per caso.

La differenza tra le clearances dei due gruppi si puo’ calcolare dalla differenza tra i valori medi,

come 100-60=40. E’ o dovrebbe esser noto dai precedenti capitoli che anche per pura casualità si

possono verificare delle differenze anche cospicue tra due diversi campioni del medesimo insieme

(pazienti nefropatici). In altre parole la differenza di 40, pur notevole, potrebbe esser dovuta agli

effetti del campionamento, non a quelli della dieta.

Per valutare la probabilità che una simile differenza si verifichi per caso occorre rapportarla ad un

qualche valore di riferimento (il concetto non dovrebbe risultare particolarmente ostico agli

operatori sanitari: per decidere se una persona è o meno ipertesa, si fa riferimento al valore

desiderabile di pressione arteriosa diastolica, che non dovrebbe superare gli 80 mm. Hg).

Lo strumento per misurare la casualità di fenomeni questo tipo è stato inventato quasi

un secolo fa da William Gosset e si tratta della statistica "t di Student per dati non

appaiati".

A molti verrebbe istintivo valutare semplicemente la differenza fra le medie.

A Gosset venne in mente un concetto più approfondito: che tale differenza poteva essere grande o

piccola a seconda della "variabilità del fenomeno".

Mai intuizione fu più corretta e condivisibile: una cifra di 10 euro è elevata per chi abbia un reddito

giornaliero di 50 euro, mentre puo’ esser risibile per chi abbia un reddito di 300 euro al giorno!

A questa intuizione è seguita una ricerca scientifica (di tipo matematico) che ha portato poi a

valutare la variabilità del fenomeno "differenza fra misure di popolazioni" e a dimostrare che

l'errore standard della differenza tra due medie campionarie è uguale alla radice quadrata della

somma delle varianze delle due popolazioni divisa per il rispettivo effettivo.

Di primo acchito non tutti comprendono perché l’errore standard di una differenza tra medie… si

calcoli con una somma, né questa è la sede per complesse dimostrazioni matematiche.

Intuitivamente, però, si puo’ comprendere perchè la variabilità del fenomeno “differenza tra coppie

di misure” è maggiore della variabilità delle misure di una singola popolazione.

Si veda questo esempio esplicativo:

Popolazione A (range di 20)

110

90

100

95

Popolazione B (range di 20)

50

70

60

55

30

105

65

Se si calcola la differenza di tutte le misure di A con le misure della popolazione B, i valori assoluti

delle misure sono:

60

40

50

45

35

40

20

30

35

45

50

30

40

40

50

55

35

45

30

40

45

45

35

55

Il range della differenza tra due popolazioni di misure è 40 (contro il range di 20 delle singole

popolazioni A e B): del resto sottraendo dalla misura più grande la più piccola, è ovvio che si

ottenga un numero grande e sottraendo dalla più piccola la più grande, invece, un numero molto

piccolo.

Il “funzionamento” del test puo’ esser così schematizzato, con le due popolazioni a confronto

inserite nella reale variabilità o errore standard del fenomeno “differenza tra le misure delle

popolazioni”.

B

A

Gosset decise di valutare la probabilità che una certa differenza tra medie di due popolazioni fosse

puramente casuale rapportandola (cioè misurandola) sulla base dell’errore standard del fenomeno

secondo questa formula:

t

mA mB

sA2 s2A

nA nB

ove

a numeratore si ha la differenza tra le medie delle due popolazioni (dieta corretta e dieta

non corretta)

a denominatore la radice quadrata della somma di due frazioni costituite dal rapporto fra le

varianze e gli effettivi di dette popolazioni

Dalla formula suindicata uscirà un certo valore di t.

A tale valore di t corrisponderà una probabilità di essersi verificato per caso che si ricava dalla

distribuzione di student (già precalcolata da Gosset stesso).

Nell’esempio presentato, si avrebbe la seguente situazione:

Dieta corretta

Dieta scorretta

m=100

m=30

s=5

s=4

n=500

n=500

Differenza tra le

medie=+70

t=243.414 G.L.=998 P<0.0001

31

La distribuzione di student qui sotto raffigurata è ottenuta dalle distribuzioni di frequenza dei

valori di t che si possono avere estraendo a caso due campioni di misure da un medesimo

universo.

È una curva a campana che assomiglia moltissimo alla curva di Gauss, ma è leggermente più bassa

e larga (più platicurtica). Come la curva di Gauss tende asintoticamente all’asse y ed è simmetrica

I valori di t possibili sono infiniti, alcuni positivi e alcuni negativi, come si puo' immaginare vedendo

la formula:

t

mA mB

sA2 s2A

nA nB

quando mA<mB, allora t <0, mentre quando mA>mB, allora t >0.

Quanto più "t" è grande (o piccolo, se negativo), tanto meno diviene probabile che la differenza fra

le medie sia avvenuta per caso, infatti ci si avvicina a valori di che corrispondono a livelli di

probabilità bassissimi sull’asse delle ordinate.

Simmetricamente rispetto allo 0 si distinguono due punti che sono i valori critici della

funzione discriminante, cioè quelli che delimitano una area sottesa dalla curva uguale

al 95% del totale.

Valori di t superiori o inferiori (se negativi) si verificheranno quindi con p<0,05.

Bisogna tenere presente che:

all'inizio dello studio non si puo’ sempre sapere se mA<mB o mA=mB o mA<mBi. Per questo si

considera come valore critico quello che delimita a destra e a sinistra dell'asse y una p=0,025.

La somma di queste due "code" fa appunto p=0,05.

I valori critici della funzione discriminante variano a seconda della numerosità dei gruppi in

esame, in funzione dei gradi di libertà

32

I gradi di libertà del t di student per dati non appaiati si calcolano tenendo presente che si fanno in

pratica 2 stime campionarie:

una della popolazione A, con nA pazienti, i GL saranno quindi in questo settore na-1

una della popolazione B, con nB pazienti, i GL saranno quindi in questo settore nB-1

i casi possono appartenere o alla popolazione A o alla popolazione B (unione di probabilità).

I GL del test risultano essere quindi nA-1+nB-1= nA+nB-2

Quando i GL sono molto grandi, la curva di student diventa assolutamente sovrapponibile alla

curva di Gauss standardizzata.

Quando i gradi di libertà sono molti la curva di Student si fa sempre meno platicurtica, finchè, per

effettivi intorno a 200, diventa sovrapponibile alla curva di Gauss normalizzata. In questo caso,

ovviamente, utilizzando il test a due code saranno sufficienti valori di t<-1,96 o >+1,96 per

ottenere la significatività statistica.

Il t di Student puo’ esser utilizzato, eccezionalmente, a una sola coda. Questo è possibile

farlo soltanto quando sia matematicamente certo che il valore di t possa esser soltanto o

negativo o positivo (occorre sapere che un certo fenomeno determina sicuramente o un

aumento o una diminuzione della media e in pratica questo lo si sa con certezza ben di

rado). Ad es., se studiassimo due gruppi di emorragici ciascuno con Hb variabile da 6 a 7

g%cc e somministrassimo al gruppo A emazie concentrate ed al gruppo B del plasma… beh,

è certo che in media il gruppo A presenterà livelli di emoglobina superiori a quelli del gruppo

B! In tal caso la significatività statistica si puo’ raggiungere anche con valori di t<0 ma

inferiori a quelli solitamente richiesti nel test a due code, perché essendo ovvio che la media

di A sia superiore, occorre identificare il punto che racchiuda una superficie del 5% da una

sola parte della curva invece che dalle due parti.

Se ogni gruppo di emorragici comprendesse 100 pazienti, sarebbe sufficiente un t>+1,64 ed

è ovvio che 1,64<1,96. Altrettanto ovvio è o dovrebbe essere che situazioni simili si

presentano eccezionalmente

33

CONTROINDICAZIONI ALL’IMPIEGO DEL TEST:

t

mA mB

sA2 s2A

nA nB

Eteroschedasticità dei due campioni: in presenza di varianze molto dissimili, il test puo’ esser

inaffidabile. Intuitivamente,

1. osservando il denominatore, che è in termini statistici, il "metro" di misura del fenomeno, si

rileva che il fenomeno stesso viene misurato sulla base della varianza dei due campioni.

Sarebbe auspicabile che tale varianza fosse ben determinata e fissa (è il metro di misura!)

2. osservando il numeratore, che rappresenta il fenomeno da misurare, si rileva che esso è

definito sulla base di due medie stimate, sarebbe auspicabile che fossero stimate con errori

standard (e quindi limiti di confidenza) non troppo diversi tra loro

Anormalità distributiva delle misure dei due campioni, particolarmente per distribuzioni

estremamente asimmetriche

f. Osservando il numeratore, si rileva che esso misura la differenza tra due medie. È ormai noto

che soltanto per distribuzioni di tipo normale, non troppo asimmetriche , la media è un

indicatore di tendenza centrale migliore della mediana. Se la distribuzione fosse troppo

asimmetrica, la nostra stima sarebbe molto poco affidabile. Come sarebbe poi la stima della

differenza tra queste due medie poco affidabili?

g. È stato dimostrato su base matematica con simulazioni che quando la numerosità dei campioni

è almeno >30 (secondo altri autori >100), il vincolo della normalità diventa meno importante.

Numerosità insufficiente puo’ esser causa di errore beta. Anche in questo, come in tutti i test

statistici, la numerosità minima indispensabile andrebbe calcolata a priori, in base:

alla differenza minima tra le medie che si ritiene clinicamente significativa (per intendersi, una

variazione di 1 nella clearance sarebbe matematicamente significativa, ma clinicamente

irrilevante

alla variabilità presentata in natura dalla misura che si sta considerando, identificabile

nell’errore standard di quella misura. Non è certo un problema conoscerlo! Basta:

o considerare i “valori normali” che vengono riportati a fianco di ogni determinazione

e che altro non sono che i limiti di confidenza al 95% di tale test nella popolazione

sana. Generalmente si tratta di valutazioni effettuate su vastissimi campioni, quindi

si possono applicare i concetti della normale standardizzata e dei suoi valori

notevoli.

o dividere l’intervallo di confidenza, cioè la differenza tra il valore maggiore e il minore

per il doppio di 1,96

o si ottiene l’errore standard

e.s.

LSC95% LIC 95%

2 1,96

al livello di errore alfa e beta che si accetta

applicare la seguente formula:

n

2 e.s.2

mA mB

2

f ,

ove f , è un fattore moltiplicativo che varia a seconda dell'errore alfa e beta che si sceglie:

34

f ,

10,8

13,5

15,8

17,8

8,6

10,5

13

14,9

6,2

7,9

10

11,7

2,7

3,8

5,4

6,6

Lo si individua dall'incrocio degli errori alfa e beta accettati.

35

Analisi della varianza monofattoriale

Differenze s.s. tra misure non appaiate secondo Fisher

Einstein ha scritto che la massima aspirazione che puo' avere uno scienziato moderno è quella di

fare una scoperta che sopravviva nel tempo come caso particolare di un’ altra scoperta più valida

ed efficace.

E' esattamente quello che è successo a William Gosset, il cui t di Student ha ispirato, ma è stato

superato dalla analisi della varianza di Fisher (uno statistico degli anni '50).

Attualmente qualsiasi farmaco che debba esser introdotto nella farmacopea ufficiale deve

contemporaneamente dimostrare di esser migliore del vecchio farmaco migliore e migliore del

placebo: sono quindi necessari almeno tre confronti.

Il problema che puo’ nascere dall’utilizzo del t di Student per confronti multipli è detto “inflazione

dell’errore alfa” e rappresenta un problema che puo’ verificarsi in generale in caso di applicazione

non corretta delle tecniche statistiche.

Nel caso specifico, dovendo confrontare tra loro tre gruppi, accadrebbe quanto sintetizzato nella

figura seguente:

A

p=0,05

p=0,05

B

p=0,05

C

Confrontanto A e B si accetta un errore alfa con p=0,05….idem nel confronto fra B e C e in

quello fra C ed A. l’errore alfa totale diventa così con p=0,15!!!

Teoricamente si potrebbe adottare il t di Student applicando una teoria geniale nella sua semplicità

che deriva dal teorema di Bonferroni (un professore universitario italiano: 1892-1960).

Tale applicazione consente di rimediare al problema accettando per ogni confronto un livello di

probabilità di errore alfa pari a p

0,05

. Semplice come l’uovo di Colombo! Nel caso su

nconfronti

riportato la correzione di Bonferroni consiste nell’accettare per ogni confronto un errore alfa con

p< 0,016

36

A

p< 0,016

B

p< 0,016

p< 0,016

C

In tal caso l’errore alfa totale è pari a 0,016 0,016 0,016 0,05

Se i gruppi fossero più numerosi, questo modo di procedere potrebbe esser molto disagevole,

perché i test da eseguire diventerebbero troppo numerosi.

5

Se i gruppi fossero anche solo 5, i confronti sarebbero:

2

5 5 2 1

10 .

2

Per evitare l'inflazione dell'errore di prima specie ogni test sarebbe accettato solo per

0,05

0,005 , in modo che l'errore totale sia ≤0,05. Si finirebbe per accettare un errore alfa

10

molto piccolo e questo potrebbe portare al rischio di un errore beta che tende ad aumentare ogni

volta che si richiede un errore alfa molti piccolo!

Il test di Bonferroni viene solitamente applicato subito dopo l’analisi della varianza (che puo’

arrivare a dimostrare che è altamente improbabile che tre o più gruppi siano uguali tra loro) per

indagare tra quali di questi gruppi si trovi la differenza (o meglio la non-uguaglianza) maggiore.

Quando i gruppi siano maggiori di 10, il test di Bonferroni diventa troppo conservativo e si utilizza

allora il test di Tuckey che è analogo, ma è formulato in modo tale da risentire meno della

numerosità dei gruppi considerati.

Per questo per confronti fra più di due gruppi di valori in scala di misure è opportuno utilizzare

l’ANOVA di Fisher.

L’anova di Fisher rapporta fra loro due misure di variabilità o dispersione:

– La varianza delle medie campionarie dalla stima dell’universale (TRA)

– La variabilità totale dei campioni considerata all’interno dei singoli gruppi (INTRA).

La formula di questo test è ben più complicata di quella del t di Student, ma per fortuna il calcolo è

affidato ai computer e qui si cercherà soltanto di comprendere il concetto che sta alla base del

test.

Intanto si osservi un fatto certamente già noto dagli studi liceali: la distanza tra due punti si calcola

facilmente:

37

, basta fare la differenza fra la posizione di un soggetto e quella del

secondo.

Non è per nulla immediato, invece, dire quanto siano distanti quei tre soggetti sotto indicati!

Occorre prendere un punto di riferimento (la bandierina) e calcolare

la distanza di ognuno dei tre soggetti dalla bandierina, sommare le

tre distanze e, volendo conoscere una distanza media, si divide per

tre.

Immaginiamo che

i tre ometti rappresentino il valore medio di un certo indicatore in soggetti trattati con

terapia A (valore = 130), con terapia B (valore = 170), e con placebo (valore = 120),

la bandierina sia la media delle tre medie (la media delle medie dei soggetti trattati con

terapia A, con terapia B e con placebo)

Il ragionamento di Fisher è stato il seguente:

• I tre campioni sono costituiti da esseri umani provenienti dal medesimo universo.

• Le differenze sono soltanto imputabili al fenomeno del campionamento, non ai farmaci

(ipotesi nulla).

• 130+170+120/3=140 si potrebbe considerare una stima della media universale.

Una qualunque misura xa=36, quindi, se viene rispettato quanto sopra detto avrà una distanza dalla

media universale pari alla sua distanza dalla media di gruppo (120) sommata alla distanza della

media di gruppo (120) dalla media delle medie

~

xa m xa 120 120 140 36 120 20 104

120

xa=36

130

140

170

Se sono vere le considerazioni di Fisher (sotto ipotesi nulla) la distanza così calcolata non puo’

esser molto diversa da un semplice 140-36=104

38

xa=36

130

120

170

140

120

Ogni elemento dei tre campioni disterà dalla media universale di un intervallo calcolabile in due

diversi modi (somma di distanza intra e distanza tra oppure distanza totale):

Campioni

Distanza

INTRA

Distanza

TRA

Distanza totale

A

(xA - 130) + (130-140)

= xA - 140

B

(xB - 170) + (170-140)

= xB - 140

C

(xC - 120) + (120-140)

= xC - 140

Trasformiamo le distanze o scarti in devianze, così come si è fatto già nelle prime pagine del

capitolo 1°

39

Campioni

Devianza

INTRA

Devianza

TRA

(xA - 130)2

(130-140) 2

A

B

C

(xB - 170)

(xC - 120)

2

2

(170-140)

2

(120-140)

2

Trasformiamo le devianze in varianze, dividendo

la somma delle devianze intra per i gradi di libertà, che, avendo effettuato tre stime delle

tre medie di A, B e C, saranno pari a n A 1 nB 1 nc 1

la somma delle devianze tra per i gradi di libertà, che avendo effettuato la sola stima della

media delle medie saranno pari a 3-1.

La formula della F di Fisher, quindi è, per 3 confronti:

m A m 2 m B m 2 mC m 2

F

x

A

mA

2

var ianza spiegata

var ianza TRA

3 1

2

2

var ianza INTRA

var ianza residua

x B m B x C mC

n A n B nc 3

Il numeratore della frazione indica le differenze eventualmente imputabili ai diversi trattamenti. Più

grande è il numeratore, più è probabile che l’ipotesi nulla sia falsa

Il denominatore indica invece la variabilità del fenomeno influenzata dal campionamento. Più

grande è il denominatore più probabile è che l’ipotesi nulla sia falsa, a meno che il numeratore

abbia un valore molto molto grande.

Per F intorno a 1, è praticamente sicura l’ipotesi nulla!!!

Anche Fisher, come Gosset prima di lui, ha predisposto uno “strumento di misura” che è la

distribuzione di probabilità F di Fisher, qui sotto disegnata per 1 grado di libertà

40

Anche l’F di Fisher ha infiniti valori, tutti positivi, però. Per tale motivo lo si definisce “test a una

coda”.

La curva è stata costruita calcolando con simulazioni matematiche tutti i possibili valori di F che si

possono ottenere dalla formula estraendo da un insieme k campioni in modo assolutamente

casuale, per cui eventuali apparenti differenze siano imputabili al campionamento, non al

trattamento.

È intuitivo che più grandi sono i valori di F meno probabile è che si siano verificati per caso.

Nella curva di distribuzione di F bisogna ricordare che:

interseca l'asse delle ordinate (quando le k medie coincidono)

ha un massimo per F=1 (quando varianza TRA=varianza INTRA)

sottende un'area di valore 1=100%

esiste un “valore critico della funzione discriminante” dal quale, innalzando la

perpendicolare, si delimita una coda che ha area uguale al 5% del totale

se dalla formula esce un F>punto critico della funzione discriminante, il test è significativo.

Il che significa che la probabilità che i k campioni non siano uguali soltanto per effetto del

campionamento è < 0,05

cambia a seconda dei gradi di libertà della varianza intra e della varianza tra, quindi cambia

anche il valore critico nei vari tipi di studio che possono esser fatti.

Esistono delle tavole cartacee che danno i valori critici, ma il computer in genere le ha

memorizzate nel proprio algoritmo.

La curva di distribuzione cambia a seconda dei gradi di libertà del numeratore e del denominatore

e come si vede tende ad assomigliare alla curva di distribuzione delle medie campionarie quando i

gradi di libertà siano >100.

41

Ricordando che:

varianza totale = varianza tra gruppi + varianza intra gruppi

se F=1, significa che VARIANZA TRA = VARIANZA INTRA, quindi la varianza tra gruppi

concorre soltanto per il 50% a formare la varianza totale del fenomeno (poco per poter

affermare che i k gruppi non sono uguali tra loro se non per caso, cioè per effetto del

campionamento).

Se F<1, significa che VARIANZA TRA < VARIANZA INTRA, quindi la varianza tra gruppi

concorre soltanto per meno del 50% a formare la varianza totale del fenomeno (è quindi

decisamente poco influente rispetto alla variabilità casuale del fenomeno).

Se F>1, significa che VARIANZA TRA > VARIANZA INTRA, quindi la varianza tra gruppi

concorre soltanto per più del 50% a formare la varianza totale del fenomeno (è quindi

decisamente più importante rispetto alla variabilità casuale del fenomeno). Quanto più

grande è il valore di F, tanto più questo è vero. Quanto più grande è il valore di F, tanto più

improbabile è che le differenze riscontrate siano imputabili al caso, cioè che siano effetto

del campionamento, più che del trattamento.

CONTROINDICAZIONI ALL’IMPIEGO DEL TEST:

F

var spiegat a

varTRA

var INTRA varresidua

Eteroschedasticità dei campioni, cioè presenza di varianze molto dissimili, il test puo’ esser

inaffidabile. Intuitivamente,

3. osservando la formula, il "metro" di misura del fenomeno sono proprio le varianze. Sarebbe

auspicabile fossero dei valori stabili (sono il metro di misura!)

Anormalità distributiva delle misure dei campioni, cioè distribuzioni estremamente

asimmetriche